Der Autor hat inzwischen einige Studien und Positionspapiere sowohl von NGOs, wie auch Landesregierungen zum unaufhaltsamen Öko-Energiewende-Umbau in Deutschland gelesen und seine (persönlichen) Einschätzungen dazu in mehreren EIKE-Artikeln vermittelt [4; 5; 6; 7].

Zudem beäugte er vor einiger Zeit ausführlich die Umsetzung der Energiewende in Bayern kritisch "warum gehen in Bayern die Lichter noch nicht aus"[4]. Klar, dass er da auf das aktuelle Positionspapier des CSU Arbeitskreises Energiewende "BR Info CSU AK Energiewende" [2] gespannt war um zu sehen, wie die CSU die in der damaligen Analyse [4] gelisteten Probleme inzwischen gelöst hat und welche richtungsweisenden Maßnahmen daraus auf dem CSU-Parteitag am 20.November beschlossen werden könnten .

In der EIKE Publizierung [7] kam bereits eine kurze Info darüber, anbei folgt nun eine abschließende Fassung.

Einleitung

Wer als Bürger der Energiewende sowieso bereits überdrüssig ist und darüber vorn und hinten nichts mehr hören kann – braucht dieses CSU-Positionspapier nicht zu lesen. Es bietet nämlich wirklich nichts Neues, außer der Erkenntnis: „Wir wissen nicht wie, machen aber konsequent so weiter“.

Kurzfassung:

· Keine Fakten, keine Lösungsstrategien, keine Zahlen

· Aber 38 Mal „Wir fordern“ und 12 Mal „Wir fordern Fördern“ im Sinn von Subventionieren

· Im Wesentlichen eine Auflistung längst bekannter Statements ohne aktualisierende Betrachtungen

Ein Fazit vorab: Die Welt hat dieses Paper bisher nicht vermisst und wird es auch nicht vermissen.

Eigentlich schade. An dem Papier haben nicht nur Juristen und Lehrer mitgewirkt, sondern auch technische Fachleute – was der Anlass zur Überlegung ist, ob Politik das eigene Wissen zerstört, oder zumindest dauerhaft unterdrückt.

Vorgeschichte

Ein Hauptautor des aktuellen CSU-Positionspapiers hat bereits als „junger Spund“ in der Jungen Union an einem Vorgängerdokument mitgearbeitet. Damals (Ende 2009) hieß es „Konzeptpapier für eine sichere und klimafreundliche Energie-Versorgung“ [1]. Dieses JU Konzeptpapier ist ca. drei Mal so dick wie das aktuelle und kann wohl als eine Basis davon betrachtet werden.

Wer es sich antut auch dieses Paper zu lesen, stellt etwas Verblüffendes fest:

In diesem JU Positionspapier werden ebenfalls keinerlei Strategien und Zahlen genannt,

dafür aber 190 Forderungen zur „Energiewende“, an die eigene Partei gestellt.

Der Autor stellt sich vor wie es wäre, in der Industrie mit einer wichtigen Problembearbeitung beauftragt zu werden und im Abschlussdokument dann nirgendwo eine Lösungen, aber 190 Forderungen an die Firma zu listen und vor versammelter Mannschaft dem Chef zu präsentieren. Einer Beförderung wäre das kaum dienlich. In politischen Parteien schein das jedoch der Start zum Aufstieg zu sein.

Der Autor hätte das „JU Paper“ sang und klanglos als „Jugendsünde“ verschwinden lassen. Doch Politiker sind auch auf so etwas stolz und verlinken es für die Nachwelt (und einen EIKE-Artikel) auf ihrer Homepage.

Das Positionspapier des CSU Arbeitskreises Energiewende

Anlass der Energiewende

Im JU Konzeptpapier von 2009 steht:

[1] Das "Stern Review on Economics of Climate Change" (Stern Report) und der UN Klimabericht (IPCC Report) haben gezeigt, dass der Klimaschutz eine Überlebensfrage ist, da der Menschheit irreparable negative ökologische und ökonomische Auswirkungen drohen. Neben Gefahren für den Menschen bedroht die globale Erderwärmung auch die Artenvielfalt von Flora und Fauna. Wegen steigender Temperaturen drohen große Teile des Amazonas-Dschungels mit rund 40.000 Pflanzen- und ca. 42753 Säugetierarten zu versteppen.

Im CSU Positionspapier vom August 2015 lautet es:

[2] In der vom ehemaligen Chefökonom der Weltbank, Nicholas Stern, in 2006 ausgearbeiteten Risikoanalyse „The Economics of Climate Change“ wurde nachgewiesen, dass die aus dem 38 Klimawandel resultierenden Anpassungsstrategien etwa 25-mal teurer sind als die Vermeidungsstrategien und deshalb eine weitere zögerliche Umsetzung der Energiewende 40 volkswirtschaftlich unverantwortbar ist.

Auf die Notwendigkeit der Energiewende wurde bereits im Jahr 1992 auf der UN- Umweltkonferenz in Rio de Janeiro verwiesen und eine schnelle Senkung des Verbrauchs an fossilen Energieträgern gefordert. Diese Forderung wurde in den nachfolgenden Jahren durch die Enquete-Kommission „Schutz der Erdatmosphäre“ des Deutschen Bundestags konkretisiert und in den letzten beiden Jahrzehnten auf mehreren internationalen Klimakonferenzen unter Berücksichtigung neuerer Ergebnisse aus der Wissenschaft und Wirtschaft (IPCC) weiter vertieft.

Trotz unterschiedlicher nationaler Interessen besteht inzwischen internationale Übereinstimmung, den weiteren Klimawandel durch eine signifikante Reduktion der globalen CO2-Emission auf einen Temperaturanstieg von nicht mehr als +2°C zu begrenzen und damit die derzeit kaum abschätzbaren Folgewirkungen zu vermeiden. Diese Zielvorgabe wurde auf dem G7-Gipfel im Juni 2015 auf bayerischem Boden nochmals bekräftigt. Die Bedeutung der Energiewende wurde schließlich im Juli 2015 56 durch die päpstliche Enzyklika „Laudato Si“ verdeutlicht, die schnelle und umfassende Maßnahmen zur Energiewende und Klimaschutz anmahnt.

Der „Stern-Report“ ist ein heftigst umstrittenes Papier. Seine Präzision liegt wohl in der Größenordnung der vielen vollkommen falschen Vorhersagen des Club of Rome (lesenswerter Essay dazu "Die Klimamacher") , der wohl als einer der Ersten Computersimulationen als Wahrheiten verkündete. Nur weil es so herrlich apokalyptisch ist, hat er die Zeiten überlebt. Wer etwas Hintergrund erfahren möchte, sollte eine Kritik zu diesem Stern-Report auf „Achgut“ nachlesen: unbequem ist stets genehm. Zitat aus dem Achgut-Artikel:

Der Stern-Report lässt ganze Landstriche verdörren, Küsten werden überflutet, Millionenheere von Klimaflüchtlingen sind obdachlos, zahllose Tierarten sterben aus, die sich ausbreitende Malaria kostet Millionen neue Opfer. Jeder einzelne dieser Punkte ist Gegenstand heftiger Debatten, doch Nicholas Stern nimmt die Spekulationen als Tatsache.

Wer einen so umstrittenen Bericht über Jahre immer wieder als Begründung anführt, zeigt nicht unbedingt ein Engagement, auch Ökodogmen einmal kritisch zu hinterfragen. Eine päpstliche Enzyklika (eine Inhaltskritik dazu: " Ein vergifteter Köder aus Rom") sozusagen als „Belegverdopplung“ zuzufügen, zeugt dann eher von einem Hang zu „Öko-Esoterik“ und lässt sich vielleicht mit dem „C“ im Name erklären. Doch wird damit eher der Rest von wissenschaftlichem Anstrich verspielt.

Und das ewige 2 Grad Ziel fehlt auch bei der CSU nie. Dabei ist es keinesfalls plausibel. Aber oft und lang genug gesagt, darf man daran nicht mehr zweifeln – sofern man in der Politik ist. Denn andere tun es, Beispiel: "Das 2 Grad Klima-Ziel ein politisches Konstrukt". Daraus zitiert:

[8] Der Natur eine "Erwärmungs-Schranke" von 2 Grad vorzuschreiben ist ein Kunst-Stück’chen, das im Land der Dichter & Denker der WBGU [] 1996/97 erfunden hat. Der WBGU erwirkte auch, daß diese willkürliche "2°-Marke" in Richtlinien der EU aufgenommen wurde, schließlich 2007 sogar in die EU-Energie-Strategie. Danach erreichte diese Zahl auch die UN-Klimakonferenzen (COP’s), erstmals in Kopenhagen 2009. Dagegen hat der Klimarat IPCC die 2° stets nur im Rahmen von vielen Emissions-Szenarien diskutiert, jedoch nie(!) als "Ziel-Vorstellung" akzeptiert. Das ist schlüssig, weil kein wissenschaftlich gesicherter Zusammenhang zwischen CO2-Emissionen und Temperaturen existiert. Gegenteilige Behauptungen beruhen auf Modell-Annahmen. Die 2° sind eine Lottozahl.

Wer es nicht glaubt, sollte sich im Fernsehmittschnitt leibhaftig anhören, wie Herr Prof. Schellnhuber vom PIK an der Zeitstelle 5.40 erklärt, dass der „Erdkörper“ genau so wie der menschliche Körper bei + 2 ºC fiebert und ab + 3 ºC stirbt: "Schellnhuber und das 2 Grad-Ziel" – und der Moderator gläubig zuhört. Kein Wunder, dass der Papst und Herr Schellnhuber sich zusammen gefunden haben.

Der (Un-)Sinn der CO2-Vermeidung

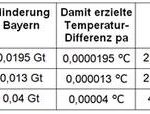

Obwohl am CSU Positionspapier genügend wirkliche Fachleute mitgearbeitet haben, wurde es auch darin sorgfältig vermieden, selbst eine einfachste Nutzenbetrachtung anzustellen. Für Bayern kann man zusätzlich die der bayerischen CO2-Minderungsmaßnahme zufügen, da diese im Irrsinn geradezu phänomenal ist (siehe: "Das bayerische CO2-Minderungsprogramm ohne jeglichen Nutzeffekt"" [9]). Es ist bezeichnend, dass selbst über Jahre nicht einmal ein zuständiger Arbeitskreis sich die Mühe macht (oder es verhindert), solch einfache Betrachtungen anzustellen. Deshalb macht es der Autor:

Wirkung einer sofortigen Dekarbonisierung Deutschlands

Es sind und bleiben selbst bei sofortiger, vollständiger Umsetzung und gerechnet mit dem viel zu hohen IPCC-Forcing weniger als 0,001 °C pa, siehe:"CO2-Rechenbeispiele" Deutschlands diesjährige Erhöhung der Maximaltemperatur um 0,1 °C gegenüber dem Stand von vor 32 Jahren lässt sich damit ab dem Jahr 2050 in weiteren 100 Jahren „zurückdrehen“.

Die Plazebo-Wirkung des bayerischen CO2-Minderungsprogrammes

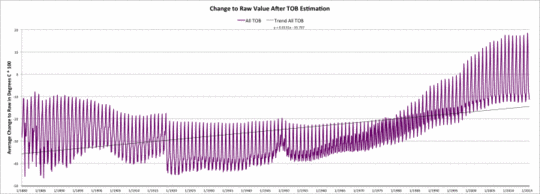

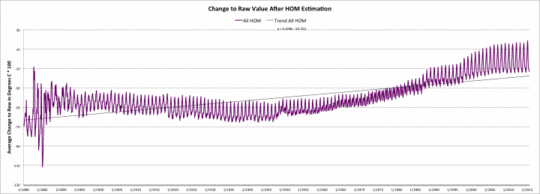

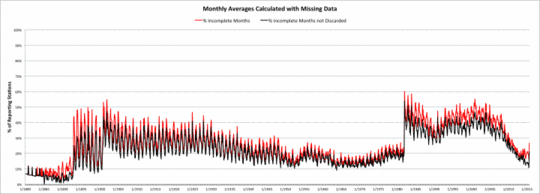

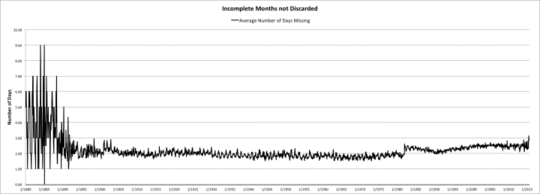

Bild2[9] Nutzentabelle des bayerischen CO2-Minderungsprogrammes

Fazit

Man kann die Energiewende vielleicht mit irgend etwas begründen, aber bestimmt nicht mit einem CO2-Nutzen.

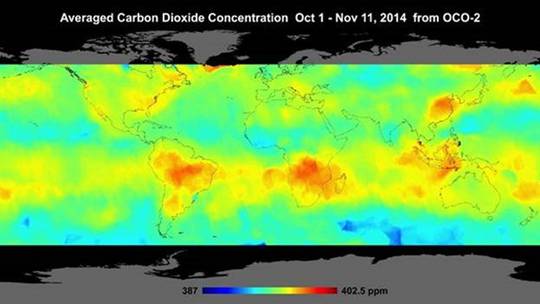

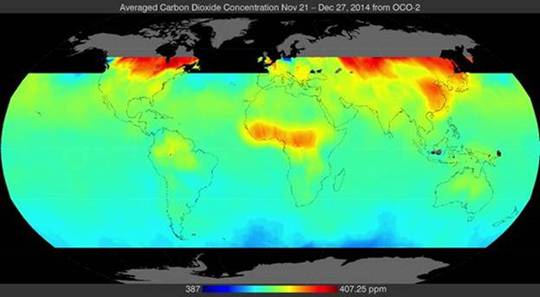

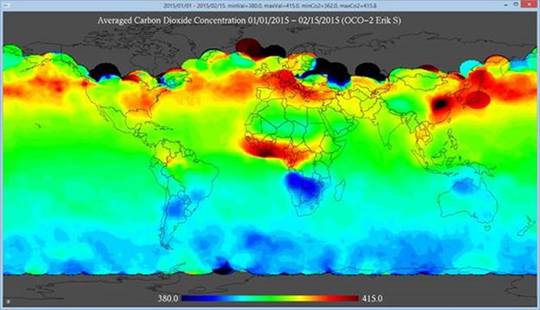

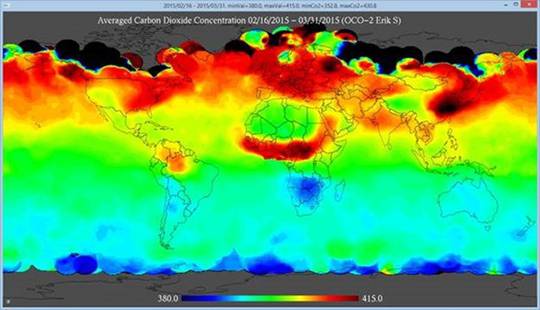

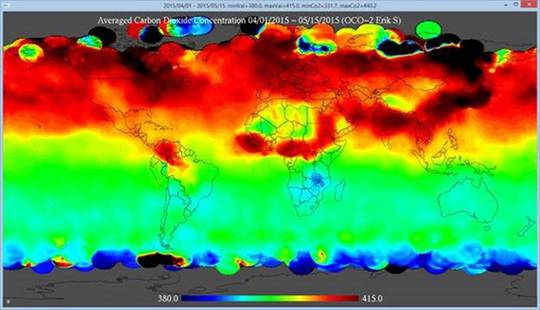

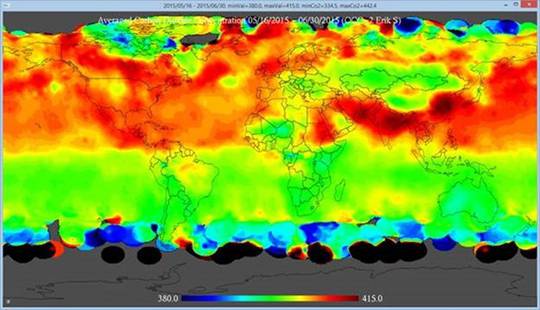

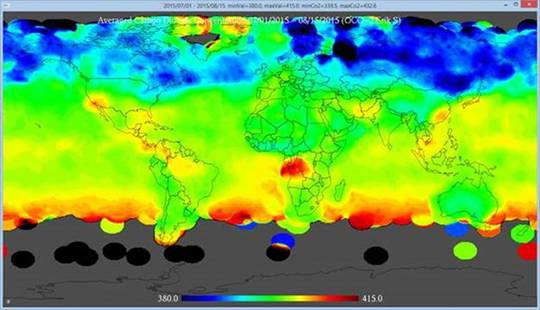

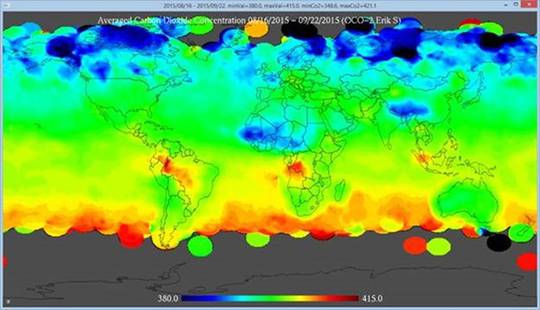

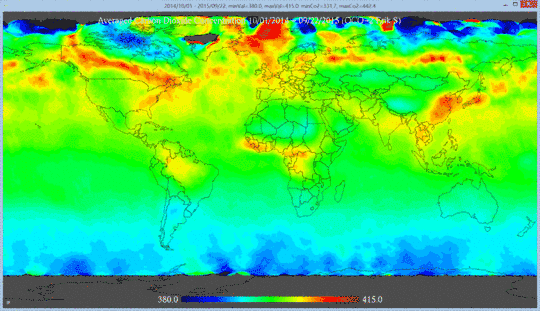

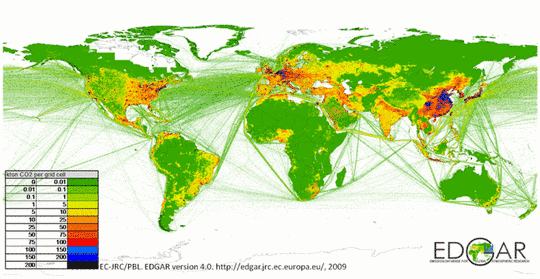

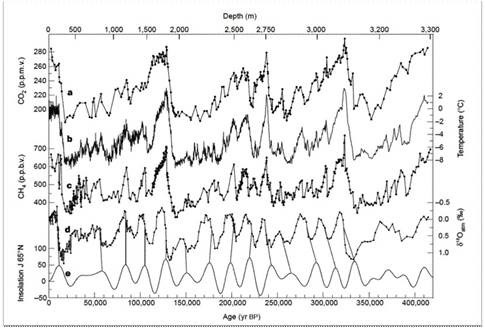

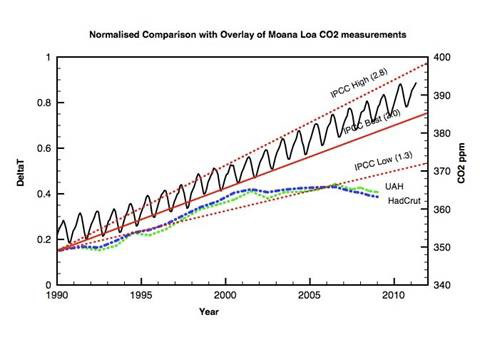

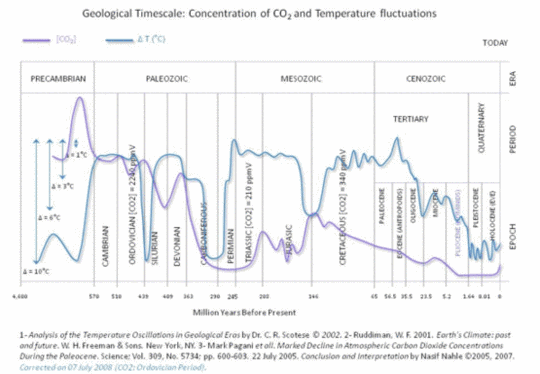

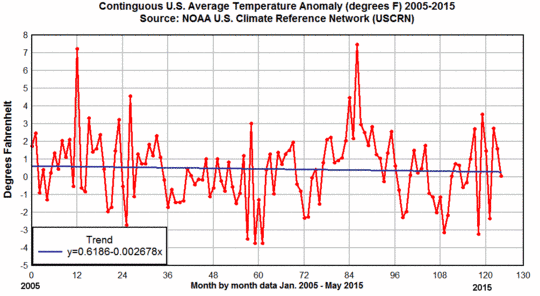

Ob das CO2 überhaupt das Klima wesentlich (nach IPCC-Szenario) beeinflusst, kann man zusätzlich bezweifeln. Aber dann würde nicht nur der Nutzen, sondern das Gebäude zusammenfallen. Als Denkanstoß zu solchen klimaketzerischen Gedanken anbei die Info aus [7].

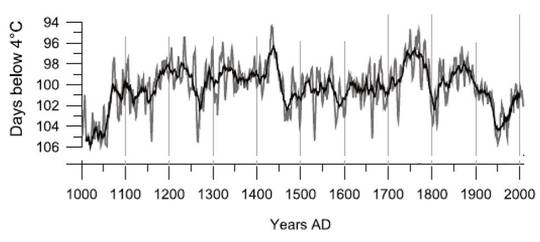

Im folgenden Bild 3 (Langfrist-Temperaturreihe von FfM) sieht man deutlich, dass CO2 und Temperaturverlauf über weite Jahrzehnte keinerlei Korrelation aufweisen und oft sogar gegenläufig sind. Zuerst stieg auch die untere Temperaturlinie und erst danach das CO2. Ein sonderbarer Effekt der Maximaltemperatur-Deckelung über zwei Jahrhunderte und ein plötzlicher Sprung ab 1985 sind deutlich erkennbar. Wie lässt sich das auch nur im Ansatz mit dem CO2-Forcing-Verlauf erklären?

Bild 3: Jahresmitteltemperatur Frankfurt a.M. Flughafen 1785 – 2014 (nach Christian-D. Schönwiese, dmg-ev.de Heft 02 2015 ISSN 0177-8501). Mit Ergänzungen und Zufügung des CO2-Verlaufs durch den Autor.

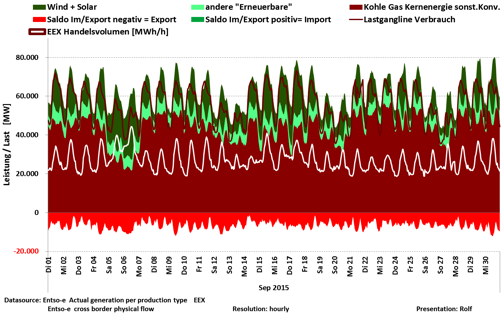

Der Zustand der Energiewende in Bayern

Im Rahmen einer recht umfassenden Analyse "warum gehen in Bayern die Lichter noch nicht aus"[4] wurde vom Autor bereits der Zustand und die vorhandenen Probleme dargestellt. Doch lassen wir eine Bayerische Ministerin selbst sagen, wie es darum steht. Anlässlich der 2. Sitzung der Plattform Energie Bayern am 18. Dezember 2014 in München stellte Ministerin Aigner höchstpersönlich lt. Protokoll fest. Zitate:

· Wir werden nach dem Abschalten der letzten Kernkraftwerke eine Lücke sowohl bei der Stromerzeugung als auch bei der gesicherten Leistung haben.

· Wir haben aus der Zwischenbilanz der Arbeitsgruppe 2 mitgenommen, dass Speichertechnologien zur Verringerung der Deckungslücke bei der Stromerzeugung keinen Beitrag leisten können. Auch der Beitrag zur Verringerung der Lücke bei der gesicherten Leistung bleibt mittelfristig gering.

· Wir haben aus der Arbeitsgruppe 3 erfahren, dass die Beiträge von Wasserkraft und Geothermie zur Stromerzeugung nicht wesentlich zu steigern sind.

· Wir erwarten, dass das bei Photovoltaik und Wind anders ist ..

· Einen Beitrag zur Schließung der Kapazitätslücke (gesicherte Leistung!) leisten die erneuerbaren Energien kaum.

· Dennoch werden wir alle Anstrengungen unternehmen, den Ausbau der erneuerbaren Energie weiter voranzutreiben.

In einer Publizierung der CSU Senioren Union von 2014 steht:

[17] Nach neuen Daten des Bayerischen Staatsministeriums für Wirtschaft und Medien, Energie und Technologie und des Umwelt- und Energieministeriums Baden-Württemberg ist die Stromversorgung für Bayern und Süddeutschland bereits ab 2016 (siehe Grafik) gefährdet. Aussagen der Bundesnetzagentur bezüglich der Versorgungssicherheit erscheinen fragwürdig.

Die Lücke zwischen der Höchstlast und der sinkenden gesicherten Leistung in Bayern wird stetig größer und beträgt ~3 GW im Jahr 2018 (dena). Das Leistungsdefizit wird in Bayern und Baden-Württemberg nach 2018 stetig steigen (BnetzA). Die Deckungslücke kann aus heutiger Sicht nicht gedeckt werden.

Die Lage wird dramatisch.

Diese Statements waren der Anlass zur einleitenden Beurteilung der bayerischen Strategie:

„Wir wissen nicht wie, machen aber konsequent so weiter“.

Als ob davon schon etwas zum Bund gedrungen wäre, informiert das Bundesamt für Bevölkerungsschutz inzwischen den deutschen Bürger per Broschüre[16] und Videoclip[15], wie er sich gegenüber Stromausfällen schützen kann. Der öko-sozialistische Energie-Fortschritt klopft an die Türen.

Bild4 [17] Screenshot vom aktuellen Video des Bundesamtes für Bevölkerungsschutz und Katastrophenhilfe

Die Energiewende und das Speicherproblem

Das inzwischen erkannte, größte Problem der Energiewende – welches zu deren Scheitern führen kann – sind die fehlenden Speicher[7].

Also darf man erwarten, dass ein aktuelles Paper speziell darauf eingeht. Und da man schon in der Energiewende mitten drin ist, auch mit richtungsweisenden Feststellungen und Aussagen. Genau das tut es aber nicht – außer man hält Forderungen dafür. Ausschnitte:

[2] Entwicklung bzw. Ausbau von Strom- und Wärmespeichern

Der Erfolg der Energiewende steht und fällt mit der Bereitstellung eines geeigneten Mix an effizienter Speichertechnologien für Strom und Wärme, die sowohl den kurzfristigen als auch mittel- und langfristigen Speicherbedarf abdecken und darüber hinaus eine hohe Effizienz aufweisen und schnelle Abrufbarkeit gewährleisten.

Daraus wird sofort ersichtlich, dass in der Speichertechnologie ein massiver Nachholbedarf besteht, der in Anbetracht des zu erwartenden Marktpotenzials von der Forschung und Wirtschaft aufgegriffen worden ist. Diese Anstrengungen haben zur Entwicklung neuer Produkte und Verfahren im Bereich der dezentralen Wärme- und Stromspeicher geführt, die aber wegen der hohen Baukosten bzw. der noch vorhandenen geringen Effizienz der Anlagen nicht oder nur in einem geringen Umfang in den Markt eingebracht werden konnten.

Der AKE fordert deshalb, Forschung und Entwicklung im Bereich der Wärme- und Stromspeicher zu intensivieren und die Markteinführung dieser Techniken, insbesondere für dezentrale Speichertechnologien durch eine Anschubfinanzierung zu unterstützen.

Allerdings war das im JU Konzeptpapier auch schon so. Bereits darin wurde das Speicherproblem unterschätzt und zudem technisch massiv falsch bewertet.

JU Konzeptpapier [1]

Es hat den Anschein, dass nur eine dezentrale und kleinteilige Speicherung der elektrischen Energie zukunftssicher und erfolgsversprechend ist.

Dezentrale Speicherung von Strom

Der Jungen Union erscheint die dezentrale Speicherung von Strom als angemessener Lösungsweg. Dabei müssen dezentrale Energiespeicher, von Kondensatoren zur Pufferung von kurzfristigsten Schwankungen über Schwungräder und Akkumulatoren bis hin zu unterirdischen Druckluftspeichern zum Ausgleich von mittelfristigen Schwankungen, so mit den Verbrauchern vernetzt werden,

Bewertungen (des Autors) zu den technischen Aussagen:

Kondensatoren als (große) Energiespeicher sind sinnlos, da das elektrische Feld im Gegensatz zum magnetischen wesentlich weniger Energieinhalt besitzt. Aus diesem Grund gab es noch nie kapazitive Großspeicher und sie kommen in keiner seriösen Analyse (mehr) vor.

Von Druckluftspeicher gibt es aktuell (nach zwischenzeitlich 9 Jahren) weltweit erst zwei größere Anlagen, eine weitere soll 2017 in Texas in Betrieb gehen[13]. Abhängig davon, ob als Kurzzeit- oder Langzeitspeicher verwendet, gibt es unterschiedliche Probleme. Z.B. erreichen sie als Langzeitspeicher nicht über 50% Wirkungsgrad und erfordern ca. 21 Cent/kWh Prozesskosten[13].

Von Schwungrädern als (Groß-) Energiespeicher redet heute ebenfalls keiner mehr. Diese Idee ist sang und klanglos in der Versenkung verschwunden.

Nach vergangenen sechs Jahren (bezogen auf das JU Konzeptpapier bis heute) zu diesem systemrelevanten Kernthema, welches eigentlich das Papier füllen müsste, nicht mehr vorzulegen, bzw. weit unter dem Niveau vergleichbarer Ausarbeitungen anderer Bundesländer zu bleiben (Beispiel „Niedersachsen-Studie“[13], (Information darüber in: "Untersuchung Energiespeicher"10]) macht die aktuelle CSU-Ausarbeitung praktisch wertlos.

Power to Gas

Auch dazu exemplarisch eine Darstellung des Unterschieds zwischen dem unverbindlichem „Gebabbel“ des CSU Positionspapiers und seriösen Analysen.

Greenpeace (sonst bestimmt kein „Freund“ des Autors) schreibt dazu:

[12] Dafür müssen wir vor allem die Wind und Solarenergie zügig auszubauen. Aber wenn die Energiewende erfolgreich sein soll, benötigen wir darüber hinaus auch eine Speicherwende. … Das funktioniert vor allem in Form von Windgas, also per Elektrolyse erzeugtem Wasserstoff, der in einem weiteren Schritt zu Methan gewandelt werden kann. Damit lässt sich der deutsche Energiebedarf bei Windflauten oder in Phasen mit wenig Sonnenlicht aus diesen erneuerbaren Speichern volkswirtschaftlich günstig decken, auch über längere Zeiträume, wie die neue Studie zeigt.

Danach kommen wenigsten rudimentäre Kostenbetrachtungen.

Die umfangreiche „Niedersachsen-Studie“[13], schreibt dazu (ganz kurze Auszüge):

Erklärung der Prozessvarianten

[13] Im Rahmen der Studie werden folgende Pfade der Wasserstoffspeicherung betrachtet:

· Speicherung von H2 in Kavernen (P2H2) mit anschließender Rückverstromung durch Brennstoffzelle

· Direkte Einspeisung von H2 in das Erdgasnetz (P2H2) mit anschließender Rückverstromung durch Brennstoffzelle

· Methanisierung von H2 und Einspeisung in das Erdgasnetz (P2G) mit anschließender Rückverstromung durch Brennstoffzelle

Dann folgen fundierte Daten

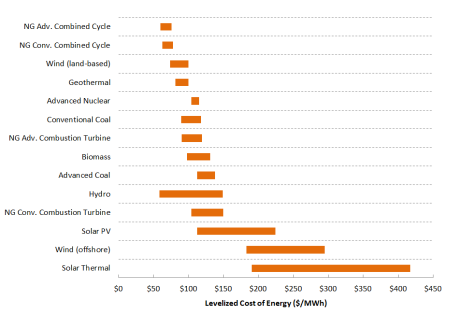

[13] Der Wirkungsgrad bei einer Power-to-Power (kurz P2P; Ausgangsprodukt und Endprodukt sind Strom) Anlage wird in der Literatur zwischen 21 und 43 % angegeben (Pehnt 2009).

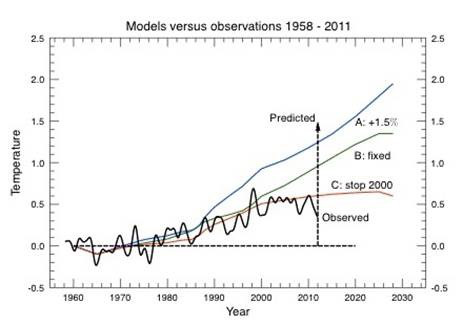

Unterstützt mit Grafiken

Bild 5[13] Wirkungsgrade von Speichersystemen.

Anm.: PSW ist Pumpspeicherwerk; AA-CAES ist Druckluftspeicher; die anderen sind Power to Gas -Speicher

Und Kostenangaben

[13] Für den Referenz H2-Speicher betragen die spezifischen Kosten der Speicherkapazität bei einer Auslegung als Kurzfristspeicher rd. 36 €/kWh. Bei einer Auslegung als Mittelfristspeicher betragen diese rd. 6 €/kWh, als Langfristspeicher nur noch 0,3 €/kWh.

Im CSU Positionspapier finden sich zu dieser systemrelevanten Basistechnologie außer Allgemeinplätzen keine verwertbaren Information. Weder zur Einstufung / Positionierung, nicht zu den technischen Varianten, nicht zum Forschungsstand, kein Hinweis auf den Stand von Pilotanlagen, und keinerlei Kostendarstellungen.

[2] CSU-Positionspapier: Power-to-Gas

Das Power-to-Gas-Verfahren ist damit insgesamt ein vielversprechender Ansatz für eine langfristige Speicherung von Strom und für eine Substitution von fossilen Energieträgern in der Wirtschaft. Das Verfahren hat insgesamt noch ein hohes Entwicklungspotenzial und wesentliche Verbesserungsmöglichkeiten für einen operationellen Einsatz im kommenden Stromverbund und in der Wirtschaft.

Der AKE fordert deshalb die Staatsregierung auf, die Entwicklung dieses zukunftsweisenden Speichersystems voranzutreiben und im Rahmen von Pilotvorhaben zu erproben, in denen die Elektrolyseure, die Energiewirtschaft, die Anwenderindustrie sowie die Gasnetz- und Stromnetzbetreiber und Hersteller von Systemkomponenten eng zusammenarbeiten.

Darüber hinaus muss eine Anschubfinanzierung für die Markteinführung der Power-to-Gas Technologie, insbesondere für dezentrale Speicheranlagen, bereitgestellt werden.

Es stellt sich die Frage, wie die CSU-Politiker mit solcher pseudo- Information versorgt, vernünftige Entscheidungen fällen sollen. Oder der Sinn ist, die Entscheidungsvorlagen – wenn man nichts weiß, immer vorsichtshalber Geld ausgeben -, nicht durch Hintergrundwissen zu beeinflussen.

Geothermie

Im Wesentlichen geht es im CSU Strategiepapier so unverbindlich und oberflächlich weiter. Beispielhaft dazu abschließend die Information zur Geothermie.

Im CSU Positionspapier steht:

[2] Besonders wichtige Energiequellen sind die Wasserkraft und die Geothermie, die zusammen wesentlich zur Grundlastsicherung von Strom und Wärme in Bayern beitragen können.

Schauen wir einmal nach, was die Realität dazu sagt. Aktuell ist der Anteil an Geothermie-Stromerzeugung in Bayern mit 0,05 TWh gelistet (Bild 6). Das ist bei 90 TWh Gesamtverbrauch ein Anteil von 0,056 %. Nirgendwo ist ein Ausbau in Bayern erkennbar, eher ein „Dahindümpeln“ hoffnungsvoll begonnener Projekte. Der Energie-Atlas Bayern listet aktuell 4 Projekte mit zusammen 49 Mio. kWh (0,055%). Bei solchen Daten von „hohem Energiepotential“ und „wesentlich zur Grundlastsicherung … beitragen können“ zu schreiben, ist verwegen.

Mit Geothermie ist natürlich nicht nur die Stromerzeugung gemeint. Aber die Geothermie-Wärmeerzeugung hat zwar lt. verschiedenen Studien „viel Potential“. aber wirklich sehen kann man davon nicht viel. Sicher auch, weildie Investitionskosten und Risiken hoch sind. Wohl nicht zufällig finden sich auf der entsprechenden Infoseite des Bay. Ministeriums dazu keine Zahlen.

Bild 6[11] Elektro-Energiehaushalt Bayern im Jahr 2013

Fazit

So oberflächlich, orientierungslos, unkonkret, ohne Terminhorizonte und vollkommen ohne Kostenangaben geht es in dem CSU-Papier weiter. Deshalb belassen wir es bei dieser exemplarischen Sichtung und schauen stattdessen auf ein „vergessenes“ Thema, die Atomkraft.

Kernkraft

Im JU Konzeptpapier war dazu eine umfangreiche Stellungnahme hinterlegt. Positiver als diese kann man die Atomkraft kaum beschreiben:

[1] JU Konzeptpapier

Seit über 30 Jahren liefert die friedliche Nutzung der Kernspaltung sauberen, sicheren und nach haltigen Strom zur Versorgung des Freistaates Bayern. Die notwendige und international beschlossene weitere Reduktion der Treibhausgase ist ohne die Übergangstechnologie Kernenergie besonders in Bayern mit einem Anteil von 60 % Nuklearstrom in absehbarer Zeit nicht machbar.

Deutschlands Kernkraftwerke sind unser wichtigster Beitrag zur Treibhausgasreduzierung

Darüber hinaus liefern Kernkraftwerke einen doppelten Beitrag zum wirtschaftlichen Wachstum Deutschlands. Einerseits wird in Kernkraftwerken konkurrenzlos kostengünstiger Strom unter an derem für Industrie, Eisenbahn und Privathaushalte erzeugt. Insbesondere bei energieintensiver Großtechnologie ist preisgünstiger Strom (z. B. Kupfer- und Aluminiumhütten) einer der entscheidenden Standortfaktoren. Zugleich ist Deutschland Standort einer der weltweit führenden Anbieter von Kernkraftwerken, Komponenten für Kernkraftwerke und Dienstleistungen in Kernkraftwerken. In Deutschland hängen ca. vierzigtausend Arbeitsplätze unmittelbar an dieser Branche.

Das theoretische Restrisiko für einen Störfall in deutschen KKW liegt mehrere Größenordnungen unter der Wahrscheinlichkeit sonstiger, allgemeiner Lebensrisiken.

Unter strenger Beachtung der Sicherheitsaspekte fordern wir deshalb eine Verlängerung der Laufzeiten der Kernkraftwerke und einen Ausstieg aus dem politisch motivierten Ausstieg der rot-grünen Koalition.

Die Betriebserlaubnis der Kernkraftwerke soll grundsätzlich unbegrenzt gültig sein und einzig von dem technischen Zustand der Anlage abhängen. Insbesondere erscheint uns ein Alleingang der Bundesrepublik Deutschland im Atomausstieg sinnlos, da die Folgen eines Vorfalls grenzüber schreitende Folgen hätten.

Falls für den Einstieg in die zukünftige Wasserstoffwirtschaft oder für den Klimaschutz der Neubau von Kernkraftwerken notwendig wird, sollte sich Deutschland diesem nicht prinzipiell verschließen.

Im aktuellen CSU Positionspapier steht:

[2] CSU Positionspapier

Die Bundesregierung hat in Anbetracht dieser Ausgangslage am 28. September 2010 beschlossen, die CO2-Emissionen in Deutschland bis 2020 um 40% und bis 2050 um 80 bis 60 95% – bezogen auf das Jahr 1990 – zu reduzieren. Dieser Beschluss gewinnt durch die Anfang 2011 getroffene Vereinbarung der Bundesregierung zum Ausstieg aus der Kernenergie bis zum Jahr 2022 insofern an zusätzlicher Brisanz, als jetzt auch noch der CO2-freie Anteil der Kernenergie an der Stromversorgung durch Erneuerbare Energien ersetzt werden muss und dadurch die Anstrengungen zum Erreichen der Energiewende deutlich steigen. Besonders betroffen davon ist Bayern, das in Spitzenzeiten der Kernenergienutzung 30% seiner Primärenergie bzw. bis zu 60% der Stromversorgung durch Kernkraftwerke abgedeckt hat.

…Gleichzeitig werden geopolitische Abhängigkeiten gesenkt, das Kernenergierisiko eliminiert…

…Unabhängig davon unterstützt der AKE die europaweiten Forschungsaktivitäten zur Kernfusion.

Über Vorteile und Nutzen der Kernenergie ist nichts mehr zu finden. Am Schluss kommt nur noch ziemlich verloren ein Hinweis, dass es auch Kernfusion gibt, welche der CSU AKE (mit Gedanken?, als Alibi?) unterstützt. Irgendwelche Angaben oder gar ein Antrag dazu fehlen. Sogar die SPD denkt da inzwischen wieder weiter. Zumindest diskutieren Genossen darüber[14].

Und nun halte sich jeder EIKE-Leser fest: Die oberste Klimaalarm-Dauer-Heulzeitung SZ brachte in der Wochenend-Ausgabe Nr. 227 wieder einen der regelmäßigen, typischen, halbseitigen Klimaalarmartikel, Titel „Klimakrieger“[19]. Und was liest man da:

[19 „… Ihre einzige (Anm.: Frau Merkels) umweltpolische Leistung entpuppte sich dann schon bald als Lobby-getriebene Klimasünde. Ihr populistischer Ausstieg aus der Atomenergie nach der Fukushima-Katastrophe führte jedenfalls nicht nur zu einem enormen Anstieg an Kohleverbrennung. Sie zog zudem die weitere Verteufelung jener Brückentechnologie nach sich, die bis zur Entwicklung funktionierender globaler Wind- und Sonnenenergienetze für den Kampf gegen den Klimawandel unentbehrlich bleiben wird“.

In sozialistischen Ländern wusste man nach einer solchen Meldung, dass eine „Säuberungswelle“ im Anmarsch ist. Mal sehen, was daraus im Öko-sozialistischen Deutschland wird. Der Autor hat sich schon lange gefragt , warum die SZ ihren Lesern vorenthält, dass alle „Klima-Vorzeigeländer“ einschließlich der USA massiv auf Atomkraft setzen. Irgend Jemand hat bei der SZ nun einen Schalter umgelegt und geht in strikte Opposition zu den bisher gehätschelten Grünen, deren bayerischer Fraktionsvorsitzender als selbsternannter Energieexperte vor noch nicht allzu langer Zeit in einem SZ Interview verkünden durfte:

[20] SZ Interview: …Kritiker der Energiewende führten lange an, mit jedem AKW, das vom Netz geht, würden vermehrt alte Kohle- oder Gasanlagen reaktiviert. Das wird nicht geschehen, zumindest nicht in spürbarem Ausmaß. Windkraft und Solarstrom haben das Potenzial, den Wegfall des Atomstroms aus Grafenrheinfeld zu kompensieren.

Fazit

Unüberlesbar ist in der Zeit zwischen den zwei Studienausgaben eine konsequente „Gehirnwäsche“ offensichtlich. Es wird klar, dass in diesem Positionspapier keinesfalls die „Wahrheit“ beschrieben werden sollte. Ausschließlich das derzeit politisch Erlaubte durfte gelistet und mit Begründungsversuchen versehen werden.

Vielleicht hinkt der CSU-Arbeitskreis damit der Zeit hinterher und hat eine beginnende Wende noch gar nicht mitbekommen. Was wäre, wenn deshalb am 20.11. auf dem Parteitag versehentlich das „falsche Vorwärts“ abgestimmt wird?

Somit lautet Erwartungs-gemäß das Schlussstatement des CSU Positionspapiers politisch über-korrekt:

[2] Auch potenzielle, kostenintensive Anpassungsstrategien im Fall eines Klimawandels können durch die Energiewende massiv minimiert werden.

Die Energiewende ist damit ein risikoarmes und generationengerechtes Investitionsvorhaben, das mit positiven sozialen, ökologischen und ökonomischen Gewinnerwartungen verbunden ist.

Fast könne man meinen, doch noch eine nicht ganz „niedergebügelte“ Opposition herauslesen zu können „im Fall eines Klimawandels“ in einem offiziellen Politikpapier hinterlegt, klingt schon sehr verdächtig. Aber die anderen Aussagen negieren diesen „Protestkeim“ sofort wieder. Und irgendwie belegt oder mit Werten versehen sind die Schlussaussagen ebenfalls wieder nicht.

Der letzte Satz kommt einem Kundigen allerdings bekannt vor. In einer Publizierung des Fraunhofer IWES kann man die Quelle finden:

[18] Fraunhofer IWES: Dabei wird verkannt, dass die Energiewende ein risikoarmes Investitionsvorhaben mit positiver Gewinnerwartung darstellt.

Nur fehlt im CSU Leitpapier eine wichtige Zusatzinformation daraus: Nämlich die darin ebenfalls angegebenen Umbaukosten von 1.500 Milliarden EUR für Deutschland. Rechnet man das auf die Einwohnerzahl um, fallen für Bayern anteilige 230 Milliarden Euro an, oder 4,5 komplette Jahreshaushalte Bayerns. Solch eine unwichtige Nebeninformation bracht man in einem Positionspapier nicht zu erwähnen.

Zudem, um dank Bayern die Erde vor 0,00004 ºC pa Temperaturerhöhung zu retten, sind solche Summen ja geradezu Peanuts.

Bei den Gewinnerwartungen kann man aber wenigstens die Richtung ahnen, wenn man die folgende Zusatzinfo richtig deutet:

Der federführende Autor des CSU-Leitpapiers, Prof. Dr. Wolfgang Seiler ist auch Vorstandsvorsitzender der Bürgerstiftung „Energiewende Oberland“ (Bad Tölz).

Diese Bürgerstiftung im bisher nicht durch sonderliche Umsetzung von Ökoenergie-Gewinnung (z.B. durch Windparks) bekannten Landkreis hat so gute Ideen (im Ausgeben von Geld des Bürgers), dass zu einer Sitzung gleich der Präsident von General Electric Deutschland anreiste, die lokalen Bankenvorstände sowieso.

Kein Wunder, das Vorhaben „SmartEnergy Region Oberland“ wird gemeinsam von Interessensvertretern aus Gesellschaft, Wirtschaft und Politik erstellt – was man wörtlich nehmen kann.

Schlussbetrachtung

An den bereits in der vorhergehenden Analyse über die Umsetzung der bayerischen Energiewende [4] gemachten Feststellungen hat sich mit dem neuen Positionspapier nichts geändert:

Die Umsetzung bleibt weiterhin:

· Nicht durch Fakten begründet,

· unsinnig und vollkommen konzeptlos,

· mit keinerlei Kostenhinweisen hinterlegt.

· Aber inzwischen werden die Profiteure besser eingebunden.

Wenn etwas nicht so richtig klappt, wird wie überall erst einmal umorganisiert. So aktuell auch der bayerische Klimarat, dessen Gremium von der bayerischen Umweltministerin ganz neu besetzt wurde. Die künftigen Mitglieder sind:

Prof. Dr. Karen Pitte, Professorin für Volkswirtschaftslehre

Prof. Dr. Jörg Völkel, Geographie, Biologie, Bodenkunde und Geologie

Prof. Dr. Harald Lesch, Astrophysiker, Philosophie, Wissenschaftsjournalist

Lt. der bayerischen Umweltministerin (Ausbildung: Studierte Betriebswirtin) liefert der Klimarat damit belastbare Ergebnisse für unsere politischen Entscheidungen“ [21]. Belastungen für den Bürger werden es auf jeden Fall werden.

Quellen

[1]

JU Konzeptpapier. CSU Junge Union, Arbeitskreis Umwelt und Energie, Projektleitung: Anja Weisgerber, Kurt Höller 29. November 2008: Konzeptpapier Für eine sichere und klimafreundliche Energie-Versorgung

[2]

CSU Positionspapier. CSU AK Energiewende 31. 08. 2015: Positionspapier Energiewende; Energiewende ganzheitlich anpacken, Produktion -Verteilung -Speicherung -Nutzung

[3]

CSU Dr. Kurt Höller Partei-Homepage

Neues Energiekonzept der JU Bayern unter Erlanger Federführung, Update: Arbeitskreis Energiewende gegründet

http://www.kurt-hoeller.de/

[4]

EIKE 02.07.2015: Der Wind bläst stetig– die Sonne steht still – wenn mein starker Arm es will oder warum gehen in Bayern die Lichter (noch) nicht aus

http://www.eike-klima-energie.eu/energie-anzeige/der-wind-blaest-stetig-die-sonne-steht-still-wenn-mein-starker-arm-es-will-oder-warum-gehen-in-bayern-die-lichter-noch-nicht-aus/

[5]

EIKE 18.06.2015: Elektro-Energiespeicherung, Notwendigkeit, Status und Kosten. Teil 3 (Abschluss)

[6]

EIKE 28.8.2015: Wenn Politologinnen "Klimastudien" machen – zur "Klimastudie" von Bündnis 90/Die Grünen

[7]

EIKE 28.09.2015: Greenpeace eNERGIE und IWES Fraunhofer fordern die vollständige Dekarbonisierung Deutschlands bis zum Jahr 2050 – die Politik macht angefeuert durch die Medien begeistert mit.

[8]

EIKE 12.06.2015: Das "2°-Klima-Z i e l“ – Ein politisches Konstrukt !

http://www.eike-klima-energie.eu/news-cache/das-2-klima-z-i-e-l-ein-politisches-konstrukt/

[9]

EIKE 16.09.2015: Nachgefragt: CO2 Minderungsprogramm der bayerischen Landesregierung – ohne den geringsten Klimanutzen, aber mit extremen Kosten

http://www.eike-klima-energie.eu/news-cache/nachgefragt-co2-minderungsprogramm-der-bayerischen-landesregierung-ohne-den-geringsten-klimanutzen-aber-mit-extremen-kosten/

[10]

EIKE 18.06.2015: Elektro-Energiespeicherung, Notwendigkeit, Status und Kosten. Teil 3 (Abschluss)

http://www.eike-klima-energie.eu/energie-anzeige/elektro-energiespeicherung-notwendigkeit-status-und-kosten-teil-3-abschluss/

[11]

Bericht 2013/14. Bayerisches Staatsministerium für Wirtschaft. Fortschrittsbereich 2013 / 2014 Zum Umbau der Stromversorgung Bayerns

[12]

GREENPEACE eNERGIE Studie Kurzfassung: Warum Windgas die Energiewende sicher macht und Kosten senkt

[13]

Niedersachsen-Studie 2014. Innovationszentrum Niedersachsen GmbH, Juli 2014. Studie 7983P01/FICHT-12919463-v19:“Erstellung eines Entwicklungskonzeptes Energiespeicher in Niedersachsen

[14]

SPD-Bezirk Braunschweig 20. Mai 2015: „Es darf keine Forschungsverbote in Deutschland geben“

[15]

Ruhrkultour: Stromausfall – Vorsorge und Selbsthilfe – Ein Ratgeber des Bundesamtes BBK

http://ruhrkultour.de/stromausfall-vorsorge-und-selbsthilfe-ein-ratgeber-des-bundesamtes/

[16]

BBK Datum 10.06.2015 Informationsbroschüre: Stromausfall Vorsorge und Selbsthilfe

http://www.bbk.bund.de/SharedDocs/Downloads/BBK/DE/Publikationen/PublikationenKritis/Stromausfall_Vorsorge_u_Selbsthilfe.html

[17]

CSU Senioren Union. SEN AG Energie. Energiewende Informationsblatt 02.2/2014

[18]

FRAUNHOFER IWES, Jan. 2014 Publikation: GESCHÄFTSMODELL ENERGIEWENDE Eine Antwort auf das „Die-Kosten-der-Energiewende“-Argument

[19]

Süddeutsche Zeitung 1. Oktober 2015: Essay Klimakrieger

http://www.sueddeutsche.de/kultur/essay-klimakrieger-1.2673550?reduced=true

[20]

Süddeutsche Zeitung Nr. 139. Artikel: „Die Lichter brennen weiter“, bzw. „Was das Aus für Grafenrheinfeld bedeutet“.

www.sueddeutsche.de/bayern/droht-der-blackout-die-lichter-brennen-weiter-1.2528576

[21]

Süddeutsche Zeitung Nr. 227: Drei Neue für den bayerischen Klimarat