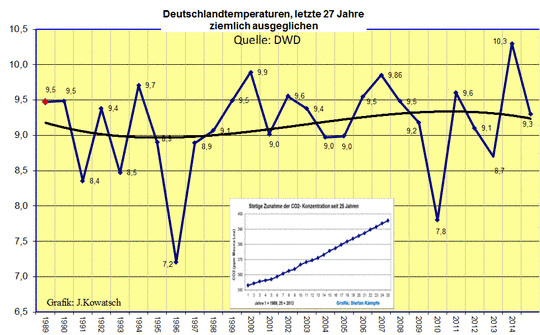

Die große Dekarbonisierungslüge – Teil 1: Halbwahrheiten und Unterschlagungen

In den Kalkgesteinen der Erde stecken zwischen 60 und 100 Billiarden Tonnen Kohlenstoff [MOOR]. Entstanden sind sie überwiegend durch die Umwandlung von atmosphärischem CO2 zu Kalkschalen und Skeletten von Meerestieren

Die Wissenschaft, so behaupten es die Vertreter der Theorie vom menschengemachten Klimawandel (Anthropogenous Global Warming, AGW), sei sich in der Frage des Klimawandels weitgehend einig: Der Mensch sei dabei, das Klima in katastrophaler Weise zu destabilisieren. Die Anhänger dieser oft mit quasireligiösem Eifer verfochtenen Lehre sehen als Hauptursache hierfür die Verbrennung fossiler Rohstoffe, welche das als „Treibhausgas“ bezeichnete CO2 freisetzt [WICC, WICO]. Dadurch werde der eigentlich stabile CO2-Kreislauf unseres Planeten in nahezu irreparabler Weise gestört.

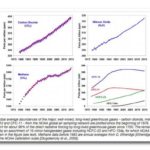

Bild 1. Nach Auffassung der Klimawandel-Anhänger hat erst die industrielle Revolution einen dramatischen Anstieg der CO2-Konzentration in der Atmosphäre verursacht (Grafik: Global Warming Art, Creative Commons)

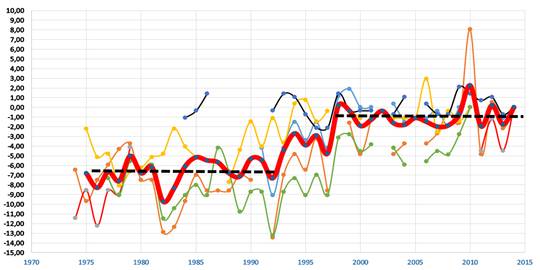

Im Wesentlichen wird von Seiten der Klimaalarmisten behauptet, dass sich die Freisetzung von CO2 aus organischer Materie und seine erneute Bindung durch Fotosynthese seit hunderttausenden von Jahren mehr oder weniger im Gleichgewicht befanden, Bild 1. Diese Balance werde erst jetzt durch den vom Menschen verursachten CO2-Anstieg gefährdet. Besonders pointiert formuliert dies Prof. Stefan Rahmstorf vom Potsdam-Institut für Klimafolgenforschung (PIK), der als Warner vor der sogenannten Klimakatastrophe zum Medienliebling avancierte. In einem Focus-Artikel sagte er: „Die CO2-Konzentration in der Atmosphäre war jahrtausendelang praktisch konstant und steigt erst an, seit wir dem System riesige Mengen an zusätzlichem Kohlenstoff aus fossilen Lagerstätten zuführen [FORA]“. Bei den vom Menschen verursachten Emissionen handele es sich um Milliarden Tonnen Kohlenstoffdioxid, die dem eigentlich stabilen Kohlenstoffkreislauf netto hinzugefügt würden. Ähnliche Auffassungen vertreten auch zahlreiche weitere Klimaforscher, so auch der bekannte Klimakatastrophen-Apologet Michael E. Mann mit seiner „Hockeystick-Kurve“ (Bild 2) [IP31]. Am drastischsten aber formulierte es der US-Politiker Al Gore anlässlich der Auszeichnung mit dem Nobelpreis: „Wir Menschen haben es mit einem globalen Notfall zu tun. Die Erde hat jetzt Fieber. Und das Fieber steigt“ [FOAL]. Am Rande sei übrigens vermerkt, dass Gore bei seinen diesbezüglichen Aktivitäten ein Vermögen von geschätzt mehr als 100 Mio. US-$ ansammeln konnte.

Bild 2. Die inzwischen diskreditierte „Hockeystick-Kurve“: Rekonstruierte Temperatur (blau) und Thermometerdaten (rot), die Fehlergrenzen sind in grau gezeigt (Grafik: Michael E. Mann, Raymond S. Bradley und Malcolm K. Hughes, IPCC/ Wikimedia Creative Commons)

Zweifel sind angebracht

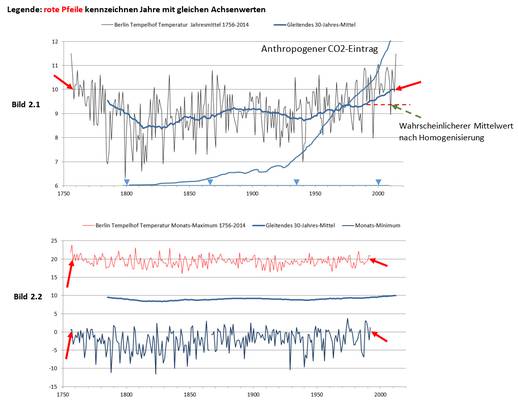

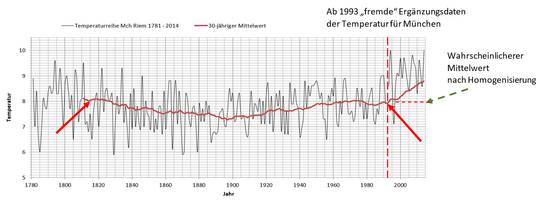

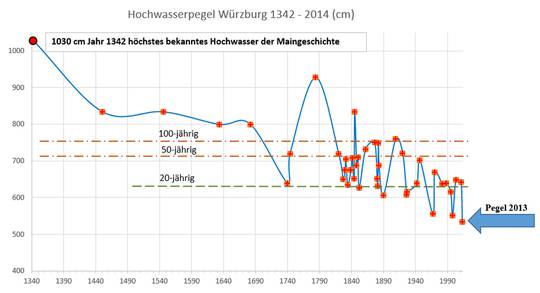

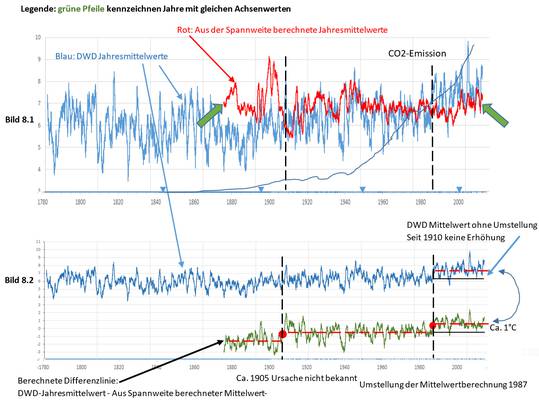

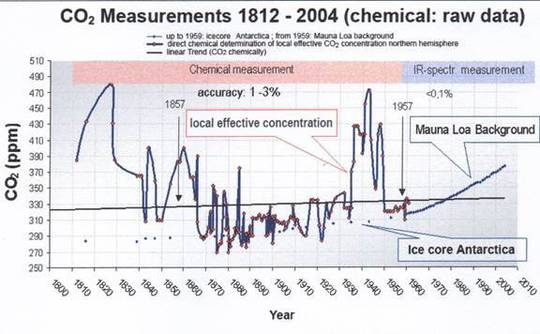

Zum Leidwesen der Klimakatastrophen-Prediger stimmt ihre Theorie mit den leicht nachprüfbaren Fakten nicht so richtig überein. Erste Zweifel sollten aufkommen, wenn man die Entwicklung der nach heutigem Stand der Klimaforschung bestimmten CO2-Konzentrationen in der Atmosphäre [NOAA] mit den gut dokumentierten Emissionen aus der Verbrennung fossiler Brennstoffe [CDIA] in den letzten ca. 260 Jahren im gleichen Diagramm aufträgt, Bild 3.

Bild 3: Theoretisch aufgrund der kumulierten menschlichen Emissionen [CDIA] zu erwartender CO2-Anstieg seit 1751 (rot) sowie Messwerte von Eisbohrkernen sowie vom Mauna Loa [CDIA,CDI2, NOAA] (grün)

Die Berechnung der theoretisch zu erwartenden Zunahme des CO2-Gehalts aufgrund der seit 1751 durch Verbrennung fossiler Rohstoffe akkumulierten CO2-Emissionen führt zu einem Wert von 383 Mrd. t Kohlenstoffäquivalent (bei dieser Berechnungsart wird nur der reine Kohlenstoffanteil im CO2 gewertet), was 189 ppm CO2-Zunahme entspricht (1 Mrd. t = 1 Gt (Gigatonne)). Ausgehend von dem behaupteten vorindustriellen CO2-Pegel von ca. 280 ppm und einem Anstieg von etwas weniger als 0,5 ppm pro Mrd. t zusätzlich eingebrachten C-Äquivalents müsste der CO2-Gehalt der Atmosphäre daher inzwischen bereits auf rund 469 ppm angestiegen sein. Die Diskrepanzen zum gemessenen CO2-Anstieg der Atmosphäre auf derzeit 400 ppm sind zudem nicht nur quantitativ. Auch die völlig unterschiedliche Charakteristik der Kurven fällt sofort ins Auge. So simpel, wie es uns die Klimaalarmisten einreden wollen, sind die Zusammenhänge also offensichtlich nicht.

Die Sache mit den Reservoirs

Die in Bild 3 verdeutlichte Diskrepanz ist natürlich auch den AGW-Vertretern bekannt. Also musste man sich mit der Tatsache beschäftigen, dass CO2 nicht nur in der Atmosphäre vorkommt und es auf der Erde schon seit jeher natürliche Kreisläufe gibt, welche CO2 zwischen verschiedenen Speicherorten hin- und hertransportieren und dabei auch zu anderen Verbindungen wie pflanzlichem oder tierischem Gewebe umsetzen. Hinzu kommen noch die Zerfallsprodukte nach dem Tod dieser Lebewesen in Form von z.B. Böden, Humus oder Torf.

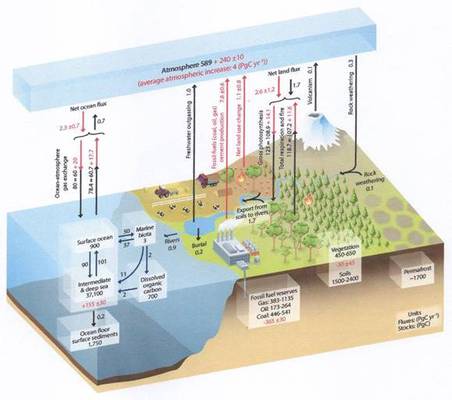

Die wichtigste Reaktion zur Entfernung des CO2 aus der Atmosphäre ist aus Sicht des IPCC (International Panel on Climate Change der UN bzw. „Uno-Klimarat“) die Fotosynthese der Pflanzen. Mit ihrer Hilfe spalten Grünpflanzen CO2 aus der Luft in Kohlenstoff und Sauerstoff auf. Den Kohlenstoff bauen sie in ihr Gewebe ein, während ein Teil des Sauerstoffs an die Atmosphäre abgegeben wird. Über die Nahrungskette hinweg dienen sowohl der Kohlenstoff als auch der Sauerstoff als Grundstoffe des Lebens. Da ein gewisser Anteil von Lebewesen nach dem Tod nicht sofort verwest, sondern zumindest teilweise im Erdboden eingeschlossen wird, enthalten auch die Böden Kohlenstoff. Als stellvertretend für die Modellvorstellungen, die der Öffentlichkeit hierzu präsentiert werden, kann die bei Wikipedia gezeigte Grafik angeführt werden, Bild 4.

Bild 4. Diagramm des Kohlenstoffkreislaufs. Schwarze Zahlen: Inhalt der verschiedenen Reservoire in Mrd Tonnen Kohlenstoff (Gt C), blaue Zahlen: Austausch von Kohlenstoff in Gt Tonnen Kohlenstoff/ Jahr (Quelle: Wikipedia, [KOKR])

Die Märchenstunde der Klimaalarmisten…

Bild 4, das in verschiedensten Varianten in zahlreichen AGW-Veröffentlichungen weite Verbreitung gefunden hat, beinhaltet mehrere grundsätzliche Falschinformationen. Diese sollen die These stützen, dass die Zunahme des CO2-Gehalts der Atmosphäre nahezu ausschließlich auf menschliche Einwirkung zurückzuführen ist und dass das CO2 dort auch auf sehr lange Zeit verbleiben soll, weil nur sehr wenig dauerhaft entfernt werde. Als Ursache des CO2-Anstiegs werden neben der Verbrennung fossiler Rohstoffe noch die Zementherstellung und die Abholzung von Wäldern aufgeführt.

Sieht man sich die Zahlen des Bildes 4 genauer an, so fällt zunächst auf, dass eine wesentliche natürliche Quelle von CO2-Emissionen komplett weggelassen wurde: Der Vulkanismus. Im Weltbild der Klimawarner spielt er eine so unbedeutende Rolle, dass man ihn hier schlicht unterschlagen hat. Dieses Vorgehen ist grob unwissenschaftlich. Hierauf wird in einer weiteren Folge dieses Artikels noch näher eingegangen.

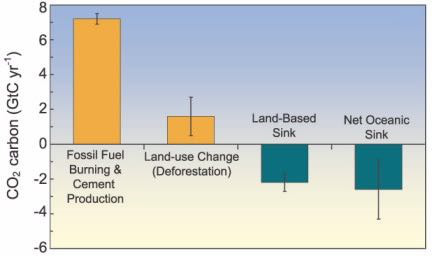

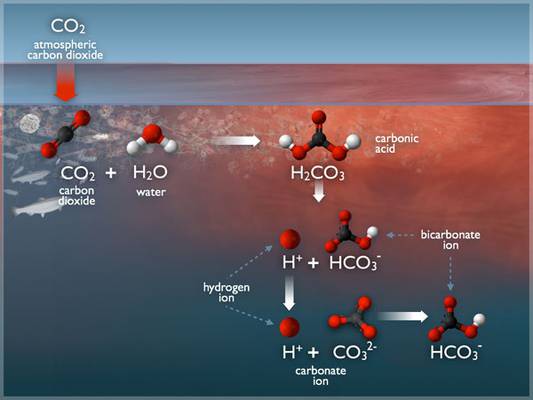

Eine weitere bewusste Falschinformation betrifft die Darstellung des CO2-Austauschs sowohl mit den Ozeanen als auch innerhalb dieser selbst. Die intelligenteren unter den AGW-Vertretern wissen, dass sie hier schummeln, aber sie sind dazu gezwungen, weil man das „Verschwinden“ von rund 55 % der vom Menschen verursachten CO2-Emissionen aus der Atmosphäre nicht mit den Austauschvorgängen mit den Pflanzen und den Böden an Land erklären kann. Deshalb wird verkündet, dass der Rest vom Ozean aufgenommen wird. Da sich dabei z.T. H2CO3 (Kohlensäure) bildet, würden die Meere „versauern“ [KIES], Bild 5.

Bild 5. Eine von AGW-Vertretern gern verwendete Grafik zur Darstellung der angeblichen Ozeanversauerung durch CO2. Die gebildete Säure H2CO3 soll Muscheln, Korallen etc. daran hindern, gesunde Kalkschalen auszubilden (Quelle: [OZEA])

In Bild 4 wird diesem „Verschwinden“ dadurch Rechnung getragen, dass man behauptet, dass 92 Gt C als CO2 vom Ozean aufgenommen werden, während das Meer lediglich 90 Gt C wieder abgibt. Ansonsten werden Kreisläufe innerhalb verschiedener Schichten des Ozeans dargestellt, welche das CO2 im Wesentlichen nur hin und her bewegen. Von den aufgenommenen 2 Gt C landen nach dieser Darstellung lediglich 0,2 Gt nach dem Absterben und Absinken der entsprechenden Lebewesen endgültig als Sediment am Meeresboden, ein auffälliger Unterschied zu den 121,3 Gt C, welche an Land jedes Jahr durch Pflanzen aufgenommen und teils in lebender Biomasse, teils im Boden abgespeichert werden.

Als „Präzisierung“ für die 0,2 Gt C, welche nach Bild 4 am Meeresboden verbleiben, werden vor allem Kieselalgen genannt, weil diese aufgrund des Gewichts ihrer Schalen schnell absinken würden [KIES]. Mit dieser Erläuterung wird das Thema Kalkschalenbildung elegant umgangen und somit verschwiegen. Urheber dieser Irreführung ist ausgerechnet „Wissenschaft im Dialog“, eine gemeinnützige GmbH, hinter der alle großen deutschen Wissenschaftsorganisationen stehen. Ein Musterbeispiel für einen „Konsens der Wissenschaft“ im Interesse des Klimaalarmismus.

Vor allem mit dieser vorgeblich geringen Abspeicherungsrate von CO2 im Meeressediment wird die behauptete lange Verweildauer von CO2 in der Erdatmosphäre begründet [DEEP]). Der Rest der Jahr für Jahr aufgenommenen 2 Gt – also 1,8 Gt C – werde einfach nur im Wasser gelöst und somit reversibel eingespeichert. Die resultierende allmähliche Akkumulation von CO2 im Meerwasser und die daraus gebildete Kohlensäure wird als Ursache für eine zunehmende „Versauerung“ der Meere gesehen, welche letztlich auch dort zu einer katastrophalen Entwicklung mit abnehmenden Erträgen der Fischerei führen werde [OZEA].

Weiterer auffallender Unterschied gegenüber der Situation an Land ist die vergleichsweise recht geringe Masse an Kohlenstoff, die in den Meeressedimenten insgesamt weggespeichert worden sein sollen. Während man davon ausgeht, dass in den Böden an Land 1.580 Gt Kohlenstoff gespeichert seien, wird behauptet, dass in den Meeressedimenten insgesamt lediglich 150 Gt C stecken. Das entspräche insgesamt nur 750 Jahresraten Abspeicherung zu je 0,2 Gt, eine angesichts des Alters unseres Planeten und seiner Meere doch ziemlich bescheidene Menge. Dabei haben die Meere und damit auch der Meeresboden einen wesentlich größeren Flächenanteil (71 %) als das Land, was die Diskrepanz zwischen den behaupteten Größen der beiden Reservoire umso größer macht.

und die dabei unterschlagenen Fakten

Zu diesen Zahlen kann man nur eines sagen: Sie stimmen nicht. Man hat die wichtigste Reaktion im Meer schlicht „übersehen“, man könnte auch sagen bewusst unterschlagen: Die Abbindung von CO2 bei der Bildung der Kalkschalen von Meerestieren wie Muscheln, Schnecken, einzelligen Algen oder Korallen, Bild 6. Kalk ist nichts anderes als Calciumcarbonat (CaCO3) [KALK]. Jedes seiner Moleküle enthält demnach ein komplettes CO2-Molekül, das in steinhartem Material fest gebunden ist. Das Meer wimmelt geradezu von Lebewesen, welche diese Umwandlung vollziehen, wie jeder Besuch an einem beliebigen Meeresstrand sofort beweist. Und diese Schalen sind nicht leicht vergänglich, sondern überdauern den Tod besagter Lebewesen teilweise um hunderte Millionen von Jahren, wie die geradezu ungeheuren Mengen Kalkgestein auf unserem Planeten beweisen.

Bild 6. Die Dekarbonisierung der Atmosphäre aufgrund der Abbindung von atmosphärischem CO2 durch Lebewesen zu Kalkschalen und -skeletten erfolgt in riesigen Mengen

Kalkbildung – die gern unterschlagene CO2-Senke

Und diese Kalkbildung, die schon seit Urzeiten vor allem in den Meeren stattfindet, geht auch heute ungebremst weiter. Auch die Gesamtmenge des in Sedimenten am Meeresboden eingelagerten Kalks bzw. des darin gebundenen Kohlenstoffs ist um ein Vielfaches höher als die von den AGW-Vertretern angegebenen 150 Gt. Nachzulesen ist dies in einer 2003 veröffentlichten Untersuchung des renommierten amerikanischen Professors Wallace Smith Broecker über den CaCO3-Zyklus in den Ozeanen [SEDI]. Dort kommt er zu folgenden Schlussfolgerungen: „Die hoch CaCO3-haltigen Sedimente, welche die ozeanischen Höhenzüge und Plateaus bedecken, haben typischerweise einen CaCO3-Gehalt von 90 % und eine Trockensubstanzdichte von 1 g/cm3. Da rund ein Viertel des Meeresbodens von diesen calcitreichen Sedimenten bedeckt ist, liegt die Gesamtmasse des darin enthaltenen Calcits bei rund 6.3 1019 g CaCO3“. Das entspricht einem Kohlenstoffinventar von rund 7.560 Gt C. Man vergleiche diese Aussagen mit dem Wert von 150 Gt C, den die AGW-Propheten des IPCC für Meeressedimente angeben. Es handelt sich um einen Unterschied um den Faktor 50 (!). Dabei bezieht sich Broecker lediglich auf die obersten 8 cm Sediment. Je nach Meeresregion erreicht die tatsächliche Dicke der Sedimente jedoch Werte im Kilometerbereich.

Interessant sind in diesem Zusammenhang auch umfassende Messungen zur Geschwindigkeit, mit der beispielsweise Cyanobakterien CO2 aus Meerwasser zu Oshenite-Aragonit (ebenfalls ein CaCO3-Mineral) abbinden können [OSHE]. Bei entsprechenden Witterungsbedingungen werden bei der Bildung dieser für tropische Flachwasserzonen typischen „whitings“ Abbindungsraten von bis zu mehr als 100 t C pro Quadratkilometer und Jahr erreicht. Das wiederum entspricht in diesen Bereichen einem kompletten Umschlag des CO2-Inventars des Oberflächenwassers innerhalb weniger Stunden, was darauf hinweist, dass die in der Literatur aufgeführten Übergangszeiten (einige Jahre, s.u.) bei entsprechender organischer Aktivität um etliche Größenordnungen unterschritten werden können. Angesichts der Fläche der Ozeane von ca. 396 Mio. km2 käme man selbst dann, wenn man eine Rate der CO2-Abbindung zu Kalk im Mittel annimmt, die um den Faktor 10.000 niedriger liegt, immer noch auf 4,3 Gt C/ Jahr. Zu beachten ist hierbei, dass unabhängig von den „whitings“ genannten CaCO3-Ausfällungen auch die Kalkbildung durch Muscheln, Korallen, Seeigel, Algen sowie weitere Lebewesen ständig weiterläuft. Die Annahme des IPCC, dass insgesamt pro Jahr nur 0,2 Gt C im Ozeansediment landen, ist vor diesem Hintergrund wohl kaum zu rechtfertigen.

Dichtung und Wahrheit zu CO2-Verweildauern in der Atmosphäre

Aus der gleichen Betrachtung heraus kann man auch sofort Aussagen über die angeblich jahrhunderte- oder gar jahrtausendelange Verweildauer neu in die Atmosphäre eingetragener CO2-Moleküle [IPCC, SKEP, ARCH] als wohl kaum zutreffend bezeichnen. Die Geschwindigkeit, mit der CO2 von der Atmosphäre in die Ozeane übergeht, wurde schon seit den 1950er Jahren dokumentiert. Eine eingehende Recherche von T. V. Segalstad umfasst neben eigenen Untersuchungen auch eine Auswertung von rund 35 Quellen aus den 50er bis 90er Jahren des vorigen Jahrhunderts [SEGA]. Er kommt auf eine Verweildauer von 5,4 Jahren bei einer Spanne von 1 bis 25 Jahren. Auf rund 5 Jahre kommt auch C. Starr [STAR]. Interessanterweise geht auch der Blog „Skeptical Science“, bekannt als Plattform für besonders aggressive AGW-Positionen, von einer Verweildauer des CO2 in der Atmosphäre von lediglich 5 Jahren aus [SKEP]. Um dennoch ihre Theorie von der langen Verweildauer zu stützen, wird von AGW-Seite behauptet, dass es meist lediglich zu einem wechselseitigen Austausch von CO2-Molekülen zwischen Ozean und Atmosphäre komme. Der von der oberen Schicht des Ozeans gebildete Puffer, welcher zunächst das CO2 aus der Luft aufnehme, laufe schnell voll. Platz für die Aufnahme von weiterem CO2 erfordere einen Abtransport durch Strömungsaustausch mit den tieferen Schichten des Ozeans. Dieser Strömungsaustausch erfolge sehr langsam mit Umlaufzeiten von 500 Jahren bis hin zu tausenden von Jahren. Aus diesem Grund sei die Annahme, dass einmal in die Atmosphäre eingebrachtes CO2 dort für bis zu 500 Jahre verbleibe, realistisch. Bei dieser Betrachtungsweise wird die oben beschriebene Abspeicherung von CO2 in Kalksedimenten schlicht ignoriert. Man kann angesichts der hier dargelegten Fakten nur staunen, was heutzutage als vom „Konsens der Wissenschaft getragen“ verbreitet wird.

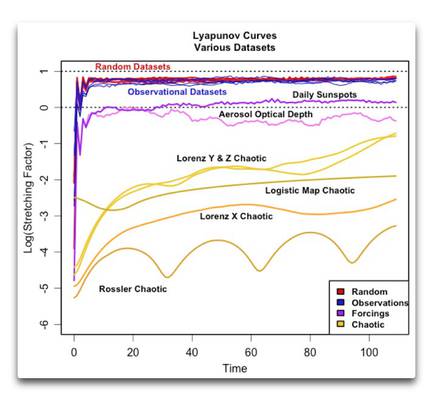

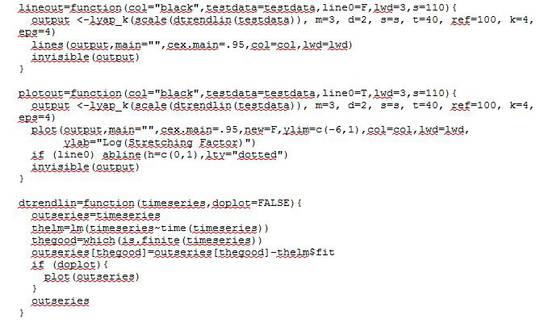

Der CO2-Austausch mit den Meeren ist eine große Unbekannte

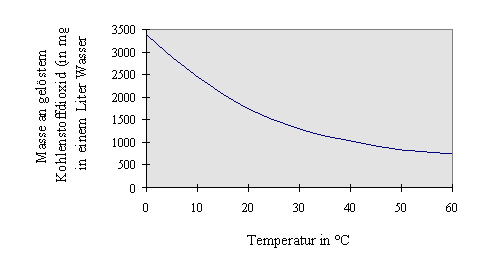

Wie sieht es nun tatsächlich mit dem CO2-Austausch zwischen Atmosphäre und Ozeanen aus? Dass sich CO2 in Wasser lösen und auch wieder daraus entweichen kann, beweisen uns täglich kohlensäurehaltige Getränke von Mineralwasser über Limonaden bis Bier und Sekt, wenn sie beim Öffnen sprudeln. In ihnen wurde CO2 unter hohem Druck gelöst, das beim Absinken des Drucks beim Öffnen wieder entweicht. Nach den Gesetzen der physikalischen Chemie bildet sich zwischen dem CO2-Gehalt der Luft und demjenigen des im Wasser gelösten Kohlenstoffdioxids ein Gleichgewicht, das durch die Parameter (Partial)-Druck und Temperatur gesteuert wird, Bild 7.

Bild 7. Mit steigender Wassertemperatur nimmt die Löslichkeit von CO2 erheblich ab [LOES]

Was bei Flaschengetränken durch starken CO2-Überdruck erreicht wird, funktioniert im System Ozean-Atmosphäre lautlos und automatisch in beide Richtungen: Zwischen den jeweiligen CO2-Gehalten bildet sich ein Gleichgewicht. Kommt mehr CO2 in die Atmosphäre, dann nimmt der Ozean solange CO2 auf, bis das Gleichgewicht wiederhergestellt ist. Steigt dagegen die Temperatur des Wassers, so sinkt seine Löslichkeit für das Gas und es wird teilweise in die Atmosphäre entweichen.

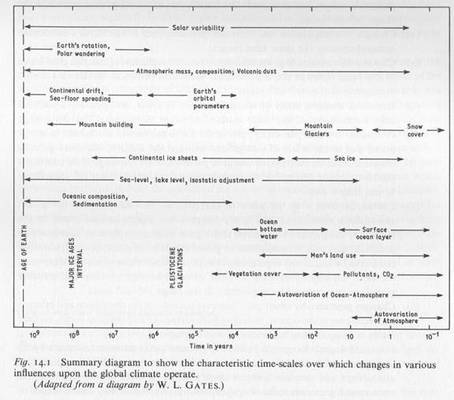

Soweit die Theorie. In der Praxis stellen sich die Dinge allerdings sehr viel komplizierter dar. Während für die Atmosphäre kein temperaturabhängiger Grenzwert der CO2-Aufnahme existiert und die Durchmischung aufgrund der Turbulenz der Luftströmungen äusserst schnell erfolgt, weisen die Ozeane sehr komplexe und noch dazu dreidimensionale Temperaturverteilungs- und Strömungsmuster auf. Während vor allem kalte polnahe Ozeanbereiche CO2 aufnehmen, wird es in wärmeren Regionen wieder abgegeben. Zudem erfolgt der CO2-Austausch zwischen verschiedenen Tiefen über meist sehr langsame Strömungen. Zu all diesen Vorgängen gibt es allerdings nur bruchstückhafte Daten. Für umfassende quantitative Aussagen sind die Ozeane viel zu riesig, die Vorgänge viel zu komplex und die Zahl der Messdaten viel zu gering, siehe auch Bild 8 [ESCH].

Die chaotische Realität des CO2-Austauschs zwischen Ozean und Atmosphäre. Dargestellt sind die Unterschiede zwischen dem CO2-Partialdruck der Atmosphäre (damals 321 ppmv) und demjenigen im Meerwasser bei verschiedenen Oberflächentemperaturen (Grafik: W. Eschenbach [ESCH]

Die Daten zu Bild 8 stammen von verschiedenen Messkampagnen des Scripps-Instituts (USA) aus den Jahren 1957 bis 1963. Die Abweichungen vom Gleichgewicht zwischen Meer und Atmosphäre erreichen teilweise an die 100 ppm!

Weiteres Handicap ist, dass man im Ozean – im Unterschied zu meteorologischen Stationen an Land – so gut wie gar nicht ortsfest messen kann. Die IPCC-Zahlen aus Bild 4 sind auch aus diesem Grund nichts weiter als äußerst grobe Schätzwerte aufgrund bruchstückhafter Daten. Zudem werden, wie weiter oben nachgewiesen, wesentliche Einflussgrößen einfach ausgeblendet.

Andererseits ist der Austausch des CO2 zwischen Atmosphäre und dem gigantischen Speicher, den die Ozeane darstellen, entscheidend für die Annahmen zu künftigen CO2-Gehalten der Atmosphäre. Da alle Klimamodelle mit diesen Annahmen arbeiten, sind ihre Ergebnisse demnach samt und sonders grob fehlerbehaftet. Die damit errechneten Aussagen können keinen Anspruch auf Korrektheit erheben.

Fred F. Mueller

Quellen

[ARCH] David Archer & Victor Brovkin The millennial atmospheric lifetime of anthropogenic CO2. Climatic Change (2008) 90:283–297, DOI 10.1007/s10584-008-9413-1

[CDIA] http://cdiac.ornl.gov/trends/emis/overview.html abgerufen am 29.6.2013

[CDI2] http://cdiac.ornl.gov/ftp/trends/co2/lawdome.combined.dat…. abgerufen 6.10.2015

[ESCH] http://wattsupwiththat.com/2013/11/27/co2-in-the-air-co2-in-the-seawater/

[FOAL] http://www.focus.de/politik/zitate/zitat_aid_228903.html abgerufen am 2.5.2013

[FORA] Klimawaage außer Balance, FOCUS Magazin http://www.focus.de/wissen/klima/tid-8638/diskussion_aid_234323.html abgerufen am 21.4.2013

[IPCC] https://www.ipcc.ch/ipccreports/far/wg_I/ipcc_far_wg_I_chapter_01.pdf

[IP31] Fig. 2.20 des dritten Berichts des Intergovernmental Panel on Climate Change (IPCC) der UNO

[KALK] Kalk – ein Rohstoff aus Schalen und Knochen, http://www.kalk.de/index.php?id=35 abgerufen am 20.4.2013

[KOKR] https://de.wikipedia.org/wiki/Kohlenstoffzyklus#/media/File:Carbon_cycle-cute_diagram-german.png

[LOES] http://www.uni-muenster.de/imperia/md/content/didaktik_der_chemie/kernpraktikumfriese/loeslichkeit_von_gasen_in_wasser__kohlenstoffdioxid_.pdf

[MIAT] Kalkgesteine, Mineralienatlas, https://www.mineralienatlas.de/lexikon/index.php/Mineralienportrait/Calcit/Kalkgesteine abgerufen am 26.9.2015

[MOOR] http://www.eike-klima-energie.eu/news-cache/greenpeace-gruender-haelt-eine-grosse-rede-und-lobt-kohlendioxid/

[NOAA] http://www.esrl.noaa.gov/gmd/ccgg/trends/

[OSHE] Robbins, L.L.; Yates, K. K.: Direct Measurement of CO2 Fluxes in Marine Whitings. Contract No. DE-AI26-99FT40596, U.S. Geological Survey, Center for Coastal and Regional Marine Studies, 600 Fourth Street South, St Petersburg, Florida 33701

[OZEA] https://fmss12ucheme.wordpress.com/2013/05/05/ocean-acidification-2/

[SEGA] Segalstad, T.V.: Carbon cycle modelling and the residence time of natural and anthropogenic atmospheric CO2: on the construction of the "Greenhouse Effect Global Warming" dogma. In “Global Warming: The Continuing Debate", European Science and Environment Forum (ESEF), Cambridge, England (ISBN 0-9527734-2-2), pages 184-219, 1998.

[SKEP] http://www.skepticalscience.com/co2-residence-time.htm

[STAR] Starr, C.: Atmospheric CO2 residence time and the carbon cycle. 1992 EPRI/SIO Symposium on Global Warming. Energy, Vol. Volume 18, Issue 12, December 1993, Pages 1297–1310, doi:10.1016/0360-5442(93)90017-8

[WICC] Kohlenstoffzyklus, Wikipedia, http://de.wikipedia.org/wiki/Kohlenstoffzyklus abgerufen 21.4.2013

[WICO] Kohlenstoffdioxid, Wikipedia, http://de.wikipedia.org/wiki/Kohlenstoffdioxid abgerufen 21.4.2013