Und wieder verlängert sich der Stillstand

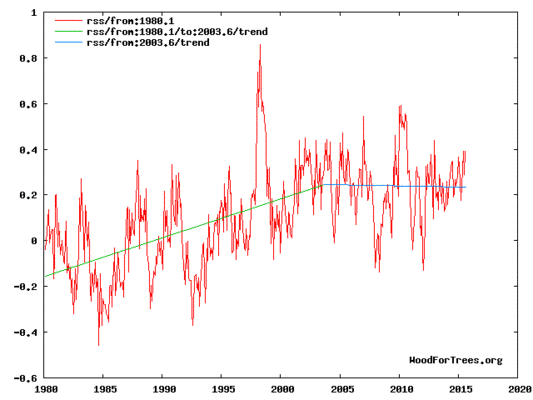

Bild rechts: Die lineare Regression kleinster Quadrate des Trends der globalen monatlichen Temperaturanomalie nach RSS zeigt keine globale Erwärmung seit 18 Jahren und 8 Monaten, also seit Januar 1997, obwohl ein Drittel aller anthropogenen Antriebe während der Periode des Stillstands Eingang fand.

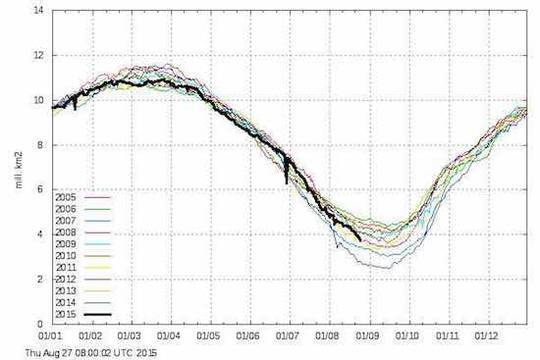

Wie immer aber eine Warnung hinsichtlich des gegenwärtigen El Niño. Wahrscheinlich wird die Temperaturzunahme, die normalerweise mit einem El Niño einhergeht, den Stillstand irgendwie unterbrechen, gerade pünktlich zum Klimagipfel in Paris, obwohl ein nachfolgendes La Niña den Stillstand wiederherstellen und verlängern dürfte.

Zu einer globalen Temperaturspitze aufgrund der thermohalinen Zirkulation, der die warmen Wasser des tropischen Pazifiks um die ganze Welt transportiert, kommt es in einem El Niño-Jahr gewöhnlicherweise im nordhemisphärischen Winter.

Allerdings entwickelt sich ein oder zwei Jahre nach einem El Niño normalerweise – aber nicht immer – eine La Niña, wobei sich zuerst die Oberfläche des Ozeans abkühlt und danach die Lufttemperatur, was die globale Temperatur wieder auf ihre Normalwerte bringt.

Abbildung 1a: Wassertemperatur-Index für die Nino 3.4-Region des tropischen Ostpazifiks. Er zeigt einen Anstieg in Richtung einer Spitze, zu der es normalerweise im nordhemisphärischen Winter kommt. Vorerst verlängert sich der Stillstand noch weiter, aber nicht mehr lange, und das wärmere Wasser im Pazifik wird durch die thermohaline Zirkulation auf der ganzen Welt verbreitet, was zu einer vorübergehenden Wärmespitze der globalen Temperaturen führt.

Die Stillstandsperiode von 18 Jahren und 8 Monaten ist der am weitesten zurück reichende Zeitraum in den Satelliten-Temperaturaufzeichnungen, den man betrachten kann und der immer noch einen Null-Trend zeigt. Das Anfangsdatum ist nicht cherry picked, es ist berechnet. Und die Graphik bedeutet nicht, dass es so etwas wie eine globale Erwärmung nicht gibt. Geht man noch weiter zurück, zeigt sich eine geringe Erwärmungsrate.

Der UAH-Datensatz zeigt den Stillstand fast genauso lang wie der RSS-Datensatz. Allerdings zeigen die vielfach veränderten Temperatur-Datensätze am Boden eine geringe Erwärmungsrate.

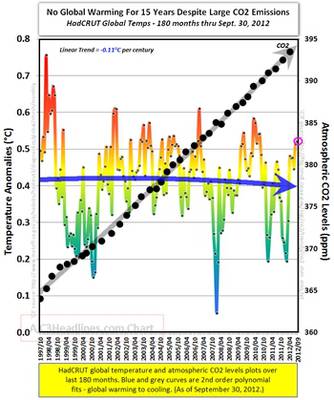

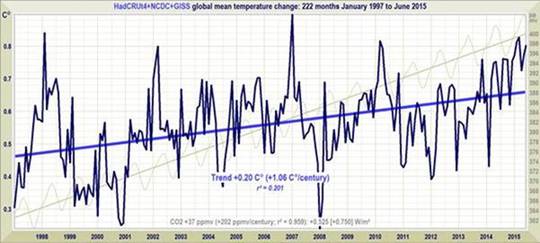

Abbildung 1b: Der lineare Regressionstrend kleinster Quadrate in der mittleren monatlichen Temperaturanomalie nach GISS, HadCRUT4 und NCDC zeigt eine globale Erwärmung mit einer Rate äquivalent zu etwas über 1°C pro Jahrhundert im Zeitraum des Stillstands von Januar 1997 bis Juli 2015.

Wenn man bedenkt, dass ein Drittel des Strahlungsantriebs von 2,4 W/m² aus allen anthropogenen Quellen während des Stillstands-Zeitraumes stammt, ist eine Erwärmungsrate von etwas mehr als 1°C pro Jahrhundert nicht wirklich alarmierend. Allerdings hat es die Studie, die das vermeintliche Fehlen des Stillstands zeigte, sorgfältig vermieden zu erwähnen, wie gering die Erwärmung in den terrestrischen Datensätzen tatsächlich ist – selbst nach all den zahlreichen Manipulationen.

Wie immer muss man hier aber aufpassen: Nur weil es während der letzten Jahrzehnte keine oder nur eine geringe Erwärmung gegeben hat, kann man daraus nicht folgern, dass die Erwärmung für immer zum Stillstand gekommen ist. Die Trendlinien messen nur das, was geschehen ist; sie sagen nicht voraus, was geschehen wird.

Der Stillstand – so politisch nützlich er auch für alle sein kann die wünschen, dass die „offizielle“ wissenschaftliche Gemeinschaft seiner Pflicht zum Hinterfragen nachkommt – weit weniger wichtig ist als die immer größer werdende Diskrepanz zwischen den Prophezeiungen der globalen Zirkulationsmodelle und der beobachteten Realität.

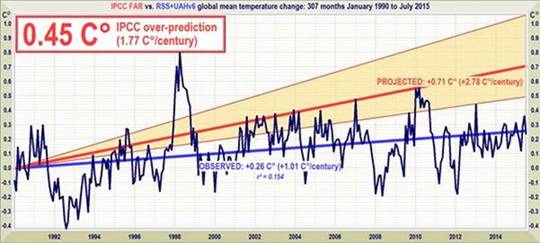

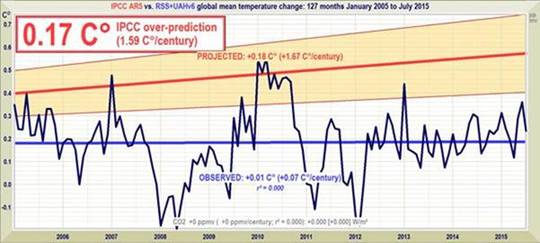

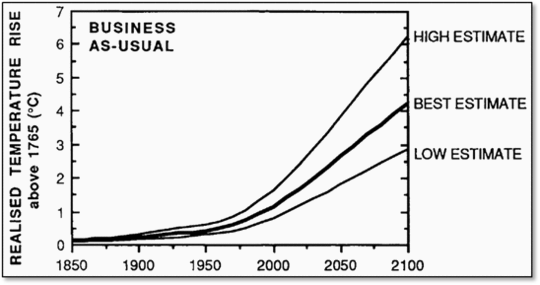

Die Diskrepanz zwischen den Modellprophezeiungen im Jahre 1990 (Abbildung 2) und 2005 (Abbildung 3) einerseits und die tatsächlichen Messungen andererseits vergrößert sich immer weiter. Falls sich der Stillstand noch ein wenig weiter fortsetzt, wird die Erwärmungsrate in dem Vierteljahrhundert seit dem ersten IPCC-Zustandsbericht aus dem Jahr 1990 unter ein Äquivalent von 1°C pro Jahrhundert absinken.

Abbildung 2: Echtzeit-Projektionen der Erwärmung mit einer Rate äquivalent zu 2,8 (1,9; 4,2) K pro Jahrhundert, erstellt mit „substantiellem Vertrauen“ des IPCC im Jahre 1990 für die 307 Monate von Januar 1990 bis Juli 2015 (orangefarbener Bereich und rote Trendlinie) im Vergleich zu gemessenen Anomalien (dunkelblau) und Trend (hellblau) mit einem Äquivalent von nur 1 K pro Jahrhundert, gemittelt aus den Satelliten-Datensätzen von RSS und UAH.

Abbildung 3: Vorhergesagte Temperaturänderung von Januar 2005 bis Juli 2015 mit einer Rate äquivalent zu 1,7 (1,0; 2,3) K pro Jahrhundert (orangefarbener Bereich mit dicker roter Best Estimate-Trendlinie), verglichen mit den beobachteten, nahe Null liegenden Anomalien (dunkelblau) und Trend (hellblau) der realen Welt, gebildet aus dem Mittel der Temperaturanomalien in der unteren Troposphäre nach RSS und UAH.

Die Liste der Kernfakten über die globale Temperatur (unten) sollte man jedem vorlegen, der weiter daran glaubt, dass – um es mit den Worten von Mr. Obamas Twitterei auszurücken – „die globale Erwärmung real, vom Menschen verursacht und gefährlich“ ist.

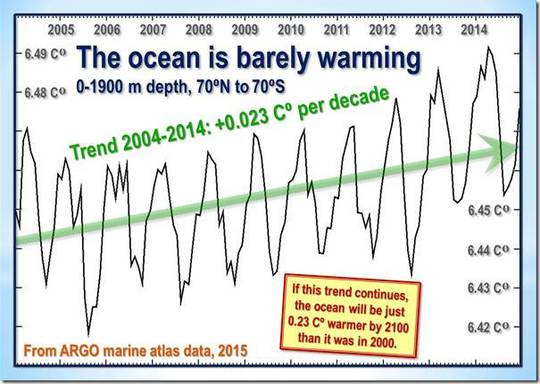

In Hintergründe werden die Quellen der IPCC-Vorhersagen aus den Jahren 1990 und 2005 erläutert. Auch wird gezeigt, dass sich die Ozeane den ARGO-Daten zufolge mit einer Rate äquivalent zu weniger als 0,25°C pro Jahrhundert erwärmen.

Kernfakten zur globalen Temperatur

● Der RSS-Satelliten-Datensatz zeigt keinerlei globale Erwärmung seit 223 Monaten von Januar 1997 bis Juli 2015 – also während über der Hälfte der 439 Monate langen Satelliten-Aufzeichnungen.

● Es gab keine Erwärmung, obwohl ein Drittel aller anthropogenen Antriebe seit 1750 erst nach Januar 1997 freigesetzt wurden, also während des Stillstands der globalen Erwärmung.

● Der gesamte RSS-Datensatz von Januar 1979 bis heute zeigt eine globale Erwärmung mit einer wirklich nicht alarmierenden Rate von lediglich 1,2°C pro Jahrhundert.

● Seit 1950, also seit dem Zeitpunkt, an dem ein menschlicher Einfluss auf das Klima zum ersten Mal theoretisch möglich ist, lag der Trend der globalen Erwärmung unter einem Äquivalent von 1,2°C pro Jahrhundert.

● Der globale Erwärmungstrend seit dem Jahr 1900 ist äquivalent zu 0,75°C pro Jahrhundert. Dies liegt deutlich innerhalb der natürlichen Variabilität und dürfte mit uns nicht viel zu tun haben.

● Zur höchsten Erwärmungsrate über 15 Jahre oder mehr seit 1950 kam es während der 33 Jahre von 1974 bis 2006. Die Rate lag äquivalent zu 2,0°C pro Jahrhundert.

● Zum Vergleich, die Erwärmung im Temperatur-Datensatz aus Mittelengland während der 40 Jahre von 1694 bis 1733, also lange vor der industriellen Revolution, erreichte ein Äquivalent zu 4,33°C pro Jahrhundert.

● Im Jahre 1990 lag die Mittelfrist-Prognose des IPCC äquivalent zu 2,8°C pro Jahrhundert, also um zwei Drittel höher als seine jüngste Prognose von 1,7°C pro Jahrhundert.

● Der Erwärmungstrend seit 1990, dem Jahr des 1. IPCC-Zustandsberichtes, ist äquivalent zu 1°C pro Jahrhundert. Das IPCC hat eine zweieinhalb mal so hohe Rate prophezeit.

● Damit die zentrale Prognose des IPCC von einer Erwärmung um 1°C von 1990 bis 2025 doch noch eintrifft, müsste es im nächsten Jahrzehnt zu einer Erwärmung von 0,75°C kommen, also einem Äquivalent zu 7,5°C pro Jahrhundert.

● Obwohl das IPCC seine Erwärmungsprognose im Kurzfristzeitraum zurückgefahren hat, sagt es langfristig bis zum Jahr 2100 bei Business as Usual immer noch eine Erwärmung um 4,8°C voraus.

● Die vom IPCC vorhergesagte Erwärmung um 4,8°C bis zum Jahr 2100 liegt deutlich mehr als zweimal so hoch wie die höchste Erwärmungsrate über mehr als 15 Jahre, die seit dem Jahr 1950 gemessen worden ist.

● Die IPCC-Vorhersage von 4,8°C bis 2100 liegt viermal so hoch wie der gemessene globale Erwärmungstrend, seit wir diesen theoretisch hätten beeinflussen können, also seit 1950.

● Die Ozeane erwärmen sich den ARGO-Bojen zufolge mit einer Rate von lediglich 0,02°C pro Jahrzehnt, äquivalent zu 0,23°C pro Jahrhundert oder 1°C in 430 Jahren.

Hintergründe

Unsere jüngste Graphik zeigt die lineare Regression kleinster Quadrate des Trends der monatlichen globalen mittleren Temperaturen, der so weit zurückreicht, wie es möglich ist und immer noch einen Null-Trend findet. Das Anfangsdatum ist nicht cherry picked, um mit der Temperaturspitze des El Niño des Jahres 1998 zusammenzufallen. Stattdessen ist er berechnet, um den längsten Zeitraum mit einem Null-Trend zu finden.

Die Tatsache des langen Stillstands ist ein Hinweis auf die sich stetig vergrößernde Diskrepanz zwischen Prophezeiung und Wirklichkeit bei den Temperaturmessungen.

Die Satelliten-Datensätze sind allgemein deutlich weniger unzuverlässig als andere Datensätze, zeigen sie doch den Großen El Niño klarer als alle anderen Datensätze. Dieses Ereignis verursachte wie seine beiden Vorgänger während der letzten 300 Jahre eine verbreitete Korallenbleiche, was eine unabhängige Verifikation erlaubte, dass Satelliten-Datensätze mehr als alle anderen in der Lage sind, derartige Fluktuationen ohne künstliches Herausfiltern abzubilden.

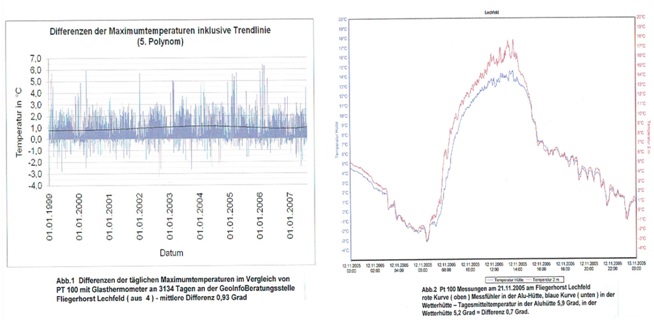

Terrestrische Temperaturen werden mit Thermometern gemessen. Korrekt in ländlichen Gebieten aufgestellte Thermometer abseits von menschlichen Wärmequellen zeigen Erwärmungsraten, die unter jenen liegen, die veröffentlicht werden. Die Satelliten-Datensätze basieren auf Referenzmessungen mittels der genauesten derzeit verfügbaren Thermometer – Platin-Widerstands-Thermometer, welche eine unabhängige Verifikation der Temperaturmessungen ermöglichen, indem man mittels ins Weltall gerichteter Spiegel die kosmische Hintergrundstrahlung heranzieht, die etwa 1% des Gefrierpunktes von Wasser beträgt oder einfach 2,73 Grad über dem Absoluten Nullpunkt liegt. Es waren Messungen von minimalen Variationen dieser kosmischen Hintergrundstrahlung, die es der NASA ermöglichten, das Alter des Universums zu berechnen: 13,82 Milliarden Jahre.

Die RSS-Graphik (Abbildung oben rechts) ist akkurat. Die Daten wurden monatlich direkt von der RSS-Website heruntergeladen. Ein Computer-Algorithmus liest sie aus dem File heraus und plottet sie automatisch mittels einer fortschrittlichen Routine, die automatisch das Bildformat des Datenfensters an beide Achsen anpasst, um die Daten der Klarheit halber im maximal möglichen Maßstab zu zeigen.

Der letzte monatliche Datenpunkt wird visuell untersucht um sicherzustellen, dass er korrekt positioniert ist. Die hellblaue, über die gezackte dunkelblaue Linie gelegte Trendlinie zeigt die Daten nach der linearen Regression kleinster Quadrate sowie die den Schnittpunkt mit der Y-Achse und die Neigung der Linie.

Das IPCC und die meisten anderen Agenturen verwenden lineare Regression, um globale Temperaturtrends zu berechnen. Prof. Phil Jones von der University of East Anglia verlangt dies in einer der Klimagate-E-Mails. Das Verfahren ist angemessen, weil die globalen Temperaturaufzeichnungen nur wenig Autoregression zeigen, werden doch die Sommertemperaturen auf der einen Hemisphäre durch die Wintertemperaturen auf der anderen Hemisphäre kompensiert. Daher würde ein AR(n)-Modell Ergebnisse erzeugen, die sich ein wenig vom Trend der kleinsten Quadrate unterscheiden.

Dr. Stephen Farish, Professor für epidemiologische Statistik an der University of Melbourne hat freundlicherweise die Zuverlässigkeit des Algorithmus‘ verifiziert, mit dem der Trend in der Graphik und der Korrelationskoeffizient berechnet werden. Dieser ist sehr klein, und obwohl die Daten hoch variabel sind, verläuft der Trend flach.

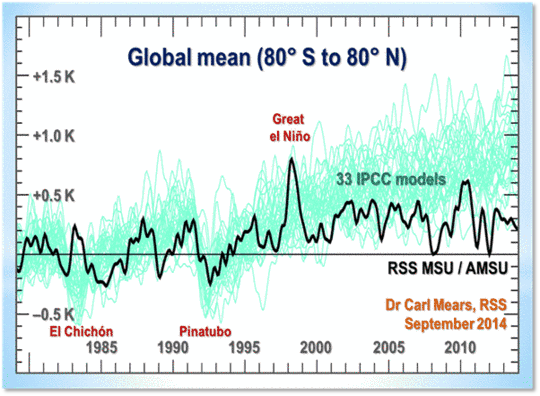

Bei RSS selbst ist jetzt ernsthaftes Interesse an der Länge des Großen Stillstands aufgekommen. Dr. Carl Mears, der leitende Forschungswissenschaftler bei RSS, diskutiert dieses hier.

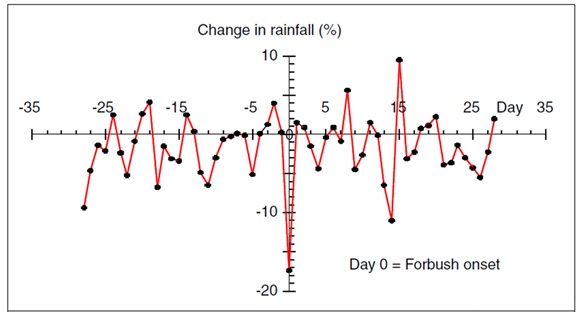

Die Ergebnisse von Dr. Mears werden in Abbildung T1 zusammengefasst:

Abbildung T1: Output von 33 IPCC-Modellen (türkis) im Vergleich mit der globalen Temperaturänderung nach RSS (schwarz) von1979 bis 2014. Die vorübergehenden Abkühlungen durch die Vulkanausbrüche des El Chichon (1983) und des Pinatubo (1991) zeichnen sich ab, ebenso wie die Wärmespitze des Großen El Nino von 1998.

Dr. Mears schreibt:

„Die Leugner mögen es zu vermuten, dass der Grund für die Diskrepanz zwischen Modellen und Beobachtungen eine Art Problem mit der zugrunde liegenden Modellphysik ist, und sie weisen alle anderen Formen der Erklärung zurück. Dies verleitet sie zu der Schlussfolgerung, sehr wahrscheinlich irrig, dass die langfristige Sensitivität des Klimas viel geringer ist als ursprünglich gedacht“.

Dr. Mears räumt die wachsende Diskrepanz zwischen RSS-Daten und den Modellen ein, führt diese allerdings auf Rosinenpickerei des Anfangsdatums der Graphik der globalen Temperatur zurück:

„Jüngst war in einer Anzahl von Artikeln der Mainstream-Presse zu lesen, dass es nur eine geringe oder gar keine Änderung der global gemittelten Temperatur während der letzten beiden Jahrzehnte gegeben zu haben scheint. Deswegen stellt man uns viele Fragen mit dem Tenor ;Ich habe diese Graphik auf einer Leugner-Website gesehen. Sind das wirklich Ihre Daten?‘ Während einige dieser Berichte den Endzeitpunkt ,cherry-picked‘ haben, um ihre Beweise noch stärker aussehen zu lassen, gibt es kaum einen Zweifel daran, dass die Erwärmungsrate seit Ende der neunziger Jahre geringer ist als von den meisten IPCC-Simulationen des historischen Klimas im AR 5 vorhergesagt. … Die Leugner mögen es wirklich, die Trends im Jahre 1997 beginnen zulassen, so dass das gewaltige ENSO-Ereignis von 1997/1998 am Beginn ihrer Zeitreihe liegt, was zu einer linearen Anpassung mit der kleinstmöglichen Neigung führt“.

Tatsächlich wird die vom Großen El Niño 1998 verursachte Temperaturspitze aus zwei Gründen fast vollständig bei der Berechnung des linearen Trends ausgeglichen: dem Fehlen einer ähnlichen Spitze beim El Niño 2010 und der schieren Länge des Stillstands selbst.

[Was ist das für ein „Wissenschaftler“, der alle anderen als „Leugner“ bezeichnet, die lediglich zu anderen Erkenntnissen gekommen sind als er selbst? Anm. d. Übers.]

Komischerweise bevorzugt Dr. Mears die terrestrischen Datensätze vor den Satelliten-Datensätzen. Das UK Met.-Office jedoch verwendet die Satellitendaten, um seine eigenen terrestrischen Daten zu kalibrieren.

Die Länge des Stillstands der globalen Erwärmung, so signifikant sie auch daherkommt, ist weit weniger wichtig als die stetig und rasch weiter zunehmende Diskrepanz zwischen den von den Modellen prophezeiten Temperaturtrends und der weit weniger ausgeprägten Temperaturänderung der realen Welt. Der El Niño dieses Jahres kann sich durchaus noch in diesem Jahr verstärken, was die Länge des Großen Stillstands reduziert. Allerdings setzt sich die Verbreiterung des Grabens zwischen Prophezeiung und Beobachtung weiter fort.

Quellen der IPCC-Projektionen in den Abbildungen 2 und 3.

Im Ersten Zustandsbericht des IPCC wurde prophezeit, dass die Temperatur bis zum Jahr 2025 um 1,0 °C (0,7; 1,5°C) steigen würde, was äquivalent ist zu einer Rate von 2,8°C (1,9; 4.2°C) pro Jahrhundert. In der Executive Summary wurde die rhetorische Frage gestellt: „Wie viel Vertrauen haben wir in unsere Prophezeiungen?“ Das IPCC verwies auf einige Unsicherheiten (Wolken, Ozeane usw.), kam aber dennoch zu dem Ergebnis:

„Nichtsdestotrotz haben wir substantielles Vertrauen, dass die Modelle zumindest die groben Umrisse des Klimawandels prophezeien können … Es gibt Ähnlichkeiten zwischen Ergebnissen der gekoppelten Modelle mittels einfacher Repräsentationen des Ozeans und jenen komplizierteren Beschreibungen, und unser Verständnis der Differenzen, die es auch gibt, bestärkt uns in dem Vertrauen in unsere Ergebnisse“.

Dieses „substantielle Vertrauen“ war substantielles Über-Vertrauen. Und zwar weil die Rate der globalen Erwärmung seit 1990 – die wichtigsten „groben Umrisse des Klimawandels“, die die Modelle vermeintlich prophezeien sollten – inzwischen weniger als halb so groß ist wie vom IPCC damals prophezeit.

Im Jahre 1990 schrieb das IPCC Folgendes:

„Auf der Grundlage der gegenwärtigen Modelle prophezeien wir:

Bei Treibhausgas-Emissionen unter dem Szenario A (Business as Usual) gibt es eine Rate der Zunahme der globalen mittleren Temperatur während des nächsten Jahrhunderts um etwa 0,3°C pro Jahrzehnt (mit einer Unsicherheits-Bandbreite von 0,2°C bis 0,5°C pro Jahrzehnt). Dies ist größer als während der letzten 10.000 Jahre aufgetreten. Dies wird zu einer wahrscheinlichen Erwärmung um etwa 1°C über dem jetzigen Wert bis zum Jahr 2025 und um 3°C vor dem Ende des nächsten Jahrhunderts führen. Der Anstieg wird nicht gleichmäßig verlaufen infolge des Einwirkens anderer Faktoren (S. Xii).

Später hieß es vom IPCC:

Die Zahlen unten basieren auf hoch auflösenden Modellen, skaliert, um mit unserer Best Estimate der globalen mittleren Erwärmung von 1,8°C bis zum Jahr 2030 konsistent zu sein. Für Werte, die konsistent mit anderen Schätzungen des globalen Temperaturanstiegs sind, sollten die Zahlen unten um 30% reduziert werden für die niedrige Schätzung oder um 50% erhöht werden für die hohe Schätzung (S. xxiv).

Der orangefarbene Bereich in Abbildung 2 repräsentiert die mittelfristige IPCC-Schätzung unter Szenario A einer kurzfristigen Erwärmung, d. h. 1,0°C (0,7; 1,5) bis zum Jahr 2025.

Die vom IPCC prophezeite globale Erwärmung während der 25 Jahre ab 1990 bis zur Gegenwart differiert wenig um eine gerade Linie (Abbildung T2)

Abbildung T2: Historische Erwärmung von 1850 bis 1990 sowie prophezeite Erwärmung von 1990 bis 2100 unter dem IPCC-Szenario A (IPCC 1990, S. xxii)

Weil diese Differenz zwischen einer geraden Linie und dem leichten Sprung aufwärts der von IPCC im Zeitraum 1990 bis 2025 prophezeiten Erwärmungsrate so klein ist, kann man das noch in anderer Weise betrachten. Um die zentrale Schätzung von 1 K seit 1990 bis 2025 zu erreichen, müsste es eine doppelt so starke Erwärmung während der nächsten zehn Jahre geben, als es während der letzten 25 Jahre der Fall war. Das ist unwahrscheinlich.

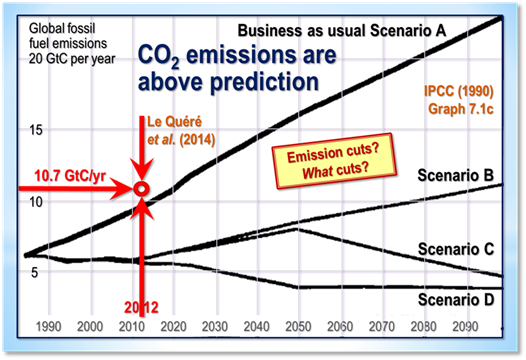

Aber ist der Stillstand vielleicht der Tatsache geschuldet, dass CO2-Emissionen nicht annähernd so stark gestiegen sind wie die IPCC-Prophezeiung unter Szenario A im Jahre 1990 benannt? Nein: Die CO2-Emissionen sind ziemlich deutlich über die unter Szenario A prophezeite Menge gestiegen (Abbildung T3)

Abbildung T3: CO2-Emissionen durch fossile Treibstoffe usw. im Jahre 2012 aus Le Quéré et al. (2014) im Vergleich zur Karte der „anthropogenen Kohlendioxid-Emissionen“ in Milliarden Tonnen Kohlenstoff pro Jahr. Quelle: IPCC 1990

Daher haben sich die CO2-Emissionen seit 1990 als viel näher Szenario A entsprechend erwiesen als an jedes andere Szenario, weil trotz all des Geredes um Reduktionen von CO2-Emissionen die Tatsache besteht, dass die Rate der Ausweitung des Verbrennens fossiler Treibstoffe in China, Indonesien, Indien, Brasilien usw. die geringen Reduktionen in westlichen Ländern bis heute weit in den Schatten stellen.

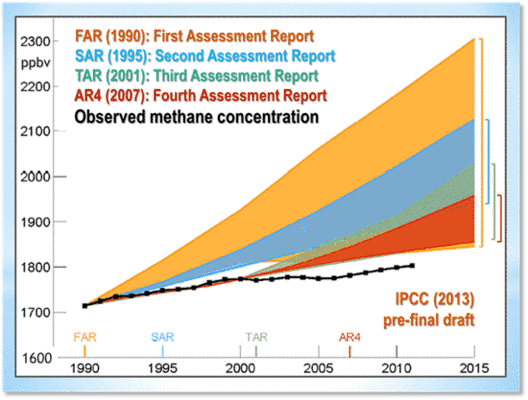

Es stimmt schon, die Methankonzentration ist nicht so gestiegen wie im Jahre 1990 prophezeit, weil die Methan-Emissionen, obwohl weitgehend ungesteuert, einfach nicht so steigen, wie die Modelle prophezeit hatten. Auch hier war also die Grundlage aller Prophezeiungen abwegig.

Das Gesamtbild ist klar. Szenario A ist das Emissions-Szenario aus dem Jahr 1990, dass der Menge der beobachteten CO2-Emissionen am Nächsten liegt.

Abbildung T4: Methan-Konzentration wie in vier IPCC-Zustandsberichten prophezeit, zusammen mit der beobachteten Konzentration, welche sich entlang der unteren Grenze der Geringst-Prophezeiung bewegt. Diese Graphik erschien in der vorläufig-endgültigen Version von IPCC (2013), wurde jedoch auf mysteriöse Weise aus der veröffentlichten Endversion entfernt, vermutlich weil das IPCC einen solchen direkten Vergleich zwischen absurd übertriebenen Prophezeiungen und der wenig aufregenden Wirklichkeit nicht zeigen wollte.

Um genau zu sein, ein Vierteljahrhundert nach 1990 beträgt die globale Erwärmung bis jetzt 0,27°C, was äquivalent zu etwa über 1°C pro Jahrhundert ist – wenn man es ausdrückt als linearer Regressionstrend kleinster Quadrate des Mittels von RSS und UAH der monatlichen mittleren globalen Temperaturanomalien. Die zentrale Schätzung des IPCC von 0,71°C, also äquivalent zu 2,8°C pro Jahrhundert, welche unter Szenario A im Jahre 1990 mit „substantiellem Vertrauen“ prophezeit worden war, war dreimal zu hoch gegriffen. Tatsächlich liegt die tatsächliche Rate sichtlich deutlich unter selbst der kleinsten Schätzung.

Im Jahre 1990 war die zentrale Prophezeiung der kurzfristigen Erwärmungsrate des IPCC um zwei Drittel höher als dessen heutige Prophezeiung. Damals war es ein Äquivalent von 2,8°C pro Jahrhundert, heute ist es ein solches von 1,7°C pro Jahrhundert – und wie Abbildung T5 zeigt, hat sich selbst das als eine substantielle Übertreibung erwiesen.

Erwärmt sich der Ozean?

Eine oft herangezogene Erklärung des Großen Stillstands lautet, dass das gekoppelte Ozean-Atmosphäre-System weiterhin Wärme akkumuliert hat mit etwa der von den Modellen prophezeiten Rate, aber das die Wärme während der letzten Jahrzehnte durch die Ozeane aus der Atmosphäre herausgefiltert worden ist. Und man hypothetisiert angesichts des Umstands, das die oberflächennahen Schichten weit weniger Erwärmung zeigen als von den Modellen prophezeit, dass das, was man die „fehlende Wärme“ nennt, irgendwie in die kaum vermessenen Tiefen unter 2000 m diffundiert ist, von wo sie irgendwann in Zukunft wieder freigesetzt wird.

Tatsächlich ist unbekannt, ob sich der Ozean erwärmt: jede der automatisierten ARGO-Bojen führt nur drei Messungen pro Monat durch für eine Wassermenge von 200.000 km³ – grob etwa ein 100.000 Quadratmeilen [ca. 259.000 km²] großes Gitterquadrat mit einer Kantenlänge von 316 km und einer Tiefe von 2000 m. Im Klartext, die Ergebnisse einer so geringen Auflösung sind nicht viel besser als Raten. (Willis Eschenbach drückt es so aus: es ist etwa das Äquivalent zu versuchen, eine einzelnes Temperatur- und Salzgehalts-Profil an einem einzigen Punkt im Oberen See einmal pro Jahr zu erstellen).

Unglücklicherweise scheint es, als ob ARGO den Ozean-Datensatz seit Dezember 2014 nicht mehr aktualisiert hat. Allerdings haben wir 11 ganze Jahre mit Daten. Die Ergebnisse zeigt Abbildung T5. Falls die ARGO-Messungen richtig sind, ist die Erwärmung der Ozeane äquivalent zu 0,2°C pro Jahrhundert.

Abbildung T5: Der gesamte, fast globale ARGO-Datensatz der Wassertemperatur der Ozeane in den oberen 2000 m von Januar 2004 bis Dezember 2014 (schwarze gezackte Kurve), zusammen mit dem linearen Regressionstrend kleinster Quadrate, berechnet aus den Daten vom Autor (grüner Pfeil).

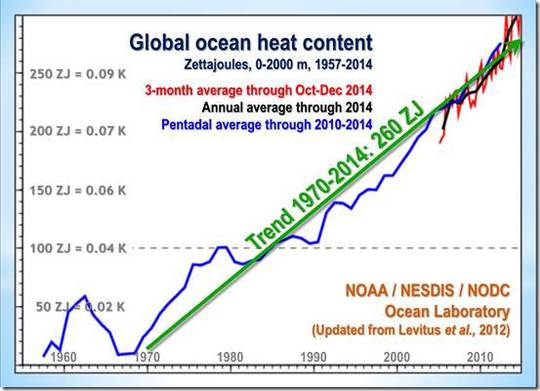

Und schließlich, obwohl die ARG-Bojen die Temperaturänderung in den Ozeanen direkt messen, ändert die NOAA die Temperaturänderung künstlich in Zetajoule der Änderung des ozeanischen Wärmegehaltes, wodurch die Änderung viel größer aussieht.

Die erschreckend klingende Änderung des Wärmegehaltes von 260 ZJ im Zeitraum 1970 bis 2014 (Abbildung T6) ist äquivalent zu lediglich 0,2 K pro Jahrhundert globaler Erwärmung. All jene „Hiroshima-Bomben von Wärme“, von denen die extremistischen Klima-Websites reden, sind in Wirklichkeit ein kaum wahrnehmbarer Nadelstich. Der Ozean und dessen Wärmekapazität sind viel größer als so Mancher wahrhaben will.

Abbildung T6: Änderung des ozeanischen Wärmegehaltes von 1957 bis 2013 in Zetajoules vom NODC Ocean Climate Lab der NOAA: http://www.nodc.noaa.gov/OC5/3M_HEAT_CONTENT, wobei die Werte des Wärmegehaltes zurück konvertiert wurden zu den Änderungen der Wassertemperatur in den Ozeanen in Kelvin, wie sie ursprünglich gemessen worden sind. Die Konversion der NOAA der minimalen Erwärmungszahlen in Zetajoule, kombiniert mit einer übertriebenen vertikalen Achse der Graphik, hat die Auswirkung, dass eine sehr kleine Änderung der Wassertemperatur viel signifikanter aussieht als sie ist.

Die Rück-Konversion der Änderung des ozeanischen Wärmegehaltes in Temperaturänderungen enthüllt eine interessante Diskrepanz zwischen den NOAA-Daten und denen des ARGO-Systems. Während des Zeitraumes der ARGO-Daten von 2004 bis 2014 implizieren die NOAA-Daten eine Erwärmung der Ozeane um 0,05°C pro Jahrzehnt, äquivalent zu 0,5°C pro Jahrhundert – oder eine fast doppelt so hohe Rate wie von ARGO gemessen.

Zwar hat ARGO den besser aufgelösten Datensatz, aber da die Auflösung aller Ozean-Datensätze sehr gering ist, muss man all diese Ergebnisse mit Vorsicht betrachten. Was man sagen kann ist, dass aufgrund solcher Beweise, wie sie diese Datensätze erbringen können, die Differenz zwischen dem zugrunde liegenden Erwärmungstrend des Ozeans und dem der Atmosphäre nicht statistisch signifikant ist. Dies zeigt, dass falls sich die „fehlende Wärme“ wirklich in den Ozeanen versteckt, sie auf magische Weise den Weg in tiefe Schichten gefunden hat, ohne die oberen Schichten auf ihrem Weg zu erwärmen. Ebenfalls aufgrund dieser Daten gibt es keine Beweise für eine rapide oder katastrophale Erwärmung der Ozeane.

Außerdem gibt es bis heute keine empirische, theoretische oder numerische Methode, komplex oder einfach, die erfolgreich mechanistisch spezifiziert hat, wie entweder die durch die anthropogene Anreicherung der Atmosphäre mit Treibhausgasen verursachte Erwärmung die Tiefsee erreicht hat, ohne den Wärmegehalt der durchdrungenen oberen Ozeanschichten wesentlich zu verändern, oder wie die Wärme vom Grund der Ozeane eventuell irgendwie wieder die Klimabedingungen nahe der Oberfläche beeinflussen kann, die für das Leben auf dem Festland der Erde relevant sind.

Die meisten Ozean-Modelle, die zur Berechnung der gekoppelten allgemeinen Modell-Sensitivität herangezogen worden sind, können die meisten der physikalischen Prozesse nicht auflösen, die für die Wärmeaufnahme durch die Ozeane relevant sind. Ultimativ verlangt der Zweite Hauptsatz der Thermodynamik, dass sich jedwede in der Tiefsee akkumulierte Wärme via verschiedener Diffusionsprozesse auflösen muss. Es ist nicht plausibel, dass irgendwelche durch die Tiefsee aufgenommenen Wärmemengen plötzlich die oberen Ozeanschichten erwärmen und damit auch die Atmosphäre.

Falls die „Tiefsee“-Erklärung für den Stillstand korrekt wäre (und diese ist lediglich eine von Dutzenden Anderen, die präsentiert worden sind), haben die komplexen Modelle dabei versagt, dies korrekt abzubilden: anderenfalls wäre die wachsende Diskrepanz zwischen den prophezeiten und beobachteten atmosphärischen Erwärmungsraten nicht so signifikant geworden, wie es der Fall ist.

Warum waren die Modell-Prophezeiungen übertrieben?

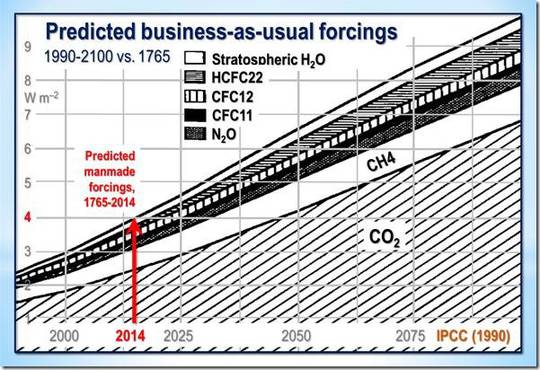

Im Jahre 1990 prophezeite das IPCC – unter seinem Szenario A (Business as Usual) – dass es vom Beginn der industriellen Revolution an bis zur Gegenwart einen Strahlungsantrieb von 4 Watt pro Quadratmeter geben würde, der durch den Menschen verursacht ist (Abbildung T7):

Abbildung T7: prophezeite, vom Menschen verursachte Strahlungsantriebe (IPCC 1990).

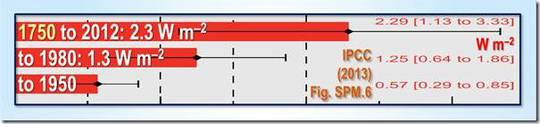

Allerdings hat sich das IPCC von 1995 an entschlossen, aufgrund dürftiger Beweise zu vermuten, dass anthropogene Aerosole – meist Ruß durch Verbrennung – die Erde abschattet, und zwar stark genug, um einen starken negativen Strahlungsantrieb auszulösen. Auch hat es inzwischen verspätet erkannt, dass seine projizierten Zunahmen der Methan-Konzentration wilde Übertreibungen waren. Als Folge dieser und anderer Änderungen schätzt es jetzt, dass der gesamt-anthropogene Antrieb der industriellen Ära lediglich 2,3 W/m² beträgt oder etwas weniger als halb so groß ist wie laut dessen Prophezeiung im Jahre 1990.

Abbildung T8: Gesamt-anthropogene Antriebe von 1750 bis 1950, 1980 und 2012 (IPCC 2013).

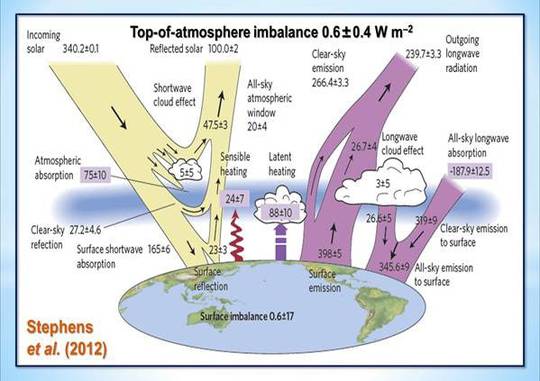

Allerdings könnte selbst das noch eine erhebliche Übertreibung sein, beträgt doch die Best Estimate des tatsächlichen gegenwärtigen Strahlungs-Ungleichgewichtes an der Obergrenze der Atmosphäre (TOA) lediglich 0,6 W/m² (gesamter natürlicher und anthropogener Antrieb); Abbildung T9:

Abbildung T9: Energiebudget-Diagramm für die Erde nach Stephens et al. (2012).

Kurz gesagt, der größte Anteil des vom IPCC prophezeiten Antriebs ist entweder eine Übertreibung oder hat bereits zu der Temperaturänderung geführt, welcher auch immer, die er verursachen sollte. Es gibt nur wenig globale Erwärmung in der Pipeline als Folge unserer Emissionssünden in Vergangenheit und Gegenwart.

Es kann auch sein, dass das IPCC und die Modelle unablässig die Klimasensitivität übertrieben haben. Eine jüngst erschienene Studie zu dieser Frage von Monckton of Brenchley et al. (2015), kam auf eine Klimasensitivität im Bereich von 1°C pro Verdoppelung des CO2-Gehaltes (man gehe zu www.scibull.com und klicke dort auf „Most Read Articles“). Die Studie identifizierte Fehler in der Art und Weise, wie die Modelle mit Temperatur-Rückkopplungen umgegangen waren, sowie deren Verstärkung, welche für zwei Drittel der Gleichgewichts-Erwärmung verantwortlich waren, die das IPCC prophezeit hatte.

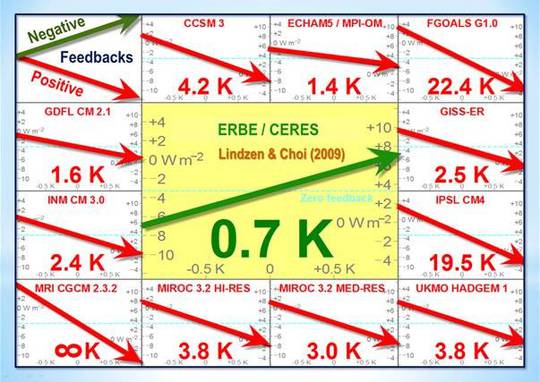

Prof. Ray Bates hat jüngst in Moskau eine Studie veröffentlicht, in der er auf der Grundlage der Analyse von Lindzen & Choi (2009, 2011) zu dem Ergebnis gekommen war (Abbildung T10), dass Temperatur-Rückkopplungen insgesamt negativ sind. Demzufolge hat er die Schlussfolgerungen sowohl von Lindzen & Choi (1990) als auch von Spencer & Braswell (2010, 2011) bestätigt, denen zufolge die Klimasensitivität unter – und vielleicht beträchtlich unter – 1°C pro CO2-Verdoppelung liegt.

Abbildung T10: Realität (Mitte) im Vergleich zu 11 Modellen. Aus Lindzen & Choi (2009).

Eine zunehmende Anzahl begutachteter Studien kommt zu dem Ergebnis, dass die Klimasensitivität deutlich unter den 3°C (1,5; 4,5) pro CO2-Verdoppelung liegt, die zum ersten Mal im Charney-Report aus dem Jahr 1979 für die Academy of Sciences in den USA kolportiert worden war. Hierbei handelt es sich bis heute um die Best Estimate des IPCC.

Auf der Grundlage der bis heute vorliegenden Beweise gibt es daher keine wissenschaftliche Basis, überhaupt irgendwelche Maßnahmen zu ergreifen, um die CO2-Emissionen abzuschwächen.

Und zum Schluss: Wie lange wird es dauern, bevor die Freiheits-Uhr 20 Jahre ohne jede globale Erwärmung erreicht? Falls das geschieht, wird die Klimaangst unhaltbar werden.

Übersetzt von Chris Frey EIKE

Link: http://wattsupwiththat.com/2015/09/04/the-pause-lengthens-yet-again/