Bild1 (rechts): Bayerns Wirtschafts- und Energieministerin Ilse Aigner bei der Zwischenbilanz-Präsentation der bayerischen IHKs zur Energiewende am 17. Juli 2015. Sie bekommt vom bayerischen IHK Haupt-Geschäftsführer ein „Präsent“ überreicht.

Vor Kurzem hat die IHK Bayern ein Positionspapier zur Energiewende veröffentlicht[1]. Wenn ein solcher Verband, der auf das geballte Wissen und Know-how von Industrie, Mittelstand und Handel zurückgreifen kann dazu Stellung nimmt, ist man gespannt auf eine fundierte und reflektierende Darstellung dieses kritischen Themas. Entsprechend wird im Vorwort auch die Erwartung geschürt:

Vorwort des IHK Präsidenten und des Haupt-Geschäftsführers:

[1] …. Vor diesem Hintergrund hat der Bayerische Industrie- und Handelskammertag (BIHK) gemeinsam mit im BIHK-Ehrenamt tätigen Unternehmen aller Branchen dieses Positionspapier erarbeitet.

Das Papier zieht eine Zwischenbilanz zum Stand der Energiewende nicht nur in Bayern, sondern auch in Deutschland und Europa, im Hinblick auf die Sicherheit und Wirtschaftlichkeit der Energieversorgung und leitet hieraus Handlungsempfehlungen ab. Das Papier wird durch die BIHK-Schlussfolgerungen zum Energiedialog Bayern ergänzt.

Der Autor – dem EEG gegenüber erkennbar kritisch eingestellt[5] – hat sich die Publizierung angesehen. Wie er diese persönlich einschätzt, ist in diesem Artikel für EIKE-Blogleser zusammen-gefasst. Um es nicht zu lang werden zu lassen, musste er sehr selektiv auswählen. Deshalb hat er sich auf die Themen: CO2-Vermeidung, Sinnhaftigkeit und Machbarkeit der Energiewende, sowie politische Orientierung beschränkt.

Beginnen wir mit einem Zitat aus dem Vorwort, und zwar der Einleitung davon:

[1]

Diese Zeilen hätten die Grünen so „kurz und knackig“ für eines ihrer Wahlplakate nicht besser texten können, nach dem Motto: Gutes tut man mit dem Herzen und nicht mit dem Verstand:

unterstützt den Umbau der Energieversorgung

Senkung der klimarelevanten Emissionen

schrittweiser Ausstieg aus der Kernenergie

stärkere Nutzung erneuerbarer Energien

Schonung der natürlichen Ressourcen

Ein wunderschön formuliertes „Zieldreieck“ beschreibt dazu ergänzend den paradiesischen Endzustand:

[1]

Nur ein paar Kleinigkeiten findet die IHK störend:

[1] Die Gefährdung der Wettbewerbsfähigkeit zeigt sich auch in den immer höheren Strompreisen, die die Bezahlbarkeit der Energieversorgung immer weiter erschweren.

Aber was noch nicht gelungen ist, kann nach 25 Jahren wohl immer noch werden. Ein paar Mängelchen beseitigt und schon wird es richtig flutschen. Realitätsferne ist eben keine Parteidomäne:

[1] .

Der Autor des EIKE-Artikels „Was die Energiewende wirklich kostet“[4] (und viele andere) müssen sich da wohl verrechnet haben. Leider führt im Gegensatz zum EIKE-Autor die IHK keine Belege an.

Nun sind Vorwörter noch kein Inhalt. Nicht selten steht darin das Gegenteil drin, weil „die Sachbearbeiter oder engstirnigen Ingenieure“ etwas anderes ermittelt haben, als Vorstände hören wollten. Stürzen wir uns also darauf.

Zwischenbilanz der bayerischen IHKs zur Energiewende 2015

1 Zielsetzung der Energiepolitik in der EU, Deutschland und Bayern

1.1 Energiepolitische Ziele in der EU

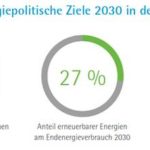

Es werden die EU-Ziele gelistet und erklärt. Das folgende Bild 2 zeigt die Kernaussagen. Interessant ist, dass dem Anteil erneuerbarer Energien ein identisches Einsparziel gegenüber steht. Es zeigt zumindest einen Realitätssinn (der EU-Politiker). Diese bedeutet allerdings, dass der Verbraucher doppelt bezahlen muss. Bezahlen der „Erneuerbaren“ und bezahlen, damit man sie nicht benötigt, weil sie als Zappelstrom unplanbar sind. Das Kapitel geht darauf leider nicht ein. Es geht auch nicht darauf ein, was der Nutzen der Emissionsreduzierung sein soll.

Bild2 [1]

1.2 Energiepolitische Ziele in Deutschland

Textausschnitt:

[1] Deutschland steht als führende Industrienation Europas mit seiner Energiewende im

Fokus der weltweiten Öffentlichkeit. Es wird dabei durchaus unterschiedlich bewertet:

Die Einschätzungen reichen von einem unkalkulierbaren Wagnis bis hin zu einer Vorbildfunktion.

Leider wird nicht gesagt, wer wie über die deutsche Energiesende denkt. Bei [18] kann man ein Beispiel lesen.

Ansonsten werden nun die deutschen Ziele, basierend auf dem Energiekonzept (2010) und „10-Punkte-Energie-Agenda“ des BMWi, die im Juni 2014 veröffentlicht wurde, erklärt. Inhaltliche Diskussionen dazu sind nicht zu finden.

Bild3 [1]

1.3 Energiepolitische Ziele in Bayern

Textausschnitt:

[1] In Deutschland übernimmt Bayern eine Vorreiterrolle beim Ausbau der erneuerbaren Energien. Der Anteil der Erneuerbaren an der Stromerzeugung lag in Bayern 2013 bei 34 Prozent, der Anteil am Primärenergieverbrauch bei 16,2 Prozent. Bei Photovoltaik, Wasserkraft und Geothermie liegt der Freistaat auf dem 1. Platz, bei Bioenergie auf Platz 2 unter den Ländern. Bei der Windenergie erreicht Bayern beim aktuellen Zubau Platz 6 (Bayerisches Staatsministerium für Wirtschaft). Nachfolgende Grafik stellt die prominentesten energiepolitischen Ziele Bayerns dar (Bayerisches Energiekonzept 2011).

Ansonsten werden nun die bayerischen Ziele, basierend auf dem bayerischen Energiekonzept 2011 erklärt.

Bild4 [1]

Die Kernziele des bayerischen Energiekonzeptes „Energie innovativ“, die im Wesentlichen durch den Energiedialog bestätigt wurden, sind[1]:

Umstieg auf eine überwiegend auf erneuerbaren Energien basierende Energieversorgung in Bayern

Eine sichere, bezahlbare und umweltfreundliche Energieversorgung in Bayern

· Bayern bleibt Produktionsstandort für Energie und strebt bei der Energiewende die Technologieführerschaft in Wissenschaft und Wirtschaft an.

Mit dem Zusatz:

[1] Die größten Zuwächse beim erneuerbaren Strom sollen Photovoltaik und Windenergie erzielen.

Auch zu diesen Listungen ist keine inhaltliche Diskussion zu finden. Dabei gäbe es doch so viel Klärungsbedarf, wie es gelingen soll, dieses offensichtliche Wunschdenken und die erschreckende Wirklichkeit[5] in Übereinstimmung zu bringen.

Anschließend wird es etwas interessanter. Auch die IHK weiss, dass nach dem Abschalten aller Kernkraftwerke in Bayern die Hälfte der Elektro-Stromerzeugung fehlt[5].

[1] Bayern hat deutschlandweit den größten Anteil an Atomkraftwerken zur Stromerzeugung und ist deshalb von der Energiewende mit dem Atomausstieg besonders stark betroffen. Bis 2022 werden in Deutschland alle Kernkraftwerke stillgelegt. Damit fallen in Bayern 46 Prozent der grundlastfähigen Kraftwerke weg. Diese Kapazitäten müssen rund um die Uhr ersetzt werden können, was für Bayern eine große Herausforderung darstellt.

Erstmals liest man auch, dass Bayern vom EEG gleich „besonderst stark betroffen ist“. Dass das eine große Herausforderung darstellt, sollte auch einem Nicht-Fachmann klar sein. Eine Diskussion darüber findet im Kapitel aber nicht statt.

2 Energiewende: Zwischenbilanz der bayerischen IHKs 2015

2.1 Europäische Union: Nicht alle Länder im Gleichschritt

In diesem Kapitel geht es vor allem um die CO2-Reduktionsziele.

[1] Mit der Priorisierung der Reduktion der Treibhausgase im Rahmen der EU-Ziele für 2030 gegenüber den Zielen für den Ausbau erneuerbarer Energien und die Einsparung von Energie ist die europäische Politik einen großen Schritt vorwärts gegangen. Es sieht alles danach aus, dass das EU-Ziel erreicht wird, und zwar bei geringen Kosten für die Endkunden und Märkte.

Was der „große Schritt Vorwärts“ sein soll, wird nicht ausgeführt. Die Worthülse „Vorwärts“ hat zudem viel Historie. Die meisten Länder, in denen sie konsequent einen imaginären „Fortschritt“ begründete, existieren nicht mehr, oder leiden noch heute darunter. Auch wie man auf die Darstellung „…und zwar bei geringen Kosten für die Endkunden..“ kommt, bleibt bei einem Endkunden-Strompreisverlauf, wie es Bild 5 darstellt, ein Rätsel. Aber vielleicht sind nur die davon befreiten Industriebertriebe gemeint. Wer es schon bisher bezahlt, kann man jedenfalls überdeutlich sehen.

Bild5 [6] Strompreisverlauf Deutschland (Pfeile durch den Autor hinzugefügt)

Eine inhaltliche Diskussion zum Thema: Sinn der CO2 Reduzierung, findet nicht statt.

2.2 Deutschland und Bayern: Bundesregierung hat Ziele lange nicht erreicht

Bei all der Euphorie und vorbehaltlosen Zustimmung, welche die IHK bis hier zur Energiewende listet, kommen nun Wermutstropfen. Ausgerechnet dort, wo die bayerische IHK sitzt, ist es leider „ernüchternd“.

[1] Sowohl auf Bundesebene als auch auf Landesebene kommt die Energiewende trotz der 10-Punkte-Agenda des Bundeswirtschaftsministeriums an den entscheidenden Punkten nicht mehr richtig voran. Die Zwischenbilanz ist mit Blick auf den Atomausstieg und die Sicherung der Versorgung nach 2022 ernüchternd.

Die bayerische IHK meint nun, dagegen komme man wohl am besten an, indem man der „Ernüchterung“ Wünsche entgegenstellt. Alles ist toll und das Paradies schon nah, wie Experten es laufend belegen, doch leider funktioniert es hinten und vorne nicht, lautet das Credo. Irgendwie kann man sich dabei in einen DDR-Funktionär kurz vor der Wiedervereinigung hineinversetzen:

[1] Der Strommarkt der Zukunft soll laut BMWi für einen effizienten Kraftwerkseinsatz bei wachsenden Anteilen erneuerbarer Energien sorgen. Gleichzeitig muss er Versorgungssicherheit gewährleisten. Umlagefinanzierter EE-Strom kann kostenfrei oder sogar zu negativen Preisen an den Strombörsen angeboten werden. Er drückt dadurch die Börsenpreise auf ein Niveau, auf dem die nicht geförderten Marktteilnehmer ihre Kosten nicht mehr decken können. Ohne diese kann die Stromversorgung aber nicht funktionieren. Hier besteht dringender Handlungsbedarf.

Die dadurch entstehende weitere Verzögerung des Netzausbaus darf die Versorgungssicherheit nicht weiter gefährden.

Netzengpässe und deren Management sind somit die derzeit größte Hürde für eine möglichst kostengünstige Integration erneuerbarer Energien in das Stromsystem. Je höher der Anteil von EE-Strom wird, desto höher wird auch der Bedarf an Netzkapazitäten im Übertragungs- und Verteilernetz. Der Netzausbau wird also zunehmend zur Achillesferse der Energiewende.

Lösungsansätze sind aber nicht zu finden. Jedoch listet die IHK nun immer mehr grundlegende Mängel.

3. BIHK-Positionen zur Energiepolitik:

Was jetzt getan werden muss

Das Prinzip wird nicht in Frage gestellt. Also ist es zu „verbessern“. Es folgt eine Kaskade an Vorschlägen und Wünschen, die wohl jeden damit betrauten Politiker alleine beim Durchlesen zur Verzweiflung treiben müssen. Die im Raum stehende Frage: Könnte vielleicht die Systembasis falsch sein, wird nicht angesprochen.

[1] Die Zwischenbilanz 2015 zeigt, dass bereits viel erreicht wurde. An vielen Stellen herrscht jedoch Nachbesserungsbedarf. Die Abschaltung der letzten Kernkraftwerke 2022 rückt näher. Der Stromleitungsbau gerät immer stärker in Verzug. Flexible Bestandskraftwerke stehen unter enormem wirtschaftlichem Druck. Neuinvestitionen in flexible Kraftwerke als Partner der Erneuerbaren unterbleiben. Maßnahmen zur Steigerung der Energieeffizienz müssen vorangebracht werden. Die Politik muss daher einen langfristig stabilen und verlässlichen Ordnungsrahmen schaffen, um auch zukünftig das energiepolitische Zieldreieck einer sicheren, bezahlbaren und verlässlichen Energieversorgung zu gewährleisten. Insbesondere die Bezahlbarkeit und Verlässlichkeit sind unverzichtbare Voraussetzungen für die Unternehmen in Bayern.

Die energieintensive Industrie muss zum Erhalt ihrer internationalen Wettbewerbsfähigkeit von der EEG-Umlage angemessen entlastet werden – dabei dürfen kleine und mittelgroße gegenüber großen Betrieben nicht benachteiligt werden.

Alles würde also gut werden (können), wenn nur das eigene Klientel nicht davon getroffen wird. Wer es dann bezahlen könnte, ist sonnenklar (Hervorhebungen durch den Autor):

[1] Aufgrund der genannten Problemfelder besteht beim EEG weiterhin dringender Reformbedarf. Wettbewerbsverzerrungen, Nachteile im globalen Wettbewerb und Verlagerungstendenzen legen eine deutliche Reduzierung oder Abschaffung der EEG-Umlage nahe. Für das EEG-Konto müssen daher neue Finanzierungsquellen gefunden werden.

Dabei sollte es keine Denkverbote geben: Emissionshandel, Energie und Stromsteuer, allgemeiner Haushalt etc. sind als Möglichkeiten zu prüfen.

Es ist jedoch nicht so, dass man nicht auch schwierigere Probleme kennen würde:

[1] BIHK-Schlussfolgerung zum Energiedialog: Ausbau erneuerbarer Energien

Erneuerbare alleine werden unter den heutigen Bedingungen und nach dem aktuellen Stand der Technik weiterhin nicht in der Lage sein, zu jedem Zeitpunkt im Jahr eine gesicherte Versorgung zu garantieren.

Puh – eine Aussage mit erdrückender Wahrheit. Und nun kommt die Lösung – denkt man (vergebens):

[1] BIHK-Schlussfolgerung zum Energiedialog:

Gaskraftwerke zur Reserve, aber keine Subventionen für wirtschaftlichen Betrieb.

Irgendwie dreht sich das Thema nun immer mehr Kreis. Die Wünsche werden zum Vater des Gedankens. Man fragt sich, ob die Zeile darunter den Inhalt der Zeile darüber kennt.

[1] Als Ersatz für die in den nächsten acht Jahren wegfallenden Kernkraftwerke werden neben den erneuerbaren Energien zahlreiche weitere Optionen benötigt (flexible Gaskraftwerke, Speicher, steuerbare Lasten etc.). Damit hier investiert wird, sind technologieoffene Marktanreize notwendig, die zu möglichst geringen Zusatzkosten führen.

Lösungsansätze, wie der erforderliche Netzausbau werden gelistet. Aber gleichzeitig illusionäre Durchführungsszenarien vorgeschlagen „… Unterstützung aller Positionen….“ usw. Liest niemand der Schreiber eine Tageszeitung? Hat die IHK schon einmal mit Trassengegnern diskutiert, deren Positionen unterstützt und dadurch die „Erlaubnis“ zum Trassenbau erhalten? Zumindest mit den CSU-Bürgermeistern von „Protestgemeinden“ könnte sie das ja einmal üben.

[1] Der Ausbau der erneuerbaren Energien und ihr wachsender Anteil am Stromverbrauch funktionieren ohne den hierzu notwendigen Netzausbau nicht.

Der BIHK unterstützt die Position aller Partner des Energiedialogs von Umweltschützern, über Trassengegner bis zur Wirtschaft, dass die Umsetzung des Leitungsausbaus so bürger und landschaftsfreundlich wie möglich erfolgen muss (Masthöhen, Teilerdverkabelung, wo wirtschaftlich darstellbar).raft wurde bestätigt

asserkraft wurde bestätigt.

Klima- und energiepolitische Zielsetzung auf die Minderung von Treibhausgasemissionen und den Ressourcenverbrauch konzentrieren

Es wiederholt sich das Thema CO2 und Energieeffizienz. Nicht im Ansatz ist eine inhaltliche Reflexion (einer CO2-Reduktion) vorhanden. Man könnte sich vorstellen, dass von einer Kammer, in der zumindest ein Teil der „Intelligenz“ verknüpft ist, wenigstens ein Mal die Sinnhaftigkeit angesprochen und überprüft wird [7] [8]. Leider – Fehlanzeige.

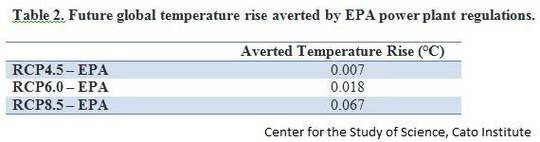

Auch dieses „strategische Dokument“ klammert die Frage vollkommen aus, weshalb ein deutsches CO2-Vermeidungsziel, welches die Welttemperatur um sagenhafte 0,0005 ºC pa „rettet“ [8] und Milliarden kostet[4], ein Erfolg und Ziel sein soll.

Die ständige Wiederholung nach Energieeffizienz als Heilsbringer kann zudem richtig nerven. Eine Lösung, welche Vergangen geglaubte Ostblock-Not-Verwaltungsmechanismen als zukunftsträchtig propagiert, kann nicht wirklich überzeugen.

Energieforschung und bayerische Cluster stärken

Leider listen sich die Banalitäten nun weiter. Ein Wunsch-Feuerwerk wird genannt. Dabei wird nirgends erwähnt, dass praktisch alles bereits ausreichend bekannt ist und aus Gründen mangelnder Effizienz, nicht Realisierbarkeit bzw. hoher Kosten schon verworfen wurde[9].

[1] Eine nachhaltige Energieversorgung wirft vielfältige Probleme auf, deren Lösungen erst noch entwickelt werden müssen. Hierbei ist ein besonderes Augenmerk auf Speichertechnologien, verlustarme Netze und Transformatoren, Lastmanagement, Smart-Grid-Lösungen, hocheffiziente Kraftwerke, CO2-arme Brennstoffe und energieeffiziente Querschnittstechnologien zu legen. Forschung muss aber auch stets offen bleiben für völlig neue Lösungen. Erst kürzlich wurde beispielsweise über wesentliche Fortschritte bei der Fusionstechnologie berichtet, wodurch die zukünftige Energieversorgung eine heute noch unerwartete Entwicklung nehmen könnte.

Man muss sich das vorstellen. Wir befinden uns im Jahr 25 nach Beginn der „Energiewende“ [10] und 7 Jahre vor der Abschaltung des letzten bayerischen Kernkraftwerkes. Und nun erzählt eine IHK „ … wirft vielfältige Probleme auf, deren Lösungen erst noch entwickelt werden müssen“ und listet lediglich ein technisches Wunschkonzert dazu. Dabei sind doch die Firmen, welche „… noch entwickeln müssen“ ihre eigenen Mitglieder. Hätte man da nicht mal nachfragen können?

Speichertechnologien: Es ist sattsam bekannt, welche Problematiken bestehen und dass keine Lösungen vorhanden sind[11][9]. Sogar der zuständige Arbeitskreis des bay. Ministeriums hat es in einem Protokoll hinterlegt:

[15] Fazit: Speicher werden keinen Beitrag zur Deckungslücke bei der erzeugten Strommenge von ca. 40 TWh leisten können

Der IHK ist aber auch keine Lösung eingefallen, sonst hätte sie wenigstens eine Minimalinformation gelistet.

Verlustarme Netze und Transformatoren: Die gibt es schon länger [12] [13]. Der Einsatz ist aber eine Frage der Kosten. Zudem ist leider bei 100% Wirkungsgrad schluss und der wirkliche Zusatznutzen damit sehr begrenzt, was allerdings nicht für die Kosten gilt. Bei den meisten geht es auch gar nicht um den Wirkungsgrad, sondern um die (sehr teure) Regelbarkeit. Die benötigt man, um die aufgrund der Ökoeinspeisung stark schwankenden Spannungsebenen übergangsweise noch halten zu können.

Lastmanagement, Smart-Grid-Lösungen, hocheffiziente Kraftwerke, CO2-arme Brennstoffe und energieeffiziente Querschnittstechnologien:

o Ein unverbindliches Sammelsurium an Schlagwörtern – aber kein Hinweis auf Sinn und Lösungsumfang.

Im Kern handelt es sich um die teure Verwaltung des selbst erzeugten Energiemangels. Die mangelbedingte Notabschaltung gilt heute im Neusprech als Lastmanagement – ist im Ergebnis aber nicht besser. Und die „Effizienzkeule“, welche im ganzen Dokument laufend „gebetet“ wird, ist vor allem für die Lieferanten hoch effizient.

Die DDR ging danach kaputt, weil sie Mangel erzeugte, aber nicht das Geld hatte, ihn hochtechnologisch zu steuern. Wir erzeugen den Mangel, aber verwalten ihn hoch-technologisch; das soll die Lösung sein.

Verblüffend ist dazu der Hinweis über die Fusionstechnologie und Erfolge bei der Realisierung. Leider fehlt eine Fundstelle dazu. Wie ein Fachmann die Realisierbarkeiten sieht, zeigt Bild 6. Man wird also sicher noch etwas warten müssen, denn in dieser extrem schwierigen Technologie waren bisher alle Erfolgsankündigungen falsch (und eine ohne Quellenangabe hat sowieso den Stand „Hoffnung“ und gehört niemals in ein solches Dokument). Und welche Richtung wirklich eine „… unerwartete Entwicklung nehmen könnte“ ist auch nicht präzise genug um irgendwie planbar zu werden.

Bild6 [14] Fusionstechnologie Entwicklungs-Zeitstrahl

Auf ein ganz heikles Thema geht das Dokument ebenfalls nicht ein.

Im Kapitel: Energiemix und Anteil der erneuerbaren Energien sieht man die folgende Grafik:

Bild7 [1] Darstellung der EU- EEG-Vorbildländer

Worin besteht der EEG-Erfolg der Vorzeigeländer?

Schweden: hat einen Atomstromanteil von 63,7 %[16]. Das ist das Doppelte des höchsten – gewesenen – Atomkraftanteils in Deutschland.

· Lettland: Hat wenig Industrie. Der Energiemix ist nur unter diesem Gesichtspunkt verständlich. Er würde bei uns zu einer Preis (Gasanteil) und Umweltkatastrophe (Wald nur noch als Energiewald) führen.

Bild8 [17] Lettland: Energieverbrauch und –Quellen

Finnland: hat einen Atomstromanteil von 33 %[16], also aktuell so viel, wie Deutschland um 2000 maximal hatte. Diesen baut es aber weiter aus, anstelle ab:

[18] In den kommenden Jahren will Finnland vor allem Stromkapazitäten in Atommeilern (+2,8 GW), Windparks (+2,1 GW) und Biomassekraftwerken (+0,8 GW) ausbauen

Und das wohl Schlimmste: Das Klimawandel-Bekämpfer-Vorzeigeland USA setzen ebenfalls wieder auf Atom[18]. Obama kann leicht Kohlekraftwerke abschalten, wenn er es durch Atomkraft und mittels Fracking-gewonnener Energie kompensiert. Deutschland macht es auch – Kohlekraftwerke abschalten – der Rest als Lösung fehlt.

Dazu der Verlauf des Atomstromanteils in Deutschland.

Bild 9 Verlauf des Atomstrom-Anteils in Deutschland

Nur Deutschland macht also etwas ganz Sonderbares. Die Länder, welche das Gegenteil des deutschen EEG-Atomausstiegs durchführen, sind in der EU Vorzeigeländer. Wir schalten die Atomkraft ab und beklagen uns, die EU-CO2-Richtlinien nicht erfüllen zu können. Der US-Präsident setzt auf Atomkraft und sagt zur deutschen Energiewende:

[18]. „Der Klimaschützer Obama weiß das – und hat deshalb erklärt, er halte Atomkraftwerke für sicher und sauber. Innerhalb der US-Regierung sieht man die Entscheidung von Bundeskanzlerin Angela Merkel, nach dem Unfall in Fukushima den Ausstieg Deutschlands aus der Nuklearenergie festzuschreiben, als Panikreaktion.“

Anstelle dies zu Hinterfragen oder zumindest anzusprechen, wird darüber kein Wort verloren.

Nun wird dieses IHK-Dokument durch die BIHK-Schlussfolgerungen zum Energiedialog Bayern ergänzt[2]. Also noch darin hineingesehen. Allerdings sind wesentliche Passagen daraus in das Positionspapier 2015 übernommen, weshalb sich darin nicht viel Neues findet. Lediglich ein paar Punkte sind konkretisiert.

BIHK-Schlussfolgerungen zum Energiedialog

Fundstellen

[2] Ausgangspunkt sind die „Lücken“ von 40 TWh Arbeit und 5 GW gesicherter Leistung im Jahre 2023 (Bedarf in Bayern, gemessen an Erzeugung in Bayern), deren Sicherung durch Netzausbau, Reservekraft, den Ausbau erneuerbarer Energien und Speicher im bayerischen Energiedialog besprochen und überprüft wurde.

Das ist nur die halbe Wahrheit. In [5] konnte belegt werden, dass „überprüft“ nur bedeutet, sicher zu sein, keine Lösung gefunden zu haben. Ein bisschen Realitäts-Akzeptanz ist zu finden. Etwas abgewandelt wurden diese (Er-) Kenntnisse in das Hauptdokument übernommen.

[2]. Speichertechnologien

Der BIHK stimmt mit der Erkenntnis des Dialogs überein, dass Speichertechnologien bis zur Abschaltung des letzten Kernkraftwerks 2022 nur einen Beitrag zur Stabilisierung der Netze leisten können.

[2]. Ausbau erneuerbarer Energien

Eine der wichtigsten Erkenntnisse der AG 3 (Ausbau erneuerbarer Energien) für den BIHK ist, dass Erneuerbare alleine unter den heutigen Bedingungen und nach dem aktuellen Stand der Technik weiterhin nicht in der Lage sein werden, zu jedem Zeitpunkt im Jahr eine gesicherte Versorgung zu garantieren.

Zu den Themen Atomkraft und Sinn der CO2-Vermeidung ist auch in diesem Dokument allerdings nichts zu finden.

Detailkritiken

Im Artikel hat der Autor viel kritisiert weil er meint, von einer Industrie und Handelskammer realistische und realisierbare Darstellungen erwarten zu dürfen. Dadurch besteht die Gefahr, dass diese Kritiken als ungerechtfertigte Pauschalurteile betrachtet werden. Anbei deshalb ein paar Konkretisierungen:

Im Kapitel „Mehr Wettbewerb und Wirtschaftlichkeit bei erneuerbaren Energien“ steht:

[1] Um mehr Wirtschaftlichkeit und Wettbewerb bei den erneuerbaren Energien zu erreichen, muss das Strommarktdesign weiterentwickelt werden. Die Reform des Strommarktdesigns ist nicht vollständig, wenn sie nicht auch die Vermarktung erneuerbarer Energien einbezieht.

„Erneuerbare alleine werden unter den heutigen Bedingungen und nach dem aktuellen Stand der Technik weiterhin nicht in der Lage sein, zu jedem Zeitpunkt im Jahr eine gesicherte Versorgung zu garantieren. Das unter dem gegebenen Ordnungsrahmen nur noch geringe Ausbaupotenzial der grundlastfähigen Technologien Bioenergie, Geothermie und Wasserkraft wurde bestätigt.“

Die Wasserkraft ist mit rd. 16,3 Prozent (2013) ein bedeutender Eckpfeiler der Stromerzeugung in Bayern. Ein weiterer Ausbau ist aufgrund hoher ökologischer Einschränkungen begrenzt, aber technisch möglich und sinnvoll. Umweltanforderungen müssen hierfür in einen angemessenen und praktikablen Ausgleich mit den Vorteilen der Nutzung dieser wertvollen erneuerbaren Energie gebracht werden. Die Rahmenbedingungen für die Wasserkraft müssen von der Energiepolitik so gestaltet werden, dass ein sinnvoller Ausbau wieder möglich wird.

Mit dieser Darstellung werden zwei Aussagen vermittelt: Die „neuen Energien“ sind nur unwirtschaftlich, weil die Wettbewerbsbedingungen nicht stimmen. Und als Zweites, dass die mit Lösung der Wettbewerbsbedingungen „sinnvoll“ werdenden „grundlastfähigen Technologien“ nur wegen des „gegebenen Ordnungsrahmens“ nicht ausreichend ausgebaut werden könnten, ein weiterer Ausbau aber „… technisch möglich und sinnvoll wäre“. Konkretisiert wird dies am Beispiel Wasserkraft.

Wasserkraft

Das technische Ausbaupotential der Wasserkraft beträgt in Bayern 10 %[21]. Aktuell sind es 16,3 %. Also würde sich der Energieanteil damit um 1,63 % von 16,3 auf 18 % erhöhen. Bei fehlenden 50 %[5] soll das eine Lösung sein? Für diesen vernachlässigbaren „Vorteil“ von 1,63 % soll die Natur laut der BIHK einfach so geopfert werden?

Geothermie

Ihr Anteil an der Stromerzeugung in Bayern ist so gering, dass sie als Position im Energieatlas Bayern nicht auftaucht. Und das hat seinen Grund:

2020 soll laut Planung der Geothermiestrom in Deutschland 1.654 GWh pa[22] betragen, während die elektrische Energieerzeugung Deutschlands ca. 634 Terawattstunden (TWh) beträgt.

Der Anteil der Geothermie an der deutschen Stromversorgung beträgt im Jahr 2020 damit ca. 0,00026 % !!!!!

Der Bundesverband Geothermie textet zu diesen Zahlen:

[22] Die Geothermie wird im Zusammenspiel mit den anderen Erneuerbaren Energien die Wärme- und Stromversorgung nach und nach von den fossilen Energieträgern (Kohle, Öl und Gas) und der Atomkraft übernehmen.

Mehr Realitätsferne (man könnte auch viel schlimmeres dazu sagen) ist kaum vorstellbar. Beim EEG und auch zur Klimaerwärmung stört das jedoch niemanden. Aber von einer BIHK darf man es verlangen.

Bioenergie

Was sagt der Energieatlas Bayern dazu:

[23] „Ausgehend vom heutigen Energieverbrauch Bayerns kann Biomasse aus technischer Sicht nur einen kleinen Anteil der Energieversorgung übernehmen (bis zu 10 %).“

Dabei sind die gravierenden Umweltprobleme und der geringe, bis gar nicht vorhandene Nutzen noch nicht angesprochen, wie es der NABU in einer Publizierung gut darlegt[24]. Diese alleine sollten einen weiteren Ausbau eher verbieten als unterstützen.

Die BIHK bietet damit bezüglich der „erneuerbaren Energien“ ausser Darlegungen zu Kosten- und Subventions-Betrachtungen bei den wesentlich wichtigeren technischen Details keinerlei schlüssige Lösungen.

Speichertechnologien

Dazu listet das Paper[1] außer unverbindlichen Statements nirgendwo eine fundierte Betrachtung. Obwohl genau das Speicherthema technisch gesehen mit das größte Problem gerade der bayerischen Energiewende darstellt, wie man in[5] und auch in den BIHK-Schlussfolgerungen lesen kann:

.

[2] „Wind und Photovoltaik werden auch künftig keine ausreichenden Beiträge zur Versorgungssicherheit leisten können, wenn keine günstigen und leistungsfähigen Speicher zur Verfügung stehen.“

Auch der BIHK ist bestimmt klar, dass ihre Aussage dazu, nur noch etwas forschen zu müssen, allen bisher bekannten Fakten widerspricht und damit ein bewusstes Verharmlosen des wahren Problemzustandes darstellt.

Atomkraft

Dazu hätte der Autor eine Stellungnahme erwartet.

Wenn die EEG-Vorzeigeländer und nun auch die USA massiv darauf setzen, sind diese Länder entweder ganz dumm, oder am deutschen Konzept stimmt etwas nicht. Eine technisch orientierte BIHK, welche den deutschen EEG-Weg bedingungslos unterstützt, hat schon die Not, dies auch zu begründen.

Wer sagt:

[1] „Bayern bleibt Produktionsstandort für Energie und strebt bei der Energiewende die Technologieführerschaft in Wissenschaft und Wirtschaft an.“

sollte sich gut überlegen, ob als Technologieführerschaft alleine das Forschen an mittelalterlichen Energiegewinnungsformen zukunftsträchtig sein kann.

CO2-Vermeidung

Auch dazu fehlt jegliche Diskussion. Obwohl man zur Kosten- Nutzenberechnung lediglich Grundschulwissen benötigt[8] und man denken sollte, das Ergebnis müsste jeden Laien überzeugen (oder jemand belegt, dass die Abschätzungen falsch sind), wird an keiner Stelle auf den Sinn der politischen Vorgaben eingegangen. Dabei stellt die CO2-Reduktion die wichtigste Prämisse des EGG dar (die zweite des Atomausstiegs gilt ja vorwiegend nur für Deutschland – und Österreich -).

Fazit

Die bayerische IHK hat mit ihrer Publizierung die Chance vertan, etwas für die Bürger, zur Begründng oder zur Realisierung sproblematik Sinnvolles im Thema Energiewende beizutragen. Sie macht lediglich den Versuch, ihr eigenes Klientel vor den Auswirkungen zu schützen.

Der Anspruch

[1]Das Papier zieht eine Zwischenbilanz zum Stand der Energiewende nicht nur in Bayern, sondern auch in Deutschland und Europa, im Hinblick auf die Sicherheit und Wirtschaftlichkeit der Energieversorgung und leitet hieraus Handlungsempfehlungen ab.

ist nicht ansatzweise erfüllt, außer man würde eine reine Listung, verbunden mit einem Wunschkatalog als Expertise betrachten.

Leider wird damit auch exemplarisch vor Augen geführt, dass es wohl keine öffentlich wirkende Institution in Deutschland gibt, welche den EEG- und CO2-Vermeidungs-Unsinn hinterfragen, in Frage stellen oder gar stoppen wollte.

Siemens CEO Joe Kaeser macht es vor. Nur im Ausland traut er sich Kritisches darüber zu äußern. Im Inland fehlt im vollkommen der Mut dazu[20] :„Siemens-Chef Joe Kaeser hat den Beschluss der G7 zum Ausstieg aus den fossilen Energien als "visionäres Ziel" begrüßt“. Die Siemens-Mitarbeiterzeitung liest sich auch entsprechend, als wären Teile davon von Greenpeace selbst geschrieben (persönliche Meinung des Autors).

Eines ist dem Autor beim Analysier-Versuch dieses „EEG-Bilanzdokumentes“ der IHK wieder klar geworden. Ein Politiker mit wenig Zeit und ganz anderen Sorgen (nämlich der seiner Wiederwahl) muss an solchen Dokumenten verzweifeln. Wem es gelingt, herauszulesen was wirklich wichtig wäre und dazu Umsetzbares abzuleiten ist ein Genie, wer es versucht, ev. ein EIKE-Autor. Aber vielleicht war der Sinn auch nur, das Foto von Bild 1 zu erzeugen.

Quellen

[1]

Industrie- und Handelskammern in Bayern. Energiewende. Zwischenbilanz der bayerischen IHKs 2015

[2]

BIHK München, 16. Februar 2015. Schlussfolgerungen zum Energiedialog

[3]

DIHK Positionspapier Die Energiewende zum Erfolg führen

[4]

EIKE 08.08.2015, Blogartikel: Was die Energiewende wirklich kostet

[5]

EIKE Blogartikel 02.07.2015: Der Wind bläst stetig– die Sonne steht still – wenn mein starker Arm es will oder warum gehen in Bayern die Lichter (noch) nicht aus

http://www.eike-klima-energie.eu/energie-anzeige/der-wind-blaest-stetig-die-sonne-steht-still-wenn-mein-starker-arm-es-will-oder-warum-gehen-in-bayern-die-lichter-noch-nicht-aus/

[6]

EnergieAgentur.NRW

[7]

EIKE Blogbeitrag 30.10.2013: Klaus-Eckart Puls EIKE: CO2 – Gift oder Lebenselixier?

[8]

EIKE Blogbeitrag 11.06.2015: Mit CO2-Reduzierung retten wir die Welt – Einige Rechenspiele (nicht nur) für regnerische Nachmittage

[9]

EIKE Blogbeitrag 17.06.2015: Elektro-Energiespeicherung, Notwendigkeit, Status und Kosten. Teil 2

[10]

WIKIPEDIA Energiewende: Obwohl sie in der Öffentlichkeit oft fälschlicherweise mit dem zweiten Atomausstieg 2011 verbunden wird, begann die Energiewende in Deutschland bereits in den 1980er Jahren mit der Förderung von Erneuerbaren Energien und Einstellung neuer Kernkraftwerksprojekte.

[11]

Niedersachsen-Studie 2014. Innovationszentrum Niedersachsen GmbH, Juli 2014. Studie 7983P01/FICHT-12919463-v19:“Erstellung eines Entwicklungskonzeptes Energiespeicher in Niedersachsen“

[12]

Energiedienst Netze GmbH Rheinfelden. Lagebericht für das Geschäftsjahr 2013: In den neuen Ortsnetztrafostationen werden seit 2012 nur noch verlustarme Transformatoren eingesetzt bzw. beschafft.

http://www.ednetze.de/cms/medienboard/html/EDN_31.12.2013.html

[13]

Netzgesellschaft mbH Chemnitz. Publikation: Stromverteilung In Kürze

[14]

Günther

Plasmaphysik, ca. 2010. Publikation: Stand der Fusionstechnik

http://www.muenchner-wissenschaftstage.de/2010/upload/download/Hasinger_Stand_der_Fusionstechnik.pdf

[15]

Bayerisches Staatsministerium. Plattform Energiedialog AG 2. Protokoll vom 18.12.2014 zu den Zwischenergebnissen: Beitrag der Speichertechnologien

[16]

WIKIPEDIA. Kernenergie nach Ländern

https://de.wikipedia.org/wiki/Kernenergie_nach_L%C3%A4ndern

[17]

AHK Deutsch-Baltische-Handelskammer. Publikation: EIGENVERSORGUNG MIT ERNEUERBAREN ENERGIEN IN DER INDUSTRIE IN LETTLAND

[18]

German Trade & Invest. Homepageinfo 09.05.2014: Finnland setzt auf Atomkraft, Windparks und Biomasse

http://www.gtai.de/GTAI/Navigation/DE/Trade/Maerkte/suche,t=finnland-setzt-auf-atomkraft-windparks-und-biomasse,did=1008722.html

[18]

Südkurier 05.08.2015: Barack Obama sagt Nein zu Kohle und Ja zu Atomkraft.

„Der Klimaschützer Obama weiß das – und hat deshalb erklärt, er halte Atomkraftwerke für sicher und sauber. Innerhalb der US-Regierung sieht man die Entscheidung von Bundeskanzlerin Angela Merkel, nach dem Unfall in Fukushima den Ausstieg Deutschlands aus der Nuklearenergie festzuschreiben, als Panikreaktion.“

http://www.suedkurier.de/nachrichten/politik/Barack-Obama-sagt-Nein-zu-Kohle-und-Ja-zu-Atomkraft;art410924,8054026

[19]

Frankfurter Allgemeine 23.04.2015: Ölkonferenz in Houston Siemens-Chef macht Witze über Energiewende

[20]

EIKE 10.06.2015: Energiewende schafft Jobs. Im Jobcenter

http://www.eike-klima-energie.eu/energie-anzeige/energiewende-schafft-jobs-im-jobcenter/

[21]

34. Dresdner Wasserbaukolloquium 2011 Frank Pöhler: Der Stellenwert der Wasserkraftnutzung in Bayern – Potentiale und Hemmnisse eines weiteren Ausbaus

[22]

Bundesverband Geothermie, Homepage-Info: Geothermie in Zahlen

[23]

Bayerische Staatsregierung. ENERGIE-ATLAS BAYERN

http://www.energieatlas.bayern.de/thema_biomasse/potenzial.html

[24]

NABU 2011. NABU Schleswig-Holstein 5. September 2011. Agrargasanlagen und Maisanbau. Eine kritische Umweltbilanz

und Wetter

und Wetter