Update 12.7.15

Mit Mail vom 12.7.15 wurden die Podiumsteilnehmern über diesen Faktencheck informiert. Gleichzeitig wurde ihnen von mir angeboten, falls sie sich dazu äußern wollten, wenn ggf. eine oder mehrere Äußerungen von mir – wenn auch ungewollt- falsch interpretiert worden sind, dies anzumerken und ihre Sicht der Dinge klarzulegen.

Soeben (21:09) erreicht mich von Herrn Fell diese Mail, mit der Bitte sie im Beitrag zu veröffentlichen, was ich hiermit umkommentiert tue:

fell@hans-josef-fell.de

An: Dipl. Ing. Michael Limburg

AW: Podiumsdiskussion am 22.6.15 bei der BPB Faktencheck Teil I

Sehr geehrter Herr Limburg

Bitte veröffentlichen zu diesen Stellungnahmen von Ihnen folgende kurze Stellungnahme:

Ich, Hans-Josef Fell erkläre, dass ich nicht antworten werde auf die Interpretationen von Herrn Limburg zu meinen Aussagen. Diese Nichtantwort ist nicht gleichzusetzen, mit einer Akzeptanz zu Herrn Limburgs Interpretationen meiner Äußerungen. Ich erkläre ausdrücklich, dass Herr Limburg bezüglich meiner Äußerungen mit Falschinterpretationen, Faktenverdrehungen und Aussagenverdrehungen arbeitet und gar noch den unseriösen Versuch unternimmt, eine Nichtantwort als Akzeptanz zu missinterpretierten.

Dies ist unseriös und deshalb werden diese Falschinterpretationen von mir pauschal zurückgewiesen. Ich sehe auch keinen Sinn in einer unendlichen unproduktiven Diskussion darüber, weil sie mir Zeit raubt, an einer Lösung des Menschheitsproblems Erderwärmung zu arbeiten.

Mit freundlichen Grüßen

Hans-Josef Fell

Faktencheck Teil 1

Die BPB hat diesen Mitschnitt hier vor einigen Tagen veröffentlicht. Auf Grund der Tatsache, das hier – wohl zum ersten Male- nicht nur Klimaalarmisten und Energiewendebefürworter eingeladen waren, sondern auch der als Klimarealist und entschiedener Gegner der Energiewende bekannte Autor dieser Zeilen, waren die ausgetauschten Argumente sehr kontrovers.

Zudem können in einer derartigen Diskussionsrunde Argumente zwar ausgetauscht werden, sie reduzieren sich aber für den uninformierten Zuhörer auf reine Behauptungen, da im Allgemeinen den meisten die Kompetenz fehlt, um die Richtigkeit der jeweiligen Behauptung überprüfen zu können. Das sei hier mit dem Faktencheck für die wichtigsten Argumenten nach geholt.

Zur Verständnis: Der BPB Mitschnitt selber enthält keine Zeitmarken. YouTube hingegen setzt diese Zeitmarken und erlaubt auch die automatisierte Erstellung von Untertiteln aus dem gesprochenen Wort. Die Umwandlung in Schriftdeutsch ist nicht gut, aber brauchbar, doch sie verlangt eine erhebliche Nachbearbeitung. Die hat EIKE vorgenommen. Obendrein wurden in der EIKE Youtube Version die freundlichen Begrüßungsworte des Gastgebers Herrn Kopp für diesen Faktencheck weggelassen, somit fängt jeder Teilmitschnitt mit 0:00 min an. Wichtig sind daher allein die Zeitmarken, dann kann der interessierte Leser schneller den Originalton abhören.

Audiomitschnitt Teil 1 (Länge 13,46 Min) der Podiumsdiskussion im Hause der BPB am 22.6.15 Quelle BPB Hier. Die (editiert) Untertitelfunktion kann eingeschaltet werden

Zum Klimawandel:

Die Moderatorin begann mit der Frage an den Autor:

(0:01:43) Herr Limburg: ist die Frage, ob es ein anthropogenen Einfluss auf das Klima gibt, also ob der Klimawandel denn vom Menschen gemacht wird im Prinzip nicht längst überholt?

Limburg

Meine Antwort darauf: (ab 0:01:55) zusammen gefasst: Nein, sie ist nicht überholt. In Bezug auf die veränderte Landnutzung, der Zuwachs von Städten und seiner Bevölkerung und der stark gestiegene Bevölkerung selber ist das lokale Klima natürlich anthropogen beeinflusst, aber ein Weltklima, dass zudem gar nicht real sondern nur in Modellen existiert, ist – zumal vom CO2- nicht beeinflusst. Das zeigen die Daten und deren Zeitreihen ganz deutlich. Und das geben die Experten auch zu. Sie sagen: Wir können die Wirkung des nur in unseren Modellen zeigen.“ Der Einfluss, insbesondere des anthropogenen CO2 ist nicht vorhanden und was doch viel interessanter ist, in der gesamten Vergangenheit die wir nun geologisch sehr gut kennen ist niemals ein Einfluss, ein treibender Einfluss, des CO2 auf die Temperatur der Luft in dieser Welt nach zuweisen. Umgekehrt schon.“

Fakt ist

John Mitchell dazu ehemals Chef des UK Met Office und Leitautor des IPCC

“It is only possible to attribute 20th Century warming to human interference using numerical models of the climate system.” [1]

Richtig ist auch, dass CO2 niemals in der Vergangenheit – und das auf jeder historischen Zeitskala – die Temperatur der Atmospäre diese Planeten bestimmt hat. Zwei Beispiele dafür zeigen die folgenden Abbildungen.

Abb 1 CO2 und Temperaturverlauf über viele Mio Jahre.

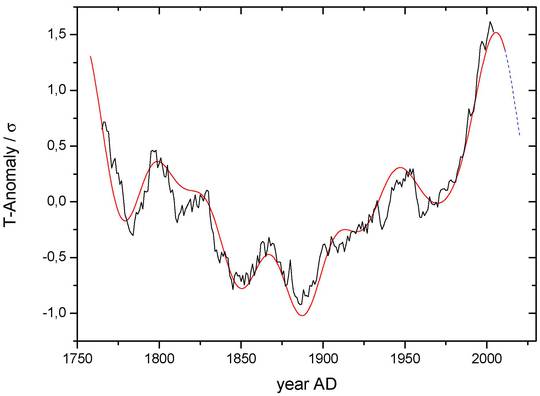

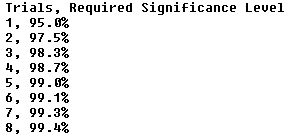

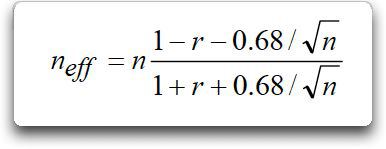

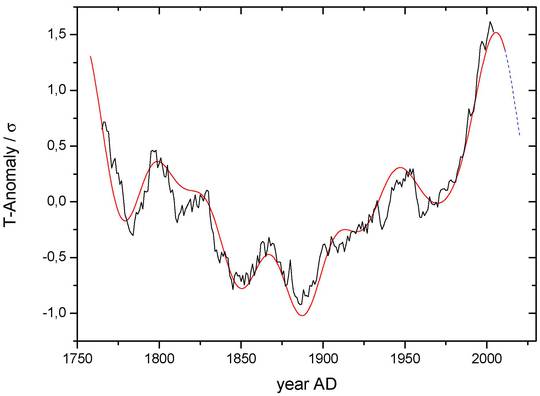

Abb 2 Temperaturverlauf (schwarz; 15 year running mean) von 6 historischen Temperaturstationen mit mindestens 250 Jahren Aufzeichnungsdauer, von deren Frequenz-Spektrum nur die zwei stärksten addiert wurden (rot). Die Übereinstimmung ist frappierend. Und diese entsprechen in ihrer Periode sehr genau dem bekannten solaren De Vries Zyklus mit rd. 210 Jahre und dem ozeanischen AMO/PDO Zyklus mit ca. 65 Jahren. Quelle[2] s.Fußnote Details hier

Besonders interessant an Abb2 sind die deutlich erkennbaren Fakten,

1. dass offenbar –zumindest bei den Messstationen- die Temperatur insgesamt fast 1:1 den beiden genannten Zyklen folgt .

2. Von chaotischen Verhalten in diesem Zeitraum nichts zu erkennen ist

3. Für CO2 kein Platz ist

4. Sollten die der Kurve unterlegten Prozesse weiterhin ihre Wirksamkeit behalten, wie es die gestrichelte Kurve anzeigt, wird die Mitteltemperatur wieder sinken.

Ein weiteres paper der Autoren (bis auf einen, alles EIKE),dass die Zusammenhänge mit den genannten Zyklen genauer untersucht ist derzeit im Peer Review Prozess verschiedener internationaler Fachzeitschriften

Moderatorin Frau Dr. Zink (0:04:01)

Kommen wir nachher noch ein bisschen spezifischer dazu, aber ich möchte gern erst mal den Herrn Fell fragen: Sie haben ja auch Physik studiert. Haben Sie denn Verständnis für so´ne Klimaskepsis?

H.J. Fell (0:04:09): Überhaupt nicht!

..Es ist so was von anti-wissenschaftlich ignorierend, dass das was die Physik seid die vielen Jahrzehnten als Erkenntnisse hat….. Nein, also ich bitt´Sie!

Herr Fell führt dann umfassend aus, dass das CO2 gewisse spektro-physikalische Eigenschaften hätte, die er als junger Student auch gemessen hätte, und die eindeutig zeigten, dass eingestrahlte Energie von der Sonne vom CO2 zurückgehalten würden und diese Energie könne sich nur in steigender Erwärmung äußern. Und stellte den Zuhörern diese seine Versuche als Beleg für die seiner Meinung nach unbestreitbare Erwärmungswirkung des CO2 dar. Dann beurteilte er meinen Zeitreihenvergleich als politisches Manöver.

Fakt ist:

Herr Fell übersieht bei seiner Gegenrede völlig, dass ich in meiner Argumentation die spektro-physikalischen Eigenschaften des CO2 weder benannt, noch angezweifelt habe. Hingegen habe ich mich auf den seit den Zeiten Galileo Galilei geltenden ehernen wissenschaftlichen Grundsätze gestützt, dass jede wissenschaftliche Hypothese

1. erst durch die Bestätigung ihrer Annahmen durch Beobachtungen und Messungen zur akzeptablen Theorie wird.

Und

2. durch richtiges Vorhersagen zukünftiger Werte

ihre Tauglichkeit erweist.

Warum diese elementaren Grundsätze bei der Klimawissenschaft nicht gelten sollen, erklärten weder Herr Fell, noch Frau Zink, noch die anderen Teilnehmer. Denn auch eine plausible Hypothese – wie es die Hypothese von der Treibhauswirkung des anthropogenen CO2 für viele ist- ersetzt nicht die Überprüfung im Experiment oder/und durch Beobachtung. Sie geben damit auch indirekt zu, dass die Klimawissenschaften eine galileische Überprüfung in der Realität nicht benötigten.

Zu 1. Und sie wissen auch nicht, dass es seit den ersten IPCC Berichten genau dieses Problem ist, welches die Forscher beschäftigt. Es hat sogar einen Namen: „Detection and attribution problem“ und ist seither trotz vielfältigster Anstrengungen außerhalb von Modellen[3] ungelöst.

Der wichtigste Beitrag dazu ist der Versuch die sog. Klimasensitivität (CS Climate Sensitivity) des CO2 zu bestimmen. Damit ist der nur theoretisch ableitbare Wert gemeint, um den sich die globale Mitteltemperatur erhöhen sollte, bei Verdopplung der CO2 Konzentration. Das IPCC geht im Mittel von 3,2 °C (3a) (bei einer Spanne von 4,5 K bis 1,5 K) aus, obwohl es im SPM des jüngsten Berichtes AR 5 – allerdings nur in einer Fußnote[4]- zugab, dass dieser Wert bisher nicht bestimmbar sei. Der Wert 3,2 °C entsteht, wenn man den rechnerischen direkten Wert von ca. 1,2 °C über die sog. Wasserdampfverstärkung (mehr Wärme, mehr Verdunstung, mehr Wasserdampf, mehr Wärme) mit 3 x nimmt. Viele andere Autoren haben

erstens die Wasserdampfverstärkung nicht finden können, sie fanden stattdessen eine Dämpfung, (Mehr Wärme, mehr Wasserdampf, mehr Wolken, mehr Abkühlung) und kommen

zweitens zu wesentlich niedrigeren Werten des CS Wertes bis hinunter auf nur 0,5 °C[5].

Damit treffen beide Grundsätze für die Hypothese vom anthropogenen Treibhauseffekt nicht zu. Weder lässt sich deren Annahmen im Experiment bestätigen

Zellner Zitat

• Reinhard Zellner [6] (Typisch ist der Einwand, dass der Treibhauseffekt nicht nachzuweisen sei): Das stimmt, es gibt kein Laborexperiment, das die Erwärmung durch Infrarotabsorption des CO2 direkt nachweist. Das System Atmosphäre kann aufgrund seines Temperatur- und Druckgradienten in einem stationären Experiment gar nicht reproduziert werden. Wir sind also auf ein klimawissenschaftliches Modell angewiesen,

…noch in der Realität durch den aktuelle oder historische Beobachtungen.

Abgesehen von wenigen, überdies für Klimazeitdistanzen, kurzen Zeitspannen, in denen der Trend der „Welttemperatur „ eng und positiv korreliert mit dem CO2 Anstieg verläuft (Rahmstorf [7]: mehr CO2 = mehr Temperatur) ist immer wieder auch die gegenteilige Entwicklung erkennbar. Also mehr CO2 und negativer Temperaturtrend. Und dies ist auf allen geologischen Zeitskalen zu beobachten. (Siehe z.B. Abb. 1)

Zudem ist, was auch Herr Fell (und später auch Frau Dehmer wissen müsste) eine Korrelation kein Ersatz für eine nachweisbare Ursache-Wirkungsbeziehung)

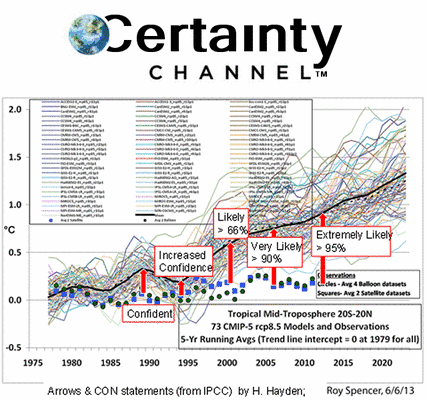

Besonders deutlich aber zeigt sich, dass auch die Modelle schwer daneben liegen. (Abb. 3) wenn man bereits vergangene Zeitspannen mit den Modellprognosen vergleicht. (Abb 1)

Abb. 3 Vergleich „zukünftige“ Verläufe (ab 1983) des globalen Temperaturtrends von 90 Modellen und zwei Messungen Grün: Hadcrut Daten, Blau: Satelliten Daten UAH; schwarz Mittlerer Trend aller Modelle: Quelle hier

Auch die Behauptung von Herrn Fell – er hätte „die Versuche gemacht wie Kohlendioxid die Strahlung beeinflusst, wie das Kohlendioxid die umgewandelte Infrarotstrahlung von der Sonne aufnimmt. Sind klare Versuche gewesen, nicht irgendwie Trial and Error sondern Messungen“, um damit dem Publikum zu suggerieren, damit sei der anthropogene Treibhauseffekt bewiesen, kann so nicht stehen bleiben. Es klingt zwar plausibel, aber das reicht in den Naturwissenschaften bei weitem nicht.

Auf meine Nachfrage per Email an Herrn Fell vom 23.6.15

…bitte ich Sie daher mir Details zum Experiment mitzuteilen. Besonders interessant sind für mich dabei die Klärung der Fragen

1. Wie war der experimentelle Aufbau?

2. Wie haben Sie gemessen?

3. Was haben Sie gemessen?

4. Wie groß war die Unsicherheit bei Ihrer Messung?

schrieb mir Herr Fell am 24.6.15

Ich sagte, dass ich das Grundlagenexperiment wie jeder andere Physikstudent auch machte. Damit messen die Physikstudenten die Anregungswellenlängenlängen und damit die Energieaufnahme von Molekülen, wie CO2.

Nun, derartige Eigenschaften hatte auch niemand bezweifelt. Und wie schon erwähnt, die spektro-physikalischen Eigenschaften des Spurengases CO2 (mit nur 0,04 Vol % in der Atmosphäre vorhanden) wie aller anderen Bestandteile der Luft sind seit Jahrzehnten gut bekannt, aber bieten keinerlei Ersatz für einen Beweis des THE.

Moderatorin: (0:05:41)

Hmm; Frau Dehmer wie schätzen Sie denn diese kritischen Stimmen ein?

Frau Dehmer 0:05:46.

Science-fiction

(0:05:48)

Hm; die Messreihen, die vorhanden sind, sind ja mehr als hundert Jahre alt. (Anmlerung des Autors Siehe Abb. 1) Und wenn sie sich die Messzahlen, und das ist nur das Gemessene anschauen, sowohl bei den Ozeantemperaturen als auch bei den Luft- Temperaturen dann haben die eben einen Trend nach oben. Und man kann auch zurück verfolgen, wann der begonnen hat. Hm. ich finde diese Diskussion völlig sinnlos

Fakt ist:

Auf diesem Niveau zu argumentieren, wie es hier Frau Dehmer macht, ist natürlich völlig sinnlos. Aus der unbestrittenen geringen Erwärmung – nach dem Ende der kleinen Eiszeit etwa ab 1850 (da musste es wärmer werden, sonst bestünde die Eiszeit ja immer noch) – und der gleichzeitigen – aber erst seit Mitte der fünfziger Jahre genau genug bekannten Konzentrationszunahme des CO2 in der Luft, eine bestätigte Abhängigkeit zu konstruieren, ist schon science fiction. Allerdings ganz ohne science. [8]

Mit gleicher Berechtigung könnte Frau Dehmer folgern, weil die Zahl der Störche in Deutschland abnimmt, gibt es weniger Babys. Beides unbestreitbare Tatsachen, beide Verläufe eng korreliert, doch sollte heutzutage -jedenfalls unter Erwachsenen- keiner glauben, dass die Störche die Babys bringen.

Ich frage mich außerdem immer wieder, woher die Protagonisten des anthropogenen Global Warming das Recht ableiten, dass das Klima konstant zu sein hat. Das war es bisher niemals und wird es auch in Zukunft nicht sein.

Frau Dr. Zink (0:06:51)

Daraufhin fühlte sich auch die Moderatorin Frau Dr. Zink veranlasst Ihre Sicht der Dinge darzustellen. Sie verwies am Anfang auf ihre Mitarbeit bei Wissenschaftssendungen erst von Joachim Bublath und dann von Harald Lesch und Dirk Steffens (Terra X). Dann erläuterte sie, dass sie und bezog andere Kollegen ein, spätestens seit 1995 im Grunde aber schon nach Rio (1992) aufgehört hatten kritische Stimmen zur Rolle des CO2 zu journalistisch zu überprüfen. Und schloss mit dem Beispiel ….im Kriminalfall würde man vielleicht sagen, die Faktenlage ist erdrückend und deswegen ist bei den Wissenschaftsjournalisten dieses gar nicht mehr in Diskussion; muss ich sagen.

Fakt ist:

Dieses Statement ist insofern korrekt, als dass die Zustimmung (ja Panikmache) zur THE Hypothese, tagtäglich in allen Medien- von wenigen rühmlichen Ausnahme abgesehen-, zu sehen, zu lesen und zu hören ist.

Diese Meinung, und um nichts anderes handelt es sich, beweist für die Existenz des THE natürlich gar nichts. Sie beweist aber etwas ganz anderes, nämlich, dass die allermeisten Journalisten es vorziehen im Mainstream mit zu schwimmen. Obwohl es gerade die vordringliche Aufgabe von Journalisten wäre, besonders misstrauisch bei Behauptungen von dieser Tragweite zu sein und ständig der uralten Frage nachgehen müssten – Cui Bono? Tun sie aber nicht, obwohl das investigative Hinterfragen für Wissenschaftsjournalisten umso mehr gelten müsste.

Es ist nämlich in den Naturwissenschaften überhaupt kein Gütesiegel, anders als in der Politik, wenn alle oder eine große Mehrheit einer Meinung sind. Die Beispiele bei denen das falsch war, sind Legion. Denn im Gegenteil, besonders dann ist höchstes Misstrauen angebracht, weil dann so gut wie immer die Wissenschaft unter die Räder kommt. Und eine – noch dazu promovierte- Physikerin täte gut daran, diesem Grundsatz zu folgen. Gesundes Misstrauen tut daher not, ein Misstrauen, wie es die investigative Journalistin Donna Laframboise[9] antrieb, mit der Folge, dass sie die Machenschaften großer Umwelt-NGO´s wie z.B. WWF und Greenpeace, aber auch anderer, bei der verdeckten Übernahme des IPCC aufdeckte. Eine Übernahme, die denen nicht nur großen Einfluss brachten, sondern auch das Agenda-Setting erlaubt. Die Folgen davon erleben wir täglich.

Abgesehen von dieser Verhaltensfrage enthält die Frau Zinks „Beweisführung“ eine Behauptung, die nicht unwidersprochen bleiben kann. Nämlich der „Beweis“ wie im „Kriminalfall“, den auch Hans v Storch unlängst verwendete, als beide behaupteten, dass die Beweislage erdrückend sei. Dabei wird übersehen, oder verschwiegen, dass schon im Gründungsauftag des IPCC steht, man solle Beweise dafür finden, dass der Klimawandel gefährlich und dass der Mensch dafür verantwortlich sei[10].

Klar nach der Drehbuchanweisung des Club of Rome 1972 (Quelle King & Schneider, 1991):

„Auf der Suche nach einem neuen Feind, der uns vereint, kamen wir auf die Idee, dass sich dazu die Umweltverschmutzung, die Gefahr globaler Erwärmung, Wasserknappheit, Hunger und dergleichen gut eignen würden…. Alle diese Gefahren werden durch menschliches Eingreifen verursacht…Der wirkliche Feind wäre dann die Menschheit selbst….“

Folgerichtig werden sowohl vom IPCC als auch vielen Vertretern der Wissenschaft die weiteren Akteure in diesem „Kriminalfall“ bewusst außen vorgelassen. Wie z.B. der alles überragende und vielfältige Einfluss der Sonne. Damit wird durchgehend eine voreingenommene „Wissenschaft“ gefordert und auch betrieben.

Ich will mich aber hier nur auf den von mir angeführten „Beweis“ über die Wirkung des CO2 auf die Temperatur über Klima-Modelle fokussieren, den Hans v. Storch dem erstaunten Publikum präsentierte[11].

Fakt ist:

Limburg 0:08:20:

Sie sagen wir haben Modelle: Neulich Herr von Storch hat Modelle gezeigt, hat Bilder gezeigt wie die Temperatur nach oben geht in ihren Modellen (Anmerkung Autor Siehe Abb. 4) mit der Aussage wir können das nicht in der Natur beweisen, dafür ist das System zu komplex, zu großartig, zu umfangreich.

Niemand bestreitet ja die spektralen Eigenschaften des CO2.

Natürlich nicht!

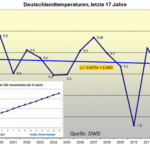

Aber sie können sie nicht in der in der Darstellung der Messdaten sehen und deswegen baut man eben diese komplexen, hochkomplexen Klimamodelle und dann sagt man: „guckt mal hier“ das sind so vier Graphen…..wie die Temperatur nach oben steigt, je nachdem wie das CO2 sich entwickelt und wenn man dann, das sind die Modellaussagen, wenn man dann das CO2 weglässt dann ist dieser Temperaturanstieg flach. Wie er übrigens seit über 18 Jahren inzwischen auch ist (Anmerkung Autor Siehe Abb. 4)

Abb 4: Satellitenmessung der globalen Mitteltemperatur – und nur die sind eigentlich für globale Klimazwecke geeignet- der letzen > 18 Jahre. Man sieht trotz stark steigenden CO2 um ca. 2 ppm/Jahr ist der Trend genau Null

So, aber das ist ein Zirkelschluss! Wenn ich ein Modell baue, wo das CO2 die Temperatur treibt, was es, wie gesagt, in der Vergangenheit noch nie gemacht hat dann steigt die Temperatur. Wenn ich dann in diesem Modell dass CO2 weglasse.. wie soll da die Temperatur steigen? Also das als Beweis anzunehmen -und nur das existiert- das müssen Sie halt schlicht zur Kenntnis nehmen- das sind die Fakten

Abb. 5: Modellberechnungen für verschiedene Kontinente des jeweiligen Verlaufs der Mitteltemperatur mit und ohne die Annahme der Wirkung der Treibhausgase (gemeint war immer als stärkster Treiber CO2 (Quelle: IPCC AR4 4)

Dann murmelte Frau Zink etwas von (0:09:29).

Na ja, es gibt ja sehr viele Beweise, da muss man sich nur viele Baumrinden anschauen,

… ging aber nicht weiter darauf ein.

Fakt ist:

Man muss vermuten, dass sie berüchtigte Hockeyschlägerkurve des Michael Mann meinte, von dem sein Freund Phil Jones später mailte, dass er „Mikes Nature trick“ erfolgreich angewendet hätte „to hide the decline“. Gemeint war, dass dieser „decline“ seit den 1960er Jahren in der Proxykurve der Mannschen Baumringdaten zu sehen war, aber Michael Mann sie schlicht abgeschnitten hatte und sie durch ihm genehmere Thermometerdaten, die sich nicht absenkten, sondern im Gegenteil nach oben stiegen, ersetzt hatte. Ein bis heute ungeahndeter Betrug. (Einige Details dazu hier)

Etwas später meinte die Moderatorin wieder gegen halten zu müssen (0:10:45)

Dann muss ich gleich mal ein bisschen noch dagegen schießen. Auch ich mache meine Hausaufgaben als Wissenschaftsjournalistin. Es gibt Meta Studien. Das sind ja Studien über alle wissenschaftlichen Artikel….

Und zitierte die Cook Studie, wonach 12.000 klimawissenschaftliche Studien (peer reviewed) von Cook et al daraufhin untersucht worden sein sollen, wie viel davon die anthropogen induzierte Erwärmung bejahten. Und das seien bis auf 80 Artikel alle gewesen.

Fakt ist,

dass nach der neuesten Überprüfung der Methodik dieser Studie (Legates et al[12]) die Verfasser zu dem Schluss gekommen seien, dass Cooks Behauptung nur 0,3 % der Studien folgten (Details dazu hier) Der Rest stimmt zwar einer Erwärmung zu, die aber eben nicht zwangsläufig anthropogen erzeugt.

Und, Fakt ist auch, das John Cook kein Klimawissenschaftler sondern ein Blogger und Psychologe ist. Was Frau Zink verneinte.

Jedoch schreibt derselbe John Cook, welcher die Mainstream Website „SkepticalScience“ betreibt in seinem Blog,

about..

(John Cook) is currently completing a PhD in cognitive psychology, researching how people think about climate change. He is also developing a MOOC (Massive Online Open Course),Making Sense of Climate Science Denial, to be released in April 2015.

Nur in einer Hinsicht behielt Frau Dr. Zink recht: Cook ist kein Australier, sondern US-Amerikaner. Ich hatte ihn in der Eile in Bezug auf seine Landsmannschaft mit seinem Bruder im Geiste Lewandowski verwechselt. Der ist Australier.

Aber obwohl diese Cook Studie, wissenschaftlich, den Klimawandel und seine vermuteten Ursachen betreffend, völlig irrelevant ist, wird sie gerne von allen – auch und besonders häufig von Umwelt- und/oder Wissenschaftsjournalisten geglaubt. Die Betonung liegt dabei auf geglaubt.

Es scheint ja so gut zu passen. Mit dem Strom schwimmen ist eben leichter als gegen den Strom, oder wie es Einstein viel besser formulierte, als man ihm vorhielt, dass hundert Wissenschaftler seine Relativitätstheorie für falsch hielten, er sagte kühl: „Wenn die recht hätten genügte einer.“

Wird fortgesetzt

[1] ‘CLIMATE CHANGE Response to Carteret al.’, World Economics, 8 (1): 221228. –

[2] Multi-periodic climate dynamics: spectral analysis of long-term instrumental and proxy temperature records H.-J. Ludecke ¨ 1,*, A. Hempelmann2 , and C. O. Weiss3,*

[3] Man sehe z.B. den SPM Seite 18 figure SPM.6. In der Bildunterschrift steht u.a „:::Comparison of observed and simulated climate change based on three large-scale indicators in the atmosphere, the cryosphere and the ocean: change in continental land surface air temperatures (yellow panels), Hervorhebung von mir.

[3a] IPCC (2013): Climate Change 2013, Working Group I: The Science of Climate Change, Box 12.2

[4] „Die Fußnote lautet: No best estimate for equilibrium climate sensitivity can now be given because of a lack of agreement on values across assessed lines of evidence and studies. Quelle SPM AR5 final, S 16 hier

[5] Quellen: [6] H. Harde, Open Journal of Atmospheric and Climate Change (2014), http://tinyurl.com/p9ac6xg

[7] IPCC-Berichte (scientific basis), www.ipcc.ch

[6] Prof. Reinhard Zellner in Nachrichten aus der Chemie, S 213 Mai 2014 Mitglied u.a Enquetekommissionen – „Schutz der Erdatmosphäre“ und „Schutz des Menschen in der Umwelt“

[7] Das genaue Zitat geht so: Stefan Rahmstorf am 3.2.2007 (Die Welt): Wir Klimaforscher können nur nach dem Wenn-dann-Prinzip sagen: Wenn so und so viel CO2 ausgestoßen wird, dann wird das Klima sich so und so stark erwärmen.“

[8] Siehe auch ergänzend hierzu diesen Beitrag von Limburg & Willis Eschenbach

[9] Details zu den unglaublichen Fakten über das IPCC finden Sie hier

[10] Auf der IPCC Website unter Mandate findet man .”… Its role is to assess on a comprehensive, objective, open and transparent basis the latest scientific, technical and socio-economic literature produced worldwide relevant to the understanding of the risk of human-induced climate change::”

[11] Den Erlebnisbericht dazu finden Sie hier

[12] Legates et al ‚Climate Consensus and ‘Misinformation’: a Rejoinder to ‘Agnotology, Scientific Consensus, and the Teaching and Learning of Climate Change’ in Science and Education