Im Teil I des Faktenchecks habe ich mich ausführlich mit den kontroversen Aussagen der Teilnehmer der ersten 13:46 Minuten beschäftigt. Um jedermann den Vergleich zwischen den gesagten Statements und Bestätigung oder Widerlegung der Behauptungen auf einfachste Weise sowie objektiv und fair zu ermöglichen, hat EIKE sich die Mühe gemacht und den gesamten gesprochenen Text mit Untertiteln samt Zeitmarken zum schnellen Auffinden (und damit zu überprüfen) der in Frage kommenden Stelle zu hinterlegen. Diese Prinzip wird hier im zweiten wie auch im dritten Teil fortgesetzt. Der Fairness halber wird allen Teilnehmern dazu noch die Möglichkeit angeboten, ihre Sicht der Dinge hier darzustellen.

Doch anstatt sich über diese Möglichkeit zu freuen, erlaubte sich das ehemalige grüne MdB Herr H.J. Fell, (in einer Mail vom 12.7.15) mir „Falschinterpretationen, Faktenverdrehungen und Aussagenverdrehungen „ vorwerfen zu müssen. Und dazu noch sein Schweigen zu diesen vermeintlichen Missetaten, mir als „unseriösen Versuch“ zu unterstellen ihn ..“als Akzeptanz zu missinterpretier(t)en“.

Tonmitschnitt ab Minute 13:46 der Podiumsdiskussion am 22.6.15 in den Räumen der Bundeszentrale für politische Bildung. Der Tonmitschnitt kann zum einfacheren Vergleich der unten zitierten Aussagen deutsch untertitelt werden.

Dazu kann ich nur feststellen: Solch ein billiges Verhalten mit pauschaler Verleugnung von Fakten, die einem nicht in den Kram passen, mag ja in grünen Politikseminaren als semantischer Trick gelehrt werden, um unliebsame Fakten zumindest rhetorisch aus der Welt zu schaffen, verfängt aber keineswegs bei den Lesern dieses Blogs und sicher auch nicht bei all denen, die sich selber ein Urteil bilden wollen und dabei auf objektive Berichterstattung angewiesen sind. Und für die ist dieser Faktencheck gemacht.

Der hier gezeigte Mitschnitt fängt wieder bei 0:00 min, schließt aber nahtlos an das Ende des hier gezeigten Teilmitschnittes an. Im Folgenden werden die anschließenden 21:27 Minuten behandelt.

(00:00 Min. bis 02:36) Wieviel „Erneuerbare“ sind denkbar?

Es geht um die Frage, wie viel „Erneuerbare“ sich jeder der Anwesenden vorstellen kann. Herr Brabeck kann sich irgendwann mal 90 bis 95 % „Erneuerbare“ vorstellen. Herr Fell erwartet irgendwann auch 100 % und verbindet diese Meinung mit einer Attacke auf die Versorger die s.M.n. vor 10 Jahren „falsch“ in Kohlekraftwerke investiert hätten. Zur Unterstützung seiner Ansicht nennt er solch bedeutende Länder wie Schweden, Dänemark und Costa Rica, die die Umstellung ganz oder tlw. schon geschafft hätten. Und erklärt die unbestreitbaren Umsatz und Ertragsprobleme der Versorger mit deren „Versäumnissen“ in der Vergangenheit. Es fällt jedoch kein Wort über die üppige, weit über dem Marktpreis liegende Honorierung des EE Angebots, samt Vorrangeinspeisezwang, die sein EEG erst möglich machte hat. Und er scheut sich anschließend auch nicht, mit diesem halben Argument von Deutschland auf die ganze Welt zu schließen.

Hier gilt: Es ist Meinung und daher zulässig!

(0:02:36) Moderatorin: Frau Dehmer glauben Sie, das hundert Prozent Erneuerbare Energien überhaupt politisch umsetzbar wäre?

0:02:43 Frau Dehmer

Frau Dehmer bejaht diese Frage, auch mit dem Verweis auf den Elmauer G7 Gipfel Dekarbonisierungsbeschluss bis zum Ende des Jahrhunderts. Und argumentiert weiter:..

…. Aber weltweit ist es mit Sicherheit so, dass der Trend in die Richtung geht; die Investitionen in Erneuerbare sind seit einigen Jahren jedes Jahr höher als In fossile Energien; … Trotzdem sind Erneuerbare da in der Regel vorn, weil sie einfach billiger sind als große Kraftwerken, die eine große Infrastruktur brauchen.

Kommentar:

Neben der evtl. punktuell richtigen Beobachtung, dass in Norwegen alle 10 m ein „Tesla“ herumsteht, behauptet Frau Dehmer dass

1. … weltweit …. der Trend in die Richtung geht; die Investitionen in Erneuerbare sind seit einigen Jahren jedes Jahr höher als In fossile Energien;

und

2. Trotzdem sind Erneuerbare da in der Regel vorn, weil sie einfach billiger sind als große Kraftwerken, die eine große Infrastruktur brauchen.

Fakt ist:

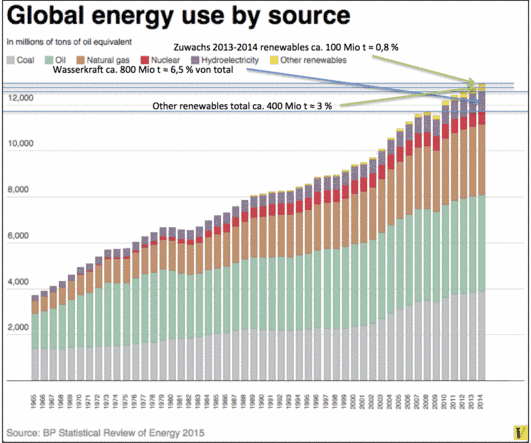

Zu 1: Die Investitionen in „Erneuerbare“ sind weltweit unzweifelhaft hoch. Der größte Anteil entfällt dabei auf die Wasserkraft (s. Abb.3 und Tabelle 1). Die Gründe für die Investitionen in andere „Erneuerbare“ liegen in der massiven Förderung durch staatliche Subventionen[1] und dem Preisverfall bei den Solarpanelen.

Für 2014 beziffert die Internationale Energieagentur (IEA), mit Sitz in Paris, die Gesamtinvestition auf 270 Mrd US $. Sie lagen damit so hoch wie im Jahr 2013. Die Investitionen in konventionelle Energieträger (vermutlich fossile wie Kern- Energie) liegen jedoch immer noch deutlich höher auch wenn die IEA in ihrem 2015 Report [2] schreibt:

„Renewables accounted for nearly half of all new power generation capacity in 2014, led by growth in China, the United States, Japan and Germany, with investment remaining strong (at $270 billion) and costs continuing to fall“.

| Elektritzätsproduktion weltweit in TWh |

2013 |

2014 |

Zuwachs 2014-2013 |

Quelle |

| Gesamt |

23.200 |

23.800 |

600 |

Enerdata Yearbook 2015 |

| Davon Wind + Solar in % v. Gesamt |

3,6 |

4% |

0,4 |

REN 21 |

| Davon Hydro in % v. Gesamt |

18,7 |

18,9 |

0,2 |

Enerdata Yearbook 2015 |

| Installierte Kapazität |

|

|

|

|

| „Erneuerbare“ o. Hydro in GW |

560 |

657 |

97 |

REN21 |

| Hydro in GW |

1.578 |

1.712 |

134 |

REN21 |

Tabelle 1: Vergleich der Elektrizitätsproduktion und inst. Kapazität weltweit mit Anteil von Wind + Solar und Hydro als Hauptquellen „erneuerbarer“ Energien. Trotz massiver Förderung in über 160 Ländern[3] (davon mit Einspeisevorrang 108) ist die installierte Kapazität bei Wind und Sonne immer noch ziemlich klein. Berücksichtigt man dann noch den äußerst geringen Nutzungsgrad der installierten Wind- und Solarkapazitäten, dann zeigt sich, dass hier mit Kanonen auf Spatzen geschossen wird.

Jedoch wurden gleichzeitig– auf Grund des Preisverfalls bei Öl- und Gas- die Investitionen in diese beiden Bereiche zurückgefahren. Während die Investitionen in Kohle boomen. So werden derzeit weltweit 2100 Kohlekraftwerke geplant. Der grüne Sierra Club – Mutter unsers NABU – hofft jedoch, dass davon nur etwa ein Drittel wohl realisiert werden:[4]

Das mag zutreffen oder nicht, jedenfalls ist Kohle auf dem Vormarsch, zum Entsetzen aller Klimaschützer.

Viele Regierungen großer Länder (China, Indien) verkündeten dennoch in ihren vorbereitenden Absichts-Erklärungen zur kommenden UN Klimakonferenz CP21 in Paris, ihre Subventionspolitik zugunsten der „Erneuerbaren“ auszuweiten oder stabil zu halten. Wie weit das Lippenbekenntnisse sind oder praktische Politik, wird sich zeigen. Jeder Regierungswechsel kann demnach das Aus für diese Politik bedeuten, wie es Spanien, Tschechien und jetzt Großbritannien und Australien (Details dazu hier und hier) bereits vorgemacht haben.

Zu 2. Frau Dehmer glaubt und behauptet, dass „Erneuerbare“ ..“einfach billiger“ sind.

Fakt ist

jedoch, dass von „billiger“ keine Rede sein kann. Ebenso wenig, wie von weniger – oder kleinerer- Infrastruktur, als große Kraftwerke. Das Gegenteil ist richtig. Zum Thema „billiger“ stellt die IEA etwas verschwiemelt fest, Renewable technologies are becoming increasingly cost competitive in a number of countries and circumstances, but public support schemes are still required to support deployment in many others. (Chapter 1; p. 21 hier) (Siehe auch Fußnote 1).

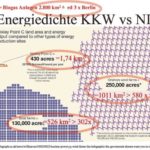

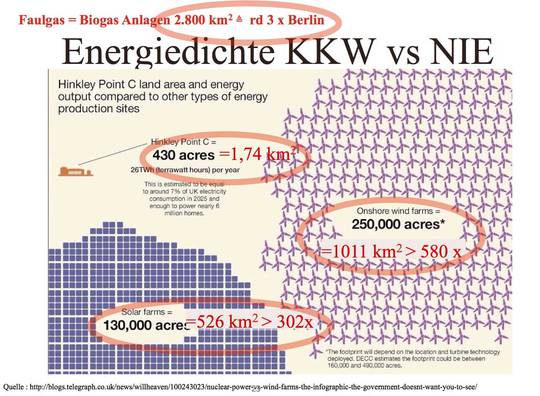

Der Grund dafür, dass sie deutlich teurer sind, sein müssen, liegt hauptsächlich darin, dass die Energiedichte der „Erneuerbaren verglichen mit konventionellen Brennstoffen, sehr viel geringer ist. Der Aufwand diese Energie zu verdichten, lässt weitere Preissenkungen – nachdem der Economy of Scale Effekt- z.B. bei Solarpanelen, ausgeschöpft ist- nicht zu. Auch ist und bleibt deswegen der Flächenbedarf riesig, was insbesondere die Grünen veranlassen müsste, wenn sie es mit dem Umweltschutz wirklich ernst meinten, vor der Förderung der „Erneuerbaren“ Abstand zu nehmen. Auch ließen alle Podiumsteilnehmer das Thema „fehlende Speicher“ außen vor,

Abbildung 1: Vergleich des Flächenbedarfes eines (hier) Kernkraftwerkes in UK (es könnte aber ebenso gut ein rein fossil betriebenes Kraftwerke sein, samt zugehöriger Infrastruktur wie Umspannstationen und Netzanbindung) gegenüber verschiedenen „NIE“ –Nachhaltig instabile Energie-Kraftwerke, wie Wind- Solar und Biomasse, bezogen auf die rechnerisch gleiche Energiemenge.

..obwohl sie aus dem Publikum per Zwischenruf mehrfach darauf hingewiesen wurden. Rechnet man die erforderlichen Speicher dazu, werden sie gänzlich unbezahlbar. (wird hier etwas später beleuchtet)

Hier bei EIKE haben wir die verschiedensten realisierten Investitionen in Solar- oder Windparks etc. untersucht. Ergebnis: Die Investitionskosten pro erzeugter kWh liegen 6 (Offshore Wind, Ostsee) bis 17 x (Solarpark) höher als die für konventionelle Kraftwerke gleicher Energieabgabekapazität (Siehe Abb 2). Und die fehlenden Brennstoffkosten werden bei weitem durch die hohen Wartungs- und Reparatur wie auch Amortisationskosten übertroffen.

Abbildung 2: Vergleich der Investitionskosten und des Flächenbedarfes eines älteren Kohle-Kraftwerke in Wilhelmshaven, gegenüber dem größten und zweitgrößten Solarkraftwerk in Deutschland, bezogen auf die rechnerisch gleiche Energiemenge.

0:04:06. Herr Brabeck

nimmt alles gelassen und meint, dass die Verbraucher 10 Mrd € an EEG Umlage für die PV pro Jahr zahlen und dass in Kürze ein „Game Changer“ im Elektroenergiemarkt zu erwarten sei. Weil, so seine Begründung, die Batteriepreise fallen. Deswegen erwartet RWE massenhafte Installationen von Solardächern mit Batteriespeichern im Keller.

Fakt ist (mit Korrektur vom 28.7.15):

Die EEG Umlage kostete die Verbraucher bereits im Jahr 2013 rd. 20 Mrd €. Mit stark steigender Tendenz. Also das Doppelte. Allein 10 Mrd € wurden für die PV aufgebracht. Da hat Herr Brabeck recht. Nur hat uns niemadn um Erlaubnsi gefragt, ob wir der Welt die PV Technik „schenken“ wollten.

Die Betreiber von NIE Anlagen kassierten ihrerseits von den Netzbetreibern für den gelieferten Strom rd. 23 Mrd, während dieser Strom an der Börse hingegen nur knapp 3 Mrd € wert war. Die Differenz trug der Verbraucher.

Fakt ist..

..auch, dass die Batteriepreise nicht mehr wesentlich fallen können, weil sowohl die Elektrochemie als auch die Leistungs- und Lebensdaueranforderungen an brauchbare Batteriespeicher aus naturgesetzlichen Gründen ganz enge Grenzen setzen. Die politisch gesetzte Zielgröße von 100 EUR/kWh Anschaffungspreis wird kaum zu unterschreiten sein.

Die elektrochemische Spannungsreihe ist durch die Thermodynamik unveränderlich und auf 6 Volt Spannungsdifferenz (Lithium/Fluor) begrenzt. Batterien mit langzeitstabilen Elektrolyt- und Elektrodenkombination werden nur schwer über die heutigen 4,2 Volt Spannung von Lithium-Polymer-Akkus hinauskommen, was die Leistungsabgabe von der Spannungsseite her arg begrenzt. „5-Volt-Systeme“ sind noch in weiter Ferne, eine merkliche Verbesserung der Energiedichten von aktuell rund 0,1 – 0,2 kWh/kg nicht absehbar.

Zusätzlich unterliegen sie einer kalendarischen wie zyklischen Alterung, die ihre Nutzungsdauer massiv begrenzt. Wer heute bspw. Lebensdauern von 30 Jahren und 30.000 Lade und Entladezyklen mit brauchbarem Output verspricht, wie man es immer mal wieder hört oder liest, belügt seine Kundschaft.

Mehr als 1000 Lade- und Entladezyklen, bei gleichzeitiger rigoroser Begrenzung der Lade und Entladeströme auf rd. 1/3 des Nennstromes sind lt. Prof. Endres [5] für einen Akku kaum machbar, und die in der Presse zu lesenden 10.000 – 30.000 Zyklen werden nur unter definierten Laborbedingungen erreicht. Evtl. können irgendwann mal Preise für Akkus von 100 EUR/ kWh Kapazität angeboten werden. Aktuelle LiPo-Akkus liegen bei Anschaffungskosten um 500 EUR/kWh, Bleiakkus um 200 EUR/kWh.

Da kann sich jeder leicht ausrechnen wie teuer seine Batterie im Keller wird, wenn er/sie nur die sonnenarme Jahreszeit überbrücken möchte. Wenn man zur Maximierung der Lebensdauer immer nur 30% der maximalen Kapazität nutzt, resultiert eine Verdreifachung der notwendigen Batteriekapazität: Wer 1 kWh Strom speichern muss, muss demnach 3 kWh kaufen. (Weitere Details zu diesem Thema hier)

00:06:55. Limburg

Ich berichtete dann über die aktuelle BP-Studie, die vor kurzem vorgestellt wurde, Danach steigen die Investitionen in Kohle fünf mal schneller als die in Erneuerbare und immer noch doppelt so schnell wie in Öl! Indien hat gerade festgestellt, dass sie bis zum Jahr 2020 ihren Kohleverbrauch verdoppeln werden. Auch China eröffnet jede zweite Woche ein neues Kohlekraftwerk und hat sich ausbedungen und alle haben gejubelt Sie wahrscheinlich inklusive, dass sie bis 2030ihren CO2-Ausstoß massiv erhöhen.

Fakt ist:

Indien erhöht massiv Kohleförderung und Verbrauch, während China seinen Kohleverbrauch zumindest nicht massiv weiter steigert (zusätzlich 22 GW Kapazität Kohle vs 18 GW Wind wurden in 2014 installiert), da hat Herr Fell zumindest dem Trend nach recht, das China seinen (langsamer wg. Verlangsamung des Wachstums) ansteigenden Energiebedarf durch andere Quellen, insbesondere Wasserkraft, zu decken sucht.

Zitat:

IEEFA estimates that China installed 22 GW of hydro, 18 GW of wind, 13 GW of solar, 5-7 GW of nuclear and 4-6 GW of gas-fired electricity capacity in 2014 alone. Combined with another 22 GW of net new coal-fired capacity, China’s total electricity capacity installs are forecast at 90 GW in 2014 (over 6 percent yoy total capacity growth). Siehe auch Fußnote 6 für weitere Details.

Jedoch darf nicht vergessen werden, dass alle Energiequellen, bis auf Wind + Solar grundlastfähig sind, und daher ihre Einspeisung ein Vielfaches von Wind + Solar beträgt, als es der Vergleich allein der Nennleistungen suggeriert.

00:08:19: Herr Fell

Zunächst mal Herr Limburg: Es ist ja ihre gute Größe die Statistiken so zu nehmen, wie Sie sie brauchen.. Erneuerbare Energien passen nicht in eine Statistik mit den Primärenergieverbrauch! Jede Kilowattstunde, jede Kilowattstunde Wind- oder Solarstrom ersetzt 3 Kilowattstunden konventionellen Kohle- oder Erdgas-Strom. Schlicht weil die Wind- und die Solaranlagen keine Abwärme haben die niemand braucht.

Kommentar Limburg:

Zur Abwärme 1:

Es ist korrekt, dass bei der konventionellen Stromerzeugung Abwärme im Verhältnis 2:1 entsteht. Diese wird jedoch überall da gebraucht, wo man Kraftwärmekopplungstechnologie (KWK) eingeführt hat. Wegen der großen Bedeutung dieser Nutzungsart, um letztendlich die Energie besser zu nutzen, also die Energieeffizienz zu steigern, wird die KWK massiv subventioniert. Das hat dazu geführt, dass die KWK ca. 18% (Statista) zur Nettostromerzeugung betragen. Also ein knappes Fünftel, und damit deutlich mehr als Strom aus Wind- und Solaranlagen. Doch die so umgerüsteten KWK Kraftwerke erleiden das gleiche Schicksal wie die „normalen“ Kraftwerke. Sie können ihren Strom nicht mehr verkaufen und deswegen auch keine Heizenergie ( zwei von 3 kWh) mehr liefern. Es ist verwunderlich, dass Herr Fell, weder die Technologie kennt, noch deren Schicksal, dass sein EEG herbeiführte.

Und wenn er sie kennt, warum er sie nicht erwähnt hat.

Zur Abwärme 2.

Jede Energieumwandlung erzeugt Abwärme. Wenig bei Wind und Solar (Reibung, Betriebstemperatur bei Leistungsabgabe etc) viel bei fossilen wie Kernkraftwerken. Doch das sagt nichts über ihre ökonomische Effizienz aus.

Herr Fell:

Das Zweite, mit den hohen Subventionen 550 Milliarden US-Dollar sind die Direkt-Subventionen aus staatlichen Geldern in das fossile Energie System. Wer davon spricht, dass Erneuerbare hoch subventioniert seien hat schlicht die Subventions- Gelder nicht im Kopf und weiß es nicht! Das ist nicht der Fall was Sie sagen.

Kommentar:

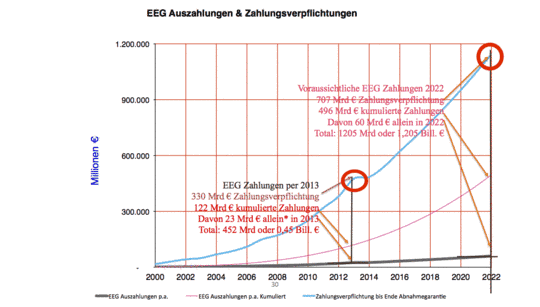

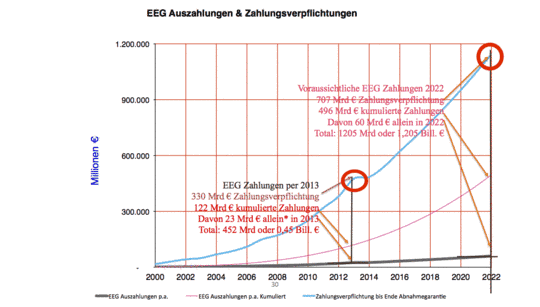

Woher Herr Fell die Zahl von 550 Mrd US-$ hat, weiß ich nicht? Daher kann ich auch nicht beurteilen, ob sie einigermaßen stimmt, oder ob sie eine reine Greenpeace Zahlenente ist. Doch sie interessiert hier, in diesem Zusammenhang, nicht besonders, denn wir diskutierten die Subventionen für NIE, die sich hierzulande, u.a. als Zahlungen der deutschen Verbraucher für das EEG, ausgeschüttet werden. Und die schlagen mit über 330 Mrd € bereits per Ende 2013 zu Buche und wachsen jedes Jahre exponentiell weiter

Abbildung 3: EEG Zahlungen per 2013 und hochgerechnet auf 2022. Schwarz: Bisher geleistete Zahlungen der Netzbetreiber an EEG Besitzer jeweils pro Jahr. Rot: Kumulierte Zahlungen von Beginn an. Blau: Noch zu leistende Zahlungen für die aufs jeweilige Jahr folgenden 20 Jahre. Quelle BDEW, Statista etc. Grafik Limburg

00:09:45 Fell

Sie dürfen nicht ne BP-Statistik hier nehmen, die über das letzte Jahrzehnt -in der Tat- den hohen Kohle Zubau auch im China beschrieben hat, Sie müssen die neuesten Erkenntnisse und Entwicklungen in dieser… Ja, vorgestern wurde dieser Bericht über das letzte Jahrzehnt veröffentlicht. Das sagt aber nichts aus, was seit der Jahrzehnten-Wende jetzt, seit 2010 passiert ist und da, wenn sie ausgerechnet China nehmen, da sollten sie mal richtig nach China schauen.[6]

Kommentar zur BP Statistik:

Hier versucht Herr Fell einen alten Trick rotgüner Rhetorik; immer dann Statistiken als überholt zu deklarieren, wenn man ihren Aussagen nichts entgegen zu setzen hat.

Fakt ist:

Aktueller geht es nicht. Die BP Statistik endet erst im Dezember 2014

Herr Fell:

China hat deswegen im ersten Vierteljahr diesen Jahres schon fünf Prozent CO2-Emissionen reduziert, zum Erstaunen der das gesamten Weltöffentlichkeit weil die wirklich glaubte, das was Sie sagten, bis 2030 werden sie noch steigern.

Fakt ist:

Lt Internationaler Energie Agentur (IEA) hat China -hauptsächlich dank der Wirtschaftsschwäche- von 2013 auf 2014 seine Emissionen um rd. 2 %[7] gesenkt. Vermutlich hat sich dieser Trend in 2015 fortgesetzt. Deswegen stimmt die Angabe von Herrn Fell. Gleichzeitig stiegen die weltweiten Emissionen außerhalb von China und OECD Ländern um netto rd 290 Mio t weiter.

Die IEA begründet diese Veränderung wie folgt:

CO2 emissions outside the OECD and China were up by around 290 Mt in 2014, led by increased use of coal for power generation in India and Southeast Asia. Indeed, across most emerging and developing countries, the relationship between economic growth and emissions growth remains strong as these countries are in the energy-intensive process of building up their capital stock. (Seite 20)

Emissionshandel

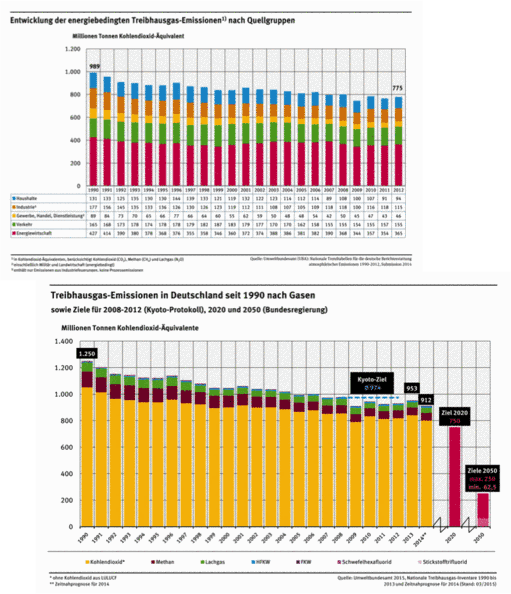

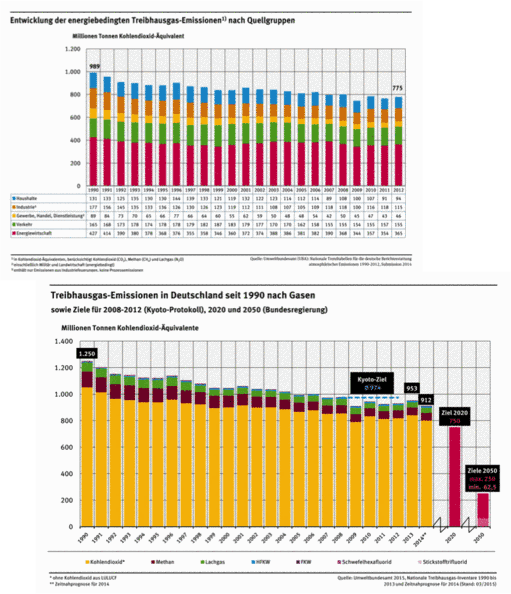

(00:12:14.) Herr Fell betonte, dass der Emissionshandel nichts gebracht hätte. Das ist auch meine Meinung. Er behauptete aber dann anschließend, dass ..von den 300 Tonnen CO2; Millionen Tonnen CO2 -Reduktion die Deutschland seit 1990 hat, geht die eine Hälfte auf den Niedergang der ostdeutschen Industrie nach der Wende.. und die andere Hälfte auf den Ausbau der erneuerbaren Energien.

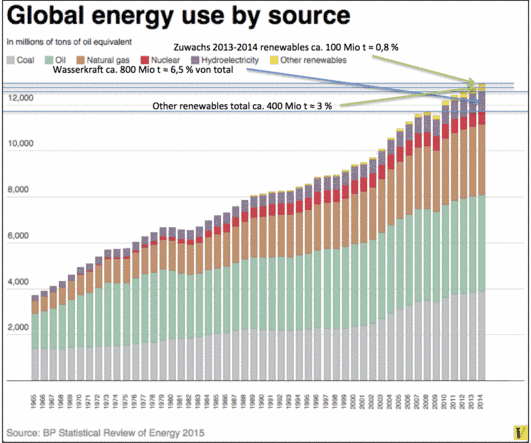

Abbildung 4: Primär Energieverbrauch nach Quellen weltweit lt. BP Studie, jeweils in Mio t Öl Äquivalent. Vom Autor eingezeichnet sind die Anteile der Wasserkraft, sowie total und Zuwachs der „Erneuerbaren“. Wasserkraft dominiert die „Erneuerbaren“ mit rd. 8 % von Gesamt. Alle anderen „Erneuerbaren“ zusammen liegen bei 3 % von Gesamt, während der Zubau aus diesen Quellen bei 100 Mio t bzw. 0,8 % vom Gesamt liegt. Nach einem Siegeszug der „Erneuerbaren“ sieht das nicht aus.

Fakt ist:

Die 300 Mio tC äquivalent Reduktion sind in etwa korrekt, allerdings nicht korrekt ist die behauptete 50:50 Aufteilung.

Zur Menge

Es ist schwer offizielle Zahlen, die dazu auch noch stimmen, über diese Entwicklung zu finden. Selbst wenn die Zahlen aus derselben Quelle stammen, weichen sie absolut und in ihrer Entwicklung deutlich voneinander ab.

So zeigt eine Grafik des UBA von 2014 für die Jahre 1990 bis 2014 im Jahre 1990 eine Menge von 1250 Mio t GtC (äquivalent) und z:B. im Jahre 2012 eine Menge von 930 Mio t GtC (äquivalent) = – 320 Mio t oder -25,6 %, während eine andere Grafik aus demselben Hause für das Jahr 1990 (s. Abb 4) eine Start-Menge von nur 989 Mio t aufweist, welche im Jahr 2012 auf 775 Mio t abgesunken ist. (Siehe Abb. 5). Zum Jahr 1990 beträgt die Differenz daraus dann nur noch 214 Mio t oder 21,6%.

Erschreckend bei dieser Ungenauigkeit ist, dass ganze Industriezweige, wie die Braunkohle, stillgelegt werden sollen, um ein Zehntel dieser Menge (22 Mio t) „einzusparen“, wenn die zu Grunde liegenden Zahlen um das Zehnfache dieser Menge differieren.

Abbildung 5: Deutschlands CO2 Emissionen nach UBA für die Jahre 1990 bis 2012/2013 mit unterschiedlichen Startangaben und unterschiedlichen Senkungsverläufen.

Es wird auch kein Hinweis auf evtl. sonstige Emissionsquellen gegeben, die in der Grafik nach Quellen (nicht nach Gasarten) nicht erfasst wurden.

Ursachen der Reduktion

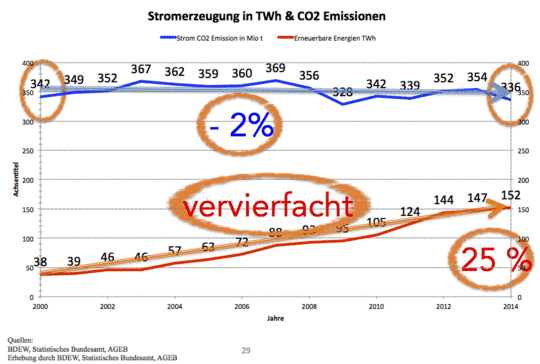

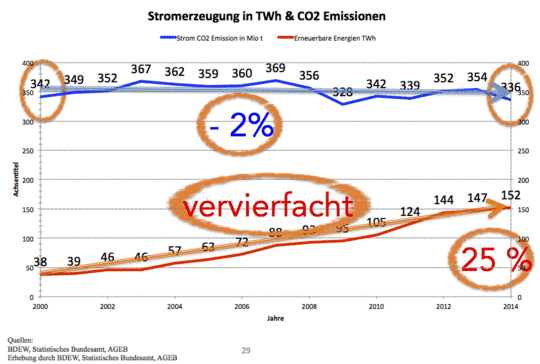

Abbildung 6: CO2 Emissionen deutscher fossil betriebener Kraftwerke für die Jahre 2000 bis 2014. Es fällt sofort auf, dass die Emissionen praktisch konstant blieben, während die erzeugte konventionelle Energiemenge um gut ¼ wg. der vorrangigen Einspeisung des NIE-Stromes abgesenkt wurde. Damit ist auch die Aussage der FEU Studie widerlegt, welche die errechnete Einsparung von 11 Mrd. € hauptsächlich konventioneller Brennstoffkosten, dank NIE Einspeisung begründet. Da wurde nichts eingespart und auch nichts abgesenkt.

Ursache war fast allein, der Niedergang der ostdeutschen Wirtschaft, verbunden mit normaler Effizienzsteigerungen beim Rest der Wirtschaft (insbesondere der Stahlindustrie) Sie hat bis zum Jahr 2000 eine Senkung der Gesamt-Emissionen sog. Treibhausgase um rd. 190 Mio t bis gebracht, da zu der Zeit, die NIE nur in sehr geringem Umfang (mit z.B. rd. 38 TWh in 2000), zur Gesamtelektroenergieerzeugung beitrugen. (s. Abb 5)

Dank des Fell´schen EEG wurde deren Einspeisung dann bis 2014 um dramatische 300 % auf 152 TWh gesteigert, (also vervierfacht) jedoch fielen die Emissionen aus der Erzeugung aus Elektroenergie nur um kaum merkbare 2 %. Die Aussage von Herrn Fell bezüglich der Quellen der Senkung erweist sich also als falsch.

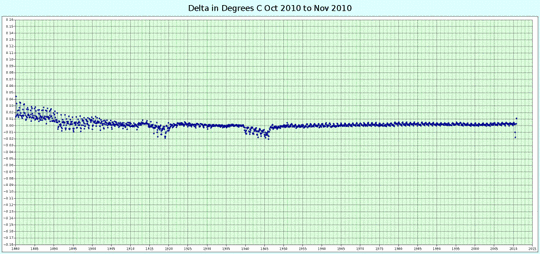

(00:18:27) Herr Fell zum CO2 Gehalt der Atmosphäre von derzeit rd. 400 ppmVol.

Herr Fell behauptete, dass diese 400 ppm bereits wg. der ihnen theoretisch zugeschriebenen Erwärmungswirkung, zuviel seien. Und bezog dies auf die vermuteten (Eisbohrkernmessungen mit großere Unsicherheit) 280 ppm, die vorindustriell geherrscht hätten. Sekundiert von Frau Zink, die ..60.000 Jahre lang.. in die Debatte einwarf. Deswegen verwarf Fell kategorisch jede zulässige Erhöhung, (Absenkung um nur 40 % bis 2020 EU Plan), was der Emissionshandel ja erlaubt und forderte stattdessen eine sofortige rigorose Umstellung auf Null-Emissionstechnologien, um jedwede Erhöhung nach Möglichkeit zu vermeiden.

Kommentar

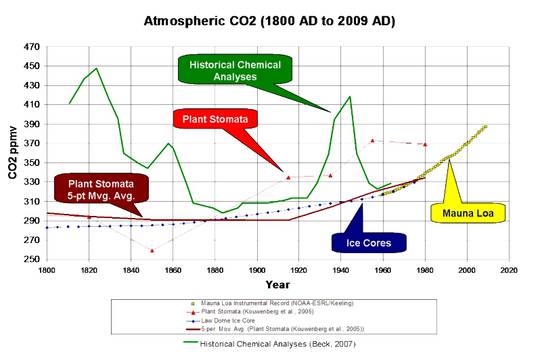

Die genannten 400 ppm sind korrekt. Alles andere sind Meinungen und Annahmen, die als Fakten ausgeben wurden. Dies betrifft die angenommenen 280 ppm vorindustriell, ebenso wie die Wirkung des CO2 auf die Temperatur der Atmosphäre, (Dazu wurde ausführlich im ersten Teil Stellung genommen hier).

Fakt ist:

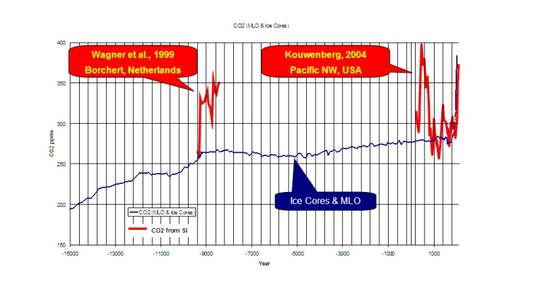

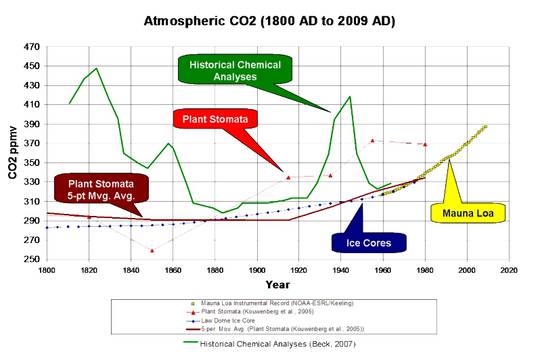

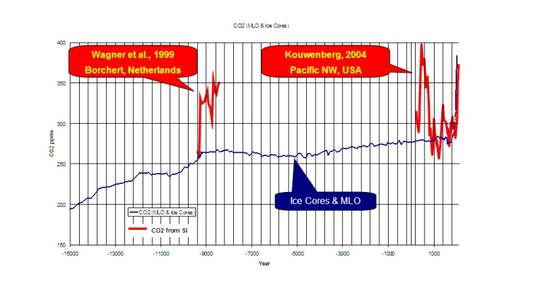

Genaue CO2 Messungen, die global gelten dürften, gibt es erst seit der Mitte der 50er Jahre des vorigen Jhh. Seit dem ersten Drittel des 19. Jhh. existieren aber bereits sehr genaue Messungen des atmosphärischen CO2. Das leider so früh verstorbene EIKE Gründungsmitglied E.G. Beck, hat diese Messungen akribisch aufgeschrieben (> 200.000 Messwerte) und ausgewertet. Diese zeigen einen erratischen Verlauf mit ausgeprägten Spitzen bis zu 400 ppm. Und ähnliche Verläufe zeigen die vielen weiteren Untersuchungen an Proxydaten, wie z.B. Stomata (das sind Blattspaltöffnungen an bestimmten Pflanzen)

In dem Beitrag Eisbohrkerne und Pflanzenstomata: Der historische CO2 Gehalt der Atmosphäre war oft deutlich höher als 280 ppm! vom Geologen David Middleton wird ausführlich auf die aktuellen Forschungsergebnisse eingegangen. Hier seien nur zwei Grafiken daraus angeführt, die zeigen, dass beide Ausagen ..nämlich

…konstante 280 ppmv (Herr Fell)

Abbildung 7: CO2 Konzentrationen für die Zeit von 1800 bis 2000. Sie zeigen erratisch anmutende Spitzen gem. der Beckschen Analyse[8] bis 400 ppm und weniger erratische Verläufe aus Stomata Analysen bis 370 ppmv. Zum Vergleich sind die Eisbohrkerndaten aufgetragen, die nachgewiesenermaßen eine starke Dämpfung auf die CO2 Werte der eingeschlossenen Luftblasen ausüben, zudem in Gebieten gewonnen wurden, deren CO2 Gehalt um 20 bis 40 ppm niedriger ist als in niedrigeren Breiten.

und

über 60.000 Jahre (Frau Zink)

Abbildung 8: CO2 Konzentrationen aus Eisbohrkernen und Stomataanalysen für die Zeit von vor 15.000 Jahre bis heute. Sie zeigen 1. Eine erhebeliche Diskrepanz zwischen beiden Messmethoden in Bezug auf den absoluten Wert, aber auch hochfrequenten Schwankungen, die bei den Eisbohrkernen allesamt geglättet werden. Deutlich auch die Werte um im Mittel 330 ppmv, um die die Stomatawerte schwanken. Mit einer Spitze bei 400 ppmv um 500 n.Chr.

…wissenschaftlich nicht haltbar und damit falsch sind.

Wie deutlich zu erkennen, schwankt die CO2 Konzentration in den vergangenen Jahrhunderten und Jahrtausenden ganz erheblich und das ohne jegliches menschliche Eingreifen. Unabhängig davon, wie genau die dargestellten Werte sind, unabhängig davon, wie groß ggf. ihre Unsicherheit ist, muss klar sein, dass wir heutzutage in einem absoluten CO2 Minimum leben, dass insbesondere für die Pflanzen Mangelernährung bedeutet. Ein mehr an CO2 ist deswegen kein Fluch sondern ein Segen, um die stark angewachsene Bevölkerung dieser Erde auch in Zukunft zu ernähren.

Wird fortgesetzt..

[1] Die IEA umschreibt diese Tatsache so: Renewable technologies are becoming increasingly cost competitive in a number of countries and circumstances, but public support schemes are still required to support deployment in many others. (Chapter 1; p. 21 hier)

[2] Nachzulesen in „Energy Climate and Change“ World Energy Outlook Special Report Summary Seite 11, Quelle hier

[3] Quelle http://www.ren21.net/wp-content/uploads/2015/06/GSR2015_KeyFindings_lowres.pdf S. 7 und 9

[4] „The CoalSwarm/Sierra Club report calculates that since 2010, for every coal proposal that actually gets built, two are getting canceled. Which means we’re on track to build roughly one-third of those 2,177 plants.“ Quelle hier

[5] Prof. Frank Endres ist Direktor des Instituts für Elektrochemie der TU Clausthal und exzellenter Kenner der Batterieforschung. Er arbeitet auf grundlegender Basis u.a. an Batteriematerialien.

[6] Aus: http://www.ieefa.org/wp-content/uploads/2015/01/IEEFA-BRIEFING-NOTE-Global-Energy-Markets-in-Transition.pdf IEEFA estimates that China installed 22 GW of hydro, 18 GW of wind, 13 GW of solar, 5-7 GW of nuclear and 4-6 GW of gas-fired electricity capacity in 2014 alone. Combined with another 22 GW of net new coal-fired capacity, China’s total electricity capacity installs are forecast at 90 GW in 2014 (over 6 percent yoy total capacity growth). Coal-fired power 4 http://www.stats.gov.cn/english/PressRelease/201412/t20141216_653855.html 5 http://af.reuters.com/article/energyOilNews/idAFB9N0T400220141217 6 http://www.brecorder.com/markets/commodities/asia/216783.html Production (TWh) (TWh) share (TWh) share YoY Thermal (gas and coal combined) 3,818 79.7% 3,807 76.5% -0.3% Hydro 725 15.1% 887 17.8% 22.4% Other 245 5.1% 281 5.6% 14.6% Electricity 4,788 4,975 3.9% China coal production (Mt) 3,513 -2.1% YTD Nov’13 YTD Nov’14 4 plants average utilisation rates have declined from an estimated 60 percent in 2011 to around 56 percent in 2014. Given this excess capacity, new installations of coal power are expected to rapidly slow and China could well see net annual coal-fired power capacity reductions from 2016 onwards.

[7] Quelle IEA Seite 20 hier

[8] Details hier: http://www.biomind.de/realCO2/literature/evidence-var-corrRSCb.pdf