Die miserable Wirtschaftslage der deutschen Energieriesen sei selbstverschuldet, sagt Greenpeace und stützt sich auf eine Analyse von Heinz-Josef Bontrup und Ralf-Michael Marquardt von der Westfälischen Hochschule in Recklinghausen. Auslöser der prekären Lage sei nicht die Energiewende, sondern vielmehr gravierende und anhaltende Managementfehler der Stromriesen.

Was haben die schlechten Manager der bösen Konzerne falsch gemacht? Kurz gesagt: Statt auf Erneuerbare Energie zu setzen, damit die Strompreise noch weiter in die Höhe zu treiben und satte Profite zu machen, haben die Konzerne versucht, ihre bestehenden Kraftwerke weiter zu nutzen, um bedarfsgerecht preiswerten Strom zu liefern. Schön doof. Und selbst schuld, sagt Greenpeace.

Was tun? Greenpeace nennt in der Zusammenfassung der Studie zwei „Auswege“. Der erste bestehe in „Desinvestition und Rationalisierung, um die dringend benötigten finanziellen Mittel für einen Neuanfang zu mobilisieren.“ Mit anderen Worten: Kraftwerke verkaufen, um an Geld für Investitionen in Erneuerbare zu kommen. Bleibt die Frage, an wen RWE oder EnBW ihre Kohlekraftwerke verkaufen sollen. Welche andere Firma sollte sie in Deutschland wirtschaftlich betreiben können?

Der zweite Ausweg bestehe darin, für das Wegbrechen des Kerngeschäftes der konventionellen Stromerzeugung einen adäquaten Ersatz zu finden. Hier bestätigt Greenpeace den Konzernen, es richtig zu machen: „Alle Big 4 setzen in diesem Kontext auf den Ausbau der Erneuerbaren Energien inklusive der dazugehörigen Infrastruktur und auf das Geschäftsfeld der Energiedienstleistungen.“

Für diese Schlussfolgerung hätte es keiner 300-seitigen Studie bedurft. Da es aufgrund der politischen Vorgaben keine andere Wahl gibt, müssen alle das Spiel mitspielen. Die Konzerne werden tun, wofür es im staatlich regulierten System Profite gibt. Und die Verbraucher werden bezahlen.

Die Kosten der Energiewende

Wie entwickeln sich die Stromkosten in Deutschland und was treibt die Verteuerung? Im Jahr 2000 betrug der durchschnittliche Strompreis für deutsche Haushalte knapp 14 Cent pro Kilowattstunde, heute sind es rund 29 Cent. Der Strompreis für die Industrie lag bei etwa 6 Cent, heute sind es 15. Die Gesamtbelastung durch Steuern und Abgaben lag im Jahr 2000 bei knapp sieben Milliarden Euro, heute sind es über 35 Milliarden.

Die Behauptung, der private Verbraucher müsse bluten, weil Teile der bösen Wirtschaft entlastet werden, ist aus zwei Gründen haltlos. Erstens zahlen die privaten Haushalte nur rund 35% der EEG-Umlage in Höhe von 23,6 Mrd. Euro, 53% kommen von der Wirtschaft, der Rest von öffentlichen Einrichtungen (Zahlen für 2014).] Zweitens ist es für den Verbraucher egal, ob er die Kosten direkt über die Stromrechnung zahlt oder indirekt über verteuerte Brötchen und U-Bahn-Fahrscheine oder Steuern, aus denen öffentliche Einrichtungen finanziert werden. Entscheidend ist die Gesamthöhe der Belastung, die der Volkswirtschaft entsteht. Und diese Belastung beschränkt sich keineswegs auf die EEG-Umlage.

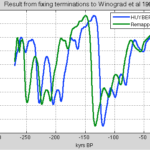

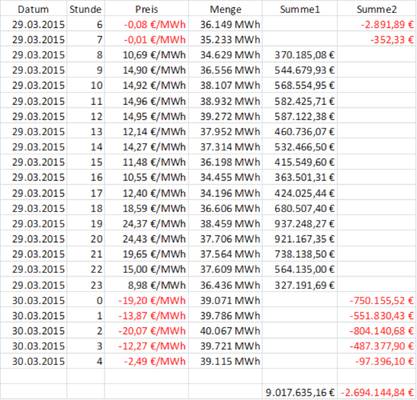

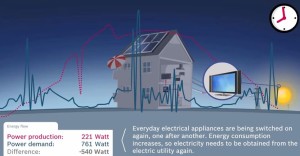

Eine weitere Behauptung besagt, durch das hohe Angebot von Erneuerbaren werde der Preis an der Strombörse gedrückt und somit würden die Erneuerbaren nicht zu einer Preissteigerung, sondern zu einer Kostensenkung beitragen. „Verbraucher würden ohne Wende gleich viel bezahlen wie mit, aber die Industrie wesentlich mehr. Das liegt an den billigen Börsenstrompreisen und diese sind preiswertem Solar- und Windstrom geschuldet. Sonne und Wind schicken keine Rechnung“,erfahren wir von Ökostromguru Franz Alt. Mit der Realität hat diese Vorstellung sehr wenig zu tun. Wahr ist, dass in Zeiten mit hoher Wind- oder Solarstromeinspeisung der Preis am sogenannten Spotmarkt tatsächlich sinkt. Denn auch hier gilt grundsätzlich, dass Preise sinken, wenn das Angebot höher ist als die Nachfrage. Konkret passiert dann Folgendes: Der Bedarf wird so gedeckt, dass zunächst der gesamte Ökostrom gekauft werden muss, dann die billigsten konventionellen Anbieter liefern, dann die etwas teureren, usw.. Alle konventionellen Erzeuger erhalten am Ende den Preis, der den Grenzkosten des bis dahin teuersten Anbieters entspricht. Wenn so viel Strom aus Erneuerbaren da ist, dass der ganze Rest durch billigen Atom- bzw. Kohlestrom gedeckt werden kann, bleibt der Börsenpreis auf dem niedrigen Niveau des Kohlestroms. Alle Kraftwerke, die nicht zum Zug kommen, müssen abschalten bzw. außer Betrieb bleiben. Das trifft insbesondere moderne, saubere Gaskraftwerke und Pumpspeicherkraftwerke.

Der Verbraucher merkt von diesen gedrückten Preisen leider aus zwei Gründen kaum etwas. Erstens macht die Stromerzeugung weniger als ein Viertel des Strompreises aus, da ja über 50 Prozent aus Steuern und Abgaben bestehen und der Rest aus den Netzkosten resultiert, die unabhängig davon sind, woher der Strom ursprünglich kommt. Zweitens machen die Beschaffungskosten am Spotmarkt einen relativ geringen Anteil aus, da dieser von den Stromanbietern hauptsächlich für den Ausgleich kurzfristiger Bedarfsschwankungen oder kurzfristige Anpassungen im Beschaffungsportfolio genutzt wird. Der überwiegende Teil des Stroms wird bereits im Voraus am Terminmarkt beschafft.

Der Preisverfall am Spotmarkt führt vor allem dazu, dass konventionelle Kraftwerke immer unrentabler werden, weil sie mit sinkender Auslastung und somit ineffizienter arbeiten müssen. So entstehen weitere volkswirtschaftliche Kosten. Es trifft über schwindende Dividenden und drastische Kursverluste zunächst einmal die Aktionäre. Letztlich werden aber wir alle darunter zu leiden haben. Schadenfreude, weil sich die Stromkonzerne nun keine goldene Nase mehr verdienen, hilft hier nichts. Fehlende Gewinne bedeuten auch fehlende Investitionsmöglichkeiten.

Aus unternehmerischer Sicht müssten die Stromerzeuger ihre nicht mehr ausgelasteten Gas- und Kohlekraftwerke, die Verluste schreiben, stilllegen. Das wird jedoch in der Regel nicht gestattet. Die Kraftwerke müssen als so genannte Netzreserve in Betrieb bleiben, die Betreiber erhalten eine Kostenerstattung.

Kosten der Versorgungssicherheit

Wie kann trotz immer größerem Anteil an stark fluktuierendem Ökostrom die Versorgungssicherheit gewährleistet werden? Grundsätzlich werden verschiedene Optionen diskutiert, die letztlich alle auf erhebliche Überkapazitäten angewiesen sind. Eine Möglichkeit wäre ein Kapazitätsmarkt. Wir zahlen einen Marktpreis dafür, dass die Kraftwerke in Bereitschaft bleiben und bei Bedarf hochgefahren werden. Das Produkt, das gehandelt wird, ist also nicht Strom, sondern Lieferbereitschaft. Diesen Ansatz hat Sigmar Gabriel mit der Bemerkung abgelehnt, es dürfe nicht auf „Hartz-IV für Kraftwerke“ hinauslaufen: „Nicht arbeiten, aber Geld verdienen.“ Die andere Option wäre ein reiner Marktmechanismus. Das bedeutet, dass der Strompreis bei entsprechender Nachfrage beliebig steigen darf. Ein Gaskraftwerk könnte dann die meisten Ziel des Jahres ungenutzt herumstehen und nur liefern, wenn es wolkig und windstill ist. Dann dürfte die Gigawattstunde statt 50 Euro auch 5000 Euro kosten, letztlich eben so viel, dass das Kraftwerk auch rentabel betrieben werden kann, wenn es 98 Prozent des Jahres stillsteht. Das ist der Politik auch nicht geheuer, würde aber nur funktionieren, wenn eine freie Preisbildung wirklich garantiert würde.

Eine weitere Möglichkeit, Versorgungssicherheit zu verbessern, ist der Stromtransport über lange Strecken. In Deutschland geht es bekanntlich darum, den Windstrom aus den Norden in den Süden zu bringen, wo die Industrie einen großen Bedarf hat. Das kann man machen. Es hat aber ebenfalls seinen Preis. Wenn Strom von Nord- nach Süddeutschland transportiert wird, gehen rund 10 Prozent verloren. Es müssen also nicht nur die Milliarden für den Bau und Unterhalt der Hochspannungsleitungen bezahlt werden, sondern auch Milliarden für die Transportverluste. Nochmal

teurer wird es, wenn die Leitungen, die sich ja bei den betroffenen Anwohnern keiner großen Beliebtheit erfreuen, unterirdisch verlegt werden.

Die vierte Option ist der Austausch mit den Nachbarländern. Das setzt aber voraus, dass dort keine Windräder stehen, sondern konventionelle Kraftwerke, die bedarfsgerecht liefern können. Damit die deutsche Energiewende gelingt, darf sie in den Nachbarländern nicht stattfinden. Fünftens gibt es noch Energiespeicher, die aber insgesamt im Vergleich zur Vernetzung als noch teurer gelten.

Die aktuellen Pläne von Sigmar Gabriel sehen eine Kombination verschiedener Maßnahmen vor. Neben dem Netzausbau soll die Netzreserve bestehen bleiben. Zusätzlich soll eine Kapazitätsreserve geschaffen werden. Hierfür „mietet“ der Staat alte Kraftwerke und hält diese für den Notfall in Bereitschaft. Was die Kosten anbetrifft, die am Ende der Stromkunde bezahlt, nimmt sich das alles nicht viel. Egal wie man es macht: Bei fortschreitender Energiewende wachsen die volkswirtschaftlichen Kosten der ganzen Angelegenheit. Mit den Kosten aus dem Erneuerbare-Energien-Gesetz, die alle früheren Prognosen längst gewaltig überschreiten, ist es nicht getan.

Energiewende als Selbstzweck

Nun könnten wir sagen: Die gute Sache ist es uns wert. Wäre da nicht jener Makel, der selbst die größten Befürworter der Energiewende etwas in Verlegenheit bringt. Es sollte ja eigentlich darum gehen, das Klima zu retten, indem der Ausstoß von CO2 verringert wird. Das hat bisher leider nicht hingehauen. Erstens, weil durch den europäischen Emissionshandel jede in Deutschland eingesparte Tonne Kohlendioxid eben anderswo in die Luft geblasen werden darf. Zweitens, weil die emissionsfreien Kernkraftwerke abgeschaltet werden. Und drittens, weil durch den Preismechanismus die Gaskraftwerke zugunsten der auch gerne „Dreckschleuder“ genannten Kohlekraftwerke aus dem Markt gedrängt werden.

Für dieses letzte Problem hat Gabriel jetzt eine kosmetische Lösung vorgeschlagen. Er möchte den Braunkohlestrom künstlich verteuern. Ab 2017 sollen die Betreiber älterer Kohlekraftwerke einen „Klimabeitrag“ bezahlen, damit letztlich unrentabel werden und verschwinden. Das kostet zwar wieder Geld und Arbeitsplätze, hat aber den Vorteil, dass wir dann stolz den Ausstieg aus der Braunkohleverstromung verkünden könnten. Der Nachteil: Fürs Klima macht es keinen Unterschied. Auf europäischer Ebene wird dadurch nicht weniger CO2 emittiert, denn am Emissionshandel ändert sich ja nichts. Global gesehen liegen die Emissionen der deutschen Stromerzeugung ohnehin unter einem Prozent.

Aus Sicht der Politik scheint es in Hinblick auf die zum Selbstzweck gewordene Energiewende nur eine Devise zu geben: Augen zu und schönreden!

Thilo Spahl ist Ressortleiter Wissenschaft bei NovoArgumente. Dort erschien dieser Beitrag zuerst.