Bild rechts: Illustration von Harry Campbell

Heutzutage ist keines der drei Argumente noch stichhaltig. Tatsächlich zeigt eine realistischere Abschätzung unserer Energie- und Umweltsituation, dass wir noch viele Jahrzehnte lang unverändert abhängig sein werden von den fossilen Treibstoffen, die so dramatisch zu Wohlstand und Fortschritt in der Welt beigetragen haben.

Im Jahre 2013 kamen etwa 87% der weltweit verbrauchten Energie aus fossilen Treibstoffen, eine Zahl, die sich gegenüber dem Wert von 10 Jahren zuvor bemerkenswerterweise nicht verändert hat. Dies lässt sich grob in drei Kategorien von Treibstoff und in drei Kategorien des Verbrauchs einteilen: Öl hauptsächlich für Transporte, Gas hauptsächlich zum Heizen und Kohle hauptsächlich zur Stromerzeugung.

Während dieses Zeitraumes ist das Volumen des Verbrauchs fossiler Treibstoffe insgesamt dramatisch gestiegen, jedoch mit einem ermutigenden Umwelttrend: Einer Verringerung der CO2-Emissionen pro Einheit erzeugter Energie. Den größten Beitrag zur Dekarbonisierung des Energiesystems bei der Stromerzeugung hat der Wechsel von kohlenstoffreicher Kohle zu kohlenstoffärmerem Gas geleistet.

Im globalen Maßstab haben erneuerbare Energiequellen wie Wind und Solar kaum etwas zum Rückgang der Kohlenstoffemissionen beigetragen, und ihr Wachstum hat lediglich dazu geführt, die kohlenstofffreie Kernenergie zurückzudrängen. (Der Leser sollte wissen, dass ich ein indirektes Interesse Kohle habe, besitze ich doch Ländereien in Nordengland, auf denen Bergbau betrieben wird, aber nichtsdestotrotz applaudiere ich der Ersetzung von Kohle durch Gas während der letzten Jahre).

Das Argument zu Ende gehender fossiler Treibstoffe ist zumindest für die nächste Zeit zusammengebrochen. Der Kollaps des Ölpreises während der letzten sechs Monate (hier ) ist eine Folge von Überfluss : eine unvermeidliche Konsequenz der hohen Ölpreise der letzten Jahre, welche Innovationen in hydraulischem Brechen, horizontalem Bohren, Seismologie und Informations-Technologie vorangebracht hat. Die USA – das Land mit den ältesten und am besten erschlossenen Kohlenwasserstoff-Feldern – hat sich selbst wieder einmal überraschend an der Spitze der Energie erzeugenden Liga wiedergefunden, hat es doch seine Rivalen Saudi Arabien bzgl. Öl und Russland bzgl. Gas hinter sich gelassen.

Der Schiefer-Geist ist jetzt aus der Flasche heraus. Selbst wenn der gegenwärtige niedrige Preis einige kostenintensive Ölerzeuger aus dem Rennen schubst – in der Nordsee, in Kanada, Russland, Iran und Offshore ebenso wie in Amerika – können die Schiefer-Bohrer sofort wieder loslegen, sobald sich die Preise erholen. Mark Hill von der Allegro Development Corporation hat kürzlich gesagt , dass die Fracker gegenwärtig ihre eigene Version von Moores Gesetz erleben: ein rapider Rückgang der Kosten und der zum Bohren erforderlichen Zeit zusammen mit dem rapiden Anstieg des Volumens der Kohlenwasserstoffe, die zu extrahieren sie in der Lage sind.

Und die Schiefer-Revolution muss sich noch global ausbreiten. Sowie das der Fall ist, werden Öl und Gas in soliden Felsformationen der Welt überreichlich Kohlenwasserstoffe für Jahrzehnte verschaffen, wenn nicht für Jahrhunderte. Und dahinter verborgen lauert für spätere technologische Durchbrüche das Methanhydrat, eine Gasquelle am Meeresboden mit einer Quantität, die über die gesamten Kohle-, Öl- und Gasvorräte der ganzen Welt zusammen hinausgeht.

Jene, die die unmittelbar bevorstehende Erschöpfung fossiler Treibstoffe predigen, wiederholen also lediglich die Fehler der US-Präsidialkommission, die im Jahre 1922 der Ansicht war, dass „schon jetzt die geförderte Gasmenge abnimmt. Die Ölerzeugung kann nicht mehr lange mit der derzeitigen Rate erfolgen“. Oder die Fehler von Präsident Jimmy Carter, der im Jahre 1977 in einer Fernsehansprache sagte, dass „wir alle nachgewiesenen Ölreserven in der ganzen Welt bis zum Ende des nächsten Jahrzehnts aufgebraucht haben werden“.

Dass fossile Treibstoffe begrenzt sind, ist ein Ablenkungsmanöver. Der Atlantische Ozean ist begrenzt, aber das heißt nicht, dass man Gefahr läuft, auf Frankreich zu stoßen, wenn man aus einem Hafen in Maine ausläuft. Die [Anzahl der] Büffel im Westen der USA war unbegrenzt in dem Sinne, dass sie Nachwuchs zeugen konnten, und doch gerieten sie an den Rand der Ausrottung. Es ist eine ironische Wahrheit, dass nicht erneuerbare Ressourcen niemals an ihre Grenzen stießen, während dies bei erneuerbaren Ressourcen – Wale, Kabeljau, Wälder, Brieftauben – schon häufig der Fall war.

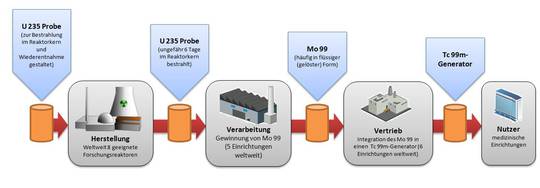

Das zweite Argument für das Aufgeben fossiler Treibstoffe lautet, dass neue Rivalen sie in Kürze preislich aus dem Markt drängen werden. Aber das wird nicht geschehen. Die große Hoffnung lag lange Zeit auf Kernenergie, aber selbst bei einem Boom des Baus neuer Kernkraftwerke während der nächsten paar Jahre werden die neuen höchstens die alten Kraftwerke ersetzen, die heruntergefahren werden. Im Jahre 2003 bestand die weltweit verbrauchte Energie zu 6% aus Kernkraft, heute sind es noch 4%. Es gibt Vorhersagen der Energy Information Administration, dass der Anteil bis zum Jahr 2035 wieder auf 6,7% steigt.

Das Problem der Kernkraft sind die Kosten. Um den Sicherheitsanforderungen von Umweltaktivisten, Politikern und Gesetzgebern Rechnung zu tragen, gibt es zusätzliche Vorgaben für mehr Beton, Stahl und Rohrleitungen – und sogar zusätzliche Kosten für Rechtsanwälte, Papierkram und Zeit. [Anm. d. Redaktion: Hier schreibt Matt Ridley den aktuellen Status einfach fort. Schon bei KKW der 3. Generation, aber noch viel mehr bei KKW Kernkraftwerke der 4. Generation benötigt man derartige Vorkehrungen nicht mehr. Damit fallen auch div. Zulassungsbeschränkungen weg, sofern sie nicht – zumindest hierzulande- durch neue politisch motivierte ersetzt werden) Dahinter steckte die Absicht, Kernkraftwerke in riesige und umständliche Zeitverschwendungs-Maschinen zu verwandeln, ohne Wettbewerb oder Experimentieren, um die Kosten zu senken. Kernkraft kann derzeit im Wettbewerb nur mit Subventionen neben fossilen Treibstoffen bestehen.

Kommen wir zu erneuerbarer Energie: Wasserkraft ist der größte und billigste Versorger, aber gleichzeitig auch derjenige mit der geringsten Erweiterungs-Kapazität. Technologien zum Einfangen der Energie von Wellen und der Gezeiten bleiben unbezahlbar und unpraktikabel, und die meisten Experten gehen davon aus, dass sich daran vorerst auch nichts ändert. Und Bioenergie – das heißt Holz, Äthanol aus Mais oder Zuckerrohr oder Diesel aus Palmöl – hat sich als ein ökologisches Desaster herausgestellt. Es führt zu Entwaldung und dramatischen Steigerungen von Preisen für Nahrungsmittel, was verheerende Folgen für die Atmen dieser Welt hat. Außerdem wird bei dieser Art der Energieerzeugung mehr CO2 freigesetzt als bei der Verbrennung von Kohle.

Windenergie hat inzwischen trotz all der Steuergelder für deren Expansion einen Anteil von – Moment – 1 Prozent des Weltenergieverbrauchs im Jahre 2013 erreicht. Solarenergie ist trotz des riesigen Hypes um sie herum noch nicht einmal so weit gekommen: Falls wir auf die nächste ganze Zahl runden, beträgt ihr Anteil am Weltenergieverbrauch 0 Prozent. [Hervorhebung vom Übersetzer]

Sowohl Wind- als auch Solarenergie sind vollständig abhängig von Subventionen bei der ökonomischen Brauchbarkeit, die sie derzeit haben. Weltweit belaufen sich die Subventionen für erneuerbare Energie gegenwärtig auf grob geschätzt 10 Dollar pro Gigajoule. Diese Summen werden von Verbrauchern gezahlt und gehen an die Erzeuger, so dass sie dazu tendieren, von den Armen zu den Reichen zu fließen, oftmals an Landbesitzer. (Ich bin ein Landbesitzer und kann bestätigen, dass ich viele Angebote von risikofreien Wind- und Solarsubventionen bekomme – und ablehne).

Es stimmt, dass einige Länder den Gebrauch fossiler Treibstoffe subventionieren, aber das tun sie mit einer viel geringeren Rate – das weltweite Mittel beträgt etwa 1,20 Dollar pro Gigajoule – und hierbei handelt es sich zumeist um Subventionen für Verbraucher (nicht Erzeuger), so dass diese dazu tendieren, den Armen zu helfen, für die Ausgaben für Energie ein unverhältnismäßig hoher Anteil an ihren Gesamtausgaben ausmachen.

Die Kosten für erneuerbare Energie sinken zwar, vor allem bei Solar. Aber selbst wenn Solarpaneele umsonst wären, würde die von ihnen erzeugte Energie immer noch kaum mit fossilen Treibstoffen im Wettbewerb bestehen können – außer in sehr sonnigen Gebieten – weil die Hauptausrüstung vorhanden sein muss, diese Energie zu konzentrieren und zu transportieren. Darin enthalten sind noch nicht der immense Landverbrauch durch die Installation dieser Paneele sowie die Kosten ausreichender konventioneller Erzeugungskapazität, um die Versorgung auch an einem dunklen, kalten, windstillen Abend sicherzustellen.

Die zwei fundamentalen Probleme erneuerbarer Energie sind, dass sie zu viel Raum beanspruchen und zu wenig Energie erzeugen. Man betrachte Solar Impulse, das solar angetriebene Flugzeug, das derzeit um die Welt fliegt. Trotz der enormen Flügelspannweite (ähnlich einer Boeing 747), geringer Geschwindigkeit und häufigen Zwischenlandungen ist die einzige Fracht, die das Flugzeug tragen kann, die Piloten selbst. Das ist eine gute Metapher für die Grenzen der Erneuerbaren.

Um die US-Wirtschaft komplett mit Windenergie zu versorgen, würde man für den entsprechenden Windpark das Gebiet von Texas, Kalifornien und New Mexico zusammen benötigen – mit Gas als Backup an windstillen Tagen. Um sie mit Holz zu versorgen, bräuchte man einen Wald, der zwei Drittel des Gebietes der USA bedecken würde, den man stark und ununterbrochen roden müsste.

John Constable, der einem neuen Energieinstitut an der University of Buckingham in UK vorstehen wird, weist darauf hin, dass das Rinnsal von Energie, das die Menschen aus Wind, Wasser und Holz vor der Industriellen Revolution extrahieren konnten, eine gewaltige Beschränkung für Entwicklung und Fortschritt war. Die ständige Mühe von Farmarbeitern erzeugte so wenig überschüssige Energie in Form von Nahrungsmitteln für Mensch und Vieh, dass die Akkumulation von Kapital wie etwa der Maschinen-Fuhrpark ein schmerzhaft langsamer Prozess war. Selbst noch Ende des 18. Jahrhunderts war diese energiearme Wirtschaft lediglich ausreichend, um das Leben für einen Bruchteil der Bevölkerung zu bereichern.

Unser alter Feind, der Zweite Hauptsatz der Thermodynamik, ist hier das Problem. Wie das Schlafzimmer eines Teenagers allgemein illustriert, das man sich selbst überlässt, wird alles immer weniger geordnet, chaotischer und tendiert zu Entropie oder thermodynamischem Gleichgewicht. [Als Philosoph kann man es auch so ausdrücken: Jedes allein gelassene Kind in seinem Kinderzimmer beweist das Entropiegesetz. Anm. d. Übers.] Um diese Tendenz umzukehren und etwas Komplexes, Geordnetes und Funktionsfähiges zu erschaffen, ist Arbeit erforderlich. Und Arbeit erfordert Energie.

Je mehr Energie zur Verfügung steht, umso aufwändiger, stärker und komplexer kann man ein System erschaffen. Genau wie der menschliche Körper Energie braucht, um ordentlich zu bestehen, gilt das auch für Gesellschaften. In dieser Hinsicht waren fossile Treibstoffe ein eindeutiger Fortschritt, weil sie es den Menschen erlaubten, außerordentlich komplexe Dinge – Maschinen und Gebäude – zu erzeugen, womit sich ihr Leben enorm verbessert hat.

Die Folge dieses gewaltigen Energieschubs ist das, was die Wirtschaftswissenschaftlerin und Philosophin Deirdre McCloskey die Große Bereicherung nennt. Im Falle der USA gab es grob geschätzt eine Wertzunahme von 9000% bei Gütern und Dienstleistungen für alle Amerikaner seit dem Jahr 1800, die fast vollständig auf fossilen Treibstoffen beruht.

Immer noch haben über eine Milliarde Menschen auf dem Planeten keinen Zugang zu Strom und können daher nicht an dem enormen Schub des Lebensstandards teilhaben, den ausreichend Energie mit sich bringt. Dies ist nicht nur eine Unbequemlichkeit für sie: Luftverschmutzung in Räumen durch Holzfeuer tötet pro Jahr etwa 4 Millionen Menschen. Das nächste Mal, wenn Sie von irgendjemandem belehrt werden über das mögliche schlimme Schicksal Ihrer Enkel, zeigen Sie ihm das Bild eines afrikanischen Kindes, das heute diesen Dreck eines rauchenden Feuers einatmen muss.

Man bedenke auch, auf welch vielfältige Weise fossile Treibstoffe zum Erhalt des Planeten beigetragen haben. Der amerikanische Autor und Befürworter fossiler Treibstoffe Alex Epstein zeigt in einem tapfer gegen den Mainstream kämpfenden Buch mit dem Titel „The Moral Case for Fossil Fuels“, dass der Verbrauch von Kohle die Entwaldung von Europa und Nordamerika zunächst gestoppt und dann umgekehrt hat. Der Gebrauch von Öl sorgte für ein Ende des Abschlachtens von Walen und Seelöwen, um an deren Blubber zu kommen. Auf der Grundlage von Gas erzeugte Düngemittel halbierten den Landverbrauch bei der Erzeugung einer gegebenen Menge von Nahrungsmitteln, was eine wachsende Bevölkerung satt machte und mehr Land für den Naturschutz übrig ließ. [Hervorhebung vom Übersetzer]

Um diese immensen ökonomischen, umweltlichen und moralischen Vorteile über Bord zu werfen, muss man sehr gute Gründe haben. Der heute am häufigsten genannte Grund ist, dass wir das Klima des Planeten zerstören. Aber tun wir das wirklich?

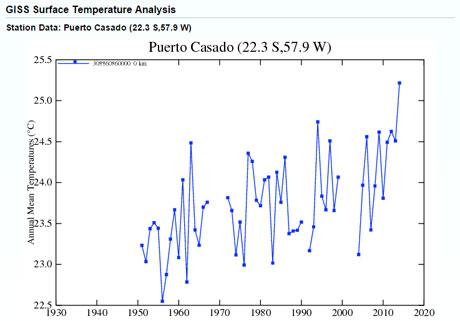

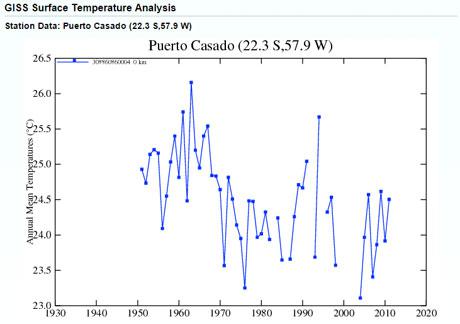

Obwohl sich die Welt sicherlich seit dem 19. Jahrhundert erwärmt hat, war die Rate dieser Erwärmung langsam und erratisch. Es gab keine Zunahme der Häufigkeit und Stärke von Stürmen oder Dürren, keine Beschleunigung des Meeresspiegel-Anstiegs. Das arktische Meereis hat ab-, das antarktische Meereis aber zugenommen. Gleichzeitig haben Wissenschaftler übereinstimmend festgestellt, dass zusätzliches CO2 in der Luft zu einer Verbesserung der Ernteerträge beigetragen hat sowie zu einer Zunahme aller grünen Vegetation um etwa 14% seit dem Jahr 1980.

Das CO2-Emissionen Erwärmung verursachen könnten, ist kein neuer Gedanke. Bereits im Jahre 1938 dachte der britische Wissenschaftler Guy Callender, dass er bereits damals die Erwärmung finden konnte als Folge der CO2-Emissionen. Er räumte allerdings ein, dass sich dies „wahrscheinlich als vorteilhaft für die Menschheit erweisen wird“ durch die Nordverschiebung der Klimazonen, in denen Kultivierung möglich ist.

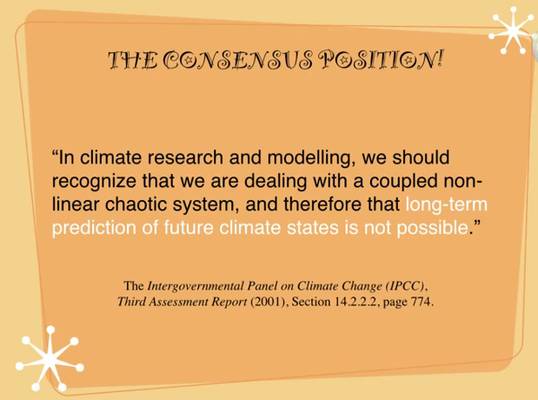

Erst in den siebziger und achtziger Jahren des vorigen Jahrhunderts haben Wissenschaftler angefangen zu sagen, dass die geringe Erwärmung als direkte Folge der Verbrennung fossiler Treibstoffe – etwa ein Grad Celsius pro Verdoppelung des CO2-Gehaltes in der Atmosphäre – erheblich verstärkt werden könnte durch Wasserdampf und zu einer gefährlichen Erwärmung von zwei bis vier Grad innerhalb eines Jahrhunderts führen könnte. Diese „Rückkopplungs“-Hypothese hoher „Sensitivität“ verbleibt in nahezu allen vom IPCC bis auf den heutigen Tag verwendeten mathematischen Modellen zur Vorhersage des Klimas.

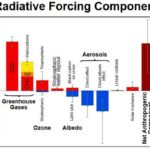

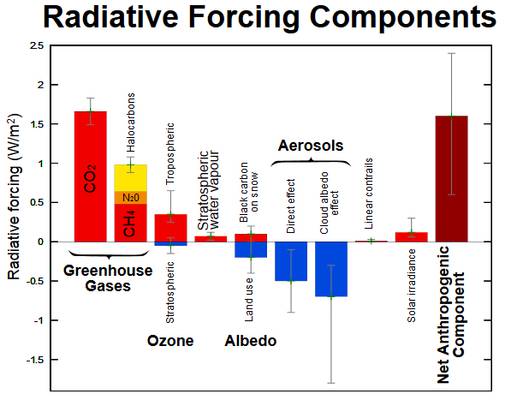

Dabei wird immer klarer, dass dies falsch ist. Wie Patrick Michaels vom libertären Cato Institute geschrieben hat: Seit dem Jahr 2000 sind 14 begutachtete Studien, veröffentlicht von 42 Autoren, von denen viele zentral zu den IPCC-Berichten beigetragen haben, zu dem Ergebnis gekommen, dass die Klimasensitivität gering ist, weil die Gesamt-Rückkopplungen moderat sind. Sie kommen zu diesem Ergebnis auf der Grundlage beobachteter Temperaturänderungen, der Wärmeaufnahme der Ozeane und dem Gleichgewicht wischen erwärmenden und abkühlenden Emissionen (hauptsächlich Sulfat-Aerosole). Im Mittel stellen sie eine um 40% geringere Sensitivität fest als von den Modellen errechnet, auf die sich das IPCC stützt.

Wenn diese Schlussfolgerungen stimmen, würden sie erklären, warum sich die Erde während der letzten 35 Jahre nicht einmal annähernd so stark erwärmt hat wie prophezeit, zu einer Zeit also, als die Erwärmungsrate – trotz des schneller als erwartet steigenden CO2-Niveaus – nicht einmal zwei Zehntelgrad pro Jahrzehnt erreicht und sich während der letzten 15 bis 20 Jahre auf fast nichts verlangsamt hat. Dies ist einer der Gründe, warum im jüngsten IPCC-Bericht kein „Best Estimate“ der Sensitivität angegeben wird und warum die Schätzung der Erwärmung im Kurzfristzeitraum verringert wurde.

Die meisten Wissenschaftler weigern sich jedoch, die Modelle zu verwerfen und vertreten den Standpunkt, dass der gegenwärtige „Stillstand“ die rapide Erwärmung lediglich verzögert hat. Ein Wendepunkt hin zu einer gefährlichen rapiden Erwärmung könnte schon hinter der nächsten Ecke lauern, obwohl sich ein solcher inzwischen hätte zeigen müssen. Es wäre also angebracht, um etwas zur Verringerung unserer Emissionen zu tun, solange es nicht die Armen schädigt und jene, die einen modernen Lebensstandard zu erreichen trachten.

Wir sollten uns hinter die Ersetzung von Kohle durch Gas bei der Stromerzeugung stellen, Anreize für [die Verbesserung der] Energieeffizienz schaffen, Kernkraft wiederbeleben und Solarenergie und Stromspeichermöglichkeiten versuchen weiterzuentwickeln. Wir sollten auch in Forschungen investieren, CO2 aus der Luft zu holen [wieso das denn?! Anm. d. Übers.] durch Düngung der Ozeane oder durch CCS. All diese Maßnahmen machen Sinn. [Schade! Mit dieser Ansicht widerspricht Ridley seinem gesamten Artikel bis hier und entwertet ihn auch. Anm. d. Übers.] Und wir haben allen Grund, unbegrenzt nach völlig unerwarteten neuen Energiequellen zu suchen [stimmt! Anm. d. Übers.]

Was wirklich nicht funktionieren wird, ist das, worauf die Umweltbewegung mit aller Gewalt besteht: nämlich die kumpelhafte Subventionierung von Kapitalisten, um erneuerbare Energiesysteme zu errichten mit geringer Energiedichte, geringem Output, die kapitalintensiv und landhungrig sind, während man gleichzeitig den Armen nahelegt, ihren Traum von einem besseren Leben durch fossile Treibstoffe aufzugeben.

Mr. Ridley is the author of “The Rational Optimist: How Prosperity Evolves” and a member of the British House of Lords. He is a member of the GWPF’s Academic Advisory Council

The Wall Street Journal, 14 March 2015

Link: http://www.thegwpf.com/matt-ridley-fossil-fuels-will-save-the-world-really/

Übersetzt von Chris Frey EIKE