Baden-Würtemberg kann alles, außer Windkraft!

Auswertung Windstromerzeugung 2014

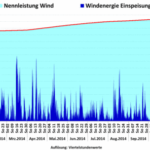

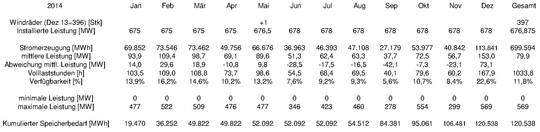

Die Auswertung der Anlagendaten ergibt zu Jahresbeginn 2014 einen Bestand von 396 Windrädern mit 675 MW Nennleistung. Im Mai 2014 wurde eine WKA mit 3 MW Nennleistung neu errichtet, so dass sich am Jahresende ein Bestand von 397 Windrädern mit 678 MW Gesamt-Nennleistung ergibt.

Alle WKA in Baden-Württemberg erzeugten 2014 insgesamt 699.564 MWh Strom. Das entspricht einer jahresdurchschnittlichen Windstromeinspeisung von 79,9 MW oder 11,8% Verfügbarkeit der installierten Gesamtkapazität von jahresdurchschnittlich 676,9 MW. Im Jahresverlauf ergaben sich somit 1033,8 Volllaststunden. Das ist zwar eine erheblich höhere Erzeugung gegenüber dem windschwachen Vorjahr (809,5 Vollaststunden), im Vergleich zum restlichen Bundesgebiet erzeugte ein Windrad in Baden-Württemberg aber nur wenig über zwei Drittel (1482,5 Stunden nach Fraunhofer, ISE) der Leistung, die die gleiche WKA im restlichen Bundesgebiet erzeugt hätte.

Die monatliche Stromerzeugung varierte zwischen 27.179 MWh im September und 113.841 MWh im Dezember. Die Einspeiseleistung bewegte sich zwischen 0 MW (Windstille), was in jedem Monat vorkam, und 569 MW (= 83,9%), die am 11. Dezember 22:15 und 20. Dezember 17:45 erreicht wurden. Die Windeinspeisung verteilt sich im Detail wie folgt auf die einzelnen Monate:

Tabelle 1: Installierte Windräder und Windstromerzeugung 2014

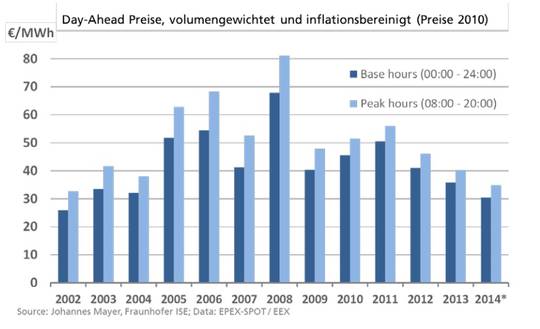

Soll Windstrom eine Versorgungsaufgabe in der Energiewirtschaft übernehmen, muss eine feste Einspeiseleistung, beispielsweise die jahresdurchschnittliche Einspeiseleistung von 79,9 MW für jeden Zeitpunkt des Jahres sichergestellt werden (Grundlast). Aktuell gleichen in Schwachwindzeiten konventionelle Kraftwerke fehlenden Windstrom aus. Herrscht umgekehrt ein Überangebot an Windstrom, muss dieser an der Strombörse in Leipzig europaweit veräußert werden.

Die als eigentliches Ziel der Energiewende formulierte Einsparung von CO2 kann aber nur möglich werden, wenn die Glättung des schwankenden Windstroms an den Bedarf nicht mehr durch fossile Kraftwerke sondern durch Speicherung überschüssigen Stroms erfolgt. Die einzige derzeit für Großanlagen verfügbare Technologie sind Pumpspeicherwerke. Aufgrund ihres großen Platzbedarfs sowie der hohen Herstellungskosten und gravierenden Natureingriffe sind sie aber ungeeignet und neue Speichertechniken für großtechnischen Einsatz werden gesucht. Ob und wann solche Stromspeicher in der erforderlichen Menge verfügbar sein könnten, ist derzeit nicht abzusehen.

Um den Speicherbedarf zum Ausgleich der Schwankungen des Windstroms zu bestimmen, müssen ständig Einspeisung und gewünschte gesicherte Versorgung verglichen und die Abweichungen addiert werden. Der monatlich saldierte Wert ist in der Tabelle als ‘Kumulierter Speicherbedarf’ und als Graph in Diagramm 2 widergegeben. Der größte Füllstand des Speichers ergab sich nach dem windreichen Frühjahr am 14. Mai 19:30 mit 52.069 MWh, das größte Defizit bestand nach dem windschwachen Herbst am 10. Dezember um 6:00 mit -68482 MWh. Um eine autarke Windstromversorgung sicherzustellen, wäre in 2014 also ein Stromspeicher mit einer Kapazität von 120.551 MWh Kapazität erforderlich gewesen. das sind 17,2% der gesamten Windstromerzeugung.

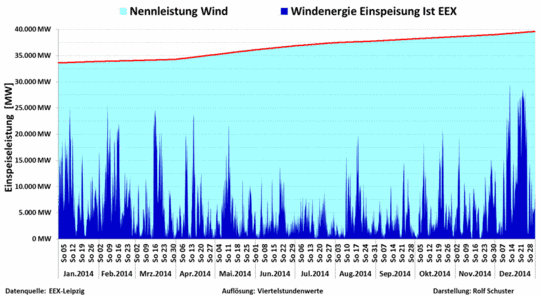

Windstromeinspeisung 2014

Diagramm 1: Windstromeinspeisung (rot) und installierte Nennleistung (grün) im Verlauf 2014

Kumulierter Speicherbedarf Windstrom 2014

Diagramm 2: Speicherbedarf zur Sicherung der mittleren Jahreseinspeiseleistung 79,9 MW

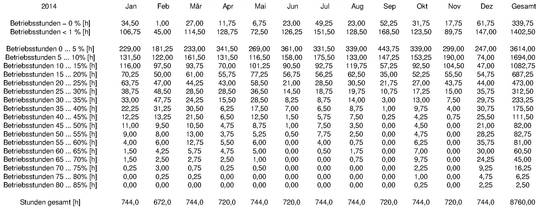

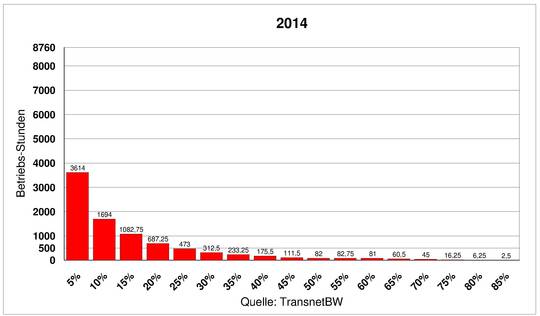

Betriebsstunden nach Windstromleistung

Da Stromspeicher in der notwendigen Größe auf unabsehbare Zeit nicht verfügbar sein werden, ist in Tabelle 2 die Anzahl der Betriebsstunden zusammengestellt, in denen Windstrom bestimmte Quoten der installierten Kapazität erreicht. Hier ist zu ersehen, dass konventionelle Kraftwerke auch weiterhin die meiste Zeit des Jahres fehlenden Windstrom ausgleichen müssen.

339,75 Stunden (= 14,2 Tage = 3,9%) waren windstill (0 MW), es wurde kein Windstrom erzeugt.

1403,50 Stunden (= 58,5 Tage = 16,0%) blieb die Einspeiseleistung unter 7 MW (1%).

3614 Stunden (= 5 Monate = 41,3%) blieb die Erzeugung unter 5% und

5308 Stunden (= 7,4 Monate = 60,6%) blieb Windstrom unterhalb 10% der Nennleistung.

An nur 294,3 Stunden (3,4%) übertrafen die Windräder in BaWü 50% der installierten Leistung:

Tabelle 2: Betriebsstunden der verschiedenenen Windstromeinspeisungsleistungen 2014

Diagramm 3:Betriebsstunden der verschiedenenen Windstromeinspeisungsleistungen 2014

Abschließende Betrachtungen

In Diagramm 1 fällt auf, dass mit Ausnahme des September und November in jedem Monat mehrtägige Zeiten mit besonders starker Windstromerzeugung sich mit mehrtägigen Phasen sehr geringer Windstromausbeute abwechseln. Besonders ausgeprägt sind diese Gegensätze im April, Oktober und vor allem im Dezember 2014. Hier wird nach zunächst 10 Tagen weitgehender Flaute in knapp 3 Wochen ein in über 3 Monaten seit Anfang September aufgebautes Windstromdefizit wieder abgebaut. Diese Zeiten mit stark abweichender Windstromerzeugung vom Jahresdurchschnitt sind auch deutlich an großen Änderungen der Speicherbedarfskurve in Diagramm 2 zu erkennen.

Diagramm 2 liefert aus der Differenz zwischen dem größten Stromspeicherdefizit und -überschuss den Gesamtspeicherbedarf, der erforderlich wäre, damit die Windkraftanlagen Baden-Württembergs gesicherte 79,9 MW Stromerzeugungsleistung bereitstellen könnten. Im Januar, Februar, März, Mai und Dezember lag die monatliche Windstromproduktion teils erheblich über dem Jahresmittel; im April und von Juni bis November lag sie durchgängig darunter. Infolge solcher langandauernden Abweichungen der Monatsproduktion vom Mittel ergab sich für 2014 ein Stromspeicherbedarf von 120.551 MWh, was über 1/6 der gesamten Windstromerzeugung des Jahres entspricht.

Diagramm 3 zeigt die windstrom-typische Leistungs-Zeit-Verteilung. Es fällt auf, dass Windkraft die überwiegende Zeit des Jahres nur sehr geringe Leistungen erzeugte. Über 60% der Zeit lag die Einspeisung unter 10% der Nennleistung und nur 3,4% der Zeit übertraf sie die halbe Nennleistung. Die meist schwache Windstromerzeugung wird auch daran deutlich, dass die jahresdurchschnittliche Einspeiseleistung von 79,9 MW nur 11,8% der insgesamt installierten Nennleistung der Winddräder entspricht. Das ist gleichbedeutend mit 1033,8 Volllaststunden, mit denen die Windstromausbeute in Baden-Württemberg 2014 zwar erheblich über dem windschwächeren Vorjahr mit 809,5 Volllaststunden lag, sie blieb aber weit unter dem Durchschnitt von 1482,5 Volllaststunden (16,9%) für alle Windkraftanlagen in Deutschland (nach Fraunhofer Institut ISE, www.ise.fraunhofer.de).

Um Windstrommangel mit den Überschusszeiten zu bedarfsgerechter Stromerzeugung zu glätten, werden Stromspeicher benötigt, die nach Abzug der Wirkungsgradverluste 120 GWh Kapazität bereitstellen. Das ist eine Strommenge, die der 12fachen Kapazität des Schluchsee-Kraftwerks (10.000 MWh) oder der 600fachen Kapazität der Schwarzenbach-Talsperre (200 MWh) entspricht.

Pumpspeicher

Um bei 80% Wirkungsgrad moderner Pumpspeicherwerke die jahresdurchschnitttliche Windleistung zu sichern, muss die Windleistung um 10% erhöht werden. Dies erfordert den Bau weiterer rund 30 Windräder mit 67,7 MW Leistung für 135 Millionen Euro, die die Speicherverluste ausgleichen. Für den überschüssigen Windstrom müssen dann noch 10 PSW von der Größe des geplanten PSW Atdorf (Kapazität 13 GWh, 1,6 Milliarden Euro, www.schluchseewerk.de/index.php/projekt-atdorf) also Gesamtkosten von rund 16,1 Milliarden Euro aufgewendet werden. Das ist der fast 12fache zusätzliche Investitionsaufwand, den der Bau der Windräder selbst erfordert hat. Die bedarfsgerechte Glättung des für sich alleine nicht netztauglichen Windstroms mit Pumpspeicherwerken würde diesen also auf das 13fache verteuern!

Li-Akkumulatoren

Soll die Glättung mit verlustfrei angenommenen Akku-Speichern wie der kürzlich vorgestellten ‘Ökostrombatterie’ in Schwerin (25.000 Li-Ion-Akkus, 5 MWh Kapazität, 6 Millionen Euro, www.wemag.com) erfolgen, wären 24.110 solcher Anlagen mit Gesamtkosten von 144,7 Milliarden Euro erforderlich! Die extremen Kosten dieser Anlagen spiegeln die von Akkumulatoren bekannte geringe Energie-Effizienz wider. Ein Kommentar über die Sinnhaftigkeit solcher Speicher, die die Windstromkosten also auf das über 100fache steigern würden, erübrigt sich. Überlegungen zur Plausibilität hätte man auch im Bundeswirtschaftsministerium anstellen können, bevor man eine derart energie-ineffiziente und sinnlose Anlage mit 1,3 Millionen Euro Steuergeld subventionierte.

Windgas:

In jüngerer Vergangenheit wird zur Stromspeicherung ein ‘Windgas’ oder ‘Power-to-Gas’ genanntes Verfahren vorgeschlagen. Überschüssiger Windstrom soll durch Elektrolyse in synthetisches Methan gewandelt werden, das im Erdgasnetz zwischengespeichert und bei Windstrommangel in Gas- Kraftwerken rückverstromt werden kann. Es ist jedoch zu beachten, dass bei dem gesamten Prozess selbst unter idealen Bedingungen prinzipiell nur ein Wirkungsgrad von 33% erreicht werden kann. Um die jahresdurchschnittliche Windstromleistung von 79,9 MW zu sichern, müsste deshalb zunächst die Windstrom-Nennleistung um weitere 338,5 MW vereineinhalbfacht werden, was eine Investition von knapp 0,7 Milliarden Euro erfordern würde. Der Bedarf an Anlagen zur P2G-Synthetisierung ergibt sich dann aus der Differenz zwischen der zu sichernden Grundleistung (79,9 MW) und der größten Windstromeinspeisung (569 MW x 1,5) zu 774 MW. E.ON betreibt im brandenburgischen Falkenhagen eine P2G-Pilotanlage (www.powertogas.info). Der Betreiber schätzt, dass bei großtechnischer Umsetzung solche Anlagen mit 2,5 Millionen Euro je MW realisierbar wären. Das würde weitere 2 Milliarden Euro Investition für die Windgaserzeugung erfordern. Da man für die Speicherung auf die bestehende Infrastruktur des Erdgasnetzes zurückgreifen kann und nur wenige Erdgas-Speicher neu errichten müsste, scheint mit den zusätzlichen noch zu installierenden Gas-Kraftwerken mit 79,9 MW Leistung ein gesamtes Investitionsvolumen möglich, das unter idealen Voraussetzungen eine Vervierfachung der Windstromkosten bedeutete. Damit könnte Windgas großtechnisch tatsächlich die günstigste Stromspeichertechnik werden, dennoch sind solche Kosten auf unabsehbare Zeit wirtschaftlich nicht zu bewältigen und belegen, dass auch dieses Verfahren energie-ineffizient ist, denn hohe Kosten sind immer eine Folge geringer Effizienz.

Windstrom kann aus diesem Grund auf unabsehbare Zeit keinen Beitrag zum Ersatz konventioneller Kraftwerke leisten. Diese bleiben unverzichtbar – laufen durch die stark schwankende Einspeisung von Windstrom aber zunehmend unwirtschaftlicher, so dass der Aufbau der doppelten (Wind-)Strominfrastruktur tatsächlich nur große Mengen an Ressourcen und Energie vernichtet.

Wie unwirtschaftlich und folglich energie-ineffizient Windstrom tatsächlich ist, wird deutlich, wenn man den enormen Investitions-Aufwand für Windkraftanlagen und ihren riesigen Flächenverbrauch mit dem neuen hochmodernen Block 8 des Karlsruher Steinkohlekraftwerks vergleicht. Diese Anlage benötigt weniger als 100 Hektar Anlagen-Fläche und ist direkt im Ballungsgebiet gelegen, wo das Gros der Energie gebraucht wird. Das Kraftwerk wurde für 1,2 Milliarden Euro errichtet, was in etwa auch der Investition für die 397 Windräder (676,9 MW, 1033,8 Volllaststunden in 2014) Baden-Württembergs entspricht. Das RDK8 verfügt über 912 MW Strom- und 220 MW Fernwärme-Erzeugung und kann in über 8000 Volllaststunden mehr als 9.000.000 MWh Strom und Fernwärme im Jahr erzeugen. Es liefert damit die über 13fache Energiemenge, die die 397 Windräder Baden-Württembergs im Jahr 2014 erzeugt haben.

Um die Jahresenergiemenge des RDK8 mit Wind herzustellen, müsste man bei äußerst optimistischer Annahme von 2000 Volllaststunden 1875 Windräder ‘Modell Straubenhardt’ (2,4 MW, 5 Mill. Euro) errichten. Das würde mit 9,3 Milliarden Euro den fast 8fachen Investitionsaufwand und einen Flächenbedarf von 187.500 Hektar Wald mit 37,5 Millionen zu fällenden Bäumen bedeuten!

Strom und Fernwärme aus dem RDK8 werden planbar und bedarfsgerecht erzeugt. Damit auch Windstrom versorgungssicher wird, brauchen Windräder Kohle- oder Gaskraftwerke zum Ausgleich. Die Kraftwerke aber laufen als Lückenbüßer in verschwenderischem Stotterbetrieb. Windkraft erspart deshalb weder konventionelle Kraftwerke noch deren Brennstoff! Dies ließe sich erst vermeiden, wenn Strom-Speicherung zum Einsatz käme. Bei Windgas müsste dann die Zahl der Windräder wegen der Wandlungsverluste auf 2813 WKA ausgebaut werden. Insgesamt vervierfachten sich die Kosten der Windstrom-Investition so auf 37 Milliarden Euro. Trotz des kaum noch zu bewältigenden Flächenbedarfs von 2813 Windrädern auf die 36.000 km2 Landesfläche, also eine gleichmäßige Bedeckung des Landes mit 200m hohen Windrädern im Abstand von je 3,5 km, wäre damit erst 1/5 des Strombedarfs von 45 TWh von Baden-Württemberg gedeckt. Die gleiche Versorgungsleistung erbringt alleine das 1,2 Milliarden Euro billige RDK8.

Anmerkung:Hier finden Sie das Datenmaterial für eine mögliche Überprüfung durch Zweifler oder für weitergehende Auswertungen auf der Webseite der BI unter http://www.gegenwind-straubenhardt.de/Auswertung%20Wind%20BW%202014%20Daten.pdf