Die Dinge laufen nicht gut für die Klima Chaos, Inc. Die Umweltbundesbehörde feilt an der Umsetzung ihrer Kohlendioxid-Vorschriften, und Präsident Obama will die Möglichkeiten auf mehr Öl und Gas aus Alaska zu einem Tabu machen. Aber auch sonst ist die Klima-Alarm-Industrie unter Belagerung – und das zu Recht.

Kurz nachdem Obama ihn vor dem bevorstehendem Klimauntergang warnte, kündigte Premierminister Modi an, dass Indien die Kohleproduktion verdoppeln wird (hier) [1], um Strom für 300 Millionen mehr Menschen zu erzeugen. Fracking hat eine neue Ära des Erdölreichtums ins Leben gerufen, so dass es schwieriger wird, Subventionen in erneuerbare Energien zu rechtfertigen.

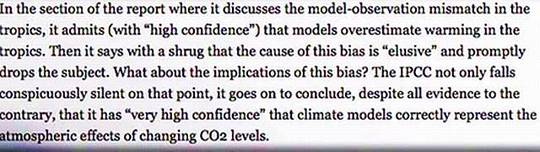

Textgrafik, Auszug aus dem Bericht im Science Bulletin. Übersetzung:

In dem Teil des (IPCC-) Berichts, in dem die Missverhältnisse der Modelle zu den Beobachtungen in den Tropen diskutiert werden, wird eingestanden, dass die Modelle die Erwärmung in den Tropen (mit hoher Wahrscheinlichkeit) zu hoch bewerten. Dann wird mit einem Achselzucken abgetan, dass die Ursache für diese Voreingenommenheit schwer zu fassen ist, und unverzüglich fällt das Thema „unter den Tisch“.

Was ist mit den Konsequenzen dieser Voreingenommenheit? Das IPCC wird nicht nur auffällig still in diesem Punkt, es kommt weiter zu dem Schluss, trotz aller gegenteiligen Beweise, dass es „sehr hohe Zuversicht“ hat, dass die Klimamodelle die atmosphärischen Auswirkungen bei Änderung des CO2 Niveaus korrekt beschreiben.

Die Vorhersagen einer Globalen Erwärmung werden immer amüsanter (hier) [2], bizarrer (hier)[3] und realitätsfremder (hier) [4] gegenüber dem Weltklima und des Wetters. Das IPCC hat eingestanden, dass sein wahres Ziel die Umwandlung der Weltwirtschaft ist (hier) [5] und die Umverteilung des Reichtums (hier) [6]. Immer mehr Menschen erkennen, dass das eigentliche Problem nicht der Klimawandel ist, der schon immer im Laufe der Geschichte stattfindet. Es ist die Politik, die im Namen der Verhinderung von Klimaänderung den Menschen teure Maßnahmen auferlegt die allzu oft Arbeitsplätze vernichten, Armut verewigt und Menschen tötet.

Diese Wahrnehmungen werden durch neuere Studien verstärkt. Man hat belegt, dass Klimaforscher die tatsächlich gemessenen Temperaturen systematisch nach oben revidiert haben, um eine globale Erwärmung für Australien, Paraguay, der Arktis und an anderer Stelle behaupten zu können.

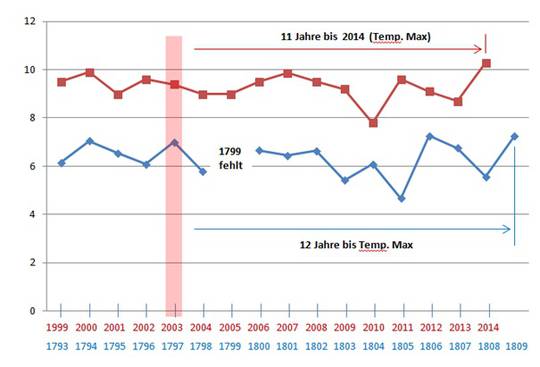

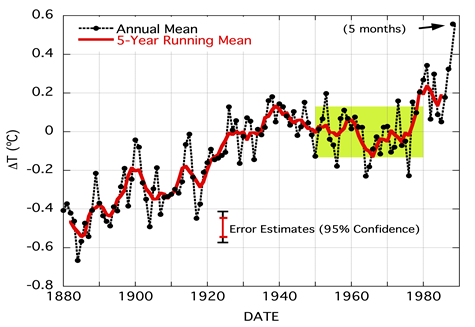

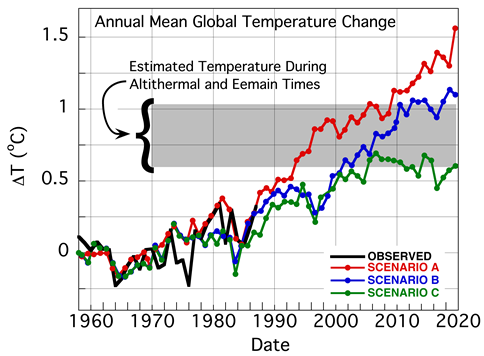

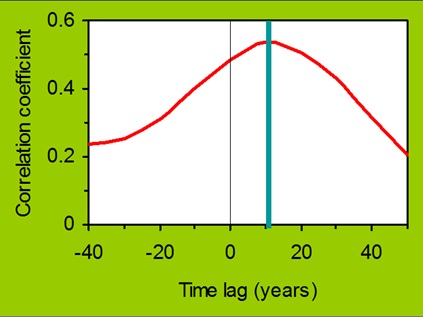

Eine weitere Studie untersucht: "Warum zeigen die Modelle Erwärmung?

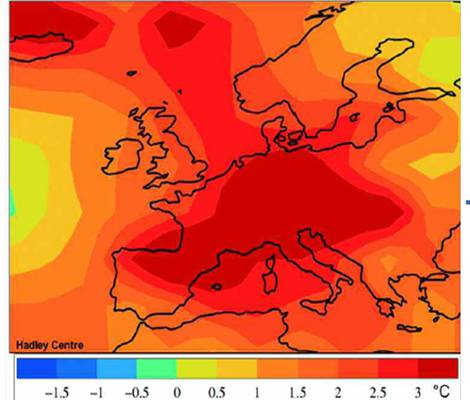

Dieses sind die Ergebnisse von reduzierten und einfachen Klimamodellen. Werden die Diskrepanzen der IPCC-Computermodelle berücksichtigt, so ergibt sich, dass die Auswirkungen der CO2-getriebenen, künstlichen globalen Erwärmung in diesem Jahrhundert (und darüber hinaus) wahrscheinlich „nicht mehr als ein Drittel bis die Hälfte der aktuellen Prognosen des IPCC betragen" – das heißt, nur 1º-2º C bis zum Jahr 2100! Das ist vergleichbar mit den römischen und mittelalterlichen Warmzeiten und wäre von Vorteil, nicht schädlich.

Geschrieben durch Christopher Monckton, Willie Soon, David Legates, und William Briggs, die Studie wurde veröffentlich im Januar 2015 im ScienceBulletin der Chinesischen Akademie der Wissenschaften. Unglaublich, es hat inzwischen mehr als zehntausend Aufrufe erhalten, mehr als jemals andere wissenschaftlichen Arbeiten.

Anstatt diese Veröffentlichung (das paper) zu kritisieren, greifen Klima-Panikmacher die Autoren an. Der geschäftsführende Direktor des Klima-Untersuchungs-Zentrums (und ehemaliger Greenpeace- Spitzenfunktionär) Kert Davies, sagte dem Boston Globe, es kann „einfach nicht wahr sein", dass die Autoren keinen Interessenkonflikt mit ihrer Studie haben in Anbetracht ihrer mutmaßlichen industriellen Finanzierungsquellen und externen Beratungsaufträgen. Davies griff Dr. Soon heraus und unterstellte, dass der Harvard-Forscher mehr als 1 Million Dollar von Unternehmen erhielte, die kritische Studien zu dem von Menschen verursachten Klimawandel unterstützen. Eine verwandte Gruppe startete eine Petition, dass Dr. Soon entlassen werden sollte.

Dr. Willie Soon

Kert Davies‘ verleumderische Behauptungen haben keine Grundlage. Nicht einer dieser vier Autoren erhielt einen Cent in Form von Zuschüssen oder sonstigen Zahlungen (hier) [7] für die Recherche und das Schreiben ihrer Ausarbeitungen zu Klimamodellen. Jeder von ihnen arbeitete daran in seiner Freizeit. Das einzige an das Science Bulletin wegen dessen Bemühungen geflossene Geld wurde für den freien Zugang der Öffentlichkeit zu der genannten Studie ausgegeben, so dass die Leute diese ohne Zahlschranke lesen konnten.

Ich weiß, dass diese Männer und ihre Arbeit, ihre Integrität und Hingabe an die wissenschaftliche Methode über jeden Zweifel erhaben sind. Sie gehen dorthin, wo ihre Forschung sie hinführt. Sie weigern sich, ihre Wissenschaft oder Schlussfolgerungen zu verbiegen, um sich Zuschüsse zu sichern, eine bestimmte Linie auf die globale Erwärmung zu ziehen oder ihre Sichtweisen der Industrie, der Regierung oder Anderen anzupassen.

In Bezug auf Dr. Soon’s unterstellten "Aufzeichnungen der Annahmen von Zuschüssen der Energieindustrie ", gingen $1 Mio über einen Zeitraum von Jahren an das Harvard-Smithsonian Center for Astrophysics, die rund 40% davon für Verwaltungsaufwand kassierte. Die Details sind alle offen in den öffentlichen Aufzeichnungen zu finden. Nicht ein Cent wurde für Ihre Abhandlung verwendet.

Aber da Kert Davies die Fragen zu Geld, Interessenkonflikten und Offenlegung der Finanzierung aufbrachte und wie das Geld angeblich die Wissenschaft beeinflusst – Lassen Sie uns diese Themen von der anderen Seite des Zauns erkunden.

Die Industrie der Klimapanik hat ein riesiges Interesse am Klimaalarmismus – nicht nur am Teil der $1 Mio über einen Zehn-Jahres-Zeitraum, aber an Hunderten Milliarden Dollar aus Politik, Wirtschaft, Stiftungen und andere Quellen während der letzten paar Jahrzehnte. Einiges davon ist offen und transparent, aber viel ist verborgen und verdächtig.

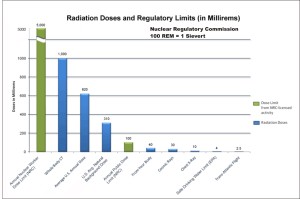

Zwischen 2003 und 2010 hat die US-Regierung allein für Klima und erneuerbare Energieprojekte mehr als 105 Milliarden US-Dollar Steuergelder (hier) [8] ausgegeben. Die Europäische Union und andere Unternehmen spendierten weitere Milliarden. Das meiste Geld ging an Klimamodellierer, Wissenschaftler und andere Forscher und deren Agenturen und Hochschulen; Subventionen für Unternehmen für erneuerbare Energien und für Kreditbürgschaften auf Projekte, für Ausnahmegenehmigungen bedrohter Arten und menschlicher Gesundheitsgesetze und Strafen für Unternehmen die fossile Brennstoffe nutzen. Und sogar an Umweltschutzorganisationen [environmental pressure groups : englisch ist manchmal sehr deutlich, der Übersetzer], die diese Aktionen applaudieren. Diese Umweltaktivisten verlangen nach mehr und treiben die öffentliche Politik.

Weitere Milliarden gingen an staatliche Aufsichtsbehörden, die viele dieser Aktivitäten koordinieren und Vorschriften erlassen, die oft auf geheimnisvoller, trügerischer und vorherbestimmter "Wissenschaft" basieren, Anklagen, ausgedacht von Abzocker John Beale (hier) [9] und anderer Taktierer und dann „prozessieren-und-kassieren“. Politiker erhalten Millionen in Bargeld für ihre Kampagnen und Sachleistungen dieser Organisationen und ihrer Gewerkschaften, um sie im Amt und den Selbstbedienungsladen auf Kurs zu halten.

Die American Lung Association (hier)[10] (ALA amerikanischer Lungenschutzverein) unterstützt die Klimapolitik der US-Umweltbehörde EPA – ALA erwähnte die $25 Mio Zuwendungen von der EPA in den letzten 15 Jahren aber nie. Insgesamt erhielt der ALA in dieser Zeit 591 Zuschüsse der Regierung in Höhe von $ 43Mio., finanzierte Big Green Stiftungen mit zusätzlichen $76Mio und das EPA zahlte $181 Mio an 15 seiner Mitglieder im Clean Air Scientific Advisory (Wissenschaftlicher Beirat für saubere Luft), die regelmäßig mit ihm abstimmen.

Linksaußen-Sponsoren wie die David und Lucille Packard Foundation (Computer), Schmidt Family Foundation (Google), Rockefeller Brothers Fund (Öl), Marisla Foundation (Öl) und Wallace Global Fund II (Anbau) unterstützen Greenpeace und andere Gruppen, um Klimawandel zu Rechtfertigung von Anti-Energie und Anti-Personen Politik zu verwenden. Der Leitende Direktor eines Gas-Unternehmens und ein New Yorker Bürgermeister gab dem Sierra Club $76 Mio für seine Anti-Kohle-Kampagne.

Seit Jahren nutzt Greenpeace (hier) [11] Webseiten von DeSmogBlog, ExxonSecrets, Polluterwatch und anderen Frontgruppen, um Wissenschaftler und andere anzugreifen, die ihre Taktik und Politik herausfordern. Greenpeace USA allein hatte Erträge in Höhe von $ 32.791.149 im Jahr 2012, wie Ron Arnold und ich in Cracking Big Green (hier) [12] feststellten.

Geben Sie Text oder eine Website-Adresse ein oder lassen Sie ein Dokument übersetzen.

Ausgangssprache: Englisch

HINWEIS: DeSmogBlog Geldgeber John Lefebvre bekannte sich schuldig wegen Verschwörung zur Durchführung illegaler Internet-Glücksspiel-Transaktionen und erklärte sich bereit, mit der Staatsanwaltschaft zusammenarbeiten und als Kronzeuge aufzutreten, wenn nötig. Das Gericht verurteilte ihn zur Rückzahlung von $185Mio.)

Andere US-Umweltschutzorganisationen, die Anti-Job-, Anti-Personen-Klimapolitik betreiben, hatten auch in 2012 fette Einkommen: Environmental Defense Fund ($ 111.915.138); Natural Resources Defense Council ($ 98.701.707 ); Sierra Club ($ 97.757.678); National Audubon Society ($ 96.206.883) ; Wilderness Society ($ 24.862.909); und Al Gores Allianzen für Klimaschutz ($ 19.150.215). Insgesamt mehr als 16.000 amerikanische Umweltgruppen sammeln jährlich mehr als $ 13.4Mrd. ein (Zahlen für 2009). Nur ein kleiner Teil davon stammt aus Mitgliedsbeiträgen und Einzelbeiträgen.

Richard Rahn (hier) [13] und Ron Arnold (hier ) [14] wiesen darauf hin, dass eine weitere wichtige Quelle für ihr Geld Wladimir Putins Russland ist . Ein gut dokumentierter aktueller Bericht (hier) [15] zu Allianzen in der Umweltpolitik zeigt, wie mehrere zehn Millionen Dollar von russischen Interessenten offenbar über Wakefield Quinn, Bermuda [führende Kanzlei für Rechtsdienstleistungen, internationale Kundenbasis und wirkt für Firmen und Institutionen, vermögende Privatkunden und Investmentgesellschaften] an Umweltbünde floss, einschließlich der Sea Foundation, an große Öko-Interessengruppen wie der Sierra Club, der NRDC und die Liga der Wählerschützer. Auch das Amerikanische Fortschrittscenter von John Podesta, ehemaliger Berater des Weißen Hauses, nahm Millionen von Sea Change.

Es kommt noch viel empörender. Eine der Websites, die Dr. Soon angreifen, wird von George Soros (hier ) [16] finanziert; es wird hart gearbeitet, um die Meteorologen, die mit Klima-Panikmache nicht einverstanden sind, zu knebeln. Und um das Ganze abzurunden, reichte Kert Davies eine FOIA-Anfrage gegen Dr. Soon und sechs andere Klimawissenschaftler ein und verlangte, dass sie alle ihre E-Mails und Finanzierungsunterlagen veröffentlichen. Aber währenddessen hält er die Finanzierung seines Klima-Untersuchungs-Zentrum top secret (die Website ist bei Greenpeace registriert und das Zentrum ist als Rainbow Warriors front group (hier) [17] bekannt). Und die Wissenschaftler, die immer alle unsere Steuergelder bekommen, behaupten dagegen, ihre Rohdaten, Computercodes, und die CO2–treibenden Algorithmen wären Privateigentum und von FOIA und sogar US-Kongress-Anfragen ausgenommen.

Lassen Sie uns auf jeden Fall Ehrlichkeit, Integrität, Transparenz und Rechenschaftspflicht in unserer Klima-Wissenschaft und den regulatorischen Prozessen der Politik fordern. Beenden Sie die Interessenkonflikte, führen Sie lebhafte Debatten, und stellen Sie sicher, dass solide Wissenschaft unsere öffentlichen Gesetze und Richtlinien bestimmt (und nicht die Regierung, Stiftungen oder Russisches Bargeld).

Und lassen Sie uns dort beginnen, wo das große Geld und die Macht zu finden sind.

Erschienen auf cfact am 12. Februar 2015

Übersetzt durch Andreas Demmig für das EIKE

Link: http://www.cfact.org/2015/02/12/vilifying-realist-science-and-scientists/

Im Originaltext vorhandene Verlinkungen der Quellenangaben

[1] http://articles.economictimes.indiatimes.com/2015-01-29/news/58586736_1_coal-output-plan-generation-renewable-portfolio

Das Versprechen Indiens zum Klimawandel behindert nicht den Plan seiner Kohleförderung

NEU-DELHI: Indien ehrgeizige Pläne, die Kohlenförderung zur Stromerzeugung um mehr als das Doppelte zu erhöhen wird die Erwärmung nicht antreiben, so die Aussagen von Ministerpräsident Narendra Modi zur Bekämpfung des Klimawandels. Ironischerweise hat die Kohlenstoff emittierende Energieform Schutz vor den Plänen der Regierung ihre Solarstromkapazität zu verfünffachen. Um Kohle wurde einen großen Bogen gemacht in der Obama Klima- und Energie Abmachung..

[2] http://www.numberwatch.co.uk/warmlist.htm

Eine komplette Liste der durch die globale Erwärmung hervor gerufenen Dinge

Unzählige Links weisen auf viele, viele Webseiten hin, komplett kann das m.e. nie werden– lohnt sich für lange Abende.

Hier nur ein kleiner Auszug mit grober Übersetzung:

AIDS, Wetterkapriolen zerstört afghanischen Mohn, afrikanischer Brandopfer, Alte Menschen von mehr Todesfällen bedroht, Mohnpflanzen werden fruchtbarer, Afrika’s Wüsten wachsen, Afrika in Konflikt, wucherndem Unkraut, Air France Absturz, Luftblasen, Luftdruckänderungen, Flughafen Malaria, Agulhas Strom , Alaska Städte langsam zerstört, al-Qaida und Taliban geholfen, Allergie Anstieg, Allergie-Saison länger, Alligatoren in der Themse, Alpen schmelzen, Amazon eine Wüste, amerikanischen Traum am Ende, Amphibien Brut schlüpft früher (oder auch nicht), anaphylaktische Reaktionen auf Bienenstiche, Urwälder dramatisch verändert, Tiere gehen in die Berge, Tiere schrumpfen, Antarktis Gras gedeiht, Antarktis wächst, Antarktis schrumpft, antarktisches Meeresleben in Gefahr, Angst Behandlungen nehmen zu, Algenblüten, archäologische Stätten bedroht, Arktis schmilzt, Arktis in voller Blüte, Arktis eisfrei, Eis der Arktis schmilzt schneller, Arktische Seen verschwinden, arktische Tundra verloren, Erwärmung der Arktis findet nicht statt, eine Rose riecht nach nichts, Asteroiden Treffer Risiko, Asthma, Atlantic weniger salzig, Atlantic salziger, atmosphärische Zirkulation modifiziert, Angriff der Killer-Quallen, Lawinengefahr reduziert, Lawinengefahr erhöht,

[3] http://wattsupwiththat.com/climate-fail-files/

Datei der Klimafehler

Diese Seite führt die Klimawissenschaft und die Klimafolgen-Behauptungen auf, die entweder nicht bewiesen oder geändert, verschoben oder erweitert wurden um den Autor davor zu schützen, zuzugeben, dass die ursprüngliche Aussage falsch war. – Beispiele werden weiter fortgesetzt

https://www.cfact.org/wp-content/uploads/2014/09/Climate-Hype-Exposed.pdf

Klima Übertreibungen offengelegt

UNO und Obama-Regierung fördern Pseudo-Wissenschaft um eine Politik zu rechtfertigen, die Energie, Arbeit, Freiheit verletzt – und die Menschen

[5] http://thehill.com/blogs/pundits-blog/energy-environment/232229-the-climate-comintern-speaks

Weiterer Bericht über “UN Offizielle enthüllt den wahren Grund der Erwärmungs-Panikmache“, siehe auch http://tinyurl.com/o5azqkf

[6] http://wattsupwiththat.com/2010/11/18/ipcc-official-%E2%80%9Cclimate-policy-is-redistributing-the-worlds-wealth%E2%80%9D/

Thema wie [5] jedoch schon vom 18.Nov. 2010: IPCC-Beamter: "Die Klimapolitik ist das Neuverteilen des Reichtums der Welt"

[7] http://www.climatedepot.com/2015/01/29/monckton-ridicules-allegations-of-conflict-of-interest-against-dr-willie-soon/

Monckton spottete über die Behauptung, es gäbe einen Interessenkonflikt bei Dr. Soon,

ein offener Brief an den Herausgeber des Science Bulletin, Dr Zhang Li

Im Text weiter unten: Es scheint, wir haben jetzt eine neue Mafia am Werk, mit Namen Greenpeace. Und die Regierungen und die unehrlichen Geschäftsführer arbeiten gemeinsam mit Greenpeace, wie ein organisiertes Verbrechersyndikat.

[8] http://www.forbes.com/sites/larrybell/2011/08/23/the-alarming-cost-of-climate-change-hysteria/

Die alarmierenden Kosten der Klimawandelhysterie

Der oberste US Rechnungshof (GAO) kann keine Vorteile angeben, die Steuerzahler bekommen haben, für die Milliarden von Dollar die jedes Jahr durch die Politik ausgegeben werden, angeblich zur Bekämpfung des Klimawandels.

[9] http://junkscience.com/?s=beale

Eine Zusammenstellung mehrerer Vorkommnisse, wie das EPA mit den Aufgaben seinen Mitarbeitern schwindelt, diese für wenig Arbeit geschmiert werden. Mr. Beale war jedoch auch für andere grüne Organisationen tätig. Die Machenschaften flogen auf, Beale muss für 36 Monate in Gefängnis und rd. $1 Mio zurückzahlen. Er wird jedoch weich fallen, so wie andere vor ihm.

[10] http://www.globalwarming.org/2014/06/15/american-lung-association-manipulates-maternal-instinct-to-sell-epa-power-grab/

Die American Lung Association (ALA) manipuliert in einer TV und Anzeigenkampagne den "Mutterinstinkt „ um für den EPA Clean Power-Plan zu werden, der die Kohlenstoff "Verschmutzung" für bestehende Kraftwerke einschränkt..

[11] http://townhall.com/columnists/pauldriessen/2014/07/15/greenpeace-showcases-its-antihuman-side-n1862066

Greanpeace zeigt seine unmenschliche Seite

Interview, eher jedoch ein Verhör, von Paul Driessen durch Greenpeace Aktivist Connor Gibson . Nach anfänglichem Geplänkel über Fakten der Realität und deren Ignorierung durch Gibson kam das Gespräch auf die Finanzierung von cfact. Driessen konterte jedoch mit Wissen über die hohen Summen die Greenpeace und andere NGO’s bekommen. „In der Tat, Gibson wollte die zerstörerischen und auch tödlichen Wirkungen der Politik und Kampagnen von Greenpeace nicht wirklich diskutieren.“

[12] http://www.amazon.com/Cracking-Big-Green-Save-Earth-ebook/dp/B00O4F3F22

Link zu einem Buch von Ron Arnold und Paul Driessen: Knackt die Big Green: Rettet die Welt vor der Rettet-die-Erde Geldmaschine.

[13] http://www.washingtontimes.com/news/2015/feb/2/richard-rahn-vladimir-putin-funding-opposition-to-/

Die russische Geld-Pipeline

Welches Land hat das größte Interesse die Expansion der Öl- und Gasindustrie in Europa und Nordamerika zu stoppen? Antwort: Die Russische Föderation in hohem Maße – in der Höhe von mehreren hundert Milliarden Dollar.

[14] http://dailysignal.com/2015/02/04/obama-rejects-arctic-oil-gas-drilling-putin-preparing-come-take/

Obama lehnt Arktische Öl- und Gasbohrungen ab. Ist Putin bereit, das zu übernehmen?

[15] https://www.biggreenradicals.com/wp-content/uploads/2015/01/Klein_Report.pdf

PDF, Klein Report: Am 30. Juli 2014 stellte US Senat-Ausschuss für Umwelt und öffentliche Arbeiten ein Minderheitsbericht mit dem Titel vor: "Die Kette der Umwelt Befehle: Wie ein Club der Milliardäre und Ihre Stiftungen die Umweltbewegung und Obamas EPA kontrollieren. " Der 92-seitige Bericht detailliert ein Lügennetz des "dunklen Geldes" von ausländischen Investitionen in die amerikanische Umweltbewegung über eine Stiftung namens Sea Foundation.

[16] http://wattsupwiththat.com/2012/01/22/ForecastTheFacts-org-political-activists-gagging-our-tv-meteorologists-on-climate-issues/

Politische Aktivisten knebeln unsere TV-Moderatoren bei Klimathemen

Jemand oder eine Organisation versucht, die bevorstehenden Jahrestagung der Amerikanischen Meteorologischen Gesellschaft (AMS) zu beeinflussen.

"Dies ist ein wichtiger Moment in der Geschichte des AMS", sagte Daniel Souweine, Direktor der Kampagne. "Es ist allgemein bekannt, dass eine große Zahl von Meteorologen Klimawandel-Leugner sind. Es ist wichtig, dass das AMS Council dem Druck dieser Leugner widersteht und eine starkes Statement übergeben, welches derzeit geprüft wird. "

[17] http://www.greenpeace.org/canada/en/About-us/The-new-Rainbow-Warrior-is-coming-home/

Web Seite von Greenpeace, Werbung und Aktivitäten der Regenbogen-Krieger

![]()