H i s t o r i e

Bereits in den 70er Jahren wurde eine "2°-Marke" bei historischen Klima-Betrachtungen erwähnt [2]:

"William D. Nordhaus (Yale University), einer der weltweit führende Klima-Ökonomen, führte im Jahr 1975 erstmals die 2°C-Marke als kritische Grenze der Erderwärmung an. Er begründete dies mit Hilfe des normalen Bereichs langfristiger Klima-Änderungen der letzten Hunderttausende von Jahren. In diesem Zeitraum seien Schwankungen von ± 5 °C aufgetreten."

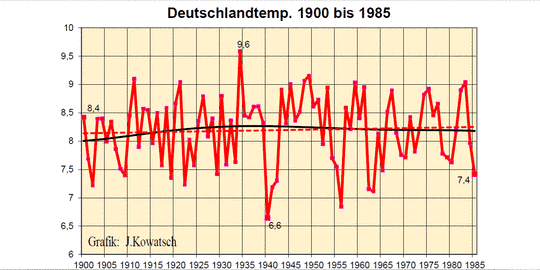

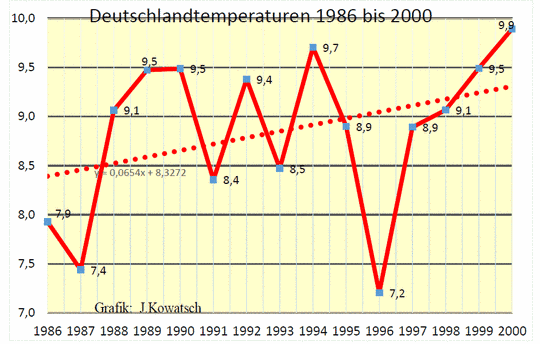

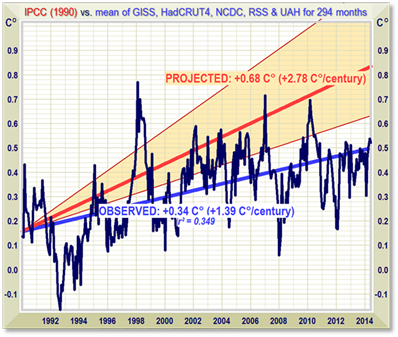

Diese damalige Überlegung hatte noch keinen Bezug zur derzeitigen AGW-Katastrophen-Debatte, denn zu dem Zeitpunkt (1975) befanden wir uns mitten drin in einer Phase zweier Jahrzehnte globaler Abkühlung [3], die auch in den Medien drastisch reflektiert wurden [4]:

"Kommt eine neue Eiszeit ? … Katastrophe auf Raten …".

In neuerer Zeit war es dann der nach seine Gründung 1992 zunehmend ideologisierte und alarmistische "Wissenschaftliche Beirat der Bundesregierung Globale Umwelt-Veränderungen" (WBGU), der im Rahmen der seinerzeit beginnenden CO2-Klima-Hysterie schon frühzeitig über irgendwelche "zu regulierenden Temperatur-Ziele" bei der Klima-Erwärmung philosophiert hat, wobei man dort 1995 zunächst findet [5]:

"Aus der Analyse der ökologisch und ökonomisch vermutlich noch tragbaren Belastungen durch Klimaänderungen wird zunächst ein "Toleranzfenster" für die zulässigen Klimaentwicklungen festgelegt. Ökologische Grenzen ergeben sich dabei aus der Maximaltemperatur und den Temperaturgradienten, an die sich die Biosphäre noch anpassen kann."

A.a.O. ist jedoch selbst im Kapitel "A.1.1. Tolerierbare Belastung für Natur und Gesellschaft" das <2°-Ziel> noch nicht auffindbar. Lediglich einer Graphik (Abb.A1 a.a.O.) ist ein "Tolerierbarer Akzeptanzbereich für ein Temperaturfenster“ zu entnehmen : 1,3 Grad zwischen To ("derzeitige mittlere globale Temperatur 15,3°C") und Tmax ("Tolerierbarer Akzeptanz-Bereich 16.6°C").

Das <2°-Ziel> wird dann beim WBGU erstmals 1997 ausdrücklich dokumentiert [6]:

"Eine Erwärmung um mehr als 2°C (bezogen auf den vorindustriellen Wert) bzw. eine Erwärmungsrate von mehr als 0,2°C pro Dekade kennzeichnen demnach Klima-Änderungen, die in keinem Fall als tolerierbar angesehen werden."

Diese <2°> tauchen dann weiterhin auf in all den zahlreichen WBGU-Folgeberichten [7]. Diese umfassen Tausende und Abertausende Seiten – mit Anhängen, Erläuterungen, Hunderten von Graphiken und Tabellen. Der Aufwand an Zeit und Geld war und ist gigantisch. Ob all das wohl jemals jemand durch gelesen hat ? Der Autor hier hat es versucht, auf der Suche nach der "Erfindung" des <2°-Zieles> : Gähnende Langeweile und Erschöpfung breiten sich aus, denn neben den naturwissenschaftlichen Betrachtungen und daraus "abgeleiteten" Spekulationen und Horror-Szenarien für eine trotz alledem ungewisse Klima-Zukunft enthalten die WBGU-Papiere auch zahlreiche philosophische, religiöse ("Schöpfungsbewahrung") und nahezu esoterischen Passagen.

Jedoch – das ist nicht Thema dieses Aufsatzes hier.

Sehr bald schon hat sich dann die Politik dieser naturwissenschaftlich u.E. aberwitzigen und absurden Zahl bemächtigt, allen voran die "Klima-Rettungs-Oberlehrer" Deutschland und EU [8] :

"Die Europäische Union propagiert das 2-Grad-Ziel in ihrer Klimapolitik bereits seit dem Jahre 1996 und hat es im Jahre 2007 in den Mittelpunkt der ersten europäischen Energiestrategie gerückt."

Eine darüber hinaus gehende, politische Protokollierung erfolgte im Juli 2009 auf dem G-8-Gipfel in L’Aquila [9] :

“L’Aquila – Die großen Industriestaaten sind sich im Klimaschutz zumindest ein wenig näher gekommen: Auf dem G-8-Gipfel im italienischen L’Aquila haben sich die USA, Kanada, Japan, Deutschland, Großbritannien, Italien, Frankreich und Russland zu dem Ziel bekannt, den globalen Temperaturanstieg im Vergleich zum Beginn des Industriezeitalters auf zwei Grad Celsius zu begrenzen.“

Ganz anders beim Klimarat, wo in den IPCC-Berichten zunächst bis 2009 die "2-Grad-Marke" als ZIEL nicht erwähnt wird [10]:

"Im 4. IPCC-Sachstands-Bericht findet sich … keinerlei eindeutige Bezugsnahme auf eine Zielmarke von 2 Grad Celsius"

Das wird bestätigt in einer ausführlichen Analyse von Deutsches Institut für Internationale Politik und Sicherheit Berlin: Abkehr vom 2-Grad-Ziel [11] :

"Schon der jüngste IPCC-Report (Anm.: hier 2009) legt sich hinsichtlich einer Interpretation des in Artikel 2 UNFCCC genannten Stabilisierungsziels keineswegs fest, nicht auf eine spezifische Zielkategorie, erst recht nicht auf konkrete Höchstwerte. Der 4. Sachstandsbericht diskutiert vielmehr ergebnisoffen die Vor- und Nachteile für sechs mögliche Zielkategorien, …".

Ähnlich verhält es sich auch weiterhin im jüngsten IPCC-Bericht 2014.

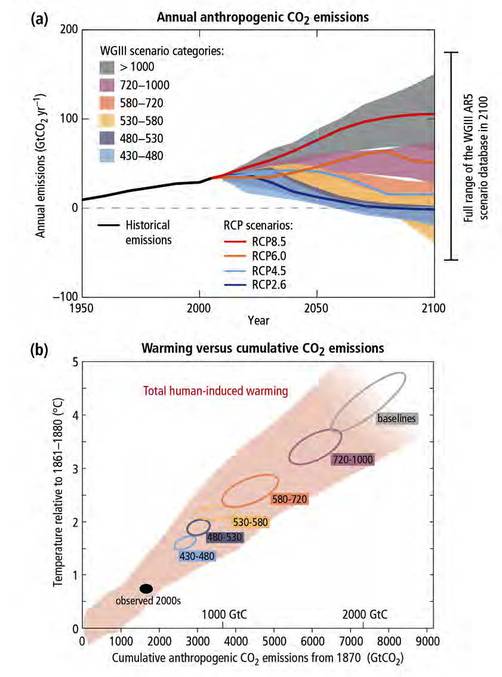

Die "2°-Marke" wird dort zwar erstmals im SPM des AR5 im Jahre 2014 erwähnt [12] :

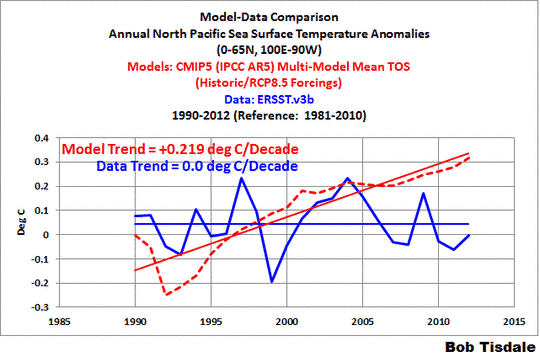

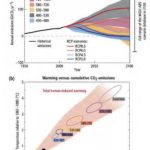

"Scenarios without additional efforts to constrain emissions (“baseline scenarios”) lead to pathways ranging between RCP6.0 and RCP8.5. RCP2.6 is representative of a scenario that aims to keep global warming likely below 2°C above preindustrial temperatures (Figure SPM.5.a+b)."

J e d o c h :

Der dazu angeführte Bezug ist wiederum, wie schon in den Vorberichten, lediglich eine Abbildung (Fig. SPM.5.a+b" ; vgl. Abbildung). Auch diese enthält das <2°-Szenario> wiederum nur als eines von sechs, wie schon in den w.o.a. IPCC-AR’s von 2001 und 2009 !

Fig. SPM.5 (IPCC 2014; http://tinyurl.com/nlf2gbe)

Folglich:

Das IPCC führt die "2-Grad-Debatte" nur als eine Möglichkeit von vielen; sehr viel zurückhaltender, als das bei den "Ober-Alarmisten" in Deutschland und bei der EU getan wird, wo die <2-Grad-Modell-Variante> zum <2-Grad-Ziel> mutiert wurde.

Bemerkenswert auch, daß selbst die ohnehin sehr alarmistischen jährlichen UNO-Klimakonferenzen (COP’s seit 1995) das <2-Grad-Ziel> nicht erfunden haben, sondern offensichtlich erst dem politischen Mainstream in Deutschland und EU – zunächst zögerlich(!) – ab 2009 folgten [8] :

"Jedoch wurde es von den 194 Teilnehmerstaaten der 15. UN-Klimakonferenz in Kopenhagen im Jahre 2009 lediglich zur Kenntnis genommen und ist somit nicht als rechtlich bindendes Ziel anerkannt."

Erst ab 2010 gab es dann bei den UN-COP’s kein Halten mehr [13]:

"2009 wurde das Ziel im Abschlußdokument der UN-Klimakonferenz in Kopenhagen aufgegriffen und auf der UN-Klimakonferenz in Cancún (Mexiko) im Dezember 2010 erstmals offiziell akzeptiert."

Das beinhaltet jedoch keinerlei völkerrechtliche Anerkennung oder gar Festschreibung, was jüngst 2014 auch wieder beim Deutschen Bundestag nachzulesen war [14]:

"Der Forscher (Anm.: H.-J. Schellnhuber) forderte daher im Namen des WBGU, das Zwei-Grad-Ziel rechtsverbindlich zu verankern. Bisher sei dieser 2010 in Cancun getroffene Beschluß in keiner Weise völkerrechtlich abgesichert."

Bei alledem:

Die rein politisch dominierten jährlichen UN-Klima-Konferenzen (COP 1-20 ; Berlin 1995 … Lima 2014) dürfen nicht verwechselt werden mit den IPCC-Konferenzen, auf denen die nur alle 5-7 Jahre erscheinenden Klimarat-Reports präsentiert werden.

Während auf den UN-COP’s seit einigen Jahren das <2°-Ziel> nun plakativ propagiert wird, spielt in den IPCC- Berichten und diesbezüglichen Konferenzen diese <2-Grad-Marke> keine hervor gehobene Rolle, sondern erscheint nur als ein Szenario von vielen. Zumindest das darf man dem sonst eher alarmistischen Klimarat IPCC zu Gute halten.

Das ist wissenschaftlich auch folgerichtig, denn in einem Arbeitspapier des Deutschen Instituts für Internationale Politik und Sicherheit Berlin werden nochmals die vielen Unsicherheiten von Modellen und Klimafolgen klar gestellt [11] :

"In der erkennbaren Tendenz zur Vereindeutigung der Ursache-Wirkungs-Ketten wird auf Seiten von Klimapolitik und Medienöffentlichkeit zumeist ausgeblendet, daß nicht nur Aussagen über die konkreten Folgen eines Temperaturanstiegs um 2 Grad mit einem hohen Maß an Unsicherheit behaftet sind. Auch die Schätzungen über das Ausmaß des Zusammenhangs der atmosphärischen Konzentration von Treibhausgasen und dem Anstieg der globalen Durchschnittstemperatur weisen eine sehr hohe Bandbreite auf, die sich zudem von Klimamodell zu Klimamodell deutlich unterscheiden können."

Die weiter oben differenzierte Diskussion zu den IPCC-Szenarien verdeutlicht das im Detail.

W a r u m ausgerechnet "genau" 2 Grad ?

Es gibt Tausende von Artikeln, Publikationen, Medien-Aufsätzen aller Art über diese Zahl.

J e d o c h :

Eine wissenschaftlich abgeleitete quantifizierbare Berechnung und Begründung zu dieser "ausgewählten" Zahl existiert nirgendwo !

Stattdessen wird drumrum geredet, philosophiert, schwadroniert, geplappert, geschwätzt … und über allerlei Minderungs-Quoten von CO2 und der anderen Treibhaus-Gase spekuliert und geschwafelt, um ein solches <2-Grad-Ziel> zu erreichen. Eine wissenschaftlich auch nur halbwegs überzeugende Berechnung für ausgerechnet diese Zahl gibt es nicht, und kann es auch aus physikalischen Gründen gar nicht geben! Auch beim IPCC ist es stets nur ein Szenario von vielen.

Es wird hier nicht als lohnenswert erachtet, einzelne Zitate aus der unüberschaubaren <2-Grad-Ziel-Debatte> heraus zu greifen und zu diskutieren und zu kommentieren. Jeder kann sich selbst im WEB von all diesem Durcheinander und Unfug ein Bild machen.

Man kann diese <2-Grad-Lotto-Zahl> durch eine "x-beliebige" andere Zahl ersetzen, gegebenenfalls nach oben oder unten nahezu beliebig verschieben, mit Komma-Stellen versehen oder auch nicht. Die zu Tausenden auffindbaren "Behauptungen und Erläuterungen" dazu passen zu allem – und letztlich zu NICHTS!

F a z i t :

Es handelt sich um eine politische und ideologische Zahl,

die wissenschaftlich absurd und nicht begründbar ist !

So kann es nicht Wunder nehmen, daß es dazu eine Fülle von kritischen Publikationen und Kommentaren seriöser Wissenschaftler gibt, die sogar bis in die "Alarmisten-Szene" hinein reichen.

Einige Beispiele seien in Folgendem aufgeführt :

"Internationaler Konsens" : Kritik und auch Spott für das <2-Grad-Ziel>

() Prof. Horst Malberg (eh. Dir. d. Inst.f.Meteorologie, FU Berlin) [15] :

"Wie ideologisch vermessen muß man sein, um der Natur ein „2-Grad-Ziel“ vorzugeben. Der dominierende solare Einfluss auf unser Klima in Verbindung mit dem thermischen Gedächtnis des Ozeans wird sich auch dann nicht ändern, wenn sich der Mensch als Zauberlehrling versucht."

() Prof. Hans von Storch (Dir.Inst.f.Küstenf. HH) [16] :

“Politik darf sich nicht hinter angeblich wissenschaftlichen Notwendigkeiten verstecken – solche Notwendigkeiten gibt es nicht in der Klimapolitik, auch nicht das Ziel der Begrenzung der Erwärmung auf 2 Grad relativ zum vorindustriellen Zustand.“

() Prof. Martin Claußen (Max-Planck-Institut für Meteorologie in Hamburg) [17]:

"Das Ziel, die Erderwärmung auf zwei Grad gegenüber dem vorindustriellen Zeitalter zu begrenzen, sei politisch begründet, aber nicht wissenschaftlich; allenfalls Wissenschaftler, die die Nähe zur Politik suchten, sähen dies anders. Was Claußen meint: Wissenschaftler, die apokalyptische Horrorszenarien entwerfen, erlangen Schlagzeilen. Und Wissenschaftlern mit kurzem Draht zur Politik winken Drittmittel.“

() Prof. Reinhard Hüttl (Direktor GFZ Potsdam) [18]:

"Wie wir gesehen haben, besteht das System Erde aus einer Vielzahl von Teilsystemen. Das Klima ist eine der Schnittstellen, auf die Prozesse in Atmosphäre, Hydrosphäre, Geosphäre, Biosphäre und Anthroposphäre einwirken. Unsere Forschungen geben uns ständig neue und überraschende Einsichten in diese Prozesse und ihre verzweigten Wechselwirkungen, und wir sind immer noch weit davon entfernt, sie vollständig zu verstehen.

Vor diesem Hintergrund erscheint die Annahme, wir könnten die aktuelle Entwicklung durch Reduktion der vom Menschen verursachten Treibhausgasemissionen bis 2050 auf zwei Grad begrenzen, als fragwürdig. Eine tatsächliche Erreichbarkeit dieses Zwei-Grad-Ziels läßt sich wissenschaftlich nicht begründen, dafür sind im Gesamtsystem Erde zu viele Variablen im Spiel, und auch der Teilkomplex Klima selbst besitzt eine hohe Eigendynamik."

() Prof. Claus Leggewie (Dir.Kulturwiss.Inst.Essen) u. Prof. Reinhard Leinfelder (FU Berlin) [19]:

“Die Zwei-Grad-Leitplanke ist im politischen Jargon zum Zwei-Grad-Ziel mutiert … wer dann einen (Anm.: "einen bestimmten“) Temperaturanstieg als Leitplanke setzt, bleibt zwar Wissenschaftler. Er wird dabei aber zwangläufig politisch, und somit Partei eines Interessenkonfliktes.“

() Nahezu vernichtend für das <2-Grad-Ziel> ist die Kritik von drei DirektorenInnen namhafter Wissenschafts-Institute [20] in einem sehr ausführlichen Interview in der FAZ [21]:

“Drei große deutsche Geo-Insitute stellen sich quer zur internationalen Klimapolitik. Statt nur über Temperaturen und Emissionen sollte über ein Erdsystem-Management verhandelt werden, sagen die drei Direktoren. In Kürze soll das auf der gemeinsamen Konferenz „Klima im System Erde" in Berlin besprochen werden. Im Gespräch erläutern sie ihre Motive.“

MOSBRUGGER: "Wir wissen zu wenig, um sagen zu können, wo die Schwellenwerte für die wichtigsten Klimaelemente liegen. Das Problem, vor dem wir stehen, ist viel komplizierter als nur ein Klimawandel. Wir müssen das gesamte System in Betracht ziehen."

….

HÜTTL: "Das Klima ist dynamisch. Im Laufe der Erdgeschichte gab es immer wieder dramatische Veränderungen, die weit über eine solche Grenze von plusminus zwei Grad hinausgingen. Und das war allein auf natürliche Faktoren zurückzuführen."

……..

HÜTTL: "Wärmephasen waren nicht immer katastrophal. Sie haben auch zur Artenvielfalt beigetragen. Oder schauen Sie sich die Entwicklung vom Homo sapiens seit der letzten Warmphase vor 150 000 Jahren an. Unsere Spezies hat in dieser Zeit den Klimawandel gemeistert. Wir sind außergewöhnlich anpassungsfähig. Nur haben wir zuletzt eben eine glückliche Situation mit relativ stabilem Klima gehabt. Daher kommt sicher auch die Forderung nach der Zwei-Grad-Grenze. Das ist politisch wünschenswert, aber aus geowissenschaftlicher Sicht nicht haltbar."

…………

MOSBRUGGER: "Jetzt ausschließlich auf Emissionsreduktionen zu setzen, ist unklug. Wir müssen uns darauf einzustellen, daß sich das System immer verändert."

…………

LOCHTE: "Die Auflösung der Modelle ist nicht perfekt. Je weiter man in die Vergangenheit zurückrechnet, um so problematischer wird das. Das gilt auch für Hochrechnungen in die Zukunft."

…………..

HÜTTL: "Aus geowissenschaftlicher Sicht wird deutlich, daß wir grundsätzliche Zusammenhänge noch nicht verstehen."

……….

HÜTTL: "Die Politik konzentriert sich derzeit fast ausschließlich auf die Kohlendioxid-Reduktion. Wir wissen aber, daß das System Erde komplex ist. Es gibt natürliche Effekte, die wir so nicht einfach kontrollieren können, wie wir uns das vorgestellt haben."

…………..

MOSBRUGGER: "Es ist kein Erdsystem-Management, wenn man sich nur auf einen Parameter fokussiert."

…..

D a s war und ist "starker Tobak" für die "2-Grad-Alarmisten" – und zwar von kompetenter Stelle !

Und das ausgerechnet v o r dem UNO-Klima-Gipfel in Kopenhagen im Dezember 2009.

So ist es nicht verwunderlich, daß es einen "Alarmisten-Aufschrei" gab [22]:

“Merkel will am Klimagipfel teilnehmen und so ihr politisches Gewicht in die Waagschale werfen. Da kommt es höchst ungelegen, wenn Forscher die Sinnhaftigkeit des 2-Grad-Limits anzweifeln. Genau das aber taten drei führende deutsche Geowissenschaftler“.

… u.w.a.a.O. im FOCUS

“Dem widersprechen vier namhafte Klimaforscher um den Fachbereichsleiter Peter Lemke vom Bremerhavener Alfred-Wegener-Institut. Das Interview löse großes Befremden aus, schreiben sie in einem Kommunique.“

Nahezu pikant dabei ist es, daß sich Peter Lemke (AWI) gegen seine eigene Chefin artikulierte.

D a n n passierte d a s [23]:

"Der Kopenhagener Klimagipfel ist vollständig gescheitert: Der von 30 Ländern erstellte Entwurf einer Abschluß-Erklärung wurde in der Vollversammlung vorgestellt – und unter wütenden Protesten zerrissen."

Danach zeigte selbst die "Klima-Kanzlerin" Angela Merkel Wirkung [24]:

"Doch ausgerechnet jetzt vollzieht Kanzlerin Angela Merkel eine Wende in der Klimapolitik.

Noch im Dezember sagte sie: ‚Wenn es uns nicht gelingt, die Erwärmung auf zwei Grad zu begrenzen, dann werden die Kosten für die eintretenden Schäden um ein Vielfaches höher sein als das, was wir mit einer Änderung unserer Lebensweise jetzt erreichen können.‘

Nun gilt: Merkel wird international nicht mehr versuchen, das Zwei-Grad-Ziel vertraglich durchzusetzen, also mit rechtlich verbindlichen Werten für die Reduktion von Treibhausgasen zu versehen. Sie will sich nicht wieder eine Abfuhr holen, weil sie erkannt hat, daß wichtige Länder auch beim nächsten Mal nicht mitziehen werden. Das wurde ihr vor zwei Wochen bei Nukleargipfel in Washington von chinesischen Präsidenten Hu Jintao und vom indischen Premier-Minister Mammohan Singh bestätigt. Deutschland muß nun die Grenzen seines Einflusses einsehen. Die Klimapolitik war ein Versuch, auf der großen Bühne eine Führungsrolle zu spielen. Doch die anderen sind nicht gefolgt. …

Der Kollaps von Kopenhagen hat Merkel nachhaltig verstört …. So eine Demütigung hatte sie selten erlebt … Merkel läßt im Kreis ihrer höherrangigen Kollegen erkennen, daß sie von europäischen Alleingängen nichts mehr hält“.

Wenige Monate später – im April 2010 – reibt man sich dann die Augen, denn einige der deutschen "Ober-Alarmisten" scheinen in Kopenhagen nicht dabei gewesen zu sein, sondern auf einem ganz anderen Kongreß, wenn man vom PIK-Chef H.-J. Schellnhuber et al. in der ZEIT [25] liest:

“2 Grad und nicht mehr ; Der Kopenhagen-Accord richtet die internationale Klimapolitik zum ersten Mal an einer konkreten Zahl aus.“

Nur: D i e s e n “2°-Accord“ gab es dort in Kopenhagen nicht, und es gibt ihn bis heute nicht, wie alle folgenden UNO-Konferenzen gezeigt haben – bis zur "COP Lima 2014" !

D a s belegen die weiter oben dargelegten Aussagen von namhaften Naturwissenschaftlern, von denen man wohl niemanden den "bösen Klima-Skeptikern" zuordnen kann.

Sogar innerhalb der alarmistischen Wissenschafts-Diskussion gibt es allmählich ernst zu nehmende Analysen, die sich kritisch mit dem <2-Grad-Ziel> auseinander setzen. Dazu gehört ein im WEB publiziertes 20-seitiges Arbeitspapier von Deutsches Institut für Internationale Politik und Sicherheit Berlin mit dem bemerkenswerten Titel "Abkehr vom 2-Grad-Ziel" [11].

Bevor wir hier einige u.E. beachtenswerte Überlegungen daraus zitieren, sei angemerkt: Es handelt sich um eine bezüglich der CO2-Klima-Katastrophen-Hypothese vollkommen im IPCC-Mainstream gehaltene Arbeit :

"Die hier angestellten Überlegungen dürfen keinesfalls als Plädoyer für eine spezifische Variante der Re-Formulierung des derzeit zentralen klimapolitischen Globalziels mißverstanden werden."

Dennoch präsentieren die Autoren innerhalb des AGW-Mainstreams selten zu lesende naturwissenschaftliche Wahrheiten:

"Das 2-Grad-Ziel … fungiert als zentraler Referenzpunkt der Klimadebatte, mit der bemerkenswerten Besonderheit, daß (Klima-)Politiker durchgängig darauf verweisen, es handele sich dabei um ein wissenschaftlich abgesichertes oder gar von der Wissenschaft vorgegebenes Ziel, während Klimaforschern bewußt ist, daß das 2-Grad-Ziel genuin politischer Natur ist." [a.a.O.: Fußnote 2 auf S.3].

…und weiter a.a.O. zum "2°-Ziel" :

"Aktiv treten für eine solche Leitplanke jedoch nur Teile der scientific community ein. Während das „Intergovernmental Panel on Climate Change“ (IPCC) in seinen viel beachteten Sachstandsberichten auf ein Plädoyer für das 2-Grad-Ziel verzichtet, tritt etwa der „Wissenschaftliche Beirat der Bundesregierung Globale Umweltveränderungen“ (WBGU) bereits seit Mitte der1990er Jahre für eine solche Zielbestimmung ein."

"Der 2-Grad-Konsens ist innerhalb der Klimapolitik inzwischen derart stabil, daß die Konstruktionsmodi dieser Schranke kaum noch Gegenstand einer öffentlichen Thematisierung sind, geschweige denn einmal kritisch diskutiert werden würden."

…u.w.a.a.O.:

"Wissenschaftlich ist der Versuch, eine eindeutige Grenze zwischen gefährlichem und ungefährlichem Temperaturanstieg zu ziehen, unhaltbar – das wird selbst von denjenigen Klimaforschern, die das 2-Grad-Ziel politisch unterstützen, nicht bestritten. Vorhersagen darüber, welche globale Durchschnittstemperatur in einigen Dekaden gerade noch „sicher“sein wird, lassen sich nicht zuverlässig treffen".

U.a.a.O. zu "Globaltemperatur" :

"So ist im klimapolitischen Diskurs kaum präsent, daß eine "globale Durchschnitts-Temperatur“ selbstverständlich nicht existiert, daß es sich dabei um ein – wenn auch nützliches – wissenschaftliches Konstrukt handelt."

"Bei der „Herstellung“ der globalen Durchschnittstemperatur müssen die Werte von Tausenden über den Globus verteilten Meßstationen sinnvoll zueinander in Beziehung gesetzt werden. Dementsprechend wird nicht einfach der nominelle Durchschnittswert der gemessenen Temperaturen ermittelt, sondern vielfach eine theoriegeleitete Anpassung dieser Meßwerte vorgenommen, um verfälschende Faktoren zu nivellieren, etwa die regional ungleiche Verteilung der Meßpunkte oder die zunehmende Besiedlung der Umgebung von Meßstationen (Trenberth et al. 2007)."

….womit der kaum irgendwo herausgerechnete Wärme-Insel-Effekt angesprochen wird, der zu einer Verfälschung der berechneten Global-Temperatur hin zu höheren(!) Werten führt.

Schließlich soll hier den Lesern eine glossierende Betrachtung des Wissenschafts-Journalisten Dirk Maxeiner zum "2°-Ziel" nicht vorenthalten werden [26]:

"Eine Politik, die nicht in der Lage ist, die Krankenkassenbeiträge zu stabilisieren, gibt nun vor, die Welttemperatur in 100 Jahren um 2 Grad regulieren zu können. Und das Schöne dabei: Man kann mit dem sogenannten Klimaschutz alles rechtfertigen, jedes Verbot, jeder Steuererhöhung. Kurz: Man kann die Menschen auf einen Horizont niedriger Erwartungen einstimmen. Also auf etwas, was man ohnehin für geboten hält. Während die Menschen die Stabilisierung der Gesundheitskosten innerhalb einer Wahlperiode überprüfen können, ist eine Erfolgskontrolle beim Klimaschutz – wenn überhaupt – erst in 100 Jahren möglich. Eine beruhigende Aussicht für jeden Politiker, der wiedergewählt werden will."

Der in allen "Lagern" anerkannte und geachtete Mathematiker und Klimaforscher Hans von STORCH, einer der Pioniere der ersten Klima-Modelle beim Max-Planck-Institut in Hamburg, bringt es auf den Punkt – kurz & klipp & klar [27] :

“Zwei Grad ist eine politische,

eine sinnlose Zahl.

Ich halte das für Verarschung“ !

Danke – d a s genügt !

Klaus-Eckart Puls

==================================================================

N a c h t r a g :

Der ganze "2-Grad-Unfug" hatte im Januar 2015 wieder mal einen Gipfelpunkt im SPIEGEL-ol. erreicht [28]:

"Studie zur Klimaerwärmung: Diese Brennstoffe müssen im Boden bleiben :

Wenn die globale Erwärmung unter zwei Grad bleiben soll, dürfen 80 Prozent der Kohlevorkommen nicht gefördert werden – das haben britische Forscher errechnet. Auch die Produktion von Öl und Gas müßte eingeschränkt werden."

Dazu werden dann wieder einmal ellenlang all die untauglichen, geheuchelten, verlogenen, wirtschafts-feindlichen, dümmlichen …. Thesen zur Welt-Klima-Rettung ausgebreitet !

==================================================================

Q u e l l e n :

[1] Wissenschaftlicher Beirat der Bundesregierung Globale Umweltveränderungen, Gründung 1992

[2] http://www.kwis-rlp.de/index.php?id=7584

[3] http://www.cru.uea.ac.uk/documents/421974/1301877/Info+sheet+%231.pdf/52a8dd1d-8c4d-49f7-b799-6448fff27150

[4] DER SPIEGEL, 33 (12.08.1974), S.38-48

[5] Szenario zur Ableitung globaler CO2-Reduktionsziele und Umsetzungsstrategien, S.29 :

http://www.wbgu.de/fileadmin/templates/dateien/veroeffentlichungen/sondergutachten/sn1995/wbgu_sn1995.pdf

[6]http://www.wbgu.de/fileadmin/templates/dateien/veroeffentlichungen/sondergutachten/sn1997/wbgu_sn1997.pdf ; S.15

[7]http://de.wikipedia.org/wiki/Wissenschaftlicher_Beirat_der_Bundesregierung_Globale_Umweltver%C3%A4nderungen#cite_note-26

[8] http://www.kwis-rlp.de/index.php?id=7584

[9] http://www.spiegel.de/politik/ausland/0,1518,635136,00.html

[10] http://www.swp-berlin.org/fileadmin/contents/products/arbeitspapiere/Arbeitspapier_2_Grad_Ziel_formatiert_final_KS.pdf ; Mai 2010, Fußnote 2 auf S.3

[11] Deutsches Institut für Internationale Politik und Sicherheit Berlin; Forschungsgruppe EU-Integration; Stiftung Wissenschaft und Politik; Oliver Geden: Abkehr vom 2-Grad-Ziel; Skizze einer klimapolitischen Akzentverschiebung; Mai 2010; http://tinyurl.com/m5n9mvm

[12] http://ipcc.ch/pdf/assessment-report/ar5/syr/SYR_AR5_SPMcorr1.pdf

[13] http://wiki.bildungsserver.de/klimawandel/index.php/2-Grad-Ziel

[14] Deutscher Bundestag: Umwelt, Naturschutz, Bau und Reaktorsicherheit/Fachgespräch – 03.12.2014; http://www.bundestag.de/presse/hib/2014_12/-/343954 und http://tinyurl.com/lwe9k6w

[15] Beitr. z. Berliner Wetterkarte, 28.9.2010, 58/10, SO 26/10, http://www.Berliner-Wetterkarte.de

[16] Hans von Storch: Die Nachhaltigkeit der Klimaforschung; Hannover Messe, 23.4.2010; 10-min-Statement; Seite 1, http://www.hvonstorch.de/klima/pdf/Hannover%20Messe.pdf

[17] FAZ, 12.02.2010, Eine Ungewisse Welt, Klimaimperative und Klimakonjunktive, Eine Schadensbesichtigung nach Kopenhagen

[18] Hüttl, R. F. J., Ein Planet voller Überraschungen, Spektrum Akademischer Verlag (2011), S. 8/10

[19] FAZ, 21.04.2010, S. N2

[20] Karin Lochte, Direktorin am Alfred-Wegener-Institut für Polar- und Meeresforschung; Reinhard Hüttl, Direktor am Deutschen Geoforschungs-Zentrum GFZ in Potsdam; Volker Mosbrugger, Direktor am Senckenberg-Forschungsinstitut und Museum in Frankfurt

[21] FAZ, 28.10.2009: “Ein Limit von zwei Grad Erwärmung ist praktisch Unsinn“

[22] FOCUS, 48/2009, 23.11.09, S.60

[23] http://www.spiegel.de/wissenschaft/natur/gipfel-in-kopenhagen-plenum-zerfetzt-kompromiss-papier-a-668086.html ; 19.12.2009

[24] DER SPIEGEL, 17/2010, Schlacht bergauf, S.34-36 ; http://www.spiegel.de/spiegel/print/d-70228760.html

[25] DIE ZEIT,15.04.2010, S.30; H.-J. Schellnhuber, C. Leggewie und R. Schubert : Zwei Grad und nicht mehr;

[26] D. Maxeiner, Hurra, wir retten die Welt", WJS-Verlag, 2007, S.103

[27] DIE ZEIT, 20.08.2009, S.29

[28] http://www.spiegel.de/wissenschaft/natur/klima-wieviel-kohle-erdgas-und-erdoel-darf-noch-gefoerdert-werden-a-1011767.html ; 08.01.2015

==================================================

Anmerkung der EIKE-Redaktion:

Der vorstehende Aufsatz ist hier als Anhang (PDF) zum Download verfügbar

===================================================

Related Files