Energiewende Hauptakteur Graichen gesteht: Wir haben uns geirrt!

Der Artikel titelt mit „Schmutziger Irrtum”: “Wir haben uns geirrt bei der Energiewende“, um dann weiter in Auslegung der Äußerungen von Patrick Graichen [1] – wenn auch nur indirekt und nach Frank Drieschners Erinnerung oder Einschätzung [2] daraus zu folgern:

Graichen sagt kurz gefasst: Nicht in ein paar Details, sondern in einem zentralen Punkt. Die vielen Windräder und Solaranlagen, die Deutschland baut, leisten nicht das, was wir uns von ihnen versprochen haben. Wir hatten gehofft, dass sie die schmutzigen Kohlekraftwerke ersetzen würden, die schlimmste Quelle von Treibhausgasen. Doch das tun sie nicht…

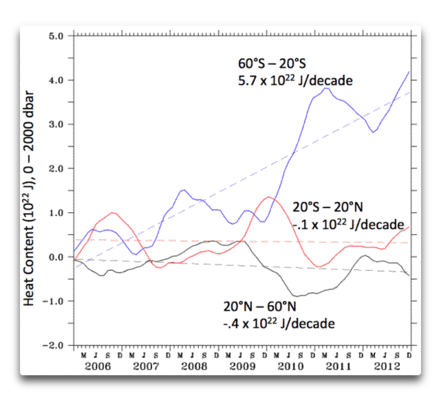

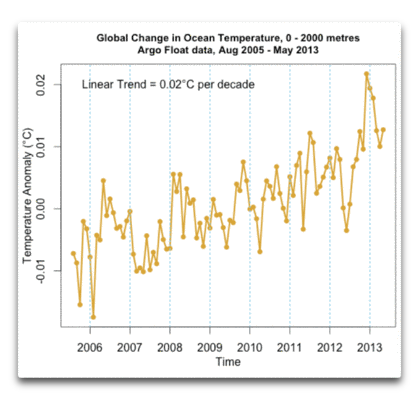

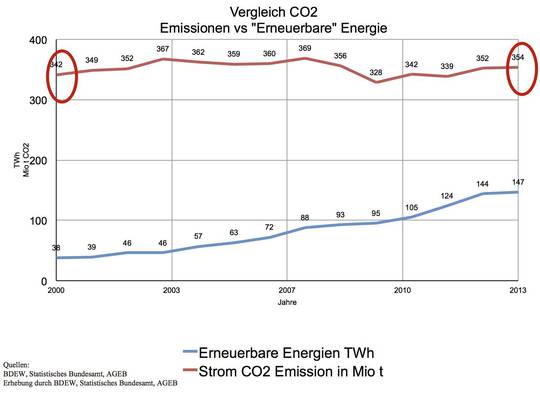

Abb. 1 Entwicklung der der EE-Stromerzeugung in TWh vs strombedingter Erzeugung von CO2 Emissionen in (Mio t) in Deutschland von 2000 bis 2013 (Grafik Limburg EIKE, Daten siehe Grafik)

und weiter schreibt Drieschner…

Um den Irrtum zu verstehen, muss man sich noch einmal den Grundgedanken der Energiewende vor Augen führen. Der ging ungefähr so: Deutschland steigt aus der Nuklearenergie aus und setzt stattdessen auf erneuerbare Energien, auf Sonne und Wind vor allem. Wenn es mal nicht genug Ökostrom gibt, dann springen Emissionsarme Gaskraftwerke ein, bis irgendwann auch diese überflüssig werden. Der böse Atomstrom verschwindet zuerst, als Nächstes der schmutzige Kohlestrom, die Luft wird sauberer, und Deutschland wird zum Vorbild und Vorreiter beim Klimaschutz.

So haben sich das alle gedacht. Nur leider wird daraus nichts. Das ist der Irrtum, den Patrick Graichen beklagt.

………...»Im Nachhinein ist das alles logisch«, sagt Graichen. »Trotzdem hat hier vor drei, vier Jahren keiner diese Logik so durchschaut. «

Nur zur Erinnerung, es ist derselbe Graichen dessen AGORA Institut noch im September des Jahres in einer Studie die seltsame aber „wissenschaftliche“ Logik verkündete, dass… „der Ausbau der „Erneuerbaren“ auf Stromspeicher nicht warten muss“ [3].

…und weiter unten schreibt Drieschner dann…

…Die Energiewende würde nicht funktionieren: Wer es wissen wollte, der konnte es wissen, auch damals schon. Aber wer wollte es wissen? Rund um die Erneuerbaren ist in den vergangenen Jahren ein regelrechter politisch-industrieller Komplex herangewachsen. Sein Einfluss ist wahrscheinlich nur dem Geflecht zwischen Staat und Atomwirtschaft im vergangenen Jahrhundert vergleichbar. Alle Akteure in diesem Komplex verbindet ein Interesse: Probleme der Energiewende müssen lösbar erscheinen, damit die Wind- und Sonnenbranche weiter subventioniert werden.”

Diese Erkenntnisse sind aber weder neu, noch wurden sie geheim gehalten, noch hätte sie den Akteuren unbekannt bleiben dürfen. Denn nicht nur bei EIKE wurden sie seit Jahren öffentlich thematisiert, sondern auch durch Legionen von Fachleuten, die sich auf allen öffentlichen Foren und Kanälen dazu äußerten. Deswegen kann man sie getrost als typisch frechen Akt eines im Politikbetrieb erfahrenen Akteurs und Nutznießers einordnen: nämlich dann, wenn man ertappt wurde, nur das zuzugeben, was sich vor aller Welt auf keinen Fall mehr leugnen lässt und es Folge höherer Gewalt darzustellen. So auch Graichen, aber nicht nur der.

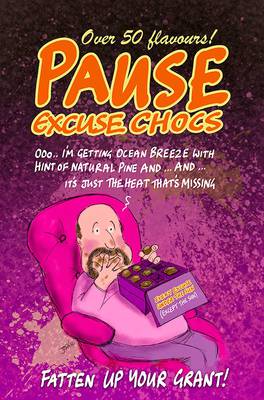

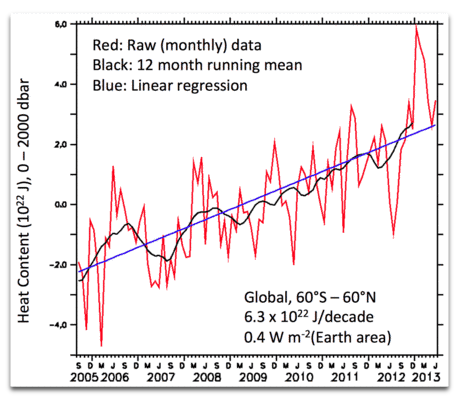

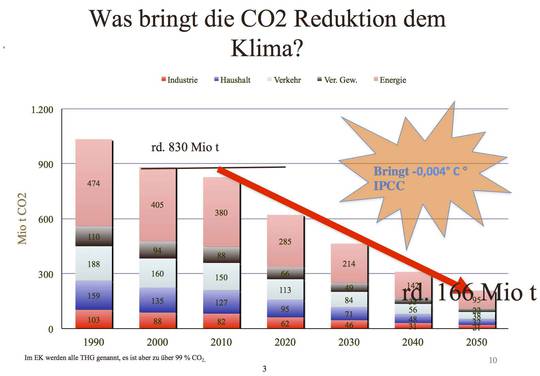

Abb. 2: "Klimawirkung" der in D hypothetisch eingesparten CO2 Emissionen bis 2050 lt. Klimaplanung der Regierung auf den ebenso hypothetischen modellierten Temperaturanstieg nach IPCC Vorgaben (Klimasensitivität von ~3,5 °C). Der simulierte Anstieg würde um 0,004 K geringer ausfallen. Die CO2 Wirkung ist dabei mit nicht vorhandener Rückkoppelpung angenommen, die das IPCC aber voraussetzt. Diese Berechnung setzt auch voraus, dass der gesamte Zuwachs an Konzentration 1. anthropogen ist 2. der deutsche Anteil daran 2,5 % beträgt. Anders ausgedrückt: Was Deutschland bis 2050 im Laufe von rd. 35 Jahren einsparen will, kompensieren die BRIC-Länder (insbesondere dabei China) in weniger als einem Jahr (Quelle http://wattsupwiththat.com/2012/11/23/a-graphical-look-at-worldwide-co2-numbers/)

Denn gerade in der ZEIT, der Hauspostille für beamtenrechtlich gut versorgte Lehrer, Träger von Bio-Sandalen sowie für anderweitige, staatsnahe grüne Profiteure von der harten Arbeit anderer Leute, war die Forderung nach mehr „Klimaschutz“ und mehr „Erneuerbare“ wider alle Fakten das tägliche Brot und wurde mit grün-ideologischer Inbrunst unter die Leute gebracht. Sachkenntnis hingegen über die technisch/naturwissenschaftlichen Grundlagen der Energiewende und deren Hauptbegründung (dem angeblich anthropogen verursachten Klimawandel) waren nicht nur Fremdwörter sondern Unwörter. Die Belege für diese fragwürdige Berichterstattung sind im ZEIT Archiv aufzufinden, stellvertretend insbesondere die Verleumdungskampagnen gegen EIKE (hier, hier) – unsere Kommentierung dieser für eine hochwertige Zeitung peinlichen Machwerke (hier).

Deshalb weiß DIE ZEIT zwar auch jetzt nur, dass etwas mächtig schief läuft, aber vielleicht dämmert es ihr wenigstens, dass auch ihre eigene Berichterstattung dazu kräftig beitrug.

Was aber ist da schiefgelaufen? Am guten Willen aller Propagandisten und Profiteure der Energiewende lag es wohl kaum, denn wer von ihr profitiert – und das sind nicht wenige – hatte diesen Willen. Auch ideologische Defizite können es nicht gewesen sein, schließlich kam eine Frau Claudia Kemfert häufig und ausführlich in der ZEIT zu Wort: als höchst gehandelte „Expertin“ der Energiewende, von der sich viele Leute inzwischen freilich fragen, wie diese Dame zu ihrer Professur gelangte. Nein, guter Wille zur Weltrettung und Vorbildfunktion Deutschlands in Energiewende und Klimaschutz waren vorhanden, das war es sicher nicht. Es waren noch nicht einmal politische Management-Fehler. Politiker können nämlich bekanntermaßen noch ganz anderen Unsinn zusammenmanagen, ohne dass gleich eine Katastrophe eintritt.

Nein, es waren ganz einfach das Ausblenden oder gar das komplette Fehlen elementarer Kenntnisse der Grundlagen und Regeln von Technik, Naturwissenschaft und elementarer Kostenrechnung, die zum sich inzwischen deutlich abzeichnenden Energiewende-Desaster führten. Es hat sich in der Politik und in fast allen deutschen Medien (welcher Redakteur hat schon einen naturwissenschaftlich/technischen Ausbildungshintergrund) immer noch nicht ausreichend herumgesprochen, dass man zwar fast straflos alle wirtschaftlichen und finanztechnischen Regeln über Bord werfen darf und sich an gegebene Zusagen nicht zu halten braucht (Soli, Maastricht-Vertrag etc.), sich dagegen das gleiche Vorgehen in technischen Umsetzungen unvermeidbar und brutal rächt. Wasser kocht auf Meereshöhe eben bei 100 °C, es denkt gar nicht daran bei 60 °C zu kochen, bloß weil es irgendwelche unkundigen Politiker und die diese Leuten unterstützenden Journalisten und Redakteure so wünschen.

Die Stichworte "zu geringe Leistungsdichte" der grünen Energieträger (Sonne und Wind) und "Volatilität des grünen Stromangebots" (letzteres auch noch zufällig), müssten eigentlich schon ausreichen. EIKE hat über diese beiden Themen in bereits kaum noch zählbaren Artikeln sachlich korrekt und zutreffend berichtet. Insbesondere DIE ZEIT, aber auch alle anderen deutschen Medien geruhten, noch nie davon Notiz zu nehmen. Diese ideologische Arroganz holt sie nun ein. Aus den beiden Grundnachteilen folgt keineswegs, dass die Energiewende nicht prinzipiell machbar wäre (Frau Barbara Handricks benötigt zu dieser Erkenntnis keinen Nobelpreis, s. hier). Sie ist aber nicht mit auch nur ansatzweise vertretbaren Kosten machbar. Ferner geht es mit Windrädern, deren Höhe heute schon das Ulmer Münster überschreiten, ohne massive Naturschädigung nicht ab. Und die Vermaisung unserer Äcker schädigt dann noch einmal unsere Natur. So verbohrt kann eigentlich niemand sein, dies zu übersehen. Anscheinend aber doch, denn anders ist die bisherige Entwicklung der Energiewende nicht zu erklären. Doch halt, wir haben die Profiteure der Energiewende und von Klimaschutz übersehen. Wenn wir ihren Druck auf die Politik mit ins Kalkül ziehen, hellt sich das Erscheinungsbild etwas auf.

Folgerichtig und erwartungsgemäß musste mit Fortschreiten der Energiewende und seiner gesetzlichen Basis (EEG) die Vernichtung der deutschen Stromerzeuger einhergehen. Diese können unter den Voraussetzungen des EEG nicht überleben. Die betroffenen Vorstände und Aufsichtsräte haben viel zu spät die volle Wucht der kommenden Entwicklung erkannt und es in der Vergangenheit vorgezogen, sich der Politik mit Öko-Observanz anzudienen. Solche Fehleinschätzungen sind aus der deutschen Vergangenheit zwar bestens bekannt, aber aus tödlichen Fehlern kann man hierzulande anscheinend nicht lernen. Insofern sollte sich das Mitleid mit den betroffenen Unternehmensführungen, nicht aber mit den unschuldigen Mitarbeitern, die ihren Arbeitsplatz verlieren, in Grenzen halten

Nachdem nun E.ON aufgegeben und der Politik den Bettel vor die Füße geworfen hat, braucht man kein Hellseher zu sein, um vorherzusagen, dass weitere Versorger folgen werden. Und es werden (hoffentlich) auch endlich die Gewerkschaften begreifen, was hier abläuft und auf die Straßen gehen. Die Gewerkschaften scheinen nach Einschätzung der beiden Autoren dieses Beitrags die einzig verbleibende Kraft zu sein, die es vermögen, die Politik endlich zur Raison zu bringen. Doch auch da scheint bisher der reine Opportunismus zu dominieren, denn anders ist nicht zu erklären, warum VERDI nur die Überführung der Versorger in Staatsbesitz fordert, statt den vollen Ausstieg aus der Energiewende. Denn damit würde die Katastrophe nur verschleiert, ihre Kosten auf den Steuerzahler direkt verlagert und die Agonie durch eine völlig ungeeignete Krücke, beschönigend „Kapazitätsmarkt“ genannt, nur verlängert.

Die Kosten einer so total verqueren Politik, verantwortet von einer Naturwissenschaftlerin, die es wissen müsste, werden wir alle unter keinen mehr zu behebenden Umständen tragen müssen. Zudem wird, wenn sich bald nichts Grundlegendes ändert, unsere industrielle Basis untergehen. "Kleinigkeiten" wie das Scheitern der South-Stream Pipeline geraten beim Mega-Desaster "Energiewende" fast schon aus dem Blickfeld. Noch törichter ist wohl das sture Festhalten der Kanzlerin am tödlich kostspieligen Klimaschutz. Die Tatsache, dass selbst NULL-Emissionen von deutschem CO2 durch wenige Wochen CO2-Emissionen der BRIC-Länder (China, Indien, Brasilien) kompensiert werden, sollte einer rechnenden Physikerin eigentlich geläufig sein.

Es ist infolgedessen unerfindlich, was unsere Kanzlerin zu diesen Fehleinschätzungen treibt. Trotz der massiven Schädigung unserer Industriestruktur infolge ihrer Politik ist sie immer noch die beliebteste Politikerin – laut Umfragen. Sie nimmt billigend den Exodus der deutschen Grundstoffindustrie und den Verlust deutscher Arbeitsplätze in Kauf. Ist einmal die Grundstoffindustrie weg, wird es auch mit dem Maschinenbau und der Autoindustrie bergab gehen. Auch hier haben wir freilich wieder etwas übersehen – einen Machterhaltungswillen, der anscheinend vor nichts zurückschreckt. Damit ist das Erscheinungsbild nicht mehr ganz so unverständlich.

Braunkohle ist der einzige fossile Energielieferant über den Deutschland in großen Mengen und zu günstigen Preisen abbaubar, verfügt. Es ist ein Schatz auf dem wir sitzen. Und wir werden die klassischen fossilen Braunkohlekraftwerke weiterhin dringend brauchen, da wir ja die weltweit sichersten Kerkraftwerke wegen zu hoher "Gefährlichkeit" in den Mülleimer warfen und dabei Hunderte von Milliarden Euro einfach so in Luft auflösten. Die für die Stabilität der Stromnetze zutreffend als "Gift" zu bezeichnende Fluktuation der "Erneuerbaren" wird nach wie vor auch Gaskraftwerke erfordern, deren Kosten aber nun der Steuerzahler übernehmen muss. Letztlich läuft dies alles auf eine unvermeidbare Verstaatlichung der Stromerzeugung hinaus, deren Kosten ins Unermessliche ansteigen werden (siehe Beispiel DDR).

Die einzigen sachgerechte Optionen, nämlich das EEG samt Energiewende in die Tonne zu treten, sowie die Restlaufzeiten unserer sicheren Kernkraftwerke wieder zu nutzen und die Forschung von modernen Kernkraftwerken (schnelle Brüter) wieder aufzunehmen, wagt derzeit keine politische Partei auch nur zu denken. Noch nicht einmal die FDP oder die AfD, und doch ist diese Option für das wirtschaftliche Wohlergehen und die Naturschonung unseres (noch) schönen Deutschlands die einzig sachlich richtige. Jedes Jahr sterben auf Deutschlands Straßen mehr als 3000 Menschen, durch vermeidbare Bakterienverseuchung und schlechte Hygiene in unseren Krankenhäusern mehr als 30.000, so die Schätzungen. Seit Nutzung der Kernenergie kam hierzulande noch niemand ums Leben. Und weltweit sind es weniger als 150, Tschernobyl eingeschlossen (hier). Warum schalten wir dann die Kernkraftwerke ab und geben nicht besser den Straßenverkehr oder die Krankenhäuser auf?

Mit der “Energiewende“ und dem noch unsinnigeren “Klimaschutz“ werden ohne Sachverstand und mit deutscher Gründlichkeit nur unsere Wirtschaft, unsere Landschaften und unsere Natur ruiniert. Vorteile gibt es keine. Der Laie kann dies infolge unserer Medien, die sich fast alle zu freiwilliger Selbstgleichschaltung mit dem Klima- und Energiewendewahn entschlossen haben, nur schwer durchschauen; zumindest solange nicht, ehe Windräder vor seinem Haus, ein längerer Black-Out oder seine Stromrechnung ihm die Augen öffnen. Dann wird es zu spät sein. Freilich sollte wenigstens jeder nicht ganz auf den Kopf gefallene Naturschützer erkennen, dass Windturbinen für Flugtiere tödlich sind. Zumindest die Natur- und Tierschützer unter uns müssten daher die moralische Verpflichtung verspüren laut zu protestieren.

Nach historisch bekanntem Muster sieht die Mehrheit der deutschen Bevölkerung nicht nur zu, sondern begrüßt die schädliche Entwicklung auch noch. Infolgedessen werden nicht einmal mehr politische Mehrheiten benötig. Freiwillig und vorauseilend öffnen Behörden und Bürgermeisterämter ihre Türen der Ökobewegung. Man will nicht bei den Letzten sein und vom Subventionskuchen möglichst viel abbekommen. Und man möchte natürlich wiedergewählt werden. Der Konformitätsdruck ist inzwischen so groß, dass sich eine ehemals wertkonservative große Volks- und Regierungsparteien das Zerstörungswerk ihrer schärfsten politischen Gegner zu Eigen machen. Der ursprünglich als emotionales Zugpferd eingesetzte Natur- und Umweltschutz ist für die Ökoideologie längst lästig und überflüssig geworden. Die Zerstörungen unserer Wälder, um Platz für riesige Windradungetüme zu schaffen, zeigen es. Man hat den Umweltschutz sang- und klanglos aufgegeben.

Die deutsche Intelligenz in Medienredaktionen, Hochschulen und Führungsetagen von Unternehmen, die diese Entwicklungen, die entstehenden Ökostrukturen und deren mafiose Seilschaften nicht billigt, schweigt, duckt sich weg und versucht sogar zu profitieren. Man fürchtet, gegen die übermächtige Ökobewegung keine Chancen zu haben. Man erkennt, wie die Ökobewegung sich die Unterstützung der Mehrheit der deutschen Medien und der Politik gesichert hat. Zum wiederholten Male in der deutschen Geschichte verweigert sich die deutsche Intelligenz dem entschiedenen Widerstand gegen Entwicklungen, deren Unheilspotential nicht zu übersehen ist. Die Gründe für das Gewährenlassen von Bewegungen mit undemokratischen Zielen waren und sind hierzulande immer die gleichen: Unterschätzung der Gefahr, Bequemlichkeit, Karriere-, Konsens- und Profitstreben. Zivilcourage ist kein deutsches Wort.

[1] Dr. Patrick Graichen hat Volkswirtschaftslehre und Politikwissenschaft studiert und am Interdisziplinären Institut für Umweltökonomie der Universität Heidelberg über kommunale Energiepolitik promoviert. Von 2001 bis 2012 hat er im Bundesumweltministerium gearbeitet – zunächst im Bereich der internationalen Klimapolitik, von 2004 bis 2006 als Persönlicher Referent des Staatssekretärs und ab 2007 als Referatsleiter für Energie- und Klimapolitik. Quelle hier: http://www.agora-energiewende.de/ueber-uns/team/

[2] Von Herrn Christoph Podewils; Leiter Kommunikation / Director of Communications; Agora Energiewende wurden wir soeben (11.12.14 um 11:49) darauf hingewiesen, dass F. Drieschners Zitat ein indirektes ist, und Herr Graichen das so nicht gesagt hätte. Wir haben Herrn Drieschner angefragt und um Aufklärung gebeten. Er hat das jetzt bestätigt, die Darlegungen unter "Graichen sagt kurz gefasst:" sind F. Drieschners Schlussfolgerungen.

[3] „Stromspeicher in der Energiewende“ Studie von FENES, IAEW, ISEA, ef.Ruhr im Auftrag von Agora Energiewende BERLIN, 15.09.2014