Der Mathe-Student, der nie rechnen konnte – Die surreale Welt des Boris Palmer

Aber lassen wir ihn doch einmal selbst zu Wort kommen:

„Im Mathematikstudium (Anmerkung des Autors: auf Lehramt, eine Abschlussnote habe ich nirgendwo gefunden) habe ich mir angewöhnt, immer den exakten Beweis zu führen. Wenn der gefunden wurde, habe ich keinen Widerspruch mehr zugelassen. Das ist in der Mathematik der einzige Weg zur Erkenntnis. Aber in der Politik führt er nicht zum Ziel. Denn da geht es auch um die Frage, wie ich mein Argument so erkläre, dass mein Gegenüber es annehmen kann. Darüber habe ich mir viele Jahre zu wenig Gedanken gemacht.“[1]

Bild rechts: Boris Palmer, Bündnis 90/Die Grünen in 2006 auf einem Grünen Parteitag in Köln; Lizenz über Wikipedia Hochgeladen von Flickr upload bot Link hier

Zwei Punkte wollen wir festhalten. Erstens, wenn ein Beweis vorliegt, dann gilt dieser widerspruchslos. Zweitens, Argumente (dies sind keine Beweise) muss man so erklären, dass sie der Gegenüber annehmen kann.

Am 13.8.14 (der Tag des Mauerbaus) veröffentlichte Boris P. in der Welt einen Artikel mit dem Titel „Wir kommen an Windrädern nicht mehr vorbei“.

Das Credo des Artikels lautet:

„Es ist nicht statthaft, zweifelhafte und wandelbare ästhetische Gegenwartsbedürfnisse über die Lebensbedürfnisse künftiger Generationen zu stellen. Wer heute nicht auf Strom und Wärme verzichten will, muss den Anblick von Wärmedämmungen und Windrädern ertragen.“

In was für einer Welt leben wir, wenn außer in Deutschland die Lebensbedürfnisse zukünftiger Generationen missachtet werden. Es tröstet etwas, dass dafür die meisten Menschen in Europa im Kalten und im Dunklen sitzen müssen, da sie auf den Anblick von Dämmplatten und Windmühlen verzichten. Aber wie sagte Siegmar Gabriel so treffend:

“Für die meisten anderen Länder in Europa sind wir sowieso Bekloppte”. Vielleicht sind wir aber nicht nur bekloppt, sondern sogar wahnsinnig. Zumindest Boris P. nannte sich selbst auf einer Konferenz in Düsseldorf 2010, auf der es um das „Einpacken“ von Häusern und ganzen Städten, um Sinn und Unsinn des „Dämmwahns“ ging, einen „Dämmwahnsinnigen“. Er weiß vermutlich gar nicht wie recht er damit hat.

Während Gabriel in einem kurzen Augenblick der Erkenntnis gesteht:

“Die Wahrheit ist, dass die Energiewende kurz vor dem Scheitern steht”, aber dies nicht konsequent zu Ende denkt, kommt der OB zu einer ganz anderen Schlussfolgerung:

„Die Energiewende kann nur funktionieren, wenn wir auch schöne Landschaften mit Windrädern verändern. Die Auswirkungen von Windparks auf die Natur sind jedoch von wenigen Vogelarten abgesehen nahezu null. Jeder Kilometer Autobahn richtet mehr Schaden an der Umwelt an als ein Windpark. Die einzige relevante Beeinträchtigung der Windkraft bleibt die optische.“ „Die Zahl von derzeit rund 25.000 (onshore)-Windkraftstandorten in Deutschland müssen wir verdoppeln, um Deutschland erneuerbar zu versorgen.“

Etwaige Andersdenkende werden von ihm mit seiner Feststellung abgekanzelt:

„Wer sich intensiver mit den Initiativen auseinandersetzt, die im Namen des Naturschutzes gegen Windräder mobilisieren, stellt fest, dass dies häufig gerade die Menschen sind, die Bioprodukte für Firlefanz halten, große Autos in der Garage haben, nie Grün wählen würden und Umgehungsstraßen in freier Landschaft für einen Segen halten, kurz die Ökologie erst dann entdecken, wenn ihnen ein Windrad ins Blickfeld gerät.“

Lassen wir einen der Andersdenkenden zu Wort kommen. Enoch von Guttenberg, der vor 37 Jahren den BUND mitgegründet hat, diesen aber kürzlich aus Protest gegen die derzeitige Führung, die er wegen ihrer Zusammenarbeit mit der Windlobby als verantwortungslose und korrumpierte Technokraten bezeichnet, wieder verließ, sagt über die Windkraftanlagen:

„Windkraftanlagen sind nicht nur Geländefresser. Sie erfordern nicht nur die Erschließung, also die Entwaldung ganzer Höhenzüge. Sie sind zudem hocheffiziente Geräte zur Vernichtung von Vögeln und Fledermäusen. Die „Hinweise zur Planung und Genehmigung von Windkraftanlagen“ der Bayerischen Staatsregierung vom 20. Dezember 2011 benennen als besonders gefährdet unter anderen den Schwarzstorch, den Weißstorch, die Wiesen- und die Rohrweihe, den Schwarz- und den Rotmilan, den Baum- und den Wanderfalken, den Wespenbussard, den Uhu, den Graureiher – all dies ohnehin bedrohte Vogelarten, die vom Sog der Windräder eingezogen und buchstäblich zerhäckselt werden. Den Fledermäusen lässt bereits der Druckunterschied im Umkreis der Rotoren ihre Lungen platzen.“

Quantifiziert und dokumentiert wurde dies von Clive Hambler von der Oxford Universität. Demnach „werden in jedem Jahr zwischen 6 und 18 Millionen Vögel und Fledermäuse in Spanien allein durch Windräder getötet, einschließlich seltener Gänsegeier, von denen in einem Jahr 400 Exemplare getötet worden sind, ….. In Tasmanien sind die Keilschwanzadler wegen der Windturbinen vom Aussterben bedroht. Norwegische Windparks töten jedes Jahr zehn Seeadler. Deutsche Windturbinen töten 200 000 Fledermäuse pro Jahr“.[2]

Mehrere Millionen Opfer pro Jahr sind also für den ökologischen OB „nahezu null“. Irgendwie muss der Mathematiker bei der Zahlentheorie geschlafen haben.

Mit den Zahlen scheint er eh ein Problem zu haben, denn was soll es bringen noch einmal 25 000 Windanlagen aufzustellen, wenn „gut 70 % aller deutschen Windräder unwirtschaftlich sind und die meisten investierenden Bürger kaltblütig betrogen und über die Tische gezogen werden.“ „Im Übrigen konnten diese Zahlen von den Windrad-Bauern und -Betreibern bis jetzt nicht dementiert werden, da dies das Zahlenmaterial des eigenen Dachverbandes ist und ungewollt an die Öffentlichkeit gelangte.“ [3]

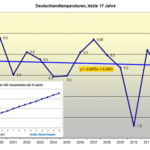

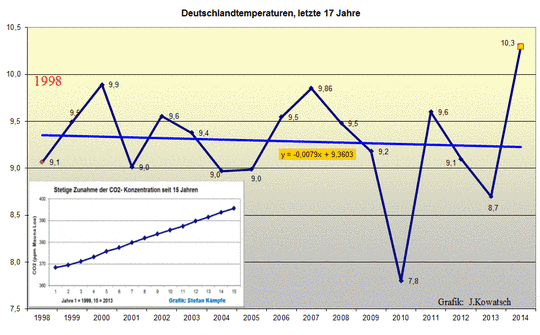

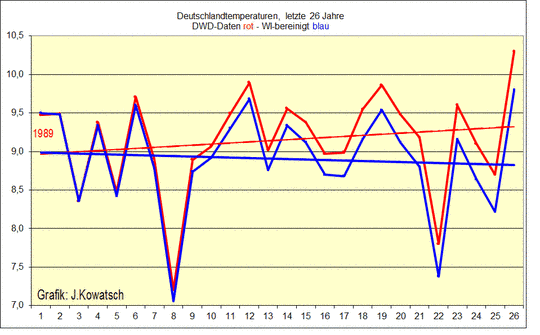

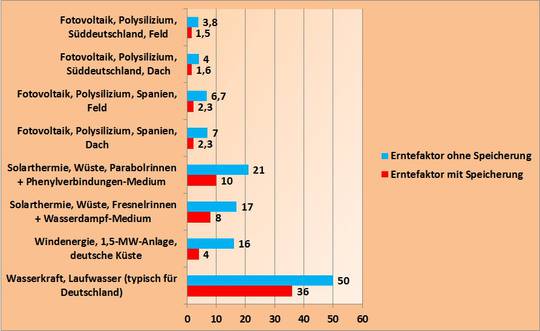

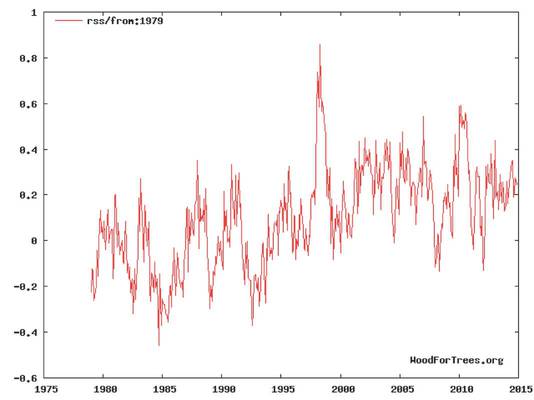

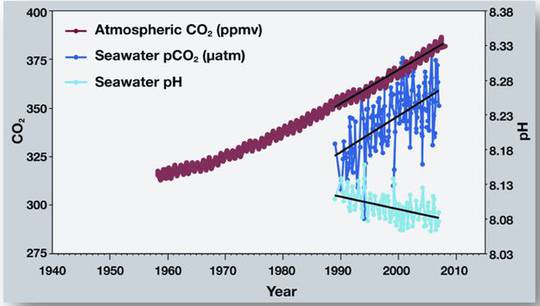

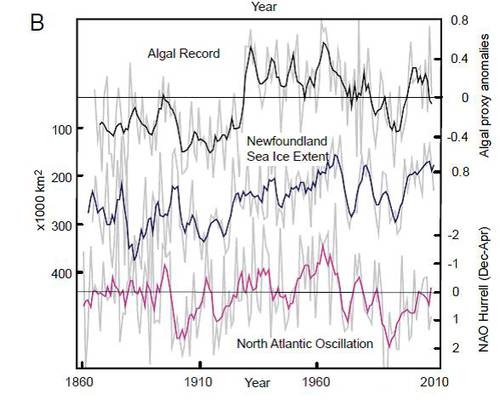

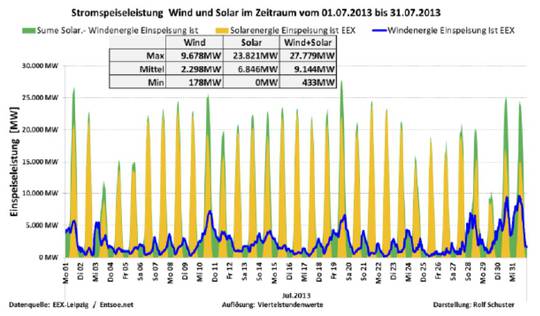

In Deutschland werden an einem „normalen Tag“ 65 GW Leistung benötigt. An einem Spitzenlasttag im Winter können es für wenige Stunden auch rd. 82 GW sein. Derzeit sind rd. je 32 GW Windleistung und 34 GW Photovoltaikleistung installiert. Wenn wir also nach Boris P. die Windenergie verdoppeln, dann sind wir bei knapp 100GW angelangt, was wohl immer ausreichen sollte. Dies impliziert zumindest sein Gedanke, wenn da nicht die vertrackte Natur wäre. Die folgende Graphik zeigt einen typischen Verlauf der real eingespeisten Energie.

Bei einer verdoppelten Windenergie kommen wir im Mittel auf knapp 11.5GW, was weniger als 18% der benötigten Leistung ist, aber im Minimum sind es nur rund 0,5%!

Dies ist ein klarer empirischer Beweis über den Unsinn von 100% „erneuerbarer“ Energie. Nehmen Sie sich beim Wort Herr Palmer, machen Sie eine 180° Wende und dulden Sie dann keinen Widerspruch.

In der Mathematik genügt ein Beweis um eine These zu falsifizieren. Aber vielleicht brauchen Sie noch einen?

Und trotzdem geht es, wie Prof. Endres von der TU Clausthal gezeigt hat.

„Man muss die „erneuerbare“ Erzeugungskapazität bei einem Flächenverbrauch von ca. 20 % „nur“ auf ca. 500 – 600 GW erweitern und für die Speicherung von 40 TWh Strom (mehrwöchige Flaute) ein paar Milliarden Batterien installieren. Gehe ich von einem Preis von 100 EUR/kWh aus (sehr sehr sportlich), kostet der Spaß wohl rund 4 Billionen Euro nur für die Batterien, und das bitte alle spätestens 6 Jahre noch mal. Dazu kommt dann noch die Ladeelektronik usw.. Kurz und gut, der ganze Spaß würde Installationskosten von ca. 10 Billionen EUR erfordern, mit wiederkehrenden Kosten von ca. 5 Billionen EUR alle 6 Jahre und ca. 1 Billion EUR alle 10 – 15 Jahre für die WKA´s – ja, wenn das keine Perspektive ist.“

Zum Vergleich, der Bundeshaushalt von 2014 betrug knapp 0.3 Billionen Euro, Selbst wenn eine heilige Fee die Installationskosten übernehmen würde, überstiegen die jährlichen Wartungskosten den kompletten Haushalt.

Dies wird schwierig zu erwirtschaften sein, da die Windanlagen selber einen jährlichen Verlust zwischen 300- bis 500-tausend Euro verursachen. Konkret für den Windpark Münsterwald mit 7 WKA’s beträgt der Wert rund 3.2 Millionen Euro pro Jahr. Die Rechnung hierzu findet man im Anhang als pdf. Hochgerechnet auf die Wunschzahl des OB aus Tübingen ergibt dies weitere 20 Milliarden Kosten pro Jahr.

Sie können die Zahlen drehen, wie Sie wollen. Es ist nicht machbar. Beweis Nr. 2.

Langsam schwant mir, warum ich keine Abschlussnote gefunden habe.

Soviel zu den Beweisen. Kommen wir zu den Argumenten. Wie erklären Sie, dass der Pfälzerwald, der für die Grünen vor drei Jahren oberste Priorität als zusammenhängendes Waldgebiet hatte, nun den Windkraftanlagen geopfert werden soll? Ist Waldschutz der Firlefanz von gestern?

Sie bejahen auf der einen Seite die Vermaisung der Landschaft und fordern auf der anderen den Vorrang der Ökologie ein. Die größte Biogasanlage im Land benötigt 1000 Tonnen Mais pro Tag. 7000 Anlagen stehen bereits, pro Jahr kommen im Durchschnitt etwa 1000 hinzu. Um diesen Widerspruch zu erklären muss man schon tief in die Kiste des dialektischen Materialismus greifen. Kampf und Einheit der Widersprüche wäre da das Stichwort. Der Segen dieser Philosophie ging, wenn auch vermutlich nur temporär, vor 25 Jahren unter.

Zwischenzeitlich hat man sich aber für eine neue Ideologie entschieden –

den Klimaschutz.

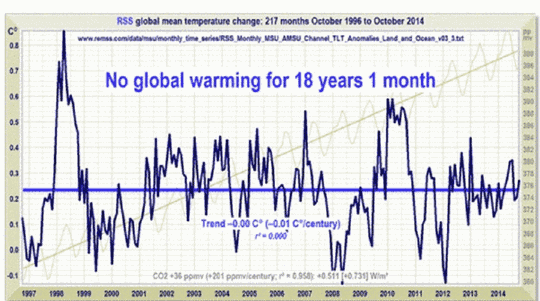

Als Experte dient Al Gore. „Schon Al Gore hat in seiner „unbequemen Wahrheit“ darauf hingewiesen, dass in 99 Prozent aller wissenschaftlichen Publikationen die Erderwärmung als menschengemachte Tatsache akzeptiert ist.“

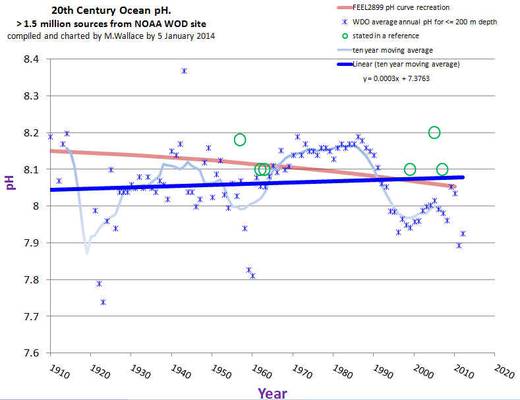

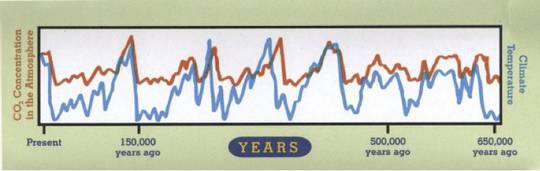

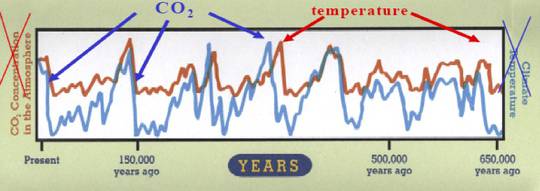

Al Gore, der Experte, der auf die Frage nach der Temperatur in zwei Kilometer Tiefe von ein paar Millionen Grad faselte, wobei es um die Erde(!) ging, Diese Temperatur gibt es nicht einmal in dieser Tiefe auf der Sonne. Al Gore der Ursache und Wirkung tauscht, damit die Ideologie stimmt.

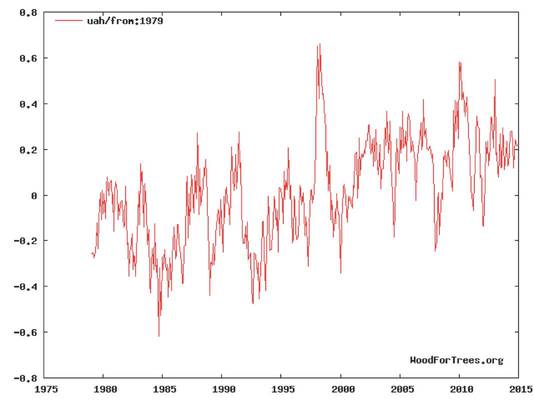

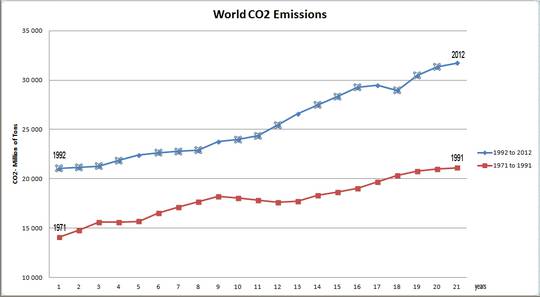

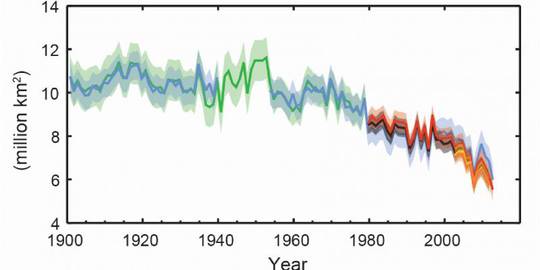

Das obige Bild präsentiert er in dem Film „An inconvenient truth“. Und so sieht die Wahrheit aus, erst steigt die Temperatur und dann das CO2. Dies ist eine Folge der Temperaturabhängigkeit der Löslichkeit von CO2 in Wasser (Henry Gesetz). Aber was stören Naturgesetze den Experten.

So unglaubwürdig Al Gores „wissenschaftliche“ Aussagen sind, so unglaubwürdig sind auch die 99%. Die neueste und größte Studie besagt folgendes:

„We analyze the evolution of the scientific consensus on anthropogenic global warming (AGW) in the peer-reviewed scientific literature, examining 11 944 climate abstracts from 1991–2011 matching the topics ‘global climate change’ or ‘global warming’. We find that 66.4% of abstracts expressed no position on AGW, 32.6% endorsed AGW, 0.7% rejected AGW and 0.3% were uncertain about the cause of global warming.”[4]

Womit die 99% auf ein Drittel geschrumpft sind. Bedenkt man noch, dass es viel schwieriger ist so genannte skeptische Artikel zu publizieren, wie climategate gezeigt hat, dann schrumpft die Konsensuszahl weiter.

[Climategate: From: Phil Jones <p.jones@xxxx>To: "Michael E. Mann" <mann@xxxx> Der Erfinder der Hockeyschlägerkurve.Subject: HIGHLY CONFIDENTIALDate: Thu Jul 8 16:30:16 2004The other paper by MM (McIntyre und McKitrick, die den Erfinder überführten) is just garbage - as you knew. Pielke is also losing all credibility.I can't see either of these papers being in the next IPCC report. Kevin and I will keep them out somehow - even if we have to redefine what the peer-review literature is!]

Dies ficht aber Boris P. nicht an. Er behauptet und nennt dies Argumentieren:

„Klimaskeptiker sind Leute, die an die Stelle dieser Erkenntnis obskure Alternativerklärungen setzen, um die menschliche Sucht nach fossiler Energie zu rechtfertigen.“

Wo sind Ihre Argumente, die die Windkraftgegner annehmen können? Leider habe ich keine gefunden. Dafür gibt es Plattitüden, wie „große Autos in der Garage“ und das wohl Schlimmste in Ihrer Vorstellung „Menschen die nie Grün wählen“. Bitten Sie doch Herrn Kretschmann, dass per Gesetz nur noch Grün gewählt werden darf.

[1] Welt 26.10.14

[2] http://www.spectator.co.uk/features/8807761/wind-farms-vs-wildlife/

[3]http://www.deutscherarbeitgeberverband.de/aktuelles/2014_11_16_dav_aktuelles_BUND_Technokraten.html

[4] Cook et al. – Environ. Res. Lett. 8 (2013) 024024 (7pp)