Redaktionelle Vorbemerkung: dieser Teil ist ungewöhnlich lang und enthält einige Bildunterschriften sowie eine ganze Reihe von Anmerkungen, die wir der Einfachheit halber im Englischen belassen haben. Leider hat Typo3 zwar die schöne Möglichkeit Textstellen im Entwurf hoch bzw. tiefer zu stellen, also beispielsweise das Sauerstoffisotop 18 mit hochgestellter 18 zu schreiben, das ist beim Abspeichern aber sofort wieder weg (vielleicht kennt ja ein Leser den Trick, wie’s trotzdem geht). Leider bleibt es bisher also beim unschönen 18O, CO2 usw. Nun zum SOD – Text:

Im einem vorigen Teil Eleven – End of the Last Ice age haben wir die Abfolge der Ereignisse betrachtet, die zum Ende der jüngsten Eiszeit geführt haben – Termination I.

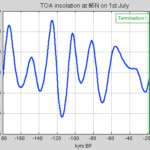

Der Zeitpunkt dieses Ereignisses lag vor 17.500 bis 18.000 Jahren (Anmerkung 1). Wir haben auch gesehen, dass die „zunehmende solare Einstrahlung“ dies nicht erklären kann. Mit Hilfe von Illustration habe ich einige Plots in Pop Quiz: End of An Ice Age erstellt – alle aus den letzten 100 Jahren und habe die Leser aufgefordert herauszufinden, welcher Plot zu Termination I passt.

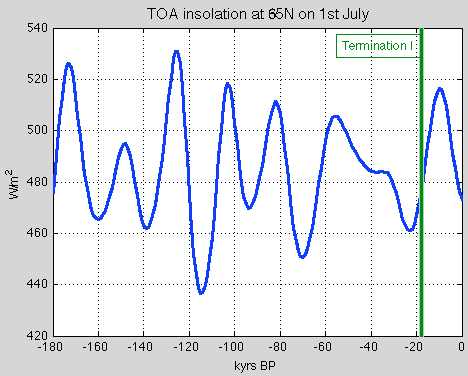

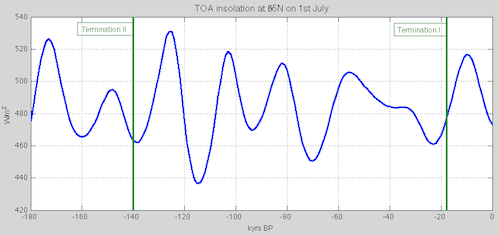

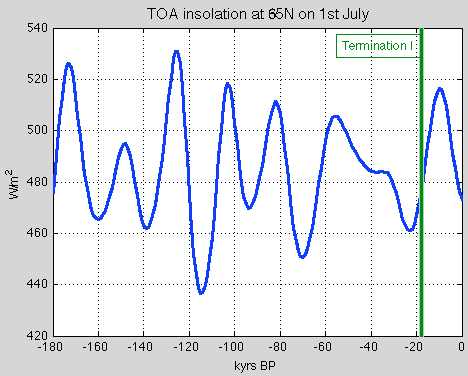

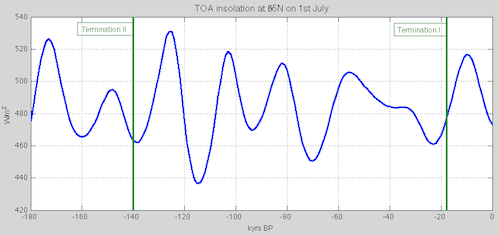

Aber diese einfache Graphik der Einstrahlung auf 65°N am 1. Juli bringt das Problem für die „klassische Version“ der „Milankovitch-Theorie“ auf den Punkt (siehe Part Six – “Hypotheses Abound). Einfach gesagt, falls die Sonneneinstrahlung vor 18.000 Jahren zum Ende der Eiszeit führte, warum hat die gleiche oder eine sogar noch höhere Einstrahlung vor 100.000, 80.000 oder 60.000 bis 30.000 Jahren nicht zu einem früheren Ende der Eiszeit geführt hatte:

Figure 1

Und eine visuellere Demonstration der Sonneneinstrahlung mit der Zeit siehe man bei den Hövmoller-Plots in den comments of Part Eleven nach. Das andere Problem für die Milankovitch-Theorie als Ursache für das Ende der Eiszeit ist die Tatsache, dass die Temperaturen auf der südlichen Hemisphäre vor den globalen Temperaturen gestiegen sind. Der Süden hat also die Welt aus der Eiszeit geführt. Das ist schwer zu erklären, falls das Schmelzen der Eisschilde auf der Nordhemisphäre der Grund für das Ende der Eiszeit sein sollten. Man schaue dazu noch einmal Eleven – End of the Last Ice age an. Soweit unser kurzer Rückblick auf Termination I (T-I). Jetzt also Termination II (T-II). Dies ist das Ende der vorletzten Eiszeit.

Die traditionelle Milankovitch-Theorie sagt aus, dass der Höhepunkt der Sonneneinstrahlung in hohen Breiten vor rund 127.000 Jahren der Auslöser für eine massive Deglaziation war, die jene frühere Eiszeit beendet hatte. Die gut bekannte SPECMAP-Datierung des Meeresspiegels/Eisvolumen mit der Zeit legt den Zeitpunkt für T-II vor 128.000 Jahren ±3000 Jahre fest. Alles in Ordnung. Oder doch nicht?

Welche Grundlage hat die SPECMAP-Datierung?

Die am meisten verwendeten und am besten bekannten Aufzeichnungen bzgl. Eiszeiten stammen aus Ozean-Sedimenten. Diese waren die ersten langzeitlichen Klimaaufzeichnungen, die hunderttausende Jahre zurückreichen. Wie funktionieren sie, und was messen Sie?

Sauerstoff existiert in Form einiger unterschiedlicher stabiler Isotope. Das häufigste dieser Isotope ist 16O, gefolgt von 18O, jedoch mit einem deutlich kleineren Anteil. Wasser existiert ebenfalls in Gestalt dieser beiden Isotope und das bequeme Verhalten zu verdunsten und als Niederschlag als H218O mit unterschiedlichen Raten im Vergleich zu H216O zu fallen. Die Messungen werden dargestellt als das Verhältnis (oder delta oder δ) als δ18O in parts per thousand.

Die Reise des aus den Ozeanen verdunsteten Wasserdampfes gefolgt von Niederschlag, erzeugt eine Maßzahl des Start-Verhältnisses der Isotope ebenso wie die lokale Temperatur des Niederschlags. Das komplexe Endergebnis dieser unterschiedlichen Prozess-Raten ist, dass in der Tiefsee benthic foraminifera 18O aus der Tiefsee aufnehmen, und dieses δ18O steht dann meistens in einem Verhältnis zum globalen Eisvolumen. Die daraus resultierenden Tiefsee-Sedimente sind daher eine Zeitreihe des Eisvolumens. Allerdings sind die Raten der Sedimentation keine exakte Wissenschaft und auch nicht zeitlich konstant.

Als Ergebnis viel sorgfältiger Arbeit durch zahlreiche Forscher über viele Jahrzehnte ergab sich eine Studie von Hays, Imbrie & Shackleton (1976). Dies zeigte, dass Änderungen des Eisvolumens mit orbitaler Häufigkeit von Präzession und Schiefe erfolgen (etwa alle 20.000 und alle 40.000 Jahre). Aber es gibt sogar ein noch stärkeres Signal – den Beginn und das Ende von Eiszeiten – etwa alle 100.000 Jahre. Dies fällt grob zusammen mit Änderungen der Exzentrizität des Erdorbits. Jedoch hat niemand eine (brauchbare) Theorie, die diesen Umstand mit Beginn und Ende von Eiszeiten in Verbindung bringt.

Nun gibt uns das klare Signal von Schiefe und Präzession in den Aufzeichnungen die Option, die Aufzeichnung so zu tunen, dass die Spitzenwerte in der Aufzeichnung zu den orbitalen Häufigkeiten von Präzession und Schiefe passen. Wir haben die Tuning-Methode in einigen Kommentaren zu Teil IX zu einem ähnlichen, aber viel späteren Datensatz diskutiert – den LR04. Die Methode ist nicht falsch, aber wir können das Timing der Schlüsselereignisse nicht bestätigen. Glücklicherweise gibt es inzwischen einige neue Verfahren.

Datierung von Eisbohrkernen

Es waren begeisternde Zeiten der letzten mehr als zwanzig Jahre in der Klimawissenschaft für Leute, die dicke warme Kleidung tragen und „alles hinter sich lassen“ wollen.

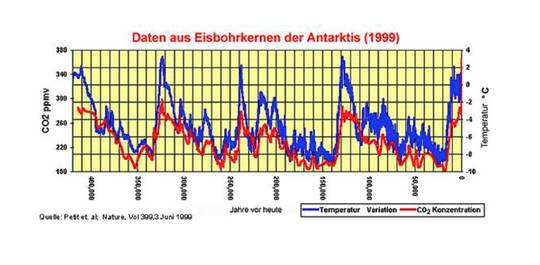

Viele Eisbohrkerne stammen aus Grönland und der Antarktis. Aus Grönland gibt es eine Reihe, die 123.000 Jahre zurück reicht (NGRIP). Aus der Antarktis gibt es eine Reihe, die 800.000 Jahre zurück reicht (EDC bzw. „Dome C“). Aus der Antarktis stammt auch der Wostok-Eisbohrkern, der etwa 400.000 Jahre zurück reicht und einen aus Dronning Maud Land (bzw. DML oder EDML), der eine etwas höhere Auflösung hat, aber nur 150.000 Jahre zurück reicht.

Was messen diese Eisbohrkerne, und wie wird die Datierung vorgenommen? Die Eisbohrkerne messen die Temperatur zur Zeit der Ablagerung als Schnee mittels der oben diskutierten δ18O-Messung (Anmerkung 2), welche in diesem Fall nicht eine Maßzahl für das globale Eisvolumen, sondern für die Lufttemperatur ist. Das in Bläschen eingeschlossene Gas in den Bohrkernen gibt uns die CO2 und CH4-Konzentrationen. Wir können auch Staubablagerungen und alle möglichen anderen Inhalte messen.

Das erste Problem ist nun, dass das Gas „jünger“ ist als das Eis, weil es sich noch so lange bewegt, bis der Schnee genügend komprimiert ist. Also brauchen wir ein Modell, um dies zu simulieren, und es gibt einige Unsicherheiten über den zeitlichen Unterschied zwischen Eis und Gas. Das zweite Problem ist das der Datierung. Zu Beginn können wir jährliche Schichten ablesen. Nach einer ausreichenden Zeit (einige Jahrzehnte bis tausende von Jahren) können diese Schichten nicht mehr voneinander unterschieden werden, stattdessen kann man nur noch Modelle der Physik über Eisflüsse heranziehen. Dann kam es zu einigen günstigen Zeitmarken wie den 10Be-Ereignissen (hier) vor etwa 50.000 Jahren. Nachdem die Physik von Eisflüssen und externe Ereignisse nicht mehr ausreicht, werden die Daten durch anderweite Methoden weiter justiert, ebenso wie Bohrkerne aus der Tiefsee.

Höhlen, Korallen und genaue Terminierung via Radiometrie

Weder Bohrkerne aus der Tiefsee noch aus Eis bieten viel Gelegenheit einer Radiometrischen Datierung. Aber Höhlen und Korallen tun dies sehr wohl.

Für Neulinge hinsichtlich von Datierungs-Verfahren: hat man eine Substanz A, die sich in Substanz B mit einer „Halbwertszeit“ auflöst, die genau bekannt ist, und wenn man genau weiß, wie viel von Substanz A und Substanz B zu Beginn vorhanden war (d. h. keine Möglichkeit des Eindringens zusätzlicher Mengen der Substanzen A oder B in das, was wir messen wollen), dann kann man sehr genau das Alter berechnen, in der sich die Substanz gebildet hat. Im Grunde läuft alles darauf hinaus, wie der Ablagerungsprozess funktioniert. Die Datierung mittels Uran-Thorium war erfolgreich bei Kalkablagerungen im Gestein.

Man nehme also eine lange Reihe, kontinuierlicher Ablagerungen, messe das δ18O (und 13C) an einer Menge Punkten entlang dieser Reihe. Dann nehme man eine Anzahl von Beispielen und berechne das Alter entlang der Reihe mittels Radiometrie. Das, was genau in den Bohrkernen gemessen wird, ist kompliziert, aber ich werde erheblich vereinfachen und einfach behaupten, dass es nur um zwei Problempunkte geht:

1. Die tatsächliche Menge der Ablagerung, wenn während extremer Vereisung nicht viel Wasser zur Verfügung steht, um diese Ablagerungen hervorzubringen.

2. Die Variation von δ18O (and 13C), die in erster Linie von der lokalen Lufttemperatur abhängt.

Für an mehr Details Interessierte empfehle ich McDermott 2004. Einige relevante Auszüge finden sich unten in Anmerkung 3.

Korallen bieten die Möglichkeit, via radiometrischer Datierung genaue Daten zum Meeresspiegel zu bekommen. Die wichtigste Variable, die man kennen muss, sind Absenkungen und Hebungen der Erdkruste. Die genaue Datierung von Höhlen und Korallen war während der letzten 20 Jahre eine Wachstumsindustrie mit einigen interessanten Ergebnissen.

T-II

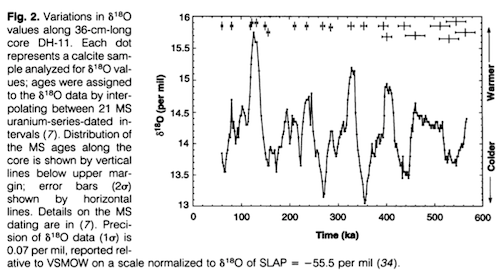

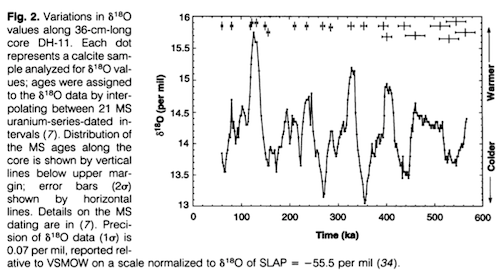

Winograd et al. (1992) analysierten die Höhle Devils Hole [= Teufelsloch”] in Nevada (DH-11):

Der zeitliche Verlauf von δ18O in Devils Hole (Abbildung 2) zeigt klar die Sägezahn-Verteilung der maritimen δ18O-Aufzeichnungen, die interpretiert worden sind als die Folge von Ausdehnung und Rückzug der nordhemisphärischen Eisschilde. Aber was war die Ursache für die δ18O-Variationen in DH-11 in Abbildung 2? Man nimmt an, dass die δ18O-Variationen im atmosphärischen Niederschlag – in erster Näherung – Änderungen der mittleren Temperatur im Winter und im Frühjahr reflektieren.

Fig. 2, Bildinschrift: Variationen der δ18O-Werte entlang des 36 cm langen Bohrkerns DH-11. Jeder Punkt repräsentiert ein Stück Kalkspat, das auf δ18O-Werte analysiert worden ist; die Zeitpunkte wurden auf die δ18O-Daten übertragen durch Interpolation zwischen 21 MS-Intervallen datiert nach Uran-Reihen in Intervallen. Die Verteilung der MS-Alter entlang des Bohrkerns wird markiert durch vertikale Linien unter dem oberen Rand; Fehlerbalken (2σ) durch horizintale Linien. Die Präzision der δ18O-Daten (1σ) beträgt 0,07 pro mil dargestellt relativ zu VSMOW in einem Maßstab normalisiert zu δ18O von SLAP = -55,5 pro mil. Aus Winograd et al 1992

Termination II ereignet sich bei 140±3 (2σ) ka in der DH-11-Reihe, bei 140± 15 ka in der Wostok-Reihe (14) und bei 128 ± 3 ka in der SPECMAP-Reihe (13). (Die Unsicherheit in der DH-11-Reihe liegt in den 2σ-Unsicherheiten der MS-Datierungen via Uran; andere Datierungen und Unsicherheiten stammen aus den angegebenen Quellen). Termination III ereignete sich bei etwa 253 +/- 3 (2σ) ka in der DH-11-Reihe und bei etwa 244 +/- 3 ka in der SPECMAP-Reihe. Diese Unterschiede sind Minimum-Werte.

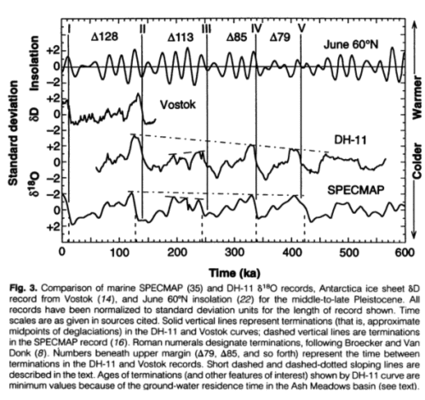

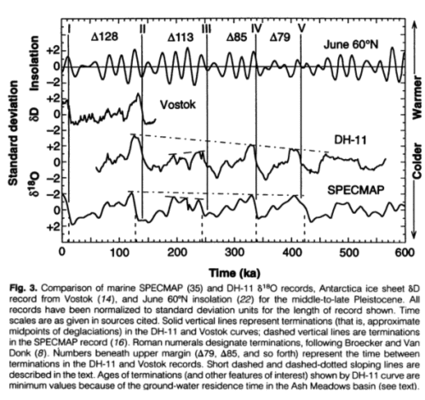

Sie vergleichen die sommerliche Einstrahlung bei 65°N mit SPECMAP, Devils Hole und dem Wostok-Bohrkern in einer einfachen Graphik:

Figure.3, Bildinschrift: Vergleich der maritimen SPECMAP und DH-11 δ18O-Reihen, des antarktischen Eisschildes δD-Aufzeichnung aus Wostok und Einstrahlung im Juni auf 60°N im mittleren und späten Pleistozän. Alle Aufzeichnungen wurden normalisiert in Einheiten der Standardabweichung über die Länge der gezeigten Aufzeichnung. Zeitskalen sind wie in den genannten Quellen. Durchgezogene vertikale Linien repräsentieren Terminationen (das heißt, näherungsweise Mittelpunkte der Deglaziationen) in den Kurven von DH-11 und Wostok. Gestrichelte vertikale Linien sind Terminationen in der SPECMAP-Aufzeichnung. Römische Zahlen stehen für Terminationen nach Broecker und Van Donk. Die Zahlen am oberen Rand repräsentieren die Zeit zwischen den Terminationen in den DH-11- und Wostok-Aufzeichnungen. Kurze gestrichelte und strichpunktierte Linien werden im Text beschrieben. Zeitpunkte von Terminationen (und von anderen interessierenden Ereignissen) in der DH-11-Kurve sind Minimum-Werte wegen der Verweilzeit des Grundwassers im Ash-Meadow-Becken (siehe Text). Nach Winograd et al 1992

Natürlich war nicht jeder glücklich mit diesen neuen Informationen, und wer weiß schon, wofür die Isotopen-Messungen wirklich ein Proxy waren?

Slowey, Henderson & Curry 1996

Einige Jahre später, im Jahre 1996 haben Slowey, Henderson & Curry (nicht die berühmte Judith) über ihre Forschung Folgendes gesagt: Unsere Daten implizieren ein Timing und eine Dauer in Übereinstimmung mit der maritimen Chronologie. Die ursprüngliche U-Th-Datierung der maritimen δ18O-Aufzeichnungen stützt die Theorie, dass orbitale Variationen ein fundamentaler Grund für die Klimaänderung im Pleistozän waren.

Henderson & Slowey 2000

Dann, im Jahr 2000, kamen die gleichen Henderson & Slowey (ohne Curry) mit:

Milankovitch vermutete, dass die sommerliche Einstrahlung in mittleren Breiten der Nordhemisphäre direkt die Klimazyklen der Eiszeit verursacht hätten. Dies würde implizieren, dass Zeiten mit einem Zusammenbruch der Eisschilde korrespondieren sollten mit Spitzen der nordhemisphärischen Juni-Einstrahlung.

Aber die vorletzte Deglaziation hat sich als dem widersprechend erwiesen, weil die Juni-Einstrahlung vor 127.000 Jahren ihren Spitzenwert erreicht hatte, während viele Aufzeichnungen des Klimas der Vergangenheit zeigen, dass es bereits 15.000 Jahre früher Änderungen gegeben haben könnte. Es gibt eine eindeutige Signatur der vorletzten Deglaziation in den maritimen Aufzeichnungen der Sauerstoff-Isotope. Aber die Datierung dieses Ereignisses, das signifikant vor der 14C-Altersbandbreite liegt, war nicht möglich.

Hier datieren wir die vorletzte Deglaziation mittels einer Aufzeichnung von den Bahamas mit einer neuen U-Th-Isochronen-Methode. Nach den erforderlichen Korrekturen für eine a-recoil mobility von 234U und 230Th und einer kleinen Alterskorrektur wegen der Sediment-Durchmischung wird der Mittelpunkt der vorletzten Deglaziation bestimmt als vor 135.000 ± 2.500 Jahren. Dieses Alter ist konsistent mit einigen auf Korallen basierenden Schätzungen des Meeresspiegels, aber es ist schwierig, dies mit der Juni-Einstrahlung der Nordhemisphäre abzugleichen als Auslöser der Eiszeit-Zyklen.

Zhao, Xia & Collerson (2001)

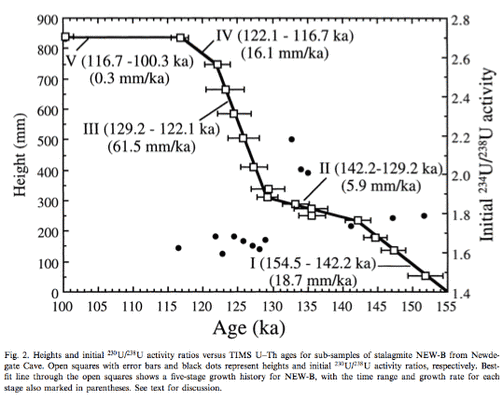

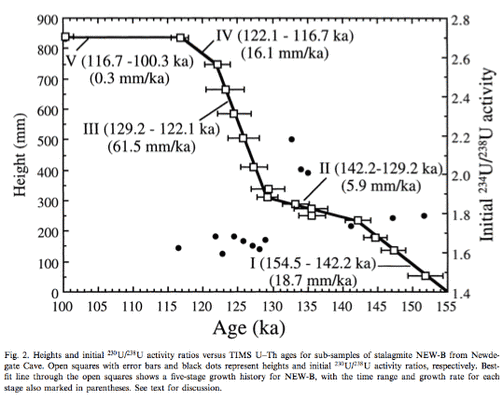

Hoch präzise 230Th-238U-Altersbestimmungen aus einem Stalagmiten aus der Newdegate-Höhle im südlichen Tasmanien sagen aus: Das schnellste Stalagmiten-Wachstum erfolgte zwischen vor 129.200 ± 1600 Jahren und 122.100 ± 2000 Jahren († 61,5 mm pro 1000 Jahre). Dies fällt zusammen mit einer Zeit produktiven Korallenwachstums in Westaustralien (vor 128.000 bis 122.000 Jahren). Dies ist die erste hoch aufgelöste kontinentale Aufzeichnung der Südhemisphäre, die verglichen und korreliert werden kann mit den maritimen Aufzeichnungen. Eine derartige Korrelation zeigt, dass das Auftreten des Meeresspiegels während der Zwischeneiszeit und der Beginn höchster Regenmengen auf dem Festland synchron erfolgte. Die Stalagmiten-Wachstumsrate zwischen vor 129.200 und 142.200 Jahren († 5,9 mm pro 1000 Jahre) lag niedriger als im Zeitraum vor 1452.200 und 154.500 Jahren († 18,7 mm pro 1000 Jahre). Dies impliziert trockenere Bedingungen während der vorletzten Deglaziation trotz steigender Temperatur und steigendem Meeresspiegel.

Diese asymmetrische Verteilung der Niederschlagsmenge wird verursacht durch breitenabhängige Bewegungen subtropischer Hochdruckgebiete und einer damit verbundenen Westwind-Zirkulation als Reaktion auf den Temperaturgegensatz zwischen Äquator und Polen. Sowohl maritime als auch kontinentale Aufzeichnungen in Australien zeigen, dass das Einstrahlungsmaximum im Zeitraum zwischen vor 126.000 und 128.000 Jahren auf 65°N direkt verantwortlich war für die Aufrechterhaltung der vollen zwischeneiszeitlichen Bedingungen, obwohl unklar bleibt, welche Auslöser die vorletzte Deglaziation (vor † 142.000 Jahren) hatte.

Bildinschrift: Höhen und initiale 230U/238U-Aktivitäts-Verhältnisse für Unterbeispiele des Stalagmiten NEW-B aus der Newdegate-Höhle. Offene Quadrate mit Fehlerbalken und schwarze Punkte repräsentieren jeweils Höhen und initiale 230U/238U-Aktivitäts-Verhältnisse. Die Anpassungslinie durch die offenen Quadrate zeigt eine Wachstumshistorie für NEW-B in fünf Phasen, einschließlich der Zeitspanne und Wachstumsrate für jede Phase in Klammern. Aus Zhao et al 2001

Gallup, Cheng, Taylor & Edwards (2002)

Funde innerhalb der letzten Zwischeneiszeit-Terrasse auf Barbados enthalten Korallen, die während der vorletzten Deglaziation gewachsen sind, oder Termination II. Wir verwendeten kombinierte Datierungen mit 230 Th und 231Pa, um zu bestimmen, dass sie vor 135.800 ± 800 Jahren gewachsen sind. Dies zeigt , dass der Meeresspiegel zu jener Zeit um 18 ± 3 Meter unter dem Niveau von heute lag. Dies wiederum zeigt, dass der Meeresspiegel bis auf 20% seines Spitzenwertes während der letzten Zwischeneiszeit vor 136.000 Jahren gestiegen ist. Dies ist ein Widerspruch zu den Vorhersagen der Milankovitch-Theorie.

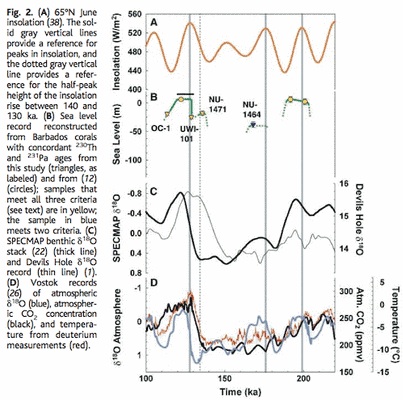

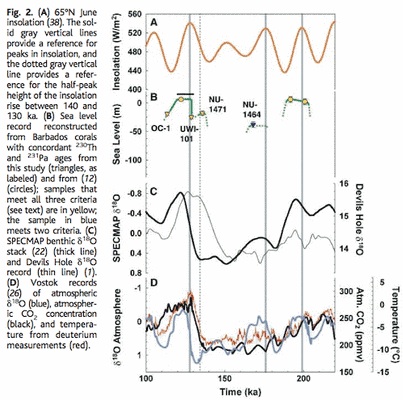

Abbildung 2B fasst die Aufzeichnung der Höhe des Meeresspiegels zusammen, wie er sich aus den neuen Daten ergibt. Am wichtigsten: unsere Aufzeichnung enthält auch Korallen, die die Höhe des Meeresspiegels direkt während T-II zeigen. Dem zufolge ereignete sich der meiste Anstieg (ca. 80%) während dieser Zeit vor 135.000 Jahren. Das ist grob konsistent mit frühen Verschiebungen von δ18O, gefunden auf den Bahamas und in Devils Hole und mit frühen (vor 134.000 Jahren) Korallen der letzten Zwischeneiszeit aus Hawaii. All diese stellen das Timing von Termination II in der SPECMAP-Aufzeichnung in Frage.

Figure 5, Bildinschrift: Abbildung 2 (A): Juni-Einstrahlung auf 65°N. Die durchgezogenen vertikalen grauen Linien sind eine Referenz zu Spitzenwerten der Einstrahlung, und die gepunkteten vertikalen Linie repräsentiert eine Referenz für die halbe Höhe des Spitzenwertes im Zeitraum zwischen vor 140.000 und 130.000 Jahren. (B) Höhe des Meeresspiegels, rekonstruiert mit Korallen von Barbados mit übereinstimmenden 230Th und 231Pa-Zeitaltern aus dieser Studie (Dreiecke mit Beschriftung) und von (12) (Kreise). Die alle drei Kriterien erfüllenden Beispiele (siehe Text) sind in gelb; das Beispiel in blau erfüllt zwei Kriterien. (C) δ18O-Aufzeichnungen in Ablagerungen von SPECMAP (dicke Linie) und von Devils Hole (dünne Linie). (D) Wostok-Aufzeichnungen des atmosphärischen δ18O (blau), atmosphärische CO2-Konzentration (schwarz) und Temperatur aus Deuterium-Messungen (rot). Aus Gallup et al 2002

Natürlich ist für die vielköpfige Hydra noch nicht alles verloren (siehe auch Anhang 4): Die Milankovitch-Theorie in ihrer einfachsten Form kann T-II zwar nicht erklären. Wie auch Termination I. Allerdings ist es aber zumindest immer noch plausibel, dass Antrieb durch Insolation eine Rolle beim Timing von T-II gespielt hat. Da Deglaziationen beginnen müssen, während sich die Erde in einem Eiszeit-Zustand befindet, ist es nützlich, Faktoren zu betrachten, die eine Deglaziation während eines eiszeitlichen Maximums auslösen können. Darunter sind (i) Meereis schneidet eine Feuchtigkeitsquelle für die Eisschilde ab; (ii) isostatische Depression kontinentaler Krusten und (iii) hohe sommerliche Einstrahlung auf der Südhemisphäre durch Auswirkungen auf die atmosphärische CO2-Konzentration.

Yuan et al 2004 präsentieren gegenteilige Beweise:

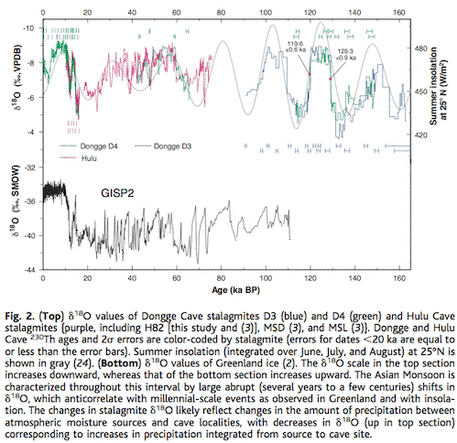

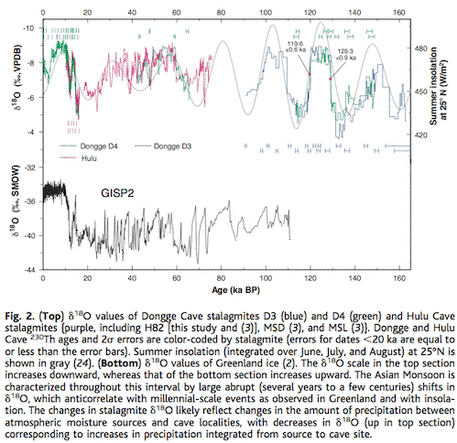

Datierungen mit Thorium-230 und Sauerstoffisotopen von Stalagmiten aus der Dongge-Höhle in China zeigen den asiatischen Monsun und den Niederschlag in niedrigen Breiten währewnd der letzten 160.000 Jahre. Zahlreiche abrupte Änderungen der 18O/16O-Werte resultieren aus Änderungen des tropischen und subtropischen Niederschlags, getrieben von Einstrahlung und Zirkulationsverschiebungen im Zeitmaßstab von Jahrtausenden.

Der Letzte zwischeneiszeitliche Monsun dauerte 9700 ± 1100 Jahre und begann mit einem abrupten Abfall (weniger als 200 Jahre) der 18O/16O-Werte vor 129.300 ± 900 Jahren. Er endete mit einem abrupten Anstieg (weniger als 300 Jahre) dieser Werte vor 119.600 ± 600 Jahren. Der Beginn fällt zusammen mit einem Anstieg der Einstrahlung und dauerte während der gesamten zwischeneiszeitlichen vollumfänglichen Bedingungen. Dies zeigt, dass die Einstrahlung den finalen Anstieg bis hin zu vollständigen zwischeneiszeitlichen Bedingungen ausgelöst hat.

Aber sie kommentieren auch: Obwohl das Timing von Monsun-Termination II konsistent ist mit dem Einstrahlungs-Antrieb auf der Nordhemisphäre, sind nicht alle Klimaänderungen zu dieser Zeit konsistent mit solch einem Mechanismus.

Figure 6

Der Meeresspiegel war offensichtlich bis auf ein Niveau von 21 Metern unter dem heutigen Niveau gestiegen, und zwar schon vor 135.000 Jahren (27 & Gallup et al. 2002), was dem größten Teil der Einstrahlungs-Zunahme voraus lief. Die halbe Strecke von T-II aus maritimen Sauerstoffisotopen wurde datiert auf einen Zeitpunkt vor 135.000 ± 2500 Jahren (Henderson & Slowey 2000).

Auf Funde in Höhlen basierende Beweise aus den Alpen zeigen Temperaturen nahe dem heutigen Niveau vor 135 ± 1200 Jahren (31). Die Halbe Höhe des δ18O-Anstiegs in Devils Hole (vor 142.000 ± 3000 Jahren) läuft ebenfalls dem größten Teil des Einstrahlungs-Anstiegs voraus (20). Eine Zunahme der antarktischen Temperatur und des atmopsphärischen CO2 (32) um die Zeit von Termination II scheint zu Zeiten begonnen zu haben, die von einigen wenigen bis zu vielen Jahrtausenden vor dem größten Teil der Einstrahlungs-Zunahme reichen (4, 32, 33).

Drysdale et al 2009

Es wird verbreitet angenommen, dass Variationen der Intensität der Einstrahlung in hohen nördlichen Breiten, hauptsächlich durch die Präzession der Äquinoktien, das Timing der Eiszeit-Terminationen des späten Pleistozäns gesteuert haben. Allerdungs wurde jüngst darauf hingewiesen, dass Änderungen der Schiefe der Ekliptik ein wichtigerer Mechanismus dafür sein könnte. Wir präsentieren eine neue, auf Stalagmiten basierende maritime Chronologie des Nordatlantik, die zeigt, dass die vorletzte glaziale Termination (Termination II) vor 141.000 ± 2500 Jahren vor heute stattgefunden hat. Das ist zu früh, um mit der sommerlichen Einstrahlung auf der Nordhemisphäre erklärt werden zu können, ist aber konsistent mit Änderungen der Schiefe der Erde. Unsere Aufzeichnung zeigt, dass die Terminationen I und II durch drei Erdachsenschiefe-Zyklen voneinander getrennt sind und dass sie in nahezu identischen Phasen der Schiefe begannen.

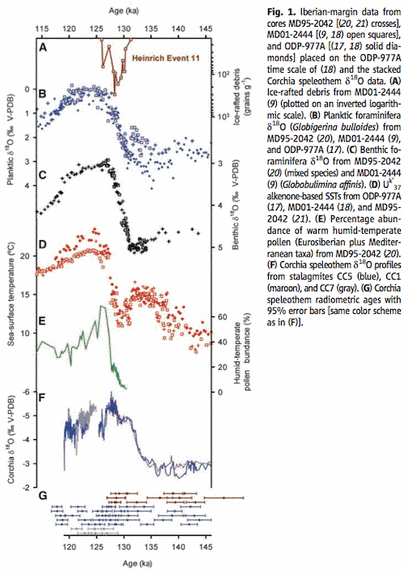

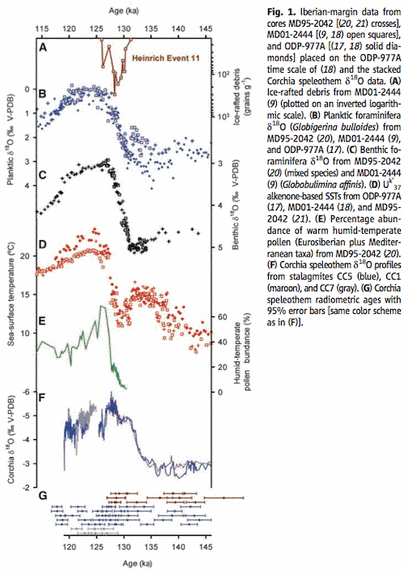

Für Leser, die bis hier durchgehalten haben, ist das inzwischen Standard. Aber die Drysdale-Studie ist in zweierlei Hinsicht interessant: wegen ihrer Datierungsmethode und ihres „ein Ergebnis in einer Reihe“, was zu einer Theorie mit Beweisen passt (Mehr Text aus der Studie habe ich in Anmerkung 5 extrahiert). Schauen wir zuerst auf die Datierungs-Methode:

Was sie getan haben war im Grunde, die Bohrkerne aus der Tiefsee, die das globale Eisvolumen zeigen (aber sie haben keine unabhängige Datierung), mit genauen radiometrisch datierten Höhlenablagerungen zusammenzubringen. Wie haben sie es gemacht? Es ist kompliziert, beruht aber auf dem Zueinanderbringen der δ18O – Werte in beiden Aufzeichnungen. Der Versuch einer absoluten Datierung für existierende Tiefsee-Bohrkerne ergibt sehr interessante Ergebnisse, falls er konsistent ist.

Figure 7, auf die Übersetzung des Bildinhalts wurde verzichtet und dafür auf das englische Original verwiesen.

Der Zusammenhang zwischen Corchia δ18O und Wassertemperaturen vor der Iberischen halbinsel während T-II (Abbildung 2) ist bemerkenswert. Obwohl die Mechanismen, die die δ18O-Variationen in den Höhlenablagerungen steuern, komplex sind, glauben wir, dass Corchia δ18O hauptsächlich durch Variationen der Regenmenge getrieben wird – als Reaktion auf Änderungen der regionalen Wassertemperatur. Frühere Studien von Corchia zeigen, dass das δ18O sensitive ist gegenüber vergangenen Änderungen der nordatlantischen Zirkulation sowohl im orbitalen als auch im Millenium-Zeitmaßstab. Dabei nimmt δ18O während kälterer Phasen zu und während wärmerer Phasen ab.

Figure 8, von Drysdal et al. 2009, Bildinschrift im Original belassen.

Und jetzt zur Hypothese:

Figure 9, von Drysdale et al. 2009

Wir finden, dass die Stärke der norhemisphärischen Sommer-Insolation nicht sehr wahrscheinlich die treibende Kraft für Termination II war. Die Intensitäten waren nahe am Minimum zum Startzeitunkt von T-II und ein verzögerter Response zu dem vorangegangenen Insolations-Peak um ~148.000 ka ist wegen seiner kleinen Amplitude unwahrsheinlich (Fig. 3A). Das ist ein Argument gegen die SPECMAP Kurve als verlässlicher Zeit-Spiegel durch T-II, wenn man den Zeitabstand von ~8 ka für den T-II Mittelpunkt (8) mit unserem Record vergleicht. Ein viel stärkeres Argument ist mit der Erdachsenschiefe als dem verantwortlichen Mechanismus gegeben.Auf der Basis unserer Ergebnisse (Fig. 3B) beginnen sowohl T-I als auch T-IImit derselben Phase der Erdachsenneigung und die Periode von beiden ist exakt die gleiche wie die 3 Erdachsen Zyklen (~123 ka).

EPICA 2006

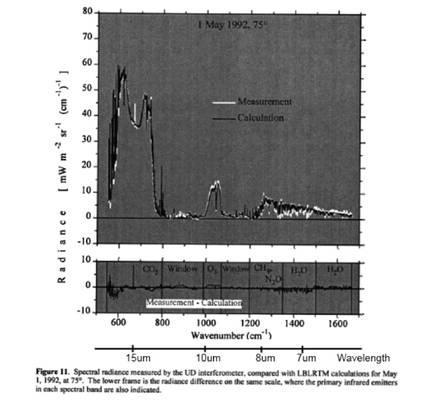

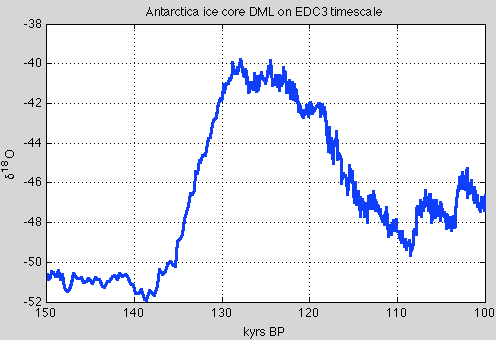

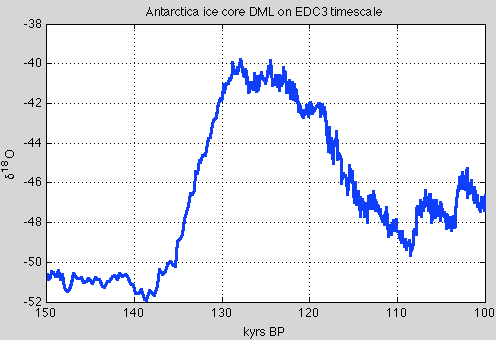

Here is my plot of the Dronning Maud Land ice core (DML) on EDC3 timescale from EPICA 2006 (data downloaded from the Nature website):

Figure 10, Daten von Epica

Die zahlreichen antarktischen und grönländischen Eisbohrkerndaten unterliegen immer noch zahlreichen Datierungsverbesserungen, daher habe ich die letzten Arbeiten nicht berücksichtigt. Ich dachte nur, es wäre gut das Eisbohrkernthema zu vertiefen. Der Wert δ18O ist ein temperaturproxy. Auf diser Zeitskala begannen die lokalen temperaturen um 138.000 Jahre BP anzusteige

Zusammenfassung

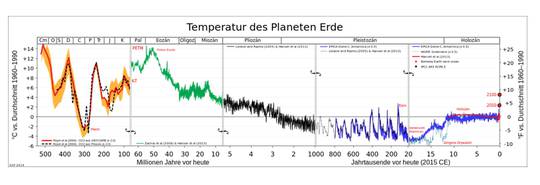

Neue Daten zu T-II aus den letzten 20 Jahren radiometrischer Zeitermittelung und aus verschiedenen Stellen zeigen, dass T-II ungefähr 140.000 Jahre BP begann. Als nächsten Bild nun die Insolationskurve bei 65ºN über die letzten 180 kyrs zusammen mit den besten Daten der Eiszeitenden, die um ungefähr 121 bis 125 kyrs auseinanderliegen:

Figure 11

Wir lernten ein paper mit unterschiedlicher Evidenz für den Start von T-II kennen – Yuan et al. (see note 6). Alle Evidenz einschließlich Datierung des Meeresanstiegs, spricht für T-II Start um 140.000 Jahre BP. Dies bedeutet, dass die Zeit zwischen den Eiszeitenden ungefähr 122.000 Jahre beträgt!

Noch als Ergänzung, weil Winograd et al, 1992 T-III um etwa 253 kyrs berechneten: Dies bedeutet für die Zeit zwischen T-III und T-II um die 113.000 Jahre, also genau fünf einschlägige Erdschiefen-Zyklen!

References

A Pliocene-Pleistocene stack of 57 globally distributed benthic D18O records, Lorraine E. Lisiecki & Maureen E. Raymo, Paleoceanography (2005) – free paper

Continuous 500,000-Year Climate Record from Vein Calcite in Devils Hole, Nevada, Winograd, Coplen, Landwehr, Riggs, Ludwig, Szabo, Kolesar & Revesz, Science (1992) – paywall, but might be available with a free Science registration

Palaeo-climate reconstruction from stable isotope variations in speleothems: a review, Frank McDermott, Quaternary Science Reviews 23 (2004) – free paper

Direct U-Th dating of marine sediments from the two most recent interglacial periods, NC Slowey, GM Henderson & WB Curry, Nature (1996)

Evidence from U-Th dating against northern hemisphere forcing of the penultimate deglaciation, GM Henderson & NC Slowey, Nature (2000)

Timing and duration of the last interglacial inferred from high resolution U-series chronology of stalagmite growth in Southern Hemisphere, J Zhao, Q Xia & K Collerson, Earth and Planetary Science Letters (2001)

Direct determination of the timing of sea level change during Termination II, CD Gallup, H Cheng, FW Taylor & RL Edwards, Science (2002)

Timing, Duration, and Transitions of the Last Interglacial Asian Monsoon, Yuan, Cheng, Edwards, Dykoski, Kelly, Zhang, Qing, Lin, Wang, Wu, Dorale, An & Cai, Science (2004)

Evidence for Obliquity Forcing of Glacial Termination II, Drysdale, Hellstrom, Zanchetta, Fallick, Sánchez Goñi, Couchoud, McDonald, Maas, Lohmann & Isola, Science (2009)

One-to-one coupling of glacial climate variability in Greenland and Antarctica, EPICA Community Members, Nature (2006)

Millennial- and orbital-scale changes in the East Asian monsoon over the past 224,000 years, Wang, Cheng, Edwards, Kong, Shao, Chen, Wu, Jiang, Wang & An, Nature (2008)

Notes

Note 1 – In common ice age convention, the date of a termination is the midpoint of the sea level rise from the last glacial maximum to the peak interglacial condition. This can be confusing for newcomers.

Note 2 – The alternative method used on some of the ice cores is δD, which works on the same basis – water with the hydrogen isotope Deuterium evaporates and condenses at different rates to “regular” water.

Note 3 – A few interesting highlights from McDermott 2004:

2. Oxygen isotopes in precipitation

As discussed above, d18O in cave drip-waters reflect

(i) the d18O of precipitation (d18Op) and

(ii) in arid/semi- arid regions, evaporative processes that modify d18Op at the surface prior to infiltration and in the upper part of the vadose zone.

The present-day pattern of spatial and seasonal variations in d18Op is well documented (Rozanski et al., 1982, 1993; Gat, 1996) and is a consequence of several so-called ‘‘effects’’ (e.g. latitude, altitude, distance from the sea, amount of precipitation, surface air temperature).

On centennial to millennial timescales, factors other than mean annual air temperature may cause temporal variations in d18Op (e.g. McDermott et al., 1999 for a discussion). These include:

(i) changes in the d18O of the ocean surface due to changes in continental ice volume that accompany glaciations and deglaciations;

(ii) changes in the temperature difference between the ocean surface temperature in the vapour source area and the air temperature at the site of interest;

(iii) long-term shifts in moisture sources or storm tracks;

(iv) changes in the proportion of precipitation which has been derived from non-oceanic sources, i.e. recycled from continental surface waters (Koster et al., 1993); and

(v) the so-called ‘‘amount’’ effect.

As a result of these ambiguities there has been a shift from the expectation that speleothem d18Oct might provide quantitative temperature estimates to the more attainable goal of providing precise chronological control on the timing of major first-order shifts in d18Op, that can be interpreted in terms of changes in atmospheric circulation patterns (e.g. Burns et al., 2001; McDermott et al., 2001; Wang et al., 2001), changes in the d18O of oceanic vapour sources (e.g. Bar Matthews et al., 1999) or first-order climate changes such as D/O events during the last glacial (e.g. Spo.tl and Mangini, 2002; Genty et al., 2003)..

4.1. Isotope stage 6 and the penultimate deglaciation

Speleothem records from Late Pleistocene mid- to high-latitude sites are discussed first, because these are likely to be sensitive to glacial–interglacial transitions, and they illustrate an important feature of speleothems, namely that calcite deposition slows down or ceases during glacials. Fig. 1 is a compilation of approximately 750 TIMS U-series speleothem dates that have been published during the past decade, plotted against the latitude of the relevant cave site.

The absence of speleothem deposition in the mid- to high latitudes of the Northern Hemisphere during isotope stage 2 is striking, consistent with results from previous compilations based on less precise alpha-spectrometric dates (e.g. Gordon et al., 1989; Baker et al., 1993; Hercmann, 2000). By contrast, speleothem deposition appears to have been essentially continuous through the glacial periods at lower latitudes in the Northern Hemisphere (Fig. 1)..

..A comparison of the DH-11 [Devils Hole] record with the Vostok (Antarctica) ice-core deuterium record and the SPEC- MAP record that largely reflects Northern Hemisphere ice volume (Fig. 2) indicates that both clearly record the first-order glacial–interglacial transitions.

Note 4 – Note the reference to Milankovitch theory “explaining” Termination I. This appears to be the point that insolation was at least rising as Termination began, rather than falling. It’s not demonstrated or proven in any way in the paper that Termination I was caused by high latitude northern insolation, it is an illustration of the way the “widely-accepted point of view” usually gets a thumbs up. You can see the same point in the quotation from the Zhao paper. It’s the case with almost every paper.

If it’s impossible to disprove a theory with any counter evidence then it fails the test of being a theory.

Note 5 – More from Drysdale et al 2009:

During the Late Pleistocene, the period of glacial-to-interglacial transitions (or terminations) has increased relative to the Early Pleistocene [~100 thousand years (ky) versus 40 ky]. A coherent explanation for this shift still eludes paleoclimatologists. Although many different models have been proposed, the most widely accepted one invokes changes in the intensity of high-latitude Northern Hemisphere summer insolation (NHSI). These changes are driven largely by the precession of the equinoxes, which produces relatively large seasonal and hemispheric insolation intensity anomalies as the month of perihelion shifts through its ~23-ky cycle.

Recently, a convincing case has been made for obliquity control of Late Pleistocene terminations, which is a feasible hypothesis because of the relatively large and persistent increases in total summer energy reaching the high latitudes of both hemispheres during times of maximum Earth tilt. Indeed, the obliquity period has been found to be an important spectral component in methane (CH4) and paleotemperature records from Antarctic ice cores.

Testing the obliquity and other orbital-forcing models requires precise chronologies through terminations, which are best recorded by oxygen isotope ratios of benthic foraminifera (d18Ob) in deep-sea sediments (1, 8).

Although affected by deep-water temperature (Tdw) and composition (d18Odw) variations triggered by changes in circulation patterns (9), d18Ob signatures remain the most robust measure of global ice-volume changes through terminations. Unfortunately, dating of marine sediment records beyond the limits of radiocarbon methods has long proved difficult, and only Termination I [T-I, ~18 to 9 thousand years ago (ka)] has a reliable independent chronology.

Most marine chronologies for earlier terminations rely on the SPECMAP orbital template (8) with its a priori assumptions of insolation forcing and built-in phase lags between orbital trigger and ice-sheet response. Although SPECMAP and other orbital-based age models serve many important purposes in paleoceanography, their ability to test climate- forcing hypotheses is limited because they are not independent of the hypotheses being tested. Consequently, the inability to accurately date the benthic record of earlier terminations constitutes perhaps the single greatest obstacle to unraveling the problem of Late Pleistocene glaciations..

..

Obliquity is clearly very important during the Early Pleistocene, and recently a compelling argument was advanced that Late Pleistocene terminations are also forced by obliquity but that they bridge multiple obliquity cycles. Under this model, predominantly obliquity-driven total summer energy is considered more important in forcing terminations than the classical precession-based peak summer insolation model, primarily because the length of summer decreases as the Earth moves closer to the Sun. Hence, increased insolation intensity resulting from precession is offset by the shorter summer duration, with virtually no net effect on total summer energy in the high latitudes. By contrast, larger angles of Earth tilt lead to more positive degree days in both hemispheres at high latitudes, which can have a more profound effect on the total summer energy received and can act essentially independently from a given precession phase. The effect of obliquity on total summer energy is more persistent at large tilt angles, lasting up to 10 ky, because of the relatively long period of obliquity. Lastly, in a given year the influence of maximum obliquity persists for the whole summer, whereas at maximum precession early summer positive insolation anomalies are cancelled out by late summer negative anomalies, limiting the effect of precession over the whole summer.

Although the precise three-cycle offset between T-I and T-II in our radiometric chronology and the phase relationships shown in Fig. 3 together argue strongly for obliquity forcing, the question remains whether obliquity changes alone are responsible.

Recent work invoked an “insolation-canon,” whereby terminations are Southern Hemisphere–led but only triggered at times when insolation in both hemispheres is increasing simultaneously, with SHSI approaching maximum and NHSI just beyond a minimum. However, it is not clear that relatively low values of NHSI (at times of high SHSI) should play a role in deglaciation. An alternative is an insolation canon involving SHSI and obliquity.

Note 6 – There are a number of papers based on Dongge and Hulu caves in China that have similar data and conclusions but I am still trying to understand them. They attempt to tease out the relationship between δ18O and the monsoonal conditions and it’s involved. These papers include: Kelly et al 2006, High resolution characterization of the Asian Monsoon between 146,000 and 99,000 years B.P. from Dongge Cave, China and global correlation of events surrounding Termination II; Wang et al 2008, Millennial- and orbital-scale changes in the East Asian monsoon over the past 224,000 years.

Link: http://scienceofdoom.com/2014/01/23/ghosts-of-climates-past-thirteen-terminator-ii/

Teil I und II: http://www.eike-klima-energie.eu/climategate-anzeige/das-raetsel-der-eiszeiten-teil-i-und-ii/

Teil III: http://www.eike-klima-energie.eu/climategate-anzeige/das-raetsel-der-eiszeiten-teil-iii-hays-imbrie-shackleton/

Teil IV: http://www.eike-klima-energie.eu/climategate-anzeige/das-raetsel-der-eiszeiten-teil-iv-umlaufbahnen-jahreszeiten-und-mehr/

Teil V: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-v-aenderungen-der-ekliptik-und-der-praezession/

Teil VI: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-vi-hypothesen-im-ueberfluss/

Teil VII: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-7-global-circulation-models-i/

Teil VIII: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-8-global-circulation-models-ii/

Teil IX: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-9-global-circulation-models-iii/

Teil X: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-10-global-circulation-models-iv/

Teil XI: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-xi-das-ende-der-letzten-eiszeit/

Teil XII: http://www.eike-klima-energie.eu/klima-anzeige/das-raetsel-der-eiszeiten-teil-xii-gcm-v-wie-enden-eiszeiten/

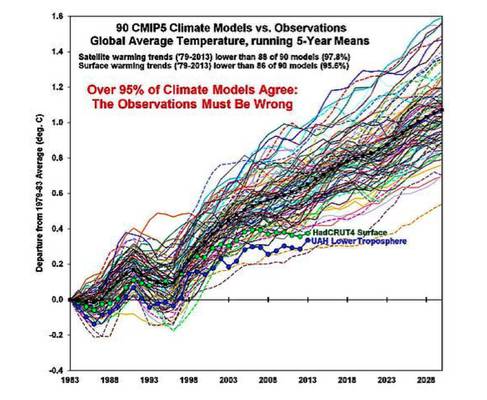

Abb.1 Klimamodelle im Vergleich zur Beobachtung.

Abb.1 Klimamodelle im Vergleich zur Beobachtung.