Siehe auch im Internet mit Diskussionsforum: www.klimanotizen.de/html/klima-_und_kernenergieskepsis.html

Fossile Energien leisten den überwiegenden Anteil an der weltweiten Energieversorgung. Eine Welt im Wohlstand ohne sie ist auf längere Zeit nicht vorstellbar. Und die Ressourcen sind dabei auch auf lange Zeit gesichert.

Warum sollte man nun Energieformen in großem Umfang einsetzen, die im Vergleich schlechter abschneiden, als die Fossilen?

Jede andere Energieform muss sich an den Fossilen messen lassen. Dabei interessieren vor allem Wirtschaftlichkeit, Verfügbarkeit, Versorgungssicherheit, Gesundheit/Umweltverträglichkeit und Sicherheit (bspw. Terrorismusgefahr).

Heutige Kernkraftwerke liefern auch nur Strom wie die Fossilen und das zu einem höheren Preis und großer Gefährdung der Sicherheit und Belastung zukünftiger Generationen.

Ein oft angeführter Vorteil der Kernenergie – die Energiedichte – ist gleichzeitig auch die eigentliche Ursache ihrer Sicherheitsprobleme.

Im Folgenden wird gezeigt, wie die heutige und real existierende Kernenergie bei einem Vergleich mit den Fossilen in relevanten Punkten deutlich schlechter abschneidet.

Es wird auch gezeigt, dass Klima- und Kernenergieskeptiker (eigentlich) natürliche Verbündete sind.

Besonders gravierend: ein starker Ausbau der Kernenergie wäre ein Eldorado für den Islamischen Staat und andere Terroristen.

Hinweis: Einige Anmerkungen zur Radioaktivität im Anhang

Inhalt

1. Sechs Mindestanforderungen an die Kernenergie

2. Gibt es Alternativen?

3. Fukushima, der aktuelle Anlass

4. Heutige KKWs haben kaum lösbare Sicherheitsprobleme

5. Sichere KKWs wären zu teuer und schaffen sich daher selber ab

6. KKWs sind die wichtigste Voraussetzung zur Verbreitung von Atomwaffen

7. KKWs werden nicht benötigt, da es ausreichend saubere fossile Energie für einen langfristigen Übergang gibt

8. Wie wird die Kernenergie verteidigt?

9. Vollversorgung durch KKWs?

10. Heutige KKWs sind Folge eines Versagens der Fachwelt – ähnlich wie beim Klima und anderen Themen

11. Klima- und Kernkraftskeptiker sind natürliche Verbündete

12. Für die Kernenergie – zum Schaden der Klimaskepsis und des Fortschritts

1. Sechs Mindestanforderungen an die Kernenergie

Leitgedanke: So sicher wie moderne Fossile Energie

Angewandt auf die Besonderheiten der Kernenergie müssen folgende sechs Bedingungen gestellt werden, um bei einem Vergleich mit den Fossilen bestehen zu können:

Kernenergie …

♦ muss inhärent sicher sein,

♦ muss eine zuverlässige Folgenbegrenzung bei Angriffen (Terror, Krieg) und Havarien haben,

♦ darf nur geringe Mengen radioaktiver Abfälle hinterlassen,

♦ darf keine Weiterverbreitung von Atomwaffen ermöglichen,

♦ darf auch bei maximalen gesellschaftlichen Umbrüchen (Krieg, Failed State) nur geringe, begrenzte Folgen haben und

♦ muss die dauerhafte Funktionssicherheit vorstehender Bedingungen im Dauerbetrieb nachgewiesen haben.

Wird auch nur eine dieser Bedingungen nicht zuverlässig erfüllt, dann kann die reale Kernenergie keine Alternative zu den Fossilen sein. Die Risiken wären groß.

Keine der real existierenden Kernenergietechnologien ist jedoch in der Lage alle vorstehenden Bedingungen zu erfüllen.

Daher ist die derzeitige realexistierende Kernenergie in Sicherheitsfragen gegenüber den Fossilen ein Rückschritt und sollte bei neuen Kraftwerken nicht mehr eingesetzt werden.

2. Gibt es Alternativen?

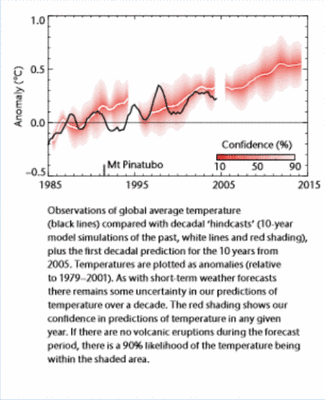

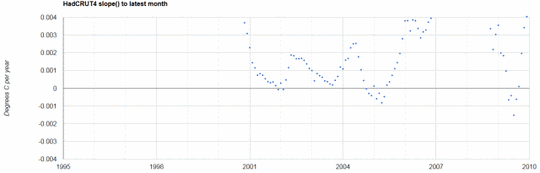

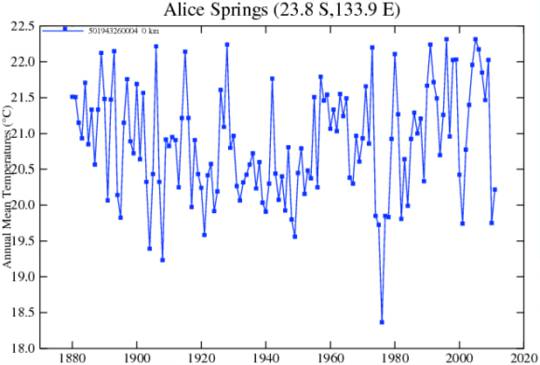

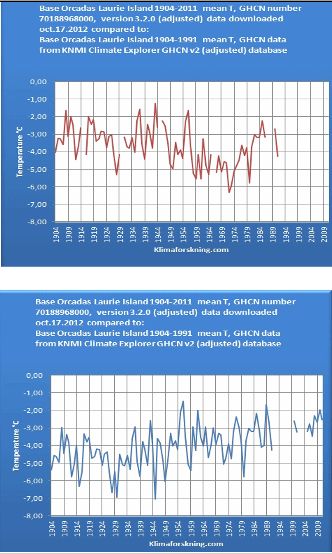

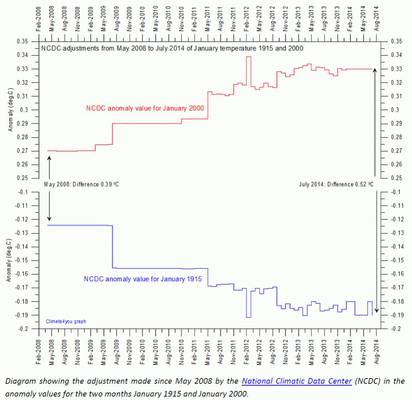

Es gibt ausreichend fossile Brennstoffe für mehr als 200, vielleicht sogar für 1.000 Jahre7. Eine realistische Alternative zu den Fossilien im Großmaßstab gibt es derzeit nicht. Ein Klimaproblem wegen den CO2-Emissionen ist nicht vorhanden5. Die Energiewende mit den Erneuerbaren kann bereits als gescheitert6 betrachtet werden.

Alle über die real existierende Kernenergie hinausgehenden Konzepte sind mehr oder weniger reine Theorie ohne ausreichende Bewährung in der Praxis.

Menschlicher Erfindergeist wird jedoch im Laufe des 21. Jahrhunderts attraktive Alternativen entwickeln: vielleicht auf solarer oder aber auch auf atomarer Basis.

Die Zeit für die Menschheit ist dafür in ausreichendem Umfang vorhanden.

3. Fukushima, der aktuelle Anlass

Zusätzlich zum Erdbeben und dem Tsunami in Japan hat die Havarie des Kernkraftwerkes Fukushima die Bevölkerung dort hart getroffen. Der dort verwendete Siedewasserreaktor (SWR) ist nicht inhärent sicher.

Evakuierung aus der 30 und mehr Kilometerzone, unverkäufliche landwirtschaftliche Produkte, Belieferungsschwierigkeiten der lokalen Supermärkte aus Angst vor Strahlung, Exportschwierigkeiten, etc.. Die weltweite Aufmerksamkeit ist vom eigentlichen Erdbeben abgelenkt. Am KKW haben die Zuständigen nicht viel im Griff und machen einen unbeholfenen und unvorbereiteten Eindruck. Währenddessen war es nicht absehbar, ob das Schlimmste überstanden ist oder erst noch bevorsteht. Vor allem wegen der fehlenden inhärenten Sicherheit geriet das KKW außer Kontrolle.

Wäre dort ein fossiles Kraftwerk mit der reichlich vorhandenen Kohle gebaut worden, ginge es den Menschen dort heute deutlich besser.

Die heutige Kenenergie ist kein Ausdruck technologischen Fortschritts, da sie unausgereift ist. Die Glaubwürdigkeit der Kernindustrie bezüglich Sicherheit ist mittlerweile dramatisch geschrumpft.

Immer deutlicher wird, was Klima- und Kernenergieskeptiker gemeinsam haben: Sie stehen unausgereiften und u.a. vom Staat in den Markt gedrückten Konzepten und Technologien gegenüber, die großen Schaden anrichten.

4. Heutige KKWs haben kaum lösbare Sicherheitsprobleme

Die Terrorgefahr ist hochaktuell. Die Attentäter vom 11. September 2001 hätten sich auch ein KKW als Ziel aussuchen können, was im Erfolgsfalle zu einer dauerhaften großräumigen radioaktiven Verseuchung geführt hätte. Ein kräftiger Beschuss durch Raketen o.ä. würde jederzeit das gleiche bewirken.

Außergewöhnliche Naturereignisse wie Erdbeben, Fluten und Erdrutsche würden viele KKWs überfordern und zu ähnlichen oder schlimmeren Ergebnissen führen wie in Fukushima. Warum sollte man den stets abwiegelnden und beschönigenden Erklärungen der Betreiber noch Glauben schenken?

In anderen Technologiebereichen wie der Automobilindustrie ist es üblich, Sicherheit praktisch und glaubwürdig zu demonstrieren (bspw. Crashtests). Warum entfällt das bei den KKWs?

Realistische Sicherheitstest mit Flugzeugen, Geschossen, Sabotage, etc. unterbleiben, weil ihre Durchführung nicht nur überaus teuer wäre, sondern auch zu großräumiger Verstrahlung führen könnte.

Daher stellt der Umgang mit der Sicherheit bei der Kernenergie einen Rückschritt dar, da auf einen solchen realitätsnahen Nachweis verzichtet wird. Berechnungen und Modellierungen gelten als ausreichend. Das erinnert an die analoge Praxis beim Klimaalarmismus.

Das Haftungsrisiko für die Betreiber von KKWs wird in Wirklichkeit nach der Wirtschaftlichkeit definiert und deckt bei Weitem längst nicht alle Kosten ab.

Kernenergie erfordert kurz- und langfristig ununterbrochene, stabile Verhältnisse weltweit. Wer hätte sich vor einigen Jahrzehnten noch archaische Ideologien mit Selbstmordterrorismus in einer modernen Welt vorstellen können? Die Risiken der heutigen Kernenergie passen nicht in diese real existierende Welt.

Solange die Sicherheit der Kernenergie nicht praktisch und der Öffentlichkeit gegenüber nachvollziehbar demonstriert wird, kann eine ausreichende Sicherheit als nichtexistent gelten. Warum sollten nicht Kohlekraftwerke als Referenz für ein akzeptables Sicherheitsrisiko für die Kernenergie gelten? Das wäre auch in Übereinstimmung mit dem Fortschrittsbegriff.

Wir Deutschen haben seit Jahrzehnten eine kritische und aktive Öffentlichkeit gegenüber der Kernenergie, während die Japaner eher unkritisch gewesen sind.

Ein derart anfälliges KKW wie in Fukushima wäre höchstwahrscheinlich in Deutschland wegen der kritischen Öffentlichkeit nicht gebaut worden.

5. Sichere KKWs wären zu teuer und schaffen sich daher selber ab

Allein die umfassende Sicherung gegen Terroranschläge dürfte so hohe Kosten verursachen, dass keine KKWs mehr gebaut werden würden. Ein seinerzeit diskutiertes Ministeriumspapier4 zur Sicherheitsüberprüfung dürfte bei konsequenter Umsetzung das Aus vieler KKWs bedeuten.

6. KKWs sind die wichtigste Voraussetzung zur Verbreitung von Atomwaffen

Die Verbreitung von Atomwaffen gehört zu den größten weltweiten Problemen.

Iran, Nordkorea, Pakistan und früher der Irak, u.a. binden dabei die internationale Aufmerksamkeit und Ressourcen. Die vorhandenen oder erstrebten Atomwaffen dieser Länder verhindern langfristig Problemlösungen und sichern menschenverachtende Diktaturen. Was passiert, wenn in Pakistan die Islamisten den atomaren Bereich übernehmen? Das ist inzwischen realistisch geworden.

Ohne die Kernenergie hätten wir diese Probleme mit der Weiterverbreitung von Atomwaffen und ihren Folgen nicht.

7. KKWs werden nicht benötigt, da es ausreichend saubere fossile Energie für einen langfristigen Übergang gibt

Alle gegenwärtigen und zukünftigen Probleme durch die heutige Kernenergie sind vermeidbar, wenn beispielsweise auf die reichlich vorhandenen Fossilen Kohle und Gas gesetzt wird. Dabei können problemlos Übergangszeiten von mindestens 200 Jahre überbrückt werden bis es etwas Besseres gibt. Heutige Kohlekraftwerke sind im Gegensatz zu früher sauber, was einen echten Fortschritt darstellt.

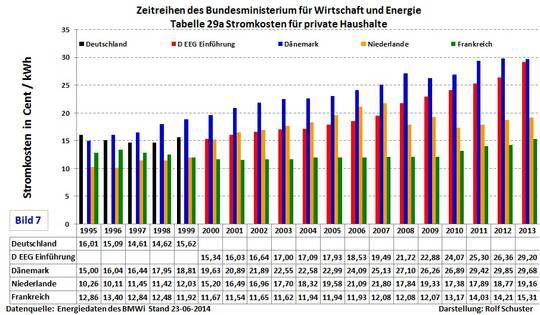

Kohle ist auch die vergleichsweise günstigste Energie. Die Erzeugungskoste n1 für Strom aus Kraftwerken, die 2010 fertig wurden, betragen pro kWh: Braunkohle 2,5 ct, und Steinkohle 3,3 ct. Die Alternativenergien liegen astronomisch darüber.

Die Stromerzeugungskosten bei der Kernenergie für Neubauten müssen wohl deutlich nach oben korrigiert werden und liegen inzwischen sogar in der Größenordnung der Erneuerbaren.

So vereinbarte Großbritannien einen auf 30 Jahre festgelegten Garantiepreis von 11 ct/KWh für neu zu errichtende Kernkraftwerke. Das ist mehr als es bei Windenergieanlagen (9 ct/KWh) in Deutschland üblich ist.

Bei den unterschiedlichen Energiearten gibt es normalerweise unterschiedliche Anzahl von Opfern durch verschiedene Einflüsse. Dabei werden jetzt Statistiken2 in die Diskussion gebracht, bei denen die Kohle mit relativ viel angegebenen Opfern (161 Tote pro TWh) oben und die Kernenergie (0,04 Tote pro TWh) ganz unten rangiert. Klimaskeptiker haben jedoch leidvolle Erfahrungen gemacht, wie Statistiken so aufbereitet werden können, dass sie einen gewollten Eindruck hinterlassen. In diesem Fall sind die Angaben für Kohle grob irreführend, denn es sind dort Tote weltweit durch Abgase gemeint. Da alle Kohlekraftwerke in Deutschland über eine Rauchgaswäsche verfügen, sind solche Angaben irrelevant.

8. Wie wird die Kernenergie verteidigt?

Klimaschutz ist inzwischen das zentrale Argument zum Bau von KKWs weltweit geworden. Die früheren Argumente wie „Die Lichter gehen aus!“ und für saubere Luft gegen schmutzige fossile Energien sind längst überholt oder waren nie zutreffend.

Desweiteren wird mit Ressourcenschutz und nur geringen Gefahren argumentiert. Fukushima sei bald vorbei und dann wenig dramatisch ausgegangen. Gerade wir in Deutschland seien hysterisch und voller Zukunfts- und Fortschrittsängste. Die Medien wären voller Unwahrheiten in wesentlichen Punkten. Diese Sichtweisen mögen zur subjektiv empfundenen Entspannung beitragen, begründet aber nicht die Notwendigkeit von Kernenergie.

Über Kernenergie wird von ihren Verteidigern in der Regel nicht ganzheitlich diskutiert. Das Restrisiko durch überraschend große Naturereignisse (Erdbeben, Fluten) wird als gering eingeschätzt. Fukushima ist jedoch ein Beispiel, dass die Betreiber nicht mit einem Ereignis dieser Größenordnung gerechnet hatten. Ebenfalls werden der Terrorismus und Kriegsereignisse wenig einbezogen. Auch die Verbreitung von Atomwaffen besonders an Schurkenstaaten spielt bei den Betrachtungen der Verteidiger kaum eine Rolle.

Zur ganzheitlichen Betrachtung gehören auch die Bewertung von Alternativen und die Frage, ob die heutige Kernenergie angesichts des Restrisikos überhaupt gebraucht wird.

Nirgends gibt es einen Beleg, dass die Kernenergie unverzichtbar sei.

Auch hier gibt es meiner Beobachtung nach eine Vermeidungshaltung in der Diskussion.

Die fossilen Energien erleben gerade einen Aufschwung. Neue Fördermöglichkeiten bei Schiefergas haben einen Trend ausgelöst und auch die Kernenergie preislich stark unter Druck gesetzt. Vor allem, wenn Nachrüstungen angeordnet werden. Es gibt eine Abschätzung, wonach die USA über die meisten Energiereserven weltweit verfügen und sogar zum Nettoexporteur werden können. Es ist derzeit viel in Bewegung bei den fossilen Energien.

9. Vollversorgung durch KKWs?

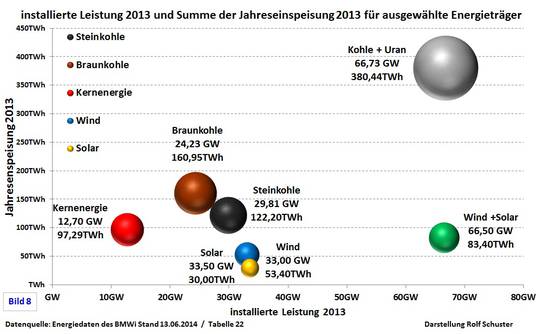

Wie bei den Erneuerbaren wird auch bei der Kernenergie fast immer nur über die Stromversorgung geredet. Dabei macht diese nur ca. 20% des Primärenergiebedarfes Deutschlands aus.

Entscheidend ist jedoch:

Wie groß wäre der Aufwand, wenn Deutschland eine Voll- oder Teil- (50%) Versorgung des Primären Energiebedarfs aus KKWs hätte?

Folgende Rechnung9 ist dabei – erst einmal vorläufig – entstanden:

100%-Lösung: 357 KKWs ständig in Betrieb, à 2.000 MW.

Danach müssten jedes Jahr 7 KKWs fertig gestellt werden und gleich viele abgeschaltet und entsorgt werden.

50%-Lösung: wie vor, jedoch 178 KKWs in Betrieb, 4 KKWs müssten jährlich neu gebaut und gleich viele abgeschaltet und entsorgt werden.

Plus zusätzliche Infrastruktur mit allem was dazu gehört.

Fazit: Eine derartige Energieinfrastruktur wäre ein Eldorado für Terroristen und andere Feinde des Fortschritts!

Gerade für den “Islamischen Staat” dürfte das ein “gefundenes Fressen” sein.

10. Heutige KKWs sind Folge eines Versagens der Fachwelt – ähnlich wie beim Klima und anderen Themen

Die Kernenergie ist nicht im freien Markt eingeführt worden wie Autos oder Computer. Sie war das Ergebnis einer Anstrengung gesellschaftlicher Gruppen und des Staates aufgrund „höherer“ Einsicht. Die Energiewirtschaft war ursprünglich skeptisch. Politischer Druck hat die Kernenergie durchgesetzt und das erinnert an den Klimaschutz und die Erneuerbaren Energien.

Arnolf Baring in der FAZ3:

Die Anfänge der deutschen Kernenergie-Debatte

Blickt man zurück auf die Anfänge der Kernenergie-Debatte, stellt man fest, dass in den fünfziger und sechziger Jahren unter Politikern aller Parteien und Publizisten aller Richtungen Euphorie herrschte, ein wahrer Atomenthusiasmus. Diese Euphorie war Ausdruck einer allgemeinen Aufbruchsstimmung im Deutschland der Nachkriegszeit, zumindest in der Bundesrepublik. Wirtschaftswachstum und technologische Innovation waren damals Inbegriffe des gesellschaftlichen Fortschrittsdenkens. Dem entsprach die rückhaltlose Bejahung neuer Technologien, die eine gute, eine bessere Zukunft verhießen.

Ausgelöst wurde die Atombegeisterung durch die berühmte "Atoms for Peace"- Rede des amerikanischen Präsidenten Eisenhower vor den Vereinten Nationen 1953. Diese Ausführungen weckten in der Weltöffentlichkeit die Hoffnung, nach dem nuklearen Schrecken von Hiroshima und Nagasaki werde die Kernenergie nunmehr für friedliche Zwecke eingesetzt.

Skepsis gegenüber der Kernenergie wurde in diesen frühen Jahren ausgerechnet von jenen geäußert, bei denen man es am wenigsten erwarten würde: von der Energiewirtschaft. Zu einer Zeit, in der die fossilen Energieträger im Übermaß zur Verfügung standen, beugten sich die Erzeugergesellschaften nur zögerlich dem politischen Druck, in die teure und komplexe neue Energietechnik zu investieren. Interessanterweise wurden die Risiken der Kernenergie gerade in Betreiberkreisen zu jener Zeit noch recht offenherzig diskutiert – etwa die gesundheitsschädlichen Wirkungen der radioaktiven Strahlungen oder das Problem der Entsorgung radioaktiver Abfälle.

Bis in die sechziger Jahre hinein fanden solche kritischen Stimmen jedoch keinen bedeutsamen öffentlichen Widerhall.

Aus der Fachwelt gab es bis Ende der 70er kaum Kritik an der Sicherheit der Kernenergie. Sie war bereit das große Restrisiko zu verteidigen oder durch Schweigen zu tolerieren. Darin liegt das Versagen der Fachwelt.

So schrieb die Kernindustrie damals in der Broschüre „66 Fragen, 66 Antworten“: „Ernsthafte Wissenschaftler haben sich nicht auf die Seite der Gegner gestellt“. Zehn Jahre später war das schon anders. Die Klimaskeptiker machen inzwischen eine analoge ähnliche Erfahrung.

11. Klima- und Kernkraftskeptiker sind natürliche Verbündete

Beides sind soziale Bewegungen und haben den gleichen Gegner: den Klimaalarmismus.

Klimaskeptiker sehen darin nicht nur ein falsches wissenschaftliches Konzept für die Zukunft. Wenn es nur um Wissenschaft ginge, dann wäre die Auseinandersetzung eine rein akademische, wie es sie in der Wissenschaftsgeschichte immer wieder gab.

Klimaskeptiker sehen darin jedoch vielmehr eine Fehlorientierung der Gesellschaft, die dabei ist großen Schaden zu nehmen: in Wirtschaft, Politik/Demokratie und Wissenschaft. Der Klimaalarmismus zeigt fundamentalistische Tendenzen.

Kernkraftskeptiker sehen die Sicherheit großräumig gefährdet und sind mit den Argumenten des Klimaalarmismus konfrontiert, der dabei ist weltweit KKWs wieder durchzusetzen. Das Hauptargument dabei ist die Reduktion menschengemachter Treibhausgase wie CO2 zur Vermeidung einer vorausgesagten Klimakatastrophe.

Bisher gibt es zwischen diesen beiden Bewegungen eine große Distanz. Viele Klimaskeptiker meinen, dass die Kernkraftgegner fortschrittsfeindlich sind und viele von ihnen gesellschaftlich radikale Ziele verfolgen. Die meisten Kernkraftskeptiker selbst jedoch würden dieses vehement bestreiten.

Die allermeisten Kernkraftgegner meinen, dass sie ihre Ziele auf Abschaltung der KKWs mit dem Klimaschutz und den Erneuerbaren Energien erreichen müssen. Sie haben noch nicht erkannt, dass sie die falschen Partner haben.

Zwischen diesen beiden Bewegungen gibt es bisher so gut wie keine Kontakte. In einer Zusammenarbeit würden jedoch riesige Chancen für beide Seiten liegen.

12. Für die Kernenergie – zum Schaden der Klimaskepsis und des Fortschritts

Inzwischen sind weltweit einige bekannte Ökoaktivisten von ihrer Kritik an der Kernenergie abgerückt und sehen nun die Klimazukunft bei der Kernenergie besser aufgehoben, als dagegen zu sein.

Viele Klimaskeptiker, die die Kernenergie befürworten, sehen sich jetzt bestätigt. Wenn sogar bekannte Ökoaktivisten die Kernenergie befürworten, dann muss es ein starkes Argument für sie sein. Wird jedoch nicht eher umgekehrt ein Schuh daraus?

Liegt es nicht nahe, dass es Leute sind, die aus Sicht der Klimaskepsis schon einmal grob danebenliegen und nur wegen dem Kimaalarmismus nun für die Kernenergie sind? Folgt nicht eher aus dem einen Irrtum der nächste? Erleben wir bald gemeinsame Resolutionen und Demos von kernenergiebefürwortenden Klimaskeptikern und Klimaalarmisten? Sind diese vielleicht sogar auch natürliche Verbündete?

In einer aktuellen Broschüre von EIKE (8) wird faktisch ein allererster Schritt in Richtung Zusammenarbeit von Klimaschützern und klimaskeptischen Kernenergiebefürwortern getan. Dor8t (, S. 24) heißt es:

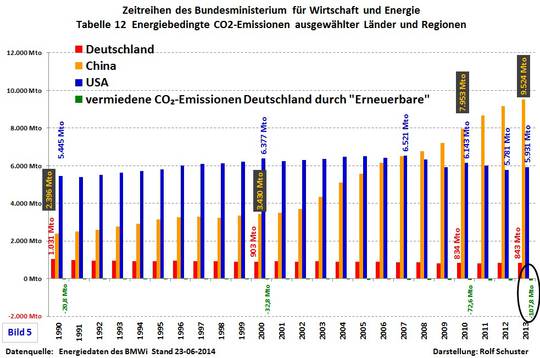

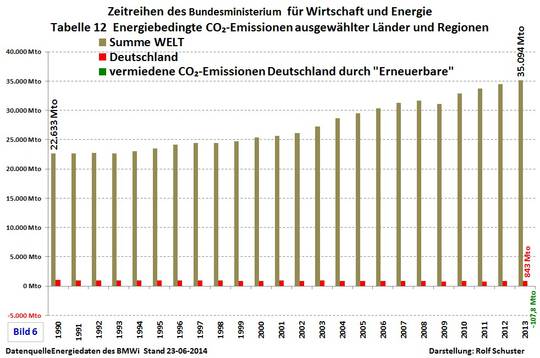

“Wer allerdings die Klima-CO2-Warnungen ernst nimmt, sei darauf hingewiesen, dass die weltweit arbeitenden Kernkraftwerke 2012 etwa 2,4 Milliarden Tonnen CO2 –Emissionen (von insgesamt ca. 33 Mrd t) vermieden haben.” Auch anderen Stellen dieser Broschüre wird die Treibhausgasvermeidende Rolle der Kernenergie immer wieder fast lobend hervorgehoben.

Von einer weltweiten positiven Wirkung von CO2 auf das Pflanzenwachstum ist im Gegensatz zu sonst bei EIKE in dieser Broschüre nun keine Rede mehr.

Jedenfalls spielte und spielt die unausgereifte Kernenergie den Wachstums- und Fortschrittskritikern seit 40 Jahren in die Hände. Und viele Freunde des Wachstums und des Fortschritts spielen den unfreiwilligen nützlichen Aktivisten für die Kernenergie und deren Gegner gleichzeitig.

Es ist nicht fortschrittlich für die Verbreitung einer unausgereiften Technologie zu sein. Im Gegenteil.

Vielleicht ist es jetzt an der Zeit die Sprachlosigkeit, Informationsblockaden und die teilweise Diskursunfähigkeit der Lager zu überwinden.

Klaus Öllerer

Publizist

www.KlimaNotizen.de, 0170 92 60 771, Klaus.Oellerer@oellerer.net

Letzte Änderung: 16.09.2014

Siehe auch >> Antworten auf “Hundert gute Antworten”

Anhang

Grundsätzliche Anmerkungen zur Gefährlichkeit der Radioaktivität

* Diese wird von Kernenergiegegnern oft masslos übertrieben und von Befürwortern manchmal unterschätzt.

* Diese kann möglicherweise in geringem Ausmaß sogar nützlich sein.

* Die reale Möglichkeit der umfassenden Freisetzung des radioaktiven Inventars einer Kernenergieanlage ist nicht hinnehmbar (Tschernobyl, Fukushima). Große Landstriche würden ggfs. unbewohnbar. Es gibt genügend Energiealternativen.

Quellen

1) Stromerzeugungskosten

http://www.klimanotizen.de/2010.10.16_Stromerzeugungskosten_www.energie-verstehen.de_-_Das_Informationsportal_des_BMWi_fur_Verbraucher.pdf

2) Tote nach Energiearten

Bei Kohle werden Abgastote gezählt. In Deutschland haben jedoch alle Kohlekraftwerke eine Rauchgaswäsche.

http://nextbigfuture.com/2011/03/deaths-per-twh-by-energy-source.html

3) Die Anfänge der deutschen Kernenergie-Debatte

http://www.faz.net/s/Rub0E9EEF84AC1E4A389A8DC6C23161FE44/Doc~EAD3C1D5168B74DC2A201DA0EAB23CB52~ATpl~Ecommon~Scontent.html

4) Internes Papier – Regierung erwägt strengere Vorschriften für AKW

http://www.spiegel.de/wissenschaft/technik/0,1518,751741,00.html

5) Kein Klimaproblem mit CO2-Emissionen

Siehe bei folgenden Links:

www.kaltesonne.de, www.eike-klima-energie.eu, www.wattsupwiththat.com, www.KlimaNotizen.de

6) Scheitern der Erneuerbaren

Energiewende und die Kosten

http://tiny.cc/v858mw

7) Genügend Fossile Energien sind vorhanden

„Energie – Beam me up, Scotty“

http://www.klimakontroverse.de/2013.10.31_Energie_Beam_me_up_Scotty.pdf

8) Energiepolitisches Manifest

Argumente für die Beendigung der Energiewende

http://www.eike-klima-energie.eu/uploads/media/Energiepolitisches_Manifest_31-01-2014_23_10.pdf

9) Vollversorgung durch KKWs?

Annahmen:

Primärenergiebedarf Deutschland: ca. 4.000 Mrd KWh

Pro KKW: 2 Mio KW, 7.008 h jährliche Verfügbarkeit (80%), Anzahl Reservekraftwerke: 25%, angenommene Lebensdauer: 50 Jahre., Bedarf bei 100%-Versorgung: 357 KKWs, jährlicher Neubau und Entsorgung von jeweils 9 KKWs

Der Einfachheit halber ohne Berücksichtigung von Grund- und Spitzenlast.

Stellungnahme von Dr. Dietmar Ufer vom 12.10.14

Herrn Öllerers Ausführungen sind von einer einzigartigen Besessenheit geprägt: Von Angst! Und damit befindet er sich in bester Gesellschaft mit großen Teilen der deutschen – und leider nicht nur der deutschen – Politik. Die einen haben Angst vor der Kernenergie („Nuklearphobie“), andere Angst vorm Klimawandel („Klimaphobie“), weitere haben Angst vorm Ende der Energieressourcen („Energiemangelphobie“) – ohne irgend eine oder zwei dieser Ängste oder sogar aller drei gleichzeitig (wie in der Bundesregierung) lässt sich offenbar keine „moderne Energiepolitik“ mehr betreiben. (Ich bin mir natürlich darüber im Klaren, dass es noch viel mehr Ängste gibt, mit Hilfe derer die Menschheit „regiert“ und dirigiert wurde und wird…)

Wenn derartige Ängste, wie sie hier von Herrn Öllerer formuliert wurden, schon immer die Menschheit beherrscht hätte, würden wir heute noch Feuersteine sammeln, um sie zu Faustkeilen umzuarbeiten – und hätten Angst davor, dass Feuersteine bald nicht mehr zu finden sein könnten.

Natürlich sollte auch berücksichtigt werden, dass Angst zu großen Teilen auch aus Unwissenheit entspringt: Es ist ja auch schwierig, ein Kernkraftwerk zu verstehen… Noch schwieriger zu verstehen sind neue technische Entwicklungen zur friedlichen Nutzung der Kernenergie, wie sie in vielen Ländern der Erde betrieben werden – trotz der Warnungen von Herrn Öllerer. Die Tatsache, dass Deutschland auf die gegenwärtig sichersten Kernkraftwerke der Welt verzichten will und sogar weitere Forschung zur Weiterentwicklung nicht mehr fördert, sogar verbietet sind, zeugt vom erkennbaren Niedergang des Wissenschaftsstandortes D. und vom zu erwartenden Untergang des Wirtschaftsstandortes D. Man könnte auch von Dekadenz eines Landes sprechen, dass sich einbildet, so wohlhabend zu sein, dass es keinen energietechnischen Fortschritt mehr braucht… (Das gilt sinngemäß auch für andere Fachgebiete, z. B. die Stammzellforschung oder die Gentechnik!) Herr Öllerer bekämpft die gegenwärtigen Kernkraftwerke – will aber auch keine neuen, die noch sicherer, noch kostengünstiger sind. Öllerer und die deutsche Energiepolitik – vereint in die Steinzeit zurück?

Viele der hier genannten Contra-Öllerer-Argumente kann man nur unterstreichen, auch das Argument von Hanna Thiele, wonach die Begründung für die Kernenergie in Deutschland Hand in Hand ging (und leider immer noch geht) mit der „Klimaphobie“. Wenn der deutschen Nuklear-Wissenschaft und -Industrie (Deutsche Physikalische Gesellschaft, Deutsches Atomforum etc.) zu ihrer Rechtfertigung nichts anderes einfällt als die Angst vor der Klimakatastrophe zu schüren, dann muss das als ein mit abgrundtiefer Dummheit gepaarter Opportunismus gebrandmarkt werden, auch wenn damit namhafte Persönlichkeiten angeprangert werden. Falsch ist es aber, nur wegen dieses durch nichts zu rechtfertigenden Fehlverhaltens der deutschen Kernenergielobby die gesamte Nuklearwirtschaft ins Abseits zu stellen! Nebenbei bemerkt: Die Kernenergietechnik in der DDR, zu der ich (auf Grund meiner fachlichen Vergangenheit) beste Beziehungen hatte, hat sich nie einer solchen Argumentation bedient! Unsere Sorge waren die immensen Schwefeldioxid-Emissionen der Braunkohlenkraftwerke. Der Begriff „Klimaschutz“ spielte weder in der wissenschaftlichen Debatte noch in der Praxis eine Rolle. Dass Kohlendioxid ein Schadstoff sei, habe ich erst nach 1990 „gelernt“!

Abschließend noch ein Faktum aus einem untergegangenem Land: Das KKW Lubmin lieferte auch Fernwärme zur Beheizung der Neustadt des benachbarten Greifswald.