Bild rechts: Phantasialand bei Brühl, Original, Quelle: www.staedte-server.de

Die selbsternannten Klimaretter, oder übersetzt, Mittelwertretter, haben daraus gelernt – 30 Jahre, wer will ihre Aussagen nach 30 Jahren denn überprüfen, wenn sie, natürlich wieder einmal, nicht eingetroffen sind und, 30 Jahre gut leben von der Klimahype ist doch viel besser als 5 Jahre. Auch den Journalisten ist damit gedient. Können sie doch viel länger ihren Phantasien freien Lauf lassen (als journalistische Freiheit bezeichnet man dies wohl) und die Bevölkerung mit immer abenteuerlichen Szenarien in ihren Bann ziehen. Nein, weder in 5 Jahren, noch in 30 Jahren, noch in 100 Jahren wird es (sofern uns nicht der Himmel in Form eines Asteroiden auf den Kopf fällt) eine Klimakatastrophe geben. Warum? Dies erfahren Sie in unserem Bericht.

Wärmster April, wärmster Mai, wärmster Frühling, wärmster Sommer, wärmster September, …. Wer kennt sie nicht, diese Meldungen, die stereotyp und ohne zu hinterfragen, durch die Presse geistern. Von den ZDF-Wetterfröschen zuverlässig jeden Monatsende einer breiten Zuschauerschar aufgenötigt werden. Aufgenötigt daher, weil sie ungefähr so viel mit dem Wetter, also dem Tatsächlichen zu tun haben, wie Star Track mit der Realität.

„Ich traue nur der Statistik, die ich selbst gefälscht habe.“ Dieser geflügelte Satz von einem der ganz Großen der europäischen Geschichte, Herrn Winston Churchill, passt in der heutigen Zeit wohl nirgends so gut, wie zu den Argumenten von Deutschem Wetterdienst (DWD) und Co. zur Verteidigung der Klimakatastrophe. Wir möchten an dieser Stelle anführen, dass wir mit DWD, nicht die vielen Wissenschaftler/Meteorologen meinen, die dort täglich ihr Bestes geben, uns „Verbrauchern“ die Informationen zukommen zu lassen, mit denen wir jeweils die nächsten Tage vom Wettergeschehen planen können, sondern die DWD-Führung, die in verantwortungsloser Weise die Pfade der Wissenschaft verlassen hat und Verlautbarungen von sich gibt, wie z.B. den Temperaturgang der nächsten 100 Jahre zu kennen, die vielleicht Hollywood-verdächtig sind, aber mit Wissenschaft und Rechtschaffenheit nichts zu tun haben. Die DWD-Führung argumentiert schlichtweg gegen die eigenen Daten. Eine Klimaerwärmung gibt es definitiv seit 15 Jahren nicht mehr!

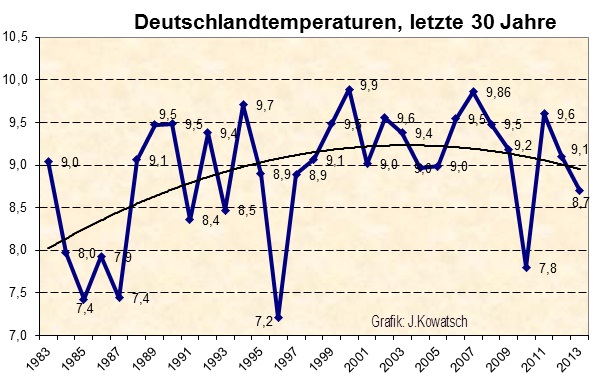

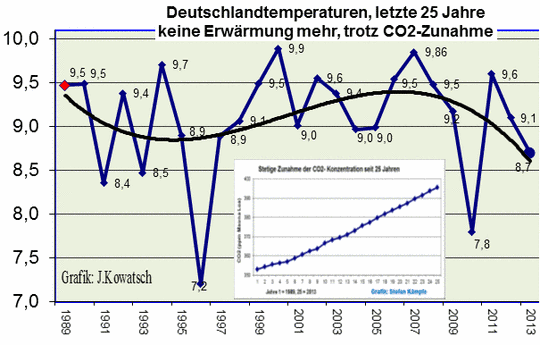

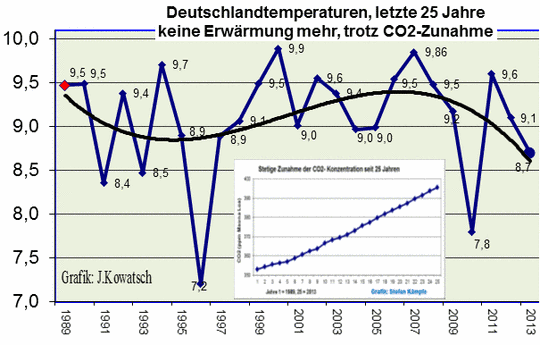

Mit Statistik ist Alles und Nichts zu beweisen. Aus Abb.1 wird dies ersichtlich. Wir betrachten nacheinander die Temperaturen Deutschlands der letzten 30 Jahre, der letzten 25 Jahre und der letzten 14 Jahre.

Abb.1a, nach Daten den DWD, zeigt den Temperaturgang für Deutschland der letzten 30 Jahre (diese Zeitspanne wird im allgemeinen als Klimazeitraum definiert). Man sieht den Anstieg ab 1983, der in Deutschland dann im Jahre 2000 den bisherigen Rekordwert erreichte.

Abb.1b, die letzten 25 Jahre.

Auf den ersten Blick ist leicht zu erkennen, dass es seit 25 Jahren keine Erwärmung mehr gibt in Deutschland. Nach dem Kälter werden der letzten Jahre sind wir momentan wieder auf dem Temperaturniveau von 1988/1989/1990 angekommen. In diesem Zeitraum sind übrigens die Kohlendioxidwerte, die angeblich für weitere Erwärmung dienen sollen, weiter angestiegen. Das zeigt die kleine eingeblendete Grafik. Die Temperaturen sind indes deutlich gefallen. Irgendetwas scheint demnach mit der Theorie von IPCC und Co. nicht zu stimmen…

und nun die letzten 14 Jahre Temperaturentwicklung in Deutschland.

Abb.1c: Je näher wir uns der Gegenwart, also der Realität nähern, umso deutlicher fallen in unserem Land die Temperaturen. Umso deutlicher wird es in Deutschland, nein, nicht wärmer, sondern kälter. Die Klimastatistik 30 Jahre sagt: In Deutschland wird es (bis zum Jahr 2000) wärmer, die Statistik der 25 Jahre: In Deutschland wird es kälter. Die Statistik der 14 Jahre: In Deutschland wird es noch kälter.

Die Temperaturgänge in Abb.1 sind nach Originaldaten des DWD gezeichnet. Sie zeigen keine Momentaufnahme, sondern viele Momentaufnahmen, die zu einem Vergleich aneinander gereiht sind. Genauso, wie dies DWD und Co. für ihre Darstellungen nutzen. So veröffentlicht der DWD eine Deutschlandtemperaturreihe der letzten 100 Jahre und mehr. Nur, ist dieser Momentvergleich, hier Jahresvergleich, überhaupt statthaft? Jeder, der sich halbwegs mit Deutscher Geschichte auskennt, weiß: Nein, dieser Vergleich ist nicht statthaft.

Unser Land hat sich in den letzten 120 Jahren vielfältig geändert. In seinen Grenzen (andere Wetterstationen, die in die Statistik eingehen). Andere Messverfahren (die Celsius-Messung existierte nur tlw.). Aber vor allem änderte sich das Landschaftsbild grundlegend. Eine Ausuferung der Urbanisierung durch die Bevölkerungszunahme seit 1900, den Städte- und Straßenbau und die gewaltige Zunahme des Energieverbrauches sind Kennzeichen der letzten 120 Jahre.

Völlig unberücksichtigt blieb bislang beim Deutschen Wetterdienst in der Betrachtung seiner Temperaturreihen auch die enorme Trockenlegung der freien Landschaft durch Kanalisierungen, Entwässerung und Überbauungen. Wo einst Flüsse und Bäche durch die Landschaft flossen, stehen neue Wohnsiedlungen. Unzählige Kilometer Sickerungsgräben entlang der Straßen und Feldwege, Drainagen und zigtausende Kilometer an (gelben) Sickerschläuchen, wodurch sich die physikalischen Eigenschaften des Erdbodens verändern. Das Regenwasser fließt schneller ab, die Verdunstungsrate der freien Landschaft und damit die Kühlung haben abgenommen und nehmen ständig weiter ab. Wo vor 50 Jahren beispielsweise in Hüttlingen bei Aalen die Kühe in den Feuchtwiesen „Wasserstall“ bis zu den Knien im Wasser weideten, da steht heute ein ausgedehntes trockenes Neubaugebiet in schönster warmer Südhanglage, mit der für Fremde unerklärlichen Bezeichnung „Wasserstall/Teich“.

Abb.2a: Früher so, im Jahre 1955

Die beiden Aufnahmen sind vom gleichen Standpunkt aus gemacht worden und decken auch den gleichen Bildausschnitt ab.

Und heute so.

Abb.2b: Zum Bild: Der kühlende Effekt des Weihers und der dahinter liegenden Sumpfauen auf die Landschaftsumgebung ist bei der oberen Aufnahme offensichtlich. Inzwischen hat sich der Ort ausgeweitet und an derselben Stelle steht der Gewerbebetrieb. Nicht nur der kühlende Effekt der einstigen Naturlandschaft ging verloren, sondern es wird zusätzlich durch die Gebäude und den eigenen Energieumsatz des Betriebes Wärme in die Landschaft eingetragen.

Und der Trend zur Trockenlegung und Betonierung der Landschaft hält an: Laut Angaben des Statistischen Bundesamtes betrug der Flächenverbrauch in Deutschland seit 2005 im Durchschnitt 107 ha pro Tag. In Baden-Württemberg beispielsweise im Jahr 2009 allein 7 ha pro Tag. Bei jedem neuen Bauwerk ist die Natur der Verlierer. Die Kühlung des feuchten Bodens entfällt, die Fotosynthese der Pflanzen, die einen Teil der Sonnenwärme verschlang, um Nährstoffe herzustellen, entfällt, umgekehrt speichert der Beton die Wärme für die Nacht, die achtmonatige Heizung vom September bis Mai verstärkt den Wärmeinseleffekt.

Aus den einstigen, viel kleineren Wärmeinseln um 1900, sind inzwischen weiträumige zusammenhängende Wärmeflächen entstanden. Der ganze Oberrheingraben, der Mittlere Neckarraum und die weite Tourismuszone um den Bodensee, verbunden mit der Trockenlegung der einstigen Sumpflandschaft Oberschwaben, sind ein nachweisbarer Beleg dieser Entwicklung in Baden-Württemberg.

Die Aussage des Deutschen Wetterdienstes Offenbach: Auch früher habe es den WI schon gegeben, deshalb könne man ihn unberücksichtigt lassen, ist somit nicht richtig. Es gab früher den WI, er war aber wesentlich kleiner. Bei jeder Klimastation vergrößert sich der Wärmeinseleffekt von Jahr zu Jahr. Vor allem in den Alpen macht sich der WI stark bemerkbar, denn dort ist in den letzten 60 Jahren der Eingriff in die Natur, verstärkt durch das Anschwellen der Touristenströme, recht groß. Zudem steigt die Warmluft der Täler nach oben und damit auch die Vegetationszonen.

Fazit: Ein direkter Temperaturvergleich von heute und vor 120 Jahren ist bei keiner Klima-Station möglich. Das wäre unseriös und führt zu falschen Ergebnissen. Man muss vom heutigen Temperaturmesswert einen Korrekturfaktor abziehen, eben den stetig zunehmenden Wärmeinseleffekt, um zu erfahren, welche Restwärme durch eine globale Klimaänderung seit 120 Jahren dazugekommen ist.

Und Einstein sagt uns nicht umsonst „Die Zeit ändert den Raum“ und damit all seine Eigenschaften, die ihn bestimmen und eine seiner Eigenschaften ist seine Temperatur. Ergo, darf es nicht einfach eine Aneinanderreihung nicht vergleichbarer Momentaufnahmen, hier der Jahrestemperatur, geben. Sie ist unzulässig. Dem haben die Autoren Rechnung getragen. Leistenschneider hat für drei Zeitabschnitte unseres Landes, in denen sich sein Erscheinungsbild und damit sein Raum besonders änderte, den in der Wissenschaft bekannten Wärmeinseleffekt berechnet und von den gemessenen Temperaturen abgezogen, um so die richtigen Vergleichstemperaturen zu erhalten, damit nicht falsche Vergleiche vorgenommen werden.

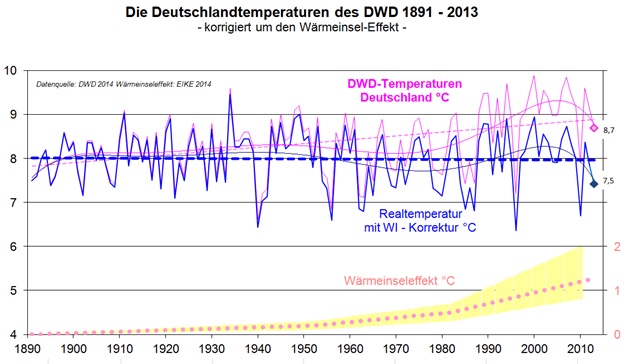

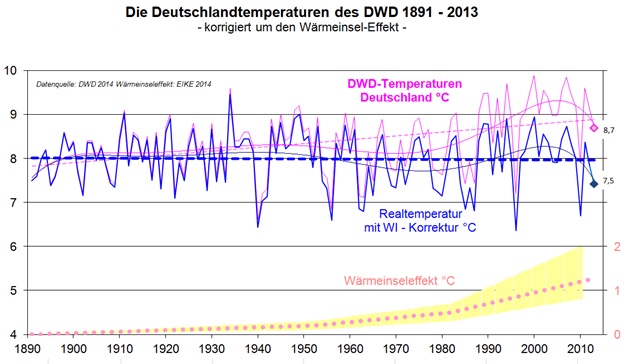

Die Theorie zur Berechnung basiert auf den Strahlungsgesetzen nach Planck und dem Abkühlungsgesetz nach Newton. Die Berechnung erfolgte anhand Vergleichsbetrachtungen in den Kennliniensteigungen des Temperaturganges für Deutschland und der Referenzstation Hohenpeißenberg (HPB). Leistenschneider hatte daher HPB als Referenz ausgewählt, weil auch der DWD diese Station als Referenzstation ansieht. Abb.3 zeigt die tatsächlichen Vergleichstemperaturen für Deutschland.

Abb.3: Die rote Kurve zeigt den Temperaturgang in Deutschland von 1890 – 2013, so wie sie vom DWD erfasst wird. Man sieht den Anstieg bis zum Jahr 2000 und den darauf folgenden Abfall.

Wir haben diese Temperaturen WI-bereinigt und in blau in die gleiche Grafik eingetragen. Sofort wird sichtbar, dass die WI-bereinigten Vergleichstemperaturen für die letzten dreißig Jahre deutlich fallen. Was wäre also, wenn sich Deutschland in diesen letzten 130 Jahren überhaupt nicht verändert hätte, d.h. gleiche Einwohnerzahl mit dem gleichen Lebensstandard, keinen Eingriff in die Landschaft. Ohne diesen zunehmenden Wärmeinseleffekt hätten wir gegenwärtig in Deutschland vergleichbare Temperaturen, wie vor ca. 130 Jahren.

Von einer Klimakatastrophe ist weit und breit nichts zu sehen. Mehr noch, anhand der nachlassenden solaren Aktivität, dem einzigen Energielieferanten für unser Wetter und dessen Mittelwert, dem Klima, ist für die nächsten Jahrzehnte von weiter fallenden Temperaturen auszugehen. So ist es natürlich nicht verwunderlich, dass die Gesamteismasse beider Pole im letzten Jahrzehnt zunehmend ist, auch tritt der menschengemachte WI dort (noch) nicht auf.

WI-bereinigte Daten heißt:

1) Die Zivilisationsveränderungen durch den Menschen sind erfasst.

2) Die Änderungen des Raumes durch die Zeit werden berücksichtigt.

Wie ist nun diese starke Diskrepanz zwischen den DWD-Darstellungen und den Unsrigen zu erklären? Nun, in 2010/2011 haben wir gut 150 DWD-Stationen einer Güteprüfung unterzogen ( http://eike-klima-energie.eu/climategate-anzeige/der-waermeinseleffekt-wi-als-antrieb-der-temperaturen-eine-wertung-der-dwd-temperaturmessstationen/ )

und dabei festgestellt, dass, selbst nach wohlwollender Prüfung, ca. 40% der DWD-Temperaturstationen für eine Vergleichsmessung ungeeignet sind (Abb.4).

Abb.4 zeigt eine typische Flughafenmessstation (hier Frankfurt) im direkten Umfeld heißer (ca. 600°C) Triebwerksabgase. Bei Temperaturvergleichen, die sich im Zehntel-Grad-Celsius-Bereich abspielen, braucht nun wirklich niemanden erläutert zu werden, dass solche Vergleiche mit WI-unbereinigten Messstationen sinnlos sind.

Abb.5 zeigt die langjährige DWD-Messstation Karlsruhe in unmittelbarer Nähe eines Parkplatzes. Die heiße Motorabwärme der Fahrzeuge steht über Stunden an. Auch mit solchen Stationen in der Nähe von Parkplätzen sind Temperaturvergleiche sinnlos.

Frankfurt/Main ist ein gutes Beispiel, dass sich Flughäfen überdurchschnittlich erwärmen. In der folgenden Abbildung 6 wurden die DWD- Werte von Frankfurt/Main mit dem Deutschland- Mittel seit 1949 verglichen:

Und just diese Station am Frankfurter Flughaben führt der DWD als ländliche Station in seiner Statistik, angeblich weitab von allen Wärmeinseln.

Abb. 6: Im Vergleich zum Deutschland-Mittel hat sich der immer wieder stark erweiterte und immer stärker frequentierte Flughafen in Frankfurt/Main überdurchschnittlich erwärmt. Das ohnehin im Vergleich zum Deutschland-Mittel sehr warme Frankfurt hatte anfangs, um 1950, einen „Temperaturvorsprung“ von etwa 1,2 Kelvin, der bis heute auf 1,8 Kelvin angewachsen ist. Zur besseren Orientierung sind neben den immer weiter auseinander laufenden Lineartrends auch dien polynomischen dargestellt. Man erkennt sehr schön die markanten Abkühlungsphasen kurz nach der Mitte des 20. Jahrhunderts und nach dem Beginn der 2000er Jahre. Mit dem CO2- Anstieg, der in dieser Zeit kontinuierlich verlief, hat diese Temperaturentwicklung nichts zu tun!

Nicht schwer zu erraten, dass dem DWD sowohl unsere Aussagen, als auch unsere berechneten WI-Werte für Deutschland nicht gefallen und er beides in Abrede stellt. Eingangs möchten wir den für Deutschland berechneten WI-Wert nennen, um ihn dann zu prüfen. Er beträgt nach Abb.3 +0,9°C bis +1,2°C. Die Wertepaarung ergibt sich, je nachdem, ob der Referenzstation HPB ein eigener WI zugeordnet wird, oder ob nicht.

Prüfung unseres WI-Wertes anhand unserer Hauptstadt Berlin

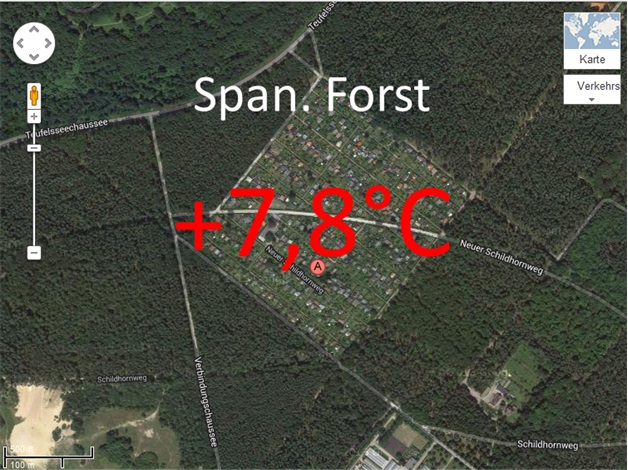

Die Freie Universität Berlin erhielt in den 1970-Jahren ein umfangreiches Netzwerk von Wetterstationen in (West)Berlin. Diese Epoche eignet sich auch daher in besonderem Maße, weil sie die Zeit abdeckt, in denen sich noch niemand mit einem menschengemachten Klimawandel und mit einer Angst vor hohen Temperaturen befasste und daher auch frei von irgendwelchen „Betrachtungsinterpretationen“ ist. Die Stationen befanden sich in Charlottenburg, Tempelhof, Tegel, Dahlem, Grunewald, Zehlendorf, Insel Scharfenberg, Pfaueninsel, Gatow, Baumschule Neukölln, Rudow, Botanischer Garten, Heiligensee, Frohnau, Kohlhasenbrück, Tegel am Fließtal und Span. Forst (Jagen 64). Sie decken damit die unterschiedlichsten geographischen Gegebenheiten ab und eignen sich daher in erstklassiger Weise zur Betrachtung der Temperaturentwicklung in gleichen Zeiträumen und unterschiedlichen Bebauungszonen. Also mit ein und denselben Wetterverhältnissen im Raum (West)Berlin. Bevor wir zur Temperaturbetrachtung und Analyse übergehen, die Aussage des DWD zu den Auswirkungen des WI in Deutschland:

In persönlichen Mails (an Herrn Kowatsch), räumt der DWD für Städte wie Frankfurt zwar einen WI-Antrieb von 1°C ein, geht aber davon aus, dass dieser in der Fläche umgerechnet nicht mehr als +0,1°C liegt, was, wie gezeigt wird, eine Falschaussage ist.

Herr M.-W. vom DWD, Zitat: “Natürlich gibt es einen Wärmeinseleffekt in großen Städten. Er kann dort im Mittel auch etwa 1 Grad ausmachen. In Anbetracht des auch in Deutschland geringen Anteils dicht bebauter Gebiete an der Gesamtfläche ist das aber weniger als 0,1 Grad. Dieser Effekt ist auch nicht neu und hat sich in den letzten Jahrzehnten kaum verändert, so dass der Wärmeinseleffekt für irgendwelche Temperaturveränderungen in den letzten Jahren völlig ohne Belang ist.“ Zitat Ende.

Grundsätzlich vertritt der DWD in Offenbach die Meinung: Auch früher habe es den WI schon gegeben, deshalb könne man ihn unberücksichtigt lassen. Der DWD begreift (noch) nicht, dass der WI ein ständig steigender Wert ist.

Der DWD geht also höchstenfalls von einem WI-Fehler in seinen Messungen und Ergebnissen von +0,1°C aus. Weiter sieht der DWD Flughafentemperaturmessstationen als ländliche Stationen, ohne WI an. Hier ein Schreiben des DWD vom Juni 2010: „… In diesem Jahr war es in Frankfurt auch 0,5 Grad wärmer als im Vergleichszeitraum, weil der Wärmeüberschuss im Süden und Westen Deutschlands höher war als im Landesdurchschnitt. Mit einem Wärmeinseleffekt hat das aber alles nicht zu tun, denn der aktuelle Wert und der Bezugswert stammen von der Station am Flughafen weitab von irgendwelchen Wärmeinseln.“

Wir werden sehen, was es mit beiden Aussagen auf sich hat – was beide Aussagen des DWD wert sind. Siehe auch:

http://www.eike-klima-energie.eu/climategate-anzeige/was-sind-temperaturmessungen-auf-grossflughaefen-wert-oder-wie-das-zdf-mit-bewusst-falschen-temperaturaussagen-die-oeffentlichkeit-taeuscht-und-die-abkuehlung-in-deutschland-verschleiert/

In der folgenden Abbildung 7 haben wir die Temperaturgänge von 6 Stationen in Berlin betrachtet.

Tempelhof: Eine ausgesprochen Städtische Station

Dann die beiden Flughäfen Tempelhof und Tegel, die der DWD als ländlich einstuft.

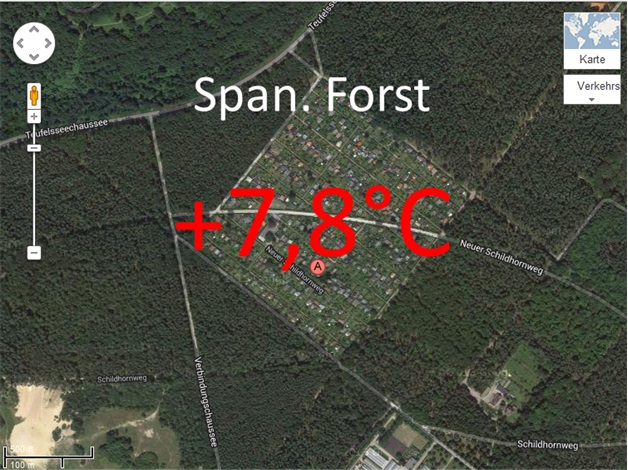

Und dann noch drei ländliche Stationen, sofern man in Berlin überhaupt von ländlich reden kann. Jedenfalls liegen Kohlhasenbrück, Tegel im Fließtal und Spandauer Forst nicht mitten in der Stadt.

Die Ergebnisse sind eindeutig und bestätigen unsere früheren Arbeiten zum Wärmeinseleffekt, z.B.

http://www.eike-klima-energie.eu/news-cache/klimawandel-in-deutschland-bedeutet-abkuehlung-trotz-deutlicher-zunahme-von-co2-teil-1/

http://www.eike-klima-energie.eu/news-cache/klimawandel-in-deutschland-bedeutet-abkuehlung-trotz-deutlicher-zunahme-von-co2-teil-2/

Abb.7 zeigt den Temperaturgang der beiden Flughafenstationen Tempelhof und Tegel im Zeitraum von 1970 – 1974 und dazu den Temperaturgang von Charlottenburg, deren Messstation mitten in der Stadt liegt – städtischer geht es nicht. Damit Sie sich ein Bild von der Lage der Station machen können, haben wir Ihnen jeweils die Satellitenaufnahme (Quelle: Google-earth, Abbildungen 9) angefügt. Die räumliche Veränderung heute zu 1970 ist auf den beiden Flughäfen unwesentlich verändert, was auch für Charlottenburg zutrifft, welches seinerzeit wie heute, mitten in der Innenstadt liegt.

Beachte: Tempelhof (braune Grafik) ist ab 1971 deckungsgleich mit Tegel, deshalb verschwindet der Graph im Diagramm.

Anhand der obigen Aussage des DWD, dass Flughafenstationen als ländlich einzustufen sind, „überrascht“ das Ergebnis, denn es ist nicht der geringste Unterschied zu erkennen. Flughafentemperaturmessstationen sind nicht als ländlich, sondern als städtisch, mit einem hohen WI einzustufen. Der DWD sollte schnellstens seine unsinnige Aussage zu den Flughafentemperaturmessstationen korrigieren. Deutlich kühler sind die drei ländlichen Temperaturstationen, sie zeigen zugleich, welche Temperaturunterschiede durch Bebauung bereits auf einer verhältnismäßig kleinen Fläche wie in Berlin vorliegen.

In Abb.7 haben wir die Ergebnisse von städtischen Stationen betrachtet. Deren Temperaturgang von all der städtischen Abwärme aus Heizungsanlagen, technischen Anlagen, Straßenverkehr, Bebauung, Reduzierung Luftzirkulation und Bodenversiegelung, um einige zu benennen, beeinflusst und damit deren Ergebnisse nach oben, zu höheren Temperaturen verfälscht werden. Bei Flughafenstationen sind dies die heißen Triebwerksabgase und die Abwärme der Motoren. Weiter zeigt Abb.7 die Messergebnisse von drei ländlich gelegenen Berliner Temperaturmessstationen. Aus Abb.8 geht hervor, warum solch ein Unterschied in den Temperaturen vorhanden ist. Sie zeigt, wie sich der Temperaturgang in Abhängigkeit zur Bodenbeschaffenheit ändert.

Abb.8 zeigt den Tagesgang der Temperatur an einem sonnigen Sommertag in Bodenhöhe für verschiedene Böden, nach Fezer 1975.

Nicht nur, dass über Beton und insbesondere Asphalt die Temperaturen z.B. sehr stark über denen des Waldbodens liegen, sondern, auch ein deutlicher Temperaturunterschied von mehreren °C zwischen Gras, Wald oder landwirtschaftlichen Flächen vorliegt. Messstationen, die ursprünglich auf freiem Feld standen und zwischenzeitlich in einer Gras, Hecken oder offenen Waldlandschaft stehen (oder umgekehrt), weil sich das Landschaftsbild über die Jahrzehnte änderte, was nicht wirklich verwundern kann, geben somit deutlich veränderte Temperaturwerte wieder und verzerren jeglichen Temperaturvergleich. Die Gründe hierfür sind vielfältig:

– Im Sommer speichert der verwendete Feststoff die tagsüber von der Sonne eingestrahlte Wärme (spezifische Wärmekapazität der Stoffe) und gibt sie nachts ab, die Bebauung erwärmt somit die Umgebung.

– Bei Regen fließt Regenwasser sofort ab und erzeugt keine Verdunstungskälte.

– Bäume und Pflanzen, die vor der Versiegelung der Landschaft angesiedelt waren, haben einen erheblichen Teil der Sonnenstrahlung für ihre Fotosynthese verwendet. Nur ein Teil der Sonnenstrahlung erreichte den Boden. Die Sonnenstrahlung wurde abgefangen, und in chemischer Form in den Pflanzen gespeichert. Die Versiegelung der Landschaft hält weltweit an, bedingt durch die Bebauungszunahme. In Deutschland pro Tag 104 ha.

– Zunahme des Wohlstandes in Teilen der Welt, vor allem auf der Nordhalbkugel.

Auch die freie, unbebaute Landschaft hat gegenüber dem Deutschland vor 100 Jahren eine Erwärmung erfahren, die auf dem WI beruht. Dabei handelt es sich nicht um eine statistische Umlegung des WI aus der Bebauung auf die Gesamtfläche des Landes, wie der Deutsche Wetterdienst dies per Mail darlegt und eine genannte Schätzung von +0,1°C WI in der Gesamtfläche abgibt, sondern um einen realen Wärmeinseleffekt, basierend auf einer wärmenden Landschaftsumgestaltung.

Abb.7 zeigt den Temperaturgang von 1970 – 1974 der drei städtischen Messstationen, die einen hohen WI-Anteil beinhalten, mit den drei ländlichen Stationen des Messnetzwerks der Freien Universität Berlin. Wie stark der WI-Anteil die Temperaturwerte beeinflusst und damit nach oben verfälscht, ist offensichtlich.

Eingangs wurde darauf hingewiesen, dass anhand der von Leistenschneider auf Basis der Planckschen Strahlungsgesetze und dem Newtonschen Abkühlungsgesetz berechnete WI für Deutschland +0,9°C bis +1,2°C beträgt.

Abb.9a zeigt die Satellitenaufnahme von der Umgebung, in der die Messstation Charlottenburg lag und den durchschnittlichen Jahreswert der Temperatur im Betrachtungszeitraum 1970-1974.

Abb.9b zeigt die Satellitenaufnahme von der Umgebung, in der die Messstation Flughafen Tempelhof lag und den durchschnittlichen Jahreswert der Temperatur im Betrachtungszeitraum 1970-1974.

Abb.9c zeigt die Satellitenaufnahme von der Umgebung, in der die Messstation Flughafen Tegel lag und den durchschnittlichen Jahreswert der Temperatur im Betrachtungszeitraum 1970-1974.

Abb.9d zeigt die Satellitenaufnahme von der Umgebung, in der die Messstation Kohhasenbrück lag und den durchschnittlichen Jahreswert der Temperatur im Betrachtungszeitraum 1970-1974.

Abb.9e zeigt die Satellitenaufnahme von der Umgebung, in der die Messstation Tegel am Fließtal lag und den durchschnittlichen Jahreswert der Temperatur im Betrachtungszeitraum 1970-1974.

Abb.9f zeigt die Satellitenaufnahme von der Umgebung, in der die Messstation Spandauer Forst lag und den durchschnittlichen Jahreswert der Temperatur im Betrachtungszeitraum 1970-1974.

Sowohl zur Messvergleichbarkeit, als auch der statistischen Vergleichbarkeit haben wir jeweils drei Stationen am Ende der jeweiligen Messwerteskala bewertet. Die Temperaturmittelwerte der Betrachtungsjahre ergibt ein Wertepaar von 9,2°C (städtische Messwerte) zu 8,0°C (ländliche Messwerte). Der Temperaturunterschied Stadt zu Land in gleichen Zeitfenstern ist der WI und beträgt anhand der Daten der Freien Universität Berlin +1,2°C.

Eingangs erwähnten wir, dass selbst bei wohlwollender Prüfung gut 40% der DWD-Messstationen für Temperaturvergleichsbetrachtungen wertlos sind, da sie z.B. auf Flughäfen, in der Nähe von Parkplätzen oder in Städten, den Alpen, … sind. All diese Stationen sind stark WI-behaftet, da sie in einer sich stetig ändernden Landschaft hin zu mehr Verkehr oder mehr Bebauung (oder Tourismus) liegen. Das flächendeckende Netz des DWD eignet sich demnach nicht zum Vergleich von Jahrestemperaturen oder Monatstemperaturen über längere Zeiträume. Dies ist bei der WMO, die die Jahreserdtemperaturen veröffentlicht, nicht besser. Über 50% von deren Stationen liegen auf Flughäfen, weitere gut 30% in Städten, so dass über 80% der Messstationen der WMO ungeeignet sind. Darüber hinaus decken diese über 80% nur ca. 3% der Landfläche der Erde ab. D.h. die Erdjahrestemperatur wird zu einem Großteil aus einer Fläche von 3% der Erde ermittelt. Absurder kann Wissenschaft nicht hintertrieben werden. Wie sagte noch der ganz Große der europäischen Geschichte "Ich traue nur der Statistik, die ich selbst gefälscht haben."

Ergebnisse

1) Der berechnete WI anhand der DWD-Deutschlanddaten zur DWD-Referenzstation HPB, den der DWD nicht wahrhaben will und daher in Abrede stellt, beträgt:

+1,2°C (vgl. Abb.3).

2) Der ermittelte WI aus den Temperaturaufzeichnungen der Freien Universität Berlin beträgt:

+1,2°C

3) Somit ist festzustellen, dass unser bereits in 2011 veröffentlichter WI für Deutschland korrekt ist und die vom DWD veröffentlichten Temperaturvergleichswerte um diesen Betrag nach unten zu korrigieren sind. Wir zeigen Ihnen zum Abschluss daher nochmals, die für Deutschland richtigen Vergleichstemperaturen, die so gar nichts gemein haben, mit den stereotyp vorgetragen Metaphern, wärmster…, wärmster,… etc.

Abb10. Die blaue Temperaturreihe zeigt die richtigen Vergleichstemperaturen für Deutschland. Gegenwärtig haben wir vergleichbare Temperaturen wie um 1890. Von einem anthropogenen Klimawandel oder gar einer sich anbahnenden Klimakatastrophe ist nichts zu erkennen!

Fazit

Wir fühlen Temperaturen nicht aus leeren Statistiken, sondern am täglichen Wettergeschehen. Ob es wärmer oder kälter wird, entscheiden unsere Empfindungen, nicht irgendwelche Statistiken, die am Ende eine Monats verkündet werden, die sich darüber hinaus noch auf einen Vergleichsbetrachtungszeitraum von 1961 – 1990 beziehen, in dem es, wie aus Abb.10, sowohl aus der DWD-Reihe, als auch der Unsrigen, WI-bereinigten, besonders kalt war. Werden aktuelle Temperaturen mit diesen kalten, unterdurchschnittlichen Temperaturen verglichen, müssen sie zwangsläufig hoch ausfallen. Auch hier wieder das Zitat von Herrn Churchill.

Um weiteren Schaden von der einstigen Wissenschaftsinstitution DWD abzuhalten, sollte die Führungsspitze des Deutschen Wetterdienstes endlich vor den Medien offenbaren, dass das Jahr 2000 in Deutschland das wärmste Jahr war und seitdem die Temperaturen sinken. In persönlichen Mails wird das nämlich schon längst zugegeben, nur vor der Presse und der Öffentlichkeit wird durch die DWD-Führungsspitze in Offenbach getrickst und das Märchen aufgrund der sich fortsetzenden CO2-Erwärmung verkündet.

Neuerdings schicken wir den Bundestagsabgeordneten unsere DWD Graphiken mit den seit 17 Jahren fallenden Trendlinien zu, was ein unglaubliches Staunen hervorruft. Die Nachfragen der MdBs beantwortet der DWD dann stets sinngemäß so, es sei richtig, dass die Temperaturen seit der Jahrtausendwende fallen, aber über die letzten 130 Jahre seien sie immer noch gestiegen. Unsere abermaligen Antworten, dass man diese Temperaturen nicht direkt vergleichen könne, sondern einen WI-faktor zur Betrachtungskorrektur brauche, beantwortet der DWD dann mit lapidaren Aussagen, dass es diesen WI auch schon früher gegeben habe und man brauche ihn deshalb nicht berücksichtigen oder dass die Korrekturen bereits eingerechnet seien. Die Abgeordneten, auch das Verkehrsministerium geben sich dann mit solchen Antworten -gläubig oder ungläubig- zufrieden. Immerhin erfahren die Abgeordneten dann zum ersten Male, dass die Temperaturen seit 17 Jahren fallen.

Es wird daher höchste Zeit, dass die DWD-Führung erkennt, dass sich die reale Welt nicht im Computer, in willkürlichen Klimamodellen, mit willkürlich gewählten Parametrierungen abspielt, sondern ihren eigenen Charakter hat. Diesen findet man nicht in beliebigen Algorithmen, sondern dort, wo die Väter der modernen Naturwissenschaften unterwegs waren. Ein Alexander von Humboldt hätte z.B. schwerlich seine Erkenntnisse aus theoretischen Gebilden gewonnen, die mit der Realität ungefähr so viel zu tun haben, wir Star Track mit der realen Welt. Aber offenbar verwechselt die DWD-Führung Fiktion und Wirklichkeit und kann nicht mehr erkennen, dass sie die Wirklichkeit längst verlassen hat und sich mit den Hobbits auf ihrer Reise durch die Mittelerde befinden.

Damit die DWD-Führung nicht noch weitere Kreise unseres Landes auf ihrer Reise durch Fantasia Land mitnimmt, besonders die deutsche Presse, der die Rolle der Nazgûl übertragen wurde, gibt es EIKE und seine vielen Unterstützer, die sich als Naturforscher unter den Klimaforschern verstehen.

Mit unserer Untersuchung konnten wir einmal mehr zeigen, wo und wie DWD, PIK, IPCC und deren Unterstützer unterwegs sind: Auf einer Reise, fernab der realen Welt, längst verirrt in den Nebelgebirgen der Mittelerde.

Raimund Leistenschneider – EIKE

Josef Kowatsch – Hüttlingen

Stefan Kämpfe – Weimar