Oktober warm – dass Gott erbarm‘?!

Wenden wir uns zunächst den Bauernregeln zu. Ihnen liegt das Prinzip zugrunde, dass man den Wetter- oder Witterungsverlauf zu einem bestimmten Zeitpunkt oder einem bestimmten Zeitraum beobachtet und dann versucht herauszufinden, ob die Folgewitterung ebenfalls einen bestimmten Verlauf nimmt.

Hinsichtlich der Bauernregeln gibt es nun aber drei fundamentale, unlösbare Probleme, die den Gebrauch von Bauernregeln bis zur Unbrauchbarkeit einschränken. Entstanden sind sie ja während des Mittelalters. Die Bauern des Mittelalters (heute nennt man sie Landwirte) waren natürlich Witterungsunbilden noch viel stärker ausgesetzt als heutzutage. Diese eventuellen Unbilden rechtzeitig erkennen zu können war ihnen naturgemäß ein dringendes Anliegen. Es ist schon absolut erstaunlich, wie sorgfältig die Bauern der damaligen Zeit das Wetter beobachtet und ihre Schlüsse daraus gezogen haben.

Es gibt aber, wie gesagt, drei fundamentale Probleme:

1) Die meisten Bauernregeln sind vor etwa 1000 Jahren entstanden. Damals herrschte bekanntlich ein deutlich wärmeres Klima als heute, und ob die damals gefundenen Zusammenhänge auch in einem kälteren Klima gelten, ist nicht erforscht.

2) Um sich Bauernregeln besser merken zu können, wählte man als Bezugszeitpunkt in der Regel (katholische) Feiertage, die damals eine ganz andere Bedeutung hatten als heute. Außerdem wurden sie der besseren Merkfähigkeit wegen auch in Reimform gepresst. Die Beobachtungen erfolgten naturgemäß am Wohnort der Bauern. Die Herumreiserei von heute gab es natürlich damals nicht. Die Örtlichkeit oder das Gebiet, in dem die jeweilige Bauernregel entstanden ist, ist aber von ausschlaggebender Bedeutung. Ob eine im Allgäu gefundene Bauernregel auch für Ostfriesland gültig ist, ist zumindest fraglich. Der Ursprung der jeweiligen Bauernregeln ist aber heute nicht einmal ansatzweise feststellbar.

3) Dann gab es da noch eine Kalenderreform, bei der 10 Tage einfach unter den Tisch fielen (interessante Parallele: Die katholische Kirche hatte damals so viel Macht, dass sie mit der Zeit das machen konnte, was das IPCC heute mit Klimadaten macht, nämlich manipulieren. Der Unterschied ist jedoch, dass der Nutzen der Kalenderreform heute völlig unbestritten ist, während man dies von der ,Datenreform‘ des IPCC wohl nicht unbedingt sagen kann).

Die Tage-Bezugspunkte der Bauernregeln machten diese Verschiebung jedoch nicht mit, ein Umstand, der bei der Diskussion um die Bauernregeln heute in der Regel vergessen wird. (Dieser letzte Punkt ist vermutlich nicht so relevant, wenn man Zeiträume, d. h. in der Regel Monate, als Bezugspunkt nimmt. Dazu später mehr).

Vorhersagen auf der Grundlage von Bauernregeln werden heute seriöserweise nicht mehr gemacht, wenngleich viele Menschen immer noch auf sie schwören. Es wäre jedoch grob fahrlässig, den Wissensschatz der Bauernregeln einfach außen vor zu lassen. An dieser Stelle kommt einer der meiner Ansicht nach größten Zufälle der Wissenschaft ins Spiel. In den fünfziger und sechziger Jahren hat nämlich ein Meteorologe versucht, das statistische Prinzip, auf dem die Bauernregeln beruhen, in die heutige Zeit zu übertragen. Warum Zufall? Weil dieser Meteorologe Baur hieß (ohne e)! Mehr zu seiner Person hier bei Wikipedia.

Prof. Dr. Franz Baur hat im vorigen Jahrhundert auf Basis von Beobachtungen (Numerik gab es damals noch nicht bzw. steckte allenfalls in den Kinderschuhen) genau dieses Prinzip der Bauernregeln angewendet. Er fand auch viele teils sehr deutliche Zusammenhänge, die als die – Baur’schen Regeln bekannt sind. Zu Prof. Baur, seiner Vita und seiner Arbeit kann man viel googeln. Es würde aber diesen Beitrag sprengen und auch ein wenig am Thema vorbeigehen, wenn man hier näher darauf eingehen würde.

Häufig war es so, dass Prof. Baur altbekannte Bauernregeln einfach für die heutige Zeit „übersetzt“ hat. So wurde aus der altbekannten Bauernregel zum Siebenschläfer (astronomisch am 26. Juni) eine Baur’sche Regel zum Siebenschläfer (dem meteorologischen um den 5. Juli).

Prof. Baur selbst hat noch sehr genau seine eigenen Baur’schen Regeln mit der Realität überprüft. Hinsichtlich der Siebenschläfer-Regel fand er (und findet man bis heute!) eine Korrelation über 0,9 unter der Voraussetzung, dass die Statistik strikt angewendet wird.

Wie wichtig dies ist, soll am Beispiel der in der Überschrift zu diesem Beitrag genannten Bauernregel erläutert werden. In den Medien war schon vielfach die Rede davon, dass auf einen warmen Oktober ein kalter Winter folgen soll. Tatsächlich gibt es auch andere Bauernregeln, die mit anderen Worten auf den o. g. Zusammenhang hinweisen. Nicht von ungefähr sind jedoch von mir hinter die Überschrift die zwei Satzzeichen gesetzt worden. Übersetzen wir doch diese Regel mal in eine Baur’sche Regel. Die gibt es wirklich, und zwar die Regel Nr. 64. Sie hat folgenden Wortlaut:

„Wenn der Oktober in Mitteleuropa mehr als zwei Grad zu warm und gleichzeitig deutlich zu trocken ausfällt, ist mit hoher oder sehr hoher Wahrscheinlichkeit ein kalter oder extrem kalter Januar in Mitteleuropa zu erwarten“.

Anhand dieser Regel soll näher erläutert werden, was man mit einer solchen statistischen Regel anfangen kann – und was nicht. Unabdingbar ist zu prüfen, ob die genannten statistischen Witterungserscheinungen wirklich so aufgetreten sind. Für diesen Oktober 2014 bedeutet das, dass er sicher deutlich zu warm ausfällt, vermutlich weit über 2 Grad zu warm. Der kurze Kaltlufteinbruch um den 20. des Monats ändert daran nicht viel. Aber hinsichtlich des zweiten Kriteriums gilt das nicht! Er war eben nicht deutlich zu trocken. In manchen Gebieten war er das zwar wirklich, aber nicht im Flächenmittel. Dabei spielt es statistisch keine Rolle, ob der Regen mehr oder weniger gleichmäßig über den ganzen Monat verteilt ist oder ob ein singuläres, flächendeckendes Starkregenereignis an einem einzigen Tag die Ursache dafür ist, dass der Monat zu nass ausfällt. Wer jetzt sagt „nun ja, wenn man von dem einzelnen Tag absieht…“. Das wäre bereits eine Verbiegung der Statistik. Beim IPCC ist das zwar gang und gäbe, aber es ist unwissenschaftlich. Fazit: die Regel ist also in diesem Jahr nicht anwendbar.

Nun ist dauerhaft warme und trockene Witterung im Oktober nur auf wenige Wetterlagen beschränkt. Ein zentrales Hochdruckgebiet über Mitteleuropa ist dafür im Gegensatz zum Hochsommer auf keinen Fall geeignet. Sehr schnell würde sich nämlich in den immer längeren Nächten Nebel bilden, der sich tagsüber kaum noch auflöst, mit der sukzessiven Folge einer immer weiter fortschreitenden Abkühlung der unteren Luftschichten. Starker Wind würde zwar für Durchmischung sorgen, doch wird dies nur von durchziehenden Tiefdruckgebieten bewerkstelligt, die aber eben auch Regen mitbringen. Warme und gleichzeitig nasse Okobtermonate treten also viel häufiger auf (beispielsweise in diesem Jahr 2014) als trockene und warme bzw. deutlich zu warme. Die einzige Wetterlage, die noch im Oktober dauerhaft warmes und trockenes Wetter bringen könnte, wäre eine kräftige südwestliche Strömung zwischen einem Hochdruckgebiet über dem Balkan und dem jahreszeitlich bedingten Aufleben der atlantischen Tiefdrucktätigkeit. Eine milde Westwindwetterlage mit viel Regen bringt eben nicht gleichzeitig warmes und trockenes Wetter.

Nun gab es in diesem Oktober tatsächlich immer wieder ausgeprägte Südwestlagen. Die teils extrem hohen Maxima bis hin zu Sommertagen (< 25°C Maximum) können nur aufgrund einer solchen Wetterlage zustande kommen. Nur wurden diese Südwestlagen in diesem Monat immer wieder unterbrochen. Außerdem macht die Statistik nach Prof. Baur keinerlei Aussage darüber, aufgrund welcher Wetterlage die warme und trockene Witterung zustande kommt. Im vorigen Jahrhundert kam es etwa 10 bis 12 mal vor, dass der Oktober mehr als 2 Grad zu warm und gleichzeitig deutlich zu trocken ausgefallen war. In allen Fällen ohne Ausnahme gab es danach in der Tat einen kalten Winter in Mittelruopa. Das heißt nun aber NICHT, dass ein zu warmer und gleichzeitig zu nasser Oktober einen milden Winter zur Folge hat!

(Nebenbei: ein statistisch viel signifikanteres Ereignis ist die Tatsache, dass im völligen Gegensatz zum vorigen Jahr im Oktober die atlantische Tiefdrucktätigkeit kaum Anzeichen einer merklichen Belebung zeigt. Außerdem ist bereits der russische Hochdruckblock unübersehbar – zu einem statistisch ungewöhnlich frühen Zeitpunkt).

Auch wenn man die Statistik in einer solchen Regel ins Gegenteil verkehrt, also ein kalter und überaus nasser Oktober auftritt, ist keine statistische Aussage möglich. Das heißt, die nachfolgenden Winter waren teils zu kalt, teils zu mild oder teils ausgeglichen. Gäbe es hier einen Zusammenhang, hätte Prof. Baur den mit Sicherheit entdeckt. Zwar gab es statistisch in 6 oder 7 von 10 Fällen mit einem nassen und kalten Oktober tatsächlich einen milden oder sehr milden Winter in Mitteleuropa, aber ein solches Verhältnis ist sicher noch nicht als statistisch signifikant einzustufen. Musterbeispiel hier war der Oktober des Jahres 1974, der im Flächenmittel in Deutschland über 300% (!) der im Mittel zu erwartenden Regenmenge gebracht hatte. Auf dem Zugspitzplatt lag der Schnee damals Ende Oktober, also zu einem Zeitpunkt, an dem die Schneedecke dort besonders niedrig bzw. (noch) gar nicht vorhanden ist, über 300 cm hoch.

Dies alles sollte bedenken, wer in den Medien pauschal mit der Prämisse „warmer Oktober – kalter Winter“ konfrontiert ist.

Und weil es so schön ist und gerade passt, soll hier noch eine weitere Baur’sche Regel genannt werden, und zwar eine mit einem Korrelationsfaktor von fast 1:

„Fällt die erste Dekade im Dezember mehr als 2 Grad zu mild aus und ist auch die gesamte erste Dezemberhälfte zu mild, ist mit sehr hoher Wahrscheinlichkeit ein milder oder sehr milder Hochwinter in Mitteleuropa zu erwarten unter der Voraussetzung, dass die milde Witterung mit einer Westlage verknüpft ist“.

Diese Einschränkung am Ende wird gerne vergessen, ist aber sehr wichtig, wie Prof. Baur selbst betont hat. Im Dezember 1986 beispielsweise (den hat Prof. Baur nicht mehr erlebt) herrschte in der ersten Dezemberhälfte sehr mildes und trockenes Wetter im Bereich einer kräftigen südlichen und südöstlichen Strömung. Ziemlich genau zur Monatsmitte kippte diese Wetterlage. Es folgten eine klassische „weiße Weihnacht“, die in Berlin die höchste jemals an den Weihnachtstagen gemessene Schneedecke gebracht hatte, und ein sehr kalter Winter.

Aber auch diese Regel ist die Übersetzung einer uralten Bauernregel: „Ist bis Weihnachten kein Winter, kommt auch keiner mehr dahinter“.

Das heißt, auch im Mittelalter, vor allem zur Zeit der MWP, gab es schneelose, milde Winter. Diese Erkenntnis zu vermerken würde manchen Alarmisten ganz gut zu Gesicht stehen!

Zum Abschluss noch eine Anmerkung: Diese letzte Regel für den Dezember lässt sich aus synoptischer Sicht sehr gut herleiten. Das ist im Falle eines warmen und trockenen Oktober nicht so ohne Weiteres möglich. Generell gilt aber für statistische Betrachtungen:

Wenn in 10 von 10 Fällen immer der gleiche Ablauf verzeichnet wird, besteht hier ein sehr hoher statistischer Zusammenhang. Das heißt NICHT, dass beim elften Mal diese Abfolge MIT SICHERHEIT wieder eintritt, sondern nur, dass es dafür eine sehr hohe statistische Wahrscheinlichkeit gibt. Für Prognosezwecke ist es dabei aber VÖLLIG UNERHEBLICH, wie dieser Zusammenhang beschaffen ist, solange er nur statistisch signifikant ist.

Hans-Dieter Schmidt

Kleiner Nachtrag für die Alarmisten, die ja die Wärme so gerne als die große Katastrophe darstellen: Die Bauern der damaligen Zeit hatten natürlich vor der Kälte Angst, nicht vor der Wärme!

Hans-Dieter Schmidt war schon von Kindesbeinen an ein – wie er es nennt – Wetterfreak. Bereits während seines Studiums in den siebziger Jahren arbeitete er nebenher als Wetterbeobachter im Beobachtungs- und Radardienst. Nach seinem Diplom im Jahre 1980 arbeitete er durchweg im Bereich synoptische Meteorologie und Wettervorhersage. Da es zu seiner Zeit längst nicht die technischen Möglichkeiten wie heute gab, wurde er zum Spezialisten für Synoptik mit heute über 40-jähriger Erfahrung, um allein aus Wettermeldungen möglichst viele Erkenntnisse für die Vorhersage zu gewinnen. – Vita zusammengestellt von Chris Frey

anchenrelevanten Feldern der Energie-, Umwelt- sowie Industriepolitik bei und leistet damit einen wichtigen, technologisch orientierten Beitrag zur Gestaltung zukünftiger politischer und wirtschaftlicher Entscheidungen. Sitz des Verbands ist Düsseldorf.

anchenrelevanten Feldern der Energie-, Umwelt- sowie Industriepolitik bei und leistet damit einen wichtigen, technologisch orientierten Beitrag zur Gestaltung zukünftiger politischer und wirtschaftlicher Entscheidungen. Sitz des Verbands ist Düsseldorf.

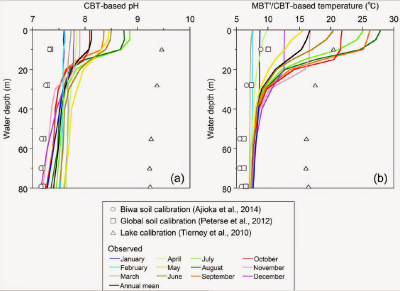

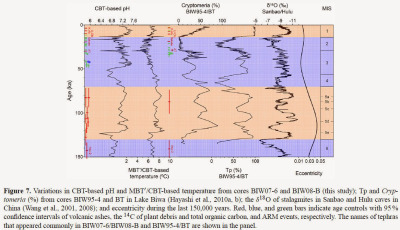

EIKE-Pressesprecher Prof. Dr. Horst-Joachim Lüdecke sprach über „Präzises Klima-Timing über die letzten 2500 Jahre“. Der Beitrag behandelte eine neue Methode, die es ermöglicht, den in der Fachliteratur schon mehrfach vermuteten und beschriebenen Einfluss des bekannten De Vries/Suess – Sonnenzyklus auf Klimazyklen besser sichtbar zu machen und zu analysieren. Die Klimazyklen sind in Proxy-Temperaturreihen aus Stalagmiten, Baumringen und Sedimenten enthalten, die Sonnenzyklen in den Produktionsraten der kosmischen Isotope 14C und 10Be. Die Arbeit zs. mit Koautoren wird aktuell zur Veröffentlichung eingereicht.

EIKE-Pressesprecher Prof. Dr. Horst-Joachim Lüdecke sprach über „Präzises Klima-Timing über die letzten 2500 Jahre“. Der Beitrag behandelte eine neue Methode, die es ermöglicht, den in der Fachliteratur schon mehrfach vermuteten und beschriebenen Einfluss des bekannten De Vries/Suess – Sonnenzyklus auf Klimazyklen besser sichtbar zu machen und zu analysieren. Die Klimazyklen sind in Proxy-Temperaturreihen aus Stalagmiten, Baumringen und Sedimenten enthalten, die Sonnenzyklen in den Produktionsraten der kosmischen Isotope 14C und 10Be. Die Arbeit zs. mit Koautoren wird aktuell zur Veröffentlichung eingereicht. Prof. Dr. Carl-Otto Weiss berichtete in „Grund zur Panik? Klimazyklen der letzten 250 Jahre“ über die Ergebnisse der Publikation von Lüdecke, Hempelmann und Weiss in Clim. Past (2013) der Europäischen Geophysikalischen Union (EGU). In dieser Studie konnte kein anthropogenes CO2-Signal in jüngster Zeit aufgefunden werden, was den heutigen Kenntnisstand bestätigt. Ein solches Signal – so es denn gibt – ist offenbar zu schwach, um es aus dem natürlichen Klimarauschen herausdestillieren zu können. Dagegen stellte sich heraus, dass zumindest die nordhemisphärische Temperaturentwicklung der letzten 250 Jahre von nur wenigen Zyklen ungewöhnlich genau wiedergebbar ist (

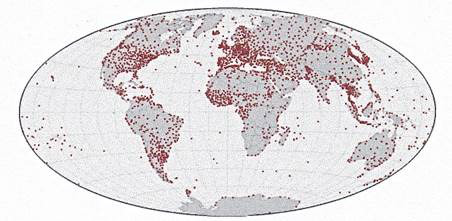

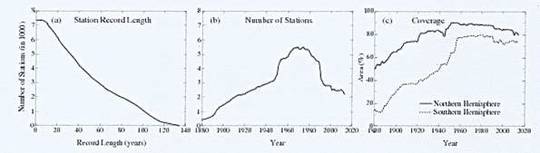

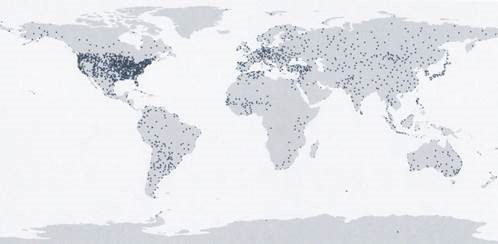

Prof. Dr. Carl-Otto Weiss berichtete in „Grund zur Panik? Klimazyklen der letzten 250 Jahre“ über die Ergebnisse der Publikation von Lüdecke, Hempelmann und Weiss in Clim. Past (2013) der Europäischen Geophysikalischen Union (EGU). In dieser Studie konnte kein anthropogenes CO2-Signal in jüngster Zeit aufgefunden werden, was den heutigen Kenntnisstand bestätigt. Ein solches Signal – so es denn gibt – ist offenbar zu schwach, um es aus dem natürlichen Klimarauschen herausdestillieren zu können. Dagegen stellte sich heraus, dass zumindest die nordhemisphärische Temperaturentwicklung der letzten 250 Jahre von nur wenigen Zyklen ungewöhnlich genau wiedergebbar ist ( Prof. Dr. Friedrich-Karl Ewert sprach über „Klimafakten – was wurde gemessen?“ Der Vortrag betonte die Priorität der Messungen vor (Klima)Modellen, dem seit Galilei gültigem Paradigma der Physik. Tatsächlich gibt es bis heute keinen messtechnischen Nachweis einer Einwirkung von anthropogenem CO2 auf das Klima. Nur fiktive Klimamodelle, die noch nicht einmal die Klimavergangenheit oder die Eintrittszeitpunkte des ENSO (El Nino) wiederzugeben in der Lage sind, können hierüber etwas aussagen. Der Vortrag ging weiter auf Einzelheiten der verfügbaren instrumentellen

Prof. Dr. Friedrich-Karl Ewert sprach über „Klimafakten – was wurde gemessen?“ Der Vortrag betonte die Priorität der Messungen vor (Klima)Modellen, dem seit Galilei gültigem Paradigma der Physik. Tatsächlich gibt es bis heute keinen messtechnischen Nachweis einer Einwirkung von anthropogenem CO2 auf das Klima. Nur fiktive Klimamodelle, die noch nicht einmal die Klimavergangenheit oder die Eintrittszeitpunkte des ENSO (El Nino) wiederzugeben in der Lage sind, können hierüber etwas aussagen. Der Vortrag ging weiter auf Einzelheiten der verfügbaren instrumentellen Dr. Volker Wrede vom geologischen Dienst NRW sprach über „Unkonventionelle Gasvorkommen in Deutschland – Potential und Risiken aus geowissenschaftlicher Sicht“. Wredes Vortrag war sehr ausführlich, dies war angesichts der gebotenen Information auch angebracht. So gut wie kein Gesichtspunkt, kamen sie nun seitens der Befürworter oder der Gegner des Fracking, wurde ausgelassen. Es handelt sich nach unserer Kenntnis wohl um die bislang beste und erschöpfendste Darstellung des Themas in einem allgemeinverständlichen Fachvortrag. Selbst die berühmten-berüchtigten „Flammen aus dem Wasserhahn“, die als US-Bild immer wieder durch die Medien geistern, kamen zur Sprache. Es handelte sich hier aber erwiesenermaßen um ein ganz natürliches Eindringen von CH4 ins Grundwasser ohne menschliches Zutun. Das "brennende" Leitungswasser wird damit zwar weder ungenießbar noch giftig, es besitzt aber das Potential der Verpuffung. Mit Fracking hatte diese Erscheinung, die in den USA wiederholt beobachtet wurde (das erste Mal 1965 im Bundesstaat Michigan beschrieben) nichts zu tun.

Dr. Volker Wrede vom geologischen Dienst NRW sprach über „Unkonventionelle Gasvorkommen in Deutschland – Potential und Risiken aus geowissenschaftlicher Sicht“. Wredes Vortrag war sehr ausführlich, dies war angesichts der gebotenen Information auch angebracht. So gut wie kein Gesichtspunkt, kamen sie nun seitens der Befürworter oder der Gegner des Fracking, wurde ausgelassen. Es handelt sich nach unserer Kenntnis wohl um die bislang beste und erschöpfendste Darstellung des Themas in einem allgemeinverständlichen Fachvortrag. Selbst die berühmten-berüchtigten „Flammen aus dem Wasserhahn“, die als US-Bild immer wieder durch die Medien geistern, kamen zur Sprache. Es handelte sich hier aber erwiesenermaßen um ein ganz natürliches Eindringen von CH4 ins Grundwasser ohne menschliches Zutun. Das "brennende" Leitungswasser wird damit zwar weder ungenießbar noch giftig, es besitzt aber das Potential der Verpuffung. Mit Fracking hatte diese Erscheinung, die in den USA wiederholt beobachtet wurde (das erste Mal 1965 im Bundesstaat Michigan beschrieben) nichts zu tun.

Dr. Jacob Nordangard sprach über "Biotreibstoffe – Die unheilige Allianz zwischen Lebensmittelindustrie und Umweltschützern"

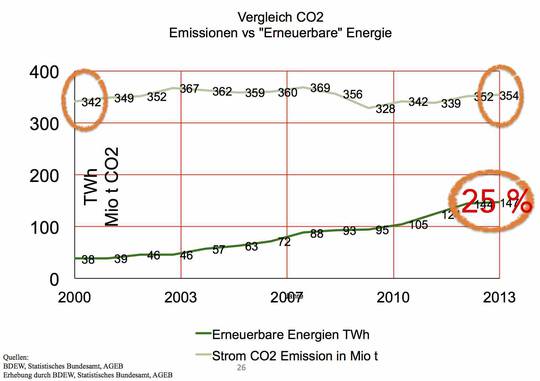

Dr. Jacob Nordangard sprach über "Biotreibstoffe – Die unheilige Allianz zwischen Lebensmittelindustrie und Umweltschützern" Dipl.-Ing. Limburg trug über "Energiewende – Das Milliardengrab?" vor. Anhand vieler Beispiele zeigte Limburg die exponentiell ansteigenden Kosten derEnergiewende auf. Viele Beispiele dazu wurden gebracht, auch der notwendige zusätzliche Netzausbau wurde dargestellt, der nur dazu dient, Überschussstrom aus den Erzeugergebieten an der Küste zu den Verbrauchszentren im Süden zu leiten. Da diese rechnerisch die meiste Zeit des Jahres keinen Strom liefern, aber bei vollem Ausbau und voller Leistung ein Vielfaches des Bedarfes erzeugen, müssen die Leitungen für diesen zigfachen Überschuss ausgelegt sein. Die Gesamtksoten der Energiewende incl. der Dämmung von Häusern bezifferte Limburg auf einen Betrag von 5-7 Billionen €. Deswegen korrigierte der den Titel seines Vortrages zum Schluss auf

Dipl.-Ing. Limburg trug über "Energiewende – Das Milliardengrab?" vor. Anhand vieler Beispiele zeigte Limburg die exponentiell ansteigenden Kosten derEnergiewende auf. Viele Beispiele dazu wurden gebracht, auch der notwendige zusätzliche Netzausbau wurde dargestellt, der nur dazu dient, Überschussstrom aus den Erzeugergebieten an der Küste zu den Verbrauchszentren im Süden zu leiten. Da diese rechnerisch die meiste Zeit des Jahres keinen Strom liefern, aber bei vollem Ausbau und voller Leistung ein Vielfaches des Bedarfes erzeugen, müssen die Leitungen für diesen zigfachen Überschuss ausgelegt sein. Die Gesamtksoten der Energiewende incl. der Dämmung von Häusern bezifferte Limburg auf einen Betrag von 5-7 Billionen €. Deswegen korrigierte der den Titel seines Vortrages zum Schluss auf  Abendveranstaltung – Gemeinsames Essen mit Tischrede von Prof. Dr. Hartmut Kliemt, Professor für Philosophie und Ökonomik an der Frankfurt School of Finance & Management, mit dem Thema "Klimaberichterstattung – Glauben vs. Wissen. Warum Fakten keine Rolle spielen". In diesem, mit humorvollen Randbemerkungen gewürzten Vortrag lernten die Zuhörer den Unterschied zwischen "Fakten" und "Glauben an nicht vorhandene Fakten" näher kennen. Die Klimafrage hat zumindest bei Zeitgenossen mit nicht allzu hohem intellektuellen Niveau Glaubens- oder gar Religionsqualität erreicht. Sachargumenten prallen dagegen wirkungslos ab. Nur die mit Sicherheit kommenden harten wirtschaftlichen Folgen der derzeitigen EU- und Deutschland-Politik in "Klimaschutz" und "Energie" werden dies ändern. Bis dahin werden unzählige Milliarden nutzlos verbrannt und insbesondere der Musterschüler Deutschland um ein Erhebliches ärmer geworden sein.

Abendveranstaltung – Gemeinsames Essen mit Tischrede von Prof. Dr. Hartmut Kliemt, Professor für Philosophie und Ökonomik an der Frankfurt School of Finance & Management, mit dem Thema "Klimaberichterstattung – Glauben vs. Wissen. Warum Fakten keine Rolle spielen". In diesem, mit humorvollen Randbemerkungen gewürzten Vortrag lernten die Zuhörer den Unterschied zwischen "Fakten" und "Glauben an nicht vorhandene Fakten" näher kennen. Die Klimafrage hat zumindest bei Zeitgenossen mit nicht allzu hohem intellektuellen Niveau Glaubens- oder gar Religionsqualität erreicht. Sachargumenten prallen dagegen wirkungslos ab. Nur die mit Sicherheit kommenden harten wirtschaftlichen Folgen der derzeitigen EU- und Deutschland-Politik in "Klimaschutz" und "Energie" werden dies ändern. Bis dahin werden unzählige Milliarden nutzlos verbrannt und insbesondere der Musterschüler Deutschland um ein Erhebliches ärmer geworden sein.