Heute möchte ich die zeitliche Abfolge der Entstehung der Hockeyschläger-Graphik aus dem Jahr 1999 beleuchten, und zwar im Lichte der bis jetzt bekannten Klimagate-Mails. Zu den grundlegenden Ereignissen war es am Dienstag, dem 16. November 1999 gekommen.

Die Dinge kamen gegen 9 Uhr (UK-Zeit) ins Rollen, als Tim Osborn die neuen Briffa- und die nachgeeichten Jones-Zeitreihen an Phil Jones gesendet hatte, zusammen mit dem Vorschlag, den Rückgang zu verstecken.

Es sind fertig geeichte Werte in Grad Celsius von 1961 bis 1990 im Vergleich zu den mittleren Temperaturen auf dem Festland der Nordhemisphäre nördlich von 20°N. Diese reichen von 1402 bis 1994 – aber man sollte wegen des Rückgangs wirklich die Werte nach 1961 durch die gemessenen Temperaturwerte ersetzen.

Zwanzig Minuten später schreibt Jones an das MBH-Team (mit cc an Briffa und Osborn) und erklärt die WMO-Pläne und wie genau die Graphik aussehen wird.

Jones erklärte, dass die Graphik auf dem Cover des jährlichen WMO-Berichtes erscheinen soll, welcher eine Print-Auflage von 10.000 hat. Jones sagte, dass er sich gegen den Gebrauch der Jahrtausend-Reihe in der Promotion ausgesprochen habe, weil er wusste, dass er „die Forschritte in der Paläoklimatologie überreizt hatte“:

Das nachhaltigste Thema aus Genf betrifft den WMO-Zustandsbericht des Klimas 1999. Die WMO hat diese Berichte während der letzten 6 Jahre ausgegeben, jedes Mal mit einer Auflage von 10.000 Exemplaren. Es gab zwei Möglichkeiten der Cover-Gestaltung (1998 wurde die instrumentale Aufzeichnung seit 1856 gezeigt) – nämlich einmal die tausendjährige Temperaturreihe oder die kontrastierenden Zugbahnen von Stürmen der Jahre 1998 und 1999. Ich habe als Einziger für Letzteres gestimmt – teils weil ich wusste, dass ich Ersteres organisieren musste. Ich wurde mit 12 zu 1 überstimmt, vielleicht weil ich in einer kurzen Präsentation die Fortschritte überreizt hatte, die während der letzten Jahre im Bereich Paläoklimatologie gemacht worden sind!

Jones erklärte die geplante Abbildung für MBH so:

Die WMO möchte die tausendjährige Reihe auf dem Cover bringen, und ich sagte, dass ich etwas erstellen würde, zusammen mit etwas Text. Die Abbildung wird die 3 Kurven enthalten (die von Mike, meine und die von Keith/Tim). Tim erstellt diese Kurve (alle Werte von 1961 bis 1990 und über 50 Jahre geglättet). Jede Kurve wird bis 1999 ausgeweitet durch instrumentelle Daten der Zonen/Jahreszeiten, die sie repräsentieren.

Dabei ist auch der Entwurf des kurzen Textes, der auf Seite 4 des Berichtes für die Kommentare erscheinen soll. Jones riskiert außerdem eine große Lippe hinsichtlich der Wichtigkeit der WMO-Veröffentlichung:

Der vollständige Text des Berichtes wird dann im Februar 2000 gedruckt – im vorigen Jahr ging er über 12 Seiten. Er wird am 15. März in Genf veröffentlicht, um zusammenzufallen mit dem Weltwettertag und auch den Feiern zum 50. Jahrestag der WMO. Die WMO plant, mindestens zwei mal so viele Ausgaben zu drucken als gewöhnlich und sprach von 25.000! Kopien gegen an alle WMO-Mitglieder und werden auf zahllosen Treffen verteilt, ebenso wie an eine Unmenge von verfügbaren gelisteten Adressen.

Danach fängt Jones offensichtlich an, mit der Zeitreihe zu arbeiten. Um 13.30 Uhr war er fertig und sendet die infame Trick-E-Mail. (Bradley scheint bereits dazu etwas gesagt zu haben, aber diese E-Mail ist in dem Dossier nicht zu finden):

Wenn ich Tims Diagramm erst einmal habe, werden wir dieses entweder noch heute oder als Erstes morgen versenden.

Ich bin gerade fertig geworden mit Mikes Nature Trick, nämlich die realen Temperaturen jeder Reihe der letzten 20 Jahre hinzuzufügen (d. h. ab 1981) und seit 1961 für die Daten von Keith, um den Rückgang zu verstecken. Mikes Reihe enthielt die jährlichen Werte von Festland und Ozeanen, während die anderen beiden die Werte von April bis September für das Festland der Nordhemisphäre nördlich von 20°N enthielten. Letztere sind real für 1999, während die Schätzung der Nordhemisphäre für 1999 zusammen +0,44°C ausmacht von 1961 bis 1990. Die globale Schätzung für 1999 mit Daten bis Oktober beträgt +0,35°C verglichen mit 0,57 für 1998.

Danke für die Kommentare, Ray.

Man beachte, dass Jones genau erklärt, was er mit „Mikes Nature Trick“ meint. Mann hat behauptet, dass sein „Nature Trick“ nichts weiter war als die klare Abbildung von Beobachtungen und Rekonstruktionen in der gleichen Graphik mit geeigneter Beschriftung. Aber der direkte Vergleich von Beobachtungen mit Rekonstruktionen ist so alt wie die Statistik selbst – und Jones und Briffa haben selbst solche Vergleiche in früheren Artikeln gezogen, ohne eine angemessene Beschriftung als mehr zu betrachten als elementare Hygiene. In dieser E-Mail (die oftmals verkürzt zitiert wird) sagt Jones, dass Manns „Nature Trick“ die „realen Temperaturen zu jeder Reihe der letzten 20 Jahre hinzufügt (d. h. seit 1981) und ab 1961 zu denen von Keith“, wie ursprünglich im November 2009 hier erklärt.

Zwei Stunden später antwortet Michael Mann, der seinen legalen Dokumenten zufolge „absolut nichts mit der Graphik zu tun hatte“ (was in seinem Lebenslauf immer noch der Erwähnung wert ist). Er stimmt dem Text vollständig zu und ergänzt, dass er „helfen wird, die im IPCC-Bericht AR 3 gemachten Behauptungen zu stärken“:

Der Text sieht gut aus, und ich stimme allem zu, was darin steht. Ich glaube, dass es ein starkes, aber vertretbares Statement ist, das helfen wird, die Behauptungen, die das IPCC aufstellen wird, zu stärken. Die Zahlen von 1999 sind sehr interessant und sollten helfen, die manchmal aufgestellten dubiosen Behauptungen zu durchkreuzen, dass El Nino der einzige Verantwortliche der anomalen jüngsten Wärme ist.

Es wird nichts gegen den Graphen gesagt, welcher Manns Märchenbuch zufolge eindeutig irreführend ist (und für den vollständig Jones verantwortlich gemacht wird):

…und die Cover-Graphik von Jones auf dem WMO-Bericht 1999 mit den Temperaturtrends der Vergangenheit wurde kritisiert als potentiell „irreführend“, weil Proxy-Daten und instrumentelle Daten in eine einzige Kurve gepresst worden sind – eine Schlussfolgerung, die niemand wirklich in Frage stellte.

Mann versucht weiter zu helfen, indem er „zum Vergleich“ die Entwurfsversion der Abbildung 2-21 im IPCC-AR 3 versendet, und erklärt einen netten „Trick“, wie man angesichts des Rückgangs grundsätzlich damit umgehen könnte:

Nur zum Vergleich mit dem, was Tim erzeugt, füge ich den Plot an, von dem Sie sich erinnern werden, dass wir (die Mitarbeiter am Met.Office) uns auf die Endversion des Kapitels 2 vorbereiten (pdf). Um Ihrer Erinnerung auf die Sprünge zu helfen, haben wir den Zeitraum 1961 bis 1990 für die absolute Anomalie-Skala herangezogen, aber wir haben die Reihen mit der Grundlage eines früheren Intervalls mit Instrumentenmessungen (1931 bis 1960) angeglichen. Diese gehen zum größten Teil dem jüngsten Rückgang in der Reihe von Briffa et al. voraus. Ich glaube, dass dies zu einem ähnlichen Bild führt, aber wenn Sie meinen, dass es irgendwelche signifikanten Diskrepanzen zu dem gibt, was Tim vorbereitet, sollten wir darüber reden.

Zehn Minuten später sendet Osborn die Entwurfsgraphik an Jones, der sie eine halbe Stunde später weiterleitet an die Mannschaft mit einer Erklärung der Grundlinie.

Das Diagramm von Keith und Tim ist das neue Diagramm, das nicht Eingang gefunden hat in den gegenwärtigen IPCC-Entwurf. Für die anderen beiden sind 0,12°C hinzugefügt worden, um die Basisperiode von 1902 bis 1980 auf den Zeitraum 1961 bis 1990 zu korrigieren (ich erinnere mich nicht an die genauen Daten). Für meine Graphik hat Tim einen Mittelwert benutzt und eine Standardabweichung berechnet auf der Grundlage der mittleren Temperaturen von April bis September auf dem Festland der Nordhemisphäre nördlich von 20°N.

Es gab keinen Protest der MBH-Mannschaft nach der Sichtung der Abbildung, und nur Malcolm Hughes kommentiert eine Stunde später:

Hallo Phil, der Text sieht m. E. gut aus. Ich habe keine starke Vorliebe hinsichtlich der Diagramme, außer dasjenige, das Mike in Umlauf gebracht hat wegen des Vorteils einer Schätzung von Unsicherheiten.

Bis hier scheint nur Keith Briffa keine Kommentare zu der Veröffentlichung abgegeben zu haben. Allerdings erkennt man seine Akzeptanz aus dem Brief, den er am nächsten Morgen an eine Herausgeberin von Elsevier geschrieben hat mit der Nachfrage, ob die neue Version von Briffas QSR (2000) Abbildung 5 ersetzt worden ist:

Amanda,

mit Bezug auf meinen vorherigen Brief – können Sie bestätigen, dass die neue Abbildung ersetzt worden ist, da ich inzwischen die Absicht habe, diese in einer kommenden WMO-Veröffentlichung zu erwähnen, die weit verbreitet wird.

QSR (2000) steht als Referenz für Briffas Reihe in der WMO-Veröffentlichung und später im IPCC-AR 3. Die E-Mail ist schon für sich allein wichtig, erklärt sie doch die Schwierigkeiten, die ich und George Kukla 15 Jahre später hatten.

Unabhängig von Jones war Manns Verteidigungslinie dieser „übermäßig vereinfachten Darstellung“ (per Manns Antwort-Memorandum), dass die „vereinfachte“ Abbildung erstellt worden ist mit einem „großenteils nichttechnischen Publikum“ im Hinterkopf. Die moderne Arabian Nights schreibt:

Das war, kurz gesagt, Maikes „Trick“, den Jones gewählt hat, um die Proxy-Temperaturreihe in seinem Vergleich bis zur Gegenwart zu aktualisieren, obwohl die Proxy-Daten selbst schon viele Jahrzehnte zuvor aufhörten. Es gab jedoch eine Sache, die Jones in seiner WMO-Graphik getan hat, die über das hinausging, was wir in unserem Nature-Artikel getan haben: Er hat nahtlos die Proxy- und die instrumentellen Daten zusammengeführt in eine einzige Kurve, ohne zu erklären, welche Kurve was zeigte. Das war potentiell irreführend, wenn es nicht Absicht war: Er trachtete lediglich danach, das Bild zu vereinfachen für eine großenteils nichttechnische Leserschaft des WMO-Berichtes.

Wie man jedoch aus Obigem erkennt, gab es keine Überlegung bzgl. der speziellen Zuhörerschaft, als die Graphik erstellt worden ist. Stattdessen argumentierte Mann, dass sie „helfen wird, die Behauptungen zu stützen“, die man vor der IPCC-Zuhörerschaft aufgestellt hatte.

Außerdem scheint aus den CG-Briefen hervorzugehen, dass die „übermäßig vereinfachte und künstlerische Darstellung“ unter ihren Kollegen für die wissenschaftlichen Ziele weiter verbreitet worden ist. Im Februar 2000 erbittet Bradley die Abbildung für eine mögliche Verwendung in dem PAGES-Synthesebericht:

…können Sie mir eine weitere Kopie der WMO-Abbildung zuschicken, die Sie vorbereitet haben – zumindest falls sie sich nach dem 16.11.1999 geändert hat. Bei einer erneuten Durchsicht Ihrer Anmerkungen zu derjenigen Abbildung, die Sie verschickt haben, scheint es so, als ob sie immer noch mit 40- oder 50-Jahres-Filtern herumgespielt haben, so dass vielleicht diejenige, die ich habe, nicht die Letzte ist. Es könnte dazu führen, dass wir dies im PAGES-Synthese-Kapitel verwenden – ich glaube, dass sie unterschiedlich ist im Vergleich zu der von Keith verwendeten Abbildung in Science ist (7. Mai 1999 – v284, Seite 927).

Im April 2000 sendet Jones die Abbildung zusammen mit der gesplitteten Zeitreihe an Curtis Covey:

Im Anhang finden Sie die von Ihnen gewünschten Daten. Es gibt 5 Spalten (meine, Mike Mann, Keith, jährlich Nordhemisphäre und Juni, Juli, August Nordhemisphäre). Die letzten beiden sind instrumentell und beginnen erst in den fünfziger Jahren des 19. Jahrhunderts. Keith‘ Reihe beginnt etwa um das Jahr 1400. Alle beziehen sich auf 1961 bis 1990. Sie werden sehen, dass dieser File für die 3 Multiproxy-Reihen bis 1999 ausgeweitet wurde, indem instrumentelle Daten pro Jahreszeit und Region hinzugefügt wurden, die sie repräsentieren sollen. Der andere Anhang enthält eine Abbildung der ersten 3, die auf dem Cover des WMO-Statements für 1999 erschienen war.

Und später im Oktober 2000 an Jim Hurrell:

Tim kann Ihnen etwas schicken, das alle Reihen enthält. Es war auf dem Cover des WMO-Statements 1999 erschienen. Darin wurden die Reihen ausgeweitet mit äquivalenten instrumentellen Daten bis 1999.

Tatsächlich scheint es, dass sie so stolz auf ihre Abbildung waren, dass sie die Graphik auf der Rückseite des offiziellen CRU-T-Shirts platzierten. Mann hat diese dann überglücklich bestellt:

p. s. Ich trage ein Medium 😉

Die WMO-Abbildung erscheint ein weiteres Mal, diesmal im CG-Dossier. In einem bemerkenswerten Brief, der es wert ist, in Gänze dargestellt zu werden, schreibt später George Kukla im Januar 2001 an Keith Briffa und befragt ihn hinsichtlich der Inkonsistenz zwischen der WMO-Präsentation der Daten und des Rückgangs, erkennbar in Briffas technischen Studien. Er nennt die WMO-Präsentation „nicht sehr verantwortlich“:

Hallo Keith,

Sie sind der Einzige, der wissen kann, was in den nördlichen Wäldern passiert ist und passiert. In dieser Hinsicht glaube ich nicht, dass das WMO-Statement #913 zum Status des globalen Klimas 1999 ein hinreichend zuverlässiges letztes Wort ist. Zum Einen: die Ihnen zugeschriebene Kurve scheint mit keiner der Abbildungen Ihrer 2000 QSR-Studie zu schwingen. Woher nehmen Sie die 0,6 Grad Abweichung um das Jahr 1600?

Ein weiteres Problem: Die Ringdichte und -breite während der letzten Jahrzehnte nehmen beide ab, was zu jeder anderen Zeit als ein Anzeichen von Abkühlung interpretiert werden würde. Warum also wird daraus im WMO-Bericht eine beispiellose Erwärmung? Wie Sie angemessen in Ihren Studien diskutieren wissen wir einfach nicht, wie genau die Baumringe mit dem Wetter zusammenhängen. Meiner Ansicht nach haben wir folgende Optionen:

1) Die Kalibrierungen der Ringe mit der Temperatur vor 1950 sind verzerrt, möglicherweise wegen der geringen Abdeckung mit Temperaturstationen.

2) Etwas Anderes als die Temperatur beeinflusste die Bäume während der letzten Jahrzehnte, und wir wissen nicht, was.

In jedem Falle ist es nicht sehr verantwortungsvoll, die Kurven mit dem globalen Klima in Zusammenhang zu bringen, wie die WMO es getan hat. Sie sagen das, wenngleich irgendwie indirekt, aber ziemlich klar in allen Ihren Studien. Unglücklicherweise scheint es so, als ob diese viel zu lang sind, um von der WMO gelesen zu werden.

Grüße

Ich denke, man kann mit Fug und Recht feststellen, dass Georg Kukla der erste war, der Hide-The-Decline entdeckt hat.

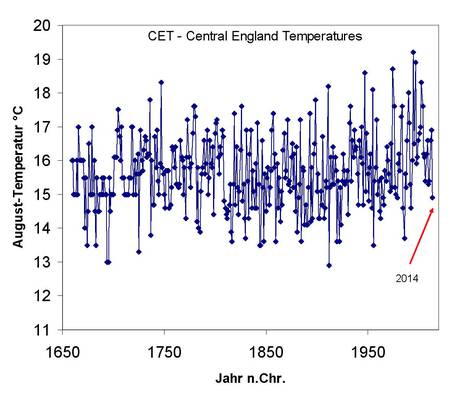

Und so sehen die Bilder „vorher“ und „nachher“ aus:

Siehe oben rechts!

Link: http://climateaudit.org/2014/09/22/black-tuesday-of-climate-science/

Übersetzt von Chris Frey EIKE