Schlüsselpunkte in dieser Übersicht:

• Die Obama-Administration, deren Verbündete im Kongress und die Umweltgemeinschaft propagieren die Vorteile grüner Technologie und der Erzeugung grüner Arbeitsplätze, um die Arbeitslosigkeit zu lindern.

• Grüne Arbeitsplätze ersetzen kaum Arbeitsplätze in anderen Bereichen und tragen im Endeffekt weniger zum wirtschaftlichen Wachstum bei.

• Erfahrungen mit erneuerbarer Energie in Europa haben zu Verlusten von Arbeitsplätzen geführt ebenso wie zu höheren Energiepreisen und Korruption.

Grün ist das neue Schwarz, sowohl in den USA als auch in Europa. Fast jeder im linken Spektrum hat sich grüne Hosen angezogen, grüne Hemden und grüne Deckmäntel; zusammen mit der Versicherung, dass dies die Zukunft des Lebens auf der Erde ist, so wie wir sie kennen.

Präsident Obama spricht in seinen Reden regelmäßig die grüne Ökonomie an. Das Obama/Biden-Dokument mit dem Titel New Energy for America aus dem Jahr 2008 konzentriert sich auf grüne Arbeitsplätze, grüne Technologie, grüne Herstellungsprozesse, grüne Gebäude und sogar grüne Veteranen. In einer Rede vor dem Democratic National Committee im September 2010 hat Obama getönt: „Wir waren zurückgefallen, und jetzt sind wir wieder da und befinden uns in der Ersten Reihe von Forschung und Entwicklung. Wir haben die größten Investitionen in grüne Energie in unserer Geschichte getätigt, so dass wir jetzt Solarpaneele und Windturbinen überall im Lande errichten können“. (1)

In einer Rede vom 13. August hat Vizepräsident Joe Biden in die gleiche Kerbe gehauen: „Es reicht nicht, einfach nur die Wirtschaft zu retten, sondern wir müssen sie besser als zuvor aufbauen – und diese Arbeit beginnt damit, den amerikanischen Produzenten die Ressourcen zu geben, die die Grundlage für saubere, grüne Energie-Technologie unserer Wirtschaft im 21. Jahrhundert bildet. Mit der heutigen Einführung von 2,3 Milliarden Dollar Steuererleichterungen für grüne Produzenten sind wir dabei, die Herstellung von Materialien für grüne Energie in diesem Lande zu beschleunigen, während wir tausende neuer Arbeitsplätze genau hier in unserem eigenen Hinterhof schaffen. Von Wind- und Solarstrom bis zur Technologie von Elektroautos wird unsere Erholung befeuert von den Anreizen unserer Steuergesetze, die wir heute den Unternehmen anbieten, die dann morgen der Motor unserer Wirtschaft sein werden“. (2)

Die ehemalige Sprecherin Nancy Pelosi von den Demokraten unterstützt ebenfalls die Causa grün. Ein Waschzettel einer Pelosi-Rede vor der Stanley School in Waltham, Massachusetts beginnt mit den Worten: „Für eine bessere und blühendere Wirtschaft müssen wir in grüne Infrastruktur investieren, in eine grüne Wirtschaft und in grüne Schulen, um eine Arbeitswelt mit gut bezahlten grünen amerikanischen Arbeitsplätzen zu erschaffen“. (3)

Natürlich wurde auch Senator Harry Reid von den Demokraten nicht außen vor gelassen. Auf einem Gipfeltreffen der Senatoren von den Demokraten im Jahre 2009 über grüne Arbeitsplätze überschlug sich Reid mit Lobhudeleien auf seine grünen Leistungen: „Wir haben beispiellose Investitionen in saubere, erneuerbare Energien und neue, grüne Arbeitsplätze gesteckt, die niemals ausgelagert werden können. Im Jahre 2007 haben wir ein Eckpfeiler-Energiegesetz erlassen, das zur Entwicklung sauberer, erneuerbarer Treibstoffe hier bei uns führte sowie zur Erzeugung wichtiger amerikanischer Produktions-Arbeitsplätze. Wir haben zum ersten Mal in einer Generation die Standards bzgl. Energie-Effizienz angehoben und neue Energieeffizienz-Standards gesetzt für Beleuchtung, Haushaltsgeräte sowie öffentliche Gebäude und Fahrzeuge. Im Wirtschaftsplan, in diesem Jahr in Kraft gesetzt, investierten wir 67 Milliarden Dollar, um saubere Energie zu entwickeln, und weitere 500 Millionen Dollar, um neue Arbeiter in führenden grünen Positionen zu trainieren, die unsere Nation jeden Tag energieeffizienter und energieunabhängiger machen“.

[Was könnte man mit all diesem Geld tun, wenn es für sinnvollere Zwecke verwendet werden würde! Anm. d. Übers.]

Alles in allem heißt es also auf der Linken Seite einstimmig, dass die Zukunft der Welt grün ist: grüne Energie, die grüne Technologien antreibt; grüne Häuser erzeugt sowie Gebäude, Autos und Jobs, Jobs, Jobs. Aber basiert dieses Denken auf realistischer Ökonomie, realistischem Verständnis grüner Technologie oder realistischen Erwartungen hinsichtlich des Wachstumspotentials der grünen Bewegung? Dieser Artikel untersucht, ob die Regierung Arbeitsplätze mittels Subventionen aller Art erzeugt und schaut dann auf die besorglichen europäischen Erfahrungen mit grüner Energie und der Schaffung von Arbeitsplätzen.

Grüne Energie und grüne Arbeitsplätze

Um den Trugschluss der Regierung hinsichtlich der Schaffung grüner Jobs mittels Subventionen und Vorschriften zu verstehen, müssen wir den französischen Ökonom Frédéric Bastiat zu Rate ziehen. Bereits im Jahre 1850 hat Bastiat den Trugschluss erklärt, der solchen Denkweisen zugrunde liegt, und zwar in einem Essay über die unsichtbaren Kosten derartiger Bemühungen. Er nannte es den „Trugschluss des zerbrochenen Fensters“.

Der Trugschluss geht folgendermaßen: Man stelle sich vor, einigen Ladenbesitzern werden die Scheiben durch ein Steine werfendes Kind zerschlagen. Zunächst sympathisieren die Leute mit den Ladenbesitzern, bis jemand behauptet, dass die zerschlagenen Scheiben eigentlich gar nicht so schlecht sind. Schließlich „schaffen sie Arbeit“ für den Glaser, der dann in der Lage ist, mehr Nahrung zu kaufen, was wiederum von Vorteil für den Krämer ist, oder sich neue Kleidung zuzulegen, wovon der Schneider profitiert. Wenn nur genug Fenster zerschlagen werden, könnte der Glaser sogar einen Helfer einstellen – und hätte einen Arbeitsplatz geschaffen.

Hat also das Kind der Öffentlichkeit mit dem Zerschmeißen der Fenster einen Gefallen getan? Nein! Wir müssen auch in Betracht ziehen, was der Ladenbesitzer mit dem Geld gemacht hätte, das er für die Reparatur des Fensters ausgeben musste, wenn das Fenster nicht zerbrochen worden wäre. Höchstwahrscheinlich hätte der Ladenbesitzer dieses Geld wieder in seinen Laden investiert; vielleicht hätte er von seinem Händler noch mehr Güter gekauft oder neue Mitarbeiter eingestellt.

Wären die Fenster nicht zerschlagen worden, würde es in der Stadt immer noch die Arbeitsplätze geben, die durch das Geld des Ladenbesitzers geschaffen worden wären, plus das eingesparte Geld für die nicht zerbrochene Scheibe. Weil der Wert des Fensters zerstört worden ist, wurde er – und die Stadt als Ganzes – jedoch ärmer.

Es ist unter Ökonomen ein alter Hut, dass Regierungen keine Arbeitsplätze „schaffen“; der Wille der Unternehmer, ihr Kapital zu investieren, zusammen mit der Nachfrage der Verbraucher nach Gütern und Serviceleistungen macht dies. Alles, was die Regierung tun kann, ist einige Industrien zu subventionieren, während sie anderen höhere Kosten auferlegt. Im Falle grün zerstört sie Arbeitsplätze im konventionellen Energiesektor – und höchstwahrscheinlich auch in anderen industriellen Bereichen – durch Steuern und Subventionen für neue grüne Unternehmen, die die Dollars der Steuerzahler dazu verwenden, den Wettbewerb zu unterlaufen. Die durch Subventionen „geschaffenen“ Arbeitsplätze sind per definitionem weniger effizient bei der Verwendung von Kapital als Arbeitsplätze, die der Markt hervorgebracht hat. Das bedeutet, sie sind ökonomisch weniger produktiv als die Jobs, die sie ersetzen, und sie tragen weniger zum wirtschaftlichen Wachstum bei. Schließlich ist das Produkt, das durch von der Regierung geförderten Arbeitsplätzen entstanden ist, eine nicht ökonomische Ware, die auf unbestimmte Zeit gestützt werden muss, oftmals ohne einen wirtschaftlichen Nutzen, also anders als bei Straßen, Schienen, Massentransit und vielleicht Windmühlen, Installationen von Solarpaneelen oder andere grüne Technologien.

Um zu verstehen, wie das in der Praxis läuft, wende ich mich jetzt sechs europäischen Ländern zu, die für Erneuerbare außer Rand und Band geraten sind, während sie das Hohelied grüner Arbeitsplätze singen: Spanien, Italien, Deutschland, Dänemark, UK und die Niederlande.

Spanien

Spanien wurde lange als führend beim Übergang zu erneuerbarer Energie gesehen. Tatsächlich hat Obama in einer Rede im Jahre 2009 Spanien als rühmliches Beispiel hervorgehoben. Der Präsident hatte gesagt: „Es gibt enormen wirtschaftliche Verbindungen zwischen unseren beiden Ländern, und wir haben uns geschworen, hart zu arbeiten, um diese noch weiter zu stärken, besonders in Schlüsselbereichen wie erneuerbarer Energie und dem Transportwesen, wo Spanien weltweit führend war und die USA nach meiner Überzeugung ein enormes Potential haben voranzugehen“. (4).

Aber die Geschichte der führenden Rolle Spaniens hinsichtlich grüner Arbeitsplätze hat nach dieser Rede Obamas eine Reihe harter Rückschläge erlebt. Im März 2009 haben die Forscher Gabriel Calzada Alvarez und seine Kollegen an der Universidad Rey Juan Carlos eine Studie veröffentlicht, in der sie die ökonomischen und arbeitsplatztechnischen Auswirkungen der starken Offensive Spaniens zu Erneuerbaren untersucht. Ihre Ergebnisse haben die gewöhnliche Rhetorik bzgl. grüner Jobs gehörig durcheinander gewirbelt (5):

● Seit dem Jahr 2000 hat Spanien 571.138 Euro für jeden grünen Arbeitsplatz ausgegeben, einschließlich Subventionen von über 1 Million Euro pro Job in der Windindustrie.

● Die Programme, die zur Bildung dieser Arbeitsplätze geführt haben, haben fast 110.500 Arbeitsplätze anderswo in der Wirtschaft vernichtet (2,2 vernichtete Arbeitsplätze für jeden geschaffenen grünen Job).

● Die hohen Stromkosten betreffen hauptsächlich die Produktionskosten und das Beschäftigungsniveau in den Bereichen Metallurgie, nichtmineralischen Bergbau und die Erzeugung von Nahrungsmitteln sowie in der Getränke- und Tabakindustrie.

● Jedes installierte „grüne“ Megawatt vernichtet im Mittel 5,28 Arbeitsplätze in anderen Bereichen der Wirtschaft.

● Diese Kosten spiegeln noch nicht Spaniens besonderes Vorgehen, sondern vielmehr die Natur der Art und Weise, mit der erneuerbare Energiequellen vorangetrieben werden.

In Spanien hat man inzwischen herausgefunden, dass der Ausflug des Landes in die erneuerbaren Energien unhaltbar geworden ist. Bloomberg berichtet, dass Spanien seine Subventionen für neue Solarkraftwerke drastisch gekürzt hat (6). Der Analyst Andrew McKillop schreibt in dem Magazin Energy Tribune:

In Spanien beliefen sich die Subventionen in die massiven Windparks des Landes und deren abhängige Industrien schätzungsweise auf bis zu 12 Milliarden Euro allein im Jahr 2009, entweder direkt oder durch „Einspeisetarife“. Daher hat die Regierung diese Subventionen um mindestens 30% gekürzt. Bedeutende Firmen im Bereich Windenergie wie Gamesa haben begonnen, ihre Arbeitsplätze abzubauen, während sie gleichzeitig versuchen, außerhalb Europas ihre Produkte zu verkaufen, wobei ein schwächerer Euro hilfreich ist. Zusätzlich und wegen der hoch defizitiären Handelsbilanz Spaniens, was das Land zum Ziel von Spekulanten werden lässt, die darauf bauen, dass deren Kurse steigen müssen, wird die spanische Regierung wahrscheinlich auch den finanziellen Rückhalt der bestehenden Kraftwerke erneuerbarer Energien kürzen, obwohl diese in Erwartung garantierter Preise und Regierungs-Subventionen für 25 Jahre errichtet worden waren (7).

Und dann ist da noch das Problem der Korruption. Bloomberg Businessweek berichtet: „In einer Anhörung zur Solarstromerzeugung von November 2009 bis Januar 2010 kam heraus, dass einige Betreiber von Solarpaneelen dafür bezahlt worden sind, das ‚Unmögliche‘ zu schaffen – nämlich die Erzeugung von Sonnenstrom während der Nacht (8)“. Außerdem scheint es so, als ob die Solarenergie-Erzeuger „Dieselgeneratoren betrieben und den so erzeugten Strom als Solarstrom verkauft haben, was viele Male lukrativer ist als der Verkauf fossilen Stromes“. Neunzehn Personen im spanischen Sektor „saubere Energie“ sind verhaftet worden, und zwar unter Vorwürfen, die von Bestechung bis zu zwielichtigen Landverkäufen reichen, um Freunden und Familien Lizenzen auszustellen mit falschen Angaben zur Konstruktion. Der Guardian berichtet: „als die spanische nationale Kommission für Energie beschloss, 30 Solarfarmen zu inspizieren, kam es zu dem Ergebnis, dass nur 13 davon ordnungsgemäß errichtet worden waren und tatsächlich Strom in das Netz einspeisten“ (9).

Italien

Ähnlich ist die Lage in Italien, ebenfalls ein Führer bei der Entwicklung von Wind- und Solarenergie. Eine Studie von Luciano Lavecchia und Carlo Stagnaro vom Bruno Leoni-Institut in Italien fanden sogar eine noch schlimmere Lage:

Schließlich haben wir das Kapital pro Arbeiter im RES (Renewable Energy Systems) mit dem Kapital pro Arbeiter in der Industrie und der gesamten Wirtschaft verglichen. Wir fanden ein Verhältnis von jeweils 6,9 bzw. 4,8. Anders gesagt, die gleiche Kapitalmenge, die einen Arbeitsplatz im grünen Sektor schafft, würde 6,9 oder 4,8 Arbeitsplätze schaffen, wenn man dieses Kapital in die Industrie oder die Wirtschaft allgemein investiert – obwohl es innerhalb der Erneuerbaren selbst schon Unterschiede gibt. Windkraft wird wahrscheinlich mehr Arbeitsplätze schaffen als Photovoltaik. Diese Tatsache ist besonders relevant, weil wir nicht einmal den nicht-trivialen Wert der erzeugten erneuerbaren Energie betrachtet haben, sondern uns ausschließlich auf die Subventionen konzentriert haben. Falls wir den Energiewert in Betracht gezogen hätten, wäre das Kapital pro Arbeiter sogar noch höher. Da Subventionen gewaltsam dem wirtschaftlichen Kreislauf entzogen und für politische Zwecke verwendet werden, ist es besonders wichtig, sich darüber im Klaren zu sein, welche Konsequenzen das hat (10).

Die Forscher fanden auch heraus, dass die große Mehrheit der geschaffenen grünen Arbeitsplätze nur zeitweiliger Natur waren: „Aus verschiedenen Quellen haben wir einen Startpunkt mit 9000 bis 26.000 Arbeitsplätzen in der Windkraft und 5500 bis 14.500 Arbeitsplätzen im Bereich solar gewählt. Ausgehend von dieser Zahl haben wir berechnet, dass dank der von Rom versprochenen Subventionen die Anzahl der in der grünen Ökonomie beschäftigten Personen bis zum Jahr 2020 auf eine Gesamtzahl von 50.000 bis 112.000 steigen wird. Allerdings sind die allermeisten dieser Arbeitsplätze – mindestens 60% – bestimmten Gruppen vorbehalten, nämlich Installateuren und anderen Zeitarbeitern, die verschwinden werden, wenn die Windturbine oder das Solarpaneel erst einmal in Betrieb ist“ (11).

Und wie in Spanien kam es auch in Italien zu wild wuchernder Korruption im Sektor Erneuerbare. Aber nicht zahlreiche Individuen, die die Regierung hintergehen, sind das Problem, sondern die Mafia hat ihre Finger im Spiel. Nick Squires und Nick Meo berichten im Telegraph: „Angezogen durch die Aussichten generöser Zuwendungen, um den Verbrauch alternativer Energien zu befeuern, hat die sog. ,Öko-Mafia‘ damit begonnen, auf betrügerische Weise Millionen Euro von der italienischen Regierung und der Europäischen Union abzusahnen“ (12). Weiter berichten sie:

Acht Personen sind in der Operation „Eolo“ verhaftet worden, benannt nach Äolus, dem antiken griechischen Gott des Windes. Der Vorwurf: Bestechung von Funktionären in der Küstenstadt Mazara del Vallo, und zwar in Gestalt von Luxusautos und individuellen Zuwendungen von 30.000 bis 70.000 Euro.

Polizeiliche Abhöraktionen brachten das Ausmaß der Infiltration der Mafia im Windenergie-Sektor ans Licht. Sie hatten einen mutmaßlichen Mafioso abgehört, der seiner Frau gesagt hat: „Keine einzige Windturbine wird in Mazara errichtet, wenn ich dem nicht zustimme“.

In einer anderen Operation im November 2013 mit dem Codenamen „Gone with the Wind“ wurden 15 Personen unter dem Verdacht verhaftet, versucht zu haben, 30 Millionen Euro in Fonds der Europäischen Union unterschlagen zu haben. Unter den Verhafteten befand sich auch der Präsident der nationalen Windenergie-Vereinigung Italiens Oreste Vigorito.

Deutschland

Deutschlands Ausflug in die erneuerbare Energie begann in großem Stil im Jahre 1997, als die Europäische Union ein Ziel übernommen hat, 12 Prozent ihres Stromes aus erneuerbaren Quellen zu erzeugen (13). Der deutsche Weg zur Erreichung derartiger Ziele war ein Einspeisegesetz, welches die Einrichtungen zwang, unterschiedliche Arten erneuerbaren Stromes zu unterschiedlichen Preisen zu kaufen. In einer Studie zu den Auswirkungen der aggressiven Befürwortung Deutschlands von Wind- und Solarenergie fand Martin Frondel heraus, dass das deutsche Einspeisegesetz die Einrichtungen verpflichtete, Solarenergie zu einem Preis von 59 Cent pro Kilowattstunde zu kaufen, also zu einem weit höheren Preis als die konventionellen Stromkosten, die zwischen drei und zehn Cent lagen. Einspeise-Subventionen für Windkraft lagen seinen Ergebnissen zufolge um 300 Prozent höher als konventionelle Stromkosten (14).

Unnötig hervorzuheben, dass diese massive Subvention von Wind- und Solarenergie eine Menge Investoren anzog: Schließlich ist es so, falls die Regierung mehrere Jahrzehnte lang einen Markt garantiert und einen Preis festsetzt, der hoch genug ist, dass Erzeuger von Erneuerbaren noch Profit machen, wird Kapital in diesen Markt fließen. Deutschland wurde zum zweitgrößten Windenergie-Erzeuger nach den USA, und die Investitionen des Landes in Solarenergie waren genauso aggressiv.

Aber Frondel zufolge lief die Chose nicht so, wie die deutschen Politiker und die Umweltaktivisten gesagt haben. Anstatt ökonomische Vorteile zu zeitigen in Gestalt billigerer Energie und einer starken Vermehrung von Arbeitsplätzen bzgl. grüner Energie, hat die Einführung von Wind- und Solarenergie zu Stromkosten-Steigerungen für die Haushalte um 7,5 Prozent geführt. Außerdem waren die Kosten für Treibhausgas-Emissionen erstaunlich hoch: über 1000 Dollar pro Tonne für Solarenergie und über 80 Dollar pro Tonne für Windkraft. Angesichts des Umstands, dass der Kohlenstoffpreis im europäischen Handelssystem zu der Zeit bei 19 Dollar pro Tonne lag, waren Treibhausgas-Emissionen aus Wind und Solar keine großen Investitionen.

Frondel folgert: „Die deutsche Politik hinsichtlich erneuerbarer Energie und im Besonderen das übernommene Schema für Einspeisetarife war ein Fehlschlag hinsichtlich der Nutzung der Marktanreize, um eine zuverlässige und kosteneffektive Einführung erneuerbarer Energie in das Energie-Portfolio des Landes sicherzustellen, Im Gegenteil, die Methoden der Regierung zur Unterstützung [der Erneuerbaren] haben diese Anreize in vielfacher Hinsicht unterlaufen, was zu massiven Ausgaben führte, die wenig Aussicht auf eine Stimulierung der Wirtschaft zeigen, die Umwelt zu schützen oder die Energiesicherheit zu erhöhen. Im Falle Photovoltaik hat das deutsche Subventions-Regime ein Niveau erreicht, das bei Weitem die Löhne der Arbeiter übersteigt, und zwar um bis zu 175.000 Euro“. Er fügt hinzu:

Summa summarum hat es die Politik der Regierung nicht vermocht, sich die Marktanreize zunutze zu machen, die nötig sind, eine zuverlässige und kosteneffektive Einführung erneuerbarer Energie in das deutsche Energie-Portfolio sicherzustellen. Im Gegenteil, die deutschen grundsätzlichen Methoden, die erneuerbaren Technologien durch Einspeisetarife zu unterstützen, hat hohe Kosten verursacht, ohne auch nur eine einzige der vermeintlichen positiven Auswirkungen zu zeitigen, wie beispielsweise Reduktion von Emissionen, Beschäftigungsniveau, Energiesicherheit oder technologische Innovation. Die Politiker sollten also die Erfahrungen in Deutschland sehr sorgfältig untersuchen. Das gilt auch für die USA, wo gegenwärtig fast 400 Programme der [US-]Bundesregierung und der US-Staaten in Kraft sind, die finanzielle Anreize für erneuerbare Energie bringen. Obwohl das deutsche Vorantreiben erneuerbarer Energien allgemein in den Medien als „ein leuchtendes Beispiel für die Welt“ gepriesen wird (The Guardian 2007),sollten wir stattdessen die Erfahrungen dort als ein abschreckendes Beispiel einer ungemein teuren Umwelt- und Energiepolitik betrachten, der jedwede ökonomischen und umweltlichen Vorteile fehlen.

Wie in Spanien und Italien wird es auch in Deutschland immer schwieriger die Subventionen für Wind- und Solarenergie auf dem bestehenden Niveau aufrecht zu erhalten. Im Mai hat der Deutsche Bundestag die Subventionen für auf Dächern montierte Solar-Photovoltaik-Systeme um 16 Prozent gekürzt; bei frei stehenden Anlagen um 15 Prozent (15).

…

Anmerkung des Übersetzers: Hier folgt noch die Beschreibung der Verhältnisse in Dänemark, UK und den Niederlanden. Die Probleme sind jeweils etwas anders gelagert, laufen aber immer auf das Gleiche hinaus: Wind und Solar ist ein Flop.

Aus Zeitgründen wird hier darauf verzichtet, auch diese drei Abschnitte zu übersetzen, denn das Bild ist eigentlich klar. Der Autor fügt noch eine kurze Schlussfolgerung an:

Conclusion

Sowohl die Wirtschaftstheorie als auch die Erfahrungen europäischer Länder, die versucht haben, eine Wirtschaft auf der Grundlage grüner Energie zu etablieren mit dem Ziel, grüne Arbeitsplätze zu schaffen, enthüllen, dass diese Denkreise zutiefst trügerisch ist. Spanien, Italien, Deutschland, Dänemark, UK und die Niederlande haben allesamt versucht, positive Ergebnisse mit erneuerbarer Energie zu erzielen – und sind gescheitert. Einige wollen zeigen, dass die Verhältnisse in den USA anders sind und dass die US-Planer die Weisheit haben, hierzulande die grüne Wirtschaft zum Laufen zu bringen. Aber man kommt nicht um die Tatsache herum, dass man nicht unsere Wirtschaft verbessert oder Arbeitsplätze schafft, indem man Fenster zerschmeißt, und die US-Planer sind nicht allwissender als ihre europäischen Kollegen.

I would like to thank AEI research assistant Hiwa Alaghebandian for her valuable assistance with this Outlook.

Kenneth P. Green (kgreen@aei.org) is a resident scholar at AEI.

View this Outlook as a PDF

Notes

1. White House, "Remarks by the President at DNC Event," news release, September 16, 2010, www.whitehouse.gov/the-press-office/2010/09/16/remarks-president-dnc-event (accessed January 27, 2011).

2. White House, "Statement from Vice President Biden on Launch of $2.3 Billion Recovery Act Green Manufacturer Credit Program," news release, August 13, 2009, www.whitehouse.gov/the-press-office/statement-vice-president-biden-launch-23-billion-recovery-act-green-manufacturer-ta (accessed January 27, 2011).

3. Nancy Pelosi, remarks to the Stanley Elementary School, Waltham, Massachusetts, March 10, 2008.

4. White House, "Remarks by President Obama and President Zapatero of Spain after Meeting," news release, October 13, 2009, www.whitehouse.gov/the_press_office/Remarks-by-President-Obama-and-President-Zapatero-of-Spain-after-meeting (accessed January 27, 2011).

5. Gabriel Calzada Alvarez, Raquel Merino Jara, Juan Ramon Rallo Julian, and Jose Ignacio Garcia Bielsa, "Study of the Effects of Employment of Public Aid to Renewable Energy Sources" (draft, Universidad Rey Juan Carlos, March 2009), www.juandemariana.org/pdf/090327-employment-public-aid-renewable.pdf (accessed January 27, 2011).

6. Ben Sills, "Spain Slashes Prices 45% for New Ground-Based Solar Plants, 5% for Homes," Bloomberg, November 19, 2010.

7. Andrew McKillop, "The Bursting of the Green Energy Bubble?" Energy Tribune, June 4, 2010, www.energytribune.com/articles.cfm/4264/The-Bursting-of-the-Green-Energy-Bubble (accessed February 1, 2011).

8. Todd White, "Spanish Solar-Panel Trade Group Calls for Fraud Investigation," Bloomberg Businessweek, April 12, 2010.

9. Giles Tremlett, "Scandal Sullies Spain’s Clean Energy," Guardian, March 22, 2009.

-

Luciano Lavecchia and Carlo Stagnaro, Are Green Jobs Real Jobs? The Case of Italy (Milan, Italy: Instituto Bruno Leoni, May 2010), http://brunoleonimedia.servingfreedom.net/WP/WP-Green_Jobs-May2010.pdf (accessed January 27, 2011).

11. Carlo Stagnaro and Luciano Lavecchia, "Clean Jobs, Expensive Jobs: Why Italy Can’t Afford a ‚Green Economy,’" Wall Street Journal, May 11, 2010.

12. Nick Squires and Nick Meo, "Mafia Cash In on Lucrative EU Wind Farm Handouts–Especially in Sicily," Telegraph, September 5, 2010.

13. Konrad Bauer, "German Renewable Energy Policy," German Energy Agency, October 24, 2007, www.gaccsanfrancisco.com/fileadmin/ahk_sanfrancisco/Dokumente/2007-10_Solar_Delegation/_1__California_Solar_Business_Delegation_Vortrag_Konrad_Bauer_241007.pdf (accessed January 27, 2011).

14. Manuel Frondel, Nolan Ritter, Christoph M. Schmidt, and Colin Vance, Economic Impacts from the Promotion of Renewable Energies, the German Experience (Germany: Rheinisch-Westfälisches Institut für Wirtschaftsforschung, 2009).

15. "German Bundestag Approves Solar Incentive Cuts," Reuters, May 6, 2010.

16. Igor Kossov, "Transcript: Obama’s Earth Day Speech," CBS News, April 22, 2009.

17. US Energy Information Administration,"Wind," http://tonto.eia.doe.gov/kids/energy.cfm?page=wind_home-basics-k.cfm (accessed January 28, 2011).

18. Hugh Sharman, Henrik Meyer, and Martin Agerup, Wind Energy: The Case of Denmark (Copenhagen, Denmark: Center for Politiske Studier, September 2009), www.cepos.dk/fileadmin/user_upload/Arkiv/PDF/Wind_energy_the_ case_of_Denmark.pdf

(accessed January 28, 2011).

19. Andrew Gilligan, "An Ill Wind Blows for Denmark’s Green Energy Revolution," Telegraph, September 12, 2010.

20. Paul Eccleston, "Labour Conference: Gordon Brown Says CO2 Targets Must Be Raised to 80% by 2050," Telegraph, September 23, 2008.

21. Hélène Mulholland, "Ed Miliband Announces Boost for Green Jobs," Guardian, September 17, 2009.

22. Catherine Airlie, "UK, India to Create Millions of ‘Green‘ Jobs, Cameron Says," Bloomberg Businessweek, November 15, 2010.

23. Fiona Harvey, "Go-Ahead for Wind to Generate 70,000 Jobs," Financial Times, October 25, 2010.

24. Richard Marsh and Tom Miers, Worth the Candle? The Economic Impact of Renewable Energy Policy in Scotland and the UK (Kirkcaldy, Scotland: Verso Economics, March 2011), www.versoeconomics.com/verso-0311B.pdf (accessed March 17, 2011).

25. Ibid.

26. Richard Littlejohn, "You Don’t Need a Weatherman to Know Which Way the Wind Blows," Daily Mail, December 27, 2010.

27. Greg Weston, "Ice Buildup on Wind Turbines Cuts Reusable Energy," Vancouver Sun, February 16, 2011.

28. Jose Mario, "The Dutch Lose Faith in Windmills," Energy Debate, January 16, 2011.

29. Ibid.

30. Michael Gassmann, "Holland’s Radical U-Turn on Climate and Energy Policy," Global Warming Policy Foundation, February 9, 2011.

31.The Netherlands Board of Tourism and Conventions, "The Land of the Windmills," May 21, 2007, http://us.holland.com/e/7779/The%20land%20of%20the%20windmills.php (accessed March 17, 2011).

Link: http://www.aei.org/article/energy-and-the-environment/the-myth-of-green-energy-jobs-the-european-experience/

Übersetzt von Chris Frey EIKE

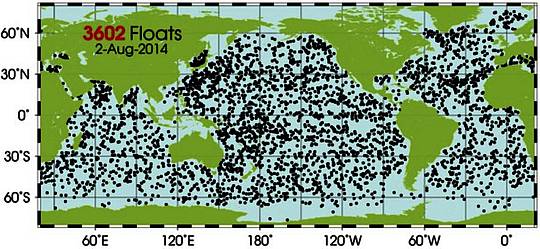

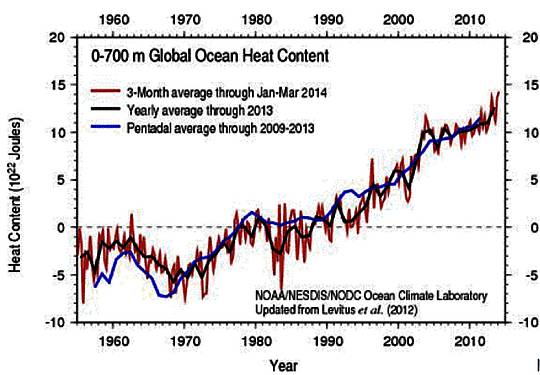

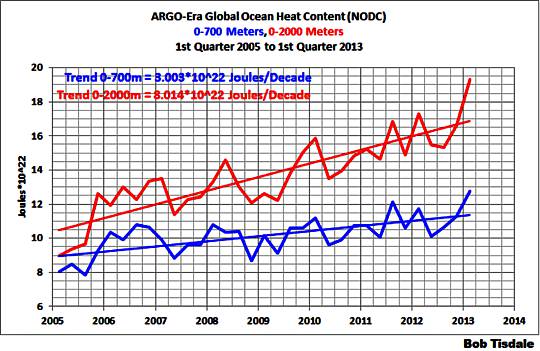

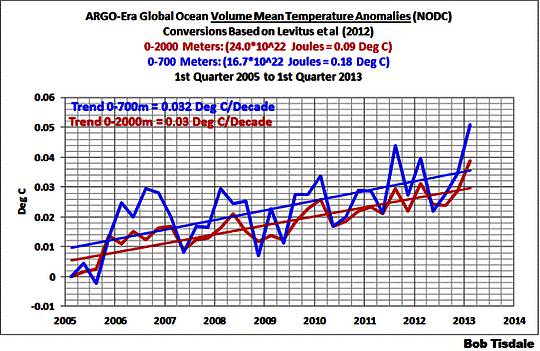

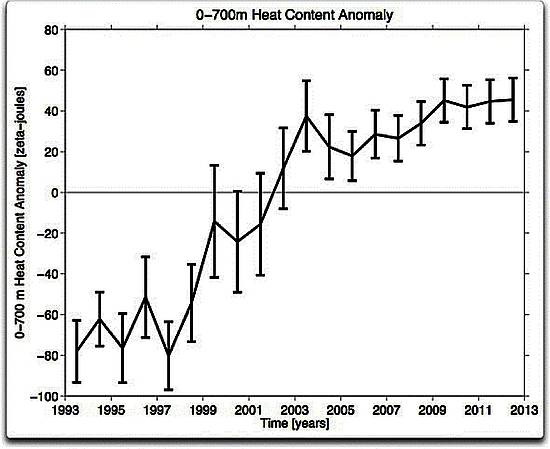

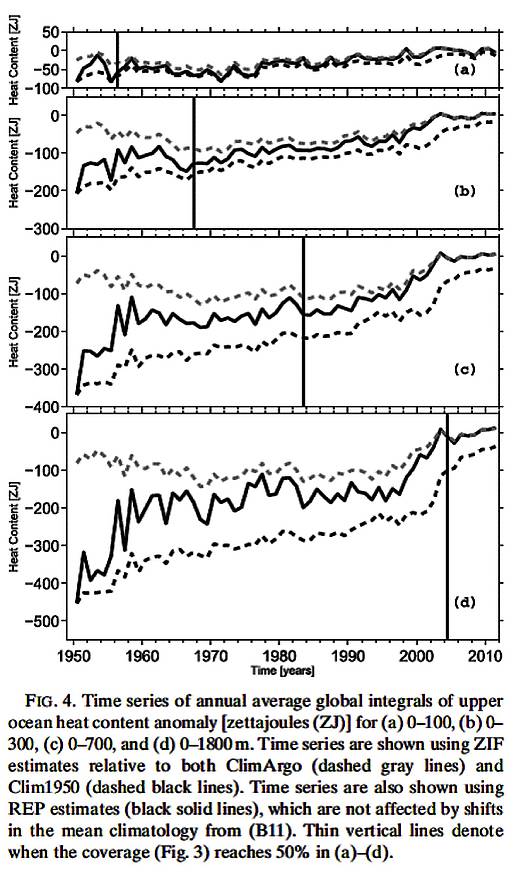

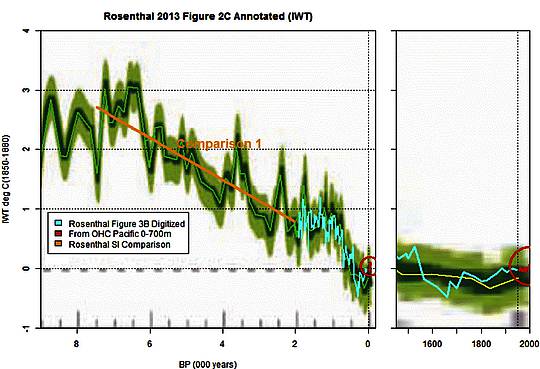

Abbildung 9: Entwicklung der OHC für das Tiefenintervall 0-700m während der letzten 20 Jahre. Daten und Graphik: NOAA Pacific Marine Environment Laboratory (

Abbildung 9: Entwicklung der OHC für das Tiefenintervall 0-700m während der letzten 20 Jahre. Daten und Graphik: NOAA Pacific Marine Environment Laboratory (

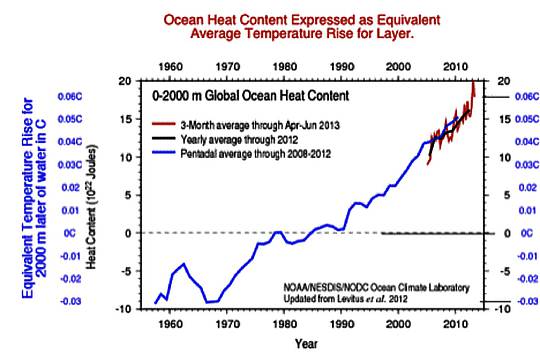

KNMI-Webseite

KNMI-Webseite