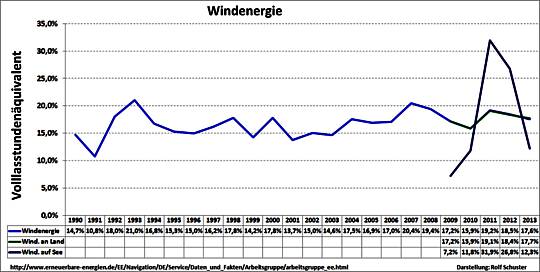

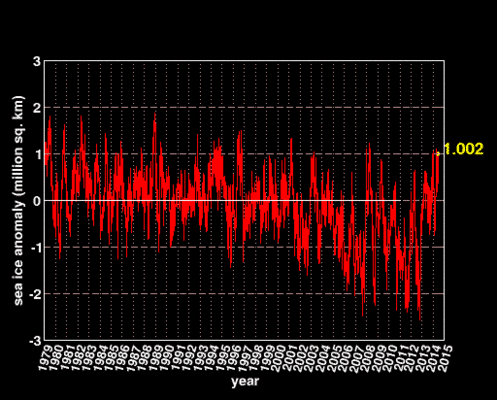

(1) Meeres-Anstieg an der Deutschen Nordsee-Küste seit 10.000 Jahren

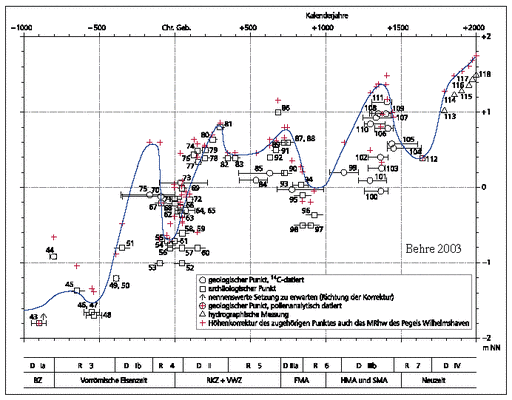

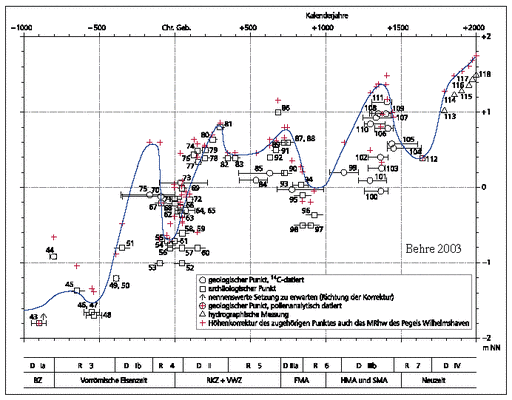

Es ist das große Verdienst des Wilhelmshavener Küstenforschers Karl-Ernst BEHRE vom Niedersächsischen Institut für Historische Küstenforschung (NIHK), daß wir gute Kenntnisse über die Trans- und Regressionen an der deutschen Nordsee-Küste seit dem Ende der letzten Eiszeit haben [1], vgl. Abb.1 :

Abbildung 1 [1c, S.21]

Meeres-Anstieg für die südliche Nordsee seit 10.000 Jahren

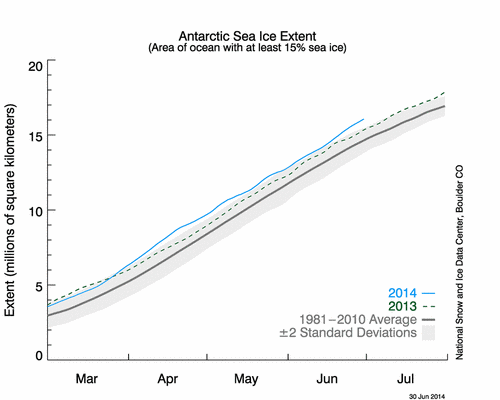

Abbildung 2 [1a (2003), S.35]

Meeres-Anstieg für die südliche Nordsee der letzten 3.000 Jahre

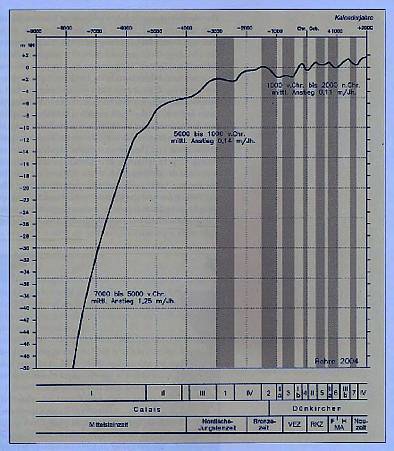

Aus den Abbildungen 1 und 2 ergibt sich: Der Meeres-Spiegel ist in den letzten 10.000 Jahren um mehr als 50 Meter gestiegen. Der Anstieg hat sich immer mehr verlangsamt, wenn man den übergreifenden Trend auch über die Trans- und Regressionen der letzten 3.000 Jahre betrachtet. In den "jüngsten" 400 Jahren (1600-2000) hat es (ohne GIA-Korrektur) einen Anstieg von 1,35 m gegeben, in den vergangenen 100 Jahren nur einen solchen von 25 cm, folglich eine weitere Verlangsamung.

Bezüglich der säkularen Abschwächung des Meeres-Anstieges in den letzten Jahrhunderten kommen andere umfangreiche Untersuchungen [2] zum ähnlichen Ergebnis wie BEHRE:

"The last detailed regional study was by Shennan and Woodworth (1992). They used tide gauge and geological data from sites around the North Sea to infer 20thcentury and late Holocene secular trends in MSL. They concluded that a systematic offset of 1.0 ± 0.15 mm/yr in the tide gauge trends compared to those derived from the geological data could be interpreted as the regional geocentric rate of MSL change in the 20th century. They also constructed a sea level index to represent the coherent part of sea level variability in the region and found no evidence for a statistically significant acceleration in the rates of SLR over the 20th century. These results were in agreement with those of Woodworth (1990), who found a significant acceleration in the order of 0.4 mm/yr per century when focusing on time scales longer than a century (up to 300 years), but not for the 20th century."

Dieses alles gilt insbesondere auch für die Deutsche Nordsee-Küste, wie der Niedersächsische Landesverband für Wasser, Küsten- und Naturschutz NLWKN in 2013 erneut bestätigte [3] :

"Bislang, betont Heyken (Anm.: Sprecherin NLWKN), gebe es aber keine Anzeichen, daß die Fluten schlimmer werden. ‚Wir messen die Hochwasserstände seit 100 Jahren. Während dieser Zeit ist das mittlere Hochwasser um 25 Zentimeter gestiegen. Daß der Meeresspiegel in den letzten Jahrzehnten schneller steigt, können wir nicht bestätigen.‘ Auch gebe es keine Belege für häufigere Fluten."

F a z i t :

Der Meeres-Anstieg hat sich verlangsamt, über Jahrtausende und auch im letzten Jahrhundert. Ein "CO2-Klima-Signal" ist nicht auffindbar !

(2) Pegel als Bilanz-Messer: Küsten-Senkung und/oder Meeres-Anstieg ?

Weltweit wird die Veränderung des Meeres-Spiegels an Küsten mit etwa 1.000 Pegeln gemessen, wovon einige (wenige) sogar über 200 Jahre zurück reichen, die Mehrzahl weniger als 100 Jahre. Die direkten absoluten Ablesungen und Trends sind zunächst immer nur eine Bilanz-Messung:

Anstieg oder Absinken des Meeres gegenüber Hebung oder Senkung der Küsten. Dafür gibt es mehrere Ursachen, insbesondere Platten-Tektonik, Vulkanismus und Eiszeit-Prozesse (Isostasie und Eustasie).

Für die Deutsche Nordsee-Küste hat BEHRE [1a] sich auch damit beschäftigt: "Das Nordseebecken ist bereits seit sehr langer Zeit ein Senkungsgebiet, und diese tektonische Senkung hält auch heute noch an" ….u.w.a.a.O.: "Die deutsche Küste liegt im oberen Bereich dieses Senkungsgebietes. Zur genaueren Abschätzung der Vertikalbewegung eignet sich hier die Oberkante mariner Sedimente des Eem-Meeres …. Damit kommt man für den Bereich der Deutschen Bucht zu einer tektonisch bedingten mittleren Absenkung zwischen 0,64 cm/Jh. im Westen und 0,54 cm/Jh. im Osten, mithin zu einem geringen Betrag."

Darüber hinaus diskutiert BEHRE (a.a.O.):

"Zu der früher stark diskutierten Frage eines möglichen tektonischen Absinkens der deutschen Nordseelüste wurden in den Jahren 1928-31, 1949-55 und 1980-85 drei sehr genaue Nordseeküsten-Nivellements durchgeführt ….".

Unter der Berücksichtigung aller dieser bis 2003 bekanten Fakten kommt BEHRE zu dem Ergebnis:

"Danach erscheint für die Gegenwart ein tektonisch verursachtes Absinken von < 1,0 cm/Jh. wahrscheinlich….".

Diese Zahlen sind nach neuere Untersuchungen zu gering abgeschätzt.

Im Jahre 2011 wurde eine Arbeit zu den Trends von 15 Küsten-Pegeln in der Deutschen Bucht publiziert [4]. Darin werden auch Abschätzungen zum Glacial Isostatic Adjustment (GIA) angegeben:

"This, initially, gives estimates of rates of vertical land movement for the three tide gauges providing the longest records ( -0.7 ± 0.2 mm/a for Cuxhaven, -0.5 ± 0.1 mm/a for Lt. Alte Weser and -0.9 ± 0.2mm/a for Norderney; negative values denote land subsidence)."

Für diese drei Langzeit-Pegel wird also im Mittel eine Küsten-Absenkung von 0,7 mm/yr angegeben, was einen säkularen Absenkungs-Trend von 7 cm/Jh. bedeutet.

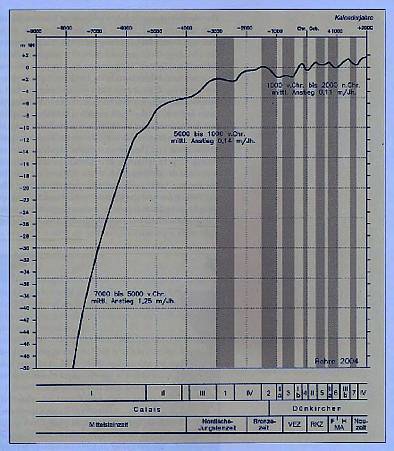

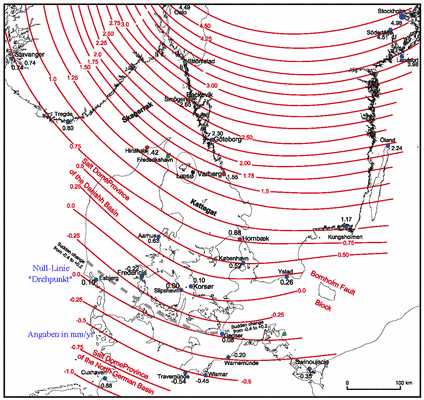

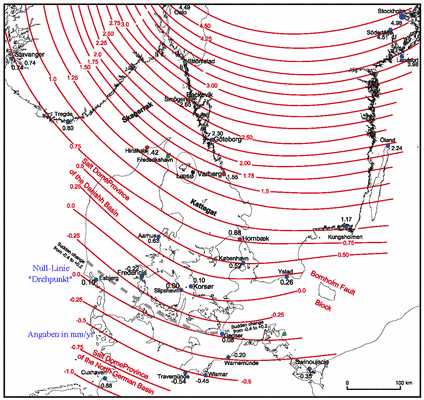

Im gleichen Jahre 2011 erschien eine umfangreiche Arbeit [5], die sich mit den postglazial anhaltenden vertikalen Landbewegungen des letzten Jahrtausends in Südskandinavien und Jütland beschäftigt. Die Null-Linie ("Drehpunkt") verläuft danach von den Nordfriesischen Inseln in einem nach Süden ausgreifendem Bogen über Dänemark in die mittlere Ostsee (Abb.3).

Für den Bereich der Deutschen Nordseeküste ergibt sich daraus ein tektonischen Absinken von etwa 10 cm/Jh.

Abbildung 3 [5, dort Fig.9] (blaue Erläuterungen ergänzt)

Present-time isostatic uplift rates (mm/yr) of Denmark and surroundings.

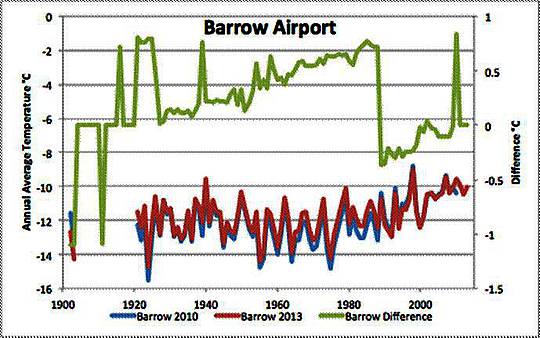

In einer soeben publizierten Arbeit von MÖRNER werden auch drei Pegel im Kattegat analysiert, also in Nähe des tektonischen Nullpunktes ("Drehpunktes"):

"In the Kattegatt Sea, the glacial isostatic component factor is well established and the axis of tilting has remained stable for the last 8000 years. At the point of zero regional crustal movements, there are three tide gauges indicating a present rise in sea level of 0.8 to 0.9 mm/yr for the last 125 years." Daraus ergibt sich ein säkularer absoluter Meeres-Anstieg (ASLR) von nur etwa 7 cm.

Die Pegel in Cuxhaven und Norderney zeigen einen relativen säkularen Anstieg von 25 cm, wozu die Landesregierung Niedersachsen unlängst feststellte [6]:

"Klimawandel nicht bemerkbar: Für einen steigenden Meeres-Spiegel an Niedersachsens Nordseeküste als Folge des Klimawandels sieht die Landesregierung keine Anzeichen. Auch ein Trend zu höherer Sturmflut-Häufigkeit sei nicht erkennbar, teilte Umweltminister Hans-Heinrich Sander im Landtag mit. Danach liegt der Trend des Anstieges bei unverändert 25 cm je Jahrhundert. Ein schnellerer Anstieg sei nicht zu beobachten."

Dabei wären die von BEHRE genannten 1 cm/Jh. vernachlässigbar, wogegen die von HANSEN genannten 10 cm/Jh. zu einer bedeutsamen Schlußfolgerung führt: Der bilanzierte "Absolute Sea Level Rise" (ASLR) beträgt dann nur etwa 15 cm/Jh.

F a z i t :

Der mit Pegeln gemessene Meeres-Anstieg an der Deutschen Nordsee-Küste beträgt in den letzten 100 Jahren 25 cm. Eine Beschleunigung ist nicht zu erkennen. Berücksichtigt man natürliche tektonische Küsten-Absenkungen (GIA), so beträgt der ASLR sogar nur etwa 15 cm. Ein CO2-AGW-Klima-Signal ist so oder so nicht erkennbar.

(3) Auswertung von 15 Küsten-Pegeln in der Deutschen Bucht

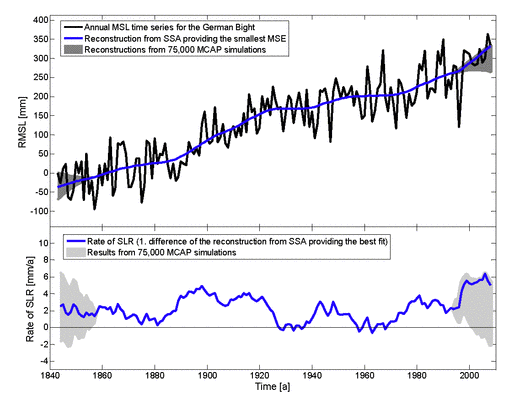

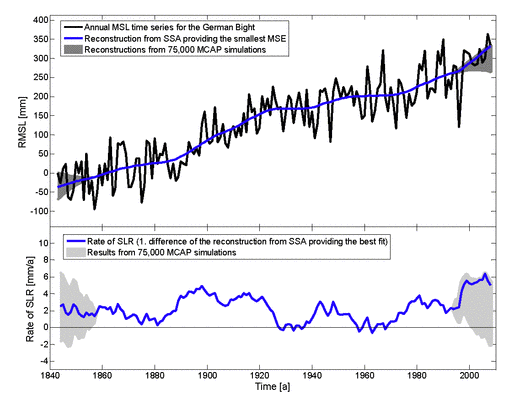

Von einem internationalen Autorenteam unter der wissenschaftlichen Leitung des Instituts für Wasserbau und Hydromechanik der Universität Siegen wurden 2011 Auswertungen aller verfügbaren Pegel für die Deutsche Bucht publiziert [7], im Einzelfall zurück reichend bis zu 166 Jahre v.h.

Dabei wird auch über Isotstasie-Abschätzungen diskutiert:

"Rates of vertical land movement are estimated from the sea level records using a simple approach and are compared with geological data and modelled GIA (Anm.: GIA: Glacial Isostatic Adjustment) estimates." [7a]

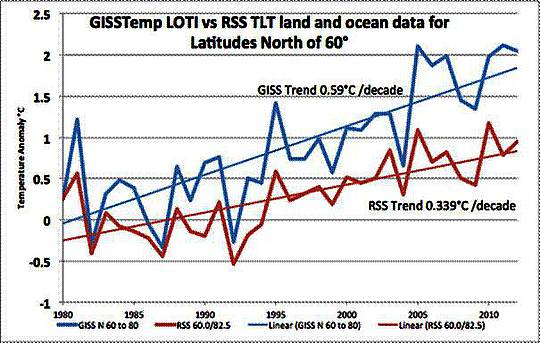

Die in Abb. 4a übergreifend gemittelte geglättete Auswertung zeigt, daß im Zeitraum von 166 Jahren abwechselnd Perioden mit beschleunigtem und verlangsamten Meeres-Anstieg auftreten:

"An accelerated sea level rise is detected for a period at the end of the nineteenth century and for another one covering the last decades." [7a].

Das verdeutlichen insbesondere auch die Abb. 4b dargestellten, sich dekadal ändernden jährlichen Anstiegs-Raten.

Abbildung 4 a+b [7a]

Trends von 15 Küsten-Pegeln Deutsche Bucht

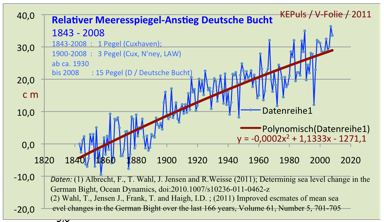

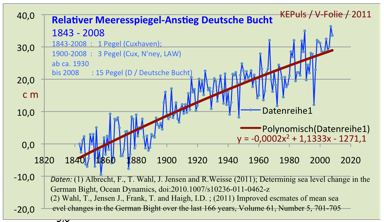

Betrachtet man den Gesamtzeitraum mit einem Polynom 2. Grades [8], so ergibt sich ebenfalls keine säkulare Beschleunigung des Anstieges, eher eine Abschwächung: vgl. Abb. 5:

Abbildung 5 (Daten: F.ALBRECHT, Th.WAHL et al. [7] ; Graphik: Puls/EXCEL)

Polynomischer Trend von 15 Küsten-Pegeln in der Deutschen Bucht

Auch die Autoren [7] finden keinen Trend:

"Provided local sea level variations in Cuxhaven are unaffected by local effects and represent the large scale signal in the German Bight we would expect these residuals to be small and oscillating around zero with no long-term trend or discontinuity." (a.a.O.; Fig.6)

Ergebnis:

"The estimated long-term trend (1843 – 2008) for the Cuxhaven station is 2.3 mm/a." [7a]

Und w.a.a.O.: "For the period 1951-2008, for which data are available from all gauges, the trends vary between 1.0 mm/a (Bremerhaven) and 2.8 mm/a (Norderney)." [7a]

Diese Daten sind ohne GIA-Korrektur. Dafür müßten folgende Korrekturen angebracht werden (a.a.O.):

"This, initially, gives estimates of rates of vertical land movement for the three tide gauges providing the longest records ( -0.7 ± 0.2 mm/a for Cuxhaven, -0.5 ± 0.1 mm/a for Lt. Alte Weser and -0.9 ± 0.2mm/a for Norderney; negative values denote land subsidence)."

Danach beträgt der ASLR in der Deutschen Bucht im Mittel für das 20.Jh. nur etwa 13 cm!

F a z i t :

Der über alle 15 Pegel – mit unterschiedlichen Registrier-Zeiträumen – gemittelte Relative Meeres-Anstieg (RSLR) für die Deutsche Bucht beträgt von 1843-2008 etwa 32 cm, der säkulare Anstieg im 20. Jahrhundert rund 20 cm. Die GIA-korrigierten Werte (vgl. auch Kap.3) ergeben für die o.a. Zeiträume einen ASLR von etwa 22 bzw. 13 cm. Es existiert keine säkulare Beschleunigung, das Polynom in Abb.5 zeigt demgegenüber sogar eine leichte säkulare Abschwächung des Anstieges. Ein CO2-Klima-Signal (AGW) ist nicht auffindbar.

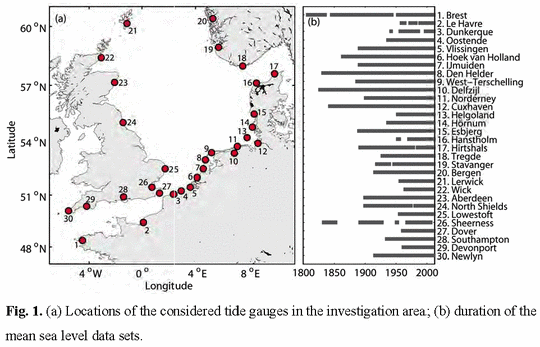

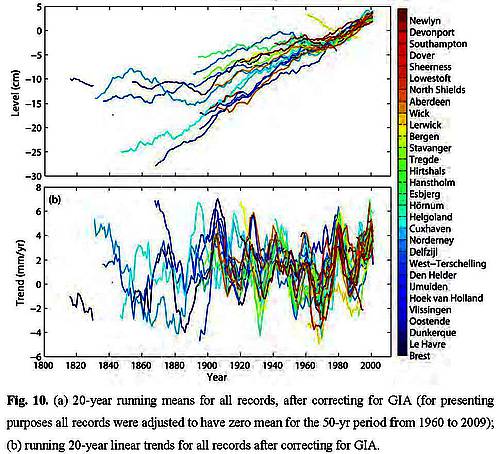

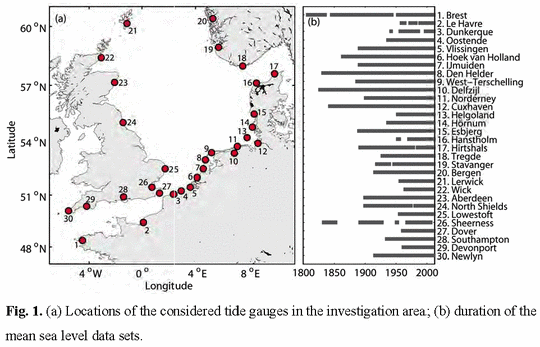

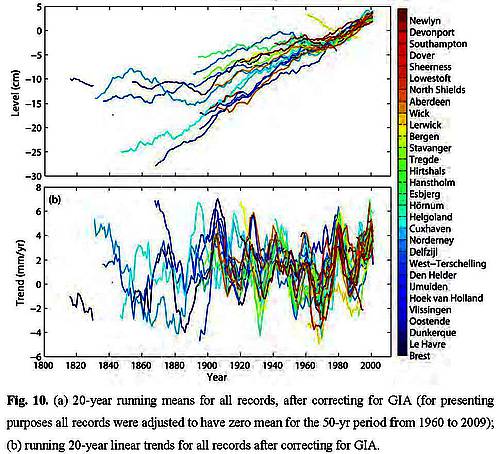

(4) Auswertung von 30 Küsten-Pegeln rund um die Nordsee

Ein Internationales Autoren-Team hat 2013 eine Auswertung von 30 Küsten-Pegel (1880-2011) rund um die Nordsee publiziert [9], vgl. Abb. 6+7 :

Abbildung 6 [9; dort Fig.1]

Abbildung 7 [9; dort Fig.10] (GIA: Glacial Isostatic Adjustment)

Das zusammengefaßte Ergebnis (mit GIA-Korrektur) :

"The long-term geocentric mean sea level trend for the 1900 to 2011 period is estimated to be 1.5 ± 0.1 mm/yr for the entire North Sea region."

Folglich: Der säkulare lineare Trend im 20. Jh. beträgt 15 cm.

"In summary the long term trends in the North Sea are not significantly different from global sea level trends …" u.w.a.a.O. :"The recent rates of sea level rise (i.e. over the last two to three decades) are high compared to the long-term average, but are comparable to those which have been observed at other times in the late 19th and 20th century."

Für die alarmistischen Meeres-Szenarien im Rahmen der Klima-Debatte ist auch dieses Ergebnis nahezu ein Desaster, denn es wird – auch anhand einer umfangreichen Literatur-Übersicht – festgestellt, daß es überhaupt keinen Trend zu einer Beschleunigung des Anstieges gibt, weder säkular noch in den letzten Dekaden, im krassen Gegensatz zu den Klima-Modellen:

"… found little or no evidence for on-going positive sea level acceleration for the tide gauges located in the North Sea between 1870 and the late 1980’s of the sort suggested for the 20th century itself by climate models."

F a z i t :

Der über alle 30 Pegel gemittelte und mit GIA-Korrektur versehene Absolute Meeres-Anstieg (ASLR) für die gesamte Nordsee im Zeitraum 1900-2011 beträgt 15 cm. Eine Beschleunigung wurde nicht gefunden, daher auch kein AGW-CO2-Klima-Signal.

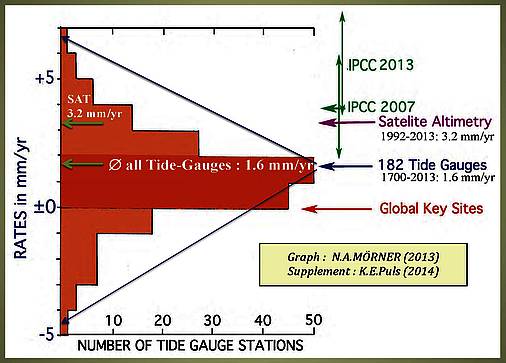

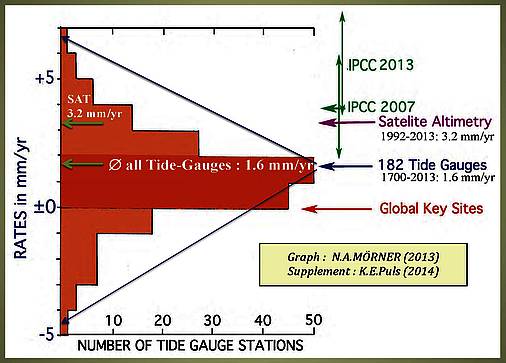

(5) Auswertung von 182 Pegeln global

NIEL-AXEL MÖRNER legte in zwei 2013 erschienen Arbeiten [10] globale Auswertungen von Pegeln (NOAA 2012) vor, von denen einige (wenige) sogar bis in das 18. Jahrhundert zurück reichen:

"Removing outliers of obvious uplift or subsidence, there are 182 records left, which

forms a nice Gaussian distribution around a mean value of +1.65 mm/yr."

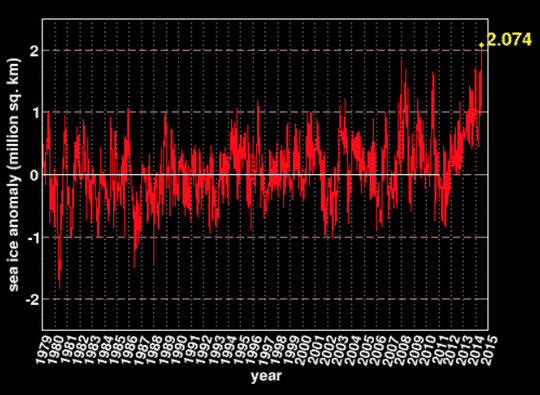

Die in Abb. 7 dargestellten Pegel-Daten sind nicht GIA-korrigiert, stellen folglich den RSLR (Relative Sea Level Rise) dar:

"Because many tide gauge stations are affected by local subsidence, this value should rather be considered an overestimate, however."

Abbildung 8: GAUSS-Verteilung 182 Pegel [10]

(RSLR: ohne Glacial Isostatic Adjustment GIA; "key sites: i.e. sites of special importance like the Maldives, Bangladesh, Tuvalu, Kiribati and Vanuatu …Venice" )

Kritisch äußert sich MÖRNER auch hier zu den hohen Satelliten-Werten(vgl.Kap.8):

"Satellite altimetry is a new and important tool. The mean rate of rise from 1992 to 2013 is +3.2 ±0.4 mm (UC, 2013). This value is not a measured value, however, but a value arrived at after much “calibration” of subjective nature (Mörner, 2004, 2011a, 2013a).

The differences between the three data sets < ±0, +1.65 and +3.2 mm/yr > are far too large not to indicate the inclusions of errors and mistakes."

F a z i t :

Die Auswertung von weltweit 182 Pegeln ergibt im Mittel einen säkularen Meeres-Anstieg von 16 cm, ohne GIA-Korrektur. Eine säkulare Beschleunigung des Anstieges wurde nicht gefunden, daher auch kein AGW-CO2-Klima-Signal.

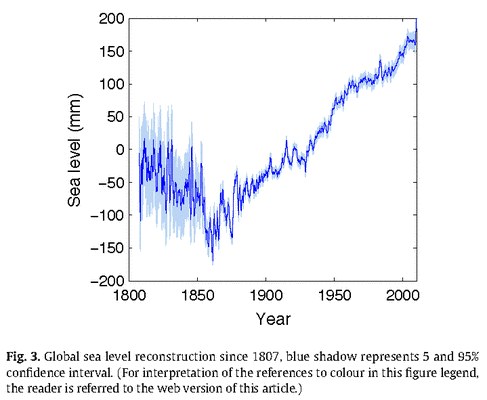

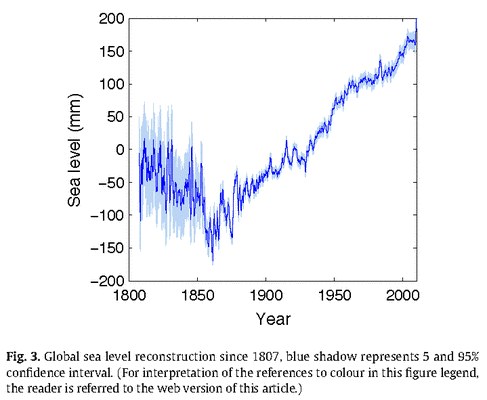

(6) Auswertung von 1200 Pegeln global

Ein internationales Autorenteam legte 2013 die Auswertung von 1277 Pegeln für dem Zeitraum 1807-2010 vor [11]. Das globale Gesamtmittel zeigt Abb.9.

Dabei wurden GIA-Korrekturen vorgenommen:

"The large uncertainties (up to 0.3–0.6 mm/yr) in our global sea level reconstruction are due to choice of GIA corrections, with difference up to 8 mm/yr in rate of sea level rise in individual locations, such as the Arctic, Baltic and Antarctic regions. The GIA correction adds up to 0.3 mm/yr trend in the global sea level reconstruction, with large differences between GIA datasets."

Abbildung 9

Meeres-Trend 1807-2009; 1277 Pegel [11; dort Fig.3]

In die Graphik (Abb.9) ist zwar von den Autoren weder eine Regressions-Gerade eingefügt noch ein Polynom, aber auch so ist "durch Augenschein" erkennbar:

() In der ersten Hälfte des 19. Jh. ist der Meeresspiegel um ca. 15 cm abgesunken;

() Seit ca.1860 steigt der Meeresspiegel – bis heute;

() Seit 1860 sind dekadale Phasen rascheren und verlangsamten Anstieges erkennbar, eine Trend- Beschleunigung über den Gesamtzeitraum seit 1860 nicht; für die letzten 10 Jahre seit ca. 2000 sogar nur noch ein Plateau !?

Zu diesen Betrachtungen passen zunächst auch diese Aussagen der Publikation (Abstract):

"The new reconstruction suggests a linear trend of 1.9 ± 0.3 mm·yr− 1 during the 20th century, with 1.8 ± 0.5 mm·yr− 1 since 1970.“ (Anm.: 1970-2009).

Woraus folgt:

Die Anstiegsrate für den Teil-Zeitraum ab 1970 ist geringer als die Anstiegsrate für das gesamte 20. Jahrhundert! Es hat folglich eine Verlangsamung des Anstieges im 20. Jahrhundert bis heute statt gefunden.

Demgegenüber steht in der Publikation wenige Sätze weiter unten, ebenfalls im Abstract:

"We calculate an acceleration of 0.02 ± 0.01 mm·yr− 2 in global sea level (1807–2009)“.

WOW ! Für 100 Jahre ergäbe das 2 mm, Küsten-Überflutung voraus ?

Hierzu stellt sich zudem doch die Frage :

Wie kann der in der Publikation analysierte säkularer "linear trend “ (vgl.w.o.) eine Beschleunigung aufweisen ?

Das ist ein Widerspruch in sich. Ein linearer Trend wird durch eine Regressions-Gerade beschrieben, kann also u.E. keine Beschleunigung aufweisen !?

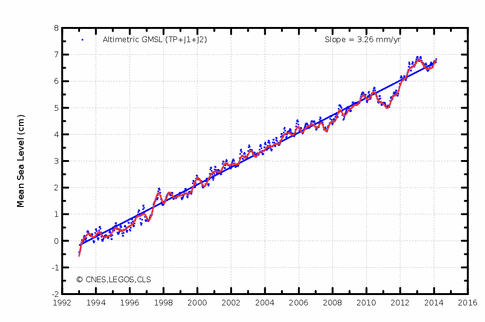

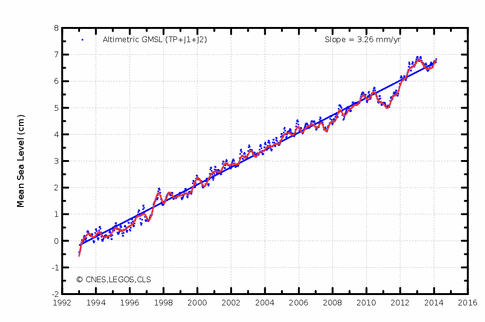

Das ist auch nicht der Fall, wie die Regressions-Gerade zu den SAT-Altimeter-Daten von AVISO in Abb.10 zeigt:

Abbildung 10

SAT-Altimeter-Daten [12; AVISO] (POSEIDON/TOPEX/JASON)

Es finden sich jedoch noch weitere Widersprüche in den Aussagen der JEVREJEVA-Publikation.

Zunächst und einerseits:

"… a linear trend of 1.9 ± 0.3 mm·yr− 1 during the 20th century" (Abstract), und: "GSL12 shows a linear trend of 1.9 ± 0.3 mm·yr−1 during the 20th century …" (Conclusion).

Das ist nur wenig mehr als die Hälfte der Altimeter-Messungen von 3.3 mm/yr in den AVISO-Daten (Abb.10).

Demgegenüber heißt es – u.E. im Widerspruch dazu – unmittelbar im Satz davor in "Conclusion": "There is an excellent agreement between the linear trends from GSL12 and satellite altimetry sea level since 1993, with rates of 3.1 ± 0.6 mm·yr−1 and of 3.2 ± 0.4 mm·yr−1 respectively".

WIE denn nun (?) :

3.1 mm/yr oder 1,8 mm/yr – denn: die hier genannte Pegel-Periode 1970-2008 enthält doch auch die Altimeter-Messungs-Periode seit 1993 ! D a h e r müßte ein solcher "Daten-Sprung" ab 1993 auch in der Abb.9 (Fig.3) auffindbar sein, ist er aber nicht! Stattdessen findet man in Abb.9 ab etwa 2000 eine Art Plateau – "Null-Anstieg" !

Gänzlich rätselhaft wird die Sache, wenn man dazu noch die Fig.7 in der JEVREJEVA-Publikation [11] anschaut: Dort verlaufen zwei Regressions-Geraden Pegel & Altimeter 1993-2009 nahezu kongruent:

"Dashed red and blue lines represent linear trends for satellite altimetry (3.2 mm·yr−1) and tide gauge (3.1 mm·yr−1)…". wovon sich in Fig.3/Abb.9 im Vergleich mit den SAT-Daten von AVISO (Abb.10) keine Spur finden läßt !?

Es ist nicht nachvollziehbar, wie eine solche umfangreiche Publikation voller Widersprüche ein "Peer Review" passieren kann.

F a z i t :

Die Arbeit von JEWREJEVA et al. schafft bezüglich einer Klärung der großen Diskrepanz zwischen den Daten der Pegel und der Satelliten u.E. keine Klarheit, sondern eher zusätzliche Verwirrung. Das Gleiche gilt für die widersprüchlichen Trend-Aussagen zum Meeres-Anstieg in der Arbeit.

(7) GRACE-Satelliten bestätigen die Pegel: 1.7 mm/yr !

Eine aktuelle Auswertung [13] der Schwerefeld-Messungen mit den GRACE-Satelliten bestätigt die zahlreichen Publikationen von Pegel-Auswertungen:

Eine aktuelle Auswertung [13] der Schwerefeld-Messungen mit den GRACE-Satelliten bestätigt die zahlreichen Publikationen von Pegel-Auswertungen:

"Neue Studie mittels GRACE-Daten: Meeresspiegel steigt um weniger als 17 cm pro Jahrhundert" … "Eine neue Studie, erstellt mit den GRACE-Daten (Gravity Recovery And Climate Experiment) zeigt, dass der Meeresspiegel während der letzten 9 Jahre mit einer Rate von nur 1,7 mm pro Jahr gestiegen ist. Das ergibt ein Äquivalent von 6,7 Inches (fast 17 cm) pro Jahrhundert. Dies paßt gut zu Messungen an Pegeln."…

… nämlich (a.a.O.) :

"Aus dem IPCC FAR Abschnitt 5.5.2: Holgate und Woodworth (2004) schätzten eine Rate von 1,7 ± 0.4 mm pro Jahr, und zwar gemittelt entlang der globalen Küstenlinie während des Zeitraumes 1948 bis 2002 und basierend auf Messungen von 177 Stationen (Anm.: Pegeln), eingeteilt nach 13 Regionen.

Church et al. (2004) berechneten einen globalen Anstieg von 1,8 ± 0.3 mm pro Jahr während der Periode 1950 bis 2000, und Church und White (2006) berechneten eine Änderung von 1,7 ± 0.3 mm pro Jahr im 20. Jahrhundert."

…und w.a.a.O. :

"Bedeutung dieses Ergebnisses :

Das Geocenter-korrigierte Schlußergebnis von Baur et al. ist höchst ermutigend, wenn Chambers et al. (2012) zeigen, dass der Meeresspiegel im Mittel um 1,7 mm pro Jahr während der letzten 110 Jahre gestiegen ist, wie es sich auch aus den Analysen von Church und White (2006) sowie Holgate (2007) ergibt.

Gleichzeitig ist die CO2-Konzentration in der Luft um fast ein Drittel gestiegen. Und immer noch hat dieser Anstieg nicht die Rate des globalen Meeresspiegel-Anstiegs beeinflusst !"

F a z i t :

Die beiden extrem unterschiedlichen Methoden der Pegel- und der Schwerkraft-Messungen (GRACE-Satelliten) stimmen mit jeweils 1,7 mm/yr erstaunlich gut überein, auf ein Zehntel Millimeter! Das wirft allerdings erneut die in der Literatur immer wieder kritisch gestellte Frage auf, wieso die Satelliten-Meßverfahren TOPEX/POSEIDON/JASON – als einzige aller Meßmethoden – nahezu doppelt so hohe Werte ergeben (è Kap.(8) ) :

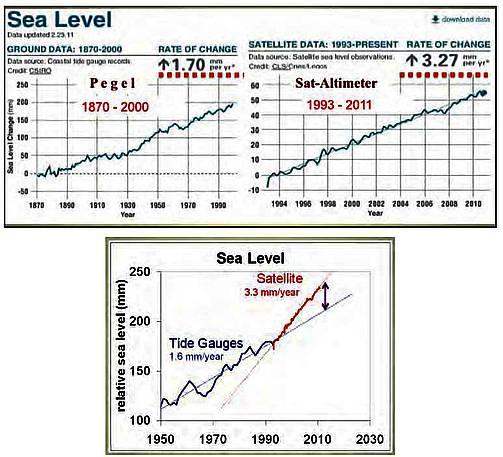

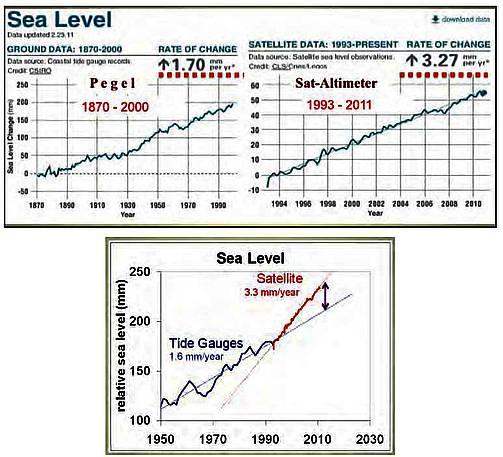

(8) Pegel versus SAT-Altimeter

Weltweit publizierte Pegel-Messungen (vgl. Abb. 4-9, und weitere Publikationen [14] ) sowie gleichermaßen die Schwerkraft-Messungen der GRACE-Satelliten zeigen global einen mittleren jährlichen Meeres-Anstieg von 1,5 – 1,7 mm/yr, also säkular 15-17 cm, wogegen von den erst seit 1992 verfügbaren Altimeter-Messungen anderer Satelliten (Abb. 10 + 11) doppelt so hohe Anstiegs-Raten publiziert werden [15]: 3,2 mm/yr.

Zu Beginn der SAT-Altimeter-Ära (1992) lagen die zunächst publizierten Messungen sogar deutlich unter 1 mm/yr, also auch noch deutlich unter den Pegel-Meßwerten. Im Laufe der folgenden Jahre wurden dann die SAT-Daten mehrfach zu höheren Werten hin korrigiert. Die Gründe bleiben unklar, wie eine dazu sehr ausführliche Historie von RUDOLF KIPP dokumentiert [16] :

"Nur durch zahlreiche Korrekturen, die auf Annahmen beruhen die nicht weiter ausgeführt werden, ergibt sich der “offizielle” Wert von zur Zeit 3,1 mm pro Jahr."

Es ist aufschlußreich, hier einige weiteren Passagen aus dieser Dokumentation zu zitieren:

"Der “Environmental Satellite” (Envisat; 2002-2012) ist so etwas wie das Prunkstück der European Space Agency (ESA). … Zu den Aufgaben dieses Satelliten gehört unter anderem … die Vermessung des Meeresspiegels. Allerdings hat die Auswertung letzterer Daten bislang zu Ergebnissen geführt, die weder mit den Aussagen (Anm.: IPCC) eines beschleunigten Meeresspiegel-Anstiegs, noch mit den Messungen der amerikanischen Jason-Satelliten in Einklang standen. …

Der von Envisat gemessenen Anstieg des Meeresspiegels betrug im Zeitraum von Ende 2003 bis Ende 2011 lediglich 0,48 mm/Jahr, was 4,8 cm in 100 Jahren entsprechen würde. Die Messungen des Jason-1 Satelliten haben für den gleichen Zeitraum einen Anstieg von 2,05 mm pro Jahr gefunden. … Um diesem Umstand zu begegnen wurden bei der ESA bereits im letzten Jahr Methoden diskutiert, wie man die Envisat Daten rechnerisch an die Ergebnisse der Messungen der Jason Satelliten angleichen kann. Diese Anpassung wurde jetzt beim Umstellen auf die neueste Version der Envisat Daten (Version 2.1) offensichtlich vorgenommen. Aus dem bisherigen minimalen Anstieg von 0,48 mm/Jahr wurde dadurch quasi über Nacht ein Anstieg von 2,32 mm/Jahr. Wer nach einer Begründung für diese Maßnahme sucht, der wird auf der Aviso-Homepage unter “Processing and corrections” fündig. Dort heißt es: ’sign of instrumental correction (PTR) corrected via external CLS input (impact of +2 mm/year drift)‘ Man hat also einen Abgleich an externen Daten vorgenommen. Es findet sich allerdings kein Wort dazu, was für Daten das sind oder welcher Umstand diesen radikalen Eingriff notwendig gemacht hätte."

…und w.a.a.O.:

"Und auch die aktuell bei den Daten des europäischen Envisat Projektes vorgenommenen Korrekturen folgen nicht nur dem altbekannten Schema, dass diese Maßnahmen ausnahmslos in eine Richtung weisen, und zwar zu höheren Werten." …

"Auch die Begründung, welche die Wissenschaftler anbieten, trägt mehr zur Verschleierung bei, als dazu aufzuklären, warum ein so fundamentaler Eingriff in die Daten vorgenommen werden musste. Was bleibt ist der Eindruck, dass hier Daten systematisch “hochgerechnet” werden. Schließlich steht der nächste Zustandsbericht des Weltklimarates (IPCC) für das Jahr 2014 an. Und dieser kann seine volle Wirkung nur entfalten, wenn alles sich noch viel schlimmer darstellt, als man im letzten Report 2007 bereits gesichert wusste. Ein seit Jahren langsamer werdender Anstieg des Meeresspiegels wäre hierzu ganz sicher nicht hilfreich."

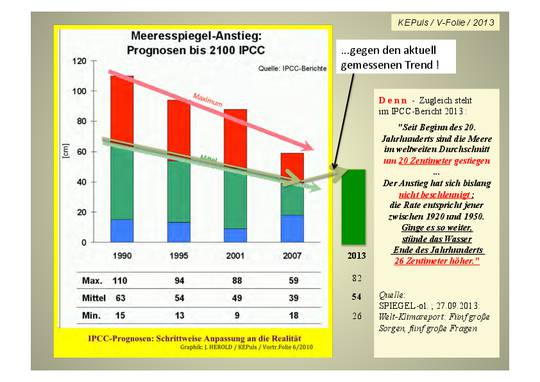

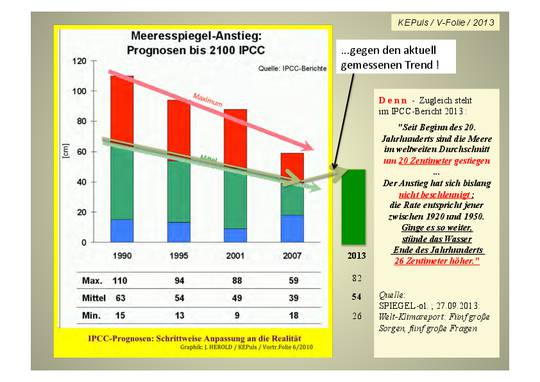

Und diese nahezu prophetischen Worte von RUDOLF KIPP im Jahre 2012 haben sich schon 2013 "erfüllt", denn – genau so ist es gekommen: der Klimarat IPCC hat seine Meeres-Prognose im AR 2014 für 2100 erstmals wieder erhöht, nachdem IPCC in den drei Vorberichten (AR’s 1995, 2001, 2007) schrittweise eine "Herunter-Stufung" der Prognosen Richtung Meß-Realität vorgenommen hatte: vgl. Abb. 12 !

D a z u einige Äußerungen von namhaften Meeres-Forschern [17]:

"Ich halte es für unwahrscheinlich, dass sich der Meeresspiegel-Anstieg ausgerechnet in dem Jahr beschleunigt haben sollte, als Satelliten in Dienst gestellt wurden", ergänzt SIMON HOLGATE, Meeres-Spiegel-Forscher am National Oceanography Centre in Liverpool." …

"Ob wir seit 1993 eine Beschleunigung haben, ist nicht klar", sagt JOHN CHURCH vom australischen Klimaforschungsinstitut CSIRO."

NILS-AXEL MÖRNER [18] (Univ. Stockholm, Paleogeophysics & Geodynamics) dazu:

"Satellite altimetry is a new and important tool. The mean rate of rise from 1992 to 2013 is +3.2 ±0.4 mm (UC, 2013). This value is not a measured value, however, but a value arrived at after much “calibration” of subjective nature (Mörner, 2004, 2011a, 2013a). The differences between the three data sets < ±0, +1.65 and +3.2 mm/yr > are far too large not to indicate the inclusions of errors and mistakes."

In einer Graphik wurde das alles so zusammen gefaßt (Abb. 11 a+b) :

Abbildung 11 a+b: Gegenüberstellung der Pegel- und Sat-Daten

[19] (Textfelder in Abb.11a ergänzt )

In den jüngst erschienen, schon unter den Abschnitten (3)+(4) zitierten umfangreichen Arbeiten zu den Nordsee-Pegeln [WAHL, ALBRECHT et al. 2011, 2013] wird zwar übereinstimmend fest gestellt, daß der säkulare Anstieg in der Nordsee bei etwa 13-18 cm liegt – ohne(!) Beschleunigung, aber über die krasse Diskrepanz dieser Daten gegenüber den Altimeter-Messungen wird dort kaum ein Wort verloren, sieht man einmal von einer solchen lapidaren Anmerkung ab:

"For the period 1993 to 2009, the estimated global MSL trend from altimetry records is 3.2 ± 0.4 mm/yr, almost double that observed from 1900 to 2009 (Church and White, 2011)."

Eine wissenschaftlich kritische Diskussion oder gar Bewertung dazu fehlen hier völlig – seltsam.

F a z i t :

Die erhebliche Diskrepanz zwischen Sat-Altimeter-Daten und Pegeln ist bis heute u.E. nicht geklärt [20] :

"Trotz der neuen Satellitenmessungen wurden die Pegelmessungen natürlich weitergeführt. Und die ließen sich nicht beirren und blieben stur bei ihrem alten Kurs von deutlich unter 2 mm/Jahr. Anstatt die Satellitendaten nun an die real am Boden gemessenen Daten anzupassen und nach unten zu korrigieren, besteht die Diskrepanz zwischen Pegel- und Satellitenmessungen aber leider bis heute weiter. Und es scheint irgendwie auch niemanden zu stören. Ein mysteriöser Fall."

(9) SPIEGEL: "Feilschen wie auf dem Basar"

Bemerkenswert ist u.E. noch, was DER SPIEGEL [21] unter dem Titel "Klimarat feilscht um Daten zum Meeresspiegel-Anstieg" über die Art und Weise der "Entstehung" von Meeres-Spiegel-Prognosen beim IPCC über eine diesbezügliche Tagung der Meeresspiegel-Forscher (Juli 2011) berichtet :

"Viele Milliarden Euro stehen auf dem Spiel: Ein Uno-Gremium entscheidet über die Prognose zum Anstieg der Ozeane – sie bestimmt, wie viel Steuergeld die Staaten in den Küstenschutz pumpen müssen. Hunderte Studien werden verhandelt, es geht zu wie auf einem Basar."

Und weiter a.a.O. :

"Das Feilschen um die Ergebnisse gleicht dem Handel auf einem Basar:

Auf der einen Seite haben Forscher alarmierende Meeresspiegel-Prognosen veröffentlicht, die die Angaben des letzten Uno-Klimareports weit übertreffen.

Demgegenüber stehen tatsächliche Messungen des Meeresspiegels: Sie lassen bislang keinen extremen Anstieg erkennen." … "4000 Experten diskutierten auf der IUGG-Tagung von Ozeanforschern im australischen Melbourne ihre Ergebnisse. Mitunter lautet dabei die Maxime: "Wer bietet mehr?" …"Der Klimaforscher James Hansen von der Nasa zum Beispiel warnt in einem aktuellen Papier vor einem Anstieg der Meere um fünf Meter in den nächsten 90 Jahren – er verneunfacht damit die Schätzung des Höchstszenarios aus dem letzten Uno-Klimareport. Der Nasa-Forscher riskiere mit der Extremprognose seine Glaubwürdigkeit, meinen manche Klimatologen."

Bei dieser Art von "BASAR" gibt es allerdings auch nüchterne sachliche Stimmen (a,a,O.):

"Die höheren Anstiegsraten seit 1993 seien nichts Außergewöhnliches, meint Guy Wöppelmann von der Université de La Rochelle in Frankreich. Im 20. Jahrhundert habe sich der Meeresspiegel-Anstieg zuvor schon mal ähnlich beschleunigt; doch dann verlangsamte er sich wieder."

"Ähnliches geschehe nun wieder, sagt Eduardo Zorita vom GKSS-Institut für Küstenforschung: In den vergangenen acht Jahren habe sich der Anstieg der Ozeane abgeschwächt; wie es weitergehe, sei ungewiss."

…und weiter a.a.O.:

" Die Geoforscher Jim Houston vom Engineer Research Center in Vicksburg und Bob Dean von der University of Florida in Gainsville in den USA legten im Fachblatt "Journal of Coastal Research" überraschend dar, dass der Meeresspiegel während des vergangenen Jahrhunderts ziemlich gleichbleibend angestiegen sei – eine Beschleunigung sei nicht zu erkennen."

Dieses alles hat den Klimarat nicht davon abgebracht, gegen alle früheren und aktuellen Meßdaten nun im IPCC-Bericht 2013/14 wieder eine Beschleunigung des Meeres-Anstieges für die nächsten 100 Jahre zu prognostizieren, nachdem man in den Berichten davor (AR’s 1995, 2001, 2007) Schritt um Schritt eine weitgehende Herunterstufung in Richtung der Meß-Realität vorgenommen hatte (Abb. 12) :

Abbildung 12 [IPCC/AR’s 1990-2013]

IPCC-Prognosen zum Meeres-Anstieg

F a z i t :

Die Erstellung von IPCC-Prognosen zum Meeres-Anstieg haben mit sachlicher Wissenschaft kaum noch etwas gemein [ SPIEGEL-ol. 14.07.2011] : "Das Feilschen um die Ergebnisse gleicht dem Handel auf einem Basar."

(10) Vertrauens-Krise der IPCC-Institute auch beim Meeres-Spiegel-Alarm

Mit dem "Climate-Gate-Skandal" begann 2009 für das IPCC eine schwere Vertrauens-Krise [22], die bis heute anhält.

Dieser Vertrauens-Verlust in die IPCC-Prognosen zeigt sich immer wieder auch bei den von einigen Instituten verbreiteten Phantastereien zu gigantischen Meeresspiegel-Anstiegen [23]:

"4000 Experten diskutierten auf der IUGG-Tagung von Ozeanforschern im australischen Melbourne ihre Ergebnisse. Mitunter lautet dabei die Maxime: "Wer bietet mehr?" (vgl. Kap.9).

So kann es nicht verwundern, daß Planer beim Küstenschutz derartigen Prophezeiungen keinen Glauben mehr schenken. Daher werden z.B. auch Stefan Rahmstorf und das PIK mit derartigen Extrem-Prognosen zum Meeres-Spiegel international kaum noch ernst genommen [24]:

"Unter sorgfältiger Abwägung aller verfügbaren Informationen entschied der Senat von North Carolina im Juni 2012 mit 35 zu 12 Stimmen, dass bei Küstenschutzplanungen zukünftig mit der historisch gut dokumentierten Meeresspiegel-Anstiegsrate kalkuliert werden muss. Eine Beschleunigung wie sie von der Rahmstorf-Gruppe für die Zukunft postuliert wird, soll nicht eingerechnet werden. (Siehe Berichte auf junkscience, Climatewire, WUWT, John Droz Jr.).

Das Gesetz wurde Anfang Juli 2012 auch vom Repräsentantenhaus von North Carolina abgesegnet. … Die republikanische Politikerin Pat McElraft hatte sich für die beschlossene Regelung eingesetzt und erklärte, dass sie eine zukünftige starke Beschleunigung des Meeresspiegel-Anstiegs als unrealistisch ansieht und dies lediglich Vermutungen darstellt."

Die Vertrauenskrise des IPCC ist mittlerweile sogar in den sonst überwiegend Klima-katastrophilen deutschen Medien [25] angelangt:

"Wenn bald über die Verlierer des Jahres nachgedacht wird, stehen die Klimaforscher auf vielen Listen sicher weit oben. … Stocker [26] war schon einige Wochen vorher bei der Vorstellung seines IPCC-Berichts praktisch baden gegangen, weil er der Öffentlichkeit und Politik vergeblich zu vermitteln versuchte, dass die jahrelange Quasi-Stagnation der Welttemperatur, der „Hiatus“, von der Klimapolitik ausgeklammert werden sollte. … Die Logik der Politik ist aber eine andere: Wenn die Klimaforschung schon so gravierende Schwankungen der Gegenwart nicht auf ihrer Rechnung hat, wie sollen wir ihr dann die Prognosen für die nächsten hundert Jahre abnehmen?"

DER SPIEGEL [27] macht bereits einen "Abgesang" auf den Klimarat IPCC:

"Der Ehrentag des Klimarats der Vereinten Nationen (IPCC) wurde am Freitag mit einer spärlich besuchten Pressekonferenz in der georgischen Stadt Batumi (Anm.: 18.10.2013) begangen … Zum 25. Geburtstag kamen kaum Gäste, es wurde nur Wasser gereicht … Es wirkte wie ein Abgesang auf jene Organisation, die 2007 immerhin mit dem Friedens-Nobelpreis geehrt wurde. Einen weiteren großen Klimareport wird es womöglich nicht mehr geben."

====================================================================

Z u s a m m e n f a s s u n g :

Die ständigen Alarm-Meldungen zu angeblich dramatischen Meeres-Spiegel-Anstiegen in Gegenwart und Zukunft können durch Messungen nicht bestätigt werden, sondern werden durch die Meß-Daten sogar widerlegt. Weltweit zeigen weder die Pegel-Daten (200 Jahre) noch die Satelliten-Daten (20 Jahre) eine Beschleunigung des Meeres-Anstieges. Dazu in krassem Widerspruch stehen alle bisherigen und derzeitigen Aussagen vom Klimarat IPCC, von einigen Klima-Instituten sowie die der Klima-Modelle. Darüber hinaus gibt es Anhalts-Punkte dafür, daß die Satelliten-Daten zu höheren Beträgen hin erheblich "über-korrigiert" wurden [28]: "Anstatt die Satellitendaten nun an die real am Boden gemessenen Daten anzupassen und nach unten zu korrigieren, besteht die Diskrepanz zwischen Pegel- und Satellitenmessungen aber leider bis heute weiter. Und es scheint irgendwie auch niemanden zu stören. Ein mysteriöser Fall."

Klaus-Eckart Puls

===================================================================

Q u e l l e n :

[1] BEHRE, K.-E.: (a) Eine neue Meeresspiegel-Kurve für die südliche Nordsee, Probleme der Küstenforschung im südlichen Nordseegebiet, Band 28, (2003), Isensee-V.; (b) A new Holocene sea-level curve for the southern North Sea; Boreas, Vol. 36, pp. 82–102. Oslo. ISSN 0300-9483, 2007 (January); (c) Landschaftsgeschichte Norddeutschlands, Wachholz-Verlag Neumünster, (2008), 308 S.

[2] Shennan, I., Woodworth, P.L., 1992. A comparison of late Holocene and twentieth century sea-level trends from the UK and North Sea region. Geophys. J. Int. 109, 96–105; nachzitiert nach: T. WAHL et al.: "Observed mean sea level changes around the North Sea coastline from 1800 to present" ; Earth-Science Review; Vol. 124, Sept. 2013, 51-67

[3] NLWKN; NZ, 16.11.2013, S.25, in: "Superdeich schützt die Küste"

[4] Wahl, T., Jensen J., Frank, T. and Haigh, I.D. ; (2011) Improved escmates of mean sea level changes in the German Bight over the last 166 years, Ocean Dynamics, May 2011, Vol. 61, Issue 5, 701-715

[5] J.M. HANSEN et al.: Absolute sea levels and isostatic changes of the eastern North Sea to central Baltic region during the last 900 years ; BOREAS, DOI 10.1111/j.1502-3885.2011.00229.x (2011)

[6] NZ, 04.02.2010, S.4; Klima-Wandel nicht bemerkbar

[7] (a) Wahl, T., Jensen J., Frank, T. and Haigh, I.D. ; (2011) Improved escmates of mean sea level changes in the German Bight over the last 166 years, Ocean Dynamics, May 2011, Vol. 61, Issue 5, 701-715; (b) Albrecht, F., T. Wahl, J. Jensen and R.Weisse (2011); Determinig sea level change in the German Bight, Ocean Dynamics, doi:2010.1007/s10236-011-0462-z

[8] Wir bedanken uns bei den Autoren F.ALBRECHT, Th.WAHL et al. [7] für die Überlassung der Original-Daten für die Abb.5

[9] T. WAHL et al.: "Observed mean sea level changes around the North Sea coastline from 1800 to present" ; Earth-Science Review; Vol. 124, Sept. 2013, 51-67

[10] NILS-AXEL MÖRNER: (a) Sea Level Changes Past Records And Future Expectations, ENERGY &ENVIRONMENT, VOL. 24 No. 3 & 4 (2013) (b) Sea Level Changes; A short comment; (2013); Paleogeophysics & Geodynamics, Stockholm, The Global Climate Status Report (GCSR) © is a product of the Space and Science Research Corporation, (SSRC), P.O. Box 607841, Orlando, Florida

[11] JEVREJEVA, S., et al.: Global Sea Level Behavior of the Past Two Centuries; Global and Planetary Change 113: 11-22; (2014); http://kaares.ulapland.fi/home/hkunta/jmoore/pdfs/Jevrejevaetal2013GPChange.pdf

[12] http://www.aviso.altimetry.fr/en/data/products/ocean-indicators-products/mean-sea-level.html

[13] http://www.eike-klima-energie.eu/news-cache/neue-studie-mittels-grace-daten-meeresspiegel-steigt-um-weniger-als-17-cm-pro-jahrhundert/ 09.07.2013 ; und http://sealevel.colorado.edu/content/continental-mass-change-grace-over-2002%E2%80%932011-and-its-impact-sea-level 08.07.2012

[14] (a) http://wattsupwiththat.com/2012/05/16/issea-levelriseaccelerating/ und: (b) http://www.kaltesonne.de/?p=4429

[15] http://www.aviso.altimetry.fr/en/data/products/ocean-indicators-products/mean-sea-level.html

[16] (a) http://www.science-skeptical.de/blog/was-nicht-passt-wird-passend-gemacht-esa-korigiert-daten-zum-meeresspiegel/007386/ ; 13. April 2012 | Von Rudolf Kipp (b) Nachträgliche Korrekturen der Satelliten-Meeresspiegeldaten: Was nicht passt wird passend gemacht? 14. Juli 2012 ; http://www.kaltesonne.de/?p=4544

[17] SPIEGEL-ol.; 25.08.2011: http://www.spiegel.de/wissenschaft/natur/ozeane-wetterumschwung-senkt-globalen-meeresspiegel-a-782324.html

[18] Nils-Axel Mörner: Sea Level Changes; A short comment; (2013); Paleogeophysics & Geodynamics, Stockholm, The Global Climate Status Report (GCSR) © is a product of the Space and Science Research Corporation, (SSRC), P.O. Box 607841, Orlando, Florida

[19] http://climatesanity.wordpress.com/2011/06/06/deception-from-nasa-satellites-are-true-cause-of-sea-level-rise/

[20] http://www.kaltesonne.de/?p=4544 ; 14. Juli 2012

[21] SPIEGEL: "Klimarat feilscht um Daten zum Meeresspiegel-Anstieg" ; 14.07.2011 ; http://www.spiegel.de/wissenschaft/natur/0,1518,774312,00.html

[22] http://laufpass.com/ausgaben/eBook/eBook_0210/flash.html ; Nr.24 (2010), S. 8-13 ; u n d

http://www.eike-klima-energie.eu/climategate-anzeige/vertrauen-in-welt-klima-rat-im-freien-fall-die-irrungen-wirrungen-und-manipulationen-des-ipcc-ein-update/ ; 08.06.2010

[23] http://www.spiegel.de/wissenschaft/natur/0,1518,774312,00.html ; 14.07.2011

[24] http://www.kaltesonne.de/?p=4506 ; 12. Juli 2012

[25] FAZ, 27.11.2013, "Durchhaltemodelle"

[26] THOMAS STOCKER, Sitzungsleiter beim IPCC auf der Tagung in Stockholm, Sept. 2013

[27] SPIEGEL: Uno-Forscher wollen große Klimaberichte abschaffen ; 18.10.2013 ;

http://www.spiegel.de/wissenschaft/natur/umbau-des-uno-klimarats-klimabericht-des-ipcc-arbeitsgruppe-2-a-928717.html

[29] Nils–Axel Mörner: Deriving the Eustatic Sea Level Component in the Kattaegatt Sea; Global Perspectives on Geography (GPG) Volume 2, (2014), p.16-21

===================================================

Anmerkung EIKE-Redaktion:

Die vorstehende Publikation kann in der Anlage hier als PDF runter geladen werden, sowohl in Deutsch als auch in einer Englisch-sprachigen Version; mit jew. besserer Qualität der Abbildungen als hier vorstehend im WEB-Artikel; s.w. unten.

====================================================

Related Files