Energiewende: Land unter im Stromsee – Nur hohe Nutzungsgrade machen Sinn

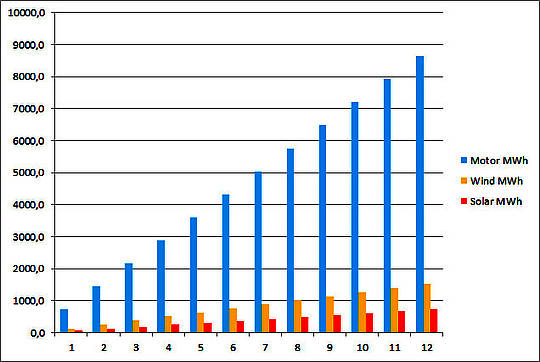

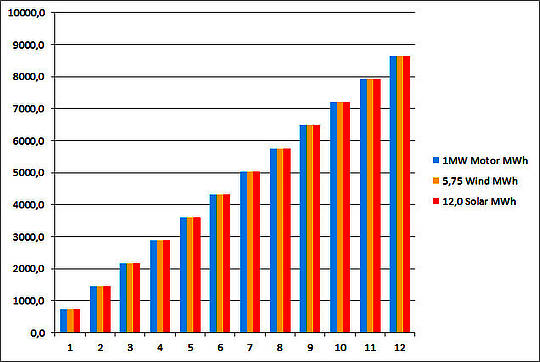

Das Hauptproblem bei den wetterabhängigen Stromerzeugungsverfahren aus Wind und Sonne sind die geringen Nutzungsgrade. Will man z.B. aus Windenergie einen im Jahresmittel definierten Ertrag gewinnen, dann kann man die am Typenschild der Anlagen ablesbare Leistungsangabe nicht heranziehen. Entscheidend ist vielmehr der Nutzungsgrad, eine prozentuale Angabe über den Abschlag, mit dem die Typenschildabgabe multipliziert werden muss. Wie Bild 1 zeigt, würde ein motorisch betriebenes Kraftwerk, das nahezu unterbrechungsfrei arbeiten kann, bei einer nominellen Leistung von 1 MW bis zum Ende eines Betriebsjahres ca. 8600 MWh elektrischer Arbeit abliefern. Bei einer Windenergieanlage mit nominell gleicher Leistung wären es zum Jahresende lediglich 1524 MWh und bei einer Solaranlage sogar lediglich 727 MWh. Ursache ist der miserable Nutzungsgrad der „Erneuerbaren“: Sowohl Wind- als auch Solarkraftwerke liefern nur ganz selten die volle Höchstleistung ab, die weitaus meiste Zeit kommen nur Bruchteile davon aus den Anschlüssen. Bei an Land errichteten Windenergieanlagen liegt der Mittelwert daher bei lediglich 17,4 % statt 100 % des theoretisch möglichen Ertrags, bei Solaranlagen sind es sogar nur 8,3 %.

Bild 1: Vergleich der gelieferten Jahresstrommenge für ein Motorkraftwerk, eine Windenergieanlage und eine Solaranlage, jeweils mit einer Typenschildleistung von 1 MW

Da jedoch 100 % bzw. 8600 MWh benötigt werden, muss man bei EE-Anlagen deshalb eine entsprechend höhere Kapazität installieren, Bild 2. Bei Wind entspricht dies dem Faktor 5,75, bei Solarstrom mit seinem noch deutlich schlechteren Nutzungsgrad von 8,3 % liegt der Faktor sogar bei 12,05.

Bild 2: Gleicher Stromertrag von 1 MW Motorkraft, 5,75 MW Windenergie oder 12 MW Solarpaneelen.

Anders ausgedrückt: Um ein Motorkraftwerk mit nominell 1 MW bei 98,5 % Auslastung zu ersetzen, muss man 5,75 MW Windleistung oder sogar 12 MW Solarleistung installieren – und deren Produktion bei „gutem“ Wetter auch irgendwohin schaffen, wo sie sinnvoll genutzt werden kann.

Strom-Tsunamis sind vorprogrammiert

Direkte Folge der großen Überkapazitäten, die man beim Ersatz konventioneller Stromerzeugungstechnologien durch Wind- und Solaranlagen mit schlechten Nutzungsgraden vorsehen muss, ist eine entsprechend hohe Überproduktion an Strom, wenn es der Wind oder die Sonne mal besonders gut meinen. Während ein konventionelles Kraftwerk mit 1 MW Leistung stets genau diese Leistung zur Verfügung stellt, sieht dies bei einem Windpark ganz anders aus: Es wird je nach Wetterlage zwischen 1 % und 575 % der eigentlich benötigten Leistung ins Netz einspeisen, egal wie hoch der aktuelle Bedarf ist. Bei einem Solarkraftwerk sind es dementsprechend zwischen 0 % und 1200 %.

Allerdings kann man den bei „guter“ Wetterlage zuviel produzierten Strom nicht einfach „wegwerfen“, da man damit im Prinzip die Zeiten schwächerer Produktion ausgleichen muss. Anderenfalls würde man die für das Gesamtjahr benötigte Stromproduktion nicht darstellen können. Das Ganze kann daher nur funktionieren, wenn man die in Zeiten des Überflusses produzierten Strom-Tsunamis irgendwohin leitet, wo sie sinnvoll verwendet werden können. Das könnten in Zukunft irgendwelche Speichersysteme oder – so wie es jetzt gehandhabt wird – einfach die Stromnetze unserer diversen Nachbarländer sein, denen man den Segen mit teils massiven Zuzahlungen auf’s Auge drückt.

Das Problem ist dabei, dass man hierfür die Leitungsnetze entsprechend der im Extremfall zu erwartenden Strommengen überdimensionieren muss. Während für das bereits angesprochene 1-MW-Motorkraftwerk eine Leitung mit einer Transportkapazität von 1 MW völlig ausreichen würde, müsste sie für den Anschluss eines Windparks mit 5,75 MW auch für dessen Maximalkapazität ausgelegt werden, auch wenn im Jahresmittel nur 1 MW Transportkapazität genutzt wird. Anders ausgedrückt: Man muss eine 5,75 MW-Leitung vorsehen, die jedoch statt zu 98,5 % lediglich zu 17,4 % ausgelastet wird. Im Straßenbau entspräche dies dem Bau einer sechsspurigen Autobahn, über die dann im Mittel das Verkehrsaufkommen einer einspurigen Landstraße abgewickelt wird, Bild 3. Noch schlechter sieht es bei Solaranlagen aus, da hier das Verhältnis 1/12 ist. Das entspräche einer 12spurigen Autobahn statt einer Landstraße.

Bild 3: Stromnetz-Analogie: Wo bei konventionellen Kraftwerken eine einspurige Landstraße reichen würde, müsste man bei Windstrom für die Bewältigung des gleichen Jahresstromaufkommens eine sechsspurige Autobahn vorsehen

Ausbauziele für Deutschland

Um abzuschätzen, wie sich die weitere Entwicklung des EEG in den kommenden Jahren auf die Stromproduktion Deutschlands sowie auf die dortigen Stromnetze auswirken dürfte, gehen wir zunächst von der aktuellen Stromproduktion und von den EE-Planungen der Großen Koalition aus. Als Referenz nehmen wir das Jahr 2013 mit einer Gesamt-Stromproduktion von 629 TWh. Während die Stromerzeugung in Deutschland – außer in Kriegs- und Krisenzeiten – stets zunahm, unterstellen wir einmal, dass die aktuellen Sparbemühungen zu einem „Einfrieren“ des Stromverbrauchs auf dem Niveau des Jahres 2013 führen werden. Da die Politik jedoch den Autoverkehr auf elektrische Antriebe umstellen will, muss der hierfür benötigte Strom zusätzlich erzeugt werden. Für 2020 sind 1 Mio. Elektrofahrzeuge geplant, während bis 2050 die gesamte PKW-Flotte von heute rund 44 Mio. Fahrzeugen durch Stromschlucker ersetzt sein soll. Aufgrund dieses zusätzlichen Verbrauchs ergäbe sich dann für 2050 eine Stromerzeugung von 759 TWh. Für 2050 plant die große Koalition einen EE-Anteil an der Stromproduktion von 80 %. Noch weiter gehen Grüne, WWF, Greenpeace und die evangelische Kirche, die 100 % EE-Anteil fordern.

Setzt man die obigen Zahlen um, so lassen sich für die Stromproduktion aus EE-Quellen folgende Zielvorgaben errechnen:

Jahr 2050: TWh

Wind Onshore (erforderl. Kapazität 288100 MW, Nutzungsgrad 17,4 %) 439,1

Wind Offshore (erforderl. Kapazität 36010 MW, Nutzungsgrad 34,8 %) 109,8

Solar (erforderl. Kapazität 52000 MW, Nutzungsgrad 8,3 %) 37,8

Wasser (Kapazität 4300 MW) 20,5

Jahr 2050 bei 100 % EE-Erzeugung (Forderung ev. Kirchentag) TWh

Wind Onshore (erforderl. Kapazität 367800 MW, Nutzungsgrad 17,4 %) 560,6

Wind Offshore (erforderl. Kapazität 46000 MW, Nutzungsgrad 34,8 %) 140,1

Solar (erforderl. Kapazität 52000 MW, Nutzungsgrad 8,3 % ) 37,8

Wasser (Kapazität 4300 MW ) 20,5

Diesen Zahlen liegen folgende Annahmen zugrunde: Die Produktion von Strom aus Wasserkraft wird sich in Deutschland kaum noch steigern lassen. Auch der Erzeugung von Strom aus Getreide – vornehm als Biogas bezeichnet – dürfte wegen der Amoralität dieses Tuns in einer hungrigen Welt (man braucht sich nur zu fragen, warum so viele Bootsflüchtlinge auf dem Mittelmeer ihr Leben riskieren) kaum noch großes Wachstum beschieden sein. Und bei Fotovoltaik ist ein Deckel von 52000 MW geplant. Alle künftigen Steigerungen der Erzeugung von EE-Strom können daher im Prinzip fast nur noch durch Ausbau der Windenergie erfolgen. Blieben von den EE-Erzeugern theoretisch also noch Müllverbrennungsanlagen (5,2 TWh in 2013) und Getreidegasanlagen (42,6 TWh in 2013), die parallel zu den Wind- und Solaranlagen einspeisen. Aus naheliegenden Gründen dürfte ihr Anteil in den kommenden Jahrzehnten jedoch gegen Null tendieren, da alle heute existierenden Anlagen bis 2050 aus der Förderung herausfallen und neue Anlagen wohl kaum noch errichtet werden. Die heute noch existierenden Kraft-Wärme-Kopplungsanlagen dürften bis 2050 wegen mangelnder Wirtschaftlichkeit vom Markt verschwunden sein.

Auswirkungen auf die Stromproduktion

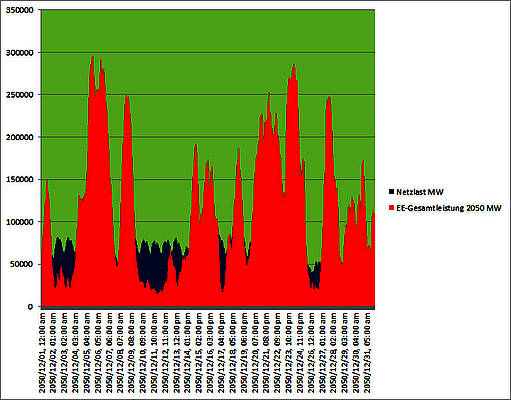

Um die konkreten Auswirkungen des beschlossenen Ausbaus von Wind- und Solarstromerzeugung im Jahre 2050 zu veranschaulichen, wurden die realen Zahlen der Stromproduktion des Dezembers 2013 in viertelstündlicher Auflösung zugrunde gelegt. Dann wurden sowohl die vollständige Netzlast als auch die zu erwartende Leistungsbereitstellung durch Wind- und Solarkraftwerke mit Hilfe der oben aufgeführten Zahlen umgerechnet. Bild 4 zeigt die entsprechenden Werte für die Netzlast (entspricht in etwa dem inländischen Verbrauch) sowie für die Summenleistung von Wind- und Solarenergieanlagen plus Wasserkraft. Der Spitzenwert liegt bei 296000 MW.

Bild 4: Projektion der Netzlast (dunkelblau) sowie der kumulierten Leistung von Wind-und Solarstromanlagen im Dezember 2050

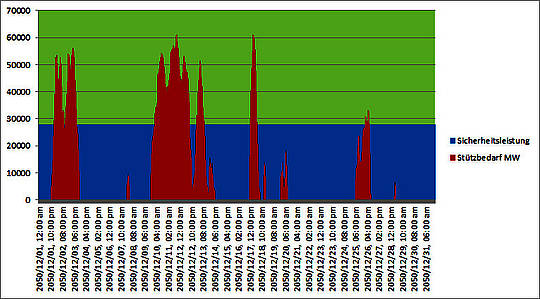

Wer beim Blick auf diese Darstellung jetzt annimmt, man könne angesichts der großen Mengen an EE-Strom die Kapazität der konventionellen Kraftwerke stark reduzieren, den wird ein Blick auf Bild 5 enttäuschen. Trotz der riesigen Kapazitäten von Wind- und Solarenergieanlagen gibt es weiterhin zahlreiche kürzere oder auch längere Zeiträume, wo konventionelle Kraftwerke einspringen müssen, weil die Produktion von EE-Strom nicht ausreicht, um Deutschland zu versorgen. In der Spitze müssen konventionelle Kraftwerke bis zu 61000 MW Leistung bereitstellen, damit die Stromversorgung gesichert bleibt. Darüber hinaus müssen zahlreiche Kohle- und Gaskraftwerke sogar kontinuierlich am Netz bleiben, um die Mindestleistung von etwa 28000 MW zu sichern, die benötigt wird, um die zur Stabilisierung des Netzes erforderliche Regelleistung darstellen zu können.

Bild 5: Im fiktiven Dezember 2050 benötigte Leistung aus konventionellen Kraftwerken: Rot für die Tage, an denen die Produktion aus EE-Quellen nicht zur Deckung der Netzlast ausreicht, und blau die zur Aufrechterhaltung der Netzsicherheit erforderliche Mindestleistung

Auswirkung auf die Netze

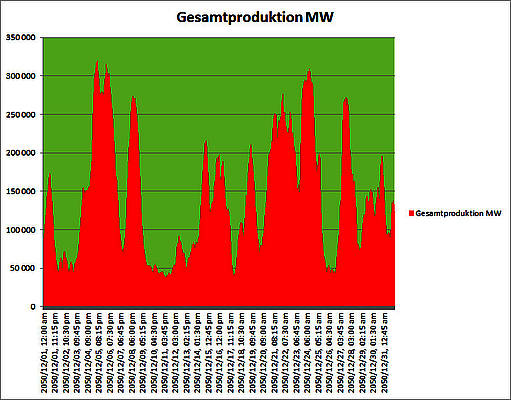

Würde der Ausbau der Stromproduktion aus sogenannten „Erneuerbaren Energien“ entsprechend der bisherigen Planungen konsequent umgesetzt, so hätte dies erhebliche Konsequenzen auch im Bereich der Hochspannungs-Übertragungsnetze für den erzeugten elektrischen Strom. Charakteristisch für die aktuelle Situation ist die weitgehende Planlosigkeit, mit der offensichtlich agiert wird. Grund hierfür ist sicherlich auch die Tatsache, dass sich bisher keinerlei vertretbare großtechnische Lösung für die Speicherproblematik abzeichnet. Deshalb werden bezüglich der Leitungsnetze zurzeit nur kleinere Lückenfüller wie „SüdLink“ projektiert, mit denen man die auf uns zurollende Erzeugungswelle auf keinen Fall bewältigen kann. Dies zeigt ein Blick auf Bild 6 mit der Simulation der gesamten Erzeugungsleistung des Dezembers einschließlich der Produktion der nach wie vor unverzichtbaren konventionellen Kraftwerke.

Bild 6: Im Dezember 2050 würde die maximale Einspeiseleistung bei weiterer Fortführung der Pläne der Bundesregierung bis zu 319600 MW erreichen

In der Spitze – d.h. bei günstigen Wetterverhältnissen und einer auf die Sicherheitsreserve reduzierten Leistung der konventionellen Kraftwerke – würden bis zu 319600 MW an elektrischer Leistung eingespeist – das ist um den Faktor 3,76 Mal mehr als die 85000 MW an gesicherter Leistung, für die unser Stromversorgungssystem einschließlich der Leitungsnetze ausgelegt ist. Anders ausgedrückt: Wo heute eine Hochspannungsleitung verläuft, dürften es bis 2050 vier sein, Bild 7.

Bild 7: Wo heute nur eine Stromleitung verläuft, könnten es in einigen Jahrzehnten vier sein

Egal ob man diesen Strom jetzt in „Wunderspeicher“ einlagert, die irgendwelche grünen Genies bis dahin noch „mal eben schnell“ erfinden müssen, oder ob man vorhat, damit die Energiewirtschaft diverser Nachbarländer zu beglücken: Diesem massiven Überangebot wäre unser heutiges Übertragungsnetz nicht im Entferntesten gewachsen. Man kann grob über den Daumen schätzen, dass unser Netz für die Bewältigung dieser Strommengen um den oben errechneten Faktor erweitert werden müsste. Ausgehend von der heutigen Länge von rund 38000 km müsste demnach ein Ausbau um 104900 km auf eine Gesamtlänge von 142900 km erfolgen. Bezüglich der Kosten kann man in erster Näherung von dem aktuell veranschlagten Aufwand von bis zu 10 Mrd. € für die rund 800 km lange „SüdLink“-Trasse ausgehen, die dereinst Windstrom von der Nord- und Ostsee nach Grafenrheinfeld transportieren soll. Dabei kann dieser Ansatz noch als konservativ eingestuft werden, wenn man sich das Ausmaß der Kostenüberschreitungen ansieht, die bei Großprojekten wie Stuttgart 21, der Elbphilharmonie oder dem BER-Flughafen die Regel zu sein scheinen. Rechnet man diesen Wert auf die genannten 104900 km hoch, so landet man bei Investitionskosten von etwa 1311 Mrd. € – nur allein für den bis 2050 voraussichtlich erforderlichen Ausbau des Stromnetzes.

Sind „100 % EE“ tatsächlich machbar?

Eine interessante Frage, die sich in diesem Zusammenhang stellt, ist die nach der angeblich möglichen Vollversorgung mit EE-Strom, eine Position, die von diversen politischen Kräften sowie von der Evangelischen Kirche vertreten wird. Auch dieses Szenario lässt sich am Beispiel des Dezembers 2050 durchrechnen. Voraussetzung hierfür ist die Annahme, dass ein „grüner“ Wundereffekt, auf den bisher noch kein Ingenieur gekommen ist, die Stabilisierung des Netzes auch ohne die Stützfunktion konventioneller Kraftwerke bewirken wird. Das vom Übertragungsnetz in diesem Fall zu bewältigende Leistungsangebot von bis zu 376000 MW zeigt Bild 8. Bei diesem Szenario müsste man die Netze um den Faktor 4,4 auf 168000 km erweitern. Dafür wären 1625 Mrd. € aufzubringen.