Das IPCC hat inzwischen 5 grundlegende Berichte veröffentlicht, zum ersten Mal den FAR im Jahre 1990. Dies bietet Gelegenheit, einmal zu schauen, was vorhergesagt worden und was tatsächlich geschehen war. Die Untersuchung vergangener Berichte in dieser Hinsicht ist ziemlich erhellend, da sie enthüllen, was das IPCC während der letzten 24 Jahre gelernt hat.

Ich komme zu dem Ergebnis, dass nichts gelernt worden ist außer zu verschleiern, in die Irre zu führen und zu betrügen.

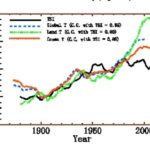

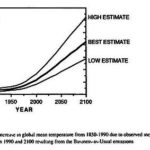

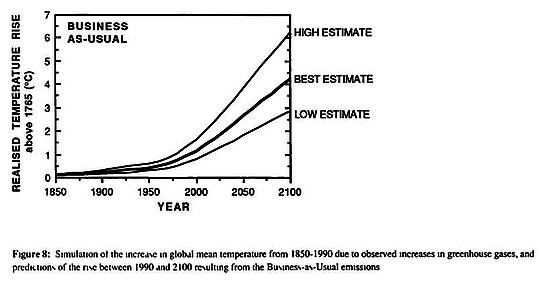

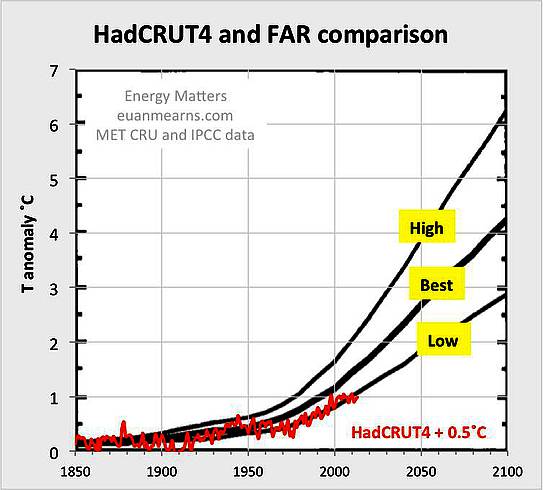

[Bildinschrift: Abbildung 8: Simulation der Zunahme der mittleren globalen Temperatur von 1850 bis 1990 infolge zunehmender Treibhausgase sowie Vorhersagen des Anstiegs von 1990 bis 2100 bei ‚Business as Usual‘-Emissionen]

Abbildung 1: Temperaturvorhersagen aus dem FAR (1990). Ist dies die beste Vorhersage, die das IPCC jemals ausgegeben hat? In der Bildunterschrift heißt es klar und deutlich, dass jedem Modell das gleiche Emissions-Szenario zugrunde liegt. Folglich beruhen die Unterschiede zwischen ‚Low-, Best- und High‘-Schätzungen auf unterschiedlichen physikalischen Hypothesen wie der Klimasensitivität von CO2. Durch das Konstant-Halten der Schlüsselvariablen (CO2-Emissions-Trajektorie) wird es dem Leser ermöglicht zu erkennen, wie unterschiedlich wissenschaftliche Beurteilungen zu Buche schlagen. Das ist der richtige Weg, dies zu tun. Alle Modelle haben den Startzeitpunkt 1850 und zeigen bereits bis zum Jahr 2000 eine signifikante Divergenz. Wie verhält sich dies im Vergleich zu dem, was eingetreten war, und zur nachfolgenden Arbeit des IPCC?

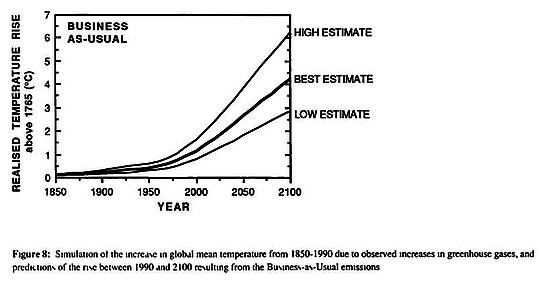

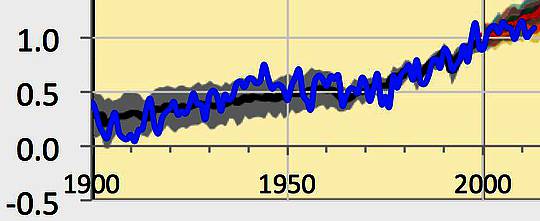

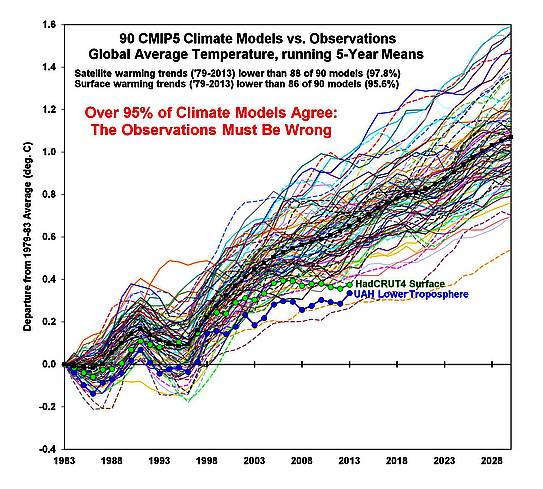

Mir ist klar, dass viele andere genau dies schon zuvor getan haben, und zwar viel differenzierter als ich das hier tun werde. Das beste Beispiel hierfür, das mir bisher untergekommen ist, stammt von Roy Spencer (1), der die folgende ausgezeichnete Graphik erzeugt hat, die jedoch auch einige Kritik auf sich gezogen hat.

Abbildung 2: Vergleich der multiplen IPCC-Modelle mit der Realität, zusammengestellt von Roy Spencer. Die Tatsache, dass sich die Realität entlang der unteren Grenze der Modelle bewegt, wurde von IPCC-Skeptikern schon oft belegt. Die einzigen Wissenschaftler, die aus dieser Realität geflohen zu sein scheinen, sind die mit dem IPCC Verbundenen.

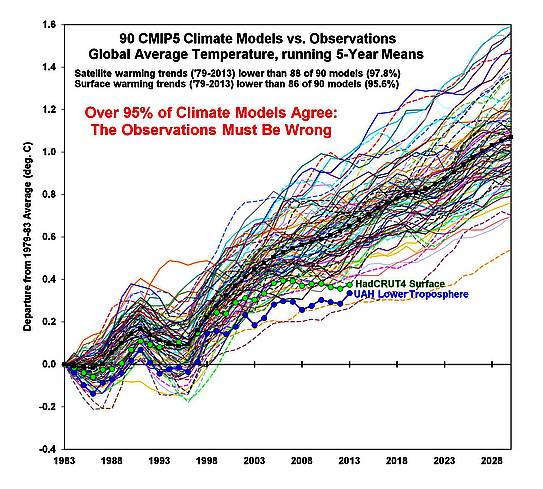

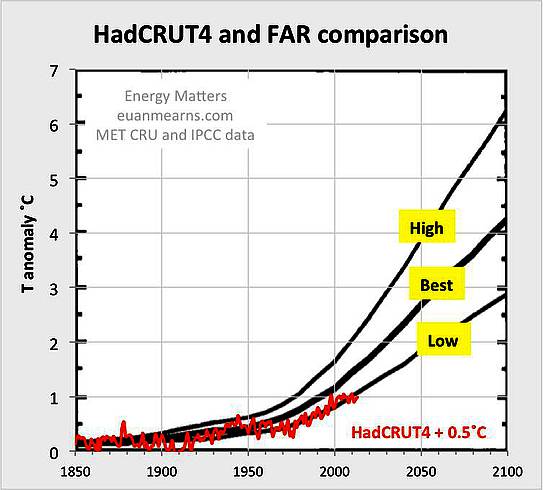

Mein Verfahren ist viel einfacher und gröber. Ich habe einfach IPCC-Graphiken via copy and paste in große Karten kopiert, wo ich die IPCC-Vorhersagen vergleiche mit Temperatur-Rekonstruktionen von HadCRUT4. Wie wir sehen werden, hat das IPCC ein außerordentlich laxes Verfahren hinsichtlich der Temperaturbestimmungen, und in jedem Beispiel muss eine unterschiedliche Adjustierung von HadCRUT4 vorgenommen werden, um es mit dem IPCC-Rahmen vergleichbar zu machen.

Abbildung 3: Vergleich der Temperaturvorhersagen aus dem FAR (1990) mit HadCRUT4. Diese Daten wurden heruntergeladen von der Site von WoodForTrees (2) und dann das jährliche Mittel berechnet.

Abbildung 3 zeigt, wie die Temperaturvorhersagen aus dem FAR (1990) im Vergleich zur Realität aussehen. Es ist ziemlich eindeutig, dass das beste Modell das untere Modell ist. Ich habe Schwierigkeiten, die Parameter zu finden, die für die Definitionen von Low, Best und High gemacht worden waren, aber der Bericht stellt eine Bandbreite von Klimasensitivitäten zwischen 1,5 und 4,5°C fest. Eindeutig liegt das Low-Modell der Realität von HadCRUT4 am Nächsten. Das High-Modell ist bereits im Jahre 2013 um 1,2°C zu warm.

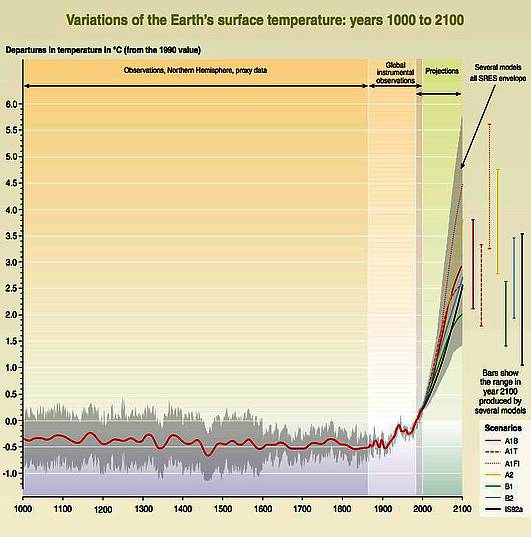

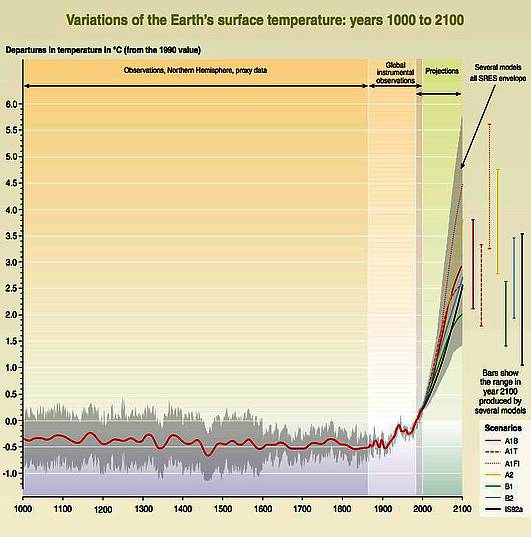

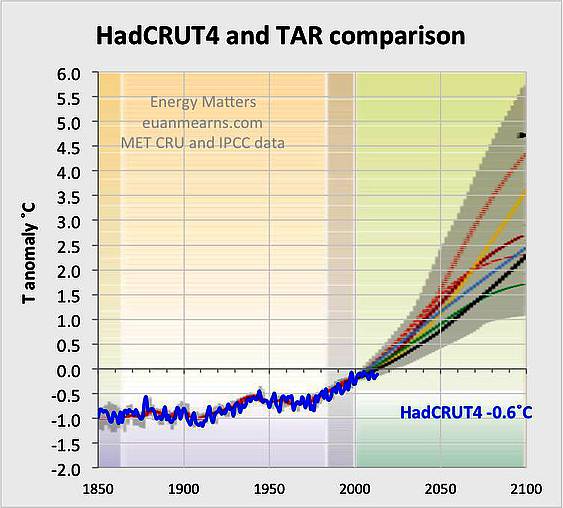

Abbildung 4:Im Dritten Zustandsbericht TAR (2001) wurde der Hockeyschläger eingeführt. Die gemessene Temperaturaufzeichnung wird aufgeteilt in eine Proxy-Aufzeichnung, die Modell-Aufzeichnung in einen gemessenen Anteil, und es wird keine Gelegenheit angeboten, den Wahrheitsgehalt der Modelle zu untersuchen. Aber seitdem sind 13 Jahre vergangen, und wir können sehen, wie die Realität im Vergleich zu den Modellen nach diesem sehr kurzen Zeitraum aussieht.

Ich konnte keine Zusammenfassung des Zweiten Zustandsberichtes (SAR) aus dem Jahr 1994 finden und bin daher gleich zum Dritten Zustandsbericht TAR (2001) gesprungen. Ich glaube, dass dies das Jahr war, in dem der Hockeyschläger das Licht der Welt erblickte. In der imaginären Welt des IPCC waren die Temperaturen auf der Nordhemisphäre von 1000 bis 1900 konstant verlaufen ohne die geringste Spur der Mittelalterlichen Warmzeit oder der Kleinen Eiszeit, wo die wirklichen Menschen entweder aufgeblüht oder millionenfach umgekommen sind. Der aktuelle Temperaturverlauf wird aufgeteilt in die Proxy-Aufzeichnung und die Modellwelt derart, dass sie das Bild einer zukünftigen Temperatur-Katastrophe erzeugen soll. Wie sieht das im Vergleich zur Realität aus?

Abbildung 5: von 1850 bis 2001 zeigt das IPCC-Hintergrundbild die Beobachtungen (keine Modellergebnisse), die mit den HadCRUT4-Messungen übereinstimmen. Sehr gut gemacht, IPCC! Was seit dem Jahr 2001 geschehen ist, zeigt detailliert Abbildung 6. Um irgendeinen Aussagewert oder irgendwie von Bedeutung zu sein, hätten alle Modelle zum Zeitpunkt 1850 beginnen sollen. Dann würde man nämlich erkennen, dass die Mehrheit der Modelle seit 2001 viel zu warm ausgefallen war.

Abbildung 5 zeigt den Vergleich der HadCRUT4-Daten mit der Modell-Welt. Die Übereinstimmung von 1850 bis 2001 ist exzellent. Grund hierfür ist, dass man einfach die Messungen in diesem Zeitraum geplottet hat. Nichtsdestotrotz musste ich 0,6°C von HadCRUT4 abziehen, um sie zu den Beobachtungen passend zu machen, während ich ein Jahr zuvor noch 0,5°C addieren musste. Der Maßstab der X-Achse über 250 Jahre macht es schwierig zu erkennen, wie die Modelle seit 2001 im Vergleich zu den 13 Jahren Beobachtungen seitdem aussehen. In Abbildung 6 ist dies als Lupe nachgeholt.

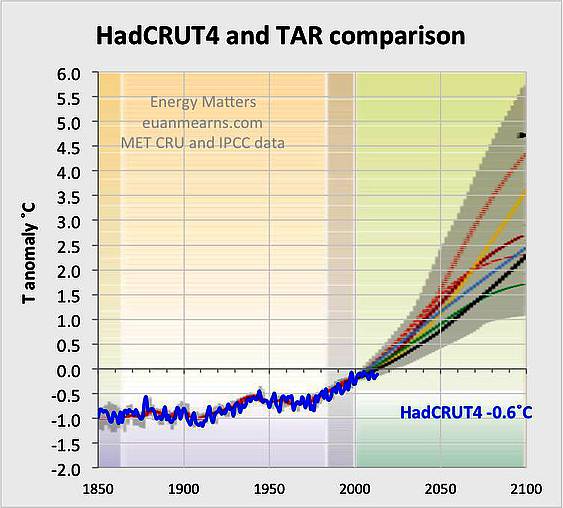

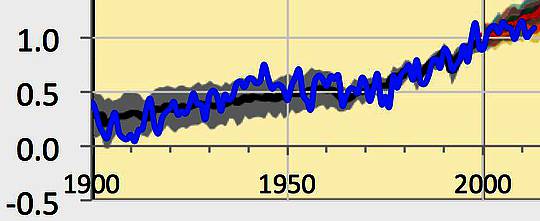

Abbildung 6: Die einzelne vertikale Gitternetzlinie ist das Jahr 2000. Die blaue Linie zeigt HadCRUT4 (Realität). Sie bewegt sich waagerecht, während alle Modelle einen Aufwärtstrend zeigen.

Der detaillierte Ausschnitt illustriert die Natur des Problems bei der Evaluierung der IPCC-Modelle. Während die Temperaturen der realen Welt seit etwa 1997 flach verlaufen sind und alle Modelle klar einen Aufwärtstrend zeigen, ist die Zeit wirklich nicht lang genug, um die Modelle angemessen zu evaluieren. Um wissenschaftlich valid zu sein hätte man die Modelle ab dem Jahr 1850 laufen lassen sollen (Abbildung 1), was man aber nicht getan hat. Hätte man das getan, würde die Realität bis zum Jahr 2001 breit divergent (wie 1990) sein, und es wäre einfach gewesen, den Gewinner zu finden. Aber bequemerweise hat man die Modelle um das Jahr 2000 initiiert. Wissenschaftlich ist das eine schlechte Praxis.

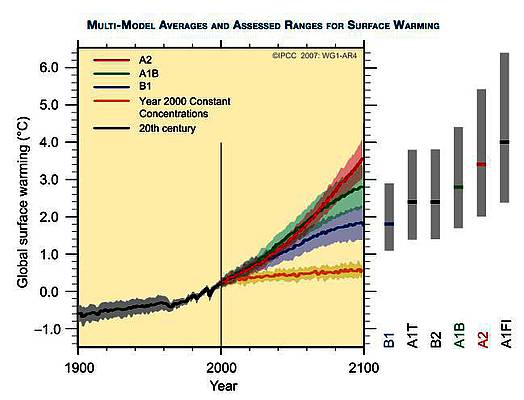

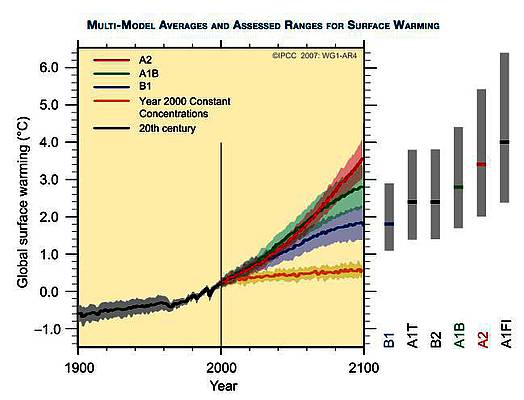

Abbildung 7: Zukunftsszenarien der Temperatur des IPCC aus dem AR 4 (2007). Es scheint, dass das IPCC die Notwendigkeit erkannt hat, die Modelle in der Vergangenheit zu initiieren, und in diesem Falle liegt der Startzeitpunkt weiterhin im Jahr 2000. Damit werden die gleichen 14 Jahre angeboten, in denen die Modellergebnisse mit dem verglichen werden können, was tatsächlich geschehen ist.

Für den Vierten Zustandsbericht AR 4 (5) kommen wir zum Jahr 2007 und der Summary, gezeigt in Abbildung 7. In diesem Stadium bin ich mir nicht sicher, was die Szenarien B1 bis A1F1 bedeuten sollen. Die Bildunterschrift zu dieser Graphik in den Berichten lautet:

Abbildung SPM 5: Durchgezogene Linien sind die multi-modellierten Mittel der Erwärmung (relativ zum Zeitraum 1980 bis 1999) für die Szenarien A2, A1B und B1, gezeigt als Fortsetzungen der Simulationen des 20. Jahrhunderts. Die Schattierung kennzeichnet die ±1-Standardabweichung der jährlichen Mittelwerte eines jeden individuellen Modells. Die orange Linie gilt, wenn die Konzentrationen konstant bei den Werten aus dem Jahr 2000 gehalten werden. Die grauen Balken rechts zeigen den Best Estimate (durchgezogene Linie in jedem Balken) und die wahrscheinliche Bandbreite der sechs SRES-markierten Szenarien. Die Bestimmung des Best Estimate und der wahrscheinlichen Bandbreiten in den grauen Balken enthalten auch die AOGCMs im linken Teil der Abbildung, ebenso wie die Ergebnisse einer Hierarchie unabhängiger Modelle und Einschränkungen aufgrund von Beobachtungen.

In dieser Bildunterschrift steckt implizit die Vermutung, dass die schwarze Linie vor dem Jahr 2000 eine von Modellen nach dem Jahr 2000 erzeugte Simulation ist (Fettdruck von mir). Die orange Linie kennzeichnet einen konstanten CO2-Gehalt, und die Tatsache, dass es sich dabei um eine nahezu flach verlaufende Linie handelt zeigt, dass das IPCC zu jener Zeit glaubte, dass Veränderungen des CO2-Gehaltes der einzige Prozess war, der zu Temperaturänderungen auf der Erde führen könnte. Ich weiß nicht, ob die Szenarien B1 bis A1F1 alle die gleiche oder unterschiedliche Trajektorien zunehmender CO2-Konzentration verwenden. Was ich aber sicher weiß ist, dass es für Modelle physikalisch unmöglich ist, einen breiten Bereich physikalischer Input-Variablen zu verarbeiten, die für das Jahr 1900 initiiert, eng ausgerichtet wurden und dann im Jahr 2000 konvergieren, wie hier gezeigt. Es ist eine physikalische Unmöglichkeit, wie die IPCC-Modelle aus dem Jahr 1990 gezeigt haben (Abbildung 1).

Wie also sehen die Simulationen aus dem Jahr 2007 im Vergleich zur Realität aus?

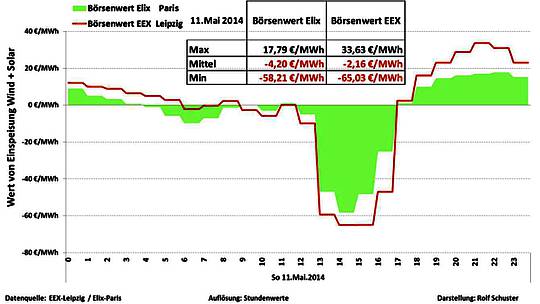

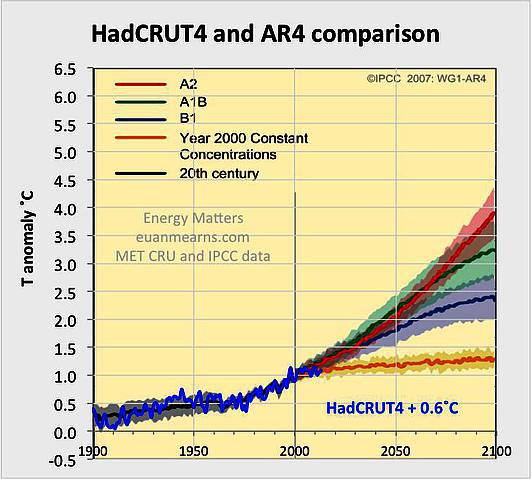

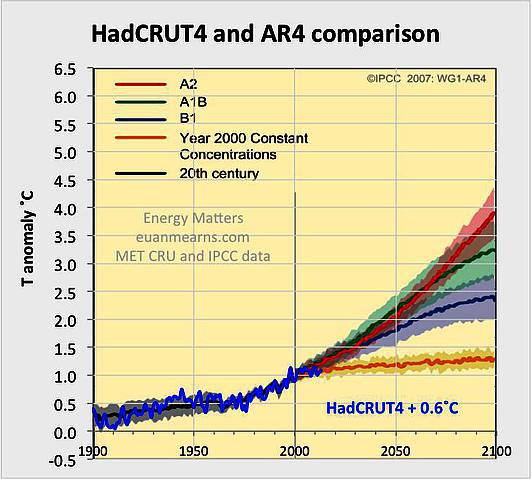

Abbildung 8*: Vergleich der AR 4-Modelle mit der Realität. Seit dem Jahr 2000 verläuft die Realität nahe der unteren Grenze der Modelle, wie von Roy Spencer und vielen anderen hervorgehoben worden ist. Falls überhaupt, passt die Realität zum Modell mit dem anthropogenen Antrieb Null, gezeigt in orange.

[*Siehe Anmerkung am Ende dieser Übersetzung!]

Beim vorigen Mal musste ich 0,6°C abziehen, um die Realität mit den IPCC-Modellen passend zu machen. Jetzt muss ich 0,6°C addieren, um auf das HadCRUT4-Werte zu kommen. Und der Luxus, die Historie ab dem Jahr 1850 abzubilden, wurde jetzt verkürzt und läuft ab dem Jahr 1900. Die Simulationen vor dem Jahr 2000 passen ziemlich gut zu den gemessenen Temperaturen seit 1940, obwohl wir schon wissen, dass es für die Simulationen vor 2000 unmöglich ist, durch eine große Anzahl unterschiedlicher Computer-Modelle erzeugt worden zu sein, die programmiert worden sind, um unterschiedliche Dinge zu tun – wie kann das sein? Nach dem Jahr 2000 scheint die Wirklichkeit am besten zur orangefarbenen Version zu passen ohne CO2-Anstieg/Modell ohne anthropogenen Antrieb.

Von 1900 bis 1950 reproduzieren die vermeintlichen Simulationen die Realität überhaupt nicht gut (Abbildung 9). Die tatsächliche Temperaturaufzeichnung zeigt einen steileren Gradienten als die Modellaufzeichnung. Und die Realität weist eine viel größere Variabilität infolge natürlicher Prozesse auf, die das IPCC in großem Umfang ignoriert.

Abbildung 9: Von 1900 bis 1950 bilden die vermeintlichen AR 4-Simulationen die Realität nur sehr unzureichend ab. HadCRUT4 in blau.

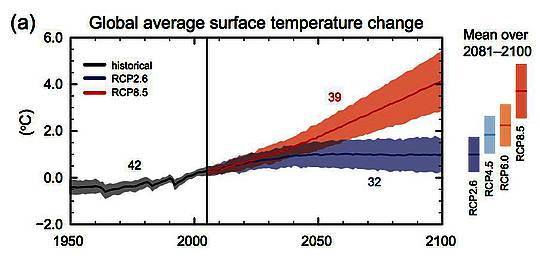

Abbildung 10: Die Sicht des IPCC aus dem AR 5 (2014). Die unbequeme Diskrepanz von 1900 bis 1950 aus dem AR 4 wird umgangen, indem man die Graphik einfach erst ab dem Jahr 1950 beginnen lässt. Die flache blaue Linie ist im Wesentlichen äquivalent zur flachen orangefarbenen Linie im AR 4.

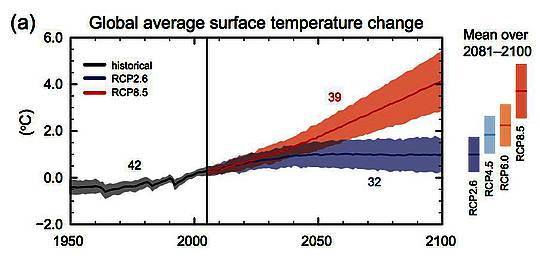

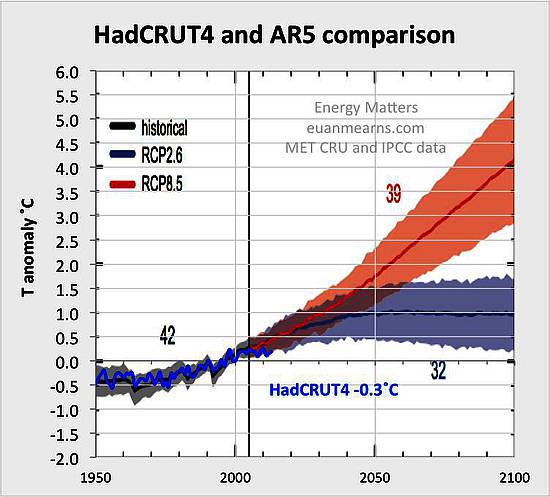

Der Fünfte Zustandsbericht AR 5 wurde in diesem Jahr veröffentlicht, und die gegenwärtige Sicht des IPCC auf die zukünftigen Temperaturen zeigt Abbildung 10 (6). Die unbequeme Diskrepanz von 1900 bis 1950 aus dem AR 4 wird umgangen, indem man die Graphik einfach erst ab dem Jahr 1950 beginnen lässt. Ein sehr einfaches Simulationsbild wird präsentiert. Zukünftige Temperatur-Trajektorien werden gezeigt für eine Bandbreite von repräsentativen Konzentrations-Verläufen [Representative Concentration Pathways (RCP)]. Dies ist das total falsche Verfahren, da das IPCC nicht mehr das Klima modelliert, sondern unterschiedliche menschliche, gesellschaftliche und politische Entwicklungen auswählt, die zu unterschiedlichen CO2-Trajektorien führen. Bei SkepticalScience werden diese Beschreibungen gezeigt (7):

RCP2.6 wurde entwickelt vom IMAGE-Modellierungs-Team der PBL Netherlands Environmental Assessment Agency. Der Emissions-Verlauf ist in der Literatur für Szenarien repräsentativ, die zu sehr geringen Konzentrationen von Treibhausgasen führen. Es ist ein „Spitzenwert-und-Abnahme“-Szenario [a “peak-and-decline” scenario]; das Niveau des Strahlungsantriebs erreicht zuerst einen Wert um 3,1 W/m² zur Mitte des Jahrhunderts und sinkt auf 2,6 W/m² bis zum Jahr 2100. Um dieses Niveau des Strahlungsantriebs zu erreichen, werden die Treibhausgas-Emissionen (und indirekt die Emissionen von Luftverschmutzern) substantiell mit der Zeit reduziert (Van Vuuren et al. 2007a)

UND

RCP8.5 wurde entwickelt mit dem MESSAGE-Modell und dem IIASA Integrated Assessment Framework durch das International Institute for Applied Systems Analysis (IIASA) in Österreich. Dieses RCP wird charakterisiert durch zunehmende Treibhausgas-Emissionen mit der Zeit, repräsentativ für Szenarien in der Literatur, die zu höheren Treibhausgas-Konzentrationen führen (Riahi et al. 2007).

Dies ist wissenschaftliche Sprechweise à la Micky Maus. Im Wesentlichen zeigen sie, dass 32 Modelle, programmiert mit einem geringen zukünftigen Emissions-Szenario niedrigere Temperatur-Trajektorien aufzeigen als 39 Modelle mit hohen zukünftigen Emissions-Trajektorien.

Die Modelle beginnen mit dem Jahr 2005 (der bessere Weg, den Beginn auf das Jahr 2000 zu legen wie im AR 4 wurde einkassiert), und von 1950 bis 2005 wird behauptet, dass 42 Modelle eine vernünftige Version der Realität abbilden (siehe unten). Wir wissen nicht, ob (wenn überhaupt) einige der 71 Modelle nach dem Jahr 2005 in der Gruppe vor 2005 enthalten sind. Wir wissen aber, dass die Gruppe vor 2005 aktuelle CO2-Konzentrationen zur Grundlage haben, und da sie alle eng beieinander liegen, müssen wir annehmen, dass sie alle ähnliche Klimasensitivitäten aufweisen.

Was der Leser wirklich sehen möchte ist, wie variierende Klimasensitivitäten die unterschiedlichen Modelle beeinflussen unter Verwendung fixierter CO2-Trajektorien, und das hat man eindeutig nicht getan. Die Modellierungsarbeit in Abbildung 10 ist effektiv wertlos. Nichtsdestotrotz wollen wir schauen, wie das im Vergleich zur Realität aussieht:

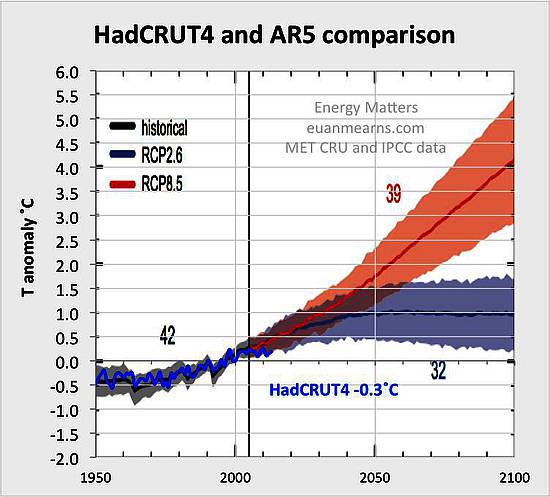

Abbildung 11: Vergleich der Realität mit Modellszenarien aus dem AR 5.

Mit Modellbeginn im Jahre 2005 haben wir nur 8 Jahre, um die Modelle mit der Realität zu vergleichen. Dieses Mal muss ich von HadCRUT4 0,3°C abziehen, um Übereinstimmung mit den Modellen zu erreichen. Vor 2005 bilden die Modelle vermeintlich die Realität seit 1950 ab. Vor 1950 wird uns eine Ansicht verwehrt, wie die Modelle damit aussahen. Nach 2005 ist klar, dass die Realität entlang der unteren Grenze der Bandbreite der beiden Unsicherheitsbereiche verläuft, die geplottet sind. Dies ist eine Beobachtung, die auch viele andere gemacht haben (z. B. 1).

Abschließende Kommentare

• Um Übereinstimmung der IPCC-Modelle mit der HadCRUT4-Wirklichkeit zu erzielen, müssen folgende Temperatur-Korrekturen angebracht werden: 1990 +0,5; 2001 -0,6; 2007 +0,6; 2014 -0,3. Mir fällt kein guter Grund ein, das Temperatur-Datum ständig zu ändern außer um eine Barriere vor der Verifikation der Modellergebnisse zu errichten.

• Der Vergleich der Modelle mit der Realität wird ernstlich behindert durch die armselige Art und Weise, wie das IPCC die Daten präsentiert. Im Jahre 1990 wurden sie noch korrekt gezeigt, das heißt, alle Modelle begannen ab 1850 zu laufen und zeigten die gleichen CO2-Emissions-Trajektorien. Die Variationen der Modellergebnisse werden konsequent durch physikalische Parameter wie der Klimasensitivität kontrolliert, und mit den seitdem vergangenen Jahren ist es geradlinig, die Modelle auszuwählen, die die beste Übereinstimmung mit der Realität zeigen. Im Jahre 1990 war ziemlich klar, dass es das „Low-Modell“ war, das fast mit Sicherheit auf eine geringe Klimasensitivität hindeutete.

• Es gibt keinen guten wissenschaftlichen Grund für das IPCC, heute nicht mehr das korrekte, im Jahre 1990 entwickelte Verfahren zu übernehmen außer dem, die Tatsache zu verschleiern, dass die Sensitivität des Klimas in bezug auf CO2 vermutlich deutlich unter 1,5°C liegt, basierend auf der Aussage von mir und anderen, dass eine Komponente der Erwärmung im 20. Jahrhundert natürlichen Ursprungs ist.

• Im Jahre 1990 hatte das IPCC eine Bandbreite von 1,5 bis 4,5°C als Klimasensitivität angegeben. 2014 war es immer noch eine Bandbreite von 1,5 bis 4,5°C. 24 Jahre sind vergangen, Milliarden Dollar sind ausgegeben worden, und absolut nichts wurde gelernt! Tomaten wurden auf die Augen von Politikern, Regierungen und der Öffentlichkeit geworfen bis hin zu einer totalen Gehirnwäsche. Billionen Dollar wurden fehlgeleitet und in die Energie-Infrastruktur gesteckt, die ultimativ zu weit verbreitetem Elend unter Millionen führen wird.

Falls eine kommerzielle Forschungsorganisation in UK der Verdrehung von Forschungsergebnissen überführt würde, nur um Geld zu verdienen und ohne Rücksicht auf die öffentliche Sicherheit, würde rasch die Polizei an deren Tür klopfen.

References

[1] Roy Spencer: 95% of Climate Models Agree: The Observations Must be Wrong

[2] Wood For Trees

[3] IPCC: First Assessment Report – FAR

[4] IPCC: Third Assessment Report – TAR

[5] IPCC: Fourth Assessment Report – AR4

[6] IPCC: Fifth Assessment Report – AR5

[7] Skepticalscience: The Beginner’s Guide to Representative Concentration Pathways

Link: http://wattsupwiththat.com/2014/06/12/the-temperature-forecasting-track-record-of-the-ipcc/

Übersetzt von Chris Frey EIKE

HINWEIS: Im Original ist die Nummerierung der Abbildungen offenbar durcheinandergeraten, taucht doch die Bezeichnung ‚Abbildung 7‘ zweimal hintereinander auf. Ich habe bei der Übersetzung die Nummerierung aber fortlaufend vorgenommen, aus der zweiten Abbildung 7 also die Abbildung 8 gemacht, und auch die folgenden Nummern angepasst. Im Text wird auf die Abbildungen Bezug genommen., und da bin ich nicht ganz sicher, ob die von mir korrigierte Zuordnung noch passt. Anm. d. Übers.