[*Das Wort ‚Energiewende‘ steht im gesamten Artikel immer auch so kursiv gesetzt im Original. Hier im Subheader wird eine Übersetzung angeboten als ‚energy turn‘ oder ‚energy transition‘. Anm. d. Übers.]

Aber für Deutschland ist dies viel mehr als nur nationale Energiepolitik. Dies ist Deutschlands Apollo-Weltraumprogramm. Falls es funktioniert, wäre Deutschland weltweit führend bei der Integration von Erneuerbaren mit einer potentiellen Multi-Milliarden Euro umsetzenden Exportindustrie. Aber anders als die grundlegende technische Herausforderung, einen Menschen den Mond betreten zu lassen, steht die Energiewende vor beispiellosen Herausforderungen weit jenseits des rein technischen Aspektes. Der Lebensstandard einer Nation basiert auf dem Kapital und der Arbeitsproduktivität seiner Energiesysteme zusammen mit einer hinreichend hohen Gesamtenergie.

Während der geplante Rückzug aus der Kernkraft in Deutschland nach Fukushima im Grunde eine Überreaktion war vor dem Hintergrund des fehlenden Risikos von Erdbeben und Tsunamis, bildete sich die deutsche Ambivalenz gegen Kernkraft seit den siebziger Jahren. Die Studentenproteste Ende der sechziger Jahre erzeugten einen Zusdammenschluss von Anti-Amerikanismus, Anti-Kapitalismus und Anti-Kernkraft, wobei die Kernkraft im Zentrum des Argwohns gegen Kapitalismus und Militarismus stand. Das Symbol der „lachenden Sonne“ tauchte überall auf – Atomkraft? Nein Danke* – und wurde als ein Ausdruck „politischer Abweichung“ angesehen, wurde es doch cool, gegen Kernkraft zu sein.

[*Auch dieser Begriff taucht kursiv so im Original auf. Angeboten wird die Übersetzung ‚Nuclear power? No thanks!‘ Anm. d. Übers.]

Dieses Zusammentreffen kam nicht überraschend – die Altlast des Holocaust und des Zweiten Weltkriegs, West Berlin [in dieser Schreibweise!] als Mittelpunkt des Kalten Krieges, wobei in Deutschland [hier meint der australische Autor die BRD] Cruise Missiles und Pershings der NATO stationiert waren zusammen mit amerikanischen, britischen und französischen Truppen. Diese Befürchtungen manifestierten sich durch Anti-Kernkraft-Aktivismus durch Wissenschaftler wie Klaus Traube. Traube, der ursprünglich ein Befürworter der Kernkraft war, wurde zu einem der prominentesten und einflussreichsten Kritiker (1). Und es waren auch ‚lokale Bürgerinitiativen‘, die sich um lokale Themen bildeten und die später die Grundlage der Grassroots-Kampagnen ausmachten wie die Opposition gegen den Standort eines neuen Kernkraftwerkes in der Weinanbau-Stadt Wyhl im Jahre 1975 (2)

Die australische Anti-Kernkraft-Bewegung hatte ähnliche Wurzeln und war aus einer Protestbewegung der sechziger Jahre hervorgegangen, jedoch mit ausschließlichem Bezug auf Australien (3). Das war die Zeit des Vietnam-Krieges, den Landrechten der Aborigines, den französischen Kernwaffentests auf dem Mururoa-Atoll, der Nachwirkungen der Maralinga-Waffentests [?] und auch die Zeit des Links-Helden [hero of the left] Gough Whitlam. Es war auch die Zeit vor der funktionellen Trennung von staatlich geförderten Waffenprogrammen und kommerziellen Kernkraft-Anbietern – die Wahl des British Steam Generating Heavy Water Reactor (SGHWR) für das in Jervis Bay geplante Kernkraftwerk (NPP) Ende der sechziger Jahre zusammen mit dem Widerstand gegen die Unterzeichnung der Nichtverbreitung von Kernkraft zeigte eine Strategie der Erhaltung einer Zukunftsoption für alle Möglichkeiten.

Nach der Übernahme der Regierung im Jahre 1972 unterschrieb Whitlam das Nichtverbreitungsabkommen von Kernwaffen (NPT), stoppte Kernkraft und führte neue Bildungsstandards ein. Plötzlich war es in akademischen Kreisen und der politischen Linken „in“, gegen Kernkraft zu sein. Diese frühere Periode legte den Grundstein für Australiens Anti-Kernkraft-Maßstäbe, die Jahrzehnte lang eine nicht in Frage gestellte Doktrin geblieben ist. Ende der neunziger Jahre führte Jim Green (5) den Begriff „Strahlungs-Rassismus“ [radiation racism] ein, unter dem sich grün-linker Aktivismus, Uran-Bergbau, Landrechte der Aborigines, Waffentests und Kernkraft einfanden. Dies verkörpert dieses andauernde, aber inzwischen archaische Narrativ.

Aber es war die unkontrollierte Freisetzung radioaktiver Strahlung infolge der Kernschmelze des mit Graphit moderierten Tschernobyl-Reaktors, die in Deutschland die Anti-Kernkraft-Stimmung aufkommen ließ. Anders als in anderen betroffenen Nationen, in denen die Anti-Kernkraft-Stimmung während der folgenden Jahre pragmatischeren Erwägungen wich, war die Reaktion in Deutschland sowohl irrational als auch nachhaltig. Selbst noch nach der Veröffentlichung des UNSCEAR-Berichtes 2011, in dem gezeigt worden ist, dass die Auswirkungen der Strahlung sich als viel harmloser herausstellten als ursprünglich befürchtet (6), blieb in Deutschland der tiefe Skeptizismus bestehen. Außerdem, obwohl die Welt-Gesundheitsorganisation zu dem Ergebnis gekommen war, dass die gesundheitlichen Auswirkungen durch die Strahlung in Fukushima minimal sind (7), verfestigte sich der deutsche Skeptizismus hinsichtlich Kernkraft. Nachfolgende Berichte enthüllten die institutionalisierte Kultur regulatorischer Vorschriften in Japan, bekannt unter dem Begriff amakudari, wörtlich übersetzt “descent from heaven” [aus dem Himmel kommend]. Hierbei ziehen sich leitende Gesetzgeber und Bürokraten auf die mächtigen exekutiven Posten zurück, die sie einst reguliert hatten (8). Die Konsequenz des „nuklearen Dorfes“ war, dass man Risiken unangemessen durch Operatoren begegnete und dass sich herausstellte, dass man routinemäßige Sicherheitsmaßnahmen, wie sie beispielsweise in den USA herrschen, einfach nicht implementiert hatte (9).

Obwohl die Gefühle zu Kernkraft in Europa zwiespältig sind, lautet die interessante Frage: Was ist anders in Deutschland im Gegensatz zu – sagen wir – Frankreich, wo man 75% des Strombedarfs durch 58 Kernkraftwerke deckt? Französische Politiker haben die Zielkonflikte der Energiepolitik verstanden. Dort fehlen die in Deutschland heimischen Kohlevorräte, und man führte eine starke institutionelle Unterstützung an, untermauert durch öffentliche Unterstützung. Eine populäre Antwort in Frankreich auf die Frage, warum sie dort so viel Kernkraft-Energie erzeugen, lautet: „Kein Öl, kein Gas, keine Kohle, keine Wahl“. In Frankreich gibt es eine Tradition großer, von der Regierung gemanagter Projekte, die genauso populär sind wie Hochgeschwindigkeits-Züge (10). Anders als das US-Modell dezentralisierter Projekte standardisierte das französische Modell einen einzelnen US-Reaktor, zusammen mit standardisierter Übung und Sicherheit.

Aber vielleicht ist die entscheidende Antwort dem Erbe der ausgeprägten Reaktion in Deutschland auf die industrielle Revolution des 19. Jahrhunderts geschuldet, die eine eigentümliche Synthese von Naturalismus und Nationalismus erzeugte (11). UK war gegen die härteren Elemente der industriellen Revolution immunisiert durch die „protestantische Arbeits-Ethik“ [the „protestant work ethic“]; die USA und Australien als Pionier-Nationen nutzten die Kraft von Dampf und Kohle für die Bildung einer Nation, und in Frankreich fehlte eine geeignete Kohlequelle. Aber eine ausgeprägte Vorliebe der Deutschen für Natur, ländliches Leben und Wälder trieb eine kulturelle Gegenreaktion vor sich her – die Romantische Bewegung [Romantic Movement] war eine Revolte gegen die rationale und strukturierte Welt der Industriellen Revolution (12). Diese Ideale waren enthalten in der völkischen Bewegung, für welche es keine einfache englische Übersetzung gibt*, sondern die lose die Gedanken eines romantischen Nationalismus‘ und Heimatgefühl verkörpert (13).

[Im Original liest sich das so: ‚ These ideals were embodied in the völkisch movement, which has no simple English translation, …’]

Der deutsche Philosoph Martin Heidegger (14) bietet einen Ansatzpunkt zur Hervorhebung einiger dieser Ideale Ende des 19. und Anfang des 20. Jahrhunderts in Gestalt eines proto-umweltlichen Denkens in Deutschland. Heidegger äußerte Kritik an den Gedanken der Aufklärung und der wissenschaftlichen Revolution. Er behauptete, dass die Wissenschaft die natürliche Landschaft zu „Zeug“ und einer „stehenden Reserve“ für die Menschheit degradiert. Heideggers Problem war der fehlende Respekt für die Natur – seine Hauptsorge war nicht Verschmutzung, Abwertung oder Grenzen des Wachstums, wie neuzeitliche Neo-Malthusianer sagen würden, sondern die reduktionistische Beziehung zwischen den Menschen und ihrer Welt. Diese zutiefst ökologischen Standpunkte fanden sich ähnlich auch bei Ernst Moritz Arndt und seinem Schüler Wilhelm Heinrich Riehl, die beide gegen die industrielle Ausbeutung von Wäldern und Boden (11) mobil machten. In den fünfziger Jahren des 19. Jahrhunderts war Riehl vielleicht der Vorläufer des modernen Umweltaktivismus‘, wenn er „für die Rechte der Wildnis“ eintrat. Sowohl Arndt als auch Riehl repräsentierten eine besondere deutsche Fusion von Naturalismus und Nationalismus und waren dem Urbanismus gegenüber feindlich eingestellt. Klaus Bergmann benutzte den Term Großstadtfeindschaft*, der sich grob übersetzen lässt mit „hostility to the City“ oder „anti-urbanism“. Er spiegelt die Ablehnung der kosmopolitischen, internationalen und kulturellen Toleranz von Städten.

[*Steht ebenfalls so im Original!]

Die Australier haben wahrscheinlich eher von Rudolf Steiner und seiner berühmten „Steiner-Bildung“ [= Waldorf-Pädagogik] gehört. Steiner vermischte rassistische Ideologie mit seiner einzigartigen spirituellen Anthroposophie-Bewegung und entwickelte eine frühe Form einer ganzheitlichen „vitalistischen“ organischen Landwirtschaft, Biodynamik genannt (11). Biodynamik betrachtet die Fruchtbarkeit des Bodens und das Pflanzenwachstum als ökologisch in Wechselwirkung stehende Dinge – tatsächlich war der Ausdruck „Ökologie“ zuerst von dem deutschen Wissenschaftler Ernst Haeckel definiert worden. Selbst heute noch findet fast die Hälfte der globalen biodynamischen Landwirtschaft in Deutschland statt (12).

Im Deutschland zu Anfang des 20. Jahrhunderts gab es keine spezifische Bewegung, die als „umweltlich“ oder „grün“ etikettiert war, so wie wir es heute definieren. Vielmehr haben Organisationen wie der Deutsche Bund Heimatschutz (Homeland Protection Association of Germany) die Gedanken von Heimat- und Naturschutz verkörpert*. Sie standen für die Ideale des Schutzes der deutschen Heimat und der Landschaft. Brüggemeier et al. (15) erklären: in der gleichen Weise, wie wir über die architektonischen Eigenschaften denken, die die Vorlieben einer Nation reflektieren, enthielt die Landschaft Deutschlands den ausgeprägten deutschen Fußabdruck.

[Wieder das Original: ‚ the Deutscher Bund Heimatschutz (Homeland Protection Association of Germany)’]

Führend bis in die dreißiger und vierziger Jahre fanden diese Ideale Eingang in Nationalen Sozialismus, am meisten kontrovers vielleicht mit der Behauptung von Anna Bramwell (16), dass die Nazi-Partei einen „grünen Flügel“ habe. Brüggemeier (15) und andere stehen solchen Polemiken kritisch gegenüber, welche kontrovers eine einfache lineare Beziehung der heutigen Grünen zu den gestrigen nationalsozialistischen Umweltaktivisten implizieren. Trotzdem haben viele Gelehrte die offensichtliche Überlappung zwischen den Zielen der Nationalen Sozialisten und der Umweltaktivisten in der ersten Hälfte des 20. Jahrhunderts diskutiert. Die Umweltschutzbewegung in Deutschland war mächtiger und beweglicher als irgendwo sonst in Europa, und die diktatorische Macht der Nazis bot Gelegenheiten, Umwelt-Agenden zu implementieren.

Aber man könnte auch in dem Begriff Energiewende den Ausdruck Heimat (homeland) identifizieren, das „Gefühl zusammen zu gehören“ und den kommunitaristischen [?] Impulsen (17). Dies ist vielleicht die wichtigste Lektion politischer Gemeinde-Bewegungen – die Energiewende ist ein erstaunlich erfolgreiches Modell mit umfassender Unterstützung des politischen Rechts/Links-Spektrums. Deutschland ist einzigartig bei der Mobilisierung der Grassroot-Bewegung der siebziger und achtziger Jahre und konvertierte diese Unterstützung in greifbare politische Ergebnisse.

Auf einer philosophischen Ebene sehen wir die Ausdrücke Solar und nuklear als polarisierende Gegensätze des Romantik- mit dem Aufklärungs-Spektrum – solar (und Wind) als Rückkehr zum einfacheren Weg, unter Einbeziehung der Natur, und einem zeitgenössischen Ausdruck des archetypischen Instinktes der Anbetung der Sonne – wohingegen nuklear steht für die Höhepunkte von Wissenschaft, Empirismus und der Abschöpfung der unvorstellbaren Kraft des Atoms mit den begleitenden Risiken. Diese miteinander im Wettbewerb stehenden Philosophien koexistieren in allen Ländern, aber nur in Deutschland ist diese Polarität so krass an das Romantik-Ende des Spektrums gefallen. Aber der erstaunliche Erfolg von solar liegt auch begründet in den Idealen des einfacheren Weges, und durch den „hellgrünen“ Umweltaktivismus werden die Gedanken von Sonne und Wind verschmolzen mit dem Techno-Optimismus der Informationstechnologie und einer Silikon-Revolution.

Angesichts des starken vorübergehenden Zusammengehens der politischen Linken mit Umweltwerten kann die deutsche Erfahrung ungewöhnlich scheinen. Und doch, in der jüngeren Geschichte der anglophilen Länder waren konservative Werte öfter mit traditionellen konservativen politischen Werten verbunden, während die Linksaußen-Tradition ein Evangelium des Überflusses gepredigt hat und die Reduktion von Armut durch wirtschaftliches Wachstum (18). Zum Beispiel war es der republikanische Präsident Richard Nixon, der eine Reihe von Umweltinitiativen übersah, die die Grundlage des amerikanischen Umweltschutzes bildeten. In Australien waren die sechziger und siebziger Jahre eine Periode, als die konservative Seite der Politik häufig umweltliche Initiativen übernahm. In Victoria wurde das grundlegende Environmental Protection Act erlassen [ein Umweltschutzgesetz], und zwar während der Regierungszeit des liberalen Premierministers Henry Bolte. Und es war Alan, der Vater von Greg Hunt, der unter Bolte, Hamer und Thompson im Amt war. Er trieb die ‚Green Wedges urban strategy’ in den Vororten von Melbourne (20). Im größten Teil des 20. Jahrhunderts waren es oftmals die Jäger und Freizeit-Angler, die am stärksten den Schutz von Wäldern und Flüssen unterstützten. Selbst die australische Conservation Foundation wurde gegründet, und der Konservative Sir Garfield Barwick diente als Präsident.

Es ist möglich, zwei getrennte Zeiträume zu identifizieren, als traditionelle konservative Werte und moderner Umweltaktivismus auseinanderliefen. Die Erste Periode war eine Reaktion auf das neo-malthusianische Buch The Population Bomb von Paul und Anne Ehrlich. Wie Sabin in (21) anmerkte, stammte vieles der Antagonismen von der politischen Rechten von der katastrophalen Zukunft, die Bevölkerungs-Campaigner wie Ehrlich an die Wand malten. Unter der Reagan-Administration erreichte dies eine Apotheose. Der zweite Zeitraum war die Reaktion auf Kyoto 1997, welches die Energieunternehmen explosionsartig aktiv werden ließ, sich geschlossen gegen eine globale Reaktion auf die Klimaänderung zu stellen (22).

In Australien war es die Frustration der Umwelt-Linken über den Klimaskeptizismus der Regierung Howard und die „Treibhaus-Mafia“ (23, 24) während der neunziger Jahre und des ersten Jahrzehnts dieses Jahrhunderts, die den Schwall fragmentierter und ultimativ ineffektiver Treibhaus-Politik trieb. Das Grattan Institute (25) identifizierte 300 Maßnahmen der Treibhaus-Politik, wobei lediglich eine Handvoll marktbasierter Instrumente ein erstrebenswertes Ergebnis zeitigte.

Wohl das signifikanteste Einzel-Scheitern der australischen Klimapolitik bleibt die Ablehnung der Vorschläge von Robert Hill für einen moderaten Kohlenstoff-Preis nach Kyoto durch die Regierung Howard. Mit grausamer Ironie wäre ein moderater, einkommensneutraler Kohlenstoffpreis, der sowohl die Unsicherheiten der Klimaänderung als auch globales Engagement reflektierte, ein weit effektiveres und flexibleres Instrument gewesen. Außerdem hätte das viel besser zu Prinzipien der Liberal Party gepasst. Zumindest hätte es eine stabile Basis für eine kohärente Klimapolitik gebildet, während die kostspieligen und unzusammenhängenden Maßnahmen vermieden worden wären, die wir bis heute erlebt haben.

Und doch wurde das von der Regierung Howard eingeführte Ziel erneuerbarer Energie zu einem Modell-Schema für Förderung von Erneuerbaren, obwohl es die ursprüngliche Absicht der Politik war, die lokale Entwicklung sowie Industrie und Innovationen voranzubringen und nicht das Aufbringen gewaltiger Subventionen für importierte Windenergie (26). Die Schwierigkeit besteht darin, dass – einmal in Kraft gesetzt – eine ganze Industrie von Kapitalgesellschaften, Gutachtern und Lobbygruppen entstanden ist, die sich auf das RET [?] verließen, da die sich selbst erhaltende industrielle Entwicklung einfach nicht zustande kam. Wir erleben das auch in Deutschland, wo Karrieren erzeugt worden sind, die abhängig sind von fortlaufender institutioneller Unterstützung für Erneuerbare. Die Krux ist, dass die australische Klimapolitik nur dann langzeitlich glaubwürdig ist, wenn sie von der Liberal/National Party begrüßt wird; aber die Kernkraft kann nur erfolgreich sein, wenn sie als eine der zentralen Punkte von Low-Carbon-Energie eingeführt wird, falls sie von der Labor Party übernommen wird.

Die langfristige Konsequenz dieses Scheiterns von politischen Maßnahmen auf breiter Basis war es, verzweifelte Versuche anzuführen, Australien in Mainstream-Klimamaßnahmen einzubinden. Da die ökonomisch Rechte diese Rolle abgeschafft hat, wurde das resultierende politische Vakuum von Narrativen der Umwelt-Grün-Linken dominiert. Und dies bedeutete, sich dem Mekka der Klimapolitik zuzuwenden: Deutschland.

[Hier wird natürlich endgültig deutlich, warum man sich in Australien so grundlegend und umfassend Gedanken über Deutschland in dieser Hinsicht macht! Anm. d. Übers.]

Es ist interessant, wie sehr die Sprache des deutschen Umweltaktivismus’ den Weg in das Narrativ der australischen Umweltaktivisten gefunden hat. Ein Schlüsselbeispiel hierfür ist die Übernahme des FiT-Solarmodells und das damit verbundene Konzept „demokratisierter Energie“. Obwohl die erste Form von Einspeisetarifen in den USA unter der Carter-Administration implementiert worden ist, war es das deutsche Modell, das zur Vorlage für kleinteilige Unterstützungs-Mechanismen seit den neunziger Jahren geworden ist. Dies ging einher mit dem Konzept demokratisierter Energie, welche durch grüne Gruppen und Befürworter von Solarenergie nach Australien importiert worden ist.

Was den Demokratie-Gedanken in einem australischen Zusammenhang so interessant macht ist, dass es kaum Präzedenzfälle für das Konzept in Relation zu Energieversorgern und öffentlichen Dienstleistungen gibt – tatsächlich bevorzugen die Australier allgemein sozialisierte öffentliche Dienste (wie Medicare), und der langfristige Trend für Haushalte und Gewerbe ist es, Dienste auszulagern anstatt sie „demokratisch“ ins Haus zu bringen (man denke an Rasen mähen, Autowartung, Anlieferungen nach Hause, Gesundheitsfürsorge). Es ist für einen Haushalt zum Beispiel leichter, hinsichtlich der Wasserversorgung „netz-unabhängig“ zu sein, und doch diskutiert niemand die „Demokratisierung von Wasser in den Vororten“. Selbst falls man einen berechtigten finanziellen Grund für netz-unabhängige Energie geltend machen kann, gibt es wenig Hinweise darauf, dass die meisten Menschen, abgesehen von Enthusiasten, darauf vorbereitet sind, die Verantwortung für die Wartung von Batterien und deren Ersatz zu übernehmen ebenso wie für Backup-Erzeugung und Systemwartung.

Im Gegensatz dazu wird die Demokratisierung von Personentransporten – Autos – stark von grünen Gruppen kritisiert, die sich stattdessen für das sozialisierte Modell städtischer Transporte einsetzen – Eisenbahnen und öffentlicher Verkehr. Daran kann man erkennen, dass das „Demokratisierungs“-Modell ein opportunistischer Sprachgebrauch ist – Demokratie wird übernommen als ein universeller Wert und in Verbindung gebracht mit einer wertebeladenen Ursache, anstatt ein kohärentes Argument zu präsentieren. Und doch wird die unmoderne Sprache „sozialisierter“ Modelle oder „sozialisierter“ Tarife sorgfältig vermieden. Interessanterweise sind in den Staaten mit dem erfolgreichsten Betrieb von Kernkraft und deren Akzeptanz diese Staaten am stärksten in Strom involviert – Frankreich, Schweden, Japan, Russland und China.

Dieser Sprachgebrauch ist vorherrschend in Diskussionen über die erneuerbare Revolution. Zum Beispiel wird der Begriff „sporadisch“ [intermittent] häufig ersetzt durch „variabel“ oder VRE (variable erneuerbare Energie), hat doch „variabel“ den Beiklang von Anpassung, Volumen oder Kontrolle. Wir könnten vielleicht den genaueren Term „unkontrollierbar variabel“ an Stelle von „sporadisch“ verwenden, aber natürlich würde diese verbesserte sprachliche Genauigkeit kontraproduktiv für jene sein, die nach dem Ausbau sporadischer Energie trachten.

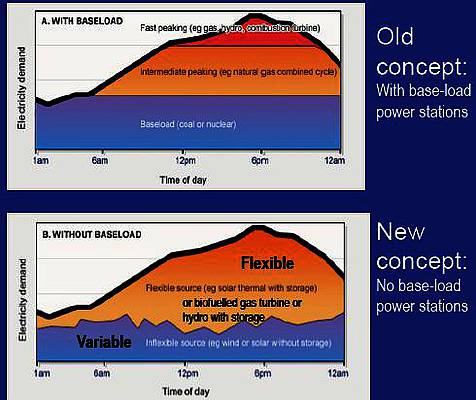

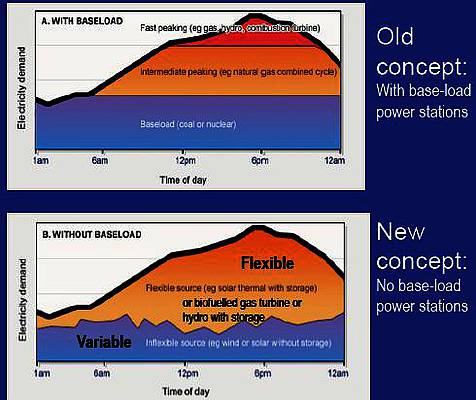

Ein weiteres heimisches Beispiel ist der so genannte „Grundlast-Mythos“ [base load myth] und der Gedanke, dass „Sporadität auch Grundlast sein kann“. Dies wurde zum ersten Mal von Mark Diesendorf (27) in Australien verbreitet, aber rasch von der Umweltgemeinde aufgenommen. Dies demonstriert eine Korrumpierung eines etablierten technischen Jargons mit dem Ziel zu verwirren anstatt zu klären. Und doch ist selbst hier die Korrumpierung der Sprache hoch spezifisch – Grundlast im Zusammenhang mit Kohle und Kernkraft wird als unnötig, ineffizient und verschwenderisch bezeichnet, im Zusammenhang mit konzentrierter Solarenergie oder geothermischer Energie aber als vernünftig proklamiert.

Hier sehen wir das Kohle/Kernkraftmodell verleugnet zugunsten von „verteilter Erzeugung“, doch war das Grundlast-Modell der Energieversorgung bemerkenswert widerstandsfähig und ein effektives Modell, um die Gemeinde zuverlässig und bezahlbar mit Energie zu versorgen. Dies ist kein Argument gegen die Erkundung alternativer oder Verbesserung bestehender Modelle. Tatsächlich verdienen jüngste Bedenken hinsichtlich steigender Kosten und der Abnahme des Nutzungsgrades infolge Air Conditioning größere Aufmerksamkeit. Trotzdem ist das zentralisierte Modell bemerkenswert effizient hinsichtlich von Verteilungs-Verlusten zwischen Kraftwerk und Verbraucher im Mittel um 6% (28), aber die Verluste zwischen Solarpaneel und Stromwandler-Output durch Widerstands-Verluste, Stromwandler-Konversion, Staub und Temperaturminderung betragen typischerweise 18% (29). Es ist also offensichtlich, dass es beim Narrativ „ineffizienter“ zentralisierter Grundlast im Gegensatz zu den Werten der „verteilten Erzeugung“ mehr um brandmarken geht als um ein bedeutsames Statement mit Substanz.

Aber würde es wirklich funktionieren?

Perverserweise wird die Demokratisierung des Netzes manchmal auch mit der Sprache sozialer Gerechtigkeit beschrieben, obwohl dies eine Umkehr der Logik ist – Ein Exodus in großem Umfang aus dem Netz würde zum Dilemma geringerer Profite als Grundlage für die hohen Fixkosten der Netzwerke führen, was den Haushalten mit niedrigem Einkommen, Rentnern, Pensionären, Schulen, Krankenhäusern und anderen Einrichtungen eine viel höhere Kostenlast auferlegen würde. In Deutschland, Spanien und UK ist Energiearmut bereits zu einem ernsten sozialen Problem geworden. Außerdem hat ein Photovoltaik-System außerhalb des Netzes eine Gesamt-Energieausbeute während seiner Lebenszeit von wenig mehr als einer Einheit [little better than unity]. Dies impliziert, dass die Versorgung einer Gemeinde außerhalb des Netzes ökonomisch und umweltlich katastrophal wäre. Also wurden die Themen der Demokratisierung, sozialer Gerechtigkeit und verteilter Energie von Deutschland importiert und von den Grün-Linken für ihre universellen Werte übernommen. Und doch führen sie etwas an, das Frank Furedi „hoch gehaltene oberflächliche Meinungen“ nennt [shallow opinions held strongly]

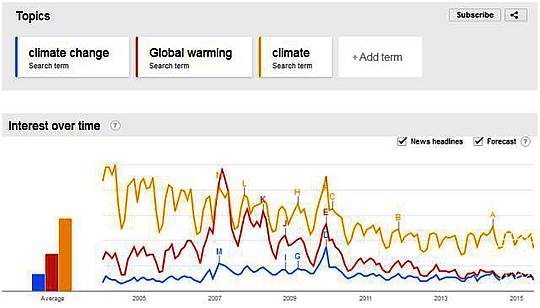

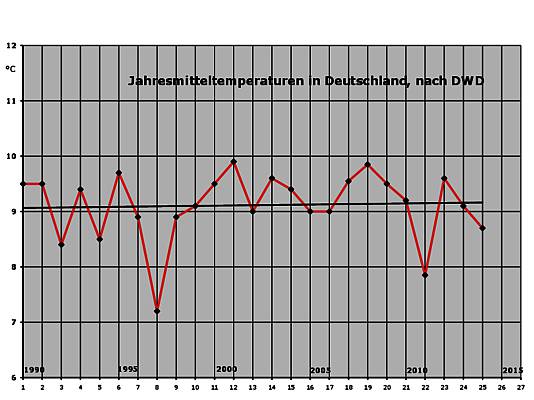

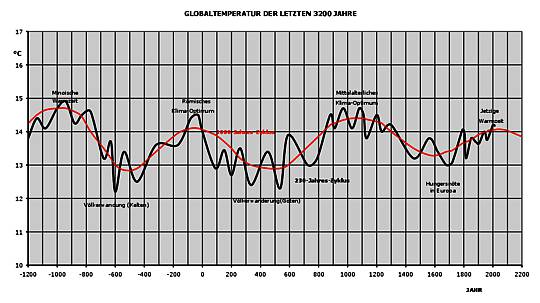

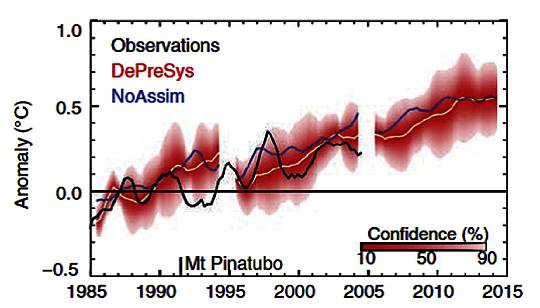

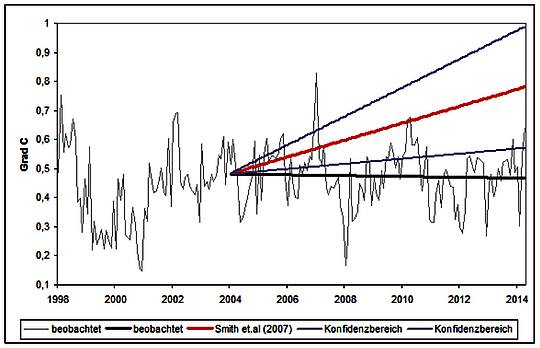

Aber trotz dieser Dinge verbleibt ein Triumph über die Energiewende, der völlig fehl am Platze ist. Tatsächlich tendiert die Konzentration auf Wachstumszahlen dazu, vorbestimmte Glauben [beliefs – Plural] zu validieren anstatt als Grundlage für eine gründliche Analyse zu dienen. Kürzlich wurde ein neuer Rekord für die augenblickliche Durchdringung von Wind und Solar in Deutschland verkündet (30) – am 11. Mai 2014 um 13 Uhr erreichte der Anteil von Wind und Solar 67%. Und doch ist die Folge hiervon zu demonstrieren, dass Deutschland bereits kurz davor steht, an harte Integrations-Grenzen zu stoßen – das nächste Stadium der Integration wird umfängliche und teure Speicherung sein oder Energie als Müll zu entsorgen.

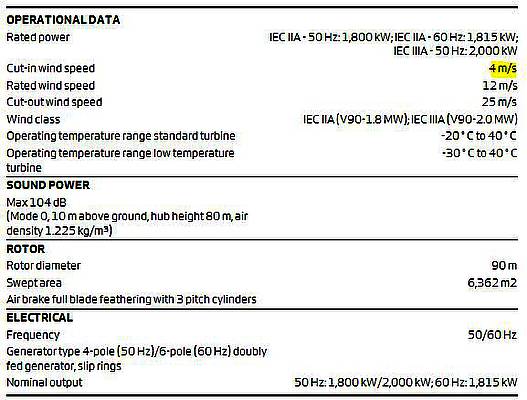

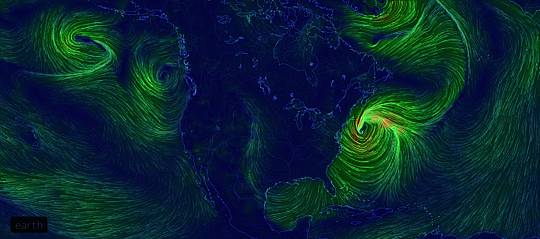

Der jährliche Beitrag von Wind und Solar beträgt jeweils etwa 8% bzw. 6%, trotz des manchmal unmittelbar auftretenden Beitrags, der sechsmal so hoch ist wie dieses Niveau. Während des Sommers werden 40% des PV-Stromes bereits exportiert (31). Aber diese Exportstrategie kann nicht europaweit funktionieren, weil alle Länder zur gleichen Zeit danach trachten, Strom zu exportieren. Das mitteleuropäische Netz überspannt lediglich 17 Längengrade, was im Wesentlichen dazu führt, dass der tägliche Spitzenwert in jedem Land innerhalb oder in etwas mehr als einer Stunde auftritt (32). Große, sich nur langsam verlagernde europäische Tiefdrucksysteme erzeugen in ähnlicher Form hoch korrelierte Windmaxima im gesamten synchronen Netz. Dies sind keine Argumente gegen den Einschluss zeitweiliger Kraftwerke mit einer umfassenden Low-Carbon-Strategie – tatsächlich gibt es Bedingungen, unter denen zeitweilige Kraftwerke nützliche Treibstoffersparnisse bringen können – sondern beleuchten die fundamentalen Hindernisse, wenn man sich auf Energiequellen verlässt mit einem Kapazitäts-Faktor um 18% bzw. 10%. Diese Zahlen sind weitgehend immun gegen Technologie.

Der Triumph der Energiewende ist wirklich ein klassischer Fall, das falsche Ziel anzusprechen – die Messung der installierten erneuerbaren Kapazität oder der jährlich erzeugten Energie sagt wenig bis nichts über die Gesamtauswirkungen auf Treibhausgas-Emissionen, Energiesicherheit, stetige Zuverlässigkeit oder soziale Gerechtigkeit. Genauso könnten wir den Erfolg eines Football-Clubs mit der Anzahl der unbestrittenen Ballbesitze im ersten Viertel definieren. Und tatsächlich, trotz der starken politischen, sozialen und ökonomischen Unterstützung für Wind und Solar seit den neunziger Jahren bleibt der CO2-Ausstoß bei der deutschen Stromerzeugung stur 10 bis 20 mal höher als in den in dieser Hinsicht am besten abschneidenden Nationen in Europa (33), und keinem der definierten Ziele ist man merklich näher gekommen (34). Es ist schwierig, schon jetzt Schlussfolgerungen wie z. B. hinsichtlich der makroökonomischen Auswirkungen der Energiewende in Deutschland zu ziehen, aber als der unwillige Hegemon Europas hat Deutschland bisher nur gezeigt, dass ausreichend Reserven zur Verfügung stehen, um die ökonomischen Schwierigkeiten zu vermeiden, zu denen es in Spanien mit seinem PV-Programm gekommen war.

Eine großartige Anekdote aus dem Buch The Innovation Paradox (35) von Farson und Keye beschreibt vielleicht Deutschlands Energiewende-Dilemma am besten. Dort hat ein Junior-Direktor 10 Millionen Dollar verloren bei einem riskanten Venture während der frühen Jahre von IBM. Darauf hat der geschäftsführende Direktor von IBM Tom Watson Jr. sein Angebot zurückgewiesen zurückzutreten, und zwar mit der Bemerkung: „Sie können das nicht ernst meinen. Wir haben gerade 10 Millionen Dollar für Ihre Weiterbildung ausgegeben!“

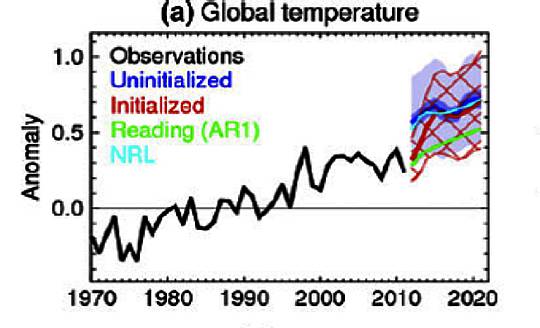

Vielleicht lautet die Frage hinsichtlich der Energiewende nicht, ob die festgesetzten Ziele erreicht werden oder nicht, sondern ob es ein Reale-Welt-Fall der Grenzen der Energiedichte und Periodizität ist, wenn eine wohlhabende, technologisch fortschrittliche und absolut überzeugte Nation alles in Frage stellt. Die jüngsten Signale von Kanzlerin Angela Merkel und Vizekanzler Sigmar Gabriel scheinen auf eine heraufdämmernde Erkenntnis zu deuten, dass die Realität langsam an Raum gewinnt (36).

[Schlussbemerkung des Übersetzers: Bei der Übersetzung dieses in australischem Englisch geschriebenen Artikels hatte ich manchmal größere Schwierigkeiten. Offenbar gibt es doch gewisse Unterschiede zu US-amerikanischem Englisch, das mir viel vertrauter ist.]

References

[1] Johnson, Daniel, (2011), Why Germany said no to nuclear power, The Telegraph

[2] Brandon, Ruth (1987) The Burning Question: The Anti-Nuclear Movement Since 1945, Heinemann.

[3] Zoellner, Tom (2009) Uranium: War, Energy, and the Rock That Shaped the World, Penguin.

[4] Cawte, Alice (1992) Atomic Australia, Sydney, NSW, Australia: New South Wales University Press.

[5] Green, Jim, (1999) Radiation Racism, Green Left Weekly

[6] World Health Organisation (2011) Chernobyl at 25th anniversary Frequently Asked Questions

[7] World Health Organisation (2013) Health risk assessment from the nuclear accident after the 2011 Great East Japan earthquake and tsunami, based on a preliminary dose estimation

[8] Fam, SD et al. (2014) Post-Fukushima Japan: The Continuing Nuclear Controversy. Energy Policy

[9] Ferguson, Charles D, Jansson, Mark (2013) Regulating Japanese Nuclear Power in the Wake of the Fukushima Daiichi Accident. Federation of American Scientists

[10] Palfreman, Jon (1997) Why the French like Nuclear Power, PBS Frontline

[11] Staudenmaier, Peter/Biehl, Janet (1995) Ecofascism: Lessons From the German Experience.

[12] Paull, John (2011) Organics Olympiad 2011: Global Indices of Leadership in Organic Agriculture. Journal of Social and Development Sciences 1/4, pp. 144–150.

[13] Uekötter, Frank (2006) The Green and the Brown: A History of Conservation in Nazi Germany, Cambridge University Press.

[14] Rohkrämer, T in Brüggemeier, Franz-Josef/Cioc, Mark/Zeller, Thomas (2005) How Green Were the Nazis?: Nature, Environment, and Nation in the Third Reich, Ohio University Press.

[15] Brüggemeier, Franz-Josef/Cioc, Mark/Zeller, Thomas (2005)How Green Were the Nazis?: Nature, Environment, and Nation in the Third Reich, Ohio University Press.

[16] Bramwell, Anna (1985) Blood and Soil: Richard Walther Darré and Hitler’s” Green Party”, Kensal Press Abbotsbrook, Bourne End, Buckinghamshire.

[17] Applegate, C. (1990). A nation of provincials: The German idea of Heimat. Univ of California Press.

[18] O’Neill, Brendan (2014) There’s nothing left wing about being green, Spiked Online

[19] Palmer, Graham (2010) A Battle of Interests: The Conservative Rejection of Climate Change. Dissent Autumn/winter 2010, pp. 25–29.

[20] Colebatch, Tim (2013) Liberal hailed for his legacy, The Age

[21] Sabin, Paul (2013) The Bet: Paul Ehrlich, Julian Simon, and Our Gamble Over Earth’s Future, Yale University Press.

[22] Oreskes, Naomi/Conway, Erik M (2010) Merchants of Doubt: How a Handful of Scientists Obscured the Truth on Issues From Tobacco Smoke to Global Warming, Bloomsbury Publishing USA.

[23] ABC Four Corners (2006) The Greenhouse Mafia

[24] Hamilton, Clive (2007) Scorcher: The Dirty Politics of Climate Change, Black Inc.

[25] Daley, J., Edis, T., & Reichl, J. (2011). Learning the hard way: Australian policies to reduce carbon emissions. Grattan Institute, Melbourne.

[26] The Australia Institute (2004) Notes from a LETAG meeting

[27] Diesendorf M. (2007) The base load fallacy. Energy Science briefing paper. 2007

[28] BREE (2012) Energy in Australia 2012, Table 9

[29] Prieto, P.A./Hall, C.A.S. (2013) Spain’s Photovoltaic Revolution: The Energy Return on Investment, New York, NY, USA: Springer.

[30] Chabot, Bernard (2014) May 11, 2014: a Record Production from Wind and PV in Germany

[31]Fraunhofer Institute for Solar Energy Systems ISE (2013)Electricity Production From Solar and Wind in Germany in 2012.Reported by Burger, Bruno, see slide 180

[32] Palmer, Graham (2014) Energy in Australia: Peak Oil, Solar Power, and Asia’s Economic Growth, Springer.

[33] Germany 672 g CO2-e/kWh, Sweden 23 g CO2-e/kWh, and France 71 g CO2-e/kWh, from Brander M, Sood A, Wylie C, Haughton A, Lovell J., (2011) Electricity-specific emission factors grid electricity. Ecometrica.

[34] Mearns, Euan (2014) Germany: Energy Kaput, Energy Matters

[35] Farson, Richard/Keyes, Ralph (2003) The Innovation Paradox: The Success of Failure, the Failure of Success, Simon and Schuster.

[36] McKillop, Andrew (2014) Merkel Snubs Global Warming And Dumps The Solar Industry, Energy Matters

—————————————————-

Graham Palmer. Graham recently published the book “Energy in Australia: Peak Oil, Solar Power, and Asia’s Economic Growth” (“Springer Briefs in Energy” series).

Link: http://euanmearns.com/germanys-energiewende-as-a-model-for-australian-climate-policy/#more-3389