Wir bleiben am Leben, obwohl unsere Gene einiges aushalten müssen – Teil II

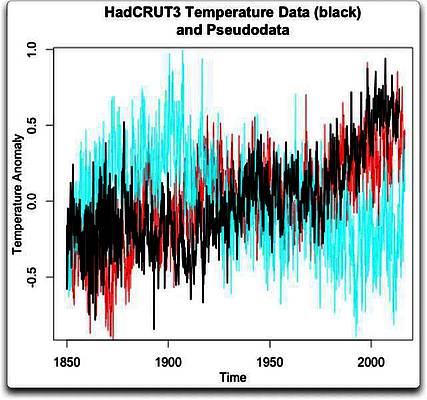

Bild rechts: Ist dies jetzt die Folge einer Schädigung durch Strahlung, oder…

Ich werde eure 200.000 Male sehen und es verzehnfachen!

Bei Menschen mit der seltenen Krankheit Bloom-Syndrom kommt es etwa zehnmal so häufig zu Brüchen des Doppelstrangs wie normal. Das ist so, als wäre die DNA dem 2-Millionenfachen der normalen Hintergrundstrahlung ausgesetzt.

Genetische Krankheiten gab es schon seit Urzeiten. Vor allem beim Bloom-Syndrom sieht es so aus, als ob es mindestens schon ein paar tausend Jahre existiert (hier). Einige Mutationen der BRCA1-Gene [?], von denen eines jüngst durch Angelina Jolie Berühmtheit erlangte, traten beispielsweise wahrscheinlich schon vor 1800 Jahren zum ersten Mal auf (hier). Eine Million Japaner tragen eine Mutation in sich, welche bei einem unglücklichen Kind das 10.000-fache Risiko von Hautkrebs in sich birgt. Dieses liebliche evolutionäre Geschenk ist ebenfalls schon tausende Jahre alt (hier). Mukoviszidose [cystic fibrosis] lässt sich mindestens bis zur Eisenzeit zurückverfolgen (hier). Menschen mit all diesen Mutationen ist es bislang gelungen, genug Kinder zu zeugen, um irgendwelche Tendenzen natürlicher Selektion auszusetzen, die sie vor dem Genpool bewahren.

Während diese Krankheiten und tausende ähnlich gelagerte Fälle Leben verkürzt und unsägliches Leid über sehr lange Zeit gebracht haben, ist doch keine davon durch einen Atomunfall oder einen Atomkrieg ausgelöst worden. Und es sollte jetzt offensichtlich sein, warum kein Atomunfall oder –krieg in der Lage ist, genauso viele Brüche in der Doppelhelix auszulösen wie es Menschen mit Erfahrung hinsichtlich des Bloom-Syndroms gibt.

Und jetzt gibt es einen neuen Mitspieler

Die wirklich bahnbrechende Nachricht zu genetischen Krankheiten, die während der letzten beiden Jahrzehnte bekannt geworden ist, lautet, dass Strahlungsunfälle nicht die alleinige Ursache tausender bekannter genetischer Krankheiten sind, sondern lediglich offensichtlich unschuldige Zuschauer. Und dass man nicht einmal Mutationen braucht, um eine genetische Krankheit auszulösen. Und wenn man keine Mutationen braucht, dann braucht man auch keine DNA-Schäden. Und was den Krebs betrifft, man braucht nicht einmal Karzinogene im normalen Sinne des Wortes.

Es ist irgendwie offensichtlich, wenn man darüber nachdenkt. Die Zellen sowohl im Gehirn als auch im Bizeps haben exakt die gleiche DNA, agieren jedoch sehr, sehr unterschiedlich. Es muss irgendeinen Mechanismus geben, der dafür sorgt, dass Gene abgeschaltet werden, die im Gehirn Muskel-Proteine bilden und umgekehrt im Bizeps. Es muss wirklich Wege geben, irgendwelche und alle Gene an- oder auszuschalten, in jeder Zelle im Körper. Und es gibt sie.

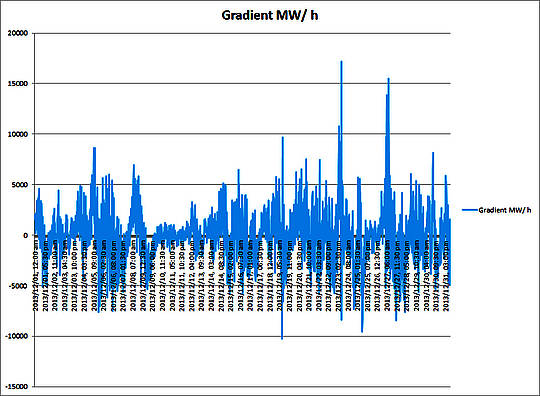

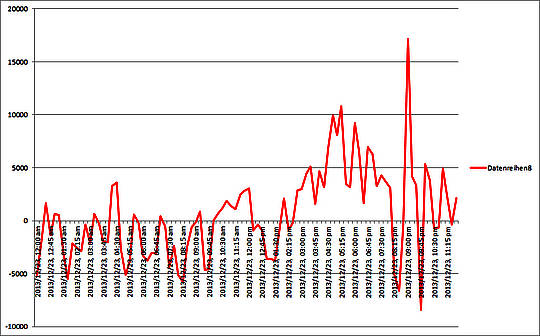

Massive DNA-Schäden, verursacht durch … Milch. Mehr zu diesem Bild siehe hier in einem weiteren Artikel von Geoff Russell.

Im Rahmen der molekularen Genetik wurden seit Langem bestimmende Mechanismen innerhalb der DNA untersucht, aber während der letzten 20 Jahre wurden zahlreiche neue Klassen von Mechanismen entdeckt, was zur Bildung eines Unterbereiches führte mit der Bezeichnung Epigenetik. In Teil III wird der Zusammenhang zwischen Epigenetik und Krebs erklärt, aber schon vorab möchte ich sagen, dass die Wissenschaft jetzt die Gründe für Krebs und andere Krankheiten zu verstehen beginnt, und zwar über Mutationen hinaus, und einige sind unglaublich banal. Aber mehr dazu später.

Mutations-Mythen

Die Aussage, dass Atombomben besonders schrecklich sind im Vergleich zu konventionellen Bomben infolge ihrer Strahlung ist normalerweise gekoppelt mit einer Ignoranz gegenüber Geburtsfehlern. Greenpeace ist eine von vielen Organisationen, die zu denken scheinen, dass das Auftauchen der Begriffe „Geburtsschaden“ und „Kernkraft“ in einem einzelnen Satz ausreicht, einen kausalen Link herzustellen. Der ABC-Journalist Greg Hoy hat den gleichen Trick in einer vor kurzem veröffentlichten Story angewandt, in der es um die Technologie der Anreicherung von Uran ging. Er behauptete, dass ein starker Anstieg schrecklicher Geburtsschäden in Fallujah, Irak, die Folge von Bomben mit abgereichertem Uran seien (welches weniger radioaktiv ist als normales Uran … „abgereichert“ hier als Hinweis). Seine Beweise? Keine. Die davor aufgetretenen Geburtsschäden werden in Hoys Story mit keinem Wort erwähnt. Bomben aller Art töten, verkrüppeln, zerstören und verbrennen. Sie zerstören Leben, Eigentum und Hoffnungen. Aber Hoys Brennpunkt war etwas, das sie nicht tun … nämlich dass sie massive und ausgedehnte Serien von Geburtsschäden hervorrufen.

Die Tatsache, dass Hoy dachte, keine Beweise zu brauchen, zeigt einen intellektuellen Stammbaum, der bis zur anti-nuklearen Übertreibung zurückreicht, die kurz nach dem Zweiten Weltkrieg begann nach den Bombenabwürfen auf Hiroshima und Nagasaki. Später erlebte diese einen neuen Aufschwung durch die Tschernobyl-Mythologie.

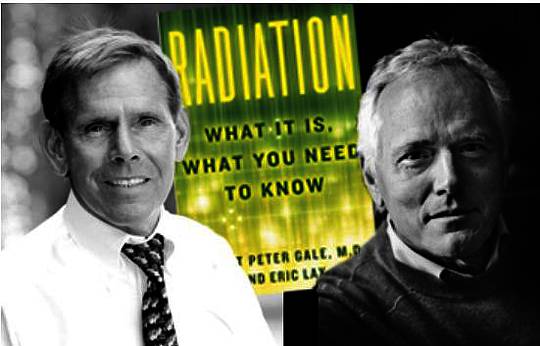

Sie schulden es sich selbst, dieses Buch zu lesen, bevor sie darüber lamentieren, was Strahlung ist und was sie tut oder nicht tut. Quelle

Ein vor kurzem erschienenes Buch von Robert Gale und Eric Lax mit dem Titel [übersetzt] „Strahlung – was man wissen muss“ (hier bei Amazon) behandelt dieses Thema detailliert. Gale ist ein Professor, dessen Name über 823 Studien zu diesem Thema steht, das sind 823 mehr als Anti-nuklear Guru Helen Caldicott und auch 823 mehr als von Greg Hoy oder irgendeiner der Personen, die er für seine Studie befragt hat. Gale wurde für die Behandlung der Feuerwehrleute von Tschernobyl zu Hilfe gerufen und war bei vielen Strahlenunfällen aller Größenordnungen während der letzten Jahrzehnte zugegen. Hier folgt eine kurze Zusammenfassung seiner Einschätzung eines Zusammenhangs zwischen Strahlung und Geburtsschäden.

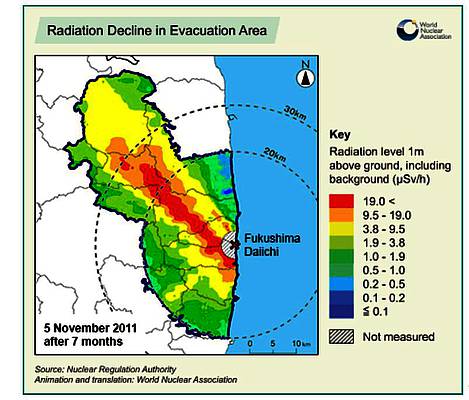

Von etwa 3000 schwangeren Frauen, die die Abwürfe von Hiroshima oder Nagasaki überlebt haben, bekamen 30 Kinder mit Mikrenzephalie (kleine Köpfe und leichte bis moderate Retardierung). Das ist alles. Die gegenwärtige Rate von Mikrenzephalie in Südaustralien liegt bei 2 bis 3 Kindern pro 3000 Geburten. Die Zahl 30 ist also sicher eine Tragödie, aber erheblich weniger tragisch als die Opferzahl der konventionellen Bombardierung von Tokio, die weitaus mehr Menschen tötete und noch größeres Leid hervorgerufen hatte. Sie ist ebenfalls viel weniger tragisch als die Atombomben selbst. Es ist einfach nicht der Stoff für Horrorfilme über strahlenverseuchtes Land. Die am schlimmsten betroffenen Kinder dieser 30 Frauen wurden von Müttern geboren, die Strahlung mit einer Menge gleichbedeutend mit 400 Jahren Hintergrundstrahlung ausgesetzt waren. Kinder von Frauen, die lediglich eine Menge von 120 Jahren abbekommen hatten, hatten keine Probleme.

Die überlebenden Frauen, die zu jener Zeit nicht schwanger waren, haben später Familien gegründet, und die [Anzahl von] Geburtsschäden unter zehntausenden geborenen Kindern war normal. Die Kinder dieser Frauen sind sehr gründlich untersucht worden, und ihre Gesundheit ist ebenfalls normal.

Und in Tschernobyl?

Es gab in der Folge eine Flut von Fehlgeburten. Aber nicht durch Strahlung, sondern durch blinde Angst, Panik und Ignoranz.

Man stelle sich eine schwangere irakische Frau vor in irgendeinem Gebiet, das Schauplatz amerikanischer Bombardierung war, und wie sie die traurigen und grauenhaften Bilder in der Story von Greg Hoy sieht. Die einzige noch verbleibende Wahl wäre eine zwischen einem Kleiderbügel und Stricknadeln als Instrument der Termination.

Gale beziffert die Zahl unnötiger Abtreibungen nach Tschernobyl mit etwa 100.000. Diese sowie alle daraus folgenden psychologischen Traumata sind ein Erbe der Unkenntnis über Strahlung, die nach Kräften durch anti-nukleare Campaigners gefördert worden ist. Keine Frau in Tschernobyl hat auch nur ansatzweise eine Strahlendosis abbekommen, die den wachsenden Fötus geschädigt hätte. Nur die Feuerwehrleute an vorderster Front erhielten eine starke Dosis, aber von denen war keiner schwanger. Als Folge sind 30 Feuerwehrleute gestorben, aber nicht einfach durch Strahlung, sondern an den gleichen Verletzungen, die im gleichen Jahr 119 US-Feuerwehrleute das Leben gekostet hat (hier).

Einer der überlebenden Feuerwehrmänner war Andrej Tarmosian, zu jener Zeit 25 Jahre alt. Gale und sein Team haben sein Leben gerettet, und in der Folge blieben er und Gale in Kontakt. Aber populäre Mythen triumphierten über die Beurteilung eines der besten Strahlungsexperten der Welt. Tarmosian glaubte, dass ihn die Strahlung, der er ausgesetzt war, zum Krebstod verdammte. Er glaubte auch der russischen Legende, dass Wodka ein gutes Mittel zum Strahlenschutz war. Diese patente Mischung aus Angst und Unsinn würde ihn bis zum Jahr 2010 seiner Ansicht nach im Alter von 50 Jahren an Leberzirrhose sterben lassen. Er war ein Kollateralschaden des weit verbreiteten Unwissens über Strahlung wie all die abgetriebenen Föten und die Frauen, die diese Abtreibungen vorgenommen haben.

Diese Statue soll an die Bemühungen der Feuerwehrleute und der Liquidatoren nach dem Nuklearunfall in Tschernobyl erinnern.

Beweis durch schockierende Bilder

Es ist nicht schwierig, im Bereich einer mittelgroßen Population von Menschen oder Tieren eine Reihe von Geburtsschäden zu finden, um einen journalistischen Fotobeweis zu konstruieren. Alles, was man braucht, ist Ignoranz gekoppelt mit bösem Willen. Die Rate von Geburtsschäden in Südaustralien liegt derzeit bei 4,5 Prozent. In den USA werden 2 bis 3 Prozent aller Geburten als schwer missgebildet gelistet, zusammen mit weiteren 10 Prozent, die interne Anomalien und funktionelle Probleme aufweisen, die erst später im Leben durchbrechen. In jedem Jahr bedeuten die 4,5 Prozent in Südaustralien etwa 1000 Kinder. Es gibt viele seltene Bedingungen mit langen Namen und ernsten Konsequenzen zusätzlich zu allgemeineren Dingen wie Mikrenzephalie, Down-Syndrom und Chromosomen-Defekte. Etwa 200 Kinder kommen dort mit verschiedenen Herzproblemen zur Welt. Und nun überlege man: Wie viele Zehntausende Geburtsschäden kann man jährlich in einem Land wie der Ukraine erwarten, deren Einwohnerzahl Ende der achtziger Jahre 50 Millionen betragen hatte? Wie schwer wäre es gewesen, ein Dutzend oder einhundert Menschen für ein Foto-Shooting zu finden?

Dass man Kinder mit Geburtsschäden finden und fotografieren kann, heißt noch lange nicht, dass man die Ursache der Geburtsschäden kennt. Der Zusammenbruch des Gesundheitssystems mit dem Untergang der Sowjetunion sorgte dafür, dass alle Arten von Krankheiten zunahmen. Die Ignoranz, die die Ukrainer zu Wodka als Schutz vor Strahlung greifen ließ, ist genau das Gleiche wie die vermeintliche Ursache von Strahlung hinter bedauerlichen gesundheitlichen Beeinträchtigungen, vor allem Geburtsschäden.

Außer dass abergläubische Feuerwehrleute früh zu Tode kommen – was kann Wodka noch tun? Mikrozephalie zum Beispiel (hier). Außer dem Überleben einer Atombombe finden sich auf der Liste von Ursachen für Mikrozephalie nicht nur Alkohol, sondern auch zahlreiche Drogen und Viren. Unter den Viren sind Masern und Windpocken. Eine andere effektive Ursache ist unbehandelte Phenylketonuria [?], eine genetische Fehlanordnung.

Es ist deprimierend einfach, einen Geburtsschaden zu bekommen

Niemand weiß, wodurch die meisten Geburtsschäden zustande kommen, weil es so viele potentielle und banale Gründe gibt.

Niemand verursacht freiwillig Geburtsschäden bei Menschen, aber Tiere sind nicht so glücklich. Wissenschaftler haben nach den Arbeiten von Hermann Müller sicherlich nicht aufgehört, mit Fruchtfliegen zu arbeiten. Sie haben seit Jahrzehnten mutierte Tiere vieler Spezies erzeugt. Wie haben sie das gemacht? Eine umfassende Liste der Methoden wäre lang. Natürlich kann man es mit massiven Strahlendosen machen oder Wasserstoff-Peroxid oder Blei oder Quecksilber oder Vitamin A, aber wenn das Budget schmal ist und man einen Sinn für das Banale hat, macht es auch eine Heizlampe oder eine elektrische Decke. Alles ist möglich. Man erhöhe lediglich die innere Körpertemperatur eines ausgewählten Tieres um wenige Grad, und siehe da, schon kann man ganze Skala von Neuralrohrdefekten und noch viel mehr erzeugen (hier). Microphtalmia (kleine Augen), grauer Star, Coloboma (Loch im Auge), Schielen, Unterentwicklung von Zähnen und Klauen, Exomphalos (Därme oder andere Organe, die bei der Geburt außerhalb des Körpers liegen), Nierenagenesie (wenn eine oder beide Nieren fehlen), Klumpfüße, Muskelstörungen, Arthrogyposis (defekte Gelenke). Und natürlich kann man die gleiche Mikrenzephalie (kleiner Kopf bzw. Gehirn) mit der Strahlung der Atombomben auslösen, der die Kinder der 30 Überlebenden ausgesetzt waren.

Wie kann man die innere Körpertemperatur sonst noch zum Steigen bringen? Grippe oder andere Fieber erzeugende Krankheiten können dafür sorgen (hier), und die höhere Körpertemperatur ist in der Lage, fast die gesamte Palette der Geburtsschäden hervorzurufen. Hierzu erinnere man sich an die Schweinegrippe-Epidemie im Jahre 2009. Sie war ein wenig unterschiedlich verglichen mit der normalen jahreszeitlichen Grippe, weil viel mehr junge Leute betroffen waren und ihr zum Opfer fielen. Insgesamt forderte die Epidemie global 284.000 Todesopfer (hier). Und gab es eine Zunahme der Geburtsschäden nach der Pandemie? Ja! Eine Studie in UK kam zu dem Ergebnis, dass sich angeborene Anomalien in etwa verdoppelt hatten (hier). Aber evolutionäre Mechanismen bevorzugen noch drakonischere Schritte zur Verminderung solcher Ereignisse. Die Anzahl der Toten vor, während und kurz nach dem Ereignis hat um einen Faktor zwischen drei und sechs zugenommen, je nach Art der medizinischen Kategorie. Andere Ergebnisse, die einst zu frühem Tod geführt haben, werden jetzt routinemäßig mit professioneller Hilfe gehandhabt: Sehr geringes Gewicht bei der Geburt, Frühgeburten, Verdoppelung von Kaiserschnitten. Dies war eine recht kleine Studie, begrenzt auf Frauen, die mit bestätigter Schweinegrippe ins Krankenhaus kamen. Der Tribut in Ländern ohne gute Gesundheitsfürsorge, um Frühgeburten zu behandeln, kann als deutlich höher eingeschätzt werden, und der gesamte globale Zoll würde schrecklich sein. Forscher fanden auch nach der Grippe-Pandemie im Jahre 1958 eine Zunahme von Geburtsschäden.

Und jetzt betrachte man die tägliche Höchsttemperatur in Irak während der Sommermonate und frage sich selbst, ob den Frauen in Irak die hohen Risiken von Geburtsschäden bewusst sind, die mit einer erhöhten inneren Körpertemperatur oder einer fiebrigen Krankheit während der Schwangerschaft einhergehen. Man frage sich, ob Stromunterbrechungen und Anstehen nach Wasser und anderem Grundbedarf des Lebens helfen würden.

Bemerkung: Ich stelle hier keine Verbindung her zwischen Geburtsschäden in Fallujah und den hohen Sommertemperaturen in Irak. Sondern ich versuche zu erklären, warum das Aufspüren kausaler Verbindungen bei Gegenwart zahlreicher wirklich brauchbarer Alternativen sehr schwierige Wissenschaft ist. Sie liegt deutlich jenseits der Aufgabenstellung von Dokumentarfilmern und fast allen Ärzten. Sehr wenige Ärzte haben die erforderlichen statistischen Fertigkeiten, und die meisten sind genauso anfällig für fragwürdige Einflüsse wie alle anderen auch.

Einige gute Nachrichten … umweltliche Teratogene [?] sind flüchtig

Natürlich hat man recht, wenn man sich um die Auswirkungen einer Pandemie und einer Zukunft mit viel höheren Temperaturen macht, aber sollte man sich auch Sorgen machen um deren Einflüsse auf unser wertvolles „Bakterien-Plasma“?

Fast mit Sicherheit nein! Warum?

Weil der gegenwärtige Wissensstand von Fachleuten, die diese Dinge untersuchen, folgender ist – trotz der Entdeckung zahlreicher umweltlicher Teratogene wie Wärme, Vitamin A, Contergan und zahlreicher anderer Substanzen:

Bis heute konnte nicht festgestellt werden, dass genetisch bedingte Fehlbildungen durch irgendwelche umweltlichen Dinge verursacht werden, selbst nicht durch jene Dinge, die sich als fähig herausgestellt haben, Schäden an genetischem Material in individuellen Zellen anzurichten.

Einfacher gesagt, umweltliche Teratogene (Dinge außerhalb des Körpers) können sicherlich einen sich entwickelnden Fötus schädigen oder töten, aber bis auf den heutigen Tag wurden keine gefunden, die neue Mutationen hervorrufen, die die Menschen noch lange Zeit in der Zukunft plagen werden; zum Beispiel das historische BRCA1 [?] oder jenes involvierte Bloom-Syndrom. Es können noch mehr solcher Schrecknisse auftauchen, aber sie sind wohl allein großem Pech und Mutter Natur geschuldet. Der erweiterte Zusammenhang des obigen Zitats stellt fest, dass Strahlung im Einzelnen genau das nicht verursacht hat, trotz der hohen Belastungen während der Atombomben-Abwürfe auf Japan.

Es ist an der Zeit, dass unsere Filmemacher die Strahlung als Ursache von Monster-Mutationen aufgeben. Wir haben viele Gründe, uns Sorgen zu machen; viele Gründe für Maßnahmen. Wir brauchen aber nicht zu übertreiben… besonders wenn diese fantastischen Übertreibungen die Art realer und effektiver Maßnahmen erschweren, die wir um einer besseren Zukunft willen durchführen müssen; nicht nur für uns selbst, sondern für alle Spezies, mit denen wir uns diesen Planeten teilen.

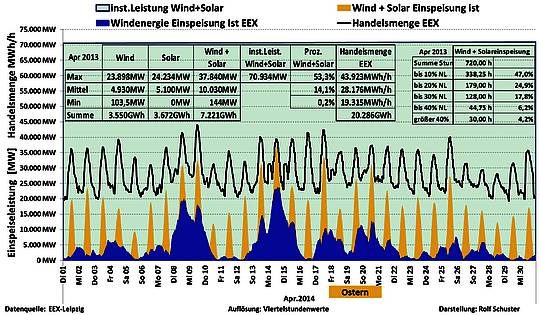

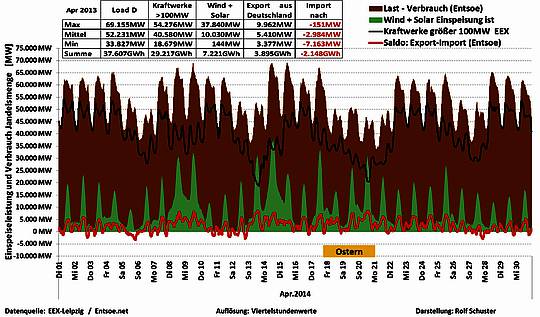

Der nukleare Beitrag zur menschlichen Gesundheit war seit vier Jahrzehnten überwältigend positiv. Er hat mindestens 1,8 Millionen Totgeburten verhindert durch die Erzeugung sauberer Energie, um die toxischen Abfallprodukte von auf fossilen Treibstoffen basierender Elektrizität zu ersetzen. Es hätten noch mehr sein können, wenn Science über Fiction die Oberhand behalten hätte. Hat es aber nicht. Die gute Nachricht lautet, dass der Kampf gegen die Leugnung des Klimawandels den Menschen klarmacht, wie viel sie mit der Anti-Kernkraft-Bewegung gemein haben. Aber Bildung ist ein langsamer Prozess, und wir haben nicht viel Zeit. Angesichts des deutschen Experiments mit erneuerbarer Energie, das von einem Scheitern zum nächsten taumelt, hat sich die Kernkraft nicht nur als die umweltfreundlichste Energietechnologie erwiesen, die wir haben, sondern auch als die einzige Technologie, mit der die Hoffnung besteht, eine weitere Destabilisierung des Klimas [?] zu verhindern (hier).

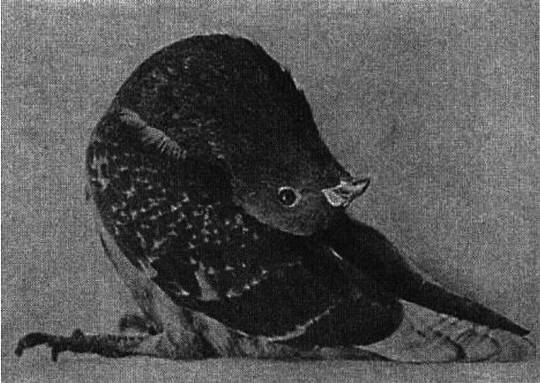

Ich möchte hier mit einem schnellen Quiz enden. Das Bild unten zeigt eine schrecklich entstellte Taube mit einer doppelt gebogenen Wirbelsäule, so dass ihr Kopf auf dem Rücken liegt. Dieser Vogel wurde von Wissenschaftlern während einer Forschungsstudie erzeugt, und die offensichtliche Frage lautet, warum dieser Vogel nicht bei der Geburt gestorben ist. Warum ließ man diese arme Kreatur am Leben? Können Sie den Grund für diese Deformierung erraten? War es Chemie oder eine Art Strahlung mit welcher Dosis?

(Quelle)

Irgendwelche Vorschläge?

Nur wenige Leser werden die Antwort kennen und ich bezweifle, dass irgendein Vorschlag der Wahrheit auch nur nahe kommt. Ich habe deutlich daneben gelegen.

Ich muss bekennen, dass ich im Interesse der Illustrierung, wie leicht es ist, die Menschen mit schrecklichen Bildern in die Irre zu führen, gelogen und eine Story erfunden habe, die sie sofort glauben würden.

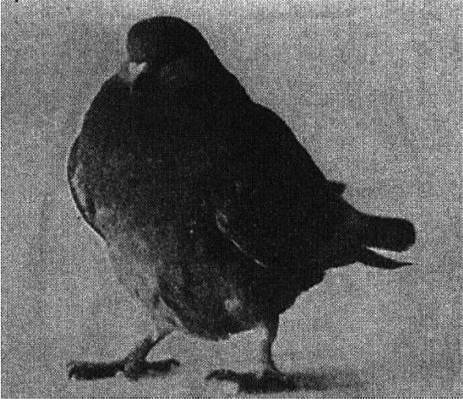

Der Vogel wurde mit keinerlei Schäden geboren, sondern völlig gesund. Dem armen Vogel wurde lediglich einige Wochen lang eine Diät mit weißem Reis verabreicht und bekam als Folge davon einen Vitamin-B-Mangel. Hier ist der gleiche Vogel wenige Stunden nach einer Injektion von Vitamin B:

(Quelle)

Geoff Russell ist Mathematiker, Programmierer, Veganer, Umwelt-Aktivist und ganz allgemein ein von Zahlen Besessener.

Link: http://bravenewclimate.com/2013/11/08/stayin-alive-gene-pool-p2/

Übersetzt von Chris Frey EIKE

Bemerkung des Übersetzers: Dieser Artikel ging bisweilen weit über die „Fachkenntnisse“ des Übersetzers hinaus, der auch kein Physikstudium absolviert hat. SACHLICHE Korrekturen sind willkommen. Außerdem wurden ALLE LINKS eingearbeitet und auf ihre Funktion überprüft.

C. F.