Teil 3: Warum und wie El Niño das Wettergeschehen in Europa und Nordamerika steuert

Teil 3 zeigt, wie die Sonne ihre Energie auf die irdischen Wettersysteme einprägt. Die physikalischen Grundlagen werden dargelegt, über die die Auswirkungen von El Niño-Ereignissen global wirken und wie das Wettergeschehen (über die NAO) in Europa und Nordamerika diesen Parametern folgt.

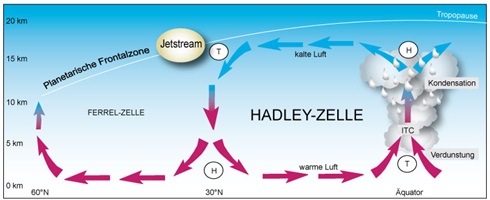

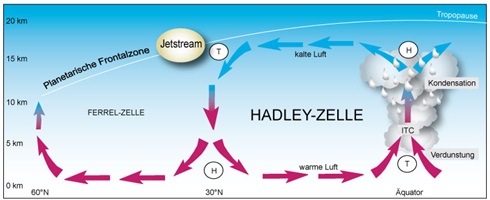

Bleibt noch die Frage zu klären, wie die in den Teilen 1 und 2 gezeigte Sonnenaktivität ihren Einfluss sozusagen umsetzt? Hier geben die Antwort, die Passatwinde (englisch: Trade Winds), also die Großraumwetterlage, die durch die Hadley-Zellen bestimmt wird. Die Passatwinde sind ein beständiges Windsystem, welches sich auf beiden Seiten des Äquators bis zum 24. Breitengrad ausbildet. Es liegt damit im Bereich der Hadley-Zellen und unterteilt sich in den Nordost-Passat (Nordhalbkugel) und in den Südost-Passat (Südhalbkugel). In der Wissenschaft ist unstrittig, dass die Passatwinde durch die Sonne entstehen und ihre Ausbildung und Stärke von der Sonnenscheindauer und -Stärke abhängt. Durch erwärmte, aufsteigende Luftschichten (Tiefdruckgebiet entlang der innertropischen Konvergenzzone) die an der Tropopause vom Äquator weg strömt und ca. 30° Nord oder Süd wieder zu Boden fällt (Hochdruckgebiet) entsteht ein Druckgefälle, wodurch sich Ausgleichströmungen zwischen den Hoch-/Tiefdruckgebieten bilden. Durch die Corioliskraft werden sie entsprechend abgelenkt.

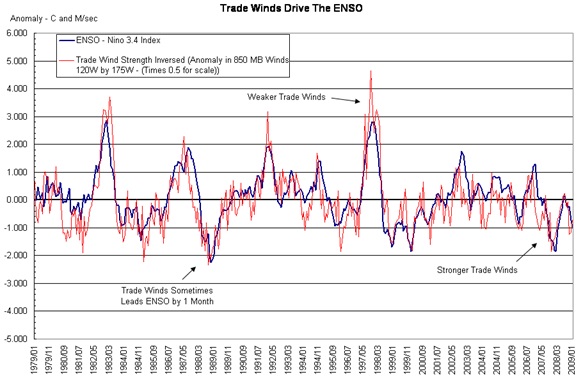

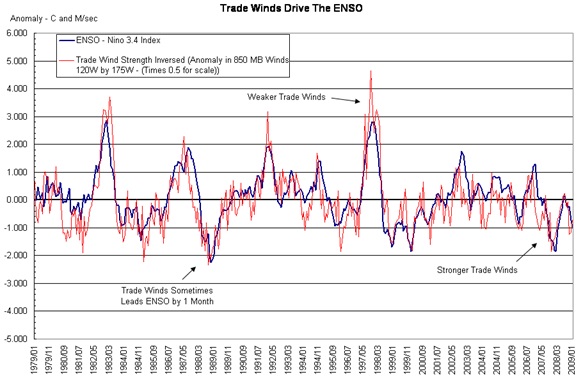

Abb.23 (Quelle) zeigt die ENSO und die invertierte Windstärke der Passatwinde (Trade Winds). Unschwer ist zu erkennen, dass beide zusammenhängen. Die Passatwinde werden von den Hoch- und Tiefdrucksystemen (neben der Corioliskraft = Erddrehung) bestimmt. Diese wiederum durch die Wolkenbedeckung und dies ist der Ansatzpunkt, wie die Sonne neben ihrer Strahlungsleistung ihren Einfluss auf das irdische Wettersystem umsetzt. Seit Svensmark gibt es eine These, wie die solare Aktivität die Bewölkung beeinflusst. Den Einfluss des Polfeldes (Hale-Zyklus) auf die Wolkenbedeckung hat der Autor in seiner 8-teiligen EIKE-Reihe “Dynamisches Sonnensystem – Die tatsächlichen Hintergründe des Klimawandels“ gezeigt.

Da die Passatwinde Ausdruck der Hadley-Zellen sind und diese in einem Band zwischen ±30° um den Globus verlaufen, wird der unmittelbare solare Einfluss auf die Hadley-Zellen untersucht.

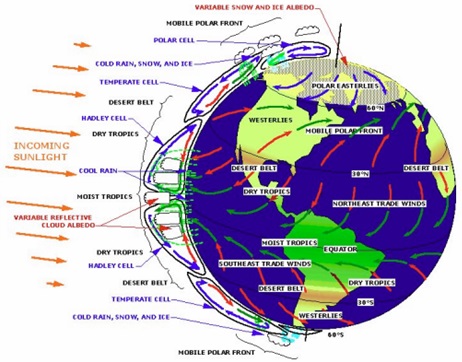

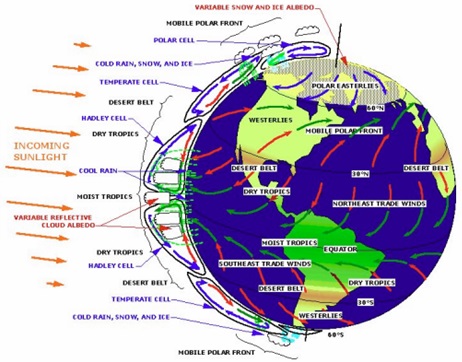

Die Hadley-Zelle ist ein wesentlicher Bestandteil der atmosphärischen Zirkulation. Sie entsteht durch die meridional unterschiedliche Sonneneinstrahlung und dem daraus resultierenden Energietransport von den Tropen zu den Polen. Diese thermisch angeregte Zirkulation reicht jedoch im ersten Schritt nur bis zum 30-Breitengrad, weil dort die Strahlungsenergie der Sonne deutlich abfällt (Abb.25). Die daraus entstehende Hadley-Zelle ist als globale (verläuft um den ganzen Globus) Vertikalzirkulation zwischen dem Hochdruckgürtel der Subtropen und der äquatorialen Tiefdruckrinne ausgebildet. Die Hadley-Zelle kann näherungsweise als ein in sich abgeschlossenes System betrachtet werden (Abb.24).

Abb.24: Über der ITCZ (Innertropische Konvergenzzone) steigt aufgrund der Konvektion warme und feuchte Luft auf, wobei dort ein Tiefdruckgebiet entsteht. Die Luft expandiert, kühlt dabei ab, was zur Wolkenbildung führt. Durch die Corioliskraft wird die Luft abgelenkt. Im Bereich des Subtropenhochdruckgürtels sinkt die kalte und trockene Luft (schwerer) ab, wodurch am Boden ein Hochdruckgebiet entsteht. Die sich dabei erwärmende Luft nimmt über den Ozeanen große Mengen an thermischer Energie in Form von fühlbarer und latenter Wärme (Luftfeuchte) auf und fließt als Nord/Ost-Passat zum Äquator zurück. Der übrige meridionale Energietransport findet über die sich anschließenden Zellen durch horizontale zyklonale (entgegen dem Uhrzeigersinn drehende) und antizyklonale (mit dem Uhrzeigersinn drehende) Zirkulation statt. In der Ferrel-Zelle wird die Energie durch die Westwinddrift abgeführt. Diese entsteht aus thermodynamischen Gründen wegen des Temperaturgegensatzes der Luft von ca. 20K zwischen 30° und 60°-Breite.

Wie Untersuchungen zeigen, hat sich die Hadley-Zelle im Zeitraum der moderaten Erwärmung zwischen 1979 und 2005 (Anstieg des Hauptsonnenzyklus und dem Brückner-Zyklus) um 5-8 Breitengrade ausgedehnt und sich deren Volumen, da auch die Tropopause wegen der erhöhten Konvektion durch die Wärmeflüsse um einige Zehnmeter erhöhte, um ca. 5% vergrößert, D. J. Seidel et al. (2008), ”Widening of the tropical belt in a changing climate“, Nature Geoscience 1, 21-24.

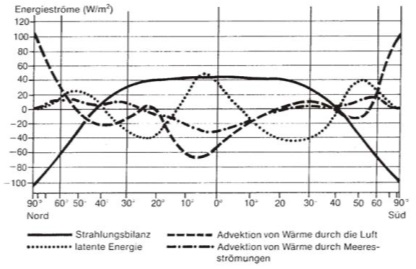

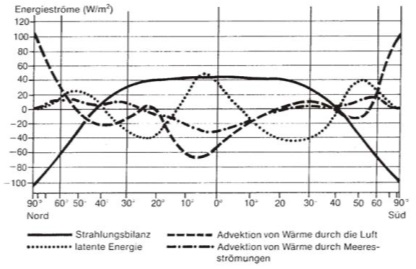

Abb.25 zeigt das Jahresmittel der Energieflüsse der Atmosphäre in Abhängigkeit von der geographischen Breite nach Häckel, 1990. Neben der Strahlungsbilanz dominieren die Flüsse von sensibler und latenter Wärme (Luftfeuchte). Die Advektion von Wärme durch die Luft, verhindert die Auskühlung der Pole. Gut zu sehen, wie Energie meridional transportiert wird, Quelle: Häckel, 1990, “Meteorologie“. Bis etwa zum 25. Breitengrad ist die Strahlungsenergie konstant und am größten. Ab dem 30-Breitengrad fällt der Energiestrom der Strahlungsbilanz deutlich ab.

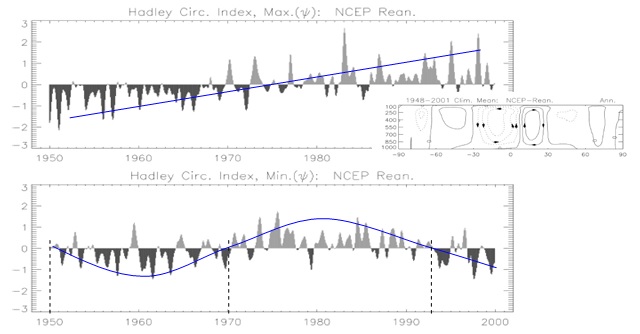

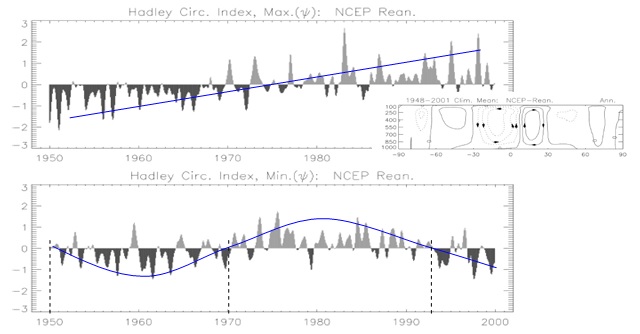

Die Wissenschaftler Xiao-Wei Quan et al. untersuchten, wie sich die Hadley-Zelle seit den 1950-Jahren veränderte “Change of the Tropical Hadley Cell Since 1950“. Abb.26 entstammt ihrer Untersuchung. Dieser wird aus der gemittelten Windgeschwindigkeit der 200 hpa-Höhe, minus der gemittelten Windgeschwindigkeit in der 850 hpa-Höhe gebildet und ist somit ein Maß für die Luftmassengeschwindigkeit und des Luftmassenstroms in der Hadley-Zelle.

Abb.26 zeigt den Hadley-Zirkulations-Index. Dies ist die Abweichung vom Mittel der zonalen Meridiangeschwindigkeit in der 200 hpa-Höhe minus des Mittels der zonalen Meridiangeschwindigkeit in 850 hpa-Höhe und steht für die Luftmassenströmungen in der Hadley-Zelle. Y-Achse = 1010 kg/s. Während die südliche Hadley-Zelle (unten) eine Schwingung von ca. 23 Jahren zeigt, was der Länge des Polaritätszyklus (Hale-Zyklus) der Sonne entspricht, steigt der Index auf der Nordhalbkugel bis zur Jahrtausendwende stetig an. Die Erklärung für das unterschiedliche Verhalten könnte in der Zellgröße und den Landmassen liegen. So ist die nördliche Zelle fast doppelt so groß (kleine Abbildung), was wiederum mit der größeren Landfläche auf der Nordhalbkugel zusammenhängen könnte, die sich mit dem Ansteigen des Hauptsonnenzyklus direkter und schneller erwärmt, als die großen Wasserflächen unter der südlichen Hadley-Zelle.

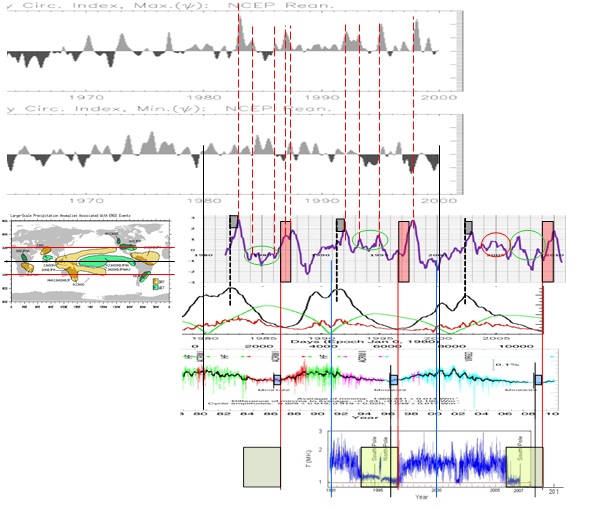

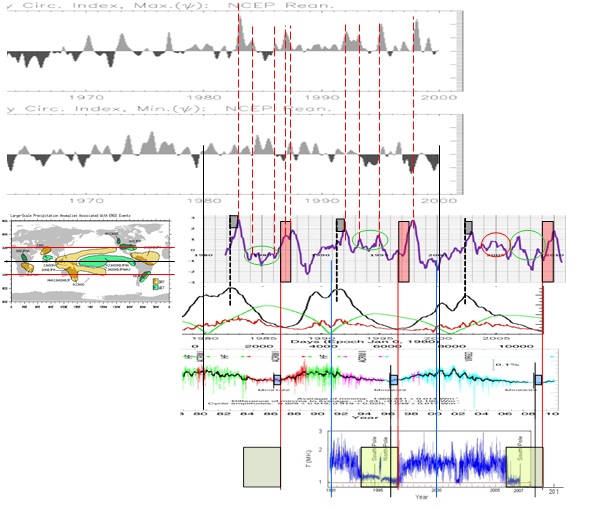

Da die Untersuchungsergebnisse von Xiao-Wei Quan et al. auf solare Einflüsse hindeuten, sollen diese mit den gezeigten Untersuchungen des Autors in Relation gesetzt werden (Abb.27).

Abb.27 bestätigt, dass die El Niño-Ereignisse unmittelbar mit der Aktivität in der Hadley-Zelle gekoppelt sind. Wie bereits gezeigt, sind die Auswirkungen von El Niño um den ganzen Globus zu verzeichnen, insbesondere in einem Band von ±30° nördlicher und südlicher Breite, was dem Gebiet der Hadley-Zellen entspricht. Wie die Gesamtabbildung zeigt, ist jeder El Niño einem Hadley-Ereignis direkt zugeordnet (rote gestrichelte Linien) und damit, wie bereits bewiesen, der solaren Aktivität unmittelbar zuzuordnen. Die Abbildung zeigt ganz deutlich, dass mit Eintreten eines El Niño-Ereignisses und des entsprechenden solaren Parameters, die Windgeschwindigkeiten in der Höhe zunehmen. Dies ist auch der Schlüssel zu der Erkenntnis, dass die El Niño-Auswirkungen nicht nur zonal (zwischen ±30° geographischer Breite), sondern global auftreten.

Abb.25 zeigt schematisch, wie der Energietransport zwischen der Hadley-Zelle und den nördlichen Breiten verläuft, sowie der Luftmassenstrom über die Hadley-Zelle zu den nördlichen Breiten. Daraus wird ersichtlich, dass El Niño-Ereignisse über den Bereich der Hadley-Zelle Einfluss auf das Wettergeschehen haben, wie dies aus den Untersuchungen von Prof. Brönnimann und des MPI-M und der University of Cambridge (“Central Pacific El Niño, the “subtropical bridge,” and Eurasian climate“, Journal of Geophysical Research, Vol. 117, D01102, 10 PP., 2012), sowie Prof. Malberg (erschienen in der Berliner Wetterkarte e.V. am 31.01.2012) hervorgeht. Die Erklärung ist im Drehimpulserhaltungssatz zu finden.

Abb.28 zeigt das Druckverteilungsmuster und die Windverhältnisse der bodennahen Troposphäre. Im Absinkbereich der Hadley-Zelle bilden sich Hochdruckgebiete, wodurch dort trockenes Klima vorherrscht. So liegen in ihrem Bereich die Wüstengebiete der Erde. Durch die Passatwinde fließt ein stetiger Rückstrom (Oststrom) in Richtung Äquator. In der IPCZ fließt daher ein schwacher Ostwind. In der Westwinddrift der Ferrel-Zelle fließen die Frontensysteme der Tiefdruckgebiete nach Osten und zwar entlang des Polarfrontjet, an dem sich fortwährend Tiefdruckgebiete bilden. An der sich angrenzenden Polar-Zelle entsteht an der absinkenden schweren Kaltluft ein Hochdruckgebiet. Zwischen dem Druckgradient und der Corioliskraft bildet sich dort ein Gleichgewicht, welches einen schwachen Ostwind verursacht. Sowohl die Ostwinde der Subtropen/Tropen, als auch die Ostwinde der Polargebiete und der Westwind der mittleren Breiten sind mit einem Drehimpuls verbunden. Aus Gründen der Drehimpulserhaltung muss deren Summe Null ergeben.

Drehimpuls

Der Drehimpuls (Einheit: Nms) wirkt bei einer Kreisbewegung in Richtung Zentrum und gibt die Drehachse der Bewegung an. Er steht damit senkrecht zur Ebene, in der sich die Masse bewegt. Der Drehimpuls ist abhängig von der Geschwindigkeit, der Masse, sowie dem Abstand zur Drehachse. Bei Zunahme einer der drei vorgenannten Parameter, wächst der Drehimpuls an. Der Drehimpulserhaltungssatz gibt an, dass der Gesamtdrehimpuls in abgeschlossenen Systemen konstant ist.

Verändert sich z.B. der Drehimpuls auf Grund einer Geschwindigkeitszunahme der Luftströmungen in der Hadley-Zelle, so muss dies wegen dem Drehimpulserhaltungssatz Auswirkungen auf die Luftströmungen in den beiden anderen Zellen (Ferrel- und/oder Polar-Zelle) haben. Wird die Geschwindigkeit der Luftströmungen durch ein solares Ereignis in der (oberen) Hadley-Zelle erhöht, so sind durch die Kopplung über den Drehimpuls auch die anderen Zelle(n) beeinflusst. In der Ferrel/Polarzelle stellen sich dann geringere Drehimpulse ein, was zu einem ruhigen, kalten Winter führt (siehe Untersuchungen von Prof. Brönnimann).

Da die Hadley-Zelle zeitlich begrenzt, als geschlossenes System betrachtet werden kann, gilt natürlich, wie für jedes geschlossene System, der Energieerhaltungssatz. D.h. eine Erhöhung der Windgeschwindigkeiten in der Höhe muss mit einer zeitlich begrenzten Verringerung der Windgeschwindigkeiten in niedriger Höhe verbunden sein, wodurch bei einem El Niño die Passatwinde erschlaffen.

Abklingen des El Niño-Ereignisses

Stellt sich noch die Frage, warum das El Niño-Ereignis nicht bestehen bleibt? Dies ist bei El Niño-Ereignissen, die vom magn. Maximum des jeweiligen Schwabe-Zyklus oder durch die Polarfeldaktivitäten ausgelöst werden, recht einfach zu begründen: Weil die solare Aktivität und damit die Energiezufuhr dann am höchsten ist und anschließend wieder abfällt. Die mit einem Ereignis unter den Punkten 2 oder 3 erfolgte Energiezufuhr baut sich also wieder ab.

Diese Begründung kann jedoch nicht für die El Niño-Ereignisse unter Punkt 1 heran gezogen werden, weil nach der integralen Zunahme der Koronatemperatur (der integralen Zunahme der Korona-Aktivität) die solare Aktivität nicht abnimmt, sondern weiter zunimmt, bzw. die Korona-Temperatur in der Fläche auf ihrem hohen Wert von nahezu 2 Mio. Kelvin verbleibt. Also müsste das El Niño-Ereignis bestehen bleiben.

Der Gund, warum ein El Niño-Ereignis letztendlich entsteht (ausgelöst wird), besteht in den Änderungen von Energiedifferenzen zwischen den oberen Atmosphärenschichten und den unteren Atmosphärenschichten. Wie die Untersuchungen von Xiao-Wei Quan et al., “Change of the Tropical Hadley Cell Since 1950“ und die Korrelation mit der solaren Aktivität zeigen, wird durch die Aktivitätszunahme der Sonne die Luftmassenströmung zwischen oberen und unteren Atmosphärenschichten deutlich erhöht. Auch bei der Aktivitätszunahme der Korona. Die Änderung in der Aktivitätszunahme löst die Erhöhung des Luftmassenstromes und der Luftgeschwindigkeit in den oberen Atmosphärenschichten aus.

Xiao-Wei Quan et al. konnten zeigen, dass durch die entstandenen Energiedifferenzen zwischen oberen und unteren Atmosphärenschichten, die Erhöhung des Luftmassenstromes, damit verbunden, der Drehimpulsänderung und dem Erschlaffen der Passatwinde, entsteht. Obere und untere Atmosphärenschichten gelangen durch die Änderung (Impuls) aus ihrem vorherigen relativen Gleichgewichtszustand und zwar so lange, bis die Energie der oberen Atmosphäre, die die Erhöhung des Luftmassenstroms zwischen 200 hPa und 800 hPa bewirkt, an die unteren Atmosphärenschichten (und die übrigen Zellen – Ferrel- und Polarzelle) abgegeben wird. Also der Energieausgleich stattfindet. Ist dieser Energieaustausch abgeschlossen, also das vor dem Ereignis gültige relative Gleichgewicht wieder hergestellt, ist das El Niño-Ereignis beendet. Eine weitere gleichbleibend hohe Aktivität (Koronatemperatur bleibt auf 2 Mio. Kelvin) kann dann keine weitere Zustandsänderung hervorrufen. Der stabile Zustand zwischen oberen und unteren Atmosphärenschichten ist allerdings jetzt auf einem höheren Niveau und zwar für beide Luftschichten, die oberen und unteren, was keinen Einfluss mehr auf Änderungen der Luftmassenströmungen zwischen beiden Schichten (daher relatives Gleichgewicht) haben kann, also auch kein El Niño-Ereignis bestehen lassen oder entstehen lassen kann.

Vereinfacht dargestellt: Das System wird durch den Aktivitätsschub der Sonne vorrübergehend aus seinem Gleichgewicht gebracht, wodurch der El Niño entsteht. Dieser bleibt so lange bestehen, bis sich das vorherige relative Gleichgewicht wieder einstellt. Dies ist auch der Grund, warum das El Niño-Ereignis unter Punkt 1 stärker ausgeprägt ist, als die El Niño-Ereignisse, die durch Punkt 2 oder 3 ausgelöst werden. Zum einen, ist das System zwischen oberen und unteren Atmosphärenschichten durch das solare Minimum in seinem energieärmsten Zustand (eine „plötzliche“ Aktivitätssteigerung der Sonne kann also ein starkes Ungleichgewicht auslösen) und zum anderen, verhindert die weiter ansteigende solare Aktivität, den schnellen Energieabbau und damit das Einstellen des vorherigen relativen Gleichgewichts zwischen oberen und unteren Atmosphärenschichten, wogegen der Abfall der Energiezufuhr der Sonne bei den El Niño-Ereignissen unter Punkt 2 oder 3 das einstellen des vorherigen relativen Gleichgewichts unterstützt.

Weiter steht die Hadley-Zelle, wie gezeigt, mit der Ferrel-Zelle im Energieaustausch, so dass die Energiezunahme, die ein solares Ereignis auslöst, über diese und den Jetstream wieder abgebaut wird, wodurch sich die „normalen“ Bedingungen wieder einstellen und die Passatwinde an Kraft gewinnen. Dieser Energieaustausch (Abbau) beschleunigt den vorgenannten Energieangleich und damit den Abbau des El Niño-Ereignisses.

Soweit zur Theorie, die sich erst noch anhand der Realität bestätigen oder verworfen werden muss. Dies wird Ende dieses Jahres sein.

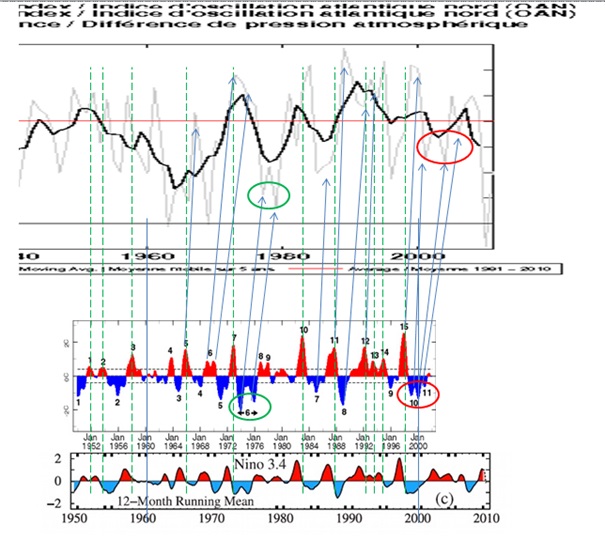

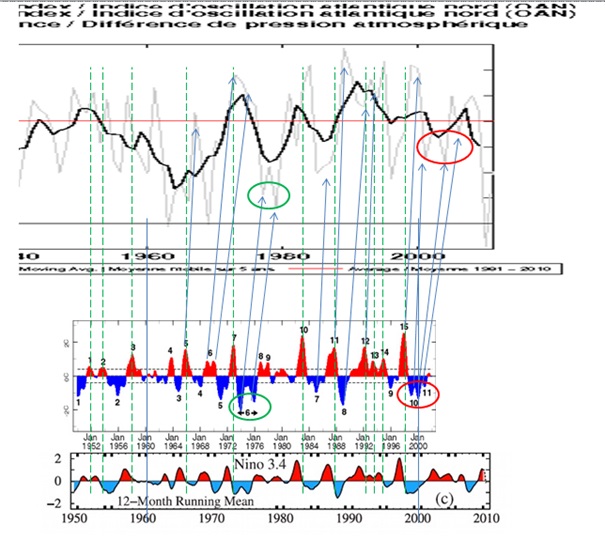

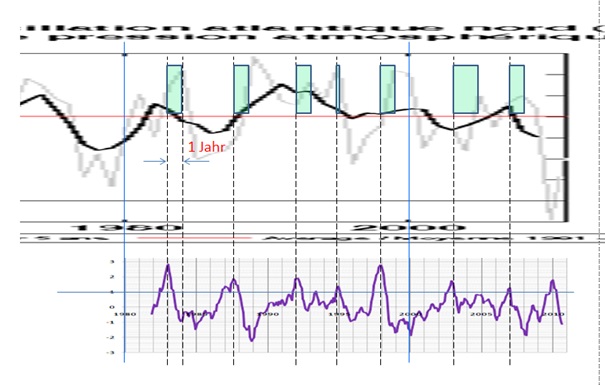

Wenn ein El Niño sich so verhält und auf diese Weise seine Auswirkungen an Ferrel- und/oder Polarzelle weitergibt, dann sollte sich auch sein „Fingerabdruck“ dort finden lassen. Exakt, der Verlauf des El Niño 3.4 (oder seiner größeren „Schwester“, der ENSO) sollten sich auch in den Parametern der Ferrel-Zelle abzeichnen. Daher soll die NAO, die unser Wettergeschehen in Europa maßgeblich beeinflusst, mit der ENSO in Relation gesetzt werden, Abb.29.

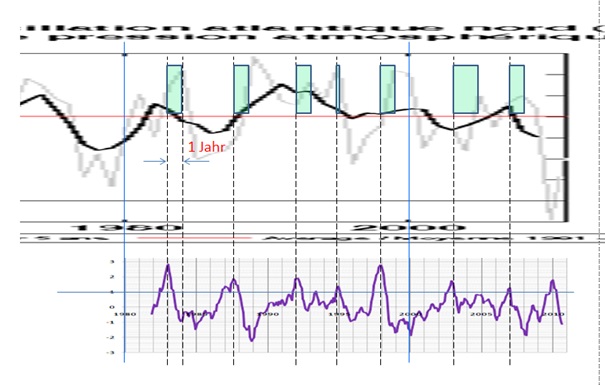

Abb.29 zeigt, dass NAO und ENSO zusammenhängen und deren Extrema weitgehend identisch sind. Wobei die Ereignisse in der NAO mit einem zeitlichen Versatz von ca. 1 Jahr auftreten. Markante Ereignisse in der ENSO (rote und grüne Ovale) hinterlassen in der NAO regelrecht ihren Fingerabdruck.

Wie eingangs gezeigt, lässt sich der gesamte Temperaturgang der letzten 35 Jahre, der Zeitraum also, der für die solare Abkopplung der Temperaturen und dem Temperaturantrieb durch Treibhausgase stehen soll, mit den El Niño-Ereignissen und damit der solaren Aktivität erklären. Diesem Beweis und der Logik, dass El Niño über die Drehimpulskopplung auf die anderen Zellen unmittelbaren Einfluss ausübt, müsste sich der Temperaturgang der letzten 35 Jahre genauso in der Ferrelzelle, ihren Parametern, abzeichnen und wie in Abb.30 gezeigt, zeitversetzt.

Abb.30 zeigt die NAO mit dem El Niño 3.4, der in Abb.7 den Beweis zum Temperaturgang erbrachte. Wie unschwer zu erkennen, tritt in der NAO jedes Maxima des El Niño 3.4 auf und mit einem Versatz von im Mittel 1 Jahr.

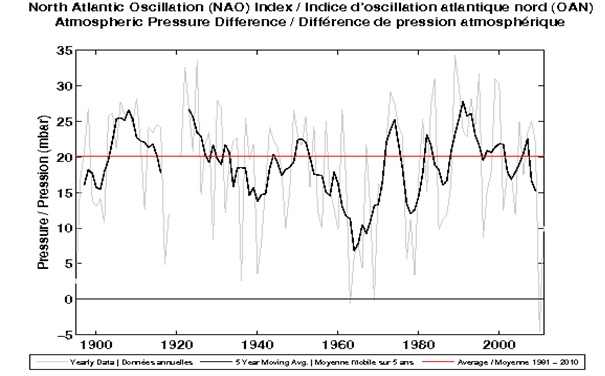

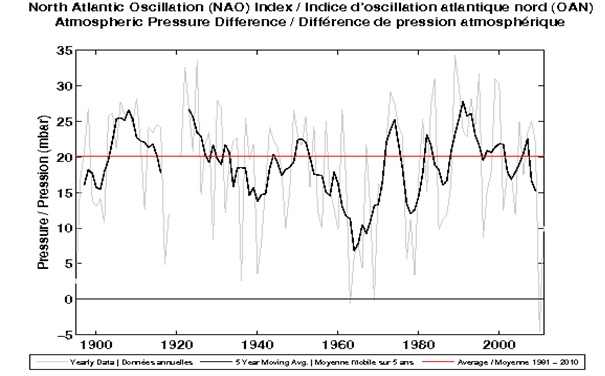

Abb.31 zeigt die Gesamtabbildung, aus der die NAO in Teilbereichen für den Vergleich in Abb.29 und Abb.30 stammt.

Abb.31 zeigt die verwendete Zeitreihe der NAO.

Wer die Wetter- und deren Klimageschehen verstehen will, der muss sich der Natur zuwenden. Insofern betrachtet der Autor die sog. Klimarealisten, als die Naturforscher unter den Klimaforschern, die das Erbe Alexander von Humboldts, einem der größten Naturforscher, leben. Das Zentrum zum Verständnis der Wetter- und Klimavorgänge, sofern ein statistischer Mittewert überhaupt als wissenschaftliches Refugium betrachtet werden darf, ist unser Zentralgestirn, die Sonne. Ihr gilt es, die Forschungsanstrengungen zu konzentrieren und die notwendigen Mittel dazu bereitzustellen, als diese für sinnlose Forschung in pseudowissenschaftlichen Bereichen, wie der von Treibhausgasen zu vergeuden und für "Forscher" bereitzustellen, die sich in immer aberwitzigeren Theorien und Horrorgeschichten verstricken, die sie dann einer unwissenden Presse- und Politikerschar verkaufen. Lenin nannte Journalisten einst "nützliche Idioten". Er hätte gewiss seine Freude, würde er sehen, wie ein Großteil der heutigen deutschen Journalistenschar seine Aussage immer wieder aufs Neue bestätigt.

El Niño – ein Rätsel. Wie beschrieben, Nein! Die Natur kennt keine Rätsel. Das Rätsel sind allein wir Menschen. Betrachten wir die Natur doch immer nur mit unseren eigenen Augen und spiegeln damit lediglich die Natur an uns selbst, wodurch zwangsläufig ein Zerrbild entsteht (was übrigens durch die Quantentheorie begründet ist, aber dies ist ein anderes Thema). Dabei gilt es, sich diesem bewusst zu sein und es zu erkennen. Dies gelingt einzig durch unseren Verstand und unsere Fähigkeit zu denken. So entsteht „Blindheit“, wenn Verstand und Denken abgeschaltet und/oder durch ideologische Vorgaben außer Kraft gesetzt werden. Insofern wird das Verhalten des IPCC und ihrer nahestehenden Institute erkenn- und begründbar und insbesondere das der deutschen Presse, bei der es aussieht, als ob der Verstand und das Denken durch ideologische „Blindheit“ außer Kraft gesetzt ist und daher solche Artikel entstehen, wie der eingangs genannte von Fokus. In Kenntnis der kurz angerissenen menschlichen Eigenschaften geht der Autor davon aus, dass der deutsche Leser von ideologischen Zerrbildern in der Wissenschaft und ihrer Berichterstattung, auch in Zukunft nicht verschont bleiben wird. Um das entstandene Zerrbild wieder der Natur anzugleichen und damit der Realität zuzuführen, gibt es die Wissenschaftler von EIKE. Wir werden unseren Lesern die Natur zeigen, wie sie ist. Ohne Zerrbilder und ohne ideologische Verblendung. Einfach nur schön anzusehen…

Raimund Leistenschneider – EIKE