Nach zehn Jahren der internationalen Zusammenarbeit bei der Entwicklung von Reaktoren der sogenannten "vierten Generation" erschien eine Überarbeitung der Ursprünglichen Fahrplanes aus dem Jahre 2002 erforderlich (https://www.gen-4.org/gif/upload/docs/application/pdf/2014-03/gif-tru2014.pdf). In der letzten Dekade ist viel geschehen: Dies betrifft die Zusammensetzung und Forschungsintensität der Mitglieder, die bereits gewonnenen Erkenntnisse und nicht zuletzt die Veränderung der äußeren Randbedingungen (Shale Gas Boom, Fukushima, etc.).

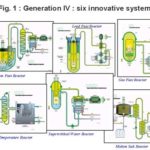

Es ist bei den ursprünglich ausgewählten sechs Konzepten geblieben. Neue sind nicht hinzugekommen. Mehrere teilnehmende Länder haben bedeutende Mittel in die Entwicklung natriumgekühlter Reaktoren mit einem schnellen Neutronenspektrum (sodium-cooled fast reactor, SFR) und gasgekühlten Reaktoren mit möglichst hoher Betriebstemperatur (very-high-temperature reactor, VHTR) investiert.

Die restlichen vier Konzepte: Mit Wasser im überkritischen Zustand gekühlte Reaktoren (SCWR), bleigekühlte Reaktoren mit schnellem Neutronenspektrum (LFR), gasgekühlte Reaktoren mit schnellem Neutronenspektrum (GFR) und mit Salzschmelzen gekühlte Reaktoren wurden — mehr oder weniger — auf Sparflamme entwickelt.

Ziele

Weiterhin gelten als zentrale Anforderungen an die sogenannte vierte Generation folgende vier Bereiche:

· Nachhaltigkeit

· Sicherheit und Verfügbarkeit

· Wirtschaftliche Wettbewerbsfähigkeit

· nicht zur Produktion von Waffen geeignete Technologien und ein physikalischer Schutz gegen jedwede Einwirkungen von Außen (Naturkatastrophen, Terrorismus etc.).

Interessant ist in diesem Zusammenhang die Definition der vier Generationen: Die ersten Reaktoren der Baujahre 1950-1960 (z. B. Shippingport, Dresden, MAGNOX usw.) werden als Demonstrationskraftwerke verstanden und sind bereits stillgelegt. Die zweite Generation umfaßt die Baujahre 1970-1990 und stellt die überwiegend heute im Betrieb befindlichen Leichtwasser- und Schwerwasserreaktoren dar. Die dritte Generation wird als die Leichtwasserreaktoren der Baujahre 1990-2000 definiert, wobei die Reaktoren nach dem Jahr 2000 als Generation III+ bezeichnet werden. Sie stellen eine evolutionäre Weiterentwicklung der Druck- und Siedewassertechnologie dar. Die Vielzahl unterschiedlichster Reaktortypen der Anfangsjahre, hat sich also auf lediglich zwei Bauarten verengt. Die Weiterentwicklungen der schwerwassermoderierten, der gasgekühlten und der metallgekühlten Reaktoren ist — zumindest, was die Stückzahlen anbetrifft — auf das Niveau von Demonstrationsanlagen zurückgefallen. Erst ab dem Jahr 2030 wird von der Einführung einer vierten Generation ausgegangen.

Als die zentralen Ziele für die vierte Generation wir dabei die Verringerung der Gesamtkosten über den Lebenszyklus eines Kraftwerks, eine nochmals verbesserte Sicherheit, ein möglichst großer Schutz vor missbräuchlicher Nutzung (Waffen, Terrorismus) und eine erhebliche Verringerung des (Atom)mülls gesehen.

Abgebrannte Brennelemente

Nach einer gewissen Zeit ist jedes Brennelement in einem Reaktor nicht mehr nutzbar und muß ausgetauscht werden. Im Sprachgebrauch der "Atomkraftgegner" ist es dann "Atommüll" der zudem auch noch für Jahrtausende tödlich sein soll. In Wirklichkeit sind in einem "abgebrannten" Brennelement eines Leichtwasserreaktors noch über 95% Brennstoff enthalten. Dieser Brennstoff muß und kann recycled werden. Aber selbst die übrig bleibenden Spaltprodukte sind keinesfalls wertlos. Aus wirtschaftlichen Gründen lohnt meist keine sofortige Aufbereitung. Es empfiehlt sich daher, diesen Atommüll (Müll in Bezug auf eine energetische Verwertung) für längere Zeit sicher zu lagern um ein Abklingen der Radioaktivität abzuwarten. Durch eine Nachbehandlung des Abfalls in geeigneten Reaktoren (mit schnellem Neutronenspektrum oder sog. Transmutation) kann diese notwendige Lagerzeit auf wenige hundert Jahre beschränkt werden. Eine "Endlagerung" ist weder nötig noch sinnvoll. Das übrig bleibende "Erz" — mit hohem Gehalt wertvollster Materialien — kann anschließend dem normalen Wirtschaftskreislauf zugeführt werden.

Die Aufgabe der nahen und mittleren Zukunft liegt in der Entwicklung und Realisierung solcher Kreisläufe mit möglichst geringen Kosten. Das bisher vorliegende "Henne-Ei-Problem" beginnt sich gerade von selbst zu lösen: Es gibt inzwischen weltweit große Mengen abgebrannter Brennelemente, die eine Aufbereitung mit unterschiedlichsten Verfahren im industriellen Maßstab möglich machen. Viele dieser Brennelemente sind bereits soweit abgelagert (die Strahlung nimmt in den ersten Jahren besonders stark ab), daß sich ihre Handhabung stark vereinfacht hat.

Ein "Endlager" — besser ein Lager mit sicherem Einschluß über geologische Zeiträume — ist nur für die Abfälle nötig, deren Aufbereitung zu kostspielig wäre. Dieser Weg wird bereits für Abfälle aus der Kernwaffenproduktion beschritten. Dafür reicht aber maximal ein "Endlager" pro Kernwaffenstaat aus.

In naher Zukunft wird sich ein weltweiter Austausch ergeben: Es wird unterschiedliche Wiederaufbereitungsanlagen in verschiedenen Ländern geben. Die Kraftwerksbetreiber können diese als Dienstleistung nutzen. Die dabei wiedergewonnen Wertstoffe werden auf speziellen Märkten gehandelt werden. Wer zukünftig beispielsweise einen "Brutreaktor" bauen möchte, kann sich das für die Erstbeladung notwendige Plutonium auf diesem Markt zusammenkaufen. Wem die Mengen langlebiger Aktinoiden zu groß werden (Lagerkosten) kann diese an Betreiber von schnellen Reaktoren oder Transmutationsanlagen zur "Verbrennung" abgeben. Es wird sich genau so ein Markt für "nukleare Müllverbrennungsanlagen" etablieren, wie er heute für Industrie- und Hausmüll selbstverständlich ist.

Ebenso wird es kommerzielle "Endlager" geben, die gegen (teure) Gebühren Restmengen aufnehmen, die sich anderweitig nicht mehr wirtschaftlich verwenden lassen. Gerade Deutschland ist weltweit führend, in Erwerb und Endlagerung von hoch toxischen Abfällen in ehemaligen Salzbergwerken. Hier ist es auch sprachlich gerechtfertigt, von Endlagern zu sprechen, da die dort eingelagerten Stoffe — anders als radioaktive Stoffe — nie verschwinden werden. "Gefährlich" ist (zumindest in Deutschland) halt nur eine Frage des ideologischen Standpunktes.

Die sechs Systeme

Im Jahre 2002 wurden aus über 100 Vorschlägen sechs Konzepte ausgewählt. Leitgedanke dabei war, aus verschiedenen Reaktortypen symbiotische Systeme zu bilden. Beispielsweise durch die Verknüpfung von Leichtwasserreaktoren mit Reaktoren mit schnellem Neutronenspektrum, sodaß der "Abfall" des einen Reaktortyps als Brennstoff für den anderen dienen kann. In diesem Sinne, konzentrierte man sich nicht auf die Entwicklung eines einzelnen neuen Reaktors, sondern wählte sechs Konzepte aus, aus denen ein weltweites Netz aufgebaut werden könnte. Jeder einzelne dieser sechs ausgewählten Konzepte hat ganz spezielle Vor- und Nachteile, die es jedem Land ermöglichen sollte, für seinen speziellen Bedarf, das geeignete Modell auswählen zu können. Es geht also eher darum, Möglichkeiten zu eröffnen, als Konzepte fest zu schreiben. Dies ist ein sehr flexibler und (theoretisch) Kosten sparender Ansatz, da jedes Land seine besonderen Stärken (Werkstofftechnik, Fertigungstechnik, Datenverarbeitung etc.) in die gemeinsame Forschung und Entwicklung einbringen kann, ohne sich ein komplettes Entwicklungsprogramm für einen einzelnen Reaktor aufbürden zu müssen. Insbesondere auch kleinen Ländern, mit beschränkten Ressourcen steht es offen, sich zu beteiligen.

Die ursprünglich ausgewählten Konzepte sind alle in den letzten zehn Jahren verfolgt worden und sollen auch weiter entwickelt werden. Allerdings haben sich durch neue Erkenntnisse und einem unterschiedlichen finanziellen Einsatz in den beteiligten Ländern, der ursprünglich geplante Zeitplan etwas verschoben. Die Entwicklung wurde in jeweils drei Phasen unterteilt.

Zeitplan

Für alle sechs Reaktortypen sollten die Machbarkeitsstudien als erste Phase bereits abgeschlossen sein. Bei der Machbarkeitsstudie sollten alle relevanten Probleme geklärt worden sein und insbesondere für kritische Eigenschaften, die später sogar eine Aufgabe erforderlich machen könnten, zumindest Lösungswege aufgezeigt werden. Für Salzbadreaktoren glaubt man diese Phase nicht vor 2025 und für gasgekühlte Reaktoren mit schnellem Neutronenspektrum, nicht vor 2022 abschließen zu können.

In der Durchführungsphase sollten alle Materialeigenschaften, Berechnungsverfahren etc. entwickelt und als Prototypen getestet und optimiert sein. Diese Phase wurde bisher bei keinem Konzept abgeschlossen. Am weitesten vorn im Zeitplan, liegen der mit Natrium gekühlte schnelle Reaktor (erwartet 2022) und der mit Blei gekühlte schnelle Reaktor (erwartet 2021).

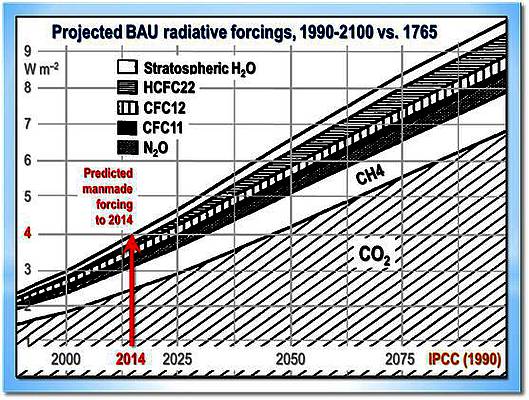

Aus heutiger Sicht wird deshalb kein Reaktor die Demonstrationsphase bis zum Jahr 2030 abschließen können. Bevor eine kommerzielle Anlage in Angriff genommen werden kann, muß wenigstens ein Demonstrationskraftwerk (einschließlich dem erforderlichen Genehmigungsverfahren!) errichtet worden sein und einige Jahre Betriebserfahrung gesammelt haben. Selbst in Ländern mit durchweg positiver Einstellung zur Nutzung der Kernenergie und einem gewissen Pioniergeist (ähnlich der 1950er Jahre) dürfte dies ein ehrgeiziges Ziel sein. Zumal kein wirklicher Zeitdruck vorliegt: Es gibt genug Natururan zu günstigen Preisen, die Mengen abgebrannter Brennelemente sind immer noch so gering, daß kein Kostendruck zur Beseitigung von "Atommüll" existiert und der Bedarf an Prozeßwärme mit hoher Temperatur kann problemlos durch kostengünstiges Erdgas gedeckt werden. Es bleibt die Erzeugung elektrischer Energie: Die kann aber problemlos und kostengünstig (im Vergleich zu Kohlekraftwerken mit Abgaswäsche) durch konventionelle Leichtwasserreaktoren erzeugt werden. China stellt dies eindrucksvoll unter Beweis.

Fukushimas Auswirkungen

Fukushima hat die Bedeutung für eine nach den Regeln der Technik entsprechende Auslegung und Bauweise gezeigt. Die Lehren aus dem Unglück beeinflussen nicht nur die in Betrieb befindlichen Kraftwerke, sondern auch zukünftige der vierten Generation. Schädigende Einflüsse von außen müssen bauartbedingt von den Reaktoren fern gehalten werden (z. B. Baugrund oberhalb von möglichen Flutwellen) und die Nachzerfallswärme muß auch über längere Zeit und in jedem Falle sicher abgeführt werden (z. B. passive Wasserkühlung aus oberen Tanks ausreichender Dimension).

Für die Reaktoren der vierten Generation sind umfangreiche Forschungsarbeiten zur Beantwortung dieser Fragen notwendig. Dies betrifft insbesondere das Verhalten der andersartigen Kühlmittel (Helium, Natrium, Blei etc.) und die teilweise wesentlich höheren Temperaturen (Werkstoffe, Temperaturschocks etc.). Hinzu kommt die höhere Energiedichte in den Kernen und etwaige Brennstoffkreisläufe in unmittelbarer Nähe.

Gasgekühlter schneller Reaktor (GFR)

Bei dem GFR (Gas-cooled Fast Reactor) handelt es sich um einen mit Helium gekühlten Reaktor mit schnellem Neutronenspektrum. Durch schnelle Neutronen lassen sich alle Aktinoiden — also alle radioaktiven Elemente mit langen Halbwertszeiten — spalten. Dies ist heute der Hauptgrund, warum man diese Entwicklung verfolgt. Man könnte mit solchen Reaktoren die "Endlagerfrage" eindeutig beantworten: Man braucht faktisch kein Endlager mehr, weil sich das Problem der potentiellen "Gefahr durch strahlenden Atommüll" auf technische Zeiträume von weniger als 300 Jahren reduziert. Damit ist auch klar, warum sich die "Anti-Atomkraftbewegung" mit besonderer Vehemenz — und auch Gewalttätigkeit — gegen den Bau solcher Reaktoren gewandt hat. Würden solche Reaktoren mit Wiederaufbereitung abgebrannter Brennelemente eingesetzt, wäre ihnen ihr Totschlagargument von angeblich über Millionen Jahre zu sichernden Endlagern entzogen. Die (deutsche) Scharade einer "Standortsuche" wäre schlagartig zu Ende.

Ein mit Helium gekühlter Reaktor mit schnellem Neutronenspektrum hat jedoch einen systembedingten Nachteil: Wegen des angestrebten Neutronenspektrums darf ein solcher Reaktor nur geringe Mengen an Materialien enthalten, die Neutronen abbremsen. Idealerweise würde er nur aus Brennstoff und Kühlmittel bestehen. Seine Fähigkeit "Wärme" zu speichern, ist sehr gering. Jede Leistungsänderung führt somit zu starken und schnellen Temperaturänderungen. Ein ernster Nachteil bei einem Verlust des Kühlmittels. Allein die Nachzerfallswärme könnte zu schwersten Schäden führen. Ebenso ist eine passive Nachkühlung kaum realisierbar. Helium ändert — anders als Wasser — nur geringfügig seine Dichte bei Temperaturänderungen. Man wird daher immer auf aktive Nachkühlung angewiesen sein. Die Ereignisse von Fukushima haben die Genehmigungsfähigkeit dieses Reaktorprinzips nicht unbedingt erhöht.

In nächster Zukunft müssen Gebläse bzw. Turbinen entwickelt werden, die Helium mit hoher Temperatur (Betriebstemperatur 850 °C) und unterschiedlichen Drücken (zwischen 1 und 70 bar) zuverlässig befördern können. Für die Kreisläufe zur Abführung der Nachzerfallswärme sind sicherheitsrelevante Ventile zu entwickeln und zu testen. Es sind zuverlässige Antriebskonzepte für die Notkühl-Gebläse zu entwickeln. Nach den Erfahrungen in Fukushima keine ganz einfache Aufgabe.

Die infrage kommenden Legierungen und Keramiken für die Brennelemente sind ausgiebig zu testen. Gleiches gilt für die Hüllrohre. Es müssen im Störfall Temperaturen von etwa 2000 °C sicher beherrscht werden.

Mit der bisherigen Entwicklung sind die Probleme eher größer geworden. Es wird deshalb nicht mit einem Abschluss der Machbarkeitsstudien in den nächsten zehn Jahren gerechnet. Wegen der Langfristigkeit ist der Einsatz der Mittel eher verringert worden.

Bleigekühlter schneller Reaktor (LFR)

Bei dem Lead-cooled Fast Reactor (LFR) handelt es sich um einen Reaktor, der flüssiges Blei als Kühlmittel verwendet. Blei besitzt einen sehr hohen Siedepunkt (1743 °C), sodaß man mit diesem Reaktortyp sehr hohe Temperaturen ohne nennenswerten Druckanstieg erzeugen kann. Allerdings ist Blei bei Umgebungsbedingungen fest, weshalb man den gesamten Kreislauf stets auf über 328 °C halten muß. Es gibt also zusätzlich den neuen Störfall "Ausfall der Heizung". Blei ist chemisch recht beständig und reagiert — wenn überhaupt — ohne große Wärmefreisetzung mit Luft oder Wasser. Es schirmt Gammastrahlung sehr gut ab und besitzt ein gutes Lösungsvermögen (bis 600 °C) für Jod und Cäsium. Ferner trägt die hohe Dichte von Blei eher zu einer Rückhaltung als einer Verteilung von radioaktiven Stoffen bei einem schweren Störfall bei. Allerdings stellt die Undurchsichtigkeit und der hohe Schmelzpunkt bei allen Wartungsarbeiten und Sicherheitsinspektionen eine echte Herausforderung dar. Die hohe Dichte von Blei erschwert den Erdbebenschutz und erfordert neue (zugelassene) Berechnungsverfahren. Nach wie vor, ist die Korrosion von Stahl in heißem Blei mit Sauerstoff ein großes Problem. Hier ist noch sehr viel Forschung und Entwicklung nötig, bis ein dem heutigen Niveau von Leichtwasserreaktoren entsprechender Zustand erreicht wird.

In sowjetischen U-Booten wurden Reaktoren mit einem Blei-Wismut-Eutektikum (niedrigerer Schmelzpunkt) verwendet. Die dort (meist schlechten) gesammelten Erfahrungen sind nicht direkt auf das LFR-Konzept übertragbar. Die Reaktoren sind wesentlich kleiner, haben eine geringere Energiedichte und Betriebstemperatur und eine geringere Verfügbarkeit. Außerdem arbeiteten sie mit einem epithermischen und nicht mit einem schnellen Neutronenspektrum. Der Vorteil des geringeren Schmelzpunktes einer Blei-Wismut-Legierung ist nicht ohne weiteres auf eine zivile Nutzung übertragbar, da durch den Neutronenbeschuß Plolonium-210 gebildet wird. Es handelt sich dabei um einen starken Alphastrahler (Halbwertszeit 138 Tage), der den gesamten Kühlkreislauf kontaminiert.

Im Moment werden im Projekt drei verschiedene Konzepte verfolgt: Ein Kleinreaktor mit 10 bis 100 MWel in den USA (Small Secure Transportable Autonomous Reactor or SSTAR), ein Reaktor mit 300 MWel in Russland (BREST) und ein Reaktor mit mehr als 600 MWel in Europa (European Lead Fast Reactor or ELFR – Euratom).

Wenn man einen solchen Reaktor als Brüter betreiben will, benötigt man eine Mindestleistung. Je größer, je effektiver. Ein kleiner Reaktor, wie z. B. der SSTAR, ist nur als reiner "Aktinoidenbrenner" geeignet. Allerdings kann er sehr lange ohne einen Brennstoffwechsel betrieben werden. Will man Spaltmaterial erbrüten, ist ein häufiger Brennstoffwechsel unvermeidlich. Es empfiehlt sich deshalb, einen entsprechenden Brennstoffzyklus zu entwickeln. Es wird auf den Bau mehrere Reaktoren mit einer gemeinsamen Wiederaufbereitungsanlage hinauslaufen. Das Verfahren zur Wiederaufbereitung hängt wiederum von dem Brennstoffkonzept des Reaktors ab.

Ein besonderes Konzept, im Zusammenhang mit Blei, ist die Entwicklung einer Spallationsquelle (Japan, MYRRHA in Belgien usw.). In einem Beschleuniger wird ein Strahl von Protonen auf über 1 GeV beschleunigt und auf flüssiges Blei geschossen. Beim Auftreffen auf ein Bleiatom "verdampft" dieses seine Kernelemente. Es wird eine große Anzahl von Neutronen frei. Diese Neutronen werden von einem Mantel aus Aktinoiden absorbiert. Diese eingefangenen Neutronen führen teilweise zu einer Spaltung oder einer Umwandlung. Durch die Spaltungen wird — wie in jedem Kernreaktor — Wärme frei, die anschließend konventionell genutzt werden kann. Es entsteht aber keine selbsterhaltende Kettenreaktion. Wird der Beschleuniger abgeschaltet, brechen auch sofort die Kernreaktionen in sich zusammen. Es handelt sich hierbei also um eine Maschine, die primär der Stoffumwandlung und nicht der Energieerzeugung dient. Durch die Verwendung von Blei als "Neutronenquelle" und Kühlmittel sind aber alle Erfahrungen und Probleme unmittelbar übertragbar.

Am weitesten scheint die Entwicklung in Russland vorangeschritten zu sein. Man entwickelt einen bleigekühlten Reaktor mit 300 MWel (BREST-300) und betreibt die Weiterentwicklung der U-Boot-Reaktoren mit Blei-Wismut-Eutektikum als Kühlmittel (SVBR-100). Beide Reaktoren sollen bis zum Ende des Jahrzehnts erstmalig kritisch werden. In Europa plant man eine Demonstrationsanlage mit 300 MWth (Advanced Lead Fast Reactor European Demonstrator, ALFRED).

Salzbadreaktoren (MSR)

Salzbadreaktoren (Molten Salt Reaktor, MSR) werden in zwei Gruppen eingeteilt: Reaktoren, bei denen der Spaltstoff im Salz selbst gelöst ist und Reaktoren, bei denen das flüssige Salz nur als Kühlmittel dient (Fluoride salt-cooled High-temperature Reactor, FHR).

Zwischen 1950 und 1976 gab es in den USA ein umfangreiches Entwicklungsprogramm, aus dem zwei Prototypen erfolgreich hervorgingen (Aircraft Reactor Experiment, ARE und Molten Salt Reactor Experiment, MSRE). Anfangs konzentrierte man sich in der Entwicklung auf Salzbadreaktoren mit thermischem Neutronenspektrum.

Ab 2005 entwickelte sich eine Linie, die von in Salz gelöstem Brennstoff und Spaltprodukten ausging. Als Kühlmittel soll ebenfalls Salz dienen. Das Neutronenspektrum soll schnell sein. Von dieser Kombination verspricht man sich einerseits das Erbrüten von Spaltstoff (z. B. Uran-233 aus Thorium-232) und andererseits das kontinuierliche "Verbrennen" von Minoren-Aktinoiden mit dem Ziel eines relativ kurzlebigen "Atommülls", der nur noch aus Spaltstoffen besteht. Durch das Salzbad möchte man hohe Betriebstemperaturen bei nahezu Umgebungsdruck erreichen. Bis zum Bau eines Reaktors, ist jedoch noch ein langer Weg zurück zu legen: Es müssen die chemischen (Korrosion) und thermodynamischen Zustandsdaten für solche n-Stoff-Salze bestimmt werden. Es müssen Verfahren zur kontinuierlichen Entgasung der Salzschmelze entwickelt werden, da ein großer Teil der Spaltprodukte (zumindest bei der Betriebstemperatur) gasförmig ist. Für das flüssige Salzgemisch müssen gekoppelte neutronenphysikalische und thermohydraulische Berechnungsverfahren geschaffen werden. Für die radioaktiven Salzgemische sind zahlreiche Sicherheitsversuche zur Datensammlung und Absicherung der Simulationsmodelle nötig. Die Chemie und Verfahrenstechnik der Aufbereitung während des Reaktorbetriebs muß praktisch noch vollständig getestet werden.

Natriumgekühlter schneller Reaktor (SFR)

Der Sodium-cooled Fast Reactor (SFR) verwendet flüssiges Natrium als Kühlmittel. Natrium hat nahezu ideale Eigenschaften: Relativ geringer Schmelzpunkt (98 °C), aber hoher Siedepunkt (890 °C), sehr gute Wärmeleitfähigkeit (140 W/mK) bei annehmbarer Wärmekapazität (1,2 KJ/kgK). Es hat keine korrosiven Eigenschaften, reagiert aber heftig unter Wärmefreisetzung mit Luft und Wasser. Bisher wurden bereits 17 Reaktoren gebaut und drei weitere befinden sich in Russland, Indien und China im Bau.

Ursprüngliches Ziel war die Erschaffung eines "schnellen Brüters". Mit ihm sollte mehr (thermisch) spaltbares Plutonium erzeugt werden, als dieser Reaktortyp zu seinem Betrieb benötigte. Dieses zusätzlich gewonnene Plutonium sollte dann zum Start weiterer Reaktoren verwendet werden. Inzwischen gibt es aus dem Betrieb von Leichtwasserreaktoren und der Rüstungsindustrie mehr als genug Plutonium auf der Erde. Darüber hinaus sind die Natururanvorräte nahezu unerschöpflich. Deshalb hat sich die Zielrichtung in den letzten Jahren verschoben. Die benutzten Brennelemente aus Leichtwasserreaktoren werden von "Atomkraftgegnern" abfällig als "Atommüll" bezeichnet. In Wirklichkeit sind aber das gesamte enthaltene Uran und Plutonium (weit über 95 %) vollständig zur Energiegewinnung nutzbar. Gerade aus dem wertvollsten Material — dem Plutonium — wird wegen dessen langer Halbwertszeit der Bedarf eines Endlagers und dessen "sicherer Einschluß über Millionen von Jahre" konstruiert. Selbst die Spaltprodukte — als tatsächlicher Abfall der Energieerzeugung durch Kernspaltung — sind (wirtschaftlich) nutzbar.

Man geht heute von einer Erstbeladung eines schnellen natriumgekühlten Reaktors mit einem Gemisch aus Uran und knapp 20% Plutonium aus. Das Plutonium gewinnt man aus den abgebrannten Brennelementen der Leichtwasserreaktoren. Die abgebrannten Brennelemente eines solchen schnellen Reaktors werden nach angemessener Zwischenlagerung in einem elektrochemischen Prozeß (wie z. B. bei der Kupfer- und Aluminiumproduktion) wieder aufbereitet. Bei diesem Wiederaufbereitungsverfahren liegt der Schwerpunkt in der Gewinnung möglichst reiner (kurzlebiger) Spaltprodukte. Alle langlebigen Aktinoiden werden wieder in den neuen Brennelementen weiter verwendet. Das "verbrauchte" Uran und Plutonium wird dabei durch "Atommüll" aus Leichtwasserreaktoren ergänzt. Ein solcher Reaktor gleicht also einer "Müllverbrennungsanlage", in der ja auch "gefährliche Stoffe" unter gleichzeitiger Stromerzeugung beseitigt werden.

Natriumgekühlte Reaktoren können in beliebiger Größe gebaut werden. Lediglich wenn man Brennstoff erbrüten will (d. h. mehr Plutonium produzieren als man verbraucht) muß der Reaktor geometrisch groß sein, um Neutronenverluste zu vermeiden. Gerade "Aktinoidenbrenner" können sehr klein und kurzfristig gebaut werden. Die Entwicklung bezieht sich auf die Kombination aus Brennstoff (oxidisch, metallisch, karbidisch und Nitride möglich) und die Wiederaufbereitung (naßchemisch, pyrotechnisch). Es gilt die optimale Kombination aus Werkstoffen und Verfahren zu finden. Ferner sind homogene Brennstoffe und spezielle heterogene Anordnungen zur Verbrennung von Minoren-Aktinoiden denkbar. Diese Anordnungen koppeln wieder auf die Neutronenphysik, die Regelung und damit letztendlich auf die Sicherheit zurück.

Reaktor mit überkritischem Wasser (SCWR)

Wird Wasser oberhalb des kritischen Punktes (374,12 °C bei 221,2 bar) verwendet, ändert es radikal seine chemischen und physikalischen Eigenschaften. Entscheidend ist die kontinuierliche Änderung der Dichte. Es gibt nicht mehr das gleichzeitige Auftreten von Dampf und Flüssigkeit (z. B. Blasen) in einem Behälter.

Ziel von "überkritischen Kesseln" ist die Steigerung des Wirkungsgrades. So sind heute in modernen Kohlekraftwerken Wirkungsgrade von 46 % möglich. Für den Supercritical-water-cooled reactor (SCWR) ist ein Wirkungsgrad von 44 % angestrebt. Die leidvolle Entwicklungsgeschichte bei konventionellen Kraftwerken hat jedoch gezeigt, daß die Steigerung von Druck und Temperatur mit erheblichen Werkstoffproblemen und damit Kosten verbunden ist. Solange Kernbrennstoff so billig wie heute sind, scheint dieser Weg bei Reaktoren zumindest wirtschaftlich nicht sinnvoll.

Die gesamte Sicherheitstechnik muß neu durchdacht und experimentell bestätigt werden. Es gibt keine lokale Selbstregelung durch Dampfblasenbildung mehr. Die Gefahr von überhitzten Stellen im Kern muß schon im Normalbetrieb sicher beherrscht werden. Die Notkühlsysteme müssen bei einem Druckabfall sowohl im überkritischen Zustand, als auch im Zwei-Phasenbereich voll wirksam sein. Man kann sich nicht mehr auf den Wasserstand als Stellgröße verlassen, sondern muß auf den Durchfluß übergehen, was wesentlich schwerer zu realisieren ist. Die Wasserchemie ist im überkritischen Zustand wesentlich anders und schwerer zu beherrschen.

Bisher wurden nur Tests mit Komponenten ausgeführt. Man hofft auf dieser Basis in den nächsten fünf Jahren eine Entscheidung für den Bau eines Prototyps fällen zu können. Bis zu einem kommerziell nutzbaren Reaktor dürften noch weit über 20 Jahre vergehen.

Hösttemperaturreaktor (VHTR)

Der Very-High-Temperature Reactor (VHTR) ist eine Weiterentwicklung eines mit Helium gekühlten Reaktors mit thermischem Neutronenspektrum. Es gibt die — ursprünglich in Deutschland entwickelte — Anordnung der Brennelemente als Kugelhaufen oder eine prismatischer Anordnung. Ziel war immer das Erreichen von Betriebstemperaturen von nahezu 1000 °C. Dieser Reaktortyp sollte primär als Wärmequelle in der Verfahrenstechnik (Kohleveredlung etc.) dienen. In diesem Sinne war ein Meilenstein immer das Erreichen einer Temperatur von 950 °C, bei der eine rein thermische Zerlegung von Wasser über einen Schwefel-Jod-Prozeß möglich ist. Dies war als Fundament einer "Wasserstoffwirtschaft" gedacht. In Deutschland wurde das Konzept einer "kalten Fernwärme" entwickelt, in dem Methan im Kreislauf läuft und beim Verbraucher lediglich chemisch zerlegt wird und die Bestandteile anschließend wieder mit der Hilfe der Wärme des Kernreaktors wieder zusammengesetzt werden. Der Charme dieses Konzepts liegt in der Fähigkeit, Energie über große Entfernungen mit geringen Verlusten (wie ein Erdgasnetz) transportieren und auch speichern zu können. Stellt man das "Erdgas" synthetisch aus Kohle her, kann man dieses Gas in das vorhandene Erdgasnetz einspeisen. Interessanterweise wird dieser Gedanke in China aus den gleichen Gründen, wie damals in Deutschland, wieder aufgegriffen: Luftverschmutzung durch Kohle, bei (noch) geringen eigenen Erdgasvorkommen.

Die Entwicklung von Höchsttemperaturreaktoren ist im wesentlichen ein Werkstoffproblem. Wobei nicht übersehen werden darf, daß mit steigender Temperatur der Aufwand und die Kosten exponentiell ansteigen. Allerdings kann diese Entwicklung evolutionär durchgeführt werden. China scheint offensichtlich diesen Weg eingeschlagen zu haben. Ausgehend vom (Nachbau) des deutschen Kugelhaufenreaktors begibt man sich schrittweise vorwärts.

Im Rest der Welt, dürfte die Entwicklung durch die "Shale-Gas-Revolution" nur schleppend vorankommen, wenn nicht sogar eingestellt werden. Die Gasindustrie ist einfach cleverer. Man hat Millionenspenden in die Werbung für Sonnen- und Windenergie investiert. Wohl wissend, daß für jedes Windrad und jeden Sonnenkollektor die gleiche Backup-Leistung noch einmal in konventionellen Kraftwerken bereitgestellt werden muß. Gaskraftwerke sind aber mit Abstand die Kraftwerke, mit den geringsten Investitionskosten. Der bereits erfolgte Zubau kurbelt den Gasabsatz gewaltig an. Sollte das Gas durch die erhöhte Nachfrage zu teuer werden, bleibt den Energieversorgern (wie schon einmal) die Flucht in Kern- und — vor allem — Kohlekraftwerke. Deshalb investiert die Gasindustrie bereits konsequent in "Klimaschutz". Die Krönung wird die "Wasserstoffwirtschaft" sein. Man nutzt die frei werdenden Gasmengen zur Erzeugung von Wasserstoff. Das dabei anfallende CO2 läßt man sich möglichst durch eine CO2-Abgabe vergüten, um es anschließend in der Ölförderung zum dritten Mal zu verkaufen. Wer will, kann dieses Dreieckgeschäft aus Windenergie, Wasserstoffproduktion für Raffinerien und CO2 zur Ölförderung, schon in Texas studieren. Die Ironie der Geschichte könnte sein, daß gerade die "Alternativindustrie" mit ihrem Propagandafeldzug für "Klimaschutz" sich selbst den Ast absägt, auf dem sie (noch) so profitabel sitzt. Niemand hat z. B. mit China gerechnet, die ein atemberaubendes Tempo beim Ausbau der Kernenergie vorlegen. Das Märchen von Wind und Sonne, könnte sich auch hier bald als solches erweisen.

Klaus Dieter Humpich;

der Beitrag erschien zuerst bei NUKE Klaus am 25.04.14