Wird sich die globale Abkühlung 2014 fortsetzen?

Bild rechts: WoodForTrees.org – Paul Clark. Weitere Einzelheiten

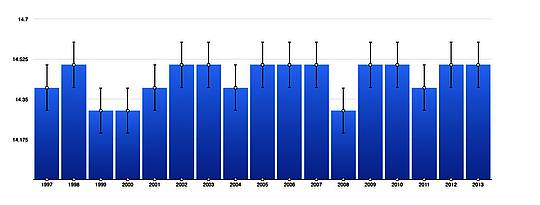

Man betrachte die Abbildung rechts. Sie zeigt den Temperaturverlauf von Januar 2001 bis 2004 und dann von Januar 2011 bis Januar 2014 nach den Daten von RSS [Satelliten]. Man sieht, dass der linke Punkt im roten Bereich höher liegt als der linke Punkt im grünen Bereich. Das bedeutet, dass der Januar 2001 wärmer ausgefallen war als der Januar 2011. Und wie sich zeigt, war das ganze Jahr 2001 wärmer als das Jahr 2011. Jetzt vergleiche man den rechten roten Punkt mit dem rechten grünen Punkt. Man sieht, dass der rechte rote Punkt höher als der rechte grüne Punkt liegt, der Januar 2004 also wärmer war als der Januar 2014. Welche logischen Vorhersagen kann man daraus ableiten?

(Jan 2001, Jan 2011); (2001 anomaly, 2011 anomaly);

(Jan 2002, Jan 2012); (2002 anomaly, 2012 anomaly);

(Jan 2003, Jan 2013); (2003 anomaly, 2013 anomaly);

(Jan 2004, Jan 2014); (2004 anomaly, 2014 anomaly?).

Man beachte, dass in den RSS-Daten die zweite Zahl in allen Fällen durchweg niedriger liegt als die erste Zahl. Was kann man an Stelle des * vorhersagen?

(0,101; 0,080), (0,246; 0,143);

(0,359; -0,064), (0,315; 0,187);

(0,440; 0,439), (0,320; 0,218);

(0,311; 0,262), (0,202; *).

Gibt es physikalische Gründe, um den "January Leading Indicator" von Walter Dnes zu erklären? Mit fallen einige ein. Vielleicht hat jemand noch andere Gründe parat.

1. Den Gesetzen der Mittelbildung zufolge sollte die Hälfte aller Januar-Monate über dem jährlichen Mittel und die andere Hälfte unter dem jährlichen Mittel liegen. Weisen mehr Januar-Monate hohe Zahlen auf, werden die End-Anomalien höher liegen als mit einer Anzahl von Monaten mit niedrigeren Zahlen.

2. Wenn also dem zufolge die Anomalie im Januar von 0,4 auf 0,3 zurückgeht, und unter der Annahme, dass die Anomalie im Jahr zuvor ebenfalls 0,4 betragen hatte und mit einer Wahrscheinlichkeit unter 50% für eine Anomalie unter 0,3 im neuen Jahr ist die Wahrscheinlichkeit für eine Anomalie unter 0,4 größer als umgekehrt.

3. Die Januar-Zahl kann so viel höher oder niedriger liegen, dass es 11 Monate normaler Werte bedarf, um den Effekt des sehr hohen bzw. niedrigen Januarwertes auszugleichen. Um es mit einer Analogie aus dem Bereich Sport auszudrücken: Zwei Teams mögen gleich stark sein, aber ein Team bricht in den ersten 5 Minuten ein und liegt danach bereits 3 Tore im Rückstand. Es ist sehr gut möglich, dass die restliche Spielzeit nicht ausreicht, um dieses Defizit auszugleichen. Walter Dnes‘ Methode ist analog der Möglichkeit, den Ausgang eines Spiels bereits nach 5 Minuten vorherzusagen.

4. Bob Tisdale zufolge zeigen sich Auswirkungen von El Nino- oder La Nina-Ereignissen oftmals im Januar, so dass in diesen Fällen offensichtlich ist, warum das restliche Jahr dem folgt.

5. Jeder andere Zyklus wie z. B. die Sonne, die derzeit mit jedem Jahr ruhiger wird, würde automatisch in den Anomalien des Januar reflektiert werden, ebenso wie über das restliche Jahr.

6. Wem fallen noch mehr Gründe ein?

In den folgenden Abschnitten möchte ich die jüngsten Fakten beschreiben. Die Informationen werden in drei Abschnitten dargestellt.

Im ersten Abschnitt wird gezeigt, wie lange in den unterschiedlichen Datensätzen keine Erwärmung mehr erkennbar ist. Im zweiten Abschnitt untersuchen wir, seit wann es in den verschiedenen Datensätzen keine statistisch signifikante Erwärmung mehr gegeben hat.

Im dritten Abschnitt vergleichen wir den Januar 2014 mit dem Januar 2013 sowie den wärmsten Jahren und Monaten jemals. Zusätzlich vergleiche ich auch den Januar 2014 mit dem Januar 2004.

Abschnitt 1

Diese Analyse zieht den jüngsten Monat heran, für den bei WoodForTrees.com (WFT) Daten zur Verfügung stehen. Alle Daten bei WFT sind auch von den spezifischen, unten genannten Quellen abrufbar. Wir beginnen mit heute und gehen zurück bis zum am weitesten zurück liegenden Monat, in dem die Steigung zumindest leicht negativ ist. Falls also die Steigung von September 4 X 10↑-4, von Oktober aber -4 X 10↑-4 beträgt, geben wir den Oktober an, so dass uns niemand vorwerfen kann, unehrlich zu sein, falls wir sagen, dass die Steigung von einem bestimmten Monat an flach verläuft.

In allen im Folgenden gelisteten Datensätzen liegt der erste Monat mit einer zumindest leicht negativen Steigung zwischen 9 Jahre und 1 Monat bis zu 17 Jahre und 5 Monate zurück.

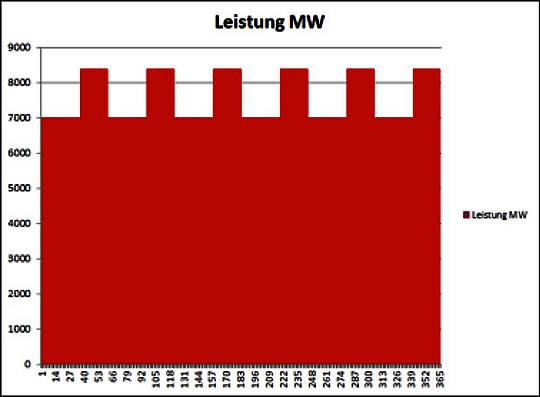

1. Bei GISS ist der Verlauf flach seit November 2001 oder seit 12 Jahren und 3 Monaten.

2. Bei Hadcrut3 ist der Verlauf flach seit August 1997 oder 16 Jahre und 6 Monate.

3. Bei einer Kombination der Daten von GISS, Hadcrut3, UAH and RSS ist der Verlauf flach seit Januar 2001 oder 13 Jahre und 1 Monat.

4. Bei Hadcrut4 ist der Verlauf flach seit Januar 2001 oder 13 Jahre und 1 Monat.

5. Bei Hadsst3 ist der Verlauf flach seit Dezember 2000 oder 13 Jahre und 2 Monate

6. Bei UAH ist der Verlauf flach seit Januar 2005 oder 9 Jahre und 1 Monat.

7. Bei den RSS-Daten ist der Verlauf flach seit September 1996 oder 17 Jahre und 5 Monate. Dieser Datensatz geht also schon über die von Ben Santer genannten 17 Jahre hinaus. (Alle Zählungen jeweils bis Januar).

Nachtrag: Die Anomalie für Februar 2014 ist inzwischen auch eingetroffen, und die Zeit beträgt nunmehr also 17 Jahre und 6 Monate; von September 1996 bis Februar 2014.*

[*In einem Anhang werden diese Punkte für jeden Datensatz extra noch ausführlicher dargestellt. Diese Zusammenstellung habe ich aus Zeitgründen nicht noch einmal übersetzt. A. d. Übers.]

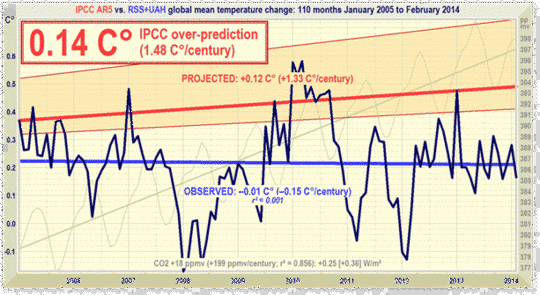

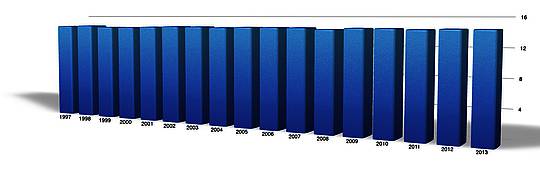

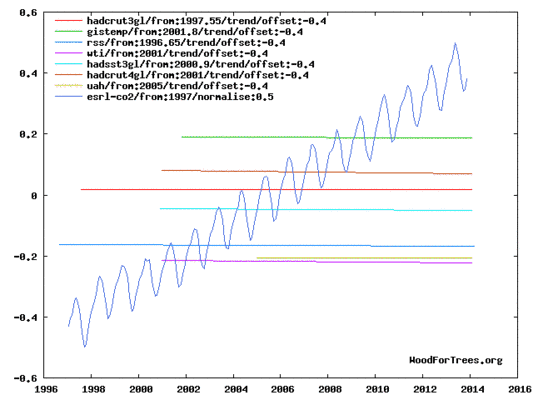

Die nächste Graphik zeigt das oben gesagte. Man betrachte es als Seitenweg-Graphik, in der die Länge der Linien die relative Zeitdauer zeigt, in der die Neigung Null ist. Zusätzlich zeigt die schwankende steigende Linie, wie der CO2-Gehalt in diesem Zeitraum zugenommen hat.

Www.WoodForTrees.org – Paul Clark

Obwohl ich zwei Dinge geplottet habe, zeigt sich links lediglich die Temperaturanomalie.

Die tatsächlichen Zahlen sind an sich bedeutungslos, da alle Linien eine Neigung nahe Null zeigen und die Lage einer jeden Linie lediglich eine Reflexion der Basisperiode ist, aus der die Anomalien für jeden Datensatz stammen. Hinsichtlich des CO2 wurden keine Zahlen genannt. Einige haben gefragt, ob man nicht den Log der CO2-Konzentration plotten könnte. Allerdings liefert WFT diese Option nicht. Die aufwärts gerichtete Steigung der CO2-Konzentration zeigt, dass der CO2-Gehalt während der letzten 17 Jahre zwar kontinuierlich gestiegen ist. Der Verlauf der Temperaturen jedoch ist für verschiedene Zeiträume in verschiedenen Datensätzen flach verlaufen.

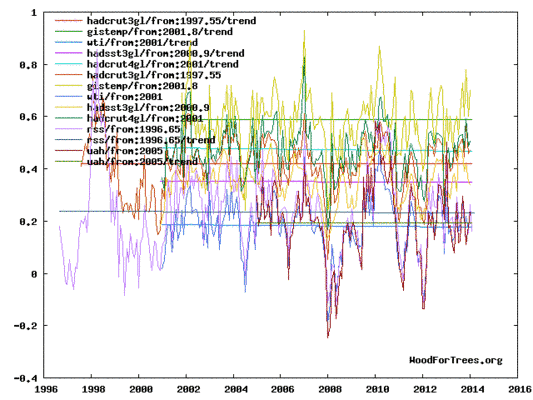

Die nächste Graphik zeigt das Gleiche, nur dass diesmal die Trendlinien zusammen mit den Datenpunkten geplottet sind und der CO2-Verlauf weggelassen worden ist.

www.WoodForTrees.org – Paul Clark

Abschnitt 2

Für diese Analyse wurden Daten von der Website Nick Stokes’ Trendviewer herangezogen. Diese Analyse zeigt, wie lange es den Kriterien von Nick zufolge keine statistisch signifikante Erwärmung mehr gegeben hat. Die Daten reichen bis zur letzten Aktualisierung in jedem Datensatz. In jedem Fall liegt die untere Grenze der Fehler-Bandbreite im negativen Bereich, so dass eine Neigung von Null im gezeigten Monat nicht ausgeschlossen werden kann.

In den verschiedenen Datensätzen zeigt sich keine statistisch signifikante Erwärmung in einem Zeitraum zwischen 16 und 21 Jahren.

Die Details für einige Datensätze folgen hier:

UAH: Seit Februar 1996: CI from -0.042 to 2.415

RSS: Seit November 1992: CI from -0.022 to 1.900

Hadcrut4: Seit Oktober 1996: CI from -0.027 to 1.234

Hadsst3: Seit Januar 1993: CI from -0.016 to 1.812

GISS: Seit September 1997: CI from -0.014 to 1.299

Abschnitt 3

Dieser Abschnitt zeigt Daten des Januar 2014 und andere Informationen in Form einer Tabelle. Die Tabelle zeigt die sechs Datenquellen von UAH, RSS, Hadcrut4, Hadcrut3, Hadsst3, GISS. In den Spalten steht Folgendes:

1. 13ra: Endrangfolge 2013 für jeden Datensatz.

2. 13a: Mittlere Anomalie für das Jahr 2013

3. Jahr: Diese Spalte zeigt das wärmste Jahr jemals für den jeweiligen Datensatz. Man beachte, dass zwei Datensätzen zufolge das Jahr 2010 und die übrigen vier das Jahr 1998 als das wärmste Jahr zeigen.

4. ano: Das Mittel der monatlichen Anomalien der in Spalte 3 genannten wärmsten Jahre.

5. mon: In diesem Monat zeigte der jeweilige Datensatz die höchste Anomalie. Die Monate werden durch die ersten drei Buchstaben eines jeden Monats und die letzten beiden Ziffern des jeweiligen Jahres gekennzeichnet.

6. ano: Die Anomalie des Monats aus Spalte 5

7. y/m: Nennt den längsten Zeitraum, in der die Neigung nicht positiv ist, dargestellt in Jahre/Monate. Dabei bedeutet 16/2, dass der Zeitraum 16 Jahre und 2 Monate beträgt, in der die Neigung Null war.

8. sig: Zeigt den ersten Monat ohne statistisch signifikante Erwärmung nach den Kriterien von Nick. Den ersten drei Buchstaben der Monate folgen die letzten beiden Ziffern des jeweiligen Jahres.

9. Jan14: zeigt die Anomalie im Januar 2014 in jedem Datensatz.

10. Jan13: Dito für den Januar 2013.

11. diff: Hier zeige ich lediglich, ob die Zahl des Januar 2014 negativ oder positiv gegenüber der Zahl des Januar 2013 ist. Eine negative Differenz bedeutet, dass 2014 kühler werden wird als 2013 und umgekehrt. Siehe Zeile 1 für den Rang 2013.

12. Jan14: Zeigt eine Wiederholung der Anomalie im Januar 2014 für den jeweiligen Datensatz. Ich wiederhole der Klarheit halber Zeile 9, weil Zeile 12 jetzt mit Zeile 13 verglichen wird.

13. Jan04: Die Anomalie des Januar 2004 für den jeweiligen Datensatz.

14. diff: hiermit kennzeichne ich einfach die Differenz, ob die Zahl im Januar 2014 positiv oder negativ ist im Vergleich zu der Zahl 2004. Eine negative Differenz bedeutet, dass das Jahr 2014 in der Vorhersage kühler ausfällt als das Jahr 2004 und umgekehrt.

15. 04rk: Hier zeige ich die Rangfolge des Jahres 2004 für jeden einzelnen Datensatz.

16. rnk: Dies ist die Rangfolge, die jeder einzelne Datensatz aufweisen würde, falls die Anomalie im Januar 2014 sich das ganze Jahr über fortsetzen würde. Natürlich wird das nicht der Fall sein, aber man betrachte es als eine Aktualisierung alle 5 Minuten in einem Spiel. Wegen der unterschiedlichen Basisperioden ist die Rangfolge aussagekräftiger als die mittlere Anomalie.

Tabelle

Nachtrag: Die RSS-Anomalie für Februar 2014 liegt vor und hat einen Wert von 0,162. Gemittelt mit der Januar-Anomalie von 0,262 ergibt sich 0,212. Dies würde das Jahr 2014 an die 11. Stelle legen, falls es über das Jahr so bliebe.

Welche Schlussfolgerungen kann man nun aus den obigen beiden Differenz-Sätzen ziehen? Im Folgenden gehe ich davon aus, dass die qualitative Vorhersage von Walter Dnes richtig bleibt und die Ergebnisse vorgibt.

UAH: der finale Rang wäre kälter als der 7., aber wärmer als der 12.

RSS: der finale Rang wäre kälter als der 11.

HadCRUT4: der finale Rang wäre kälter als der 11., aber wärmer als der 8*.

HadCRUT3: der finale Rang wäre kälter als der 7., aber wärmer als der 6*

HadSST3: der finale Rang wäre kälter als der 9., aber wärmer als der 6*.

GISS: der finale Rang wäre wärmer als der 6.

*Offensichtlich kann es keine Widersprüche geben. Wie Walter erklärt hatte, gibt es eine Menge Rauschen in diesen Zahlen. Um die wahre Vorhersage zu finden, müssen wir den Rang finden, der am Besten zum Januar 2014 passt. Die Zahlen des Januar 2004 lägen näher an der Linie in Walters Graphiken, so dass sie meiner Meinung nach die zuverlässigsten Schätzungen zeigen. Zu beachten ist dabei, dass meine Zahlen für Version 5.5 von UAH gelten, und ich habe Zahlen für HadSST3, die Walter nicht hatte. Darum kann ich diese nicht kommentieren. Allerdings sieht es so aus, als wäre Walter zufolge eine Abkühlung eher zu erwarten.

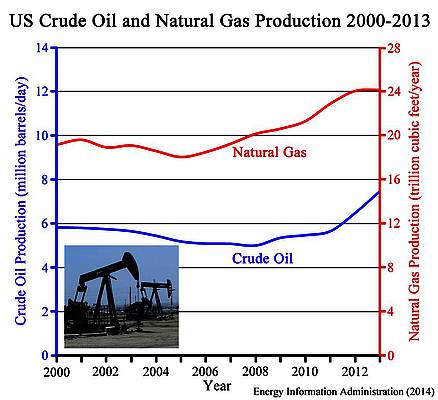

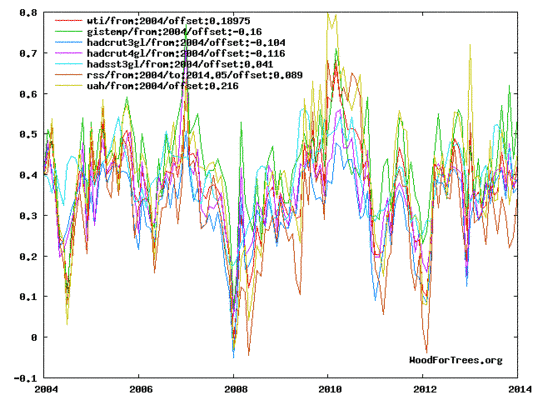

Siehe auch folgende Graphik:

www.WoodForTrees.org – Paul Clark

Alle Graphen beginnen beim Wert 0,4 für Januar 2004. Wenn man also sehen will, ob das Jahr 2014 wahrscheinlich wärmer oder kälter ausfällt als das Jahr 2004, muss man auf den Endpunkt, also Januar 2014 schauen, ob dieser unter oder über 0,4 liegt. Diers ist aber nur eine quantitative Schätzung.

Falls jemand alle der jüngsten Anomalien verifizieren will:

http://vortex.nsstc.uah.edu/public/msu/t2lt/tltglhmam_5.5.txt

For RSS, see: ftp://ftp.ssmi.com/msu/monthly_time_series/rss_monthly_msu_amsu_channel_tlt_anomalies_land_and_ocean_v03_3.txt

For HadCRUT4, see: http://www.metoffice.gov.uk/hadobs/hadcrut4/data/current/time_series/HadCRUT.4.2.0.0.monthly_ns_avg.txt

For HadCRUT3, see: http://www.cru.uea.ac.uk/cru/data/temperature/HadCRUT3-gl.dat

For HadSST3, see: http://www.cru.uea.ac.uk/cru/data/temperature/HadSST3-gl.dat

For GISS, see: http://data.giss.nasa.gov/gistemp/tabledata_v3/GLB.Ts+dSST.txt

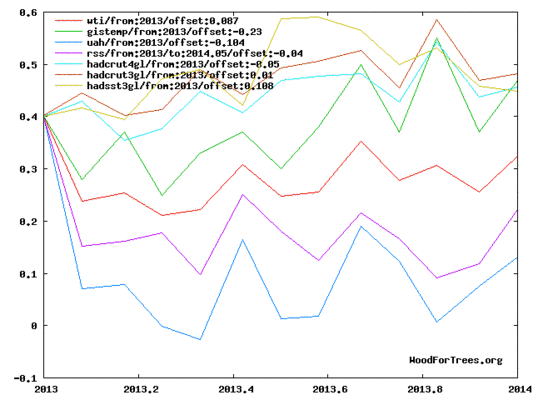

Um alle Punkte seit Januar 2013 in Form einer Graphik zu sehen, betrachte man die folgende WFT-Graphik:

www.WoodForTrees.org – Paul Clark

Wie man sieht, beginnen alle Linien an der gleichen Stelle im Januar. Das macht es einfach, den Januar 2013 mit dem Januar 2014 zu vergleichen.

Appendix

Anhang

In diesem Abschnitt werden die Daten für jeden Datensatz getrennt zusammengefasst. [Diese Einzelheiten werden hier nicht übersetzt; siehe Fußnote oben!]

Schlussfolgerung:

Walters Kriterien zufolge scheinen die Hinweise eher gemischt als eindeutig darauf hinzuweisen, ob dieses Jahr Erwärmung oder Abkühlung zeigen wird. Zeitweise sind die qualitativen Anhaltspunkte den Quantitativen Anhaltspunkten entgegengesetzt. Dies zeigt, dass es ganz schön viel Rauschen in den Daten gibt. Alles in allem scheint es aber etwas mehr Hinweise für eine Abkühlung zu geben. Meine Intuition sagt mir, in diesen Fällen der quantitativen Zahl zu vertrauen als den besten Hinweis für die Richtung, in die es gehen wird.

Ich würde sagen, solange sich nicht sehr schnell ein sehr starker El Nino einstellt, ist die Chance auf Erwärmung in diesem Jahr nur sehr gering, und der Zeitraum ohne Erwärmung wird weiter anwachsen. Ebenso wird auch der Zeitraum ohne statistisch signifikante Erwärmung immer länger werden. Oder?

Übersetzt von Chris Frey EIKE