Teil 1: Der Temperaturgang der letzten 35 Jahre – Was ihn steuert

Teil 2: 2014, ein El Niño-Jahr (?) – El Niño und seine solaren Auslöser über die letzten 1.000 Jahre

Teil 3: Warum und wie El Niño das Wettergeschehen in Europa und Nordamerika steuert

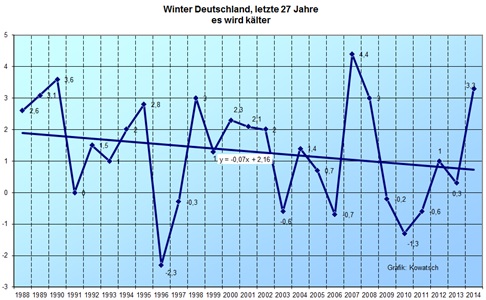

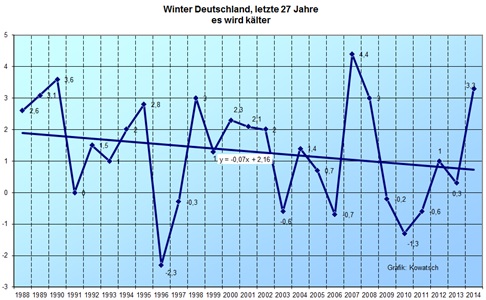

Abb.1, Quelle: Josef Kowatsch, Datenquelle: DWD, zeigt, dass auch der vergangene milde Winter nichts daran ändert, dass seit gut einem viertel Jahrhundert die Wintertemperaturen deutlich zurückgehen.

Überblick

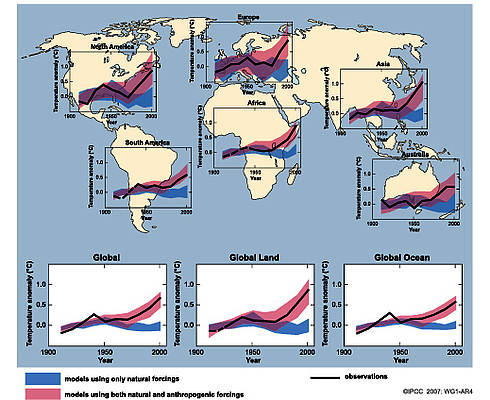

Im 1. Teil erfahren Sie, was die Erdmitteltemperaturen, wie sie z.B. im HadCRUT oder UAH veröffentlicht werden, steuert. Anhand von Belegen wird exakt aufgezeigt, wie die Erdmitteltemperaturen von El Niño-Ereignissen und diese wiederum von der variablen Sonne gesteuert werden. Das Wetter- und Klimageschehen damit vollständig von natürlichen Ursachen, der Aktivität unseres Zentralgestirns abhängt. Zur Erklärung des Wetters und seiner statistischen Größe, des Klimas, reicht allein die variable Sonne. Es wird gezeigt, dass, wie IPCC und Unterstützer gerne verlauten, es keine Abkopplung der Erd(mittel)temperaturen von der Sonnenaktivität gibt, sondern bewiesen, dass beide in exakter Weise zusammenhängen und synchron verlaufen, bis in die heutige Zeit. Zum Verständnis der Zusammenhänge wird zu Beginn die Wetteranomalie El Niño kurz erläutert und ihre globalen Auswirkungen gezeigt. Anschließend der Beweis geführt, dass ausschließlich solare Aktivität einen El Niño auslöst und somit das Wettergeschehen moderiert und wann der El Niño dabei ausgelöst wird.

Im 2. Teil werden die im Teil 1 gefundenen Korrelationen mit den Daten der letzten 140 Jahre abgeglichen und dadurch gezeigt, dass auch für diesen Zeitraum die gefundenen Beziehungen und Zusammenhänge bestehen. Darüber hinaus wird ein El Niño-Datenabgleich für die letzten 1.000 Jahre mit dem Hauptsonnenzyklus vorgenommen. Es wird gezeigt, dass immer dann ein El Niño-Ereignis stattfindet, wenn der Hauptsonnenzyklus in seiner Aktivität (nach seinem Aktivitätsminimum) wieder zu steigen beginnt. Anhand der Theorie des Autors wird anschließend dargelegt, dass Ende 2014 ein El Niño vorliegen wird, der zu Beginn 2015 sein Maximum (stärkste Ausprägung) erreicht.

Teil 3 zeigt, wie die Sonne ihre Energie auf die irdischen Wettersysteme einprägt. Die physikalischen Grundlagen dargelegt, über die die Auswirkungen von El Niño-Ereignissen global wirken und wie das Wettergeschehen (über die NAO) in Europa und Nordamerika diesen Parametern folgt.

Teil 1

Wer die Zeilen zu Beginn aufmerksam lass, wird feststellen, dass sich die Wissenschaftler und ihre Schreiberlinge geschickt ein Hintertürchen aufgelassen haben. So ist zu lesen „wahrscheinlich“. Nun, Wissenschaft ist die Lehre der Exaktheit. Wissenschaft ist sich sicher, bzw. stellt Thesen/Theorien auf, die dann an der Realität zu messen sind und ändern, sollte die Realität nicht im Einklang mit der Theorie stehen, die Theorie und versucht nicht, die Realität zu ändern (zu manipulieren), um die Theorie zu retten. Insofern zeigt dieses unscheinbar, eingefügte Wort, was es mit der Aussage auf sich hat, sie basiert auf Vermutungen, wie übrigens die gesamte Treibhaustheorie und hat demnach nichts mit Wissenschaft, sondern allenfalls etwas mit Pseudowissenschaft zu tun, wie sich so treffend der Physik-Nobelpreisträger, Ivar Giaever, ausdrückte.

Was verbirgt sich hinter El Niño? Eine kurze Erläuterung:

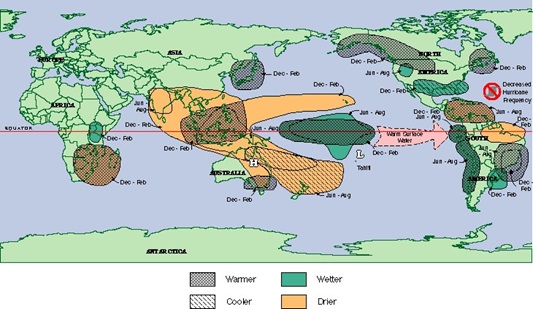

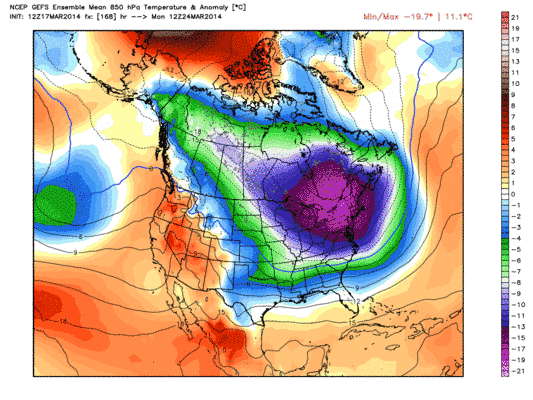

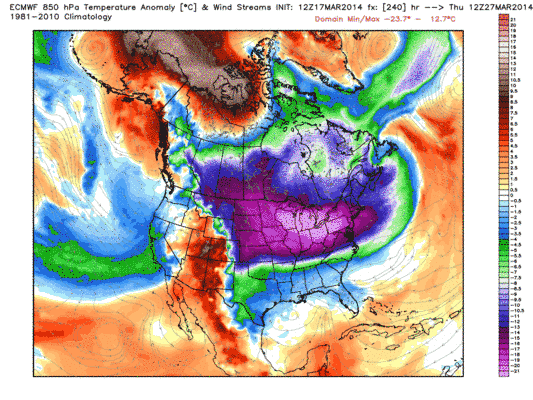

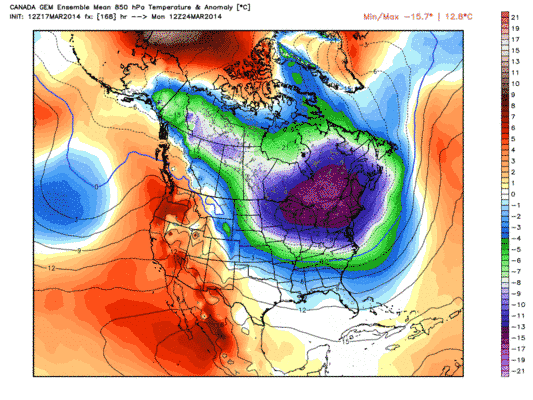

El Niño, ein in der Wissenschaft immer noch rätselhaftes Phänomen, dass scheinbar aus heiterem Himmel eintrifft und natürlich ebenfalls schon versucht wurde, von der Treibhausaktivisten für ihre Zwecke zu missbrauchen. Es gäbe eine Zunahme dieser Ereignisse und deren Stärke. Bereits der EIKE-Artikel von Herrn Lüning zeigt, dass beides nicht zutrifft (http://www.eike-klima-energie.eu/klima-anzeige/katastrophaler-focus-artikel-stellt-die-klimawissenschaften-auf-den-kopf-folgen-fuer-den-serioesen-wissenschaftsjournalismus-sind-fatal/). Aber, steht in 2014 wirklich ein El Niño an? Um die Antwort vorwegzunehmen: Anhand der wissenschaftlichen Untersuchungen des Autors, Ja! Er hat dies bereits in 01/2011 und 09/2011 auf EIKE veröffentlicht und gezeigt, warum. Seine Theorie erklärt nicht nur das Eintreten von El Niños, sondern auch dessen globale Auswirkungen, die bis in die Polarzelle reichen. So hat Prof. Brönnimann (ETH) nachgewiesen (”Extreme climate of the global troposphere and stratosphere in 1940–42 related to El Niño”, Nature 431, 971-974, 21. Oktober 2004), dass in den 40er Jahren des 20. Jahrhunderts über mehrere Jahre eine ungewöhnlich hohe Temperaturschwankung vorlag, die auf El Niño-Ereignissen beruhte. Aus alten meteorologischen Messdaten konnte er die atmosphärischen Verhältnisse auf der Nordhalbkugel zu Beginn der 1940er Jahre rekonstruieren. Dass El Niño-Ereignisse nicht regional, auf die Hadley-Zelle begrenzt sind, zeigt Abb.2.

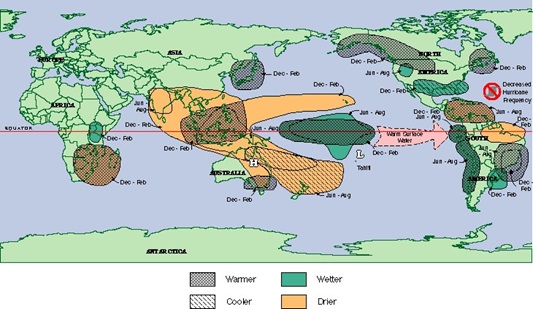

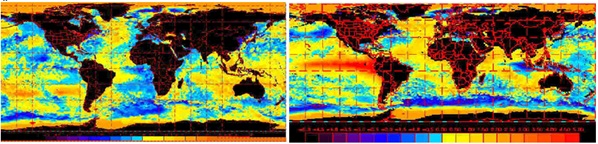

Abb.2 El Niño-Ereignisse haben Auswirkungen auf die Großwetterlagen weltweit (Quelle: South Carolina State Climatology Office). Die als ENSO (El Niño und Südliche Oszillation) benannte natürliche Schwingung hat über den pazifischen Raum Auswirkungen auf die Globaltemperaturen, Nord- und Südamerikas, Afrikas und Europas. Das El Niño-Ereignis betrifft somit nicht nur den pazifischen Raum, sondern weltweit sind einschneidende Folgen bemerkbar, so z.B. in Afrika. Dort machen im Süden des Landes starke Dürreperioden den Menschen zu schaffen. In Somalia hingegen werden ganze Dörfer von sintflutartigen Regenfällen weggespült.

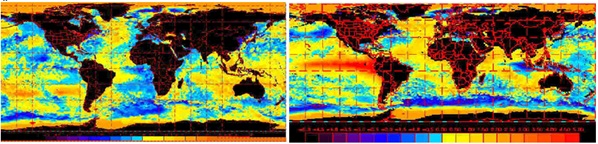

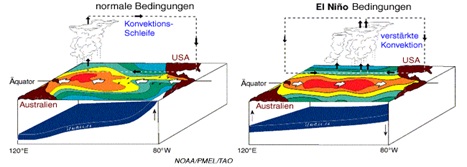

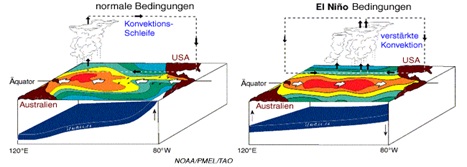

Dabei sind die Passatwinde der Motor der El Niño-Ereignisse. Die Passatwinde verlaufen aufgrund der Corioliskraft gegen Westen über den tropischen Pazifik. Der Temperaturgradient ist im Westen ca. 10°C höher. Durch die dort aufsteigende Luft kondensiert das darin enthaltene Wasser und fällt als Regen nieder. Der Ostpazifik ist dagegen relativ trocken. Die Passatwinde befördern kühles Oberflächenwasser von der südamerikanischen Küste nach Westen. Durch die Verschiebung der Wassermassen entsteht ein Kreislauf. Dem in Südostasien ankommenden, inzwischen erwärmten Oberflächenwasser weicht kaltes Wasser in genau umgekehrter Richtung aus. So bewegt sich kaltes, nährstoffreiches Wasser, welches sich wegen seiner größeren Dichte in tieferen Regionen des Pazifiks befindet, von Westen nach Osten. Die Winde im Hochdruckgebiet treiben den Humboldtstrom an, der entlang eines Tiefseegrabens fließt und kaltes Wasser aus der Antarktis an die Westküste Südamerikas bringt. Vor Südamerikas Westküste gelangt dieses Wasser in den Auftriebsgebieten an die Oberfläche. Deshalb befindet sich dort der kalte und nährstoffreiche Humboldtstrom (Abb.3 links).

Abb.3: Zu sehen ist die Wärmeverteilung der marinen Strömungen. Die Abbildung zeigt die Abweichung der Meeresoberflächentemperatur vom Durchschnitt (in °C) in einem „Normaljahr“, links und in einem „El Niño-Jahr“, rechte Abbildung. Quelle: povworld.de/michariser/de/elnino4.shtml

Bei El Niño kehrt sich das o.g. eingestellte Förderband um (siehe Abb.4, rechts), weil die Passatwinde aufgrund einer Änderung in der südlichen Oszillation (SOI) erschlaffen, wodurch es zu einem Niedergang der Ökosysteme kommt, da kaltes und nährstoffreiches Wasser nicht nachgeliefert wird. Das Druckgefälle zwischen dem Hoch vor der Westküste Südamerikas und dem Tief über Indonesien ist aufgrund der Änderung der SOI gering, wodurch die Luftströmung aus dem Hoch zum Tief erschlafft und die Passatwinde abflauen. Die Passatwinde verbleiben nun im zentralen und westlichen Pazifik, was zu einem Zusammenbruch des Temperaturgradienten im Ostpazifik führt. Im Süden der USA und Peru treten dann starke Regenfälle und Überschwemmungen auf. In Australien herrscht dagegen Trockenheit.

Die Klimaanomalie bekam ihren Namen von den stark betroffenen peruanischen Fischern (die Fischschwärme verschwinden, weil der Nachschub von nährstoffreichem Wasser ausbleibt), welche sie als erste wahrgenommen haben. Sie nannten das Klimaphänomen in sarkastischer Weise "El Niño", was auf Spanisch "Christkind" oder "Knabe" bedeutet, da sie die Auswirkungen von El Niño um die Weihnachtszeit wahrgenommen haben.

Abb.4: Wasserkreislauf „normal“ und bei El Niño (rechts), Quelle: (www.elnino.info).

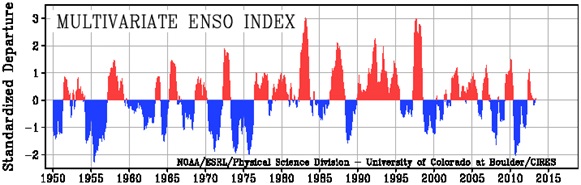

Die Verlagerung der atmosphärischen und marinen Wärme nach Osten stört die globale Luftzirkulation, was wiederum zu Wetteränderungen in weit entfernten Gebieten führt. Ein Parameter für El Niño (und La Niña, seinem Gegenpart) ist die ENSO (El Niño Southern Oscillation), die die Abweichungen der Oberflächentemperatur im El Niño-Meeresgebiet angibt.

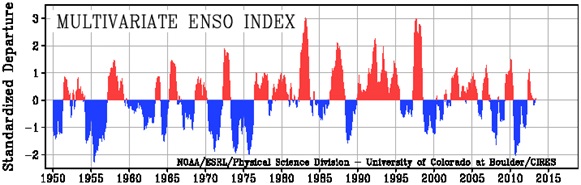

Abb.5 zeigt die ENSO (El Niño Southern Oscillation-Index) und darin die sich abwechselnden El Niño (rot) und La Niña-Ereignisse (blau) von 1950 – 2010, Quelle: NOAA

Wissenschaftler aus Australien und Neuseeland (Prof. Robert M. Carter et al. von der James Cook University in Australien) haben in ihren Untersuchungen den Zusammenhang zwischen der ENSO-Schwingung (El Niño/Southern Oszillation) und dem Weltklima aufgezeigt. Sie veröffentlichten ihre Studie, die auf gut erfassten Messdaten der vergangenen 50 Jahre zurückgriff, im "Journal of Geophysical Research". Ihr Ergebnis: Je stärker der jeweilige El Niño war, desto deutlicher stieg in der Folge die globale Temperatur an.

Die Forscher geben an, dass ca. 70% der zuletzt beobachteten Erwärmung auf die El Niño-Tätigkeit zurückzuführen ist. Es habe sich gezeigt, dass etwa 6 Monate nach einem El Niño-Ereignis die globalen Temperaturen, je nach Stärke des El Niño anstiegen. Blieben dagegen El Niño-Ereignisse über längere Zeit aus, soll dies zu einem globalen Rückgang der Temperaturen geführt haben. Die folgenden Abbildungen geben den Zusammenhang wieder.

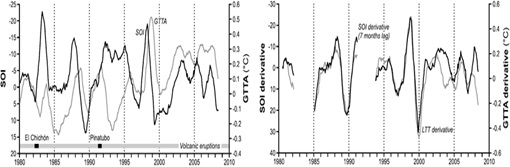

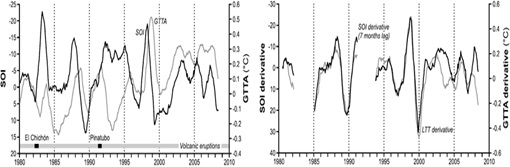

Abb.6 links zeigt den SOI (dunkle Linie) und die GTTA (Global Tropospheric Temperature Anomalies, helle Linie). Deutlich sind die Einflüsse der starken Vulkaneruptionen des El Cichon und Pinatubo zu erkennen, durch die die Globaltemperaturen zeitweise zurückgingen. Bereits hier ist deutlich zu erkennen, dass außerhalb der Vulkanereignisse eine hohe Korrelation gegeben ist. In der rechten Abbildung sind diese Einflüsse bereinigt. Quelle: McLean, de Freitas, Carter, ”Influence of the Southern Oscillation on tropospheric temperature”, Journal of Geophysical Research Atmospheres

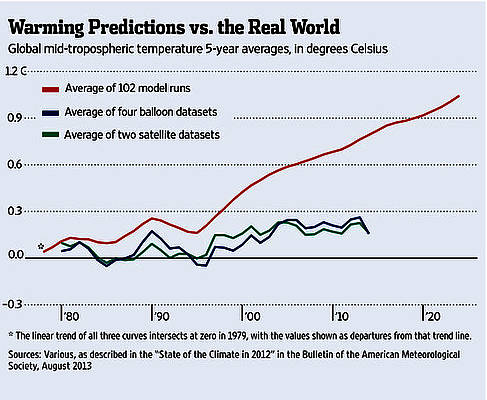

Die Forscher gehen weitgehend von natürlichen Ursachen der globalen Temperaturtrends aus. In den Klimamodellen sei dies nicht berücksichtigt. Ein Grund mehr, warum Klimamodelle nicht die Realität abbilden, wie die Globaltemperaturen und die Deutschlandtemperaturen seit langem belegen.

Soweit der kleine Exkurs zu El Niño und den exemplarisch gezeigten El Niño-Forschungsergebnissen. Aber was löst einen El Niño aus und vor allem, wann und wie wird dies auf die irdischen Wettergeschehnisse eingeprägt, die, wie wir gesehen haben, sich nicht nur auf die Hadley-Zelle beschränken, sondern darüber hinaus Auswirkungen auf die Ferrel- und Polarzelle haben. Der Reihe nach.

Durch was werden El Niño-Ereignisse ausgelöst?

Der Autor hat hierzu anhand von Auswertungen solarer Parameter eine eindeutige Korrelation gefunden und anhand dessen, eine ganzheitliche Theorie zur Beantwortung der o.g. Fragen entworfen. Erstmals veröffentlicht auf EIKE am 24.01.2011 “La Niña und El Niño, was sich dahinter verbirgt und was sie, wann auslöst – Die Sonne ist an allem schuld“ und dann in seiner 8-teiligen EIKE-Reihe “Dynamisches Sonnensystem – Die tatsächlichen Hintergründe des Klimawandels“ (Teil 1) in 09/2011. Inwieweit seine Theorie stimmig ist, muss sich natürlich, wie alle Theorien in der Wissenschaft, mit der Realität messen. Hier unterscheiden sich übrigens die Wissenschaftler von EIKE grundlegend von den Wissenschaftlern des IPCC oder ihrer nahen Institute. Während diese ihre Theorien nicht an der Realität spiegeln und ihre Richtigkeit davon abhängig machen, wie dies in der Wissenschaft üblich ist, versuchen sie, die Realität zurechtzubiegen, wenn diese nicht mit ihren Theorien in Einklang stehen, schlimmer noch, generieren sie munter weiter die aberwitzigsten Thesen über verbleibende Wärme, katastrophalem Meeresspiegelanstieg, u.s.w., stellen wir von EIKE uns der Realität und machen die Theorie von der Wirklichkeit abhängig und nicht umgekehrt. Das letztere nennt sich Wissenschaft, dass Erstere, dass Vorgehen des IPCC und ihrer Institute, Pseudowissenschaft. Anhand der Theorie des Autors muss Ende dieses Jahres ein El Niño-Ereignis eintreffen, ansonsten ist seine Theorie nicht stimmig und nicht die Realität! Insofern freut es natürlich den Autor, wenn jetzt unabhängig von ihm, deutsche Wissenschaftler, die Physiker Armin Bunde und Josef Ludescher von der Universität Gießen anhand ihrer Studie (veröffentlicht im US-Fachjournal „Proceedings of the National Academy of Sciences“) auch zu dem Schluss kommen, dass Ende diesen Jahres ein El Niño-Ereignis eintreten soll.

Die Wissenschaftler bei EIKE sind sich darüber einig, dass der maßgebliche Anteil der realen Erwärmung im 20. Jahrhundert auf natürliche Ursachen und somit auf die solare Aktivität, dem einzigen Energielieferanten (die 0,02% aus dem Erdinnern sind hier vernachlässigbar) zurückzuführen ist. Daher liegt es nahe, die El Niño-Ereignisse mit der variablen Sonne in Bezug zu setzen.

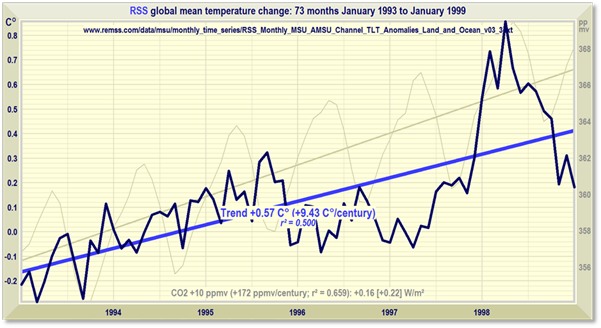

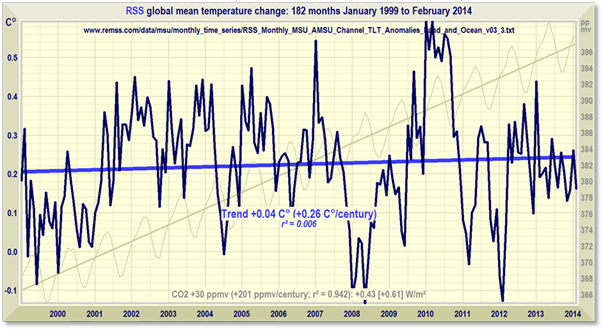

Bevor der Autor hier näher eingeht, möchte er zeigen, wie die globalen Mitteltemperaturen von El Niño-Ereignissen abhängen, wie dies auch das o.g. Forscherteam um Prof. Robert M. Carter herausfand. Anfangs wurde bereits gezeigt, dass El Niño-Ereignisse weltweiten Einfluss auf die Wettersysteme ausüben.

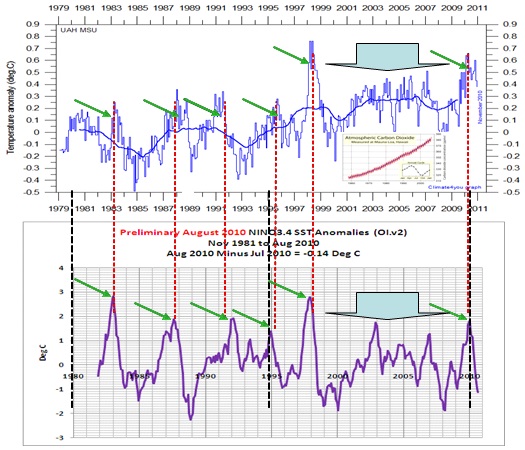

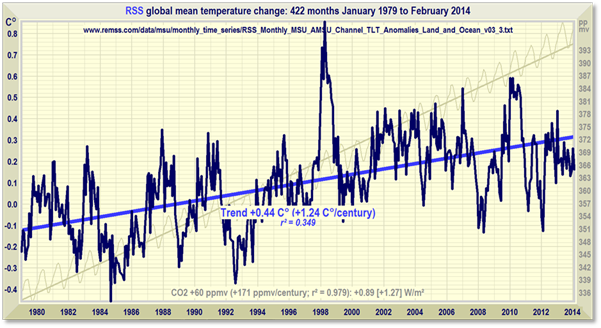

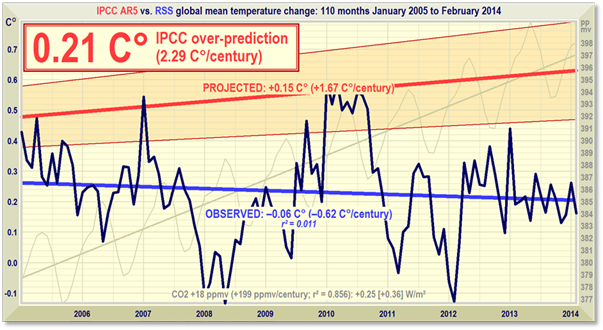

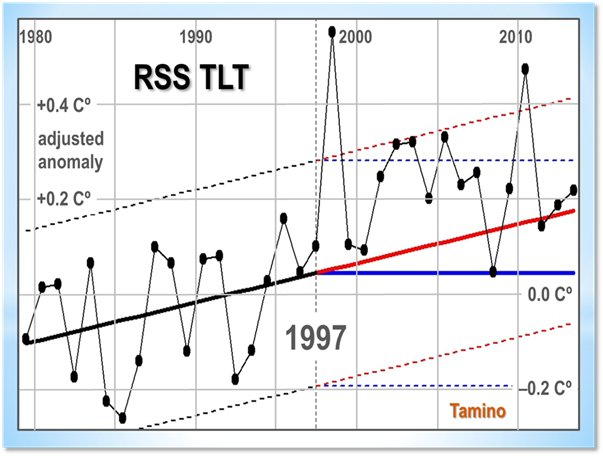

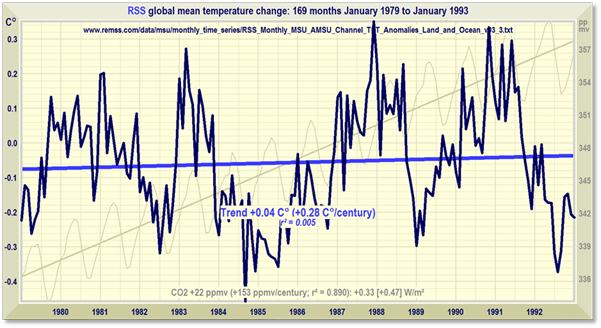

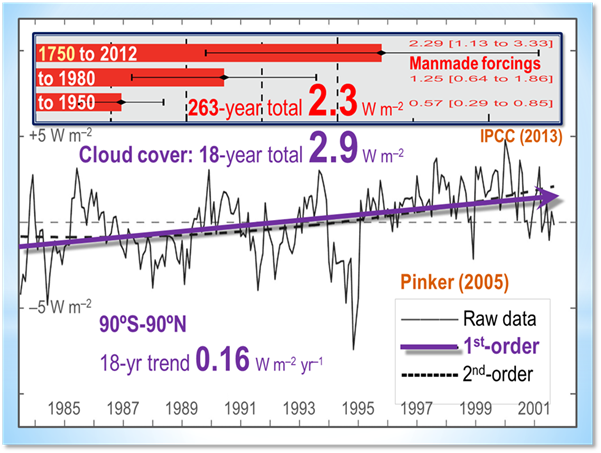

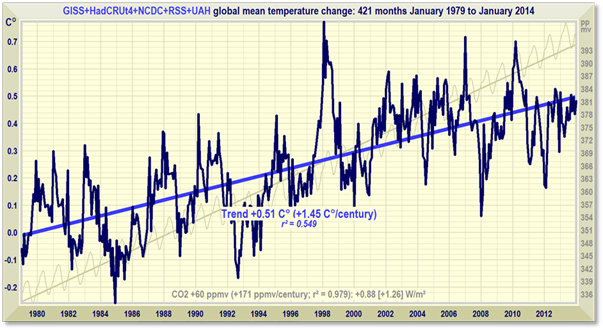

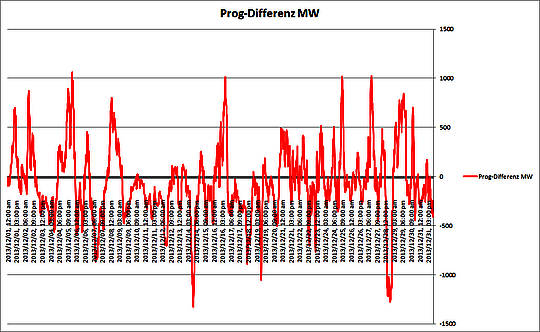

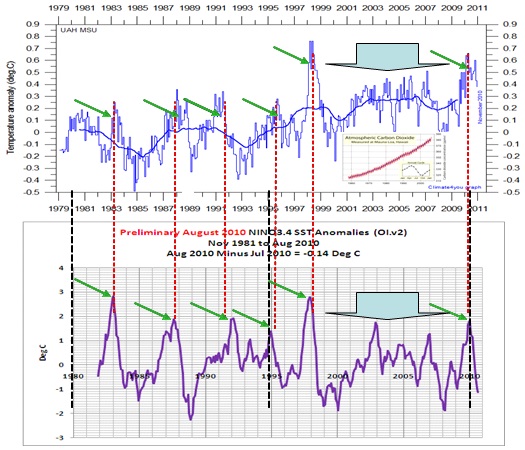

Abb.7 oben zeigt die Temperaturdatenreihe seit Beginn der Satellitenmessungen (1979). Die kleine Abbildung zeigt die atmosphärische CO2-Entwicklung nach Mauna Loa. Die Abbildung darunter die El Niño-Anomalien (El Niño 3.4) der Wasseroberflächentemperaturen. Jede globale Temperaturspitze in den letzten 30 Jahren fällt mit einem El Niño-Ereignis exakt zusammen und das bei 8 Ereignissen im Betrachtungszeitraum (grüne Pfeile und Blockpfeil). Die schwarzen Linien dienen zur zeitlichen Justierung der Datenreihen.

Die Messdaten belegen in eindrucksvoller Weise, dass die globalen Temperaturen natürlichen Schwankungen, den El Niño-Ereignissen unmittelbar folgen. Mit CO2 oder einer angeblichen anthropogenen Erwärmung hat dies rein gar nichts zu tun, wie die kleine Abbildung belegt.

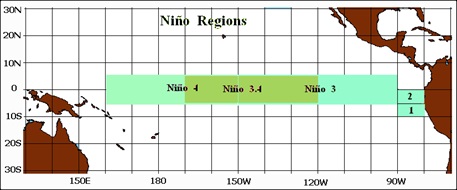

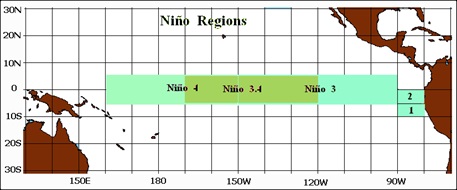

Abb.8 zeigt die El Niño-Gebiete.

Abb. 7 belegt, dass El Niño-Ereignisse die klimatischen Bedingungen weltweit beeinflussen und die Erdtemperaturen global moderieren. Aktuelle Untersuchungen des MPI für Meteorologie und der University of Cambridge, “Central Pacific El Niño, the “subtropical bridge,” and Eurasian climate“ (Journal of Geophysical Research, Vol. 117, D01102, 10 PP., 2012) und Prof. Malberg, Leiter Institut für Meteorologie der Humboldt Universität (erschienen in der Berliner Wetterkarte e.V. am 31.01.2012), bestätigen ebenfalls den dominanten globalen Einfluss von El Niño-Ereignissen auf die Erdtemperaturen und damit auf unser Wettergeschehen.

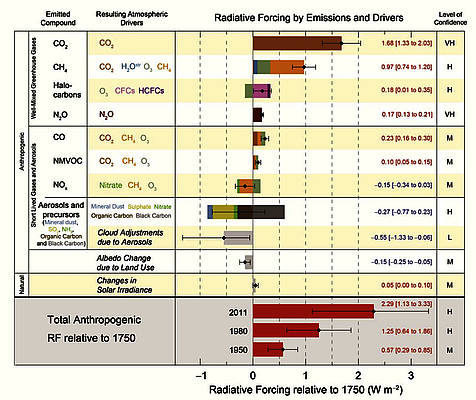

Mit einer Vielzahl von Untersuchungen wurde versucht, El Niño, bzw. La Niña mit der Sonnenaktivität zu koppeln (um eine bessere Vorhersage zu erzielen), bzw. dem CO2-Anstieg zuzuordnen, um einen anthropogenen Einfluss zu beweisen. Zur Korrelation wird dabei die Sonnenfleckenzahl oder die Strahlungsintensität herangezogen (“How will Earth’s surface temperature change in future decades?“, Judith L. Lean, David H. Rind, Geophysical Research Letters, Vol. 36), was zu keinem brauchbarem Ergebnis führt. Die Sonnenfleckenzahl ist z.B. als Proxy dann erste Wahl, wenn Vergleiche zu früheren Jahrhunderten durchgeführt werden, da ab dem 17 Jahrhundert verlässliche Beobachtungsdaten vorliegen. Die Sonnenfleckenzahl gibt jedoch nur annähernd die reale Sonnenaktivität wieder, wie der Autor in seiner 8-teiligen EIKE-Reihe nachweisen konnte. Ein weiterer Parameter ist der sog. TSI (Total Solare Irradiance). Dieser deckt jedoch nur einen eingeschränkten Teilbereich des solaren Energiespektrums ab, den Bereich zwischen 200nm und 2.000nm, von “Total“ kann also keine Rede sein.

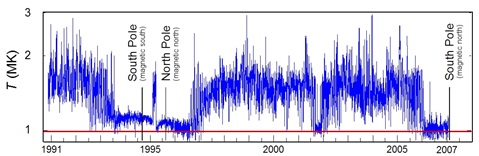

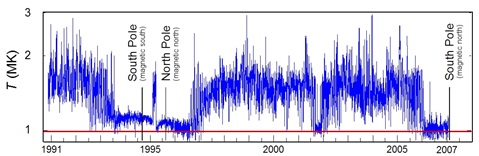

Wie der Autor in seiner 8-teiligen EIKE-Reihe .“Dynamisches Sonnensystem – Die tatsächlichen Hintergründe des Klimawandels zeigte, eignet sich besser zur Bewertung der solaren Aktivität die magnetische Aktivität der Sonne. Seit dem Satellitenzeitalter stehen noch weitere Parameter zur Verfügung, die von der Erde aus nicht beobachtbar sind, die jedoch die ganzheitliche magnetische Aktivität besser erfassen. Ein bedeutsamer Parameter ist die Korona der Sonne. Wie Abb.8 zeigt, „springt“ die Koronatemperatur scheinbar unvermittelt auf annähernd ihren doppelten Temperaturwert. Dies ist dann, wenn die Aktivität der Korona zunimmt.

Abb.9, Quelle: http://rst.gsfc.nasa.gov/Sect20/A5a.htm

Anmerkung:

Dabei handelt es sich also nicht um neue physikalische Prozesse in, bzw. auf der Sonne, die die Korona heizen, sondern bestehende Heizprozesse der Korona (Nano-Flares, Alvén-Wellen) werden verstärkt, wodurch in der Gesamtheit der solaren Fläche (Gebiete) die Koronatemperatur auf ihren nahezu doppelten Wert (im Vergleich zu „inaktiven“ Zonen) angehoben wird, der vorher in der Fläche herrschte. Darunter ist die integrale Zunahme der Koronaaktivität über der Fläche zu verstehen, die einen neuen solaren Zyklus deutlich exakter anzeigt, wie dies gegenwärtig durch den Wechsel in der Fleckenpolarität geschieht. Ein neuer solarer Zyklus kündigt sich nach Ansicht des Autors zuerst auf kleinen Skalen an und dann erst auf großen (Sonnenflecken). Hat nun dieser „Sprung“ in den Koronatemperaturen Einfluss auf das irdische Wetter und hier insbesondere auf El Niño/La Niña-Ereignisse? Hierzu werden die El Niño-Ereignisse in Relation gesetzt.

Da die Korona der Teil der Sonne ist, die (über den Sonnenwind) direkten Kontakt zur Erdatmosphäre hat, liegt es nahe, deren Aktivität mit El Niño-Ereignissen in Relation zu setzen (Abb.10).

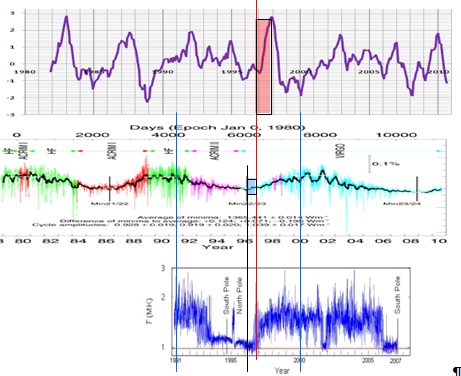

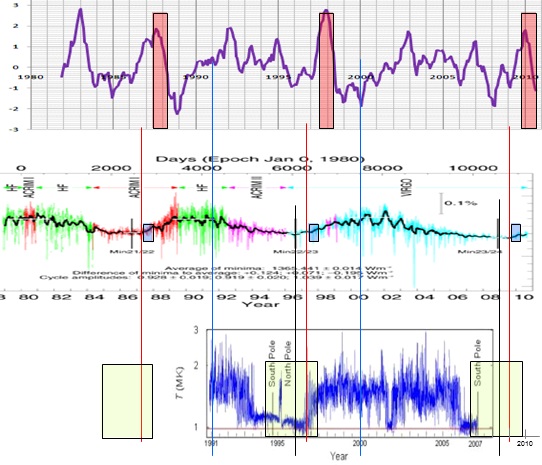

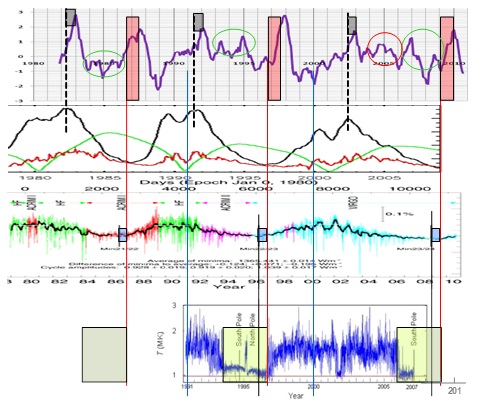

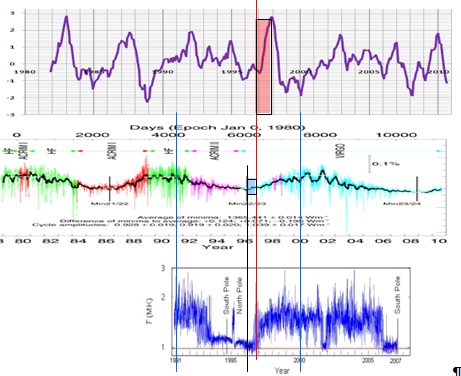

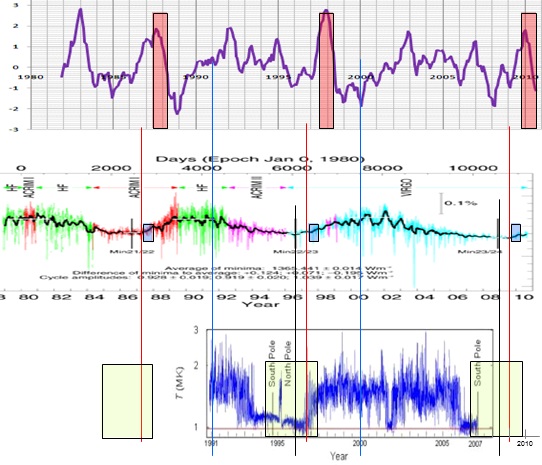

Abb.10: Die Zeitreihe oben zeigt den El Niño 3.4, der z.B. von der NOAA zur Betrachtung von El Niño-/La Niña-Ereignissen herangezogen wird. Die mittlere Zeitreihe die solare Aktivität nach Angaben der PMOD (Physikalisch-Meteorologisches Observatorium Davos) und die untere Datenreihe die Koronatemperatur. Die blauen Linien dienen zur Zeitausrichtung der Zeitreihen, die rote Linie zeigt die integrale Zunahme der Koronatemperatur von 1 Million auf annähernd 2 Millionen Kelvin. Das blaue Rechteck die verstrichene Zeit vom Sonnenminimum, welches von der PMOD durch einen senkrechten Strich gekennzeichnet ist und das rote Rechteck die Zeitspanne von der Zunahme der Koronatemperatur in der Fläche bis zum ElNiño-Maximum.

Nun lässt sich anhand einer Datenbeziehung kein Korrelationsbeweis führen. Daher sollen alle El Niño-Ereignisse in der Datenreihe El Niño 3.4 auf Korrelation zur solaren Aktivität überprüft werden. Der Zeitpunkt ab 1981 ist daher so interessant, da von den Vertretern der CO2-basierten Erwärmung die Aussage gemacht wird, dass bis ca. 1980 Sonnenaktivität und Temperatur synchron laufen, ab 1980 sich die Temperatur jedoch von der solaren Aktivität abkoppeln würde und dies auf den Austrag von Treibhausgasen zurückzuführen sei. Wir werden sehen, ob dem so ist.

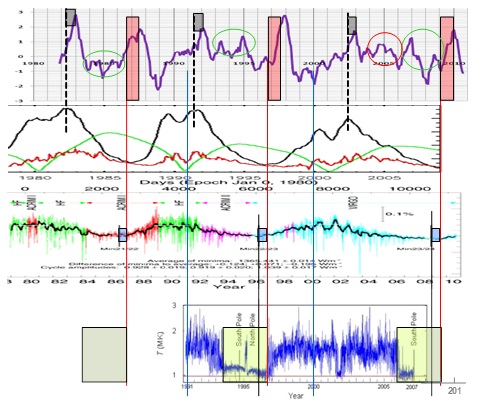

Abb.11: Da, wie bereits geschildert, Beobachtungsdaten über die Korona nur vom Weltraum aus möglich sind und Daten nur für den Zeitraum 1991 – 2007 vorliegen, wird die weitere Datenreihe rekonstruiert, wobei die Zeitabstände sowohl beim Koronaminimum (grüne Rechtecke), als beim Zyklusbeginn Schwabe-Zyklus zum Anstieg Koronatemperatur (kleine blaue Rechtecke) jeweils gleich gehalten werden und dann geprüft wird, inwieweit eine El-Niño-Beziehung zur Korona besteht. Die Abbildung zeigt, dass nach jeder integralen Zunahme der Koronatemperatur ein El Niño ausgelöst wird (rote Rechtecke) und zwar innerhalb eines festen Zeitraumes und weiter, nach ca. 11 Monaten der El Niño sein Maximum erreicht, voll ausgeprägt ist.

Abb.12 bringt den El Niño 3.4, der für die Entwicklung der Erdtemperaturen steht (siehe Abb.7) und den Total Flux, den TSI und die Korona in Relation zueinander.

Abb.12 zeigt nochmals die Erkenntnisse der bisherigen Untersuchungen und darüber hinaus die magnetische solare Aktivität (zweite Datenreihe von oben, Quelle: Max Planck Gesellschaft http://www.mps.mpg.de/projects/solar-mhd/research_new.html). Wie unschwer festzustellen, wird nach jedem magnetischen Maximum im Schwabe-Zyklus ebenfalls ein El Niño-Ereignis ausgelöst. Auch hier wird das Maximum im El Niño-Ereignis nach einer exakt festen Zeitspanne erreicht (graue Rechtecke).

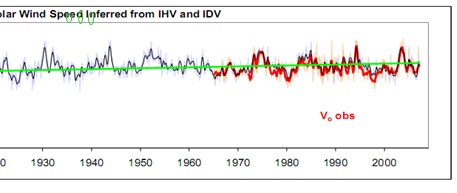

Bleibt noch die Frage zu beantworten, was die grün und rot umrundeten schwächeren El Niño-Ereignisse auslöst. Die Antwort für das rot-umrundete in 2005 lässt der Autor die NASA und zwar deren Sonnenforscher David Hathaway vom September 2005 geben: “Das Solare Minimum explodiert – Das Solare Minimum sieht seltsamerweise aus wie ein solares Maximum“. In 2005 war das Maximum im 36-jährigen Brückner-Zyklus der Sonne, der die Temperaturen maßgeblich beeinflusst. Siehe hierzu die Arbeit des Autors http://www.eike-klima-energie.eu/climategate-anzeige/arktische-sommereisschmelze-2012-menetekel-oder-nuechterne-wissenschaft/ (dort die Abb.15 und 16). Die Antwort für die grün umrundeten gibt bereits die Datenreihe von der Max Planck Gesellschaft und zwar die grüne Datenreihe, die das magnetische Polarfeld der Sonne zeigt. Der Autor möchte dies anhand der Sonnenwindaktivität weiter belegen.

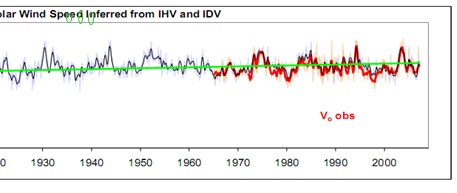

Abb.13 zeigt den 27-Tage-Durchschnitt der Sonnenwindgeschwindigkeit in 100 km/s (Ausschnitt), Quelle: (http://www.leif.org/research/files.htm). Blau, rekonstruiert, rot, direkt gemessene Werte. Der schnelle Sonnenwind kommt entweder aus dem Nonaxisymmetric Open Flux, dort von starker solarer magnetischer Aktivität (z.B. Koronale Massenauswürfe, Coronal Mass Ejections (CME) oder aus den polaren Löchern der Sonne (siehe die genannte 8-teilige EIKE-Reihe). Deren Aktivität wird durch das Polarfeld der Sonne (grüne Datenreihe von der Max Planck Gesellschaft) bestimmt. Werden nun die oben grün umrundeten Spitzen (starke magnetische Aktivität des Polarfeldes der Sonne) mit den grün-umrundeten Spitzen in der El Niño-Datenreihe verglichen, so ist Übereinstimmung festzustellen.

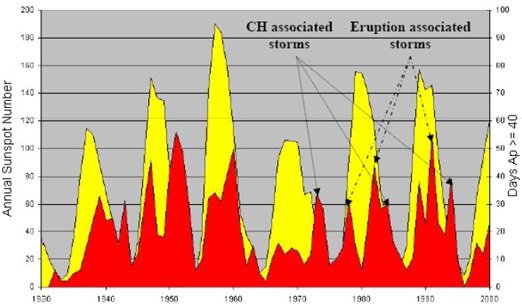

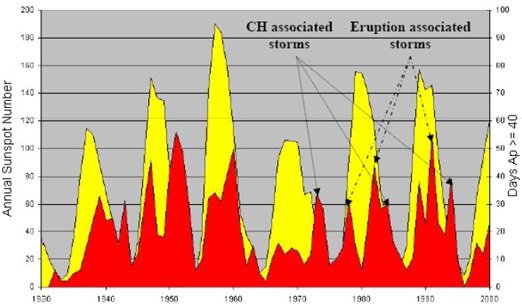

Das Max Planck-Institut für Sonnensystemforschung (MPS) nennt diese Aktivität, Coronal Hole associated storms (“Physikalische Grundlagen des Weltraumwetters – Der Sonnenwind“) Abb.14.

Abb.14 zeigt die solare magnetische Aktivität im Zeitraum von 1930 – 2000 (Quelle: MPS).

Ergebnis:

Somit ist bisher festzuhalten, dass El Niño-Ereignisse durch drei solare Ereignisse unmittelbar ausgelöst werden:

1) Der Zunahme der Koronatemperatur in der Fläche, wenn deren Temperatur auf den doppelten Wert in der Fläche ansteigt.

2) Nach jedem Maximum im magnetischen solaren Zyklus.

3) Das Polarfeld der Sonne (schwache El Niño).

4) Der Temperaturgang der letzten 30 Jahre folgt exakt der Sonnenaktivität. Von einer Abkopplung kann keine Rede sein!

Die Messdaten und die Untersuchungen belegen in eindrucksvoller Weise, dass die globalen Temperaturen natürlichen Schwankungen, den El Niño-Ereignissen und der solaren Aktivität unmittelbar folgen. Mit CO2 oder einer angeblichen anthropogenen Erwärmung hat dies nichts zu tun. Mit dem vorliegenden Nachweis, dass alle El Niño-Ereignisse im Betrachtungszeitraum durch die solare Aktivität unmittelbar ausgelöst werden und der globale gemittelte Temperaturgang diesen Ereignissen unmittelbar folgt, ist der wissenschaftliche Beweis erbracht, dass die Erwärmung (und Abkühlung seit Beginn dieses Jahrhunderts) einzig auf die Sonne zurückzuführen ist. Eine Korrelation zu Treibhausgasen wie CO2 ist nicht zu finden, siehe Kämpfe, Kowatsch, Leistenschneider (http://www.eike-klima-energie.eu/climategate-anzeige/klimawandel-in-deutschland-real-sinken-seit-25-jahren-die-temperaturen/).

Abb.14b zu Kommentar #11:

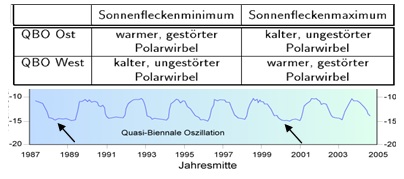

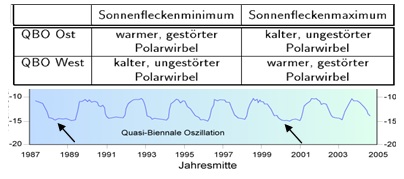

Abb.14b zeigt den Einfluss der QBO und des Schwabe-Zyklus auf die Winterzirkulation der Stratosphäre. Darunter die QBO im Zeitraum von 1987 – 2005. Deutlich ist ihre zweijährige Schwingung zu sehen. Jeweils vor einem solaren Maximum (1991 und 2001) ist ihre Phase länger ausgeprägt.

Teil 2 in Kürze

Raimund Leistenschneider – EIKE