IPCC (Klimarat) wieder in Nöten: Renommierter Wissenschaftler entlarvt Alarmismus sowie eine korrumpierende Vetternwirtschaft beim IPCC !

Richard Tol ist Professor für Wirtschafts-Wissenschaften. Er war und ist Hochschul-Lehrer an Universitäten in Amsterdam, Pittsburg, Hamburg, Dublin und Sussex. Er zählt zu den einhundert meist-zitierten Wirtschaftswissenschaftlern der Welt und hat insbesondere über die Ökonomie des Klimawandels publiziert [2] . Tol ist/war koordinierender Leitautor des IPCC-Kapitels über die wirtschaftlichen Auswirkungen des Klimawandels [2] .

Bei einem solchen Renommè wiegt es schwer, wenn ein Wissenschaftler dieses Formates nach fast 10 Jahren Mitarbeit den Klimarat verläßt, und zugleich schwere Vorwürfe erhebt:

„Der Streit um den Uno-Klimabericht eskaliert: Der renommierte Umweltökonom Richard Tol tritt aus Protest gegen Formulierungen im neuen Welt-Klimareport zurück. Der Report drifte in Richtung Alarmismus, moniert er empört.“ [3].

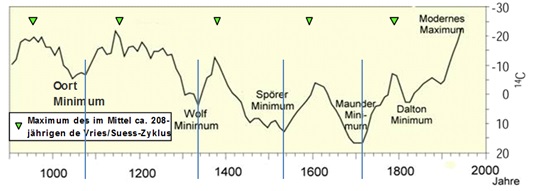

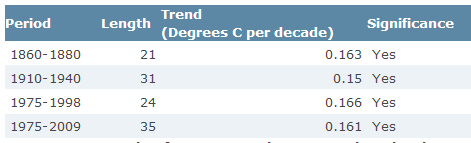

* 2. Bild rechts:Die Kästchen stellen die Aussagen zur Sicherheit der IPCC-Berichte über die Zeit dar. Je mehr die Realität (Messungen) von den Modelle abweicht, d.h. diese immer unsicherer werden, wird die Gewissheit des IPCC stärker. IPCC Logik eben.

In der FAZ [2] dazu:

„Übertrieben alarmistische Szenarien?

Der Rücktritt Tols wirft einen Schatten über die laufenden Verhandlungen über die Endfassung des Berichts der Arbeitsgruppe 2 des IPCC im japanischen Yokohama“.

Und w.a.a.O. [2]:

„Es gebe zu viel ‚Klima-Alarmismus‘. Im Gespräch mit der F.A.Z. kritisierte Tol, daß es einen starken Druck gebe, die Klimaberichte möglichst dramatisch zu formulieren.

‚Es gibt viele Bürokraten, Politiker und Wissenschaftler, deren Jobs davon abhängen, daß die Klima-Katastrophe möglichst schlimm erscheint‘, sagte Tol.

Außerdem gebe es eine Art Selbstselektion der beteiligten Wissenschaftler und Politiker: Vornehmlich solche, die Klima-Alarmismus zuneigten, würden sich bei dem Thema engagieren.“

Das beweist ganz klar:

> Einerseits werden wissenschaftliche Fakten und Schlußfolgerungen vom IPCC verbogen, hin zu alarmistischen und damit unwissenschaftlichen Aussagen ;

> andererseits werden für das IPCC bevorzugt Mitglieder eingeworben, welche abhängig und zum Teil korrumpierend mit politischen und wirtschaftlichen Interessen verflochten sind.

Welches Ausmaß die Politisierung des Klimarates bis hin zur Absurdität erreicht hat, zeigt auch dieses [3]:

„Ein ‚dämliches Statement‘ im Report sei die Feststellung, daß Menschen in Kriegsgebieten besonders durch den Klimawandel gefährdet seien. „Ich schätze aber, dass Leute in Syrien Chemiewaffen mehr fürchten als die Erwärmung“, sagt Tol.“

Tol ist insbesondere verantwortlich für die 30-seitige Zusammenfassung, welche speziell für die Politiker bestimmt ist [3]:

„Das Resümee des Uno-Berichts „driftet Richtung Alarmismus“, meint der Forscher.

Der zweite Teil des Uno-Klimareports soll das Wissen über die zu erwartenden Folgen der Erderwärmung darlegen. Die gut 30-seitige Zusammenfassung ist besonders umstritten; in Yokohama ringen die Delegierten des Uno-Klimarats IPCC derzeit um jedes Wort. Im Fokus stehen die wirtschaftlichen Folgen des erwarteten Klimawandels.

Entscheidende Formulierungen aus dem Entwurf des Reports seien für die Schlußfassung getilgt worden, moniert Tol. Der Entwurf des IPCC-Berichts habe beispielsweise konstatiert, Klimarisiken könnten mit Anpassungsmaßnahmen „gemanagt“ werden, es bedürfe allerdings erheblicher gesellschaftlicher Anstrengung.

‚Diese Feststellung ist verschwunden im Berichtsentwurf, zugunsten der apokalyptischen Reiter‘, sagt Tol.“

In der Internet-Zeitung „Freie Welt“ wird kommentiert [4] :

„In wenigen Tagen will der Weltklimarat der Vereinten Nationen (IPCC) seinen Bericht veröffentlichen und einer der Autoren zieht seinen Namen aus dem Papier zurück – aus Protest gegen »Panikmache«. Richard Tol von der Universität Sussex war verantwortlich für die Koordinierung des Kapitels über die wirtschaftlichen Auswirkungen des Klimawandels. In der Zusammenfassung des mehrere hundert Seiten starken Papiers, die der IPCC Entscheidungsträgern aus aller Welt vorlegt, sieht Tol seine Aussagen verfälscht.“

Und nochmals die FAZ [2] :

„Die Botschaft des ersten Entwurfs war, daß durch Anpassung und eine kluge Entwicklung die Risiken handhabbar sind, aber daß dies ein gemeinsames Handeln erfordert“, sagte Tol dem britischen Fernsehsender BBC. Diese Botschaft des Entwurfs sei aber in der gut 30 Seiten umfassenden Zusammenfassung für politische Entscheidungsträger herausgefallen, beklagte Tol. Die Endfassung sei nun wieder in einem apokalyptischen Tonfall gehalten.“

Und w.a.a.O. :

„Tol vertritt die Position, daß die ökonomischen Auswirkungen des Klimawandels eher gering sind. Außerdem sei es weniger teuer, eine Strategie der Anpassung an den Klimawandel zu wählen, statt ihn durch drastische CO2-Reduktion verhindern zu wollen“

… und w.a.a.O.:

„Verglichen etwa mit der Wirtschaftskrise in Südeuropa ist der Schaden durch den Klimawandel ein kleines Problem.“

…und w.a.a.O.:

„Anders als der britische Ökonom Nicholas Stern kommt Tol aber zu dem Ergebnis, daß die wirtschaftlichen Schäden durch den Klimawandel eher klein seien. Bei einem geringen Temperaturanstieg seien die Auswirkungen unterm Strich sogar positiv“.

Auch in den englischen Medien schlägt der IPCC-Rücktritt von Richard Tol und die damit an die Öffentlichkeit gelangten neuerlichen Manipulations-Versuche des IPCC erhebliche Wellen – drei Beispiele:

The Guardian, 28.03.2014 [5] :

„Governments reject IPCC economist’s ‚meaningless‘ climate costs estimate UK-based Richard Tol, who has criticised overall report, accused of underestimating costs of climate change in economics section.“

Wall Street Journal, 27.03.2014 [6] :

„Climate Forecast: Muting the Alarm – Even while it exaggerates the amount of warming, the IPCC is becoming more cautious about its effects.“

Watts Up With That, 29.03.2014 [7] :

„Richard Tol Pulls Out, Says IPCC Draft Report Alarmist.“

Wie weitgehend mittlerweile politische und auch wirtschaftliche Profiteure sowie Grüne Ideologen versuchen, das IPCC für sich zu vereinnahmen, zeigte sich auch jüngst wieder auf der IPCC-Konferenz im September 2013 in Stockholm, wovon SPIEGEL-ol. u.a. berichtete [8] :

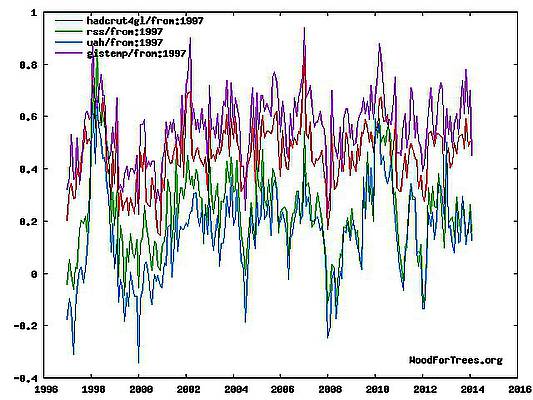

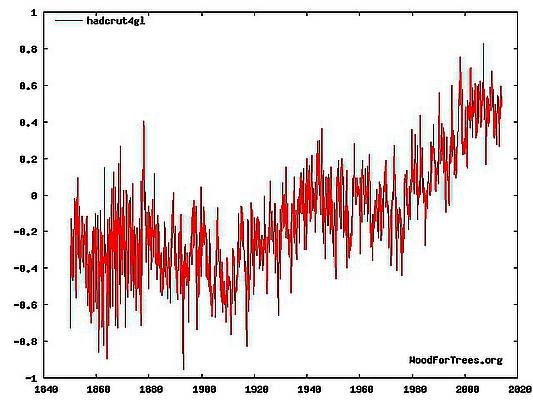

„Vor den Verhandlungen zum Uno-Klimareport, die nächste Woche in Stockholm stattfinden, ist es nach Informationen des SPIEGEL zwischen Politikern und Wissenschaftlern zu Spannungen gekommen. Gegen den Widerstand vieler Forscher wollen insbesondere Delegierte der Bundesregierung das Stocken der Erwärmung in den letzten 15 Jahren aus der Zusammenfassung des neuen IPCC-Reports heraushalten. Allenfalls eine „Verlangsamung des Temperaturanstiegs“ soll zugegeben werden, die „wissenschaftlich nicht relevant“ sei.“

Und dazu berichtete auch DIE WELT [9] :

„So ist im Entwurf der “Summary” zum Beispiel die inzwischen eineinhalb Jahrzehnte andauernde Pause in der globalen Erwärmung erwähnt, zusammen auch noch mit dem Hinweis, dass die Modelle der Klimaforscher dafür keine Erklärung liefern. … Delegierten aus zwei deutschen Ministerien … kommen nun und wollen diese Passage gestrichen haben … Die Begebenheit zeigt: Gerade in deutschen Ministerien sitzen starke, um Beharrlichkeit ringende Kräfte, die große Bedenken haben, dass die immer chaotischere Kapriolen schlagende Energiewende … hierzulande an wissenschaftlicher Legitimität verlieren könnte. Nach der Devise: Wir lassen uns unsere Katastrophe nicht nehmen.“

Zum gleichen Problem schreibt der Chefredakteur der Baseler Zeitung, Markus Somm [10]:

„…. Weil sich empirische Daten nicht der gängigen These fügen, verschweigt man sie.

Dank mehreren Indiskretionen wurden aber diese Verschleierungspläne im Vorfeld (Anm.: IPCC-Konferenz Stockholm, September 2013) bekannt, weswegen die Autoren des Summary es vorgezogen haben, diese unbequeme Wahrheit zu erwähnen.“ … : Seit fünfzehn Jahren hat sich die Erde … nicht mehr erwärmt.“

Sehr klar und deutlich äußert sich auch der renommierte deutsche Klimaforscher Hans von Storch im Interview in der Berner Zeitung v. 16.02.2014 [11], auf die Frage :

„Können Klima-Wissenschaftler die Politisierung überhaupt noch loswerden? Der 2013 veröffentlichte jüngste UNO-Klimabericht … wurde als politische Message darüber interpretiert, ob die Klima-Erwärmung überhaupt stattfindet ?“

Hans von Storch :

„An diesem Beispiel zeigt sich die verhängnisvolle Klimafalle, in die wir geraten sind und die mein Kollege, der Ethnologe Werner Krauss und ich in unserem Buch beschreiben. Die Klima-Forschung hat sich kidnappen lassen von der Politik, die ihre klima-politischen Entscheidungen als einzig richtige, weil von der Wissenschaft vorgegeben, legitimiert.“

Schließlich sei dazu noch der deutsche Physik-Professor Knut Löschke aus Leipzig zitiert [12] :

„Politische Kräfte aller Parteien versuchen, die Angst der Menschen vor einem Weltuntergangs-Szenario namens ‚Klima-Katastrophe‘ zu benutzen, um sich Machtpositionen zu schaffen, und um eine planwirtschaftliche Ordnung zu errichten.“

Dieses alles bestätigt und unterstreicht einmal mehr die Recherchen der investigativen kanadischen Journalistin Donna Laframboise, die in einem Buch (2013) sowie zahlreichen Internet-Artikeln ausführlich über die Ideologisierung und die „Grüne Unterwanderung“ des IPCC berichtet. [13] [14]

====================================================

F a z i t :

Der Rücktritt des renommierten (bisherigen!) IPCC-Wissenschaftlers RICHARD TOL zeigt: Die Politisierung des IPCC hat ein unerträgliches Ausmaß angenommen. Nicht wissenschaftliche Erkenntnisse stehen im Vordergrund, sondern Grüne Politik und z.T. persönliche Eigeninteressen. Die Glaubwürdigkeit des IPCC hat einen neuen Tiefst-Stand erreicht.

Q u e l l e n :

[2] FAZ: 27.03.2014, Weltklimarat: Protest gegen Klima-Schwarzmalerei ; Betreibt der Weltklimarat Panikmache? Ein führender Wissenschaftler erhebt schwere Vorwürfe – und hat seinen Namen von dem anstehenden Bericht zurückgezogen. http://www.faz.net/aktuell/wirtschaft/wirtschaftspolitik/weltklimarat-protest-gegen-klima-schwarzmalerei-12867411.html

[3] SPIEGEL-ol.: 26.03.2014: Angebliche Panikmache: Führender Forscher verlässt Spitze des Welt-Klimarats. http://www.spiegel.de/wissenschaft/natur/streit-um-ipcc-klimabericht-der-uno-richard-tol-ruecktritt-a-960818.html

[4] Freie Welt; 28. März 2014; http://www.freiewelt.net/nachricht/klima-alarmismus-nicht-in-meinem-namen-10028461/

[5] The Guardian, 28.03.2014 ; http://www.theguardian.com/environment/2014/mar/28/ipcc-climate-costs-estimate-meaningless

[6] Wall Street Journal, 27.03.2014 :

[7] Watts Up With That, 29.03.2014 :http://wattsupwiththat.com/2014/03/29/before-you-read-the-upcoming-ipcc-report-note-this/#more-106650

[8] SPIEGEL-ol : Streit mit Forschern: Politiker wollen Erwärmungspause aus Klimareport verbannen; 20.09.2013; http://www.spiegel.de/wissenschaft/natur/ipcc-verhandlungen-politiker-gegen-wissenschaftler-beim-uno-klimareport-a-923507.html

[9] WELT-ol., 22.09.2013: Deutsche Politiker wollen Klimabericht verschärfen;

http://donnerunddoria.welt.de/2013/09/22/deutsche-politiker-wollen-klimabericht-verschaerfen/

[10] Baseler Z.; 28.09.2013; http://bazonline.ch/ausland/europa/Unsicherheit-in-einer-unsicheren-Welt/story/10513680

[11] Berner Z.; 16.02.2014; http://www.bernerzeitung.ch/wissen/natur/Klimaerwaermung-ist-nicht-das-wichtigste-Problem-der-Welt/story/21100176

[12] Prof. Knut Löschke: Klima und Gesellschaft ; in: Klima-Konferenz der FDP-Fraktion Sachsen: „Sind wir noch zu retten?“ ; 30.06.2012; Dresden, Tagungsband/Dokumentation; Saxedo-GmbH Dresden; Tagungs-Band; S.18-34.

[13] http://www.eike-klima-energie.eu/climategate-anzeige/ein-neues-buch-ueber-das-ipcc-und-pachauri-von-donna-laframboise/ ; 18.09.2013 ;

[14] http://www.eike-klima-energie.eu/climategate-anzeige/wo-steckt-beim-ipcc-die-wissenschaft/ 17.03.2014

===================================================

Anmerkung EIKE-Redaktion:

Als PDF-Anlagen können hier herunter geladen werden:

(1) Vorstehender Aufsatz

(2) Ergänzende Zusammenstellung (Folien) zu „Politik & Klima“