Bild rechts: Fracking in Louisiana (photo: Daniel Foster)

In einem früheren Artikel habe ich einige der Gründe genannt, warum die Schiefer-„Revolution“ in den USA und Kanada stattgefunden hat und nicht auch anderswo, also in Ländern mit ähnlich großen Ressourcen. Die kurze Antwort lautete: Es ging nur um Wettbewerb.

Das Erschließen dieser Ressourcen hat mit Innovation zu tun, und daher wird es dauern, sie in Ländern auf den Markt zu bringen, die sich selbst dem freien Austausch von Investitionen und Gedanken verschließen, oder die auf heimischen Märkten keinen Wettbewerb zulassen. Die Produktion von Öl und Erdgas in großem Maßstab aus Schiefer mag neu sein, aber an diesem Prinzip ist in der Geschichte unserer Industrie nichts neu – und auch nicht, wenn man genauer nachdenkt, in der Geschichte jedweder Industrie.

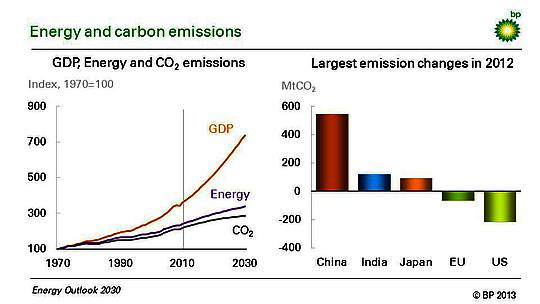

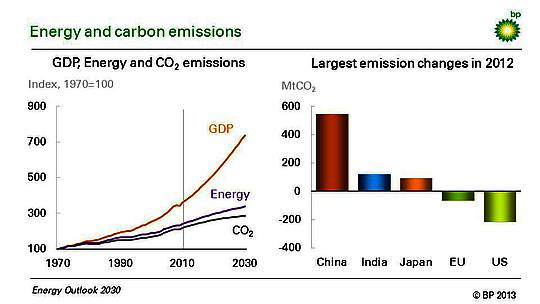

Inzwischen steigt die Erzeugung in Nordamerika immer weiter. Und Schiefer ändert auch die weiter gefasste Landschaft: Niemand zweifelt noch daran, dass die USA in nicht allzu ferner Zukunft zum Erdgas-Exporteur werden. Die Gesamteinfuhren von Öl haben sich bereits fast halbiert. Während der Rohölexport immer noch per Gesetz beschränkt wird, heimsen die USA die Vorteile einer billigeren heimischen Rohölförderung ein, indem sie stattdessen raffinierte Produkte exportieren: Wurden im Jahre 2007 noch insgesamt 2 Millionen Barrel raffinierter Produkte pro Tag eingeführt, sind jüngst 1,2 Milliarden Barrel pro Tag exportiert worden. Nicht nur die Energiesicherheit gewinnt dadurch: Im Vergleich zu allen anderen Ländern der Welt gab es in den USA im vorigen Jahr den stärksten Zuwachs bei der Öl- und Gaserzeugung – und gleichzeitig gab es den bei Weitem stärksten Rückgang bei den CO2-Emissionen – dank der beispiellosen Ersetzung von Kohle durch Erdgas bei der Stromerzeugung, ermöglicht durch Schiefergas. (Gaskraftwerke emittieren nur etwa halb so viel wie Kohlekraftwerke).

Da ist es kaum ein Wunder, dass man inzwischen allmählich begreift, dass die „Schiefer-Revolution“ oder unkonventionelles Gas und Öl in Nordamerika Konsequenzen über die Region und die Energiemärkte hinaus hat, und das noch viele Jahre lang. Und doch hinken Untersuchungen über die globalen strategischen Implikationen – hinsichtlich Energiesicherheit, Geopolitik, der Weltwirtschaft und der Umwelt – der aktuellen Entwicklung hinterher; was vielleicht nicht überraschend ist, weil sehr unsicher ist, wie sich die zukünftige Erzeugung entwickelt.

Welches sind einige dieser wahrscheinlichen strategischen, globalen Implikationen? Um dies zu beleuchten braucht man einen sinnvollen Bezugspunkt.

Es gibt zwei Aspekte, worin sich Schiefer-Ressourcen von konventionellem Öl unterscheiden. Erstens erstrecken sich Schiefer-Ressourcen in weit verbreiteten Gebieten. Die Einschätzungen stecken immer noch in den Kinderschuhen, aber alle verfügbaren Anzeichen zeigen, dass sich technisch abbaubare Öl- und Gas-Schieferressourcen in Asien, Australien, Afrika Südamerika, Europa und Eurasien befinden – näher an den Zentren des Verbrauchs als konventionelles Öl. Man vergesse nicht, wir wissen beklagenswert wenig über die Abbaubarkeit dieser Ressourcen in ökonomischer Hinsicht.

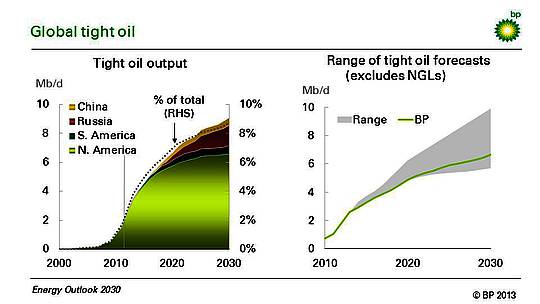

Zweitens, die meisten Forecaster – einschließlich wir selbst – sagen voraus, dass das Wachstum in absehbarer Zukunft in Nordamerika konzentriert bleibt, trotz der relativ gleichmäßigen räumlichen Verteilung. Gründe hierfür sind der fehlende Zugang, Wettbewerb und folglich innovative Anreize in anderen Ländern; und in Bezug dazu ein Fehlen einer geeigneten Infrastruktur, die zu bilden Zeit braucht.

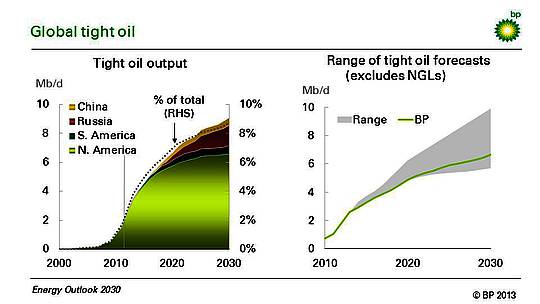

Die Abbildung oben zeigt beide Punkte. Links findet sich ein Produktionsprofil aus den Energie-Aussichten von BP 2030, veröffentlicht im Januar 2013. Basierend auf unserer Sicht der Geologie, Infrastruktur-Erfordernissen und Bohraktivitäten ebenso wie die Schnelligkeit, mit der Schiefer-Ressourcen an verschiedenen Stellen erschlossen werden können zeigt sie, dass die globale Erzeugung aus Schieferöl bis 2030 auf 9% der globalen Ölproduktion wachsen soll – während der Anteil noch vor wenigen Jahren nicht existent war.

Die Wachstumsrate wird positiv bleiben, sich jedoch nach dem Jahr 2020 verlangsamen

Drei Charakteristiken müssen erwähnt werden: (a) Die Wachstumsrate wird weiterhin von Nordamerika dominiert, (b) Das Wachstum wird positiv bleiben, sich aber etwa nach dem Jahr 2020 verlangsamen im Vergleich zu den derzeitigen sehr hohen Raten, und (c) andere Länder werden dem Spiel beitreten – namentlich Russland, China, Argentinien und Kolumbien – aber ihr Beitrag wird nicht schnell genug wachsen, um die allgemeine Verlangsamung des Wachstums nach 2020 zu kompensieren.

Als Nächstes verglichen wir diese frisch erstellte Vorhersage mit anderen Vorhersagen, dargestellt durch die grau schattierten Flächen in der Abbildung rechts. Es zeigt sich (was zu jener Zeit überraschend für uns war), dass die BP-Vorhersage tatsächlich sehr konservativ war. Sie liegt am unteren Ende der Bandbreite aller anderen Vorhersagen. Tatsächlich dürfte es schwierig werden, noch niedrigere Vorhersagen als die Unsrige zu finden.

Unsere Vorhersage liegt nicht nur niedriger, auch die Verlangsamung des Wachstums nach 2020 wird nicht überall geteilt. Viele andere sagen ein stetiges Wachstum voraus oder sogar eine Beschleunigung bis zum Jahr 2030.

Die konservative Natur dieser Vorhersage ist der springende Punkt. Offensichtlich basiert angesichts der gegenwärtigen Bandbreite der Unsicherheiten jede Diskussion über globale Implikationen – explizit oder nicht – auf einer Erzeugungs-Prognose. Unsere Vorhersage impliziert, dass die unten beleuchteten Konsequenzen erweitert werden müssen, wenn die optimistischeren Vorhersagen richtig liegen.

Was also sind nun diese Implikationen? Basierend auf diesem konservativen Bezugspunkt fallen mir mindestens fünf ein.

1.Druck auf die Konfiguration der Öl- und Gasmärkte

Eine der ersten durch die Schiefer-„Revolution“ aufgeworfenen Fragen werden die Auswirkungen steigender Schieferöl- und –gaserzeugung auf Markt und Preise sein. Wir wollen uns auf Öl konzentrieren. In einem normalen Markt sollten die Preise fallen, und das Einzige, womit sich Ökonomen befassen müssen, ist zu berechnen, wie schnell und um wieviel sie fallen. Aber der Ölmarkt ist nicht exakt ‚normal‘: Es gibt dort ein Erzeuger-Kartell mit einer langen Geschichte der Versuche, Preise und Produktion zu kontrollieren. Beim Ölmarkt geht es bei der Frage nach den Konsequenzen höherer Schieferölmengen also darum, wie die OPEC wahrscheinlich reagieren wird.

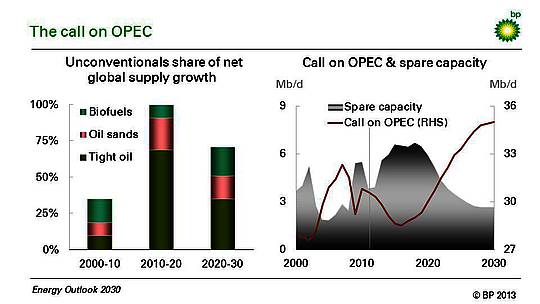

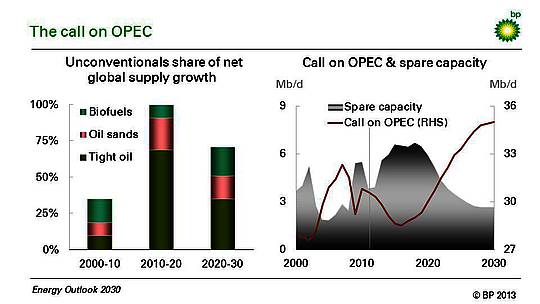

Es gibt gute Gründe für die Annahme, dass die OPEC-Mitglieder willens und in der Lage sind, mit Produktionsbeschränkungen auf die steigende Versorgung aus Nicht-OPEC-Ländern zu reagieren.

Produktionsbeschränkungen wiederum führen zu Überkapazitäten. Die Ausbildung von Überkapazitäten in OPEC-Ländern, die notwendig sind, um die zusätzliche Versorgung zu neutralisieren (einschließlich Biotreibstoffe und Ölsande) ist wirklich substantiell: Nimmt man unser Produktionsprofil als Ansatz, müsste die Überkapazität zum Ausgleich der neuen Mengen in diesem Jahrzehnt über 6 Millionen Barrel pro tag liegen – das ist der höchste Wert seit Ende der achtziger Jahre, wie die rechte Karte in der Abbildung unten zeigt.

Das wird keine leichte Aufgabe für die OPEC. Der Zusammenhalt der Organisation steht im Mittelpunkt der Unsicherheiten, vor allem im jetzigen Jahrzehnt. Es wird eine Welt sein, in der Russland, die USA und Saudi-Arabien ein Drittel der globalen Erzeugung beisteuern. Von diesen dreien wird wahrscheinlich nur das OPEC-Mitglied Saudi-Arabien die Last großer Mengen überschüssiger Kapazität auf sich nehmen. Und Saudi-Arabien liegt zwischen Irak, einem OPEC-Mitglied mit ständig steigendem Output, aber ohne Quotenregelung, und Iran, wo noch niemand vorhersagen kann wie lange die bestehenden Sanktionen die Produktion noch limitieren.

Die Rolle politischer Diskussionen wird wahrscheinlich neue Höhepunkte erreichen bei der Bestimmung, ob, wo und wann auf Schieferressourcen zugegriffen werden kann.

Andererseits werden wir wahrscheinlich nicht die Rückkehr zu den sehr niedrigen Ölpreisen erleben, die es in den neunziger oder achtziger Jahren gab (unter der Annahme, dass die OPEC so bleibt wie bisher). Die Schieferölproduktion ist nicht nur relativ teuer; mit seiner hohen Dichte der Bohrlöcher ist sie auch eminent skalierbar (anders als die konventionellen Vorräte in Alaska oder in der Nordsee seit den achtziger Jahren). Die Versorgung wird reagieren, sobald die Preise substantiell fallen.

Zunächst wird das Auftreten von Schieferöl (und –gas) Druck auf die Preise ausüben, indem die Konfiguration der Märkte, so wie wir sie kennen, auf den Prüfstand kommt. Im Falle des Öls ist die OPEC der Eckpunkt dieser Märkte. Im Falle des Gases ist es die Indexbindung der Gaspreise an das Öl.

2.Eine neue Rolle für die lokale Politik

Unsere Industrie ist stolz darauf, zwischen „Tagebau-„ und „Untergrund“-Faktoren zu unterscheiden, wenn es um den Zugang zu Ressourcen geht. Untergrund heißt Geologie, also von der Natur vorgegebene Bedingungen; Tagebau erfordert vom Menschen festgelegte Bedingungen, wie z. B. einen politischen, gesetzlichen oder ökonomischen Rahmen.

Die Rolle von politischen Diskussionen zum Thema „Tagebau“ wird vermutlich neue Höhepunkte erreichen bei der Festlegung, ob, wo und wann Schieferressourcen erschlossen werden sollen. Diese Diskussionen werden sich eher um lokale als um große geopolitische Themen drehen – einfach als Folge der weiträumigen geographischen Verteilung der Schiefer-Ressourcen.

Die Zufälle der Natur, die nennenswerte ‚konventionelle‘ Ölressourcen vor Millionen Jahren angelegt hatte, haben diese in hoch konzentrierter Weise verteilt. Bei der traditionellen Politik hinsichtlich Öl und Gas geht es als Konsequenz mehr oder weniger lediglich um die einfache Regelung, wer diese Stellen effektiv unter Kontrolle hat.

Hinsichtlich knappen Öls und Schiefergases wird es bei lokalen Debatten im Gegensatz dazu hauptsächlich um die Haltung bzgl. Energie, Wettbewerb und Umwelt vor Ort gehen – all dies als Wechselwirkung zwischen der relativ gleichmäßigen Verteilung von Schiefer-Ressourcen und der Rolle des freien Zugangs, und nicht zuletzt um Umweltaspekte bei der Erschließung.

Die Anzeichen sind schon jetzt überall erkennbar.

In Europa wetteifern Polen und die Ukraine aggressiv um Investitionen, während in Frankreich und Bulgarien Moratorien gegen Fracking verhängt worden sind, was den Schieferaspekt bis auf weiteres aufs Abstellgleis schiebt. In Deutschland und UK debattiert man noch.

Der fehlende Erfolg Chinas hinsichtlich des Zugangs zu Schiefer wie geplant ist zum größten Teil zurückzuführen auf die bevorzugte Bereitstellung entsprechender Gebiete für nationale Monopolisten und hohe Barrieren gegen den Eintritt von außen – einschließlich von Unternehmen, die über bessere Technologie verfügen und weniger vor den Risiken zurückschrecken, seien diese nun heimischer oder auswärtiger Natur. Russland steht vor einem interessanten Ausgleich zwischen der Verfolgung gänzlich neuer und kostspieliger Technologien, um die Erzeugung in arktische Gebiete zu verlagern, oder um ein wenig mehr Ausprobieren, neue Technologien zum Zugang zu den inzwischen bekannten Schieferressourcen zu bekommen. Obwohl zögerlich, reformiert Russland sein Steuersystem in Verfolgung der zweiten Option.

Selbst in den USA konzentrierte sich die Erzeugung aus Schieferformationen bislang in den zentralen Gebieten des Landes, wobei man große bekannte Felder in den küstennahen Bereichen Kaliforniens und von New York State außen vor lässt, in diesem Falle wegen Umweltbedenken.

All diese Beispiele reflektieren die politischen Diskussionen über der Erde. Sie spiegeln die Haltung vor Ort hinsichtlich des freien Zugangs, des Wettbewerbs auf den Energiemärkten und der Umwelt. Wir sollten erwarten, dass dies noch eine Weile so weitergeht.

Zunehmend wird die Festlegung, ob und wie diese Ressourcen auf den Markt geworfen werden, in den Rathäusern und Parlamenten der Verbraucher entschieden – und nicht durch die ‚große‘ Geopolitik, die die launische Art der Natur bei der Verteilung konventioneller Ölfelder in weit entfernten Gebieten spiegelt.

3.Geopolitik der Energie – die große Unbekannte

Wenn man Entscheidungen vor Ort treffen muss, heißt das nicht, dass die Geopolitik hinsichtlich Energie weniger wichtig wird. Tatsächlich ist die dritte Implikation inzwischen verbreitet erkannt worden: Es betrifft die geopolitischen Konsequenzen der Verschiebungen in den etablierten Zentren von Produktion und Verbrauch. Nirgends kommt das besser heraus als bei einem Blick auf den Nahen Osten.

Wir alle sind aufgewachsen in einer Welt, in der Öl der zentrale Treibstoff ist, und der Nahe Osten steht im Mittelpunkt der Versorgung der Welt mit Öl. Ob das nun gut oder schlecht ist – die nachfolgenden Beziehungen zwischen dem größten Ölverbraucher der Welt und diesem regionalen Vorratszentrum hatte schon immer enorme politische Konsequenzen: Man kann nicht bestreiten, dass sich mit der Zeit spezielle zweiseitige Beziehungen entwickelt haben zwischen den USA (und im größeren Rahmen der OECD) und kleinen Ökonomien des Nahen Ostens, die zufällig große Ölproduzenten sind.

Diese Beziehungen könnten sich ändern, und zwar in ziemlich unvorhersagbarer Weise.

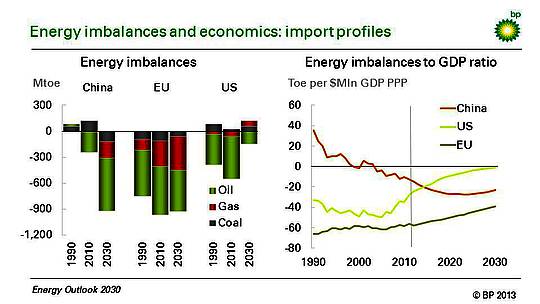

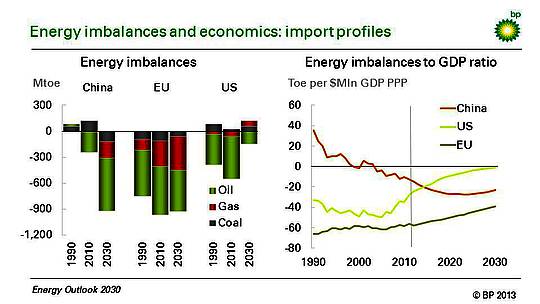

So unwahrscheinlich das klingt, aber vor zwanzig Jahren war China insgesamt ein Exporteur von Energie. Bis zum Jahre 2030 wird das Land vermutlich zum größten nationalen Einzel-Importeur (auch bzgl. Erdgas und Kohle), kann es doch zu einer Abhängigkeit von 80% von seinem Öl und über 40% von seinem Gas kommen. Während des gleichen Zeitraumes dürfte Europa ein großer Importeur fossiler Treibstoffe bleiben – dies ist in der Karte links in der Abbildung unten dokumentiert.

Die USA stehen vor anderen Perspektiven. Nehmen wir erneut unser konservatives Erzeugungsprofil als Vergleich, wird das Land nahezu energieunabhängig sein bis zum Jahr 2030. Nordamerika als Region (Mexiko, Kanada und die USA), wird diesen Punkt schon früher erreichen. Schon jetzt sind die USA insgesamt ein Kohleexporteur, und es gibt kaum noch Zweifel, dass sie bald auch zu einem Gasexporteur werden. Und selbst wenn unserem konservativen Profil zufolge die USA bis 2030 ein Importeur von Öl bleiben, werden die Importen drastisch zurückgegangen sein.

Welche Konsequenzen ergeben sich daraus? Ist es denkbar (und das ist absolut keine Vorhersage), dass eine zukünftige amerikanische Administration noch auf diese von Wirren durchzogene Region schaut, wenn sie nur noch sehr wenig Öl von dort braucht – und das Wenige, das sie noch braucht, auch aus Kanada und Mexiko geliefert werden kann? Das können wir nicht wissen. Es ist nicht vorhersagbar.

Klar ist lediglich, dass weder die Natur noch Märkte und vermutlich die Politik ein Vakuum mögen. Wir können nicht wissen, wie dieses Vakuum ausgefüllt wird. Aber die Geopolitik der Energie-Beziehungen so wie wir sie kennen, verschiebt sich.

4.Gute Nachrichten für die Weltwirtschaft – zumindest auf den ersten Blick

Bislang wird die öffentliche Diskussion über die ökonomischen Implikationen von Schieferöl und –gas von der Frage dominiert, ob niedrigere Energiepreise den USA einen Wettbewerbsvorteil verschaffen werden und sogar deren industrielles Wiedererstarken verursachen könnten. Im Gesamtbereich dieses Themenkomplexes wird sich dies jedoch nur als peripher herausstellen.

Wichtiger sind die globalen Kapitalflüsse in Verbindung mit den neuen Produktionszentren von Öl und Gas. Auf eine entsprechende Frage hätten die meisten Ökonomen während der letzten Jahre wahrscheinlich geantwortet, dass eine der größten permanenten Bedrohungen der globalen wirtschaftlichen Stabilität in dem liegt, was unter der Bezeichnung globales Ungleichgewicht bekannt ist: Der Ausdruck bezieht sich (zumeist) auf die Notwendigkeit, ein permanentes externes Defizit der USA sowie ein solches im öffentlichen Bereich zu finanzieren, und zwar mit Kapitalzuflüssen aus Ländern, die einen äußeren Überschuss haben.

Das prominenteste Beispiel hierfür ist natürlich China. Aber die USA importieren ebenfalls Kapital aus dem Nahen Osten und anderen exportorientierten Nationen. Das Risiko hinsichtlich dieser Situation besteht darin, dass sich das Überrollen dieser Finanzerforderlichkeiten eventuell als nicht nachhaltig herausstellen könnte. Globale Instabilität könnte die Folge sein.

Die kürzlich besprochenen Energie-Ungleichgewichte enthalten das Potential, diese Ungleichgewichte der Zahlungsbilanzen zu lindern. Derzeit machen diese Importe immer noch etwa 50% des äußeren Defizits der USA in Gütern und Dienstleistungen aus. Auf den ersten Blick wird der Trend zur Selbstversorgung hinsichtlich Energie dieses Defizit verringern (es wird auch der fiskalischen Situation helfen). Gleichzeitig werden aber steigende Energieimporte den chinesischen Handelsüberschuss erniedrigen. Sollte es wirklich zu niedrigeren Ölpreisen kommen, würde dies auch eine Delle in den gegenwärtigen Überschuss der Ölproduzenten des Nahen Ostens schlagen.

Urplötzlich scheint sich eine Kraft des Guten aufgetan zu haben, noch dazu von unerwarteter Seite – von den Energiemärkten, die in gewisser Weise die globale Wirtschaft neu auszurichten unterstützen.

Natürlich muss man da vorsichtig sein. Die USA könnten beschließen, mehr von irgendetwas Anderem als Energie zu exportieren. Komplizierte Auswirkungen von Wechselkursen müssen evaluiert werden, bevor am Rückschlüsse auf Kontingente ziehen kann. Bis heute hat noch niemand eine solche detaillierte Abschätzung der makroökonomischen Auswirkungen von Schieferöl und –gas vorgenommen.

Eines jedoch ist offensichtlich. Selbst nach unserem moderaten Produktionsprofil verspricht die Größenordnung dieser globalen Auswirkungen gewaltig zu sein – groß genug, um eine solche Abschätzung dringlich zu machen. Schließlich kann man wohl darauf wetten, dass dieser Zahlungsgleichgewichts-Effekt den gegenwärtigen Streit um Energiepreise und die Wettbewerbsfähigkeit der USA marginalisieren könnte.

Die Produktion von Schieferöl und –gas wird vermutlich einen deutlichen Fußabdruck in der globalen makroökonomischen Landschaft hinterlassen. Und zumindest auf den ersten Blick sieht das wie eine gute Nachricht für die globale Wirtschaft aus.

5.Ein Entscheidungskriterium für an der Umwelt Interessierte

Die Erzeugung einer Kilowattstunde Strom mit einem modernen Gaskraftwerk emittiert etwa 50% weniger Kohlenstoff als die Erzeugung mittels eines Kohlekraftwerkes. Die Konsequenzen sind erheblich.

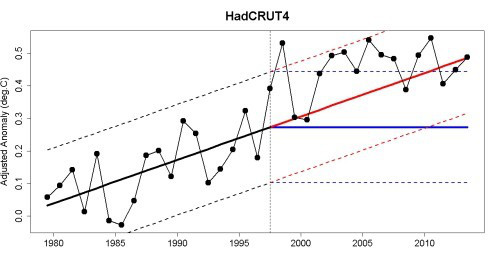

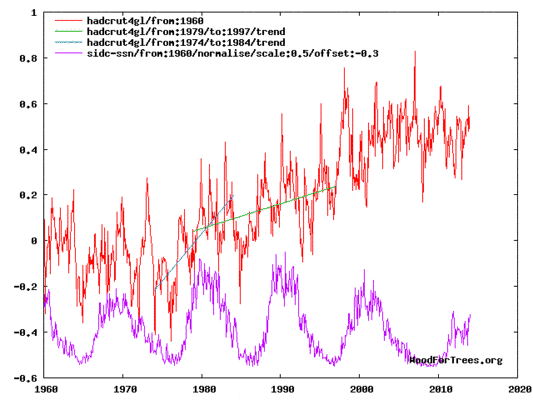

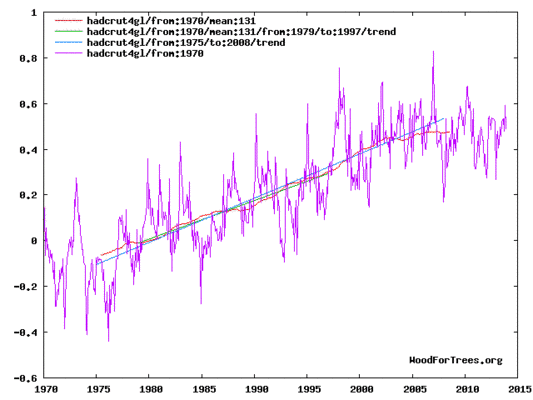

Im vorigen Jahr hatten die USA, nicht gerade bekannt für eine gewissenhafte Umweltpolitik, nicht nur den größten Zuwachs bei der Öl- und Gaserzeugung, sondern es gab auch den größten Rückgang der CO2-Emissionen weltweit – weil massiv Kohle bei der Energieerzeugung durch billigeres Schiefergas ersetzt worden ist. Im Gegensatz dazu gingen die Emissionen in der EU nur marginal zurück und auch nur als Folge einer wirtschaftlichen Rezession – wie die Abbildung unten zeigt. Die Kohlenstoff-Intensität, also die Menge des emittierten Kohlenstoffs pro Energieeinheit, stieg, als die europäischen Ökonomien Gas durch billigere Kohle, importiert aus den USA, ersetzt haben.

Die Kohle der USA wird durch die Schiefer-„Revolution“ auf das Abstellgleich geschoben: die überflüssige, weil durch billigeres Schiefergas ersetzte Kohle wird nach Europa verschifft, wo es die teureren Importe verflüssigten Gases bei der Energieerzeugung verdrängt. Die nun überflüssigen Gasvorräte dort wiederum fließen jetzt nach Asien, wo sie für Spitzenpreise erwünscht sind – auch aus anderen Gründen, nämlich als Ersatz für die Kernkraft in Japan. In dieser Weise erzeugt die europäische Energieerzeugung ein unglückliches Spiegelbild der USA: In Europa steigt der Kohleanteil und sinkt der Gasanteil; in den USA ist es genau umgekehrt. Die Konsequenzen für den Ausstoß von Kohlenstoff liegen auf der Hand.

Man denke an die schiere Größenordnung. Gas und Kohle decken derzeit jeweils ein Viertel bzw. ein Drittel des globalen Energieverbrauchs; Erneuerbare (ohne Wasserkraft) schlagen lediglich mit 2% zu Buche. Unvermeidlich führt dies zu der Frage, ob man den Zielen hinsichtlich CO2 nicht besser dient, wenn man mehr Kohle durch Erdgas ersetzt, einschließlich Schiefergas, anstatt die Erneuerbaren allein graduell und sehr kostspielig auszubauen. Das Argument, viel stärker auf den globalen Handel zurückzugreifen – zum Beispiel in dem man die Auspreisung von Kohlenstoff ernst nimmt – wird gestärkt durch die Effizienz, mit der diese beiden fossilen Treibstoffe über Grenzen und sogar Kontinente hinweg gehandelt werden, was mit Sonne und Wind einfach nicht möglich ist.

Und so erhebt sich die Frage: Was ist stärker, die Angst vor dem Fracking oder die gewissenhafte Befürwortung, mehr Kohle durch Erdgas zu ersetzen einschließlich Schiefergas? Ich habe dazu meine eigene Meinung. Fracking ist ein lokales Problem, Kohlenstoffemissionen sind abstrakt und global. Wir wissen, wie so etwas vermutlich endet. Aber für jetzt ist der Punkt, dass diese Frage in der gesamten Umweltdiskussion noch gar nicht gestellt worden ist.

Damit schließt diese Abhandlung über die globalen Auswirkungen von Schiefer. Man behalte im Hinterkopf, dass diese Einschätzung auf den bisherigen Energieaussichten vom Januar 2013 basieren. Aber sie wurde auch vorgenommen als Vorbereitung des Folgeberichtes im Januar 2014.

Editor’s Note

Christof Rühl is Group Chief Economist and Vice President of BP plc. He manages BP’s global Economics Team, providing economic input into the firm’s commercial decisions. BP’s Economics Team produces the annual Statistical Review of World Energy and the Global Energy Outlook.

Prior to joining BP, Rühl worked at the World Bank (1998-2005) where he served as the Bank’s Chief Economist in Russia and in Brazil. Before that, he worked in the Office of the Chief Economist at the EBRD (Economic Bank for Reconstruction and Development) in London. He started his career as an academic economist, first in Germany and from 1991 as Professor of Economics at the University of California in Los Angeles.

He wrote this article originally as a five-part piece on LinkedIn in December 2013: http://www.linkedin.com/today/post/article/20131206211204-259060403-on-the-global-implications-of-shale-setting-the-scene

It is published here with permission from the author.

Link: http://www.energypost.eu/five-global-implications-shale-revolution/

Übersetzt von Chris Frey

Hinweis: Der Autor hat sein Einverständnis für die Übersetzung erklärt, aber darum gebeten, die Übersetzung zu begutachten. Nachdem ich ihm diese Übersetzung vorgelegt habe und keine Antwort kam, habe ich ihm vor einigen Wochen noch einmal geschrieben, wieder ohne Antwort.

Weil ich davon ausgehe, dass daraus zu schließen ist, dass er nichts gegen die Übersetzung einzuwenden hat, wird der Artikel jetzt hier beim EIKE gepostet.

—

Die Angaben zur Biographie habe ich absichtlich nicht übersetzt.

C. F.