SMR Teil 3 — Innovative Reaktoren

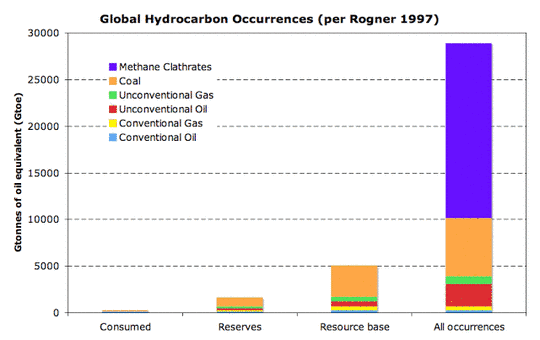

Zwar ist die Wärmeerzeugung immer noch mit großem Abstand die überragende Energieanwendung, aber nur ein geringer Bedarf entfällt davon auf Hochtemperatur-Wärme (chemische Prozesse). Die “Endlichkeit” von Kohle, Öl, Erdgas und Uran hat sich längst als Wunschtraum unbelehrbarer Anhänger der Planwirtschaft erwiesen. Längst ist man daher in diesen Kreisen auf eine indirekte Verknappung (Klimaschutz – wir dürfen gar nicht so viel fossile Brennstoffe nutzen, wie wir zur Verfügung haben) umgestiegen. Es lohnt sich nicht, sich damit weiter auseinander zu setzen. Für diese Betrachtungen reicht folgender Zusammenhang vollständig aus:

Energieverbrauch und Wohlstand sind die zwei Seiten ein und derselben Medaille. Wer das Recht aller Menschen auf ein Mindestmaß an Wohlstand anerkennt, muß von einem weiter steigenden Energiebedarf ausgehen. Oder andersherum ausgedrückt: Wer eine Senkung des Energieverbrauches fordert – wie es scheinbar immer populärer wird – will die Armut für den größten Teil der Menschheit weiter festschreiben.

Mit fortschreitender Entwicklung steigt der Verbrauch elektrischer Energie überproportional an. Der für eine zuverlässige und kostengünstige Stromversorgung einzusetzende Primärenergieaufwand, steigt damit weiter an. Ersetzt man die hierfür notwendigen Mengen an Kohle und Erdgas durch Kernenergie, bekommt man mehr als genug dieser Energieträger frei, um damit Industrie und Transportsektor zu versorgen. Die USA führen diesen Weg mit der Erschließung unkonventioneller Öl- und Gasvorkommen – bei gleichzeitigem Ausbau der Kernkraftwerke – eindrucksvoll vor.

Hat man diesen Zusammenhang verstanden, wird auch die Entwicklung der “kleinen” Reaktoren in den nächsten Jahrzehnten vorhersagbar. Das Streben nach “hohen Temperaturen” hat durch die Entwicklung des Erdgasmarktes (außerhalb Deutschlands!) an Bedeutung eingebüßt. Erdgas – egal aus welchen Vorkommen – ist der sauberste und kostengünstigste Brennstoff zur Erzeugung hoher Temperaturen und zur Gewinnung von Wasserstoff. Zur Stromerzeugung eigentlich viel zu schade!

Das Argument des geringeren Uranverbrauches durch Reaktoren mit höherer Temperatur ist ebenfalls nicht stichhaltig: Die Uranvorräte sind nach menschlichen Maßstäben unerschöpflich und der Minderverbrauch durch höhere Wirkungsgrade wiegt den wirtschaftlichen Mehraufwand bei weitem nicht auf. Ein Anhaltspunkt hierfür, bietet die Entwicklung bei Kohlekraftwerken: Sie liegt heute noch in Regionen mit“billiger” Kohle eher in der Größenordnung von Leichtwasserreaktoren (ungefähr 33 %) als bei deutschen und japanischen Steinkohlekraftwerken (fast 46 %). Bis Uran so teuer wird, daß sich eine Wirkungsgradsteigerung um 40 % wirtschaftlich lohnt, dürften eher Jahrhunderte, als Jahrzehnte vergehen. Damit dürften alle Hochtemperaturreaktoren eher Nischenprodukte bleiben, was aber gerade dem Gedanken einer Serienproduktion widerspricht. Gleiches gilt auch für sog. “Schnelle Brüter”.

Gleichwohl sind einige gasgekühlte Reaktoren und Reaktoren mit schnellen Neutronen in der Entwicklung. Diese Prototypen sollen im Folgenden etwas näher vorgestellt werden

NPMC-Reaktor

National Project Management Corporation (NPMC) hat zusammen mit dem Staat New York , der City of Oswego und der Empire State Development einen Antrag auf Förderung für einen heliumgekühlten Kugelhaufen-Reaktor mit 165 MWel eingereicht. Dem Konsortium hat sich National Grid UK, die New York State Energy Research Development und die Pebble Bed Modular Reactor (PBMR) of South Africa angeschlossen.

Eingereicht wurde ein Gas Turbine Modular High-Temperature Reactor (GT-MHR). Die Entwicklung beruht auf dem in Deutschland entwickelten THTR-Reaktor. Sie wurde in Südafrika fortgesetzt. Anders als in Deutschland und China, wollte man aber nicht einen konventionellen Dampfkreislauf sekundärseitig verwenden, sondern wollte zur Stromerzeugung eine Gasturbine einsetzen. Die Entwicklung eines solchen geschlossenen Gasturbinen-Kreisprozesses mit Helium als Arbeitsmittel überstieg aber bei weitem die wirtschaftlichen Möglichkeiten Südafrikas, was letztendlich zur Aufgabe führte.

Eine Gasturbine hat so hohe Austrittstemperaturen, daß problemlos eine trockene Kühlung mit Außenluft möglich wird. Die Schwierigkeit in den Verbrauchsschwerpunkten in Südafrika ist die Bereitstellung von ausreichend Kühlwasser. Unter dem Wassermangel leiden dort alle konventionellen Kraftwerksprojekte (hauptsächlich Kohle). In New York gibt es zwar genug Wasser, aber die (angebliche) Umweltbelastung durch Kühlwasser ist der Hauptansatz gegen die vorhandenen und geplanten Kernkraftwerke. Nichts desto trotz, könnten SMR mit geschlossenen Gasturbinen ein Modell für die dezentrale Versorgung in zahlreichen ariden Gebieten auf der Welt sein.

China verfolgt ebenfalls konsequent den Kugelhaufen-Hochtemperatur-Reaktoren weiter. Allerdings sind alle in Bau und Planung befindlichen Kraftwerke mit konventionellen Dampfkreisläufen ausgerüstet

Energy Multiplier Module (EM2)

Auch General Atomics (GA) hat ein Gas-Turbine Modular Helium Reactor (GT-MHR) Konzept mit 265 MWel eingereicht. Man geht aber nicht von einem Kugelhaufen (siehe oben), sondern von hexagonalen Prismen als Brennelementen aus. Basis ist ein eigenes Modell aus den 1980er Jahren. Das Modul soll bei einer thermischen Leistung von 500 MWth komplett und fertig mit Brennstoff beladen, auf einem LKW zur Baustelle transportiert werden. Die Austrittstemperatur des Heliums soll (extrem hohe) 850 °C betragen. Damit wäre der Einsatz als Wärmequelle in der Verfahrenstechnik, bis hin zur thermischen Wasserstoffproduktion, denkbar. Ein Turbosatz mit hoher Drehzahl wird auf einem zweiten LKW angeliefert. Die Gasturbine und der angeschlossenen Generator laufen mit mehreren 10.000 Umdrehungen pro Minute. Die Umwandlung der elektrischen Energie in “netzfähigen Strom” erfolgt über elektronische Umformer. Bei der eingereichten Variante handelt es sich um ein reines Kraftwerk zur Stromerzeugung. Im Begleittext wird betont, daß dieser Reaktor lediglich die Abmessungen eines “Schulbusses” hätte. Hinzu käme ein etwa gleich großes Modul für den Turbosatz. Insofern wäre die Leistungsdichte (umbauter Raum) konkurrenzlos gering. Wegen der hohen Austrittstemperatur hätte dieses Kraftwerk einen elektrischen Wirkungsgrad von 53 %. Das Kraftwerk käme mit Luftkühlung aus und wäre damit äußerst flexibel einsetzbar. Durch den hohen Wirkungsgrad und seine neutronenphysikalischen Eigenschaften, wäre selbst ohne Wiederaufbereitung der “Atommüll” um 80% geringer, als bei üblichen Reaktoren.

Noch innovativer als der Turbosatz, ist das Brennstoffkonzept: Der Reaktor wird in der Fabrik mit Brennstoff beladen und komplett nach 30 Jahren Laufzeit wieder in die Fabrik zurückgeliefert. Das ganze ähnelt also eher einer Batterie, als einem klassischen Kraftwerk. Dieses Konzept würde die gesamte Stromversorgung revolutionieren. Ein “Energieversorger” mietet sich quasi für 30 Jahre eine “Stromerzeugungseinheit” und gibt diese nach Gebrauch komplett wieder zurück. Durch die speziellen Sicherheits- und Betriebsanforderungen löst sich auch das Problem der Personalkosten: Verkleinert man einfach heutige Reaktorkonzepte, steigt der spezifische Personalaufwand stark an. Das ist leider die Umkehrung der Betriebskostendegression mit zunehmender Kraftwerksgröße. Die Kombination aus geringen Investitionskosten, kaum Betriebskosten, kaum Netzkosten, keine “Atommüllprobleme”…, könnte einen ähnlichen Quantensprung, wie die Einführung des PC in der Datenverarbeitung auslösen. Davon dürften sicherlich nicht alle begeistert sein!

Die Brennelemente besitzen eine Umhüllung aus einem Siliziumcarbid-Faser-Verbundwerkstoff. Das Material verträgt Temperaturen von weit über 2000 °C und reagiert wegen seiner keramischen Eigenschaften praktisch nicht mit Luft und Wasser. Der Brennstoff ist inhärent sicher und selbstregelnd: Steigt die Temperatur zu stark an, bricht die Kettenreaktion in sich zusammen (Dopplereffekt). Auch die Nachzerfallswärme kann dem Brennstoff praktisch nichts anhaben, da er sich gefahrlos so weit aufheizen kann, daß schon die Wärmeabgabe durch Strahlung (Kühlmittelverluststörfall) dauerhaft ausreicht. Dieses Verhalten ist unzählige male experimentell bestätigt worden.

Jeder Reaktor wird erstmalig mit etwa 20 to abgebranntem Brennstoff aus Leichtwasserreaktoren oder abgereichertem Uran beladen. Hinzu kommt als “Starter” rund 22 to auf 12% angereichertes Uran. Nach 30 Jahren Betriebszeit werden in einem speziellen Aufbereitungsprozess die entstandenen etwa 4 to Spaltprodukte entfernt und durch 4 to abgebrannten Brennstoff aus Leichtwasserreaktoren ergänzt.

General Atomic ist eines der führenden Unternehmen (nicht nur) der Kerntechnik. Am bekanntesten dürften die weltweit gelieferten 66 TRIGA-Reaktoren (Training, Research, Isotopes, General Atomic) sein. Zusätzlich gehören zu dem Bewerbungskonsortium noch zwei der weltweit führenden Anlagenbauer: CB&I und Mitsubishi Heavy Industries und die Mutter der schnellen Reaktoren und der Wiederaufbereitung: Das Idaho National Laboratory (INL). Es fehlt also nicht an Kapital und Sachverstand. Größte Hürde dürfte das NRC mit seinem “unendlichen” Genehmigungsverfahren sein. Aber auch auf dem Sektor des Bürokratismus bewegt sich in den USA etwas: Nicht nur, wegen der Drohkulisse, die China am Horizont aufbaut.

PRISM

Ein weiterer “schneller” Reaktor, aber mit Flüssigmetallkühlung, ist der von General Electric und Hitachi Nuclear Energy (GEH) propagierte Power Reactor Innovative Small Module (PRISM). Es handelt sich ebenfalls um einen vollständig vorgefertigten und transportierbaren Reaktor, mit einer thermischen Leistung von 840 MWth und 311 MWel . Es ist geplant, je zwei solcher Einheiten auf einen konventionellen Turbosatz (typisches Kohlekraftwerk) mit 622 MWel zusammenzuschalten.

Das PRISM-Konzept bricht ziemlich radikal mit der heutigen Nutzung der Kernenergie und ihrem Brennstoffkreislauf. Es senkt konsequent den Einsatz von Natururan und entlässt als Abfall wesentlich geringere Mengen mit deutlich kürzerem Gefährdungszeitraum. Um dieses Ziel zu erreichen, ist nicht nur der Übergang auf “schnelle” Neutronen nötig, sondern auch auf einen völlig neuen Brennstoffkreislauf. Durch die Verwendung von Neutronen mit hoher Energie (hoher Geschwindigkeit) kann man praktisch alle Aktinoide spalten – allerdings um den Preis einer geringeren Wahrscheinlichkeit. Man braucht deshalb eine wesentlich höhere Konzentration von U235 bzw. Pu239 um überhaupt eine Kettenreaktion in Gang setzen zu können. Außerdem muß man auf Wasser als Kühlmittel verzichten. Ein in diesem Sinne ideales Kühlmittel, ist das Metall Natrium. Geht man auf ein flüssiges Metall als Kühlmittel über, macht es Sinn, auch den Brennstoff in metallischer Form zu verwenden. Eine Legierung aus Uran, Zirconium und – gegebenenfalls allen möglichen – Transuranen, hat sich als besonders geeignet erwiesen. Wenn man aber schon einen Brennstoff in metallischer Form vorliegen hat – und keinerlei Ambitionen hegt, Kernwaffen zu bauen – bieten sich die erprobten Verfahren der Elektrometallurgie (Aluminium-, Kupferproduktion etc.) an. Vereinfacht gesagt, löst man den zerstückelten “abgebrannten” Brennstoff in geschmolzenem Lithiumchlorid auf und legt eine Spannung von 1,34V an. Nun wandert das Uran und alle sonstigen Aktinoide zur Kathode und scheiden sich dort ab. Die Spaltprodukte bleiben im Lithiumchlorid zurück. Die Kathode wird eingeschmolzen und daraus neue Pellets hergestellt. Diese werden in Stahlrohre (H9) gesteckt, mit flüssigem Natrium zur besseren Wärmeleitung ausgegossen und mit einem Gaspolster aus Helium versehen, zu einem neuen Brennstab verschweißt. Im Prinzip ist diese Technik so simpel und automatisierter, daß sie in ein (größeres) Kraftwerk integriert werden könnte. Die übrig geblieben Spaltprodukte – etwa 1 kg für jedes 1 MWel produziert über ein ganzes Jahr – kann man “irgendwo” lagern, da sie nach wenigen hundert Jahren auf die Intensität des ursprünglichen Uranerzes abgeklungen sind – also die Gefahr, wieder voll und ganz, natürlich ist.

Sicherheitstechnisch betrachtet, hat sich dieser Reaktortyp als äußerst gutmütig erwiesen. Selbst, wenn man alle Regelstäbe voll gezogen hatte, regelte er sich selbst herunter, da durch den starken Temperaturanstieg die nukleare Kettenreaktion unverzüglich zusammenbricht. Für die Leistungsregelung gibt es Regelstäbe aus Borkarbid (B4C). Zusätzliche Regelstäbe hängen an Magneten. Fällt der Strom aus oder geht der Magnetismus infolge zu hoher Temperaturen verloren, fallen sie in den Reaktor und stellen ihn dauerhaft ab.

Allerdings hat Natrium einen entscheidenden Nachteil: Es reagiert sowohl mit Luft als auch mit Wasser sehr heftig. Deshalb sind der Reaktorkern, die zwei Wärmeübertrager und die vier elektromagnetischen Pumpen (ohne rotierende Teile) alle zusammen in einem mit Natrium gefüllten Topf eingebettet. Dieses Gefäß ist zusammen mit dem Sicherheitsbehälter am Deckel fest verschweißt. Sowohl das Reaktorgefäß, wie auch der Sicherheitsbehälter haben keine Durchbrüche. Die etwa 20 cm Zwischenraum und der Arbeitsraum über dem Deckel sind mit Argon – unter leichtem Überdruck zur Kontrolle auf etwaige Leckagen – befüllt. Da Natrium durch Neutronenbeschuß strahlend wird (Halbwertszeit etwa 1 Minute), wird die Wärme durch die Wärmeübertrager im Reaktorgefäß an einen zweiten Kreislauf mit Natrium übertragen. Dieses Natrium ist nicht radioaktiv und wird ständig überwacht. Das Natrium gelangt durch Rohr in Rohr Leitungen zum überirdischen Dampferzeuger. Der Dampferzeuger ist ein hoher, zylindrischer Behälter, der vollständig mit Natrium gefüllt ist. In diesem Behälter verlaufen schraubenförmige Rohrleitungen, in denen das Wasser zum Antrieb der Turbine verdampft wird. Im Normalbetrieb sorgen zwei elektromagnetische Pumpen für die Umwälzung des Natriums. Zur Abführung der Nachzerfallswärme nach Abschaltung des Reaktors, würde der sich einstellende Naturumlauf ausreichen. Wegen der vorliegenden Temperaturspreizungen (Kerneintritt: 360 °C, Kernaustritt: 499 °C, Dampferzeuger Eintritt: 477 °C, Austritt 326 °C) besteht ein ausreichend großes Sicherheitsgefälle.

Der Reaktor benötigt keinerlei elektrische Energie nach einer Schnellabschaltung. Ein Unglück wie in Fukushima ist daher ausgeschlossen. Die Nachzerfallswärme kann auf drei Wegen abgeführt werden:

1. Über einen Bypass der Turbine, über den normalen Dampfkreislauf des Kraftwerks.

2. Zwischen dem Dampferzeuger und seiner Isolierung befindet sich ein Luftspalt. Ist der Weg 1 nicht möglich (z. B. Bruch einer Dampfleitung), kann über den Naturzug die Wärme an die Umgebung abgegeben werden.

3. Zwischen Sicherheitsbehälter und Betongrube befindet sich ebenfalls ein Luftspalt. Dieser ist mit Abluftkaminen oberhalb der Erde verbunden. Die durch die Nachzerfallswärme des Reaktors aufgeheizte Luft kann in diesen aufsteigen und wird durch nachströmende kühle Umgebungsluft ersetzt (Reactor Vessel Auxiliary Cooling System RVACS).

Anders, als bei Leichtwasserreaktoren, werden die abgebrannten Brennelemente nicht in einem separaten Brennelementelagerbecken gelagert, sondern verbleiben mindestens für einen weiteren Zyklus (Ladezyklus 12 bis 24 Monate, je nach Betriebsweise) im Reaktorbehälter. Dazu entfernt die automatische Lademaschine das gewünschte Brennelement, ersetzt es durch ein neues und stellt das alte zur Zwischenlagerung in das “obere Stockwerk” des Reaktorbehälters. Erst, wenn die Brennelemente zur Wiederaufbereitung sollen, werden sie von der Lademaschine aus dem Reaktor gezogen, gereinigt und übergeben. Sie sind dann bereits soweit abgekühlt, daß sie problemlos “an die Luft können”, da die Brennstäbe aus Stahlrohren gefertigt sind.

Neu, ist die ganze Technik überhaupt nicht. Allein der Experimental Breeder Reactor EBR-II hat 30 Jahre erfolgreich gelaufen. Wenn sich jetzt mancher fragt, warum solche Reaktoren nicht längst gebaut werden, ist die Antwort einfach: Wir haben einfach noch nicht genug von dem, was “Atomkraftgegner” als “Atommüll” bezeichnen! Eine Serienproduktion macht wirtschaftlich nur Sinn, wenn die Stückzahl ausreichend groß ist. Dieser Reaktor braucht zur Inbetriebnahme 11% bis 17% spaltbares Plutonium und kann 18% bis 23% Transurane vertragen. Um 100 Reaktoren erstmalig zu befüllen, benötigt man daher geschätzt 56.000 bis 70.000 Tonnen Schwermetall in der Form abgebrannter Brennelemente aus Leichtwasserreaktoren. Es ist jetzt der richtige Zeitpunkt, mit Planung und Bau eines Prototypen zu beginnen. Diesen kann man gut mit “Bomben-Plutonium” aus der Abrüstung oder bereits vorhandenem Plutonium aus Wiederaufbereitungsanlagen bauen. Die Zeit läuft nicht weg: Natururan ist noch billig und je länger die abgebrannten Brennelemente lagern, um so einfacher lassen sie sich aufbereiten. Geht man von kostenlos erhältlichem “Atommüll” aus – manche meinen ja sogar, man benötige ein Milliarden teueres Endlager für abgebrannte Brennelemente – liegen die kompletten Brennstoffkosten (einschließlich geologischem Lager für die Spaltprodukte) für diesen Reaktortyp weit unter 1/2 Cent pro kWh elektrischer Energie. Spätestens jetzt sollte jedem klar sein, warum man die abgebrannten Brennelemente so sorgfältig in so aufwendigen Behältern verpackt “zwischenlagert”. Sehen so Mülltonnen aus? Die Lagerhalle von Gorleben beispielsweise, ist eher ein Goldschatz.

ALFRED

Das einzige europäische Projekt ist der Advanced Lead Fast Reactor European Demonstrator (ALFRED). Er wird zur Zeit von dem Konsortium aus ENEA und Ansaldo Nuclear aus Italien und der rumänischen ICN verfolgt. Es wird auch Fostering Alfred Construction FALCON genannt. Die über 1 Milliarde Euro Kosten, sollen wesentlich von der EU, aus verschiedenen Töpfen aufgebracht werden. Der Standort soll in Mioveni in der Nähe von Pitesti in Rumänien sein. Baubeginn ist für 2017 und eine Fertigstellung bis 2025 gedacht. Er soll eine Leistung von 125 MWel bei 300 MWth haben. Es ist wohl eine reine Demonstrationsanlage. An eine Serienfertigung ist eher nicht gedacht.

Die Verwendung von Blei als Kühlmittel, ist ein Abfallprodukt der europäischen Entwicklung eines, durch einen Beschleuniger angetriebenen, unterkritischen Reaktors. Zum Betrieb eines “schnellen” Reaktors ist Blei ein eher exotisches Kühlmittel. Alle anderen Nationen verwenden ein Eutektikum aus Blei-Bismut als Kühlmittel. Die längste – und negativste Erfahrung – mit Blei und Blei-Bismut hat Rußland. Dort wurden sie zum Antrieb von Atom-U-Booten der sog. Alpha-Klasse in den 1950er Jahren entwickelt. Wegen ständiger Schäden – bis hin zum Totalverlust – verwendet auch die russische Marine inzwischen Leichtwasserreaktoren.

Als Vorteil von Blei bzw. Blei-Bismut werden immer wieder gerne, folgende Vorteile plakativ in den Vordergrund gestellt:

· Blei reagiert nicht mit Wasser (gemeint ist, im Gegensatz zu Natrium) und es könnten daher die Dampferzeuger angeblich gefahrlos im Reaktorgefäß integriert werden.

· Sehr hohe Siedetemperatur (1745 °C) bei sehr geringem Dampfdruck. Daraus wird ein günstiger Blasenkoeffizient der Reaktivität abgeleitet, der einen angeblichen Sicherheitsvorteil ergibt.

· Blei wäre ein besonders schlechter Moderator und besässe besonders kleine Absorptionsquerschnitte.

Ansonsten fallen einem leider nur Nachteile ein:

· Blei wird überhaupt erst bei 327 °C flüssig. Darum haben die Russen von Anfang an, mit einem Eutektikum aus Blei und Bismut (Schmelzpunkt 124 °C) gearbeitet. Wartungs- und Inspektionsarbeiten bei so hohen Temperaturen sind Neuland. Der Reaktor muß ständig beheizt werden. Es gibt den neuen Störfall “(lokale) Unterkühlung” mit entsprechenden Konsequenzen für das Genehmigungsverfahren.

· Flüssiges Blei ist korrosiv. Die Russen haben dieses Problem nie so richtig in den Griff bekommen. Die Wege über den Sauerstoffgehalt und Beschichtungen waren nicht zielführend – ein überhöhter Verschleiß (Lebensdauer) ist die Folge. Darüber hinaus, ist flüssiges Blei auch noch abtragend. Die Strömungsgeschwindigkeit muß deshalb klein gehalten werden.

· Durch die grosse Masse des Bleis im Reaktor, sind besondere Schutzmaßnahmen gegen Erdbeben notwendig.

· Durch die hohe Dichte des Bleis werden die Regelstäbe von unten eingeschwommen (völlig neues Prinzip, Genehmigungsverfahren) oder von oben pneumatisch eingeschossen (nicht passiv).

· Als Brennstoff sind Uranoxid oder Urannitrid vorgesehen. Wegen der, gegenüber metallischen Brennstoffen schlechten Wärmeleitung, besteht (wieder) die Gefahr der (lokalen) Kernschmelze. Der Effekt einer inhärenten Sicherheit scheint nur schwer nachweisbar. Eine Kühlung über unterkühltes Blasensieden (wie auch in jedem Druckwasserreaktor) scheidet durch den hohen Siedepunkt (der ja immer als Vorteil bezeichnet wird) aus.

· Bisher gibt es bei ALFRED kein echtes Notkühlsystem. Die Nachzerfallswärme müßte immer über die innenliegenden Dampferzeuger abgeführt werden. Der Nachweis, auch nach einer physikalischen Dampfexplosion oder eines abschnittsweisen Verstopfens durch Einfrieren, dürfte sich schwierig gestalten.

Bis ein mit flüssigem Blei gekühlter Reaktor in einem westlichen Land genehmigungsfähig ist, dürften noch Jahrzehnte Forschungs- und Entwicklungsarbeit nötig sein. Insofern dürften sie außerhalb der Konkurrenz mit anderen SMR-Entwürfen stehen. Manchmal fragt man sich wirklich, warum sich manche Kerntechniker immer selbst im Wege stehen müssen. Man könnte fast sagen: Gott schütze uns vor diesen Forschern, mit den “Atomkraftgegnern” werden wir schon selber fertig.

Vorläufiges Ende

Hier ist das vorläufige Ende des Drei-Teilers erreicht. Es wurden die im derzeitigen Rennen um Förderung für SMR vorne liegenden Typen vorgestellt. Was noch fehlt, wären z. B. der Super-Safe, Small and Simple, 4S von Toshiba; die Encapsulated Nuclear Heat Source ENHS; der Flibe Energy Salzbadreaktor; der International Reactor Innovative & Secure IRIS Druckwasserreaktor; der Purdue Novel Modular Reactor PNMR Siedewasserreaktor; der Travelling Wave Reactor TWR; der ANTARES von Areva, der Advanced Reactor Concept ARC–100 und wer weiß noch, welche sonst alle….