Schneller Reaktor BN-800 wird erstmals angefahren

In den kommenden Wochen wird der Reaktorbehälter des BN-800 mit flüssigem Natrium gefüllt; später folgt die Beladung mit Kernbrennstoff. Anschließend wird der Reaktor kritisch; das heißt, er baut eine selbsterhaltende Kettenreaktion auf.

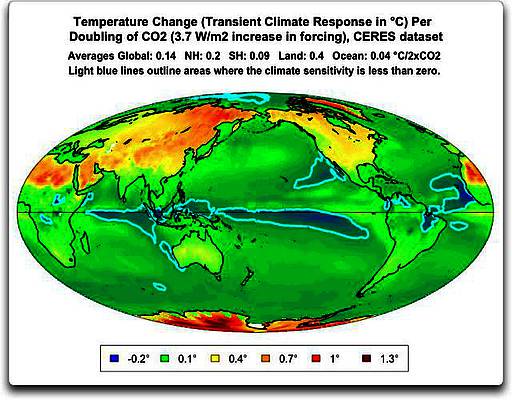

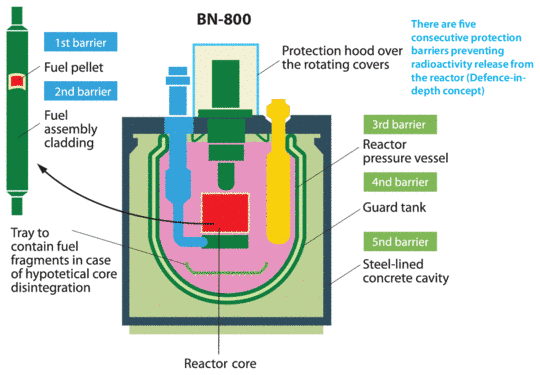

Modell des BN 800 Reaktors

Auch wenn sich dieser Vorgang noch bis Ende 2014 hinziehen dürfte, ist der Betreiber damit seiner Zeit voraus, denn die Brennelementfertigung war ursprünglich erst für 2015 geplant [5].

Plutonium-Brenner

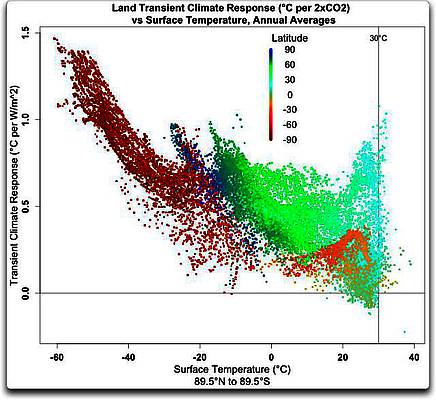

Blick in den Reaktorbehälter des BN-800 (Quelle: Atom Info)

Der BN-800 im KKW Beloyarsk ist als Schneller Brenner ausgeführt. Anders als ein Schneller Brüter verbraucht er mehr Plutonium, als er erzeugt. Dieses Mehr an Plutonium stammt in diesem Fall aus russischen Militärbeständen, ist waffenfähig und wird in Form von MOX-Brennelementen in den BN-800 eingebracht. Der neue Reaktor wird also nicht nur Strom erzeugen, sondern durch die Nutzung des Plutoniums als Brennstoff auch zur nuklearen Abrüstung beitragen. Bis zu drei Tonnen waffenfähiges Plutonium kann der BN-800 pro Jahr auf das Niveau üblicher gebrauchter Brennelemente abbauen.

Gewöhnliche Leichtwasserreaktoren, wie sie in Deutschland und auch fast überall sonst auf der Welt betrieben werden, nutzen weniger als ein Prozent des in der Natur vorkommenden Urans. Der Rest verbleibt zum einen als abgereichtertes Urans, zum anderen in Form gebrauchter Brennelemente. Schnelle Reaktoren wie der BN-800 hingegen verwerten das Uran fast vollständig, brauchen für dieselbe Strommenge nur einen Bruchteil des Brennstoffs und hinterlassen entsprechend weniger Abfall.

Nicht nur das: Schnelle Reaktoren können die hochradioaktiven und langlebigen Abfälle aus Leichtwasserreaktoren nach Wiederaufarbeitung als Brennstoff nutzen. Das ist mit dem BN-800 im Prinzip ebenfalls möglich, auch wenn das nicht geplant ist. Die Anlage soll die technische Funktionstüchtigkeit und die Wirtschaftlichkeit von BN-Reaktoren demonstrieren, und sie bekräftigt den Willen Russlands, die langfristige Kernkraftstrategie des Landes auf Schnelle Reaktoren umzustellen [12].

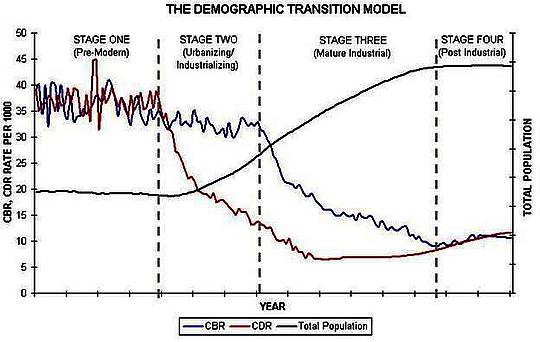

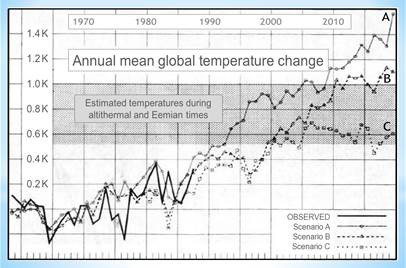

Betrieb bei Normaldruck

Wenn oben das Wort Reaktorbehälter steht und nicht Reaktordruckbehälter, so ist das durchaus korrekt. Anders als bei einem wassergekühlten Reaktor steht der BN-800 nämlich nicht unter Überdruck. Vielmehr ist der Reaktorbehälter im Grunde nichts weiter als ein mit Natrium gefüllter großer Topf, in dem sich außerdem Reaktorkern, Pumpen, Wärmetauscher und so weiter befinden. Das alles steht unter normalem atmosphärischen Druck, was die möglichen Folgen bei Schäden im Primärsystem reduziert. Möglich macht das der Siedepunkt von Natrium, der mit 890 ℃ deutlich über dem von Wasser liegt.

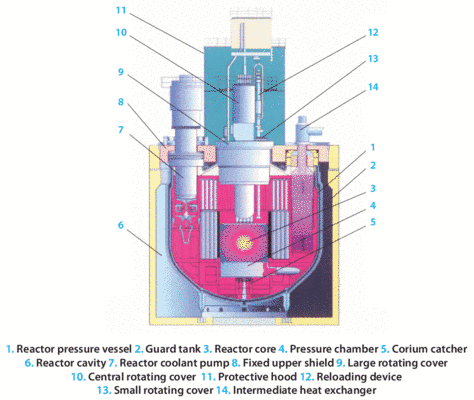

Längsschnitt des BN-800-Reaktorbehälters. Die Bezeichnung “reactor pressure vessel” mag gewohnt sein, ist aber nicht korrekt. (Quelle: [3])

Der Primärkreis befindet sich vollständig im Reaktorbehälter. Das darin enthaltene Natrium wird im Reaktorkern erhitzt und gibt die Wärme über Wärmetauscher an den Sekundärkreis weiter. Dieser enthält ebenfalls Natrium, das zu den Dampferzeugern des Tertiärkreises geleitet wird. Der dort erzeugte Wasserdampf schließlich treibt Turbinen und Generatoren (Turbosatz) an, die den Strom erzeugen.

Hohe Betriebstemperatur bringt hohe Effizienz

Während gängige Leichtwasserreaktoren auf eine Dampftemperatur von maximal etwa 300 ℃ beschränkt sind, erreicht der BN-800 durch die Flüssigmetallkühlung mit 490 ℃ eine weit höhere Temperatur. Diese ermöglicht eine höhere Effizienz des Turbosatzes und verbessert die effektive Brennstoffausbeute weiter. Für die 864 MW elektrischer Leistung des BN-800 ist eine thermische Leistung von vergleichsweise geringen 2.100 MW ausreichend. Bei einem Leichtwasserreaktor wäre für dieselbe elektrische Leistung eine thermische Leistung von etwa 2.900 MW nötig. Die geringere thermische Leistung des BN-800 führt auch zu einer entsprechend geringeren Nachzerfallswärme.

Schematische Übersicht der BN-800-Anlage (Quelle: [3])

Sicherheitsaspekte beim BN-800

Der BN-800 hat durch inzwischen über 30 Jahre Betriebserfahrung mit dem Vorläufermodell BN-600 eine Reihe von Verbesserungen erfahren (siehe [2], S. 3). Inhärente Sicherheit sollen allerdings erst die Nachfolger BN-1200 und BN-1800 bieten. Im folgenden stellen wir einige Sicherheitseigenschaften des BN-800 vor.

PROLIFERATION

Der Brennstoff des BN-800 besteht zu großen Teilen aus waffenfähigem Plutonium, welches relativ leicht chemisch abgetrennt werden könnte. Ein einziges frisches Brennelement enthält bis zu gut 5 kg Plutonium und damit bereits theoretisch genug, um eine Kernwaffe zu bauen. Das ist allerdings nicht unmittelbar ein Problem des BN-800, denn das Plutonium ist ja ohnehin bereits vorhanden. Der BN-800 wurde vielmehr explizit dazu gebaut, die Menge zu reduzieren.

PRIMÄRLECKAGEN

Mehr oder weniger große Leckagen im Primärsystem können theoretisch durch interne Ereignisse oder externe Einwirkungen auftreten, für die ein Kernreaktor natürlich ausgelegt sein muss. Interne Ereignisse sind beispielsweise ein länger andauernder Ausfall der Kühlung, etwa durch einen vollständigen Stromausfall (Station Blackout). Das kann durch eine fehlende Nachwärmeabfuhr zu einer Überhitzung des Primärkreises mit oder ohne Kernschmelze führen. Externe Einwirkungen sind beispielsweise Erdbeben, Flugzeugabstürze, Wetterextreme oder Terrorangriffe. Unter welchen Bedingungen und in welchem Umfang solche Leckagen auftreten können und wie gut die damit einhergehenden Probleme beherrscht werden, hängt vom Anlagendesign ab.

Brüche in Rohren, Pumpen oder anderen Komponenten des Primärkreises führen zu keinem Kühlmittelverlust, da der Primärkreis des BN-800 ja wie erwähnt vollständig im Reaktorbehälter steckt. Dieser ist zudem von einem Sicherheitsbehälter (Containment) umgeben, der wiederum von einem Stahlbetonmantel eingeschlossen ist. Solange nicht auch das Containment beschädigt wird, ist ein Primärleck kein auslegungsüberschreitender Störfall.

NATRIUMBRÄNDE

Die meisten Menschen haben bei natriumgekühlten Reaktoren Bedenken wegen der Verwendung von Natrium als Kühlmittel. Man kennt das aus dem Chemieunterricht: Natrium beginnt bei Kontakt mit Sauerstoff oder Wasser zu brennen. Damit dies nicht geschieht, trennt Argon das Natrium im Primärkreis vom Sauerstoff in der Luft. Argon ist ein Edelgas, das nicht mit Natrium reagiert. Wasser ist im Primärkreis oder in dessen Nähe ohnehin nicht vorhanden.

Im Sekundärkreis ist die Wahrscheinlichkeit für einen Natriumbrand höher, da das Natrium in den Dampferzeugern seine Wärme an das zu erhitzende Wasser im Tertiärkreis abgibt. Daher gibt es in den Dampferzeugern Sicherheitssysteme, die im Fall eines Kontakts zwischen Natrium und Wasser die betroffene Komponente abschotten. Das Natrium des Sekundärkreises ist nicht radioaktiv, was Gegenmaßnahmen und Reparatur vereinfacht. Ein sekundäres Natriumleck kann zu keinem schweren Unfall führen, da die drei Sekundärkreisläufe komplett unabhängig voneinander und redundant ausgeführt sind. Übrigens ist der Druck im Sekundärkreis leicht höher als der im Primärkreis, um bei Undichtigkeiten den Übertritt radioaktiven Natriums aus dem Primärkreis in den Sekundärkreis zu verhindern.

Natriumbrände, insbesondere solche im nicht radioaktiven Sekundärkreis, werden in der Regel überschätzt. Beim BN-600 traten in den ersten Betriebsjahren über zwei Dutzend Natriumbrände auf, von denen keiner zu einer Katastrophe führte. Alle Schäden ließen sich reparieren und der Reaktor wieder in Betrieb nehmen. Seit 20 Jahren läuft der BN-600 ohne weiteren Natriumbrand.

Gestaffelte Sicherheitsebenen des BN-800 gegen radioaktive Freisetzungen (Quelle: [3])

KERNSCHMELZE

Im Gegensatz zu Leichtwasserreaktoren haben natriumgekühlte Schnelle Reaktoren (Sodium-Cooled Fast Reactor, SFR) prinzipiell keinen negativen oder sogar einen leicht positiven Void-Koeffizienten. Sollte das Natrium sieden und es zur Dampfblasenbildung kommen, würde das die Reaktivität erhöhen und dadurch die Kerntemperatur weiter ansteigen. Auch ein Schmelzen der Brennelementhüllrohre kann die Reaktivität erhöhen. Bei einem Störfall mit prompter Überkritikalität durch einen Steuerungsfehler bricht die Reaktivität erst zusammen, wenn die Kernstruktur etwa durch eine Teilkernschmelze zerstört oder verändert wird. Im Gegensatz zu Leichtwasserreaktoren sind SFR daher gegenüber solchen Transientenstörfällen nicht ohne weitere Maßnamen inhärent sicher. Die schlechte Nachricht: Eine (Teil) Kernschmelze ist wahrscheinlicher als beim Leichtwasserreaktor.

Es gibt aber auch eine gute Nachricht: Durch den hohen Siedepunkt des Natriums kommt es bei einer Kernschmelze nicht zwangsläufig zu einem Kühlmittelverlust. Die Kühlung kann aufrechterhalten werden, und damit läuft die Kernschmelze völlig anders ab und ist besser beherrschbar als in einem Leichtwasserreaktor.

Das Unfallszenario Kernschmelze ist beim BN-800 nicht auslegungsüberschreitend, also kein schwerer Unfall. [7] geht sehr genau auf mögliche Transientenstörfälle und Temperaturkoeffizenten beim BN-800 ein. Es gab bereits mehrere Kernschmelzen oder Teilkernschmelzen in SFR, auch eine Teilkernschmelze (Hüllrohrschäden) im Vorgängerreaktor BN-600. Allerdings wurden bei keiner davon jemals größere Mengen an Radioaktivität freigesetzt. Und nicht nur das: Die Reaktoren konnten sogar repariert und wieder in Betrieb genommen werden. Bei natriumgekühlten Reaktoren verliert das Wort Kernschmelze seinen Schrecken.

Um eine Rekritikalität des geschmolzenen Kernbrennstoffs (Corium) und ein Durchschmelzen des Reaktorbehälters zu verhindern, besitzt der BN-800 einen Core Catcher. Dieser Kernfänger macht das Szenario eines schweren Unfalls praktisch unmöglich.

AUSFALL DER HAUPTWÄRMESENKE

Ein weiteres Störfallszenario ist ähnlich wie bei Leichtwasserreaktoren der Ausfall der Hauptwärmesenke. Der Primärkreis kann dadurch prinzipiell nach einiger Zeit überhitzen, was zu einem Versagen des Reaktorbehälters und damit zu einem Primärleck führen kann. Um das zu verhindern, kann die Nachzerfallswärme des BN-800 über den sekundären Natriumkreis mittels Radiatoren direkt an die Luft abgegeben werden. Beim BN-600 wurde ein solches System erst nachträglich eingebaut. Dies ist jedoch ein aktives System, das die Verfügbarkeit elektrischer Energie und das Funktionieren wenigstens einer der drei sekundären Kühlmittelpumpen voraussetzt. Erst für den BN-1200 ist eine direkte, passive Luftkühlung des Primärkreises vorgesehen, die auch ohne Strom funktioniert. Die sekundären Natriumpumpen sind dann zur Notkühlung nicht mehr zwingend erforderlich.

Zum »Ausgleich« ist der Reaktorbehälter des BN-800 in Relation zur Leistung größer als beim BN-1200, hat eine höhere Wärmekapazität und kann daher im Notfall mehr Wärme aufnehmen. Laut [3] beträgt der Temperaturanstieg durch die Nachzerfallswärme 30 ℃ pro Stunde. Dies sei genügend Zeit, um Gegenmaßnahmen einzuleiten, etwa Anlieferung und Einsatz mobiler Notstromgeneratoren. Die Notstromversorgung befindet sich auf dem Stand der Technik, wurde nach dem Unfall in Fukushima-Daiichi nochmals überarbeitet und macht das Szenario eines kompletten, über mehrere Stunden andauernden Stromausfalls sehr unwahrscheinlich.

EINWIRKUNGEN VON AUSSEN

Der Reaktorbehälter und der Sicherheitsbehälter befinden sich in einer Reaktorgrube aus Stahlbeton, die auch einen Stahlbetondeckel besitzt. Die sicherheitsrelevanten Komponenten sind dadurch gegen verschiedene äußere Einwirkungen geschützt (siehe [3], S. 16 – 17):

♦ Erdbeben mit Horizontalbeschleunigungen bis zum 0,1fachen der Erdbeschleunigung

♦ Druckwelle einer Explosion bis zu einem Druck von 10 kPa

♦ Winddruck von bis zu 44 m/s in einer Höhe von 10 m

♦ Schneelast von 0,2 kPa

♦ Absturz eines kleineren Passagierflugzeugs von 5,7 t bei einer Absturzgeschwindigkeit von 360 km/h

Radioaktive Freisetzungen

Die radiologischen Freisetzungen beim Normalbetrieb des BN-800 lassen sich anhand der Erfahrungen mit älteren BN-Reaktoren wie dem BN-600 oder dem BN-350 nach oben abschätzen. Beim BN-800 liegen sie aufgrund von Verbesserungen jedenfalls unter diesen Werten. Konkret bedeutet dies eine Exposition von durchweg 0,0002 Millisievert (mSv) pro Jahr in 3 km Abstand vom Kraftwerk [3]. Selbst bei Störfällen bleiben die zeitweise erhöhten Freisetzungen unterhalb von 0,1 mSv pro Jahr. Zum Vergleich: Die deutsche Strahlenschutzverordnung erlaubt für die allgemeine Bevölkerung eine Exposition von 1 mSv pro Jahr; für beruflich strahlenexponierte Personen sind es 20 mSv pro Jahr.

Bei Unfällen, die die Auslegung des Reaktors nicht überschreiten, liegt die Strahlungsexposition in 3 km Abstand laut [3] ebenfalls unterhalb von 0,1 mSv pro Jahr.

Auslegungsüberschreitende Unfälle können eine Exposition von maximal 23 mSv pro Jahr hervorrufen. Da der Grenzwert für eine Evakuierung der Bevölkerung außerhalb der 3-km-Zone bei 500 mSv pro Jahr liegt, kommt [3] zu dem Schluss, dass kein Evakuierungsplan erforderlich sei.

Fazit

Insgesamt ist der BN-800 zweifellos eine gut durchdachte und sichere Anlage, auch wenn der Schutz gegen Flugzeugabstürze besser sein könnte. Der Nachfolger des BN-800, der BN-1200, wird weitere Verbesserungen des Sicherheitsniveaus bringen.

Quellen

[1] Начался физпуск БН-800! (First criticality of the BN-800 started!), Rosatom, 2013-12-25, https://www.facebook.com/photo.php?fbid=679673262073497&set=a.235888116452016.61246.233828576657970&type=1

[2] Новый энергоблок БН-800 Белоярской АЭС выйдет на полную мощность к концу 2014 года (New Beloyarsk BN-800 reaches full capacity by the end of 2014), Rosatom, 2013-12-25,http://www.rosatom.ru/journalist/announces/e826d7804250c6d887c6f722a8040f57

[3] BN-800 NPP, Joint Stock Company St. Petersburg Research and Design Institute ATOMENERGOPROEKT (JSC SPbAEP), 2011,http://www.spbaep.ru/wps/wcm/connect/spb_aep/site/resources/6d77898047832831a7a9ef9e1277e356/BN-800_2011_EN_site.pdf

[4] Beloyarsk 4 (BN-800) im Power Reactor Information System (PRIS) der IAEA,http://www.iaea.org/PRIS/CountryStatistics/ReactorDetails.aspx?current=451

[5] »Auch Benzin ist brennbar«, Interview mit Sergey Boyarkin, 2013-08-28,http://www.heise.de/tr/artikel/Auch-Benzin-ist-brennbar-1941081.html

[6] BN-1200, Advanced Reactor Information System (ARIS), IAEA,https://aris.iaea.org/PDF/BN-1200.pdf

[7] Transient and accident analysis of a BN-800 type LMFR with near zero void effect – Final report on an international benchmark programme supported by the International Atomic Energy Agency and the European Commission 1994-1998, http://www-pub.iaea.org/MTCD/publications/PDF/te_1139_prn.pdf

[8] Core Design and Fuel Cycle of Advanced Fast Reactor With Sodium Coolant, V.M. Poplavsky, A.M. Tsiboulia, Yu.S. Khomyakov, V.I. Matveev, V.A. Eliseev, A.G. Tsikunov (SSC RF − IPPE, Russia), B.A. Vasiliev, S.B. Belov, M.R. Farakshin (OKBM, Russia),

International Conference on Fast Reactors and Related Fuel Cycles (FR09) – Challenges and Opportunities, December 7 – 11, 2009, Kyoto, Japan, http://www-pub.iaea.org/mtcd/meetings/PDFplus/2009/cn176/cn176_Presentations/parallel_session_1.1/01-05.Khomyakov.pdf

[9] Overview of SFR in Russia, Second Joint GIF – IAEA/INPRO Workshop on Safety Aspects of Sodium-Cooled Fast Reactors, 30 November – 1 December 2011,http://www.iaea.org/INPRO/cooperation/Second_IAEA-GIF_WS_on_SFRs/presentations/T1-Russia.pdf

[10] Sodium-Cooled Fast Reactors: Current Status and Proposals for the Second Workshop, Y.М. Аshurko, State Scientific Center of the Russian Federation – Institute for Physics and Power Engineering (SSC RF – IPPE), Оbninsk, Russian Federation, 5th GIF/INPRO Interface Meeting, IAEA HQs, Vienna, Austria, 3 – 4 March 2011,http://www.iaea.org/INPRO/cooperation/5th_GIF_Meeting/RF.pdf

[11] Fuels for advanced sodium cooled fast reactors in Russia: state –of-art and prospects, L. M. Zabudko, V.M. Poplavsky, I.A. Shkaboura, M.V. Skupov, F.V. Bychkov, V.A. Kisly, F.N. Kryukov, B.A. Vasiliev, International Conference on Fast Reactors and Related Fuel Cycles (FR09), 7-11 December 2009, Kyoto, Japan, http://www-pub.iaea.org/mtcd/meetings/PDFplus/2009/cn176/cn176_Presentations/plenary_session_5/INV-02.Zabudko.pdf

[12] Russia speeds up nuclear investment, World Nuclear News, 2012-11-22,http://www.world-nuclear-news.org/NP_Russia_speeds_up_nuclear_investment_2211121.html

[13] Neue russische Kernreaktoren sollen Atommüll vernichten, Nuklearia, 2013-11-23,http://nuklearia.de/2013/11/23/neue-russische-kernreaktoren-sollen-atommuell-vernichten/

[14] Beloyarsk 4 criticality soon, World Nuclear News, 2013-12-30, http://www.world-nuclear-news.org/NN-Beloyarsk-4-criticality-soon-3012131.html

[15] Development of physical conceptions of fast reactors, Y.S. Khomyakov, V.I. Matveev, A.V. Moiseev, International Conference on Fast Reactors and Related Fuel Cycles: Safe Technologies and Sustainable Scenarios (FR13), Paris, France, 4 – 7 March 2013,http://www.iaea.org/NuclearPower/Downloadable/Meetings/2013/2013-03-04-03-07-CF-NPTD/T1.1/T1.1khomiakov.pdf

Dieser Eintrag wurde zuerst veröffentlicht in Nuklearia und wurde dort von BN-800, Reaktortypen, Schneller Reaktor übernommen