[*Der Origina-Titel ist ein Wortspiel: Cause of the Pause…]

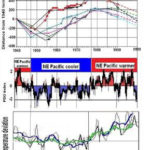

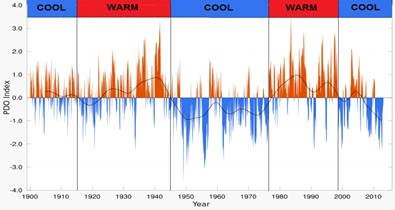

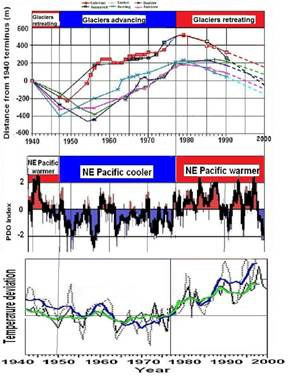

Abbildung 1: Korrelation der Gletscher-Veränderungen am Mount Baker mit der Pazifischen Dekadischen Oszillation PDO und dem globalen Klima. (Easterbrook 2001, 2011)

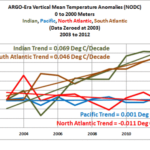

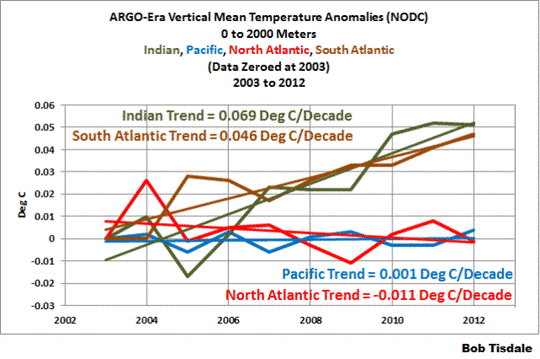

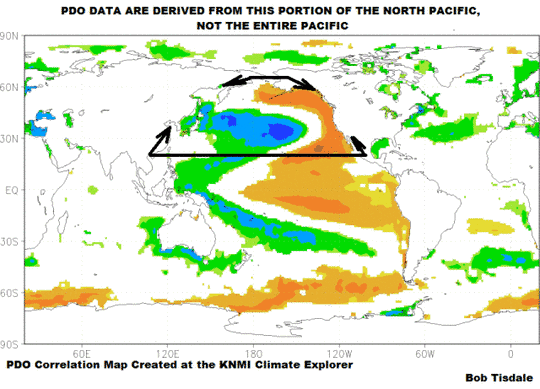

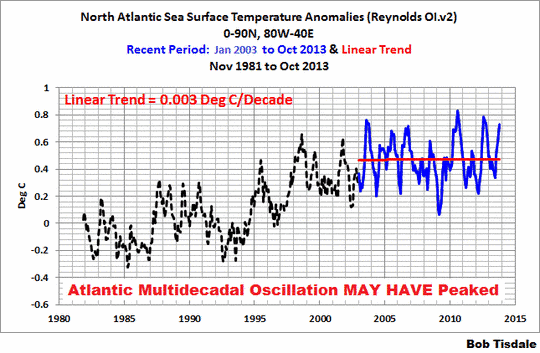

Der vielleicht einfachste Weg, den Kausalzusammenhang zwischen globaler Erwärmung/Abkühlung einerseits sowie PDO und AMO andererseits zu verstehen, besteht darin zu rekapitulieren, wie diese Korrelationen entdeckt worden sind. Im Jahre 1999, als ich jüngste glaziale Fluktuationen am Mount Baker in der North Cascade Range untersuchte, zeichnete sich deutlich eine wiederkehrende Folge von Vorstößen und Rückzügen ab. Eines nachts fiel mir eine Studie von Mantua et al. (1997) in die Hände mit dem Titel A Pacific interdecadal climate oscillation with impacts on salmon production [etwa: Eine pazifische interdekadische Klima-Oszillation mit Einflüssen auf die Lachszucht]. Das war eine frühe Erkenntnis der Existenz der PDO. Die PDO ist ein Index, kein gemessener Wert und basiert auf etwa einem Dutzend Parameter, die in Beziehung stehen zu zyklischen Variationen der Wassertemperaturen im Nordost-Pazifik. Der Begriff „Pacific Decadal Oscillation“ (PDO) war von Steven Hare (1996) in den Ring geworfen worden. Sie hat zwei Zustände, warm und kalt, und schwingt zwischen diesen beiden Zuständen etwa alle 25 bis 30 Jahre hin und her.

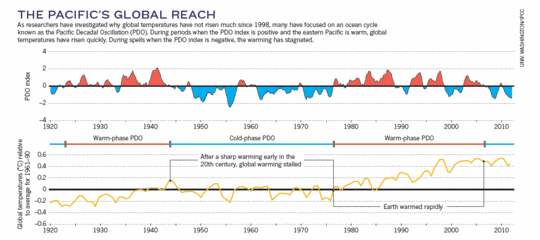

Die Kurve von Mantua et al. ähnelte meiner Gletscherkurve so stark, dass ich beide überlagerte. Zu meiner Überraschung korrespondierten sie nahezu exakt. Danach verglich ich beide mit der globalen Temperatur, und alle drei zeigten diese bemerkenswerte Korrelation (Abbildung 1)

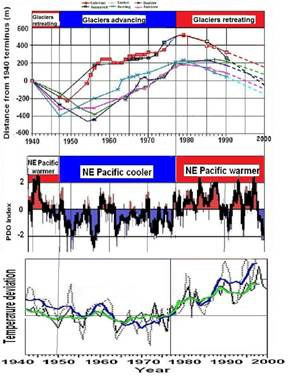

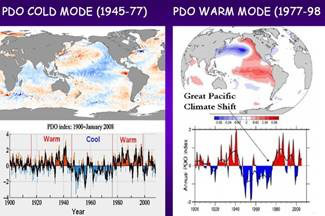

Die Bedeutung dieser Korrelation liegt darin, dass sich klar zeigt, dass die PDO der Treiber klimatischer und glazialer Fluktuationen am Mount Baker ist. Jedes Mal, wenn der Zustand der PDO von einem Zustand in den anderen wechselte, veränderte sich auch das Verhalten des globalen Klimas und des Gletschers. Diese Entdeckung war schon für sich allein bedeutsam, aber sie führte noch zu zahlreichen weiteren Entdeckungen. An diesem Punkt war aber bereits klar, dass die PDO das globale Klima beeinflusst hat (Abbildungen 2 und 3), aber was die PDO beeinflusst hat, war längst nicht so klar.

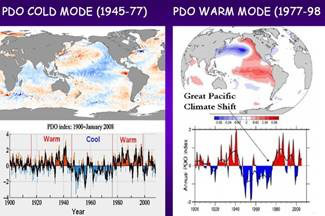

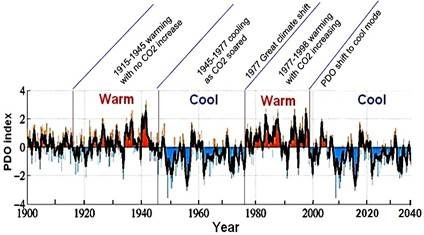

Abbildung 2: PDO-Kaltphase 1945 bis 1977 und Warmphase 1977 bis 1998 (Easterbrook 2011 aus D’Aleo)

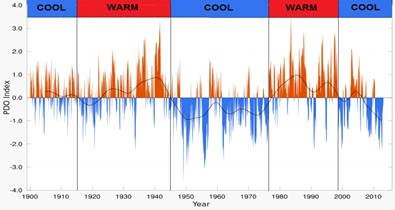

Abbildung 3: PDO-Fluktuationen von 1900 bis August 2012. In jeder Warmphase der PDO erwärmte sich das globale Klima; in jeder Kaltphase kühlte es sich ab (modifiziert aus http://jisao.washington.edu/pdo/)

Im Jahr 2000 habe ich eine Studie vorgelegt mit dem Titel „Cyclical oscillations of Mt. Baker glaciers in response to climatic changes and their correlation with periodic oceanographic changes in the Northeast Pacific Ocean” [etwa: Zyklische Oszillationen der Gletscher am Mt. Baker als Folge von Klimaänderungen und ihre Korrelation mit periodischen ozeanographischen Änderungen im Nordostpazifik], und zwar beim Jahrestreffen der Geological Society of America (GSA). Auf dem Treffen im Folgejahr habe ich eine weitere Studie vorgestellt mit dem Titel: „The next 25 years: global warming or global cooling? Geologic and oceanographic evidence for cyclical climatic oscillations” [etwa: Die nächsten 25 Jahre: Globale Erwärmung oder globale Abkühlung? Geologische und ozeanographische Beweise für zyklische klimatische Oszillationen].

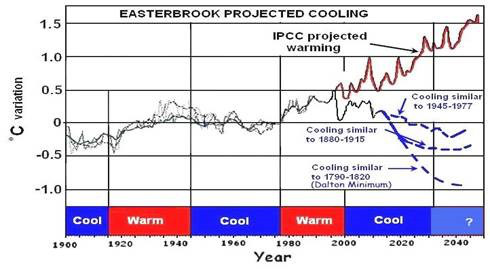

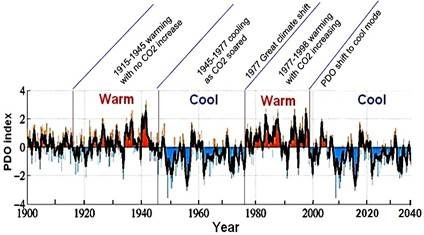

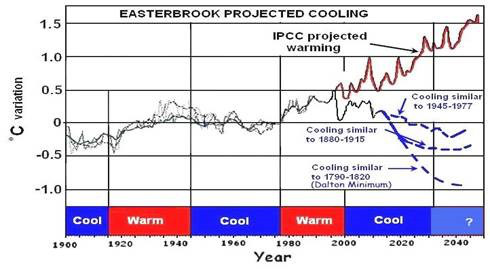

Da diese wiederkehrenden Vorgänge der PDO-Fluktuationen und des globalen Klimas während des gesamten vorigen Jahrhunderts zu beobachten waren, was könnte dann die Zukunft bereithalten? Falls sich diese Abfolge fortsetzt, können wir die gleiche Abfolge in die Zukunft projizieren und erkennen, wohin die Reise geht, d. h. die Vergangenheit ist der Schlüssel für die Zukunft. Falls wir wissen wollen, wohin die Reise geht, müssen wir wissen, wo wir schon waren. Jede der beiden Warmphasen (1915 bis 1945, 1978 bis 1998) und der drei Kaltphasen (1880 bis 1915, 1945 bis 1977, 1999 bis 2014) dauerte 20 bis 30 Jahre. Falls der Übergang in die Kaltphase im Jahre 1999 anhält, sollte sich das Klima während der nächsten Jahrzehnte abkühlen. Unter Verweis auf die Länge vergangener PDO-Phasen habe ich die Kaltphase zum Ende der Kurve aufgesplittet (ähnlich der Kaltphase von 1945 bis 1977) und dies in einer Studie auf einem GSA-Treffen 2001 in Boston gezeigt. In dieser Studie habe ich eine zu erwartende Abkühlung während der nächsten 25 bis 30 Jahre skizziert, basierend auf dem Zusammenhang schwingender PDO-Phasen der Vergangenheit und dem globalen Klima (Abbildung 4). Die Erinnerung an das zweitwärmste Jahr des vorigen Jahrhunderts 1998 war noch frisch, und vor diesem Hintergrund war das Auditorium wegen dieser Vorhersage perplex, vor allem, da diese Ergebnisse den IPCC-Vorhersagen einer katastrophalen globalen Erwärmung diametral widersprechen.

Abbildung 4 (oben): PDO-Fluktuationen und Projektion bis 2040, basierend auf dem Verhalten der PDO in der Vergangenheit.

(unten): Projizierte globale Abkühlung während der nächsten Jahrzehnte, basierend auf einer Extrapolation des PDO-Verhaltens.

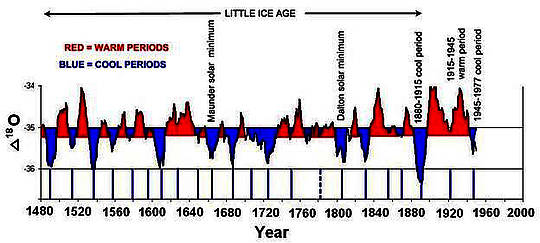

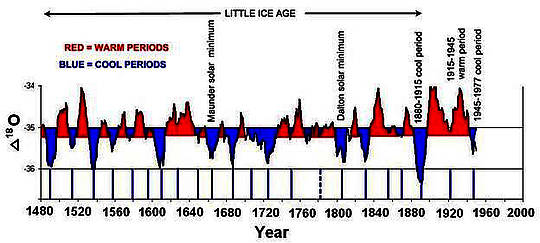

Meine erste Projektion einer zukünftigen globalen Abkühlung basierte auf der Fortsetzung von PDO-Fluktuationen während des vorigen Jahrhunderts. Aber was ist mit früheren Klimaänderungen? Weil der GISP2-Eisbohrkern aus Grönland eine solch akkurate Chronologie aus jährlichen Schichtablagerungen aufwies, schien es eine perfekte Gelegenheit zu sein zu erkennen, ob es ähnliche Änderungen auch schon in früheren Jahrhunderten gegeben hatte. Darum habe ich Messungen der Sauerstoff-Isotope durch Stuiver und Grootes (1997) für die letzten 450 Jahre geplottet. Das Verhältnis von Sauerstoff-Isotopen ist eine Funktion der Temperatur, so dass dieser Plot eine Paläoklima-Temperaturkurve ergibt. Das war ein echter Augenöffner, weil die Kurve (Abbildung 4) etwa 40 regelmäßig verteilte Warm-/Kaltphasen mit einer mittleren Zykluslänge von 27 Jahren zeigte, sehr ähnlich dem ODO-Zyklus. Es gibt keine Möglichkeit, das Verhalten der PDO so weit zurück zu verfolgen, aber die Warm-/Kaltzyklen im GISP2 waren so konsistent, dass die Korrelation mit den PDO-Zyklen eine gute Annäherung zu sein schienen. Historisch bekannte Warm-/Kaltphasen tauchten im GISP2 auf, d. h. die Kaltphase 1945 bis 1977, die Warmphase 1915 bis 1945, die Kaltphase 1880 bis 1915, die Kleine Eiszeit, die Abkühlungen jeweils des Dalton-Minimums und des Maunder-Minimums und viele andere, was der Validität der GISP2-Messungen Glaubwürdigkeit verleiht.

Abbildung 5: Warm- und Kaltphasen seit 1480 aus Sauerstoff-Isotopen des GISP2-Eisbohrkerns aus Grönland. Die mittlere Länge einer Warm- bzw. Kaltphase beträgt 27 Jahre.

Als ich diese Erkenntnisse und meine Klimaprojektionen auf dem GSA-Treffen des Jahres 2006 in Philadelphia zeigte, saß auch Bill Broad von der New York Times im Auditorium. Er schrieb ein Feature in dieser Zeitung mit meinen Daten und Vorhersagen, und die Nachrichtenmedien schnappten über. Alle großen Nachrichtenagenturen fragten nach Interviews, aber dann geschah etwas Merkwürdiges: komischerweise haben alle außer CNN, MSNBC und Fox News diese Interviews abrupt abgesagt, offensichtlich weil meine Erkenntnisse eine Bedrohung für die IPCC-Projektionen einer katastrophalen globalen Erwärmung darstellten.

Neun zusätzliche Studien, die die geologischen Beweise für eine globale Abkühlung stützen, wurden von 2007 bis 2009 präsentiert, ebenso verschiedene längere Studien von 2011 bis 2014 einschließlich:

“Multidecadal tendencies in Enso and global temperatures related to multidecadal oscillations,” Energy & Environment, vol. 21, p. 436-460. (D’Aleo, J. and Easterbrook, D.J., 2010).

“Geologic Evidence of Recurring Climate Cycles and Their Implications for the Cause of Global Climate Changes: The Past is the Key to the Future,” in the Elsevier volume “Evidence-Based Climate Science; p. 3-51. (2011)

“Relationship of Multidecadal Global Temperatures to Multidecadal Oceanic Oscillations,” in the Elsevier volume “Evidence-Based Climate Science; p. 161-180. (D’Aleo, J. and Easterbrook, D.J., 2011)

“Observations: The Cryosphere,” in Climate Change Reconsidered II, Physical Science (Easterbrook, D.J., Ollier, C.D., and Carter, R.M., 2013), p. 645-728.

Nachdrucke all dieser Veröffentlichungen können hier abgerufen werden oder durch eine E-Mail an dbunny@yahoo.com.

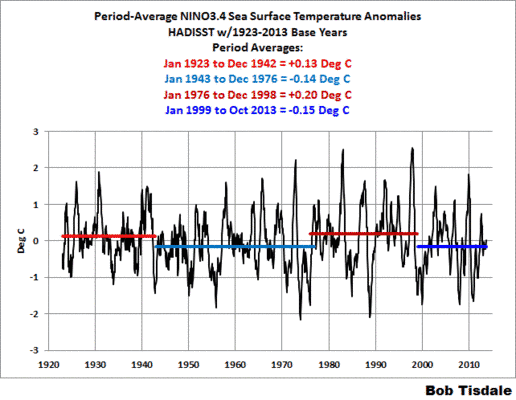

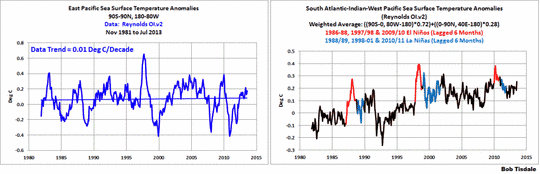

Während dieser Jahre hat Joe D’Aleo wichtige Beiträge geschrieben, zeigte er doch, dass während der Warmphasen warme El Nino-Ereignisse häufiger und intensiver auftraten als kühlere La-Nina-Ereignisse – und umgekehrt. Er dokumentierte auch die Rolle der Atlantischen Multidekadischen Oszillation AMO, die sich ähnlich verhält wie die PDO. Die AMO hat multidekadische Warm- und Kaltphasen mit Perioden von etwa 30 Jahren, genau wie die PDO.

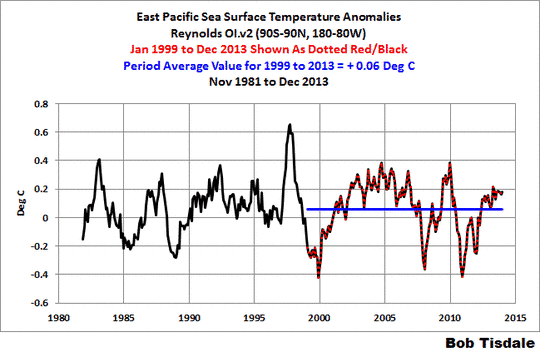

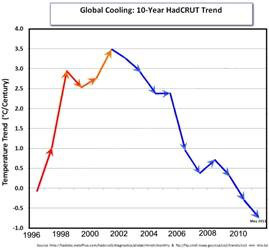

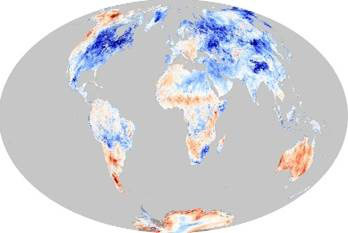

Also stellt sich jetzt die Frage, wie meine Vorhersagen validiert werden können. Mit Sicherheit nicht durch irgendwelche Computer-Modelle, die sich als im Wesentlichen wertlos herausgestellt haben. Die auf der Hand liegende Antwort lautet, meine Vorhersagen mit dem Verhalten des Klimas über mehrere Jahrzehnte zu vergleichen. Wir befinden uns seit mehr als einem Jahrzehnt in dem von mir vorhergesagten Abkühlungszyklus, und was geschah? Es gab inzwischen 17 Jahre ohne globale Erwärmung (tatsächlich gab es eine leichte Abkühlung), und zwar trotz der IPCC-Vorhersage, dass es jetzt ~1°F wärmer sein sollte (Abbildungen 6, 7 und 8). Bislang scheint meine Vorhersage aus dem Jahr 1999 richtig zu liegen, was noch etwa 25 bis 30 weitere Jahre der Fall sein sollte.

Schlussfolgerungen

Der ‚mysteriöse Stillstand’ bei der globalen Erwärmung ist alles andere als mysteriös. Es handelt sich dabei einfach um die Fortsetzung klimatischer Zyklen, zu denen es schon seit Hunderten von Jahren gekommen war. Der Stillstand war bereits 1999 vorhergesagt worden, und zwar auf der Grundlage wiederholter Warm- und Kaltphasen der PDO. Er ist also weder mysteriös noch überraschend. Das Fehlen einer globalen Erwärmung seit 17 Jahren entspricht genau der Vorhersage. Eine fortgesetzte Abkühlung während der nächsten paar Jahrzehnte wird diese Vorhersage fundamental stützen. Zeit und Natur werden die endgültigen Richter dieser Vorhersagen sein.

Die Antriebe dieser ozeanischen bzw. klimatischen Zyklen bleiben nicht eindeutig. Korrelationen mit verschiedenen solaren Parametern scheinen ziemlich gut zu sein, aber der kausale Zusammenhang bleibt unklar. Mehr dazu später.

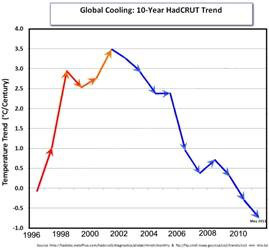

Abbildung 6: Temperaturtrend (°C pro Jahrhundert) seit 1996. Rot = Erwärmung, blau = Abkühlung

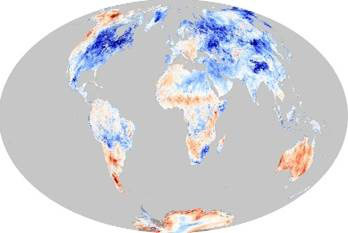

Abbildung 7: globale Abkühlung seit dem Jahr 2000 (Earth Observatory)

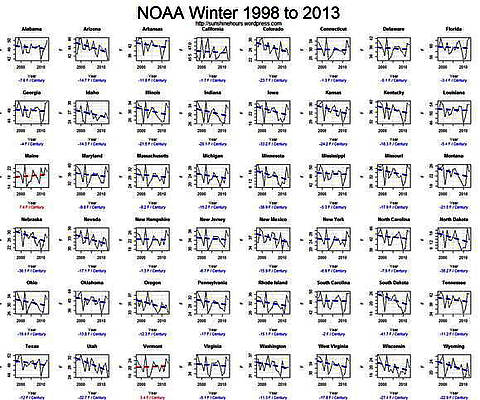

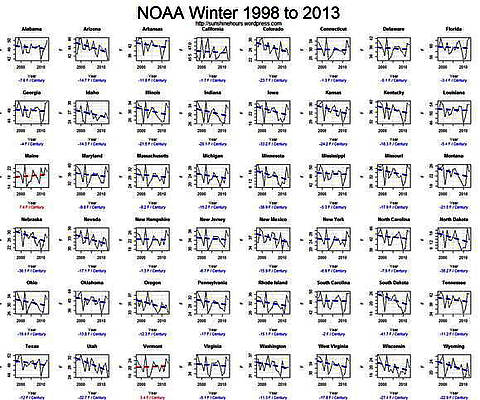

Abbildung 8: Wintertemperaturen in den USA von 1998 bis 2013. In 46 der 48 Staaten ist es signifikant kälter geworden.

REFERENCES

D’Aleo, J. and Easterbrook, D.J., 2010, Multidecadal tendencies in Enso and global temperatures related to multidecadal oscillations: Energy & Environment, vol. 21, p. 436-460.

Easterbrook, D.J. and Kovanen, D.J., 2000, Cyclical oscillations of Mt. Baker glaciers in response to climatic changes and their correlation with periodic oceanographic changes in the Northeast Pacific Ocean: Abstracts with Programs, Geological Society of America, vol. 32, p.17.

Easterbrook, D.J., 2001, The next 25 years: global warming or global cooling? Geologic and oceanographic evidence for cyclical climatic oscillations: Geological Society of America, Abstracts with Program, vol. 33, p. 253.

Easterbrook, D.J., 2005, Causes and effects of abrupt, global, climate changes and global warming: Geological Society of America, Abstracts with Program, vol. 37, p. 41.

Easterbrook, D.J., 2006a, Causes of abrupt global climate changes and global warming predictions for the coming century: Geological Society of America, Abstracts with Program, vol. 38, p. 77.

Easterbrook, D.J., 2006b, The cause of global warming and predictions for the coming century: Geological Society of America, Abstracts with Program, vol. 38, p.235-236.

Easterbrook, D.J., 2007a, Geologic evidence of recurring climate cycles and their implications for the cause of global warming and climate changes in the coming century: Geological Society of America Abstracts with Programs, vol. 39, p. 507.

Easterbrook, D.J., 2007b, Late Pleistocene and Holocene glacial fluctuations: Implications for the cause of abrupt global climate changes: Abstracts with Programs, Geological Society of America, vol. 39, p. 594.

Easterbrook, D.J., 2007c, Historic Mt. Baker glacier fluctuations—geologic evidence of the cause of global warming: Abstracts with Program, Geological Society of America, vol. 39, p.13.

Easterbrook, D.J., 2008a, Solar influence on recurring global, decadal, climate cycles recorded by glacial fluctuations, ice cores, sea surface temperatures, and historic measurements over the past millennium: Abstracts of American Geophysical Union annual meeting, San Francisco.

Easterbrook, D.J., 2008b, Implications of glacial fluctuations, PDO, NAO, and sun spot cycles for global climate in the coming decades: Geological Society of America, Abstracts with Programs, vol. 40, p.428.

Easterbrook, D.J., 2008c, Global warming’ is over: Geologic, oceanographic, and solar evidence for global cooling in the coming decades: 3rd International Conference on Climate Change, Heartland Institute, New York.

Easterbrook, D.J., 2008d, Correlation of climatic and solar variations over the past 500 years and predicting global climate changes from recurring climate cycles: Abstracts of 33rd International Geological Congress, Oslo, Norway.

Easterbrook, D.J., 2009a, The role of the oceans and the sun in late Pleistocene and historic glacial and climatic fluctuations: Abstracts with Programs, Geological Society of America, vol. 41, p. 33.

Easterbrook, D.J., 2009b, The looming threat of global cooling – Geological evidence for prolonged cooling ahead and its impacts: 4th International Conference on Climate Change, Heartland Institute, Chicago, IL.

Easterbrook, D.J., ed., 2011a, Evidence-based climate science: Data opposing CO2 emissions as the primary source of global warming: Elsevier Inc., 416 p.

Easterbrook, D.J., 2011b, Geologic evidence of recurring climate cycles and their implications for the cause of global climate changes: The Past is the Key to the Future: in Evidence-Based Climate Science, Elsevier Inc., p.3-51.

Easterbrook, D.J., 2011c, Climatic implications of the impending grand solar minimum and cool Pacific Decadal Oscillation: the past is the key to the future–what we can learn from recurring past climate cycles recorded by glacial fluctuations, ice cores, sea surface temperatures, and historic measurements: Geological Society of America, Abstracts with Programs

Easterbrook, D.J., 2010, A walk through geologic time from Mt. Baker to Bellingham Bay: Chuckanut Editions, 330 p.

Easterbrook, D.J., 2012, Are forecasts of a 20-year cooling period credible? 7th International Conference on Climate Change, Heartland Institute, Chicago, IL.

Easterbrook, D.J., Ollier, C.D., and Carter, R.M., 2013, Observations: The Cryosphere: in Idso,C.D., Carter R. M., Singer, F.S. eds, Climate Change Reconsidered II, Physical Science, The Heartland Institute, p. 645-728.

Grootes, P.M., and Stuiver, M., 1997, Oxygen 18/16 variability in Greenland snow and ice with 10-3- to 105-year time resolution. Journal of Geophysical Research, vol. 102, p. 26455-26470.

Hare, S.R. and R.C. Francis. 1995. Climate Change and Salmon Production in the Northeast Pacific Ocean: in: R.J. Beamish, ed., Ocean climate and northern fish populations. Can. special Publicaton Fish. Aquatic Science, vol. 121, p. 357-372.

Harper, J. T., 1993, Glacier fluctuations on Mount Baker, Washington, U.S.A., 1940-1990, and climatic variations: Arctic and Alpine Research, vol. 4, p. 332‑339.

Mantua, N.J. and S.R. Hare, Y. Zhang, J.M. Wallace, and R.C. Francis 1997: A Pacific interdecadal climate oscillation with impacts on salmon production: Bulletin of the American Meteorological Society, vol. 78, p. 1069-1079.

Link: http://wattsupwiththat.com/2014/01/17/cause-of-the-pause-in-global-warming/