Energiepolitisches Manifest

Argumente für die Beendigung der Energiewende

von Günter Keil, Michael Limburg und Burkard Reimer

Hinweis zur Einordnung dieses Papiers

Die Autoren wirken in einer Gruppe von Fachleuten mit, die Bewertungen und Vorschläge zur Energiepolitik für die Partei „Alternative für Deutschland “ (AfD) erarbeitet. Es handelt sich dabei um den Bundesfachausschuss Energiepolitik (BFAE) der AfD. Der Inhalt des vorliegenden Papiers ist zum Teil in die Programm-Arbeit der AfD eingeflossen, es gibt jedoch ausschließlich die Meinung der Autoren wieder und ist kein Programm-Papier der AfD. Politische Grundsätze und Ziele dieser Partei werden auf einem in Vorbereitung befindlicher Programmparteitag nach eingehender Beteiligung ihrer Landesverbände beschlossen – dieser Prozess und seine Ergebnisse bezüglich der künftigen Energiepolitik der AfD sind abzuwarten.

Gliederung

Vorwort

1. Klimaschutz – das Hauptziel der Energiewende wurde bereits aufgegeben

2. Faktencheck: Erneuerbare-Energien-Gesetz EEG, Energie-Einsparverordnung EnEV, Erneuerbare-Energien-Wärme-Gesetz EEWärmeG und Energiewende

2.0 Physik und Technik des elektrischen Stromes versus Ideologie und Betrug

2.1 Die Grenzen der Stromerzeugung mit „Erneuerbaren“

2.2 Der Weg in die staatliche Planwirtschaft mit EEG und die Vertreibung der Industrie

2.3 Ein weiteres Milliarden- Grab – EnEV und EEWärmeG

2.4 Das Speicher-Dilemma

2.5 Neue Speichertechniken ohne Chance zur Rettung der Energiewende

2.6 Konventionelle Kraftwerke: Unverzichtbar, aber bedroht.

2.7 Das Stromnetz wird überfordert

2.8 Offshore-Windparks: Die teure Illusion

2.9 Kernkraft: Ungeliebt, aber unverzichtbar

2.10 Shalegas: Die vertane Chance

2.11 Ohne Rücksicht: Die Energiewende als nationaler Alleingang

2.12 Die Energiewende bedroht den Naturschutz

2.13 Massive Verstärkung der Energieforschung und Verzicht auf die ineffektive

Markteinführung bekannter Techniken

2.14 Grüne Jobs – eine vergebliche Hoffnung

3. Die Energiewende ist schon gescheitert

Quellen

Anhang: Daten und Berechnungen

Vorwort

Dem Journalisten Daniel Wetzel war es vorbehalten, die Merkmale der Energiewende in zwei Sätzen zusammen zu fassen:

„Das Ökostrom-Eldorado Deutschland beruhte bislang auf fast völliger Zügellosigkeit. Unbegrenzter, regional völlig ungesteuerter Kapazitätsausbau, Einspeisevorrang, Abnahmepflicht selbst bei fehlender Nachfrage, gesetzliche Rendite-Garantie über 20 Jahre für jede noch so ineffiziente Ökostrom-Technologie, Sozialisierung der Risiken, Privatisierung der Gewinne: Das sind die Besitzstände, um die es geht.“(23)

Aber dies war noch längst nicht alles: In einer weltweit einzigartigen Panik-Überreaktion wurden unmittelbar nach dem Reaktorunfall von Fukushima-Daiichi acht Kernkraftwerke stillgelegt und die Stilllegung aller übrigen Kernkraftwerke bis 2022 gesetzlich angeordnet. Als wäre die mit der Energiewende – gekennzeichnet vor allem durch das Erneuerbare-Energien-Gesetz EEG – vorprogrammierte wirtschaftliche Katastrophe noch nicht genug; die Regierung verabschiedete sich mit diesem Ausstiegsbeschluss von ihrem eigenen „Klimaschutz“-Ziel, das ursprünglich die Begründung für die Energiewende-Politik lieferte. Als Folge dieser erzwungenen Stilllegung einer der beiden unverzichtbaren Grundlaststromquellen, die keinerlei Treibhausgase erzeugen, reiht sich jetzt die ehemalige Vorbild-Nation Deutschland wieder in die lange Kette der Länder ein, deren CO2-Emissionen nach wie vor steigen.

Damit ist die Energiewende endgültig zu einer sinnentleerten Politik geworden, die nur noch aus Furcht vor der völligen Blamage und aus Angst vor den Medien an ihren irrealen Plänen festhält und sich mit kosmetischen Korrekturen (siehe Koalitionsvertrag der neuen Regierung aus Union und SPD) über die Runden zu retten versucht – wohl wissend, dass der von den Bürgern und der Wirtschaft zu zahlende Preis mit jedem weiteren verlorenen Monat weiter steigt. Anscheinend wartet die Politik noch so lange mit einer radikalen Kurskorrektur, bis Arbeitslosigkeit, Energiearmut und die Abwanderung der Industrie völlig unerträglich geworden sind.

Am 16. Dezember 2013 hat die Diskussion über die Energiepolitik eine neue Qualität bekommen: An diesem Tag hielt der Direktor des Münchner ifo-Instituts Prof. Dr. Hans-Werner Sinn einen Vortrag im Audimax der Universität München mit dem Titel „Energiewende ins Nichts“ (37).

Noch nie zuvor hat ein führender Ökonom derart präzise und kompromißlos die katastrophalen Fehler der Energiewendepolitik analysiert und deren ebenso katastrophale Folgen demonstriert. Die Aussagen von Prof. Sinn zu den verschiedenen Teilthemen werden in den entsprechenden Kapiteln dieses Papiers zitiert.

Die hier vorgelegte Arbeit behandelt die Wirkungen der bisherigen Energiepolitik in den verschiedenen Sektoren der Energiewirtschaft und in weiteren betroffenen Bereichen – mit Vorschlägen für die zu ergreifenden Maßnahmen. Die Autoren erhoffen sich damit, den Lesern eine umfassende und von keinerlei ideologischen Scheuklappen eingeschränkte Sicht der Wirklichkeit zu vermitteln, die ihnen bisher von den Medien und auch von allen im Bundestag vertretenen politischen Parteien verweigert wird.

1. Klimaschutz – das Hauptziel der Energiewende wurde bereits aufgegeben

Besonders die deutsche Regierung hat sich unkritisch die auf fragwürdigen Computermodellen beruhenden apokalyptischen Warnungen des Intergovernmental Panel on Climate Change IPCC, eine von der UN und den nationalen Regierungen kontrollierte politische Organisation, zu Eigen gemacht und ihre Energiepolitik auf die Reduzierung des Spurengases CO2 ausgerichtet. Sie hat widerspruchslos hingenommen, dass die sehr ausführlichen, meist 700 Seiten übersteigenden Berichte der dem IPCC zuarbeitenden Wissenschaftler von den politischen Bearbeitern im IPCC drastisch verkürzt und von politisch unerwünschten Aussagen bereinigt wurden. Stattdessen wurden Aussagen dramatisiert. Aus diesen nur noch ca. 40 Seiten umfassenden Extrakten der Angst – genannt „Zusammenfassung für politische Entscheidungsträger“ – bezog dann die Regierung ihre Informationen für ihre Entscheidungen. Damit ließ sie sich von der rein politisch agierenden Organisation IPCC manipulieren.

Die massive Kritik aus der Wissenschaft an diesem Vorgehen und an den Aussagen wurde ignoriert; statt dessen wurde wahrheitswidrig die Behauptung von einer 98-prozentigen Zustimmung aller Klimawissenschaftler angeführt. Jetzt hat sich die Regierung stillschweigend von diesem Ziel verabschiedet, ohne allerdings ihre auf eine CO2-arme Wirtschaft ausgerichtete Energiepolitik zu ändern. Die entscheidende Begründung für die Energiewende, der „Klimaschutz“, wird nun verschwiegen, seit die Regierung erkannt hat, dass die Abschaltung der CO2-freien Grundlast-Kernkraftwerke unweigerlich zu einer verstärkten Nutzung der anderen in Deutschland verfügbaren Kraftwerke für Grundlaststrom, der Kohlekraftwerke, führen musste. Trotz des Aufbaus riesiger Kapazitäten an „Erneuerbaren“ kann der nun fehlende Kernkraft-Strom nur durch neue Kohlekraftwerke ersetzt werden. Der CO2-Ausstoß steigt zwangsläufig und der Umweltminister zeigt sich bekümmert. Die Regierung, die sich gegenüber anderen Ländern mit ihrer Vorreiter-Rolle immer wieder brüstete, schweigt dazu. Nun gab sie den Weg in Brüssel frei, 900 Millionen CO2-Zertifikate in der EU aus dem Markt zu nehmen. Einmal erhofft man sich davon, den Strom aus den fossil gefeuerten Kraftwerken teurer zu machen, um die Wettbewerbsfähigkeit der Erneuerbaren zu verbessern, und zum anderen den durch die Abschaltung weiterer Kernkraftwerke wieder steigenden CO2-Ausstoß zu bremsen.

Das wird einerseits die Stromerzeugung durch die heute noch rentablen Kohlekraftwerke weiter verteuern, andererseits wird die in Deutschland abnehmende Grundlast-Stromproduktion durch teure Kernkraftstrom-Importe ausgeglichen werden müssen – beides wird den Strompreis weiter in die Höhe treiben.

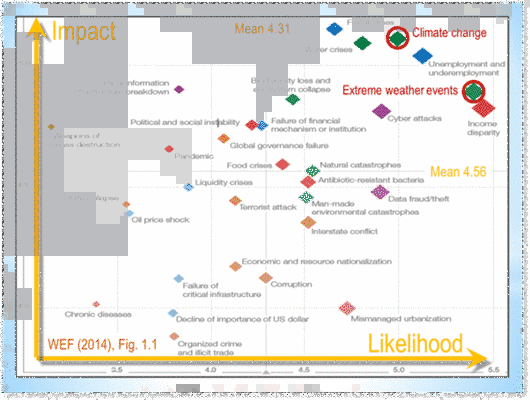

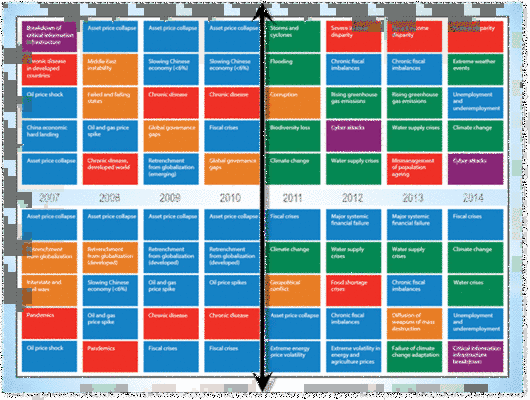

Die Kritik an den vom IPCC prognostizierten Klima-Szenarien nimmt immer mehr zu, seit die Unglaubwürdigkeit der Prognosen und politischen Absichten, die mit der Verbreitung von Klimapanik verbunden sind, immer deutlicher zutage treten.

Eine Zusammenstellung dieser Kritik (19):

· Wenige Wissenschaftler bestreiten, dass Aktivitäten der Menschen eine Auswirkung auf das lokale Klima haben können oder dass die Summe derartiger lokaler Effekte hypothetisch derart ansteigen könnte, dass es ein messbares globales Signal gibt. Die Schlussfolgerung der internationalen, unabhängigen Wissenschaftlervereinigung NIPCC (19) ist jedoch, dass jedes vom Menschen verursachte Klima-Signal sehr klein und in die Variabilität des natürlichen Klimasystems eingebettet und damit nicht gefährlich ist.

· Die Methode des IPCC, aus Beobachtungen – z.B. des zeitlichen Verlaufs der Erdoberflächentemperatur (zum unwissenschaftlichen Konzept einer angeblichen Globaltemperatur siehe unten) – auf die Richtigkeit seiner Hypothese vom menschengemachten Klimawandel zu schließen, ist unwissenschaftlich. Beobachtungen sind in der Wissenschaft in erster Linie für die Widerlegung („Falsifizierung“) von Hypothesen nützlich und können nicht beweisen, dass eine Hypothese richtig ist.

· Eine wissenschaftlich bestätigte, also nicht falsifizierte Theorie hingegen sollte zukünftige Ereignisse hinreichend sicher prognostizieren können. Doch sämtliche Prognosen des IPCC über die angebliche Rolle der sogenannten Treibhausgase, insbesondere des CO2, als die Hauptfaktoren für die Erhöhung der Globaltemperatur (siehe unten) beruhen im Wesentlichen auf Computermodellen und erwiesen sich als falsch. Es gibt weder einen experimentellen Beweis noch unterstützende Beobachtungen für diese Theorie. Sie wird allein dadurch zur bloßen Hypothese degradiert. In den exakten Wissenschaften gilt aber eine Theorie nur dann als richtig, wenn sie durch wissenschaftliche Experimente oder gesicherte Beobachtungen bewiesen und deshalb in der Lage ist zukünftige Entwicklungen vorherzusagen.

· Bei der gegenwärtigen CO2-Konzentration in der Atmosphäre von ca. 400 ppm leben wir immer noch in einer sehr CO2-armen Welt. Die Konzentrationen im Kambrium (vor 500 Mio. Jahren) betrug ca. 4500 ppm. In diesem geologischen Abschnitt fand die s.g. „kambrische Explosion“ statt, in der sich die Lebewelt, so wie wir sie heute kennen, entwickelte (43).

· Die benutzten Computermodelle sind nichts anderes als spekulative Gedankenexperimente von Modellierern. Die damit erhaltenen Ergebnisse sind nur so zuverlässig wie die eingegebenen Daten.

So lange die Antriebskräfte des Klimas und die Rückkopplungs-Vorgänge nicht völlig geklärt sind, stellen die Computermodelle nichts anderes dar als Übungen ohne Aussagekraft. Es ist weitgehend anerkannt, dass Klimamodelle nicht zur Erzeugung von Vorhersagen entwickelt und geeignet sind, sie geben vielmehr als „was-wäre-wenn“-Projektionen viele mögliche zukünftige Entwicklungen wieder. Die derzeit bekannten Schwächen der Klimamodelle betreffen ihre Kalibrierung (die Auswahl der Eingangsdaten), ihr nichtlineares Verhalten (zufällig streuende Ergebnisse bei jedem „Lauf“) und die Vernachlässigung wichtiger natürlicher klimaabhängiger Variablen. Die gegenwärtigen Klima-Computermodelle vermögen nicht einmal, innere periodische Klimaschwankungen wie die bedeutenden pazifischen und atlantischen Schwankungen (Pacific Decadal Oscillation PDO und Atlantic Multidecadal Oscillation AMO) zu simulieren.

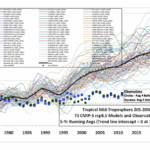

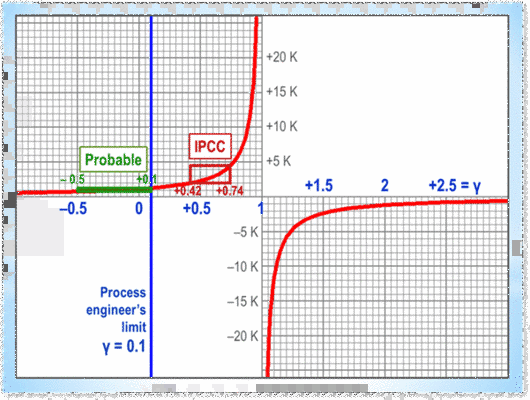

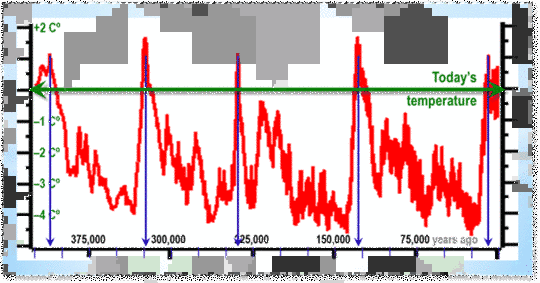

· Ebenfalls werden die Wirkungen von Veränderungen des Magnetfeldes der Sonne und der Teilchenstrahlung („Sonnenwind“) ignoriert, obwohl sie das Klima signifikant beeinflussen. Gegenwärtig zeigt sich die Unbrauchbarkeit dieser Modelle auch bei der aktuellen Entwicklung der Globaltemperatur, die – im krassen Gegensatz zu den IPCC-Vorhersagen von +0,3 oC – seit nunmehr 16 Jahren nicht nur stagniert, sondern sogar leicht zurück geht. Diese tatsächliche Entwicklung der Globaltemperatur hat bereits sogar den unteren Streubereich der IPCC-Prognosen nach unten verlassen – was nur beweist, dass diese Prognosen nicht einmal die Entwicklung auch nur der kommenden 10 Jahre zu beschreiben imstande sind. Voraussagen für das Jahr 2100 auf der Grundlage dieser völlig unbrauchbaren Instrumente sind daher nur noch lächerlich.

Diese Tatsache hat die Glaubwürdigkeit des IPCC stark erschüttert. Zu beachten ist dabei, dass die sogenannte Globaltemperatur nichts anderes ist als eine unsinnige Mittelwertbildung über ein Temperaturfeld, das sich nicht im Gleichgewicht befindet und das daher keine Temperatur aufweist. Die Erde hat nicht eine einzige Temperatur (26).

· Die Entwickler der IPCC-Computermodelle benutzten unbewiesene, ausschließlich positive Rückkopplungsannahmen in der Atmosphäre, um ihre Modelle zu den zukünftigen dramatischen Temperaturerhöhungen von 3 – 6 Grad als Ergebnis zu veranlassen. Ohne diese hypothetischen Mechanismen ergibt die Strahlungsphysik nur einen sehr geringen Erwärmungseffekt der Treibhausgase von 0,3 – 1,0 oC und knapp die Hälfte dieser Erhöhung hätte bereits stattgefunden. Das ist allerdings ein politisch unerwünschtes Ergebnis.

· In den ersten IPCC-Berichten wurde der Einfluß der Sonne auf die Klimaveränderungen der letzten 50 Jahre als sehr gering bezeichnet, verbunden mit der seltsamen Feststellung, dass man über die Art und Weise der Klimabeeinflussung durch die Sonne zu wenig wisse. Das IPCC blieb auch noch dabei, als die dänischen Wissenschaftler um Svensmark einen neuen, indirekten Mechanismus entdeckten, über den die Sonne mit ihrer Partikelstrahlung (Sonnenwind) auf die Wolkenbildung und damit auf die Oberflächentemperatur der Erde wirkt. Im Gegensatz zu den Computer-Modellierern und deren CO2–Theorie war das dänische Team in der Lage, ihre Theorie experimentell zu beweisen; im CERN erfolgte eine zweite experimentelle Bestätigung. Somit kommt der Sonne die entscheidende Rolle im Klimageschehen auf der Erde zu – wie man es bereits seit Jahrhunderten aus der Beobachtung der Sonnenflecken wusste (17) (18).

· Die Veröffentlichung des E-Mail-Verkehrs zwischen führenden Wissenschaftlern der Klimakatastrophen-Fraktion vermittelte einen deprimierenden Einblick sowohl in die Manipulation wissenschaftlicher Ergebnisse als auch in die Behinderung kritischer Kollegen bei deren Veröffentlichungen (16).

· Vom IPCC und Politikern – darunter auch Bundeskanzlerin Angela Merkel – wurde wiederholt auf einen angeblichen Konsens der Klimaforscher bezüglich der IPCC-Prognosen verwiesen. Diese Behauptung war von Anfang an unzutreffend; vielmehr gibt es eine sehr starke und stetig zunehmende Kritik von Wissenschaftlern am IPCC und dessen Methoden – und an der unakzeptablen, aber sehr bezeichnenden Ausblendung dieser fachlichen Kritik aus den IPPC-Berichten. Unerklärlich ist auch der Glaube von Politikern an das ominöse „2-Grad-Ziel“, das von der Klimaforschung als unwissenschaftlich angesehen wird (26).

· Projektionen des Sonnenzyklus (periodisch schwankende Aktivität der Sonne) in die Zukunft lassen darauf schließen, dass die nächsten Dekaden eher durch eine globale Abkühlung als durch eine Erwärmung gekennzeichnet sein könnten – trotz weiterer CO2-Emissionen.

· Eine vernichtende Selbstkritik veröffentlichte das IPCC in seinem 3. Bericht (TAR, 2001), Kapitel 14.2.2 „Vorhersagbarkeit in einem chaotischen System“. Zitat: „Das Klimasystem ist besonders herausfordernd, weil bekannt ist, das Bestandteile des Systems chaotisch sind; es gibt Rückkoppelungen, die potenziell das Vorzeichen (einer Entwicklung) wechseln können und es gibt zentrale Prozesse, die das Klimasystem in einer komplizierten, nichtlinearen Weise beeinflussen. Diese komplexen, chaotischen, nichtlinearen Triebkräfte sind ein inhärenter (innewohnender, anhaftender) Aspekt des Klimasystems. Mit einem Wort: Eine Strategie muss berücksichtigen, was möglich ist. In der Klimaforschung und Klima-Modellierung sollten wir zu Kenntnis nehmen, dass wir es mit einem gekoppelten nichtlinearen System zu tun haben und deshalb eine Langzeit-Vorhersage zukünftiger Klimazustände nicht möglich ist.“ (Seite 774 im englischsprachigen Bericht der Arbeitsgruppe I).

Diese ehrliche, aber für den politischen Auftrag des IPCC peinliche und vernichtende Analyse wurde dann in den späteren IPCC-Berichten nicht mehr zitiert – obwohl dauerhaft gültig.

Auch im 3. Bericht ging diese Bewertung in dessen drei insgesamt 2.570 Seiten starken Bänden der wissenschaftlichen Arbeitsgruppen unter, die kein Politiker jemals las – dafür hatte dann die „Zusammenfassung für Politiker“ ganze 31 Seiten. Und diese drastisch verkürzte, manipulative und auf Erzeugung von Angst ausgerichtete Miniaturfassung zeigte bei den Politikern die erhoffte Wirkung.

Auch ohne die Diskussion über die Schädlichkeit oder Unschädlichkeit von CO2 als Treibhausgas gibt es längst mehrere Gründe dafür, dass Deutschland sämtliche teuren Anstrengungen zum sogenannten Klimaschutz einstellen müsste – und zwar wegen erwiesener Bedeutungs- und Nutzlosigkeit.

Diese Gründe sind:

1. Das europäische System des Emissionshandels neutralisiert sämtliche deutschen Bemühungen, CO2 einzusparen, indem als deren Konsequenz die übrigen Euroländer durch Ankauf der Zertifikate ihre Emissionen um exakt die gleiche Menge erhöhen können. Nicht eine einzige Tonne CO2 wird deshalb durch die Anstrengungen Deutschlands in der EU eingespart. Das EEG widerspricht somit diesem Emissionshandel und stellt deshalb eine im europäischen Maßstab unwirksame und teure Parallelaktivität dar. Die dadurch verursachte „völlige Wirkungslosigkeit“ des EEG betonte auch Prof. Hans-Werner Sinn in seinem stark beachteten Vortrag (38).

2. Selbst die gesamten CO2-Einsparungsbemühungen der EU-Länder bewirken – wenn man den IPCC-Prognosen Glauben schenkt und sie anwendet – nahezu nichts. Der dänische Forscher Björn Lomborg hat berechnet, dass die von der EU geplanten Maßnahmen, für die sie bis ins Jahr 2100 jährlich 250 Milliarden Euro ausgeben will – also insgesamt 20 Billionen Euro – am Ende dieses Zeitraums eine Verringerung der vom IPCC verwendeten „Globaltemperatur“ (26) um ein zwanzigstel Grad (0,05 oC) bringen würde. Also 20 Billionen Euro für praktisch nichts.

3. Jedes Jahr erfahren wir, dass viele anderen Nationen, allen voraus China und Indien, ihre CO2-Emissionen gewaltig erhöhen. Diese Steigerungen sind dermaßen umfangreich, dass sämtliche jährlichen Einsparungen Deutschlands in den Jahren vor dem Kernkraftausstieg in jeweils knapp einer Woche allein durch die Mehremissionen Chinas ausgeglichen und zunichte gemacht wurden. Nimmt man noch die übrigen Staaten hinzu, dann wurden Deutschlands jährliche Anstrengungen in 2 – 3 Tagen durch deren CO2-Anstieg neutralisiert. Das ist die Antwort dieser Länder auf den deutschen Anspruch, Vorbild für sie zu sein.

4. Die deutsche Regierung hat ihre Klimaschutzpolitik bereits mit der Abschaltung von 8 Kernkraftwerken aufgegeben. Mit der gesetzlich vorgegebenen Abschaltung der restlichen KKW werden sich die Emissionen Deutschlands noch weiter erhöhen. Damit sind alle Gründe entfallen, die irgendeine Aktivität in diese Richtung rechtfertigen – und für die Bürger gibt es keine Gründe mehr, unter dem Vorwand eines „Klimaschutzes“ Gängelungen, Vorschriften und insbesondere Preissteigerungen für die Energie hinzunehmen.

Deshalb sollte die Energiewende wegen des klaren Verfehlens ihres Hauptziels von der Regierung kurzfristig abgesagt werden.

Vorschlag:

Die Begründung eines angeblich vom Menschen durch seine CO2-Emissionen verursachten Klimawandels und damit der angeblichen Notwendigkeit drastischer CO2-Einsparungen wird angesichts der mehrfach widerlegten Prognosen des IPCC und des seit 1998 festgestellten Ausbleibens eines globalen Temperaturanstiegs fallen gelassen. Damit entfällt auch offiziell das bisherige, wesentliche Argument für die Bevorzugung der sog. „Erneuerbaren Energien“. Alle direkt dazu dienenden Maßnahmen werden beendet – z.B. das EEG, der Emissionshandel und technische Maßnahmen wie die Abtrennung und Einlagerung von CO2.

2. Faktencheck: Erneuerbare-Energien-Gesetz EEG, Energie-Einsparverordnung EnEV

und Energiewende

2.0 Physik und Technik des elektrischen Stromes versus Ideologie und Betrug

Bei fossilen Energieträgern wie Kohle, Öl, Gas und Uran handelt es sich um materielle Güter bzw. Stoffe, die Masse besitzen, direkt gelagert oder gespeichert und als Ware gehandelt werden. Elektrischer Strom hingegen beschreibt die Bewegung von elektrischen Ladungsträgern wie Elektronen in einem Leiter, die praktisch masselos die elektrische Energie übertragen. Die Ladungsträger (und damit elektrischer Strom) lassen sich direkt nur in ganz geringem Umfang in Kondensatoren speichern. Eine direkte großtechnische Speicherung von Elektronen und damit von Strom ist aus physikalischen Gründen nicht möglich. In einem Stromversorgungsnetz ist deshalb nur ein „Online-Betrieb“ möglich, d.h. jeder Strom, der an irgendeiner beliebigen Stelle des Netzes entnommen wird, muss direkt und unmittelbar in gleicher Menge durch einen Strom-Generator eingespeist werden. Wenn kein Stromverbraucher eingeschaltet ist, kann das Netz auch keinen Strom aus den Generatoren aufnehmen. Werden alle Generatoren abgeschaltet, steht auch sofort kein Strom mehr für den Verbrauch zur Verfügung.

Wegen dieser physikalischen Eigenschaft des elektrischen Stromes spricht man im juristischen Sinne und im Handelsrecht auch bei der Stromversorgung von einer Dienstleistung. Wie beim Frisör muss der Dienstleistende und der Dienstleistungsempfänger, hier der Stromverbraucher und der Stromerzeuger über das Netz, simultan verbunden sein.

Viele Stromversorger, die Lobbyisten der "Erneuerbaren Energien" aber auch die Politiker aller Parteien verschleiern bewusst oder wegen Unkenntnis die physikalischen und technischen Gesetzmäßigkeiten der Stromversorgung. So werden Stromverträge angeboten, die einen bestimmten Anteil von EE-Strom anbieten, der bis zu 100% geht. Mit solchen Aussagen wird der umweltbewusste Kunde mehr oder weniger betrogen.

So hatte schon das Oberlandesgericht München 2001 die Werbekampagne des Stromversorgers E.ON gestoppt, der damit geworben hatte, seinen Ökostromkunden "zu 100% Strom aus Wasserkraft" zu liefern. Dieses Urteil nahm dann der Ökostromlieferant NaturEnergie AG zum Anlass, ein s.g. "Stromseemodell" zu entwickeln, das die Physik des Stromes negiert und den "Stromsee" als Speicherbecken darstellt, in das alle Lieferanten ihren Strom einspeisen. Dabei wird natürlich der Strom aus den herkömmlichen Kraftwerken als "verschmutztes Wasser" bezeichnet, der Strom des Grünstromanbieters als "sauberer Strom" ausgewiesen (44). Zwar wird dem Gerichtsurteil nicht direkt widersprochen, aber mit unglaublichen Geschichten wird dem Kunden vorgegaukelt, dass er das richtige tut, wenn er den 100-prozentigen Ökostrom kauft, auch wenn diesen andere verbrauchen, die nur herkömmlichen Strom bestellt haben. Wenn er Glück hat, erhält er eine homöopathische Dosis von seinem bestellten Ökostrom, muss aber tatsächlich weit überwiegend mit dem Strom aus konventionellen Kraftwerken vorlieb nehmen, den auch alle anderen Stromkunden aus exakt gleicher „Herkunft“ erhalten.

Das Stromseemodell wird offensichtlich heute von allen 100%-Ökostrom-Anbietern verwendet, z.B. von GREENPEACE ENERGY unter dem Motto "Gemeinsam machen wir den Stromsee sauber" (45) oder die NaturEnergie AG mit ihrer gegenwärtigen Werbung (46). Jetzt wird gar nicht mehr der Versuch gemacht, den "Stromsee" physikalisch oder technisch zu erklären. Es wird der Eindruck erweckt, dass der Strom im "Stromsee" nicht nur gemischt wird, sondern auch gespeichert werden kann. Dass die Windkraft- bzw. Photovoltaik-Anlagen aber nur maximal 3000 h bzw. 1700 h von 8760 Jahresstunden Strom liefern und damit die meiste Zeit im Jahr im Mix des Anbieters aus 100% Ökostrom fehlen, macht den Betrug erst deutlich.

Bei einem Stromliefervertrag wird dem Kunden versprochen, dass sich der gelieferte Strommix mit festen Prozentsätzen aus verschiedenen Stromquellen speist oder gar zu 100% aus Ökostrom besteht. In Wahrheit jedoch kann jeder aus dem deutschen Stromnetz versorgte Verbraucher nur den gleichen Strommix beziehen, der täglich in das Stromnetz eingespeist wird. Für das Jahr 2012 betrugen die ins Netz eingespeisten Ökostrom-Anteile wie folgt: Windkraft 8.1%, Photovoltaik 4,2%, Biomasse 6.2% und Wasserkraft 3,5%. Das waren 22% regenerativer und der Rest 78% herkömmlicher Strom. Diesen Strommix hat im Mittel jeder Kunde geliefert bekommen, egal welchen Strom er von wem bestellt hatte.

2.1 Die Grenzen der Stromerzeugung mit „Erneuerbaren“

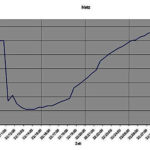

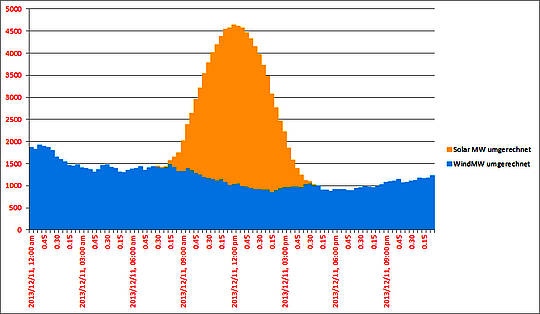

Im Jahr 2012 waren „erneuerbare“ Stromerzeuger mit einer elektrischen Gesamtleistung von 62 GW (1Gigawatt=1000 Megawatt) installiert. Deutschland braucht im Durchschnitt an normalen Tagen zur Deckung des Strombedarfs eine Anschlussleistung von 60 GW, als Spitzenleistung im kalten Winter 70 bis 80 GW. Obwohl also diese Grünstromanlagen, wenn sie mit Nennleistung kontinuierlich arbeiten würden, schon fast den gesamten Strom für Deutschland liefern könnten, zeigen die tagesgenauen Ganglinien aller per EEG-Gesetz geförderten Anlagen in Deutschland über das gesamte Jahr 2012 (1), dass gerade einmal am 15.09.2012 für wenige Stunden eine Leistung von 30 GW überschritten worden ist. Nur für diese kurze Zeit haben die EE-Stromerzeuger Deutschland zur Hälfte mit Strom versorgen können. Man sieht aber auch, dass deren angebotene Leistung täglich gewaltig schwankt und häufig bis auf nahe Null zurück geht. In einer weiteren Grafik (2) oder (3) für die Monate Januar bis März 2013 sind sowohl die Einspeiseleistung wie auch der Stromverbrauch für Deutschland dargestellt. Hier ist deutlich der geringe Anteil der Stromerzeugung der EE-Anlagen im Vergleich zu deren installierter Maximalleistung zu erkennen. Den Hauptteil der elektrischen Energie müssen nach wie vor die herkömmlichen Kraftwerke liefern.

Im Jahr 2012 haben die „Erneuerbaren“ aus Wind und Sonne nur 12,3% zur Bruttostromerzeugung beigetragen (4). Um zum Beispiel auf 25% zu kommen müsste also die Leistung von Wind- und Photovoltaik-Anlagen gegenüber 2012 verdoppelt werden. Da auch bei Verdoppelung der EE-Strom-Leistung ihre Volatilität, d.h. die vom Wetter und Tageslicht abhängigen Leistungsschwankungen nicht verringert werden, geht ihre Leistung an windarmen Nachtstunden immer wieder auf nahe Null zurück. D.h. es müssen herkömmliche Kraftwerke mit einer Leistung von 80 GW, davon 70 GW für Spitzenlast und 10 GW Reserve, ständig betriebsbereit vorgehalten werden. Will man teilweise oder ganz auf konventionelle, also Kern-, Kohle-, Gas,- oder Öl-Kraftwerke verzichten, was das Ziel des EEG und der Energiewende ist, benötigt man zwingend die Speicherung des volatilen Stroms der Wind- und Solarstromerzeuger zu den Zeiten, in denen er überhaupt verfügbar ist, und diese Speicher müssen derart groß sein, dass sie in den Ausfallperioden des Grünstroms eine sicher verfügbaren Leistung von 80 GW liefern können – und das durchaus über mehrere Tage (siehe Kap. 2.4 und 2.5).

2.2 Der Weg in die staatliche Planwirtschaft mit EEG und die Vertreibung der Industrie

Das Erneuerbare Energien-Gesetz EEG hatte von Anfang an einen durchgehend planwirtschaftlichen, Charakter. Mit den extrem zunehmenden Subventionen für die ausgewählten „Erneuerbaren“ erfolgte eine Umwandlung des ehemals marktwirtschaftlich ausgerichteten Energiesektors in einen von Planwirtschaft gefesselten Sektor. Die mit dem EEG begangenen grundlegenden Fehler sind:

· Auswahl bestimmter, ideologisch hoch bewerteter Stromerzeugungstechniken – Solarstrom, Windstrom, Biogas-Strom (hier EE-Techniken genannt) – die mittelfristig alle anderen Stromerzeugungstechniken ersetzen sollten. Unterdrückung eines echten Wettbewerbs mit anderen, bewährten Techniken.

· Extrem hohe Förderung dieser EE-Techniken mit einer 20-jährigen Garantie der s.g. Einspeisevergütungen für jede noch so ineffiziente Ökostrom-Technologie, die von den Stromverbrauchern zu bezahlen sind. Zudem der Zwang für die Netzbetreiber, den Strom aus diesen Anlagen vorrangig anzunehmen, auch wenn kein Bedarf besteht. Ferner Entschädigungen für die EE-Lieferanten, wenn die Stromlieferung von den Netzbetreibern aus sicherheitstechnischen Gründen abgelehnt werden muss.

· Unbegrenzter, regional völlig ungesteuerter Kapazitätsausbau, Einspeisevorrang, Abnahmepflicht selbst bei fehlender Nachfrage, gesetzliche Rendite-Garantie über 20 Jahre

Die zwangsläufigen Folgen:

· Gefährdung der Netzstabilität durch die zufällige, vom Wetter und Tageslicht abhängige

Stromerzeugung der Solar- und Windstromerzeuger.

· Teurer zusätzlicher Ausbau der Höchstspannungsnetze, weil das Windstrom-Überangebot in

Norddeutschland wegen fehlender Leitungen nicht zu den west- und süddeutschen

Verbrauchszentren geleitet werden kann.

· Reduzierung der notwendigen Jahreslaufzeit und damit der Rentabilität von Kohle-, Gas- und Pumpspeicher-Kraftwerken durch die gesetzlich vorgeschriebene Einspeisung des zeitlich begrenzten Strom-Überangebots der EE-Quellen, das die Verbraucher trotzdem mit der EEG-Umlage teuer bezahlen müssen.

· Starke Strompreis-Steigerungen durch die von den Verbrauchern zu zahlenden

EEG- und weiteren Umlagen.

· Privilegien für EE-Stromerzeuger, dadurch Sozialisierung der Risiken, Privatisierung der Gewinne. Eine riesige Umverteilung von den weniger Bemittelten wie den Familien in den Miethäusern zu den Wohlhabenden wie den Hausbesitzern mit Solardächern oder Windparkbetreibern.

· Belastung und Gefährdung der Stromnetze nicht nur in Deutschland, sondern auch in den Nachbarländern durch von Deutschland exportierte Stromspitzen bei Starkwind.

· Gefährdung der Wettbewerbsfähigkeit energieintensiver Unternehmen und deren Abwanderung in Länder mit niedrigeren Energiepreisen, verbunden mit der Verlagerung der CO2-Emissionen dieser Unternehmen ins Ausland, was im globalen Maßstab nichts bewirkt, außer der Verschönerung der deutschen Statistik.

Die De-Industrialisierung hat bereits begonnen

Eine im Dezember 2013 veröffentlichte Untersuchung der Forschungsgruppe der Deutschen Bank (30) kommt zu dem Ergebnis, „dass in Deutschland in energieintensiven Branchen bereits ein schleichender Prozeß der De-Industrialisierung begonnen hat. Er führt (Anm.: als offenbar gewollter) Nebeneffekt zu Verlagerungen von CO2-Emissionen in andere Länder“. Der deutsche Strompreis für industrielle Kunden übertreffe das EU-Niveau um rd. 26%. „Nicht nur sind die Energiekosten gestiegen. Auch die Unsicherheiten bezüglich der allgemeinen energiepolitischen Rahmenbedingungen haben zugenommen. Aufgrund der schwankenden Stromversorgung durch erneuerbare Energien muss zudem inzwischen ein größerer Aufwand betrieben werden, um die Versorgungssicherheit zu gewährleisten.“ (Anm.: Damit sind der Aufbau und die Verstärkung einer eigenen Notstromversorgung gemeint.)

Die DB-Forscher stellen fest: „Unternehmen aus energieintensiven Branchen hielten sich schon in den letzten Jahren mit Investitionen in Deutschland zurück. In nur zwei der letzten 17 Jahre investierten die energieintensiven Branchen mehr in ihre Anlagen, als sie abgeschrieben haben.“ Sie folgern: „Steigen die Energiepreise auch künftig … überproportional, ist bei energieintensiven Unternehmen … mit Umsatzverlusten zwischen 2 und 6% des Umsatzes zu rechnen. Das entspricht einem absoluten Verlust zwischen rd. 5 Mrd Euro und 16 Mrd. Euro pro Jahr.“

Die Forscher kommen zu der Schlussfolgerung, „dass sich (energieintensive) Unternehmen bei Erhaltungs- und Erweiterungsinvestitionen künftig häufiger gegen den heimischen Standort entscheiden, was zu einem schleichenden Substanzverlust bei den Produktionsanlagen … führen kann.“

Eine hohe Belastung dieser Unternehmen, die am Anfang einer vertikal integrierten Wertschöpfungskette stehen und Vorprodukte z.B. an den Maschinenbau, die Elektrotechnik oder den Fahrzeugbau liefern, hätte deshalb auch negative Auswirkungen auf nachgelagerte Branchen zur Folge. Und weiter: „Unter dem Strich sehen wir das Risiko, dass Deutschlands Wettbewerbsfähigkeit als Industriestandort mittel- bis längerfristig leidet.“

Mit der Vertreibung dieser Industrien ins Ausland exportiere Deutschland auch die mit ihr zusammenhängenden CO2-Emissionen – „in einer Größenordnung von gut 3 bis rd. 10 Mio. Tonnen pro Jahr.“ Kommentar der Wissenschaftler: „Letztlich zeigt sich hier das Dilemma einer national forcierten Klimapolitik. Übermäßig hohe Energiepreise oder klimapolitische Regulierungen in einem Land führen aber kurz- und mittelfristig nicht zu global sinkenden CO2-Emissionen, sondern lediglich zu deren Verlagerung (im Fachjargon: Carbon Leakage).“

Am Schluß bewerten die Wissenschaftler den Koalitionsvertrag der neuen Bundesregierung: „Die angekündigten Maßnahmen dürften nicht ausreichen, um einen weiteren Anstieg der Energiepreise zu stoppen.“

Die inhärenten Fehler des EEG sind struktureller und grundsätzlicher Natur, so dass alle Versuche einer Verbesserung aussichtslos bleiben müssen. Aus diesem Grunde wird immer stärker eine ersatzlose Abschaffung dieses Gesetzeswerks gefordert.

Einer der prominentesten Vertreter dieser Forderung ist Prof. Dr. C. Christian von Weizsäcker vom Max-Planck-Institut zur Erforschung von Gemeinschaftsgütern, Bonn. In einem neueren Interview erklärte er auf die Frage „Was sollte die Politik beim Fördersystem für die Erneuerbaren tun?“ unmißverständlich: „Die grundsätzliche Antwort müßte heute sein, dass man das EEG komplett abschafft und statt dessen andere Modelle einführt. Insbesondere solche, die zwar ein gewisses Mengenziel für erneuerbare Energien insgesamt vorgeben, dann aber die verschiedenen erneuerbaren Energien unter gewissen Schutzklauseln miteinander konkurrieren lassen“ (27).

Selbst der für die Energiepolitik zuständige EU-Kommissar Günther Oettinger erklärte am 11.1.2014 in einem Vortrag in Königswinter, „das EEG gehört in den Mülleimer“.

Die bisherige Regierung hat an der grundlegenden Fehlentscheidung, die mit dem EEG getroffen worden sind, um jeden Preis festgehalten. Als Konsequenz dieser fatalen Fehlplanung waren ständig weitere neue Reparatur-Fehlentscheidungen erforderlich, um die unübersehbaren Engpässe und Schäden vorübergehend zuzudecken. Im Ergebnis muss jetzt in Deutschland das gesamte System der Stromerzeugung doppelt errichtet werden: Riesige Investitionen in unzuverlässige und teure Wind- und Solarstromanlagen – bei gleichzeitigem Zugriff auf die unverzichtbaren Kohle- und Gaskraftwerke, die mittlerweile aber durch die subventionierte und unbegrenzte EE-Strom-Einspeisung unwirtschaftlich geworden sind und in einem marktwirtschaftlichen System eigentlich stillgelegt werden müssten. Diese selbst verschuldete Engpasssituation bekämpft der Staat wiederum durch neue Verordnungen mit der Verpflichtung von konventionellen Kraftwerken als Netzreserve – was erneut Kosten verursacht.

Die Energiesparverordnung (EnEV) und das Erneuerbare-Energien-Wärme-Gesetz (EEWärmeG) sind weitere von vielen Beispielen für eine immer mehr ausufernde Planwirtschaft im Energiesektor; typisch für die notorische Grundeinstellung der staatlichen Stellen, dass die Bürger und die Wirtschaft zu einem „klimafreundlichen“ Verhalten leider gezwungen werden müssen.

Die EnEV und das EEWärmeG führen zu einer weiteren hohen finanziellen Belastung von Bürgern und Unternehmen, die durch die damit beabsichtigte Energieeinsparung nicht annähernd finanziell kompensiert wird; insbesondere nach den geplanten Verschärfungen dieser Verordnung. Zudem verteuern sie zwangsweise Neubauten, was Hausbesitzer und Mieter zusätzlich belastet.

EnEV und EEWärmeG werden in Kapitel 2.3 behandelt.

Vorschlag:

· Das EEG ist abzuschaffen. Sämtliche Förderungen sind einzustellen. Für Bestandsanlagenbesitzer wird eine grundgesetzkonforme Entschädigungs-Lösung vorgeschlagen, die, sofern ein Schaden entstanden ist, diese nach dem Vorbild des Lastenausgleiches nach dem II. Weltkrieg die Besitzer aus einem noch zu bildenden Sonderfonds entschädigt, in den alle Besitzer von „EE“ Anlagen einzuzahlen haben.

· Abschaffung der Energie-Einsparverordnung EnEV und des Erneuerbare-Energien- Wärme-Gesetzes EEWärmeG.

Mit der Abschaffung insbesondere des EEG können auch die folgenden gesetzlichen Maßnahmen entfallen, die nur Reparaturversuche für die durch das EEG angerichteten Probleme und Schäden darstellen:

· Die Offshore-Haftungsumlage nach §19 EnWG

· Die Kraftwerksreserveverordnung

· Die Umlage nach §19 Abs.2 StromNEV (Ausgleich für Netzentgeltbefreiungen stromintensiver Unternehmen)

· Die Umlage für abschaltbare Lasten nach §18 AbLaV (zur Deckung von Kosten abschaltbarer Lasten zur Aufrechterhaltung der Netz- und Systemsicherheit

· Die Stromsteuer („Ökosteuer“), die der „Förderung klimapolitischer Ziele“ und interessanterweise auch (oder gerade) zur Absenkung und Stabilisierung des Rentenbeitragssatzes dienen sollte, ist um den Teil zu kürzen, der tatsächlich für „klimapolitische Ziele“ verwendet, also verschwendet wird.

· Die Mehrwertsteuer darf nicht mehr auch auf alle Umlagen und Abgaben, die den Strompreis betreffen, erhoben werden, da dies eine Doppelbesteuerung darstellt.

· Das Treibhausgas-Emissionshandels-Gesetz TEGH, das in Deutschland die gesetzliche Grundlage für den Handel mit Berechtigungen zur Emission von Treibhausgasen in einem gemeinschaftlichen Emissionshandels-System bildet, ist abzuschaffen, weil es fast ausschließlich um den Zertifikate-Handel für CO2–Emissionen geht. Die Begründung für dieses Gesetz ist entfallen, da der Klimawandel allenfalls in geringfügigem Maße durch CO2 beeinflusst wird.

· Das Energie-Wirtschafts-Gesetz (EnWG) und die Messstellen-Zugangs-Verordnung von 2008 dürfen nicht zwecks Einführungspflicht für Smart Meter in Bestandsgebäude geändert werden.

Diese Auflistung ist zum Zeitpunkt dieser Veröffentlichung vermutlich bereits wieder unvollständig. Es sollte sichergestellt werden, dass alle Gesetze und Verordnungen, die im Zusammenhang mit Energiewende und EEG erlassen worden sind, ebenfalls abgeschafft werden müssen.

Das generelle Ziel aller vorgeschlagenen Maßnahmen ist deshalb die Wiederherstellung einer Energiewirtschaft, die wieder durch die Regeln der Marktwirtschaft gekennzeichnet ist und in der Wirtschaftlichkeit und Versorgungssicherheit, die von den vergangenen drei Regierungen vernachlässigt worden sind, wieder im Vordergrund stehen.

Wird fortgesetzt.

Das komplette Manifest kann als pdf im Anhang heruntergeladen werden.

Related Files