Zur Verweildauer von CO2: Henne oder Ei?

1

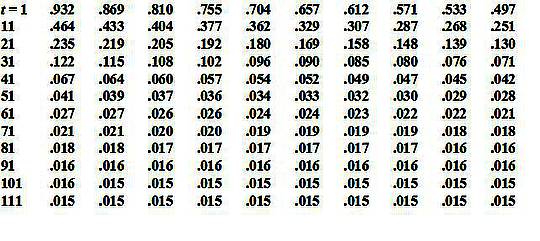

Abbildung 1 (rechts): Die Abnahme von C14 nach dem Ende der Kernwaffentests im Jahre 1963, zusammengetragen aus europäischen Aufzeichnungen von Gösta Persson.*

[*Hinweis: Die Schreibweise von C14 und anderer Isotope im Original ist:

![]()

Im Texteditor der EIKE-Website lässt sich das in dieser Schreibweise jedoch nicht darstellen. Gleiches gilt für alle anderen Isotopen-Bezeichnungen in diesem Beitrag. A. d. Übers.]

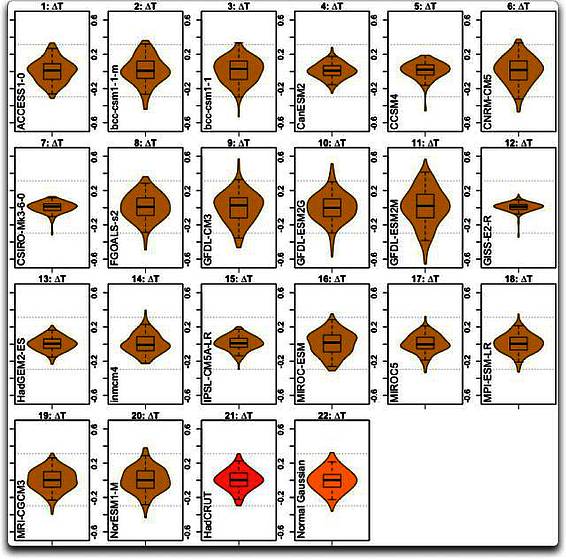

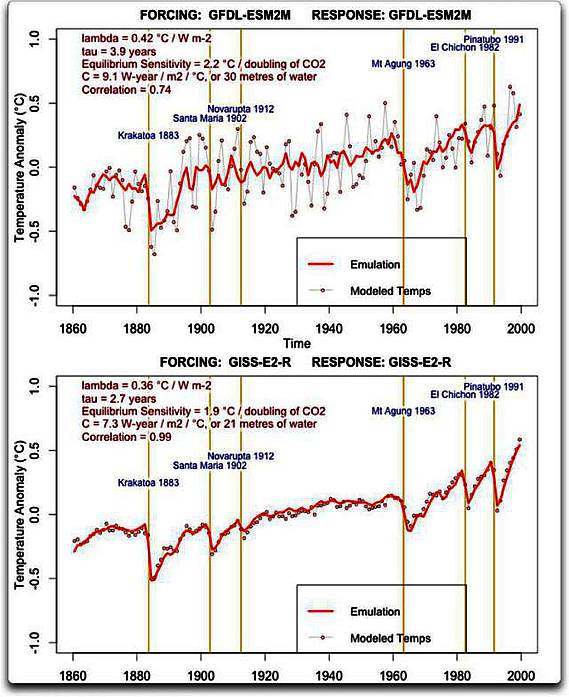

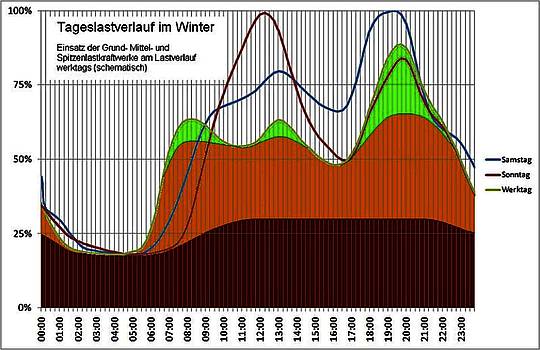

Das 1963 zu Ende gegangene Programm mit Kernwaffentests in der Atmosphäre hat die Konzentration von C14O2 verdoppelt im Vergleich zur kosmogenischen Grundlinie [= kosmische Hintergrundstrahlung?]. Allerdings ist nach dem Stopp die Hälfte des in der Atmosphäre übrig gebliebenen C14 innerhalb von 10 Jahren verschwunden. Nach 50 Jahren war fast alles verschwunden. Warum sollten die anderen CO2-Isotope nicht genauso schnell verschwinden?

In Kommentaren zu meinem letzten Beitrag sagt Mr. Born, dass die Verweildauer von CO2 keinen Einfluss auf dessen atmosphärische Konzentration hat: „Es geht nicht darum, über welches Kohlenstoffisotop wir reden. Es geht um den Unterschied zwischen der CO2-Konzentration und der Verweildauer eines typischen CO2-Moleküls oder welches Isotop auch immer in der Atmosphäre. Die Bombentests, die einige CO2-Moleküle angeregt haben, zeigten uns Letzteres, und ich habe keinen Grund für die Annahme, dass sich die Verweildauer irgendwelcher Isotope davon sehr unterscheidet“.

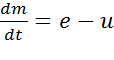

Weiter nimmt er an, dass die CO2-Konzentration unabhängig von der Verweildauer ist, also:

![]()

(1).

Setzen wir jetzt CO2 in der Atmosphäre frei, und zwar aus allen Quellen mit einer Rate von e = e12 + e14 und daraus wieder entfernt mit einer Rate u. Dann wird die Massenänderung von CO2 mit der Zeit durch Gleichung 2 beschrieben:

(2),

die besagt, dass die Gesamtmasse m des CO2 und damit der Konzentration mit der Gesamtemission variiert, welche die Differenz zwischen den Raten aus der Quelle e und der Senke u ist.

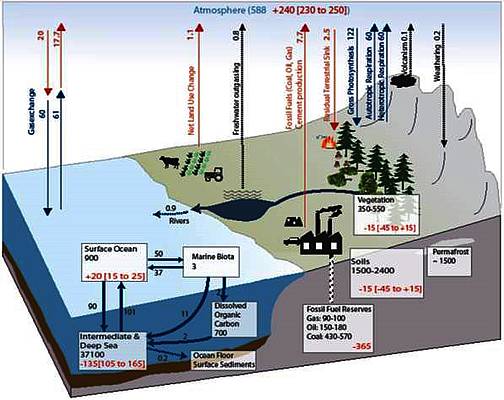

Beispiel: falls e = u ist, bleibt die Gesamtmasse m unverändert, selbst wenn einige individuelle Moleküle lange Zeit in der Luft verbleiben. Auch gilt: wenn e > u, dann wird m steigen, bis e = u. Solange danach nicht u > e wird, glaubt er, dass die Masse m unbegrenzt erhöht bleibt. Im Gegensatz dazu, sagt er, ist die Änderungsrate der Masse von C14O2 gegeben durch die Gleichung 3:

(3),

die uns seiner Ansicht nach sagt, dass selbst wenn e und u gleich bleiben, so dass die Gesamt-CO2-Konzentration konstant bleibt, die darüber hinaus gehende C14O2-Konzentration durch Gleichung 4 beschrieben wird:

![]()

(4),

welche den Unterschied beschreibt zwischen der (ursprünglich angehobenen) C14O2-Konzentration und der kosmogenischen Grundlinie der C14O2-Konzentration zuvor. Die darüber hinaus gehende C14O2-Konzentration würde also immer noch abnehmen, und zwar mit einer Zeitkonstante m/u, welche uns daher sagt, wie lange die CO2-Konzentration auf einem höheren Niveau verharren würde, auf das jene zuvor durch verstärkte Emissionen gehoben worden ist. In diesem Szenario bleibt die Konzentration beispielsweise für immer erhöht, selbst wenn x abnimmt. Mr. Born schließt daraus, dass die Abnahmerate x die Änderungsrate [turnover rate] von CO2 in der Luft beschreibt, aber nichts darüber aussagt, wie schnell sich die Aufnahmerate u an gesteigerte Emissionen anpassen wird.

Andererseits, wenn man Prof. Pettersson zusammenfasst, tendieren reversible Reaktionen zu einem Gleichgewicht, definiert durch die Konstante k. Emissionen in ein Reservoir stören dieses Gleichgewicht, worauf das überschüssige x aus dem Reservoir hinaus gedrängt wird, wodurch sich mit der Zeit erneut ein Gleichgewicht einstellt. Wo µ die Raten-Konstante der Abnahme ist, die reziprok der Verdrängungszeit ist, gibt Gleichung 5 den Anteil von x, der im Reservoir zu jeder Zeit t verbleibt, wo e, hier einheitlich, im Exponent steht:

![]()

(5).

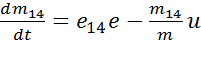

Die jüngsten Schätzungen des IPCC der vorindustriellen Grundlinie des Kohlenstoff-Reservoirs betragen 600 PgC in der Atmosphäre, 2000 PcG in der Biosphäre und 38.000 PgC in der Hydrosphäre. Entsprechend beträgt die Gleichgewichtskonstante k, äquivalent mit dem vorindustriellen Verhältnis des Kohlenstoffgehaltes von Atmosphäre einerseits sowie Biosphäre und Hydrosphäre andererseits, 600 / (2000 + 38,000) oder 0,015, so dass 1,5% jedes überschüssigen x, dass der Mensch oder die Natur in die Atmosphäre entlässt, unbegrenzt in der Luft verbleiben werden.

Empirisch hat Pettersson den Wert der Abnahme-Ratenkonstante µ mit ~0,07 ermittelt, was eine Verdrängungszeit 1/µ von ~14 Jahren zeigt, entsprechend der roten, an die Daten angepassten Kurve in Abbildung 1 oben rechts. Jährliche Werte des in der Luft verbleibenden Anteils dieses überschüssigen x mit der Zeit, von mir mittels Gleichung 5 ermittelt, zeigt Tabelle 1.

Abbildung 2: Der globale Kohlenstoff-Zyklus. Die Zahlen zeigen die Größe der Reservoire in PgC und die Kohlenstoff-Austauschflüsse in PgC pro Jahr. Dunkelblaue Zahlen und Pfeile kennzeichnen geschätzte vorindustrielle Reservoir-Größen und natürliche Flüsse. Rote Pfeile und Zahlen kennzeichnen Flüsse gemittelt über den Zeitraum 2000 bis 2009, die sich aus CO2-Emissionen durch Verbrennung fossiler Treibstoffe, Zementproduktion und Landverbrauch ergeben. Rote Zahlen in den Reservoiren kennzeichnen kumulative Änderungen des Industriezeitalters von 1750 bis 2011. Quelle: IPCC (2013), Abbildung 6.1).

Tabelle 1: Jährliche Anteile des überschüssigen, in der Luft verbleibenden x von C14O2 in einem gegebenen Jahr t im Anschluss an den Verlauf nach den Bombentests, berechnet mit Gleichung 5. Es zeigt sich ein Verbleib der Hälfte von C14 von ~10 Jahren. Wie erwartet nehmen die jährlichen Anteile nach 100 Jahren auf ein Minimum ab, das noch um 1,5% über der zuvor existiert habenden kosmogenischen Grundlinie liegt.

Nun wird sofort augenscheinlich, dass die Analyse von Prof. Pettersson unterschiedlich zu der des IPCC und zu der von Mr. Born ist, und zwar in vielerlei Hinsicht. Wer hat recht?

Mr. Born bietet eine elegante Analogie an:

„Man nehme eine Quelle an, die eine Flüssigkeit F1 mit 1 l pro Minute in ein Reservoir emittiert, das bereits 15,53 l von F1 enthält. Gleichzeitig nehme eine Senke 1 l pro Minute des Inhalts des Reservoirs auf. Der Inhalt bleibt konstant bei 15,53 l.

Jetzt ändere man die Quelle auf eine andere Flüssigkeit F2, immer noch mit einem Ausfluss von 1 l pro Minute und ideal mit F1 vermischt. Sie soll auch die gleiche Dichte und die gleichen Fließeigenschaften aufweisen. Nach 50 Minuten werden 96% von F1 das Reservoir verlassen haben, aber dieses wird immer noch 15,53 l enthalten.

Als nächstes füge man zusätzlich 1 l der Flüssigkeit F2 zu, was den Inhalt des Reservoirs auf 16,53 l steigen lässt. Was bedeutet die Abnahme um 96% innerhalb von 50 Minuten für die Geschwindigkeit, mit der sich der Inhalt des Reservoirs danach von 16,53 l ändert? Ich glaube, dass uns das gar nichts sagt. Es ist die Differenz zwischen Quell- und Sinkrate, die uns sagt, wie schnell sich das Flüssigkeitsvolumen im Reservoir ändert. Die oben beobachtete Rate, mit der sich der Inhalt ändert, sagt uns das nicht.

Das konzeptionelle Problem kann aus der Tatsache resultieren, dass die C14-Injektion so klingt, als ob sie parallel verläuft zum zweiten Schritt oben: er bestand aus der Hinzufügung eines Schwalls CO2 über zuvor bestehende Quellen. Aber diese hinzugefügte Menge war im Wesentlichen infinitesimal: Es gab keine messbare Änderung der CO2-Konzentration. Also änderte sich dadurch bloß die isotopische Zusammensetzung dieser Konzentration, nicht die Konzentration selbst.

Daher ist die C14-Injektion parallel zum ersten Schritt oben, während die jüngsten CO2-Emissionen der Menschen dem 2. Schritt entsprechen“.

Wie alle Analogien hinkt aber auch diese an bestimmten Punkten.

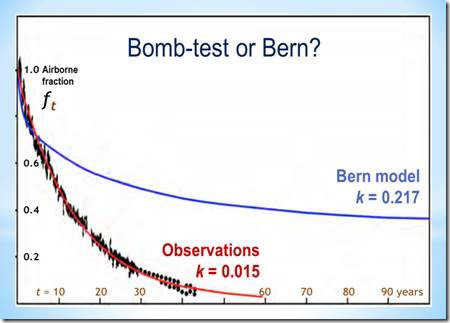

Abbildung 3: Vergleich zwischen den Abnahme-Kurven des in der Luft verbleibenden Anteils des überschüssigen x von CO2 über das Zeitintervall t in (1, 100) Jahren.

Wie Abbildung 3 zeigt, hat die Gleichgewichtskonstante k des Anteils der gesamten überschüssigen Konzentration von x, der unbegrenzt in der Luft verbleibt – wenn er groß genug ist – einen erheblichen Einfluss auf die Abnahme-Rate. Da Pettersson k = 0,15 als die Grundlinie des vorindustriellen Verhältnisses des Kohlenstoffgehaltes in der Atmosphäre, sowie in der Bio- und Hydrosphäre berechnet hat, ist die Abnahme-Kurve nahe einer Standard-Exponentialkurve, und zwar so, dass k in Gleichung 5 gleich Null ist. Allerdings ist der Verlauf der Abnahme-Kurve am Punkt 0,217, der im Bern-Klimamodell angenommen wird und auf dem alle anderen Modelle beruhen, markant verändert durch die ungerechtfertigt erhöhte Gleichgewichtskonstante.

Schon aus diesem Grunde allein würde man erwarten, dass das CO2 kürzer in der Atmosphäre verbleibt als das Bern-Modell und die darauf beruhenden Modellen annehmen. Nach Mr. Borns eigener Analogie: falls irgendeine gegebene Menge Flüssigkeit in einen Container gegossen wird, verbleibt sie dort kürzere Zeit, als sie es sonst getan hätte (kurz gesagt, falls die Flüssigkeit schneller den Weg aus dem Container findet als die festgesetzte Rate, die seine Analogie nahelegt), dann wird es weniger Flüssigkeit in dem Container geben.

Anders, als es Mr. Born über den Inhalt des Reservoirs in seiner Analogie beschrieben hat, wird der Anteil des in der Luft verbleibenden Überschusses am Ende der Abnahme-Kurve unabhängig sein von der Emissionsrate e und der Sinkrate u.

Da die Analogie am Ende des Prozesses versagt und daher bis zu einem gewissen Grad auch während des Prozesses – versagt sie dann auch bei der Frage, ob die Änderungsrate des Inhalts des Reservoirs e minus u ist, wie es Mr. Born im Gegensatz zu dem sagt, was Pettersson in Gleichung 5 zeigt?

Schauen wir, was Skeptical Science zu dem schreibt, was Soziologen eine „negative Referenz-Gruppe“ nennen – eine Bezeichnung dafür, dass das Einzige, worauf man sich verlassen kann ist, dass sie in fast allem unrecht hat. Die Schuljungen an der University of Queensland, die sich darüber wirklich schämen sollten, fürchteten Prof. Salbys Annahme, dass die Temperaturänderung, nicht der Mensch, der wesentliche Bestimmer der CO2-Konzentrations-Änderung ist.

Sie trachteten danach, seinen Gedanken zu verwerfen, und zwar mit der üblichen üblen Masche mit der höhnischen Bemerkung, dass die Änderung der CO2-Konzentration gleich ist der Summe der anthropogenen plus der natürlichen Emissionen. Da es keine nennenswerte anthropogene CO2-Aufnahme gibt, haben sie das folgende mickrige Gleichung-chen ersonnen:

![]()

(6)

Diese Kindischen [kiddiwinks] sagen, dass die Änderung der CO2-Konzentration gleich ist der Summe anthropogener plus natürlicher Emissionen minus der natürlichen Aufnahme. Sie fügen hinzu, dass wir jedes Jahr die Zunahme der CO2-Konzentration messen können (gleich der Gesamtemission), und wir können zuverlässig die anthropogenen Emissionen aus dem globalen jährlichen Verbrauch fossiler Treibstoffe ableiten. Die Umformung von Gleichung 6 ergibt Gleichung 7:

![]()

(7)

Da die beobachtete e ≈ 2ΔCO2 ist, sagen sie, dass die natürliche Welt auf der linken Seite von Gleichung 7 zwangsläufig insgesamt eine CO2-Senke ist, keine Quelle, wie sie Prof. Salby glaubten verstanden zu haben. Aber sein Gedankengang war hier wie überall sonst viel subtiler, als sie erfassen können.

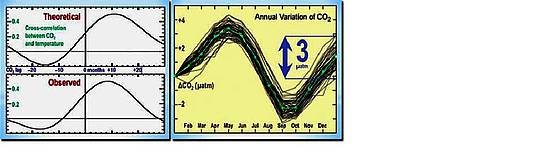

Prof. Salby, der mit Hilfe von sorgfältigen Über-Kreuz-Korrelationen über alle Zeitperioden – selbst kurzen (Abbildung 4 links) – gezeigt hat, dass die CO2-Konzentrations-Änderung einer Temperaturänderung hinterher läuft, hat dies in den Mauna Loa-Aufzeichnungen gezeigt, falls man diese mit einer höheren Auflösung untersucht als die, die gewöhnlich verwendet wird (Abbildung 4 rechts). Es gibt eine Variation von 3 µatm von Jahr zu Jahr bei der jährlichen Erhöhung der CO2-Konzentration (= der Gesamtemission).

Abbildung 4: Links: CO2-Änderung hinkt hinterher und könnte durch eine Temperaturänderung ausgelöst worden sein.

Rechts: Die mittlere jährliche CO2-Zunahme beträgt 1,5 µatm, aber die Variabilität von Jahr zu Jahr ist doppelt so hoch.

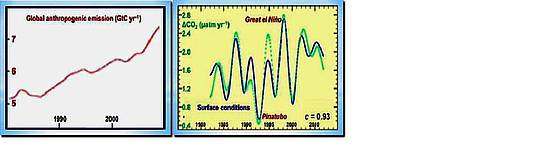

Die jährlichen Änderungen der anthropogenen CO2-Emissionen liegen nicht annähernd bei 3 µatm (Abbildung 5 links). Allerdings hat Prof. Salby entdeckt – und ich glaube, er war der Erste, der das entdeckt hat – dass die jährlichen Fluktuationen der Zunahme der CO2-Konzentration sehr eng mit jährlichen Fluktuationen der Bedingungen an der Erdoberfläche korrelieren.

Abbildung 5: Links: die globalen jährlichen anthropogenen CO2-Emissionen steigen nahezu monoton, und die jährlichen Differenzen sind klein.

Rechts: Ein Index der Bedingungen an der Oberfläche (blau: 80% Temperaturänderung, 20% Feuchtegehalt im Boden) korreliert eng mit Fluktuationen der CO2-Konzentration (grün).

Die jährlichen Fluktuationen anthropogener CO2-Emissionen sind gering, aber diejenigen der atmosphärischen CO2-Konzentration sind sehr viel größer. Prof. Salby schließt daraus, dass der wesentliche Grund dafür nicht der Mensch, sondern die Natur ist, und zwar über Änderungen der Temperatur. Zum Beispiel sagt Henrys Gesetz, dass ein kälterer Ozean mehr CO2 aufnehmen kann.

In diesem Gedanken liegt vielleicht der Ausgleich zwischen den Ansichten von Born und Pettersson, da die Quellen und Senken von CO2 nicht statisch sind, wie die Gleichungen und die Analogie von Mr. Born annehmen, sondern dynamisch. Man lasse die CO2-Konzentration zunehmen, und die Biosphäre reagiert mit einer gemessenen globalen Zunahme der Pflanzen-Produktivität. Der Planet wird grüner, wenn Bäume und Kräuter das Pflanzenfutter aufnehmen, das wir für sie emittieren.

Ganz ähnlich sieht es aus, wenn das Wetter deutlich wärmer wird, wie es kurze Zeit der Fall war während des Großen El Niño von 1997/1998. Dann werden die Ozeane kurze Zeit die doppelte Menge von CO2 emittieren. Aber falls es deutlich kühler wird, wie es in den Jahren 1991/1992 nach dem Ausbruch des Pinatubo der Fall war, geht die jährliche Gesamtakkumulation von CO2 in der Atmosphäre auf fast Null zurück, egal wie groß unsere anthropogenen Emissionen sind. Es ist daher möglich, dass die Senke Ozean mehr CO2 aufnimmt, als wir emittieren, da sich die Welt mit der fortgesetzten Abnahme der Sonnenaktivität abkühlt. Dies gilt selbst dann, wenn wir unsere Emissionen nicht reduzieren.

Interessanterweise arbeiten viele Gruppen daran, dies zu zeigen, genauso wie Prof. Salby jüngste Fluktuationen der CO2-Konzentration als Funktion des Zeitintegrals der Temperaturänderung erklären kann. Die Temperaturänderung wiederum kann erklärt werden als eine Funktion des Zeitintegrals der Variationen der Sonnenaktivität. Es ist die Sonne, Dummkopf!

Es ist eine Binsenweisheit, dass wir der Atmosphäre jedes Jahr neues CO2 zuführen, im Gegensatz zu den C14-Impulsen, die 1963 mit den Bombentests zu Ende gegangen waren. Allerdings zeigt die Kurve der Bombentests, dass fast alle CO2-Moleküle, die bequemerweise mit einem oder zwei zusätzlichen Neutronen in ihren Kernen markiert sind, innerhalb von 50 Jahren aus der Atmosphäre verschwunden sind.

Aus einem anderen Blickwinkel betrachtet: wenn wir heute jede CO2-Freisetzung in die Atmosphäre stoppen, wäre der in der Atmosphäre verbleibende Überschuss etwa 1,5% all dessen, was wir emittiert haben, und das ist alles. Mehr noch, dieser Wert lässt sich nicht nur theoretisch ableiten als Verhältnis der Inhalte des atmosphärischen Kohlenstoff-Reservoirs mit den aktiven Reservoirs von Hydro- und Biosphäre, sondern ist auch empirisch konsistent mit der beobachteten Kurve der Bombentests (Abbildung 1 oben rechts).

Falls das IPCC jedoch recht hätte, würde die CO2-Verweildauer in der Atmosphäre von 50 bis 200 Jahren für ein oder zwei weitere Jahrhunderte erheblich erhöhte Konzentrationen implizieren, weil es anderenfalls die Verweildauer nicht so an die große Glocke hängen würde. Die Verweildauer von CO2 in der Atmosphäre macht sehr wohl einen Unterschied für das Konzentrationsniveau in der Zukunft.

Machen wir die umgekehrte Beweisführung, indem wir annehmen, dass jedes von uns emittierte CO2-Molekül nur für den Bruchteil einer Sekunde in der Atmosphäre verbleibt. Dann wäre der Einfluss des anthropogenen CO2 auf die globale Temperatur vernachlässigbar, und Änderungen der CO2-Konzentration würden nahezu vollständig von natürlichen Einflüssen abhängen.

Die atmosphärische CO2-Konzentration akkumuliert sich in der Atmosphäre schon jetzt mit einer Rate, die weniger als halb so groß ist wie unsere Emissionen. Die Hälfte allen von uns emittierten CO2 scheint sofort aus der Atmosphäre zu verschwinden. Diese immer noch unerklärliche Diskrepanz, die das IPCC in seinen nicht ganz so unehrlichen Tagen als die „fehlende Senke“ bezeichnet hat, entspricht mehr oder weniger genau dem, was Prof. Pettersson gesagt hat, dass nämlich die Verweildauer von CO2 in der Atmosphäre wirklich so kurz ist, wie die Kurve der Bombentests zeigt, und nicht 50 bis 200 Jahre lang ist, wie es sich das IPCC vorstellt.

Und was hat das IPeCaC* über die Bombentest-Kurve zu sagen? Nicht viel:

„Weil das CO2 aus fossilen Treibstoffen frei von C14 ist, zeigt das Isotopen-Verhältnis C14/C des atmosphärischen CO2 aus Baumringen einen abnehmenden Trend (Levin et al 2010, Stuiver und Quay 1981) nach der massiven Einbringung von C14 in die Atmosphäre durch Kernwaffentests, die am Anfang jenes Signals der Abnahme stand“.

[*Das stand so im Original. Ich habe die Anspielung aber nicht verstanden. A. d. Übers.]

Und das ist schon alles, was sie dazu zusagen haben.

Hat Prof. Pettersson den Mechanismus beschrieben, der erklärt, warum Prof. Salby recht hat? Falls sich die Arbeit dieser beiden nach der Wahrheit Suchenden als verdienstvoll erweist, wäre das das Ende der Angst vor der globalen Erwärmung.

Kommentar von Prof. Lindzen, nachdem Prof. Salby ihm zum ersten Mal vor drei Jahren von seinen Ergebnissen erzählt hat: Da ein gegebener CO2-Exzess nur ein Drittel der vom IPCC behaupteten Erwärmung verursacht und falls nicht mehr als die Hälfte dieses CO2-Exzesses anthropogenen Ursprungs ist und falls es wesentlich kürzer in der Atmosphäre verbleibt als die Modelle sagen, gibt es kein Ziel mehr für die Klimaextremisten. Jede einzelne Komponente ihrer Theorie wäre zerschlagen.

Weil die Konsequenzen seiner Forschungen so potentiell bedeutend sind, habe ich diesen Vorgang hier sehr ausführlich beschrieben. Es ist nicht Sache eines neugierigen [fumblesome] Laien wie mich zu entscheiden, wo Prof. Pettersson und Prof. Salby (letzterer unterstützt durch Prof.Lindzen) recht haben. Oder hat Mr. Born recht?

Quid vobis videtur?

Link: http://wattsupwiththat.com/2013/11/21/on-co2-residence-times-the-chicken-or-the-egg/

Übersetzt von Chris Frey EIKE