Wo bleibt der Meeres-Anstieg ? Verlangsamung statt Beschleunigung !

Siehe auch Video zum Meeresspiegel in Kirbati, Tuvalu und anderen Inseln am Ende dieses Beitrages

(1) Neues von den Nordsee-Pegeln:

Keine säkulare Beschleunigung !

Im September 2013 ist in Earth-Science-Reviews eine Arbeit [6] erschienen, in der ein internationales Autoren-Team die Meeres-Spiegel-Trends von Nordsee-Pegeln auswertete.

Abbildung 1

Abbildung 1

Karte und Chronologie der Nordsee-Pegel [6]

Analysiert wurden rund um die Nordsee-Küsten die Aufzeichnungen von 30 Pegeln, von denen einige bis zu 200 Jahre zurück reichen, die Mehrzahl zumindest um die 100 Jahre – eine belastbare Daten-Basis.

Bei regionalen Untersuchungen und Aussagen zu Pegel-Trends wie hier in der Nordsee ist es wichtig, auch die isostatischen und eustatischen Trends der Küsten-Regionen einzubeziehen, um die absoluten Trends (AMSL) von den relativen Trends (RMSL) zu unterscheiden. Dieses wurde in der Studie berücksichtigt: "Furthermore, advanced models and geodetic techniques now allow a more accurate separation of AMSL and RMSL changes." Auf verbleibende Unsicherheiten wird dabei hingewiesen.

Das zusammengefaßte Ergebnis:

"The long-term geocentric mean sea level trend for the 1900 to 2011 period is estimated to be 1.5 ± 0.1 mm/yr for the entire North Sea region." Folglich: Der aktuelle Trend beträgt 15 cm in 100 Jahren.

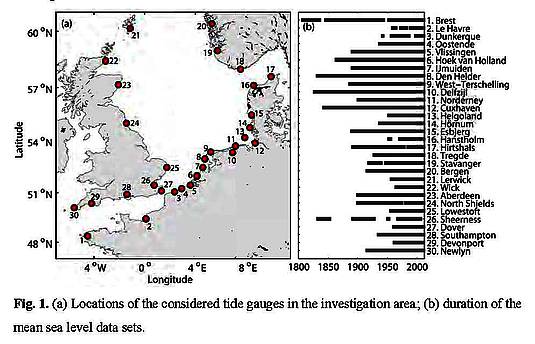

Abbildung 2

Säkulare Registrierungen der Nordsee-Pegel [6]

Abbildung 3

Abbildung 3

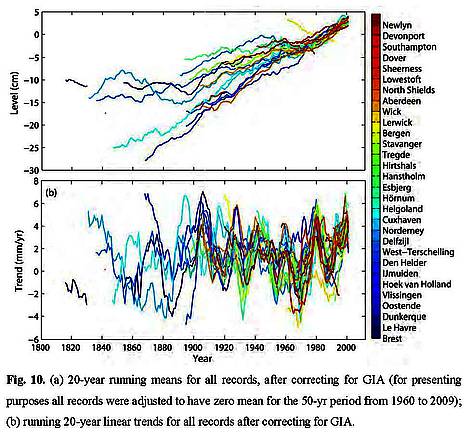

Pegel-Registrierungen: Vergleich von Nordsee und Weltmeeren [6]

Die Abbildung 3 zeigt:

"Long-term sea level trends in the North Sea are similar to global long-term trends …".

….u n d etwas differenzierter:

"In summary the long term trends in the North Sea are not significantly different from global sea level trends, while the inter-annual and decadal variability are much bigger in the North Sea and hardly comparable to those derived from the global sea level reconstruction considered here."

Mit anderen Worten:

Die Variationen der Pegel über Jahre und Dekaden sind in der Nordsee größer als auf den Welt-Meeren, aber der Trend unterscheidet sich nicht: Weder die Anstiegsraten noch der Anstieg selber zeigen eine Beschleunigung.

Für die alarmistischen Meeres-Szenarien im Rahmen der Klima-Debatte ist das Ergebnis nahezu ein Desaster, denn es wird festgestellt, daß es überhaupt keinen Trend zu einer Beschleunigung des Anstieges gibt, weder säkular noch in den letzten Dekaden:

"The recent rates of sea level rise (i.e. over the last two to three decades) are high compared to the long-term average, but are comparable to those which have been observed at other times in the late 19th and 20th century."

Folglich: Es gibt Variationen, aber keine säkulare Beschleunigung !!!

Desweiteren werden in der hier besprochenen Arbeit verschiedene mögliche Ursachen für die säkularen Variationen des Meeresspiegels diskutiert, wie z.B. meteorologische Effekte, variable Meeres-Ströme, eine "quasi 60-year-oscillation in global mean sea level" – aber abschließend heißt es: "However, the question what are the driving factors of such fluctuations remains unanswered."

Dabei bleiben für AGW-Klima-Spekulationen "Räume", aber keine Beweise, noch nicht einmal Korrelationen.

Die Ergebnisse stehen in völliger Übereinstimmung mit früheren Studien zu den Nordsee-Pegel, z.B. (nachzitiert a.a.O.):

"The last detailed regional study was by Shennan and Woodworth [7]. They used tide gauge and geological data from sites around the North Sea to infer 20th century and late Holocene secular trends in MSL. They concluded that a systematic offset of 1.0 ± 0.15 mm/yr in the tide gauge trends compared to those derived from the geological data could be interpreted as the regional geocentric rate of MSL change in the 20th century. They also constructed a sea level index to represent the coherent part of sea level variability in the region and found no evidence for a statistically significant acceleration in the rates of SLR over the 20th century. These results were in agreement with those of Woodworth (1990), who found a significant acceleration in the order of 0.4 mm/yr per century when focusing on time scales longer than a century (up to 300 years) but not for the 20th century.

Mit anderen Worten:

Wenn es überhaupt eine Beschleunigung gab, dann in früheren Jahrhunderten, jedoch nicht in der Zeit des 20. Jahrhunderts, in welcher der angeblich anthropogen verursachte Klima-Wandel begonnen haben soll ! Eine Klatsche für die Alarmisten!

Die Federführung des internationalen Autoren-Teams um Thomas Wahl lag bei der Universität Siegen, die dazu im Juli 2013 eine Presse-Mitteilung heraus gab [8]. Darin redet der Projekt-Leiter der Arbeit, Prof. Dr. Jürgen Jensen, Leiter des Forschungsinstituts Wasser und Umwelt (fwu) im Department Bauingenieurwesen an der Universität Siegen, Klartext:

"Es gibt ein relativ konstantes Anstiegsverhalten des Mittleren Meeres-Spiegels seit Beginn des 20. Jahrhunderts, aber keinen außergewöhnlichen Anstieg in den letzten Jahrzehnten, den wir direkt dem Klimawandel zuschreiben könnten.“

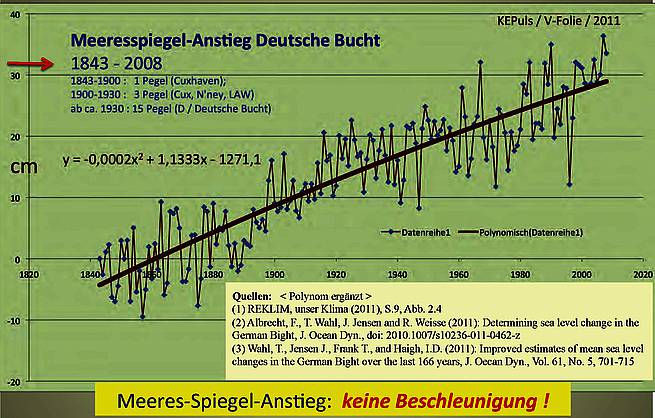

(2) Pegel in der Deutschen Bucht

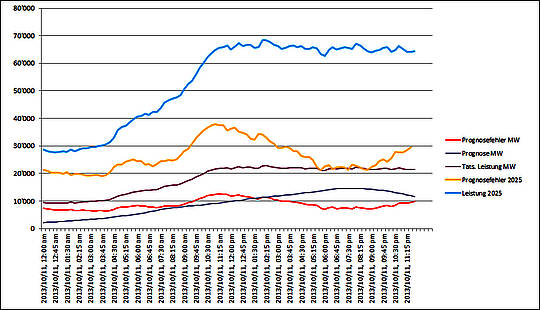

Schon 2011 sind von WAHL [9] et al. Auswertungen von Nordsee-Pegeln publiziert worden, und zwar für die Deutsche Bucht (Abb. 4) :

Abbildung 4

Abbildung 4

Auswertung von Küsten-Pegeln in der Deutschen Bucht (Daten [9])

Auch in dieser Auswertung ergibt sich:

Es wird in den zum Teil bis 160 Jahre zurück reichenden Pegeln keine Beschleunigung des Meeres-Anstieges beobachtet, eher eine leichte Abschwächung, wie das Polynom beweist.

(3) Globale Messungen

Auswertungen und Zusammenstellungen globaler langer Pegel-Messungen zeigen immer wieder das gleiche Ergebnis [10]:

"Die verfügbaren Pegel zeigen global im 20. Jahrhundert einen Anstieg von etwa 16 bis 18 cm, deutlich weniger als in den Jahrhunderten davor. Eine Beschleunigung des Anstieges ist nicht erkennbar, bei der überwiegenden Zahl der Auswertungen zeigt sich eher eine Abschwächung. Ein anthropogenes Signal des Meeresspiegel-Anstieges ist nicht zu finden!"

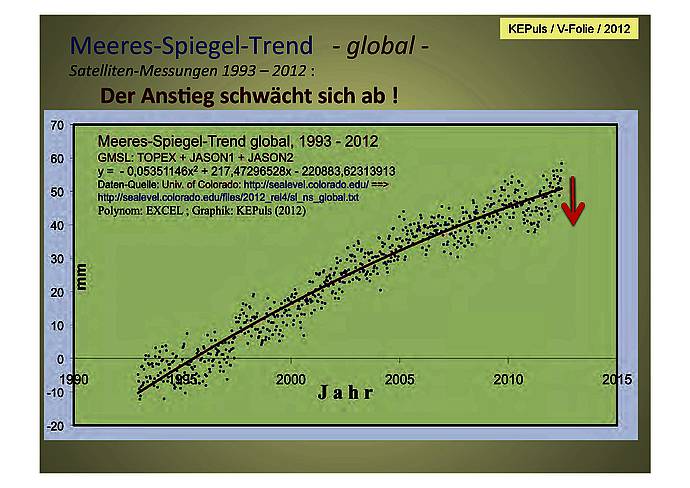

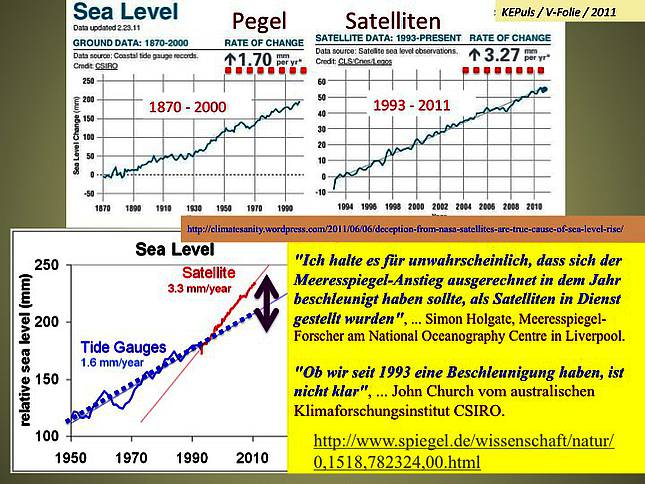

Seit etwa 20 Jahren wird der Meeres-Anstieg von Satelliten aus mit Altimetern gemessen:

Abbildung 5

Auswertung von Satelliten-Altimetern ; Daten: [11]

Selbst in diesen zwei jüngsten Dekaden ist keine Beschleunigung zu erkennen, sondern eine Abschwächung (Abb. 5).

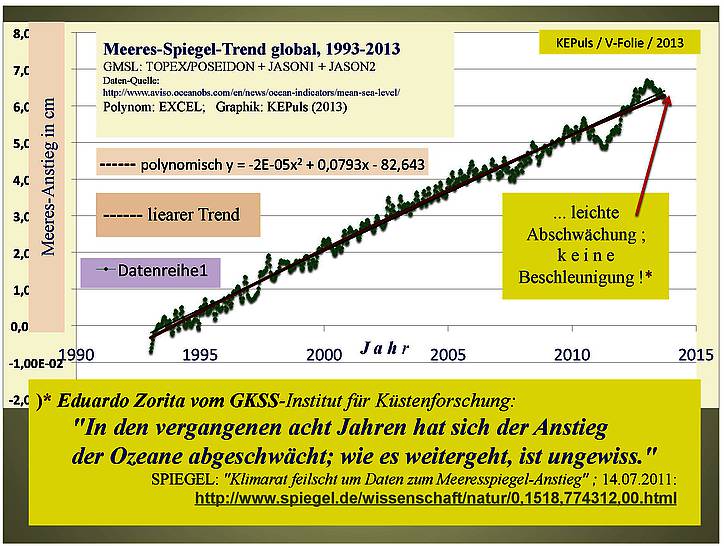

Zum gleichen Ergebnis kommt eine andere Auswertung (Abb. 6):

Abbildung 6

Auswertung von Satelliten-Altimetern ; Daten: [12]

Dazu werden international renommierte Institute zitiert [13]:

"Die höheren Anstiegsraten seit 1993 seien nichts Außergewöhnliches, meint Guy Wöppelmann von der Université de La Rochelle in Frankreich. Im 20. Jahrhundert habe sich der Meeresspiegel-Anstieg zuvor schon mal ähnlich beschleunigt; doch dann verlangsamte er sich wieder. Ähnliches geschehe nun wieder, sagt Eduardo Zorita vom GKSS-Institut für Küstenforschung:

In den vergangenen acht Jahren habe sich der Anstieg der Ozeane abgeschwächt; wie es weitergehe, sei ungewiss."

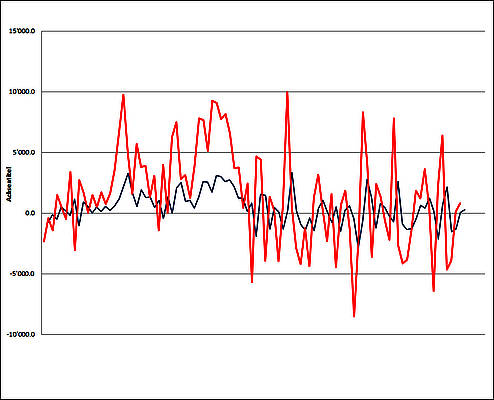

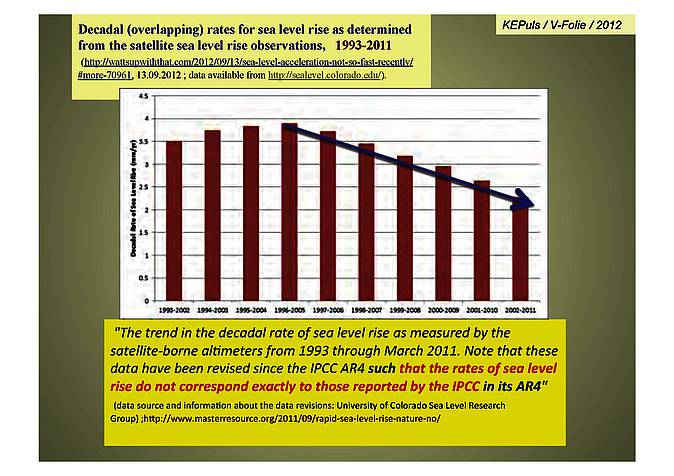

Noch deutlicher wird die "Entschleunigung" des Meeres-Anstieges in jüngerer Zeit, wenn man – zeitlich aufeinander folgend und übergreifend gemittelt – die Anstiegsraten betrachtet (Abb. 7) :

Abbildung 7

Anstiegs-Raten 1993-2011 [14]

(4) GRACE-Satelliten bestätigen Pegel-Messungen

Schwerkraft-Messungen mit Satelliten [15] bestätigen die Pegel-Messungen:

"Eine neue Studie, erstellt mit den GRACE-Daten (Gravity Recovery And Climate Experiment) zeigt, dass der Meeresspiegel während der letzten 9 Jahre mit einer Rate von nur 1,7 mm pro Jahr gestiegen ist. Das ergibt ein Äquivalent von 6,7 Inches (fast 17 cm) pro Jahrhundert. Dies passt gut zu Messungen an Pegeln. Die Studie bestätigt das Sea-Level-Budget von NOAA 2012 [16], dem zufolge der Meeresspiegel nur um 1,1 bis 1,3 mm pro Jahr während der vergangenen 7 Jahre von 2005 bis 2012 gestiegen ist. Sie bestätigt auch die Ergebnisse einer Studie von Chambers et al. [17], dass nämlich "der Meeresspiegel im Mittel während der letzten 110 Jahre um 1,7 mm pro Jahr gestiegen ist“.

(5) Satelliten-Daten TOPEX+JASON

versus Pegel-Messungen

Die weltweiten Pegel-Messungen (Abb. 2 – 7 ; und weitere [18]) sowie die Schwerkraft-Messungen (GRACE) zeigen einen mittleren jährlichen Anstieg von 1,5 – 1,7 mm pro Jahr, also säkular 15-17 cm.

Demgegenüber ergeben die Satelliten-Daten mit 3,2 mm pro Jahr (Abb.8) nahezu doppelt so hohe Werte.

Das ist widersprüchlich und grotesk. Untersuchungen dazu kommen zu diesem Ergebnis [19]:

"Dabei ging er insbesondere der Frage nach, warum Pegelmessungen nur einen Anstiegswert von etwa 2,0 mm pro Jahr oder weniger zeigen (…), während Satellitendaten mit 2,8 mm/Jahr fast einen Millimeter höhere Wert anzeigen. Homewood überprüfte dazu eine Reihe von Küstenpegelmessungen und kam zu folgendem Ergebnis:

„Meine Analyse ergab keinen Hinweis auf eine kürzliche Beschleunigung der langjährigen Meeresspiegel-Anstiegsrate. Die Anstiegsrate beträgt noch immer 2 mm pro Jahr oder sogar weniger.".

Und an anderer Stelle [20]:

"…wurden an den Küsten der Erde Messlatten eingerammt (Anm.: Pegel) , die seit vielen Jahrzehnten regelmäßig abgelesen werden. Die Daten sprechen eine klare Sprache. Seit mehr als 50 Jahren steigt der Meeresspiegel im globalen Durchschnitt um knapp 2 mm pro Jahr an. Eine Beschleunigung dieses Anstiegs ist jedoch nicht verzeichnet worden, trotz der jetzt um einige Zehntelgrade höheren Temperaturen."

Es gibt aber noch einen anderen Aspekt zu den "seltsamen" systematischen Unterschieden zwischen den Satelliten-Messungen (ca. 3 mm/Jahr) und den globalen Pegel-Messungen (unter 2 mm/Jahr) :

Die Satelliten-Daten wurden mehrfach "nach oben hin korrigiert", nachdem diese Daten ab 1992 und auch noch später zunächst sogar niedrigere Werte anzeigten als die globalen Pegel.

In einer Untersuchung dazu [21] heißt es:

"Der “Environmental Satellite” (Envisat) ist so etwas wie das Prunkstück der European Space Agency (ESA). … Der von Envisat gemessene Anstieg des Meeresspiegels betrug im Zeitraum von Ende 2003 bis Ende 2011 lediglich 0,48 mm/Jahr, was 4,8 cm in 100 Jahren entsprechen würde. Die Messungen des Jason-1 Satelliten haben für den gleichen Zeitraum einen Anstieg von 2,05 mm pro Jahr gefunden. Um diesem Umstand zu begegnen wurden bei der ESA bereits im letzten Jahr Methoden diskutiert, wie man die Envisat Daten rechnerisch an die Ergebnisse der Messungen der Jason Satelliten angleichen kann. Diese Anpassung wurde jetzt beim Umstellen auf die neueste Version der Envisat Daten (Version 2.1) offensichtlich vorgenommen. Aus dem bisherigen minimalen Anstieg von 0,48 mm/Jahr wurde dadurch quasi über Nacht ein Anstieg von 2,32 mm/Jahr …

Anpassungen dieser Art sind in der noch jungen Geschichte der Satelliten-Altimetrie nichts Ungewöhnliches. Wobei man sich im jeweiligen Fall durchaus die Frage stellen muss, ob die vorgenommenen Korrekturen nun die Wirklichkeit besser widerspiegeln, oder ob sie vorgenommen werden, damit die Ergebnisse besser zu einer vorgefertigten Meinung passen."

Eine andere Recherche kommt zu diesem Ergebnis [22]:

"Wenn man die Entwicklung der Trends bei den Satellitendaten in den letzten 10 Jahren betrachtet, dann drängt sich einem der Eindruck auf, es soll nach Kräften verhindert werden, dass die publizierten Daten unter einen Wert fallen, der dann nicht mehr als besorgniserregend wahrgenommen würde.

Kaum anders ist es zu erklären, dass die Satellitenmessungen der University of Colorado trotz des seit mittlerweile fast 7 Jahre andauernden Rückgangs des Anstiegs unvermindert hohe Werte von über 3 mm Anstieg pro Jahr angeben. Und auch die aktuell bei den Daten des europäischen Envisat-Projektes vorgenommenen Korrekturen folgen nicht nur dem altbekannten Schema, dass diese Maßnahmen ausnahmslos in eine Richtung weisen, und zwar zu höheren Werten. Auch die Begründung, welche die Wissenschaftler anbieten trägt mehr zur Verschleierung bei, als dazu aufzuklären, warum ein so fundamentaler Eingriff in die Daten vorgenommen werden musste.

Was bleibt ist der Eindruck, dass hier Daten systematisch “schöngerechnet” werden. Schließlich steht der nächste Zustandsbericht des Weltklimarates (IPCC) für das Jahr 2014 an. Und dieser kann seine volle Wirkung nur entfalten, wenn alles sich noch viel schlimmer darstellt, als man im letzten Report 2007 bereits gesichert wusste. Ein seit Jahren langsamer werdender Anstieg des Meeresspiegels wäre hierzu ganz sicher nicht hilfreich."

In einer Graphik lässt sich das so zusammen fassen (Abb. 8) :

Abbildung 8

Messungen von globalen Küsten-Pegeln gegenüber Satelliten

([23] ;Textfelder ergänzt)

Die erhebliche Diskrepanz zwischen Sat-Daten und Pegeln ist bis heute u.E. nicht geklärt [24]:

"Trotz der neuen Satellitenmessungen wurden die Pegelmessungen natürlich weitergeführt. Und die ließen sich nicht beirren und blieben stur bei ihrem alten Kurs von deutlich unter 2 mm/Jahr. Anstatt die Satellitendaten nun an die real am Boden gemessenen Daten anzupassen und nach unten zu korrigieren, besteht die Diskrepanz zwischen Pegel- und Satellitenmessungen aber leider bis heute weiter. Und es scheint irgendwie auch niemanden zu stören. Ein mysteriöser Fall."

(6) SPIEGEL: "Feilschen wie auf dem Basar"

Bemerkenswert ist u.E. noch, was DER SPIEGEL [25] unter dem Titel "Klimarat feilscht um Daten zum Meeresspiegel-Anstieg" über die Art und Weise der "Entstehung" von Meeres-Spiegel-Prognosen beim IPCC von einer diesbezüglichen Tagung der Meeresspiegel-Forscher (Juli 2011) berichtet :

"Viele Milliarden Euro stehen auf dem Spiel: Ein Uno-Gremium entscheidet über die Prognose zum Anstieg der Ozeane – sie bestimmt, wie viel Steuergeld die Staaten in den Küstenschutz pumpen müssen. Hunderte Studien werden verhandelt, es geht zu wie auf einem Basar."

Und weiter a.a.O. :

"Das Feilschen um die Ergebnisse gleicht dem Handel auf einem Basar:

Auf der einen Seite haben Forscher alarmierende Meeresspiegel-Prognosen veröffentlicht, die die Angaben des letzten Uno-Klimareports weit übertreffen.

Demgegenüber stehen tatsächliche Messungen des Meeresspiegels: Sie lassen bislang keinen extremen Anstieg erkennen." … "4000 Experten diskutierten auf der IUGG-Tagung von Ozeanforschern im australischen Melbourne ihre Ergebnisse. Mitunter lautet dabei die Maxime: "Wer bietet mehr?" …"Der Klimaforscher James Hansen von der Nasa zum Beispiel warnt in einem aktuellen Papier vor einem Anstieg der Meere um fünf Meter in den nächsten 90 Jahren – er verneunfacht damit die Schätzung des Höchstszenarios aus dem letzten Uno-Klimareport. Der Nasa-Forscher riskiere mit der Extremprognose seine Glaubwürdigkeit, meinen manche Klimatologen."

Bei dieser Art von "BASAR" gibt es allerdings auch nüchterne sachliche Stimmen (a,a,O.):

"Die höheren Anstiegsraten seit 1993 seien nichts Außergewöhnliches, meint Guy Wöppelmann von der Université de La Rochelle in Frankreich. Im 20. Jahrhundert habe sich der Meeresspiegel-Anstieg zuvor schon mal ähnlich beschleunigt; doch dann verlangsamte er sich wieder. Ähnliches geschehe nun wieder, sagt Eduardo Zorita vom GKSS-Institut für Küstenforschung: In den vergangenen acht Jahren habe sich der Anstieg der Ozeane abgeschwächt; wie es weitergehe, sei ungewiss."

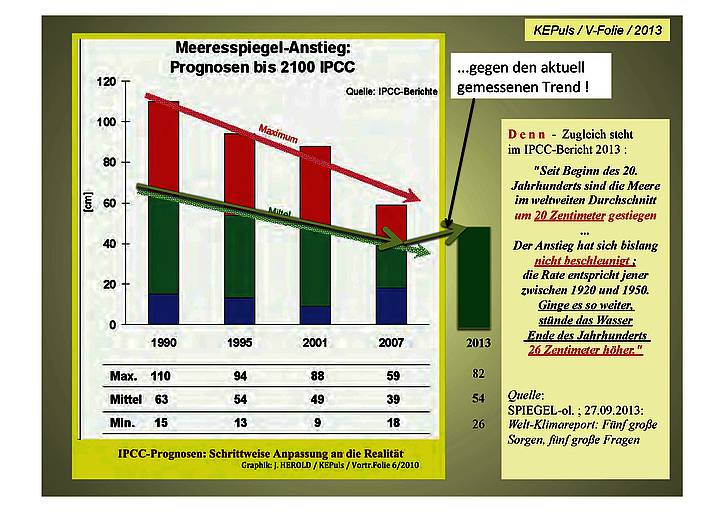

Dieses alles hat den Klimarat nicht davon abgebracht, gegen alle früheren und aktuellen Meßdaten nun im IPCC-Bericht 2013/14 eine weitere Beschleunigung des Meeres-Anstieges für die nächsten 100 Jahre zu prognostizieren, nachdem man in den Berichten davor Schritt um Schritt eine weitgehende Anpassung an die Meß-Realität vorgenommen hatte (Abb. 9) :

Abbildung 9

IPCC-Prognosen zum Meeres-Anstieg

(7) Vertrauens-Krise der IPCC-Institute

auch beim Meeres-Spiegel

Mit dem "Climate-Gate-Skandal" begann 2009 eine schwere Vertrauens-Krise [26] des IPCC, die bis heute anhält.

Dieser Vertrauens-Verlust in die IPCC-Prognosen zeigt sich immer wieder auch bei den von einigen Instituten verbreiteten Phantastereien zu gigantischen Meeresspiegel-Anstiegen, wovon DER SPIEGEL berichtet [27]:

"4000 Experten diskutierten auf der IUGG-Tagung von Ozeanforschern im australischen Melbourne ihre Ergebnisse. Mitunter lautet dabei die Maxime: "Wer bietet mehr?"

Der Klimaforscher James Hansen von der Nasa zum Beispiel warnt in einem aktuellen Papier vor einem Anstieg der Meere um fünf Meter in den nächsten 90 Jahren – er verneunfacht damit die Schätzung des Höchstszenarios aus dem letzten Uno-Klimareport. Der Nasa-Forscher riskiere mit der Extremprognose seine Glaubwürdigkeit, meinen manche Klimatologen."

…und weiter a.a.O.:

"Diese Woche eskalierte die Diskussion. Die Geoforscher Jim Houston vom Engineer Research Center in Vicksburg und Bob Dean von der University of Florida in Gainsville in den USA legten im Fachblatt "Journal of Coastal Research" überraschend dar, dass der Meeresspiegel während des vergangenen Jahrhunderts ziemlich gleichbleibend angestiegen sei – eine Beschleunigung sei nicht zu erkennen."

So kann es nicht verwundern, daß Planer beim Küstenschutz derartigen Prophezeiungen keinen Glauben mehr schenken. Daher werden auch Stefan Rahmstorf und das PIK mit derartigen Extrem-Prognosen zum Meeres-Spiegel international kaum noch ernst genommen [28]:

"Unter sorgfältiger Abwägung aller verfügbaren Informationen entschied der Senat von North Carolina im Juni 2012 mit 35 zu 12 Stimmen, dass bei Küstenschutzplanungen zukünftig mit der historisch gut dokumentierten Meeresspiegel-Anstiegsrate kalkuliert werden muss. Eine Beschleunigung wie sie von der Rahmstorf-Gruppe für die Zukunft postuliert wird, soll nicht eingerechnet werden. (Siehe Berichte auf junkscience, Climatewire, WUWT, John Droz Jr.).

Das Gesetz wurde Anfang Juli 2012 auch vom Repräsentantenhaus von North Carolina abgesegnet. … Die republikanische Politikerin Pat McElraft hatte sich für die beschlossene Regelung eingesetzt und erklärte, dass sie eine zukünftige starke Beschleunigung des Meeresspiegelanstiegs als unrealistisch ansieht und dies lediglich Vermutungen darstellen."

Die Vertrauenskrise des IPCC ist mittlerweile auch in den deutschen Medien [29] angelangt:

"Wenn bald über die Verlierer des Jahres nachgedacht wird, stehen die Klimaforscher auf vielen Listen sicher weit oben. … Stocker [30] war schon einige Wochen vorher bei der Vorstellung seines IPCC-Berichts praktisch baden gegangen, weil er der Öffentlichkeit und Politik vergeblich zu vermitteln versuchte, dass die jahrelange Quasi-Stagnation der Welttemperatur, der „Hiatus“, von der Klimapolitik ausgeklammert werden sollte. … Die Logik der Politik ist aber eine andere: Wenn die Klimaforschung schon so gravierende Schwankungen der Gegenwart nicht auf ihrer Rechnung hat, wie sollen wir ihr dann die Prognosen für die nächsten hundert Jahre abnehmen ?"

DER SPIEGEL [31] macht bereits einen "Abgesang" auf den Klimarat:

"Der Ehrentag des Klimarats der Vereinten Nationen (IPCC) wurde am Freitag mit einer spärlich besuchten Pressekonferenz in der georgischen Stadt Batumi (Anm.: 18.10.2013) begangen … Zum 25. Geburtstag kamen kaum Gäste, es wurde nur Wasser gereicht … Es wirkte wie ein Abgesang auf jene Organisation, die 2007 immerhin mit dem Friedensnobelpreis geehrt wurde. Einen weiteren großen Klimareport wird es womöglich nicht mehr geben."

F a z i t :

Die ständigen Alarm-Meldungen zu angeblich dramatischen Meeres-Spiegel-Anstiegen in Gegenwart und Zukunft können durch Messungen nicht bestätigt werden, sondern sind durch die Datenlage sogar zu widerlegen. Weltweit zeigen weder die Pegel-Daten noch die Satelliten-Daten eine Beschleunigung des Meeres-Spiegel-Anstieges, statt dessen eine Abschwächung. Das steht in krassem Widerspruch zu früheren und derzeitigen Aussagen von etlichen Klima-Instituten, der Klima-Modelle sowie des Klimarates IPCC. Darüber hinaus gibt es Anhalts-Punkte dafür, daß die Satelliten-Daten zu höheren Beträgen hin "über-korrigiert" wurden.

Klaus-Eckart Puls, EIKE

Weil es thematisch so gut passt, zeigen wir im Folgenden ein Video von Rainer Hoffmann. Es dokumentiert in knapp 32 Minuten, dass weder Klimawandel und/oder Meeresspiegelanstieg noch ein Tsunami für die Zerstörung des Dorfes auf einer Kiribati Insel im Jahr 2004 verantwortlich war, sondern die Zerstörung des Dorfes auf einen historischen Eingriff der Inselbewohner von Abaiang vor ca. 70 Jahren zurückzuführen ist.

Das Video dokumentiert auch, mit welchen abenteuerlichen Behauptungen und wider besseres Wissen manche "Journalisten" durch die Medienlandschaft geistern um ihre Ideen von der "Klimaschuld" der Industrieländer an den Mann zu bringen. Ferner zeigt es am Schluss auf, dass auf den Inseln wie den Malediven, Tuvalu und diversen anderen, seit einigen Jahrzehnten, kein Anstieg des Meeresspiegels zu verzeichnen war.

Q u e l l e n :

[1] DER SPIEGEL, Nr. 25, 17. Juni 2013, S.108-110, SPIEGEL-GESPRÄCH mit Hans von STORCH, "Wir stehen vor einem Rätsel: Seit 15 Jahren steigen die Temperaturen nicht mehr an"

[2] "Aktuell zur Durban-UN-Klimakonferenz Neuer IPCC Bericht: Zunahme von Extremwetterlagen?" 23.11.2011; http://www.eike-klima-energie.eu/news-cache/aktuell-zur-durban-unklimakonferenz-neuer-ipcc-bericht-zunahme-von-extremwetterlagen/

[3] "So viel Meereis in der Antarktis wie seit 30 Jahren nicht mehr" ; 26. Oktober 2013 ; http://www.kaltesonne.de/?p=13913

[4] "Wo bleibt denn nur die Arktis-Schmelze ?" ; 01.10.2013 ; http://www.eike-klima-energie.eu/news-cache/wo-bleibt-denn-nur-die-arktis-schmelze/

[5] SPIEGEL: KLIMA – Ratloses Orakel; 21.09.2013; http://www.spiegel.de/spiegel/print/d-113750868.html

[6] T. Wahla, et al.: "Observed mean sea level changes around the North Sea coastline from 1800 to present" ; Earth-Science Reviews ; Volume 124, September 2013, Pages 51–67; http://www.sciencedirect.com/science/article/pii/S0012825213000937

[7] Shennan, I., Woodworth, P.L., 1992. A comparison of late Holocene and twentieth century sea-level trends from the UK and North Sea region. Geophys. J. Int. 109, 96–105.

[8] "Die Ergebnisse geben uns eine gewisse Planungssicherheit für den Küstenschutz"; Aktualisiert via XIMS am 18.07.2013, von K.Knoche; http://www.unisiegen.de/start/news/forschung/536040.html

[9] (1) Albrecht, F., T. Wahl, J. Jensen and R.Weisse (2011); Determinig sea level change in the German Bight, Ocean Dynamics, doi:2010.1007/s10236-011-0462-z

(2) Wahl, T., Jensen J., Frank, T. and Haigh, I.D. ; (2011) Improved escmates of mean sea level changes in the German Bight over the last 166 years, Volume 61, Number 5, 701-705

[10] “Anthropogener“ Meeresspiegelanstieg – vom Konstrukt zur Panik?" Naturw. Rdsch. 61 (2008), H.11, S. 566-574

[11] http://sealevel.colorado.edu/

[12] http://www.aviso.oceanobs.com/en/news/ocean-indicators/mean-sea-level/

[13] SPIEGEL: "Klimarat feilscht um Daten zum Meeresspiegel-Anstieg" ; 14.07.2011 ; http://www.spiegel.de/wissenschaft/natur/0,1518,774312,00.html

[14] http://wattsupwiththat.com/2012/09/13/sea-level-acceleration-not-so-fast-recently/#more-70961 ; 13.09.2012 ; data available from http://sealevel.colorado.edu/

[15] Paulson, A., Zhong, S. and Wahr, J. 2007. Inference of mantle viscosity from GRACE and relative sea level data. Geophysical Journal International 171: 497-508 ; und :

http://www.eike-klima-energie.eu/news-cache/neue-studie-mittels-grace-daten-meeresspiegel-steigt-um-weniger-als-17-cm-pro-jahrhundert/ ; 09.07.2013

[16] http://hockeyschtick.blogspot.de/2012/12/noaa-2012-report-finds-sea-levels.html

[17] http://www.agu.org/pubs/crossref/pip/2012GL052885.shtml

[18] (1) http://wattsupwiththat.com/2012/05/16/is-sea-level-rise-accelerating/ und:

(2) http://www.kaltesonne.de/?p=4429

[19] nachzitiert nach http://www.kaltesonne.de/?p=4429

[20] http://www.kaltesonne.de/?p=4544

[22] http://www.kaltesonne.de/?p=4544

[24] http://www.kaltesonne.de/?p=4544 ; 14. Juli 2012

[25] SPIEGEL: "Klimarat feilscht um Daten zum Meeresspiegel-Anstieg" ; 14.07.2011 ; http://www.spiegel.de/wissenschaft/natur/0,1518,774312,00.html

[26] http://laufpass.com/ausgaben/eBook/eBook_0210/flash.html ; Nr.24 (2010), S. 8-13 ; u n d

http://www.eike-klima-energie.eu/climategate-anzeige/vertrauen-in-welt-klima-rat-im-freien-fall-die-irrungen-wirrungen-und-manipulationen-des-ipcc-ein-update/ ; 08.06.2010

[27] http://www.spiegel.de/wissenschaft/natur/0,1518,774312,00.html ; "Klimarat feilscht um Daten zum Meeresspiegel-Anstieg" ; 14.07.2011

[28] http://www.kaltesonne.de/?p=4506 ; 12. Juli 2012

[29] FAZ, 27.11.2013, "Durchhaltemodelle"

[30] Thomas Stocker, Sitzungsleiter des Klimarates auf der IPCC-Tagung in Stockholm, Sept. 2013

[31] SPIEGEL: Uno-Forscher wollen große Klimaberichte abschaffen ; 18.10.2013 ; http://www.spiegel.de/wissenschaft/natur/umbau-des-uno-klimarats-klimabericht-des-ipcc-arbeitsgruppe-2-a-928717.html

Artikel als PDF :

Anhang ggf. runter laden