Stromnetze am Limit – das Risiko wächst: Mit jedem Windrad nehmen die Probleme zu

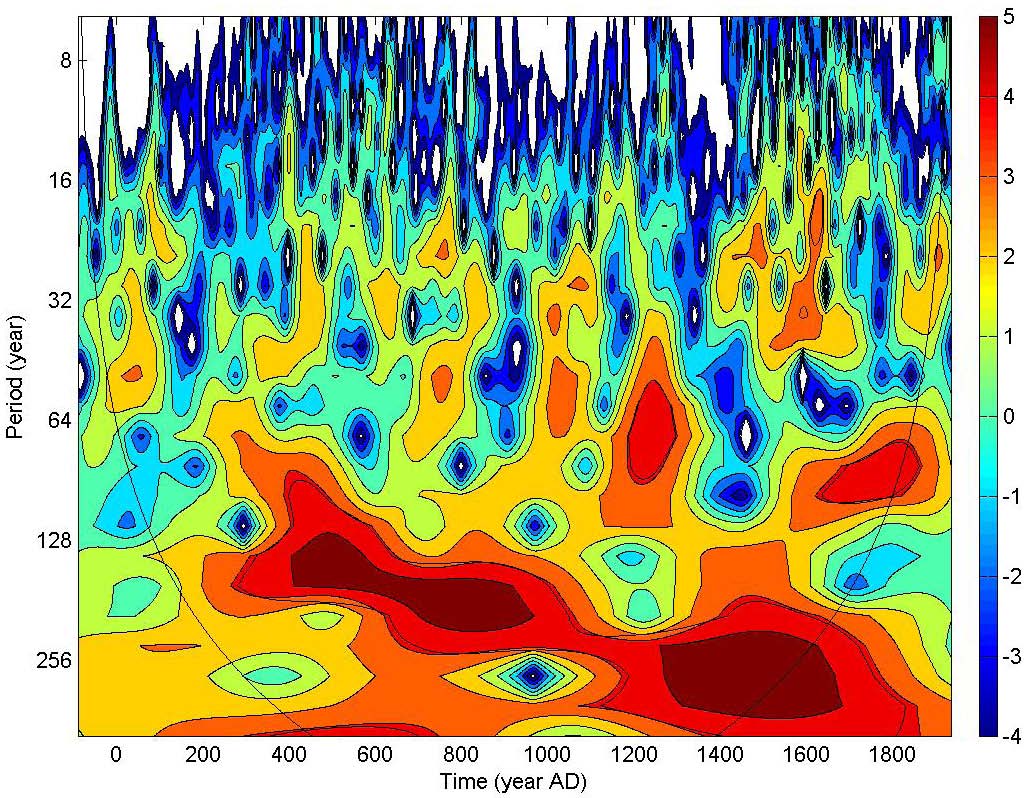

Schafft die Leitstelle dies nicht, so gerät das Netz innerhalb von Sekundenbruchteilen aus dem Takt. Grundlage des Problems ist die Tatsache, dass unsere Stromversorgung mit Wechselstrom arbeitet. Jeder Erzeuger, der in ein Verbundnetz einspeist, muss dies nicht nur mit der exakt gleichen Frequenz tun wie alle anderen Generatoren, sondern auch mit genau synchronem Verlauf der positiven und negativen Halbwellen. Anders ausgedrückt darf das eine Kraftwerk nicht gerade in dem Moment mit negativer Spannung einspeisen, wenn das andere gerade eine positive Spannung erzeugt, denn diese unterschiedlichen Polungen würden dazu führen, dass die Generatoren gegeneinander statt miteinander arbeiten würden, Bild 1. Statt gemeinsam Strom ins Netz zu liefern, würden sie sich gegenseitig innerhalb von wenigen Sekunden zerstören, weil die Wicklungen der Generatoren ausbrennen würden.

Bild 1. Würden zwei Generatoren mit derartiger Phasenverschiebung gleichzeitig ins Netz einspeisen, so würden sie sich gegenseitig beschädigen (Grafik: Saure, Wikipedia Creative Commons)

Eine der wichtigsten Aufgaben der Netzleitstellen besteht daher darin, die Netzfrequenz zu überwachen und innerhalb extrem enger Grenzen stabil zu halten, damit die mehr als eine Million Teilnehmer, die allein in das deutsche Verbundnetz einspeisen, stets synchron und mit exakt gleicher Phasenlage einspeisen können.

Zusammenhang von Frequenz und Netzlast

Die Netzfrequenz hängt wiederum direkt von Gleichgewicht zwischen Erzeugung und Verbrauch ab. Je höher der Verbrauch, desto größer ist auch das von der Turbine aufzubringende Drehmoment, damit der Generator seine exakt vorgeschriebene Drehzahl halten kann. Laständerungen wirken sich daher sofort auf seine Drehzahl und damit auf die Frequenz des erzeugten Wechselstroms aus. Das Kraftwerk überwacht deshalb die Frequenz und versucht, diese stabil zu halten, indem es mehr oder weniger Dampf auf die Turbine leitet. Im Verbundnetz muss dies stets von allen einspeisenden Generatoren synchron nachvollzogen werden, um das dynamische Gleichgewicht von Erzeugung, Verbrauch und Netzfrequenz innerhalb der für den stabilen Netzbetrieb erforderlichen Sicherheitsmargen zu halten. Voraussetzung hierfür ist die Fähigkeit der einspeisenden Kraftwerke, ihre Energieerzeugung bedarfsgerecht entweder zu steigern oder zu drosseln.

Solar- und Windenergieanlagen können solche gezielten Leistungsanpassungen prinzipbedingt nicht in nutzbarem Umfang erbringen und sind daher außerstande, das Netz zu stabilisieren. Im Gegenteil, ihre nur von den Zufällen von Wind und Wetter abhängige Einspeisung, die von den Netzbetreibern aufgrund gesetzlicher Vorgaben zwangsläufig abgenommen werden muss, erschwert den restlichen Kraftwerken die sowieso schon anspruchsvolle Aufgabe, das Netz auch im Falle unvorhersehbarer Störungen ständig im Gleichgewicht zu halten.

Reaktion auf Netzstörungen

Im Netz treten unablässig Änderungen der Belastung auf, die durch ständige Anpassung der Erzeugung aufgefangen werden müssen. Viele dieser Änderungen sind mit einer gewissen Zuverlässigkeit vorhersehbar – beispielsweise das Einschalten zahlloser Fernseher pünktlich zum Beginn eines Bundeligaspiels oder das morgendliche Duschen vor der Arbeit – und können daher in den Tagesfahrplänen der Kraftwerke berücksichtigt werden. Andere Ereignisse sind jedoch nicht planbar, zum Beispiel Leitungsausfälle, Trafo- oder Kraftwerksstörungen oder Blitzeinschläge, die zu Kurzschlüssen und damit zu größeren Ausfällen im Stromnetz führen können. Erschwerend kommt hinzu, dass solche Ereignisse oft in Sekundenbruchteilen eintreten, viel schneller, als jeder Mensch reagieren könnte. Erste Sicherheitsreserve im Netz sind deshalb die riesigen Schwungräder, als die in solchen Fällen die rotierenden Turbinen und Generatoren fungieren. In diesen rotierenden Massen (Bild 2) sind enorme Energiemengen gespeichert, die sofort zur Verfügung steht. Große Turbinen und Generatoren wiegen hunderte von Tonnen und rotieren mit hohen Drehzahlen, typischerweise 1500 oder 3000 Umdrehungen pro Minute.

Bild 2. Solche Wellen für Kraftwerke wiegen oft mehr als 100 Tonnen und rotieren mit bis zu 3000 Umdrehungen pro Minute. Sie speichern daher große Energiemengen Bild http://www.saarschmiede.com/69.html

Es ist die darin gespeicherte, sofort ohne jede Verzögerung verfügbare Energie, welche in den ersten Sekunden einer größeren Störung die Netzfrequenz und damit die Netzstabilität innerhalb der zulässigen Grenzen hält. Unmittelbar darauf reagieren die Dampfventile der für die Notversorgung herangezogenen Kraftwerke und sorgen beispielsweise dafür, dass mehr Dampf auf die Turbine geleitet wird. Damit wird die zweite Verteidigungslinie der Netzstabilisierung aktiviert, die großen Energiereserven, die in den vielen tausend Tonnen extrem hoch erhitzten und komprimierten Dampfs gespeichert sind, welchen die riesigen Dampfkessel fossiler Kraftwerke ständig vorrätig halten. Diese extrem schnelle und in Sekunden verfügbare Stabilisierung kann nur von dampfbetriebenen Fossil- und Kernkraftwerken mit massiven, schnell rotierenden Generatoren gewährleistet werden. Einen gewissen Beitrag können auch Wasserkraftwerke leisten. Solar- und Windenergie sind hierzu dagegen außerstande, denn sie halten weder nennenswerte Rotationsenergie vor noch lassen sich Sonne und Wind gezielt herauf- oder herunterregeln. Vor diesem Hintergrund lassen Behauptungen, eine 100 prozentige Stromversorgung aus erneuerbaren Energien ohne konventionelle Kraftwerke sei möglich, doch erhebliche Zweifel daran aufkommen, ob die Betreffenden überhaupt wissen, wovon sie reden.

Worst Case: Ein Kraftwerks-Totalausfall

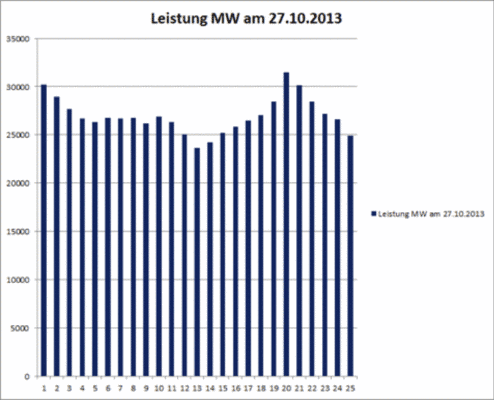

Eine der kritischsten Situationen, auf die eine Netzleitstelle ständig vorbereitet sein muss, ist der Totalausfall des größten derzeit am Netz befindlichen Kraftwerks oder einer sonstigen leistungsbestimmenden Komponente wie einer großen Fernleitung. Die im Netz vorgehaltenen Leistungsreserven müssen selbst in einem solchen Fall ausreichen, um einen Zusammenbruch zu verhindern. Dafür muss die ausgefallene Leistung innerhalb von Sekundenbruchteilen ersetzt werden. Um das zu erreichen, muss die Leitstelle dafür sorgen, dass automatisch genügend Zusatzleistung von den anderen mit dem Netz verbundenen Großkraftwerken bereitgestellt wird. Da einige wenige Kraftwerke einen solchen plötzlichen Mehrbedarf gar nicht stemmen könnten, wird die benötigte Ersatzleistung in vielen Teilbeträgen auf zahlreiche Kraftwerke aufgeteilt. Die einzelnen Beiträge sind dabei so klein, dass die jeweiligen Kraftwerke damit noch problemlos zurechtkommen. In der Regel sind dies 2,5 % der jeweils möglichen Erzeugungsleistung. Diese Reserve muss zur Hälfte innerhalb von 5 Sekunden und insgesamt innerhalb von 30 Sekunden bereitgestellt werden [PRIM]. Im Rahmen ihrer ständigen Notfallbereitschaftsplanung führt die Netzleitstelle eine ständig aktualisierte Liste mit denjenigen Kraftwerken, die zurzeit am Netz sind und über die Fähigkeit verfügen, diese Systemdienstleistung zu erbringen. Die Leistungsregler dieser Kraftwerke müssen hierfür ständig direkt von der Leitstelle aus ansteuerbar sein und werden von dort im Notfall dann aufgefahren. Dies erfolgt vollautomatisch computergesteuert innerhalb von Sekundenbruchteilen, viel schneller als ein Mensch reagieren könnte. Da Deutschland im Rahmen des europäischen Verbundnetzes im Notfall auch auf Hilfe aus dem Ausland zählen kann, liegt der Umfang dieser Leistungsreserve, die jederzeit abrufbereit zur Verfügung stehen muss, bei 700 MW [PRIM]. Aus beiden Angaben lässt sich leicht ausrechnen, dass zur Aufrechterhaltung der Netzsicherheit jederzeit 28000 MW an primärregelfähiger Kraftwerksleistung am Netz sein müssen – was inzwischen jedoch aufgrund des ständig wachsenden Aufkommens an Solar- und Windstrom im Netz nicht mehr ständig der Fall ist, Bild 3.

Bild 3. Als am 27.10. 2013 – einem Sonntag mit geringer Netzlast – ein Sturm über Deutschland hinwegfegte, war das Aufkommen an zwangseingespeistem Wind- und Solarstrom so hoch, dass der Beitrag konventioneller Kraftwerke unter die kritische Marke von ca. 28.000 MW gedrückt wurde (Daten: Strombörse EEX)

Wird diese kritische untere Grenze unterschritten, so gerät das Netz in Gefahr. Zwar kann man in solchen Fällen über das europäische Verbundnetz Hilfe von den Nachbarn erhalten, doch erwarten diese im umgekehrten Falle natürlich gleichwertige Dienste auch von Deutschland, so dass die ständig vorzuhaltende Leistung in der Summe letztlich gleich bleibt.

Die erste Regelebene ist entscheidend

Neben den ersten beiden Regelebenen – der Trägheitsreserve und der Sekundenregelung – verfügt die Leitstelle noch über eine Sekundär und Tertiärebene [WIKI], die innerhalb von 30 s bis 5 min bzw. innerhalb von 5 bis 15 min zur Verfügung stehen müssen. Aus diesem Grund bezeichnet man die zweite Ebene als Sekundenreserve und die dritte Ebene als Minutenreserve. Zur Sekundenreserve gehören vor allem schnellstartfähige Kraftwerke wie Gaskraftwerke, die innerhalb kürzester Zeit von Null auf Vollleistung gehen können, sowie Speicher-Wasserkraftwerke, die nur die Regelventile weiter zu öffnen brauchen. Die Sekundärregelung hat vor allem die Aufgabe, den Abfall der Netzfrequenz aufzufangen und damit die „rotierende Reserve“ zu entlasten, so dass sie für eventuelle weitere Notfälle wieder voll verfügbar wird. Überlappend hierzu werden auch die anderen Regelebenen aktiviert, indem zunächst Pumpspeicher- oder Gasturbinenkraftwerke – die auch die Sekundärregelung besorgen – und mit entsprechender Zeitverzögerung auch Großkraftwerke auf höhere Leistung gefahren werden.

Ungeachtet der Feinheiten des Zusammenspiels verschiedener Regelebenen muss man sich jedoch darüber im Klaren sein, dass die ersten Sekundenbruchteile einer größeren Störung entscheidend sind. Gelingt es nicht, das Netz innerhalb dieser ersten „Flackersekunden“ zu stabilisieren, so reicht selbst eine noch so große, aber eben erst nach 30 s verfügbare Zusatzleistung nicht aus, um einen Zusammenbruch zu verhindern: Dann geht es, bildlich gesprochen, nicht mehr um Therapie, sondern um Autopsie, denn die unterbrechungsfreie Stromversorgung ist dann nicht mehr möglich, es müssen Netze und/ oder Verbraucher abgeworfen und später mit hohen Kosten wieder hochgefahren werden.

Und bei der Betrachtung der zur Verfügung stehenden Rotationsenergie zeigt sich, dass die oft als „Dinosaurier“ geschmähten Großkraftwerke (Bild 4) hier einen entscheidenden Vorteil gegenüber kleineren Einheiten haben, denn ihre riesigen Turbinen-Rotor-Einheiten können erheblich mehr Energie speichern als kleinere Systeme, weil die Energie eines Schwungrads mit dem Quadrat des Durchmessers zunimmt.

Bild 4. Die oft als Dinosaurier geschmähten großen Dampfkraftwerke – hier das Kraftwerk Neurath – sind für die Aufrechterhaltung der Netzstabilität ganz einfach unersetzlich (Foto: Kohlekraftwerke.de)

Enorme Risiken

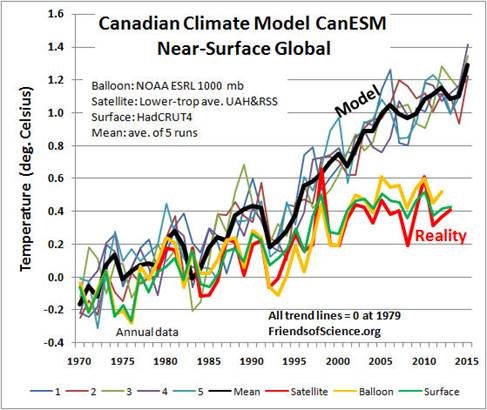

Vor diesem Hintergrund versteht man schnell, dass die „Energiewende“ mit der ins Auge gefassten Steigerung der Kapazitäten an Wind- und Solarstromerzeugung so nicht funktionieren kann, ohne die Netzstabilität zu opfern. Zur Zeit sind 32000 MW Windleistung und 34000 MW Solarleistung am deutschen Netz [EEX]. Sie tragen kumuliert jedoch nur etwa 12 % zur Gesamtstromerzeugung bei. Um die ca. 64 % zu erreichen, die nach EEG-Planung bis 2050 erreicht werden sollen (Annahme: 80 % Wind- und Solaranteil an insgesamt 80 % EE-Erzeugung), müssten bei gleichbleibendem Verbrauch noch fünfmal so viele Windräder und Solaranlagen wie aktuell verfügbar aufgestellt werden. Damit würden die konventionellen Anlagen endgültig aus dem Markt gedrängt, obwohl sie bei Flaute und fehlendem Sonnenschein dennoch gebraucht werden. Das ist völlig unrealistisch, kann doch die Lage in den deutschen Netzen bereits jetzt als kritisch bezeichnet werden [FOCU, RWE]. So sagte der Tennet-Chef einem Bericht in den VDI-Nachrichten vom 4.10.2013 zufolge: „Wir haben heute im Schnitt drei Eingriffe ins Stromnetz am Tag. Vor zehn Jahren waren es drei im gesamten Jahr” [EIKE]. Ähnliche Meldungen gibt es auch von den anderen deutschen Netzbetreibern. Falls nicht bald gegengesteuert wird, drohen im Falle von Blackouts insbesondere in modernen Industrien (Bild 5) mit ihren fein austarierten Hochleistungsprozessen oft enorme Schäden [BER].

Bild 5. Stromausfälle legen die in jedem modernen Betrieb unentbehrlichen Computer lahm. Das kann zu erheblichen Ausfällen und sogar Anlagenschäden führen

Schon eine einzige Stunde Blackout in Deutschland kann Schäden von bis zu 600 Mio. € verursachen [WEWO]. Hält man sich diese Tatsachen vor Augen, so weiß man angesichts von Berichten wie dem des Spiegel-Journalisten Stefan Schultz [SPON], der behauptet, die Stromversorgung lasse sich auf absehbare Zeit auch mit den bestehenden Mitteln ohne die Gefahr von Blackouts sichern, wirklich nicht mehr, ob man nun lachen oder weinen soll.

Vor diesem Hintergrund sind die jüngsten Äußerungen von RWE-Chef Peter Terium, dass sein Unternehmen aus den Planungen zum Bau konventioneller Kraftwerke komplett aussteigen will [RWE2], im Prinzip als Resignation zu werten. Im Bereich der Stromversorger scheint man offensichtlich die Hoffnung aufgegeben zu haben, dass die deutsche Politik in absehbarer Zukunft wieder zur Vernunft findet. Frau Merkel und ihre neue Regierung haben damit ein im Prinzip unlösbares Problem am Hals, noch bevor die Koalition auch nur steht. Auf Deutschland dürften somit im Sinne des Wortes düstere Zeiten zukommen.

Fred F. Mueller

Quellen

[BER] Bericht “Gefährdung und Verletzbarkeit moderner Gesellschaften – am Beispiel eines großräumigen und langandauernden Ausfalls der Stromversorgung”, Ausschuss für Bildung, Forschung und Technikfolgenabschätzung des Deutschen Bundestags (04/2011)

[EEX] http://www.transparency.eex.com/de

[PRIM] http://www.udo-leuschner.de/basiswissen/SB124-03.htm

[EIKE] http://www.eike-klima-energie.eu/news-cache/deutscher-journalismus-kommmir-nicht-mit-fakten-meine-meinung-steht/

[FOCU] http://www.focus.de/immobilien/energiesparen/bedrohliche-energiewende-502-stoerfaelle-im-ersten-halbjahr-stromnetz-steht-vor-kollaps_aid_1089770.html

[RWE] http://de.nachrichten.yahoo.com/rwe-chef-warnt-strom-engp%C3%A4ssen-080510591–finance.html

[RWE2] http://de.nachrichten.yahoo.com/rwe-chef-warnt-strom-engp%C3%A4ssen-080510591–finance.html

[SPON] http://www.spiegel.de/wirtschaft/soziales/kraftwerke-darum-braucht-deutschland-keinen-teuren-reservemarkt-a-929302.html

[WEWI] http://www.welt.de/wirtschaft/article121265359/Jede-Stunde-Blackout-kostet-600-Millionen-Euro.html

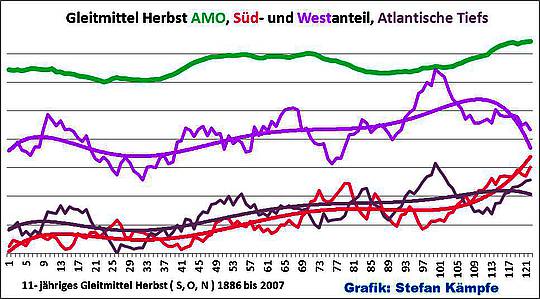

[WIKI] http://de.wikipedia.org/wiki/Regelleistung_(Stromnetz)