Im Takt der AMO und der NAO (3): Das Häufigkeitsverhalten der Großwetterlagen und dessen Auswirkungen auf die Deutschland- Temperaturen

Bild rechts: Mehr Dürren und mehr Hochwasser- stimmen diese Behauptungen? Fotos: Stefan Kämpfe

Die Analyse der langzeitlichen Häufigkeitsentwicklung der Großwetterlagen ersetzt zwar kein exakt erhobenes Datenmaterial wie Niederschlags-, Wind- und Temperaturmessungen, liefert aber wichtige Hinweise, ob sich durch eine Zu- oder Abnahme einzelner Großwetterlagen und deren Cluster bestimmte Wetterereignisse häufen könnten. Um den Umfang dieser Arbeit überschaubar zu halten, sollen einmal die beliebtesten, gern auch von den Medien und der Allgemeinheit geäußerten Thesen überprüft werden. Hierzu ist es zeitweise erforderlich, die Jahresebene zu verlassen und sich auf die Ebene der Jahreszeiten zu begeben, so auch gleich bei der ersten Behauptung.

„Die Sommer werden in Deutschland immer heißer und trockener.“

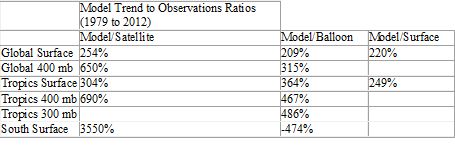

Ob ein Sommer (der Meteorologische, also Juni bis August) trocken- warm oder eher feucht- kühl ausfällt, entscheiden die vorherrschenden Großwetterlagen. Trocken- warmes Hochdruckwetter beinhaltet das Cluster „Kontinentale Hochs“, das sind Großwetterlagen, bei denen überwiegend Luftmassen kontinentaler Prägung nach Deutschland gelangen. Feucht- kühles Wetter umfasst das Cluster „Sommermonsun“, das sind wolkenreiche West- bis Nordwest- oder Nordlagen mit überwiegend Meeresluftmassen, die den Temperaturausgleich zwischen dem sommerwarmen Festland und dem kühleren Meer herstellen (siehe Teil 1, Tabelle der Wetterlagen). Der Begriff „Sommermonsun“ wurde unter anderem von KOCH (1953) geprägt. Natürlich hat der mitteleuropäische Sommermonsun keinesfalls die Intensität, Bedeutung und die Beständigkeit der asiatischen Monsune, außerdem ist sein Wirkeffekt auf die erweiterte Grenzschicht bis maximal 2500 Meter Höhe beschränkt, aber er bewirkt doch, dass die in Mitteleuropa meist westliche Strömung im Hochsommer etwas auf Nordwest dreht. Wir sehen, wie sich die Häufigkeit dieser sehr gegensätzlichen Cluster im Meteorologischen Sommer verändert hat (Zur Orientierung wird auch stets wieder die AMO bei diesen Gleitmitteln gezeigt):

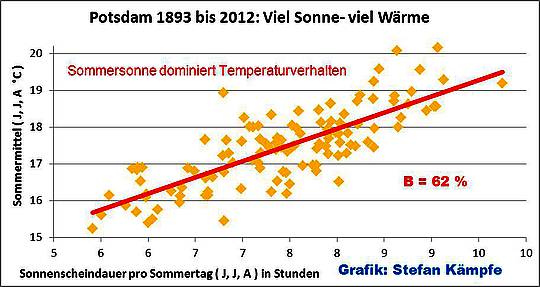

Abb. 1: Bis in die 1970er Jahre nahm die Häufigkeit der kühlende Sommermonsunlagen (Blau) zwar deutlich ab; wärmende Kontinentalhochlagen (Dunkelgelb) nahmen hingegen bis Ende der 1990er Jahre nur leicht zu; danach jedoch wieder ab.

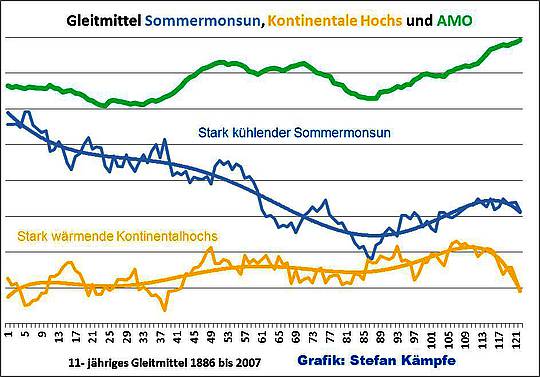

Und noch klarer wird das bisherige Ausbleiben der gehäuft trocken- warmen Sommer nach Betrachtung der folgenden Abbildung:

Abb. 2: Bei dem deutlichen Anstieg der oft Niederschläge bringenden Z- Lagen und dem (folgerichtigen) Rückgang der A- Lagen ist bislang keine eindeutige Änderung des Klimas in Deutschland hin zu trockeneren, heißeren Sommern zu erkennen. Die stärksten Zunahmen (lineare Regression) waren bei SWZ (leicht erwärmend, +7 Tage/Sommer), TRM (kühlend, + 6 Tage) und TRW (leicht erwärmend, +6 Tage) zu beobachten.

Der angekündigte Klimawandel hin zu immer trockeneren, heißeren Sommern lässt sich am Verhalten der meisten dafür in Frage kommenden Wetterlagen bislang nicht eindeutig erkennen. Allenfalls die Lagen mit südwestlicher bis südlicher Strömungskomponente, die im Sommer, wie auch im Frühling, Herbst sowie im Jahresmittel (siehe Teil 2, Abb. 5), häufiger wurden, können einen gewissen Beitrag zur sommerlichen Erwärmung geleistet haben; doch diese bringen oft Niederschläge. Zumindest an der Station Erfurt- Bindersleben haben außerdem die Sommerniederschläge seit 1979 nach eigenen Untersuchungen zu- und nicht abgenommen; besonders im Juli und August. Untersuchungen von SCHÖNWIESE/TRÖMEL zeigen, dass die Sommerniederschläge in Deutschland zwischen 1901 und 2000 zwar um 2,7% geringfügig abnahmen; bei Betrachtung des Zeitraumes 1981 bis 2010 zeigte sich jedoch eine Zunahme um gut 12%. Außerdem ist zu beachten, dass die Südwestlagen, welche im Sommer den Hauptanteil bei der Zunahme aller Wetterlagen mit Südkomponente ausmachten, in dieser Jahreszeit am wenigsten erwärmend wirken. Dass die Sommer im Verlauf der vergangenen 130 Jahre etwas wärmer wurden, hat zwei wesentliche andere Ursachen, den zunehmenden, oftmals auch flächenhaften Wärmeinseleffekt und eine erhöhte Sonnenscheindauer, welche besonders in den vergangenen 30 Jahren zu beobachten war und von der am Ende des 20. Jahrhunderts hohen Sonnenaktivität sowie durch Luftreinhaltemaßnahmen verursacht wurde (KÄMPFE, LEISTENSCHNEIDER, KOWATSCH, 2012, 2013; MALBERG, 2009; WEHRY, 2009; WEHRY, MYRCIK, 2006). Die folgende Abbildung belegt eindrucksvoll, wie stark der Einfluss der Sonnenscheindauer auf die sommerlichen Lufttemperaturen zumindest während der vergangenen 120 Jahre war:

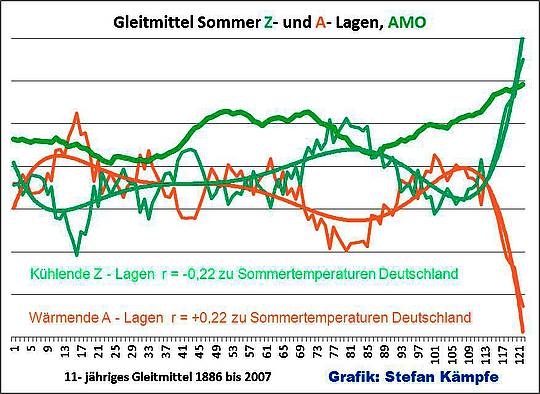

Abb. 3: Die sommerliche Sonnenscheindauer beeinflusste die Variabilität der Sommertemperaturen in Potsdam mit 62% sehr stark. Dieses Ergebnis ist nicht auf ganz Deutschland übertragbar- dennoch zeigt es, dass es wohl nicht die geänderten Häufigkeitsverhältnisse der Großwetterlagen waren, welche den leichten Anstieg der sommerlichen Lufttemperaturen vorrangig verursachten. Quelle des Datenmaterials: PIK

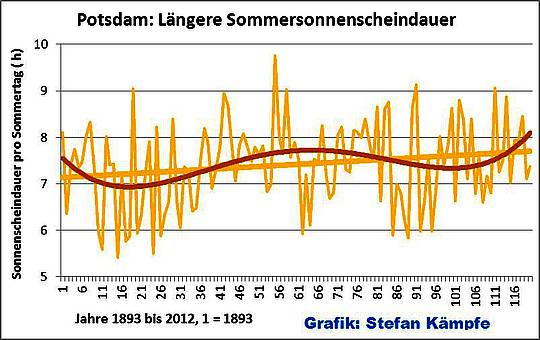

Außerdem nahm die Sonnenscheindauer im Sommer in Potsdam insgesamt leicht zu:

Abb. 4: Man erkennt eine leichte Zunahme der Sonnenscheindauer um insgesamt etwa eine halbe Stunde pro Sommertag; außerdem gab es leichte periodische Schwankungen. Quelle des Datenmaterials: PIK

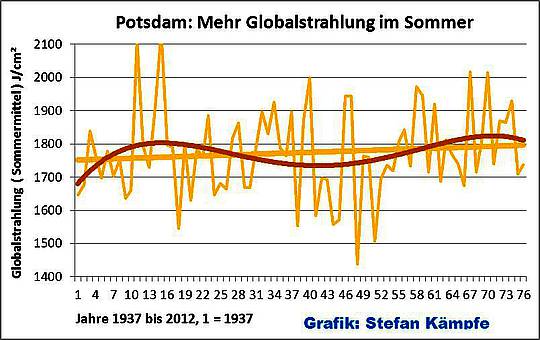

Und auch die Intensität der Globalstrahlung, welche leider in Potsdam erst seit 1937 gemessen wird, zeigt eine leichte sommerliche Zunahme:

Abb. 5: Auch die erwärmend wirkende Globalstrahlung (gesamte Einstrahlung) nahm im Sommer leicht zu- sicher auch durch Luftreinhaltemaßnahmen begünstigt. Quelle des Datenmaterials: PIK

Zahlreiche Untersuchungen, Arbeiten und Indizien belegen die Zusammenhänge zwischen saubererer Luft, aktiverer Sonne, weniger Nebel, weniger (tiefer) Bewölkung, mehr Sonnenschein und höheren Temperaturen auch in den übrigen Jahreszeiten in Deutschland sowie teilweise global (CALDER/SVENSMARK (2007); CLIMATE4YOU; HOFFMANN/MÜLLER, 1994; KÄMPFE, 1997, 1999, KÄMPFE/LEISTENSCHNEIDER/KOWATSCH, 2012, 2013; LEISTENSCHNEIDER, 2011; NABEL; PELZ, 1993, 1994; WEHRY, 2009; WEHRY/MYRCIK, 2006). Der Juli 2013, in diesen Untersuchungen noch gar nicht enthalten, bestätigte den dominanten Einfluss der Sonnenscheindauer erneut eindrucksvoll, denn trotz vorherrschender Nordwest-, Nord- und Nordostströmung heizte die in vielen Regionen mit weit über 250 Monatsstunden deutlich übernormal scheinende Sonne die Luftmassen subpolarer Herkunft stark auf; nur die kurzen Sommernächte fielen mit Minima teilweise um die 10°C empfindlich kühl aus. Erst im letzten Monatsfünftel bescherten uns dann feucht- heiße, wolkenreichere Luftmassen aus dem Süden auch sehr warme Nächte. Die leichte Zunahme der sommerlichen (und auch der jährlichen) Temperaturen hatte bislang auch keine wesentlichen Auswirkungen auf die Pflanzenwelt. Ein zeitweise häufigeres Auftreten Wärme ertragender Arten oder von solchen mit später Blüte und Fruchtreife beziehungsweise langer Vegetationszeit (Kleines Liebesgras, Hirse- Arten, Ranken-Platterbse, Runder Lauch, Wermut, Beifuß- Ambrosie, verwilderte Astern, Weißer Stechapfel, Einjährige Sonnenblume, Gefleckter Schierling, aber auch manche Orchideen und Frühblüher) war um Weimar zu beobachten, aber nicht von Dauer (KÄMPFE, 2009). Besonders die sehr wärmebedürftige Ranken- Platterbse, aber auch der Runde Lauch und der Wermut, sind in den letzten 5 Jahren um Weimar wieder seltener geworden.

„Die Winter werden immer milder. Schon bald ist Wintersport nur noch in den höheren Lagen der Alpen möglich, und Schnee kennen die meisten Kinder nur noch von Fotos oder den Erzählungen der Großeltern. Außerdem gibt es immer häufiger schwere Winterstürme.“

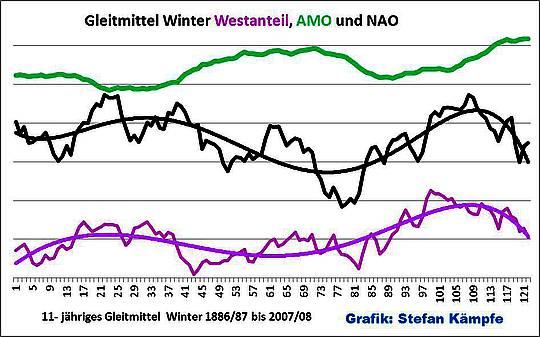

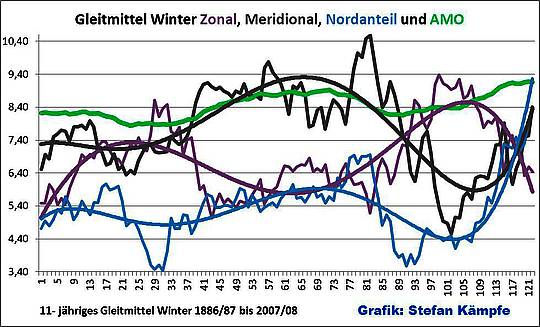

Dieser weit verbreitete Mythos entstammt den späten 1980er und den frühen 1990er Jahren, als es eine Serie ungewöhnlich milder und schneearmer Winter zwischen 1987/88 und 1994/95 in Deutschland gab. Warum das so war, sehen wir in der folgenden Darstellung (bei allen Grafiken, die den Winter, also Dez bis Feb., betreffen, ist als schwarze Kurve der saisonale NAO- Index mit abgebildet, welcher im Winter einen gewissen Einfluss auf die Wintermitteltemperaturen in Deutschland mit r = 0,48 im Untersuchungszeitraum hatte):

Abb. 6: Lagen mit Westanteil (Rotviolett), das sind solche, die im Winter meist sehr deutlich erwärmend wirken, wurden bis etwa 1990 häufiger; danach aber wieder seltener. Deutlich ist ein gewisser Gleichklang mit der Nordatlantischen Oszillation (NAO- Index, Schwarz) und ein inverser Verlauf zur AMO erkennbar.

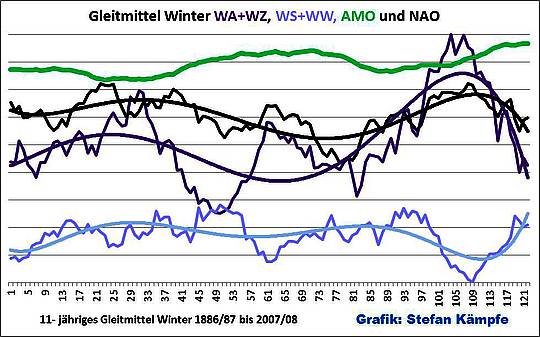

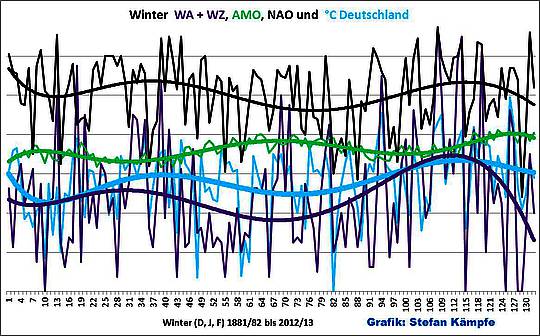

Betrachtet man nur den GWT West (Zonale Lagen), und „zerlegt“ diesen in seine zwei Bestandteile, die deutlich erwärmend wirkenden WA- und WZ- Lagen sowie die kaum erwärmend wirkenden („gestörten“) Lagen WS und WW, so ergibt sich folgendes Bild:

Abb. 7: „Westlagen im engeren Sinne“, die überwiegend deutlich erwärmend wirken (WA + WZ, Dunkelviolett) schwankten im Winter bezüglich ihrer Häufigkeit in einem etwa 30- bis 40- jährigen Rhythmus; am Beginn der 1990er hatten sie ein auffälliges Häufigkeitsmaximum und nahmen seitdem auf das Niveau der 1890er Jahre ab. Man achte wiederum auf die Ähnlichkeit zum Verlauf des NAO- Index und den inversen Verlauf zur AMO. Die „gestörten“ Westlagen (WS und WW, hell blauviolett) sind insgesamt seltener, sie verhalten sich außerdem invers zu den Westlagen im engeren Sinne. Bei gesamtjährlicher Betrachtung zeigt sich ein ähnliches Verhalten der Westlagen- siehe Teil 2, Abb. 6.

Die vorhergesagte Häufung „immer milderer Winter“ ist ausgeblieben, denn die dafür verantwortlichen Wetterlagen sind in den ersten 13 Wintern des 21. Jahrhunderts deutlich seltener geworden, was sich auch schon in den dämpfend wirkenden Gleitmitteln zeigt. Vielmehr unterliegt die Häufigkeit der „Westwetterlagen“ im Winter periodischen Schwankungen, die unter anderem von der NAO und der AMO beeinflusst werden. Und genau diese Tatsache ist auch dem Deutschen Wetterdienst (DWD) seit mehr als 10 Jahren bekannt. Der DWD- Autor P. BISSOLLI schrieb in seiner Arbeit „Kommen Westlagen häufiger vor als früher?“, veröffentlicht im Klimastatusbericht 1999, folgendes: „… . Dies bedeutet, dass eine Häufung von Westwetterlagen, die zweifellos während der letzten Jahre stattgefunden hat, zwar deutliche Auswirkungen auf die Wintermitteltemperaturen haben kann, aber eine einfache Kausalkette anthropogener Treibhauseffekt- mehr Westlagen- mildere Winter lässt sich dennoch nicht ohne weiteres aufstellen. …“ Wie sich nun zeigt, eine weise Formulierung, vermutlich hat er mit dem Rückgang der Westlagenhäufigkeit bereits gerechnet. Schade, dass solcherlei Erkenntnisse nie den Weg über die Medien in die breite Öffentlichkeit finden. Und wie sieht es mit der „katastrophalen Häufung der Winterstürme“ aus? Eine Voruntersuchung im Rahmen dieser Arbeit ergab, dass, bis auf ganz wenige Ausnahmen, schwere Winterstürme von 3 Großwetterlagen (WZ, NWZ, mitunter auch SWZ) verursacht werden, die im Cluster „Atlantische Tiefs“ zusammengefasst sind:

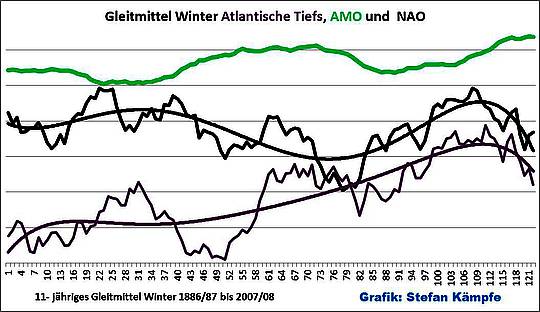

Abb. 8: Die bis zum Ende des 20. Jahrhunderts währende starke Häufigkeitszunahme Atlantischer Tiefs (Grauviolett, unterste Kurve) erklärt, warum es in der 2. Hälfte des 20. Jahrhunderts, besonders aber in den 1990er Jahren, gehäuft schwere Winterstürme in Deutschland gab, doch auch hier zeigt sich die Abnahme im frühen 21. Jahrhundert.

Anhand langjähriger Sturmstatistiken, darunter der Anzahl nordatlantischer Sturmtiefs zwischen November und März und der Häufigkeit der Sturmfluten in Hamburg, wies PULS (2009) nach, dass die prognostizierte Zunahme von Stürmen ausgeblieben ist. Mit der Abnahme der Westwetterlagen wurden Meridional- Lagen seit Beginn des 21. Jahrhunderts wieder deutlich häufiger. Betrachtet man den Gesamtzeitraum 1881/82 bis 2012/13 unter Einbeziehung des Wintermittels der Lufttemperaturen in Deutschland, so ergibt sich folgendes Bild:

Abb. 9: Das Deutschland- Wintermittel der Lufttemperaturen (°C Deutschland, hellblau) ähnelt in seinem Verlauf dem NAO- Index und der Häufigkeit der am stärksten erwärmend wirkenden Westlagen im engeren Sinne (WA + WZ), während zur AMO ein eher inverser Verlauf besteht.

Man beachte den starken Rückgang der Westlagen während der vergangenen knapp 2 Jahrzehnte; außerdem ist das Wintermittel der Lufttemperaturen- trotz eines (wie lange noch?) positiven Lineartrends- wieder genau auf dem Niveau der 1880er Jahre angekommen- die vorhergesagten immer milderen, stürmischeren Winter finden in der Realität nicht statt. Und weil sich diese unumstößliche Tatsache nicht verheimlichen lässt- die Auswirkungen von Schnee und Kälte bekam in den letzten „Horror- Wintern“ nahezu jeder auf die ein oder andere Art und Weise zu spüren- wurde gleich die nächste Behauptung in die Welt gesetzt:

„Die Winter werden in Deutschland trotz der Klimaerwärmung kälter, weil das Arktische Meereis schmilzt. Dadurch bilden sich im Norden mehr winterliche Hochs, die eisige Nord- bis Ostluft nach Deutschland lenken.“

Zur Beurteilung dieses Mythos ist es wichtig zu wissen, dass

1. Eine exakte, kontinuierliche Beobachtung und Quantifizierung der flächen- und mengenmäßigen Ausdehnung des Meereises erst seit den späten 1970er Jahren (Aufkommen und stetige Verbesserung der Satellitentechnik) möglich ist, so dass langfristige, über deutlich mehr als 4 Jahrzehnte reichende, für diese Arbeit verwendbare Datensätze fehlen.

2. Beobachtungen aus früheren Jahrhunderten und Jahrzehnten zeigen, dass es immer wieder rhythmische Phasen mit Vorrücken und Zurückweichen der Eisfelder gab (Quelle: KALTESONNE.DE, 2012). Mitunter konnten Nordost- und Nordwestpassage problemlos befahren werden, dann gab es wieder Jahre oder gar Jahrzehnte, in denen diese völlig unpassierbar waren.

3. Letztmalig wurde ein den heutigen Dimensionen möglicherweise ähnelnder Rückgang der Eisfelder und Arktis- Gletscher in den 1930er bis 1940er Jahren beobachtet (Quelle: FOTOS AUS DEN 30er JAHREN…, 2012). Dieser fällt (ähnlich wie das heutige Eisminimum) in die Positiv- Phase der AMO, weil die AMO über den Golfstrom Wärme und Salz in die arktischen Gewässer einträgt, so dass ein Zusammenhang zwischen der AMO und der Eisausdehnung besteht (Quelle: WIKIPEDIA). Ein mögliches Indiz ist (die hier schon dargestellte) tendenzielle Häufigkeitsabnahme der Westlagen in AMO- Positivphasen, weil dann der vermehrte Wärmeeintrag in die Arktis das Temperaturgefälle zwischen Süd und Nord verringert. Es ist aber nicht ausgeschlossen, dass der jüngste Eisrückgang auch noch andere Ursachen haben kann.

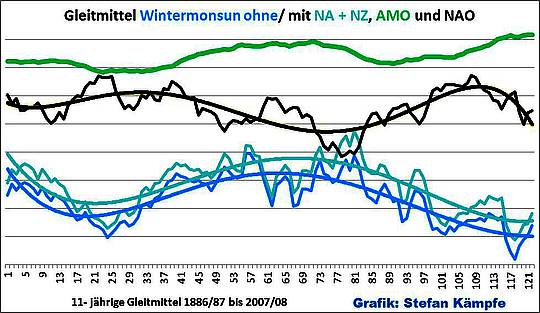

Nach diesen Vorbetrachtungen wollen wir uns nun das Verhalten des Clusters „Wintermonsun“ (quasi das Gegenteil des Sommermonsuns, der Wind weht jetzt vom kalten Festland auf die wärmere See), ansehen:

Abb. 10: Die beiden bläulichen Kurven zeigen den Häufigkeitsverlauf aller meist sehr kalten Großwetterlagen mit vorwiegend nördlichem bis östlichem Wind in der untersten Troposphäre im Winter über Mitteleuropa. Da strittig ist, ob die Nordlagen im engsten Sinne (NA + NZ) hinzugehören, weil sie erstens häufig eine bodennahe nordwestliche Strömung aufweisen und sie zweitens durch den Weg der Luftmassen über die relativ warme Ost- und Nordsee meist nur wenig kühlen, sind sie in der untersten (Blauen) Kurve nicht enthalten- aber im Häufigkeitsverhalten zeigen sich kaum Unterschiede. Alle diese kalten Wetterlagen werden positiv von der AMO beeinflusst (in deren Warmphasen sind sie häufiger), und sie verhalten sich konträr zum NAO- Index. Aber trotz der synchronen Schwingung mit der AMO und der momentan geringen Arktiseisausdehnung, sind diese Wetterlagen heute deutlich seltener, als in den 1880er Jahren oder zur Mitte des 20. Jahrhunderts.

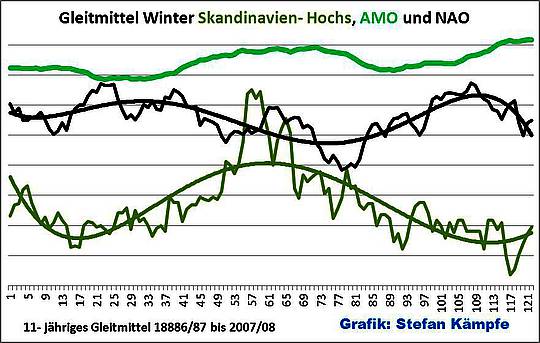

Es zeigt sich also, dass auch dieser Mythos auf tönernen Füßen steht- trotz der heute etwas höheren Wassertemperaturen und der geringeren Eisausdehnung in der Arktis sind zu Kälte neigende winterliche Großwetterlagen heute seltener, als zu den beiden letzten AMO- Positivphasen des späten 19. Jahrhunderts und der 1930er bis zu den frühen 1960er Jahren. Und um jeden Zweifel auszuräumen, das Wetterlagen- Cluster sei so geschickt gewählt, dass die wirklich zu extremster Winterkälte neigenden Lagen, die berühmt- berüchtigten Skandinavien- Hochs, nicht mehr zur Geltung kämen, hier zur Entkräftung aller Zweifel deren Cluster „Skandinavien- Hochs“ (Ostlagen im engeren Sinne):

Abb. 11: Auch wenn man nur die Skandinavien- Hochs (olivgrün) als „Ostlagen im engeren Sinne“ betrachtet- sie unterscheiden sich vom „Wintermonsun“ nur durch ihre markante Häufung in den 1940er Jahren (strenge Kriegs- und Nachkriegswinter).

Nun muss aber noch die Frage geklärt werden, warum die Winter im frühen 21. Jahrhundert bislang wieder etwas kälter wurden, obwohl in den Abb. 10 und 11 bisher kein wesentlicher Häufigkeitsanstieg der sehr winterkalten Lagen am Ende des Untersuchungszeitraums erkennbar wird. Die folgende Abbildung zeigt die Ursachen dafür:

Abb. 12: Ab etwa der Mitte der 1990er Jahre häuften sich Lagen mit Nordanteil (Blau), etwas später auch Meridionale Lagen (Dunkelgrau); Zonale Lagen (Großwettertyp West, Grauviolett) hingegen nahmen ab. Zwecks Übersichtlichkeit musste hier auf die Darstellung des winterlichen NAO- Index verzichtet werden.

Im Cluster „Meridionale Lagen“ sind auch alle Südlagen enthalten, die im Winter aber kaum häufiger wurden und meist auch nicht erwärmend wirken, dazu sämtliche Ost- und Nordlagen. Das Cluster „Nordanteil“ beinhaltet alle Nord- und Nordostlagen (insgesamt 8) sowie zusätzlich die beiden Nordwestlagen. Eine genauere Prüfung ergab, dass die Großwetterlagen TRM und NWZ deutlich, NZ, HNZ und HB etwas häufiger wurden, während die beiden Nordostlagen sowie NWA deutlich seltener wurden und sich die Häufigkeiten bei NA und HNA kaum änderten. Die häufiger gewordenen Lagen zeichnen sich im Langjährigen Temperaturmittel meist durch normale bis leicht unternormale Wintertemperaturen mit Tagesmitteln zwischen minus 2 und +2°C aus; in einzelnen Fällen oder an einzelnen Tagen können sie deutlich zu mild, mitunter auch deutlich zu kalt, sein. Und weil die Westlagen insgesamt seltener wurden, und das auch noch ausschließlich auf Kosten der deutlich wärmenden WA- und WZ- Lagen (Abb. 7 und 9), mussten die Wintertemperaturen in den letzten Jahren wieder etwas fallen.

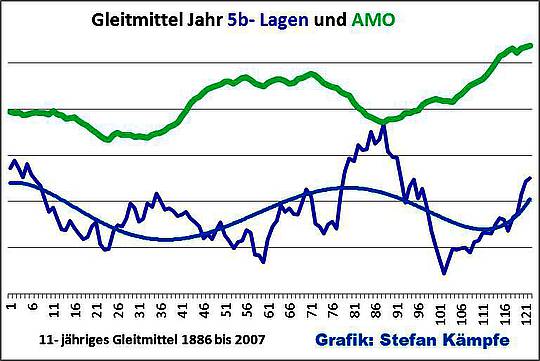

Als letzter Mythos soll noch ein Blick auf die angeblich „immer häufiger auftretenden Hochwasserlagen“ geworfen werden. Im Rahmen der Winterbetrachtung hatten wir gerade schon gesehen, dass Westwetterlagen, welche besonders in Westdeutschland (Rhein und Nebenflüsse) die berüchtigten Winterhochwasser verursachen, einer Rhythmik unterliegen und keinen dauerhaften Trend zur Häufigkeitszunahme zeigen. Bleiben die Wetterlagen mit Potential zu 5b- Charakter, das sind meist Lagen mit kalter bodennaher Nordwest-, Nord- bis Ostströmung, während in der Höhe feucht- warme Luftmassen mitunter aus Ost, meist aber Südost, Süd oder Südwest, aufgleiten. Diese können ganzjährig Hochwasser besonders in Ost- und Süddeutschland verursachen, wobei aber die gesamte Variationsbreite von nur ein paar Regentropfen oder Schneeflocken bis hin zu (glücklicherweise seltenen) schwersten Unwettern möglich ist, was ihre Beurteilung erschwert. Dass es nur ein gutes Jahrzehnt nach dem August- Hochwasser von 2002 erneut zu schwersten Überflutungen in Ostdeutschland kam (Mai/Juni 2013), löste natürlich Befürchtungen aus, die betreffenden Wetterlagen mit 5b- Charakter könnten sich massiv häufen; was aber sagen uns die Daten?

Abb. 13: Mehr Lagen mit Potential für Starkniederschläge in Ost- und Süddeutschland- Mitnichten! Zwar nahmen 5b- artige Lagen (Dunkelblau) seit ihrem Minimum um 1990 wieder leicht zu- doch auch ihr Häufigkeitsverhalten unterliegt einer gewissen Rhythmik- ein eindeutiger Trend zur dauerhaften Häufung fehlt; und in den 1880er und 1970er Jahren waren sie häufiger als heute.

Auch hier muss angemerkt werden, dass sich die Häufigkeitsverhältnisse innerhalb des Clusters zugunsten der TRM- Lagen verschoben haben. Etwas öfter traten in jüngster Vergangenheit auch HFZ, HNFZ und HNZ auf, während NZ, NEZ und TM deutlich seltener und SEZ in fast unveränderter Häufigkeit zu beobachten waren. Wesentliche Rückschlüsse auf ein erhöhtes Unwetterpotential lassen sich daraus aber schon deshalb nicht ableiten, weil die meisten dieser Lagen erstens relativ selten vorkommen und sie zweitens in ihren räumlichen Auswirkungen (es können nur sehr kleine Areale, mitunter jedoch ganze Landstriche von den Überschwemmungen betroffen sein) stark variieren. Ob Hochwasser oder andere witterungsbedingte Katastrophen überhaupt als solche empfunden und wahrgenommen werden, hängt auch sehr stark von den sozial- ökonomischen, politischen und gesellschaftlichen Rahmenbedingungen ab. Im Amazonasbecken kommen die Ureinwohner mit jährlich wiederkehrenden Überflutungen von 10 bis 15 Metern Höhe problemlos zurecht. Für hunderte Millionen Menschen in Südasien sind die von den jährlich wiederkehrenden Monsunregenfällen verursachten Hochwasser ebenfalls Alltag. Der Umwelt- und Hochwasserschutz in Deutschland ist jedoch in sich widersprüchlich. Einerseits wird dem Naturschutz große Aufmerksamkeit gewidmet. Auch deshalb wurden- trotz der Beteuerungen nach der Flutkatastrophe von 2002- viele Dammbauprojekte verzögert oder verhindert, obwohl sich begrünte Dämme aus Erde meist problemlos in die Landschaft einfügen beziehungsweise der Pflanzen- und Tierwelt kaum schaden. Andererseits werden selbst in einem Kleinstaat wie Thüringen pro Tag etwa 3 Hektar Fläche versiegelt, so dass die Pufferwirkung der natürlich gewachsenen Böden als Wasserspeicher weiter geschwächt wird.

Zusammenfassung und Ausblick

Im Rahmen dieser Arbeit konnte gezeigt werden, dass…

1. …die Deutschland- Temperaturen von der AMO und der Häufigkeit bestimmter Wetterlagen mit beeinflusst werden, wobei die Zusammenhänge im Jahresmittel nur gering bis mäßig sind. Im Winter üben jedoch die meisten Wetterlagen mit westlicher Strömung und solche mit östlicher Strömung einen sogar dominanten Einfluss auf die Deutschland- Temperaturen aus. Dies gilt außerdem für die einzelnen Wintermonate sowie für einzelne Sommermonate, jedoch nur für das Cluster „Kontinentale Hochdrucklagen“. Ansonsten vermag die Länge und Intensität der Sonnenscheindauer in der strahlungsreicheren Jahreszeit luftmassenbedingte Unterschiede, welche von den verschiedenen Großwetterlagen und deren Häufigkeitsverteilung verursacht werden, teilweise auszugleichen, so dass zwischen Ende März und Anfang Oktober insgesamt nur mäßige Zusammenhänge zwischen Wetterlagen und Temperaturen bestehen.

2. …die AMO das Häufigkeitsverhalten bestimmter Wetterlagen andeutungsweise mit beeinflusst, wobei meist erwärmend wirkende Süd- und Südwestlagen mit steigenden Wassertemperaturen tendenziell häufiger und solche mit nördlichen bis östlichen Strömungsanteilen eher seltener wurden. Dabei „schwingen“ nördliche Lagen im Takt der AMO; Westlagen im engeren Sinne verhalten sich entgegengesetzt. Übergeordnete Antriebsmechanismen für dieses Verhalten werden vermutet.

3. …es insgesamt eine (bislang dauerhafte) Häufigkeitszunahme nur bei den Süd- und vor allem den Südwestlagen sowie bei den Troglagen gab. Die in Mitteleuropa insgesamt viel häufigen Westlagen zeigen hingegen eine rhythmische Zu- und Abnahme, die andeutungsweise von der AMO, im Winter außerdem deutlich von der NAO, beeinflusst wird, was besonders im Winter Auswirkungen auf die Deutschland- Temperaturen hat (tendenziell mildere Winter in Phasen mit positiven NAO- Indizes und häufigeren Westlagen).

4. …sich bei gesamtheitlicher Betrachtung am Langzeitverhalten der Großwetterlagen bislang keine gravierende Zunahme von Lagen mit Extremwetterpotential erkennen lässt. Die Häufung der im Sommer bedingt zu Hitzewellen neigenden Südlichen Lagen wurde durch die Abnahme der in dieser Jahreszeit insgesamt sehr warmen Hochdrucklagen teilweise kompensiert. Die Rhythmik der westlichen Lagen bedingte die vorübergehende Häufung der milden Winter und Winterstürme um 1990, und der auf verschiedenen Ursachen, unter anderem der AMO- Positivphase, beruhende Eisrückgang bewirkte bislang keine Häufung der für extreme Kältewellen infrage kommenden winterlichen Wetterlagen. Auch eine wesentliche Häufung der Lagen mit Potential für großflächige Starkniederschläge blieb aus, weil sich die Zu- und Abnahmen der dafür infrage kommenden einzelnen Wetterlagen in etwa die Waage hielten.

Das rhythmische Verhalten der hier betrachteten Größen und deren Einfluss auf das Deutschland- Mittel der Lufttemperatur (die ebenfalls hierfür sehr wichtige Sonnenaktivität, welche auch die AMO mit beeinflussen kann, die Intensität der allgemeinen, globalen Zirkulation sowie weitere, mögliche Einflussfaktoren wie El Nino, QBO, die Rhythmik weiterer Meeresströmungen oder die Wassertemperaturen der Randmeere Nord-/Ostsee und Mittelmeer konnten aus Umfangsgründen im Rahmen dieser Arbeit nicht geprüft werden) verleitet dazu, Mutmaßungen über die weitere Zukunft anzustellen. Sichere Vorhersagen sind nicht möglich, und es kann nicht oft genug davor gewarnt werden, beobachtete Trends und Zusammenhänge bedenkenlos in die Zukunft zu extrapolieren. Trotzdem sollte, natürlich nur im Rahmen weiterer Untersuchungen, über folgende Szenarien nachgedacht werden:

1. Falls die AMO ihre bisherige Rhythmik beibehält, hat sie aktuell ihr Maximum erreicht oder bereits leicht überschritten, so dass im Atlantik für die kommenden 20 bis 30 Jahre mit fallenden Wassertemperaturen zu rechnen ist. Die seit 2003 insgesamt stark rückläufige Sonnenaktivität dürfte sich nach den (freilich mit Unsicherheiten behafteten) Vorhersagen (ABDUSSAMATOV 2012, CALDER/SVENSMARK 2007, MALBERG 2002 bis 2013; VAHRENHOLT/LÜNING 2012, LANDSCHEIDT 1983, LEISTENSCHNEIDER, 2011) bis mindestens etwa 2050 weiter abschwächen, was sich zeitverzögert auch auf die AMO auswirken kann, so dass insgesamt eine Abnahme der Wassertemperaturen im 21. Jahrhundert nicht unwahrscheinlich ist.

2. Mit der zyklusbedingten und tendenziellen Abnahme der AMO- Werte könnte sich das Häufigkeitsverhalten der Großwetterlagen im 21. Jahrhundert umkehren- tendenziell wieder weniger Südliche Lagen; im Sommer wieder mehr feucht- kühle Lagen („Sommermonsun“); insgesamt im Jahr wieder mehr Hochdrucklagen sowie mehr Lagen mit nördlicher Strömungskomponente.

3. Falls sich auch die Rhythmik der westlichen Lagen fortsetzt, so ist möglicherweise das Minimum ihrer Häufigkeit aktuell bereits erreicht. Eine Zunahme der Westlagen könnte im Winter den aktuell beobachteten Rückgang der Wintertemperaturen in Deutschland stoppen oder zumindest dämpfen.

Die vorliegende Arbeit konnte nur die Möglichkeit bestimmter Zusammenhänge andeuten und zu weiterer Forschungsarbeit anregen. Diese wird nötig sein, um die äußerst spannenden Zusammenhänge besser zu quantifizieren und daraus möglicherweise präzisere Vorhersagen für die künftige Entwicklung von Witterung und Klima in Deutschland zu treffen.

Verfasst und zusammengestellt von Stefan Kämpfe, Weimar, 2012/2013.

Literaturliste und Informationsquellen für alle drei Teile

Abdussamatow, H. I. (2012): Zweihundertjährige Abnahme der Solarstrahlung führt zu einem Ungleichgewicht des thermischen Budgets der Erde und zu einer Kleinen Eiszeit. Petersburg 2012 http://nextgrandminimum.files.wordpress.com/2012/11/abduss_apr.pdf

Alles schon einmal dagewesen – Arktische Meereisschmelze in der ersten Hälfte des 20. Jahrhunderts (2012). www.kaltesonne.de/

AMO smoothed from the Kaplan SST V2 Calculated at NOAA/ESRL/PSD1 http://www.esrl.noaa.gov/psd/data/timeseriesimeseries/AMO/

Atlantische Multidekaden- Oszillation https://de.wikipedia.org/wiki/Atlantische_Multidekaden-Oszillation

Bissolli, P. (1999/2000): Kommen Westlagen häufiger vor als früher? Veröffentlicht im Klimastatusbericht 1999 des DWD, erschienen im Jahr 2000.

Bissolli, P. (2001/2002): Wetterlagen und Großwetterlagen im 20. Jahrhundert. Veröffentlicht im Klimastatusbericht 2001 des DWD, erschienen im Jahr 2002.

Bissolli, P., Dittmann, E. (1998 bis 2005): Objektive Wetterlagenklassifikation. Veröffentlicht in den Klimastatusberichten 1998 bis 2005 des DWD, erschienen 1999 bis 2006.

Borchert, H.(2013): Die bodennahen Temperaturen in Potsdam und Hohenpeissenberg und Sonnenfleckenhäufigkeit von 1900 bis 2012. http://www.eike-klima-energie.eu/news-cache/die-bodennahen-temperaturen-in-potsdam-und-hohenpeisenberg-und-sonnenfleckenhaeufigkeit-von-1900-bis-2012/

Calder, N., Svensmark, H. (2007): The Chilling Stars – A New Theory of Climate Change, übersetzt ins Deutsche von Helmut Böttiger: Sterne steuern unser Klima: Eine neue Theorie zur Erderwärmung. Patmos Verlag, Düsseldorf 2008.

Climate4you: Low clouds tend to have a net cooling effect on global climate. Scatter diagram showing the total monthly global cloud cover plotted versus the monthly global surface air temperature, since July 1983. High values of global cloud cover is associated with low global temperatures, demonstrating the cooling effect of clouds. http://www.climate4you.com/ClimateAndClouds.htm

Deutscher Wetterdienst (DWD) (2010, 2011, 2012, 2013): Großwetterlagen- Anzahl der Tage. www.dwd.de

Deutscher Wetterdienst (Herausgeber): Stadtklima. Hauptschriftleiter M. Schlegel. promet, Jahrgang 9, Heft 4, 1979.

Fett, W. (2012): Klimawandelschuldzuweisung: Mensch oder doch Sonne? Beiträge des Instituts für Meteorologie der Freien Universität Berlin zur Berliner Wetterkarte, Beilage 73/12 (Sonderbeilage 35/12) vom 12.12.2012.

Fotos aus den dreißiger Jahren: Grönland-Gletscher haben sich damals schneller zurück gezogen als heute (2012)… www.eike-klima-energie.eu Vom 15.06.2012.

Hess, P., Brezowsky, H.: Katalog der Großwetterlagen Europas. Ber. Dt. Wetterd. in der US- Zone 33, 1952.

Hess, P., Brezowsky H.: Katalog der Großwetterlagen Europas. 2. neu bearbeitete und ergänzte Auflage. Ber. Dt. Wetterd. 15 (113), 1969.

Hess, P., Brezowsky, H.: Katalog der Großwetterlagen Europas 1881–1976. 3. verbesserte und ergänzte Aufl.. Ber. Dt. Wetterd. 15 (113), 1977.

Heyer, E.: Witterung und Klima. Leipzig 1977.

Hoffmann, G.; Müller, B.: Nebel in Berlin- Dahlem (II). Klimanormalperiode 1961- 90. Beiträge des Instituts für Meteorologie der Freien Universität Berlin zur Berliner Wetterkarte, Beilage 65/94 (Sonderbeilage 17/94) vom 23.06.1994

Hurrell Station-Based Seasonal NAO Index http://climatedataguide.ucar.edu/sites/default/files/cas_data_files/asphilli/nao_station_seasonal_2.txt

Kämpfe, S., Kowatsch, J., Leistenschneider, R.: Starker Temperaturanstieg seit 1979 in Erfurt- warum CO2 dabei nur eine unbedeutende Nebenrolle spielt! Teil 1 Vorstellung der Hauptakteure (20.10.2012) und Teil 2 „Trittbrettfahrer“ CO2- Das Phantom der Klimawissenschaft (26.10.2012) www.eike-klima-energie.eu

Kämpfe, S., Kowatsch, J., Leistenschneider, R. (2013): Erst zum Gipfel, dann talwärts: Die Temperaturentwicklung in Deutschland seit 1980 und deren wesentliche Ursachen. Teile 1 bis 3. www.eike-klima-energie.eu

Kämpfe, S. (2009): Die Flora Weimars und seiner Umgebung. Weimarer Schriften, Stadtmuseum Weimar.

Kämpfe, S., Kowatsch, J., Leistenschneider, R (2013).: Die Winter werden in Deutschland seit einem Vierteljahrhundert deutlich kälter. www.eike-klima-energie.eu

Kämpfe, S. (2012): Zu trockener, warmer, sonniger Herbst 2011 in Thüringen -ungewöhnlich oder einfach nur schön? Beiträge des Instituts für Meteorologie der Freien Universität Berlin/Berliner Wetterkarte, Beilage 03/12 (SO 01/12) vom 04.01.2012 und in leicht geänderter Fassung bei www.eike-klima-energie.eu 27.12.2011.

Kämpfe, S. (1997): Nebel in Thüringen. Eine Untersuchung unter Zuhilfenahme von Theorie und Praxis. Beilage Nr. 179/1997 zur Wetterkarte des Deutschen Wetterdienstes, Offenbach am Main (liegt nur analog vor).

Kämpfe, S. (1999): Die Horizontalsichtweite- Anmerkungen zu einer interessanten meteorologischen Größe. Beilage Nr. 53/1999 zur Wetterkarte des Deutschen Wetterdienstes, Offenbach am Main (liegt nur analog vor).

Kämpfe, S., Kowatsch, J., Leistenschneider, R (2013).: Klimawandel in Deutschland bedeutet Abkühlung- trotz deutlicher Zunahme von CO2. www.eike-klima-energie.eu

Koch, H. G. (1953): Wetterheimatkunde von Thüringen. Gustav Fischer Verlag Jena (nur analog vorliegend).

Kowatsch, J., Leistenschneider, R. (2010): Der Wärmeinseleffekt (WI) als Antrieb der Temperaturen- eine Wertung der DWD- Temperaturmessstationen. www.eike-klima-energie.eu 04.10.2010.

Landscheidt, T. (1983): Solar oscillations, sunspot cycles and climatic change. Boulder 1983.

Leistenschneider, R., Kowatsch, J. (2012): Der Wärmeinseleffekt (WI) als maßgeblicher Treiber der Temperaturen. www.eike-klima-energie.eu 20. Januar 2012.

Leistenschneider, R., Kowatsch, J. (2012): Der Wärmeinseleffekt (WI) als maßgeblicher Treiber der gemessenen Temperaturen. www.eike-klima-energie.eu 04.08.2012.

Leistenschneider, R. (2011): Dynamisches Sonnensystem- die tatsächlichen Hintergründe des Klimawandels, Teile 1 bis 8

Teil 1 – Die Sonne bestimmt den Temperaturgang

Teil 2 – Die Sonne, der faszinierende Stern

Teil 3 – Sonnenflecken und ihre Ursachen

Teil 4 – Die Sonnenatmosphäre, Korona, Heliosphärische Stromschicht,

interplanetares Magnetfeld

Teil 5 – Die variable Sonne

Teil 6 – Der Einfluss der Sonne auf unser Wetter/Klima

Teil 7 – Der Einfluss der Sonne auf die Wolkenbedeckung über Svensmark hinaus

Teil 8 – Zukünftige Temperaturentwicklung und deren Schwankungen.

Teile 1 bis 8 bei www.eike-klima-energie.eu

Malberg, H. (2002 bis 2013) Beiträge des Instituts für Meteorologie der Freien Universität Berlin/Berliner Wetterkarte:

– Über den Klimawandel in Mitteleuropa seit 1850 und sein Zusammenhang mit der Sonnenaktivität. SO 17/02

– Die globale Erwärmung seit 1860 und ihr Zusammenhang mit der Sonnenaktivität. SO 27/02

– Die nord- und südhemisphärische Erwärmung seit 1860 und ihr Zusammenhang mit der Sonnenaktivität. SO 10/03

– Der solare Einfluss auf das mitteleuropäische und globale Klima seit 1778 bzw. 1850. SO 01/07 (2007) – In Memoriam Prof. Richard Scherhag

– Über den dominierenden solaren Einfluss auf den Klimawandel seit 1701. SO 27/07

– El Nino, Vulkane und die globale Erwärmung seit 1980. SO 34/07

– El Niño und der CO2-Anstieg sowie die globale Erwärmung bei CO2-Verdopplung. SO 02/08

– Die unruhige Sonne und der Klimawandel. SO 20/08

– Über die kritische Grenze zwischen unruhiger und ruhiger Sonne und ihre Bedeutung für den Klimawandel. SO 03/09

– La Niña – El Niño und der solare Einfluss – Der Klimawandel 1950-2008. SO 11/09

– Über das Stadtklima und den Klimawandel in Deutschland seit 1780. SO 18/09

– Langfristiger Klimawandel auf der globalen, lokalen und regionalen Klimaskala und seine primäre Ursache: Zukunft braucht Herkunft. SO 29/09

– Der solare Einfluss auf den Klimawandel in Westeuropa seit 1672. SO 37/09 (2009)

– Rekonstruktion des Klimawandels seit 1860 bzw. 1672 aufgrund solarer Aktivitätsänderungen, SO 11/10 (2010)

– Kurzperiodische und dekadische Klimavariabilität im Zeitraum 1980-2009. SO18/10 (2010)

– Über scheinbare und tatsächliche Klimaerwärmung seit 1850. SO 26/10 (2010)

– Analyse des solaren Effekts und des langfristigen Klimawandels seit 1680 sowie des gegenwärtigen kurzperiodischen Klimaverhaltens SO 09/11 (2011)

– Über sprunghafte Anstiege von CO2 und globaler Temperatur SO 05/12 (2012)

– Fakten zum Klimawandel seit der Kleinen Eiszeit SO 01/13.

NABEL (Nationales Beobachtungsnetz Luft in der Schweiz) www.bafu.admin.ch/luft

Pelz, J. (1993): Das Zeitverhalten des Schwebstaubs und der Niederschlagsbeimengungen in Berlin- Dahlem. Beiträge des Instituts für Meteorologie der Freien Universität Berlin zur Berliner Wetterkarte, Beilage 26/93 (Sonderbeilage 4/93) vom 26.02.1993.

Pelz, J. (1994): Dreißig Jahre Staubmessungen in Berlin- Dahlem. Beiträge des Instituts für Meteorologie der Freien Universität Berlin zur Berliner Wetterkarte, Beilage 100/94 (Sonderbeilage 31/94) vom 21.10.1994.

PIK Werte der Lufttemperaturen, der Sonnenscheindauer und der Globalstrahlung in Potsdam www.pik-potsdam.de/services

Puls, K. E. (2009): Viel Wind um Nichts. Die prognostizierte Zunahme von Stürmen bleibt aus. http://www.eike-klima-energie.eu/uploads/media/PULS.Stuerme_LP.0908.pdf

Schönwiese, Chr- D., Trömel, S.: Langzeitänderungen des Niederschlags in Deutschland. http://www.climate-service-center.de/imperia/md/content/csc/warnsignalklima/Warnsignal_Klima_Kap3.1_3.1.6_Scho__nwiese.pdf

Standardisierte beziehungsweise normalisierte NAO- Werte Januar 1950 bis Dezember 2011: www.cpc.noaa.gov/

Tabellen der Sonnenfleckenrelativzahlen www.schulze-md./de (dort auch Abbildungen aller 23 Zyklen) und www.swpc.noaa.gov/solarCycle

Tinz, B. (2002, 2003): Die Nordatlantische Oszillation und ihr Einfluss auf die europäischen Lufttemperaturen. Veröffentlicht im Klimastatusbericht 2002 des DWD, erschienen im Jahr 2003.

Vahrenholt, F., Lüning, S. (2012): Die kalte Sonne. Warum die Klimakatastrophe nicht stattfindet. Hoffmann und Campe, Hamburg 2012.

Wehry, W. (2009): Mehr Sonnenschein, weniger Nebel und höhere Temperatur- anthropogene Klima- Änderung? Beiträge des Instituts für Meteorologie der Freien Universität Berlin zur Berliner Wetterkarte, Beilage 47/09 (Sonderbeilage 23/09) vom 09.07.2009.

Wehry, W., Myrcik, G. (2006): Sonniger und warmer Herbst- Anzeichen auch für einen milden Winter? Beiträge des Instituts für Meteorologie der Freien Universität Berlin zur Berliner Wetterkarte, Beilage 86/06 (Sonderbeilage 29/06) vom 13.12.2006.

Werner, P. C., Gerstengarbe, F.W.; Rüge, U. (1999): KATALOG DER GROSSWETTERLAGEN EUROPAS (1881-1998) NACH PAUL HESS UND HELMUT BREZOWSKY. Potsdam und Offenbach a. M., 1999.

Werner, P. C., Gerstengarbe, F.W. (2010): KATALOG DER GROSSWETTERLAGEN EUROPAS (1881-2009) NACH PAUL HESS UND HELMUT BREZOWSKY. PIK Report No. 119 Potsdam 2010.

Zeitreihe der Lufttemperatur in Deutschland ab 1761. Jahres-, Jahreszeiten- und Monatswerte. http://de.wikipedia.org/wiki/Zeitreihe_der_Lufttemperatur_in_Deutschland