800×600

Gleich im 1. Kapitel mit der Überschrift „Imagine“, das man so etwas wie eine Einleitung nennen kann, wird ein Zitat des Club of Rome dem gegenüber gestellt, was Delingpole uns vorzustellen auffordert. Weil sich das wie ein roter Faden durch das ganze Buch zieht, folgt hier die erste Übersetzung (Seite 1 bis 2 oben):

Zunächst das Zitat des Club of Rome, mit dem Delingpole sein Buch einleitet:

„Auf der Suche nach einem neuen Feind, der uns einigen könnte, kam uns die Idee, dass Verschmutzung, die Bedrohung einer globalen Erwärmung, Wasserknappheit, Hungersnöte und dergleichen diesem bestreben nachkommen könnten … All diese Gefahren werden durch menschliche Eingriffe heraufbeschworen … der wirkliche Feind ist also die Menschheit selbst.“

(Council des Club of Rome, 1991)

Dem stellt Delingpole nun seine Vorstellungen gegenüber, die er mit einer logischen Schlussfolgerung abschließt:

Stellen wir uns vor, dass alles, was wir über die Umwelt wissen, falsch ist.

Stellen wir uns vor, die globale Erwärmung wäre etwas Wünschenswertes und nicht etwas, das man fürchten muss.

Stellen wir uns vor, dass organische Nahrungsmittel, Nachhaltigkeit, Biotreibstoffe und der WWF viel schlimmere Auswirkungen auf die Umwelt und seine Bewohner hätten als GM Food, die Industrie und Exxon Mobil.

Stellen wir uns vor, dass es nicht im Mindesten eine Rolle spielt, wie groß Ihr Kohlenstoff-Fußabdruck ist, wie oft Sie mit dem Auto fahren, wie viele Meilen Sie im Flugzeug zurücklegen ohne den Zwang, sich auch nur ansatzweise schuldig zu fühlen hinsichtlich der Umweltschäden, die Sie damit verursachen.

Stellen wir uns vor, dass Kohlendioxid unser Freund wäre.

Stellen wir uns vor, dass der schlimmste Massenmörder eine Frau wäre, die gegen Chemikalien und Pestizide wettert, und der größte Retter der Menschheit der Mann wäre, der hunderte Millionen vor Hunger bewahrt durch genverändertes Getreide und moderne Landwirtschaft.

Stellen wir uns vor, dass wir nur mit einem Bruchteil des Geldes, dass wir für den ‚Kampf gegen den Klimawandel’ ausgeben, sicherstellen können, das kein Kind der Welt mehr hungrig oder unterernährt ist und dass jedermann in der Welt Zugang zu sauberem Trinkwasser hätte.

Stellen wir uns vor, dass ‚Überbevölkerung’ ein illusorisches Problem wäre.

Stellen wir uns vor, dass fossile Treibstoffe ein Wunder wären, das wir hochschätzen sollten, und nicht etwa ein Fluch.

Stellen wir uns vor, wir könnten damit aufhören, uns Sorgen über ‚zu Ende gehende Ressourcen’ machen.

Stellen wir uns vor, dass es den Eisbären, Gletschern, Korallenriffen, Regenwäldern, den Pazifikinseln und den polaren Eiskappen einfach durchweg gut gehen würde.

Stellen wir uns vor, dass wirtschaftliches Wachstum, weit davon entfernt, die Welt zu zerstören, diese sauberer, gesünder, glücklicher macht – und mit mehr Platz für uns alle.

Stellen wir uns vor…

Wie ich sicher annehme, haben Sie längst erkannt, dass sie sich all diese Dinge gar nicht vorstellen brauchen, weil sie allesamt schon jetzt wahr sind.

Es folgen dann mehrere Beispiele, in denen Verleumdungen der Alarmisten sowie haarsträubende Äußerungen vieler Personen, die teilweise schon den Tatbestand der Volksverhetzung erfüllen, den Aussagen und Studien der Realisten gegenüber gestellt werden.

Schließlich macht sich Delingpole Gedanken über die Gründe, warum sich die Realisten diesem von Regierungen und Medien entfesselten Sturm aussetzen (Seite 9 unten):

Was sie alle antreibt – und mit Sicherheit mich selbst – ist ihr absoluter Schrecken darüber, was die grüne Bewegung unserer Welt antut – alles im Namen, diese zu ‚retten’. Regenwälder werden vernichtet und Menschen hungern als Folge der Politik gegenüber Biodiesel. Flora und Fauna werden zerstört, und die Landschaft wird verspargelt durch Windparks. Und die Natur, einst eine Quelle endloser Freude, wird zunehmend zu etwas, gegenüber dem wir uns schuldig fühlen sollen, angestachelt durch Lehrer, Umweltaktivisten und elegischen Dokumentationen von David Attenborough auf BBC. Sie alle wollen uns verantwortlich machen für die (vermeintlich) schwindenden Pole.

Es folgen zahlreiche Beispiele, wie Politiker und Medien in vielen Ländern der Welt die globale Erwärmungskatastrophe sehen. Dabei gibt es so viele erschreckende Worte von Politikern und anderen Mächtigen, dass man sich immer wieder aufs Neue wundert…

Aber folgen wir weiter Delingpole. Wie gesagt, dieses erste Kapitel kann man als eine Art Einleitung für alles Folgende sehen. Es schließt mit den Worten (Seite 16):

Es spielt keine Rolle, wer ich bin, wie viel ich von Wissenschaft verstehe, ob ich es für Geld mache oder ob ich gegen alles bin oder weil ich zutiefst überzeugt und ernst bin. Und es spielt auch keine Rolle, ob die vom Menschen verursachte Katastrophe wirklich stattfindet oder nicht, weil der Beweis, dass sie nicht stattfindet, unmöglich geführt werden kann.

Was ich mit den folgenden Kapiteln machen werde ist, Ihnen die einzigen Dinge zu beweisen, die man in dieser traurigen Geschichte beweisen muss – von Narrentum und sinnloser Verschwendung, größer denn je in der Geschichte der Menschheit. Die Menschen, die ihnen verkünden, dass AGW fast sicher bevorsteht, sind ein Haufen Lügner, Schummler und Betrüger. Ihre Steuern werden erhöht, Ihre Freiheiten beschränkt und Ihr Geld einkassiert, um einer ‚Krise’ zu begegnen, die so außerordentlich unwahrscheinlich und so wenig durch Daten der realen Welt oder objektive Wissenschaft gestützt wird, dass sie genauso gut auch gar nicht existent sein könnte.

In Kapitel 2 geht es um Klimagate und wie es dazu gekommen war. Vieles davon ist aus anderen Quellen bekannt, so dass das hier übersprungen werden kann. Seine zusammenfassende Bewertung der Klimagate-E-Mails ist aber wieder sehr aussagekräftig (Seiten 36 bis 37 oben):

Die Natur der Klimagate-E-Mails sieht so aus: Die schlimmsten Teufeleien stecken oftmals in den obskuren und ziemlich weitschweifigen Details. Sollten Sie auf E-Mails des Inhalts gehofft haben wie ‚Klasse! Mal sehen, wie lange wir noch mit diesem lächerlichen Betrug der globalen Erwärmung durchkommen’ oder ‚Ja, ich weiß! Fügen wir doch dem Datensatz der Sommer in den achtziger Jahren noch weitere 10 Grad hinzu’, dann werden Sie enttäuscht. Es gibt wenig Beweise dafür, dass die Klimagate-Wissenschaftler nicht an AGW glauben. Im Gegenteil: die meisten E-Mails beweisen, dass sie nur allzu inbrünstig daran glauben. So inbrünstig, dass sie nichts Unrechtes darin erkennen, Beweise zu verzerren, um den Eindruck der wissenschaftlichen Gewissheit zu stärken oder einen ‚Konsens’ zu konstruieren, der in Wirklichkeit gar nicht existiert. Darin liegt der wirkliche Skandal von Klimagate: Es handelt sich um einen Fall von Wissenschaftlern, die die Regeln der Wissenschaft brechen und sich stattdessen wie politische Aktivisten verhalten.

Wir sehen, wie sie Daten ‚willkürlich herauspicken’ [cherry-picking], die ihre Theorien stützen und alle Daten vernichten, die das nicht tun. Wir sehen, wie sie Schlussfolgerungen aufgrund von Bauchgefühlen ziehen und nicht aufgrund von Beweisen. Wir sehen, wie sie Herausgeber von Magazinen, Journalisten und andere Wissenschaftler unter Druck setzen, die mit ihnen nicht übereinstimmen. Wir sehen sie Schmierenkampagnen lostreten. Wir sehen, wie sie den Begutachtungsprozess untergraben und entwürdigen. Wir sehen, wie sie falsche Graphen und irreführende Informationen in offizielle Berichte einschleusen, in Berichte, die doch den ‚goldenen Standard’ der internationalen wissenschaftlichen Kenntnisse repräsentieren sollen. Wir sehen, dass sie nicht nur Aufzeichnungen angemessen durchführen, sondern auch, wie sie die notwendigen, unersetzlichen Rohdaten vernichten, die zu sammeln und auszuwerten sie von den Regierungen bezahlt werden. Wir sehen, wie sie auf jede nur erdenkliche Weise verhindern, Daten bekannt zu geben, obwohl sie gesetzlich unter dem Freedom of Information Act dazu verpflichtet wären.

…

Am schlimmsten aber ist, dass die Klimagate-Wissenschaftler so unendlich viel Macht ausüben.

Dann stellt er diesen Machenschaften die Arbeitsweise der Realisten gegenüber sowie die Umstände, unter denen diese ihre Arbeiten durchführen und was man beim Hacken ihrer E-Mails finden würde (Seite 38):

Man würde nichts Ehrenrühriges finden, das mir das Gefühl gibt, dass mein Ruf beschädigt worden wäre. Vor allem würde man nichts finden, was mich zu einem leidenschaftlichen Leugner der globalen Erwärmung machen würde. Keine geheimen Zahlungen von Big Oil! (Was schade ist). Kein vertrauter Austausch mit Viscount Monckton oder Christopher Booker oder Pat Michaels darüber, wie man am Besten die Daten so zurechtbiegt, dass es so aussieht, als würde AGW nicht wirklich stattfinden. Es ist einfach nicht die Art und Weise, in der wir Skeptiker agieren.

Warum nicht? Weil wir das nicht nötig haben! Wir versuchen nicht, irgendetwas zu verstecken, und wir befinden uns mit Sicherheit nicht auf einer Mission, Lügen zu verbreiten. Das Gegenteil ist der Fall! Alles, worum es uns geht ist, dass die Wahrheit ans Licht kommt. Falls diese Wahrheit aufschlussreiche Beweise dafür hergibt, dass anthropogene CO2-Emissionen ein signifikanter, beispielloser und gefährlicher Klimatreiber sind, dann in Ordnung: Wir werden unseren Skeptizismus ablegen und anfangen, darüber zu diskutieren, wie man diesem Problem begegnen kann. Bis es soweit ist, ist alles, was wir wollen, eine offene und ehrliche Debatte, in der die bekannten Fakten verfügbar gemacht werden und in der der am besten belegte Sachverhalt vorherrschen soll bis zu dem Zeitpunkt, an dem ein besser belegter Sachverhalt auftaucht.

Das ist es, was uns von unseren Gegnern unterscheidet, und es ist ein Faktum, das ganz klar aus jenen Klimagate-E-Mails hervorgeht. Das Letzte, was diese Leute wollen, ist Offenheit und Ehrlichkeit. Schon beim leisesten Anklang eines Dissens’ begegnen sie diesem nicht mit der überlegenen Kraft ihrer Argumente, sondern sie schlagen zu mit Schikanen, Erpressung und persönlichen Angriffen.

Es geht weiter mit wirklich haarsträubenden Beispielen von Tom Wigley und Michael Mann, wie man mit solchen Leuten umgehen sollte. Das Kapitel schließt mit den Worten (Seite 40):

Das vielleicht Sympathischste, was man von den Klimagate-Wissenschaftlern sagen kann ist, dass sie aus freien Stücken daran glauben, Männer auf einer Mission zu sein, um die Welt zu retten, und dass sie uns allen mit dem Unterdrücken jedweden Dissens’ einen Gefallen tun. Falls das so ist, wäre es eine politische Entscheidung, keine wissenschaftliche. … Am Schluss dieses Kapitels möchte ich eine einfache Frage stellen. Nehmen wir mal für einen Moment an, dass es wirklich einen starken Konsens pro AGW gibt, und nehmen wir weiter an, dass die wissenschaftlichen Beweise für AGW so überwältigend sind – wie Mann, Jones et al zu glauben scheinen – dass man keine Opposition dulden muss. Wie kommt es dann, dass die Wissenschaftler im gesamten Klimagate-E-Mail-Schriftwechsel so schreckliche Angst davor haben, dass ihre Forschungen, Meinungen und ihre Glaubwürdigkeit einer offenen öffentlichen Debatte unterzogen werden? Was genau versuchen sie eigentlich zu verstecken?

Im dritten Kapitel mit der Überschrift „Es geht nicht um ‚die Wissenschaft’“ geht Delingpole ausführlich auf die Rolle von Margaret Thatcher ein. Er schlägt einen Bogen von einer katastrophalen Alarmismus-Rede am 27. September 1988 bis hin zu ihrem Buch Statecraft, in dem Thatcher hart mit den Alarmisten ins Gericht geht. Delingpole ist Engländer, daher liegt ihm dieser Punkt wohl nahe. Auch andere Politiker und öffentlich aktive Personen kommen mit ihren Plattitüden zu Wort. Das alles ist aber im Wesentlichen auch Gegenstand zahlreicher Beiträge u. a. hier beim EIKE, daher wird hier nicht weiter darauf eingegangen.

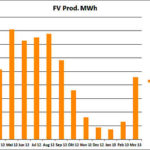

Das vierte Kapitel trägt den Titel ‚In the Pay of Big Koch’ [muss man das übersetzen?]. Und genau darum geht es auch im gesamten Kapitel, nämlich um Geld. Eingeleitet wird es von ein paar Beispielen des Jahreseinkommens bestimmter Personen an der Alarmisten-Front, dem Delingpole sein eigenes Einkommen gegenüberstellt (eine Zehnerpotenz weniger!) Es folgen zahlreiche Beispiele, in denen er Zuwendungen an die AGW-Seite solchen an die Skeptiker-Seite gegenüberstellt. Er zitiert Jo Nova, die errechnet hat, dass die AGW-Seite seitens öffentlicher oder industrieller Zuwendungen etwa 3500 mal so viel Geld erhalten hat als die Skeptiker-Seite (Seite 71).

Auch hier soll der Schlussabschnitt übersetzt werden (Seite 87):

Klimagate hat einen der größten wissenschaftlichen Skandale der Weltgeschichte ans Tageslicht gebracht, für den Milliarden Dollar Steuergelder verschwendet worden sind.

Und worin bestand die fast einhellige Reaktion des Establishments auf der ganzen Welt? Nun, es hat alle verfügbare Macht, alle Ressourcen und die ganze Autorität dazu verwendet, die durch Klimagate bekannt gewordenen Probleme zu leugnen.

Vor zehn, zwanzig, dreißig Jahren wären sie damit möglicherweise auch davon gekommen. Heute ist das aber einfach nicht mehr möglich. Von der geduldigen, akribischen Zerstörung des Hockeyschlägers von McIntyre und McKitrick über den Blogger Richard Norton …, Donna Laframboise und anderen sind die lügenden Lügner des großen grünen Öko-Schwindels einer Überprüfung ausgesetzt, so unbarmherzig und gnadenlos, dass man fast Mitleid mit ihnen bekommen könnte.

Fast!

Das fünfte Kapitel trägt die Überschrift ‚The Science is unsettled’. Eingeleitet wird es von dem Statement von Michael Crichton „Es gibt so etwas wie Konsens in der Wissenschaft nicht. Wenn es Konsens ist, ist es keine Wissenschaft. Wenn es Wissenschaft ist, ist es kein Konsens!“

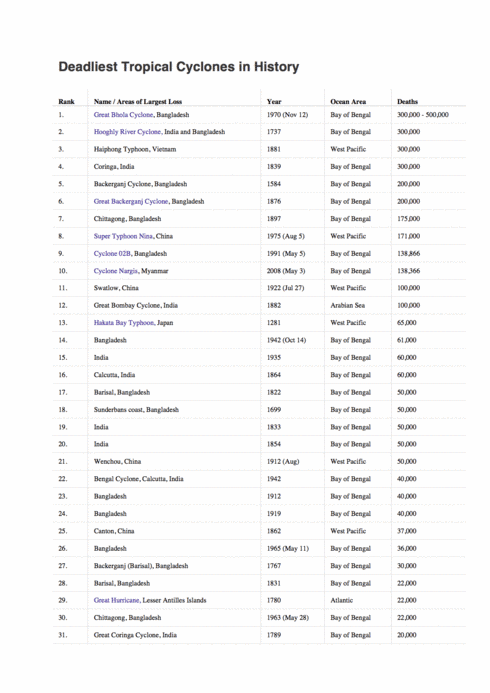

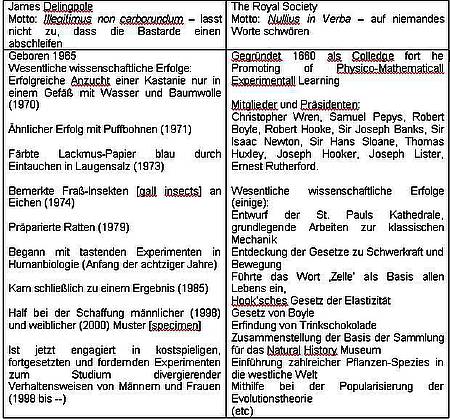

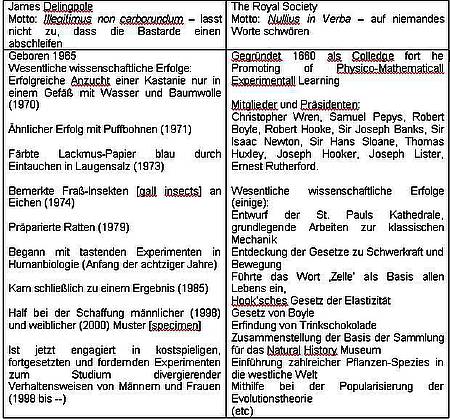

Im Folgenden werden zahlreiche Beispiele gelistet, in denen die Aussagen von Skeptiker-Einzelkämpfern der geballten Macht vom IPCC und Konsorten gegenüber gestellt werden. Dabei hebt er besonders die Royal Society hervor, mit der sich Delingpole selbst als ein solches Beispiel vergleicht. Stellvertretend für alle zeigt der auf Seite 94 diese Tabelle, die hier übersetzt eingefügt werden soll:

Und dann zitiert er die Stellungnahme eben dieser Royal Society zur globalen Erwärmung, in der zwar von heftigen Debatten um Einzelheiten die Rede ist, aber auch von einem bestehenden ‚überwältigenden Konsens hinsichtlich der Grundlagen’.

Die zusammenfassenden beiden Absätze am Schluss des Kapitels sollen hier wieder übersetzt werden (Seite 111):

Mit anderen Worten, ‚Klimaänderung’ hat wenig wenn überhaupt etwa mit ‚Wissenschaft’ zu tun, so wie Sie oder ich das Konzept verstehen könnten. Es handelt sich nicht um ein echt gefährliches Problem, das gelöst werden muss, sondern um eine handliche Entschuldigung – mit einer modischen grünen Patina – um bestimmte soziale und politische Agenden voranzutreiben unter dem Deckmantel ökologischer Rechtschaffenheit und wissenschaftlicher Autorität.

Nach Klimagate muss man fragen: ‚die wissenschaftliche Autorität welcher Wissenschaftler’? Alles ist gut für jemand wie Lord Rees, der die Haltung der Royal Society zur globalen Erwärmung verteidigt, indem er die Nullius-in-Verba-Keule schwingt als ob dieses Motto immer noch ein Emblem einer unwiderlegbaren Wahrheit ist. Tatsache ist aber, dass die Integrität seiner Institution – genauso wie die der US-Schwesterorganisation, die National Academy of Sciences – in Trümmern liegt, und zwar genau deswegen, weil sie etwas getan hat, das sie laut ihrem Motto niemals tun würde. Sie hat auf einen Klüngel postnormaler Wissenschaftler gehört, die mehr an politischem Aktivismus interessiert waren als an objektiver Wahrheit – und deren Wort dafür übernommen.

Im sechsten Kapitel mit der Überschrift „A Few Things you should Know about ‚Global Warming’ werden die wichtigsten Behauptungen der Alarmisten auf den Prüfstand gestellt und widerlegt. Weil das vielfach hier und in anderen Blogs auch schon gemacht wurde, kann dieses Kapitel weitgehend übersprungen werden. Am Ende nennt Delingpole einen Link, auf dem über 800 Probleme aufgelistet sind, deren Ursache die globale Erwärmung sein soll: http://www.numberwatch.co.uk/warmlist.htm. (Auch in dem im Subheader genannten Link findet sich am Ende ein solcher Link).

Im siebenten Kapitel, Titel ‚Watermelons’ geht es mehr um die dem Spektakel um die globale Erwärmung zugrunde liegende Psychologie. Zu Beginn stellt er die Ansichten eines gewissen Keith Farnish vor, der meint, dass der einzige Weg, den globalen ökologischen Kollaps zu verhindern darin besteht, die industrielle Zivilisation abzuschaffen. Delingpole schreibt dazu (Seite 139):

…Man kann mich altmodisch nennen, aber ich bin höchst interessiert daran, die industrielle Zivilisation zu erhalten, die abzuschaffen Farnish so bestrebt ist. Sie hat mir Arbeit gegeben, die Möglichkeit zu reisen, Unterhaltung, sauberes Wasser, gesunde Kinder, ein schönes Zuhause, angenehme Ferien und vieles mehr. Ich glaube, dass ich nur sehr ungern das Handtuch werfe, nur weil irgendein Kerl in einem Buch schreibt, dass dies die einzige Möglichkeit für das Überleben unseres Planeten ist. Und es macht mir große Sorgen, dass es Leute gibt, die dieses Zeug lesen und aus vollem Herzen zustimmen.

Einer von Ihnen ist James Hansen, der das Buch von Farnish in einer Rezension aufgepeppt hat. …

Und etwas weiter unten (Seite 140):

Klar, für Farnish und seine grünen Mitläufer sind wir genau das, was sie als ‚Leugner’ bezeichnen: unsere Aktivitäten und Ansichten sind das Ergebnis einer Mischung von Gier, Eigennutz, Selbstgefälligkeit und reflexartigem Konservativismus. Er würde einfach nie begreifen, dass wir unser Leben nur deswegen nicht ändern wollen, weil wir die Welt angeschaut, die Fakten studiert und erkannt haben, dass es dafür absolut keine Notwendigkeit gibt. Der Grund, warum er das niemals verstehen wird, ist der Glaube der Grünen wie aller anderen Zeloten auch, dass sie ein Monopol auf die einzige Wahrheit besitzen.

Dann folgt eine längere Passage, in der er hervorhebt, wie wichtig Umweltschutz ist und dass es gerade Menschen wie er sind, dem der Naturschutz sehr am Herzen liegt. Am Ende dieser Passage beschreibt er die in diesem Zusammenhang von den Wassermelonen ausgehende Gefahr so (Seite 145 unten):

Es gibt etwas, das alle hartgesottenen Grünen [hardcore greenies] überraschend gemeinsam haben. Ich nenne es die Mentalität ‚um-die-Stadt-zu-retten-müssen-wir-sie-zerstören’. Oder, wenn man mag, die Orthodoxie ‚Die Natur übertrumpft die Natur’. … Je genauer man die Kern-Grundsätze dieses Glaubens untersucht, umso mehr kommt man zu der Erkenntnis, dass an der grünen Religion nichts Kuscheliges, Lockeres oder irgendwie Liebenswertes ist. Tatsächlich könnte man sie als einen heidnischen Totenkult beschreiben, der im Hass auf die Menschheit wurzelt; der versessen darauf ist, fast alles zu zerschlagen, was die Menschheit bisher erreicht hat; der sklavisch, unheimlich und wahnwitzig einer herzlosen Gottheit opfert, die im Gegenzug nichts anbietet außer kalter Gleichgültigkeit.

Dann beschreibt er ausführlich seine Sicht der ‚Wassermelonen’ – grün außen, tiefrot innen. Unterlegt wird es mit Beispielen von Äußerungen einiger Personen wie (unter mehreren) Paul Ehrlich und einer Definition von Heinrich Himmler zum Begriff ‚Lebensraum’ (der so original im Buch steht).

Die Schlussabsätze auch dieses Kapitels sind wieder eine Übersetzung wert (Seiten155 und 156):

Mit etwas Glück habe ich Ihnen bis hierher zu zeigen vermocht, wofür die Wassermelonen stehen. Und damit meine ich nicht die netten, flauschigen Assoziationen, die die Bezeichnung ‚grün’ mit den Jahren entwickelt hat – pflegend, sich kümmernd, erhaltend, säubernd und so weiter. Ich meine vielmehr die Eckpfeiler des Glaubens, auf dem die grüne Religion basiert, wie er in den Schriften der einflussreichsten Philosophen zum Ausdruck kommt.

Diese Eckpfeiler des Glaubens, obwohl oft verkleidet als Sorge um die Natur und die Zukunft der Menschheit, wurzeln in bitterster Misanthropie und dem düstersten Pessimismus. Sie kümmern sich keinen Deut um die Myriaden Errungenschaften der Menschheit; sie ziehen es vor, unsere Rasse als ein Schandmal in der Landschaft zu betrachten, ein Parasit, eine Krankheit, die die ansonsten perfekte Ausgewogenheit des Ökosystems bedroht und die am Besten mit natürlichen Mitteln reduziert werden sollte oder – im schlimmsten Fall – skrupellos ausgemerzt werden muss.

Sind das wirklich die Personen von denen Sie wollen, dass sie die Zukunft unserer Kinder kontrollieren?

Das achte Kapitel trägt die Überschrift ‚Welcome to the New World Order’. Vorangestellt ist u. a. ein Wort von Christopher Booker: Böse Menschen stehen nicht morgens auf und sagen, dass sie jetzt Böses tun wollen. Sie sagen: ‚Ich werde aus der Welt einen besseren Ort machen’.

Dann stellt Delingpole die Kernthese dieses Kapitels gleich an den Anfang (Seite 157):

Hier handelt es sich nicht um böse, kahlköpfige Männer mit Narben im Gesicht. … Im Gegenteil, die Leute, die Sie von Ihren demokratischen Rechten befreien wollen, einen größeren Teil der globalen Bevölkerung ausmerzen wollen, die industrielle Zivilisation zerstören wollen und die den Planeten nach ihrer eigenen Agenda regieren wollen, könnten netter oder fürsorglicher nicht daherkommen. Sie tun doch das alles für uns, verstehen Sie. Weil sie sich kümmern. Weil sie im Gegensatz zu Ihnen oder mir das Wissen für die Erkenntnis erhalten haben, dass sich unser kränkelnder Planet auf der Überholspur in die Hölle befindet und dass nur radikale Eingriffe durch eine erleuchtete Elite die Hoffnung bieten, das nächste Millenium zu überstehen.

Im Folgenden werden die unglaublichen Einlassungen des Club of Rome sowie mehrerer prominenter Vertreter beleuchtet. Das kommt so einprägsam und logisch beschrieben daher, dass man sich wundert, dass die Gesellschaft schlechthin das nicht durchschaut. Die ‚neue Weltordnung’ aus der Überschrift ist jene, die die Wassermelonen am liebsten einführen wollen.

Vor etwa zwei Jahrzehnten ist in Rio die Agenda 21 aus der Taufe gehoben worden, vor drei Jahrzehnten hat die Bruntland-Kommission das Konzept der ‚Nachhaltigkeit’ entwickelt, das vor vier Jahrzehnten erstmals vom Club of Rome ins Spiel gebracht worden war. Das war mehr als genug Zeit für jene, die an das Projekt glauben und alles getan haben, um das System zu infiltrieren und zu übernehmen.

Delingpole listet dann auf, wie die Agenda 21 funktioniert. Davon steht anderweitig auch schon viel, daher soll hier nur Delingpoles Fazit erwähnt werden.

In Punkt 5 der Agenda resigniert er: …Und es gibt rein gar nichts, was man dagegen tun kann! (Seite 175). Nach einem Vergleich, der diese Agenda kennzeichnen soll (was aber etwas am Ziel vorbeigeht), ist der Schluss dieses Kapitels auf jeden Fall wieder eine Übersetzung wert (Seite 184/185). Dabei fängt er bei unsäglichen Äußerungen von Prinz Charles an und schwingt einen weiten Bogen zu anderen Wassermelonen:

Es ist diese Art gut gemeinter Idiotie, die mich veranlasst hat, eine boshafte Denunziation meines zukünftigen Königs [= Prinz Charles] in dem Magazin The Spectator zu schreiben. Genau wie einer seiner Vorfahren, Æthelred the ‚Unready‘, argumentierte ich, dass auch Prinz Charles ‚unread‘ ist – was angelsächsisch für ‚schlecht beraten‘ steht. Aber mehr noch als das ist er verdorben, bockig, unverantwortlich und dick.

Nicht alle meine Leser teilen diese Einstellung. Einige der Kritiken, die ich erhalten habe, waren reiner Snobismus – etwa so: ‚Wer bist du, du ekelhafter kleiner Untermensch [oik], der du dich erfrechst, unseren zukünftigen König einen Trottel zu nennen?‘ Andere bewegten sich auf ähnlich sicher abzuschätzendem Grund und sagten, dass Prinz Charles ein netter, wohlmeinender Kerl ist, der sein bestes tut, und wenn er über das Sparen seltener Ressourcen oder die Reduktion von Kohlenstoff-Fußabdrücken redet – was ist daran unrecht?

Unrecht daran ist, dass es in der modernen grünen Bewegung keine halben Maßnahmen gibt. Wenn man nur deswegen mitmacht, weil man Bäume, Blumen und Vogelgezwitscher liebt, ist das grob so ähnlich wie dem Beitritt zur Nazi-Partei Mitte der dreißiger Jahre nur wegen der tollen Uniformen und effizienterer Eisenbahn-Fahrpläne. Was bedeutet, dass die ökofaschistischen Elemente keine optionalen Extras sind. Der Anti-Kapitalismus, der Hass auf ökonomisches Wachstum, die Beschneidung persönlicher Freiheit, die Geringschätzung der menschlichen Rasse, die Sehnsucht nach einer ‚Eine-Welt-Regierung‘ durch ‚Experten – all dies ist genauso integraler Bestandteil der Wassermelonen, wie es der Lebensraum und die Konzentrationslager für die Nazis waren.

Ich bin sicher, dass der Prince of Wales, Ted Turner, Robert Redford, Leonardo DiCaprio, Deepak Chopra, Ed Begley Jr und der Rest langen, langen Liste der grünen Bewegung mit berühmten nützlichen Idioten alle wirklich liebe Menschen sind, wenn man sie einmal kennenlernt. Aber ich fürchte, die Zeit ist lange vorbei, in der Ignoranz und Naivität in irgendeiner Form ihre Unterstützung für einen derartig bösartigen Grund entschuldigen können.

In ihrem selbstgerechten Trachten nach Errettung der Welt sind die Wassermelonen ideologisch dem Weg hörig, der höchstwahrscheinlich zur Zerstörung der Welt führt. Das ist nicht lieb. Das ist nicht sich kümmern. Das ist reine Sinnlosigkeit.

Das 9. Kapitel trägt den Titel „Malthus & Co“, und das sagt auch schon alles. Wie in allen anderen Kapiteln auch bringt Delingpole haarsträubende Beispiele über Exzesse à la Malthus. Kernaussagen sind aber darin nicht enthalten, weshalb ich hier gleich übergehen zum 10. Kapitel mit dem Titel „They don’t Like it up ‘em“.

Hier wird erst aus dem Inhalt deutlich, was mit dem Titel gemeint ist. Es beginnt mit dem Beispiel des unsäglichen Films ‚No Pressure‘, in dem Kinder, die sich nicht linientreu verhalten, in Blut und Fleischfetzen explodieren. Aber es folgen viele weitere, teils extrem üble Methoden, wie Warmisten versuchen, ihre Agenda durchzudrücken, Medien unter Druck setzen, die Öffentlichkeit zu zwingen, ihrem Weg zu folgen.

Das Fazit dieses Kapitels ist aber wieder die Übersetzung wert (Seiten 226 und 227):

Erinnern Sie sich, das Verhältnis zwischen den Mitteln, die den Warmisten zukommen und den Mitteln für die Skeptiker ist derzeit einer sehr konservativen Schätzung von Jo Nova zufolge 3500 zu eins. Erinnern Sie sich auch daran, dass ein großer Teil dieses Geldes, da es ‚Geld von der Regierung‘ ist, aus Ihren und meinen Taschen gezogen wird. Nicht unvernünftigerweise könnten Sie da zu der Schlussfolgerung kommen, dass dies den Warmisten die größere Last an Redlichkeit, Präzision und Transparenz auferlegt, verglichen mit den Skeptikern.

Und schließlich, falls Andrew Bolt oder Jo Nova mit einem ihrer Fakten falsch liegen, was könnte dann schlimmstenfalls passieren? Während eines kurzen Zeitraumes, bis die Korrektur ordnungsgemäß angebracht worden ist, könnte einer ihrer Leser das geringe Risiko eingehen, ein wenig in die Irre geführt zu werden. Wenn andererseits führende Warmisten wie Ross Garnaut oder Tim Flannery ein Faktum falsch haben (Nur ein Faktum? Was für ein Glück das für uns wäre!), hängt das Schicksal einer ganzen Nation davon ab: Scheußliche Entsalzungsanlagen für 1 Milliarde Dollar werden gebaut, Maßnahmen zum Schutz vor Überschwemmungen werden aufgeschoben, Kohlenstoffsteuern werden eingeführt, Landbesitzer verlieren ihre Eigentumsrechte, wirtschaftliches Wachstum erleidet einen Rückschlag, die Arbeitslosigkeit steigt, Kindheiten werden zerstört.

Sehen Sie den Unterschied?

Oh, und noch etwas: Nur eine Seite in dieser Debatte glaubt, dass ihre Sache so gerecht und dringend ist, dass es sie davon befreit, irgendwelche Standards von Anstand einzuhalten. Es gibt nur eine Seite, die denkt, dass es in Ordnung ist, wenn: öffentliche Untersuchungen manipuliert werden, unbescholtene Menschen aus ihren Arbeitsplätzen gedrängt werden, Gesetze zur Informationsfreiheit gebrochen werden, wissenschaftliche Methoden missbraucht werden; wenn gelogen, gedroht, bestochen und geschummelt wird, wenn rein politische Positionen in vom Steuerzahler finanzierten Agenturen und Beraterposten übernommen werden, die an sich strikt neutral sein sollten; wenn man auf Eigentumsrechten herumtrampelt, Regenwälder zerstört, für steigende Lebensmittelpreise sorgt (die zu Unruhen im Nahen Osten und Hunger in der Dritten Welt führen), Steuern erhöht werden, persönliche Freiheiten eingeschränkt werden, Energiepreise künstlich verteuert werden, Landschaften verschandelt werden, Wähler beschwindelt werden, Beweise verzerrt werden; wenn jedermann gezwungen wird, teure, dunkle Glühlampen zu verwenden, Schulkinder geängstigt werden, Erwachsene drangsaliert werden, die Arbeitslosigkeit zunimmt, demokratische Verantwortlichkeiten zerstört werden, Kontrolle über die Herrschaft über die Welt übernommen und eine neue Weltordnung eingeführt wird.

In Kapitel 11 werden Ideologie und Realismus gegenüber gestellt. Eingeleitet wird das mit einem fiktiven Beispiel aus dem alten Rom, das von den Barbaren angegriffen wird. Aus diesem Kapitel sollen einige Stellen übersetzt werden, wodurch auch verdeutlicht wird, um was es geht und was Delingpole zum Ausdruck bringen möchte.

Es beginnt mit der These, warum AGW eine Religion ist (Seiten 232/233):

AGW ist eine Religion. Sie hat Hohepriester und Propheten: Al Gore, der Prince of Wales, Sir Jonathan Porritt. Sie hat Tempel: die National Academy of Sciencs, die Royal Academy, das IPCC. Sie hat Kriegermönche (und Nonnen): Leonardo DiCaprio, Ed Begley Jr., Tamsin Omond. Sie hat das Konzept einer Erbsünde – der Kohlenstoff-Fußabdruck – von dem man sich mit Hilfe von Ablass‘ freikaufen kann – den Kohlenstoff-Zertifikaten. Sie wird motiviert durch die überwältigende Schuld, dass wir alle Sünder sind, aber wir können uns selbst davon loskaufen, in dem wir uns kasteien: z. B. Ersetzen hell leuchtender Glühlampen durch solche, die flackernd und vergilbt arbeiten, aber ökofreundlich sind; die Ihnen Kopfschmerzen verursachen, aber vermeintlich besser für die Umwelt sind, (solange man all das Quecksilber vergisst, das sie enthalten). Außerdem durch Selbstentsagung (weniger Urlaub, mehr Geld an die Regierung zahlen, kleine Vergnügen opfern um zukünftiger Generationen willen).

Und am Wichtigsten: All dies basiert auf keinerlei harten Beweisen irgendwelcher Art. Nur auf Glaube. Reiner, blinder Glaube.

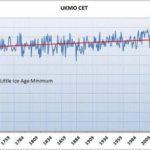

Über ein Zitat von Lawrence Solomon („wir haben zwei mächtige Verbündete auf unserer Seite: die Zeit und die Natur selbst“) schlägt er dann einen Bogen zu den Verhältnissen, was Kälte oder Wärme wirklich bedeuten vor dem Hintergrund, dass es immer mehr Wissenschaftler gibt, die aufgrund solarer Vorgänge von einer unmittelbar bevorstehenden Abkühlung unseres Planeten ausgehen. Hier könnte man das gesamte restliche Kapitel übersetzen, aber ich hoffe, die Kernaussagen auch mit den folgenden Auszügen zu treffen.

Auf den Seiten 236 und 237 heißt es:

Die Welt wird also kälter – das ist unbequem und vielleicht gefährlich. Historisch gesehen haben Kaltphasen zu schlechten Ernten, Nahrungsmittelknappheit, Hungersnöten und zivilen Unruhen geführt. Trotz der Fortschritte, die wir in der Biotechnologie gemacht haben, erwirtschaftet die Getreideerzeugung der Welt einen Überschuss von lediglich 15%. Wenn die Weizen- und Maisanbaugebiete der Nordhemisphäre von einer längeren Abkühlung betroffen werden würden – und das werden sie – könnte dieser Überschuss sich in kürzester Zeit in ein Defizit verwandeln. Und wenn diese schon dadurch verringerten Ernten durch einen massiven Vulkanausbruch weiter beeinträchtigt werden würden – wie nach demjenigen, der zu einem ‚Jahr ohne Sommer‘ geführt hat – würde es auf der ganzen Welt verbreitet zu Hungersnöten kommen, vor allem aber dort, wo man den unvermeidlich folgenden Preissprung nicht stemmen kann. Dies würde zu einer klimainduzierten Katastrophe führen, und zwar in einer Größenordnung, die bislang nicht ein einziges Mal aufgetreten ist während der segensreichen Periode globaler Erwärmung, die unsere Zivilisation glücklicherweise zwischen Mitte der siebziger Jahre und 1998 durchlaufen hat.

Kann jemand die Absurdität hier erkennen? Globale Erwärmung ist etwas Gutes. Sie ging einher mit einigen der besten und kulturell blühendsten Perioden in der Menschheitsgeschichte einschließlich der segensreichen, weitgehend friedlich verlaufenden Dekaden, die jetzt leider vorbei sind. Erwärmung bedeutet, dass wir weniger Energie für unser Überleben aufbringen müssen und dass wir mehr Zeit haben, uns zu vergnügen und all die großen sozialen und technologischen Fortschritte zu machen, die (anders als in den kalten, rauen Perioden der Dark Ages) jede Generation reicher und komfortabler gemacht hat als die jeweils vorige.

…

Welches geistig gesunde menschliche Wesen während der letzten 10.000 Jahre, als wir aus den Schrecken der letzten Eiszeit gekommen sind, hat sich jemals ein kälteres und nicht ein wärmeres Klima gewünscht?

Niemand – bis jetzt! Was sind wir nur für eine besondere Generation! Wie stolz müssen wir auf uns selbst sein! Wir sind die ersten in der gesamten Weltgeschichte, die Vernunft und Logik in so großem Maßstab überwinden, dass – soweit es unsere Politiker betrifft – schwarz jetzt weiß ist und weiß schwarz; vor Erwärmung muss man sich fürchten, Kälte ist etwas Willkommenes; Überfluss etwas, das man ablehnen muss, wirtschaftliche Stagnation etwas, das aktiv angestrebt werden muss; Begründungen und Beweise müssen vermieden werden, rauschhafte Emotionalität und billige Gefühle müssen ermutigt werden. Mit guten Gründen bezeichnet der US-Meteorologe Roy Spencer unsere gegenwärtige Paranoia bzgl. der globalen Erwärmung als ‚den schlimmsten Ausbruch einer Massenhysterie der Welt‘.

Dann führt er als explizites Beispiel David Cameron an und geht mit dessen Vorgehen hart ins Gericht. Das gilt vordergründig erst einmal für UK, ist aber natürlich auf D und die ganze Welt übertragbar. Er schreibt, das Cameron seine Absichten kundgetan hat, „den Klimawandel zu bekämpfen“ und „der grünsten Regierung jemals vorzustehen“. Und weiter (Seite 238):

Aber das Gesamtergebnis ist immer das Gleiche: gewaltige Verschwendung, empörende Einmischung der Regierung in das Privatleben freier Bürger, in den Himmel schießende Steuern, die zu widerrufen schwierig sein wird und ein schwerer Knick in den wirtschaftlich sensibelsten Bereichen zu einer Zeit, zu der sie so etwas am wenigsten gebrauchen können. Und all das nur, um einer Bedrohung zu begegnen, die so verschwindend gering ist! Das ist genauso sinnvoll wie die Errichtung von Knoblauch-Farmen, um Vampire abzuschrecken. …

Zum Ende dieses Kapitels geht er noch auf die Rolle der Entwicklung der Zivilisation hinsichtlich der Natur auf unserem Planeten ein. Er beschreibt die segensreichen Auswirkungen menschlichen Fortschritts auf die Natur, wie sie auch anderweitig schon oft beschrieben worden sind. Das Kapitel endet dann mit der Gegenüberstellung beider Alternativen. Das soll hier wieder übersetzt werden (Seiten 248 und 249):

Entweder man glaubt, wie ich es tue, dass wir Menschen im Wesentlichen eine wohltätige Spezies auf der Erde sind: innerhalb gewisser legaler und sozialer Beschränkungen – wie Eigentumsrechten und Gesetzen – lässt man uns am Besten in Ruhe, frei von Einmischungen der Regierung, und man kann uns allgemein vertrauen, dass wir das Richtige tun und alle jene Vorteile genießen, die – wie uns die Geschichte lehrt – auf freien Märkten, freiem Handel und persönlicher Freiheit beruhen.

Oder man übernimmt die pessimistische Sichtweise, dass wir eine Landplage sind, die mit immer weiter reichenden Vorschriften in Schach gehalten werden muss, kontrolliert von Experten, über die wir keine demokratische Kontrolle haben, sind sie doch schließlich die Experten, und sie haben nur unser Bestes im Sinn. Man lehne sich mit dieser Sicherheit zurück, diese Art des Kollektivismus‘ – in all seinen hässlichen Formen – wird immer in Tränen enden.

Es gibt keinen Mittelweg! Selbst wenn man glaubt, dass es einen gäbe – die Personen, die uns unsere Freiheiten und unsere demokratischen Rechte stehlen wollen im Namen der ‚Umwelt‘ haben sehr intensiv daran gearbeitet, einen solchen Mittelweg auszuschließen.

Es ist wirklich so einfach: Optimismus oder Pessimismus, Freiheit oder Tyrannei, Freude oder Leid. Sie haben die Wahl!

Das könnte schon als Schlusswort stehen, und es kommt auch kein weiteres nummeriertes Kapitel. Aber es folgt noch ein Abschnitt mit der Überschrift Postskript: The Big Lie.

Die Überschrift ist eine bewusste Anspielung auf Hitler, was gleich in den ersten Absätzen dieses Nach-Kapitels deutlich wird (Seiten 251 und 252):

Manchmal frage ich mich, warum ich mich so echauffiere. Hier stehen wir zwei Jahre nach Klimagate, und trotz all der schockierenden Enthüllungen über die Korruption, Betrügereien, Lügen, Inkompetenz, Geldgier, Verschwendung und mutwillige Destruktivität der globalen AGW-Industrie – der größte und teuerste wissenschaftliche Skandal jemals – kommen die Bastarde immer noch damit durch.

Wie? Um Gottes Willen, wie?!

Tatsächlich glaube ich inzwischen zu wissen, wie. Was wir derzeit mit den Klimakriegen erleben, ist das Phänomen, das Hitler in ‚Mein Kampf‘ beschrieben hat, als er über die ‚Große Lüge‘ sprach. Die Theorie ist ganz einfach: Man flüchte sich in kleine Lügen, und man wird wahrscheinlich überführt. Aber wenn man eine wirklich große Lüge erzählt, hat man ausgesorgt. Warum? Weil die Lüge dem Widerspruch trotzt, wenn sie nur groß genug ist. ‚Niemand kann so verwegen sein, eine Lüge von derartigem Umfang zu äußern!‘, sagt das Auditorium der Großen Lüge zu sich selbst. Und so kommt es, dass die Große Lüge vorgibt, sich den Mantel akzeptierten Wissens umgehängt zu haben.

So war es in großem Umfang auch im Falle der globalen Erwärmung. Sicher, in allen Meinungsumfragen nimmt der Skeptizismus in der Öffentlichkeit zu. Aber angesichts des Wetters, der Folgen für die Wirtschaft, des wachsenden Widerstands gegen Windparks, Biotreibstoffe und Kohlenstoffsteuern kommt das nicht überraschend. Nein, was wirklich überrascht – und auch sehr deprimierend ist – ist, wie viele Menschen es da draußen noch gibt, die trotz all dem der vom Menschen verursachten globalen Erwärmung anhängen als einen lieb gewonnenen Glauben.

Auch die abschließenden Worte sollen hier nicht fehlen. Danach folgt noch ein kurzer Abschnitt, mit dem sich Delingpole allerdings keinen Gefallen getan hat. Sein resignierend klingendes Resümee lautet (Seiten 264 und 265):

Die globale Erwärmung ist inzwischen für so viele Menschen so unendlich wichtig, dass man sie hätte einführen müssen, wenn sie nicht schon existieren würde.

Was sie komischerweise ja auch getan haben: Die Klimawissenschaftler; die Kohlenstoffhändler; Die Installateure von Solarpaneelen; die Investoren in erneuerbare Energie; die Versicherungs- und Rückversicherungsunternehmen; die ethischen Verwalter des Vermögens [the ethical fund managers]; die Umweltkorrespondenten in Presse und Fernsehen; die professionellen Öko-Krieger, die diesen Schwindel brauchen, um Sponsoren für ihren nächsten Kanu-Ausflug zum Nordpol zu gewinnen; die lokalen Umweltfunktionäre der Regierung; die Verkäufer von Kohlenstoff-Zertifikaten; die grünen Berater und PR-Spezialisten; die grünen Politiker; die Hersteller von Elektroautos; die Windpark-Ingenieure; die Schreiberlinge, die auf alle Packungen beschreiben, wie kohlenstoffneutral das Produkt ist; die Lehrer an Schulen, die die glauben, die Welt zum Besseren zu wenden, wenn sie unseren Kindern beibringen, sich schuldig zu fühlen und sich Sorgen zu machen; die Redakteure von BBC-Dokumentationen; die Lobbyisten; die Prius-Verkäufer; die Autoren von Zeitungsartikeln mit Namen wie ‚Öko-Krieger‘; die Geistlichen, die Gott mehr oder weniger aufgegeben haben und ausschließlich Gaia in den Vordergrund rücken; die Touristenbehörde auf den Malediven; die Technokraten und Administratoren und Sekretäre der UN und der EU; die Mechaniker, die die Aston-Martin-Limousine des Prince of Wales umgerüstet haben, so dass er jetzt mit Biotreibstoffen fahren kann; die Luftfahrtunternehmen, die regelmäßig von Al Gore und Rajendra Pachauri für ihre Flüge in der Weltgeschichte brauchen, um uns daran zu erinnern, wie wichtig es ist, unsere mit dem Flugzeug zurück gelegten Strecken zu beschränken…

Niemals zuvor wurde so viel Paranoia erzeugt, so viel Geld verschwendet, so viel Unsinn verbreitet, so viele Leben beschränkt, so viel wirtschaftlicher Schaden angerichtet, so viele hoffnungsvolle Aussichten zerstört auf Basis von so wenigen oder fehlenden Beweisen.

Das ist der schreiende Skandal der Klimaänderung!

Fazit: Dies ist kein wissenschaftliches Buch. Es ist auch kein Buch, das auf Recherchen beruht wie die Arbeit von Donna Laframboise. Im Grunde ist es das Aufbegehren des ‚gesunden Menschenverstandes‘ gegen die überwältigend starke Maschinerie, die von UN und IPCC und den ganzen Ideologen vor Ort betrieben wird.

Ein ganzes Buch, um den an sich unglaublichen Vorgang um die Klimaänderung zu beschreiben. Wenn man mich, Chris Frey, den Schriftsteller und Nicht-Fachmann fragt, warum „ich nicht an die globale Erwärmung glaube“, noch dazu von Leuten, auch guten Freunden, die sehr stark diesem Glauben anhängen – wie soll ich da in zwei oder drei Sätzen antworten?