Man vergleiche die industrialisierte Nation mit einer internen Verbrennungsmaschine auf Basis fossiler Treibstoffe. Man kann die Maschine auf zwei Arten anhalten: Die Treibstoffzufuhr unterbinden oder den Auspuff stopfen. Die Treibstoffzufuhr zu unterbrechen ist ein politisches Mienenfeld. Die Menschen merken sofort, wenn alle Preise steigen, vor allem für Nahrungsmittel. Es ist einfacher zu zeigen, dass die Auspuffgase zu irreparablen Umweltschäden führen. Das ist der Grund, dass CO2 zum alleinigen Brennpunkt des IPCC geworden ist. Verfahren und Methoden wurden aufeinander abgestimmt, CO2 zu isolieren und zu zeigen, dass dieses Gas zu einer globalen Runaway-Erwärmung führt.

In den achtziger Jahren habe ich Henry Hengeveld, Mitarbeiter bei Environment Canada davor gewarnt, dass es ein Problem ist, einen Politiker von einem Gedanken zu überzeugen. Das Propagieren von CO2 als ein Problem war Teil von Henrys Karriere. Ich erklärte ihm, dass das größere Problem auftaucht, wenn man ihn überzeugt und dann die Behauptung als falsch überführt wird. Entweder räumt man den Fehler ein, oder man verschweigt die Wahrheit. Environment Canada und die Mitgliedsstaaten des IPCC haben sich dafür entschieden, die Wahrheit zu verschleiern.

1 Die IPCC-Definition des Begriffes Klimaänderung war der erste große Betrug

Die Menschen sind betrogen worden, als das IPCC gegründet wurde. Die meisten glauben, dass es sich um einen regierungsamtlichen Untersuchungsausschuss handelt, der alles zur Klimaänderung untersuchen soll. Die aktuelle Definition vom United Nations Environment Program [Umweltprogramm der UN] (Artikel 1) des UNFCCC begrenzt diesen ausschließlich auf menschliche Ursachen.

„…eine Änderung des Klimas, die direkt oder indirekt menschlichen Aktivitäten zugeordnet werden kann, die die Zusammensetzung der Erdatmosphäre verändern und die zusätzlich zur natürlichen Klimavariabilität über längere Zeiträume beobachtet werden kann“.

In einem anderen Betrug haben sie die in den ersten drei Berichten (1990, 1995, 2001) verwendete Definition im Bericht 2007 geändert. In der Summary for Policymakers ist das eine Fußnote.

„Klimaänderung nach Lesart des IPCC bezieht sich auf jedwede Änderung des Klimas mit der Zeit, erfolge diese nun aufgrund natürlicher Variabilität oder als Folge menschlicher Aktivitäten. Diese Definition unterscheidet sich von der des UNFCCC, in der eine Änderung des Klimas, die direkt oder indirekt menschlichen Aktivitäten zugeordnet werden kann, die die Zusammensetzung der Erdatmosphäre verändern und die zusätzlich zur natürlichen Klimavariabilität über längere Zeiträume beobachtet werden kann“.

Diese Definition fand aber keine Anwendung, weil die Zustandsberichte aufeinander aufbauen. Eine Einbeziehung der natürlichen Variabilität hätte einen völligen Neustart erforderlich gemacht.

Es ist unmöglich, den menschlichen Beitrag zur Klimaänderung zu bestimmen, wenn man die natürlichen (nicht-menschlichen) Klimaänderungen nicht kennt oder nicht versteht. Professor Murray Salby zeigte, wie der menschliche Anteil des CO2 bedeutungslos ist, und dass Variationen bei den natürlichen CO2-Quellen fast alle jährlichen Änderungen erklären. Er zeigte, dass eine Änderung um 5% aus diesen Quellen mehr ist als die gesamte menschliche Erzeugung.

2 Das IPCC zieht Rückschlüsse und will eine Hypothese unbedingt beweisen

Um dieses Verfahren wissenschaftlich aussehen zu lassen, wurde eine Hypothese konstruiert, die auf folgenden Annahmen basierte:

● CO2 ist ein Treibhausgas (GHG), das die Rückstrahlung von Wärme von der Erde behindert.

● die Wärme wurde auf die Erde zurück gestrahlt und hat die globale Temperatur steigen lassen.

● Nimmt das CO2 zu, steigt die globale Temperatur.

● Der CO2-Gehalt nimmt zu aufgrund der sich immer mehr erweiternden industriellen Aktivitäten.

● Der globale Temperaturanstieg war unvermeidlich.

Um noch sicherer zu machen, dass auch das gewünschte Ergebnis herauskommt, hat sich das IPCC daran gemacht, diese Hypothese zu untermauern, anstatt zu versuchen, sie zu widerlegen, wie es die wissenschaftliche Methode erfordert. Wie Karl Popper gesagt hat:

„Die Regel gibt vor, dass die anderen Regeln wissenschaftlicher Verfahren so gestaltet sein müssen, dass sie nicht irgendein Statement der Wissenschaft vor der Falsifikation schützen“.

Das beständige und unermessliche Verhalten des IPCC enthüllt falsche Interpretationen bzgl. CO2. Sobald ein Umstand von Wissenschaftler auftauchte, die ihrer Rolle als Skeptiker gerecht geworden waren, hat das IPCC nicht etwa die Gültigkeit und Wirksamkeit dieser Dinge in Betracht gezogen und getestet, sondern es arbeitete daran, diese Dinge zu zerstreuen, selbst mittels einiger falscher Erklärungen. Diese falschen Antworten waren erfolgreich, weil die meisten Menschen gar nicht wussten, dass sie falsch waren.

3 Fakten über CO2 sind den meisten unbekannt, aber problematisch für das IPCC

Einige grundlegende Fakten über CO2 sind den meisten Menschen unbekannt und illustrieren die Diskrepanzen und Unterschiede zwischen den Behauptungen des IPCC und dem, was die Wissenschaft weiß.

● Der Anteil des natürlichen CO2-Niveaus in der Atmosphäre liegt derzeit unter 0,04% und bei 0,4% aller Treibhausgase. Es ist nicht das bedeutendste Treibhausgas.

● Wasserdampf macht durch Volumen 95% aller Treibhausgase aus. Es ist bei Weitem das bedeutendste Treibhausgas.

● Methan (CH4) ist ein anderes natürliches Treibhausgas, das vom IPCC dämonisiert wurde. Es hat nur einen Anteil von 0,000175% an der ganzen Atmosphäre und 0,036% an den Treibhausgasen.

● Abbildung 1 von ABC News zeigt die falsche Information. Diese Darstellung gilt nur für eine trockene Atmosphäre.

Abbildung 1

● Diese Prozentanteile machten dem IPCC Sorgen. Also hat es die Bedeutung des CO2 vergrößert, indem ein „Beitrag“ pro Einheit geschätzt wurde (Abbildung 2). Die Bandbreite der Schätzungen macht die Messungen effektiv bedeutungslos, es sei denn, man hat eine politische Agenda. Wikipedia räumt ein: „Es ist nicht möglich festzustellen, dass ein bestimmtes Gas einen genauen Prozentanteil am Treibhauseffekt hat“.

Abbildung 2 (Quelle: Wikipedia)

4 Die menschliche Produktion von CO2 ist kritisch für die IPCC-Objektive. Daher kontrolliert es die Informationen.

Die Erklärung lautet:

Welche Rolle spielt das IPCC bei der Bestandsaufnahme von Treibhausgasen und bei den Berichten an das UNFCCC?

A: Das IPCC hat eine Reihe von Verfahrensberichten zur Bestandsaufnahme nationaler Treibhausgas-Emissionen erzeugt mit der Absicht, international akzeptable Methoden für diese Bestandsaufnahme zur Verfügung zu stellen. Das IPCC übernimmt die Verantwortung, wissenschaftliche und technische Ratschläge zu speziellen Fragen zu erteilen, die mit diesen Methoden der Bestandsaufnahme zusammen hängen oder auf Anforderung des UNFCCC in Übereinstimmung mit etablierten IPCC-Verfahren. Das IPCC hat die Task Force on Inventories (TFI) ins Leben gerufen, um das National Greenhouse Gas Inventory Programme (NGGIP) [etwa: Programm zur Bestandsaufnahme von Treibhausgasen] zu betreiben, um diese Ratschläge zum Verfahren zu geben. Die Parteien im UNFCCC stimmen überein, die IPCC-Richtlinien bei den Berichten an die Convention zu verwenden.

Wie erstellt das IPCC seine Richtlinien für die Bestandsaufnahme? Unter Verwendung von Methoden des IPCC entwerfen benannte Experten aus der ganzen Welt die Berichte, die dann zweimal extensiv begutachtet werden, bevor sie das IPCC absegnet. Dieses Verfahren stellt sicher, dass die größtmögliche Vielfalt von Meinungen in die Dokumente einfließen.

Es kontrolliert den gesamten Prozess, die Verfahrensweise, die Benennung technischer Ratschläge, die Etablierung von Arbeitsgruppen, Richtlinien für die Berichterstattung, Benennung der Experten, die die Berichte erzeugen bis zur schließlichen Absegnung der Endfassung. Die Zahlen, die sie erzeugen, sind eine Hochrechnung, aber man schätzt, dass Menschen von dieser Zahl 50% entfernen.

Wie auch immer, wenn man die natürlichen Quellen und die Variabilität von CO2 nicht kennt, kann man den menschlichen Anteil nicht ermessen. Man hat behauptet, dass der Anteil in der Atmosphäre durch Verbrennung fossiler Treibstoffe bekannt sei aus dem Verhältnis der Kohlenstoff-Isotope C13/C12. Roy Spencer hat gezeigt, dass dies nicht der Fall war. Außerdem wird die natürliche Verbrennung fossiler Treibstoffe ignoriert, als da wären Waldbrände oder langlebige Kohle- und Torfbrände. Hans Erren zufolge ist fossile Kohle in der Erde begrabenes Holz. Spencer kam zu dem Ergebnis:

Wenn das Verhältnis C13/C12 durch der NATÜRLICHEN Variabilität von Jahr zu Jahr geschuldet ist, wie können dann welche behaupten, dass das Trendsignal VOM MENSCHEN VERURSACHT ist?

Antwort: Um die Hypothese zu beweisen und den Betrug fortzuführen.

5 Druck für dringende politische Maßnahmen

In früheren IPCC-Berichten wurde behauptet, dass die Zeit des Verbleibens von CO2 in der Atmosphäre sehr lang sei. Dies implizierte, dass es weiterhin ein Problem sein würde, selbst bei sofortiger Einstellung aller CO2-Emissionen. Allerdings hat Segalstad geschrieben:

Essenhigh (2009) weist darauf hin, dass das IPCC in seinem ersten Bericht (Houghton et al. 1990) eine CO2-Verweildauer von 50 bis 200 Jahren angegeben hatte (als eine „grobe Schätzung“). Diese Schätzung wird verwirrend als eine Anpassungszeit für ein Szenario mit einem gegebenen menschlichen CO2-Input genannt und ignoriert natürliche CO2-Flussraten (durch Ozean und Vegetation). Solche Schätzungen sind analytisch unsinnig und stehen in Konflikt mit einer korrekteren Erklärung an einer anderen Stelle im gleichen IPCC-Bericht: „Dies bedeutet, dass es im Mittel nur wenige Jahre dauert, bis ein CO2-Molekül in der Atmosphäre durch Pflanzen aufgenommen oder im Ozean gelöst wird“.

6 Verfahren, um Probleme mittels IPCC-Wissenschaft zu verschleiern und den Alarmismus zu erhöhen

IPCC-Verfahren wurden zum Zwecke des Betrugs entwickelt. Das IPCC hat drei Arbeitsgruppen (WG). WG 1 erstellt den Physical Science Basis Report, in welchem bewiesen wird, dass CO2 die Ursache ist. WG 2 erstellt den Impacts, Adaptation and Vulnerability Report [Auswirkungen, Anpassung und Verwundbarkeit]. Er basiert auf dem Bericht von WG 1. WG 3 erstellt den Bericht zur Abschwächung des Klimawandels. Die Arbeitsgruppen 1 und 2 akzeptieren die Behauptung der WG 1, dass die Erwärmung unvermeidlich ist. Sie stellen fest:

Es werden fünf Kriterien für Klimaszenarien gelistet, falls sie für Folgenforscher und Politiker für Entscheidungen nützlich sind: Kriterium 1: Konsistenz mit den globalen Projektionen. Sie sollten konsistent sein mit einer großen Bandbreite von Projektionen der globalen Erwärmung aufgrund zunehmender Konzentrationen von Treibhausgasen. Diese Bandbreite wird in verschiedenen Quellen angegeben mit 1,4°C bis 5,8°C bis zum Jahr 2100 oder 1,5°C bis 4,5°C bei einer Verdoppelung der atmosphärischen CO2-Konzentration (anderswo bekannt als die „Gleichgewichts-Klimasensitivität“).

Sie wussten, dass nur Wenige den wissenschaftlichen Bericht mit seinen eingeräumten ernsten Grenzen lesen oder verstehen würden. Sie haben dessen Veröffentlichung absichtlich verzögert bis nach dem Erscheinen der Summary for Policymakers. David Wojick erklärt:

Unübersehbare Auslassungen sind nur für Experten unübersehbar. Daher werden die „Politiker“ – einschließlich der Medien und der Öffentlichkeit –, die den SPM lesen, nicht erkennen, dass man ihnen nur die eine Seite der Medaille nahebringt. Aber die Wissenschaftler, die den Bericht entworfen haben, kennen die Wahrheit, wie die mitunter sehr kunstvollen Versuche ihrerseits belegen, diese Wahrheit zu verschleiern.

…

Was systematisch in dem SPM ausgelassen wird, sind genau die Unsicherheiten und positiven Gegenbeweise, die die Theorie der anthropogenen Einmischung widerlegen könnten. Anstatt diesen Einwänden nachzugehen, stehen in der Summary nur jene Ergebnisse, die die Theorie stützen. Kurz gesagt, dass ist Ideologie, keine Wissenschaft.

Ein Beispiel für diesen Betrug in der SPM liefert der Bericht aus dem Jahr 1995. Im Bericht 1990 und dem Entwurf 1995 hieß es, dass es keine Beweise für einen menschlichen Einfluss gibt. Benjamin Santer hat als Leitautor von Kapitel 8 den Entwurf 1995 seiner Mitautoren ohne deren Wissen verändert. Sie hatten gesagt:

„Während einige der hier diskutierten Dinge die Entdeckung einer signifikanten Klimaänderung behauptet haben, konnte bislang noch keine Studie positiv nachweisen, dass die gesamte Klimaänderung oder ein Teil davon anthropogenen Ursachen zugeordnet werden kann“.

Ben Santer machte daraus:

„Die Masse der statistischen Beweise in Kapitel 8 deuten jetzt auf einen erkennbaren menschlichen Einfluss auf das globale Klima hin, wenn man diese Beweise im Zusammenhang unseres physikalischen Verständnisses des Klimasystems untersucht“.

Die Phrase „erkennbarer menschlicher Einfluss” machte es wie geplant in die Schlagzeilen.

Mit dem AR 5 verschlimmerten sie den Betrug durch die Veröffentlichung einer SPM, der sie eine Korrektur folgen ließen. Sie bekamen die gewollte Schlagzeile. Es ist das gleiche Spiel wie der Unterschied zwischen der Bloßstellung der Probleme im Wissenschaftsreport der WG 1 und der SPM. Die Medien haben nicht über die Korrekturen berichtet, aber das IPCC konnte jetzt behaupten, dass es die Unzulänglichkeiten ihres Berichtes aufgelistet hat. Es ist nicht ihre Schuld, dass die Leute das nicht verstehen.

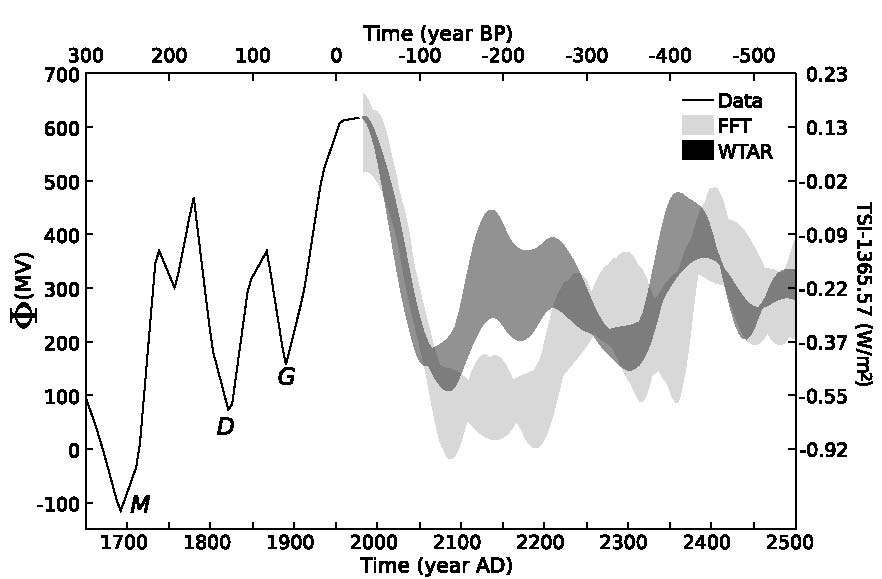

7 Klimasensitivität

Ursprünglich hatte man angenommen, dass ein konstant steigender atmosphärischer CO2-Gehalt zu einer konstant steigenden Temperatur führen würde. Dann wurde berechnet, dass die ersten paar ppm die Treibhausgas-Kapazität von CO2 bereits erreicht haben. Eschenbach hat die Wirklichkeit dargestellt:

Abbildung 3

Es ist wie schwarze Farbe auf einem Fenster. Um durch ein Fenster fallendes Sonnenlicht abzuschirmen, wird die erste Schicht schwarzer Farbe dazu den Löwenanteil beitragen. Folgeschichten reduzieren das Sonnenlicht nur noch wenig.

Es gab sofort Uneinigkeit über die Höhe der Klimasensitivität durch eine Verdoppelung oder Verdreifachung des atmosphärischen CO2-Gehaltes. Milloy hat eine Graphik konstruiert, der die drei unterschiedlichen Sensitivitäts-Schätzungen miteinander vergleicht (Abbildung 4):

Abbildung 4.

Das IPCC erzeugte eine positive Rückkopplung, um die Temperaturen weiter steigen zu lassen. Es behauptet, dass CO2 zu einer Temperaturzunahme führt, was zu vermehrter Verdunstung führt, und Wasserdampf verstärkt den Temperaturtrend. Lindzen und Choi haben dies in ihrer Studie aus dem Jahr 2011 widerlegt und kamen zu dem Ergebnis, dass „die Ergebnisse zeigen, dass die Modelle die Klimasensitivität übertreiben“.

Die Klimasensitivität hat seitdem immer weiter abgenommen und nähert sich allmählich Null. In einer kürzlichen Studie von Spencer wird behauptet, dass „…das Klimasystem nur halb so sensitiv auf CO2 reagiert wie ursprünglich angenommen“.

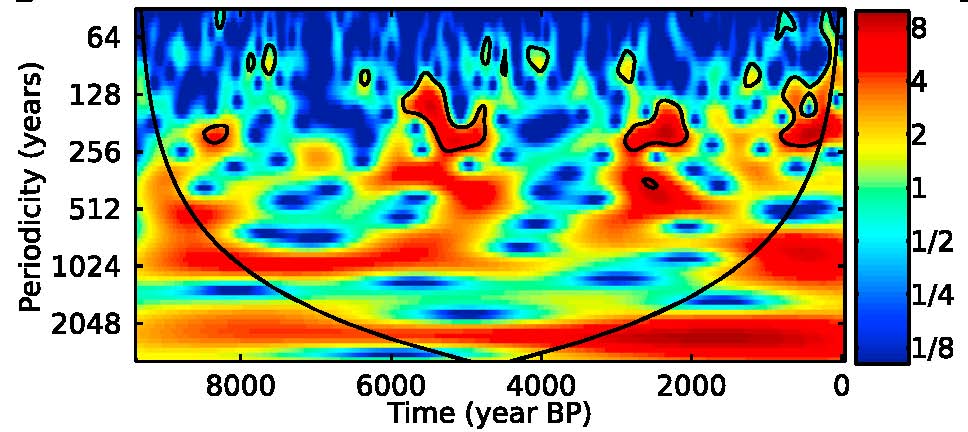

8 Die Eisbohrkerne waren grundlegend, aber voller ernster Fehler

Die wesentliche Annahme der abgeleiteten IPCC-Hypothese sagt, dass eine CO2-Zunahme eine Temperaturzunahme bedingt. Nach der Veröffentlichung von Petit et al. (1999) erschienen die Eisbohrkerne aus der Antarktis als Beweis im Bericht 2001 (Abbildung 5):

Abbildung 5. Antarktischer Eisbohrkern

Vier Jahre später ergaben Forschungen das Gegenteil – eine Temperaturzunahme war einer CO2-Zunahme stets vorausgegangen, was ein klarer Widerspruch zur Hypothese war. Dies wurde beiseite geschoben mit der ablenkenden Behauptung, dass der Zeitverzug 80 bis 800 Jahre betrug und damit nicht signifikant sei. Das war so verstörend, dass Al Gore in seinem Film ein betrügerisches Bild erzeugte. Nur wenige Experten haben das bemerkt.

Tatsächlich ändert sich die Temperatur vor einer Änderung des CO2-Gehaltes in jeder Aufzeichnung für jede Periode oder jeden Zeitraum. Abbildung 6 zeigt einen kürzeren Zeitraum (1958 bis 2009) dieses Verhältnisses. Falls eine CO2-Änderung in jeder Aufzeichnung einer Temperaturänderung nachfolgt, warum sind dann alle Computermodelle mit der gegenteiligen Beziehung programmiert worden?

Abbildung 6: Verzögerung für einen kurzen Zeitraum, 1958 bis 2009.

Das IPCC brauchte niedrige vorindustrielle CO2-Niveaus

Ein präindustrielles CO2-Niveau, niedriger als heute, war unabdingbar für die IPCC-Hypothese. Es war genauso nötig wie die Eliminierung der Mittelalterlichen Warmzeit, weil diese gezeigt hat, dass es heute eben nicht wärmer als jemals zuvor war.

Eisbohrkerne sind nicht die einzigen Quellen, die Aufschluss über den präindustriellen CO2-Gehalt geben. Es gibt Tausende direkte Messungen des atmosphärischen CO2-Gehaltes schon im 19. Jahrhundert, genauer seit dem Jahr 1812. Wissenschaftler haben genaue Messungen mit kalibrierten Instrumenten durchgeführt, wie Ernst Beck sorgfältig dokumentiert hat.

In einer an das US Senate Committee on Commerce, Science, and Transportation Hearing übermittelten Studie hat Professor Zbigniew Jaworowski festgestellt:

“Die Basis der meisten IPCC-Ergebnisse bzgl. anthropogener Gründe und Projektionen der Klimaänderung ist die Annahme eines niedrigen CO2-Gehaltes in der präindustriellen Atmosphäre. Diese Annahme ist glaziologischen Studien zufolge falsch“. [1]

Gleichermaßen bedeutsam ist Jaworowskis weitere Feststellung:

Die Auffassung eines niedrigen vorindustriellen CO2-Niveaus, die auf so wenig Wissen beruht, wurde zu einem weithin akzeptierten Heiligen Gral der Klimaerwärmungs-Modelle. Die Modellierer ignorierten die Beweise direkter Messungen von CO2 in der Luft, die zeigen, dass die mittlere Konzentration im 19. Jahrhundert 335 ppmv betragen hatte (11), Abbildung 2. In Abbildung 2 zeigen die eingekreisten Werte eine verzerrte Auswahl von Daten, die verwendet worden sind um zu zeigen, dass das atmosphärische CO2-Niveau im 19. Jahrhundert 292 ppmv betragen hatte (12). Eine Studie von Stomata in fossilen Blättern aus dem Holozän in Ablagerungen in einem See in Dänemark zeigen, dass der CO2-Gehalt der Atmosphäre vor 9400 Jahren 330 ppmv betragen hatte und vor 9600 Jahren 348 ppmv. Dies falsifiziert das Konzept eines stabilen und niedrigen CO2-Gehaltes der Luft bis zum Einsetzen der industriellen Revolution (13).

Es gibt noch andere Probleme bei den Aufzeichnungen in Eisbohrkernen. Es braucht Jahre, um Luft im Eis einzuschließen. Was also wurde tatsächlich eingefangen und gemessen? Schmelzwasser, das sich durch das Eis gearbeitet hat, vor allem im oberflächennahen Eis kann die Luftblasen kontaminieren. Bakterien innerhalb des Eises setzen sogar Gase in 500.000 Jahre altem Eis in größeren Tiefen frei. (Dissertation von Brent C. Christner 2002 mit dem Titel [übersetzt]: „Auffinden, Bergung, Isolation und Charakterisierung von Bakterien in Gletschereis und Eis aus dem Wostok-See“). Der Druck des darüber liegenden Eises verursacht eine Änderung in Tiefen unter 50 m, und brüchiges Eis wird plastisch und beginnt zu fließen. Die Schichten, die sich jedes Jahr mit dem Schneefall gebildet haben, verschwinden mit zunehmendem Druck. Man benötigt eine beträchtliche Dicke des Eises über einen langen Zeitraum, um eine einzelne Ablesung in der Tiefe durchführen zu können.

Jaworowski identifizierte die Probleme durch Kontamination und Verlusten während des Bohrungs- und Bergungsprozesses des Eiskerns.

Jaworowskis Behauptung, dass die Modellierer die Messungen des 19. Jahrhunderts ignoriert haben, ist nicht richtig. Sie wussten es, weil T. R. Wigley die Informationen über die Messungen im 19. Jahrhundert schon 1983 zur Verfügung stellte. (Wigley, T.M.L., 1983 “The pre-industrial carbon dioxide level.” Climatic Change 5, 315-320). Allerdings hat er Werte willkürlich au seiner großen Bandbreite herausgepickt, durchweg hohe Messwerte eliminiert und das vorindustrielle CO2-Niveau von etwa 270 ppm ‘erzeugt’. Ich nehme an, dass dies die Modellierer beeinflusst hat, weil Wigley mit ihnen zusammen gearbeitet hat als Direktor der Climatic Research Unit CRU in East Anglia. Er war der Vorgänger von Phil Jones und war die Schlüsselfigur, der die durch die Klimagate-E-Mails enthüllten Machenschaften dirigiert hatte.

Wigley war nicht der erste, der die Daten des 19. Jahrhunderts missbraucht hatte, aber er hat sie erneut in die Klimagemeinschaft eingeführt. Guy Stewart Callendar, ein britischer Dampftechnik-Ingenieur, brachte die These voran, dass zunehmendes CO2 zu Erwärmung führt. Er tat das, was Wigley getan hat, nämlich nur die Daten auszuwählen, die die Hypothese stützen.

Es gibt 90.000 Messwerte aus dem 19. Jahrhundert, und die Graphik zeigt die sorgfältig von G. S. Callendar ausgewählten Werte, um seine Schätzung zu stützen. Es ist eindeutig, dass er ausschließlich niedrige Werte ausgewählt hat.

Abbildung 7 (nach Jaworowski, Trendlinien hinzugefügt)

Man kann die Änderungen der Neigung und des Trends erkennen, wenn man die ausgewählten Daten mit der Gesamtzahl der Daten vergleicht.

Ernst-Georg Beck bestätigte Jaworowskis Forschungen. In einem Artikel in Energy and Environment wurden die Messwerte sehr detailliert untersucht und die Ergebnisse validiert. Beck kommt zu dem Ergebnis:

Die moderne Treibhaushypothese basiert auf den Arbeiten von G. S. Callendar und C. D. Keeling. Sie folgen damit S. Arrhenius, der vom IPCC popularisiert worden ist. Die Begutachtung der verfügbaren Literatur wirft die Frage auf, ob diese Autoren systematisch eine große Anzahl technischer Studien aussortiert und ältere Bestimmungen des atmosphärischen CO2-Gehaltes verworfen haben, weil diese nicht zu ihrer Hypothese passten. Offensichtlich haben sie nur ein paar sorgfältig ausgesuchte Werte aus der älteren Literatur verwendet und ausnahmslos Ergebnisse gewählt, die mit der Hypothese eines CO2-Anstiegs infolge Verbrennung fossiler Treibstoffe konsistent sind.

Das vorindustrielle Niveau liegt um etwa 50 ppm höher als behauptet.

Beck weiter:

„Seit 1812 hat die CO2-Konzentration der Luft in der Nordhemisphäre fluktuiert mit drei Maxima um die Jahre 1825, 1857 und 1942, wobei im letzteren Jahr 400 ppm vorhanden waren“.

Die Herausforderung für das IPCC bestand darin, einen gleitenden Übergang zu erzeugen vom CO2-Niveau in den Eisbohrkernen zu dem auf dem Mauna Loa gemessenen Niveau. Beck zeigte, wie man das gemacht hat, und auch, wie die Messungen des des 19. Jahrhunderts willkürlich ausgewählt werden mussten, um zu den Eisbohrkern- und den Mauna Loa-Daten zu passen (Abbildung 8).

Abbildung 8

Die Variabilität ist extrem wichtig, weil der Eisbohrkern einen außerordentlich glatten Verlauf zeigt, der mittels einer Mittelung über 70 Jahre erreicht worden ist. Selektion und Glättung wurde auch auf die Mauna Loa-Daten angewendet sowie auf alle atmosphärischen Messungen in jüngster Zeit, die auf natürliche Weise im Verlauf eines Tages bis zu 600 ppm variieren. Die Glättung im Maßstab wie bei dem Eisbohrkern eliminiert eine große Menge an Information. Man betrachte die Variabilität der Temperatur der letzten 70 Jahre. Der Statistiker William Brigg sagt, dass man niemals, niemals eine Zeitreihe glätten darf. Die Eliminierung hoher Werte vor der Glättung bringt noch größere Verluste. Beck erklärt, wie Charles Keeling die Mauna Loa-Daten bearbeitet hat, indem er die niedrigsten Messwerte des Nachmittags verwendete und natürliche Quellen ignoriert hat. Beck vermutet, dass Keeling beschlossen hat, diese natürlichen Quellen zu vermeiden, indem er den Messpunkt 4000 m hoch auf dem Vulkan errichtet hat. Beck:

Der Mauna Loa repräsentiert nicht den typischen atmosphärischen CO2-Gehalt in verschiedenen globalen Gebieten, sondern die Werte sind nur typisch für diesen Vulkan in einem Meeresgebiet in einer Höhe von 4000 m in dieser geographischen Breite“. (Beck 2008, „50 Years of Continuous Measurement of CO2on Mauna Loa” Energy and Environment, Vol. 19, No.7.)

Keelings Sohn betreibt jetzt die Messungen am Mauna Loa und, wie Beck anmerkt, „er besitzt das globale Monopol bei der Kalibrierung aller CO2-Messungen“. Er ist Mitautor der IPCC-Berichte, und das IPCC betrachtet alle Messungen am Mauna Loa als repräsentativ im globalen Maßstab.

Als Klimatologe weiß ich um die Notwendigkeit, so viele unabhängige Verifikationen der Daten wie möglich zu erhalten. Stomata sind kleine Öffnungen an Blättern, deren Größe direkt mit der Menge des atmosphärischen CO2 variiert. Sie unterstreichen die Auswirkungen von Glättung und der künstlich niedrigen Ablesungen in den Eisbohrkernen. Ein Vergleich der Stomata mit einem Eisbohrkern über einen Zeitraum von 2000 Jahren (9000 bis 7000 v. Chr.) illustriert dies (Abbildung 9):

Abbildung 9.

Daten aus Stomata zeigen höhere Werte und Variabilität als der exzessiv geglättete Eisbohrkern. Sie passen quantitativ zu den Messungen des 19. Jahrhunderts, wie Jaworowski und Beck zeigen. Das mittlere Niveau des Eisbohrkerns zeigt etwa 265 ppm, während die Stomata etwa 300 ppm nahe legen.

Das vorindustrielle CO2-Niveau war marginal geringer als jetzt und liegt wahrscheinlich innerhalb der Fehlergrenze. Weder diese Werte noch der gegenwärtige Wert von 400 ppm ist hoch im Vergleich mit der geologischen Vergangenheit. Der gesamte Output der Computer-Klimamodelle beginnt mit der Vermutung, dass das vorindustrielle Niveau messbar geringer ist. Die Eliminierung dieser Hypothese unterminiert die Behauptung noch weiter, dass die Erwärmung während der Periode der Industrialisierung Folge einer Freisetzung anthropogenen CO2 in die Atmosphäre war. Man kombiniere dies mit der IPCC-Behauptung, dass CO2 eine Temperaturzunahme bewirkt, wenn alle Aufzeichnungen das Gegenteil zeigen, dann ist es keine Überraschung, dass die IPCC-Vorhersagen steigender Temperaturen konsistent falsch sind.

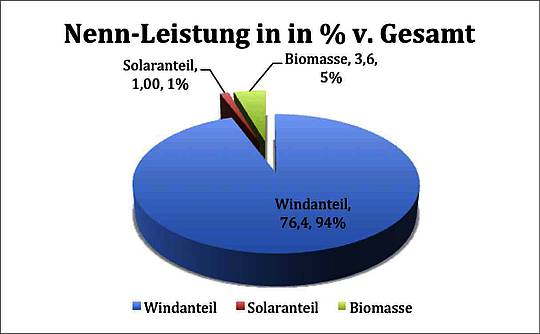

Der IPCC-Betrug ist vorsätzlich geplant worden, und zwar unter Maurice Strongs Anleitung, um zu beweisen, dass CO2 eine globale Erwärmung hervorruft, was als Begründung für die Schließung industrieller Nationen herhalten muss. Sie haben ihr Ziel teilweise erreicht, wie alternative Energien und grüne Arbeitsplätze belegen. All dies passiert vor dem Hintergrund immer weiter zunehmender Beweise gegen die Hypothese, weil sich die Natur mitzuspielen weigert. CO2 steigt, während die Temperatur fällt, was dem IPCC zufolge nicht sein kann. Politiker müssen nach den Fakten handeln und alle politischen Maßnahmen zurückweisen, die auf der Behauptung basieren, dass CO2 ein Problem ist; vor allem die Maßnahmen, die schon jetzt große Schäden verursachen.

Quelle: The Global Warming Policy Foundation: CCNet 14/10/13

1. [1] “Climate Change: Incorrect information on pre-industrial CO2” Statement written for the Hearing before the US Senate Committee on Commerce, Science, and Transportation by Professor Zbigniew Jaworowski March 19, 2004

Link: http://wattsupwiththat.com/2013/11/13/why-and-how-the-ipcc-demonized-co2-with-manufactured-information/#more-97390

Übersetzt von Chris Frey EIKE