Die Verstaatlichung der Energiewirtschaft

Beängstigend waren von Anbeginn die vorhersehbaren, zerstörerischen Auswirkungen auf die Wirtschaft und die privaten Verbraucher., denn die Ruinierung der Energieversorgung eines Industrielandes bedeutet die Vertreibung derjenigen Unternehmen, die dem Bankrott durch Flucht ins Ausland entkommen können, während die übrigen schlicht untergehen. Die privaten Verbraucher werden zuerst durch immer höher steigende Energiepreise ausgeplündert, bevor sie auch noch ihre Arbeitsplätze verlieren.

Nun muss man sich fragen, ob das so gewollt war. Hat die Regierung im Auftrag einer finsteren Macht beschlossen, ihr Land in den Staatsbankrott zu treiben ? Zu den Zeiten des Kalten Krieges hätte man sicherlich diese Möglichkeit erwogen, denn der Untergang des Kapitalismus und seiner westlichen Vertreter war schließlich tatsächlich das Ziel des uns nicht wohl gesonnenen Warschauer Paktes.

Heutzutage ist ein solcher Verdacht natürlich absurd. Wenn es aber nicht die Absicht der Regierung war, das Land über die Zerstörung seiner Energieversorgung kaputt zu machen – was war dann der Grund für ihre Handlungsweise ?

Die beiden einzig plausiblen Antworten auf diese Frage sind unendlich peinlich.

Die Regierung:

Der Anlass für diesen krassen Kurswechsel, der zu Recht als „Wende“ bezeichnet wurde, war eine politische strategische Überlegung: Der Opposition, speziell den Grünen , sollten alle Argumente abgenommen werden – indem die Regierung plötzlich selbst deren Linie vertrat.

Sie hat ungeprüft ideologische Konzepte der Grünen übernommen. Sie hat auf die Zuziehung von externem fachlichem Sachverstand verzichtet; andernfalls wäre das Ausmaß des Unsinns nicht so extrem geworden. Und in ihren Ministerien fehlte es allem Anschein nach an dem nötigen Sachverstand; insbesondere im Umweltministerium, in dem es direkt nach der Amtsübernahme durch Trittin einen Exodus von Fachleuten und eine Einstellungswelle von grün-ideologisch geprägten Mitarbeitern gab, die bis heute – zwei Regierungen später – immer noch die Arbeit des Hauses bestimmen.

Die Folgen dieser Wende interessierten die Kanzlerin ganz offensichtlich überhaupt nicht. Es ging nur um den Machterhalt.

Das Parlament:

Man hätte daraufhin erwarten können, dass die Abgeordneten, unter denen sich schließlich eine nicht geringe Anzahl von Fachleuten und Managern befindet, die Regierungspläne zu Konfetti zerreißen würden. Aber es lief völlig anders ab.

Unsere Parlamentarier haben sich – mit wenigen ehrenwerten Ausnahmen – wie die sprichwörtlichen Lemminge verhalten, als sie sowohl über die Energiewende-Pläne als auch über das Kernkraft-Moratorium und den Kernkraft-Ausstieg abstimmten. Es war offenbar eine Mischung aus verschiedenen Faktoren, die sie dazu veranlaßten: Die Opposition aus SPD, Grünen und Linken sah erstaunt, wie ihre eigenen Forderungen von der Regierung erfüllt wurden. Die Regierungsfraktionen standen unter dem Druck ihrer Fraktionsführungen. Zudem fehlte der Mehrheit die fachliche Kompetenz zur Beurteilung der Konsequenzen. Durch Zeitdruck wurde die Zuziehung externen Sachverstands verhindert. Und schließlich herrschte eine große Angst vor den Medien, deren überwiegend grün-rot orientierte Redakteure ihrerseits einen Druck ausübten, den alle Politiker fürchten.

Und so beschloß der gesamte Bundestag fast einstimmig den Einstieg in das „erneuerbare Zeitalter“ (Zitat aus dem Energiekonzept) – und de facto den Untergang ihrer Nation.

Dieser Vorgang dürfte den Historikern noch viel Stoff für Analysen bieten.

Es ist diese praktisch einstimmige Zustimmung des gesamten Parlaments zur Energiewende und zum „Atomausstieg“, die wie eine schwere Hypothek auf den Altparteien und ihren Abgeordneten liegt. Diese Hypothek liegt auch auf dem nun neu gewählten Bundestag, denn die maßgeblichen Parteien sind immer noch dieselben – mit Ausnahme der FDP – und auch die meisten der neuen Abgeordneten sind die alten, die der energiepolitischen Blamage ihre Zustimmung gegeben hatten.

Jede nur denkbare Regierungskoalition wird aus Parteien bestehen, die alle dafür waren. Und sie müßten nun im Grunde fast alles, was sie vor nicht langer Zeit mitbeschlossen haben, wieder zerschlagen.

Dieses Dilemma in Verbindung mit den unausweichlichen, sehr bald fälligen drastischen energiepolitischen Maßnahmen eröffnet nun leider ziemlich erschreckende Aussichten. Denn es besteht die Möglichkeit, dass an Stelle einer Rücknahme der falschen Entscheidungen – insbesondere das EEG betreffend – die letzten Hemmungen fallen und der bereits eingeleitete Prozeß der Planwirtschaft direkt in eine Verstaatlichung des Energiesektors führt.

Schließlich bietet ein weitgehend verstaatlichter Energiesektor für eine Regierung, die eine mit Gesichtsverlust verbundene Revision des Zerstörungsprogramms fürchtet, eine Reihe von vorübergehenden Vorteilen:

- Es geschieht schließlich etwas; man zeigt Handlungsfähigkeit.

- Immer neue, verschlimmbessernde Reparaturmaßnahmen , die durch die gegenüber wirtschaftlichen Fehlern gnadenlose Marktwirtschaft erzwungen werden, sind nun nicht mehr nötig. Denn die Marktwirtschaft wird ja in diesem Sektor abgeschafft.

- Man kann nun mit vielen Milliarden Euro die selbst verschuldeten und immer neuen Probleme vorübergehend „heilen“.

- Es gibt neue Behörden und viele schöne Pöstchen für verdiente Parteisoldaten.

- Und man gewinnt Zeit. Nicht sehr viel, denn nach maximal zwei Jahren dürften alle Verstaatlichungskosten, Firmenaufkäufe – (bevorzugt: notleidende Stadtwerke) -, Subventionen, Investitionszuschüsse, Kapazitätsvorhaltungs-Prämien für stillstehende Kraftwerke und soziale Hilfsprogramme für Energiekosten-geschädigte Bürger die Finanzkraft des Bundes übersteigen. Dann steckt der Karren zwar noch viel tiefer im Dreck, aber der Zeitgewinn wäre es der Politik vermutlich wert.

Pläne, Visionen und Gesetze

Wer einen Blick in die Zukunft wagen möchte, tut gut daran, die bisherige Entwicklung genau in Augenschein zu nehmen. Wir kennen die Programme, die unsere Regierung seit 2009 auf dem Feld der Energiepolitik beschlossen hat und wir kennen die bisherigen Ergebnisse, heute, gerade einmal 4 Jahre später.

Sie sind überaus aufschlußreich und erlauben eine Beurteilung der Qualität der Regierungsarbeit – und daher gestatten sie auch eine Prognose über die künftigen Schritte der Regierung in diesem volkswirtschaftlich extrem wichtigen Sektor. Um eine Bewertung der deutschen Energiepolitik zu erhalten, genügt der Blick auf die Aktionen der Bundesregierung seit dem Sommer des Jahres 2009.

Im August des Jahres 2009 wurde das Gesetz zum Ausbau von Energieleitungen im 380 kV-Höchstspannungs-Übertragungsnetz (EnLAG) verabschiedet.

- ♦ In der gegenüber 2009 leicht modifizierten Fassung gilt heute eine Planung von 1.855 km. Zweck dieses enormen Netzausbaus, der bisher nur das Höchstspannungs-Übertragungsnetz betrifft, ist vor allem der Transport des in Norddeutschland fern von den Verbrauchszentren erzeugten Windstroms nach West- und Süddeutschland. Von dem noch viel gewaltigeren Ausbau der Mittel- und Niederspannungsnetze, der durch die flächendeckend vorhandenen Solarstrom- und Windkraftanlagen mit ihrem gesetzlich garantierten Einspeisevorrang verursacht wird, ist dabei noch gar nicht die Rede.

Am 28. September 2010 beschloss die Regierung dann das „Energiekonzept für eine umweltschonende, zuverlässige und bezahlbare Energieversorgung“, das nach der wahrlich größenwahnsinnigen Feststellung des Bundesumweltministeriums „die energiepolitische Ausrichtung Deutschlands bis 2050 beschreibt“.

Wesentliche Ziele darin waren:

- ♦Reduzierung der Treibhausgasemissionen bis 2020 um 40 % gegenüber 1990.

- ♦Erreichen eines Anteils der „erneuerbaren“ Energien an der Stromerzeugung von 50 % bis 2030; von 65 % bis 2040 und von 80 % bis 2050.

- ♦Bei diesen Zielen handle es sich um „ehrgeizige Klimaschutzziele“.

- ♦Zur Kernenergie liest man im Energiekonzept: „Der notwendige Umbau der Stromversorgung hin zum (wörtlich) erneuerbaren Zeitalter mit der Perspektive 2050 wird den traditionellen Energiemix (gemeint sind Kohle und Kernkraft) deutlich verändern. Ein solcher Prozeß benötigt nicht nur Zeit, sondern muss auch wirtschaftlich vernünftig ausgestaltet werden.“ Dann kommt der entscheidende Satz:

-

„Um diesen Übergang zu gestalten, brauchen wir noch zeitlich befristet die Kernenergie und werden deshalb die Laufzeiten (der 17 KKW) um durchschnittlich 12 Jahre verlängern“. Und noch besser: „Darüber hinaus werden die Regelungen über Sicherheitsanforderungen an die deutschen Kernkraftwerke im Rahmen einer 12. Atomgesetz-Novelle erweitert und auf technisch höchstem Niveau fortgeschrieben.“

- ♦Zum Endlager für Kernkraft-Abfälle: „Dies (Anm.: das Endlager Konrad) wird möglichst zügig errichtet und in Betrieb genommen. Für 90 % der anfallenden radioaktiven Abfälle ist dann ein sicheres Endlager vorhanden.“ Zum Thema hochradioaktive Abfälle steht dort: Die Erkundung (Anm.: des Salzstocks Gorleben) wird ab Oktober 2010 ergebnisoffen wieder aufgenommen. In einer vorläufigen Sicherheitsanalyse werden bis Ende 2012 alle bisherigen Ergebnisse über den Salzstock zusammengetragen und einer internationalen Expertenprüfung unterzogen. Darauf aufbauend können wir die Erkundung zielgerichtet abschließen.“

- ♦Zur Abtrennung und Speicherung von CO2 (CCS): „Bis 2020 sollen zwei der 12 EU-weit förderfähigen CCS-Demonstrationsvorhaben gebaut werden.

- ♦ „Wir wollen mittelfristig die verfügbaren deutschen Potenziale für Pumpspeicherwerke im Rahmen der technischen und wirtschaftlichen Möglichkeiten erschließen.“

- ♦„Bis 2020 sollen 1 Million Elektrofahrzeuge in Deutschland fahren; bis 2030 sollen es 6 Millionen sein.“

- ♦Am Schluß wird ausführlich „die Einbettung (dieser Pläne und Bemühungen) in die europäische Energiepolitik“ versprochen.

Nur 8 Monate später: Ein Grundpfeiler der Stromversorgung wird zerstört

Kurz nach dem durch ein schweres Erdbeben mit nachfolgendem katastrophalem Tsumani verursachten Reaktorunfall in Fukushima verkündete am 14. März 2011 die Bundeskanzlerin eine auf 3 Monate befristete Aussetzung der gerade beschlossenen Laufzeitverlängerung – das sog. Moratorium. Am darauf folgenden Tag teilte sie mit, dass die 7 ältesten deutschen Kernkraftwerke während des Moratoriums abgeschaltet werden sollten. Auch das seit 2009 abgeschaltete KKW Krümmel sollte in dieser Zeit außer Betrieb bleiben.

Weil die fachlich zuständige Reaktorsicherheits-Kommission allen Reaktoren eine sehr hohe Sicherheit bescheinigte, berief die Regierung eine sogenannte Ethik-Kommission, die dann unbelastet durch Fachkenntnisse und wunschgemäß den Kernkraftausstieg befürwortete.

Am 6. 6. 2011 beschloss die Regierung ein Energiepaket mit dem Titel „Der Weg zur Energie der Zukunft – sicher, bezahlbar und umweltfreundlich“.

Es war streckenweise eine Neuauflage des Papiers vom September 2010. Aber durch das begleitende 13. Gesetz zur Änderung des Atomgesetzes wurde die Laufzeitverlängerung vom Oktober 2010 am 6.8.2011 zurückgenommen.

Diese sachlich völlig unbegründete und rein politisch-taktische Kehrtwendung bezüglich der Rolle der Kernenergie zerstörte einen Grundpfeiler der deutschen Stromversorgung, denn die zuvor allein durch Kohle- und Kernkraftwerke sichergestellte Grundlast-Stromerzeugung wurde plötzlich allein den Kohlekraftwerken auferlegt. Das war nicht nur ein schwerer Schlag gegen die Versorgungssicherheit der Wirtschaft und der Verbraucher, sondern zugleich auch ein Schlag gegen die hochfliegenden Pläne mit der stufenweisen und weitgehenden Übernahme der Stromversorgung durch die „Erneuerbaren“, die nun auch alle Kernkraftwerke ersetzen sollten. Diese Vision wurde nun vollkommen illusorisch, weil die wegfallende große Grundlast-Kapazität überhaupt nicht durch „Erneuerbare“ ersetzt werden kann und höchstens ein kleiner Teil der entstehenden Lücke durch neue Braunkohlekraftwerke ausgefüllt werden könnte – falls sich überhaupt noch ein Investor dafür findet (s.u.).

Weiterhin zerstörte dieser Beschluss die Hauptbegründung der Energiewende, die Treibhausgase drastisch zu Gunsten eines angeblichen „ehrgeizigen Klimaschutzes“ zu reduzieren. Wer mit mehr Kohlekraftwerken die CO2-freien Kernkraftwerke ersetzen muß, bekommt unweigerlich mehr CO2-Emissionen – das wusste selbst diese Regierung.

Damit war nach nur 8 Monaten nach seiner Verkündung dem Energiekonzept der Regierung das Hauptziel abhanden gekommen und alle anderen, die Stromversorgung betreffenden Ziele waren endgültig illusorisch geworden.

Damit endete dann auch schon die angeblich 40 Jahre in die Zukunft reichende Energieplanung.

Der Blick auf eine Trümmerlandschaft

Zwei Jahre darauf gleichen das Energiekonzept von 2010 und das „Energiepaket“ von 2011 einer Trümmerlandschaft.:

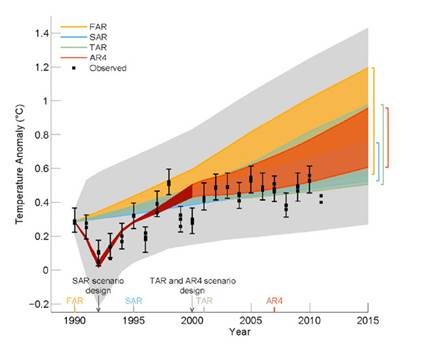

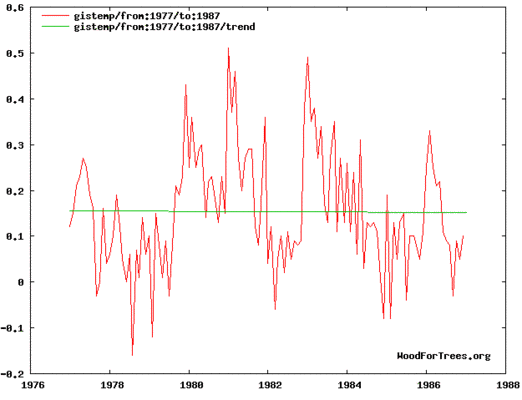

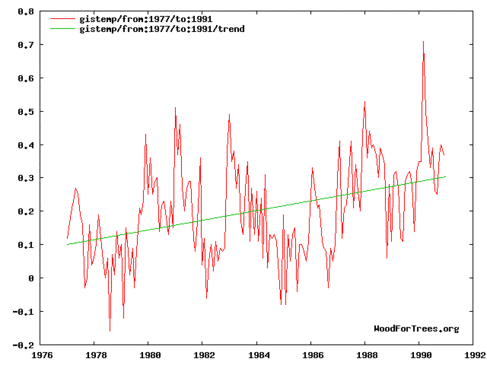

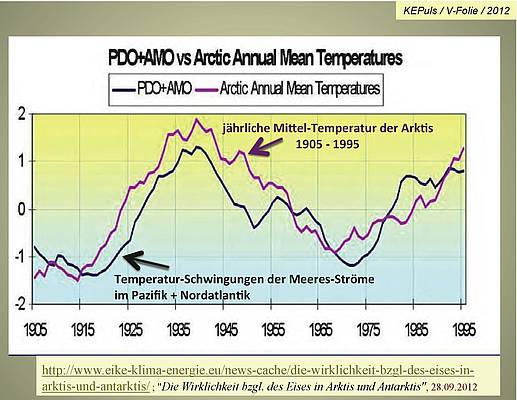

- ♦ Die Emissionen des angeblichen Treibhausgases CO2 steigen seit der Abschaltung der 8 Kernkraftwerke unaufhaltsam. Das macht im Grunde nichts, denn die Hypothese vom CO2-angetriebenen Klimawandel zerfällt gerade, weil die reale Temperaturentwicklung im Begriff ist, selbst den Streubereich der IPCC-Horrorprognosen in Richtung Abkühlung zu verlassen. Das politische Hauptziel „Klimaschutz“ der gesamten Energiepolitik ist damit aufgegeben worden. Darüber spricht man nicht mehr, da zu peinlich.

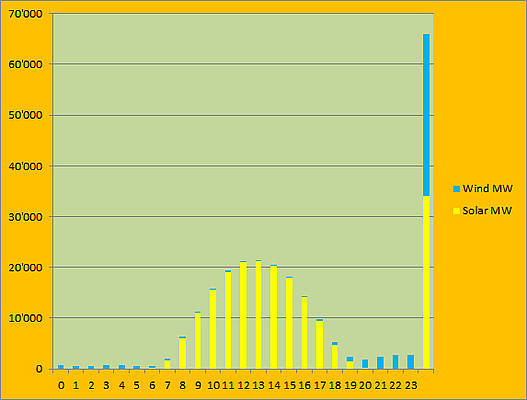

- ♦ Der Ausbau der sogenannten erneuerbaren Energien ist dank großzügigster Subventionierung stärker als geplant erfolgt, allerdings mit unerwünschten Folgen: Ein starker Anstieg des Strompreises; die ruinierte Wirtschaftlichkeit von Gas-, Steinkohle- und Pumpspeicherkraftwerken mit der Folge ihrer drohenden Stilllegung; die Gefährdung der Netzstabilität durch witterungsbedingte Schwankungen von Wind- und Solarstrom; Landschaftsverschandelung, Naturzerstörung und Lärmbelastung durch Windkraftanlagen; riesige Monokulturen durch Mais- und Rapsanbau für Biogasanlagen werden zur Konkurrenz für landwirtschaftlich genutzte Flächen; Anstieg der Pachtkosten für Agrarflächen; Anstieg der Holzpreise; Feinstaubbelastung durch Holzpellet-Heizungen; Belastungen der Stromnetze unserer Nachbarländer durch Überschuß-Strom von Windkraftanlagen; Zuzahlungen für Nachbarländer, damit sie die unerwünschten Leistungsspitzen annehmen. Und dennoch kein Ersatz der konventionellen Stromerzeugung durch Erneuerbare, weil diese auch bei größtem Ausbau niemals eine sichere Versorgung garantieren können. Damit wird die gesamte Stromerzeugung doppelt aufgebaut – die dadurch verursachten Kosten kann keine Wirtschaft verkraften: Die Abwanderung der Grundstoffindustrie ist die Konsequenz. Womit die Regierung ebenfalls nicht rechnete, war der große Widerstand der Bürger gegen Windkraftanlagen: Es gibt lt. SPIEGEL-Bericht über 700 Bürgerinitiativen gegen diese Technik. Hinzu kommen Bürgerinitiativen gegen den Bau von Hochspannungsleitungen und gegen den großflächigen Anbau von Energiepflanzen sowie gegen Biogasanlagen.

- ♦ Der durch die Abschaltung der Kernkraftwerke verursachte Ausfall an Grundlaststrom wird nun teilweise durch Stromimporte ausgeglichen: Dieser Strom kommt aus französischen und tschechischen Kernkraftwerken.

- ♦ Alle entschlossen im Energiekonzept vom September 2010 verkündeten Pläne zur Endlagerung radioaktiver Abfälle wurden schon 2013 Makulatur. Am 23.7.2013 wurde das von allen Parteien im Bundestag verabschiedete „Standortauswahlgesetz“ veröffentlicht. Das neue zeitliche Ziel ist nicht mehr 2012, sondern 2031 – aber nicht etwa für die Eröffnung des Endlagers, sondern nur für die Entscheidung, wo es denn errichtet werden könnte. Wörtlich im Gesetz: „Das Standortauswahlverfahren soll (!) bis zum Jahr 2031 abgeschlossen sein.“ Woraufhin dann der „Gorleben-Effekt“, also massiver Bürgerwiderstand, an jedem neuen, in Aussicht genommenen Standort eintritt. Dieses Gesetz ist nichts anderes als eine Totalkapitulation vor einer unangenehmen Entscheidung: Es bedeutet, dass sämtliches hochradioaktive Material für einen unabsehbaren Zeitraum oberirdisch gelagert werden muss. Ob das die Endlager-Gegner wollten ?

- ♦Die Pläne für Demonstrationsanlagen zur CO2-Abtrennung und unterirdischen Speicherung wurden durch den Ausstieg von Vattenfall sowie die massiven Bürgerproteste in Norddeutschland ebenfalls Makulatur.

- ♦ Von den wenigen, energiewirtschaftlich bedeutungslosen Projekten zum Bau neuer Pumpspeicherkraftwerke scheiterte das große Projekt am Rursee; Trianel warf das Handtuch nach sehr großem Widerstand aus der Bevölkerung.

- ♦ Auch beim Thema Elektrofahrzeuge droht eine Blamage. Im ersten Halbjahr des Jahres 2013 gab es nicht einmal 2.500 Neuzulassungen.

- ♦ Der Ausbau des Höchstspannungsnetzes kommt nicht voran: Von den aktuell geplanten 1.855 km sind bislang 268 km und damit knapp 15 % realisiert. Weitere Fertigstellungen erwarten die Netzbetreiber erst wieder 2014. Inzwischen werden die genannten Zahlen als viel zu niedrig angezweifelt: Minister Rösler erklärte, dass nach dem Netzentwicklungsplan 2.900 km optimiert und weitere 2.800 km neu gebaut werden müßten.

- ♦Und die von der Regierung zugesagte „Einbettung in die europäische Energiepolitik“ fand nicht nur nicht statt, vielmehr vollzog sie ihren extremen Schritt mit der überstürzten Abschaltung von 8 Kernkraftwerken von immerhin 8422 Megawatt Leistung ohne jede Vorwarnung oder gar Konsultation mit den Nachbarländern, die mit ihren Stromnetzen mit Deutschland verbunden sind. Auch der extreme Ausbau der Windkraft und der Photovoltaik hat durch die dadurch verursachten starken Leistungsschwankungen erhebliche Auswirkungen auf benachbarte Länder. Die Regierung hat diese einseitige Politik niemals mit ihren in Bezug auf die Auswirkungen auf den Strompreis und die Netzstabilität direkt betroffenen Nachbarn abgestimmt. Jetzt planen Nachbarländer – insbesondere Polen – den Bau technischer Sperreinrichtungen gegen unerwünschte deutsche Stromexporte in ihr Netz. Abwehr anstelle von Integration ist nun die Richtung.

Energie-Planwirtschaft als Folge von Hilflosigkeit

In der Wirtschaftspresse ist bereits harsche Kritik daran geübt worden, dass im Energiesektor immer mehr marktwirtschaftliche Grundprinzipien von der Regierung missachtet und durch politisch motivierte Verletzungen dieser Prinzipien ersetzt werden.

Zahlreiche durch diese Politik hervorgerufenen Probleme zwangen die Regierung bereits zu „Reparaturmaßnahmen“, die allerdings niemals den Grundübeln zu Leibe rückten, sondern im Gegenteil stets so eingerichtet wurden, dass die gefährlich gewordenen primären Schadwirkungen durch neue kostspielige Investitionen, Subventionen und Kostenüberwälzungen auf die Verbraucher zugekleistert wurden – womit sie selbst zu neuen Schädigungen von Bürgern und Wirtschaft führen.

Die Methode ist: Fehlentscheidungen nicht rückgängig machen, sondern neue Fehler einführen, um die dahinter stehende planwirtschaftliche Ideologie zu schützen.

Folgendes geschah bereits:

1. Das Erneuerbare Energien-Gesetz (EEG), also die Zwangssubventionierung unwirtschaftlicher und auch technisch ungeeigneter Methoden der Stromerzeugung – verbunden mit dem Zwang, den so erzeugten Strom vorrangig ins Netz einzuspeisen und seinen Weiterverkauf notfalls noch zusätzlich zu bezahlen

2. Entschädigungs-Verpflichtung für die Nicht-Produktion eines Wirtschaftsgutes – s. §12 EEG.

3. Die mit Angstszenarien begründete Stilllegung einer großen Grundlast-Stromerzeugung (Kernkraft) mit der Folge von Preissteigerungen, Versorgungsengpässen und abnehmender Netzstabilität.

4. Gewaltiger Ausbau der Stromnetze, der ohne die Fehlentscheidung der erzwungenen Bevorzugung unrentabler Erzeugungstechniken – s. Punkt 1 – überhaupt nicht notwendig wäre.

5. Die Übernahme der Kosten, die den Windparkbetreibern durch einen verzögerten Anschluss der Offshore-Windparks an das Land-Stromnetz entstehen, durch die Stromverbraucher – eine staatswirtschaftliche Maßnahme, die das vormals FDP-geführte Wirtschaftsministerium erfunden und durchgesetzt hatte.

6. Die Entlastung von energieintensiven Produktionen von den durch das EEG verursachten Strompreiserhöhungen – und deren Überwälzung auf die übrigen Verbraucher. Hier besteht die Möglichkeit eines Eingriffs der EU wegen Wettbewerbsverletzung.

7. Neue Subventionen, um weitere Folgen der Fehlsteuerung durch das EEG und den Kernkraftausstieg zu bekämpfen: Die Vorrangseinspeisung von Wind- und Solarstrom drückt den Börsenpreis speziell in den Mittagsstunden und macht Kohle- und Gaskraftwerke und auch Pumpspeicherkraftwerke unrentabel: Die Betreiber planen Stilllegungen. Damit zerstört das EEG sogar die Rentabilität der einzigen Kraftwerke, die zu einer Stützung und Stabilisierung des vom stark schwankenden EEG-Strom gefährdeten Stromnetzes imstande sind. Die verzweifelte Regierung hilft sich mit: Neuen Subventionen. Das Stichwort heißt „Kapazitätsmanagement“. Im Klartext: Zur Stilllegung vorgesehene Kraftwerke werden zur „Kaltreserve“ ernannt und deren Betreiber erhalten Geld, um die stillstehende Anlage bei Engpässen hochzufahren. Bereits erfolgt beim bayerischen modernen Gaskraftwerk Irsching, dessen Normalbetrieb durch das EEG ruiniert wurde. Der Staat hält sich also auf eigene Kosten eine Kaltreserve. Für die von niemand mehr geplanten Kraftwerksneubauten kommt Entsprechendes: Siehe unten.

8. Stromspeicher werden im Ausland gesucht – so die per Seekabel teuer anzuschließenden Pumpspeicherwerke Norwegens – weil nicht benötigter, überschüssiger Windstrom zwischengespeichert werden muss. Die Seeekabelverbindung Nord.Link ist geplant.

9. Durch die Energieeinsparverordnung werden Hausbesitzer zur energetischen Sanierung und Nachrüstung gezwungen. Auch wenn sie das nicht wünschen. Sie dürfen die Kosten auf die Mieter umlegen.

10. Für Neubauten ist bereits die Installierung der sog. intelligenten Stromzähler vorgeschrieben. Ein Zwang für alle Verbraucher, diese Geräte anzuschaffen, ist angesichts der die Bürger bevormundenden Energiepolitik zu erwarten.

11. In Baden-Württemberg wurden Hausbesitzer bereits gesetzlich verpflichtet, bei einer Modernisierung ihrer Heizungsanlage eine anteilige Versorgung durch „Erneuerbare Energie“ sicherzustellen.

12. Durch die wetterabhängige, bei Bewölkung rasch schwankende Stromeinspeisung der Photovoltaikanlagen geraten die Verteilnetze in Stabilitätsprobleme. Weil ein durch zu große Einspeisung hervorgerufenes Überschreiten der Netzfrequenz von 50,2 Hertz vermieden werden muss, wurde den Betreibern der Solarstromanlagen die Anschaffung eines Regelgerätes vorgeschrieben. Die Kosten dafür wurden – unbemerkt – wieder den Stromverbrauchern auferlegt, obwohl sie für diese Störung des Netzes nicht verantwortlich sind.

Die Verstaatlichung des Energiesektors in der Zukunft

Der bereits eingeschlagene Weg in die Verstaatlichung der Stromerzeugung und -verteilung führt folgerichtig zu folgenden Schritten – und bei einer großen Koalition erst recht:

1. Die von den EVU geplante Stilllegung von konventionellen Kraftwerken hat nicht nur den Einbruch des Börsenpreises durch hochsubventionierten und mit gesetzlichem Einspeise-Vorrang versehenen EEG-Strom als Ursache: Es geht ebenfalls um alte, unmoderne und mit schlechten Wirkungsgraden arbeitende Anlagen, die demnächst das Ende ihrer Betriebsdauer erreichen. Auch das fürchtet die Regierung, denn sie braucht alle existierenden Kraftwerke, weil keine neuen mehr gebaut werden – s.u.

Die staatswirtschaftliche und anti-marktwirtschaftliche Konsequenz: Bezuschussung auch dieser Altanlagen; d.h. Finanzierung umfassender Modernisierungsmaßnahmen und Subventionierung des Betriebes.

2. Die Bevorzugung von Wind- und Solarstrom macht nicht nur die bestehenden konventionellen Kraftwerke unrentabel. Insbesondere Kraftwerksneubauten werden von der Regierung dringend gefordert, weil die durch den Kernkraftausstieg entstandene Lücke mit neuen Kohlekraftwerken ausgefüllt werden muss. Von CO2-Emissionen spricht ohnehin niemand mehr. Die privaten Investoren denken jedoch angesichts dieser Energiepolitik verständlicherweise nicht mehr an Neubaupläne. Das bekannte Heilmittel: Geld vom Staat – hier Investitionkostenszuschüsse. Das diskutiert auch schon der BDEW und auch die Bundesnetzagentur empfiehlt, über Subventionen für den Kraftwerksneubau „nachzudenken“ Deshalb hat bereits die alte Bundesregierung derartige Investitionskostenzuschüsse für neue fossile Kraftwerke im Zeitraum 2013-2016 in Aussicht gestellt und nahm hierzu Verhandlungen mit der EU auf. Dies wird mit Sicherheit kommen, weil auch weiterhin angesichts der sprunghaften und unberechenbaren Energiepolitik niemand derartige Investitionen tätigen wird, was sich schon heute abzeichnet. Sollte das dann auch nicht helfen, wird der Staat selbst als Kraftwerksbauer auftreten müssen – vielleicht auch gerne wollen.

3. Der staatliche Geldregen für Energiewende-Reparaturmaßnahmen lockt nun auch weitere Interessenten hervor: Auf der Energiespeicher-Konferenz IHRES in Berlin wurde ein Einspeisegesetz á la EEG auch für Energiespeicher, die das Netz stabilisieren sollen, gefordert. Auch Investitionszuschüsse seien geeignet. Abermals heißt das vom Staat – also von den Verbrauchern – bezahlte „Kapazitätsbereitstellung“; hier eben für Speicher.

4. Die schon heute erheblichen Probleme, die viele Haushalte mit ihren Stromrechnungen haben – die Verbraucherschützer sprechen von 600.000 Haushalten, denen der Strom abgestellt wurde – könnten in der Logik der Staatswirtschaft dazu führen, dass es einen Eingriff in die Tarifgestaltung der Netzbetreiber gibt: Sozialtarife für Bedürftige, also höhere Preise für die Übrigen.

5. Die bereits bei den PKW erprobte Idee der Verschrottungsprämie erlebt gegenwärtig bei den Ideenproduzenten eine Neuauflage für die „weiße Ware“, speziell alte Kühlschränke und Heizkessel. Vorbild ist Mexiko: Dort wurde das seit 2009 praktiziert; 1,5 Millionen Haushalte ersetzten dadurch ihre Kühlschränke und 7 % weniger Stromverbrauch pro Haushalt war das Ergebnis.

Dieser finanzielle Anreiz kann auch noch mit der Verpflichtung zur Installation von Photovoltaikanlagen oder Wärmepumpen verknüpft werden.

6. Ebenso kann es zu staatlichen Zuschüssen beim Kauf eines Elektroautos kommen, wie es die Autoindustrie, die fast nichts derartiges verkaufen kann, vehement fordert. Nicht einmal 2.500 Neuzulassungen gab es in Deutschland im 1. Halbjahr 2013. Die Autofahrer sind eben nicht so dumm, ein überteuertes Fahrzeug zu kaufen, das auch noch ausschließlich Nachteile bringt: Geringe Reichweite, lange Ladezeiten, fehlende Lade-Infrastruktur, Unbrauchbarkeit im Winter, Sicherheitsbedenken bei den Li-Ionenbatterien, Zweifel an der Batterielebensdauer. Dazu kommt noch die Konkurrenz moderner Dieselmotoren, die kaum weniger energieeffizient, aber voll gebrauchstüchtig sind. Die Regierung hat jedoch aus nicht nachvollziehbaren Gründen das E-Auto zum Klimaretter ernannt und es ist zu befürchten, dass neue staatliche Maßnahmen erfunden werden, um diese noch ca. 20 Jahre von ihrer Brauchbarkeit entfernte Technik jetzt in den Markt zu bringen, koste es was es wolle.

7. Es ist davon auszugehen, dass die sog. Smart Meter, also „intelligente Stromzähler“ , durch staatliche Zwangsmaßnahmen in den Haushalten auch von Altbauten eingebaut werden müssen. Versuche haben zwar gezeigt, dass die damit verbundenen Kosten deutlich über den sehr geringen Einsparungen im Stromverbruch liegen, doch das dürfte nach allen Erfahrungen die Ministerialbürokratie nicht daran hindern. Es geht schließlich nicht nur um Stromeinsparungen, sondern vielmehr um die Kontrolle der Energieverbraucher sowie um deren Erziehung zum Energiesparen. Es sind deshalb Proteste zu erwarten, weil mit diesen Zählern das Verbrauchsverhalten der Bürger überwacht werden kann – mit Ermahnungen des Versorgers bei kritikwürdigem, nicht klimagerechten Verhalten. Der Schnüffelstaat läßt grüßen.

8. Kurz vor der Bundestagswahl hat das bis dahin FDP-geführte Wirtschaftsministerium 1000 Energieberatungs-Gutscheine á 250 Euro an Haus- und Wohnungsbesitzer verteilt. Ziel sei „ein weitgehender klimaneutraler Gebäudebestand bis 2050“. Dieser dreifache Unfug – die Unnötigkeit der Aktion, weil das Klimaargument passé ist, die größenwahnsinnige Perspektive 2050 und die faktische Unbezahlbarkeit trotz Gutschein – erklärt zumindest zu einem kleinen Teil den Totalabsturz der FDP. Aber die Idee zur Energieberatung der Haushalte hatte zuvor schon Minister Altmaier und es ist anzunehmen, dass die staatlich geförderte Ermunterung der Bürger zum Energiesparen noch weiter getrieben wird. Bezeichnend ist dabei, dass es mit dem Strom-Schlaraffenland der Erneuerbaren nicht so weit her sein kann, wenn geradezu verzweifelt das Stromsparen propagiert wird. Ob die Ergebnisse dieser Beratungen von staatlichen Stellen ausgewertet werden, um uneinsichtigen Bürgern „erneuerbare“ Energien nahe zu bringen, ist offen, aber keineswegs ausgeschlossen.

9. Weil mit zunehmendem Anteil von extremen Spitzen und ebenso abrupt eintretenden Versorgungslücken des Windstroms gerechnet werden muss, steigt auch die Gefahr von Netzzusammenbrüchen – neudeutsch Blackouts. Weil es nicht annähernd ausreichende Stromspeicher zum Ausgleich dieser Schwankungen gibt – und auch für die kommenden 20 Jahre nicht geben wird – werden staatliche Stellen verstärkt Großverbraucher zwingen, zeitweise Stromabschaltungen hinzunehmen. Diese Unternehmen sehen sich dadurch gezwungen, eigene größere Notstromgeneratoren zu installieren, was ihre Kosten in die Höhe treibt.

10. Weil die Lebensdauer auch von Photovoltaikanlagen und Windkraftanlagen begrenzt ist, stellt sich irgendwann die Frage der Verschrottung. Nach dem bislang eisern durchgehaltenen Prinzip der Energiewende, alle Kosten auf die Verbraucher abzuwälzen, ist zu befürchten, dass das auch bei diesen Kosten nicht anders sein wird.

11. Die Schnüffelei, die bei den intelligenten Zählern und der Energieberatung möglich ist, kann auch noch auf einer anderen, buchstäblich höheren Ebene erfolgen: Der Umweltreferent der Stadt Bonn, der über die geringe Anzahl von Photovoltaikanlagen auf den Dächern, die er aus seinem Büro sah, sehr traurig war, verbreitete sich über die Idee, aus Luftbildaufnahmen alle für eine Solarzellen-Installation geeigneten Dächer der Stadt zu bestimmen – um dann den betreffenden Hausbesitzern die Anschaffung einer Solarstromanlage ans Herz legen zu können. Hier können sich staatliche Stellen noch Meriten erwerben; vielleicht hilft auch die Luftwaffe.

13. Die Mischung aus Hilflosigkeit und Verzweiflung produziert bereits Vorschläge, die die Älteren an die letzten Jahre des Krieges erinnern. Damals wurde zum Beispiel in der Wochenschau im Kino regelmäßig der Kohlenklau vorgeführt , den man durch das Schließen der Fenster am Energiediebstahl hindern sollte. Jetzt ist das Energiesparen wieder nationale Pflicht geworden. Mit Plakaten wurde im Krieg auf die Wichtigkeit der Verdunkelung hingewiesen – damals gegen die Bomber, heute vielleicht wieder aktuell gegen den auch nicht angenehmen totalen Blackout im Winter. Minister Altmaier gab bereits Tips zum Energiesparen im Haushalt: So sollte man möglichst den Deckel auf dem Kochtopf lassen. Wenn es so weiter geht, werden auch noch unsere Kabarettisten arbeitslos.

Eine sehr ernste Warnung

Auf dem Debattenabend „Energiewende: Plan- vs. Marktwirtschaft“ der Stiftung Energie & Klimaschutz am 5.6.2013 in Stuttgart hat der Leiter des renommierten Instituts für Energiewirtschaft und Rationelle Energieanwendung (IER) der Universität Stuttgart, Prof. Dr. Alfred Voß, die Gefahr eines weiteren Ausbaus der sog. Erneuerbaren mit sehr deutlichen Worten beschrieben.

Zitat: „Die Technologieziele der Energiewende sind mit einem marktwirtschaftlichen Ordnungsrahmen nicht zu erreichen“. Trotz großer Fortschritte der erneuerbaren Energien glaube er nicht, dass diese auf einem freien Markt mit der konventionellen Stromerzeugung konkurrieren können. Deshalb werde die Energiewende „nur mit einem planwirtschaftlichen Ordnungsrahmen und mit erheblich höheren Kosten umzusetzen sein“. Voß weiter: „Alles was wir machen, wenn wir den Ausbau der Erneuerbaren so fortführen, wird dazu beitragen, dass wir ein Energieversorgungssystem haben, das ein zentrales Kriterium nicht erfüllt, nämlich einen wettbewerbsfähigen Strompreis für die Bürger und die Industrie.“

Zur Erinnerung: Im September 2010 beschloss die Regierung das „Energiekonzept für eine umweltschonende, zuverlässige und bezahlbare (!) Energieversorgung“. Wird dieses Konzept weiter verfolgt, werden alle diese Hauptziele völlig verfehlt und dieses Experiment wird in einer teuren Planwirtschaft enden.

Prognosen sind schwierig……,

insbesondere, wenn sie die Zukunft betreffen. Dieser von Mark Twain stammende Satz gilt weiterhin und ganz besonders für die deutsche Energiepolitik. Dennoch sei hier eine Voraussage gewagt. Genau so, wie neuerdings in Wetterberichten regelmäßig die ziemlich seltsame Aussage über die Regenwahrscheinlichkeit zu hören ist (als ob man dann mit 60-prozentiger Wahrscheinlichkeit seinen Schirm mitnimmt), kann man auch in diesem Politikfeld, gegen das unser Wetter – obwohl ein chaotisches System – zumindest für zwei Tage und damit besser als die gleichfalls chaotische Politik recht gut prognostizierbar ist, nur noch mit Wahrscheinlichkeiten rechnen.

Und die oben angestellten Betrachtungen ergeben mit einer höheren Wahrscheinlichkeit als alle anderen Möglichkeiten für den Energiesektor das Ergebnis Plan- und Staatswirtschaft. Sollte es anders kommen, wäre es ein guter Grund zur vorübergehenden Erleichterung.

Dr.-Ing. Günter Keil, Sankt Augustin

Den Beitrag können Sie unten als pdf herunterladen