IPCC immer noch von Kohlendioxid besessen

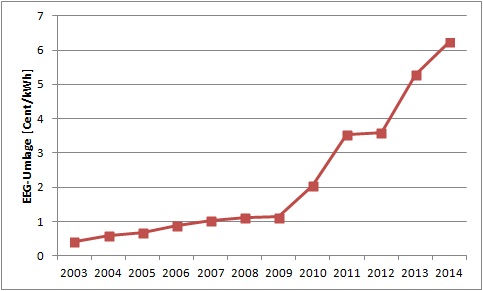

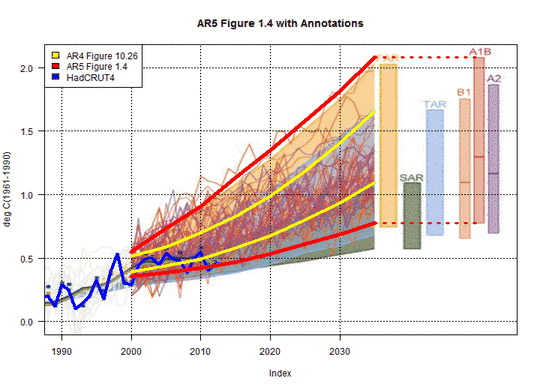

Das IPCC hat sich die am meisten in die Irre führende Graphik in der Endversion der Summary for Policymakers bis zum Schluss aufgehoben. Es handelt sich um ihre Abbildung SPM 10, in diesem Beitrag als Abbildung 1 gelistet [Bild rechts!] Sie zeigt die Anomalien der globalen Temperatur als Funktion von anthropogenen Kohlendioxid-Emissionen.

Abbildung 1 rechts

Der Begleittext beginnt mit den Worten:

Die globale mittlere Temperatur nimmt zu als Funktion der Akkumulation der Gesamt-CO2-Emissionen, belegt durch verschiedene Beweisketten. Die Ergebnisse von Multi-Modellen aus einer Hierarchie von Klima-Kohlenstoffzyklus-Modellen…

Weiter braucht man nicht zu lesen. Die Illustration basiert ausschließlich auf Klimamodellen.

Klimamodelle haben sich so weit von der Realität entfernt, dass man sie keinesfalls heranziehen kann zu unterscheiden, ob die globale Erwärmung natürlichen Prozessen oder vom Menschen verursachten Faktoren geschuldet ist. Auch kann man sie nicht für die Vorhersage der zukünftigen Klimaentwicklung nutzen, die auf Projektionen anthropogener Treibhausgase basieren.

Die Klimawissenschaftler und –modellierer haben bisher nur bewiesen, dass sie in der Lage sind, komplexe numerische Modelle zu erzeugen und dass sie in der Lage sind, diese Modelle so zu frisieren, dass sie in etwa die Erwärmungsrate während der jüngsten Erwärmungsperiode abschätzen können, die Mitte der siebziger Jahre begonnen und etwa zur Jahrtausendwende geendet hatte, aber nur während dieses Zeitraumes. Aber unabhängig davon sind selbst die Raten der modellintern erzeugten numerischen Erwärmung während jener letzten Erwärmungsperiode falsch.

Bemerkung: Vieles in diesem Beitrag ist Hintergrundinformation. Er zeigt, wie schlecht die Klimamodelle die globalen Wassertemperaturen seit 1880 simuliert haben. Wenn man nicht daran interessiert ist, wie, wo und warum die Klimamodelle nicht in der Lage sind, die Temperaturen über etwa 70% der Fläche des Planeten zu simulieren, dann scrolle man bitte vorwärts zu dem Abschnitt mit der Überschrift Die Klimamodelle unterstützen die Hypothese einer anthropogen induzierten Erwärmung nicht nach Abbildung 15.

Einführung

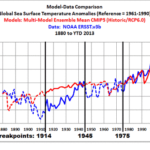

Wir verglichen Daten und die Ergebnisse von Klimamodellen bzgl. der globalen Temperatur (Festland und Ozeane) seit 1880 in dem Beitrag Model-Data Comparison with Trend Maps: CMIP5 (IPCC AR5) Models vs New GISS Land-Ocean Temperature Index. Für mein Buch Climate Models Fail habe ich die Werte in den Vergleichen mit 1914, 1945 und 1975 überarbeitet (an Stelle von 1917, 1944 und 1976). Die Werte von 1914 und 1975 wurden von Dr. Leif Svalgaard berechnet. Siehe seine Kommentare hier und hier zu diesem Beitrag auf WattsUpWithThat. Und für das Jahr 1975 habe ich mich auf den Statistiker Tamino bezogen. Der Gebrauch dieser Werte wird hoffentlich Behauptungen der Rosinenpickerei vermeiden.

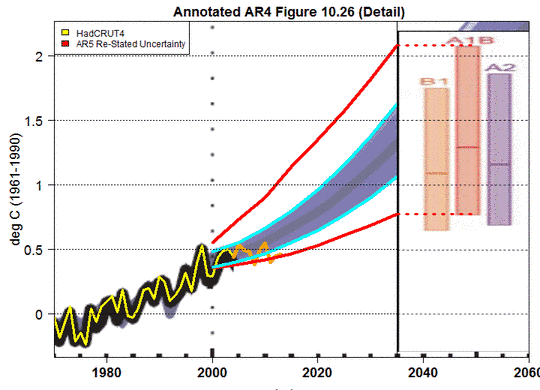

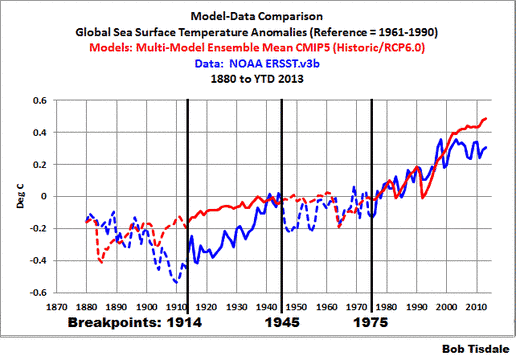

In diesem Beitrag betrachten wir die Anomalien der globalen Wassertemperatur, beginnend im Jahre 1880 und endend in diesem Jahr 2013. Der Datensatz ist ERSST.v3b – der auch vom GISS in seinem Festland-Ozean-Index verwendet wird – um die Konsistenz mit dem vorigen Beitrag und mit Climate Models Fail zu wahren. Die Modelle sind das Mittel des Multi-Model-Ensembles der Simulation der Wassertemperaturen für die CMIP5-Modelle (IPCC AR 5) unter Betrachtung der historischen und der RCP6.0-Szenarien [?]. Siehe auch den Beitrag On the Use of the Multi-Model Mean. Wir unterteilen die Daten und Modelle in zwei Erwärmungsperioden und zwei Perioden mit Abkühlung bzw. verlangsamter Erwärmung während der gleichen Werte 1914, 1945 und 1975. Weil die Temperaturdaten Festland plus Ozean nicht die gleichen Werte haben, scheinen die Punkte 1914, 1945 und 1975 etwas seltsam. Man betrachte Abbildung 2:

Abbildung 2

Ja, die Modelle agieren so schlecht.

Es ist ziemlich bemerkenswert, dass Klimamodellierer seit mehreren Jahrzehnten versucht haben, den globalen Temperaturverlauf abzubilden und vom CO2 als Treiber der globalen Erwärmung schwadronieren – wenn Klimamodelle die Temperaturen auf 70% der Erdoberfläche seit 1880 nicht simulieren können. Der einzige Grund, warum die Modellierer dem während der jüngsten Erwärmungsperiode näher kamen, besteht darin, dass sie ihre Modelle auf diesen Zeitraum abgestimmt haben. (Siehe Mauritsen et al. „Tuning the Climate of a Global Model”, paywalled. Vorabdruck hier.)

Die linearen Trends wurden berechnet durch EXCEL.

Für die Diskussion jedes Zeitraumes werden die Modelle verglichen mit auf Beobachtungen und Messungen basierenden Daten unter Verwendung von:

● Zeitreihen-Graphen

● Trendverteilungen, die Erwärmungs- und Abkühlungsraten in °C pro Jahr zeigen und

● Trends auf Basis zonaler Mittelung.

Beginnen wir mit der Periode, in der die Modelle noch die besten Ergebnisse zeigen, und bewegen uns dann in der Zeit rückwärts.

Die jüngste Erwärmungsperiode (von 1975 bis 2013)

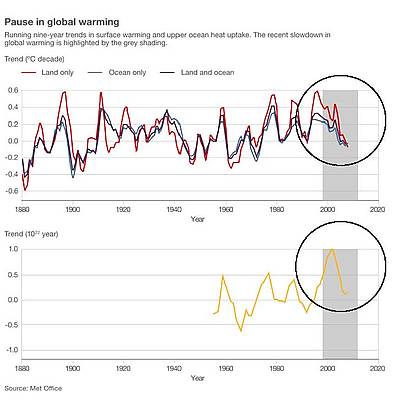

Die globalen Temperaturen (Festland + Ozeane) haben im Jahre 2001 aufgehört zu steigen [hier und der Beitrag hier]. Selbst dann noch zeigen die Modelle bis zur Gegenwart eine Fortsetzung der Erwärmung. Also betrachten wir dieses Jahr 2013 als Endpunkt der jüngsten Erwärmungsperiode.

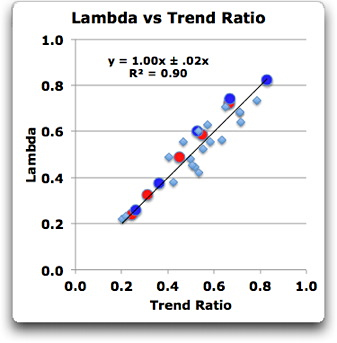

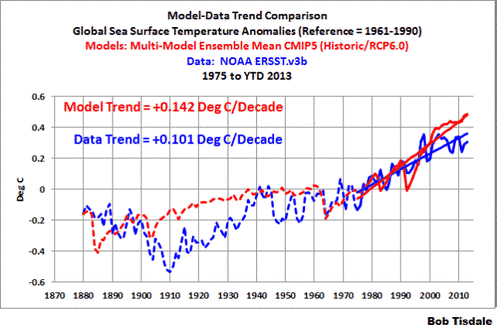

Abbildung 3 zeigt die modellierte Erwärmungsrate der globalen Wassertemperatur, die etwa 40% größer ist als der beobachtete Trend der Periode 1975 bis 2013. Man behalte im Hinterkopf, dass die Modelle auf die beobachteten Temperaturen während des größten Teils dieses Zeitraumes abgestimmt worden sind.

Abbildung 3

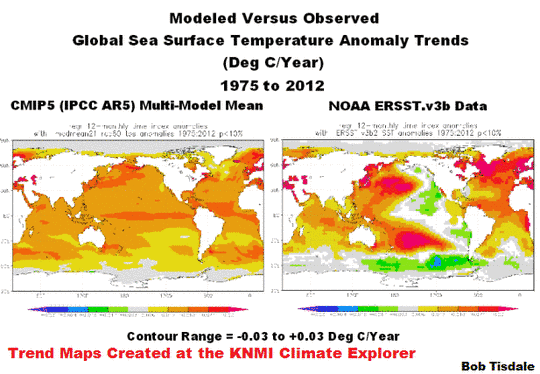

Die Modelle überschätzen nicht nur die Erwärmung insgesamt in dieser Periode, sie erfassten auch nicht die Zeiten, in denen sich die Wassertemperatur erwärmt (und abgekühlt) hat sowie das Ausmaß der Erwärmung (oder Abkühlung). Siehe Abbildung 4:

Abbildung 4

Die zeitliche und räumliche Verteilung der Erwärmung (oder Abkühlung) der Wassertemperatur trägt dazu bei, wann und wo die Temperaturen auf dem Festland variieren. Aufgrund des Versagens der Modelle hinsichtlich der angemessenen Simulation der Wassertemperatur ist es daher unwahrscheinlich, dass sie angemessen die Temperaturanomalien des Festlandes simulieren können.

Die im 5. Zustandsbericht des IPCC verwendeten Modelle haben bei der Erfassung von Folgendem versagt:

● Die extreme Erwärmung des Nordatlantik, verursacht durch die Atlantische Multidekadische Oszillation (siehe Ruiz-Barradas et al. (2013). Damit lässt sich erklären, warum die Modelle die Rate des polaren Verstärkungsfaktors [?] in der Nordhemisphäre nicht simulieren können und auch nicht die Rate des Eisverlustes in der Arktis (siehe Stroeve et al. 2012 „Trends in Arctic sea ice extent from CMIP5, CMIP3 and Observations”, paywalled).

● Die Abkühlung des Südlichen Ozeans, welche erklärt, warum die Klimamodelle die Meereisausdehnung in den Meeresgebieten um die Antarktis nicht simulieren können.

● Die Verteilung von Erwärmung und Abkühlung im Pazifik. Ursache hierfür ist das Versagen der Modelle bei der angemessenen Simulation der gekoppelten Ozean-Atmosphäre-Prozesse in Zusammenhang mit El Niño und La Niña-Ereignissen. Siehe hier und hier.

Anmerkung: Weitere Informationen über die Atlantische Multidekadische Oszillation AMO gibt es hier sowie in meinem Beitrag hier. Eine Einführung zu AMO von mir gibt es hier.

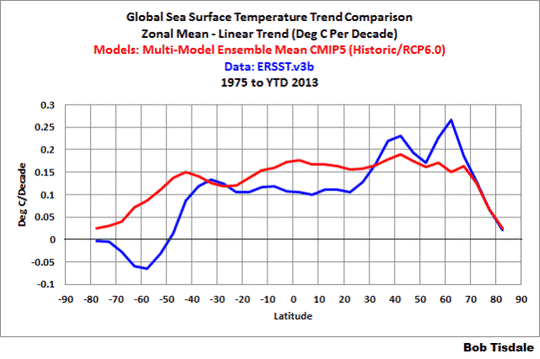

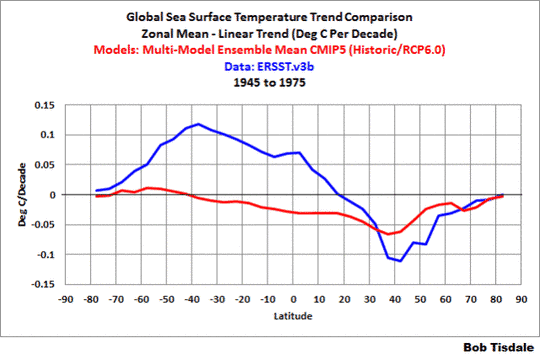

In Abbildung 5 sind die Erwärmungs- und Abkühlungsraten auf Basis eines zonalen Mittels dargestellt. Die Variablen für die Kurven des zonalen Mittels in diesem Beitrag sind die Trends in °C pro Dekade und sind auf der vertikalen y-Achse aufgetragen. Die horizontale x-Achse ist die Breite mit dem Südpol (bei -90) links und dem Nordpol (90) rechts sowie dem Äquator bei der Null-Breite. Die Graphen des zonalen Mittels in diesem Beitrag zeigen die Erwärmungs- und Abkühlungsraten der Wassertemperatur in den verschiedenen Breiten.

Abbildung 5

Wie Abbildung 5 zeigt, haben die Modelle für den Zeitraum 1975 bis 2013:

● die Erwärmung der Wassertemperatur in den Tropen um etwa 50% überschätzt,

● die Erwärmung der mittleren Breiten der Nordhemisphäre unterschätzt und

● keine Ähnlichkeit der Erwärmungs- und Abkühlungsraten der Wassertemperatur der Ozeane südlich etwa 35° südlicher Breite gezeigt.

Diese schlechte Leistung wirft die Frage auf, wie die Modellierer jemals hoffen konnten, jemals die Temperaturen auf dem Festland simulieren zu können.

Die Abbildungen 3, 4 und 5 zeigen, wie schlecht die letzte Generation von Klimamodellen (CMIP5) die Erwärmung (und Abkühlung) der globalen Wassertemperatur während der jüngsten Erwärmungsperiode von 1975 bis 2013 simuliert hat – ein Zeitraum, an den sie „angepasst“ wurden. Die Modelle weisen keine Verbesserungen im Vergleich mit früheren Perioden auf.

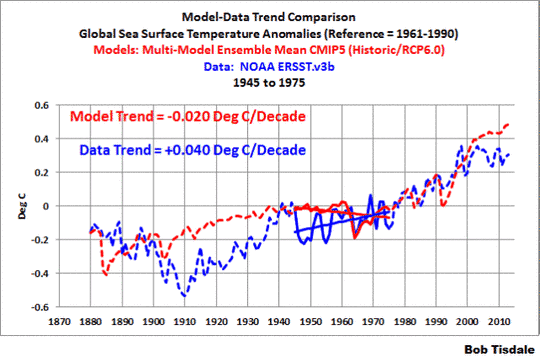

Die Periode mit geringerer Erwärmung Mitte des 20. Jahrhunderts (1945 bis 1975)

Den ERSST.v3b-Daten zufolge (Abbildung 6) haben sich die Wassertemperaturen von 1945 bis 1975 deutlich langsamer erwärmt. (Siehe dazu auch die Diskussion der HADSST3-Daten im Anschluss an Abbildung 8). Die Modelle schätzten, dass die Abkühlung während dieser Zeit im Wesentlichen eine Reaktion auf den Ausbruch des Mount Agung in den Jahren 1963/1964 ist.

Abbildung 6

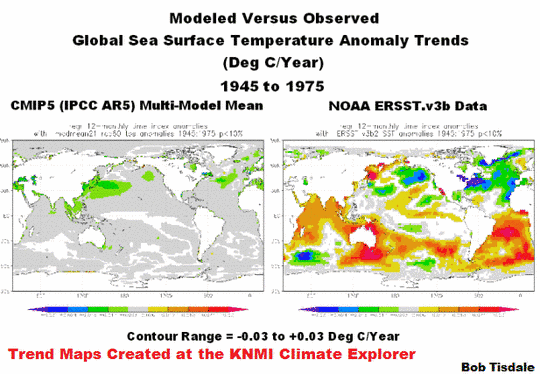

Die Unterschiede treten sogar noch deutlicher hervor, wenn wir die Karten der Erwärmungs- und Abkühlungstrends während dieses Zeitraumes betrachten (Abbildung 7)

Abbildung 7

Während der Periode von 1945 bis 1975 konnten die IPCC-Modelle des AR 5 nicht simulieren:

● die Abkühlung der Wassertemperatur im Nordatlantik in Verbindung mit der AMO und

● die Erwärmung der Wassertemperatur in der gesamten Südhemisphäre.

Deutlicher zeigen dies die Erwärmungs- und Abkühlungsraten, wenn die Daten und die Modellergebnisse auf Basis zonaler Mittel dargestellt werden (Abbildung 8)

Abbildung 8

Bemerkung: Das UKMO überarbeitete ihren Datensatz der Wassertemperatur als Folge der Ergebnisse von Thompson et al 2009 Identifying signatures of natural climate variability in time series of global-mean surface temperature: Methodology and Insights. Siehe auch Kennedy et al. 2013 Part 1 und Part 2.

Zu den größten Änderungen an den HADSST-Daten kam es von den vierziger bis zu den sechziger Jahren. Die angepassten HADSST3-Daten der Wassertemperatur des UKMO zeigen jetzt Abkühlung im Zeitraum 1945 bis 1975 – eine Abkühlung, die auf magische Weise auf einer Linie mit den Modellen liegt (Abbildung 9).

Abbildung 9

Erwärmungsperiode Anfang des 20. Jahrhunderts (1914 bis 1945)

Am offensichtlichsten wird das Scheitern der Modelle bei der Abbildung der Erwärmungsperiode zu Beginn des 20. Jahrhunderts (1914 bis 1945). Diese stach in Abbildung 2 hervor wie ein erhobener Daumen und sieht in Abbildung 10 nicht besser aus. Die Anomalien der globalen Wassertemperatur zeigten eine Rate von 0,125°C pro Dekade, aber die Modelle zeigten eine Rate von lediglich 0,036°C pro Dekade, FALLS sich das Wasser durch anthropogene Treibhausgase einschließlich Kohlendioxid erwärmt hätte. Die beobachtete Erwärmung war etwa 3,5 mal größer als die modellierte Erwärmung. Diese zusätzliche beobachtete Erwärmung muss daher durch die natürliche Variabilität verursacht sein – sie kann nicht erklärt werden durch die vermuteten Einwirkungen einer von den Modellen gezeigten anthropogenen Erwärmung. Und das ist ein gigantisches Problem für die Hypothese einer anthropogen induzierten Erwärmung, das wir weiter unten in diesem Beitrag noch ansprechen werden.

Abbildung 10

Schaut man auf die Trendkarten (Abbildung 11), muss man nicht groß ins Detail gehen, wo die Modelle gescheitert sind. Sie haben die Erwärmung nahezu nirgendwo abbilden können. Wie erbärmlich ist das denn!?

Abbildung 11

Und wie Abbildung 12 zeigt, wird das Scheitern auch durch die Trends der zonalen Mittel gestützt.

Abbildung 12

Die frühe Abkühlungsperiode (1880 bis 1914)

Den im AR 5 verwendeten Modellen zufolge hätte sich die Wassertemperatur von 1880 bis 1914 mit einer Rate von etwa 0,03°C pro Dekade erwärmen sollen (Abbildung 13), aber den ERSST.v3b-Daten der NOAA zufolge hat sich das Wasser mit einer starken Rate von über -0,1°C pro Dekade abgekühlt. Die Modelle haben die Wirklichkeit um etwa 0,13°C pro Dekade verfehlt.

Abbildung 13

Die Trendkarten in Abbildung 14 und die beobachteten Trends auf Basis zonaler Mittelwerte (Abbildung 15) zeigen, wie schlecht die Modelle die Wassertemperatur während dieses Zeitraumes simuliert haben!

Abbildung 14

Abbildung 15

Die Klimamodelle unterstützen die Hypothese einer anthropogen induzierten Erwärmung nicht

Vieles in diesem Beitrag bis hier war Hintergrundinformation.

Man erinnere sich, dass das IPCC seine klimamodellbasierten Hypothesen in Abbildung 1 [oben rechts] präsentiert hat: 1. die globalen Temperaturen haben sich aufgrund akkumulierter CO2-Emissionen von 1850 bis zur Gegenwart erwärmt, und 2. die globalen Temperaturen werden auch in Zukunft steigen aufgrund der Klimamodell-Projektionen.

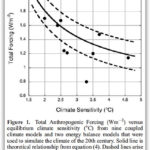

Die virtuellen Wassertemperaturen in den Klimamodellen werden zum Steigen gezwungen hauptsächlich durch die vermuteten Auswirkungen gut durchmischter anthropogener Treibhausgase, wobei Kohlendioxid die dominante Rolle spielt (siehe Abbildung 16). Beispiel: Den von GISS in ihren Klimamodellen zugrunde gelegten Antrieben zufolge [hier] haben die Klima-Antriebe in Verbindung mit gut durchmischten Treibhausgasen mit einer Rate zugenommen, die in der jüngsten Erwärmungsperiode von 1975 bis 2011 3,8 mal höher lag als in der Erwärmungsperiode zuvor von 1914 bis 1945.

Abbildung 16

Die Klimamodellierer haben dann die hypothetische Erwärmung in den Klimamodellen mit anderen fabrizierten Klimatreiber-Datensätzen unterdrückt (siehe Abbildung 17). Verwendet man jedoch noch einmal die Antriebe nach GISS, kann man erkennen, dass die Gesamtantriebe während der späteren Erwärmungsperiode immer noch eine höhere Rate der Zunahme zeigen und dass diese immer noch in der früheren Erwärmungsperiode 3,8 mal höher lag als in der späteren von 1975 bis 2011.

Abbildung 17

Dann sind die Modelle auf der Grundlage all der Unmengen von Vermutungen bei der Programmierung seitens der Modellierer durch ihre programmierten Routinen gelaufen und haben einen Salat von virtuellen Wassertemperaturen hervor gewürgt (Abbildung 18). Durch keinen großen Zufall haben sich die modellierten Wassertemperaturen während der späteren Erwärmungsperiode mit einer Rate erwärmt, die 3,9 mal höher lag als während der früheren Erwärmungsperiode von 1914 bis 1945. (Man beachte, dass es in Abbildung 18 2 weitere Jahre von Modellergebnissen der späteren Erwärmungsperiode gibt als in den Antriebsgraphiken der Abbildungen 16 und 17. GISS hat ihre Antriebe bis 2013 nicht aktualisiert).

Abbildung 18

Quintessenz der Modelle: Den als Input verwendeten Antrieben und den Multi-Modell-Ensembles der jüngsten und größten Generation von Klimamodellen (CMIP%) zufolge hätten sich die Wassertemperaturen während der späteren Periode (1975 bis 2013) fast 4 mal schneller erwärmen sollen als sie es während der ersten Erwärmungsperiode (1914 bis 1945) getan haben.

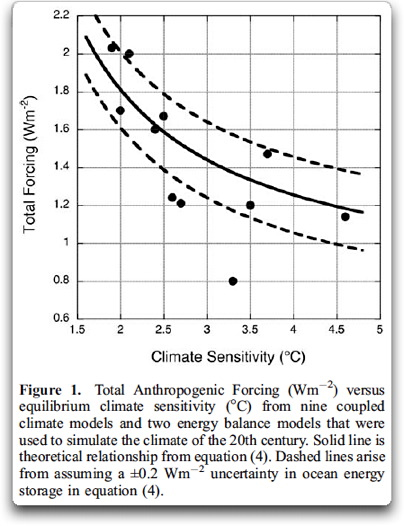

Abbildung 19

Aber zum Unglück für die Modelle zeigt Abbildung 19, dass die tatsächlich beobachtete Erwärmungsrate während der späteren Periode geringer war als während der früheren Periode. Das heißt, die Wassertemperaturen erwärmten sich während der ersten Periode um 25% schneller als während der späteren Periode.

Geschenkt, während der letzten 12 Jahre der späteren Erwärmungsperiode hat sich die globale Wassertemperatur überhaupt nicht erwärmt. Wir könnten die Daten der gegenwärtigen Stillstandsperiode eliminieren (2002 bis 2013 zum Beispiel) und zeigen, dass die Erwärmung während der verkürzten späteren Erwärmungsperiode (1975 bis 2001) vergleichbar war mit dem Trend der früheren Periode. Aber das hilft den Modellen immer noch nicht.

Anmerkung: Das Folgende ist die Zusammenfassung von Kapitel 4.4 aus Climate Models Fail. Obwohl in diesem Kapitel die globalen Temperaturen (Festland + Ozeane) präsentiert worden sind, wird die Schlussfolgerung dieses Kapitels hier beigefügt.

Die Tatsache, dass die Modelle die Erwärmung in der jüngeren Erwärmungsperiode besser simuliert haben, bedeutet nicht, dass die anthropogenen Treibhausgase Ursache dieser Erwärmung waren – es enthüllt einfach, dass es den Modellierern gelungen ist, ihre Modelle noch besser zu frisieren, um sie an die jüngere Erwärmungsperiode anzupassen.

Die Klimamodelle können die beobachtete Erwärmungsrate während der früheren Periode (1914 bis 1945) nicht simulieren, die etwa genauso hoch lag wie in der Periode 1975 bis 2012). Dies zeigt, dass die globalen Temperaturen auch ohne Antriebe steigen können – anders als den Klimamodellen zufolge, die mit natürlichen und anthropogenen Antrieben gefüttert werden müssen. Und die Ähnlichkeiten zwischen den beobachteten Erwärmungsraten damals und jetzt zeigen, dass die viel höheren anthropogenen Antriebe während der späteren Erwärmungsperiode nur einen geringen Einfluss auf die Rate hatten, mit der sich die gemessene Temperatur erwärmt hat.

Mit anderen Worten, die Klimamodelle und die Daten stützen die Hypothese einer anthropogen getriebenen globalen Erwärmung nicht; sie widersprechen dem.

Die Welt, so wie sie in all den die Zahlen vergewaltigenden Klimamodellen porträtiert wird, ist eine Phantasie-Welt – mit nur einem geringen oder gar keinem Bezug zur realen Welt.

Fügen wir dem Schaden noch den Spott hinzu [Original: LET’S ADD INSULT TO INJURY]

Seit mehr als 4 Jahren habe ich gezeigt, dass die Daten bzgl. des ozeanischen Wärmegehaltes und der Daten der Wassertemperatur während der Satelliten-Ära die Hypothese einer anthropogen induzierten Erwärmung nicht stützen, wenn man diese Daten erst einmal in logische Untersequenzen unterteilt hat. Das heißt, die NODC-Daten des ozeanischen Wärmegehaltes in einer Tiefe von 0 bis 700 m und die Reynolds OIv2-Daten der Wassertemperatur zeigen, dass sich die Ozeane als Folge natürlich auftretender, vom Sonnenlicht gespeister Kopplungsprozesse zwischen Ozean und Atmosphäre erwärmen – und nicht durch anthropogene Treibhausgase. Wenn das für Sie neu ist, schauen Sie meinen bebilderten Essay „The Global Warming Challenge” (42MB pdf).

Die natürliche Erwärmung der globalen Ozeane war auch Thema von zwei YouTube-Videos – für diejenigen unter Ihnen, die sehen und hören wollen, wie ich das erkläre. Teil 1 und Teil 2.

Ich habe mein letztes Buch Climate Models Fail einige Male in diesem Beitrag erwähnt. Es ist eine Sammlung von vergleichen zwischen Modellen und Daten einschließlich eines Kapitels über Studien, die sehr kritisch hinsichtlich des Verhaltens der Klimamodelle sind. Außerdem zeige ich die natürliche Erwärmung der Ozeane in Abschnitt 9. Siehe das Inhaltsverzeichnis in einer Vorschau dieses Buches (nicht paywalled). Auf etwa 60 Seiten der 350 Seiten starken PDF-Ausgabe einschließlich 40 Abbildungen wird dieses Thema behandelt. …

Und natürlich gibt es noch viel mehr Einzelheiten in meinem Buch Who Turned on the Heat? — The Unsuspected Global Warming Culprit: El Niño-Southern Oscillation.

Unterschiede zwischen Daten und Modellen

Abbildung 20 zeigt die gemessenen Anomalien der globalen Wassertemperatur von 1880 bis 2013. Abgebildet ist auch die Differenz zwischen den modellierten und den gemessenen Anomalien der globalen Wassertemperatur, wobei die Daten vom Mittel der Modellergebnisse subtrahiert worden sind. Ich habe die Basisjahre der Anomalien auf die gesamte Periode (1880 bis 2012) ausgedehnt, damit die Basisjahre die Differenz nicht beeinflussen.

Abbildung 20

Aus irgendwelchen Gründen will die Gemeinschaft der Klimawissenschaftler unter Federführung des IPCC die Öffentlichkeit und die Politiker glauben machen, dass seine Klimamodelle realistische Repräsentationen des Klimas sind.

Zum Schluss

Die globale Wassertemperatur hat sich während der Erwärmung zu Beginn des 20. Jahrhunderts von 1914 bis 1945 schneller erwärmt als während der jüngsten Erwärmungsperiode von 1975 bis 2013. Andererseits haben die im AR 5 des IPCC verwendeten Klimamodelle etwas gänzlich anderes gezeigt. Den Modellen zufolge hätte sich das Wasser während der jüngsten Periode von 1975 bis heute etwa 4 mal schneller erwärmen sollen als im Zeitraum 1914 bis 1945. Das zeigt eindeutig, dass die vom IPCC benutzten Klimamodelle nicht herangezogen werden können, um die globale Erwärmung menschlichen Treibhausgasen wie Kohlendioxid zuzuordnen, und sie können definitiv nicht dazu verwendet werden, das Klima für irgendeinen Zeitraum auf der Basis zukünftiger anthropogener Treibhausgasemissionen vorherzusagen.

Und doch erzeugen die Klimawissenschaftler, die den AR 5 für das IPCC vorbereitet haben, Bilder wie ihr SPM 10 (meine Abbildung 1 oben rechts), die amüsanterweise Klimamodelle als „Beweis“ anführen, dass die vergangene globale Erwärmung durch Kohlendioxid-Emissionen ausgelöst worden war und dass die globalen Temperaturen weiter steigen werden als Folge zukünftiger CO2-Emissionen. Der unerschütterliche Glaube der Klimawissenschaftler [und einiger Kommentatoren hier, A. d. Übers.], dass das Kohlendioxid die globale Erwärmung treibt, obwohl die Klimamodelle etwas anderes zeigen, ist Beweis für ihre Besessenheit bzgl. CO2 oder der Notwendigkeit, ihre Modelle falsch zu interpretieren (aus irgendwelchen Gründen). Ich persönlich glaube, dass es eine Kombination aus beidem ist.

Quelle

Die Modellergebnisse und die Daten einschließlich der Trendkarten sind verfügbar über KNMI Climate Explorer.

Link: http://wattsupwiththat.com/2013/10/07/ipcc-still-delusional-about-carbon-dioxide/

Übersetzt von Chris Frey EIKE