Energiewende: „Letztlich machen wir der Welt vor, wie man Ressourcen verschwendet“

NovoArgumente: Hauptargument für die Energiewende ist der Klimaschutz. Welche Auswirkungen hat die deutsche Energiewende auf das Klima?

Joachim Weimann: Der Anteil Deutschlands an der weltweiten Emission von CO2 beträgt weniger als 2 Prozent. Das bedeutet, dass selbst dann, wenn wir unsere Emissionen auf Null herunterfahren, kein messbarer Einfluss auf das Klima zu erwarten ist. Deshalb gilt, dass eine Lösung des Klimaproblems, bzw. die Einhaltung des 2-Grad-Ziels, auf das sich die Staatengemeinschaft verständigt hat, nur gelingen kann, wenn sich eine große Koalition von Ländern findet, die gemeinsam in den Klimaschutz investieren. Die eigentlich spannende Frage ist deshalb, ob die deutsche Energiewende dazu beiträgt, eine solche Koalition zusammen zu bekommen. Ich glaube es nicht, denn die Energiewende wird sehr teuer und wird Deutschland stark belasten. Für eine internationale Lösung bräuchten wir aber Mittel, die wir den Ländern anbieten müssten, die weder eine moralische Verpflichtung zum Klimaschutz haben, noch ein nationales Interesse daran. Ohne Kompensationen durch die Industrieländer wird man die Schwellen- und Entwicklungsländer nicht ins Boot bekommen. Ob uns die Energiewende dafür noch Raum lässt, kann man stark bezweifeln.

Hat Deutschland eine Vorreiterrolle? Ist es wahrscheinlich oder wünschenswert, dass andere unserem Beispiel folgen?

Deutschland versucht mit der Energiewende eine Vorreiterrolle einzunehmen. Angesichts des globalen Charakters des Klimaproblems kann man so ein Vorhaben auch nur rechtfertigen, wenn man damit die Hoffnung verbindet, dass andere nachziehen werden. Wenn nur Deutschland Klimapolitik betreibt, werden alle Aufwendungen sowieso umsonst sein. Aber es stellt sich die Frage, ob wir ein gutes Beispiel geben. Das kann man zu Recht bezweifeln, denn Klimaschutz ließe sich mit anderen Instrumenten um ein Vielfaches besser gestalten, als wir es mit unserem EEG tun. Ein konsequenter Ausbau des Emissionshandels und der Verzicht auf die Subvention staatlich festgelegter Techniken würden die gleichen CO2-Vermeidungen zu erheblich geringeren Kosten ermöglichen. Letztlich machen wir der Welt vor, wie man erhebliche Mengen an Ressourcen verschwendet. Wir sollten nicht hoffen, dass uns das allzu viele nachmachen. Aber selbst wenn wir effiziente Klimapolitik machen würden, wäre keineswegs sicher, dass uns andere nachfolgen. Sowohl die empirische als auch die theoretische Forschung zu der Frage, ob „Leadership“ erfolgreich sein kann, kommen zu dem Ergebnis, dass damit wohl nicht zu rechnen ist. Die Erfahrungen, die wir auf den jährlichen Klimakonferenzen bisher gesammelt haben, scheinen das ja auch zu bestätigen. Obwohl wir uns seit Jahren als klimapolitischer Musterknabe herausputzen, ist der Einfluss Deutschlands auf den Klimakonferenzen vernachlässigbar gering.

Selbst unter den Bundesländern scheint es einen Wettstreit der Vorbildlichkeit zu geben. Der Landtag von NRW hat im Januar 2013 das erste deutsche Klimaschutzgesetz mit verbindlichen Zielen verabschiedet, NRW will damit „Vorreiter des Klimaschutzes in Deutschland“ werden, Brandenburg schmückt sich mit dem Leitstern, dem „Bundesländerpreis für Erneuerbare Energien“. Horst Seehofer will Bayern zum „Vorzeigeland für das postfossile Zeitalter“ machen. Was treibt die Politiker an? Der Kampf um moralisches Musterknabentum? Oder um Subventionen? Oder glauben sie wirklich, zu Prosperität oder zur Rettung der Welt beizutragen?

Solche Dinge gewinnen eine manchmal sehr merkwürdige Eigendynamik. Wenn der Anteil derer, die etwas stark befürworten, eine bestimmte Schwelle überschritten hat, dann fällt es Politikern – und übrigens auch Journalisten – sehr schwer, der Versuchung zu widerstehen, auf den fahrenden Zug zu springen und sich dafür feiern zu lassen, dass man ihn dabei auch noch ein bisschen anschiebt. Das funktioniert sowohl bei allgemeiner Zustimmung (alle wollen die Energiewende) als auch bei allgemeiner Ablehnung (niemand will die Atomenergie). Sie finden heute keinen Politiker und fast keinen Journalisten, der sich traut, gegen die Energiewende und für die Nutzung der Kernkraft einzutreten. Was nicht bedeutet, dass es niemanden gibt, der genau das für vernünftig hält. Warum auch, schließlich ist es genau das, was die meisten anderen Länder tun.

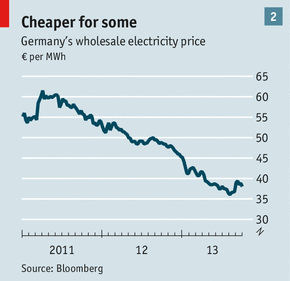

Wie lassen sich die Kosten für die Energiewende abschätzen? Inwieweit sind die Erneuerbaren für den Strompreisanstieg der letzten Jahre verantwortlich?

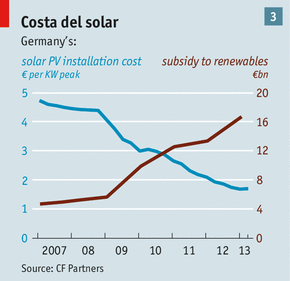

Eine halbwegs verlässliche Abschätzung der Kosten der Energiewende ist zum gegenwärtigen Zeitpunkt nicht möglich. Dazu sind die Unsicherheiten zu groß. Alle bisher vorliegenden Schätzungen gehen von mehr oder weniger unrealistischen und sehr optimistischen Prämissen aus. Dennoch zeichnet sich bereits ab, dass es sehr teuer werden könnte. Wir müssen uns klarmachen, dass wir einen Totalumbau unseres Energiesystems brauchen, um die Stromversorgung zu 80 Prozent aus Erneuerbaren zu sichern. Wind und Sonne richten sich nicht nach der Stromnachfrage und die Speicherung großer Energiemengen zu halbwegs vertretbaren Kosten ist noch in weiter Ferne. Wir müssen deshalb mit sehr großem Aufwand dafür sorgen, dass es möglich wird, bei stark fluktuierender Einspeisung die Netzspannung konstant zu halten und die Leistung der Nachfrage anzupassen. Das wird sehr schwierig und sehr teuer. Die Tatsache, dass wir inzwischen die zweithöchsten Strompreise in Europa haben, ist zu einem erheblichen Teil darauf zurückzuführen, dass wir den Erneuerbaren so viel Raum geben. Es ist nicht davon auszugehen, dass es in Zukunft billiger wird. Beispielsweise zeigt sich immer deutlicher, dass Offshore-Anlagen viel teurer sein werden als bisher gedacht. Ohne Offshore ist aber gar nicht daran zu denken, dass das Ausbauziel der Erneuerbaren erreicht werden könnte.

Wie sieht es bei den Arbeitsplätzen aus? Kann sich die Energiewende wirklich zur Jobmaschine entwickeln?

Bemerkenswerterweise werden von den Verfechtern der Energiewende einfach die Arbeitsplätze gezählt, die im Bereich der Erneuerbaren entstanden sind. So kommt man auf erhebliche Zahlen und damit begründet man die Überlegung, dass es sinnvoll sei, diesen Sektor zu stärken. Leider macht man dabei einen folgenschweren Fehler. Man vergisst nämlich, die Arbeitsplatzverluste abzuziehen, die an anderer Stelle durch die Investitionen in Erneuerbare entstehen. Durch den staatlichen Eingriff werden Investitionen in Bereiche gelenkt, in denen sonst keine stattfänden. Diese Investitionen fehlen dann aber an anderer Stelle. Dazu kommt, dass wir für die Vermeidung von CO2 viel zu viel bezahlen. Eine Tonne CO2-Vermeidung durch Photovoltaik kostet etwa 500 Euro. Im konventionellen Kraftwerkebereich liegen die Kosten bei einem Hundertstel dieses Wertes. Die 495 Euro, die wir zu viel zahlen, fehlen an anderer Stelle als Nachfrage. Auch das hat Arbeitsplatzeffekte. Dazu kommt, dass die höheren Strompreise natürlich ebenfalls negative Effekte haben. Zieht man alle diese „Kosten“ von den Bruttoarbeitsplatzzahlen ab, erhält man den Nettoeffekt, und ob der noch positiv ist, kann man sehr stark bezweifeln. Ein weiterer Punkt kommt hinzu. Im Sektor der Erneuerbaren braucht man vor allem hoch qualifizierte Arbeitskräfte aus dem technischen Bereich. Also genau die Arbeitskräfte, die in der restlichen Industrie schon heute Mangelware sind und in Zukunft erst recht eine solche sein werden. Durch die hohen Subventionen wird der Arbeitsmarkt in einer sehr schädlichen Weise verzerrt. Hoch qualifizierte Arbeit wird nicht dorthin gelenkt, wo sie die höchste Produktivität entfaltet, sondern dorthin, wo es die meisten Subventionen gibt. Vergisst man, alle diese negativen Auswirkungen in Rechnung zu stellen und zählt nur die Bruttoarbeitsplätze und die Bruttoinvestitionen, dann ist das ungefähr so, als verwechsele ein Kaufmann Umsatz mit Gewinn. Es ist schon interessant, dass Roland Berger in seiner „Green Economy Studie“, die er für das Bundesumweltministerium angefertigt hat, genau das tut. Genauso interessant ist, dass das Ministerium eine solche Studie an einen Unternehmensberater vergibt und nicht etwa an ein unabhängiges wirtschaftswissenschaftliches Forschungsinstitut, von denen es genug in Deutschland gibt.

Ein deutsches Spezifikum der Energiewende ist ja, dass gleichzeitig auf fossile Energieträger und auf CO2-freie Atomkraft verzichtet werden soll. Welche Bedeutung hat das komplette Ausblenden der Kernenergie?

Es macht alles deutlich komplizierter und teurer. Atomkraftwerke laufen in der Grundlast. Die Erneuerbaren sind bisher nicht grundlastfähig. Allein daraus ergibt sich bereits ein Problem, denn Braunkohle, die ansonsten in der Grundlast verwendet wird, kommt ja als Ersatz nicht in Frage. Man sollte sich übrigens nicht davon blenden lassen, dass es immer wieder Jubelmeldungen gibt, dass an bestimmten, windreichen Sonnentagen die Erneuerbaren bereits soundso viele Atomkraftwerke ersetzt haben. Es geht nicht darum, diese Kraftwerke an bestimmten Tagen zu ersetzen, sondern an 365 Tagen zu jeweils 24 Stunden! Dafür braucht man ein Vielfaches der bisher vorhandenen Kapazitäten an erneuerbarer Energie und die muss auch noch so verteilt sein, dass sie immer die Atomkraftwerke ersetzen kann, ganz gleich wie stark und wo der Wind bläst!

Allerdings muss man zwei Dinge feststellen. Erstens: Solange bis zu 80 Prozent der Bevölkerung die Atomtechnik ablehnen, muss die Politik sich diesem Willen beugen und aussteigen. Zweitens, der Ausstieg aus der Atomenergie bedeutet nicht, dass man eine Energiewende fahren muss, wie sie die Bundesregierung ausgerufen hat. Das ginge auch deutlich einfacher und ohne die enormen Risiken, die uns aus Gründen der politischen Opportunität auferlegt werden.

Mit welchen negativen Auswirkungen der Energiewende müssen wir rechnen?

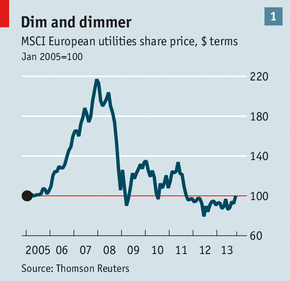

Eine offensichtliche Folge wird sein, dass Energie immer teurer werden wird. Man kann nicht auf der einen Seite das Ziel verfolgen, den Stromverbrauch um 20 Prozent zu senken und auf der anderen Seite den Strompreis konstant halten. Dazu kommt, dass der Umbau des Energiesystems per se sehr teuer werden wird. Es ist auch zu befürchten, dass die Versorgungssicherheit, die wir bisher als selbstverständlich hingenommen haben, in Gefahr gerät. Es kann sein, dass es zu Blackouts wegen Überlastung oder wegen mangelnder Kapazitäten bei Spitzenlast kommt. Schließlich kann es passieren, dass unsere Wettbewerbsposition leidet. Schon jetzt zeichnet sich ab, dass die USA einen erheblichen Standortvorteil aus der Gas- und Ölschwemme haben, die sich dort entwickelt. Jedenfalls machen sich schon heute viele energieintensive Unternehmen auf den Weg in die USA. Wir werden den Nachteil hoher Energiekosten nicht durch Export von Energietechnik kompensieren können, denn wie das Beispiel der Solarbrache zeigt, können reife Technologien (und bei Wind und Sonnenkraftwerken handelt es sich teilweise schon jetzt darum) in anderen Teilen der Erde kostengünstiger hergestellt werden als bei uns. Wir fahren unsere Exporterfolge durch Innovationen ein, aber die fördern wir mit dem EEG ja nicht, denn das EEG subventioniert nur den Einbau vorhandener Technik. Insgesamt steht einem ökologischen Scheingewinn des EEGs damit ein erheblicher ökonomischer Schaden gegenüber.

Angenommen, es herrschte Einigkeit, dass CO2-Vermeidung wichtig und richtig ist. Wie könnte dann eine sinnvolle Strategie zur Senkung von globalen CO2-Emissionen aussehen?

Inzwischen glaubt kaum noch jemand daran, dass die großen Klimakonferenzen, die wir jährlich veranstalten, jemals einen Erfolg bringen könnten. Das war auch nie zu erwarten. Die Zahl der Verhandlungsteilnehmer ist zu groß und die Interessen zu heterogen, als dass man eine große Lösung erwarten könnte. Der einzige Weg, der nach meinem Eindruck Aussicht auf Erfolg verspräche, besteht darin, ausgehend von dem europäischen Emissionshandel sukzessive zu versuchen, die Anzahl der am Handel teilnehmenden Länder zu vergrößern. Also statt eines Top-down-Ansatzes einen Bottom-up-Ansatz, bei dem Verhandlungen mit einzelnen Ländern geführt werden, mit denen die Bedingungen einer Beteiligung am Handel auszuhandeln sind. Das würde nur gehen, wenn die reichen Länder dazu bereit wären, die armen Länder zu kompensieren. Beispielsweise könnte dies über die Zuweisung von Emissionsrechten geschehen, die die Industrieländer den Entwicklungsländern abkaufen müssten, wenn sie ihre Emissionen decken wollen. Mit anderen Worten, wir müssten dazu bereit sein, andere Länder für ihre Vermeidungsanstrengungen zu bezahlen. Ein erster Schritt könnte eine Fusion des EU-Handels mit den Handelssystemen in Australien und Kalifornien sein. Wie auch immer: Unter den Ökonomen gibt es einen sehr weitgehenden Konsens darüber, dass nur ein globales Emissionshandelssystem eine vernünftige Lösung des Problems wäre.

Sie haben Ihre Einschätzung im letzten Jahr im Auftrag der Enquete-Kommission „Wachstum, Wohlstand, Lebensqualität – Wege zu nachhaltigem Wirtschaften und gesellschaftlichem Fortschritt in der Sozialen Marktwirtschaft“ zusammengefasst. Haben Sie den Eindruck, dass die Argumente zu einem Umdenken führen?

Um ehrlich zu sein, habe ich den Eindruck, dass die meisten Mitglieder der Unterkommission, in der ich meine Expertise vortragen durfte, diese überhaupt nicht zur Kenntnis genommen haben. Jedenfalls hinterließ die Diskussion, die nach meiner Präsentation geführt wurde, diesen Eindruck. Die mündliche Vorstellung der Expertise fand übrigens unter sehr merkwürdigen Bedingungen statt. Der Vortrag wurde kurzfristig in einen viel zu kleinen Raum verlegt und es gab eine strikte Redezeitbegrenzung, die es unmöglich machte, auch nur die wichtigsten Argumente so vorzustellen, dass sie jemand nachvollziehen konnte, der die Expertise nicht gelesen hatte. Einige Tage nach der Präsentation in Berlin haben sich einzelne Abgeordnete bei mir gemeldet und sich für die Art und Weise, wie mit mir umgegangen wurde, entschuldigt. Das wäre nicht nötig gewesen, aber es war einfach schon sehr klar, dass meine Argumente der Mehrheit der Kommissionsmitglieder nicht willkommen waren und deshalb (erfolgreich) der Versuch unternommen wurde, sie gar nicht erst zur Kenntnis zu bringen. Das sagt viel über das Demokratieverständnis unserer Parlamentarier.

Prof. Joachim Weimann lehrt und forscht an der Fakultät für Wirtschaftswissenschaft der Otto-von-Guericke-Universität in Magdeburg. Zuletzt erschien von ihm gemeinsam mit Andreas Knabe und Ronnie Schöb Geld macht doch glücklich: Wo die ökonomische Glücksforschung irrt (Schäffer-Poeschel 2012, S. 214, EUR 29,95).

Verwandte Artikel

Fred F. Mueller: Energiewende: Durchwursteln bis zum Crash

Gerd Ganteför: Energiewende: Zu langsam und zu teuer

Heinz Horeis: Energiewende: Im Spargang an die Wand

Mit Dank übernommen von NOVO Argumente