Kann das IPCC revolutionäre Wissenschaft durchführen?

Die SPM-Ausgabe, die den Regierungen am 2. August übermittelt worden ist, kondensiert auf 22 Seiten den Inhalt der 14 Kapitel im AR 5, in denen wissenschaftliche Studien zusammengefasst werden, die zwischen 2006 und dem 15. März 2013 veröffentlicht worden sind.

Diese SPM ist (oder könnte es sein) ein Dokument von welterschütternder Wichtigkeit. Wie Bloomberg sagt: „Sie ist dazu gedacht, von Ministern herangezogen zu werden, die bis 2015 einen globalen Vertrag zum Kampf gegen den Klimawandel aushandeln sollen“.

Der Zeitrahmen für den globalen Vertrag wurde auf der Doha-COP verschoben, weil Entwicklungsländer (vor allem China und Indien) den Eindruck hatten, dass die SPM 2013 eine unverzichtbare Grundlage der Verhandlungen sein sollte. Regierungen brauchen eine autoritative, aktualisierte Zustandsbeschreibung sowohl des Ausmaßes als auch der Gründe der Bedrohung durch den Klimawandel, und zwar jetzt und in Zukunft.

Aber die SPM wurde eingerahmt von momentanen Klimaänderungs-Ereignissen, die nach Redaktionsschluss im März aufgetreten waren – und selbst noch, nachdem die Fassung in Umlauf gebracht worden war.

Klimasensitivität

Das Thema Ausmaß der Erwärmung” konzentriert sich immer mehr auf die Frage, wie sensitiv der Planet auf die zunehmende CO2-Konzentration reagiert. Die Gleichgewichts-Klimasensitivität [equilibrium climate sensitivity (ECS)] wurde im Jahre 1979 von Charney grob geschätzt mit 3,0 ±1,5 angegeben, und diese Bandbreite wurde mehr oder weniger in allen vier IPCC-Zustandsberichten zuvor beibehalten.

Während des Jahres 2012 haben viele Forschergruppen darauf hingewiesen, dass neueste Daten und moderne Diagnose-Methoden jetzt gezeigt haben dass die 30 Jahre alte Schätzung von 3°C erheblich übertrieben war. Begutachtete Studien waren unter anderen:

● Ring et al.: Schätzungen der Klimasensitivität liegen zwischen 1,5°C und 2°C.

● Van Hateren: Die Sensitivität im Maßstab eines Jahrtausends beträgt 2,0°C ±0,3°C

● Aldrin et al.: Das 90%-Intervall liegt zwischen 1,2°C und 3,5°C mit einem Mittelwert bei 2,0°C.

Dies führte natürlich zu großen Meinungsverschiedenheiten und wurde zur wesentlichen Herausforderung, der sich die Leitautoren der WG1 gegenüber sahen. Obwohl wir noch nicht wissen, wie sie am Ende reagiert haben, zeigt eine durchgesickerte Kopie der SPM-Ausgabe, dass sie im Wesentlichen der langzeitlichen Orthodoxie verhaftet blieben.

Im Januar 2013 berichteten britische Medien, dass das UK Met. Office UKMO eine 20-jährige Pause der globalen Erwärmung bis zum Jahr 2017 projiziert hatte. Dieser ‚Stillstand’ war von den Klimamodellen nicht simuliert worden. Im Februar musste der IPCC-Vorsitzende Pachauri einräumen, dass der Temperaturverlauf schon seit 17 Jahren flach verlaufen war. Ihm zufolge wäre ein Stillstand von 30 Jahren erforderlich, um den bisherigen Konsens zu verwerfen.

Sowohl das Thema „Grund” als auch „Ausmaß” hängen stark von der Validität der Klima-Simulationen durch das derzeitige Coupled Model Intercomparison Project (CMIP5) ab, wie auch alle anderen IPCC-Projektionen der zukünftigen planetaren Temperaturen und deren Auswirkungen. Seriöse wissenschaftliche Zweifel sowohl an den mit ECS zusammen hängenden Inputs als auch an der Genauigkeit der Temperaturberechnungen wären fatal für die Glaubwürdigkeit des AR5.

Nach Redaktionsschluss für WG1-Studien haben nachfolgende Studien aus diesem Jahr 2013 starke Bedenken hinsichtlich der übertriebenen Klimasensitivität wiederbelebt:

● Otto et al.: Die beste Schätzung der Sensitivität liegt um 30% unter dem CMIP5-Multimodell-Mittelwert.

● Forster et al.: Die Analyse von CMIP5 zeigt, dass 2/3 über der ‚Wahrscheinlichkeits’-Bandbreite von Otto liegen.

● Masters: Mittlere Schätzung von ECS beträgt 1,98°C.

● Lewis: verbesserte Methoden zeigen einen Wert um 1,6 K [show the mode and median to be 1.6K].

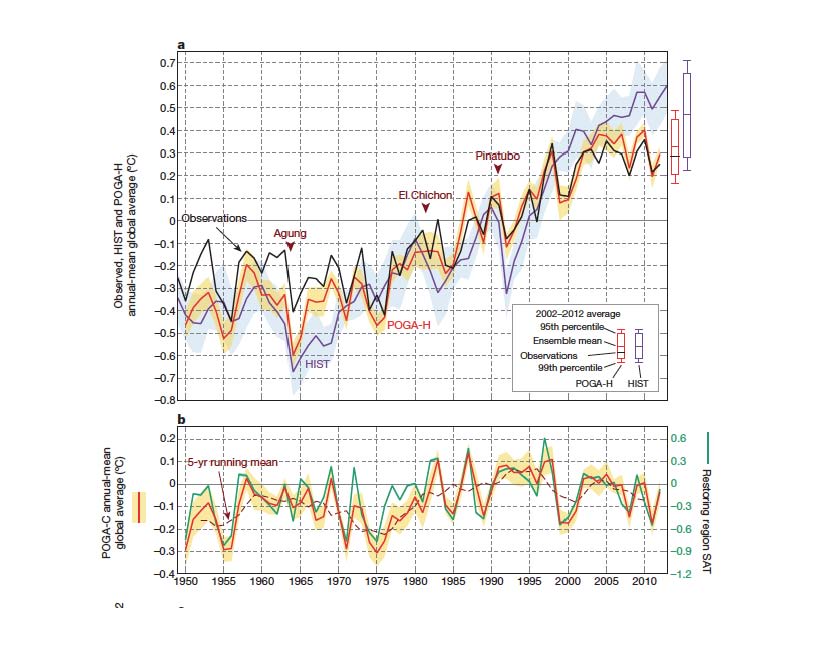

In einer Anhörung vor dem Kongress zitierte Judith Curry die Hawkins-Graphik, die beobachtete Trends unter 90% der CMIP5-Projektionen zeigt, und weist darauf hin, dass die Erwärmung bis zur Mitte des Jahrhunderts nicht wieder einsetzen könnte. James Hansen ordnet den ‚Stillstand’ einer Kombination natürlicher Variabilität und niedrigerer Sensitivität zu, sagt aber vorher, dass „die Temperatur während der nächsten paar Jahre mit der nächsten El Nino-Phase wieder signifikant steigen werde“.

Temperatur-Stillstand

Der Temperatur-Stillstand war seit vielen Jahren aus den Daten offensichtlich, aber der Standesdünkel der Klimawissenschaft hielt es nicht für nötig, dies zu erwähnen – bis zur öffentlichen Enthüllung Anfang 2013. Einmal ausgesprochen bedurfte es einer Erklärung – und dann wurde klar, dass es einen großen Mangel an Forschungen hierzu gab. Bis die Forscher in der Lage waren, diese Lücke zu füllen, war die SPM-Ausgabe bereits verteilt worden.

Im August 2013 erschien eine ganze Flut sehr einflussreicher Studien:

● von Storch & Zorita [1] fanden, dass die beobachteten Temperaturen von 1998 bis 2012 nicht konsistent waren mit 23 getesteten CMIP3 und CMIP5-Modellen, selbst auf dem 2%-Vertrauensniveau. Die Inkonsistenz nahm rapide zu mit der Trendlänge, und ein 20-Jahres-Trend (d. h. bis zum Jahr 2017) würde außerhalb des Ensembles aller vom Modell simulierten Trends liegen.

● von Storch & Zorita (die gleiche Studie) folgern, dass die ‚natürliche’ Variabilität und/oder externe Antriebe möglicherweise die anthropogene Erwärmung während des Stillstands unterbrochen haben. Eine überschätzte Sensitivität kann ebenfalls einen Beitrag dazu geleistet haben.

● Tung & Zhou [2] berichteten, dass „die zugrunde liegende anthropogene Gesamt-Erwärmungsrate seit 1910 konstant 0,07 bis 0,08°C pro Jahrzehnt betragen habe, mit überlagerten, mit der AMO zusammen hängenden Auf- und Abwärtsbewegungen…“. Die stark gestiegenen CO2-Konzentrationen der letzten Jahrzehnte haben nicht dazu geführt, dass sich die Erwärmung nicht wie von den Modellen vorhergesagt beschleunigt hat.

● Yu Kosaka & Shang-Ping Zie [3] konnten plausibel zeigen, dass die Klimamodelle die natürliche Variation erheblich unterschätzt haben. La Nina-Kaltphasen im Ostpazifik während des 21. Jahrhunderts (seit die PDO negativ geworden ist) haben die projizierte Treibhaus Erwärmung bezwungen. Der Erwärmungstrend von 0,68°C während der Jahre von 1975 bis 1998 (als die PDO positiv war), würde sich aus 0,4°C aus natürlichen und lediglich 0,28°C aus anthropogenen Gründen zusammensetzen [4].

● Katz et al. [5] sagen, dass die vom IPVV verwendeten kritischen Unsicherheits-Messungen „deutlich über ein Jahrzehnt überholt“ sind. Moderne statistische Verfahren könnten die Zustandsbeschreibungen „dramatisch“ verbessern.

● Fyfe, Gillet & Zwiers [6] konzentrierten sich auf die außerordentliche Lücke zwischen den Temperatursimulationen von 37 CMIP5-Modellen und den beobachteten Daten. Infolge einer ‚Kombination von Fehlern’ haben die Modelle die Erwärmung während der vergangenen 20 Jahre zu 100% und während der letzten 15 Jahre um 400% überschätzt.

Die Revolution kommt…

Diese neuen Studien zerschlagen die IPCC-Orthodoxie, dass die gegenwärtigen und zukünftigen globalen Temperaturen hauptsächlich durch Treibhausgas-Emissionen getrieben und später in diesem Jahrhundert ein gefährliches Niveau erreichen werden. Andererseits sind alle älteren Studien völlig überrumpelt worden durch ihr offensichtliches Scheitern, die gegenwärtigen Daten (den Stillstand) einzubeziehen.

Im IPCC-Bericht aus dem Jahr 2001 wurde besänftigt [7]: Bei der Klimaforschung und –modellierung haben wir es mit einem gekoppelten, nicht linearen, chaotischen System zu tun, weshalb eine langzeitliche Vorhersage des künftigen Klimas nicht möglich ist. Was wir noch am ehesten ereichten können, ist die Vorhersage der Wahrscheinlichkeits-Verteilung möglicher zukünftiger Zustände des Systems durch die Erzeugung von Ensembles von Modell-Lösungen. Dies reduziert die Klimaänderung auf das Beurteilungsvermögen signifikanter Unterschiede in den Statistiken solcher Ensembles.

Die Hypothese der „gefährlichen anthropogenen globalen Erwärmung” DAGW basiert auf einem eindeutigen Unterschied zwischen den CMIP5-Modellläufen mit natürlichen plus anthropogenen Antrieben im Vergleich zu natürlichen Antrieben allein. Dieser Unterschied verschwindet, wenn die Ensembles so adjustiert werden, dass sie gegenwärtige empirische Daten reflektieren. Es ist ziemlich wahrscheinlich, dass die natürliche Variabilität (einschließlich natürlicher Antriebe) die anthropogenen Effekte immer marginalisiert hat und dass dies auch in der gesamten Zukunft so ist.

In seinem Aufsatz aus dem Jahr 1962 mit dem Titel The Structure of Scientific Revolutions hat Thomas Kuhn überzeugend dargelegt, dass sich Wissenschaft nicht durch die lineare Akkumulation von Wissen auszeichnet, sondern periodische Umwälzungen oder ‚Paradigma-Änderungen’ durchläuft.

Nach Kuhns Ansicht wird es während langer Perioden normaler Wissenschaft keine Beweise geben, die inkompatibel mit dem gerade herrschenden Paradigma sind. Wenn sich jedoch Anomalien häufen, erreicht die Wissenschaft vielleicht eine Krise, die die notwendige Akzeptanz eines neuen Paradigmas befeuert, in dessen Rahmen sowohl die alten als auch die neuen Ergebnisse eingepasst werden. Kuhn nennt das den umgestaltenden Punkt; revolutionäre Wissenschaft.

Das Jahr 2013 führt in eine seit langem verspätete Revolution der Klimawissenschaft. Ein neues Paradigma wird gefordert, das anerkennt, dass AGW nichts weiter ist als eine nicht-deterministische Komponente in einem ‚nicht linearen, chaotischen System’.

Umgang mit der Paradigma-Änderung

All dies hinterlässt das IPCC in einer schlimmen Fessel hinsichtlich seines Treffens im September. Sollte es:

● eine SPM einstampfen, die von den Ereignissen überrollt worden ist?

● einen wesentlichen Vorbehalt hinsichtlich des Status’ im März 2013 hinzufügen und einen Anhang in Aussicht stellen, in dem nach Redaktionsschluss erschienene Studien behandelt werden, oder

● sollte es das Treffen verschieben, um ein Crash-Programm abzufassen, mit dem sowohl der Technical Report der WG1 als auch die daraus resultierende SPM umgeschrieben werden kann?

‚Business as usual’ ist die schlechteste Option. Angesichts der harten internationalen Verhandlungen, die auf diesem Dokument aufbauen, ist es viel besser, das Erscheinen dieses Dokuments zu verschieben, als dass es falsch im Umlauf ist – oder unhaltbar. Keine Regierung kann weit reichende politische Entscheidungen treffen, die auf einem Bericht basieren, von dem man weithin glaubt, dass er schon vor seinem Erscheinen obsolet ist.

Ein Zwischenbericht würde ein ähnliches Glaubwürdigkeits-Defizit aufweisen. Schon jetzt [8] haben die Umweltministerien in den USA und Europa formell mehr Klarheit über den „Erwärmungs-Stillstand“ angefordert und das IPCC aufgefordert, die gesamte Information in die SPM zu stecken.

„Die jüngste Verlangsamung des Temperaturtrends ist gegenwärtig ein Schlüsselthema, und doch ist es nicht in geeigneter Weise in der SPM angesprochen worden”, sagte die EU.

Obwohl es in der Ausgabe heißt, dass der Trend nachgelassen hat, sind die Implikationen unklar – was die USA zu dem Kommentar veranlasst hat: „es steht eine Reihe von Zahlen im Raum ohne konkrete Schlussfolgerung“.

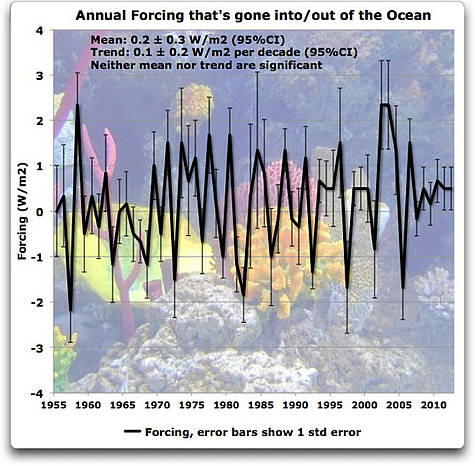

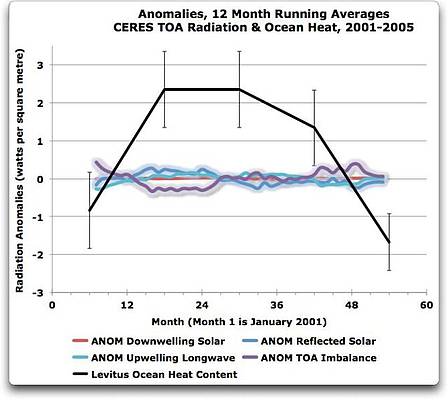

Viele Staaten, einschließlich China, trachten nach Informationen über die Wärmeaufnahme in den Ozeanen oder andere natürliche Veränderungen, die die Daten zur Klimaänderung unterdrückt haben.

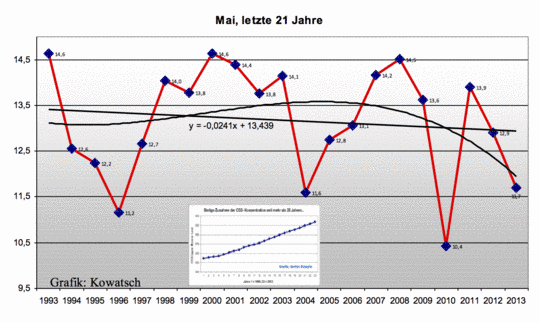

In der SPM-Ausgabe fehlt offensichtlich jeder Hinweis darauf [9], dass die 30-Jahres-Erwärmungstrends in jedem Jahr abgenommen haben seit dem Spitzenwert im Jahr 2003. Oder darauf, dass die jüngste 10-Jahres-Periode (2003 bis 2012) die kälteste Dekade seit Beginn von Satellitenaufzeichnungen im Jahr 1979 ist [10].

WG1 ist schon lange dafür bekannt, unbequeme Forschungsergebnisse zu ignorieren mit der Begründung, dass die Ergebnisse ‚isoliert’ sind oder in obskuren Journalen veröffentlicht worden sind.. Das kann kaum für die Studien im August gelten. Alle mit einer Ausnahme waren von Nature Climate Change akzeptiert worden. Viele der Autoren haben aktiv Beiträge zu den IPCC-Berichten geliefert, wobei Zwiers derzeit ein Vize-Vorsitzender der WG1 ist und Fyfe ein Herausgeber von Begutachtungen.

Revolutionäre Klimawissenschaft ist im Gange. Die Frage ist jetzt, ob das IPCC dieser Herausforderung gewachsen ist.

[1] http://www.academia.edu/4210419/Can_climate_models_explain_the_recent_stagnation_in_global_warming

[2] http://www.pnas.org/content/early/2013/01/22/1212471110.short

[3] http://www.nature.com/nature/journal/vaop/ncurrent/full/nature12534.html

[4] See http://judithcurry.com/2013/08/28/pause-tied-to-equatorial-pacific-surface-cooling

[5] http://www.nature.com/nclimate/journal/v3/n9/full/nclimate1980.html?WT.ec_id=NCLIMATE-201309

[6] http://www.nature.com/nclimate/journal/v3/n9/full/nclimate1972.html?WT.ec_id=NCLIMATE-201309

[7] 14.2.2.2 WG1 TAR IPCC

[8] http://www.bloomberg.com/news/2013-08-29/global-warming-slowdown-data-sought-in-un-climate-report.html

[9] http://www.quadrant.org.au/blogs/doomed-planet/2013/08/if-warmists-would-only-tell-the-truth

[10] http://www.skepticalscience.com/trend.php

Link: http://wattsupwiththat.com/2013/08/31/can-the-ipcc-do-revolutionary-science/

Übersetzt von Chris Frey EIKE