Diesem bis heute unbewiesenen Modell eines anthropogen verursachten Klimawandels widersprachen, wie Klimarealisten in aller Welt, auch die Mitglieder von EIKE. Sie konfrontierten das Umweltbundesamt wiederholt mit Klimafakten, erhielten aber in den Antworten keine überzeugenden Gegenbeweise, auch nicht im letzten Schreiben vom 24.5.2013. Der gesamte Komplex wird hier noch einmal erörtert – in einem Anwortschreiben und der Stellungnahme „Vom Umweltschutz zum Klimaschutz“ , die kapitelweise die wesentlichen Komplexe behandelt.

Zunächst das EIKE-Antwortschreiben vom 31. August 2013

Die vollständige Stellungnahme ist als PDF-Datei beigefügt. Auszugsweise folgen hier die Kapitel 1, 2, 8, 11 und 15

1. Praktischer Umweltschutz – Die Realität der Fakten

- „Wissenschaftliche Unterstützung des Bundesministers für Umwelt, Naturschutz und Reaktorsicherheit in allen Angelegenheiten des Immissions- und Bodenschutzes, der Abfall- und Wasserwirtschaft, der gesundheitlichen Belange des Umweltschutzes,…“.

- ♦ Wie schon behandelt, beweisen die Langzeit-Temperaturreihen, dass einerseits vor dem Beginn der anthropogenen CO2-Emissionen von 1800 bis 1870 sowie von 1920 bis 1950 die schnellsten und stärksten Erwärmungen statt gefunden haben, dass es andererseits nach dem Beginn dieser Emissionen zwei Abkühlungsphasen gab, die letzte dauert noch an.

- ♦Zur „klimabestimmenden Wirkung“ des anthropogenen CO2 auf das Klima ist zweierlei anzumerken, wobei zu beachten ist, dass es tatsächlich immer nur um das von uns erzeugte CO2 geht, denn die Naturkreisläufe wirkten schon immer.

♦ man außerhalb Europas ganz sicher nicht annehmen wird, man könne mittels einer neuen Version des Wirtschaftens das Klima nur in einem „Segment der Welt vom nördlichen Polarkreis bis zur Antarktis“ schützen; und

- ♦ dass die seit Kopenhagen immer deutlicher werdenden Veränderungen in den Auffassungen zur Erderwärmung sich sehr viel einfacher mit einer Trendwende erklären lassen als mit nationalen Interessen: außerhalb Europas nimmt die intellektuelle Selbstbeschränkung ab, die Kenntnis der Fakten und die Einsicht in ihre Wirksamkeit nehmen zu: eine Erderwärmung infolge anthropogener CO2-Emissionen wird zunehmend bezweifelt.

Hier der Brief an das UBS (ohne Kopfbogen und Unterschriften)

Sehr geehrter Herr Präsident Flasbarth,

zunächst bitten wir um Verständnis, dass wir wegen der zwischenzeitlich zu führenden Auseinandersetzung mit der UBA-Broschüre „Und sie erwärmt sich doch“ erst jetzt dazu kommen, Ihr Schreiben vom 24.5.2013 zu beantworten. In diesem Schreiben teilen Sie uns mit, dass unserem Antrag, den wir im Schreiben vom 29.04.2013 gestellt hatten, teilweise statt gegeben wird. Wir hatten darin um Einsicht in Informationen gemäß § 3 und § 2 Abs. 3 Ziff. 3 UIG in Verbindung mit § 2 Abs. 1 und 2 UBA-ErrG gebeten. In Ihrer Antwort vom 24.5.2013 haben Sie die vier Komplexe unseres Antrages berücksichtigt und kommentiert, sowie Beispiele Ihrer Arbeitsergebnisse mitgeteilt. Dafür danken wir Ihnen.

Sie konnten zu allen Komplexen nicht detailliert Stellung nehmen und mussten sich auf ein Beispiel beschränken. Das von Ihnen ausgewählte und uns als Anlage zugesandte Beispiel umfasst „ Informationen aus der von uns durchgeführten Fachgesprächsreihe ,.Internationaler Klimaschutz nach dem Durban-Gipfel 2011. Wie gelingt die Trendwende?".

Dabei handelt es sich um 22 Seiten Niederschriften der Ergebnisse von drei Fachgesprächen mit internationaler Beteiligung, die am 12.03. 2012, am 05.06.2012 und am 21.09.2012 jeweils im Bundespresseamt in Berlin durchgeführt wurden, und schließlich um eine Schlussbetrachtung. Das von Ihnen gewählte Beispiel ist geeignet, die Arbeitsweise des Umweltbundesamts kennen zu lernen und die Faktentreue Ihrer Inhalte zu beurteilen. Es erscheint uns nun geboten, Bilanz zu ziehen, indem wir die Anfangsperiode des praktischen Umweltschutzes mit der Gegenwart vergleichen, in der eine zweckbestimmte Wissenschaft durch zielgerichtete Agitation der Politik das Ziel gesetzt hat, das Klima schützen zu müssen. Unsere Analyse ist als Anlage beigefügt.

In unserem Schreiben vom 29.04.2013 wurde das Umweltbundesamt aufgefordert, gemäß § 3 und § 2 Abs. 3 Ziff. 3 UIG in Verbindung mit § 2 Abs. 1 und 2 UBA-ErrG die Unterlagen zu übergeben, in denen die angebliche Notwendigkeit der Einhaltung des 2°-Zieles begründet wird. In der beigefügten Analyse konnten wir diese Begründungen noch nicht bewerten, denn die Unterlagen wurden noch nicht übergeben. Wir bitten Sie, das umgehend nachzuholen, damit zur Herstellung der notwendigen Transparenz die gesetzlichen Bestimmungen erfüllt sind.

mit freundlichen Grüßen

Dr. Holger Thuss Michael Limburg

Präsident Vizepräsident

Nun die Stellungnahme, sie umfasst 15 Kapitel, nämlich

1. Praktischer Umweltschutz – Die Realität der Fakten

2. Das Umweltbundesamt 1974

4. Klimasimulationsmodelle

5. Der ‚Klimaschutz’ – eine gewünschte Realität ?

9. Das Umweltbundesamt im Internet

3. Das neue Paradigma: Klimawandel und Klimaschutz

6. Die Fakten

7. Und wenn es nun doch noch wärmer würde?

8. Der Umgang des Umweltbundesamtes mit den Fakten

10. Das Umweltbundesamt als Hüter der Ökologie ?

11. Das Umweltbundesamt und die Weltklimakonferenzen – die Propagierung einer

Utopie

12. Klimaschutz statt Umweltschutz – bilanzierender Vergleich

13. Das Umweltbundesamt als Auftraggeber

14. Das Umweltbundesamt als Fachberater der Regierung

15. Fazit

Vom Umweltschutz zum Klimaschutz

In der Bundesrepublik Deutschland begann der Teil des praktisches Umweltschutzes, der den Gewässerschutz, die Verfügbarkeit sauberen Trinkwassers, die Klärung der Abwässer und die möglichst schadlose Abfallbeseitigung zum Ziel hatte, mit der Verabschiedung des Wasserhaushaltsgesetzes (WHG) im Jahre 1957. Es folgte bis in die frühen 1960er Jahre die Umsetzung des WHG für die Länder. Das Landeswassergesetz (LWG) für Nordrhein-Westfalen trat 1964 in Kraft. Die praktische Umsetzung des Gesetzes, d.h. die Erfüllung der neuen Aufgaben im Bereich der Wasserwirtschaft oblag den Wasserwirtschaftsämtern (WWA), ab 1973 Staatliche Ämter für Wasser- und Abfallwirtschaft (StAWA), ab 1994: Staatliche Umweltämter (StUA). Ihre Aufgaben umfassten vor allem die Erschließung von Grundwasservorkommen für die öffentliche Wasserversorgung, die Festsetzung von Wasserschutzgebieten, die Abwasser-reinigung und die Einrichtung von dichten Abfalldeponien. Um diese Aufgaben zu erfüllen, wurde der Personalbestand der WWA ergänzt: Zu den traditionellen Wasserbauingenieuren kamen etwa ab 1964 Biologen, Chemiker und Geologen hinzu, und außerdem wurden zweck-entsprechende Laboratorien eingerichtet. Beim Wasserwirtschaftsamt Lippstadt gehörte einer der Verfasser und Mitunterzeichner dieses Schreibens (Prof. Dr.rer.nat. F.-K. Ewert) als Geologe vom 1.11.1966 bis zum 1.6.1969 zum Anfangskader, der in der Verwaltung die Verfahren zur Realisierung des Gewässerschutzes entwickelte. Grundsatz der Arbeitsweise war die absolute Faktentreue. Ihr ist es zu verdanken, dass Deutschland bereits Anfang der 1980er Jahre die Aufgaben der Wasserversorgung, der Gewässerreinhaltung, der Abfallbeseitigung und der Abwasserreinigung dem Stand der Technik und den Notwendigkeiten der Zeit entsprechend erledigt hatte.

Dem Umweltbundesamt wurden bei seiner Gründung als Aufgaben u.a. zugewiesen:

· „Aufbau und Führung des Informationssystems zur Umweltplanung sowie einer zentralen Umweltdokumentation, Messung der großräumigen Luftbelastung, Aufklärung der Öffentlichkeit in Umweltfragen…“

Diese Aufgaben umfassten Maßnahmen des praktischen Umweltschutzes und der dazugehörigen Erforschung der wissenschaftlichen Grundlagen des Schutzes unserer Umwelt vor unserem Einfluss, also der ‚Welt um uns’. Der Begriff ‚Klimaschutz’ kommt in dem Gesetz nicht vor. Damals hätte man jeden für größenwahnsinnig gehalten und ihm psychopathologische Diagnostik angeraten, der auf den Gedanken gekommen wäre und propagiert hätte, wir könnten – und müssten – das Klima schützen, wo doch schon immer und allerseits bekannt und akzeptiert war, dass die Sonne das Leben auf der Erde ermöglicht und unser Wetter entscheidend bestimmt.

Als 1974 das Umweltbundesamt (UBA) als beratende Fachbehörde der Bundesregierung seine Tätigkeit aufnahm, hat man die in den Landesbehörden gemachten Erfahrungen berücksichtigen können. Ob und in wie weit – und wenn, wie lange – das geschehen ist, kann vom o.g. Mitverfasser nicht beurteilt werden, denn 1972 übernahm er im Hochschuldienst ein anderes Tätigkeitsfeld.

8. Der Umgang des Umweltbundesamtes mit den Fakten

Zu den vielen Einzelheiten, die dem Umweltbundesamt in unseren Briefen und Stellungnahmen seit März 2012 als Beweise für die Richtigkeit unserer klimarealistischen Schlussfolgerungen mitgeteilt wurden, gab es Gegenargumente des Umweltbundesamts. Sie sind alle von uns widerlegt worden. Für unsere Antwort reicht es hier völlig aus, nur eine zu kommentieren, nämlich das UBA-Argument 6 in der Anlage zu seinem Antwortbrief vom 14.6.2012:

6) „Der Beweis für die klimabestimmende Wirkung des anthropogenen C02 wird in der stärkeren und schnelleren Erwärmung der letzten Dekaden gesehen“.

Dieser ‚Beweis’ ist nicht belastbar, denn:

* Der allergrößte Teil des CO2 ist im Meer gelöst und verlässt es wegen seiner temperaturabhängigen Löslichkeit immer erst nach einem Temperaturanstieg. Jeder Laie kann beobachten, wie lange aus einem warm werdenden Sektglas CO2-Perlen aufsteigen.

* Der den menschengemachten Klimawandel befürwortende Teil der Forschung nimmt an, die CO2-Kreisläufe seien auch quantitativ verstanden. Das ist unrealistisch, besonders aus geologischer Sicht: Von allen beteiligten Komponenten kennen wir nur den Anteil, den wir seit etwa 1960 hinzufügen – es sind kaum 4% der Gesamtmenge. Das stets neu in den Kreislauf kommende CO2 anderer Zulieferer und das stets aus dem Kreislauf entnommene CO2 natürlicher Aufnehmer kennen wir nicht, beispielsweise:

>> Vulkane und Förderschlote im Meer liefern ständig unbekannte und zeitlich wechselnde CO2-Mengen,

>> die Verwitterung der Gesteine setzt CO2 frei,

>> die Skelettbildung der Tiere und der Menschen benötigt CO2,

>> aber gleichzeitig verdanken wir unsere Lebensenergie der Verdauung der Lebensmittel, die das in ihnen enthaltene CO2 freisetzt, das wir dann ausatmen: mindestens 1 kg täglich, d.h. 7,5 Mrd Menschen produzieren jährlich wenigstens 2,7 Mrd t CO2. Das ist doppelt soviel wie aus dem weltweiten Autoverkehr (1 Milliarde Autos, je 10.000 km Jahresleistung und einem CO2-Ausstoß von 150 g/km).

Das CO2 der Meere, der Luft, des Bodens und der Biosphäre tauscht sich gegenseitig aus. Weder die Größenordnungen dieser Kreisläufe noch die CO2-Gesamtmenge und schon gar nicht die Wirkung unseres Anteiles sind bekannt.

Dass „in der schnelleren und stärkeren Erwärmung der letzten Dekaden“ ein Beweis für die Wirkung des CO2 gesehen wird, während jene unberücksichtigt bleiben, die in der vorindustriellen Zeit wiederholt aufgetreten sind und die folglich genau das Gegenteil beweisen, ist noch nicht die schlimmste Botschaft dieser UBA-Aussage. Auch die nicht, dass das Umweltbundesamt nicht bewertet, dass zwei der letzten Dekaden statt der angenommenen Erwärmung eine Abkühlung angezeigt haben. Und es ist auch noch nicht einmal der schlimmste Teil der UBA-Aussage, dass man dem anthropogenen CO2-Anteil eine solche Bedeutung zumisst, obwohl das Absorptionsvermögen des vorhandenen CO2 für die Wärmestrahlung bereits weitgehend gesättigt ist und ein weiterer CO2-Anstieg deshalb vernachlässigbar ist, weil er sich nur insgesamt in Zehntel-Graden auswirken kann. Am schlimmsten ist, dass das Umweltbundesamt überzeugt zu sein scheint, es reiche für eine zuverlässige Beurteilung aus, die letzten Dekaden zu betrachten: „Der Beweis …wird in der ….Erwärmung der letzten Dekaden gesehen“. Erstaunlich: 30 Jahre sollen 4,5 Mrd. Jahre der irdischen Klimageschichte repräsentieren.

11. Das Umweltbundesamt und die Weltklimakonferenzen – die Propagierung einer Utopie

Ihrem Antwortschreiben vom 24.5. 2013 sind 20 Seiten beigefügt, die die Ergebnisse der Niederschriften einer während des Jahres 2012 veranstalteten Fachgesprächsreihe zum Thema "Internationaler Klimaschutz nach dem Durban-Gipfel 2011. Wie gelingt die Trendwende ?" enthalten. Sie demonstrieren eindrucksvoll das Engagement des Umweltbundesamts gegen den angeblichen Einfluss des Menschen auf das Weltklima und den Abschluss eines Weltklima-Abkommens.

Eine detaillierte Diskussion dieser Niederschriften kann im Rahmen dieser Analyse nicht vorgenommen werden. Sie ist allerdings auch nicht erforderlich, denn schon die Häufigkeit der in diesen Niederschriften gewählten Stichworte lässt keinen Zweifel an der offiziellen Überzeugung des Umweltbundesamts aufkommen, dass wir Menschen mit der verstärkten Emission des als Treibhausgas wirkenden CO2 eine nicht mehr tolerierbare Erderwärmung verursachen, und dass die Existenz der Menschheit gefährdet wäre, sollten diese Emissionen nicht verringert werden. Auf den 20 Seiten findet man

· 83 mal den Begriff ‚Klimaschutz’, entweder alleine oder zusammengesetzt mit anderen,

· 31 mal den Begriff ‚international’, und

· 20 mal den Begriff ‚Abkommen’, entweder alleine oder zusammengesetzt mit anderen,

was darauf hinweist, dass das Umweltbundesamt den Schutz des Klimas für möglich hält.

Der häufige Gebrauch des Begriffes ‚Abkommen’ lässt die Zielrichtung der Bemühungen des Umweltbundesamts erkennen: Gemeint ist der Weltklimavertrag. Die Existenz der Menschheit kann gerettet werden, wenn den Empfehlungen und Handlungsanweisungen des IPCC und des Umweltbundesamts gefolgt wird. Eine dieser Anweisungen ist das Gebot einer Dekarbonisierung – einer ‚Entkohlenstoffung’, sozusagen. Diese ist direkt gegen das Leben gerichtet, denn das Schlüsselelement aller lebenden Materie ist Kohlenstoff. Ist das beim Umweltbundesamt unbekannt ?

In Anbetracht der realen Klimafakten ist das wissenschaftlich widerlegte und nur mittels Klimasimulationen generierte Modell einer anthropogen Erderwärmung ein Phantom. Mit dem vom Wissenschaftlichen Beirat der Bundesregierung und vom Umweltbundesamt als überlebens-notwendig erklärten Ziel ‚Weltklimavertrag’ und ‚Dekarbonisierung’ erreichen Absurdität, Indoktrination und Missbrauch der Wissenschaft, vor allem auch durch Wissenschaftler selbst, ein in der Menschheitsgeschichte bisher unerreichtes Ausmaß! Die von der Bundesregierung akzeptierten Empfehlungen ihres Wissenschaftlichen Beirats machen Unsinn zur regierungs-amtlich sanktionierten Methode, und es werden Hunderte von Milliarden vergeudet, die einem wirklichen Umweltschutz verloren gehen.

Wie jüngste Produktionen zeigen („Und sie erwärmt sich doch“) hält das Bundesumweltamt sein Ziel auch noch im Jahre 2013 aufrecht, obwohl dies schon 2011 auf Grund des Ergebnisses des Durban-Gipfels durch Schellnhuber indirekt als unerreichbar bewertet wurde: In seinem Interview mit der FAZ am 12.12.2011 urteilt er: „Die Weltkarte des Klimaschutzes hat sich verändert“,

denn

„Europa und Afrika haben auf dem Klimagipfel in Durban eine wegweisende Allianz geschmiedet: Ein politisches „Subuniversum“, das unseren Planeten retten könnte.“

Zunächst: Die Aussage, dass das Subuniversum Europa und Afrika alleine „unseren Planeten retten könnte“ attestiert ihrem Autor einen erschreckenden Realitätsverlust.

Wenn Schellnhuber im Interview sagte:

„Die Welt ist jetzt gleichsam quer geschnitten. Es gibt jetzt die langfristig und verantwortungsvoll denkenden Länder versus diejenigen, die immer noch ihre kurzfristigen nationalen Interessen voranstellen“, und

“ … es hat sich ganz klar eine Allianz Europa/Afrika herausgebildet. Damit hat man ein Segment der Welt vom nördlichen Polarkreis bis zur Antarktis, in dem alles vorhanden ist, was man für den Umbau braucht. Das ist ein neues Subuniversum, das für sich allein die neue Version des Wirtschaftens hervorbringen kann“,

so ist festzustellen, dass…

-

-

dass die seit Kopenhagen immer deutlicher werdenden Veränderungen in den Auffassungen zur Erderwärmung sich sehr viel einfacher mit einer Trendwende erklären lassen als mit nationalen Interessen: außerhalb Europas nimmt die intellektuelle Selbstbeschrän- kung ab, die Kenntnis der Fakten und die Einsicht in ihre Wirksamkeit nehmen zu: eine Erderwärmung infolge anthropogener CO2-Emissionen wird zunehmend bezweifelt.

-

„…die Klimawissenschaften werden auch in Zukunft die Funktion haben: ….die wissenschaftlichen Grundlagen, auch gegen die Argumente von Klimaskeptikern, weiter auszubauen und zu stärken.

Man kann das Umweltbundesamt nur ermuntern, dies zu tun, allerdings mit einer veränderten Methodik: wirkliche Wissenschaftlichkeit ist offene Diskussion mit These und Antithese, nicht die gegenseitige Bestätigung gleicher Ergebnisse, die bekanntlich in Ideologisierung mündet. Bisher hat man sich darauf beschränkt, einseitig über die Ergebnisse und Argumente der sog. Skeptiker – in Wirklichkeit sind sie die realistischen Betrachter der Klimaentwicklung – zu urteilen statt mit ihnen offen zu diskutieren. Bisher ist dies, wann immer es angeboten wurde, abgelehnt worden. Warum wohl ?

15. Fazit

Bisher hat das Umweltbundesamt die Fakten entweder nicht zur Kenntnis genommen oder nicht verstanden oder nicht verstehen wollen. Die Gründlichkeit, mit der dies geschieht, ist wohl kein Zufall. Wenn dies zutrifft, hat diese Strategie allerdings ein immanentes Problem: die Diskrepanz zwischen der Entwicklung der realen Natur und der Vorstellung vom Klima, die beim Umweltbundesamt gepflegt wird und die das Umweltbundesamt propagiert, wird zunehmen. Die öffentliche Meinung wird skeptisch werden und irgendwann wird man dem Umweltbundesamt nicht mehr glauben, denn “You can fool some people sometime, but you can’t fool all the people all the time“ (Abraham Lincoln). Bevor die Glaubwürdigkeit einer Bundesoberbehörde verloren geht, sollte sie den Mut haben, in gemeinsamen Gesprächen die Belastbarkeit der Fakten zu diskutieren, damit wir uns dann gemeinsam an der Wirklichkeit orientieren. Der praktische Umweltschutz ist für die Zukunft des Lebens zu wichtig, als dass er Ideologien geopfert werden darf.

Im EIKE-Schreiben vom 29.04.2013 wurde das Umweltbundesamt aufgefordert, gemäß § 3 und § 2 Abs. 3 Ziff. 3 UIG in Verbindung mit § 2 Abs. 1 und 2 UBA-ErrG an EIKE Unterlagen zu übergeben, in denen die angebliche Notwendigkeit der Einhaltung des 2°-Zieles begründet wird. Diese Begründungen können noch nicht bewertet werden, weil die Unterlagen noch nicht übergegeben wurden und somit die Erfüllung der gesetzlichen Bestimmung noch aussteht

Related Files

|

In einem Tweet im Namen von Präsident Obama war unterstellt worden, dass die frühere betrügerische Studie von Cook und anderen eine Bestätigung von 97% für die Gefährlichkeit des Klimawandels gefunden habe:

„97% Prozent der Wissenschaftler stimmen zu: die Klimaänderung ist real, vom Menschen verursacht und gefährlich“ (Hervorhebung hinzugefügt)

Die neue Studie durch den führenden Klimatologen Dr. David Legates und seine Kollegen wurde in dem angesehenen Journal Science and Education veröffentlicht und enthüllt, dass Cook nicht in Betracht gezogen hat, ob die Wissenschaftler in ihren veröffentlichten Studien gesagt haben, die Klimaänderung sei „gefährlich“.

Der von Cook angeführte Konsens bestand aus der Standard-Definition: dass der Mensch das meiste der Erwärmung nach 1950 verursacht hat. Selbst unter dieser schwächeren Definition unter den veröffentlichten wissenschaftlichen Studien betrug der Konsens nicht 97,1%, wie Cook behauptet hat, sondern nur 0,3%.

Nur in 41 der 11944 veröffentlichten Klimastudien, die Cook explizit untersucht hat, wurde behauptet, dass der Mensch den größten Teil der Erwärmung seit 1950 verursacht hat. Cook selbst hat 64 Studien angeführt, die diesen Konsens explizit stützen, obwohl 23 dieser 64 Studien das gerade nicht getan hatten.

Dieses Schock-Ergebnis kommt knapp vor der Herausgabe des 5. IPCC-Zustandsberichtes, in dem ein „Vertrauen von 95%“ in den vorgestellten Konsens behauptet wird. Der neuen Studie zufolge ist dies imaginär.*

[*Der Absatz enthält ein unübersetzbares Wortspiel und folgt daher hier im Original: This shock result comes scant weeks before the United Nations’ climate panel, the IPCC, issues its fifth five-yearly climate assessment, claiming “95% confidence” in the imagined – and, as the new paper shows, imaginary – consensus.]

Die neue Studie mit dem [etwas sperrigen] Titel ‚Climate Consensus and ‘Misinformation’: a Rejoinder to ‘Agnotology, Scientific Consensus, and the Teaching and Learning of Climate Change’ weist entschieden Ergebnisse von Cook und anderen zurück, dass diejenigen, die sagen, dass nur wenige Wissenschaftler explizit den fast einstimmigen Klimakonsens stützen, die Öffentlichkeit falsch informieren und in die Irre führen.

Dr. Legates: „Es ist erstaunlich, dass irgendein Journal eine Studie veröffentlichen konnte, in der ein Konsens von 97% behauptet wird, wenn der eigenen Analyse des Autors zufolge der wirkliche Konsens weniger als 1% betragen hat. Es ist noch erstaunlicher, dass das IPCC eine Sicherheit von 95% hinsichtlich des Klimakonsens’ behaupten kann, wenn nur ein so kleiner Teil der veröffentlichten Studien diesen Konsens, wie ihn das IPCC definiert, untermauert“.

Dr. Willie Soon, ein angesehener Solarphysiker, zitierte den Wissenschaftsautor Michael Crichton mit den Worten: „Wenn es Wissenschaft ist, gibt es keinen Konsens. Wenn es Konsens ist, ist es keine Wissenschaft“. Soon fügte hinzu: „Seit nunmehr fast 17 Jahren gab es keine globale Erwärmung mehr. Keines der ‚Konsens’-Computermodelle hat das vorhergesagt“.

Dr. William Briggs, „Statistician to the Stars” [?], sagte: „in jeder Erhebung nach Art von Cook ist es ganz wichtig, die Fragen sehr klar zu formulieren. Und doch hat Cook drei separate Definitionen des Klimakonsens’ wirr durcheinander verwendet. Auch schloss er 8000 der 12000 betrachteten Studien willkürlich aus, und zwar mit der inakzeptablen Begründung, dass sie hinsichtlich des Klimakonsens’ keine Meinung äußern. Diese Kunstgriffe ließen ihn zu der ungerechtfertigten Schlussfolgerung kommen, dass es einen Konsens von 97,1% gegeben hat, obwohl das gar nicht stimmt.

Tatsächlich bietet Cooks Studie den klarsten verfügbaren statistischen Beweis, dass es kaum irgendeine explizite Unterstützung unter den Wissenschaftlern für den Konsens gibt, den das IPCC, Politiker, Bürokraten, Akademiker und die Medien so lange und so falsch proklamiert haben. Das war nicht das Ergebnis, das sich Cook erhofft hatte, und es entsprach nicht dem Ergebnis, dass er in seiner Studie behauptet hat, aber es entsprach dem Ergebnis, das er wirklich herausbekommen hatte“.

Christopher Monckton of Brenchley, Experten-Begutachter für den 5. Zustandsbericht, der die Fehler in Cooks Daten entdeckt hatte, sagte: „Es kann sein, dass mehr als 0,3% der Wissenschaftler glauben, dass der Mensch für mindestens die Hälfte der Erwärmung seit 1950 verantwortlich ist. Aber nur in 0,3% der 12000 Studien kommt das auch explizit zum Ausdruck. Cook hat nicht berücksichtigt, wie viele Studien das auch nur implizieren. Zweifellos halten viele Wissenschaftler das für möglich, so wie wir es tun, dass der Mensch für etwas, aber nicht den größten Teil der Erwärmung verantwortlich ist.

Es ist unwissenschaftlich anzunehmen, dass die meisten Wissenschaftler das glauben, was sie weder gesagt noch geschrieben haben“.

###

Die Studie: Climate Consensus and ‘Misinformation’: A Rejoinder to Agnotology, Scientific Consensus, and the Teaching and Learning of Climate Change

David R. Legates, Willie Soon, William M. Briggs, Christopher Monckton of Brenchley

http://link.springer.com/article/10.1007/s11191-013-9647-9

Abstract

Nichtwahrnehmung [Agnotology] ist das Studium des Aufkommens von Ignoranz mittels der Verbreitung von Fehlinformation, die darauf abzielen, in die Irre zu führen. Legates et al. (Sci Educ 22:2007–2017, 2013) haben die Anwendbarkeit von Agnotology in politisch gefärbten Diskussionen in Frage gestellt. In ihrer Antwort haben Bedford und Cook (Sci Educ 22:2019–2030, 2013) danach getrachtet, Agnotology in der Klimawissenschaft anzuwenden, indem sie versichern, dass Interessen fossiler Treibstoffe Zweifel geweckt haben hinsichtlich eines Klimakonsens’. Ihre Definition von Klima-‚Fehlinformation’ war vielleicht angebracht für die postmodernen Hypothesen, dass wissenschaftliche Wahrheit mit der Messung eines Konsens’ unter den Experten feststellbar ist und dass ein fast einstimmiger Konsens existiert. Allerdings hat die Untersuchung einer Behauptung von Cook et al. (Environ Res Lett 8:024024, 2013) über einen Konsens von 97,1%, die sich stark auf Bedford und Cook stützt, nur eine Unterstützung von 0,3% für die Standarddefinition eines Konsens’ergeben: dass nämlich die meiste Erwärmung seit 1950 anthropogener Natur ist.

Agnotology ist also ein zweischneidiges Schwert, da jede Seite in der Diskussion behaupten kann, dass generelle Ignoranz aus Fehlinformationen stammt, die vermeintlich von der anderen Seite lanciert worden waren. Wichtige Fragen über anthropogene Einflüsse bleiben aber bestehen. Daher haben Legates et al. in geeigneter Weise vermutet, dass parteiische Präsentationen von Kontroversen die Diskussion abwürgen und in der Bildung keinen Platz haben.

================================================================

Aktualisierung: Studie von Cook und Nuccitelli abgelehnt:

Bishop Hill schreibt:

Die Benestad-Studie (Cook, Nuccitelli) über „Agnotology“, eine bizarre Erfindung, die zum Ziel hat, praktisch jede jemals geschriebene skeptische Studie zu widerlegen, ist von Earth System Dynamics (ESD) abgelehnt worden:

„Basierend auf Begutachtungen und meiner eigenen Lesart der Original- und der überarbeiteten Studie lehne ich die Studie in ihrer jetzigen Form ab. Die Einreichung ist löblich hinsichtlich der Ziele und der Verfügbarkeit des R source code [?], aber davon abgesehen gibt es kaum etwas, das als wissenschaftlicher Beitrag bei ESD fungieren könnte. Während ich glaube, das eine ESD-Veröffentlichung zumindest eine Diskussion der R-Routines [?] hätte auslösen und die Aufmerksamkeit vieler interessierter Gemeinden hätte gewinnen können, ist das Manuskript selbst unpassend für dieses Journal und bräuchte wesentliche weitere Überarbeitungen, bevor es für dieses Journal in Betracht kommt (wenn überhaupt).

Link: http://wattsupwiththat.com/2013/09/03/cooks-97-consensus-disproven-by-a-new-paper-showing-major-math-errors/

Erster Kommentar unter dem Original: Die Aussage ‚wenn es Konsens ist, ist es keine Wissenschaft’ sagt alles!

Übersetzt von Chris Frey EIKE

|

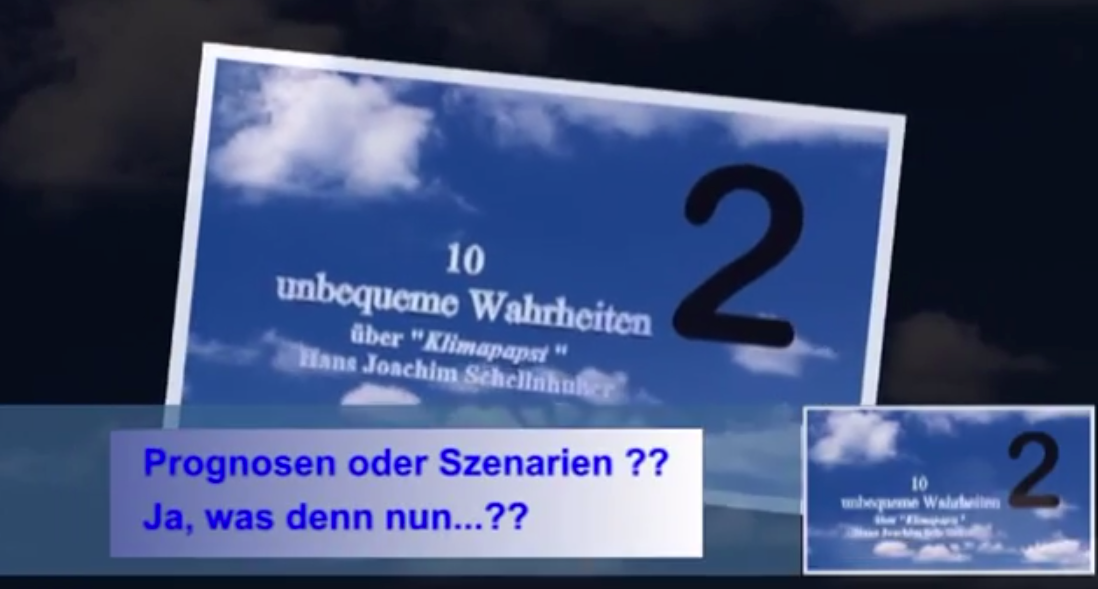

Denn in diesem Kapitel 2 wird auch erklärt und belegt, welche Bedeutung die Begriffe “Prognose“, “Szenario” und “Projektion” besitzen. Es ist davon auszugehen, dass Schellnhuber die unterschiedliche Bedeutung der drei Begriffe kennt, denn Schellnhuber selbst hat den Unterschied zwischen KlimaPrognose und KlimaSzenario im Juli 2012 auf arte differenziert beschrieben.

Video Teil 2 über die bunte Mischung aus Szenarien, Projektionen, Prognosen und Vorhersagen aus der Begriffswelt des Direktors des PIK (Potsdam Instituts für Klimaforschungsfolgen) und Kanzlerinnenklimaberaters Hans-Joachim Schellnhuber, wie er sie zu jeder passenden und auch unpassenden Gelegenheit den gläubigen Fernseh-Journalisten präsentierte. Recherchiert und erstellt vom Solarkritiker im Exils Rainer Hoffmann.

Auch die zweifelhafte Rolle der deutschen TV-Journalisten wird in diesem Kapitel 2 erneut thematisiert. Denn auch viele deutsche TV-Journalisten scheinen ebenfalls den wichtigen Unterschied zwischen “Szenario” und “Prognose” nicht zu kennen. In diesem Kapitel 2 wird dieses “Nicht-Wissen” u.a. am Beispiel von Anna Planken vom WDR aufgezeigt. Vielleicht denkt die ansonsten doch sehr nette und sympathische Anna Planken mal kritisch über Ihren fachlichen Fehler nach, wenn Sie dieses Kapitel 2 in Gänze gesehen haben sollte.

Allerdings fällt in der ARD-TAGESSCHAU-Sendung am 27.05.2013 der beachtenswerte Satz: “…ein einheitliches Szenario für den Klimawandel entwerfen.” Wenn Sie diesen Satz von der Bedeutung her genau analysieren, stellen Sie fest, daß die Wertigkeit/Bedeutung/Reihenfolge vertauscht worden ist. Denn dieser Satz in der TAGESSCHAU suggeriert fälschlich dem Zuschauer, dass ein von dem Menschen bestimmtes Szenario den Klimawandel beeinflussen und bestimmen würde. Aber es ist genau umgekehrt: In Wirklichkeit bestimmt aber der (natürliche) Klimawandel ein -wenn überhaupt – Szenario. Denn insbesondere der “grüne” Mensch litt immer schon an Größenwahn.

Rainer Hoffmann,

zuerst erschienen beim Klimamanifest von Heligenroth

|

So sind sie halt, die profitgierigen Kapitalisten von Tepco. Was ist aber mit den schönen Photos von dem Besuch des japanischen Handelsministers Toshimitsu Motegi inmitten einer solchen Gruppe? Hat man je von einem „Herrschenden“ gehört, der sich freiwillig und unnötig „verstrahlt“? Man muß also gar nichts von Strahlenschutz verstehen, um diese Berichte kritisch zu hinterfragen. Etwas gesunder Menschenverstand würde ausreichen — oder man hat halt etwas ganz anderes im Sinn.

Die Crux mit den verschiedenen Formen der Strahlung

Man unterscheidet Alpha- (Heliumkerne) Beta- (Elektronen) und Gammastrahlung (elektromagnetische). Jede, dieser ionisierenden Strahlungen hat eine charakteristische biologische Wirkung und „Durchdringungsfähigkeit“. Für Alphastrahlung reicht ein Stück Papier oder ein Zentimeter Luft als Abschirmung aus. Völlig anders ist die Situation, wenn Alphastrahlung erst im Körper freigesetzt wird. Für den gleichen Energiegehalt wird deshalb eine 20fache Schadenswirkung angenommen. Ganz ähnlich verhält es sich mit der anderen Teilchenstrahlung, der Betastrahlung. Sie dringt nur oberflächlich in Stoffe ein. Eine Abschirmung von ein bis zwei Metern Luft reicht aus. Genau hier, liegt das Mißverständnis begründet. Im Sinne des Strahlenschutzes spielt nur die Gammastrahlung für einen „Tanklagerbesucher“ eine Rolle: Man muß durch einen Schutzanzug mit Atemmaske verhindern, daß radioaktive Partikel in den Körper oder auf die Haut gelangen. Ist dies gewährleistet, kann man im Sinne des Arbeitsschutzes Alpha- und Betastrahlung vergessen. Für die Bestimmung der zulässigen Aufenthaltszeit z. B. ist nur die laufende Messung (Dosimeter) der Gammastrahlung von Interesse. Die Gammastrahlung hat in all den berichteten Fällen etwa 1,5 mSv/h (an den „heißen Stellen“, nicht etwa im gesamten Tanklager) betragen. Eigentlich, nicht der Rede wert — jedenfalls kein Grund für ein meßbar zusätzliches Krebsrisiko.

Warum also die plötzliche Aufregung über ständig steigende und gar „tödliche Strahlung“? Wahrscheinlich eine Kombination aus Unwissenheit und Sensationsgier. Das zweite dürfte überwiegen, denn man hätte ja mal jemanden fragen oder googeln können. Tepco veröffentlicht täglich die Meßwerte an verschiedenen Kontrollstellen. Da das Internet nicht vergisst, kann man die Entwicklung gut nachvollziehen. Fukushima ist eben nicht Tschernobyl! Die Meßwerte haben sich nicht verändert. In letzter Zeit ist lediglich eine Interpretation durch Laien hinzugekommen.

Tepco hat neben der Nuklidzusammensetzung der Wässer und der (Gamma-)strahlenbelastung auch einen Wert für die Betastrahlung angegeben. Wie schon weiter oben gesagt, wird Betastrahlung durch Luft sehr stark abgeschirmt. Die Meßwerte werden von Tepco in einem Abstand von 70 Mikrometer gemessen. Das Abwasser in den Tanks hat Betawerte von 1,8 bis 2,2 Sv/h. Solch hohe Werte bedeuten für einen Fachmann nur eins: Paß auf, daß du diese Brühe nicht ins Auge kriegst, sonst könntest du dein Augenlicht (Linsentrübung) verlieren! Mehr aber auch nicht. Selbst bei längerer Einwirkung auf der Haut, würde sich lediglich eine Hautrötung ergeben. Solange man die Pfütze nicht austrinkt, besteht keine Gefahr. Noch einmal in aller Deutlichkeit: Es gibt keine tödliche Dosis für eine äußerlich wirkende Betastrahlung. Schon der Schmerz durch den „Sonnenbrand“ würde jeden Menschen genug Zeit lassen, sich zu entfernen.

Das Tanklager

Bei dem betreffenden Tanklager handelt es sich um „mobile“ Tanks, die eiligst aufgestellt und teilweise sogar umgesetzt wurden. Sie sind aus einzelnen, gebogenen Segmenten zusammengeschraubt. Um sie überhaupt wasserdicht zu bekommen, sind in die Fugen Gummidichtungen eingelegt. Eine solche Konstruktion, in so hoher Stückzahl, bei den lokalen Wetterverhältnissen (große Temperaturschwankungen, Taifune, Erdbeben etc.) kann nicht über längere Zeit dicht bleiben. Ständige Leckagen waren vorhersehbar.

Die in den Medien angegebene Menge von 300 Kubikmetern, die ausgelaufen sein sollen, ist mit Vorsicht zu genießen. Geht man in die Originalangaben von Tepco, handelt es sich eher um eine Abschätzung. Es wurde in einem Tank eine Absenkung des Flüssigkeitsspiegels um etwa 3 m gegenüber seinen Nachbartanks festgestellt. Keiner weiß genau, ob er jemals ganz voll war, wieviel verdunstet ist usw. Es wurde Wasser aus der Auffangwanne um den Tank abgepumpt, aber nicht so viel. Nach Tepco etwa 4 Kubikmeter (!) bis zum 20. August. Der Rest „könnte“ im Boden versickert sein. Die in den Medien gemachte Aussage, es seien 300 Kubikmeter verseuchtes Wasser in den Ozean gelangt, ist so nicht haltbar und eher durch Meßwerte entkräftet. Erst recht nicht, daß die in dem Wasser enthaltene Radioaktivität dorthin gelangt ist. Der Boden wirkt in jedem Fall als Filter und Ionentauscher.

Als Gegenmaßnahmen wurden jetzt (!!) alle Ablaufventile in den Auffangwannen geschlossen. Es wurden unter alle Leckstellen Absorptionsmatten ausgelegt, um zukünftig besser kontrollieren zu können, wieviel Wasser ausgelaufen ist und ob etwas versickert ist. Nach dem Umpumpen des schadhaften Tanks soll die Wanne mit einem Hochdruckreiniger gereinigt werden und eine 50 cm Bodenschicht am Auslaufventil abgetragen werden. Der verseuchte Bodenbereich wurde mit Gummimatten und Sandsackbarrieren gesichert, damit kein verseuchtes Wasser (Regen) in die Entwässerungssysteme gelangen kann.

Als die wirksamste Gegenmaßnahme erscheint der gute alte Nachtwächter: Zukünftig geht alle drei Stunden eine Fußstreife kontrollieren.

Woher kommt das Wasser in den Tanks?

Nach wie vor müssen alle drei Reaktoren gekühlt werden. Dazu wird ständig Wasser in die Reaktorgefässe gepumpt. Durch die Leckagen in den Steuerstabführungen etc. fließt das Wasser in einem offenen Kreislauf in die Kellerbereiche des Kraftwerks. Dort vermischt es sich mit eindringendem Grundwasser und wird abgepumpt und einer Aufbereitung zugeführt. Das Grundwasser ist Brackwasser, wodurch der Salzgehalt im Rücklauf größer wird. Die Aufbereitung erfolgt zur Zeit in zwei Schritten: Dem SARRY-Verfahren und einer Umkehrosmose. In der SARRY-Stufe wird durch Adsorption (vor allem) Cäsium und weitere 60 Spaltprodukte (teilweise) abgeschieden. Die Umkehrosmose entspricht einer Meerwasserentsalzungsanlage: Es entsteht ein Wasserstrom „reines“ Wasser, welches wieder zur Kühlung in die Reaktoren eingespeist wird und ein „Konzentrat“, welches ins Tanklager geht. Ein typisches Meßprotokoll vom 9. 8. 2013 zeigt folgenden Verlauf: Das Wasser kommt beispielsweise mit 56000 Bq/cm^3 Cäsium-137 aus dem Keller in die Anlage rein. Dort wird soviel Cäsium abgeschieden, daß es die SARRY-Stufe im Mittel mit 1,3 Bq/cm^3 verläßt. Nach der Umkehrosmose ergibt sich ein Reinwasserstrom mit einem Gehalt unter der Nachweisgrenze, aber ein Konzentrat mit 2,7 Bq/cm^3 Cäsium-137 für die Tankanlage. Am Rande bemerkt sei, daß der Wert für Cäsium-137 für Trinkwasser nach internationalem Standard 10 Bq/Liter maximal betragen soll. Man könnte jetzt also mit fug und recht sagen, daß das Wasser im Tanklager 270 mal den Grenzwert für Trinkwasser übersteigt. Hört sich doch gleich viel gefährlicher an, nicht wahr?

Die Brennelemente sind durch das Unglück zerstört worden und teilweise wahrscheinlich aufgeschmolzen und wieder erstarrt. Sie haben jedenfalls keine Schutzhülle mehr und befinden sich auch nicht mehr in ihrem ursprünglichen (sehr widerstandsfähigen) chemischen Zustand. Das „Reinwasser“ zur Kühlung wird sie deshalb beständig weiter auslaugen. Es kann auch kein Gleichgewichtszustand angestrebt werden, solange das Wasser immer noch über die zerstörten Keller abfließen muß. Solange es nicht gelingt einen geschlossenen Kühlkreislauf zu bauen, hat man eine „ständige Quelle“ für verseuchtes Wasser. Ziel muß es daher sein, so schnell wie möglich, den alten Brennstoff aus den Reaktoren zu entfernen. Das ist aber leichter gesagt, als getan. Insofern ist es folgerichtig, mit Hochdruck eine stationäre Wasseraufbereitung zu bauen. Es wird noch eine erhebliche Menge mittelaktiven Abfalls anfallen, denn mit der Entfernung aus dem Wasser ist es nicht getan.

Einfach ins Meer kippen?

Manche Kritiker von Tepco schlagen nun eine radikale Lösung vor: Anstatt immer mehr Tankanlagen zu bauen, einen Tanker chartern und das radioaktive Wasser auf hoher See verklappen.

Radioaktive Materialien sind keine Bakterien oder Viren. Eine Vermehrung ist ausgeschlossen. Sie werden einfach nur weniger. Ferner bestimmt immer die Dosis das Gift. Je stärker man die radioaktive Lösung verdünnt, um so ungefährlicher wird sie. Setzt man sie weit genug draußen frei, ist eine Anreicherung über die Nahrungskette, auf für den Menschen schädliche Konzentrationen, ausgeschlossen. Übrigens genau die Lösung, die die Sowjetunion für die Entsorgung ihrer Atom-U-Boote gewählt hatte.

Ob man nun das Meer als Müllkippe nutzen sollte, ist eher eine ethisch-moralische oder juristische Frage. Die Naturwissenschaft kann allenfalls bei der Beantwortung helfen. Das Meer ist ist mit einem Volumen von über 1,5 Milliarden Kubikkilometern gigantisch groß. Zwar gibt es bedeutende regionale Unterschiede (z. B. Mittelmeer und offener Atlantik) und insbesondere sehr unterschiedliche Lebenswelten (Korallenriff bis Tiefseewüste), trotzdem ist es in seiner chemischen Zusammensetzung erstaunlich homogen. So enthält jeder Kubikmeter Meerwasser rund 433 Milligramm Uran, was eine Gesamtmenge von 5 Milliarden Tonnen gelösten Urans ergibt. Einschließlich der natürlich entstehenden Spaltprodukte, eine Menge Radioaktivität. Allein die Menge des gelösten radioaktiven Kalium-40 (hat auch jeder Mensch in seinen Knochen) beträgt 530 Milliarden Curie (1 Cu ist die Aktivität von einem Gramm Radium-226 oder 37 GBq). Das ist für sich eine gewaltige Menge Radioaktivität — aber eben fein verteilt. Es gibt aber durchaus auch Unterschiede: Die Konzentration im Golf von Mexiko ist höher — eine Folge der Zahlreichen Öl- und Gasbohrungen dort.

Nach Schätzungen verschiedener unabhängiger Institutionen (Tokyo University of Marine Science, Woods Hole Oceanographic Institution, National Oceanography Centre in Southampton etc.) werden etwa 0,3 TBq monatlich durch Fukushima ins Meer abgegeben. Die auf Messungen und Ausbreitungsrechnungen beruhenden Werte, bewegen sich in einer Bandbreite von 0,1 bis 0,6 TBq. Ist das nun sehr viel? Allein durch die Wasserstoffbombentests in den 1960er Jahren wurden im nördlichen Pazifik mehr als 100.000 TBq Cäsium-137 eingetragen. Die Wiederaufbereitungsanlage in Sellafield hat in 40 Jahren 39.000 TBq in die Nordsee abgegeben.

Die bisher höchsten Werte im Seegebiet zwischen 30 und 600 Kilometer vor Fukushima wurden 3 Monate nach dem Unglück gemessen. Es ergaben sich 3 Bq/Liter Cäsium-137. Im gleichen Zeitraum wurde ein natürlicher Eintrag von 10 Bq/Liter Kalium-40 gemessen. Schön, daß uns die Meßtechnik erlaubt, notfalls auch noch einzelne Kerne festzustellen.

Anreicherung über die Nahrungskette

Ist seit Beginn der „Anti-Atomkraft-Bewegung“ immer das schärfste Schwert in jeder Diskussion. Leider ist es nur sehr eingeschränkt und mit Vorsicht zu gebrauchen. In der Wissenschaft wird sie über das Verhältnis der Konzentration in der Umgebung zu der im Lebewesen bestimmt. Plankton reichert z. B. die Radioaktivität rund 40-fach an. Aber schon in den nächsten Schritten der Nahrungskette wird die Konzentration wesentlich geringer. Sie ist keinesfalls additiv. Biologie ist halt komplizierter. Zudem ist jedes Lebewesen für unterschiedliche Nuklide auch unterschiedlich selektiv. Wir erinnern uns noch an die Empfehlung nach Tschernobyl, nicht zu viel Pilze zu essen. Nebenbei gesagt, haben wir durch den „Praxistest“ Tschernobyl eine Menge über solche Ketten lernen können.

Wie schön, daß nun auch schon eine Auswirkung von Fukushima über den Pazifik bis nach Kalifornien festzustellen ist. Es ist nichts so schlecht, daß es nicht zu irgendetwas nützlich ist. Der „Nuklidcocktail“ von Fukushima dient nun dazu, die Wanderwege des von der Ausrottung bedrohten blauen Thunfisch zu erforschen. Nach Veröffentlichung erster Ergebnisse, waren sofort die Panikmacher zur Stelle und sahen sich in ihren schlimmsten Befürchtungen bestätigt. Die Ergänzung der Wissenschaftler ging natürlich bei den Medien verloren: Ein Erwachsener müßte 2,5 bis 4 Tonnen pro Jahr von diesem Thunfisch essen, um überhaupt auf den zulässigen Grenzwert zu kommen. Dieser ist aber noch weit von jeglicher Schädigung entfernt, sonst wäre es ja kein Grenzwert. Feststellbar, ist eben noch lange nicht schädlich.

Wer Angst vor „von Fukushima verseuchtem Tunfisch “ hat, sollte besser gar keinen Fisch essen. In jedem Fisch kann man unter anderem Polonium-210 mit einer zigfach höheren „Strahlenbelastung“ nachweisen. Es stammt aus der natürlichen Zerfallskette des im Meerwasser gelösten Urans. Es ist nur etwas schwieriger nachweisbar, da es sich um einen Alphastrahler handelt. Deshalb wurde 2006 auch der Putingegner Alexander Litwinenko damit in London ermordet.

Dr. Ing. Klaus Dieter Humpich ..zuerst am 8.9.13 erschienen bei NUKEKLAUS

|

[*Unübersetzbares Wortspiel: Krudd steht für Kevin Rudd, den bisherigen Premier. Es soll eine Assoziation mit dem englischen Wort mud hergestellt werden, das „Schlamm“ bedeutet. A. d. Übers.]

Tony Abbott hat die Wahlen in Australien mit einem Erdrutsch gewonnen und die Abschaffung der Kohlenstoff-Steuer als oberste und erste Priorität genannt. Abbot hat erklärt, dass Australien „jetzt wieder offen ist für die Wirtschaft“ und seinen Wahlsieg vom Sonnabend festgestellt.

Es ist ein vernichtender Schlag gegen die Labour-Party von Rudd-Gillard und ihrer grünen Ziele, die auf einer den Australiern aufgezwungenen Lüge aufbauen. Noch im Jahr 2010 hat Gillard in einer mit Video aufgezeichneten Rede gesagt „keine Kohlenstoff-Steuer“. Dies war allgemein der Punkt, als Australien seine Vertrauenswürdigkeit verloren hatte.

Das Video (15 Sekunden): https://www.youtube.com/watch?feature=player_embedded&v=KMVc0IbtyAQ

Danach, kaum dass sie zur Premierministerin gewählt worden war, agierte sie so, als ob sie diese Worte niemals gesagt hätte und führte in jedem Falle eine Kohlenstoffsteuer ein. Es gibt nichts Schlimmeres als eine Lügnerin, die gegenüber ihren eigenen Lügen so vergesslich ist, und meiner Ansicht nach war das der Katalysator, der das Ende des grünen Traums von Labour eingeläutet hat ebenso wie das Ende ihrer Dominanz in der Regierung.

Abbott sagt, dass er die Kohlenstoff-Steuer annullieren werde. In einem Artikel in der Herald Sun vom 5. August hieß es:

Im Falle seiner Wahl werde er am ersten Tag die CEFC (Clean Energy Finance Corporation) suspendieren und ein Gesetz auf den Weg bringen, diese permanent zu schließen. Außerdem werde er innerhalb von zwei Wochen einen Gesetzentwurf einbringen mit dem Ziel, die Kohlenstoff-Steuer abzuschaffen sowie alle Klimaagenturen, die mit den Labour-Gesetzen zu sauberer Energie zusammenhängen.

Heute schreibt die Herald Sun:

„Heute haben die Australier erklärt, dass das Recht, dieses Land zu regieren, nicht Mr. Rudd gehört oder mir oder seiner Partei oder meiner Partei, sondern es gehört Ihnen, dem Volk von Australien“, sagte Abbott. „Und Sie werden jeden bestrafen, der etwas anderes für sich in Anspruch nimmt!“

Andrew Bolt schrieb in seinem Blog: „Endlich, ein Mann, der es wert ist, das Büro des Premierministers zu beziehen – und bescheiden genug, um Hoffnung zu wecken“.

Ich gratuliere meinen Freunden in Australien, der Krudd ist kaput [das steht wirklich so im Original!] und die Kohlenstoff-Steuer verschwindet, ebenso wie fast mit Sicherheit auch Flim Flam Flannery. Was für ein großartiger Tag!

Cook, Ove und Sou [australische Wissenschafts-Alarmisten, A. d. Übers.], dieser Krudd ist für euch!

Aber zurück in die USA. Die Washington Post scheint diese laute Botschaft aus Down Under überhört oder vergessen zu haben, wenn sie schreibt (Dank an Steve Milloy):

Das erste, was man tun muss, ist, die Kosten der Verschmutzung auf den Preis für Energie aufzuschlagen, und zwar mittels einer einfachen Kohlenstoff-Steuer oder andere marktbasierte Mechanismen. Obwohl die Steuereinnahmen direkt an die Menschen zurückgehen könnten, würden höhere Verkaufspreise für Energie aus fossilen Treibstoffen immer noch Grund genug liefern, ihr Verhalten zu ändern und nach energieeffizienteren Mitteln zu fragen.

Es ist wieder einmal wie ein déjà vu, weil die australische Kohlenstoff-Steuer auf genau die gleiche Art und Weise eingeführt worden ist, und heute wurde sie von den australischen Wählern rundweg zurückgewiesen. Hoffen wir, dass wir hier in den Staaten nicht die gleiche Verrücktheit erleben müssen!

Aktualisierung: Der Australier Eric Worrall schreibt in einem kurzen Beitrag für WUWT nur wenige Augenblicke nach der Veröffentlichung [des Wahlsiegs]:

Tony Abbott, der die Klimaänderung einst als Mist bezeichnet hat (http://en.wikipedia.org/wiki/Tony_Abbott#Climate_change), hat einen Erdrutschsieg bei den Wahlen in Australien verbucht, einer Wahl, die gekennzeichnet war durch substantiellen Schwung gegen Labour und die Grünen.

Während wir Australier durch Abbotts Kniefall vor dem grünen Dogma enttäuscht waren, dem er durch sein Versprechen, die gehasste Kohlenstoff-Steuer durch eine verwässerte Art der Kohlenstoff-Taxierung zu ersetzen, Ausdruck verliehen hat, leben wir jetzt in der Hoffnung, dass dies lediglich ein Spruch war, um die Grünen in seiner Partei zu besänftigen. Abbott hat uns genügend Anlass für diese Hoffnung gegeben, und zwar mit Statements des Inhalts, dass sein Budget zur Abschwächung des Klimawandels gekürzt wird, egal ob die Förderung ihre gesetzten Ziele erreicht sowie mit einem Versprechen, die Bereitstellungen für das nationale Wissenschafts-Budget zu straffen.“

Abbott hat auch Tim Flannery widersprochen (hier bei Joanne Nova), dem Ober-Schwarzseher der Regierung, der mehr als jeder andere dafür getan hat, Australiens white elephant desalination plants [?] auszuliefern, und zwar mit seiner schrillen Unterstützung von Vorhersagen permanenter Dürre.

Es sind also begeisternde Zeiten für Klimaskeptiker in Down Under – und potentiell eine globale Warnung an Politiker und politische Parteien, die die sich zu stark bei den Grünen anbiedern.

Link: http://wattsupwiththat.com/2013/09/07/australia-liberated-from-their-long-national-green-nightmare/

Übersetzt von Chris Frey EIKE

|

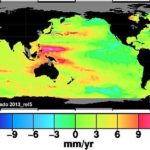

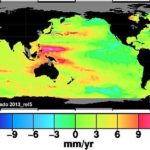

Abbildung 1: Trend des Anstiegs des Meeresspiegels seit 1993. Quelle: University of Colorado.

Nun vergleiche man dies mit der Anomalie-Verteilung des ozeanischen Wärmegehaltes in etwa dem gleichem Zeitraum:

Abbildung 2 zeigt die Anomalie des ozeanischen Wärmegehaltes von 0 bis 300 m bis Januar 2012. Quelle: University of Colorado.

Sie sehen gleich aus, oder? Die Farben in den meisten Gebieten der beiden Karten passen zusammen. Sie würden fast perfekt zusammenpassen, wenn die Farbskalen gleich wären. Aber an den Stellen mit ozeanischer Wärme (rot und orange) in Abbildung 2 gibt es einen Anstieg des Meeresspiegels (rot und orange) in Abbildung 1. Im Gegensatz dazu steht der niedrigere Meeresspiegel dort, wo der Ozean kühler ist. Warm = höherer Meeresspiegel, kühl = niedrigerer Meeresspiegel. Der Westpazifik ist wärmer und weist einen höheren Meeresspiegel auf als der Ostpazifik. Die warme Strömung östlich von Japan geht mit einem höheren Meeresspiegel einher. Kühle Stellen im Südpazifik zeigen einen niedrigeren Meeresspiegel.

Der Anstieg des Meeresspiegels, wie er von Satelliten gemessen wird, misst Wärmeunterschiede. Das beste Beispiel hierfür ist der Wärmepool im Westpazifik. Es wird nicht der Meeresspiegel an den Küsten gemessen, wo die Menschen wohnen. Tatsächlich messen Satelliten mittels Radar besonders im Abstand bis 50 km vor einer Küste nicht.

All dies bedeutet, dass die Radarmessungen für die Bestimmung des Meeresspiegels nutzlos sind hinsichtlich der Planungen von Infrastruktur an den Küsten. Sie nutzen nur einem weiteren CAGW-Betrug. Die University von Colorado gibt das hier sogar zu (Hervorhebung von mir):

„GMSL ist ein guter Indikator für Änderungen des Wasservolumens in den Ozeanen infolge Massenzufluss (z. B. Eisschmelze an Land) sowie Dichteänderungen (z. B. thermische Expansion) und sind daher zur Erkennung von Klimaänderungen von Interesse”.

Den Planern küstennaher Infrastruktur ist das Volumen egal. Sie wollen etwas über die Tiefe wissen, an der Küste bei Flut, und das hat nichts mit Klimaänderung zu tun.

Link: http://notrickszone.com/2013/08/30/university-of-colorado-admits-radar-altimetry-is-pretty-much-useless-for-measuring-sea-level/

Übersetzt von Chris Frey EIKE

|

Parallel zu dieser Umverteilung werden trotz Staatsschulden von mehreren Billionen Euro in Deutschland im Rahmen der Umstellung auf sogenannte erneuerbare Energien alte und bewährte Energieversorgungssysteme verschrottet, und es wird billigend in Kauf genommen, dass durch die zwangsläufig nötigen doppelten Installationen von Versorgungsanlagen zur Absicherung einer stabilen Stromversorgung und Subventionen für neue technisch nicht ausgereifte, teurere Versorgungssysteme die Belastung der Bevölkerung sowie die Staatsverschuldung unüberschaubar steigen.

Der deutschen Bevölkerung wird der volkswirtschaftliche Kraftakt der Energieumstellung durch die angeblich bevorstehende Klimaerwärmung begründet und mit einem Beschäftigungsboom im Bereich der erneuerbaren Energien schmackhaft gemacht. „Die Verpflichtungen zum Erreichen der Klimaziele bedeuten Arbeitsplätze und Wachstum“, lautet seit Jahren der Tenor der Politik. 2009 erklärte die deutsche Bundeskanzlerin: „Deutschland kann allein im Bereich der Energieeffizienz in den kommenden 10 Jahren 800.000 neue Jobs gewinnen“, und der Unternehmensberater Roland Berger prognostiziert, dass 2020 die Umweltbranche mehr Mitarbeiter ernähren wird als die heutigen beiden Leitbranchen Automobilbau und Maschinenbau zusammen.

Das Gegenteil ist der Fall, wie man am Beispiel des ehemaligen Musterlandes für erneuerbare Energien, Spanien, erkennen kann: Die Ökoindustrie ist keineswegs ein Job-Motor, sondern mittel- und langfristig eine Arbeitsplatz-Vernichtungs-Maschine für die Länder, die sich dieser Philosophie angeschlossen haben und ein Wohlstandvernichtungsprogramm größten Ausmaßes.

Spanien: Ökoindustrie als Jobvernichter

Für den US-Präsidenten Obama diente Spanien noch vor gar nicht so langer Zeit als Referenz für die Einführung erneuerbarer Energien und als Begründung dafür, die so nötige Belebung der amerikanischen Wirtschaft durch neue Industrien und neue Arbeitsplätze zu erreichen. Kein anderes Land hatte zu diesem Zeitpunkt die Einführung erneuerbarer Energien so intensiv unterstützt wie Spanien, das seinen Energiemarkt nach deutschem Vorbild ordnete. Entsprechend dem deutschen Erneuerbaren-Energie-Gesetz waren Renditen aus dieser Energieform für 25 Jahre gesichert, Strom aus Photovoltaik-Anlagen wurde mit bis zu 575 Prozent und Strom aus Windkraftanlagen mit bis zu 90 Prozent über dem Marktwert liegenden Strompreisen unterstützt. Das sind auch nach der aktuellen Reduktion der deutschen Einspeisevergütung noch sehr zurückhaltende Zahlen. In Deutschland liegen diese Werte heute immer noch bei cirka 900 Prozent (Solarförderung) bzw. 400 Prozent (Förderung der Windenergie).

Die Wirtschaftskrise in der zweiten Hälfte des Jahres 2007 hat jedoch die Problematik dieser Subventionen offengelegt und gezeigt, dass die derzeitige Finanzkrise in Spanien neben der explodierenden Bauwirtschaft zum großen Teil auf Fehlentwicklungen durch das Erneuerbare-Energie-Gesetz zurückzuführen ist. Die Kreditkrise 2007/08 zwang Spanien zu Kürzungen in der massiv unterstützten Bauwirtschaft, dem Transportwesen, dem Maschinenbau etc. Erneuerbare Energien blieben die bevorzugten Felder für die Kreditvergabe und starteten ein himmelstürmendes Investitionsprogramm speziell bei der Photovoltaik (allein eine Verdreifachung der Kapazitäten zwischen 2007 und 2008), während der Rest der spanischen Produktion stagnierte.

Das Wirtschaftswachstum brach ein und hat sich seitdem nicht mehr erholt. Am 27.1.2012 wurden die Subventionen für neue Solar-, Wind- und Bioenergieanlagen mit folgender Begründung gestoppt: „Was heute ein Energieproblem ist, könnte zu einem finanziellen Problem werden“ (Industrie-Minister Jose Manuel Soria in Madrid). Leider nicht früh genug, um die spanische Finanzkrise aufzuhalten! Investitionen in erneuerbare Energien, die einer ständigen Nachfinanzierung bedürfen und nicht zu einem sich selbst finanzierenden Geschäftsfeld führen, vernichten Kapital, das letztendlich dem privaten Sektor für selbsttragende Investitionen fehlt.

Die Einführung erneuerbarer Energien auf der Basis eines Erneuerbaren-Energie-Gesetzes sind keineswegs ein Job-Motor, wie es die EU- Kommission und Bundesregierung nicht müde werden zu betonen. Eine Studie der Madrider Universität Rey Juan Carlos aus dem Jahr 2009 über die spanischen Situation [1] kommt zu ganz anderen Ergebnissen. Darin sind derart viele Parallelen zur deutschen Situation zu erkennen, dass sie deutschen Politikern als Warnung dienen sollte. Gabriel Calzada Alvarez und seine Mitarbeiter gingen dabei von zwei verschiedenen Ansätzen aus. Bei der ersten Methode verglichen sie den Kapitalbedarf für einen Arbeitsplatz im Bereich der erneuerbaren Energien mit demjenigen in der privaten Wirtschaft, beim zweiten Ansatz wurde die jährliche Produktivität zwischen einem Arbeitsplatz im Bereich der erneuerbaren Energien mit demjenigen in der privaten Wirtschaft verglichen.

Durch eine Investitionssumme, die die gesamten bereits ausgegebenen und vertraglich festgelegten Subventionen von 28,67 Milliarden Euro zwischen den Jahren 2000 und 2010 erfasst, wurden in Spanien 50.000 neue Arbeitsplätze geschaffen. Das ergibt einen Betrag von 571.000 Euro pro aktuellem Arbeitsplatz. Die durchschnittlichen Kosten für einen langzeitstabilen Arbeitsplatz im Privatsektor liegen in Spanien bei 259.000 Euro. Ein Arbeitsplatz im Erneuerbaren-Energie-Bereich kostet also 2,2 mal so viel wie ein Arbeitsplatz im Privatsektor der Wirtschaft.

Trotz der aggressiven Politik in diesem Bereich entstanden jedoch nur wenige wirklich neue Jobs. Von den neuen Arbeitsplätzen im erneuerbaren Energiesektor entfielen zwei Drittel auf Konstruktion, Herstellung und Installation, ein Viertel auf administrative Tätigkeiten, Marketing und Projekt-Engineering, und gerade einmal ein Job von zehn wurde für dauerhafte Tätigkeiten in Anlagenbetrieb und -wartung sowie Verwaltung geschaffen. Wenn diese Zahlen zugrunde gelegt werden und zehn Arbeitsplätze im Sektor erneuerbare Energien 22 Arbeitsplätze im Privatsektor der Wirtschaft kosten, werden für einen dauerhaften Arbeitsplatz im Erneuerbaren-Energie-Sektor 22 Arbeitsplätze in der Privatindustrie vernichtet oder nicht aufgebaut.

Neben diesem äußerst überraschenden Effekt verbrauchten die erneuerbaren Energien viel Geld der Steuerzahler. In Spanien beträgt der jährliche Beitrag, der für die erneuerbaren Energien aufgebracht wird, bereits 4,35 Prozent der gesamten Konsumausgaben und beeinflusst den privaten Finanzrahmen merklich. Dieses Geld steht für andere Investitionen nicht mehr zur Verfügung. Der ausgeuferte Ausbau der erneuerbaren Energien hat die aktuelle spanische Finanzkrise deutlich verstärkt. Glücklicherweise hat Spanien im Gegensatz zu Deutschland keinen Beschluss zum Ausstieg aus der Kernenergie getroffen und somit nach Behebung der Finanzprobleme eine Chance, den Irrweg ohne bleibende negative Folgen für die Wirtschaft wieder zu verlassen. Die traditionelle Energieversorgung ist noch funktionsfähig.

Deutschland: Droht die Deindustrialisierung?

In Deutschland führt das Erneuerbare-Energie-Gesetz in gleicher Weise zur Verteuerung der Energiekosten und damit zu einer wachsenden Beeinträchtigung der Wettbewerbsfähigkeit. Letztlich ist in den nächsten Jahren mit einer Auslagerung von energieintensiven Produktionen in Länder besserer Wirtschaftlichkeit, verbunden mit dem Verlust von Arbeitsplätzen zu rechnen. Durch den Ausstiegsbeschluss aus der Kernenergie ist nach 2022 keine Auffanglösung wie im Fall Spanien mehr vorhanden. Von den ehemals 17 Kernkraftwerken sind bereits acht für immer abgeschaltet. Deutschland beschreitet einen noch gefährlicheren Weg als Spanien.

2012 meldete die Ökobranche in Deutschland cirka 370.000 Mitarbeiter. Das sieht auf den ersten Blick wie eine Erfolgsgeschichte aus. Übersehen wird dabei die Anzahl der Entlassenen und nicht neu Eingestellten sowie die Gegenrechnung der Umsatzverluste, die in energieintensiven Betrieben, wie den metallurgischen und metallverarbeitenden Betrieben, den Nahrungsmittelfirmen, der chemischen Industrie sowie der Papierindustrie, aufgetreten sind bzw. auftreten werden. Die zahlreichen Entlassungen in der Atomindustrie, die geplante Verlagerung metallurgischer Betriebe, vor allem der Aluminiumindustrie, ins Ausland sind ein erstes Anzeichen für diese Entwicklung. Nicht umsonst warnten etwa vor Kurzem Arbeitgeber und Arbeitnehmer der Chemiebranche in seltener Eintracht vor den unkalkulierbaren Folgen der Energiewende für den Industriestandort Deutschland. [2]

Die augenblicklich gute gesamtwirtschaftliche Lage in Deutschland überspielt diese Probleme. Deutschland hat bis zum Jahr 2010 cirka 130 Milliarden Euro in erneuerbare Energien investiert (40 Mrd. € für die Photovoltaik, 50 Mrd. € für die Windenergie und 40 Mrd. € für die Bioenergie). Auf den Arbeitsplatz umgelegt, ergibt sich ein Betrag von cirka 520.000 Euro pro Arbeitsplatz, der nicht weit von den spanischen Zahlen entfernt ist. Es kann also davon ausgegangen werden, dass im Mittel auch in Deutschland für jeden subventionierten Arbeitsplatz im Erneuerbaren-Energie-Sektor mindestens 2,2 Arbeitsplätze und insgesamt somit rund 700.000 im traditionellen Arbeitsmarkt verloren gehen.

Die Ökoindustrie ist also keineswegs ein Job-Motor, sondern mittel- und langfristig eine Arbeitsplatz-Vernichtungs-Maschine für die Länder, die sich dieser Philosophie angeschlossen haben und ein Wohlstandvernichtungsprogramm ungeahnten Ausmaßes für den Großteil der deutschen Bevölkerung.

Dr. Ing. Jürgen Langeheine

Zuerst erschienen in NOVO Argumente im Dezember 2012