Wirklich tödlich? – es sind ja „nur“ Sandkastenspiele, die bestenfalls der Willensbildungund Entscheidungsfindung im Vorfeld von Wahlterminen dienen. Aber worin unterscheiden sich nun „Freizeit-Energiepolitiker“ von den Profis in unseren Parlamenten auf Landes- und Bundesebene? Ich würde sagen nur graduell, wenigstens das sieht Frau Schwan ähnlich. Dort gibt es in der Ausschussarbeit klare Zuordnungen und Spezialisierungen auf Einzelpolitiken, und der Bildungs- oder Innenpolitiker hat eben mit der Energiepolitik weniger am Hut, einmal abgesehen vom in der Regel fehlenden technisch-naturwissenschaftlichen Hintergrund.

Und selbst als Physiker(in) – im gegenwärtigen Bundestag zusammen mit Ingenieuren, Chemikern und Mathematikern eine Minderheit von 7,5% –, das zeigt sich ganz klar an der Bundeskanzlerin, ist man Zwängen unterworfen, die einer rationalen Entscheidung im Wege stehen. Nicht zu vergessen natürlich die ständige Beeinflussung durch Medien, Vertreter von Einzelinteressen, bezahlte Politikberatung sowie der nachvollziehbare Wunsch, wiedergewählt zu werden. Im Bereich der Energiepolitik kommt erschwerend hinzu, dass es sich um ein komplexes Thema handelt, dessen Erkenntnislücken gerne mit Glaubenssätzen aufgefüllt und durch Angstszenarien untermauert werden. Nicht zu unterschätzen darüber hinaus die Verquickung wirtschaftlicher Interessen, die gerade auch in den jungen Industrien der sog. Erneuerbaren Energien ausgeprägt ist.

Was hilft dagegen? Nicht Palaver, sondern Aufklärung und Information, so objektiv wie möglich, so umfassend wie nötig und so interessenneutral wie es nur geht. Das heißt, im Vordergrund muss das Gemeinwohl stehen. Für verschiedene Fragestellungen der Energiepolitik soll hierzu in knapper Form und unter Zuhilfenahme von Quellen und Publikationen mit naturwissenschaftlich-technischem Fokus, vorwiegend aus dem Internet, ein erster Versuch unternommen werden. Dabei hilft, dass der Verfasser als „einfacher Wirtschaftswissenschaftler“ sich dem kritischen Rationalismus von Karl Popper verpflichtet fühlt.

1. Was ist Sinn und Zweck der Energiewende?

Die Energiewende soll zwei (vermeintliche?) Probleme lösen: Erstens die Abhängigkeit von fossilen Rohstoffen beseitigen, die nach den „Prophezeiungen“ des Club of Rome über die Grenzen des Wachstums aus dem Jahre 1972 „sehr zeitnah“ nicht mehr verfügbar sein werden, sprich die Begrenztheit der Vorräte an Kohle, Öl und Gas wird ins Kalkül gezogen. Dadurch sollen sich auch die anthropogen verursachten Emissionen des Gases CO2 verringern, die vom wissenschaftlichen „Mainstream“ ganz wesentlich für den Klimawandel verantwortlich gemacht werden – Stichwort: Menschengemachter Klimawandel.

Zweitens soll das deutsche Energiesystem sukzessive, d.h. in vier Schritten von fossilen auf erneuerbare Energien wie Sonne, Wind, Biomasse und Wasserkraft umgestellt werden. Bis 2020 sollen jeweils mindestens 35%, bis 2030 50%, bis 2040 65% und bis 2050 80% der Stromerzeugung regenerativ erfolgen, die gesamte Energieversorgung zur Jahrhundertmitte zu mindestens 50%. Parallel zum Umstieg auf erneuerbare Energien erfolgt der Ausstieg aus der Kernenergie – wohl die stärkste Antriebskraft –, der allerdings schon in 2022 zu 100% vollzogen sein soll.

Dies ist das Ergebnis der im Nachgang zu der Naturkatastrophe vom 11. März 2011 – dem Erdbeben und Tsunami mit anschließender Havarie von drei Reaktoren in Fukushima/Japan – von der Bundesregierung getroffenen Entscheidungen. Kurz zuvor war der Kernkraftnutzung in Deutschland noch eine Funktion als „Brückentechnologie“ zugetraut und zugebilligt worden. D.h. sie sollte einen behutsamen Systemwechsel von Fossil auf Erneuerbar auch wirtschaftlich abfedern und begleiten.

Die vom Club of Rome angestoßene Diskussion wird heute u.a. unter Begriffen wie „Peak-Oil“ und „-Gas“ stark meinungsprägend fortgeführt, wobei die Internationale Energie Agentur (IEA) in Paris die Versorgung mit fossilen Brennstoffen noch für Jahrhunderte sichergestellt sieht (siehe hierzu nur Rudolf Kipp, Peak-Oil und Anti-Fracking Propaganda in der ARD, 28.3.2013, unter www.science-skeptical.de). In Bezug auf die Kernkraftnutzung weist die Ablehnungsfront fast krankhafte Züge auf. Dies erkennt man an der gängigen Tabuisierung des Themas, wie auch an Manifestationen der schon sprichwörtlichen „German Angst“. Dies geht soweit, dass versucht wird, neuere Entwicklungen in der Kerntechnik bewusst aus der öffentlichen Diskussion herauszuhalten.

So wurde im laufenden Wettbewerb des renommierten GreenTec Awards 2013 ein durch Online-Voting mehrheitlich nominierter Salzschmelze-Reaktor durch die nachträgliche Änderung der Wettbewerbsbedingungen aus der Wertung genommen. Zwischenzeitlich hat das Berliner Kammergericht dies per einstweiliger Verfügung für unzulässig erklärt. Dem neuen Reaktortyp der Generation IV werden aufgrund seiner Vorteile gegenüber den üblichen Leichtwasserreaktoren (u.a. inhärente Sicherheit, bessere Nutzung von Thorium und Uran, Lagerung der radioaktiven Abfälle für einen Zeitraum von 300 Jahren) auf lange Sicht – in 30 bis 50 Jahren – gute Chancen eingeräumt. Die Chinesen haben schon ihr Interesse an dieser Entwicklung artikuliert.

Der Enkel des Entdeckers der Kernspaltung und Nobelpreisträgers Otto Hahn, Dietrich Hahn, weist übrigens gerne darauf hin, dass sein Großvater, wie auch seine Patentante Lise Meitner, im hohen Alter (im 89. bzw. 90. Lebensjahr) eines natürlichen Todes gestorben sind. Und darauf, dass sich Tadatoshi Akiba, ehemaliger Bürgermeister Hiroshimas und langjähriger Präsident der weltweit aktiven Organisation “Mayors for Peace” bei der Verleihung der Otto-Hahn-Friedensmedaille am 16. April 2013 in Berlin klar für eine Fortsetzung des Kernenergienutzung in seinem Heimatland Japan ausgesprochen hat.

2. Sind die Erkenntnisse über die Ursachen des Klimawandels eindeutig?

Glaubt man der neuesten einschlägigen Publikation des Umweltbundesamtes (UBA) aus Dessau, dann sind hierzu keine Fragen mehr offen. Unter dem Titel „Und sie erwärmt sich doch“ – basta – kam im Frühjahr 2013 eine amtliche Apologetik heraus, die keine Zweifel mehr daran zulässt, dass die Erderwärmung von statten geht und anthropogen, d.h. durch den Menschen verursacht ist.

Abgesehen davon, dass es verwegen erscheint, eine so komplexe Materie wie das weltweite Klimageschehen monokausal erklären zu wollen, dass der Versuch indiskutabel ist, abweichende Meinungen durch die namentliche Nennung einzelner Autoren zu diskreditieren, dass einzelne Inhalte nicht mit den neuesten Erkenntnissen des sog. Weltklimarates (Intergovernmental Panel on Climate Change – IPCC) übereinstimmen, ist es unsäglich und wissenschaftlich unredlich, einen öffentlichen Diskurs, noch bevor dieser richtig angefangen hat, für beendet zu erklären. Sehr ausführlich und die Fehler des UBA vermeidend, hat das Europäische Institut für Klima und Energie (EIKE) aus Jena im Mai 2013 die UBA-Broschüre einem Faktencheck unterworfen (http://www.eike-klima-energie.eu/uploads/media/EIKE-Faktenckeck_des_UBA_01Juni2013_02.pdf). Dabei wird u.a. darauf hingewiesen, dass schon seit 16 Jahren nicht mehr von der globalen Erwärmung ausgegangen werden kann (vgl. S. 1), im Gegenteil, dass eine globalweite Abkühlung gemessen wird und dies nicht mit dem stetig steigenden CO2 Gehalt der Atmosphäre zusammenpasst (vgl. S. 4).

Auch Extremwetterzunahmen werden (sogar unter Bezugnahme auf das IPCC) verneint. Hier verwechsele das UBA bei Flutkatastrophen auftretende größere Schäden mit angeblich höheren Pegelständen, was allein schon durch historische Hochwassermarken widerlegt wird (vgl. S. 5). Das UBA ignoriere die Rolle des CO2 für die Ernährung der Menschen, ohne dieses Gas (mit aktuell 0,04% Anteil an der Erdatmosphäre, entspricht 400 ppm = parts per million) gäbe es kein Leben. Denn CO2 ist Hauptlieferant des für den Aufbau von Biomasse notwendigen Kohlenstoffs im Zuge der Photosynthese. Wenn fachunkundige Bürgermeister eine CO2-freie Stadt anstrebten, sei dies deshalb absurd (vgl. S. 8-9).

Carl Christian von Weizsäcker hat sich bereits in 2009 zu der Frage geäußert, wer nun recht hat? „Auf beiden Seiten (den sog. „Alarmisten“ mit dem IPCC und bei den „Skeptikern“ – JG) gibt es seriöse Wissenschaftler. Aber dafür bin ich nicht der Experte. Ich stelle mich in die Schuhe derjenigen, die sagen, es gibt diesen Klimaeffekt. Das ist die pessimistischere Variante. Das Vorsichtsprinzip lässt mich sagen: Solange wir es nicht wissen, sollten wir eher die pessimistischere Variante nehmen. Ich bin durchaus skeptisch gegenüber dem, was der Mainstream behauptet. Aber ich bin kein Naturwissenschaftler und kann es nicht hinreichend beurteilen. Deshalb sage ich: Wenn der IPCC recht hat, dann finde ich als Ökonom, dass eine rationale Klimapolitik eine andere sein muss als die, die wir jetzt betreiben. Etwa, was die erneuerbaren Energiequellen angeht. Der Glaube daran trägt schon religiöse Züge. Da werden durch Lobbyinteressen finanziell gut unterfütterte Glaubenssätze propagiert“ (http://www.novo-argumente.com/magazin.php/archiv/novo99_27).

Dieser Einschätzung kann man sich auch heute noch vorbehaltlos anschließen, wobei sicherlich die Bestimmtheit – und da liegt das UBA mit seiner Broschüre voll daneben – mit der seriöse Aussagen zur globalen Erwärmung getroffen werden, weiter abnehmend und die Bandbreite der Vorhersagen zunehmend ist. Der 5. Zustandsbericht des IPCC, der für September angekündigt ist, wird dies zeigen.

3. Welchen physikalischen und wirtschaftlichen Gesetzmäßigkeiten unterliegt die Energiewende?

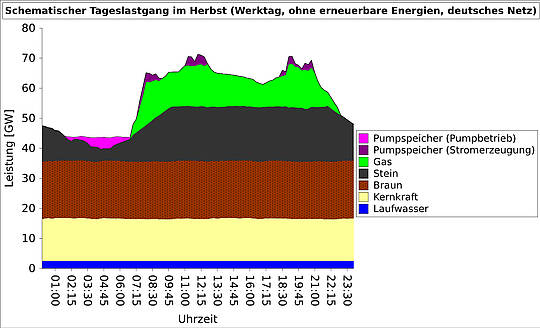

Einen „Klassiker“ hierzu hat meines Erachtens Peter Heller zu Anfang des Jahres mit seinem Aufsatz „Die Energiewende scheitert an der Physik“ verfasst (http://www.science-skeptical.de/energieerzeugung/die-energiewende-scheitert-an-der-physik/009246/). Meine mehrfach gegenüber Fachleuten aus der Energiewirtschaft geäußerte Frage, ob dies denn so (einfach) sei, wie dort beschrieben, wurde durch die Bank einschränkungslos bejaht. Dazu gehört, dass sich in einem Wechselstromnetz verbunden mit der Notwendigkeit relativ konstanter Frequenz (Norm-Frequenz in Deutschland ist 50 Hertz), Energieentnahme und Energiezufuhr stets, d.h. zu jedem Zeitpunkt ausgleichen müssen, damit es stabil bleibt. Hinzu kommt, dass man elektrischen Strom nicht speichern kann (dort S. 1), sondern hier eine Energiespeicherung erst nach Umwandlung in andere Energieformen möglich ist. So z.B. über kostspielige, mit Energieverlusten verbundene Umwege, indem man mit nicht benötigtem Strom Wasser den Berg hinauf pumpt, um es bei Bedarf durch Rohrleitungen und Turbinen-Generatoreinheiten wieder ins Tal zu leiten (daher Pumpspeicherkraftwerk) und so wieder elektrische Energie zu gewinnen (dort S. 6).

Aus drei Gründen stiftet die Energiegewinnung aus Sonne und Wind in Deutschland nur bedingt Nutzen: Zum einen ist sie nicht in der Lage die plan-, steuer- und verfügbare Stromerzeugung aus konventionellen Kohle-, Gas-, und Kernkraftwerken zu ersetzen. Daher: Wenn die Sonne nicht scheint und der Wind nicht weht, müssen diese sog. verlässlichen Kraftwerke zur Stabilisierung des Stromnetzes weiterhin bereitstehen, es müssen also Kraftwerkskapazitäten doppelt vorgehalten werden (dort S. 3). Zum anderen gibt es in Deutschland bei der Energie keinen Engpass und keine gänzlich unerschlossenen Landstriche, im Gegensatz zu Ländern wie China oder Indien mit großem Nachholbedarf und „Entwicklungshunger“. Aber wir haben, drittens, das Problem, dass für die massive weitere Integration von regenerativer Stromerzeugung auf Basis von Sonne und Wind die geeigneten Stromnetze fehlen oder vorhandene erst entsprechend ertüchtigt werden müssen: Sowohl die Übertragungsnetzbetreiber (50Hertz, Amprion, TenneT und Transnet BW) als auch die großen Energieversorger (E.ON, RWE, Vattenfall und EnBW) und die vielen hundert Stadtwerke mit ihren Verteilnetzen müssten kräftig investieren und sich entsprechend finanzieren.

Die wirtschaftlichen Auswirkungen beschreibt präzise Peter Heller: „Strom wird teurer, weil man Erzeugungskapazitäten aufbaut, die man nicht braucht. In die also niemand freiwillig investieren würde, es sei denn der Staat übernimmt das finanzielle Risiko. Nichts anderes ist das EEG und nichts anderes sind die Garantien für potentielle Betreiber von Offshore-Windparks. Er wird teurer, weil die vorhandenen Kapazitäten dadurch unwirtschaftlicher arbeiten. Er wird teurer, weil man die Vorhaltung von unwirtschaftlichen Kapazitäten für die Regelenergie subventionieren muss, um die Netzstabilität zu sichern. Er wird teurer, weil man den Betreibern volatiler Quellen auch die elektrische Energie bezahlen muss, die am Bedarf vorbei produziert wird. Er wird teurer, weil Stromspeicher weniger effizient sind, als Kraftwerke.“ (dort S. 6). Fast resignierend fügt er hinzu: „Die Energiewende bedeutet nichts anderes als steigende Preise bei gleichzeitig sinkender Versorgungssicherheit. Dauerhaft.“ (dort S. 7).

4. Was sind die Charakteristika der erneuerbaren Energien?

Die Volatilität als gemeinsames „Manko“ der erneuerbaren Energien wurde schon thematisiert. Einzige Ausnahme die Bioenergie, die sogar steuerbar produzieren kann. Ihr Problem allerdings tritt zutage, wenn man den sog. Erntefaktor vergleicht, der sich aus dem Verhältnis der durch die Anlage bereitgestellten Energie zum kumulierten Energieaufwand errechnet, der für die Bereitstellung notwendig ist. Je höher der Wert, desto effizienter die Energiequelle (siehe hierzu nurhttps://de.wikipedia.org/wiki/Erntefaktor und/oder http://www.festkoerper-kernphysik.de/erntefaktor).

Das mit Biogas betriebene Gaskraftwerk erreicht hier lediglich einen Erntefaktor von 3,5 – was auch auf den hohen Einsatz von Ressourcen für die Brennstoffbereitstellung sowie den Bau, Betrieb und Abbau des Kraftwerks hinweist (zum Vergleich: Kernkraft beginnt bei einem Erntefaktor von 75, Kohle mit 29, Erdgas hat einen Faktor von 28, Wasserkraft 36, Wind an der Küste 4, Photovoltaik (PV) auf Dächern in Süddeutschland 1,6; dabei sind bei den volatilen Kraftwerkstypen notwendige Pumpspeicher und Überkapazitäten schon erntefaktormindernd berücksichtigt).

Eine Erklärung liefert im Fall des gezielten Anbaus von Mais der große Flächenverbrauch für die durchindustrialisierte Landwirtschaft. Dabei kommt es zu ernsthaften Zielkonflikten wie „Klimaschutz vor Natur- und Vogelschutz“ oder auch „Tank vor Teller“, d.h. der Gewissensfrage, ob eine solche Verwendung angesichts der Lebensmittelknappheit weltweit verantwortbar ist (von Ulli Kulke anschaulich beschrieben in der Welt vom 7.3.2013 –http://www.welt.de/wissenschaft/umwelt/article114216742/Oeko-Strom-vertreibt-Voegel-von-deutschen-Feldern.html). Zudem sind (Mais-)Monokulturen in der Regel auch noch ökologisch problembehaftet. Anders sieht es aus, wenn Biomasse aus Rasenschnitt, Abfällen, Essensresten oder Gehölz zusammengetragen wird. Als generelles Problem bleibt aber auch hier die chronische Abhängigkeit von Subventionen bestehen, in unserem Falle von der EEG-Einspeisevergütung, im Fall der angeblich energieautarken Stadt Güssing im österreichischen Burgenland von der EU-Ziel-1-Gebietsförderkulisse. Dort musste nach Auslaufen der Förderung das auf der Verfeuerung von Holz basierende Biomassekraftwerk Insolvenz anmelden.

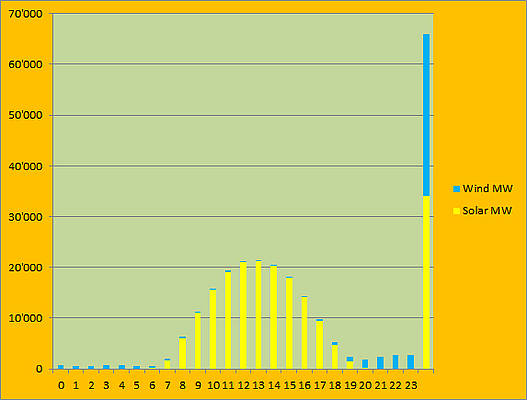

Der sehr niedrige Erntefaktor der Photovoltaik steht im krassen Gegensatz zur üppigen EEG-Förderung. Die PV-Anlagen sind damit die teuerste Stromerzeugungsmöglichkeit (siehe hierzu, wie auch zur Windkraftnutzung den sehr lesenswerten Aufsatz von Eike Roth, Chancen und Risiken der deutschen Energiewende, zu finden unter http://www.buerger-fuer-technik.de/Chancen_und_Risiken_der_deutschen_Energiewende.pdf, leider ohne Seitenangaben). Die mehr als eine Million PV-Anlagen in Deutschland haben im letzten Jahr mit einer Gesamtleistung von 28 GW (Gigawatt) 24 TWh (Terawattstunden) Strom erzeugt, die rund 23000 Windkraftwerke mit einer Gesamtleistung von 30 GW 52 TWh. Das heißt, Nennleistung unterstellt laufen die PV-Anlagen 850 Volllaststunden (gemessen an den 8760 Stunden des Jahres sind das lediglich 9,7 Prozent) und die Windkraftanlagen 1700 Volllaststunden (macht gerade mal 19,4 Prozent aus). Bei Windkraftanlagen auf See (Offshore) nehmen Eike Roth 3000 und das Fraunhofer-Institut für Windenergie und Energiesystemtechnik (IWES) im „Windenergie Report Deutschland 2012“ (http://publica.fraunhofer.de/eprints/urn:nbn:de:0011-n-2385784.pdf) für neue Anlagen sogar bis zu 4500 Volllaststunden an (entspricht 34,2 bzw. 51,3 Prozent). (Dagegen weist das IWES für Windkraftanlagen an Land (Onshore) auf S. 35 lediglich 1542 Volllaststunden aus). Zusammen genommen deckten Sonne und Wind in 2012 damit rund 13 Prozent des Stromverbrauchs ab.

Charakteristisch für Windkraft- und PV-Anlagen sind also die über den Tages- und Jahresablauf extrem schwankende und somit volatile Leistungsbereitstellung, was zur Folge hat, dass sie an Volllast gemessen im Durchschnitt 80% bzw. 90% des Jahres 2012 „stillstanden“. Bei Windkraftanlagen auf See sieht das besser aus, allerdings sind dort die Kosten höher, da der Strom vom Standort im Meer ja auch noch an Land gebracht werden und die Wind, Wasser und jedem Wetter ausgesetzte Technik ganz andere Anforderungen erfüllen muss. Aber auch hier fällt bei schwachem Wind, wie auch bei Sturm die Erzeugung auf Null. Die Stromerzeugung der Windkraftanlage, darauf weist Eike Roth hin, verhält sich proportional zur dritten Potenz der Windgeschwindigkeit: „Wenn also die Windgeschwindigkeit auf die Hälfte zurück geht, dann geht die Erzeugung … auf ein Achtel zurück! Bei einem Drittel Windgeschwindigkeit geht die Erzeugung auf ein Siebenundzwanzigstel zurück, dann ist praktisch nichts mehr da.“

Entscheidend kommt hinzu, dass enorme Anstrengungen im Ausbau von Übertragungs- und Verteilnetzen sowie hinsichtlich von Speichermöglichkeiten unternommen werden müssten. Einem forcierten Ausbau der erneuerbaren Energien sind deshalb finanzielle und planerische Grenzen gesetzt. Da hilft es auch nicht, auf technische Neuerungen zu hoffen (beispielsweise Farbstoffsolarzellen, „organische“ oder eine „konzentrierte“ PV).

Seit dem Verfall der Preise für Solarmodule besteht die ernsthafte Gefahr einer „Flucht in die Eigenversorgung“, durch die, ähnlich wie bei der EEG-Umlage, der Mehrheit der Strombezieher Kosten belastet werden (siehe die Welt vom 21.3.2013). Verstärkt wird dieser Effekt durch ein Förderprogramm der staatlichen KfW-Bankengruppe, das eine noch unausgereifte und unwirtschaftliche Batteriespeichertechnik für PV-Anlagen (einschließlich einem Tilgungszuschuss von 30 Prozent) zinsgünstig finanziert.

Charakteristisch für die erneuerbaren Energien ist auch – das folgt aus den niedrigeren Erntefaktoren – ein höher Flächenbedarf bei (unterstellt) identischer Leistungserbringung. Während dabei allein schon aufgrund der geo- und topographischen Bedingungen die Nutzung von Wasserkraft (und Pumpspeicherkraftwerken) in Deutschland eingeschränkt ist, liegen im Falle der Windkraft umfassende Expansionspläne auf dem Tisch. In Hessen werden Vorranggebiete diskutiert, die je nach politischer Couleur (schwarz-gelbe Landesregierung oder rot-grün dominierter Regionalverband) Platz zum Bau von 2300 bis 5360 Windkraftanlagen hätten, je nachdem ob man den Mindestabstand zur Wohnbebauung auf 1000 oder 750 Meter und die erforderliche Windgeschwindigkeit in 140 Meter Höhe auf 5,75 Meter oder 5,5 Meter pro Sekunde festlegt (http://www.faz.net/aktuell/rhein-main/energiewende-rhein-main-region-als-grosser-windpark-12452549.html).

Das grün-rot regierte Baden-Württemberg will bis zum Jahr 2020 auf einen Bestand von 1200 Windkraftanlagen kommen, von 400 am Ende 2012. Dabei stehen nicht nur Belange des Naturschutzes und mögliche Gefährdungen für Mensch und Tier im Weg, auch die im Südwesten weit unterdurchschnittliche Volllaststundenzahl schürt Zweifel an der Wirtschaftlichkeit des gesamten Unterfangens, die ohne die EEG-Einspeisevergütung (in Höhe von gegenwärtig 9,27 Cent/kWh) sowieso nicht gegeben ist (Angaben im Internet zu Volllaststunden in Baden-Württemberg variieren von 1155 bis 1177 (entspricht 13,4 Prozent)). Die räumliche Verteilung der Windkraftanlagen in Deutschland dokumentiert, dass es eben Standorte gibt, die windhöffiger sind (siehe bei Carsten Ender, Windenergienutzung in Deutschland. Stand 31.12.2012, die Abbildungen auf den S. 33 und 35 – http://www.dewi.de/dewi/fileadmin/pdf/publications/Magazin_42/06.pdf). Entsprechend bekommen potenzielle Investoren hier zu Recht kräftigen „Gegenwind zu spüren“ (so titelt der Staatsanzeiger vom 26.7.2013). Auch auf immer größere Nabenhöhen (Richtung 140 Meter) und Rotordurchmesser (120 Meter) zu setzen, ändert nichts an den Fakten. Das IWES verweist im Windenergie Report hierzu auf das „Square-Cube-Law“, demzufolge bei noch größeren Rotorblättern das Material an seine Grenzen stößt (S. 86).

Erneuerbare Energien sind auf Speichermöglichkeiten angewiesen, nach Eike Roth die „Achillesferse“ der Energiewende. Vorstellbar sind Pumpspeicher, die allerdings nur kurzfristig wirken, und in Deutschland nicht in ausreichender Anzahl geschaffen werden können. In dieser Hinsicht auf die norwegische Karte zu setzen erscheint illusorisch. Bei einer Reihe von Technologien (auch batteriegebundenen) ist die Reife noch nicht absehbar und vor allem die Wirtschaftlichkeit nicht gegeben. Am weitesten ist das „Power-to-Gas“-Verfahren, bei dem mit überschüssigem Wind- und Sonnenstrom durch Elektrolyse Wasserstoff erzeugt und anschließend zusammen mit Kohlendioxid in Methan umgewandelt wird. Dieses synthetische Erdgas lässt sich quasi verlustfrei im Erdgasnetz mit seinem immensen Volumen speichern und bei Bedarf rückverstromen. Es kann aber auch für den Antrieb von Erdgasautos genutzt werden – eine Option, die Audi nutzt (siehe hierzu http://www.zsw-bw.de/uploads/media/pi09-2013-ZSW-Einweihung6MWPtGAnlage.pdf).

Wie komplex unter den heutigen Randbedingungen die Steuerung der Übertragungsnetze geworden ist, zeigt auch folgender Umstand: Gab es früher kaum eine Handvoll Regelungseingriffe, so waren letztes Jahr schon über tausend notwendig. Damit wächst die Gefahr eines großflächigen und länger anhaltenden Netzzusammenbruchs, sie wird von Tag zu Tag wahrscheinlicher. Nur durch ein geschicktes Netzmanagement konnte der „Blackout“ bisher vermieden werden.

Eindeutige Schlussfolgerung: Bevor nicht klar ist, dass und wie man vernünftig speichern kann und welche Netze man wo braucht, ist der weitere Ausbau erneuerbarer Energien in Deutschland schlicht unsinnig.

5. Strickmuster und Auswirkungen des Erneuerbaren Energien Gesetzes (EEG)?

Das EEG trat zum 1. April 2000 zu Zeiten einer rot-grünen Bundesregierung in Kraft. Es löste das Stromeinspeisungsgesetz – mit dem ersten Einspeise- und Vergütungssystem zugunsten regenerativen Stroms – ab, das seit dem 1. Januar 1991 gültig war. Als Väter des ganze fünf Paragraphen starken „Gesetzes über die Einspeisung von Strom aus erneuerbaren Energien in das öffentliche Netz“ werden Matthias Engelsberger (CSU), Wolfgang Daniels (Grüne) und – als weitere Person – auch Hermann Scheer (SPD) kolportiert. Sicher ist, dass der entsprechende Gesetzesentwurf von der CDU/CSU-Fraktion eingebracht und u.a. von Helmut Kohl und dem FDP-Politiker Helmut Haussmann (dem damaligen Bundeswirtschaftsminister) unterzeichnet wurde. Wenn man so will, eine schwarz-rot-grüne Erfindung, die knapp 10 Jahre später – bei Mitwirkung von Solarunternehmern am Gesetzesvorhaben – richtig „vergoldet“ wurde.

Das Markenzeichen des an die Bedingungen im liberalisierten Strommarkt angepassten und erheblich erweiterten Erneuerbaren Energien Gesetzes – zuletzt geändert am 20.12.2012, mit zwischenzeitlich 66 Paragraphen und fünf Anhängen – sind der Einspeisevorrang für Erneuerbare, die 20 Jahre lange Garantiezeit sowie die, trotz verschiedener Anpassungen nach unten (sog. Degressionen) immer noch stattlichen Einspeisevergütungen. Mit der letzten Novellierung wurde – zum ersten Mal überhaupt – für die Förderung des weiteren Ausbaus von PV-Anlagen bei 52 GW eine Deckelung verfügt.

Der erste Erfahrungsbericht vom 28. Juni 2002 bestätigte (natürlich) den Erfolg des EEG: den gestiegenen und weiter steigenden Anteil der erneuerbaren Energien am Stromverbrauch, Umsatzrekorde der Branche mit zu diesem Zeitpunkt neu entstandenen 120.000 Arbeitsplätzen und vielen Millionen Tonnen vermiedenen Treibhausgasen. Der Erste Monitoring Bericht „Energie der Zukunft“ der Bundesministerien für Umwelt und Wirtschaft, Stand Dezember 2012, (lesenswert, nicht nur wegen des Glossars am Ende des Werkes – http://www.bmwi.de/BMWi/Redaktion/PDF/Publikationen/erster-monitoring-bericht-energie-der-zukunft,property=pdf,bereich=bmwi2012,sprache=de,rwb=true.pdf), geht ebenfalls auf die Beschäftigungseffekte ein. Dabei wird für die Jahre 2009 und 2010 von einer Netto-Beschäftigung von 70.000 bis 90.000 Arbeitsplätzen durch den Ausbau erneuerbarer Energien ausgegangen, zur Wirkung der in den Jahren 2011 und 2012 verabschiedeten Maßnahmen lägen noch kaum Daten vor (siehe S. 107).

Im Jahre 2005 hatte der damalige Bundesumweltminister Sigmar Gabriel bei der Novellierung des EEG, gestützt auf ein Gutachten, noch von 400.000 Arbeitsplätzen bis 2020 gesprochen. Berücksichtigt man die seit 2011 eingetretenen Insolvenzen in der PV-Branche und die offensichtlichen Schwierigkeiten im „Windkanal“, wird klar, dass die optimistischen Annahmen blauäugig und die frühen Warnungen zur angeblichen Mär von der Job-Maschine richtig waren, u.a. von Carl Christian von Weizsäcker (siehe oben S. 2-3) oder dem Rheinisch-Westfälischen Institut für Wirtschaftsforschung (RWI), das schon im Jahre 2004 von bestenfalls kurzfristigen, jedoch nicht nachhaltigen, am Ende sogar negativen Effekten auf die Beschäftigung sprach.

Das EEG lädt der deutschen Volkswirtschaft zudem immense finanzielle Lasten auf: nach Bundesumweltminister Peter Altmaier, der damit am 28. Januar d. J. seinen (vergeblichen) Vorstoß mit der Strompreissicherung oder -bremse begründete, eine Billion, das sind 1.000 Mrd. €. Dass selbst Experten diese Dimension lange Zeit verborgen blieb, erklärt sich vielleicht mit der verbreiteten Interessengebundenheit, aber auch damit, dass die ganze Übung ja außerhalb des Bundeshaushalts allein über Strompreisanpassungen abläuft. Prof. Hans-Werner Sinn vom ifo Institut in München warnte im Juli 2011: „Die 17 Mrd., die das EEG die Verbraucher allein in diesem Jahr kostet, sind anderswo Einkommen, zu einem erheblichen Teil allerdings in China, denn von dort kommen zwei Drittel der Sonnenpaneelen und sicherlich auch ein großer Teil der Windräder.“ Hinzu kommen weitere Umverteilungseffekte – sozial bedenklich von unten nach oben, wie auch geographisch von der Mitte (Nordrhein-Westfalen) in den Norden (Schleswig-Holstein/Niedersachsen) und Süden (Bayern). Roland Tichy hat das in einem Kommentar in der Wirtschaftswoche am 23.2.2013 treffend mit „Die große Verteile“ umschrieben: „Von den Bundesländern ist es so vor allem Nordrhein-Westfalen, das ausblutet. An Ruhr und Rhein erstreckt sich die größte Stadtregion Europas. Die Reste der Montanindustrie – Stromkonzerne, Kraftwerke, Zulieferer verlieren ihre Existenz.“ Die RWE aus Essen könnte umziehen, aber was machen die vielen Stadtwerke, die ebenso die Energiewende verkraften müssen? Verluste “fressen” deren Eigenkapital auf. Trifft dies ein Stadtwerk in einer klammen Kommune, auch hier ist NRW führend, gehen die Lichter aus und Arbeitsplätze und Wertschöpfung unwiederbringlich verloren.

In Bezug auf diese, fast mit Händen greifbaren Verteilungswirkungen erstaunt die weit verbreitete Ahnungslosigkeit: So kommt beispielsweise im 2013 erschienen Buch von Hans-Ulrich Wehler, Die neue Umverteilung – Soziale Ungleichheit in Deutschland, Energiepolitik/das EEG überhaupt nicht vor. Dass auch im vom Bundesministerium für Arbeit und Soziales im März d. J. unter dem Titel „Lebenslagen in Deutschland“ herausgegebenen vierten Armuts- und Reichtumsbericht der Bundesregierung nichts in dieser Hinsicht zu finden ist, passt ins Bild. Allgemein wird konstatiert, dass durch die Ungleichheit das Gerechtigkeitsempfinden verletzt werde. Mit Eike Roth kann man fragen, inwieweit sich dieses Gefühl verstärkt, wenn mit zunehmender Tendenz „ … die relativ finanzarmen Mieter … Hausbesitzern den Ausbau der Solarzellen …, die kleinen Leute den Grundbesitzern die Pacht für das Aufstellen von Windenergieanlagen … zahlen, … soviel, dass diese … auch noch dicke Gewinne einstreichen können, ohne irgend ein Risiko dabei zu haben.“

Die kräftigen „Wecksignale“ sollten beachtet und richtig gedeutet, vom weitverbreiteten Wunschdenken beim Prognostizieren des Anstiegs der EEG-Umlage in Wissenschaft und Politik endlich Abstand genommen werden. Rudolf Kipp belegt dies eindrücklich (siehe www.science-skeptical.de/blog/energiewende-immer-teurer) und zeigt, dass seit 2009 die EEG-Umlage regelrecht explodiert ist (von 1,13 Cent/kWh auf 2.05 in 2010, 3,53 in 2011, 3,59 in 2012 und gegenwärtig 5,28 Cent/kWh netto, d.h. noch ohne 19% Mehrwertsteuer).

Den vier Übertragungsnetzbetreibern hat man die Verpflichtung auferlegt, die EEG-Umlage bis zum 15. Oktober eines Kalenderjahres für das folgende Kalenderjahr zu ermitteln und zu veröffentlichen (siehe hierzu http://www.eeg-kwk.net/de/EEG-Umlage.htm). Das Aufkommen aus der EEG-Umlage betrug in 2012 14,1 Mrd. €, für 2013 sind 20,4 Mrd. € eingerechnet, Tendenz weiter steigend.

Auch in Bezug auf den Klimaschutz kehrt Ernüchterung ein, nachdem der CO2-Ausstoss in Deutschland seit 2012 wieder steigt. Wie von Prof. Sinn vorhergesagt, wird „kein Gramm CO2 eingespart“, da sich das EEG und der Handel mit Verschmutzungsrechten im Grunde genommen ausschließen. Nach Einführung der Emissionszertifikate auf Ebene der Europäischen Union im Jahre 2005 wollte man vom EEG nicht lassen, da es sich als gute Einkommensquelle erwies. Gleiches trifft auch auf die Verheißungen zu, mit dem EEG würden Innovationen angestoßen. Prof. Joachim Weimann von der Universität Magdeburg hat am 31.1.2011 in der FAZ nachdrücklich davor gewarnt, dass die Subvention nicht in die Entwicklung von Zukunftstechnik, sondern ausschließlich in die Produktion gehe. Die Turbulenzen in der deutschen PV-Branche sind dafür ein eindrücklicher Beweis. Gut ist, dass nicht auch noch der Streit mit China um Schutzzölle eskaliert ist, sonst hätten wir die Zeche doppelt und dreifach gezahlt.

Im gemeinsamen Monitoring Bericht von Wirtschafts- und Umweltministerium wird auf die preisdämpfenden Wirkungen der erneuerbaren Energien an der Strombörse verwiesen (siehe S. 40). Die verringerte Nachfrage nach konventionellem Strom verdrängt entsprechend der Merit-Order (Einsatzreihenfolge von Kraftwerken nach deren kurzfristigen Grenzkosten) Kraftwerke mit höheren variablen Kosten und sorgt dafür, dass Kraftwerke mit vergleichsweise niedrigeren variablen Kosten preissetzend werden. Dabei reicht in 2011 die Bandbreite für die dadurch erzielte Absenkung des Börsenstrompreises von 0,3 bis 1,0 Cent/kWh.

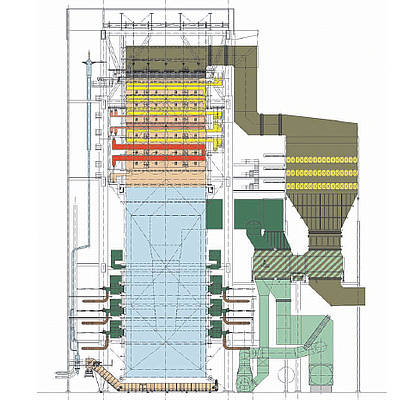

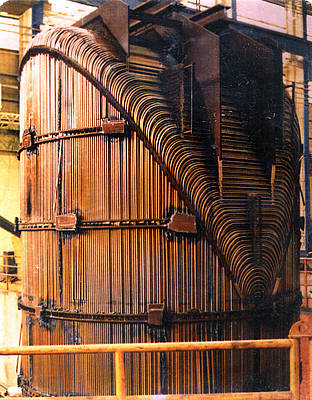

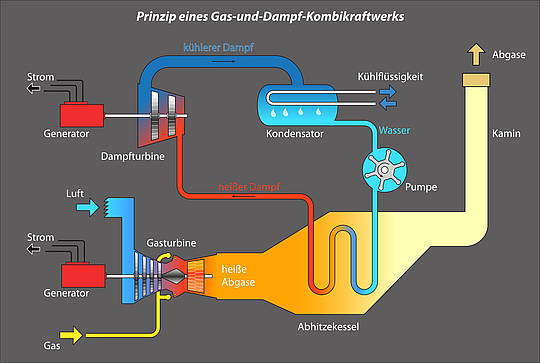

In der Praxis führt dies zunehmend zur vorläufigen Stilllegung oder gar Nichtinbetriebnahme von hochmodernen Gas- und Dampfturbinen-Kraftwerken (GuD), die aber als Produzenten von Regelenergie zur Stabilisierung des Stromnetzes dringend gebraucht werden. Entsprechende Ankündigungen liegen von allen vier großen Energieversorgern, ebenso von Stadtwerken vor. So gibt es massive wirtschaftliche Probleme beim Stadtwerkeverbund „Trianel“ bezüglich dem von 32 Stadtwerken (bei insgesamt 54 über das ganze Bundesgebiet verteilten kommunalen Gesellschaftern) gemeinsam geschulterten Steinkohlekraftwerk in Lünen, das unter den gegenwärtigen Rahmenbedingungen nach voller Inbetriebnahme (zur Zeit läuft der Probebetrieb) einen jährlichen Verlust von 100 Mio. € machen wird (siehe FAZ vom 17.7.2013). Der Bundesnetzagentur sind aufgrund einer Ende letzten Jahres beschlossenen Neuregelung Stilllegungen mindestens 12 Monate im Voraus anzukündigen, auch vorläufige Abschaltungen müssen angezeigt werden. Ist ein Kraftwerk „systemrelevant“ kann die Bundesnetzagentur anordnen, dass es zwei Jahre lang weiterbetrieben werden muss.

Vermutlich auch hieran denkt Eike Roth, wenn er als „Todsünde“ der Energiewende das Auseinanderlaufen von betriebs- und volkswirtschaftlicher Optimierung bezeichnet. Von Kriegen abgesehen, sei es das Schlimmste, was Politiker tun könnten, wenn Unternehmen, die sich betriebswirtschaftlich richtig verhalten, aufgrund fehlerhafter Rahmenbedingungen der Volkswirtschaft Schaden zufügen.

6. Wie unabhängig kann Deutschland agieren und eine Vorreiterrolle einnehmen?

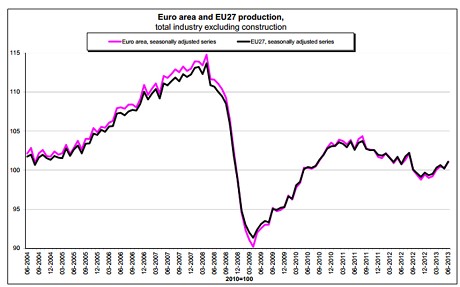

Unsere Volkswirtschaft ist stark in den internationalen Wettbewerb eingebunden. Eine wichtige Größe, neben Qualität und Markennamen ist der Preis deutscher Produkte, der entscheidend von der Arbeitsproduktivität beeinflusst wird. Die Energiekosten spielten dabei in jüngster Vergangenheit je nach Branche zumeist nur eine untergeordnete Rolle, auch weil es im EEG Ausnahme- und Härtefallregelungen für stromintensive Unternehmen und den beschriebenen Effekt der Börsenpreissenkung gibt (siehe zum Stand März 2011: http://www.bmu.de/fileadmin/bmu-import/files/pdfs/allgemein/application/pdf/eeg_stromkosten_bf.pdf). Dies ändert sich zunehmend und nicht nur beschränkt auf große Industrien, es wirkt sich inzwischen auf die gesamte Volkswirtschaft aus. Die Schere bei den Energiepreisen öffnet sich nicht nur, weil in den USA die Energie billiger wird, sondern weil gerade und vor allem in Deutschland die Energiekosten durch das EEG immer weiter “künstlich” in die Höhe getrieben werden. So warnte jüngst (am 29.7.2013 in der Mittelbayerischen Zeitung) der bayerische Wirtschaftsminister Martin Zeil von der FDP: „Wenn unsere Grundstoffindustrien von heute auf morgen 5,3 Cent EEG-Umlage pro Kilowattstunde Strom bezahlen müssten – das ist mehr als der gesamte Industriestrompreis in den USA –, dann wäre der Industriestandort Bayern schnell am Ende“. Er spielt damit insbesondere auf das am 6. März d. J. eröffnete förmliche Beihilfeverfahren durch die Europäische Kommission an, bei dem es um die Prüfung der Befreiung zugunsten energieintensiver Unternehmen geht und dessen Ergebnis nicht nur eine Signalwirkung zugeschrieben wird.

Wir müssen schauen, was machen unsere Nachbarn in Europa (z.B. Polen, das auf Kohle setzt) und die USA? Dort laufen beispielsweise Steuermäßigungen für Windkraftanlagen Ende 2013 definitiv aus; das sog. Fracking zur Gasgewinnung wird verstärkt genutzt, die freiwerdende Kohle exportiert (und damit auch die CO2-Emissionen im eigenen Land reduziert). Übrigens werden auch in Großbritannien und Polen riesige Vorkommen des unkonventionellen Schiefergases vermutet. China und Indien gehen aufgrund ihrer schieren Größe unbeirrt ihren eigenen Weg, ebenso Russland. Bis auf die Schweiz setzen dabei alle, sogar das arg gebeutelte Japan auf die weitere friedliche Nutzung der Kernenergie. Die Schweiz wendet sich, ebenso wie Deutschland von der Kernenergienutzung ab, allerdings in gemächlichem Tempo, Optionen offen haltend, keineswegs so überhastet und kopflos wie wir mit unserer Energiewende. Reine Gefolgschaft haben wir fast keine mehr.

Das EEG ist von den meisten EU-Mitgliedstaaten übernommen worden, jedoch selten eins zu eins und bei weitem nicht in dieser Umfänglichkeit. Statt des Einspeise- gibt es auch sogenannte Quotenmodelle. Österreich beispielsweise deckelt die Subvention auf maximal 27 Mio. € im Jahr, gibt „nur“ eine 13jährige Garantiezeit und wird in 2015 auf ein Quotenmodell umstellen. Italien, Spanien, Bulgarien, Griechenland und Tschechien haben zwischenzeitlich eine opulente Förderung zurückgeschnitten, in Prag läuft wegen der Solarsubventionen sogar eine von der nationalen Regulierungsbehörde angestrengte Strafanzeige gegen Unbekannt.

Wird an einzelnen Tagen im deutschen Stromnetz zu viel Strom erzeugt, erhält das Ganze automatisch ebenfalls eine internationale Dimension (siehe Handelsblatt vom 16.4.2013). Denn dann gehen überschüssige Strommengen aufgrund des paneuropäisch-technischen Netzverbundes notgedrungen unter anderem ins Nachbarland Polen, das sich die Übernahme zudem bezahlen lässt. Da dies auch die Sicherheit des dortigen Stromnetzes – wie in anderen europäischen Staaten – gefährdet, werden mittlerweile in Ländern wie Tschechien und Polen Überlegungen in Richtung technischer Stromsperren angestellt.

Das wohlwollende Interesse, mit dem das Ausland den deutschen Sonderweg in der Energiepolitik zunächst begleitet hat, ist verflogen. Die enge wirtschaftliche Verflechtung der deutschen Volkswirtschaft in Europa und der ganzen Welt gemahnt uns daran, die Energiekosten nicht aus dem Ruder laufen zu lassen.

7. Welche Weichenstellungen sind nach der Bundestagswahl am 22. September dringend geboten?

Wichtig ist zunächst einmal, die grassierende Panikmache zu beenden, denn „Angst essen Seele auf“ (Rainer Werner Fassbinder). Es muss ein Meinungsklima geben, in dem alle Fragen der Energiepolitik offen und vorbehaltlos diskutiert werden können. Es darf nicht sein, dass erst bei der Pensionierung von Spitzenbeamten, wie jüngst bei der Verabschiedung von Werner Ressing (einem studierten Ingenieur für Maschinenbau und Energietechnik) aus dem Bundeswirtschaftsministerium, die Stunde der Wahrheit schlägt: „Man baue mit den Erneuerbaren Energien Zigtausende Kilowatt Leistung auf, die nicht immer Kilowattstunden liefern. …. 80 Millionen Deutsche alimentieren seit 20 Jahren und für 20 Jahre eine Million Betreiber von EE-Anlagen. … Wo gibt es das in einem marktwirtschaftlichen System?“ (siehe hierzu die Wirtschaftswoche vom 6.8.2013).

Man sollte den Mut haben, das EEG abzuschaffen, die bereits aufgelaufenen Lasten zu begrenzen. Die Zeit für Halbherzigkeiten (wie der Vorschlag von Hanno Kempermann vom DIW oder auch die Altmaiersche Strompreisbremse) ist abgelaufen. Systematisch und ausgesprochen ehrenwert ist der Verfahrensvorschlag des Bundesumweltministers zur Neuregelung des EEG. Er sollte aber grundsätzliche Fragestellung nicht ausklammern. Auch sind die bisher im dafür vorgesehenen EEG-Dialog angestellten Überlegungen viel zu nahe am Status quo angesiedelt (zum BMU-Papierhttp://www.bmu.de/fileadmin/bmu-import/files/pdfs/allgemein/application/pdf/verfahrensvorschlag_eeg-reform_2012_bf.pdf und zum EEG-Dialoghttp://www.bmu.de/themen/klima-energie/energiewende/eeg-reform/1-eeg-dialogforum/). Auf dem Tisch liegende Vorschläge zu einem neuen Marktdesign, wie vom Verband kommunaler Unternehmen (VKU) oder auch die „EIKE Energiewende light“, selbst das AfD Energie-Programm und andere sind aufzunehmen und auf ihre Nützlichkeit hin sorgfältig abzuklopfen.

Dazu gehört auch die Antwort auf die hochsensible Frage, ob stillgelegte Kernkraftwerke nicht wieder ans Netz bzw. die noch nicht stillgelegten länger am Netz bleiben sollten? Auch hier gilt, dass Angst ein falscher Ratgeber sein kann. Auf jeden Fall ist im internationalen Kontext die deutsche Beteiligung an der Erforschung neuerer Kernkraftwerkstypen (der vierten Generation), wie beispielsweise dem Dual-Fluid-Reaktor, sicherzustellen. Wer hier mauert, verspielt wesentliche Zukunftsoptionen.

Es sollten zudem konkrete Anpassungsstrategien an den Klimawandel entwickelt und die Möglichkeit in Betracht gezogen werden, dass dieser maßgeblich natürliche Ursachen haben könnte. Davon unabhängig sind im internationalen Rahmen alle Möglichkeiten der Effizienzsteigerung und Energieeinsparung entlang des Neuentwurfs der Energie-Klima-Landkarte der IEA auszuschöpfen (http://www.worldenergyoutlook.org/publications/weo-2013/).

Die verbliebenen Unternehmen aus der PV- und Windkraftbranche (einschließlich des „Power-to-Gas“-Verfahrens) sind weiterhin in ihren Anstrengungen zu unterstützen, den Export in jene Länder kräftig anzukurbeln, die für die entsprechende Anwendung die günstigsten, das heißt auch günstigere Bedingungen als in Deutschland aufweisen (siehehttp://www.exportinitiative.bmwi.de/EEE/Navigation/downloads.html).

Vor allem sollte Deutschland keine kostspieligen Alleingänge mehr unternehmen. Dazu gehört, sich von der althergebrachten Formel zu verabschieden, „am deutschen Wesen, könne/solle die Welt genesen.“ Alles in allem geht es darum, planwirtschaftliche Experimente im Energiesektor zu beenden und zu einer langfristig angelegten, stärker ordnungspolitischen Variante zurückzufinden, die den Trias der Energiepolitik aus Sicherheit, Wirtschaftlichkeit und Umweltverträglichkeit dauerhaft gewährleisten kann.

Jürgen Gneveckow ist studierter Wirtschaftswissenschaftler und aktiver Kommunalpolitiker (CDU)

Mit Dank übernommen von Science Sceptical hier