Europa zieht den Stecker aus seiner grünen Zukunft

Bild rechts: Solarpaneele in Spanien, wo 50000 Unternehmer von Solarpaneelen vor einem finanziellen Desaster stehen, nachdem die spanische Regierung Subventionen gekürzt hatte. Quelle: AFP

Langsam, aber immer mehr wacht Europa auf in Bezug auf eine Krise grüner Energie; einem ökonomischen und politischen Debakel, das vollständig selbst verschuldet ist.

Die Mainstream-Medien, die gewöhnlich den Schub der Erneuerbaren enthusiastisch befeuern, beginnen ebenfalls, sich zu besinnen. Immer mehr Risse tun sich auf, und viele Zeitungen kehren zu der ihnen zukommenden Rolle als vierte Gewalt zurück, die die Fallen des Glücksspiels grüner Energie aufzeigen und ihre Seiten für gründliche Analysen und Debatten öffnen [da ist die „Süddeutsche“ aber noch Lichtjahre von entfernt! A. d. Übers.]. Heute sind die europäischen Medien angefüllt mit Nachrichten und Kommentaren über die Probleme einer schlecht durchgeführten Strategie, die zunehmend wackelig und unsicher wird. [Das gilt aber wohl nur für alle Länder außer Deutschland. Was kann man denn da bloß machen?! Siehe auch meine Bemerkung am Ende! A. d. Übers.]

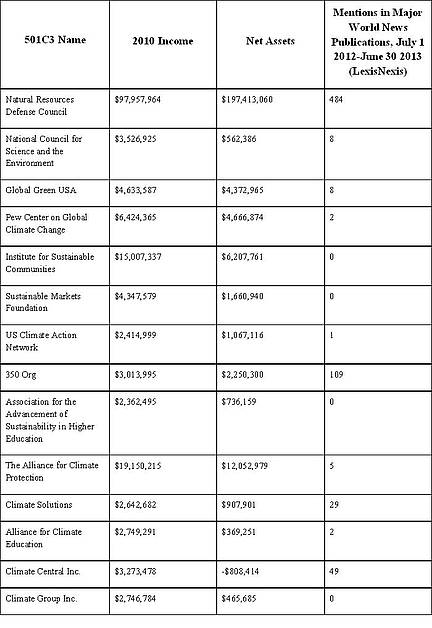

In einer Studie der britischen PR-Beratungsgesellschaft CCGroup wurden 138 Artikel über Erneuerbare analysiert, die während des Julis letzten Jahres in den fünf größten britischen nationalen Zeitungen veröffentlicht worden waren: The Sun, The Times, The Daily Telegraph, Daily Mail and Daily Mirror. Alle zusammen erscheinen täglich mit einer Auflage von etwa 6,5 Millionen.

Die Studie kam zu dem Ergebnis: „Die Analyse enthüllte eine Anzahl von Trends in der Berichterstattung über Erneuerbare Energien. Erstens und am wichtigsten, die Temperatur der Gefühle der Medien hinsichtlich der Erneuerbaren ist kalt. Mehr als 51 Prozent der 138 analysierten Artikel waren in ihrem Tenor entweder negativ oder sehr negativ bzgl. dieser Industrie“.

Mehr als 80 Prozent der Artikel erschienen unter fetten Schlagzeilen in den Zeitungen The Times, The Daily Telegraph und The Daily Mail, heißt es in der Studie; und weiter: „aber 55% dieser Artikel waren entweder negativ oder sehr negativ über die Industrie“.

Der Bloomberg New Energy Finance zufolge haben die EU-Mitgliedsstaaten seit dem Jahr 2005 etwa 600 Milliarden Euro in Projekte erneuerbarer Energie gesteckt. Die grüne Energiewende in Deutschland allein könnte die Verbraucher bis zum Jahr 2030 1 Billion Euro kosten, hat die Regierung [in Gestalt von Peter Altmaier! A. d. Übers.] gewarnt

Diese Hunderte Milliarden werden von gewöhnlichen Familien sowie kleinen und mittleren Unternehmen gezahlt. Es ist unzweifelhaft eine der größten Transfers von Wohlstand von den Armen zu den Reichen in der jüngeren europäischen Geschichte. Steigende Stromkosten dämpfen die Kauflust der Verbraucher, und das ist Gift für einen Kontinent, der mit einer ernsten ökonomischen und finanziellen Krise kämpft.

Der Bund der Energieverbraucher. e.V. in Deutschland schätzt, dass bis zu 800000 Deutsche von der Stromversorgung abgeschnitten worden sind, weil sie ihre Stromrechnungen nicht mehr zahlen konnten. Darunter waren einem Bericht des Spiegels zufolge 200000 Langzeitarbeitslose.

Der Autor Charles Lane von der Washington Post hat beobachtet: „Es ist eine Sache, den Arbeitsplatz zu verlieren, weil eine konkurrierende Firma eine größere Mausefalle entwickelt hat; es ist aber juristisch eine ganz andere Sache, ihn zu verlieren, weil ein Mitbewerber der Regierung gesagt hat, ihn zu streichen“.

Vor zwei Wochen hat die tschechische Regierung beschlossen, zum Ende dieses Jahres sämtliche Subventionen für Projekte erneuerbarer Energie zu stoppen. „Der Grund für diese Überarbeitung der Gesetze ist die steigende finanzielle Last für die Stromverbraucher“, sagte Premierminister Jiri Rusnok. „Sie bedroht die Wettbewerbsfähigkeit unserer Industrie und steigert die Unsicherheit der Verbraucher hinsichtlich der Energiepreise“. Während der vergangenen Jahre haben fast alle EU-Staaten ebenfalls den Prozess begonnen, zurückzurudern und grüne Subventionen zu kürzen.

Spanien ist ein besonders warnendes Beispiel. Durch das Versagen bei der Kontrolle der Kosten garantierter Subventionen steht das Land mit 126 Milliarden Euro bei den Investoren in erneuerbare Energien in der Kreide.

Inzwischen hat die spanische Regierung diese Subventionen drastisch gekürzt, sogar rückwirkend, und über 50000 Solarunternehmer stehen vor einer finanziellen Katastrophe und dem Bankrott.

Deutschland jedoch ist die Nation, die die Agenda der Erneuerbaren am weitesten vorangetrieben hat und kämpft auch am stärksten mit den unbeabsichtigten Schäden der sog. Energiewende [das Wort steht so kursiv gesetzt auch im Original, auch noch in folgenden Abschnitten. In diesen Fällen habe ich die Kursiv-Schreibweise übernommen. A. d. Übers.].

Die Abgaben für erneuerbare Energie in Deutschland, mit denen die Erzeugung grüner Energie subventioniert wird, sind innerhalb nur eines Jahres von 14 Milliarden Euro auf 20 Milliarden Euro gestiegen, und zwar als Folge des ungebremsten Ausbaus von Wind- und Solarenergieanlagen. Seit Einführung der Abgabe im Jahr 2000 haben sich die Stromrechnungen deutscher Verbraucher verdoppelt.

Deutsche Haushalte werden allein in diesem Jahr einen Aufpreis von 7,2 Milliarden Euro zahlen. Zusätzlich werden die Verbraucher durch indirekte Kosten belastet, weil Industrie, Handel und Kommerz die steigenden Energiepreise für ihre Produkte an die Verbraucher weiterreichen. Und weil die Subventionen für grüne Energie 20 Jahre lang garantiert sind, besteht die reale Gefahr, dass diese Kosten noch exorbitant weiter steigen, wenn der Zubau weitergeht. Energierechnungen schießen durch die Decke, die Energiearmut nimmt zu, und die Energiepolitik bzgl. der Erneuerbaren steht vor einem Rückschlag. Was aber noch mehr ins Gewicht fällt – die Regierungen in Europa machen sich zunehmend Sorgen über die Bedrohung für die industrielle Basis.

In Deutschland zahlt man die höchsten Strompreise Europas mit einem mittleren Preis von 26,8 Cent pro Kilowattstunde. Kein Wunder, dass Kanzlerin Angela Merkel davor gewarnt hat, dass die rapide Ausweitung von Programmen bzgl. grüner Energie den deutschen Wettbewerbsvorteil in der globalen Wirtschaft schwächt.

Auch die EU fährt ihre erneuerbare Agenda still und heimlich zurück, weil die EU-Führer inzwischen erkennen, dass dadurch im gesamten Kontinent die Energiepreise gestiegen sind. Auf ihrem Gipfel in Brüssel im Mai haben sie ihre Absicht bekundet, das Thema bezahlbare Energie höher zu stellen als die Reduktion von Treibhausgasen.

Von diesem EU-Gipfel ging auch das Signal aus, dass man die zurückgehende Wettbewerbsfähigkeit aufzuhalten gedenkt und die Entwicklung billiger Energie, darunter Schiefergas, zu unterstützen, während Subventionen für grüne Energie gekürzt werden.

Allerdings sind die Umweltminister der EU alarmiert über das anvisierte Zurückfahren. Sie trachten danach, die Ausbeutung der EU-Schieferreserven zu verhindern, indem sie EU-weite Hindernisse einführen.

Bis vor Kurzem hat sich Europa als der globale Anführer hinsichtlich Klimaschutz und erneuerbare Energie geriert, wobei Deutschland an erster Stelle stand mit ambitionierten Zielen und großzügigen Subventionen, die Solar- und Windenergie enorm befeuert haben.

Über die Hälfte aller in der Welt stationierten Solarpaneele steht in Deutschland. Am 6. Juni erreichte die Erzeugung von Solarstrom in Deutschland den neuen Rekord von 23,4 Gigawatt, was die gesamte Spitzenlast des Landes zu 40% gedeckt hat. Aber um zu verstehen, warum dieser Rekord ziemlich bedeutungslos ist, betrachte man das Vorbeischrammen am Netzzusammenbruch im vergangenen Winter. Viele Wochen lang in den Monaten Dezember und Januar haben die 1,1 Millionen Solarsysteme in Deutschland fast keinen Strom erzeugt. Die meiste Zeit über haben die Solarpaneele in diesen Monaten bei bedecktem Himmel die Stromerzeugung mehr oder weniger eingestellt. Um Blackouts zu verhindern, mussten die Netzbetreiber Kernkraftstrom aus Frankreich und der Tschechischen Republik importieren sowie von einem alten, mit Öl befeuerten Kraftwerk in Österreich.

Die Subventionen sind extreme generös und garantieren den Investoren 20 Jahre lang einen Rückfluss von fast 10 Prozent pro Jahr. Angesichts dieses beispiellosen Angebotes ist es keine Überraschung, dass bereits mehr als eine Million Familien Solarpaneele installiert haben. Dieser Solarboom hat jedoch dem Land Verpflichtungen in Höhe von über 130 Milliarden Euro an Subventionen aufgebürdet, was zu immer weiter steigenden Energiepreisen führt.

Während wohlhabende Hausbesitzer und Firmeneigentümer auf ihren Dächern und Fabrikgebäuden Solarpaneele installieren, müssen in Mietswohnungen lebende Familien mit geringem Einkommen die in die Höhe schießenden Stromrechnungen bezahlen. Viele können sich das nicht länger leisten, so dass die Versorger sie von der Stromversorgung ausschließen.

Um den Solarboom zu beenden hat die Regierung die Einspeisetarife für Solarstrom während der letzten Jahre reduziert. Allerdings sind seit dem Jahr 2010 über 5000 Unternehmen in der Solarbranche pleite gegangen, wobei zehntausende grüner Arbeitsplätze vernichtet worden sind.

Die größten deutschen Unternehmen wie Siemens und Bosch geben die Industrie ebenfalls auf. Ihre Strategien hinsichtlich erneuerbarer Energien endeten in kostspieligen Debakeln. Siemens, das größte derartige Unternehmen, hat im Juni angekündigt, die gesamte Abteilung Solar zu schließen, und zwar mit einem Verlust von etwa 1 Milliarde Euro. Im vorigen Monat hat der Siemens-Vorstand seinen Direktor Peter Löscher gefeuert. Sein dramatischer Hinauswurf erfolgte im Zusammenhang mit einem ganzen Bündel katastrophaler Fehlinvestitionen im Sektor grüne Energie, dem er vorstand.

Auch für Bosch, einen weiteren Riesen in Deutschland, endete das Solarabenteuer in einer Katastrophe, und zwar mit einem Verlust noch höher als bei Siemens: etwa 2,4 Milliarden Euro.

Während des vergangenen Jahres hat die Welle von Bankrotten in der Solarindustrie die gesamte Branche verheerend getroffen, während Investoren in Solar am Aktienmarkt fast 25 Milliarden Euro verloren haben.

Inzwischen plant Deutschland, alle Subventionen auslaufen zu lassen, und die Solarindustrie des Landes wird bis zum Ende dieses Jahrzehnts wohl verschwunden sein.

Die meisten Beobachter waren davon überzeugt, dass die Energielücke in Deutschland durch den vor zwei Jahren erfolgten Beschluss der Schließung von Kernkraftwerken durch Wind- und Solarenergie gefüllt werden würde. Kaum jemand hatte erwartet, dass der außerordentliche Boom erneuerbarer Energieerzeugung auch einen Kohleboom auslösen würde.

Tatsächlich sind die CO2-Emissionen seit zwei Jahren hintereinander gestiegen, weil die Kohle eine Renaissance erfährt. Aber die CO2-Emissionen in der EU als Ganzes werden wahrscheinlich ebenfalls steigen, weil zunehmend Kohlekraftwerke in Betrieb gehen. Diese Enthüllung hat die deutsche Regierung empört und die Öffentlichkeit überrascht, die nicht verstehen kann, wie ein Land, dass sich der erneuerbaren Energie mehr als jedes andere Land verschrieben hat, 20 neue Kohlekraftwerke bauen kann.

In weiten Teilen Europas ist Kohle inzwischen viel billiger für die Stromerzeugung geworden als Erdgas. Der Grund ist der Kollaps des Emissionshandels in der EU und der folgerichtige Rückgang der Kohlepreise. Das macht Kohlekraftwerke ökonomischer als Gaskraftwerke.

Bislang hat der Emissionshandel in Europa die Verbraucher über 300 Milliarden Euro gekostet. Massive grüne Investitionen, ursprünglich gedacht als Antwort auf hohe Kohlepreise wurden eingestampft und sind nicht länger möglich. Es gibt kaum noch Zweifel daran, dass die Klimapolitik des Flaggschiffs Europa total gescheitert ist. In einem Anflug von Realismus hat die International Energy Agency angemerkt, dass „die Klimaänderung ziemlich abrupt zum Ladenhüter politischer Prioritäten geworden ist“.

Von allen unbeabsichtigten Konsequenzen der deutschen Energiewende ist vielleicht die schlimmste von allen der nachteilige Effekt von Wind- und Solarprogrammen auf den Preis von durch Erdgas erzeugtem Strom. Fast 20 Prozent der Gaskraftwerke in Deutschland sind unrentabel geworden und stehen vor der Schließung, weil die Erneuerbaren das Stromnetz bevorzugt mit Energie überschwemmen. Um Blackouts zu verhindern musste die Regierung unökonomische Gas- und Kohlekraftwerke subventionieren, damit sie als Backup zur Verfügung stehen, wenn die Sonne nicht scheint und der Wind nicht weht.

Dieses Durcheinander zwingt Unternehmen zu sogar noch radikaleren Lösungen. E.ON, das größte Stromunternehmen in Deutschland, denkt darüber nach, einige seiner europäischen Gaskraftwerke abzureißen, weil sie nicht mehr profitabel sind, und sie außerhalb der EU neu aufzubauen. Solche absurden Überlegungen sind inzwischen symptomatisch für die unbeabsichtigten Konsequenzen des rasanten Ausbaus erneuerbarer Energie.

Die europäischen Hersteller verlieren massiv Boden im internationalen Wettbewerb. Anstatt ihr Geld in die energieteure EU zu stecken, gießen Investoren es lieber in die USA, wo die Energiepreise auf ein Drittel des Niveaus in der EU gefallen sind, hauptsächlich wegen der Schiefergas-Revolution.

Die naive Annahme von Politkern, dass die wesentlichen Unternehmen in Europa der Verschiebung weg von billigem fossilen Treibstoff hin zu teurer grüner Energie folgen würden, hat sich nicht erfüllt. Die Washington Post hat jüngst gewarnt, dass Europa „zu einem Fall für den Papierkorb hinsichtlich grüner Energie geworden ist. Anstatt zu einem Modell für die Welt zu werden, ist Europa inzwischen zu einem Modell geworden, wie man es nicht machen sollte“.

Die europäische Strategie war aus zwei Befürchtungen entstanden: dass die globale Erwärmung eine zwingende Bedrohung sei, die man sofort verhindern müsse, egal zu welchen Kosten; und dass der Welt die fossilen Treibstoffe ausgehen, was bedeutet hätte, dass Öl und Gas sogar noch teurer geworden wären. Beide Mutmaßungen haben sich inzwischen als falsch erwiesen.

Das Ergebnis des von Angst getriebenen Glücksspiels mit der industriellen Zukunft des Kontinents ist ein kostspieliges, heilloses Durcheinander, das droht, die ökonomische und politische Situation Europas in einer Welt zu unterminieren, die sich vernünftigerweise weigert, seiner Führung zu folgen.

Die Strategie grüner Energie in Deutschland wird sich wahrscheinlich nach den Wahlen am 22. September grundlegend ändern. Merkel hat den Wählern versprochen, die Last von 20 Milliarden Euro drastisch zu kürzen, die sie Investoren in erneuerbare Energien jedes Jahr zahlen muss, falls sie gewinnt.

Die Australier sind gut beraten, genau zu beobachten, wie dieser grüne Zug sehr bald zum Wrack wird, wenn sie verhindern wollen, dass sich das in Europa entfaltende Fiasko hierzulande wiederholt.

Benny Peiser is director of the London-based Global Warming Policy Foundation.

The Australian, 10 August 2013

Link: http://www.thegwpf.org/benny-peiser-europe-pulls-plug-green-future/

Übersetzt von Chris Frey EIKE

Anmerkung des Übersetzers:

Dieser Artikel ist so gut recherchiert, dass ich bei der Übersetzung manchmal fast vergessen habe, dass er aus australischer Sicht geschrieben ist. Man sieht die ganze Chose also außerhalb ganz anders als bei uns. Fast habe ich den Eindruck, dass sich Autor Benny Peiser gar nicht vorstellen kann, wie weit die deutschen Medien noch der Agitation anhängen und hinterher hinken.

C. F.