Die globale Mitteltemperatur – Ein Phantom?

Vom Prinzip her – und man muss unterstellen, sogar mit voller Absicht – wird dabei außen vor gelassen, dass es diese Größe in der Natur nicht gibt. Sie ist weder physikalisch an Hand der Realität definierbar, noch ist sie messtechnisch erfassbar. Wenn man nämlich versucht, sie sauber zu definieren, so bleibt nichts weiter als eine nach subjektiven Kriterien berechnete Zahl. Man könnte annehmen, dass sie eine Art Index ist. Aber auch das trifft nicht nicht zu, weil ihre Bezugsgrundlagen über der Zeit ständig variieren. Von einem aussagefähigen Index – wie z.B. dem Aktienindex DAX- verlangt man, dass die Zahl der Aktienwerte immer gleich ist. In diesem Falle sind es immer 30 DAX-Werte. Nicht immer dieselben, aber immer gleich viel. Das trifft aber für die per Thermometer bestimmten globale Mitteltemperatur nicht zu. Die Zahl der einbezogenenen Messstationen änderte sich permanent, auch deren Position im Kleinen wie im Großen, aber auch die Zeitpunkte an denen abgelesen wurde. Die Anforderungen die an einen Index gestellt werden, erfüllt sie also auch nicht.

Trotzdem kann man mit ihr und ihrem errechneten Trend viele kluge aber noch viel zahlreichere weniger kluge Sachen anstellen, über die sich trefflich und ausgiebig streiten lässt. Und gerade weil das so ist, wird der Streit darüber mit erbitterter Härte geführt und erinnert den geschichtsbewussten Beobachter immer mehr an den unendlichen Streit der mittelalterlichen Scholastiker über die Frage, wieviele Engel wohl auf eine Nadelspitze passen. Dieser Streit ist – weil völlig irreal – bis heute nicht entschieden, ebenso wenig wie der Streit darüber, was eine globale Mitteltemperatur eigentlich ist. Daher ist es gut, sich die physikalischen Realitäten zunächst einmal vor Augen zu führen.

Abbildung 1: Linkes Bild-Die Fragezeichen symbolisieren die verschiedenen Messorte von Messungen zur Bestimmung einer Durchschnittsstemperatur in einem Haus. Rechtes Bild- dasselbe Problem dargestellt an einem KfZ. In beiden Fällen wäre die Bestimmung einer Mitteltemperatur selbst wenn die Einzelwerte zur gleichen Zeit gemessen würden, sinnlos.

Die Physik definiert Temperatur in Anlehnung z.B. an Gehrtsen [Meschede, 2003] wie folgt als:

(Wärmezustand eines Körpers (nicht Wärmeenergie ))….und dann unter „Statistische Theorie der Wärme“: je Freiheitsgrad der sich in ungeordneter Wärmebewegung befindlichen Atome (L. Boltzmann 1890, Wien) gültig für Gase , Festkörper und Flüssigkeiten.

Anders ausgedrückt bedeutet dies: Die Temperatur ist eine physikalische, thermodynamische Zustandsgröße der Materie am Ort der Messung. Die physikalischen Eigenschaften der Temperatur werden in der Lehre von der Thermodynamik behandelt. Man bezeichnet dort die Temperatur als eine systemeigene, intensive Zustandsgröße.

Was ist eine „globale Erwärmung“?

In der Klimatologie wird diese Definition allerdings nicht verwendet. Welche Probleme man sich damit einhandelt, beschreiben z.B. Essex et. al [Essex, 2006] ausführlich in ihrer Arbeit. Darin zeigen sie, dass die in der Global-Klimatologie übliche Definition zu Problemen führt. Dort wird die von einer fiktiven Mitteltemperatur abhängige Temperaturabweichung Ξ(tM) (leider bildet der Zeichenvorrat des typo3 Editors mathematische Sonderzeichen nur unzreichend ab, ich bitte um Nachsicht) zur Zeit tM:

![]()

Ξ(tM) gebildet, indem von jeder Ortstemperatur ein gleitender Durchschnitt der Vergangenheit (2-ter Term in der Klammer) abgezogen wird. Ξ(tM) wird zutreffend als Temperaturanomalie bezeichnet. Die Summierung (Index i) erfordert im Prinzip eine räumliche Integration des Temperaturfeldes über die gesamte Oberfläche der Erde, wobei ![]() die Lufttemperatur an der Position ri und zur Zeit tM ist und die Summierung über j für einen passenden Zeitraum (üblich sind 30 Jahre) durchgeführt wird. Die Anomalie Ξ ist also eine Funktion von

die Lufttemperatur an der Position ri und zur Zeit tM ist und die Summierung über j für einen passenden Zeitraum (üblich sind 30 Jahre) durchgeführt wird. Die Anomalie Ξ ist also eine Funktion von ![]() für alle Ortsvektoren ri. Im Gegensatz dazu sind lokale (thermodynamische – Anm. des Verfassers -) Gleichgewichtszustände in einem Feld nur für einen besonderen Ort r definiert. Andere Orte, sofern sie sich nicht in infinitesimaler Nachbarschaft befinden, sind davon unberührt. Die statistische Größe Ξ hat dieselbe Eigenschaft wie ein arithmetischer Durchschnitt von unterschiedlichen Temperaturen zwischen räumlich voneinander entfernten Systemen. Sie hängt daher von den Zuständen aller räumlich getrennten Subsysteme ab.

für alle Ortsvektoren ri. Im Gegensatz dazu sind lokale (thermodynamische – Anm. des Verfassers -) Gleichgewichtszustände in einem Feld nur für einen besonderen Ort r definiert. Andere Orte, sofern sie sich nicht in infinitesimaler Nachbarschaft befinden, sind davon unberührt. Die statistische Größe Ξ hat dieselbe Eigenschaft wie ein arithmetischer Durchschnitt von unterschiedlichen Temperaturen zwischen räumlich voneinander entfernten Systemen. Sie hängt daher von den Zuständen aller räumlich getrennten Subsysteme ab.

Damit entsteht ein Paradox. Ξ am Ort r hängt auch von den Zuständen an allen entfernten Positionen {rk} ab. Jedoch sind chemische, physikalische oder biologische Prozesse, die durch die Temperatur am Ort r gesteuert werden, keine Funktionen der Temperaturen außerhalb von r. Wenn man in Klimamodellen darauf besteht, dass Ξ Prozesse auslöst, wie z.B. das Schmelzen von Gletschern, dann ist dieser Vorgang zwangsläufig eine Funktion von Temperaturen anderswo auf dem Planeten. Dies ist physikalisch unhaltbar. Fernwirkende Mechanismen für thermodynamische Prozesse gibt es nicht.

Mit der genauen Ermittlung der Kennziffer „Globaltemperatur“ T und ihres Verlaufes über der Zeit sollen u.a. Rückschlüsse auf eventuelle klimatisch relevante Einflussgrößen („Antriebe“ oder Forcings) ermöglicht werden. Namentlich ist hier der Einfluss des Spurengases CO2 gemeint, das gemeinhin als Treibhausgas bezeichnet wird. Durch die vielfältige statistische Behandlung wird jedoch aus dem ursprünglich physikalischen Wert der Temperatur T des Messortes und der Zeit nur noch eine fiktive Zahl T*. Sie hat keinen physikalischen Inhalt mehr, obwohl sie in der Literatur mit der Dimension °C oder K bezeichnet wird. Somit verliert die berechnete Größe „mittlere Globaltemperatur“ als Durchschnittswert aller gemessenen lokalen Temperaturwerte ihren physikalischen Bezug. Sie unterliegt in ihrer Bestimmung nicht mehr den allgemein gültigen physikalischen Gesetzen, sondern den zwar ausgefeilten, in wesentlichen Teilen jedoch willkürlich definierten statistisch-mathematischen Regeln und Konventionen. Jeder Versuch, ein Feld aus unterschiedlichsten lokalen Temperaturen über willkürliche Rechenregeln zusammenzuführen (es gibt z.B. – streng genommen – unendlich viele Methoden der Mittelwertbildung. Welche ist hier die „Richtige“?), liefert lediglich eine neue Zahl, die alle ihre physikalisch bestimmenden Eigenschaften verloren hat. Sie erhält dafür neue Eigenschaften, die sich primär aus den verwendeten Rechenregeln und den verabredeten (für den ursprünglichen Zweck möglicherweise sinnvollen, aber willkürlichen) Konventionen ergeben.

Der klimatologische Begriff der Lufttemperatur und die Messmethoden

Im Bericht des National Research CouncilXE „National Research Council“ [NRC, 2005] wird die mittlere Globaltemperatur T als “heat content”, also – im Gegensatz zur Auffassung von Gehrtsen- als Wärmeenergieinhalt, wie folgt definiert: ‘‘According to the radiative-convective equilibrium concept, the equation for determining global average surface temperature of the planet is

![]()

where H. . .. . .is the heat content of the land-ocean-atmosphere system. . … Equation (1) describes the change in the heat content where f is the radiative forcing at the tropopause, T´ is the change in surface temperature in response to a change in heat content, and λ is the climate feedback parameter (Schneider and Dickinson, 1974), also known as the climate sensitivity parameter, which denotes the rate at which the climate system returns the added forcing to space as infrared radiation or as reflected solar radiation (by changes in clouds, ice and snow, etc.).’’

Danach ist T die mittlere Globaltemperatur und T´ die Abweichung von dieser Temperatur, hervorgerufen durch die Strahlungs-Antriebe (radiative forcings) f. Diese Definition erleichtert zwar u. U. die Zuordnung einzelner Antriebe zur gemessenen oder gerechneten Veränderung T´, hilft aber bei der eigentlichen Ermittlung der Globaltemperatur T nicht weiter. Überdies unterstellt diese Definition eine reine Strahlungstemperatur, was der beobachteten Vielfalt der Temperaturquellen, zusätzlich zur Strahlungstemperatur, nicht gerecht wird.

Widersprüchliche Definitionen

Die klassische Meteorologie war sich schon lange des Widerspruchs bewusst, der sich aus der Ermittlung der lokalen wahren Lufttemperatur T und ihrer Verwendung als statistischem Mittelwert T* ergab. So erläutert R. Assmann, der Erfinder des heute noch vielfach verwendeten Aspirationspsychrometers, in seinem umfangreichen Aufsatz „Das Aspirations-Psychrometer; Ein Apparat zur Ermittlung der wahren Temperatur und Feuchtigkeit der Luft“ auf Seite 120 (6)[Assmann, 1892] Original-Zitat (alle Hervorhebungen vom Autor, die alte Schreibweise bitte zu entschuldigen):

„1. Begriff der Lufttemperatur. Sprung definiert in seinem Lehrbuche der Meteorologie auf S. 307 den Begriff der Lufttemperatur, wie man denselben in der Meteorologie schlechtweg gebraucht, als »diejenige Temperatur, welche der über betreffende Gegend hinwegstreichende Luftstrom in einer Höhe‘ von 1-2 m über der Erdoberfläche wirklich besitzt.

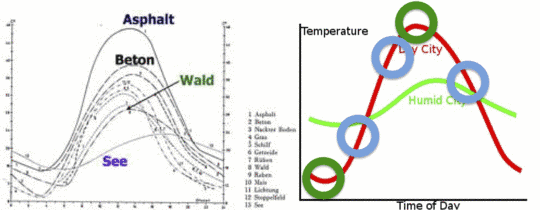

Abbildung 2: Das linke Bild zeigt den Temperaturverlauf an einem sonnigen Tag in Deutschland über verschiedenen Bodenarten. Die Temperaturskala links fängt bei 0°C an und endet bei 48 °C. Das rechte Bild zeigt den Temperaturverlauf symbolisch über einen Tag in feuchter Umgebung und in trockener Umgebung, sowie die Messwerte bei gleichem Verlauf aber zu verschiedenen Zeiten zur Berechnung des Tagesmittels.

Koeppen [Köppen, 1913] dagegen sagt in seiner Abhandlung »Studien über die Bestimmung der Lufttemperatur und des Luftdrucks« auf S. I: »Was ist Lufttemperatur ? Die Antwort lautet einfach: Die Temperatur der Luft, zunächst derjenigen, welche wir unmittelbar der Prüfung unterwerfen und weiterhin die Temperatur anderer, größerer Luftmassen, als deren Repräsentantin die erstere dienen kann«. Wie man sieht, ist Koeppens Definition die weitere, von einer Höhenangabe über dem Erdboden gänzlich absehende, während Sprung’s Definition dem für die beobachtende Meteorologie allerdings wesentlich maßgebenden Begriffe der »klimatischen Temperatur« nahe kommt.

Koeppen unterscheidet aber ferner gewissermaßen zwei verschiedene Arten der Lufttemperatur, deren erste man die physikalische nennen könnte, während die letztere auf das praktische Bedürfnis klimatologischer Untersuchungen Rücksicht nimmt. Für unsern Zweck, ….. ebenso auch im Innern eines von der Lufttemperatur abhängigen physikalischen Apparates so ermitteln, wie sie unter dem Zusammenwirken aller für den speciellen Fall wirksamen Faktoren thatsächlich vorhanden ist. Man könnte deshalb vielleicht auch sagen, dass wir als Lufttemperatur diejenige Temperatur anzusehen haben, welche eine beliebige, der Untersuchung unterworfene Luftmenge unter dem Zusammenwirken der jeweiligen sie treffenden Einflüsse der Ein- und Ausstrahlung direkter wie reflektirter Wärme jeder Wellenlänge, ferner der Leitung und Konvektion von Wärme wirklich besitzt.

Eine verschleppte „Erbkrankheit“ der Meteorologie

Damit umgeht Koeppen jede physikalische Definition der Größe, die er beobachten will, was aber bis zur Erfindung der Treibhaustheorie eigentlich niemanden störte.

Dieses klar erkannte Dilemma wurde aber in den letzten 120 Jahren nicht nur nicht ausgeräumt, sondern im Gegenteil weiter verfestigt und führt daher, auch weiter bei Klimawissenschaftlern jeglicher Provenienz zu munterer Begriffsverwirrung. An dieser „Erbkrankheit“ leidet die Meteorologie sowie die mit ihr verknüpfte Klimaforschung bis heute. Anschaulich unterstreicht dies eine aktuelle, leicht verständlich gehaltene Darstellung auf der Webseite des Goddard Institute for Space Studies, GISS) der NASA, das in den USA auch für Belange der Meteorologie und Klimaforschung zuständig ist. Dort wird das „kleine“ Problem, wie die alles entscheidende Ursprungs-Größe, die Basis aller Globaltemperaturen, nämlich die lokale bodennahe Lufttemperatur und ihr Tagesdurchschnitt zu ermitteln ist, mit Hilfe eines kurzen Frage- und Antwortspiels wie folgt beschrieben:

Boden-Temperaturanalyse nach GISS/ Die schwer fassbare Absolute Boden-Temperatur (SAT)

Frage: Was genau ist mit SAT (Absolute Surface Air Temperature) gemeint?

Antwort: Ich bezweifle, dass es eine allgemeine Übereinstimmung gibt, wie man diese Frage beantworten kann. Selbst an ein und demselben Ort kann sich die Temperatur in Bodennähe sehr von der Temperatur in einer Höhe von 5 Fuß [ca. 1,5 m] über dem Boden unterscheiden und diese wiederum von der Temperatur in 10 oder 50 Fuß [ca. 3 m bzw. 15 m] über Grund. Vor allem beim Vorhandensein von Vegetation (sagen wir mal im Regenwald) kann sich die Temperatur oberhalb der Vegetation sehr stark von der Temperatur unter dem Blätterdach unterscheiden. Ein vernünftiger Vorschlag könnte es sein, die mittlere Temperatur der ersten 50 Fuß entweder über dem Boden oder über der Vegetation zu verwenden. Um SAT zu messen, müssten wir übereinstimmend feststellen, was damit gemeint ist, und so weit ich weiß, ist bis heute ein solcher Standard nicht vorgeschlagen oder allgemein übernommen worden. Selbst wenn man den 50-Fuß-Standard übernimmt, kann ich mir nicht vorstellen, dass man an einer Wetterstation einen 50 Fuß hohen Turm mit einer Anzahl Thermometer errichtet, um die wirkliche SAT an dieser Stelle zu ermitteln.

Frage: Was meinen wir mit dem täglichen Mittel von SAT?

Antwort: Noch einmal, da gibt es keine universell korrekte Antwort. Sollten wir die Temperatur alle 6 Stunden messen und mitteln, oder sollten wir es alle zwei Stunden tun, stündlich oder mit Hilfe einer Maschine jede Sekunde, oder sollten wir einfach das Tagesmaximum und –minimum nehmen und die Summe durch zwei dividieren? An einigen Tagen werden die verschiedenen Methoden zu drastisch unterschiedlichen Ergebnissen führen.

Frage: Über welche SAT berichten die lokalen Medien?

Antwort: Die Medien melden die Messungen an einem bestimmten Thermometer einer nahe gelegenen Wetterstation. Diese Temperatur kann von der wirklichen SAT selbst an dieser Stelle sehr unterschiedlich sein und hat mit Sicherheit nichts zu tun mit der wirklichen regionalen SAT. Um die wirkliche regionale SAT zu messen, müssten wir viele 50 Fuß hohe Thermometersäulen verwenden, die gleichmäßig über das ganze Gebiet verteilt sind, eine offensichtlich praktische Unmöglichkeit.

Frage: Wenn die gemeldeten SATs nicht die wirklichen SATs sind, warum sind sie dennoch nützlich?

Antwort: Die gemeldete Temperatur ist wahrhaftig nur für jene Person von Bedeutung, die die Wetterstation zufällig in genau dem Moment aufsucht, zu dem die gemeldete Temperatur gemessen wird – mit anderen Worten also für niemanden. Allerdings fügen die Medien zusätzlich zu der gemeldeten SAT auch hinzu, ob diese Temperatur ungewöhnlich hoch oder niedrig liegt, um wie viel sie von der Normaltemperatur abweicht, und diese Information (diese Anomalie) ist für die ganze Region bedeutsam. Außerdem, wenn wir von einer bestimmten Temperatur hören (z. B. 70°F [ca. 21°C]), übertragen wir diesen Wert instinktiv in heiß oder kalt, aber der Schlüssel für diese Übertragung hängt von der Jahreszeit und dem Gebiet ab. Der gleiche Temperaturwert kann im Juli ‚kalt’ und im Januar ‚warm’ sein, da wir mit ‚warm’ immer wärmer als normal meinen. Das heißt, wir übertragen alle Temperaturwerte automatisch in Anomalien, ob wir das nun merken oder nicht.

Frage: Falls man die SATs nicht messen kann, wie werden dann Karten mit der Temperaturverteilung erzeugt?

Antwort: Das kann man nur mit Hilfe von Computermodellen, den gleichen Modellen, die verwendet werden, um die tägliche Wettervorhersage zu erstellen. Wir können die Modellrechnung mit einigen wenigen gemessenen und verfügbaren Daten füttern und den Rest mit Vermutungen (auch Extrapolationen genannt) füllen. Danach lassen wir das Modell so lange laufen, dass die Eingangs-Annahmen keine Rolle mehr spielen, aber nicht zu lange, um die zunehmenden Ungenauigkeiten des Modells mit der Zeit zu vermeiden. Man kann auch als Anfangszustand die mittleren Bedingungen mehrere Jahre nehmen, so dass das Mittel (eine ‚Klimatologie’ genannt) hoffentlich eine typische Karte für einen bestimmten Monat oder ein bestimmtes Jahr repräsentiert.

Frage: Was muss ich tun, wenn ich absolute SATs brauche und nicht Anomalien?

Antwort: In 99,9% aller Fälle wird man finden, dass Anomalien genau das sind, was man braucht, nicht absolute Temperaturen. In den übrigen Fällen muss man sich eine der verfügbaren Klimatologien heraussuchen und die Anomalien hinzufügen (unter Berücksichtigung einer geeigneten Bezugsperiode). Als globales Mittel erzeugen die Modelle, denen man am meisten vertraut, einen Wert von etwa 14°C, aber es kann gut irgendwo zwischen 13°C und 15°C liegen, und regional, geschweige denn lokal, ist die Lage sogar noch schlimmer.

Ich bin mir sicher dass die o.a. Ausführungen zu reger Diskussion führen werden. Daher eine Bitte: Bleiben Sie in Ihren Kommentaren sachlich.

Michael Limburg

Die GISS Darstellung wurde von von Chris Frey EIKE übersetzt.

Kommentar hierzu von Dipl.-Met. Hans-Dieter Schmidt:

Als mir dieser Text des GISS gezeigt wurde, habe ich mich schon im ersten Moment ertappt gefühlt – dieses unbewusste Übertragen in Anomalien, von dem in diesem Text die Rede ist, passiert mir nämlich auch – im privaten Bereich. Als Meteorologe im Vorhersagedienst (oder besser gesagt während der Arbeit) sind mir die absoluten Werte dagegen relativ egal – die Vorhersage von Wettererscheinungen ist wichtiger und schwieriger.

Dennoch, um auf die Problematik von „globalen Temperaturen“ hinzuweisen, kann dieser Artikel gar nicht hoch genug einschätzt werden. Und wenn mich mein Nachbar fragt, wie lange ‚es noch so heiß bleibe’, gebe ich gerne die Antwort: ‚Es war doch schon mal noch heißer um diese Jahreszeit!’

‚Hitze’ und ‚Kälte’ betrachte ich als Wettererscheinungen. Auch privat – ich leide unter der Hitze – und nicht unter 32°C oder 35°C. Schon während meiner Ausbildung (vor rund 40 Jahren) habe ich gelernt, Wertungen strikt aus der Formulierung von Vorhersagen herauszuhalten. Dieser Artikel liefert mir selbst nach so langer Zeit den klaren Grund für diese Anweisung.

Hans-Dieter Schmidt

Literatur in der Reihenfolge ihrer Erwähnung

Meschede, D (2003) Gehrtsen Physik. J. Springer, Berlin Heidelberg

Essex, C, Mc Kittrick, R. Andresen, B. (2006) Does A Global Temperature Exist? Non-Equilibrium Thermodynamics

NRC (2005) Radiative Forcing of Climate Change: Expanding the Concept and Addressing Uncertainties, 207 pp.,. 207 pp.

Assmann, R (1892) Das Aspirations-Psychrometer; Ein Apparat zur Ermittlung der wahren Temperatur und Feuchtigkeit der Luft.

Köppen, W (1913) Einheitliche Thermometeraufstellungen für meteorologische Stationen zur Bestimmung der Lufttemperatur und der Luftfeuchtigkeit Meteorologische Zeitschrift 30

GISS Surface Temperature Analysis The Elusive Absolute Surface Air Temperature (SAT)

http://data.giss.nasa.gov/gistemp/abs_temp.html