Kohlenstoffsteuer und Temperatur

1) Hitch Climate Tax To The ACTUAL CLIMATE, Says Top Economist – The Register, 4 July 2013

2) Temperature-Linked Carbon Tax Could Be Effective – Expert – Reuters, 4 July 2013

3) Ross McKitrick: Responses To My Critics – Ross McKitrick, 4 July 2013

1) Top-Ökonom: Man verknüpfe eine Klimasteuer mit dem AKTUELLEN KLIMA

The Register, 4 July 2013

Andrew Orlowski

Ein kanadischer Ökonom hatte eine Idee, wie man gegen die globale Erwärmung vorgehen könnte, die so einfach ist, dass es erstaunlich ist, dass niemand zuvor auf diese Idee gekommen ist. Ross McKitrick, Professor der Ökonomie an der University of Guelph in Ontario, ein IPCC-Experten-Begutachter und einer seiner führenden Kritiker, schlägt eine Kohlenstoffsteuer vor, deren Höhe sich an der Rate der Klimaänderung orientiert. Er erläuterte seine Idee kürzlich vor dem House of Lords vor einem Auditorium, in dem sich auch der Architekt des Climate Change Act in UK befand. Und es war faszinierend zu sehen, wer davon am meisten alarmiert war.

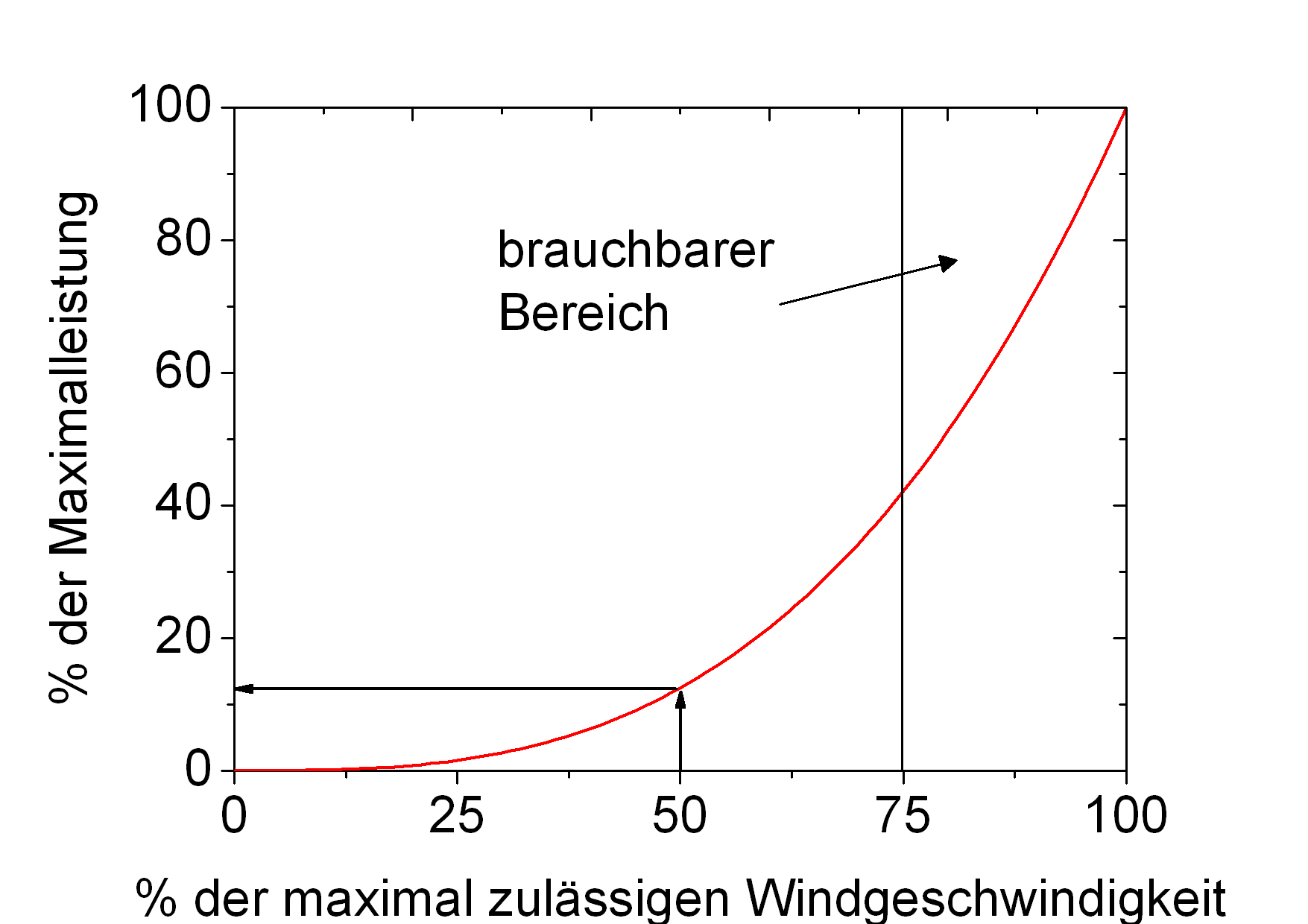

Der Plan von McKitrick ersetzt die bruchstückhaften Regulationen und Steuern, die beliebig und chaotisch sind (das reicht von der Verbannung von Heizstrahlern bis zu einem „Preis des Kohlenstoff-Fußabdrucks“) durch eine Steuer, die mit der Temperatur der Atmosphäre verknüpft ist. Dem IPCC zufolge ist die Temperatur der „Fingerabdruck“ der durch Treibhausgase induzierten globalen Erwärmung und der am schnellsten reagierende Indikator der Klimaänderung. Wenn die Temperatur steigt, steigt auch die Steuer.

Mit der Einführung handelbarer Emissionszertifikate zusammen mit dieser neuen, auf Beweisen basierenden Steuer gibt es starke Anreize an der richtigen Stelle. „Niemand wird von falscher oder übertriebener Wissenschaft profitieren“, sagte McKitrick.

“Skeptiker, die nicht an die globale Erwärmung glauben, werden nicht erwarten, dass die Steuer steigt, wenn sie nicht sogar von deren Sinken ausgehen. Diejenigen, die an die rapide Erwärmung glauben, gehen davon aus, dass die Steuer während der kommenden Jahre rasch steigen wird“, erläuterte McKitrick, wenn er seine Idee umreißt.

Unternehmen, die Fabriken und Kraftwerke betreiben, werden sich darum kümmern müssen, wer wahrscheinlicher recht hat, weil Milliarden Dollar Steuereinnahmen davon abhängen, was passieren wird”.

In Westminster führte er aus:

Niemand hat ein Interesse daran, die Vorhersagen zu ignorieren – während jeder daran interessiert ist, die Vorhersagen auf ihre Genauigkeit abzuklopfen … Als Wissenschaftler kann man seine Altersrente hinein stecken, anstatt sich darüber zu beklagen, dass einem niemand zuhört. Wenn ein Wissenschaftler sich selbst davon überzeugen kann, seine Rente in seine eigene Wissenschaft zu stecken, sollte er nicht versuchen, andere Leute dazu zu überreden.

Das klingt vernünftig.

Er erwähnte auch einige der Fallgruben und Widersprüche. War es rückwärts schauen? Nein, dachte er, da Investoren große Wetten auf die Zukunft hinsichtlich der Steuer abschließen. Ein zukünftiger Markt mit Emissionszertifikaten würde es den Händlern erlauben, „Klimaverzögerungen“ als eine Gelegenheit zur Ausnutzung von Preisunterschieden behandeln.

Ob er glaube, dass Märkte klüger als Wissenschaftler sind, fragte jemand.

„Märkte sind einfach Menschen, und sie verwenden Informationen“, sagte er. „Märkte können objektiver sein als Wissenschaftler – jeder Wissenschaftler hat seine eigenen Verzerrungen und seine eigene Agenda. Aber der Markt wird keine Vorhersagen korrigieren“.

Aber wenn die Wissenschaftler missverstanden werden, zahlt die Öffentlichkeit nicht für eine falsche Politik – da es sich nicht auszahlt, für die Abschwächung eines Problems zu zahlen, das gar nicht existiert.

Unter den Teilnehmern der von der GWPF arrangierten Gespräche waren Chris Rapley und Bryony (jetzt Baronesse) Worthington (BA, Eng.Lit.), der von Greenpeace zu DEFRA übergetretene Klimaaktivist, um dort den Climate Change Act für Ed Milliband zu entwerfen. Beide fragten McKitrick das Gleiche: Warum verwendet man nicht andere Messungen der Reaktion des Klimas? Worthington sprach hier die Zahlen der arktischen Eisschmelze an.

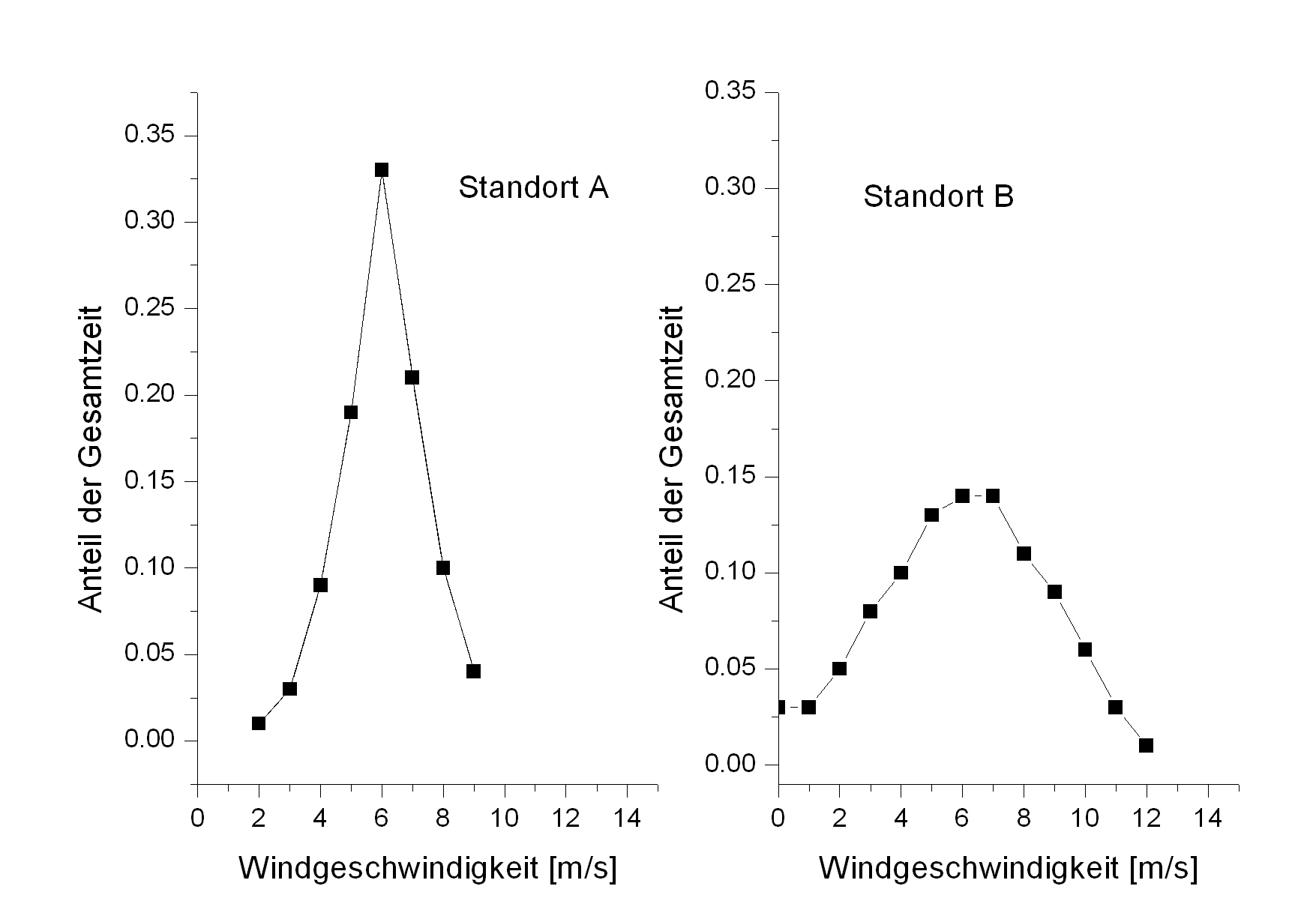

McKitrick erwiderte, dass die Arktis ein „kleines geographisches Gebiet“ und weniger geeignet als Indikator der Klimaänderung sei. Es gibt eine verstärkte Reaktion auf Änderungen der Sonne, erklärte er, was „es für unsere Zwecke ziemlich rauschend macht“.

Ein großer Anteil der arktischen Eisschmelze vor ein paar Jahren kann man eher Zirkulationsänderungen zuordnen als einer wärmeren Arktis. Die Troposphäre andererseits war die Hälfte der irdischen freien Atmosphäre.

90 Prozent des Ungleichgewichts hinsichtlich der Energiebilanz gehen in die Ozeane, also warum nimmt man nicht das?”, fragte Chris Rapley, ein ehemaliger Leiter des Antarctic Survey. McKitrick sagte, dass hier das Risiko bestehe, dass die Reaktion zu langsam erfolge.

Was ist stattdessen mit dem Meeresspiegel? Rapley sagte, die Rate des Meeresspiegel-Anstiegs sei seit 2000 Jahren konstant gewesen und dann plötzlich scharf angestiegen, während Ozeane einen rapiden Indikator der globalen Erwärmung darstellen (deswegen wohl ist die flüchtige Erwärmung der Ozeane so schwer zu finden).

Für McKitrick repräsentiert eine Steuer das am wenigsten kostspielige Mittel, Emissionen zu drosseln. Damit das jedoch funktioniert, müssen andere Steuern abgeschafft werden, weil sonst die drückende Last der Kosten das Ganze teuer und nutzlos machen. Und da liegt der Hase im Pfeffer. Politiker heben selten Steuern auf und lieben es, sie immer weiter zu erhöhen.

In einer Fußnote räumte Lord Lawson die politische Herausforderung ein, die für jeden besteht, der eine Kohlenstoffsteuer einführen will. Und doch war es nicht unmöglich sich vorzustellen, dass Politiker diese Idee übernehmen als einen das Gesicht wahrenden Weg aus selbstmörderischen grünen Steuern und Regulationen, wenn der Planet sich nicht in der vorhergesagten Größenordnung erwärmt.

McKitricks auf Beweisen basierender Vorschlag könnte sich in Wirklichkeit für Andere als zu fundiert herausstellen, um es zu ertragen.

Eine 16 Seiten starke Zusammenfassung dieser Studie findet man hier.

2) Experte: eine mit der Temperatur verknüpfte Kohlenstoffsteuer könnte effektiv sein Reuters, 4 July 2013

Erin Berger

Eine mit der Temperatur verknüpfte Kohlenstoffsteuer könnte der kosteneffektivste Weg zur Reduktion von Kohlendioxid-Emissionen und die Verlangsamung des Klimawandels sein. Aber eine solche Steuer einzuführen kann eine gewaltige Herausforderung sein, nicht zuletzt wegen politischer Konflikte, sagt ein führender Verfechter der Steuern.

Ross McKitrick, Professor der Ökonomie an der University of Guelph in Ontario, schlägt eine Steuer vor, die zu Anfang sehr niedrig ist und dann mit der Temperatur der Erde steigt oder fällt.

Ein solches System würde Investoren und potentiellen Politikern helfen zu verstehen, wie das Klima – und die Höhe der Steuern – sich mit der Zukunft ändern und klare Hinweise geben würde, welche Maßnahmen man treffen sollte.

Investoren könnten Entscheidungen treffen, die auf ihrem Vertrauen in ihre Klimaprognosen basieren, und das System würde denjenigen mit der besten Abschätzung belohnen. „Man macht am Ende alles richtig, egal was es ist. Man wusste es nur zu jener Zeit nicht!“ sagte er.

Das beste Klimamodell der Welt?

„Gewaltige Anstrengungen würde man hinsichtlich der Genauigkeit der Prognosen machen, was zum besten Klimamodell der Welt führen würde“, sagte McKitrick während eines Gesprächs im House of Lords in London.

Theoretisch ist eine Kohlenstoffsteuer der effektivste Weg, CO2-Emissionen zu reduzieren, sagte McKitrick. In der Praxis jedoch sind Kohlenstoffsteuern – wie jene in Australien, Finnland und dem US-Staat Colorado – bis zu einem bestimmten Grad erfolgreich und bleiben dann in politischen Zwistigkeiten stecken.

Viel Uneinigkeit erhebt sich darüber, wie sich die Steuerrate mit der Zeit ändern sollte, sagte McKitrick, und „selbst wenn sich die Leute über die Anfangsrate einigen könnten, wären sie sich doch in vielen Fällen über den Weg zu Anpassungen uneins“.

Ein Problem sind einander widersprechende Meinungen über die mit der globalen Erwärmung verbundenen Risiken. Diejenigen, die sich über die Auswirkungen des CO2 auf das Klima die meisten Sorgen machen, favorisieren allgemein einen schnellen Anstieg der Steuerrate mit der Zeit, um die Emissionen am effektivsten zu verlangsamen. Diejenigen, die sich über die globale Erwärmung keine Sorgen machen, sind gegen etwas, dass sie als eine unnötige Steuererhöhung ansehen.

McKitrick glaubt, dass sein Vorschlag die Notwendigkeit dieses Arguments eliminieren würde. Aber die Einführung der Steuer auf eine Weise, die wirklich funktioniert, würde Änderungen erfordern, die für die meisten Länder gar nicht passend wären, gibt er zu. „Man muss den anderen Krimskrams los werden“, sagte er. „Kein Land kann daraus Vorteile ziehen, solange sie nicht alle ihre anderen ineffizienten Klimapolitiken einstellen“.

Aus diesem Grunde glaubt er, dass ein Land mit einer aufkeimenden oder sich entwickelnden Wirtschaft am meisten versucht sei, einen Versuch zu wagen. „Es ist eine Politik mit sehr geringem Risiko, aber auch ein geeignetes Unterfangen“, sagte er. „Am wenigsten wahrscheinlich, so etwas zu versuchen, sind Orte wie UK, wo es einen starken Überhang existierender Politiken und Interessen gibt“.

Eine Frage lautet, wie man das Einkommen au seiner Kohlenstoffsteuer am besten verwenden könnte. Ein Schlüssel zu einer politisch korrekten Kohlenstoffsteuer ist McKitrick zufolge, dass das Einkommen daraus dazu genutzt werden muss, andere Formen von Steuern zu reduzieren. Anderenfalls könnte die Steuer zu einer zusätzlichen ökonomischen Belastung werden – und zu einem politischen Risiko.

3) Ross McKitrick: Antworten für meine Kritiker

Ross McKitrick, 4. Juli 2013

Hier folgen einige Antworten auf die Hauptthemen kritischer Kommentare zu meinem Vorschlag. Ich habe sie aus Kommentaren bei Bishop Hill und Watts Up With That gezogen.

In diesen Antworten werde ich nicht die grundlegenden Argumente wiederholen, die in der Studie angesprochen werden. Es gibt einige irrige Vorstellungen von Menschen, die die Studie vor dem Posten ihrer Kritik nicht gelesen haben, aber dagegen lässt sich sehr einfach etwas tun, da die Studie online einsehbar ist.

1.Erster Kommentar: Ist das neu?

Ich erlebe gerade ein Déja vu. Hat Professor McKitrick dies nicht schon seit ein paar Jahren vorgeschlagen? Dieser sein Vorschlag ist (wie schon mal jemand gesagt hat) nicht neu. Irgendwann vor ein oder zwei Jahren hat ein um seine Wahl kämpfender US-Politiker ihn nach seinen Ansichten gefragt, und er kam mit diesem Plan heraus.

Ich arbeite an diesem Thema bereits seit einigen Jahren und habe zuvor auch darüber etwas geschrieben. Es war ursprünglich nicht als Antwort für einen US-Politiker gedacht, obgleich ich eine Note hierüber für ein Mitglied des US-Kongresses als Antwort auf seine Anfrage geschrieben habe (Dingell). Ich habe eine Reihe von Projekten zu laufen, um einige der theoretischen Details herauszufiltern. Die GWPF hat mich eingeladen, eine nicht-fachliche zusammenfassende Studie für sie zur Veröffentlichung zu erstellen und vor einem Auditorium im House of Lords einen Vortrag zu halten, und das gab mir die willkommene Chance, eine aktualisierte Zusammenfassung für das allgemeine Publikum zu schreiben. Zwei Dinge haben sich geändert, seit ich darüber zum ersten Mal etwas geschrieben habe: Erstens gibt es inzwischen eine formelle Herkunft des Steuergesetzes (veröffentlicht in Energy Economics im Jahr 2010), und zweitens habe ich das Konzept eines zukünftigen Marktes in den Vorschlag eingearbeitet, basierend auf einer Idee von Shi-Ling Hsu. – Vollständige Antwort

Übersetzt und mit einer Einführung versehen von Chris Frey EIKE