Kommentare zum UKMO-Bericht über „die gegenwärtige Pause bei der globalen Erwärmung“

Das UKMO wiederholt hier immer die gleichen ausgelatschten Entschuldigungen. Als Folge spricht dieser Bericht Themen an und präsentiert Daten, um die es schon in früheren Beiträgen gegangen war. Mit anderen Worten, Teile des Folgenden sind einfach wiedergekäute Themen, über die wir früher schon gesprochen haben. Und wie ich es in meinen Beiträgen immer mache, habe ich mir das Beste zum Schluss aufgehoben: Ich glaube nicht, dass das UKMO eine Verlangsamung des ozeanischen Wärmegehaltes während des letzten Jahrzehnts oder so zeigen wollte, oder seit Anfang dieses Jahrhunderts, aber genau das haben sie getan.

Die Executive Summary lautet (Fettdruck von mir):

Eine große Zahl beobachteter Klima-Indikatoren zeigt unverändert Änderungen, die mit einer sich global erwärmenden Welt und mit unserem Verständnis, wie das Klimasystem funktioniert, konsistent sind

Die globale Temperatur ist seit den siebziger Jahren rapide gestiegen, seit den letzten 15 Jahren bis zum Jahr 2013 aber relativ flach verlaufen. Dies hat zu Spekulationen geführt, dass die vom Menschen verursachte globale Erwärmung nicht mehr im Gange ist, oder dass der menschliche Einfluss zumindest geringer ist als vorhergesagt. Andere halten dies für einen vorübergehenden Stillstand und glauben, dass die Temperatur erneut mit den zuvor beobachteten Raten steigen wird.

Diese Studie ist der erste in einer Reihe von drei Berichten des Met. Office Hadley Centre, der auf den jüngsten Stillstand hinsichtlich der globalen Erwärmung eingeht und danach trachtet, die folgenden Fragen zu beantworten. Wie lagen die Trends anderer Indikatoren des Klimas während dieser Periode; was verursacht zum größten Teil den gegenwärtigen Stillstand, und in welchem Umfang beeinflusst der gegenwärtige Stillstand unsere Projektionen des zukünftigen Klimas?

Die Wetter- und Klimawissenschaft gründet sich auf das Beobachten und Verstehen unserer komplexen und sich entwickelnden Umwelt. Die fundamentalen physikalischen Gesetze des Systems Erde bilden die Basis für die Entwicklung numerischer Modelle, welche unser Verständnis des Gesamt-Klimasystems einschließen (d. h. Atomsphäre, Ozean, Land und Cryosphäre). Sie gestatten uns, Projektionen seiner Entwicklung anzufertigen.

Es ist daher eine inhärente Notwendigkeit, dass die Klimawissenschaftler über die bestmöglichen Informationen des gegenwärtigen Klimastatus’ und über den historischen Zusammenhang verfügen. Dies erfordert sehr genaue, global verteilte Beobachtungen, Monitoring-Systeme und Netzwerke. Erforderlich sind auch eine belastbare Datenverarbeitung und Analysen, um riesige Datenmengen zu erfassen. Außerdem muss man Beobachtungs-Unsicherheiten berücksichtigen, sowohl durch Grenzen der Messbarkeit als auch durch Lücken in den Beobachtungen, sowohl räumlich als auch zeitlich. Nur mit angemessener Sorgfalt und dem Anbringen rigoroser, unverzerrter wissenschaftlicher Hypothesen können Klimawissenschaftler das vollständigste Bild des Zustands zeigen, ebenso wie Trends sowie die Variabilität der vielen Variablen des Klimasystems. Dies bildet die Basis, auf der die Beweise und die von den Verbrauchern geforderte Beratung beruhen.

Dieses Dokument präsentiert eine kurze Synthese dieses globalen Bildes, wie es heute aussieht. Ein umfangreicheres Briefing wird in Zusammenarbeit mit einer großen Zahl von Wissenschaftlern jedes Jahr erstellt und in einem Special Supplement im Bulletin of the American Meteorological Society (BAMS) (Blunden and Arndt, 2013) veröffentlicht.

Die Beobachtungen zeigen:

Eine große Anzahl von Klimafaktoren zeigt weiterhin Änderungen. Zum Beispiel gibt es einen beobachteten fortgesetzten Rückgang des arktischen Meereises und einen Anstieg des globalen Meeresspiegels. Diese Änderungen sind mit unserem Verständnis konsistent, wie das Klimasystem auf den zunehmenden atmosphärischen Gehalt von Treibhausgasen reagiert.

Die globalen Temperaturen bleiben hoch, wobei das letzte Jahrzehnt das wärmste jemals war.

Zwar sieht es so aus, als ob sich die Rate der Erwärmung während dieses Jahrzehnts merklich verlangsamt hat, doch gab es derartige Phasen auch schon für ein Jahrzehnt oder so in der Vergangenheit in den Beobachtungen. Sie werden in den Klimamodellen simuliert, in denen es vorübergehende Ereignisse sind.

Soweit UKMO. Wir werden im Folgenden jeden fett gedruckten Punkt ansprechen.

DER STILLSTAND IST UNGEWÖHNLICH IN EINER WELT, VON DER MAN GLAUBT, DASS EINE ERWÄRMUNG DURCH TREIBHAUSGASE SEIT MITTE DER SIEBZIGER JAHRE DOMINIEREND WAR.

Beginnen wir mit dem letzten Absatz der Executive Summary:

„Zwar sieht es so aus, als ob sich die Rate der Erwärmung während dieses Jahrzehnts merklich verlangsamt hat, doch gab es derartige Phasen auch schon für ein Jahrzehnt oder so in der Vergangenheit in den Beobachtungen. Sie wird in den Klimamodellen simuliert, in denen es vorübergehende Ereignisse sind“.

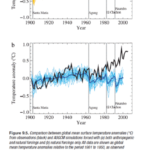

Es scheint, dass das UKMO eine ganze Reihe von Punkten übersehen hat. Erstens hat das IPCC etwas präsentiert, von dem es behauptet, dass es auf Klimamodellen basierende Beweise sind, dass nur vom Menschen emittierte Treibhausgase die Erwärmung der letzten 30 Jahre hervorgerufen haben können. Man schaue in die Präsentation und die Diskussion der Abbildung 9.5 im 4. Zustandsbericht. Sie wird hier als Abbildung 1 reproduziert. Sie stammt aus Kapitel 9: Understanding and Attributing Climate Change, und zwar im Abschnitt mit der Überschrift „9.4.1.2 Simulations of the 20th Century”.

Der begleitende Text der IPCC-Abbildung 9.5 lautet:

„Abbildung 9.5 zeigt, dass Simulationen, die den anthropogenen Antrieb einbeziehen einschließlich zunehmender Treibhausgas-Konzentrationen und der Auswirkungen von Aerosolen sowie auch natürlicher externer Antriebe eine konsistente Erklärung für die beobachtete Temperaturaufzeichnung bieten, während Simulationen, die ausschließlich die natürlichen Antriebe betrachten, die beobachtete Erwärmung der letzten drei Jahrzehnte nicht zeigen.“

Das IPCC wollte die Völker der Welt – und noch wichtiger, die Gesetzgeber – glauben machen, dass nur anthropogene Treibhausgase die Erwärmung seit Mitte der siebziger Jahre erklären können.

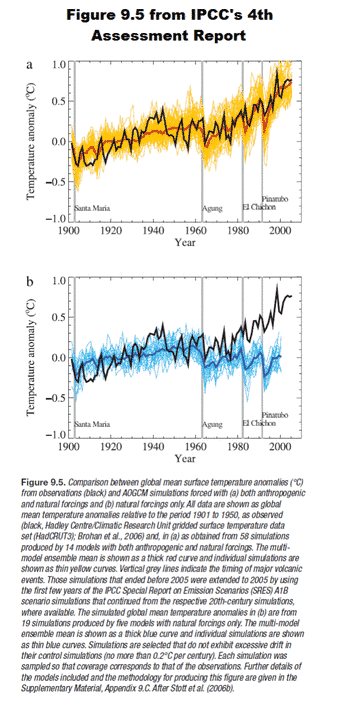

Dann zeigten sie den vorhergesagten Anstieg der globalen Temperatur basierend auf Projektionen des zukünftigen Antriebs durch Treibhausgase. Dies haben sie illustriert in Abbildung 10.4 im AR4, die hier als Abbildung 2 reproduziert wird:

Jetzt sagt das UKMO, dass „solche Verlangsamungen für ein Jahrzehnt oder so bereits in vergangenen Beobachtungen aufgetaucht waren und in den Klimamodellen simuliert werden, wo sie vorübergehende Ereignisse sind“. Es gibt in Abbildung 2 keine Jahrzehnte langen Pausen der projizierten globalen Temperatur für die Szenarien A2, A1B oder B2. Die globalen Temperaturen reagieren jedoch ähnlich auf das „Constant Composition Commitment“ [?], welches dem IPCC zufolge bedeutet, dass „Treibhausgas-Konzentrationen auf dem Niveau des Jahres 2000 festgeschrieben werden“. Und doch steigen die Treibhausgas-Konzentrationen unvermindert weiter.

Und die Aufzeichnungen der Temperatur zeigen nicht nur, dass „eine solche Verlangsamung seit einem Jahrzehnt oder so nicht nur in Beobachtungen der Vergangenheit erkennbar war“, sondern auch, dass ein solcher Stillstand viele Jahrzehnte andauern kann. Man betrachte die Beobachtungsdaten (schwarze Kurven) in Abbildung 1. Sie zeigen einen Stillstand oder einen Rückgang von Anfang der vierziger Jahre bis Mitte der siebziger Jahre.

Glaubt das UK Met Office, dass wir uns nur so kurz erinnern oder dass wir Graphen des zeitlichen Verlaufes nicht lesen können?

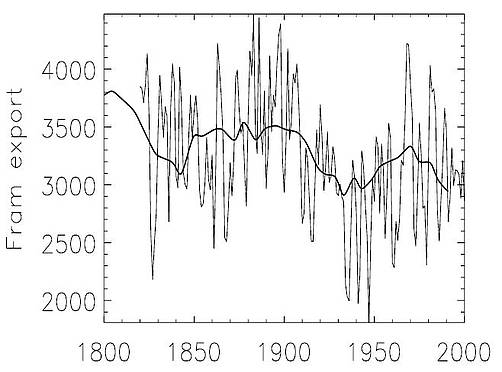

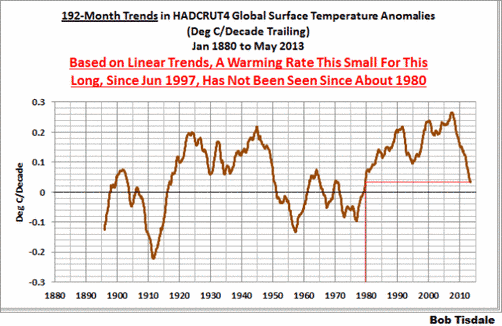

Zweitens, die öffentliche Aufmerksamkeit für den Stillstand der Erwärmung schoss in die Höhe mit dem Artikel von David Rose in der Daily Mail mit dem Titel “Global warming stopped 16 years ago, reveals Met Office report quietly released… and here is the chart to prove it” [etwa: die globale Erwärmung hat vor 16 Jahren angehalten, enthüllt ein stillschweigend veröffentlichter Bericht des Met. Office … und hier ist die Graphik, die das beweist]. Ich habe die Graphik von David Rose in meiner Antwort auf den Artikel von Kevin Trenberth von der Royal Meteorological Society aktualisiert. Darin zeige ich, dass die Temperaturen im April 2013 im Wesentlichen die gleichen waren wie im Juni 1997. Seitdem habe ich den Juni 1997 als Startmonat für Graphen benutzt, die gleitende 16-Jahres-Trends zeigen, und die ständig aktualisiert und jeden Monat ausgeweitet werden. Der Zeitraum ist jetzt 192 Monate lang. Man betrachte die folgende Graphik eines gleitenden 192-Monate-Trends von Januar 1880 bis Mai 2013 in Abbildung 3, in der die Anomalien der globalen Temperatur nach HADCRUT4 verwendet werden. Die Graphik zeigt Trends der globalen Temperaturanomalien – nicht die Temperaturanomalien. Der letzte Datenpunkt in dieser Graphik ist der lineare Trend von Juni 1997 bis zum Mai 2013 (in Grad Celsius pro Jahrzehnt). Er ist leicht positiv, was einen Erwärmungstrend von etwa 0,03°C pro Jahrzehnt bedeutet. Und das zeigt natürlich, dass sich die globale Temperatur viel langsamer erwärmt hat als von den Klimamodellen während des jüngsten 192-Monate-Zeitraumes vorhergesagt. Geht man zeitlich zurück, repräsentiert der vorletzte Datenpunkt den linearen Trend für den 192-Monate-Zeitraum von Mai 1997 bis April 2013, und der Datenpunkt davor den Trend von April 1997 bis März 2013, und so fort. Das letzte Mal hat sich die Temperatur mit der minimalen Rate von 0,03°C pro Jahrzehnt in einem 192-Monate-Zeitraum um das Jahr 1980 erwärmt.

Wie ich in meinem Beitrag Open Letter to the Royal Meteorological Society Regarding Dr. Trenberth’s Article “Has Global Warming Stalled?” geschrieben habe, hat Kevin Trenberth von der NCAR über 10 Jahre gemittelte Temperaturen präsentiert, und zwar in seinem Artikel für die Royal Meteorological Society. Er hat versucht zu zeigen, dass der derzeitige Stillstand der globalen Erwärmung seit 2001 nicht ungewöhnlich sei. Bequemerweise hat er die Tatsache übersehen, dass der Stillstand, basierend auf seinem Startzeitpunkt, dem Jahr 2001, bereits über 12 Jahre andauert, nicht 10.

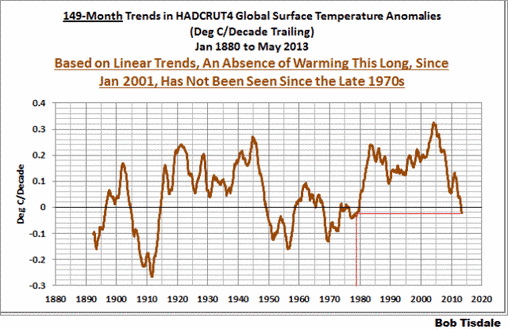

Der Zeitraum von Januar 2001 bis Mai 2013 ist inzwischen 149 Monate lang. Man betrachte Abbildung 4, also den Verlauf eines gleitenden 149-Monate-Trends von Januar 1880 bis Mai 2013, wieder mit den HADCRUT4-Daten der Temperaturanomalien. Sie wurden in gleicher Weise aufbereitet wie in der Abbildung zuvor, nur das jetzt eine Sequenz von 149 Monaten gewählt worden ist. Die höchste, auf deren linearem Trend basierende Erwärmungsrate in letzter Zeit ereignete sich während des 149-Monate-Zeitraumes, der Ende 2003 zu Ende gegangen war. Seitdem jedoch sind die Erwärmungstrends drastisch gefallen. Man beachte auch, dass Ende der siebziger Jahre zum letzten Mal ein 149-Monate-Zeitraum ohne jede Erwärmung aufgetreten war – bis jetzt.

Abbildungen 3 und 4 stammen aus dem Blogbeitrag June 2013 Global Surface (Land+Ocean) Temperature Anomaly Update.

Fazit: Der gegenwärtige Stillstand der Erwärmung ist ungewöhnlich. So etwas gab es seit Ende der siebziger Jahre oder dem Jahr 1980 nicht mehr. Und den IPCC-Klimamodellen zufolge, gezeigt in ihrer Abbildung 10.4 (meine Abbildung 2) war kein Stillstand vorhergesagt worden.

Glaubt das UKMO, dass sich die globale Temperatur wie von Zauberhand abkühlen wird?

In der von mir fett gedruckt dargestellten Passage der UKMO-Executive Summary schrieben sie:

Die globale mittlere Temperatur bleibt hoch, wobei die letzte Dekade die wärmste jemals gewesen ist.

Natürlich, „die globale Temperatur bleibt hoch…” Wo hat das UKMO festgestellt, dass die globale Temperatur während der Stillstandsperiode gesunken wäre? Es scheint, als greife das UKMO nach Strohhalmen.

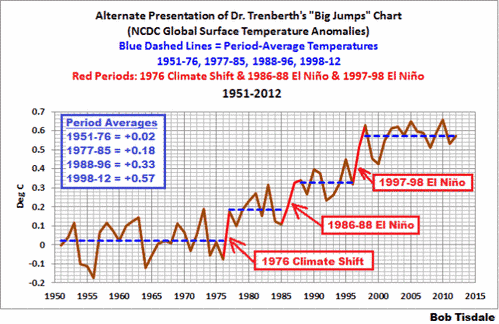

Und natürlich war das vergangene Jahrzehnt das wärmste jemals. Wie ich in meinem offenen Brief an die Royal Meteorological Society zu Kevin Trenberths Artikel „Has Global Warming Stalled?“ geschrieben habe, gab es drei natürliche Ereignisse, die die achtziger Jahre wärmer werden ließen als die siebziger Jahre, die neunziger Jahre wärmer als die achtziger Jahre und das Erste Jahrzehnt dieses Jahrhunderts wärmer als die neunziger Jahre.

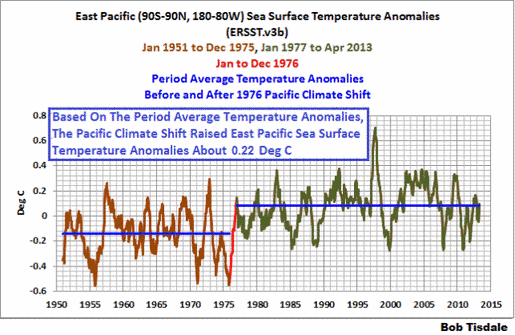

Die Pazifische Klimaverschiebung des Jahres 1976 verursachte im Ostpazifik einen Temperaturanstieg von 0,22°C. Siehe Abbildung 5! Es gibt zahlreiche begutachtete Studien über diese Verschiebung, aber keine allgemeine Übereinstimmung über deren Gründe. Die globale Temperatur rund um die Welt reagiert auf diese Verschiebung mit atmosphärischen Sattelpunkten und Fernauswirkungen.

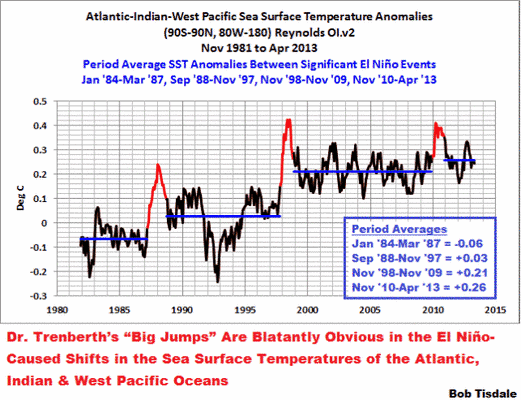

Die Wassertemperaturen des Atlantik, Indik und Westpazifik (90S-90N, 80W-180) zeigten ebenfalls Verschiebungen mit einem Anstieg. Für diese jedoch verstehen wir die Gründe. Siehe Abbildung 6! Basierend auf den gemittelten Temperaturanomalien über die Zeitperiode verursachte der El Niño von 1986/87/88 einen Anstieg der Wassertemperatur in den genannten Meeresgebieten um 0,09°C. Die Wassertemperatur in diesen Regionen stieg nochmals um etwa 0,18°C im Gefolge des El Niño von 1997/1998. Der El Niño von 2009/2010 scheint einen geringen Anstieg um etwa 0,05°C verursacht zu haben.

Die Gemeinschaft der Klimawissenschaft hat sich entschlossen, diese von El Niño verursachten Anstiege zu ignorieren, und zwar aus zwei Gründen: Erstens, weil hier dokumentiert wird, dass die Wassertemperatur der globalen Ozeane aufgrund natürlicher Ereignisse steigt. Und zweitens, weil es den Klimamodellierern selbst nach Jahrzehnten intensivster Bemühungen bislang nicht gelungen ist, die Ereignisse El Niño und La Niña angemessen zu simulieren.

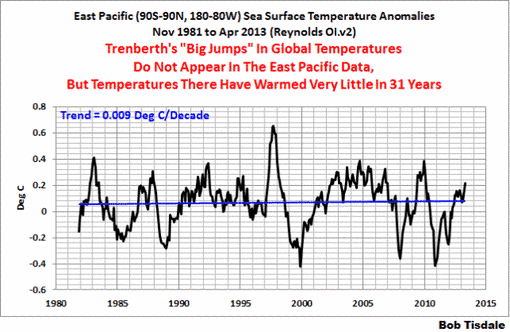

Und auch aus Abbildung 6 gehen zwei Punkte eindeutig hervor: Erstens, die Erwärmung des Wassers in den vorgenannten Meeresgebieten (oder in 67% der Weltozeane) hängt von starken El Niño-Ereignissen ab. Oder anders ausgedrückt, ohne diese El Niño-Ereignisse würden die Wassertemperaturen im Atlantischen, Indischen und Westpazifischen Ozean nur eine geringe oder gar keine Erwärmung zeigen. Dies zeigt natürlich, dass sich der Stillstand der globalen Erwärmung bis zum nächsten starken El Niño fortsetzen wird. Zweitens: Die La Niña-Ereignisse, die den El Niños von 1986/87/88, 1997/98 und 2009/10 folgten, hatten keine verhältnismäßige Auswirkung auf die Wassertemperatur in diesen Ozeanen. Lediglich die Wassertemperatur im Ostpazifik sank proportional während dieser La Niñas, Abbildung 7, aber die Wassertemperaturen dort über 31 Jahre lang nicht gestiegen.

Wie ich im oben verlinkten Beitrag über Trenberths Artikel für die Royal Meteorological Society geschrieben habe – falls diese auf natürliche Weise stattfindenden, von El Niños verursachten Anstiege der Wassertemperatur für Sie neu sind, schauen Sie in mein bebildertes Essay „The Manmade Global Warming Challenge” [42MB]. Darin stelle ich eine als Einführung gedachte Diskussion der natürlichen Prozesse vor, die solche Sprünge verursachen. Im Prinzip werden diese Sprünge durch warmes Wasser verursacht, das nach starken El Niño-Ereignissen zurückbleibt – das von den El Niños erwärmte Wasser verschwindet nach deren Abklingen nicht sogleich. Der Essay enthält auch Links zu animierten Karten mit den Daten. Darin kann man das Auftreten dieser Verschiebungen erkennen und sich klar machen, woher wir von diesem übrig gebliebenen Warmwasser wissen. Am wichtigsten aber, man kann erkennen, warum man La Niña und El Niño-Ereignisse betrachten sollte, nämlich nicht als Rauschen in den Instrumenten-Temperaturaufzeichnungen, sondern als einen natürlich stattfindenden chaotischen Oszillator. Das Sonnenlicht und nicht infrarote Strahlung nimmt im tropischen Pazifik während eines La Niña zu. Das heißt, die Daten zeigen, dass die steigenden Wassertemperaturen durch die El Niños durch Sonnenlicht angetrieben wurden, nicht durch Treibhausgase. Wir besprechen dies noch detaillierter bei der Diskussion über den ozeanischen Wärmegehalt in einem späteren Beitrag.

In jenem Beitrag über den Trenberth-Artikel an die RMS habe ich auch eine Graphik gezeigt, die ich die Alternierende Präsentation von Dr. Trenberths „großen Sprüngen“ genannt habe. Siehe Abbildung 8! Ich habe die Graphik im Jahre 1951 beginnen lassen, so dass die Reaktion auf die Klimaverschiebung im Pazifik 1976 im Ostpazifik sichtbar wird. Und ich habe auch die Zeitspannen verändert, um diese Sprünge zu isolieren von den Sprüngen im Zuge der El Niño-Ereignisse der Jahre 1986/87/88 und 1997/98. Die natürlichen Beiträge zum Anstieg der globalen Temperatur sind nur zu offensichtlich.

Jetzt wollen wir noch einmal die UKMO-Verlautbarung betrachten, die wir unter dieser Überschrift besprochen haben:

„Die globale Temperatur verharrt auf hohem Niveau, wobei die letzte Dekade die wärmste jemals war“.

Natürlich war es das. Es war das wärmste jemals, weil das Rest-Warmwasser des El Niño von 1997/98 den Auswirkungen des folgenden La Niña entgegen wirkte und zu den Anstiegen der Wassertemperatur im Atlantischen, dem Indischen und dem Westpazifischen Ozean geführt hat. Man erinnere sich, diese Meeresgebiete überdecken etwa 67% der Oberfläche der globalen Ozeane. Die Land-Temperaturen für weite Teile der Welt machen dieses Verhalten der Wassertemperatur einfach mit.

Über das arktische Meereis und den Meeresspiegel

Jetzt wollen wir uns ein anderes unsägliches Zitat aus der Executive Summary Teil 1 des UKMO vornehmen:

„Eine große Zahl beobachteter Klima-Indikatoren zeigt unverändert Änderungen, die mit einer sich global erwärmenden Welt und mit unserem Verständnis, wie das Klimasystem funktioniert, konsistent sind“.

Was das UKMO nicht sagt: Der Meeresspiegel würde weiterhin steigen, völlig unabhängig von der gegenwärtigen Temperatur. Ich möchte einen Absatz aus der Einführung meines demnächst erscheinenden Buches zitieren (Arbeitstitel Climate Models are Crap). Darin heißt es nach derzeitigem Stand:

Der Meeresspiegel ist ebenfalls von Interesse, vor allem für Küsten- und Inselbewohner. Unglücklicherweise liegen die Ergebnisse von Klimamodell-Simulationen nicht in einfach zu interpretierenden Formaten vor, daher finden sich in diesem Buch keine Vergleiche zwischen Modell und Daten. Unabhängig davon halten Viele möglicherweise steigende Meeresspiegel für eine bestätigte Tatsache. Der Meeresspiegel ist seit dem Ende der letzten Eiszeit um 100 bis 120 Meter gestiegen, und er lag weitere 4 bis 8 Meter höher als heute während der Eemian-Zwischeneiszeit (der letzten interglazialen Periode). (Siehe hierzu die Presseerklärung zu der Studie von Dahl-Jensen et al. mit dem Titel Eemian interglacial reconstructed from a Greenland folded ice core). Unabhängig von der Ursache … besser gesagt: egal ob wir die Treibhausgas-Emissionen kappen oder nicht, sollten die Temperaturen auf dem derzeitigen Niveau verharren oder weiter steigen oder selbst bei einer geringen Abkühlung während der kommenden Jahrzehnte, wird der Meeresspiegel wahrscheinlich weiter steigen. Siehe hierzu den Beitrag von Roger Pielke Jr. How Much Sea Level Rise Would be Avoided by Aggressive CO2 Reductions? Es ist sehr gut möglich, dass der Meeresspiegel zum Ende des Holozäns (des aktuellen Interglazials) das Niveau wie während der Eemian-Zeit erreicht. Nach Meinung einiger Leser könnte die Frage nicht lauten, ob, sondern wann er diese Höhe erreicht.

Roger Pielke, Jr.’s Beitrag (linked above) ist lesenswert.

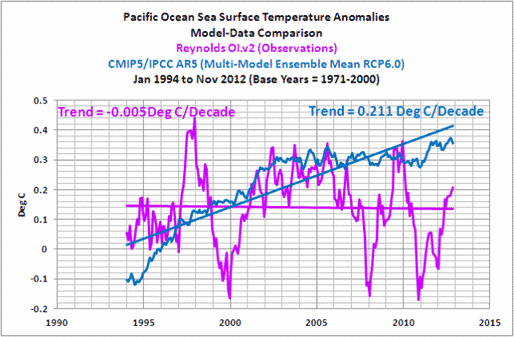

Hinsichtlich des arktischen Meereises müssen wir zunächst über die Wassertemperatur reden. Wir haben seit über 4 Jahren gezeigt und erklärt, dass die Temperaturaufzeichnungen mittels Satelliten die Erwärmung als Folge von natürlich auftretenden Ereignissen aufgetreten ist und nicht durch menschliche Treibhausgase. Noch einmal der Hinweis auf den Essay „The Manmade Global Warming Challenge” [42MB], wenn diese Diskussion für Sie neu ist. Und wir haben auch gezeigt, dass sich der Pazifik als Ganzes seit fast 2 Jahrzehnten nicht mehr erwärmt hat, wie Abbildung 9 zeigt (Abbildung 9 stammt aus diesem Beitrag).

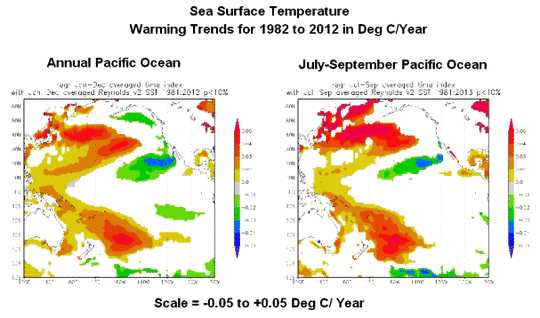

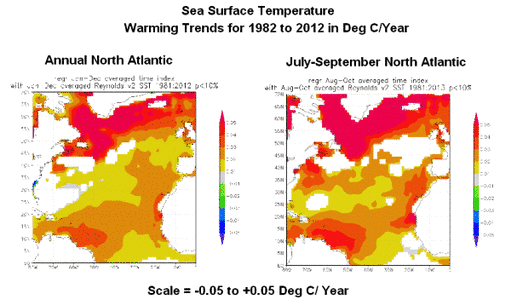

Die linke Karte in Abbildung 10 zeigt die jährlichen Trends der Wassertemperaturen im Pazifik von 1982 bis 2012. Man sieht, dass sich einige Regionen während dieser Zeit erwärmt haben, vor allem in den zentralen und westlichen mittleren Breiten des Nordpazifik. Wenn wir jedoch auf die Trends in den Quartalen mit der höchsten saisonalen arktischen Schmelzrate schauen, also Juli bis September, fallen die Erwärmungsraten in Teilen der höheren Breiten des Nordpazifik ziemlich hoch aus. Das zeigt die rechte Karte in der Abbildung.

Wir haben auch gezeigt, dass die Wassertemperaturen im Nordatlantik einen zusätzlichen Modus jahreszeitlicher Variabilität aufweisen, bekannt unter der Bezeichnung Atlantische Multidekadische Oszillation AMO. (Weiteres zur AMO bei NOAA/AOML FAQ hier, in meinem Blogbeitrag hier und in meiner Einführung zur AMO hier.) Als Folge hat sich der Nordatlantik seit Mitte der siebziger Jahre auf natürliche Weise mit einer Rate erwärmt, die höher war als in den übrigen Ozeanen, die sich ebenfalls aufgrund natürlicher Ereignisse erwärmt haben und nicht aufgrund von Treibhausgas-Emissionen.

Aber wie die Karte der jährlichen Trends im Nordatlatik zeigt (linke Karte in Abbildung 11) erfolgte die stärkste Erwärmung in hohen Breiten. Und das gilt auch und vor allem für die stärkste jährliche Abschmelzrate des arktischen Meereises von Juli bis September, was die rechte Karte zeigt.

Vergleicht man die hohen Breiten im Nordpazifik und im Nordatlantik, weist Letzterer hinsichtlich der Wassertemperatur eindeutig die höhere Erwärmungsrate als Folge der AMO auf.

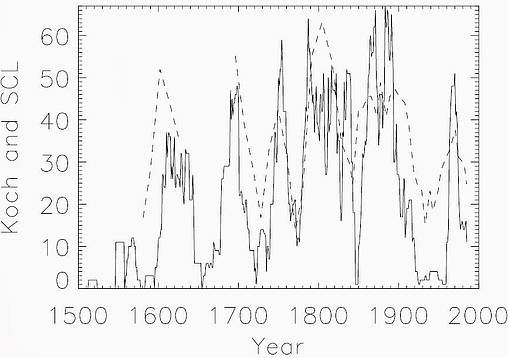

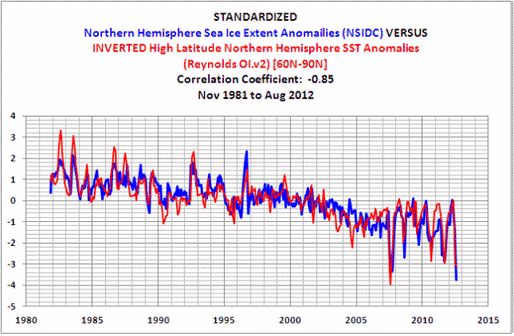

Das führt uns zur Betrachtung des arktischen Meereises. Wir betrachteten die Auswirkungen der Meereis-Ausdehnung auf eine ganze Anzahl von Datensätzen, nämlich Wassertemperatur, Temperatur der unteren Troposphäre und Temperatur an Land in dem Beitrag How Much of an Impact Does the Atlantic Multidecadal Oscillation Have on Arctic Sea Ice Extent? [etwa: wie groß ist der Einfluss der AMO auf die arktische Meereis-Ausdehnung?] Von allen gezeigten Datensätzen war der Datensatz mit der größten Übereinstimmung – der höchsten Korrelation – mit der Eisausdehnung derjenige mit den Anomalien der Wassertemperatur in den hohen Breiten der Nordhemisphäre (60 N bis 90 N). Siehe Abbildung 12! Die arktische Meereis-Ausdehnung und die Wassertemperaturen in hohen Breiten der Nordhemisphäre wiesen einen Korrelations-Koeffizienten von 0,85 auf. Die Korrelationen der arktischen Meereis-Ausdehnung mit den Temperaturanomalien in der unteren Troposphäre und der Anomalien mit den Temperaturen über Land waren viel geringer (beide in hohen Breiten: 60 N bis 90 N).

Am Ende dieses Beitrags findet sich Folgendes:

Da es keine Beweise für eine vom Menschen verursachte Komponente hinsichtlich der Erwärmung der globalen Ozeane während der letzten 30 Jahre gibt, leistete die natürliche zusätzliche Erwärmung der Wassertemperaturen im Nordatlantik – höher als die natürliche Erwärmung aller anderen globalen Ozeane – einen wesentlichen Beitrag zum natürlichen Eisverlust des arktischen Meereises während der Satelliten-Ära. Man füge jetzt noch die Wetterereignisse hinzu, zu denen es alle paar Jahre kommt. Dann können wir guten Gewissens die Aufregung um den Rekord-Eisverlust in der Arktis im Jahr 2012 vergessen.

Klimamodelle

Nun zum nächsten Punkt der unwahren Behauptungen in der Executive Summary im UKMO-Bericht. Dort heißt es:

Die fundamentalen physikalischen Gesetze des Systems Erde bilden die Basis für die Entwicklung numerischer Modelle, welche unser Verständnis des Gesamt-Klimasystems einschließen (d. h. Atomsphäre, Ozean, Land und Cryosphäre). Sie gestatten uns, Projektionen seiner Entwicklung anzufertigen.

In einer ganzen Reihe von Beiträgen während der letzten Monate haben wir gezeigt, dass die Klimamodelle zur Vorbereitung des kommenden 5. Zustandsberichtes keinerlei Neigung zeigen, die folgenden Phänomene zu simulieren:

● Global Land Precipitation & Global Ocean Precipitation

● Global Surface Temperatures (Land+Ocean) Since 1880

● Greenland and Iceland Land Surface Air Temperature Anomalies

● Scandinavian Land Surface Air Temperature Anomalies

● Alaska Land Surface Air Temperatures

● Daily Maximum and Minimum Temperatures and the Diurnal Temperature Range

● Satellite-Era Sea Surface Temperatures

Und jüngst haben wir in dem Beitrag Meehl et al (2013) Are Also Looking for Trenberth’s Missing Heat [etwa: Meehl et al. (2013) suchen ebenfalls nach der von Trenberth vermissten Wärme] gezeigt, dass die in jener Studie verwendeten Klimamodelle keinen Beweis zeigen, dass sie in der Lage sein könnten zu simulieren, wie warmes Wasser aus den Tropen zu den mittleren Breiten des Pazifik transportiert werden könnte. Warum also sollten wir dann glauben, dass sie simulieren können, wie warmes Wasser in Tiefen unter 700 m transportiert werden könnte, ohne dass sich das Wasser der oberen 700 m erwärmt?

Die Gemeinde der Klimawissenschaft mag glauben, dass sie „die fundamentale Physik des Erdsystems“ versteht, aber die Performance ihrer Modelle zeigt, dass ihr Verständnis sehr begrenzt ist und dass sie noch einen langen Weg zurücklegen muss, bevor sie „Projektionen der Entwicklung“ erstellen kann. Wenn man die Vergangenheit nicht simulieren kann, gibt es keinen Grund, dem zu glauben, was ihre Projektionen für die Zukunft bereit halten.

Noch rasch etwas zum Wärmegehalt der Ozeane

Das UKMO hatte über den ozeanischen Wärmegehalt Folgendes zu sagen (Fettdruck von mir):

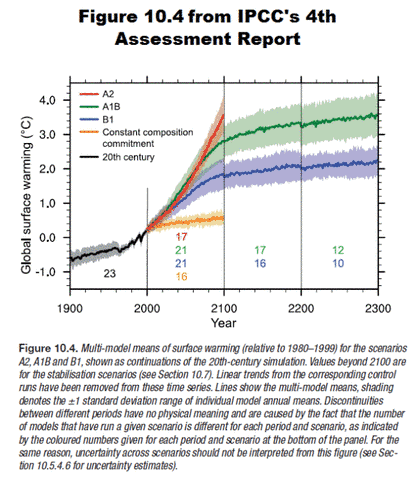

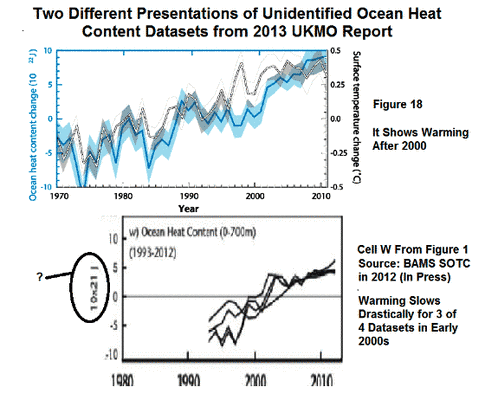

Seit etwas dem Jahr 2000 hat das ARGO-Bojensystem dafür gesorgt, dass wir eine fast globale Abdeckung der Wassertemperatur bis zu einer Tiefe von 700 m haben (15% bis 20% der mittleren Tiefe im offenen Ozean). Neuere Bojen messen bis zu einer Tiefe von 2000 m. Allerdings sind die eisbedeckten Gebiete und die Randmeere immer noch eine Herausforderung. Kombiniert man die Daten der ARGO-Bojen mit Messungen von Schiffen, kann man relativ langzeitliche Schätzungen der in den oberen 700 m gespeicherten Wärme vornehmen (Abbildung 18). Der Vergleich dieser Aufzeichnungen mit den Temperaturaufzeichnungen an Land zeigt trotz der Erwärmungspause seit dem Jahr 2000 einen Anstieg des Wärmegehalts im oberen Ozean.

Abbildung 18 aus dem UKMO-Bericht findet sich im oberen Kasten meiner Abbildung 13. Ich habe vieles der Temperaturdaten an Land gekennzeichnet, um die Daten des ozeanischen Wärmegehaltes zu beleuchten. Das UKMO hat den Datensatz des ozeanischen Wärmegehaltes in einer Tiefe von 0 bis 700 m nicht identifiziert; man hat lediglich in der Bildunterschrift darauf hingewiesen, dass der Datensatz der Temperaturdaten an Land der von HADCRUT4 ist. Im Text seines Berichtes bezog sich das UKMO auf Levitus et al. (2012). Aber der obere Kasten in Abbildung 13 (Abbildung 18 im UKMO-Bericht) zeigt nicht den ozeanischen Wärmegehalt von 0 bis 700 Metern. Die NODC-Daten des ozeanischen Wärmegehalts zeigen von den achtziger Jahren bis zu Beginn dieses Jahrhunderts keine Abkühlung, anders als beim UKMO dargestellt.

Der untere Kasten in meiner Abbildung 13 zeigt ebenfalls eine Graphik der Daten des ozeanischen Wärmegehaltes aus dem UKMO-Bericht. Sie war in ihrer Abbildung 1 als Kasten W eingefügt. Das UKMO merkt an, dass das aus dem Bulletin der American Meteorology „State of the Climate 2012“ von Blunden und Arndt (2013) stammt. Dieser Bericht wird gerade gedruckt, so dass wir den Quellen der Daten bzgl. des Wärmegehaltes nicht folgen können.

Wie man bemerken wird, zeigen in der unteren Graphik 3 der 4 nicht identifizierten Datensätze des ozeanischen Wärmegehaltes von 0 bis 700 m, dass sich die Erwärmung der Ozeane bis zum Schneckentempo verlangsamt hat mit Beginn Anfang des 21. Jahrhunderts. Diese drei Datensätze widersprechen der UKMO-Feststellung, dass „…trotz der Erwärmungspause seit dem Jahr 2000 der ozeanische Wärmegehalt in den oberen Schichten der Ozeane weiterhin steigt“.

Schlussbemerkung

Ich muss dem Titel des Beitrags von Bishop Hill über den UKMO-Bericht zustimmen, der da lautet: Ihr Schiff sinkt. Wird drehen helfen?

Wir werden in einigen Tagen einen Blick auf Teil 2 ihres Berichtes werfen. In der Zwischenzeit schreibe ich weiter an meinem Buch Climate Models are Crap.

Übersetzt von Chris Frey EIKE